循环神经网络(RNN):概念、挑战与应用

循环神经网络(RNN):概念、挑战与应用

1 引言

1.1 简要回顾 RNN 在深度学习中的位置与重要性

在深度学习的壮丽图景中,循环神经网络(Recurrent Neural Networks,RNN)占据着不可或缺的地位。自从1980年代被提出以来,RNN已经从一个理论模型演变为处理序列数据的强大工具,尤其是在自然语言处理(NLP)、语音识别和时间序列分析等领域。RNN之所以重要,是因为它们能够捕捉到数据中随时间演变的动态模式,这是传统的前馈神经网络所无法做到的。

在RNN的模型中,我们引入了时间维度,每个节点不仅接收前一层的信息,还会接收前一时刻自身的输出。这个独特的反馈机制赋予了RNN处理序列和时间数据的能力,使之能够储存并利用历史信息来影响当前和未来的决策。

数学上,RNN可以表示为一系列的递归方程:

h t = f ( W ⋅ h t − 1 + U ⋅ x t + b ) h_t = f(W \cdot h_{t-1} + U \cdot x_t + b) ht=f(W⋅ht−1+U⋅xt+b)

其中, h t h_t ht 是在时间点 t t t 的隐藏状态, f f f 是激活函数, W W W 和 U U U 是权重矩阵, b b b 是偏置项,而 x t x_t xt 是时间点 t t t 的输入。这个循环结构使得从时间点 t − 1 t-1 t−1 到 t t t 的状态转换可以通过学习数据中的序列依赖性来优化。

1.2 RNN 在处理序列数据中的核心作用

序列数据的处理无处不在,从股市的价格波动到语言中单词的排列,都是基于序列的信号。RNN能够以一种高度灵活的方式对这类数据进行建模,其核心作用体现在几个方面:

- 时间依赖性:RNN 通过其循环连接,可以捕捉到序列中时间点间的依赖关系。

- 可变长度输入的处理:与传统神经网络不同,RNN可以处理任意长度的输入序列。

- 参数共享:在RNN中,同一组参数在不同的时间步骤中被复用,这不仅减少了模型的复杂度,还提高了模型的泛化能力。

一个经典的RNN应用例子是语言模型。在这个应用中,RNN需要预测给定上文情况下,下一个最可能的单词是什么。例如,考虑一个简单的句子“天气很好,我们去___”。一个经过训练的RNN模型可能会预测空缺处的单词是“公园”,因为它已经学会了在类似上下文中,“去公园”是一个常见的活动。

在介绍了RNN的基本概念和核心作用之后,接下来的章节将进一步深入探讨RNN的内部工作原理、面临的挑战以及如何通过各种策略来克服这些挑战。我们还将了解如何将RNN应用到具体的问题中,并通过案例研究来展示它们的实际效果。随着我们对RNN及其变种的不断探索,将逐步揭开它们在处理序列数据中的强大能力和潜在的局限性。

2 RNN 基础与架构

2.1 RNN 的工作原理与基本概念

在深入探讨循环神经网络(Recurrent Neural Networks, RNNs)的工作原理之前,让我们先回顾一个核心概念:数据序列。数据序列可以是任何按特定顺序排列的数据集合,例如股票价格的时间序列、一段文字中的字词,或者是语音识别中的音频信号。RNNs 在处理此类数据时的独特之处在于其能够保存序列中先前元素的信息,并在处理当前元素时利用这些信息。

RNN 的核心是一个循环单元,它在序列的每个时间步(time step)接收两个输入:当前时间步的输入数据 x t x_t xt 以及前一个时间步的隐状态 h t − 1 h_{t-1} ht−1。隐状态是网络的记忆单元,它捕捉了序列之前步骤的信息。这个循环单元按照以下公式进行更新:

h t = σ ( W h h h t − 1 + W x h x t + b h ) h_t = \sigma(W_{hh}h_{t-1} + W_{xh}x_t + b_h) ht=σ(Whhht−1+Wxhxt+bh)

其中, h t h_t ht 是当前时间步的隐状态, σ \sigma σ 是激活函数(通常是一个非线性函数,如tanh或ReLU), W h h W_{hh} Whh 是隐状态到隐状态的权重矩阵, W x h W_{xh} Wxh 是输入到隐状态的权重矩阵, b h b_h bh 是隐状态的偏置向量。所有的时间步共享这些参数,这也就是RNNs 对参数进行节约的方式,也是它们能够处理任意长度序列的原因。

让我们举一个例子以加深理解。假设我们正在使用 RNN 来建模一个句子的生成过程。在这个例子中,序列的每个元素是一个词。网络开始于一个初始状态 h 0 h_0 h0,通常是一个零向量,然后逐个词地处理句子。当网络读入“Deep”,它会更新隐状态为 h 1 h_1 h1。这个新的隐状态现在包含了有关“Deep”这个词的信息。然后,当网络读入“Learning”时,它不仅考虑这个新词,还考虑已经累积的隐状态 h 1 h_1 h1,结果产生了新的隐状态 h 2 h_2 h2,如此继续。

2.2 展开的 RNN 网络图解

要更直观地理解 RNN,我们可以将其在时间上展开。在展开的视图中,每个时间步的循环单元都被复制并展示为一个序列。这有助于我们可视化整个序列是如何一步步通过网络传递的。展开后的RNN可以被看作是一个深度网络,其中每个时间步相当于一层。这种展开揭示了 RNN 可以被训练的方式与传统的前馈神经网络相似,即通过时间反向传播(Backpropagation Through Time, BPTT)。

在 BPTT 中,我们计算损失函数在每个时间步的值,然后将这些损失相加,得到整个序列的总损失。通过微分这个总损失,我们可以得到对应于每个权重的梯度,然后使用梯度下降或其他优化算法来更新权重。这个过程的关键在于,梯度会随着时间向后传播,影响之前时间步的权重更新。

2.3 关键元素:隐藏状态与权重参数

在 RNN 中,隐藏状态 h t h_t ht 和权重参数( W h h W_{hh} Whh, W x h W_{xh} Wxh, b h b_h bh)构成了模型的核心。隐藏状态作为传递信息的媒介,同时包含了之前时间步的信息和当前输入的影响,这是 RNN 能够处理序列数据的关键所在。权重参数则定义了这些信息如何被转换和组合。

举例来说,假设我们有一个简单的二分类问题,比如情感分析,我们试图从一句话中判断情感是正面还是负面。在这种情况下,我们的 RNN 可能会在序列的最后一个时间步输出一个预测 y t y_t yt,这个预测是基于最后一个隐状态 h t h_t ht,通过下面的公式计算的:

y t = σ ( W h y h t + b y ) y_t = \sigma(W_{hy}h_t + b_y) yt=σ(Whyht+by)

这里, W h y W_{hy} Why 是隐状态到输出层的权重矩阵, b y b_y by 是输出层的偏置向量, σ \sigma σ 可能是sigmoid函数以便输出一个介于0和1之间的概率。这个输出可以用于计算损失,进而通过BPTT更新模型的权重。

2.4 实例代码:构造一个简单的 RNN 网络

让我们看一个具体的例子,用Python来实现一个简单的RNN。这段代码不会非常复杂,但它能够给我们提供实践中构造RNN的感觉。

import numpy as npdef sigmoid(x):return 1 / (1 + np.exp(-x))class SimpleRNN:def __init__(self, input_size, hidden_size, output_size):# 权重初始化self.Wxh = np.random.randn(hidden_size, input_size)self.Whh = np.random.randn(hidden_size, hidden_size)self.Why = np.random.randn(output_size, hidden_size)self.bh = np.zeros((hidden_size, 1))self.by = np.zeros((output_size, 1))def forward(self, inputs):"""前向传播inputs: 列表,其中每个元素代表一个时间步的输入"""h = np.zeros((self.Whh.shape[0], 1))# 保存所有时间步的隐状态和输出self.hidden_states = []self.outputs = []for x in inputs:h = sigmoid(np.dot(self.Wxh, x) + np.dot(self.Whh, h) + self.bh)y = sigmoid(np.dot(self.Why, h) + self.by)self.hidden_states.append(h)self.outputs.append(y)return self.outputs# 定义网络参数

input_size = 10

hidden_size = 5

output_size = 1# 创建RNN实例

rnn = SimpleRNN(input_size, hidden_size, output_size)# 模拟的输入序列

inputs = [np.random.randn(input_size, 1) for _ in range(6)] # 假设我们有一个长度为6的序列# 前向传播

outputs = rnn.forward(inputs)

print(outputs) # 输出序列的预测

这个简单的RNN实例包含了我们讨论的所有核心元素:输入、输出、隐状态、权重矩阵、偏置向量以及激活函数。在实践中,我们还会加入损失函数和反向传播,以便训练网络。但即使在这个简化的例子中,我们也能看到 RNN 如何一步步通过序列传递信息。

在接下来的章节中,我们将探讨在训练RNNs时常见的挑战,例如梯度消失和梯度爆炸,以及如何通过技术创新,如长短期记忆网络(LSTM)和门控循环单元(GRU)来克服这些问题。

3 RNN 的挑战:梯度消失与梯度爆炸

在深入分析循环神经网络(RNN)的挑战之前,让我们快速回顾一下它们是如何工作的。RNN通过在每个时间步使用相同的权重参数和一个循环连接来处理序列数据。这种循环结构使得信息可以在网络中流动,并从之前的时间步中传递信息到当前步。然而,这种循环结构也带来了两个主要的问题:梯度消失和梯度爆炸。

3.1 详解梯度消失与梯度爆炸的原因

梯度消失和梯度爆炸是RNN训练中两个非常重要的数值稳定性问题。它们主要是由于误差梯度在通过时间反向传播时所受的影响。在反向传播过程中,梯度会通过时间反向传播到各个时间步骤,RNN的参数更新依赖于这些梯度。

梯度消失主要发生在深层网络中,当梯度在反向传播过程中经过多个层时,梯度可能会变得非常小,以至于更新的权重变化几乎不显著。这会使得训练过程非常缓慢,甚至早期层可能完全停止学习。数学上,这可以通过考虑链式法则来解释,即:

∂ L ∂ W = ∏ t = T 1 ∂ h t ∂ h t − 1 ∂ L ∂ h t \frac{\partial L}{\partial W} = \prod_{t=T}^{1} \frac{\partial h_t}{\partial h_{t-1}} \frac{\partial L}{\partial h_t} ∂W∂L=t=T∏1∂ht−1∂ht∂ht∂L

其中, ( L ) ( L ) (L)是损失函数, ( W ) ( W ) (W)是权重矩阵, ( h t ) ( h_t ) (ht)是在时间步骤 ( t ) ( t ) (t)的隐藏状态。当 ( ∂ h t ∂ h t − 1 ) ( \frac{\partial h_t}{\partial h_{t-1}} ) (∂ht−1∂ht)中包含的值小于1时,连乘积会随着时间步骤的增加而减小,导致梯度消失。

相反,梯度爆炸发生在梯度变得非常大以至于导致数值溢出。在数学上,当 ( ∂ h t ∂ h t − 1 ) ( \frac{\partial h_t}{\partial h_{t-1}} ) (∂ht−1∂ht)中的值大于1时,随着时间步的增加,连乘积会急剧增加,进而造成梯度爆炸。这会导致权重更新过大,使得模型无法收敛到一个稳定的解。

3.2 可视化:展示梯度消失与爆炸

想象一下,我们尝试可视化梯度在RNN中如何随时间变化。我们可以绘制一个图,横轴是时间步长,纵轴是梯度的大小。在理想的情况下,我们希望这个梯度能够保持相对稳定,以确保所有时间步上的权重可以得到适度的调整。然而,在实践中,这个曲线可能会急剧下降(梯度消失)或急剧上升(梯度爆炸)。

3.3 简介解决方案:权重初始化、激活函数选择等

为了解决梯度消失和梯度爆炸的问题,研究人员提出了多种解决方案:

-

权重初始化:合适的初始化方法,如Glorot初始化或He初始化,可以帮助缓解早期训练中的梯度问题。

-

激活函数选择:使用ReLU及其变体作为激活函数可以帮助缓解梯度消失问题,因为它们在正区间的梯度为常数。

-

梯度裁剪:通过设置一个阈值来裁剪梯度,可以防止梯度爆炸,从而避免了过大的权重更新。

-

使用门控机制的RNN变体:例如长短期记忆网络(LSTM)和门控循环单元(GRU),它们通过引入门控机制来调节信息的流动,这可以有效地缓解梯度消失问题。

通过采取这些措施,我们可以在一定程度上缓解RNN在训练过程中遇到的梯度问题,从而能够训练出更加稳健的模型。在后续章节中,我们将详细讨论这些解决方案,以及LSTM和GRU如何专门设计来克服这些挑战。

4 长短期记忆网络(LSTM)

在探索循环神经网络(RNN)的架构与应用时,我们面临了梯度消失与梯度爆炸的问题,这极大地限制了RNN在长序列上的性能。长短期记忆网络(LSTM)是为了解决这些问题而提出的RNN的一个变体。在这一节中,我们将深入探讨LSTM的结构,它如何克服RNN的弱点,以及它在序列建模中的应用。

4.1 LSTM 的结构与如何克服 RNN 弱点

LSTM由Hochreiter和Schmidhuber在1997年提出,其核心思想是引入了称为“门控”的结构来调节信息的流动。LSTM的关键在于它的记忆单元(cell state),它能够在整个序列中运送信息,几乎没有任何变化。LSTM通过三种类型的门控机制来维护和更新这个记忆单元:遗忘门(forget gate)、输入门(input gate)、和输出门(output gate)。

遗忘门负责决定哪些信息将被从记忆单元中抛弃,通过公式:

f t = σ ( W f ⋅ [ h t − 1 , x t ] + b f ) f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) ft=σ(Wf⋅[ht−1,xt]+bf)

其中, ( f t ) ( f_t ) (ft)是遗忘门的激活向量, ( σ ) ( \sigma ) (σ) 是sigmoid函数, ( h t − 1 ) ( h_{t-1} ) (ht−1)是前一时间步的隐藏状态, ( x t ) ( x_t ) (xt) 是当前时间步的输入, ( W f ) ( W_f ) (Wf) 和 ( b f ) ( b_f ) (bf) 是遗忘门的权重矩阵和偏置向量。

输入门决定哪些新的信息被存储在记忆单元中:

i t = σ ( W i ⋅ [ h t − 1 , x t ] + b i ) i_t = \sigma(W_i \cdot [h_{t-1}, x_t] + b_i) it=σ(Wi⋅[ht−1,xt]+bi)

C ~ t = tanh ( W C ⋅ [ h t − 1 , x t ] + b C ) \tilde{C}_t = \tanh(W_C \cdot [h_{t-1}, x_t] + b_C) C~t=tanh(WC⋅[ht−1,xt]+bC)

其中, ( i t ) ( i_t ) (it) 是输入门的激活向量, ( C ~ t ) ( \tilde{C}_t ) (C~t) 是候选记忆单元, ( W i ) ( W_i ) (Wi), ( W C ) ( W_C ) (WC) 和 ( b i ) ( b_i ) (bi), ( b C ) ( b_C ) (bC) 是对应的权重矩阵和偏置向量。

输出门控制从记忆单元到隐藏状态的信息流:

o t = σ ( W o ⋅ [ h t − 1 , x t ] + b o ) o_t = \sigma(W_o \cdot [h_{t-1}, x_t] + b_o) ot=σ(Wo⋅[ht−1,xt]+bo)

h t = o t ∗ tanh ( C t ) h_t = o_t * \tanh(C_t) ht=ot∗tanh(Ct)

其中, ( o t ) ( o_t ) (ot) 是输出门的激活向量, ( h t ) ( h_t ) (ht) 是当前时间步的隐藏状态, ( C t ) ( C_t ) (Ct) 是当前时间步的记忆单元, ( W o ) ( W_o ) (Wo) 和 ( b o ) ( b_o ) (bo) 是输出门的权重矩阵和偏置向量。

这些门控机制使得LSTM能够在必要时保留信息,并去除不必要的信息,这大大缓解了梯度消失的问题,因为梯度在经过这样的机制时不会随着时间步迅速衰减。

4.2 LSTM 单元中的各个门控机制

LSTM单元的核心是它的三个门控机制。遗忘门负责从记忆单元中遗忘不再需要的信息,输入门负责更新记忆单元的新信息,输出门负责根据记忆单元的内容确定隐藏状态。这些门控的组合使得LSTM能够在处理长序列时保留长期依赖关系。

以语言模型为例,假设我们正在处理一个长句子,在这个句子中,主语出现在句子的开始部分,而它对应的动词可能出现在句子的末尾。传统的RNN可能会在句子的这个长度上丢失主语与动词之间的关系,而LSTM的门控机制能够让模型记住主语,直到遇到相应的动词,即使它们之间相隔很长的距离。

4.3 实例代码:使用 LSTM 进行序列建模

在实际应用中,使用LSTM进行序列建模通常涉及构建一个LSTM网络,它可以通过深度学习框架如TensorFlow或PyTorch来实现。以下是一个使用PyTorch定义一个简单的LSTM层的例子:

import torch

import torch.nn as nnclass SimpleLSTM(nn.Module):def __init__(self, input_size, hidden_size):super(SimpleLSTM, self).__init__()self.lstm = nn.LSTM(input_size, hidden_size)def forward(self, input_seq):lstm_out, (h_n, c_n) = self.lstm(input_seq)return lstm_out, (h_n, c_n)

这段代码定义了一个简单的LSTM网络,它可以处理输入序列并输出LSTM的输出,以及最后一个时间步的隐藏状态和记忆单元。

4.4 可视化图表:解释 LSTM 的内部机制

为了更好地理解LSTM单元的工作原理,可视化是一个很有用的工具。通过绘制LSTM单元随时间的激活情况,我们可以看到遗忘门、输入门和输出门是如何在每个时间步上打开或关闭的,以及记忆单元是如何随时间保持或更新信息的。

例如,可视化一个训练好的模型的遗忘门激活向量 ( f t ) ( f_t ) (ft),可以揭示出模型在处理某种类型的序列时倾向于忘记哪些信息。这样的分析有助于我们理解模型的决策过程,并对它的性能作出合理的解释。

LSTM通过这些独特的特性提供了一种强有力的方式来建模时间序列数据,并且在诸如语言模型、音乐生成和情感分析等多个领域展示了它的效力。然而,正如任何模型一样,理解其内部工作原理对于有效地使用它至关重要。在下一节中,我们将介绍LSTM的另一个变体——门控循环单元(GRU),并探讨它如何与LSTM相比较。

5 门控循环单元(GRU)

在深度学习中,特别是在处理序列数据时,需要记忆信息以便之后使用。这正是循环神经网络(RNN)的用武之地,但其在长期依赖方面有所不足,这导致了门控循环单元(GRU)的发展。GRU是一种特殊类型的RNN,被设计为更有效地捕获时间序列中的长距离依赖关系。

5.1 GRU 的架构与功能

GRU的核心改进在于其引入了更新门(update gate)和重置门(reset gate),这两个门控机制决定了信息如何流入和流出隐藏状态。具体来说,GRU的隐藏状态更新可以用以下数学公式描述:

h t = ( 1 − z t ) ∗ h t − 1 + z t ∗ h ~ t h_t = (1 - z_t) * h_{t-1} + z_t * \tilde{h}_t ht=(1−zt)∗ht−1+zt∗h~t

其中, h t h_t ht 是当前时间步的隐藏状态, h t − 1 h_{t-1} ht−1 是前一时间步的隐藏状态, h ~ t \tilde{h}_t h~t 是候选隐藏状态,用公式表示为:

h ~ t = t a n h ( W h x t + U h ( r t ∗ h t − 1 ) + b h ) \tilde{h}_t = tanh(W_{h}x_t + U_{h}(r_t * h_{t-1}) + b_h) h~t=tanh(Whxt+Uh(rt∗ht−1)+bh)

而更新门 z t z_t zt 和重置门 r t r_t rt 分别由下列公式决定:

z t = σ ( W z x t + U z h t − 1 + b z ) z_t = \sigma(W_z x_t + U_z h_{t-1} + b_z) zt=σ(Wzxt+Uzht−1+bz)

r t = σ ( W r x t + U r h t − 1 + b r ) r_t = \sigma(W_r x_t + U_r h_{t-1} + b_r) rt=σ(Wrxt+Urht−1+br)

这里的 σ \sigma σ 表示sigmoid激活函数,它将任意值映射到(0,1)区间,用以计算门控信号的强度。 W W W 和 U U U 是权重矩阵, b b b 是偏置项,用于学习和调节信息的流动。

更新门 z t z_t zt 控制前一个隐藏状态 h t − 1 h_{t-1} ht−1应该被保留多少到当前时间步。而重置门 r t r_t rt 则决定了在计算候选隐藏状态 h ~ t \tilde{h}_t h~t时,应该遗忘多少先前的隐藏状态信息。

例如,在一个时间序列预测任务中,如果序列的当前值强烈依赖于先前的值,更新门会接近1,这样就可以保留更多的先前状态。如果当前值与先前值关系不大,重置门会接近0,从而允许模型忽略之前的状态。

5.2 GRU 与 LSTM 的对比分析

GRU 与 LSTM最显著的区别在于GRU有两个门(更新门和重置门),而LSTM有三个门(遗忘门、输入门和输出门)。相较之下,GRU的结构更为简单,这通常使得其在某些任务中训练起来更快,参数更少。

LSTM的遗忘门和输入门分别控制过去信息的遗忘和新信息的加入。输出门则控制从细胞状态到隐藏状态的信息流。相对于GRU的更新门和重置门,LSTM的这三个门提供了更精细的信息流控制,但也因此带来了更多的计算复杂度。

5.3 实例代码:用 GRU 进行时间序列预测

让我们用一个简单的例子来说明GRU在时间序列预测中的应用。假设我们正在处理股票市场的价格数据,我们的目标是预测下一个时间点的价格。以下是使用Python中的TensorFlow/Keras库构建GRU模型的代码片段:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import GRU, Dense# 假设 input_shape=(timesteps, features) 是我们的输入数据形状

model = Sequential()

model.add(GRU(units=50, return_sequences=True, input_shape=(timesteps, features)))

model.add(GRU(units=50))

model.add(Dense(1))model.compile(optimizer='adam', loss='mean_squared_error')

# x_train 和 y_train 是我们的训练数据和标签

model.fit(x_train, y_train, epochs=100, batch_size=32)

在这段代码中,我们首先初始化了一个Sequential模型,然后添加了两个GRU层。第一个GRU层返回完整的序列到下一个GRU层,以便捕获在序列中的所有时间步中的模式。最后一个Dense层输出预测的连续值。

5.4 可视化图表:GRU 内部状态更新解析

为了更直观地理解GRU的工作原理,我们可以可视化其状态更新过程。我们可以绘制在不同时间步下更新门和重置门的活性值,观察它们如何影响隐藏状态的更新。

以更新门为例,我们可能会看到在序列中某些关键点(如股价跳跃)时更新门的值接近1,这表示模型正在试图捕获并保留这些关键信息。相应地,重置门的活性值可能在序列中的其他点降低,表明模型正在选择性地遗忘旧的状态信息。

结合这些直观的解释和视觉展示,研究人员和实践者可以更好地理解和优化GRU模型在解决特定问题上的表现。而对于那些复杂的时间序列数据,GRU模型提供了一个强有力的工具,它通过简化的架构和有效的信息流控制,在诸多任务上仍然保持着与LSTM相媲美的性能。在未来,GRU可能会继续演变和改进,但它已经证明了自己在序列建模领域的价值。

6 RNN 的训练技巧

在深度学习,尤其是循环神经网络(RNN)的领域中,训练技巧对于构建高效、健壮的模型至关重要。这一节我们将深入探讨RNN的训练过程中的关键技术,包括序列批处理与序列填充,梯度裁剪,以及Dropout在RNN中的应用。每一项技术都会结合相应的理论基础、数学公式及其推导,以及实际的代码示例来进行详细解释。

6.1 序列批处理与序列填充的技术细节

序列数据的处理在RNN中至关重要,因为RNN的设计本质是处理及学习序列依赖关系。然而,在实际应用中,我们经常会碰到长度不一致的序列数据,这给批处理带来了挑战。为了解决这一问题,我们常常需要采用序列填充(padding)的技术。

批处理技术允许模型同时训练多个序列,通过并行处理来提高训练效率。而序列填充则是将短序列用预定义的填充符号(如0)补齐至批次中最长序列的长度。这一技术的关键在于后续处理时能够区分出实际数据与填充数据。通常,这是通过序列掩码(sequence masks)来实现的。

在数学表示上,假设我们有一个批次中的序列集合,其中最长序列的长度为 L m a x L_{max} Lmax,则其他短序列需要补齐至 L m a x L_{max} Lmax。如果我们有一个序列 s s s,其实际长度为 L s L_s Ls,填充后的序列可以表示为:

s p a d d e d = [ s 1 , s 2 , . . . , s L s , 0 , . . . , 0 ] 1 × L m a x s_{padded} = [s_1, s_2, ..., s_{L_s}, 0, ..., 0]_{1 \times L_{max}} spadded=[s1,s2,...,sLs,0,...,0]1×Lmax

序列掩码 m m m为一个与 s p a d d e d s_{padded} spadded同样长度的向量,其元素由下式给出:

m i = { 1 , if i ≤ L s 0 , if i > L s m_i = \begin{cases} 1, & \text{if } i \leq L_s \\ 0, & \text{if } i > L_s \end{cases} mi={1,0,if i≤Lsif i>Ls

在计算损失时,仅考虑序列掩码中标记为1的部分,确保填充不会影响模型的学习。

6.2 梯度裁剪:原理与实现

梯度裁剪是解决梯度爆炸问题的一种技术,通过设置一个阈值,当计算出的梯度超出这个阈值时,就将其裁剪到这个阈值。这样可以防止在训练过程中因为梯度过大而导致模型参数更新过猛,从而跳过最优解或者造成数值不稳定。

数学上,梯度裁剪可以表示为:

g t , c l i p p e d = min ( t h r e s h o l d ∥ g t ∥ , 1 ) g t g_{t, clipped} = \min\left(\frac{threshold}{\|g_t\|}, 1\right)g_t gt,clipped=min(∥gt∥threshold,1)gt

其中, g t g_t gt是在时间步 t t t的梯度, ∥ g t ∥ \|g_t\| ∥gt∥是梯度的 L 2 L2 L2范数, t h r e s h o l d threshold threshold是预先设定的阈值。如果梯度的 L 2 L2 L2范数小于阈值,则梯度不变;否则,会按比例减小梯度,确保其 L 2 L2 L2范数不超过阈值。

在实践中,这通常通过深度学习框架中的内置函数实现。例如,在PyTorch中,可以使用torch.nn.utils.clip_grad_norm_来实现梯度裁剪:

# 在进行梯度更新前

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=threshold)

optimizer.step()

6.3 Dropout 在 RNN 中的应用与示例代码

Dropout是一种正则化技术,通过在训练阶段随机丢弃(即置为零)神经网络中的一些神经元输出,来防止模型过拟合。在RNN中应用Dropout时,一个常见的做法是在各个时间步之间共享相同的Dropout掩码,以保持时间步之间的依赖关系。

对于一个给定的时间步中的隐藏状态 h t h_t ht,Dropout可以表示为:

h t , d r o p o u t = m ⊙ h t h_{t, dropout} = m \odot h_t ht,dropout=m⊙ht

其中 m m m是一个随机生成的与 h t h_t ht同尺寸的二值掩码(mask), ⊙ \odot ⊙表示逐元素的乘法。在训练时, m m m中的每个元素有概率 p p p为0,概率 1 − p 1-p 1−p为1。在测试时,不使用Dropout或者将 h t , d r o p o u t h_{t, dropout} ht,dropout乘以 1 − p 1-p 1−p以补偿训练时丢弃的元素。

在TensorFlow或Keras中,可以直接在RNN层中设置dropout参数来应用Dropout,如下所示:

from tensorflow.keras.layers import LSTM# 建立一个LSTM模型,并应用Dropout

model = Sequential()

model.add(LSTM(50, dropout=0.2, recurrent_dropout=0.2, input_shape=(sequence_length, feature_dim)))

model.add(Dense(1))

model.compile(optimizer='adam', loss='mse')

在此代码中,dropout=0.2意味着每个时间步中有20%的输入神经元会被随机丢弃,recurrent_dropout=0.2意味着每个时间步中有20%的循环连接会被随机丢弃。

通过这些训练技巧,我们可以有效地训练RNN模型,使其具有更好的泛化能力,并减少因为不稳定梯度而造成的训练困难。在接下来的章节中,我们将进一步探讨RNN在时间序列预测中的应用,并展示如何构建和训练一个RNN模型来处理此类问题。

7 应用案例:时间序列预测

在深入探讨时间序列预测的世界之前,让我们先明确几个关键点。时间序列数据是按照时间顺序排列的数据点集合,通常在金融市场分析、天气预报、物联网、和生物信号处理等领域中有广泛应用。对这类数据进行预测,不仅要捕捉数据的历史趋势,也要理解可能的周期性变化,并且做出准确的未来预测。

7.1 时间序列数据的特性与挑战

时间序列数据的特性包括趋势、季节性、周期性和不规则波动。它们可能非常不稳定,受到多种因素的影响,如偶发事件、缺失值或异常值。预测这类数据需要一个能够捕捉这些特性的模型,同时还要有合适的数据预处理和特征工程。

挑战在于时间序列的非静态性质,这要求模型必须适应数据随时间发生的变化。此外,时间序列数据可能存在长期依赖性,即当前的值可能受到很久以前值的影响,这对于传统的机器学习模型来说是一大挑战。

7.2 构建与训练一个 RNN 时间序列预测模型

循环神经网络(RNN)因其能够处理序列数据而在时间序列预测中得到了广泛应用。典型的RNN在每个时间步接收输入并更新其隐藏状态,该隐藏状态捕捉了过去信息的影响。

为构建一个RNN模型,我们通常遵循以下步骤:

- 数据预处理:包括标准化、去除季节性和趋势成分,以及处理缺失值和异常值。

- 特征选择:选择或构建能够最好地表示时间序列数据的特征。

- 模型构建:设计RNN架构,包括确定层数、隐藏单元数量等。

- 训练与验证:使用训练数据训练模型,并在验证集上评估性能。

具体来说,设时间序列为 { x 1 , x 2 , . . . , x T } \{x_1, x_2, ..., x_T\} {x1,x2,...,xT},RNN的目标是利用历史信息来预测下一个时间点的值 x T + 1 x_{T+1} xT+1。RNN在每个时间步 t t t 的前馈传播可以用以下公式描述:

h t = f ( W h h h t − 1 + W x h x t + b h ) h_t = f(W_{hh} h_{t-1} + W_{xh} x_t + b_h) ht=f(Whhht−1+Wxhxt+bh)

y ^ t = W h y h t + b y \hat{y}_t = W_{hy} h_t + b_y y^t=Whyht+by

其中, h t h_t ht 是隐藏状态, y ^ t \hat{y}_t y^t 是在时间步 t t t 的预测输出, W W W 和 b b b 分别表示权重矩阵和偏置项, f ( ⋅ ) f(\cdot) f(⋅) 是激活函数,如tanh或ReLU。

7.3 可视化:预测结果与实际数据的对比

可视化是理解模型性能的关键步骤。它能帮助我们比较模型预测和实际数据之间的差异,评估模型是否捕捉到了数据的主要趋势和模式。一个常见的做法是绘制预测值和实际值随时间变化的曲线图。

为了增强可视化的解释性,我们可以加入置信区间或预测区间,以展示预测的不确定性。例如,通过计算预测误差的标准差,我们可以绘制出预测值上下一个标准差的范围,表示95%的置信区间。

7.4 进一步阅读:深入时间序列分析

时间序列预测是一个深奥而复杂的领域,涉及多种不同的技术和方法。为了深入理解,读者可以探索更多相关的主题,例如ARIMA模型、季节性分解、波谱分析等。此外,可以学习更现代的方法,如使用激活函数门控的循环神经网络(如LSTM和GRU),以及最近非常流行的基于注意力机制的模型。

在本节中,我们深入探讨了RNN在时间序列预测中的应用。首先,我们讨论了时间序列数据的特点和面临的挑战。然后,我们概述了构建RNN模型进行时间序列预测的步骤,并通过数学公式展示了RNN的工作机制。接着,我们强调了可视化在模型性能评估中的重要性,并提供了一些可视化实例。最后,我们提供了一些用于深入研究时间序列分析的资源。

通过本节的内容,读者应该能够理解RNN在时间序列预测中的应用,并能够构建自己的RNN模型来处理实际问题。

8 应用案例:文本生成

8.1 文本数据的特殊处理需求

在深入文本生成的具体实现之前,我们必须了解处理文本数据时的一些特殊需求。不同于数字或图片数据,文本数据由一系列离散的符号组成,例如字母、单词或字符。这些符号无法直接输入到神经网络中,它们必须经过适当的预处理以转换为机器可以理解的形式。这通常涉及以下步骤:

- 分词(Tokenization): 首先,我们需要将文本分割成可处理的单元,如单词、字符或子词。

- 构建词汇表(Vocabulary Building): 接着,我们需要根据分词结果建立一个词汇表,为每个独特的标记分配一个唯一的索引。

- 编码(Encoding): 然后,将文本中的标记转换为对应的索引值。

- 向量化(Vectorization): 最后,通过词嵌入(例如,Word2Vec或GloVe)将索引值转换为稠密的向量,以便能够输入到RNN中。

8.2 构建文本生成 RNN 模型

构建一个文本生成模型,我们通常使用一个字符级别的RNN,因为它可以生成任意长度的序列,而不是受限于固定大小的词汇表。一个典型的文本生成RNN模型包括以下几个部分:

- 输入层(Input Layer): 接受向量化后的文本数据。

- 隐藏层(Hidden Layer): 由循环单元(如基础的RNN、LSTM或GRU单元)构成,处理序列数据,捕捉和记忆文本的上下文。

- 输出层(Output Layer): 通常是一个全连接层,将隐藏层的输出转换为最终的预测,预测下一个字符的概率分布。

一个基础的RNN单元可以通过以下公式表示,其中 h t h_t ht表示在时间步 t t t的隐藏状态, x t x_t xt表示在时间步 t t t的输入向量, W W W和 U U U是权重参数, b b b是偏置项:

h t = tanh ( W h t − 1 + U x t + b ) h_t = \text{tanh}(W h_{t-1} + U x_t + b) ht=tanh(Wht−1+Uxt+b)

输出层通常使用softmax函数来生成一个概率分布,表示下一个字符的预测:

y ^ t = softmax ( V h t + c ) \hat{y}_t = \text{softmax}(V h_t + c) y^t=softmax(Vht+c)

其中 V V V是隐藏层到输出层权重矩阵, c c c是输出偏置项, y ^ t \hat{y}_t y^t代表在时间步 t t t的输出向量。

8.3 实例代码:生成文本

接下来,我们会用Python演示一个使用TensorFlow和Keras框架构建的文本生成RNN模型的简单实例。代码将包括数据预处理、模型构建、训练和文本生成。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, LSTM, Dense

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

import numpy as np# 假设 `corpus` 是我们的文本数据

tokenizer = Tokenizer(char_level=True)

tokenizer.fit_on_texts(corpus)# 编码文本

encoded_text = tokenizer.texts_to_sequences(corpus)# 创建序列数据

sequences = []

for i in range(1, len(encoded_text)):sequence = encoded_text[i-1:i+1]sequences.append(sequence)# 序列填充

max_sequence_len = max([len(x) for x in sequences])

sequences = np.array(pad_sequences(sequences, maxlen=max_sequence_len, padding='pre'))# 分割数据

X, y = sequences[:, :-1], sequences[:, -1]

y = tf.keras.utils.to_categorical(y, num_classes=len(tokenizer.word_index))# 构建模型

model = Sequential()

model.add(Embedding(input_dim=len(tokenizer.word_index), output_dim=50, input_length=max_sequence_len-1))

model.add(LSTM(150, return_sequences=True))

model.add(LSTM(150))

model.add(Dense(len(tokenizer.word_index), activation='softmax'))model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

model.fit(X, y, epochs=50)# 生成文本

def generate_text(seed_text, next_words, model, max_sequence_len):for _ in range(next_words):token_list = tokenizer.texts_to_sequences([seed_text])[0]token_list = pad_sequences([token_list], maxlen=max_sequence_len-1, padding='pre')predicted = model.predict_classes(token_list, verbose=0)output_word = ""for word, index in tokenizer.word_index.items():if index == predicted:output_word = wordbreakseed_text += output_wordreturn seed_textprint(generate_text("This is a beginning of ", 100, model, max_sequence_len))

8.4 可视化:展示生成文本的过程

在训练过程中,我们可以使用各种可视化工具来展示文本生成的过程和模型的学习进度。例如,我们可以绘制训练和验证的损失曲线,来展示模型在学习过程中的表现。我们还可以在每个epoch结束后生成并打印一小段文本,观察模型生成文本的能力如何随着时间的推移而改变。

通过监控这些指标,我们可以调整模型的参数,改善模型的表现,并最终得到一个能够生成有趣并且可信文本的模型。在实际应用中,文本生成的RNN模型可以被用于聊天机器人、自动作曲、游戏设计以及其他许多需要自动文本生成的领域。

9 RNN 的替代方案与未来发展

在深入探讨RNN及其变种如LSTM和GRU的优劣之后,我们来到了本文的第9部分——RNN的替代方案与未来发展。

9.1 介绍 Transformer 与注意力机制

在序列处理任务中,Transformer模型近年来取得了显著的成功。与RNN和LSTM不同,Transformer完全依赖于注意力机制(Attention Mechanism)来捕获序列之间的全局依赖关系,移除了递归计算的需要。

注意力机制的核心思想是在序列的每一步中,动态地选择性地聚焦于最相关信息的子集。这可以用下列的数学形式表达:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

其中 Q Q Q、 K K K和 V V V分别代表查询(Query)、键(Key)和值(Value), d k d_k dk代表键的维度。注意力机制通过这种方式可以为每个输入分配一个权重,从而使模型能够更加灵活地捕获信息。

Transformer通过自注意力(Self-Attention)层和前馈神经网络层的堆叠来构建。自注意力层使得模型能够同时考虑到输入序列中的所有位置,这一点在RNN中是通过顺序处理和隐藏状态来实现的。

9.2 RNN、LSTM/GRU 与 Transformer 的适用场景比较

尽管RNN及其变种在处理序列数据方面非常有效,但它们在处理长序列时仍然存在局限性。由于RNN是逐时间步处理的,它们在抓住长距离依赖上面临挑战。LSTM和GRU引入的门控机制在一定程度上缓解了这个问题,但仍然有其不足。

相比之下,Transformer能够更好地捕捉长距离的序列依赖关系。由于其并行计算的特性,Transformer在处理大规模序列数据时更为高效。在诸如机器翻译、文本摘要和语音识别等任务中,Transformer已经展现了其优越性。

然而,这并不意味着RNN没有用武之地。在某些实时处理或资源受限的场景中,RNN的轻量级和逐步处理的特性可能更适合。例如,嵌入式系统或移动设备上的语音识别任务,可能会更倾向于使用更为简单和快速的RNN结构。

9.3 RNN的未来发展方向

尽管RNN可能在某些方面比不过Transformer,但它们在未来仍有发展空间。研究者们正致力于提高RNN的性能和可扩展性,以使其更适合于现代的大规模序列处理任务。

一种思路是通过改进梯度流和信息流,来增强RNN对长范围依赖的捕捉能力。例如,通过引入新型的门控机制或优化现有的RNN架构,可以使模型更加高效和稳定。

此外,结合RNN的时序动态特性与Transformer的并行计算优势,研究者们正在探索混合模型。这些模型旨在兼顾序列数据处理的深度表征能力与计算效率。

在未来,我们也可以预见到更多的RNN变体和改进算法的出现,这将进一步拓宽RNN在各种复杂序列处理任务中的应用前景。同时,随着计算资源的不断增强,我们有理由相信,即使是现有的RNN结构也能够得到更有效的训练和应用。

综上所述,尽管面对Transformer等新兴技术的竞争,RNN及其变种仍在序列数据处理领域占有一席之地。对于深度学习的实践者和研究者来说,理解RNN的内在工作机制和其在特定应用场景中的优势,依然是至关重要的。随着技术的不断进步,我们有望看到更多创新的RNN模型,它们将以新的形式继续在深度学习领域发光发热。

在下一节中,我们将对RNN及其在实际问题中的应用和局限性进行总结,同时强调理解RNN及其变种的重要性和应用条件。

10 总结

在本文中,我们已经深入探讨了循环神经网络(RNN)的各个方面,从其基础概念、挑战,到实际应用案例和未来的发展方向。现在,让我们总结RNN在处理序列数据中的作用和局限性,并强调理解RNN及其变体的重要性以及实际应用条件。

RNN 在实际问题中的应用与局限性

循环神经网络(RNN)是深度学习中用于处理序列数据的强大工具。RNN的特别之处在于其隐藏状态,这是网络的记忆部分,使得网络能够利用之前的信息来影响当前的输出。这种特性使得RNN在自然语言处理(NLP)、时间序列分析和音乐生成等众多领域中变得不可或缺。

但是,RNN也有其局限性,尤其是在处理长序列时。由于梯度消失和梯度爆炸问题,传统的RNN难以捕捉长距离依赖关系。尽管有许多技术,如梯度裁剪、改良的初始化方法和LSTM或GRU这样的网络设计,试图解决这些问题,但这些挑战并没有被完全克服。

在实际应用中,RNN模型的性能往往受限于可用数据量的大小、序列的长度、数据的质量和复杂性。此外,RNN模型的训练通常计算资源密集且时间消耗较大,特别是对于大规模数据集。这些因素必须在选择使用RNN及其变体时予以考虑。

理解 RNN 及其变种的重要性与应用条件

理解RNN及其变种如LSTM和GRU的工作机制对于在实际问题中成功应用这些模型至关重要。例如,在进行时间序列预测或文本生成时,研究人员和工程师必须明白如何调整模型的不同参数,以及如何设计网络结构以适应特定类型的数据和预期的任务。

选择正确的变体和参数设置取决于具体任务的需求。如在处理非常长的序列时,可能更适合使用LSTM或GRU,因为它们的设计有助于缓解梯度消失的问题。此外,必须注意数据预处理、特征工程和后处理步骤,因为这些步骤在解释模型输出和提高模型性能方面起着至关重要的作用。

最终,尽管RNN及其变种是强大的工具,但也需要与其他机器学习技术和算法结合使用,以解决更复杂和多样化的问题。例如,注意力机制和Transformer模型在处理长序列时表现出其优越性,可以作为RNN的补充或替代来使用。

总的来说,循环神经网络及其变体在序列数据建模方面具有独特的优势,并且在很多情况下,它们仍然是最合适的选择。然而,选择正确的工具和方法需要对问题、数据和可用技术有深入的理解。只有这样,我们才能充分发挥RNN在各种实际应用中的潜力,并促进深度学习领域的进一步发展。

相关文章:

循环神经网络(RNN):概念、挑战与应用

循环神经网络(RNN):概念、挑战与应用 1 引言 1.1 简要回顾 RNN 在深度学习中的位置与重要性 在深度学习的壮丽图景中,循环神经网络(Recurrent Neural Networks,RNN)占据着不可或缺的地位。自从…...

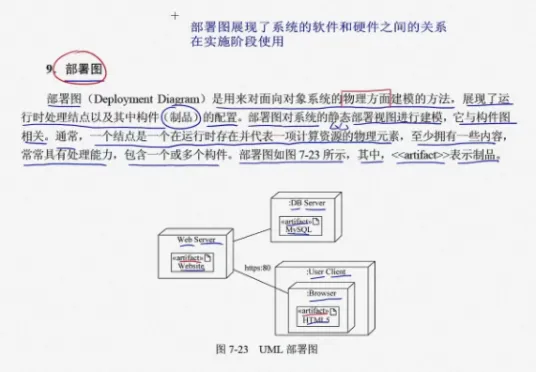

UML 介绍

前言 UML 简介。 文章目录 前言一、简介1、事务2、关系1)依赖2)关联聚合组合 3)泛化4)实现 二、类图三、对象图四、用例图五、交互图1、序列图(顺序图)2、通信图 六、状态图七、活动图八、构件图࿰…...

Pytorch——训练时,冻结网络部分参数的方法

一、原理: 要固定训练网络的哪几层,只需要找到这几层参数(parameter),然后将其 .requires_grad 属性设置为 False 即可。 二、代码: # 根据参数层的 name 来进行冻结 unfreeze_layers ["text_id"] # 用列表 # 设置冻…...

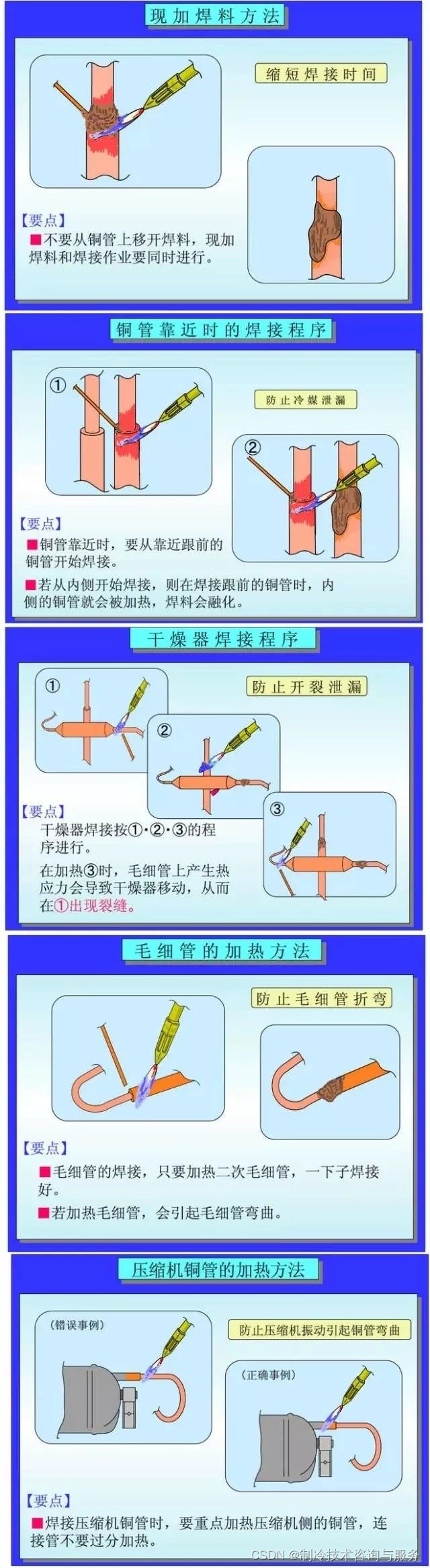

制冷铜管焊接介绍

铜管是制冷装置的重要原材料,它主要有两种用途:①制作换热器。②制作连接管道和管件。常用的焊料类型有铜磷焊料、银铜焊料、铜锌焊料等。在焊接时要根据管道材料的特点,正确的选择焊料及熟练的操作,以确保焊接的质量。 1.1对同类…...

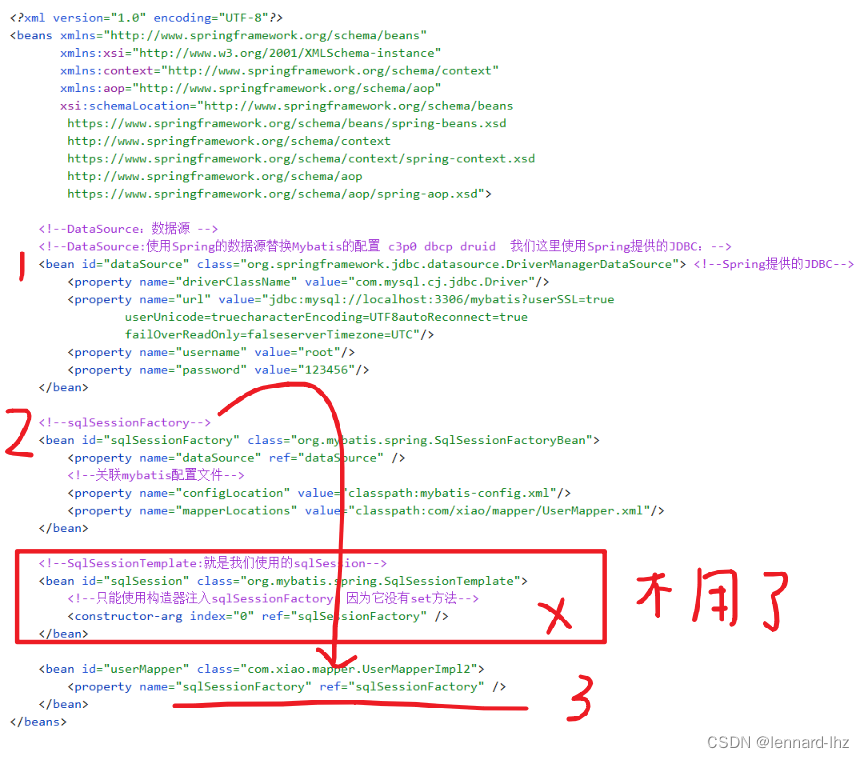

spring06:mybatis-spring(Spring整合MyBatis)

spring06:mybatis-spring(Spring整合MyBatis) 文章目录 spring06:mybatis-spring(Spring整合MyBatis)前言:什么是 MyBatis-Spring?MyBatis-Spring 会帮助你将 MyBatis 代码无缝地整合…...

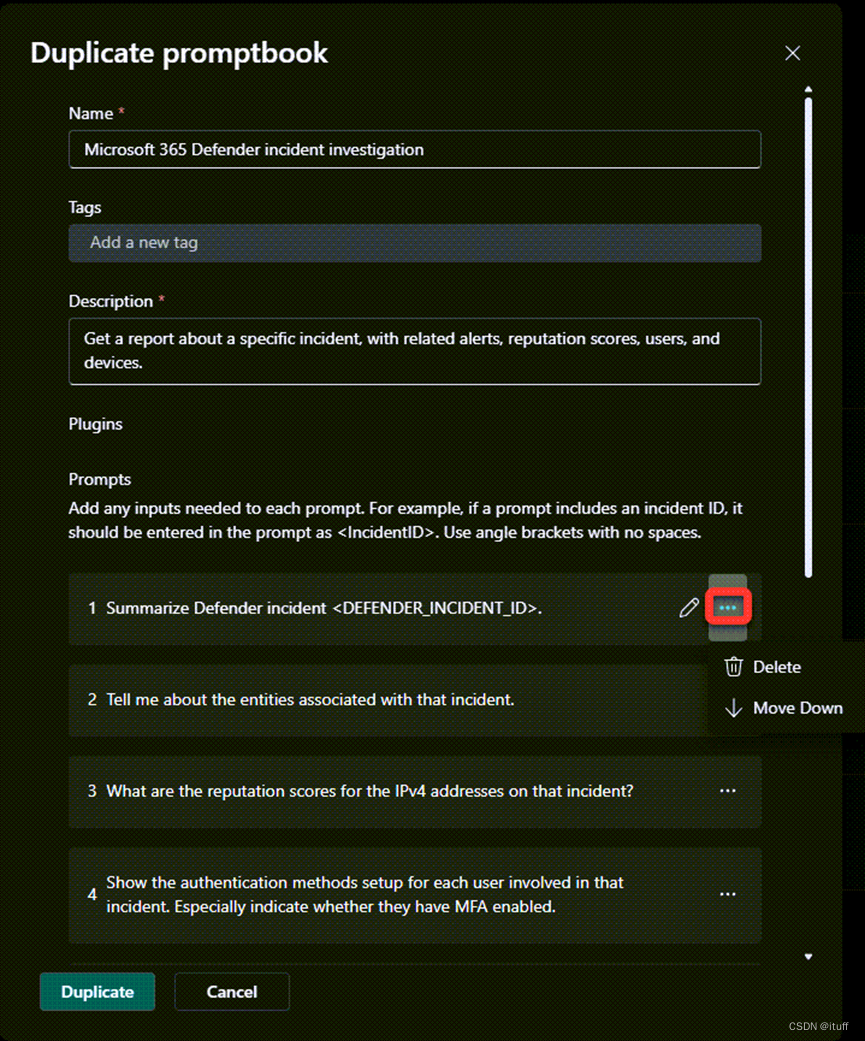

如何使用自定义Promptbooks优化您的安全工作流程

在当今的数字化时代,安全工作流程的优化变得前所未有的重要。安全团队需要快速、有效地响应安全事件,以保护组织的数据和资产。Microsoft Copilot for Security提供了一种强大的工具——自定义Promptbooks,它可以帮助安全专家通过自动化和定制…...

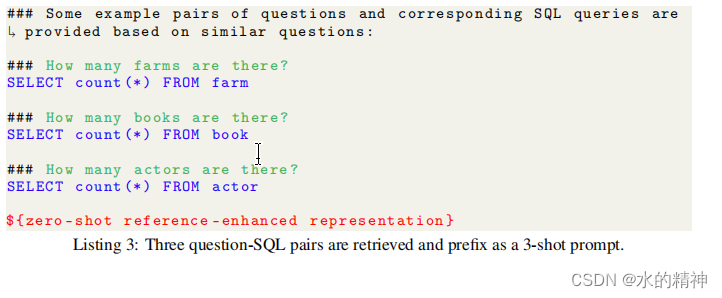

Text2sql的一些技巧

最近看到了一篇关于text2sql的文章,以及一些论文。对使用模型做text2sql给了一些不错的建议。 参考文章:24年大模型潜力方向:大浪淘沙后的Text-to-SQL和Agent - 知乎 论文:https://arxiv.org/pdf/2403.09732.pdf 关于模型的建议 …...

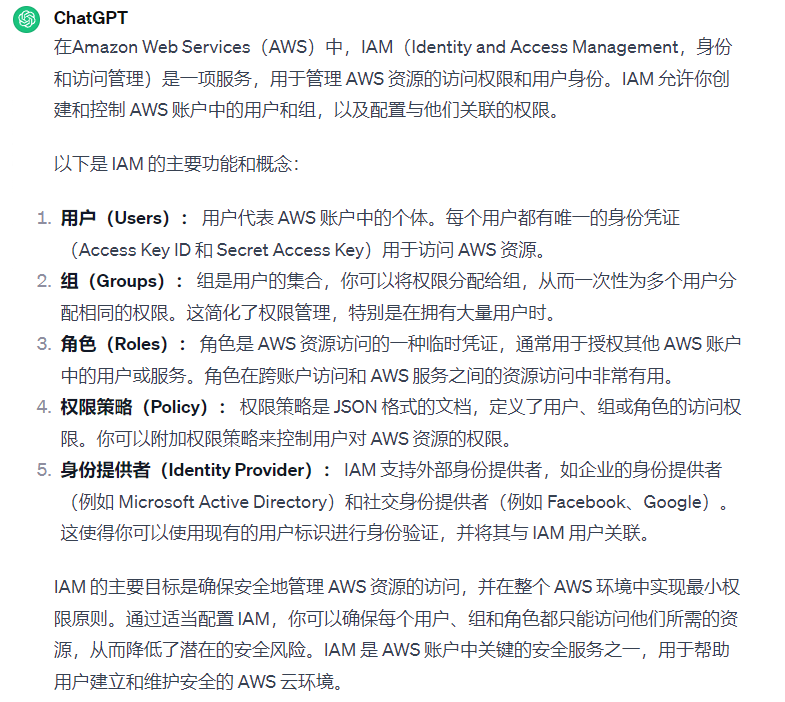

aws云靶场和一些杂记

aws靶场 在AWS靶场中,存在三个安全问题:1) 一个S3存储桶政策配置错误,允许公共访问,通过访问特定域名可获取flag。2) SQS消息队列的政策没有限制角色,允许发送和接收消息,通过aws sqs命令行工具的receive-…...

《AI编程类工具之四——GitHub copiot》

一.简介 官网:https://github.com/features/copilot GitHub Copilot是由GitHub和OpenAI合作开发的一款人工智能编程助手。这款工具基于OpenAI的GPT-3模型进行训练,旨在帮助开发者更高效地编写代码。 二.功能介绍 智能代码补全:GitHub Cop…...

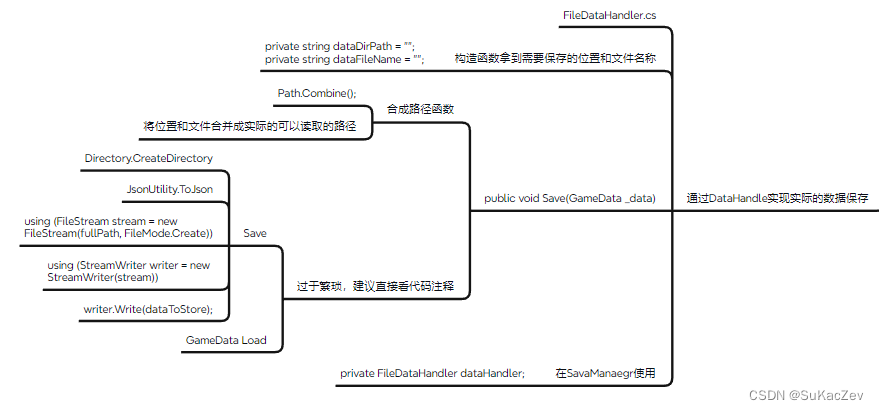

Unity类银河恶魔城学习记录13-1 p142 Save system源代码

Alex教程每一P的教程原代码加上我自己的理解初步理解写的注释,可供学习Alex教程的人参考 此代码仅为较上一P有所改变的代码 【Unity教程】从0编程制作类银河恶魔城游戏_哔哩哔哩_bilibili FileDataHandler.cs using System; using System.IO; using UnityEngine; p…...

【C++杂货铺】继承

目录 🌈前言🌈 📁 继承的概念和定义 📂 概念 📂 定义 📁 基类和派生类对象赋值转换 📁 继承中的作用域 📁 派生类的默认成员函数 构造函数 析构函数 拷贝构造函数 赋值重载…...

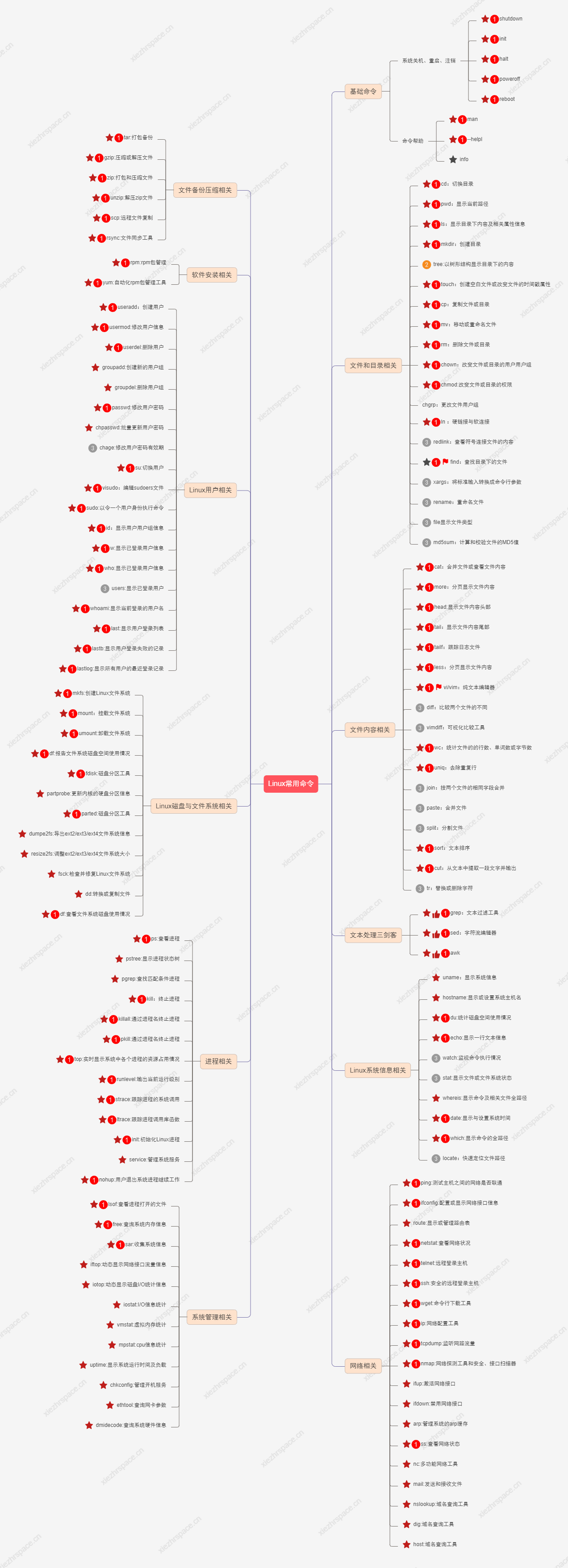

快速上手Linux核心命令

Linux 的重要性不用我多说了吧,大多数互联网公司,服务器都是采用的Linux操作系统 Linux是一个主要通过命令行来进行管理的操作系统。 只有熟练掌握Linux核心命令,在使用起来我们才会得心应手 这里给大家整理了Linux一些核心命令࿰…...

背 单 词 (考研词汇闪过)

单词: 买考研词汇闪过 研究艾宾浩斯遗忘曲线 https://www.bilibili.com/video/BV18Y4y1h7YR/?spm_id_from333.337.search-card.all.click&vd_source5cbefe6dd70d6d84830a5891ceab2bf9 单词方法 闪记背两排(5min)重复一遍(2mi…...

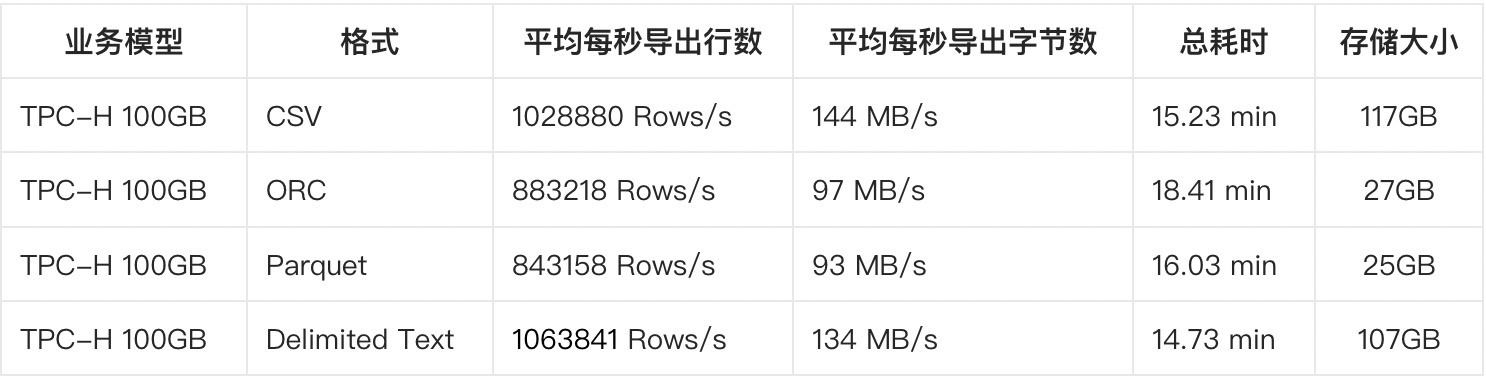

数据库工具解析之 OceanBase 数据库导出工具

背景 大多数的数据库都配备了自己研发的导入导出工具,对于不同的使用者来说,这些工具能够发挥不一样的作用。例如:DBA可以使用导数工具进行逻辑备份恢复,开发者可以使用导数工具完成系统间的数据交换。这篇文章主要是为OceanBase…...

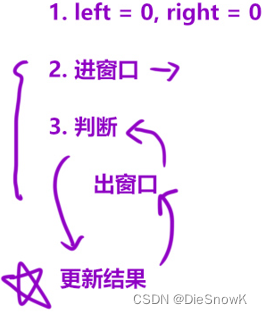

[Algorithm][滑动窗口][长度最小的子数组] + 滑动窗口原理

目录 0.滑动窗口原理讲解1.长度最小的子数组1.题目链接2.算法原理讲解3.代码实现 0.滑动窗口原理讲解 滑动窗口:“同向双指针”滑动窗口可处理「⼀段连续的区间」问题如何使用? left 0, right 0进窗口判断 是否出窗口 更新结果 -> 视情况而定 可能…...

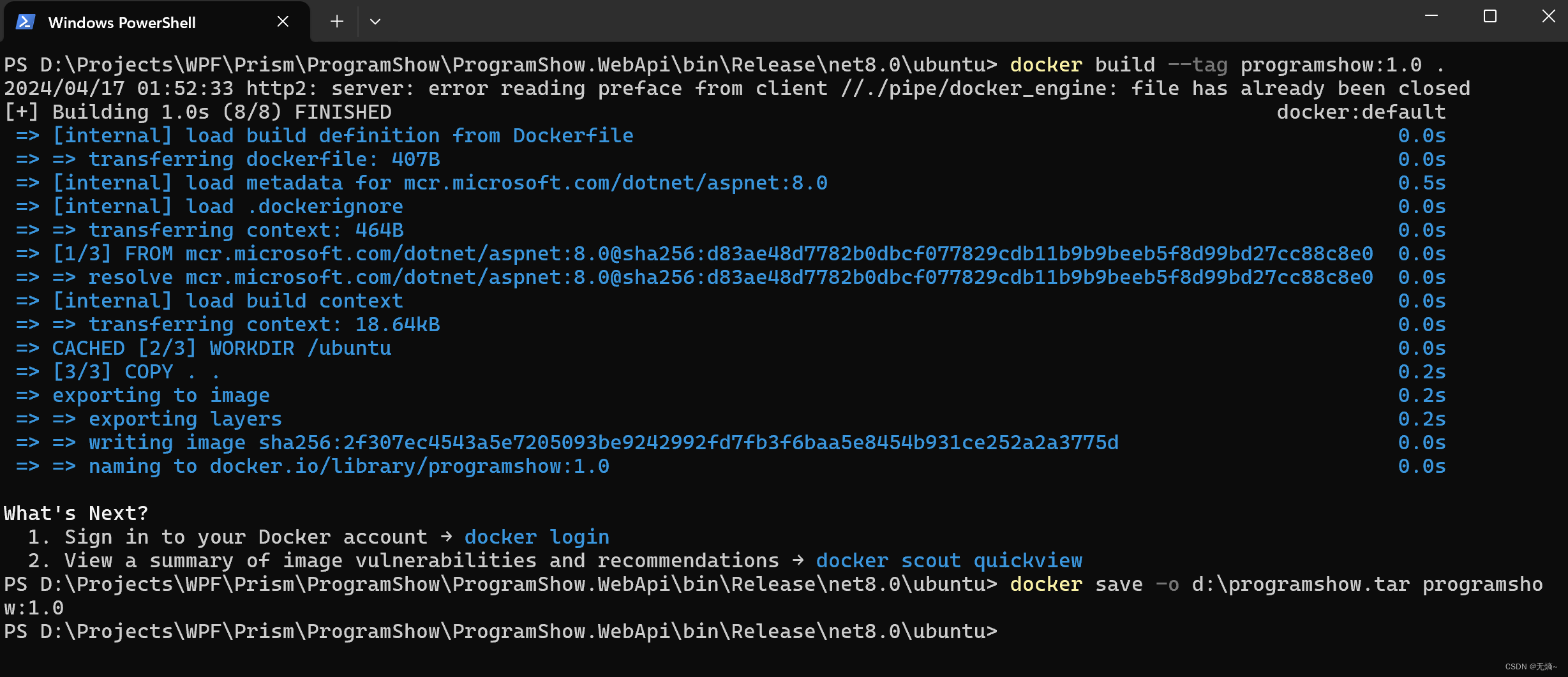

.NET 发布,部署和运行应用程序

.NET应用发布 发布.Net应用有很多种方式,下面列举三种发布方式: 单文件发布跨平台发布Docker发布 单文件发布 右键工程,选择“发布”,部署模式选择“独立”,目标运行时选择自己想要部署到的系统,我这里用…...

B树(B-tree)

B树(B-tree) B树(B-tree)是一种自平衡的多路查找树,主要用于磁盘或其他直接存取的辅助存储设备 B树能够保持数据有序,并允许在对数时间内完成查找、插入及删除等操作 这种数据结构常被应用在数据库和文件系统的实现上 B树的特点包括: B树为…...

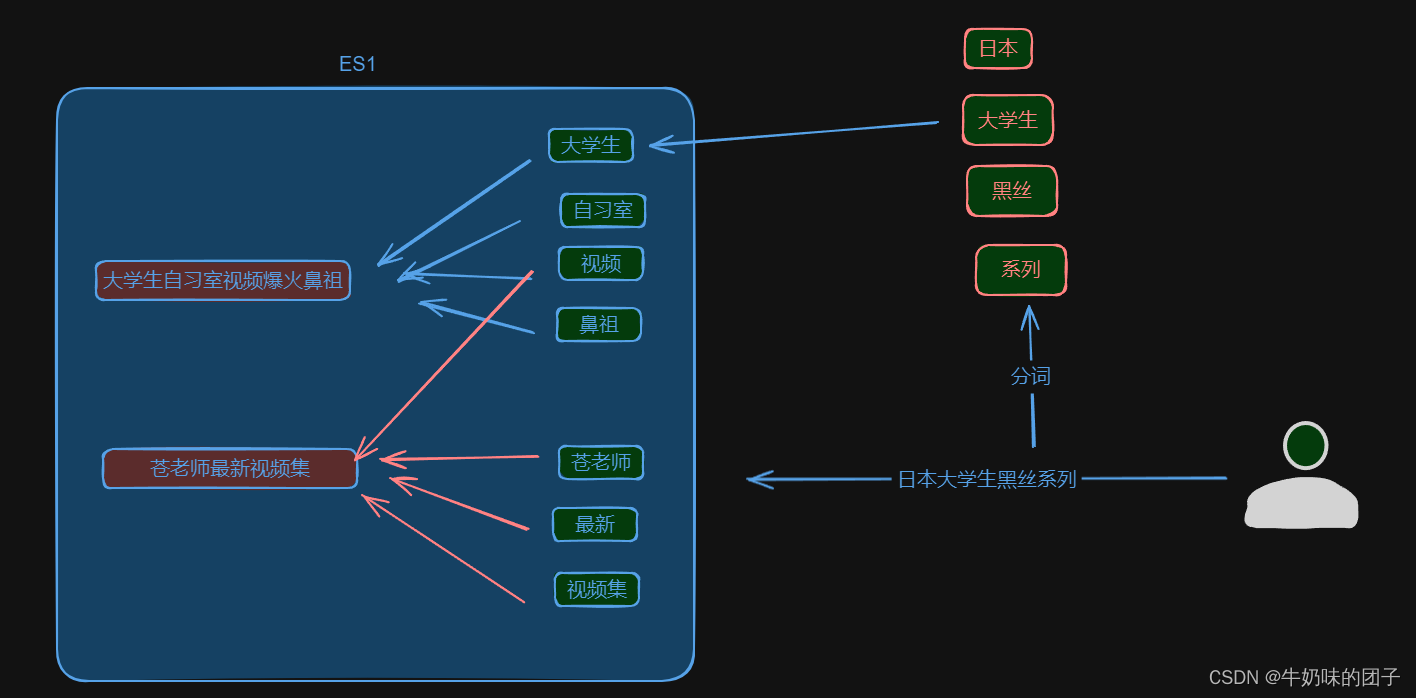

EelasticSearch是什么?及EelasticSearch的安装

一、概述 Elasticsearch 是一个基于 Apache Lucene 构建的开源分布式搜索引擎和分析引擎。它专为云计算环境设计,提供了一个分布式的、高可用的实时分析和搜索平台。Elasticsearch 可以处理大量数据,并且具备横向扩展能力,能够通过增加更多的…...

Python机器学习项目开发实战:如何进行语音识别

注意:本文的下载教程,与以下文章的思路有相同点,也有不同点,最终目标只是让读者从多维度去熟练掌握本知识点。 下载教程:Python机器学习项目开发实战_语音识别_编程案例解析实例详解课程教程.pdf 在Python机器学习项目…...

2024年五一杯数学建模C题思路分析

文章目录 1 赛题思路2 比赛日期和时间3 组织机构4 建模常见问题类型4.1 分类问题4.2 优化问题4.3 预测问题4.4 评价问题 5 建模资料 1 赛题思路 (赛题出来以后第一时间在CSDN分享) https://blog.csdn.net/dc_sinor?typeblog 2 比赛日期和时间 报名截止时间:2024…...

Java如何权衡是使用无序的数组还是有序的数组

在 Java 中,选择有序数组还是无序数组取决于具体场景的性能需求与操作特点。以下是关键权衡因素及决策指南: ⚖️ 核心权衡维度 维度有序数组无序数组查询性能二分查找 O(log n) ✅线性扫描 O(n) ❌插入/删除需移位维护顺序 O(n) ❌直接操作尾部 O(1) ✅内存开销与无序数组相…...

将对透视变换后的图像使用Otsu进行阈值化,来分离黑色和白色像素。这句话中的Otsu是什么意思?

Otsu 是一种自动阈值化方法,用于将图像分割为前景和背景。它通过最小化图像的类内方差或等价地最大化类间方差来选择最佳阈值。这种方法特别适用于图像的二值化处理,能够自动确定一个阈值,将图像中的像素分为黑色和白色两类。 Otsu 方法的原…...

【Go】3、Go语言进阶与依赖管理

前言 本系列文章参考自稀土掘金上的 【字节内部课】公开课,做自我学习总结整理。 Go语言并发编程 Go语言原生支持并发编程,它的核心机制是 Goroutine 协程、Channel 通道,并基于CSP(Communicating Sequential Processes࿰…...

详解:相对定位 绝对定位 固定定位)

css的定位(position)详解:相对定位 绝对定位 固定定位

在 CSS 中,元素的定位通过 position 属性控制,共有 5 种定位模式:static(静态定位)、relative(相对定位)、absolute(绝对定位)、fixed(固定定位)和…...

前端开发面试题总结-JavaScript篇(一)

文章目录 JavaScript高频问答一、作用域与闭包1.什么是闭包(Closure)?闭包有什么应用场景和潜在问题?2.解释 JavaScript 的作用域链(Scope Chain) 二、原型与继承3.原型链是什么?如何实现继承&a…...

用docker来安装部署freeswitch记录

今天刚才测试一个callcenter的项目,所以尝试安装freeswitch 1、使用轩辕镜像 - 中国开发者首选的专业 Docker 镜像加速服务平台 编辑下面/etc/docker/daemon.json文件为 {"registry-mirrors": ["https://docker.xuanyuan.me"] }同时可以进入轩…...

零基础在实践中学习网络安全-皮卡丘靶场(第九期-Unsafe Fileupload模块)(yakit方式)

本期内容并不是很难,相信大家会学的很愉快,当然对于有后端基础的朋友来说,本期内容更加容易了解,当然没有基础的也别担心,本期内容会详细解释有关内容 本期用到的软件:yakit(因为经过之前好多期…...

MySQL账号权限管理指南:安全创建账户与精细授权技巧

在MySQL数据库管理中,合理创建用户账号并分配精确权限是保障数据安全的核心环节。直接使用root账号进行所有操作不仅危险且难以审计操作行为。今天我们来全面解析MySQL账号创建与权限分配的专业方法。 一、为何需要创建独立账号? 最小权限原则…...

DBLP数据库是什么?

DBLP(Digital Bibliography & Library Project)Computer Science Bibliography是全球著名的计算机科学出版物的开放书目数据库。DBLP所收录的期刊和会议论文质量较高,数据库文献更新速度很快,很好地反映了国际计算机科学学术研…...

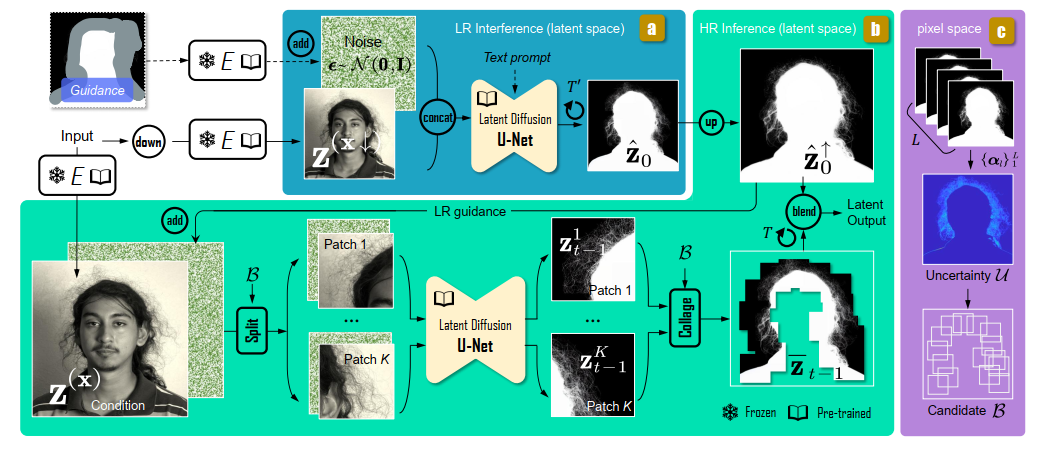

论文阅读:Matting by Generation

今天介绍一篇关于 matting 抠图的文章,抠图也算是计算机视觉里面非常经典的一个任务了。从早期的经典算法到如今的深度学习算法,已经有很多的工作和这个任务相关。这两年 diffusion 模型很火,大家又开始用 diffusion 模型做各种 CV 任务了&am…...