从【人工智能】到【计算机视觉】,【深度学习】引领的未来科技创新与变革

前几天偶然发现了一个超棒的人工智能学习网站,内容通俗易懂,讲解风趣幽默,简直让人欲罢不能。忍不住分享给大家,点击这里立刻跳转,开启你的AI学习之旅吧!

前言 – 人工智能教程

https://www.captainbed.cn/lzx

1. 引言

1.1 文章目的

本文旨在为读者提供一个全面的人工智能学习指南,涵盖从基础概念到高级技术的方方面面。我们将通过理论讲解、代码示例和应用场景分析,帮助读者深刻理解人工智能、机器学习、算法、深度学习和计算机视觉的基本原理和实际应用。

1.2 人工智能的定义

人工智能(AI)是指通过计算机系统来模拟人类的智能行为,如学习、推理、规划、理解自然语言、感知视觉和执行复杂任务等。AI的核心在于通过算法和模型使机器能够自主决策,从而替代或辅助人类进行各类复杂任务。

1.3 人工智能的重要性

人工智能的重要性日益显著。它不仅在提高生产力、优化资源配置方面发挥了关键作用,还在医疗、金融、制造业、教育等领域带来了深远的变革。AI正在改变我们生活和工作的方式,使得许多曾经不可能实现的任务成为现实。

2. 人工智能的基础

2.1 人工智能的起源与发展

起源

人工智能的起源可以追溯到20世纪50年代,当时的研究者开始探索如何让计算机执行复杂的认知任务。图灵提出的“图灵测试”是早期AI发展的一个里程碑,用于评估机器是否能够表现出与人类相似的智能。

发展历程

人工智能的发展经历了几个阶段:

- 规则系统和专家系统时代(1950-1970):AI的早期发展主要依赖于明确的规则和专家系统,用于特定领域的问题求解。

- 机器学习时代(1980-2000):随着计算能力的提升和数据量的增加,AI开始转向机器学习,通过数据驱动的方法进行学习和预测。

- 深度学习时代(2010至今):深度学习的兴起带来了AI的巨大突破,特别是在图像识别、自然语言处理等领域,表现出超越传统方法的性能。

2.2 人工智能的关键领域

计算机视觉

计算机视觉是AI的重要领域,涉及如何让机器“看懂”图像和视频。它的应用包括自动驾驶、医学影像分析、安防监控等。

自然语言处理(NLP)

NLP致力于让机器理解和生成自然语言。它的应用范围广泛,包括语音识别、机器翻译、聊天机器人等。

机器人技术

机器人技术结合了机械工程、电子工程和计算机科学,通过AI赋予机器人自主学习和执行任务的能力,应用于制造业、医疗和服务领域。

强化学习

强化学习是一种通过奖励和惩罚机制让智能体学习如何在环境中进行决策的技术。它在游戏AI、自动驾驶、金融交易等领域有着广泛的应用。

2.3 人工智能的应用领域

人工智能的应用已经渗透到各个行业。以下是一些典型的应用场景:

-

医疗保健:AI用于疾病诊断、个性化治疗方案的制定、药物研发和医疗影像分析。通过AI的帮助,医疗效率得到了显著提升。

-

金融服务:在金融领域,AI用于风险管理、欺诈检测、自动交易和客户服务。它帮助金融机构更快地处理数据和做出决策。

-

制造业:AI促进了智能制造的发展,如生产自动化、预测性维护和质量控制。通过AI的引入,制造过程变得更加高效和精准。

-

零售业:AI用于推荐系统、客户行为分析、库存管理和供应链优化。它帮助零售商更好地了解客户需求,提高销售和运营效率。

2.4 人工智能的伦理与社会影响

随着AI技术的普及,伦理问题和社会影响变得愈发重要。以下是一些关键的伦理和社会问题:

-

数据隐私:AI系统通常依赖于大量的个人数据,这带来了隐私泄露的风险。如何在使用数据的同时保护个人隐私是一个重大挑战。

-

算法偏见:由于数据和算法的固有偏见,AI系统可能会产生不公平的结果。这对社会公平性和公正性提出了挑战。

-

工作岗位的影响:AI的自动化能力可能会取代某些工作岗位,这对劳动力市场和社会结构产生深远影响。

-

AI的可解释性:许多AI系统,特别是深度学习模型,被视为“黑箱”,其决策过程难以解释。提高AI的可解释性是增强信任和透明度的重要途径。

3. 机器学习的概述

3.1 机器学习的定义与历史

定义

机器学习是人工智能的一个分支,指的是通过数据驱动的方法让计算机系统能够自动学习和改进。这种学习过程不依赖于明确的编程指令,而是通过算法从数据中提取模式,从而进行预测或决策。

历史

机器学习的发展与人工智能紧密相关。最早的机器学习算法出现在20世纪50年代,但由于计算资源的限制,其应用范围有限。随着计算能力的提升和大数据时代的到来,机器学习成为AI领域的核心技术。

3.2 机器学习的基本概念

特征与标签

特征是用于描述数据的变量或属性,而标签是指示目标值的变量。在监督学习中,模型通过学习特征和标签之间的关系来进行预测。

模型与训练

模型是一个数学表示,用于描述特征和标签之间的关系。训练过程是通过数据输入模型,并调整模型参数,使其能够准确预测输出的过程。

过拟合与欠拟合

过拟合是指模型在训练数据上表现很好,但在新数据上表现不佳的情况。欠拟合则是指模型在训练数据和新数据上都表现不佳的情况。这两种现象都表明模型的泛化能力不足。

交叉验证

交叉验证是一种评估模型性能的技术,通过将数据分成多个子集,并在不同的子集上训练和测试模型,来获得模型的稳定性和泛化能力。

3.3 机器学习的分类

监督学习

在监督学习中,模型在已知输入和输出的情况下进行训练。常见的任务包括分类和回归。

-

分类:根据输入数据的特征,将其归入某个类别。例如,垃圾邮件分类就是一个典型的分类问题。

-

回归:根据输入数据的特征,预测连续的目标值。例如,房价预测就是一个回归问题。

无监督学习

在无监督学习中,模型在没有标签的数据中发现潜在的模式和结构。常见的任务包括聚类和降维。

-

聚类:将数据分成不同的组或簇,例如,客户分群就是一种聚类任务。

-

降维:减少数据的维度,同时保留尽可能多的信息。例如,主成分分析(PCA)是一种常见的降维技术。

强化学习

强化学习是一种基于反馈的学习方式,通过与环境的交互,智能体在获得奖励或惩罚后学习如何优化其行为。强化学习在自动驾驶、游戏AI等领域有着广泛应用。

3.4 机器学习的实际应用

语音识别

语音识别系统通过分析音频信号,将语音转换为文本。这项技术广泛应用于智能助手、自动翻译、语音控制等领域。

推荐系统

推荐系统通过分析用户的行为和偏好,向用户推荐可能感兴趣的内容。这项技术广泛应用于电子商务、社交媒体、内容平台等领域。

图像识别

图像识别系统通过分析图像数据,识别出其中的物体或场景。这项技术在自动驾驶、医疗影像分析、安防监控等领域有着广泛应用。

自然语言处理(NLP)

NLP系统通过分析文本数据,理解和生成自然语言。它在机器翻译、情感分析、文本分类等任务中得到了广泛应用。

4. 机器学习的核心算法

4.1 线性回归与逻辑回归

线性回归

线性回归是一种基础的回归算法,用于预测连续目标变量。它假设目标值是输入特征的线性组合,并通过最小化预测误差来优化模型参数。

实例代码:线性回归模型

import numpy as np

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt# 数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([1, 2, 3, 4, 5])# 创建线性回归模型

model = LinearRegression()

model.fit(X, y)# 预测

predictions = model.predict(X)# 可视化

plt.scatter(X, y, color='blue')

plt.plot(X, predictions, color='red')

plt.title("Linear Regression Example")

plt.xlabel("X")

plt.ylabel("y")

plt.show()

逻辑回归

逻辑回归是一种用于二分类问题的算法,尽管名字里有“回归”,但它实际上是一个分类算法。逻辑回归通过计算每个输入属于某个类别的概率,并使用阈值将其分类。

4.2 决策树与随机森林

决策树

决策树是一种简单且直观的机器学习算法,通过一系列的决策规则将数据划分成不同的类别。每个节点代表一个决策点,分支代表可能的决策结果,叶节点代表最终的分类结果。

实例代码:决策树分类器

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn import tree

import matplotlib.pyplot as plt# 加载Iris数据集

iris = load_iris()

X, y = iris.data, iris.target# 创建决策树分类器

clf = DecisionTreeClassifier()

clf = clf.fit(X, y)# 可视化决策树

plt.figure(figsize=(12,8))

tree.plot_tree(clf, filled=True)

plt.title("Decision Tree for Iris Dataset")

plt.show()

随机森林

随机森林是一种集成学习方法,通过构建多个决策树并结合它们的预测结果,提高模型的稳定性和准确性。每棵决策树在训练时都会随机选择数据的子集和特征的子集,从而减少过拟合的风险。

4.3 支持向量机(SVM)

支持向量机的基本原理

支持向量机(SVM)是一种非常强大的分类算法,特别适用于高维数据。SVM通过寻找一个最佳的超平面,将不同类别的样本分开,最大化类间距。SVM的目标是找到使得类间距离最大的决策边界,从而提高分类的准确性。

核方法

SVM的一个重要特点是可以通过核函数将非线性数据映射到高维空间,从而在高维空间中找到线性可分的超平面。常见的核函数包括线性核、多项式核和径向基函数(RBF)核。

实例代码:SVM分类器

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

import matplotlib.pyplot as plt# 加载数据集

iris = datasets.load_iris()

X, y = iris.data, iris.target# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建SVM模型

svm_model = SVC(kernel='linear')

svm_model.fit(X_train, y_train)# 预测

y_pred = svm_model.predict(X_test)# 计算准确率

accuracy = svm_model.score(X_test, y_test)

print(f"Model Accuracy: {accuracy:.2f}")# 可视化决策边界

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm, s=20, edgecolors='k')

plt.title("SVM Decision Boundary")

plt.show()

4.4 K最近邻(KNN)算法

KNN的基本原理

K最近邻算法(KNN)是一种基于实例的学习方法,通过找到测试样本在训练集中最近的K个样本来进行分类或回归。KNN是一种懒惰学习算法,因为它在训练阶段不构建显式的模型,而是在预测时直接利用训练数据。

K的选择

K的选择对KNN算法的性能有很大的影响。K值太小可能会导致模型对噪声敏感,K值太大可能会使模型失去细节。常见的做法是通过交叉验证选择最优的K值。

实例代码:KNN分类器

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.neighbors import KNeighborsClassifier

import matplotlib.pyplot as plt# 加载数据集

iris = datasets.load_iris()

X, y = iris.data, iris.target# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建KNN模型

knn = KNeighborsClassifier(n_neighbors=3)

knn.fit(X_train, y_train)# 预测

y_pred = knn.predict(X_test)# 计算准确率

accuracy = knn.score(X_test, y_test)

print(f"Model Accuracy: {accuracy:.2f}")# 可视化KNN分类结果

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm, s=20, edgecolors='k')

plt.title("KNN Classification")

plt.show()

4.5 朴素贝叶斯分类器

朴素贝叶斯的基本原理

朴素贝叶斯分类器基于贝叶斯定理,假设特征之间是条件独立的,尽管这一假设在实际应用中不总是成立,但朴素贝叶斯在许多实际任务中仍然表现良好,特别是在文本分类任务中。

贝叶斯定理

贝叶斯定理描述了在已知先验概率和条件概率的情况下,计算后验概率的公式。朴素贝叶斯分类器通过最大化后验概率来进行分类。

实例代码:朴素贝叶斯分类器

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.naive_bayes import GaussianNB

import matplotlib.pyplot as plt# 加载数据集

iris = datasets.load_iris()

X, y = iris.data, iris.target# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建朴素贝叶斯模型

gnb = GaussianNB()

gnb.fit(X_train, y_train)# 预测

y_pred = gnb.predict(X_test)# 计算准确率

accuracy = gnb.score(X_test, y_test)

print(f"Model Accuracy: {accuracy:.2f}")# 可视化朴素贝叶斯分类结果

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm, s=20, edgecolors='k')

plt.title("Naive Bayes Classification")

plt.show()

4.6 集成学习与提升方法

集成学习的概念

集成学习是一种通过结合多个基学习器的预测结果,来提高模型的总体性能的技术。集成学习的方法包括Bagging、Boosting和Stacking。

Bagging

Bagging(Bootstrap Aggregating)通过在训练数据上训练多个模型,并将它们的预测结果结合在一起,减少了模型的方差,从而提高了稳定性。随机森林是Bagging的一个经典实例。

Boosting

Boosting是一种将弱学习器转化为强学习器的技术。通过顺序训练多个模型,每个模型关注那些前一个模型错分的样本,从而逐步提高预测性能。Adaboost和梯度提升树(Gradient Boosting)是Boosting的经典算法。

实例代码:随机森林分类器

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

import matplotlib.pyplot as plt# 加载数据集

iris = datasets.load_iris()

X, y = iris.data, iris.target# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建随机森林模型

rf = RandomForestClassifier(n_estimators=100, random_state=42)

rf.fit(X_train, y_train)# 预测

y_pred = rf.predict(X_test)# 计算准确率

accuracy = rf.score(X_test, y_test)

print(f"Model Accuracy: {accuracy:.2f}")# 可视化随机森林分类结果

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm, s=20, edgecolors='k')

plt.title("Random Forest Classification")

plt.show()

5. 深度学习的基础

5.1 深度学习与机器学习的关系

深度学习的定义

深度学习是机器学习的一个子领域,利用多层神经网络从大量数据中自动提取特征,并进行预测或决策。与传统的机器学习方法相比,深度学习能够处理更加复杂和高维的数据,如图像、语音和文本。

深度学习的优势

深度学习的主要优势在于其强大的特征提取能力,能够自动从数据中学习出有用的特征,而不需要人为设计。这使得深度学习在处理结构化和非结构化数据方面具有极大的灵活性和表现力。

5.2 神经网络的基础结构

神经元与层

神经网络的基本单位是神经元,每个神经元接收输入,进行加权求和,并通过激活函数输出结果。神经元之间通过连接形成网络,网络的层次结构决定了模型的复杂性。常见的层次结构包括输入层、隐藏层和输出层。

激活函数

激活函数用于引入非线性,使神经网络能够逼近复杂的函数关系。常见的激活函数包括Sigmoid函数、Tanh函数和ReLU(Rectified Linear Unit)函数。

前向传播与反向传播

前向传播是指数据从输入层通过隐藏层传递到输出层的过程。反向传播是通过计算损失函数的梯度,并根据梯度调整网络中的权重,从而最小化预测误差的过程。

实例代码:简单的前馈神经网络

import tensorflow as tf

from tensorflow.keras import layers, models# 创建一个简单的前馈神经网络

model = models.Sequential()

model.add(layers.Dense(128, activation='relu', input_shape=(784,)))

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax'))# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 打印模型摘要

model.summary()

5.3 深度学习的关键概念

过拟合与正则化

过拟合是指模型在训练数据上表现很好,但在新数据上表现不佳的情况。正则化是通过在损失函数中加入惩罚项,限制模型的复杂性,从而减轻过拟合的技术。常见的正则化方法包括L1正则化、L2正则化和Dropout。

优化算法

优化算法用于调整模型的参数,以最小化损失函数。常见的优化算法包括梯度下降、随机梯度下降(SGD)、动量法、AdaGrad、RMSprop和Adam。每种优化算法在收敛速度和稳定性方面各有优劣。

实例代码:使用Adam优化器的神经网络训练

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical# 加载MNIST数据集

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

train_images = train_images.reshape((60000, 784)).astype('float32') / 255

test_images = test_images.reshape((10000, 784)).astype('float32') / 255

train_labels = to_categorical(train_labels)

test_labels = to_categorical(test_labels)# 构建神经网络模型

model = models.Sequential()

model.add(layers.Dense(512, activation='relu', input_shape=(784,)))

model.add(layers.Dense(10, activation='softmax'))# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])# 训练模型

model.fit(train_images, train_labels, epochs=5, batch_size=128, validation_split=0.2)

5.4 深度学习的应用场景

图像识别

深度学习,尤其是卷积神经网络(CNN),在图像识别任务中表现卓越。CNN通过卷积操作提取图像中的空间特征,应用于人脸识别、自动驾驶、医学图像分析等领域。

语音识别

语音识别利用深度学习模型将语音信号转换为文本。深度学习在语音识别中的应用使得智能助手、语音搜索和语音翻译系统得到了显著的提升。

自然语言处理

深度学习在自然语言处理中的应用包括文本分类、情感分析、机器翻译、文本生成等。通过使用循环神经网络(RNN)和Transformer模型,深度学习在处理序列数据和上下文信息方面表现出了强大的能力。

实例代码:使用CNN进行图像分类

import tensorflow as tf

from tensorflow.keras import datasets, layers, models# 加载CIFAR-10数据集

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()# 标准化数据

train_images, test_images = train_images / 255.0, test_images / 255.0# 创建CNN模型

model = models.Sequential([layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.Flatten(),layers.Dense(64, activation='relu'),layers.Dense(10, activation='softmax')

])# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 训练模型

model.fit(train_images, train_labels, epochs=10, validation_data=(test_images, test_labels))

6. 深度学习中的经典模型

6.1 卷积神经网络(CNN)

CNN的基本原理

卷积神经网络(CNN)是一种专门用于处理图像数据的神经网络模型。CNN通过卷积层、池化层和全连接层的组合,逐层提取图像的特征,实现对图像的分类、检测和分割。

- 卷积层:通过卷积操作提取图像中的局部特征,如边缘、纹理等。

- 池化层:通过下采样减少特征图的尺寸,同时保留重要的特征信息。

- 全连接层:通过将特征图展平成一维向量,并经过多个全连接层,输出最终的分类结果。

实例代码:使用CNN进行手写数字识别

import tensorflow as tf

from tensorflow.keras import datasets, layers, models# 加载MNIST数据集

(train_images, train_labels), (test_images, test_labels) = datasets.mnist.load_data()

train_images = train_images.reshape((60000, 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((10000, 28, 28, 1)).astype('float32') / 255# 创建CNN模型

model = models.Sequential([layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.Flatten(),layers.Dense(64, activation='relu'),layers.Dense(10, activation='softmax')

])# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 训练模型

model.fit(train_images, train_labels, epochs=5, batch_size=64, validation_split=0.2)

6.2 循环神经网络(RNN)

RNN的基本原理

循环神经网络(RNN)是一类用于处理序列数据的神经网络模型,广泛应用于自然语言处理、语音识别和时间序列预测等任务。RNN通过使用循环结构,使得网络能够记住先前输入的信息,并将其应用于当前的输出。

长短期记忆网络(LSTM)

LSTM是RNN的一种变体,解决了传统RNN在处理长序列时容易遗忘信息的问题。LSTM通过引入“记忆单元”结构,使得网络能够有效地学习和记住长时间间隔的依赖关系。

实例代码:使用LSTM进行文本生成

import tensorflow as tf

from tensorflow.keras import layers, models

import numpy as np# 假设我们有一个简单的字符级文本生成任务

text = "hello world"

chars = sorted(list(set(text)))

char_indices = dict((c, i) for i, c in enumerate(chars))

indices_char = dict((i, c) for i, c in enumerate(chars))# 准备数据

maxlen = 3

step = 1

sentences = []

next_chars = []

for i in range(0, len(text) - maxlen, step):sentences.append(text[i: i + maxlen])next_chars.append(text[i + maxlen])

X = np.zeros((len(sentences), maxlen, len(chars)), dtype=np.bool)

y = np.zeros((len(sentences), len(chars)), dtype=np.bool)

for i, sentence in enumerate(sentences):for t, char in enumerate(sentence):X[i, t, char_indices[char]] = 1y[i, char_indices[next_chars[i]]] = 1# 创建LSTM模型

model = models.Sequential()

model.add(layers.LSTM(128, input_shape=(maxlen, len(chars))))

model.add(layers.Dense(len(chars), activation='softmax'))# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy')# 训练模型

model.fit(X, y, batch_size=128, epochs=60)# 文本生成

def sample(preds, temperature=1.0):preds = np.asarray(preds).astype('float64')preds = np.log(preds) / temperatureexp_preds = np.exp(preds)preds = exp_preds / np.sum(exp_preds)probas = np.random.multinomial(1, preds, 1)return np.argmax(probas)generated = ''

start_index = 0

for i in range(400):sampled = np.zeros((1, maxlen, len(chars)))for t, char in enumerate(text[start_index: start_index + maxlen]):sampled[0, t, char_indices[char]] = 1.preds = model.predict(sampled, verbose=0)[0]next_index = sample(preds)next_char = indices_char[next_index]generated += next_chartext = text[1:] + next_char

print(generated)

6.3 生成对抗网络(GAN)

GAN的基本原理

生成对抗网络(GAN)由两个神经网络组成:生成器(Generator)和判别器(Discriminator)。生成器试图生成逼真的数据,而判别器则试图区分生成的数据和真实的数据。通过这两个网络的对抗训练,生成器最终能够生成非常逼真的数据。

应用场景

GAN在图像生成、图像修复、图像超分辨率、风格迁移等领域有着广泛的应用。例如,GAN可以生成逼真的人脸图像,尽管这些人脸并不存在于现实中。

实例代码:使用GAN生成手写数字

import tensorflow as tf

from tensorflow.keras import layers, models

import numpy as np# 加载MNIST数据集

(train_images, _), (_, _) = tf.keras.datasets.mnist.load_data()

train_images = train_images.reshape(train_images.shape[0], 28, 28, 1).astype('float32')

train_images = (train_images - 127.5) / 127.5 # 归一化到[-1, 1]之间BUFFER_SIZE = 60000

BATCH_SIZE = 256# 批量化和打乱数据

train_dataset = tf.data.Dataset.from_tensor_slices(train_images).shuffle(BUFFER_SIZE).batch(BATCH_SIZE)# 创建生成器模型

def make_generator_model():model = tf.keras.Sequential()model.add(layers.Dense(7*7*256, use_bias=False, input_shape=(100,)))model.add(layers.BatchNormalization())model.add(layers.LeakyReLU())model.add(layers.Reshape((7, 7, 256)))model.add(layers.Conv2DTranspose(128, (5, 5), strides=(1, 1), padding='same', use_bias=False))model.add(layers.BatchNormalization())model.add(layers.LeakyReLU())model.add(layers.Conv2DTranspose(64, (5, 5), strides=(2, 2), padding='same', use_bias=False))model.add(layers.BatchNormalization())model.add(layers.LeakyReLU())model.add(layers.Conv2DTranspose(1, (5, 5), strides=(2, 2), padding='same', use_bias=False, activation='tanh'))return model# 创建判别器模型

def make_discriminator_model():model = tf.keras.Sequential()model.add(layers.Conv2D(64, (5, 5), strides=(2, 2), padding='same', input_shape=[28, 28, 1]))model.add(layers.LeakyReLU())model.add(layers.Dropout(0.3))model.add(layers.Conv2D(128, (5, 5), strides=(2, 2), padding='same'))model.add(layers.LeakyReLU())model.add(layers.Dropout(0.3))model.add(layers.Flatten())model.add(layers.Dense(1))return model# 创建生成器和判别器

generator = make_generator_model()

discriminator = make_discriminator_model()# 定义损失函数和优化器

cross_entropy = tf.keras.losses.BinaryCrossentropy(from_logits=True)def generator_loss(fake_output):return cross_entropy(tf.ones_like(fake_output), fake_output)def discriminator_loss(real_output, fake_output):real_loss = cross_entropy(tf.ones_like(real_output), real_output)fake_loss = cross_entropy(tf.zeros_like(fake_output), fake_output)total_loss = real_loss + fake_lossreturn total_lossgenerator_optimizer = tf.keras.optimizers.Adam(1e-4)

discriminator_optimizer = tf.keras.optimizers.Adam(1e-4)# 训练GAN模型

EPOCHS = 50

noise_dim = 100

num_examples_to_generate = 16# 保存生成器的噪声向量

seed = tf.random.normal([num_examples_to_generate, noise_dim])# 训练循环

for epoch in range(EPOCHS):for image_batch in train_dataset:noise = tf.random.normal([BATCH_SIZE, noise_dim])with tf.GradientTape() as gen_tape, tf.GradientTape() as disc_tape:generated_images = generator(noise, training=True)real_output = discriminator(image_batch, training=True)fake_output = discriminator(generated_images, training=True)gen_loss = generator_loss(fake_output)disc_loss = discriminator_loss(real_output, fake_output)gradients_of_generator = gen_tape.gradient(gen_loss, generator.trainable_variables)gradients_of_discriminator = disc_tape.gradient(disc_loss, discriminator.trainable_variables)generator_optimizer.apply_gradients(zip(gradients_of_generator, generator.trainable_variables))discriminator_optimizer.apply_gradients(zip(gradients_of_discriminator, discriminator.trainable_variables))# 每训练一个epoch,生成并保存一些图像generated_images = generator(seed, training=False)# Save or display the generated images here

6.4 Transformer模型

Transformer的基本原理

Transformer模型是一种专为处理序列数据设计的深度学习架构,最初用于自然语言处理任务。与传统的RNN相比,Transformer通过自注意力机制能够更有效地捕捉序列中各个元素之间的长距离依赖关系。

自注意力机制

自注意力机制是Transformer模型的核心,通过计算输入序列中每个元素与其他元素的相关性,模型能够选择性地关注最重要的部分,从而提高对序列数据的理解能力。

实例代码:使用Transformer进行文本分类

from transformers import BertTokenizer, TFBertForSequenceClassification

from transformers import pipeline# 加载预训练的BERT模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = TFBertForSequenceClassification.from_pretrained('bert-base-uncased')# 创建文本分类管道

nlp = pipeline('sentiment-analysis', model=model, tokenizer=tokenizer)# 使用模型进行文本分类

print(nlp("I love machine learning!"))

print(nlp("I hate bugs in the code."))

7. 深度学习的高级技术

7.1 自然语言处理(NLP)

NLP的基本任务

自然语言处理(NLP)包括文本分类、情感分析、机器翻译、文本生成等任务。深度学习,特别是RNN、LSTM和Transformer模型,在这些任务中表现卓越。

实例代码:使用BERT进行情感分析

from transformers import pipeline# 加载预训练的情感分析模型

classifier = pipeline('sentiment-analysis')# 分析文本情感

results = classifier(["I love machine learning!", "I hate bugs in the code."])

print(results)

7.2 计算机视觉中的度学习深

计算机视觉的基本任务

计算机视觉包括图像分类、目标检测、图像分割、姿态估计等任务。深度学习模型,尤其是CNN,在这些任务中取得了显著的成果。

实例代码:使用YOLO进行目标检测

from tensorflow.keras.models import load_model

import cv2

import numpy as np# 加载YOLO模型

model = load_model('yolov3.h5')# 加载图像

image = cv2.imread('example.jpg')

image = cv2.resize(image, (416, 416))

image = image.astype('float32')

image /= 255.0

image = np.expand_dims(image, axis=0)# 进行目标检测

detections = model.predict(image)# 处理检测结果(例如绘制边界框等)

# 详细处理代码省略

7.3 迁移学习

迁移学习的基本原理

迁移学习是一种利用在一个任务上训练好的模型参数,应用到另一个相关任务上,从而减少训练时间和数据需求的技术。迁移学习在小数据集的应用场景中特别有用。

实例代码:使用迁移学习进行图像分类

from tensorflow.keras.applications import VGG16

from tensorflow.keras import layers, models# 加载预训练的VGG16模型(不包含顶层的分类层)

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))# 冻结预训练模型的卷积层

for layer in base_model.layers:layer.trainable = False# 创建新模型并添加自定义分类层

model = models.Sequential([base_model,layers.Flatten(),layers.Dense(256, activation='relu'),layers.Dropout(0.5),layers.Dense(10, activation='softmax')

])# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 训练模型

# X_train, y_train, X_val, y_val 应该是加载并预处理的训练和验证数据

model.fit(X_train, y_train, epochs=10, validation_data=(X_val, y_val))

7.4 元学习

元学习的基本原理

元学习,也被称为“学习如何学习”,旨在让模型能够快速适应新任务。元学习通过优化算法的设计,使得模型能够在少量训练样本的情况下,快速学习新任务。

应用场景

元学习在快速变化的环境中特别有用,如机器人控制、在线推荐系统等。通过元学习,系统可以迅速适应新用户、新场景或新任务。

实例代码:使用MAML进行图像分类

# MAML的实现较为复杂,此处给出简化的伪代码示例

import tensorflow as tf

from tensorflow.keras import layers, models# 定义模型结构

def create_model():model = models.Sequential([layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.MaxPooling2D((2, 2)),layers.Flatten(),layers.Dense(64, activation='relu'),layers.Dense(10, activation='softmax')])return model# 初始化模型

model = create_model()# 定义MAML训练步骤

def maml_train_step(model, support_set, query_set, inner_lr=0.01, outer_lr=0.001):with tf.GradientTape() as outer_tape:# 在support set上进行inner loop更新for i in range(inner_steps):with tf.GradientTape() as inner_tape:support_predictions = model(support_set['X'])inner_loss = tf.losses.sparse_categorical_crossentropy(support_set['y'], support_predictions)grads = inner_tape.gradient(inner_loss, model.trainable_variables)inner_optimizer.apply_gradients(zip(grads, model.trainable_variables))# 在query set上计算outer loop损失query_predictions = model(query_set['X'])outer_loss = tf.losses.sparse_categorical_crossentropy(query_set['y'], query_predictions)# 计算outer loop梯度并更新模型outer_grads = outer_tape.gradient(outer_loss, model.trainable_variables)outer_optimizer.apply_gradients(zip(outer_grads, model.trainable_variables))# 训练过程

for task in tasks:maml_train_step(model, task['support'], task['query'])

7.5 深度强化学习

深度强化学习的基本原理

深度强化学习结合了深度学习和强化学习的优势,通过深度神经网络处理高维状态空间,并通过奖励机制优化策略。在游戏AI、自动驾驶、机器人控制等领域,深度强化学习展现了强大的潜力。

实例代码:使用DQN进行游戏AI训练

import tensorflow as tf

import numpy as np

import gym# 创建Q网络

def build_q_network(state_shape, action_size):model = tf.keras.Sequential([tf.keras.layers.Dense(24, input_shape=state_shape, activation='relu'),tf.keras.layers.Dense(24, activation='relu'),tf.keras.layers.Dense(action_size, activation='linear')])return model# 初始化环境和Q网络

env = gym.make('CartPole-v1')

state_shape = env.observation_space.shape

action_size = env.action_space.n

q_network = build_q_network(state_shape, action_size)# 超参数

gamma = 0.99 # 折扣因子

epsilon = 1.0 # 探索率

epsilon_min = 0.01

epsilon_decay = 0.995

learning_rate = 0.001

batch_size = 32

memory = []# 训练循环

for episode in range(1000):state = env.reset()state = np.reshape(state, [1, state_shape[0]])for time in range(500):# 选择动作if np.random.rand() <= epsilon:action = np.random.choice(action_size)else:q_values = q_network.predict(state)action = np.argmax(q_values[0])# 执行动作next_state, reward, done, _ = env.step(action)next_state = np.reshape(next_state, [1, state_shape[0]])# 存储经验memory.append((state, action, reward, next_state, done))state = next_state# 更新Q网络if len(memory) > batch_size:minibatch = np.random.choice(memory, batch_size, replace=False)for s, a, r, ns, d in minibatch:target = rif not d:target = r + gamma * np.amax(q_network.predict(ns)[0])target_f = q_network.predict(s)target_f[0][a] = targetq_network.fit(s, target_f, epochs=1, verbose=0)if done:print(f"Episode {episode+1}/{1000}, Score: {time}")breakif epsilon > epsilon_min:epsilon *= epsilon_decay

8. 算法在人工智能中的作用

8.1 算法的定义与分类

算法的定义

算法是一系列明确的步骤,用于解决特定问题。在人工智能中,算法用于驱动模型的学习、推理和决策过程。

算法的分类

算法可以根据其用途和性质分为不同的类型,例如:

- 搜索算法:用于在解决问题的搜索空间中找到最优解。

- 优化算法:用于在多维空间中寻找目标函数的最优解。

- 进化算法:基于自然选择的原理,通过遗传算法、粒子群优化等方法寻找全局最优解。

- 图算法:用于图结构数据的处理,如最短路径算法、最大流算法等。

8.2 经典算法在人工智能中的应用

搜索算法

搜索算法用于在解决问题的搜索空间中找到最优解。经典的搜索算法包括广度优先搜索(BFS)、深度优先搜索(DFS)、A*搜索等。在路径规划、问题求解等领域,搜索算法是必不可少的工具。

实例代码:A*搜索算法

from queue import PriorityQueue# A*算法的简单实现

def a_star_search(start, goal, graph):open_set = PriorityQueue()open_set.put((0, start))came_from = {}g_score = {node: float('inf') for node in graph}g_score[start] = 0while not open_set.empty():_, current = open_set.get()if current == goal:breakfor neighbor, weight in graph[current]:tentative_g_score = g_score[current] + weightif tentative_g_score < g_score[neighbor]:came_from[neighbor] = currentg_score[neighbor] = tentative_g_scoreopen_set.put((tentative_g_score, neighbor))# 重构路径path = []while current in came_from:path.append(current)current = came_from[current]path.append(start)path.reverse()return path# 示例图

graph = {'A': [('B', 1), ('C', 3)],'B': [('A', 1), ('D', 5)],'C': [('A', 3), ('D', 1)],'D': [('B', 5), ('C', 1)]

}# 运行A*搜索

path = a_star_search('A', 'D', graph)

print("Path found by A*:", path)

优化算法

优化算法用于在多维空间中寻找目标函数的最优解。常见的优化算法包括梯度下降、遗传算法、粒子群优化等。在机器学习和深度学习中,优化算法被广泛用于模型参数的调整,以最小化损失函数。

实例代码:粒子群优化算法

import numpy as np# 粒子群优化算法的简单实现

def particle_swarm_optimization(func, dim, bounds, num_particles, max_iter):# 初始化粒子群particles = np.random.uniform(low=bounds[0], high=bounds[1], size=(num_particles, dim))velocities = np.zeros((num_particles, dim))personal_best_positions = particles.copy()personal_best_scores = np.array([func(p) for p in particles])global_best_position = personal_best_positions[np.argmin(personal_best_scores)]global_best_score = np.min(personal_best_scores)# 粒子群优化循环for i in range(max_iter):for j in range(num_particles):r1, r2 = np.random.rand(), np.random.rand()velocities[j] = 0.5 * velocities[j] + 1.5 * r1 * (personal_best_positions[j] - particles[j]) + 1.5 * r2 * (global_best_position - particles[j])particles[j] += velocities[j]# 更新个人和全局最优score = func(particles[j])if score < personal_best_scores[j]:personal_best_scores[j] = scorepersonal_best_positions[j] = particles[j]if score < global_best_score:global_best_score = scoreglobal_best_position = particles[j]return global_best_position, global_best_score# 示例函数:Rastrigin函数

def rastrigin(x):return 10 * len(x) + sum([xi**2 - 10 * np.cos(2 * np.pi * xi) for xi in x])# 使用粒子群优化寻找Rastrigin函数的最小值

best_position, best_score = particle_swarm_optimization(rastrigin, dim=2, bounds=(-5.12, 5.12), num_particles=30, max_iter=100)

print(f"Best position: {best_position}, Best score: {best_score}")

进化算法

进化算法基于自然选择的原理,通过遗传算法、差分进化、粒子群优化等方法寻找全局最优解。进化算法在全局优化问题中表现出色,特别是在高维和非凸优化问题中。

实例代码:遗传算法

import numpy as np# 遗传算法的简单实现

def genetic_algorithm(func, dim, bounds, population_size, generations, mutation_rate):# 初始化种群population = np.random.uniform(low=bounds[0], high=bounds[1], size=(population_size, dim))best_individual = Nonebest_score = float('inf')for generation in range(generations):# 计算适应度scores = np.array([func(individual) for individual in population])if np.min(scores) < best_score:best_score = np.min(scores)best_individual = population[np.argmin(scores)]# 选择父代selected = population[np.argsort(scores)][:population_size//2]# 交叉与变异offspring = []for i in range(0, len(selected), 2):parent1, parent2 = selected[i], selected[i+1]child = (parent1 + parent2) / 2if np.random.rand() < mutation_rate:child += np.random.normal(size=dim)offspring.append(child)population = np.vstack((selected, offspring))return best_individual, best_score# 示例函数:Rastrigin函数

def rastrigin(x):return 10 * len(x) + sum([xi**2 - 10 * np.cos(2 * np.pi * xi) for xi in x])# 使用遗传算法寻找Rastrigin函数的最小值

best_individual, best_score = genetic_algorithm(rastrigin, dim=2, bounds=(-5.12, 5.12), population_size=30, generations=100, mutation_rate=0.1)

print(f"Best individual: {best_individual}, Best score: {best_score}")

图算法

图算法用于处理图结构的数据,如社交网络分析、网络流量分析、路径规划等。经典的图算法包括Dijkstra最短路径算法、Bellman-Ford算法、Kruskal最小生成树算法等。

实例代码:Dijkstra最短路径算法

import heapqdef dijkstra(graph, start):# 初始化距离表和优先队列distances = {node: float('inf') for node in graph}distances[start] = 0priority_queue = [(0, start)]while priority_queue:current_distance, current_node = heapq.heappop(priority_queue)if current_distance > distances[current_node]:continuefor neighbor, weight in graph[current_node]:distance = current_distance + weightif distance < distances[neighbor]:distances[neighbor] = distanceheapq.heappush(priority_queue, (distance, neighbor))return distances# 示例图

graph = {'A': [('B', 1), ('C', 4)],'B': [('A', 1), ('C', 2), ('D', 5)],'C': [('A', 4), ('B', 2), ('D', 1)],'D': [('B', 5), ('C', 1)]

}# 运行Dijkstra算法

distances = dijkstra(graph, 'A')

print(f"Shortest distances from A: {distances}")

9. 计算机视觉技术

9.1 计算机视觉的定义与应用

计算机视觉的定义

计算机视觉是一门研究如何让计算机理解和解释视觉信息的学科。它涉及图像处理、特征提取、模式识别等多个领域,旨在让计算机能够“看懂”图像和视频,并基于视觉信息做出决策。

计算机视觉的应用领域

计算机视觉的应用涵盖广泛,包括自动驾驶、医疗影像分析、安防监控、人脸识别、工业检测等。在自动驾驶领域,计算机视觉用于识别道路、车辆、行人和交通信号。在医疗影像分析中,计算机视觉用于辅助医生进行疾病诊断。

9.2 计算机视觉中的图像处理

图像处理的基本操作

图像处理是计算机视觉的基础操作,包括图像的读取、预处理、特征提取和增强等。常见的图像处理技术包括边缘检测、图像平滑、形态学操作等。

实例代码:使用OpenCV进行图像处理

import cv2

import numpy as np

import matplotlib.pyplot as plt# 加载图像

image = cv2.imread('example.jpg', cv2.IMREAD_GRAYSCALE)# 边缘检测

edges = cv2.Canny(image, 100, 200)# 图像平滑

blurred = cv2.GaussianBlur(image, (5, 5), 0)# 图像增强(直方图均衡化)

equalized = cv2.equalizeHist(image)# 可视化处理结果

plt.figure(figsize=(10, 5))

plt.subplot(1, 3, 1)

plt.title('Original Image')

plt.imshow(image, cmap='gray')plt.subplot(1, 3, 2)

plt.title('Edge Detection')

plt.imshow(edges, cmap='gray')plt.subplot(1, 3, 3)

plt.title('Equalized Image')

plt.imshow(equalized, cmap='gray')plt.show()

9.3 深度学习在计算机视觉中的作用

深度学习在图像分类中的应用

深度学习,特别是卷积神经网络(CNN),在图像分类任务中表现卓越。CNN通过卷积层提取图像的空间特征,并通过全连接层进行分类。

实例代码:使用CNN进行图像分类

import tensorflow as tf

from tensorflow.keras import datasets, layers, models# 加载CIFAR-10数据集

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()# 标准化数据

train_images, test_images = train_images / 255.0, test_images / 255.0# 创建CNN模型

model = models.Sequential([layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.MaxPooling2D((2, 2)),layers.Conv2D(64, (3, 3), activation='relu'),layers.Flatten(),layers.Dense(64, activation='relu'),layers.Dense(10, activation='softmax')

])# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 训练模型

model.fit(train_images, train_labels, epochs=10, validation_data=(test_images, test_labels))

9.4 目标检测技术

目标检测的基本概念

目标检测是计算机视觉中的重要任务,旨在识别图像中的目标物体并标注其位置。目标检测技术在自动驾驶、视频监控、人脸识别等领域有着广泛的应用。

经典目标检测算法

经典的目标检测算法包括R-CNN、Fast R-CNN、Faster R-CNN、YOLO(You Only Look Once)、SSD(Single Shot MultiBox Detector)等。这些算法在精度和速度上各有优势。

实例代码:使用YOLO进行目标检测

from tensorflow.keras.models import load_model

import cv2

import numpy as np# 加载YOLO模型

model = load_model('yolov3.h5')# 加载图像

image = cv2.imread('example.jpg')

image = cv2.resize(image, (416, 416))

image = image.astype('float32')

image /= 255.0

image = np.expand_dims(image, axis=0)# 进行目标检测

detections = model.predict(image)# 处理检测结果(例如绘制边界框等)

# 详细处理代码省略

9.5 图像分割方法

图像分割的基本概念

图像分割是将图像分成若干个区域,每个区域对应不同的对象或背景。在医学影像分析、自动驾驶等领域,图像分割是关键任务之一。

实例代码:使用UNet进行医学图像分割

import tensorflow as tf

from tensorflow.keras import layers, models# 创建UNet模型

def unet_model(input_size=(128, 128, 1)):inputs = tf.keras.Input(input_size)conv1 = layers.Conv2D(64, (3, 3), activation='relu', padding='same')(inputs)conv1 = layers.Conv2D(64, (3, 3), activation='relu', padding='same')(conv1)pool1 = layers.MaxPooling2D(pool_size=(2, 2))(conv1)conv2 = layers.Conv2D(128, (3, 3), activation='relu', padding='same')(pool1)conv2 = layers.Conv2D(128, (3, 3), activation='relu', padding='same')(conv2)pool2 = layers.MaxPooling2D(pool_size=(2, 2))(conv2)conv3 = layers.Conv2D(256, (3, 3), activation='relu', padding='same')(pool2)conv3 = layers.Conv2D(256, (3, 3), activation='relu', padding='same')(conv3)pool3 = layers.MaxPooling2D(pool_size=(2, 2))(conv3)conv4 = layers.Conv2D(512, (3, 3), activation='relu', padding='same')(pool3)conv4 = layers.Conv2D(512, (3, 3), activation='relu', padding='same')(conv4)drop4 = layers.Dropout(0.5)(conv4)pool4 = layers.MaxPooling2D(pool_size=(2, 2))(drop4)conv5 = layers.Conv2D(1024, (3, 3), activation='relu', padding='same')(pool4)conv5 = layers.Conv2D(1024, (3, 3), activation='relu', padding='same')(conv5)drop5 = layers.Dropout(0.5)(conv5)up6 = layers.Conv2D(512, (2, 2), activation='relu', padding='same')(layers.UpSampling2D(size=(2, 2))(drop5))merge6 = layers.concatenate([drop4, up6], axis=3)conv6 = layers.Conv2D(512, (3, 3), activation='relu', padding='same')(merge6)conv6 = layers.Conv2D(512, (3, 3), activation='relu', padding='same')(conv6)up7 = layers.Conv2D(256, (2, 2), activation='relu', padding='same')(layers.UpSampling2D(size=(2, 2))(conv6))merge7 = layers.concatenate([conv3, up7], axis=3)conv7 = layers.Conv2D(256, (3, 3), activation='relu', padding='same')(merge7)conv7 = layers.Conv2D(256, (3, 3), activation='relu', padding='same')(conv7)up8 = layers.Conv2D(128, (2, 2), activation='relu', padding='same')(layers.UpSampling2D(size=(2, 2))(conv7))merge8 = layers.concatenate([conv2, up8], axis=3)conv8 = layers.Conv2D(128, (3, 3), activation='relu', padding='same')(merge8)conv8 = layers.Conv2D(128, (3, 3), activation='relu', padding='same')(conv8)up9 = layers.Conv2D(64, (2, 2), activation='relu', padding='same')(layers.UpSampling2D(size=(2, 2))(conv8))merge9 = layers.concatenate([conv1, up9], axis=3)conv9 = layers.Conv2D(64, (3, 3), activation='relu', padding='same')(merge9)conv9 = layers.Conv2D(64, (3, 3), activation='relu', padding='same')(conv9)conv9 = layers.Conv2D(2, (3, 3), activation='relu', padding='same')(conv9)conv10 = layers.Conv2D(1, (1, 1), activation='sigmoid')(conv9)model = models.Model(inputs, conv10)return model# 编译和训练模型

model = unet_model()

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# model.fit(X_train, y_train, validation_data=(X_val, y_val), epochs=50)

9.6 视频分析与行为识别

视频分析的基本概念

视频分析是指对视频数据进行处理和分析,以识别和跟踪视频中的物体、检测事件和行为。在安防监控、体育分析和自动驾驶中,视频分析有着广泛的应用。

行为识别的挑战

行为识别是视频分析中的重要任务之一,涉及对人体姿态、动作和行为的识别。这一任务的挑战在于复杂的背景、遮挡和运动的多样性。

实例代码:使用OpenPose进行姿态估计

import cv2

import numpy as np# 加载OpenPose模型

protoFile = "pose_deploy_linevec.prototxt"

weightsFile = "pose_iter_440000.caffemodel"

net = cv2.dnn.readNetFromCaffe(protoFile, weightsFile)# 加载视频

cap = cv2.VideoCapture('video.mp4')while cap.isOpened():ret, frame = cap.read()if not ret:break# 图像预处理frameWidth = frame.shape[1]frameHeight = frame.shape[0]inpBlob = cv2.dnn.blobFromImage(frame, 1.0 / 255, (368, 368), (0, 0, 0), swapRB=False, crop=False)net.setInput(inpBlob)# 姿态估计output = net.forward()# 处理输出(例如绘制关键点等)# 详细处理代码省略cap.release()

cv2.destroyAllWindows()

10. 人工智能的挑战与未来

10.1 数据隐私与伦理问题

数据隐私的挑战

随着人工智能的普及,数据隐私成为一个重要的伦理问题。AI系统通常需要大量数据来进行训练和优化,这些数据往往涉及个人隐私。因此,如何在保障用户隐私的同时,利用数据提升AI性能,是一个亟待解决的问题。

伦理问题的探讨

除了隐私问题,人工智能还面临着一系列伦理挑战,如算法偏见、自动化对就业的影响、AI决策的透明性和可解释性等。这些问题需要从技术、法律、政策和社会层面进行综合应对。

实例代码:实现简单的隐私保护机制

from sklearn.preprocessing import StandardScaler

from sklearn.decomposition import PCA

import numpy as np# 假设我们有一个包含敏感数据的数据集X

X = np.random.rand(100, 10) # 这是一个示例数据集# 数据标准化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)# 使用PCA进行降维,减少数据的隐私暴露

pca = PCA(n_components=5)

X_pca = pca.fit_transform(X_scaled)# 处理后的数据X_pca可用于AI模型的训练

10.2 人工智能的可解释性与透明性

AI可解释性的必要性

在许多应用中,AI决策的透明性和可解释性至关重要。特别是在医疗、法律、金融等领域,用户需要理解AI系统的决策过程,以确保其可信度和可靠性。

可解释性技术

可解释AI技术包括可视化、模型解释工具(如LIME、SHAP)和可解释模型(如决策树、规则模型)等。这些技术帮助用户理解AI系统的内部机制和输出结果。

实例代码:使用LIME解释模型预测

import lime

import lime.lime_tabular

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target# 训练模型

rf = RandomForestClassifier()

rf.fit(X, y)# 创建LIME解释器

explainer = lime.lime_tabular.LimeTabularExplainer(X, feature_names=iris.feature_names, class_names=iris.target_names, discretize_continuous=True)# 选择一个样本进行解释

sample = X[0].reshape(1, -1)

exp = explainer.explain_instance(sample[0], rf.predict_proba, num_features=4)

exp.show_in_notebook(show_table=True, show_all=False)

10.3 人工智能的未来趋势

AI的未来发展方向

未来,人工智能将在多个领域继续深化发展。大数据、云计算、量子计算的结合,将进一步提升AI的能力。此外,跨学科的融合,如生物学与AI的结合,将催生出新的研究方向和应用场景。

人工智能的社会影响

随着AI技术的不断发展,其对社会的影响将日益深远。从经济、文化到法律,各个领域都将受到AI的冲击。因此,社会各界需要共同努力,确保AI技术的发展能够造福全人类。

10.4 技术与伦理的平衡

技术与伦理的双刃剑

技术发展和伦理挑战往往是一枚硬币的两面。如何在推动技术进步的同时,确保技术的伦理性,是AI发展的关键议题。通过制定严格的伦理准则和法律法规,可以引导AI技术朝着有益于社会的方向发展。

AI伦理框架的制定

AI伦理框架的制定需要考虑技术、法律、社会等多个维度。各国政府、技术公司、学术机构和社会组织应共同努力,制定符合社会价值观的AI伦理准则,确保技术发展与社会利益的协调统一。

11. 总结与展望

本文系统性地介绍了人工智能、机器学习、深度学习、算法和计算机视觉的基础知识、核心技术和实际应用。从基本概念到高级技术,本文旨在为读者提供一个全面的学习指南,帮助他们深入理解和掌握AI领域的关键内容。

人工智能的未来发展将更加广泛和深入。随着技术的进步,AI将在更多的领域得到应用,带来新的机遇和挑战。未来的AI技术将更加智能化、个性化和普惠化,为人类社会的发展提供强大的动力。

为了迎接AI未来的发展挑战,个人和组织需要不断学习和适应新技术。同时,社会各界需要加强合作,共同制定和实施AI技术的伦理准则和法律法规,确保AI技术在造福人类的同时,不产生负面的社会影响。

相关文章:

从【人工智能】到【计算机视觉】,【深度学习】引领的未来科技创新与变革

前几天偶然发现了一个超棒的人工智能学习网站,内容通俗易懂,讲解风趣幽默,简直让人欲罢不能。忍不住分享给大家,点击这里立刻跳转,开启你的AI学习之旅吧! 前言 – 人工智能教程https://www.captainbed.cn/l…...

基于YOLOv10深度学习的草莓成熟度检测与识别系统【python源码+Pyqt5界面+数据集+训练代码】目标检测、人工智能

《博主简介》 小伙伴们好,我是阿旭。专注于人工智能、AIGC、python、计算机视觉相关分享研究。 ✌更多学习资源,可关注公-仲-hao:【阿旭算法与机器学习】,共同学习交流~ 👍感谢小伙伴们点赞、关注! 《------往期经典推…...

log4j日志配置%X{TransId}

log4j日志配置文件中的%X{TransId}是怎么动态获取值的 在Log4j中,%X{TransId} 是用来从MDC(Mapped Diagnostic Context)中获取值的占位符。MDC 是 Log4j 提供的一种机制,用于在同一个线程的不同日志记录中传递上下文信息。通过 M…...

PHP模拟高并发异步请求测试+redis的setnx处理并发和防止死锁处理

/** PHP并发异步请求测试* /test/curlMulti*/public function curlMultiAction(){$urls ["http://localhost:801/api/order/create","http://localhost:801/api/order/create","http://localhost:801/api/order/create","http://localhos…...

访问网站出现“此站点不安全”如何解决

在网络浏览中,我们经常会遇到浏览器地址栏出现“此站点不安全”的警告。这通常意味着网站没有使用SSL(安全套接层)加密来保护用户数据的安全。那么,如何通过获得并安装SSL证书来消除这一警告,确保网站的安全可靠呢&…...

同一台电脑同时连接使用Gitee(码云)和Github

1、添加对应的密钥 ssh-keygen -t rsa -C "your_emailexample.com" -f ~/.ssh/github_id-rsa //生成github秘钥 ssh-keygen -t rsa -C "your_emailexample.com" -f ~/.ssh/gitee_id-rsa //生成码云秘钥 2、在 ~/.ssh 文件里会生成对应的文件 文件夹里会…...

GORM 插入和批量插入操作介绍

GORM 是一个功能强大的 Go 语言 ORM 库,它提供了简单易用的 API 来执行数据库操作。本文将介绍如何使用 GORM 进行单条记录插入和批量插入操作。 单条记录插入 在 GORM 中,插入一条记录非常简单。首先,你需要定义一个模型,该模型…...

企业CAD图纸加密软件推荐!2024年好用的10款CAD图纸加密软件排行

在现代企业中,CAD图纸作为重要的设计和工程数据,其安全性和保密性至关重要。为了防止图纸被非法获取、篡改或滥用,选择一款高效的CAD图纸加密软件显得尤为重要。本文将为您推荐2024年市场上十款好用的CAD图纸加密软件,帮助企业保护…...

智能电梯标志新时代:墨水屏电子标签引领变革

电梯安全墨水屏标签的智能设备悄然出现在各大写字楼和住宅区的电梯中,引发了广泛关注。这款设备替代了传统的纸质电梯标志,通过手机蓝牙标签APP直接进行编辑刷新内容,并具备Type-C接口充电功能。 本文将深入探讨这一创新技术的应用前景及其对…...

使用nvm下载nodejs版本报错

这里写自定义目录标题 使用nvm下载nodejs版本报错:Error retrieving "http://npm.taobao.org/mirrors/node/latest/SHASUMS256.txt": HTTP Status 404问题原因解决办法 使用nvm下载nodejs版本报错:Error retrieving “http://npm.taobao.org/m…...

深入理解CSS的:valid和:invalid伪类:增强表单验证的艺术

在现代网页设计中,用户输入验证是一个重要的环节,它不仅关乎用户体验,也是数据准确性和安全性的保障。CSS3引入了两个强大的伪类选择器::valid和:invalid,它们允许开发者通过CSS来增强表单输入的验证过程,而…...

稚晖君发布5款全能人形机器人,开源创新,全能应用

8月18日,智元机器人举行“智元远征 商用启航” 2024年度新品发布会,智元联合创始人彭志辉主持并发布了“远征”与“灵犀”两大系列共五款商用人形机器人新品——远征A2、远征A2-W、远征A2-Max、灵犀X1及灵犀X1-W,并展示了在机器人动力、感知、…...

【总结】冲击偶的概念与性质

冲击偶的概念与性质...

Hbase图形化界面

分享一个好用的hbase图形化界面 安装包:链接: https://pan.baidu.com/s/11Y2cDlme-P2xe--pYqy6MQ?pwdguag 提取码: guag 1、上传项目到linux 2、修改数据库配置信息 application-druid.yml 修改url、username、password为数据库连接信息 3、创建数据库(注意字符集…...

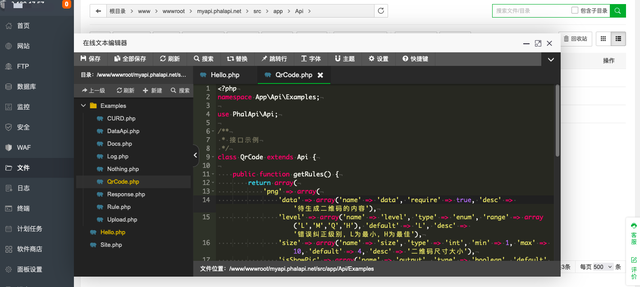

PhalApi:在宝塔一键安装部署PHP开源接口框架的教程

如何在宝塔上,一键安装部署PhalApi开源接口框架? 第一步,进入你的宝塔 - 软件商店。 第二步,切换到:一键部署; 第三步,搜索 phalapi; 第四步,点击 一键部署࿱…...

什么是BERT?工程快速入门

基本介绍 全称是Bidirectional Encoder Representations from Transformers。BERT翻译成中文通常被称为“双向编码器表征法”或简单地称为“双向变换器模型” Bidirectional:是双向神经网络,这个在学习 RNN 时候我们就了解到如何使用双向 RNN 让每一个…...

SQL - 事务

事务是代表单个工作单元的一组SQL语句,当我们需要对数据库进行多次更改的情况下,要使用事务,我们希望所有这些更改作为一个单元一起成功或失败事务属性 (ACID) 原子性(Atomicity):事务中的所有操作要么全部完成,要么全…...

系统, 安装完以后只能进ubuntu

1.问题 在已经安装了Windows10系统的情况下,用U盘安装Ubuntu 16.04双系统, 安装完以后只能进ubuntu,在grub系统选择界面,Windows10操作系统的选项都没有。 2.解决办法 进入ubuntu系统,打开终端输入: sudo update-g…...

闲鱼功能全解析:闲置物品快速变现

咸鱼(现已更名为闲鱼)作为一款闲置交易平台,其功能设计旨在提供一个方便、安全的环境,让用户能够轻松地买卖二手物品。以下是对咸鱼(闲鱼)功能的详细分析 1. 商品发布与管理 商品发布:用户可以…...

牛客网SQL进阶129 :月均完成试卷数不小于3的用户

月均完成试卷数不小于3的用户爱作答的类别_牛客题霸_牛客网 0 问题描述 基于试卷作答记录表exam_record、试卷信息表examination_info ,统计出 “月均完成试卷数”不小于3的用户作答的类别及作答次数,按次数降序输出。 1 数据准备 drop table if exis…...

Android Wi-Fi 连接失败日志分析

1. Android wifi 关键日志总结 (1) Wi-Fi 断开 (CTRL-EVENT-DISCONNECTED reason3) 日志相关部分: 06-05 10:48:40.987 943 943 I wpa_supplicant: wlan0: CTRL-EVENT-DISCONNECTED bssid44:9b:c1:57:a8:90 reason3 locally_generated1解析: CTR…...

springboot 百货中心供应链管理系统小程序

一、前言 随着我国经济迅速发展,人们对手机的需求越来越大,各种手机软件也都在被广泛应用,但是对于手机进行数据信息管理,对于手机的各种软件也是备受用户的喜爱,百货中心供应链管理系统被用户普遍使用,为方…...

)

Java 语言特性(面试系列1)

一、面向对象编程 1. 封装(Encapsulation) 定义:将数据(属性)和操作数据的方法绑定在一起,通过访问控制符(private、protected、public)隐藏内部实现细节。示例: public …...

渲染学进阶内容——模型

最近在写模组的时候发现渲染器里面离不开模型的定义,在渲染的第二篇文章中简单的讲解了一下关于模型部分的内容,其实不管是方块还是方块实体,都离不开模型的内容 🧱 一、CubeListBuilder 功能解析 CubeListBuilder 是 Minecraft Java 版模型系统的核心构建器,用于动态创…...

江苏艾立泰跨国资源接力:废料变黄金的绿色供应链革命

在华东塑料包装行业面临限塑令深度调整的背景下,江苏艾立泰以一场跨国资源接力的创新实践,重新定义了绿色供应链的边界。 跨国回收网络:废料变黄金的全球棋局 艾立泰在欧洲、东南亚建立再生塑料回收点,将海外废弃包装箱通过标准…...

从零开始打造 OpenSTLinux 6.6 Yocto 系统(基于STM32CubeMX)(九)

设备树移植 和uboot设备树修改的内容同步到kernel将设备树stm32mp157d-stm32mp157daa1-mx.dts复制到内核源码目录下 源码修改及编译 修改arch/arm/boot/dts/st/Makefile,新增设备树编译 stm32mp157f-ev1-m4-examples.dtb \stm32mp157d-stm32mp157daa1-mx.dtb修改…...

【git】把本地更改提交远程新分支feature_g

创建并切换新分支 git checkout -b feature_g 添加并提交更改 git add . git commit -m “实现图片上传功能” 推送到远程 git push -u origin feature_g...

【HTTP三个基础问题】

面试官您好!HTTP是超文本传输协议,是互联网上客户端和服务器之间传输超文本数据(比如文字、图片、音频、视频等)的核心协议,当前互联网应用最广泛的版本是HTTP1.1,它基于经典的C/S模型,也就是客…...

什么是Ansible Jinja2

理解 Ansible Jinja2 模板 Ansible 是一款功能强大的开源自动化工具,可让您无缝地管理和配置系统。Ansible 的一大亮点是它使用 Jinja2 模板,允许您根据变量数据动态生成文件、配置设置和脚本。本文将向您介绍 Ansible 中的 Jinja2 模板,并通…...

重启Eureka集群中的节点,对已经注册的服务有什么影响

先看答案,如果正确地操作,重启Eureka集群中的节点,对已经注册的服务影响非常小,甚至可以做到无感知。 但如果操作不当,可能会引发短暂的服务发现问题。 下面我们从Eureka的核心工作原理来详细分析这个问题。 Eureka的…...