Ceph 存储系统全解

1. 引言

什么是 Ceph?

Ceph 是一个开源的分布式存储系统,旨在提供高性能、可扩展、无单点故障的统一存储平台。它可以同时支持对象存储、块存储和文件系统存储,能够满足不同存储需求的多种应用场景。Ceph 通过其强大的 RADOS(可靠、自主分布式对象存储)基础架构,实现数据的智能分布和自我管理,确保数据的高可用性和冗余。

Ceph 的发展背景

Ceph 最早由 Sage Weil 在他博士研究期间提出,最初目标是创建一个自我修复、自动平衡的分布式存储系统。随着云计算、大数据等领域对存储需求的快速增长,Ceph 的特性逐渐被重视,开源后在 Linux 社区内获得了广泛的支持。随着 Ceph 的不断迭代和成熟,它已成为企业级存储解决方案的重要组成部分,尤其在 OpenStack、Kubernetes 等云平台中被广泛应用。

Ceph 的主要应用场景

Ceph 凭借其灵活的架构和高扩展性,能够适用于多种存储需求,主要应用场景包括:

- 云平台存储:Ceph 被广泛用于 OpenStack 和 Kubernetes 等云平台中,提供弹性块存储和对象存储服务。

- 大数据存储:Ceph 的高可扩展性使其适合大数据环境下的大规模数据存储和处理。

- 企业级存储:许多企业使用 Ceph 来管理海量数据,提供高可用性和数据冗余,避免单点故障。

- 备份与归档:Ceph 的对象存储模式非常适合用于数据备份和归档,具有强大的数据保护机制。

2. Ceph 的核心架构

Ceph 的设计理念

Ceph 的设计核心围绕着几个关键理念展开,以确保其具备高度的可靠性、扩展性和灵活性:

- 去中心化和无单点故障:Ceph 的设计避免了传统集中式存储的缺点,采用分布式架构,数据存储和管理分散在多个节点上,没有单点故障。即使某个节点故障,系统可以通过复制和冗余机制保持数据的可用性。

- 自我修复和自动管理:Ceph 具备强大的自我修复能力。当系统检测到数据不一致或节点失效时,它会自动触发数据恢复机制,确保数据的一致性和冗余,同时最小化管理员的干预需求。

- 可扩展性:Ceph 的架构可以根据需求轻松扩展,从几个节点扩展到数千个节点。无论是存储容量还是计算资源,Ceph 都能平滑扩展,不影响系统的性能和稳定性。

- 统一存储平台:Ceph 支持对象存储、块存储和文件系统存储三种模式,并能在同一存储集群中混合使用,简化了不同存储需求的管理。

分布式存储系统概述

Ceph 属于分布式存储系统,它将数据分散存储在多个节点上,而不是集中在一个单独的存储服务器中。这种方式带来了以下优势:

- 高可用性和数据冗余:通过将数据分布到多个节点,Ceph 可以确保即使某个节点出现故障,数据依然可以从其他节点恢复。Ceph 通过 CRUSH(Controlled Replication Under Scalable Hashing)算法实现智能数据分布,最大限度地减少数据丢失的风险。

- 并行处理能力:在分布式系统中,数据读取和写入可以同时由多个节点完成,显著提高了系统的吞吐量和性能。随着节点数量的增加,Ceph 的性能也可以线性扩展。

- 数据一致性和恢复:Ceph 采用强一致性模型,通过副本和快照机制,保证数据在系统中的一致性。此外,它具有强大的自我修复功能,当节点发生故障时,系统会自动恢复数据,保持数据完整性。

Ceph 的扩展性和无单点故障设计

Ceph 的扩展性和无单点故障设计是其核心竞争力,具体体现在以下几个方面:

- CRUSH 算法:CRUSH 是 Ceph 的核心数据分布算法,它不同于传统存储的集中索引方式。CRUSH 通过哈希算法决定数据存储的物理位置,使得数据可以均匀地分布在集群的各个节点上。随着集群规模的扩大,CRUSH 能够自动调整数据分布,确保每个节点负载均衡,避免数据过度集中。

- 无单点故障设计:Ceph 没有中心化的元数据管理节点,所有节点都可以彼此独立运作。在 Ceph 中,监控守护进程(MON)和对象存储守护进程(OSD)协同工作,监控集群状态、管理数据复制和一致性,避免了某个节点故障导致整个系统崩溃的情况。

- 线性扩展:Ceph 的存储节点可以按需添加,无需停机。通过添加更多的 OSD 和 MON,存储容量和性能可以线性增长。Ceph 的自我管理特性可以在扩展过程中自动调整数据分布和副本机制,确保整个集群始终处于最佳状态。

这种架构设计使得 Ceph 能够在大型分布式环境中稳定运行,支持从中小型企业到超大规模数据中心的存储需求。

3. Ceph 的核心组件

Ceph 的架构由多个关键组件构成,这些组件共同协作以确保系统的高可用性、数据一致性和性能优化。主要组件包括 OSD、MON 和 MDS,每个组件都有其特定的功能与职责。

OSD(对象存储守护进程)

OSD 的功能与工作原理

OSD(Object Storage Daemon)是 Ceph 中最基础的存储单元,负责数据的实际存储和管理。每个 OSD 守护进程对应一个存储磁盘或存储设备。它的主要职责包括:

- 存储数据:OSD 负责将数据块分割、存储到物理设备中,并通过 CRUSH 算法决定数据应存储在哪个 OSD 上。

- 数据副本管理:为了保证数据的高可用性,Ceph 会为每个数据块创建多个副本,OSD 会参与管理这些副本的存储、复制和恢复。

- 处理 I/O 请求:OSD 直接处理客户端的读写请求,负责数据的存取和校验操作。

- 心跳监测:OSD 守护进程之间会定期发送心跳信号,监测彼此的健康状态,确保数据的安全性和可用性。

数据复制与恢复机制

Ceph 通过 OSD 组件实现数据的高可用性和自我修复能力。Ceph 中的数据冗余和恢复机制包括以下几个步骤:

- 数据复制:当 Ceph 存储数据时,它会通过 CRUSH 算法将数据的多个副本存储在不同的 OSD 上。默认情况下,Ceph 创建 3 个数据副本,但这一数量可以根据需求配置。每个 OSD 会保存数据的一部分,并自动同步数据的副本。

- 数据恢复:当某个 OSD 故障或掉线时,Ceph 会自动触发数据恢复过程。系统会识别丢失的数据副本,并从其他健康的 OSD 中读取数据,将其复制到新的 OSD 中以重新生成丢失的副本。这一过程是自动化的,并且会尽量在后台进行,以减少对正常服务的影响。

MON(监控守护进程)

MON 的角色与集群状态管理

MON(Monitor)是 Ceph 中的监控守护进程,主要负责管理集群的全局状态和一致性。MON 是 Ceph 集群的“管理者”,在集群状态、配置和认证等方面扮演重要角色。其功能包括:

- 集群状态管理:MON 负责记录集群的整体状态,包括 OSD 的健康状况、数据分布、网络拓扑等。它持续监控每个 OSD 的状态(在线、离线、故障等),确保集群处于一致状态。

- 认证与安全管理:MON 还负责认证客户端和守护进程,确保访问和操作权限的安全性。所有 Ceph 集群成员需要通过 MON 的认证才能正常运作。

- 配置管理:MON 维护 Ceph 的全局配置,确保集群中的每个组件按照正确的配置工作。所有的配置更改都会由 MON 记录并传播到集群中的各个节点。

MON 通常是多节点部署,以防止单点故障。MON 节点之间采用 Paxos 协议来保证分布式一致性。

MDS(元数据服务器)

元数据管理与 Ceph 文件系统的运作

MDS(Metadata Server)是 Ceph 文件系统(CephFS)中特有的组件,专门用于管理文件系统的元数据。它在 Ceph 的分布式文件系统中扮演至关重要的角色,主要功能如下:

- 元数据管理:MDS 负责存储和管理文件系统的元数据,包括文件名、目录结构、权限等信息。CephFS 使用 MDS 来加速文件的定位和访问。

- 分布式文件系统管理:当客户端请求访问文件系统中的文件时,MDS 会提供文件的元数据和路径信息,指导客户端直接与 OSD 进行交互,以读取或写入文件内容。这种设计减少了 MDS 的负载,使数据传输更为高效。

- 扩展与负载均衡:为了应对大规模的文件系统需求,CephFS 可以部署多个 MDS。MDS 节点之间可以自动分配元数据管理任务,以均衡负载,提高文件系统的扩展性和性能。

4. Ceph 的存储模式

Ceph 是一个统一的存储平台,支持对象存储、块存储和文件系统三种存储模式。它们基于 Ceph 的 RADOS(Reliable Autonomic Distributed Object Store)核心协议实现,具备高可用性和强扩展性,能够满足多种存储需求。

对象存储模式(Ceph Object Storage)

RADOS 协议概述

RADOS(可靠自主分布式对象存储)是 Ceph 的底层存储系统,它作为 Ceph 存储的基础架构,支持所有三种存储模式。RADOS 管理着数据的分布、复制和恢复,确保数据的一致性和高可用性。

RADOS 的关键特性包括:

- 数据分布:通过 CRUSH 算法,RADOS 将数据对象分布在多个 OSD 中,确保负载均衡和数据安全。

- 无单点故障:RADOS 通过多副本数据管理和自我修复机制,避免单点故障。

- 高扩展性:RADOS 可以支持数千个节点,随着存储节点的增加,系统性能和容量可以线性扩展。

对象存储的优势和应用

Ceph 的对象存储模式可以用于存储非结构化数据,如图片、视频、备份文件等。对象存储的主要优势包括:

- 无限扩展性:对象存储能够存储海量数据,且数据对象可以无缝扩展。

- 自定义元数据:每个对象可以附带丰富的自定义元数据,方便数据管理和检索。

- 简单的接口:对象存储使用简单的 RESTful API,易于与应用集成,特别适合云存储平台。

应用场景:

- 大型数据备份与归档

- 内容分发网络(CDN)

- 云原生应用中的持久化存储

块存储模式(Ceph Block Storage)

RBD(RADOS Block Device)的工作原理

RBD(RADOS Block Device)是 Ceph 提供的块存储解决方案,它将分布式存储中的对象抽象为块设备,供虚拟机或应用程序使用。RBD 的工作原理如下:

- 逻辑卷创建:RBD 将分布式存储中的多个数据对象组合成一个逻辑卷,供虚拟机或应用程序挂载使用。

- 数据存取:当虚拟机或应用写入数据时,RBD 会将数据切分成对象并存储在 Ceph 的 OSD 中。数据读取时,RBD 从多个 OSD 中并行读取数据,提升 I/O 性能。

- 快照与克隆:RBD 支持数据快照和卷克隆功能,能够快速创建数据副本,方便备份、恢复或环境复制。

使用场景与性能优化

RBD 是虚拟化平台中常用的块存储解决方案,适用于以下场景:

- 虚拟机磁盘存储:RBD 是 OpenStack 等云平台中为虚拟机提供存储卷的理想选择。

- 高性能数据库:RBD 可以作为高 I/O 性能数据库的后端存储,支持快速扩展和高并发处理。

性能优化建议:

- 调整 I/O 队列深度:根据硬件性能和应用需求,合理调整 RBD 的 I/O 队列深度,以提高并发处理能力。

- 数据缓存:启用数据缓存,减少直接读写磁盘的操作,提升存储性能。

- 快照与克隆的合理使用:利用 RBD 的快照和克隆功能,实现高效的备份与灾难恢复。

文件系统模式(Ceph File System)

CephFS 架构

CephFS 是 Ceph 提供的分布式文件系统,具备高扩展性和 POSIX 兼容性。CephFS 的架构包括以下核心组件:

- MDS(元数据服务器):MDS 负责管理文件系统的元数据,如文件路径、权限等。通过将元数据管理与实际数据存储分离,CephFS 能够提高文件系统操作的并发性。

- OSD(对象存储守护进程):CephFS 通过 OSD 来存储文件的实际内容。文件被分割成对象并分布存储在多个 OSD 上,确保数据的安全性和高可用性。

文件存储的优势和适用场景

CephFS 提供了标准的 POSIX 文件系统接口,适用于需要文件级存储和高并发访问的场景。其优势包括:

- POSIX 兼容:CephFS 支持标准的文件系统操作,如读写、权限控制等,便于与现有应用集成。

- 高并发支持:通过多个 MDS 服务器分担元数据管理任务,CephFS 可以支持大量客户端的并发操作。

- 自动扩展:随着存储需求的增加,CephFS 可以动态增加 OSD 和 MDS,自动平衡负载,确保性能和容量的扩展。

应用场景:

- 大规模数据存储和共享平台

- 高性能计算(HPC)集群的文件系统

- 需要复杂文件操作的企业存储解决方案

5. Ceph 集群的部署与管理

Ceph 集群安装步骤

部署 Ceph 集群需要准备多个节点,并遵循以下主要步骤:

-

硬件准备:确保部署 Ceph 的服务器具备足够的计算和存储资源,通常需要准备以下节点类型:

- 监控节点(MON):负责监控集群状态。

- 存储节点(OSD):存储数据的节点。

- 元数据服务器(MDS)(如果使用 Ceph 文件系统)。

- 管理节点:安装管理工具进行部署和监控。

-

软件环境准备:

- 安装 Ceph 支持的 Linux 发行版,如 Ubuntu 或 CentOS。

- 更新系统,并确保所有节点可以通过 SSH 相互访问。

-

Ceph 安装工具:

- 使用

cephadm或ceph-deploy工具来简化集群部署。

- 使用

-

初始化 Ceph 集群:

- 安装

cephadm或ceph-deploy管理工具。 - 通过管理工具创建初始 MON 节点。

- 添加 OSD 节点以存储数据。

- 安装

-

配置 OSD 磁盘:

- 在 OSD 节点上配置磁盘,并将其加入 Ceph 集群。

-

监控和测试:

- 使用 Ceph 的管理命令监控集群状态,确保 MON、OSD 等组件的正常运行。

- 测试数据读写,验证存储的可靠性和性能。

常见部署架构(单节点与多节点集群)

-

单节点集群:

- 特点:在测试和开发环境中常见,所有 MON、OSD、MDS 等组件部署在同一节点上。

- 优点:便于快速测试和集群调试。

- 缺点:没有冗余,无法实现高可用性,不适用于生产环境。

-

多节点集群:

- 特点:在生产环境中,Ceph 通常部署为多节点架构,以实现高可用性和性能优化。通常包括:

- 多个 MON 节点:至少需要 3 个 MON 节点,以保证集群状态一致性。

- 多个 OSD 节点:存储数据的主力节点,数量越多,存储容量和吞吐量越大。

- MDS 节点(可选):如果使用 Ceph 文件系统(CephFS),则需要部署 MDS。

- 优点:高扩展性和高可用性,适合大规模生产环境。

- 缺点:部署相对复杂,硬件资源需求较高。

- 特点:在生产环境中,Ceph 通常部署为多节点架构,以实现高可用性和性能优化。通常包括:

Ceph 的数据一致性与高可用性保障

Ceph 通过一系列机制来确保数据的一致性和高可用性:

-

CRUSH 算法:Ceph 使用 CRUSH(Controlled Replication Under Scalable Hashing)算法,将数据分布在集群的 OSD 节点中。CRUSH 可以智能分配数据,确保负载均衡,同时减少单点故障的风险。

-

多副本数据冗余:默认情况下,Ceph 会为每个数据对象创建多个副本(通常为 3 个),分布在不同的 OSD 上。当某个 OSD 故障时,Ceph 会自动从其他 OSD 读取数据副本,确保数据的可用性和一致性。

-

Paxos 协议:Ceph 的 MON 节点通过 Paxos 分布式一致性算法管理集群状态。多个 MON 节点之间相互协作,确保在某个 MON 节点失效时,其他 MON 节点可以继续维护集群的一致性和可用性。

-

自我修复:当 Ceph 监测到 OSD 节点故障或网络中断时,会自动触发数据恢复机制,将丢失的数据副本重新分配到其他健康的 OSD 上,从而保证数据冗余和高可用性。

Ceph 管理工具概览(cephadm, ceph-deploy)

-

cephadm:

- 简介:

cephadm是 Ceph 最新推出的官方管理工具,使用容器化技术来简化 Ceph 的部署、管理和监控。 - 功能:

- 容器化部署 Ceph 集群。

- 支持滚动升级、动态扩展等功能。

- 提供监控和自动化运维功能,易于管理大规模集群。

- 优点:

- 容器化管理,简化了部署和运维工作。

- 支持集群自动化管理和扩展。

- 简介:

-

ceph-deploy:

- 简介:

ceph-deploy是 Ceph 较早期的部署工具,专为传统裸机集群设计,适用于简单部署场景。 - 功能:

- 快速安装 Ceph 集群。

- 手动管理 MON、OSD、MDS 等服务。

- 优点:

- 易于使用,适合小规模测试环境。

- 简单直观,适合对容器技术要求不高的部署场景。

- 缺点:

- 不支持容器化部署。

- 功能较为简单,较适用于小规模集群。

- 简介:

6. Ceph 的性能优化

在 Ceph 集群中,性能优化是确保系统高效运行和可靠存储的关键。通过合理的硬件选择、配置调优和优化数据复制与恢复机制,Ceph 可以满足高负载场景下的存储需求。以下是 Ceph 性能优化的几个重要方面:

硬件选择与配置优化

-

服务器硬件选择:

- CPU:选择多核、高主频的处理器,能够提升数据处理和存储请求的响应速度,特别是在高并发的情况下。

- 内存:Ceph 对内存要求较高,建议每个 OSD 节点至少配置 1GB 内存,以确保流畅的元数据操作和缓存管理。

- 存储设备:

- SSD 与 NVMe:用于存储 Ceph 的日志(journal)或数据库,能够显著提升 I/O 性能。NVMe SSD 提供比传统 HDD 更高的随机 I/O 性能,非常适合 OSD 读写密集的场景。

- HDD:用于存储数据对象的大容量磁盘,适合存储大量数据。虽然 HDD 的 IOPS 不如 SSD,但其容量更大,适用于数据归档和低频访问场景。

-

网络配置:

- 网络带宽:Ceph 对网络的依赖性较强,建议至少使用万兆网络以支持高并发和大量数据的传输。在大规模集群中,考虑使用双网卡或 RDMA(Remote Direct Memory Access)以减少网络延迟。

- 网络分离:将存储网络与管理网络分离。这样可以避免数据传输和管理操作相互干扰,提升网络吞吐量和稳定性。

OSD 性能调优技巧

-

操作系统和文件系统优化:

- 内核优化:在 Linux 操作系统上,使用适合 Ceph 的高版本内核,可以更好地支持 Ceph 的高并发和高负载场景。同时,启用

noatime和nodiratime选项以减少文件系统的元数据更新负担。 - 文件系统选择:Ceph 通常使用 XFS 或 BlueStore 作为 OSD 的文件系统。BlueStore 是 Ceph 原生的存储引擎,优化了 I/O 性能,相较于传统的 XFS,提供了更好的性能表现。若使用 XFS,建议开启

inode64选项以支持大规模文件存储。

- 内核优化:在 Linux 操作系统上,使用适合 Ceph 的高版本内核,可以更好地支持 Ceph 的高并发和高负载场景。同时,启用

-

OSD 调优技巧:

- OSD 进程数量:在 SSD 上运行 OSD 时,可以使用多线程优化 OSD 处理能力。针对每个 OSD 进程,适当地增加 CPU 核心绑定数,可以提升并发性能。

- OSD 的 journal 存储优化:将 OSD 的日志(journal 或 WAL)存储在高速的 SSD 或 NVMe 上,可以显著提高 Ceph 的 I/O 性能,特别是在写操作较为频繁的场景下。

-

缓存与队列调整:

- 写缓存:开启 OSD 的写缓存功能,可以提升写入性能,但需要确保有良好的电源保护(如 UPS),防止电源故障导致数据丢失。

- I/O 队列深度调整:调整 OSD 的 I/O 队列深度,根据硬件配置和负载情况调整适当的深度,以提高并发读写能力。

数据复制与恢复的性能优化策略

-

数据复制策略优化:

- 副本数调整:Ceph 默认使用 3 副本存储数据,但可以根据业务需求和硬件资源适当调整副本数量。例如,对于高性能场景,可以减少副本数以提高写入速度。对于高可用性要求高的场景,副本数可以设置为 3 或更多。

- 使用 EC(Erasure Coding):EC 是一种数据冗余策略,通过将数据切分成数据块和校验块的方式存储,相比于 3 副本模式,EC 能够节省大量存储空间,同时提供数据冗余,但会带来一些计算开销。适用于写入频率低、数据量大的场景。

-

数据恢复优化:

- 优先恢复设置:当 OSD 节点发生故障时,Ceph 会自动触发数据恢复。可以通过调整

osd_recovery_max_active和osd_max_backfills等参数来控制恢复时的并发任务数量,从而加快数据恢复速度。 - 带宽限制:在数据恢复过程中,恢复流量可能会影响到正常的数据读写操作。通过配置

osd_recovery_max_bytes和osd_recovery_sleep_hdd等参数,可以限制恢复带宽,减少对正常业务的影响。 - 延迟恢复机制:Ceph 允许配置延迟恢复机制,设置在系统负载较低时再执行数据恢复任务,以减少数据恢复对高峰期业务的干扰。

- 优先恢复设置:当 OSD 节点发生故障时,Ceph 会自动触发数据恢复。可以通过调整

-

负载均衡与自动再平衡:

- CRUSH 映射优化:通过合理调整 CRUSH 映射规则,使数据均匀分布在不同 OSD 上,避免 OSD 之间的负载不均衡。尤其在添加新的 OSD 或移除 OSD 时,Ceph 能够自动触发数据再平衡操作,确保集群的性能和稳定性。

7. Ceph 与容器及云平台的集成

随着容器化技术和云平台的广泛应用,Ceph 作为一个高可扩展性的分布式存储系统,已经成为 Kubernetes 和 OpenStack 等云原生平台的重要存储后端。Ceph 提供的对象存储、块存储和文件系统,可以轻松为容器和虚拟化平台提供持久化存储支持。

Ceph 与 Kubernetes 的集成

Kubernetes 是容器编排系统,应用于大规模的容器化工作负载环境中。为了提供持久化存储,Kubernetes 需要与外部存储系统集成,Ceph 是其中一个理想的选择。

使用 Ceph 提供持久化存储

-

RBD(RADOS Block Device)作为持久卷(Persistent Volume):

- Ceph 的块存储(RBD)可以直接作为 Kubernetes 的 Persistent Volume (PV) 进行使用。

- 管理员可以通过配置 StorageClass 来动态分配 Ceph RBD 卷,实现自动化的存储管理。

- 配置步骤:

- 部署 Ceph CSI(Container Storage Interface)插件:Ceph CSI 是与 Kubernetes 集成的关键组件,支持块存储和文件存储的持久化。

- 创建 StorageClass,定义 Ceph RBD 作为存储类型。

- 创建 Persistent Volume Claim(PVC),用户通过 PVC 来申请存储资源,并与 Pods 关联。

优势:

- 自动化管理:通过 Ceph CSI,Kubernetes 可以自动创建、扩展和删除 Ceph RBD 卷。

- 高性能:RBD 提供了高性能的块存储,适合需要低延迟、高吞吐量的工作负载,如数据库等。

-

CephFS 作为持久卷:

- Ceph 文件系统(CephFS)可以作为 Kubernetes 的持久卷,提供共享存储的能力。

- 使用 Ceph CSI 插件,管理员可以配置 CephFS 作为 StorageClass。

- 通过 PVC,多个 Pod 可以同时访问同一个 CephFS 卷,适合需要文件级共享的应用,如日志服务或大数据处理。

优势:

- 共享存储:多个容器可以同时访问同一个文件系统卷。

- POSIX 兼容性:CephFS 支持标准的文件系统操作,方便集成现有的文件存储应用。

-

Ceph 对象存储(S3 兼容)集成:

- Kubernetes 应用程序可以使用 Ceph 的对象存储(通过 RADOS Gateway 提供 S3 兼容接口)来存储非结构化数据。

- Kubernetes 内的应用可以直接通过 S3 API 访问 Ceph 对象存储,非常适合存储图片、视频等大文件。

应用场景:

- 数据备份与归档

- 静态文件存储

- 日志和监控数据存储

Ceph 在 OpenStack 中的应用

OpenStack 是一个开源的云计算平台,常用于构建私有云和公有云环境。Ceph 与 OpenStack 紧密集成,为 OpenStack 提供高效、可靠的存储解决方案,特别是块存储和对象存储。

Ceph 与 Cinder 和 Glance 的协同工作

-

Ceph 与 Cinder 的集成(块存储):

- Cinder 是 OpenStack 的块存储服务,提供持久化存储卷给虚拟机(VM)。Ceph 的 RBD 可以直接作为 Cinder 的后端存储。

- 当用户创建新的存储卷时,Cinder 会使用 Ceph 的 RBD 在 Ceph 集群中创建块设备,并将其挂载到虚拟机上。

- 快照和克隆:Ceph RBD 支持快速创建卷的快照和克隆,方便用户进行数据备份、恢复和环境复制。

优势:

- 高可用性与冗余:通过 Ceph 的多副本机制,数据存储在多个 OSD 上,保证数据的安全性。

- 横向扩展:Ceph 可以根据需求动态扩展存储容量,适应不断增长的数据量。

- 性能优化:Ceph RBD 可以通过 SSD 和 HDD 的组合实现性能和成本的平衡。

-

Ceph 与 Glance 的集成(镜像存储):

- Glance 是 OpenStack 的镜像服务,用于存储和管理虚拟机的操作系统镜像。Ceph 的 RBD 可以作为 Glance 的后端存储。

- 当用户启动虚拟机时,Glance 会将操作系统镜像从 Ceph 中读取并分发给虚拟机。

- Ceph 的对象存储(通过 RADOS Gateway)也可以用于 Glance 镜像存储,特别适合大规模的镜像存储和分发。

优势:

- 快速启动虚拟机:Ceph RBD 支持镜像的直接挂载和克隆,可以加速虚拟机的启动过程。

- 集中管理与扩展:通过 Ceph,所有的镜像都集中存储,易于管理,并且可以根据需求动态扩展存储容量。

-

Ceph 与 Swift 的集成(对象存储):

- Ceph 的对象存储通过 RADOS Gateway 提供与 OpenStack Swift 兼容的 API,作为对象存储后端,适合存储大规模非结构化数据,如备份、归档和大文件。

- 使用 Ceph 作为 Swift 的后端,用户可以继续使用 Swift 的 API 来进行对象存储操作,而在底层,数据则通过 Ceph 进行管理和存储。

应用场景:

- 数据备份与恢复

- 日志、监控文件的存储

- 视频、图片等非结构化数据存储

8. Ceph 的数据保护与备份

在分布式存储系统中,数据的保护与备份是关键问题,确保数据的高可用性和安全性是 Ceph 设计的重要目标之一。Ceph 提供了一系列机制来保证数据的可靠性,包括数据冗余、复制策略以及快照与备份功能。

数据冗余与复制策略

Ceph 通过冗余与复制机制,确保数据即使在硬件故障、网络中断等意外情况下,也能够安全可用。

-

数据冗余:

- 副本机制:Ceph 默认采用多副本机制,即每个数据对象会有多个副本(通常是 3 个副本),这些副本分布在不同的 OSD 节点上,确保即使一个 OSD 节点出现故障,其他副本仍然可以正常访问。

- 副本数设置:管理员可以根据存储需求设置副本数,增加副本数可以提升数据的冗余性和容错能力,但同时也会占用更多的存储空间。

-

复制策略:

- CRUSH 算法:Ceph 使用 CRUSH(Controlled Replication Under Scalable Hashing)算法将数据智能地分布在集群中的多个 OSD 上,确保数据分布均匀,避免负载过重的单点节点。

- 多区域复制:Ceph 支持跨数据中心或地理位置的多区域复制,可以将数据副本分布在不同的物理位置,增强灾难恢复能力。在某一地区或数据中心发生重大故障时,其他地区的数据副本仍然可以正常使用。

- Erasure Coding(EC):对于需要节省存储空间的场景,Ceph 支持 Erasure Coding(纠删码)作为替代副本机制的一种冗余方式。EC 通过将数据分割成多个数据块和校验块来存储,比多副本机制更节省存储空间,但会带来额外的计算开销,适用于冷数据或备份场景。

优势:

- 副本机制提供了高可用性和容错能力。

- 通过 CRUSH 算法,数据分布均匀,避免单点故障。

- 支持跨区域复制,提升灾难恢复能力。

快照与备份机制

Ceph 的快照与备份功能为数据提供了更高层次的保护,支持细粒度的数据保护和恢复操作。

-

快照机制:

- RBD 快照:Ceph 支持 RADOS Block Device(RBD)卷的快照功能。快照是块设备在某一时间点的只读副本,快照创建快速、不会影响性能,可以用于数据备份、恢复和环境复制。

- 增量快照:Ceph 的快照是增量的,意味着创建新的快照只记录自上次快照以来的数据更改,这减少了存储空间的使用和快照管理的开销。

- 写时复制(Copy-on-Write):当数据发生写入操作时,Ceph 通过写时复制技术将原始数据保留在快照中,同时允许新数据写入,确保快照的完整性。

- CephFS 快照:Ceph 文件系统(CephFS)也支持文件级别的快照,用户可以为文件系统创建快照,方便对文件系统的历史状态进行回溯。

- RBD 快照:Ceph 支持 RADOS Block Device(RBD)卷的快照功能。快照是块设备在某一时间点的只读副本,快照创建快速、不会影响性能,可以用于数据备份、恢复和环境复制。

-

备份机制:

- 备份到远程 Ceph 集群:Ceph 支持将快照数据复制到另一个远程 Ceph 集群,以确保即使在整个集群出现灾难性故障时,数据依然可以在另一个集群中恢复。这种跨集群备份机制适用于灾难恢复场景。

- 对象存储备份:Ceph 的对象存储模式可以通过 S3 兼容接口,将数据备份到 Ceph 的对象存储集群中。对象存储模式适用于备份大量非结构化数据,如图片、视频和日志文件。

- 第三方备份工具集成:Ceph 可以与多种备份和恢复工具集成,如 Bacula、Restic 等,实现自动化的备份和恢复流程。这些工具通过 Ceph 的 API 与 Ceph 集成,实现数据的自动定期备份和灾难恢复。

-

快照恢复:

- 快照是 Ceph 数据保护的重要组成部分,当数据发生意外删除或错误修改时,可以通过快照快速恢复到之前的状态。恢复过程是高效的,因为 Ceph 使用增量快照和写时复制技术,减少了恢复过程中对资源的消耗。

- 对于 RBD 卷,可以通过

rbd snap rollback命令将卷恢复到快照时间点。CephFS 的快照也可以通过管理命令恢复文件系统到指定状态。

优势:

- 快照提供了细粒度的恢复能力,适合灾难恢复和数据保护。

- 快照是增量的,减少了存储空间占用。

- 支持与第三方备份工具的集成,方便实现自动化备份。

9. Ceph 的未来发展与前景

Ceph 作为一个开源的分布式存储系统,凭借其可扩展性、高性能和灵活性,已经成为云计算、大数据和企业存储的重要组成部分。随着云原生架构、人工智能、以及大数据处理技术的快速发展,Ceph 的社区活跃度和技术发展也在不断加速。展望未来,Ceph 将继续保持强劲的创新势头,并针对新兴技术趋势进行优化和拓展。

Ceph 社区的活跃度与未来发展趋势

-

社区活跃度:

- Ceph 的开源社区一直非常活跃,由 Red Hat 及其他贡献者主导,定期发布新版本,修复 bug 并引入新功能。社区成员包括云服务提供商、大型企业和个人开发者,形成了一个全球性的技术支持与合作网络。

- Ceph 的定期发布周期(大约每 9-12 个月)保证了系统的持续发展,并且每个版本都会带来新的特性、性能改进以及安全增强。社区中活跃的讨论和贡献,确保了 Ceph 的持久生命力和市场适应性。

-

未来发展趋势:

- 云原生与 Kubernetes 深度集成:随着 Kubernetes 成为主流的容器编排平台,Ceph 社区正进一步优化 Ceph 与 Kubernetes 的集成。Ceph CSI(Container Storage Interface)插件的持续改进,以及对动态存储卷创建、更强的持久化支持的需求,推动 Ceph 成为云原生环境中的核心存储解决方案。

- 高性能和低延迟优化:Ceph 社区一直致力于提升 Ceph 的 I/O 性能,特别是在 NVMe 和 RDMA(Remote Direct Memory Access)等新兴硬件的支持上。随着 SSD、NVMe 逐渐成为企业存储的主流,Ceph 正优化其存储引擎(如 BlueStore)以支持更高的吞吐量和更低的延迟。

- 边缘计算与分布式架构:边缘计算的兴起对 Ceph 的分布式架构提出了新的挑战。未来,Ceph 将进一步优化跨地域、跨数据中心的数据复制与一致性,支持边缘存储节点的部署,实现更低的延迟和更灵活的数据处理能力。

- 容错与自我修复的增强:随着存储系统规模的不断扩大,数据保护和自我修复能力将变得更加重要。Ceph 的未来版本将进一步增强其自我修复功能,提升系统容错能力,使得即使在极端故障场景下也能确保数据完整性。

新版本功能预览

Ceph 社区持续推动新功能和优化改进,每个新版本都会引入一系列增强功能。以下是一些 Ceph 未来版本中的关键功能预览:

-

Ceph Pacific 和 Quincy(最新稳定版):

- 性能改进:未来的 Ceph 版本将会在存储引擎(特别是 BlueStore)上进一步优化,减少写入延迟,提升 I/O 吞吐量,特别是对 SSD 和 NVMe 的支持将更加完善。Ceph 的 RDMA 支持也将进一步增强,以加速数据传输。

- RADOS Gateway(对象存储)的增强:Ceph 正在对 RADOS Gateway(RGW)进行改进,以提升其在大规模对象存储场景下的性能和稳定性。此外,Ceph 将加强对 S3 API 的兼容性,使其能够更好地与现有的云原生对象存储服务(如 AWS S3)集成。

- 多租户支持与隔离:未来的版本将进一步优化多租户存储的安全性和资源隔离,提升企业级应用中的数据安全和合规性,特别是在金融、医疗等行业的应用场景中。

- CephFS 的改进:Ceph 文件系统(CephFS)将在未来的版本中增加对高可用性的进一步支持,包括对多 MDS(元数据服务器)配置的改进,提升文件系统在大规模并发访问场景下的性能和扩展能力。

-

更好的监控与管理工具:

- Ceph Dashboard 增强:Ceph Dashboard 是 Ceph 的图形化管理工具,未来版本将增加更多的可视化功能,包括对集群状态、性能指标、告警的实时监控和分析,帮助管理员更好地管理大规模存储集群。

- 集群自动化与自愈能力:Ceph 将增强自动化管理工具(如 cephadm),支持更复杂的集群自动化部署和运维,包括滚动升级、节点自动恢复等。集群的自愈能力也将进一步提升,减少管理员的手动干预,确保系统的高可用性。

-

支持新型存储架构与技术:

- 混合存储支持:Ceph 未来可能支持更多混合存储架构,包括分层存储和存储分级(如冷热数据分离)。这将使得 Ceph 能够更高效地管理 SSD、HDD、甚至是新的存储介质(如持久内存)的资源分配。

- Erasure Coding 改进:未来的版本将进一步优化 Erasure Coding 的性能,特别是在写密集型和大规模集群中。通过减少计算开销和提升数据恢复速度,Erasure Coding 将成为大规模存储集群中的常用选择。

-

边缘计算与物联网支持:

- Ceph 社区正在探索如何在边缘计算环境中部署 Ceph 以满足边缘设备的数据存储需求。未来的 Ceph 版本可能会增加对轻量级 Ceph 集群的支持,适合资源有限的边缘节点,并优化跨边缘节点的数据同步与一致性保障。

10. 总结

Ceph 在现代存储系统中的地位

Ceph 已经成为现代存储系统中的核心技术之一,凭借其高度可扩展、分布式架构和开源特性,广泛应用于企业数据中心、云计算平台、容器化环境等。Ceph 的统一存储平台提供了对象存储、块存储和文件系统存储,能够满足多种存储需求,特别是在需要弹性、高可用性和大规模存储的场景下表现出色。

Ceph 的 无单点故障 和 强一致性 设计使其在处理大规模数据时具有显著优势,尤其在现代云原生架构和边缘计算中,Ceph 的灵活性和可扩展性为企业提供了极大的便利。无论是跨数据中心的数据同步、多区域数据备份,还是高性能块存储和文件共享,Ceph 都能胜任。

适用 Ceph 的场景与建议

-

云平台与容器环境:

- 适用场景:Ceph 在 OpenStack 和 Kubernetes 等云平台中的集成表现优异,适用于需要大规模分布式存储和持久化存储的场景。它提供了可扩展的存储解决方案,适用于虚拟机磁盘存储(Cinder)、对象存储(Swift 和 S3)以及容器持久卷(Persistent Volume)。

- 建议:在使用 Ceph 提供块存储或文件系统时,确保硬件资源(如网络带宽、SSD 存储设备)足够,以保证高性能的存储体验。通过 Ceph CSI 插件进行 Kubernetes 集成,是云原生环境中的最佳实践之一。

-

大数据与分析平台:

- 适用场景:对于需要存储和处理海量数据的大数据分析平台,Ceph 的对象存储和 Erasure Coding 机制可以有效地节省存储空间,确保数据的冗余性和安全性。

- 建议:在大数据环境下,使用 Ceph 的对象存储模式,并配置适当的副本数或使用 Erasure Coding,以在性能与存储成本之间取得平衡。

-

高性能计算(HPC)与科学研究:

- 适用场景:Ceph 的文件系统(CephFS)适用于需要高并发访问和大规模数据共享的高性能计算(HPC)和科研平台。CephFS 的 POSIX 兼容性允许研究人员方便地进行数据读写,并且通过多个 MDS 提供高扩展性。

- 建议:对于高并发环境,建议部署多个 MDS 以均衡元数据请求负载,并选择 SSD/NVMe 存储设备以提高 I/O 性能。

-

企业级存储与备份:

- 适用场景:企业可以使用 Ceph 作为统一的存储平台,整合多种存储需求(块存储、文件存储、对象存储)。它特别适合用于数据备份、恢复和灾难恢复,确保业务持续性。

- 建议:利用 Ceph 的快照与远程备份功能,定期备份关键数据。同时,可以使用 Ceph 的多区域复制功能,将数据备份到多个数据中心,增强灾难恢复能力。

-

边缘计算与物联网:

- 适用场景:Ceph 可以部署在边缘节点,用于处理物联网设备产生的大量数据。Ceph 的分布式架构和跨区域复制能力非常适合需要分散存储的边缘计算场景。

- 建议:针对边缘计算场景,建议使用轻量化 Ceph 部署,并合理设置数据同步策略,确保边缘节点之间的数据一致性与安全性。

相关文章:

Ceph 存储系统全解

1. 引言 什么是 Ceph? Ceph 是一个开源的分布式存储系统,旨在提供高性能、可扩展、无单点故障的统一存储平台。它可以同时支持对象存储、块存储和文件系统存储,能够满足不同存储需求的多种应用场景。Ceph 通过其强大的 RADOS(可…...

C# ftp帮助类 项目实战优化版

上位机开发中有时要与客户的文件服务器进行数据交互。如Mapping文件下载。结果文件上传等。我在项目中就常用到。现在把项目实战代码进行分享一下。 功能列表:连接服务器,下载文件,上传文件,删除服务器文件,获取当前目…...

栈和队列相关|有效的括号|用队列实现栈|用栈实现队列|设计循环队列(C)

20. 有效的括号 判断左右括号是否匹配,匹配返回true,不匹配返回false 通过栈来实现,类型和顺序,数量都要匹配 控制数量通过size 每个右括号都要找最近的左括号去判断类型匹配不匹配,顺序匹配不匹配 最后来判断数量匹配…...

云原生后端开发教程

云原生后端开发教程 引言 随着云计算的普及,云原生架构逐渐成为现代软件开发的主流。云原生不仅仅是将应用部署到云上,而是一种构建和运行应用的方式,充分利用云计算的弹性和灵活性。本文将深入探讨云原生后端开发的核心概念、工具和实践&a…...

TortoiseSVN小乌龟下载安装(Windows11)

目录 TortoiseSVN 1.14.7工具下载安装 TortoiseSVN 1.14.7 工具 系统:Windows 11 下载 官网:https://tortoisesvn.subversion.org.cn/downloads.html如图选 TortoiseSVN 1.14.7 - 64 位 下载完成 安装 打开 next,next Browse…...

Android adb命令获取设备id

Android adb命令获取设备id 方式很多,以下均可获得Android device id: adb shell settings get secure android_id adb shell settings get secure android_id adb devices -l adb shell content query --uri content://settings/secure --where "…...

Skywalking教程一

Skywalking教程一 概述Skywalking功能特点: 概述 一个大型分布式系统架构,监控平台是必不可少的,常用的分布式系统监控平台有:SkyWalking和Prometheus。Skywalking是一款比较优秀的分布式系统监控平台,一款分布式系统…...

React中管理state的方式

使用useState 使用useReducer 既然已经有了useState,为什么还需要useReducer呢? 那么useReducer是如何将解决这些问题的呢? reducer是如何更新state的呢? reducer的工作方式非常类似JavaScript中的reduce方法,随着时…...

服务器数据恢复—RAID5阵列中部分成员盘重组RAID5阵列后如何恢复原raid5阵列数据?

服务器数据恢复环境: 一台服务器挂接一台存储,该存储中有一组由5块硬盘组建的RAID5阵列。 服务器故障: 存储raid5阵列中有一块硬盘掉线。由于RAID5的特性,阵列并没有出现问题。工作一段时间后,服务器出现故障ÿ…...

【Linux】文件切割排序 cut sort

文章目录 Linux文件切割命令:cut1. cut命令的基本用法2. cut命令的选项和参数3. cut命令的实际应用案例 Linux文件排序命令:sort1. sort命令的基本用法2. sort命令的选项和参数3. sort命令的实际应用案例 常见问题和解决方案1. cut和sort命令的联合使用2…...

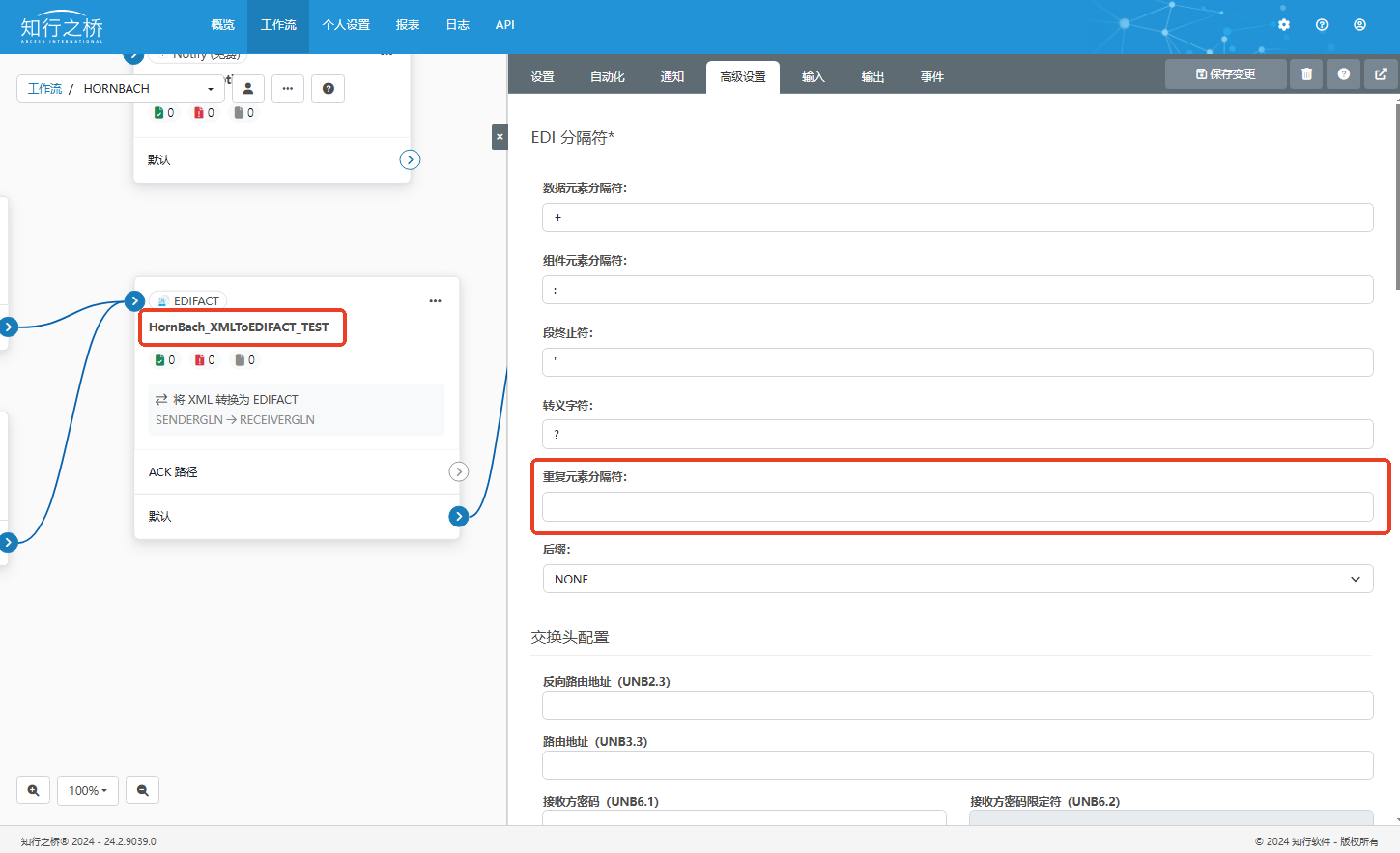

零售EDI:HornBach EDI 项目案例

HornBach 是一家总部位于德国的家居和建筑材料零售商,成立于1968年。它以大型仓储式商店而闻名,提供广泛的产品,包括建筑材料、园艺、家居装饰和工具等。 近期我们帮助HornBach的供应商W公司成功实现了与HornBach的EDI直连,除了满…...

SpringBoot 集成RabbitMQ 实现钉钉日报定时发送功能

文章目录 一、RabbitMq 下载安装二、开发步骤:1.MAVEN 配置2. RabbitMqConfig 配置3. RabbitMqUtil 工具类4. DailyDelaySendConsumer 消费者监听5. 测试延迟发送 一、RabbitMq 下载安装 官网:https://www.rabbitmq.com/docs 二、开发步骤:…...

基于java ssm springboot女士电商平台系统源码+文档设计

基于java ssm springboot女士电商平台系统源码文档设计 🍅 作者主页 网顺技术团队 🍅 欢迎点赞 👍 收藏 ⭐留言 📝 🍅 文末获取源码联系方式 📝 🍅 查看下方微信号获取联系方式 承接各种定制系统…...

Matlab数字信号处理——基于改进小波变换的图像去噪方法(7种去噪算法)

1.基于小波变换的阈值收缩法去噪 该方法利用小波变换分离出信号中的噪声成分,并通过设置合适的阈值对小波系数进行收缩,保留主要信息的同时,去除噪声。 %基于小波变换的阈值收缩法去噪算法 clear clc Iimread(nana.png); X im2double(I); …...

leetcode hot100【LeetCode 70. 爬楼梯】java实现

LeetCode 70. 爬楼梯 题目描述 假设你正在爬楼梯。需要 n 阶你才能到达楼顶。 每次你可以爬 1 或 2 个台阶。你有多少种不同的方法可以爬到楼顶呢? 注意: 给定 n 是一个正整数。 示例 1: 输入:n 2 输出:2 解释&…...

Java异常2

异常抛出的两种形式: 系统隐式抛出;int n10/0;—隐式抛出一个异常;手动抛出异常:throw new Exception(); import java.util.InputMismatchException; import java.util.Scanner;public class Main {public static void main(Str…...

2024熵密杯初始题2

问题简要: 已知 counter 0x7501E6EA token 0xF4CE927C79B616E8E8F7223828794EEDF9B16591AE572172572D51E135E0D21A 伪造出另一个可以通过验证的counter和token。 给出token生成及验证代码如下: import binascii from gmssl import sm3# 读取HMAC ke…...

echarts属性之title

title 标题组件,包含主标题和副标题。 在 ECharts 2.x 中单个 ECharts 实例最多只能拥有一个标题组件。但是在 ECharts 3 中可以存在任意多个标题组件,这在需要标题进行排版,或者单个实例中的多个图表都需要标题时会比较有用。 例如下面不…...

VUE errolog, vue 错误集

I) installation As to command “npm install” on cmd or powershell, we must execute it under the program folder...

驱动开发系列13 - Linux tasklet用法介绍

一:概述 Tasklet 是 Linux 内核中的一种轻量级任务调度机制,通常用于在中断上下文中执行短小的任务。它们在软中断处理过程中被调用,允许将较长的处理工作延后到一个较低优先级的上下文中,以减少中断处理的延迟。Tasklet 的使用可以帮助开发者更好地管理系统资源,提高性能…...

golang循环变量捕获问题

在 Go 语言中,当在循环中启动协程(goroutine)时,如果在协程闭包中直接引用循环变量,可能会遇到一个常见的陷阱 - 循环变量捕获问题。让我详细解释一下: 问题背景 看这个代码片段: fo…...

FFmpeg 低延迟同屏方案

引言 在实时互动需求激增的当下,无论是在线教育中的师生同屏演示、远程办公的屏幕共享协作,还是游戏直播的画面实时传输,低延迟同屏已成为保障用户体验的核心指标。FFmpeg 作为一款功能强大的多媒体框架,凭借其灵活的编解码、数据…...

五年级数学知识边界总结思考-下册

目录 一、背景二、过程1.观察物体小学五年级下册“观察物体”知识点详解:由来、作用与意义**一、知识点核心内容****二、知识点的由来:从生活实践到数学抽象****三、知识的作用:解决实际问题的工具****四、学习的意义:培养核心素养…...

剑指offer20_链表中环的入口节点

链表中环的入口节点 给定一个链表,若其中包含环,则输出环的入口节点。 若其中不包含环,则输出null。 数据范围 节点 val 值取值范围 [ 1 , 1000 ] [1,1000] [1,1000]。 节点 val 值各不相同。 链表长度 [ 0 , 500 ] [0,500] [0,500]。 …...

基础测试工具使用经验

背景 vtune,perf, nsight system等基础测试工具,都是用过的,但是没有记录,都逐渐忘了。所以写这篇博客总结记录一下,只要以后发现新的用法,就记得来编辑补充一下 perf 比较基础的用法: 先改这…...

Qt Http Server模块功能及架构

Qt Http Server 是 Qt 6.0 中引入的一个新模块,它提供了一个轻量级的 HTTP 服务器实现,主要用于构建基于 HTTP 的应用程序和服务。 功能介绍: 主要功能 HTTP服务器功能: 支持 HTTP/1.1 协议 简单的请求/响应处理模型 支持 GET…...

dify打造数据可视化图表

一、概述 在日常工作和学习中,我们经常需要和数据打交道。无论是分析报告、项目展示,还是简单的数据洞察,一个清晰直观的图表,往往能胜过千言万语。 一款能让数据可视化变得超级简单的 MCP Server,由蚂蚁集团 AntV 团队…...

基于matlab策略迭代和值迭代法的动态规划

经典的基于策略迭代和值迭代法的动态规划matlab代码,实现机器人的最优运输 Dynamic-Programming-master/Environment.pdf , 104724 Dynamic-Programming-master/README.md , 506 Dynamic-Programming-master/generalizedPolicyIteration.m , 1970 Dynamic-Programm…...

计算机基础知识解析:从应用到架构的全面拆解

目录 前言 1、 计算机的应用领域:无处不在的数字助手 2、 计算机的进化史:从算盘到量子计算 3、计算机的分类:不止 “台式机和笔记本” 4、计算机的组件:硬件与软件的协同 4.1 硬件:五大核心部件 4.2 软件&#…...

Chromium 136 编译指南 Windows篇:depot_tools 配置与源码获取(二)

引言 工欲善其事,必先利其器。在完成了 Visual Studio 2022 和 Windows SDK 的安装后,我们即将接触到 Chromium 开发生态中最核心的工具——depot_tools。这个由 Google 精心打造的工具集,就像是连接开发者与 Chromium 庞大代码库的智能桥梁…...