机器学习(1)

一、机器学习

机器学习(Machine Learning, ML)是人工智能(Artificial Intelligence, AI)的一个分支,它致力于开发能够从数据中学习并改进性能的算法和模型。机器学习的核心思想是通过数据和经验自动优化算法,而不是通过显式的编程规则。

1.1、机器学习的基本概念

-

数据:机器学习的基础是数据。数据可以是结构化的(如数据库中的表格数据)或非结构化的(如文本、图像、音频等)。

-

模型:模型是机器学习算法的核心,它是一个数学表示,用于从输入数据中学习并做出预测或决策。

-

学习:学习是指模型通过数据进行训练,调整其内部参数以最小化预测误差的过程。

-

特征:特征是数据中的变量或属性,模型使用这些特征来进行预测或分类。

-

标签:标签是数据中的目标变量,模型通过学习特征和标签之间的关系来进行预测。

1.2、机器学习的分类

- 监督学习

- 半监督学习

- 无监督学习

- 强化学习

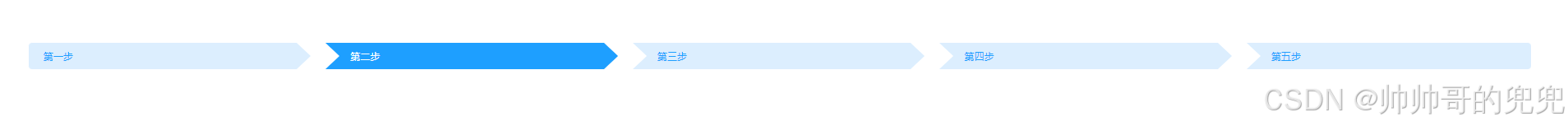

二、机器学习步骤

- 收集数据:数据是机器学习的基础。

- 准备数据:高质量的数据才能提高模型精准度。

- 训练模型:对处理后的数据进行训练,并留存部分数据用作验证。

- 评估模型:对模型进行验证,确定模型的精准度。

- 提高性能:对代码和模型进行优化。

2.1、前期准备——scikit-learn的安装

执行下面的代码

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple scikit-learn

或

pip install scikit-learn

2.2、数据集

2.2.1、数据集的分类

- 玩具数据集:轻量的数据集,直接在sklearn库本地,无需下载

示例:

from sklearn.datasets import load_iris # type: ignoreiris = load_iris() # type: ignore

print(iris.data)

- 现实数据集:数据量大,需要从网络上下载

from sklearn.datasets import fetch_20newsgroups #这是一个20分类的数据news = fetch_20newsgroups(data_home=None,subset='all')

print(len(news.data))

2.2.2、数据集的操作

# data 特征

# feature_names 特征描述

# target 目标

# target_names 目标描述

# DESCR 数据集的描述

# filename 下后到本地保存后的文件名

2.2.3、读取本地文件

本地csv文件

import pandas as pd # type: ignoredata = pd.read_csv('../dataset/ss.csv')

print(data)

本地ecxel文件

在读取excel文件时,需要使用openpyxl来读取,

我是用pip命令来安装的该引擎

pip install openpyxl

import pandas as pd# type: ignore# 指定使用 openpyxl 引擎来读取 Excel 文件

data = pd.read_excel('../dataset/ss.xlsx', engine='openpyxl')

# print(data)# 选择特定的列

x = data.iloc[:, [0, 1, 2]]

y = data.iloc[:, [-2]]# print(x)

print(y)

2.2.4、数据集的划分

数据集划分函数

from sklearn.model_selection import train_test_split # type: ignore

参数注释

参数

(1) *array

这里用于接收1到多个"列表、numpy数组、稀疏矩阵或padas中的DataFrame"。

(2) **options, 重要的关键字参数有:

test_size 值为0.0到1.0的小数,表示划分后测试集占的比例

random_state 值为任意整数,表示随机种子,使用相同的随机种子对相同的数据集多次划分结果是相同的。否则多半不同

strxxxx 分层划分,填y

2 返回值说明

返回值为列表list, 列表长度与形参array接收到的参数数量相关联, 形参array接收到的是什么类型,list中对应被划分出来的两部分就是什么类型

list数据数据划分

import numpy as np# type: ignore

from sklearn.model_selection import train_test_split# type: ignoreX=[[11,2,3,31,111],[12,2,3,32,112],[1,23,3,33,113],[14,2,3,34,114],[15,2,3,35,115],[16,2,3,36,116],[1,23,3,36,117],[1,23,3,316,118],[1,23,3,326,119],[1,23,3,336,120]

]

y=[1,1,1,1,1,2,2,2,2,2]

# 打印生成的数据

print("随机生成的x数据:")

print(X)

print("标签y:")

print(y)# 划分训练集和测试集

x_train, x_test, y_train, y_test = train_test_split(X, y, train_size=0.8, stratify=y)# 打印划分结果

print("训练集 x_train:\n")

print(x_train)

print("测试集 x_test:\n")

print(x_test)

print("训练集标签 y_train:\n")

print(y_train)

print("测试集标签 y_test:\n")

print(y_test)

ndarray的数据集划分

from sklearn.model_selection import train_test_split# type: ignore

import numpy as np# type: ignorex = np.arange(100).reshape(50,2)

# print(x)

x_train,x_test = train_test_split(x,test_size=0.8,random_state=42)

print(x_train)

print("----------------------------------")

print(x_test)

dataFrame的数据集划分

import numpy as np# type: ignore

import pandas as pd# type: ignore

from sklearn.model_selection import train_test_split# type: ignore# 数据集的划分

data = np.arange(1,100).reshape(33, 3)

data = pd.DataFrame(data,columns=['a','b','c'])

# print(data)

x_train,x_test = train_test_split(data,test_size=0.3)

print("\n",x_train)

print("--------------------------")

print("\n",x_test)

玩具数据集划分

# 鸢尾花数据集划分

from sklearn import datasets# type: ignore

from sklearn.model_selection import train_test_split# type: ignoreiris = datasets.load_iris()

x = iris.data

y = iris.target

x_train, x_test, y_train, y_test = train_test_split(x, y, test_size=0.2, random_state=4)

print(x_train.shape)

print(x_test.shape)

print(y_train.shape)

print(y_test.shape)

print(iris.feature_names)

print(iris.target_names)

现实数据集划分

import numpy as np# type: ignorefrom sklearn.datasets import fetch_20newsgroups# type: ignore

from sklearn.model_selection import train_test_split# type: ignorenew_date = fetch_20newsgroups(data_home='../dataset/',subset='train')

# print(new_date.data[0])x_train,x_test,y_train,y_test = train_test_split(new_date.data,new_date.target,test_size=0.2,random_state=666)

print(np.array(x_train).shape)

print(np.array(x_test).shape)

print(np.array(y_train).shape)

print(np.array(y_test).shape)print(new_date.target_names)

2.3、特征工程

特征工程api

# DictVectorizer 字典特征提取

# CountVectorizer 文本特征提取

# TfidfVectorizer TF-IDF文本特征词的重要程度特征提取

# MinMaxScaler 归一化

# StandardScaler 标准化

# VarianceThreshold 底方差过滤降维

# PCA 主成分分析降维

#转换器对象调用fit_transform()进行转换, 其中fit用于计算数据,transform进行最终转换fit_transform()可以使用fit()和transform()代替fit_transform()、fit()和transform()之间的区别1. fit()

作用: fit() 方法用于计算数据集的统计信息(如均值、方差等),以便后续的转换操作。

返回值: 无返回值,直接在对象内部存储计算结果。

适用场景: 当你需要对训练数据集进行统计信息的计算时使用。2. transform()

作用: transform() 方法使用 fit() 计算的统计信息对数据集进行转换。

返回值: 返回转换后的数据集。

适用场景: 当你需要对训练数据集或测试数据集进行相同的转换时使用。3. fit_transform()

作用: fit_transform() 方法结合了 fit() 和 transform() 的功能,先计算统计信息,然后对数据集进行转换。

返回值: 返回转换后的数据集。

适用场景: 当你需要对训练数据集进行一次性计算和转换时使用。

字典的特征提取和数据集划分

from sklearn.feature_extraction import DictVectorizer# type: ignore

from sklearn.model_selection import train_test_split# type: ignoredata_dict = [{'city': '北京', 'count':2300,'tempertrye': 41},{'city': '上海', 'count':2300,'tempertrye': 39}, {'city': '深圳', 'count':2750,'tempertrye': 30},{'city': '广州', 'count':2500,'tempertrye': 40},{'city': '杭州', 'count':2800,'tempertrye': 33},{'city': '西安', 'count':2700,'tempertrye': 28},{'city': '西安', 'count':2700,'tempertrye': 28}

]# sparse=False:表示返回完整的矩阵,True:表示返回稀疏矩阵

model = DictVectorizer(sparse=False)

data_new = model.fit_transform(data_dict)

# print(data_new)

x_train,y_train = train_test_split(data_new,test_size=0.2,random_state=666)

print(x_train)

print('------------------------------------------------------------------------------')

print(y_train)

文本特征提取

from sklearn.feature_extraction.text import CountVectorizercorpus = ['I love machine learning.Its awesome.', 'Its a amazon book', 'Amazon is a great company']# 创建一个词频提取对象

vectorizer = CountVectorizer(stop_words=['amzzon'])

# 提取特征词频

X = vectorizer.fit_transform(corpus)print(X)print(X.toarray())

# 打印特征词频

print(vectorizer.get_feature_names_out())CountVectorizer 中文本特征提取

中文提取需要用到库jieba

使用下面的命令进行安装

pip install jieba

import jieba

from sklearn.feature_extraction.text import CountVectorizer

# arr = list(jieba.cut("我爱北京天安门"))

# print (arr)

# str01 = ' '.join(arr)

# print (str01)

def my_cut(text):#传入没有断词的文本,用jieba分词工具转化为数据容器,然后把数据容器中的元素用空格连接起来return ' '.join(list(jieba.cut(text)))corpus = ['我爱北京天安门','我爱成都天府广场']

# 创建一个词频提取对象

vectorizer = CountVectorizer(stop_words=[])

# 提取词频

data = [my_cut(el) for el in corpus]

x = vectorizer.fit_transform(data)

# print(x)

# print(x.toarray())

print(vectorizer.get_feature_names_out())data02 = pd.DataFrame(x.toarray(),columns=vectorizer.get_feature_names_out())

print(data02)TfidfVectorizer TF-IDF文本特征词的重要程度特征提取

import jieba

import pandas as pd

from sklearn.feature_extraction.text import TfidfVectorizerdef cut_words(text):return " ".join(list(jieba.cut(text)))data = ["教育学会会长期间,坚定支持民办教育事业!", "扶持民办,学校发展事业","事业做出重大贡献!"]

data_new = [cut_words(v) for v in data]transfer = TfidfVectorizer(stop_words=['期间', '做出',"重大贡献"])

data_final = transfer.fit_transform(data_new)pd.DataFrame(data_final.toarray(), columns=transfer.get_feature_names_out())

无量纲化

MinMaxScaler 归一化

data = [[1, 2, 3, 4],[1, 2, 3, 4],[1, 2, 3, 4],[1, 2, 3, 4]

]

tran = MinMaxScaler(feature_range(1,2))

data = tran.fit_transfrom(data)

print(data)

StandardScaler 标准化

import numpy as np

from sklearn.preprocessing import StandardScaler# 创建一个示例数据集

X = np.array([[1, 2], [3, 4], [5, 6]])# 初始化 StandardScaler

scaler = StandardScaler()# 对训练数据进行 fit_transform

X_train_scaled = scaler.fit_transform(X)# 打印标准化后的训练数据

print("标准化后的训练数据:")

print(X_train_scaled)# 创建一个新的测试数据集

X_test = np.array([[7, 8], [9, 10]])# 对测试数据进行 transform

X_test_scaled = scaler.transform(X_test)# 打印标准化后的测试数据

print("标准化后的测试数据:")

print(X_test_scaled)

2.4、特征降维

VarianceThreshold 低方差过滤特征选择

# 1、获取数据,data是一个DataFrame,可以是读取的csv文件

data=pd.DataFrame([[10,11],[11,13],[11,11],[11,15],[11,91],[11,13],[11,12],[11,16]])

print("data:\n", data)

# 2、实例化一个转换器类

transfer = VarianceThreshold(threshold=1)#0.1阈值

# 3、调用fit_transform

data_new = transfer.fit_transform(data)

print("data_new:\n",data_new)PCA降维

from sklearn.dec**** import PCAdata = [[1, 2, 3, 4],[1, 2, 3, 4],[1, 2, 3, 4],[1, 2, 3, 4]

]

pac = PCA(n_com**** = 0.95)data = pca.fit_transfrom(data)print(f"降维后的数据为:{data}"}

相关文章:

机器学习(1)

一、机器学习 机器学习(Machine Learning, ML)是人工智能(Artificial Intelligence, AI)的一个分支,它致力于开发能够从数据中学习并改进性能的算法和模型。机器学习的核心思想是通过数据和经验自动优化算法ÿ…...

深入理解 Redis跳跃表 Skip List 原理|图解查询、插入

1. 简介 跳跃表 ( skip list ) 是一种有序数据结构,通过在每个节点中维持多个指向其他节点的指针,从而达到快速访问节点的目的。 在 Redis 中,跳跃表是有序集合键的底层实现之一,那么这篇文章我们就来讲讲跳跃表的实现原理。 2. …...

)

Halcon HImage 与 Qt QImage 的相互转换(修订版)

很久以前,我写过一遍文章来介绍 HImage 和 QImage 之间的转换方法。(https://blog.csdn.net/liyuanbhu/article/details/91356988) 这个代码其实是有些问题的。因为我们知道 QImage 中的图像数据不一定是连续的,尤其是图像的宽度…...

【Golang】——Gin 框架中的模板渲染详解

Gin 框架支持动态网页开发,能够通过模板渲染结合数据生成动态页面。在这篇文章中,我们将一步步学习如何在 Gin 框架中配置模板、渲染动态数据,并结合静态资源文件创建一个功能完整的动态网站。 文章目录 1. 什么是模板渲染?1.1 概…...

CSS:导航栏三角箭头

用CSS实现导航流程图的样式。可根据自己的需求进行修改,代码精略的写了一下。 注:场景一和场景二在分辨率比较低的情况下会有一个1px的缝隙不太优雅,自行处理。有个方法是直接在每个外面包一个DIV,用动态样式设置底色。 场景一、…...

使用示例)

onlyoffice Command service(命令服务)使用示例

一、说明 文档在这里:https://api.onlyoffice.com/docs/docs-api/additional-api/command-service/ 命令服务提供有几个简单的接口封装。也提供了前端和后端同时操作文档的可能。 二、正文 命令服务地址:https://documentserver/coauthoring/Com…...

QSS 设置bug

问题描述: 在QWidget上add 一个QLabel,但是死活不生效 原因: c 主程序如下: QWidget* LOGO new QWidget(logo_wnd);LOGO->setFixedSize(logo_width, 41);LOGO->setObjectName("TittltLogo");QVBoxLayout* tit…...

交换排序——快速排序

交换排序——快速排序 7.7 交换排序——快速排序快速排序概念c语言的库函数qsort快速排序框架quickSort 7.7 交换排序——快速排序 快速排序概念 快速排序是Hoare于1962年提出的一种二叉树结构的交换排序方法(下文简称快排),其基本思想为&a…...

nodejs入门(1):nodejs的前后端分离

一、引言 我关注nodejs还是从前几年做了的一个电力大数据展示系统开始的,当然,我肯定是很多年的计算机基础的,万变不离其宗。 现在web网站都流行所谓的前后端结构,不知不觉我也开始受到这个影响,以前都是前端直接操作…...

笔记|M芯片MAC (arm64) docker上使用 export / import / commit 构建amd64镜像

很简单的起因,我的东西最终需要跑在amd64上,但是因为mac的架构师arm64,所以直接构建好的代码是没办法跨平台运行的。直接在arm64上pull下来的docker镜像也都是arm64架构。 检查镜像架构: docker inspect 8135f475e221 | grep Arc…...

gorm框架

连接 需要下载mysql的驱动 go get gorm.io/driver/mysql go get gorm.io/gorm 约定 主键:GORM 使用一个名为ID 的字段作为每个模型的默认主键。表名:默认情况下,GORM 将结构体名称转换为 snake_case 并为表名加上复数形式。 例如…...

免费送源码:Java+Springboot+MySQL Springboot多租户博客网站的设计 计算机毕业设计原创定制

Springboot多租户博客网站的设计 摘 要 博客网站是当今网络的热点,博客技术的出现使得每个人可以零成本、零维护地创建自己的网络媒体,Blog站点所形成的网状结构促成了不同于以往社区的Blog文化,Blog技术缔造了“博客”文化。本文课题研究的“…...

【ASR技术】WhisperX安装使用

介绍 WhisperX 是一个开源的自动语音识别(ASR)项目,由 m-bain 开发。该项目基于 OpenAI 的 Whisper 模型,通过引入批量推理、强制音素对齐和语音活动检测等技术。提供快速自动语音识别(large-v2 为 70 倍实时…...

【计算机网络】协议定制

一、结构化数据传输流程 这里涉及协议定制、序列化/反序列化的知识 对于序列化和反序列化,有现成的解决方案:①json ②probuff ③xml 二、理解发送接收函数 我们调用的所有发送/接收函数,根本就不是把数据发送到网络中!本质都是…...

【SQL】mysql常用命令

为方便查询,特整理MySQL常用命令。 约定:$后为Shell环境命令,>后为MySQL命令。 1 常用命令 第一步,连接数据库。 $ mysql -u root -p # 进入MySQL bin目录后执行,回车后输入密码连接。# 常用参数&…...

阿里云引领智算集群网络架构的新一轮变革

阿里云引领智算集群网络架构的新一轮变革 云布道师 11 月 8 日~ 10 日在江苏张家港召开的 CCF ChinaNet(即中国网络大会)上,众多院士、教授和业界技术领袖齐聚一堂,畅谈网络未来的发展方向,聚焦智算集群网络的创新变…...

几何合理的分片段感知的3D分子生成 FragGen - 评测

FragGen 来源于 2024 年 3 月 25 日 预印本的文章,文章题目是 Deep Geometry Handling and Fragment-wise Molecular 3D Graph Generation, 作者是 Odin Zhang,侯廷军,浙江大学药学院。FragGen 是一个基于分子片段的 3D 分子生成模…...

Python爬虫下载新闻,Flask展现新闻(2)

上篇讲了用Python从新闻网站上下载新闻,本篇讲用Flask展现新闻。关于Flask安装网上好多教程,不赘述。下面主要讲 HTML-Flask-数据 的关系。 简洁版 如图,页面简单,主要显示新闻标题。 分页,使用最简单的分页技术&…...

监控易监测对象及指标之:全面监控华为FusionInsight服务

随着大数据技术的广泛应用,华为FusionInsight以其卓越的性能和稳定性,成为了众多企业处理和分析海量数据的首选平台。然而,为了确保FusionInsight服务的持续稳定运行,对其进行全面监控至关重要。本文基于监控易工具,对…...

SQL面试题——蚂蚁SQL面试题 会话分组问题

会话分组问题 这里的分组不是简单的分组,而是会话的分组。 比如说,进入一个网站以后,可以连续的点击很多个页面,后台会记录用户的行为日志; 如果T日上午连续点击几个页面后退出了网站,直到第二天的下午才再次进入网站,单单从时间线上来看,昨天退出的那条日志跟今天进…...

java_网络服务相关_gateway_nacos_feign区别联系

1. spring-cloud-starter-gateway 作用:作为微服务架构的网关,统一入口,处理所有外部请求。 核心能力: 路由转发(基于路径、服务名等)过滤器(鉴权、限流、日志、Header 处理)支持负…...

【Java学习笔记】Arrays类

Arrays 类 1. 导入包:import java.util.Arrays 2. 常用方法一览表 方法描述Arrays.toString()返回数组的字符串形式Arrays.sort()排序(自然排序和定制排序)Arrays.binarySearch()通过二分搜索法进行查找(前提:数组是…...

iPhone密码忘记了办?iPhoneUnlocker,iPhone解锁工具Aiseesoft iPhone Unlocker 高级注册版分享

平时用 iPhone 的时候,难免会碰到解锁的麻烦事。比如密码忘了、人脸识别 / 指纹识别突然不灵,或者买了二手 iPhone 却被原来的 iCloud 账号锁住,这时候就需要靠谱的解锁工具来帮忙了。Aiseesoft iPhone Unlocker 就是专门解决这些问题的软件&…...

linux 下常用变更-8

1、删除普通用户 查询用户初始UID和GIDls -l /home/ ###家目录中查看UID cat /etc/group ###此文件查看GID删除用户1.编辑文件 /etc/passwd 找到对应的行,YW343:x:0:0::/home/YW343:/bin/bash 2.将标红的位置修改为用户对应初始UID和GID: YW3…...

)

相机Camera日志分析之三十一:高通Camx HAL十种流程基础分析关键字汇总(后续持续更新中)

【关注我,后续持续新增专题博文,谢谢!!!】 上一篇我们讲了:有对最普通的场景进行各个日志注释讲解,但相机场景太多,日志差异也巨大。后面将展示各种场景下的日志。 通过notepad++打开场景下的日志,通过下列分类关键字搜索,即可清晰的分析不同场景的相机运行流程差异…...

Java面试专项一-准备篇

一、企业简历筛选规则 一般企业的简历筛选流程:首先由HR先筛选一部分简历后,在将简历给到对应的项目负责人后再进行下一步的操作。 HR如何筛选简历 例如:Boss直聘(招聘方平台) 直接按照条件进行筛选 例如:…...

IP如何挑?2025年海外专线IP如何购买?

你花了时间和预算买了IP,结果IP质量不佳,项目效率低下不说,还可能带来莫名的网络问题,是不是太闹心了?尤其是在面对海外专线IP时,到底怎么才能买到适合自己的呢?所以,挑IP绝对是个技…...

)

C#学习第29天:表达式树(Expression Trees)

目录 什么是表达式树? 核心概念 1.表达式树的构建 2. 表达式树与Lambda表达式 3.解析和访问表达式树 4.动态条件查询 表达式树的优势 1.动态构建查询 2.LINQ 提供程序支持: 3.性能优化 4.元数据处理 5.代码转换和重写 适用场景 代码复杂性…...

给网站添加live2d看板娘

给网站添加live2d看板娘 参考文献: stevenjoezhang/live2d-widget: 把萌萌哒的看板娘抱回家 (ノ≧∇≦)ノ | Live2D widget for web platformEikanya/Live2d-model: Live2d model collectionzenghongtu/live2d-model-assets 前言 网站环境如下,文章也主…...

适应性Java用于现代 API:REST、GraphQL 和事件驱动

在快速发展的软件开发领域,REST、GraphQL 和事件驱动架构等新的 API 标准对于构建可扩展、高效的系统至关重要。Java 在现代 API 方面以其在企业应用中的稳定性而闻名,不断适应这些现代范式的需求。随着不断发展的生态系统,Java 在现代 API 方…...