Apache zookeeper kafka 开启SASL安全认证 —— 筑梦之路

简介

Kafka是一个高吞吐量、分布式的发布-订阅消息系统。Kafka核心模块使用Scala语言开发,支持多语言(如Java、Python、Go等)客户端,它可以水平扩展和具有高吞吐量特性而被广泛使用,并与多类开源分布式处理系统进行集成使用。

Kafka作为一款开源的、轻量级的、分布式、可分区和具备复制备份的、基于ZooKeeper协调管理的分布式流平台的功能强大的消息系统。与传统消息系统相比,Kafka能够更好的处理活跃的流数据,让数据在各个子系统中高性能、低延迟地不停流转。

自0.9.0.0版本开始Kafka社区添加了许多功能用于提高Kafka集群的安全性,Kafka提供SSL或者SASL两种安全策略。SSL方式主要是通过CA令牌实现,此方案主要介绍SASL方式。

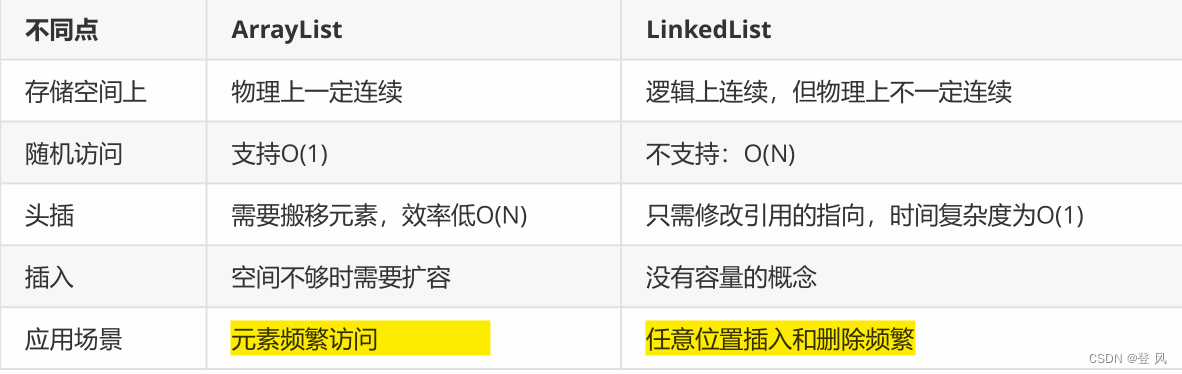

| 验证方式 | kafka版本 | 特点 |

|---|---|---|

| SASL/PLAIN | 0.10.0.0 | 不能动态添加用户 |

| SASL/SCRAM | 0.10.2.0 | 可以动态添加用户 |

| SASL/Kerberos | 0.9.0.0 | 需要独立部署验证服务 |

| SASL/oauthbearer | 2.0.0 | 需要自己实现接口, 实现token的创建和验证, 需要额外的oauth服务 |

使用SSL加密在代理和客户端之间,代理之间或代理和工具之间传输的数据

SCRAM认证配置的优点:

如果使用PLAIN认证有个问题,就是不能动态新增用户,每次添加用户后,需要重启正在运行的Kafka集群才能生效。

因此,在生产环境中,这种认证方式不符合实际业务场景,不利于后期扩展。然而使用SCRAM认证,可以动态新增用户,添加用户后,可以不用重启正在运行的Kafka集群即可进行鉴权。所以生产环境推荐使用SCRAM+PLAIN搭配的认证方案。

配置zookeeper集群启用SASL

zookeeper官方地址:Apache ZooKeeper

1. 配置zookeeper,启用sasl认证

cat zoo.cfgtickTime=2000

initLimit=1

syncLimit=5

dataDir=/data/zookeeper/data

dataLogDir=/data/zookeeper/datalog

clientPort=2181

admin.serverPort=8888

maxClientCnxns=3000

autopurge.snapRetainCount=3

autopurge.purgeInterval=24

server.1=192.168.100.110:2888:3888

server.2=192.168.100.111:2888:3888

server.3=192.168.100.112:2888:3888

4lw.commands.whitelist=conf,stat,srvr,mntr.envi

#zk SASL

authProvider.1=org.apache.zookeeper.server.auth.SASLAuthenticationProvider

jaasLoginRenew=3600000

requireClientAuthScheme=sasl

zookeeper.sasl.client=true2. 配置zookeeper JAAS

cat zk_jaas.confServer {org.apache.zookeeper.server.auth.DigestLoginModule requiredusername="admin"password="admin123"user_kafka="kafka123";

};注意:admin用户 是zk 集群之间使用的。

kafka用户 是 broker 与 zk 之间使用的。3. 修改zkEnv.sh

将上一步添加的 jaas 配置文件添加到zookeeper的环境变量中,zkEnv.sh文件最后添加一行:vim zkEnv.shZOOBINDIR="${ZOOBINDIR:-/usr/bin}"

ZOOKEEPER_PREFIX="${ZOOBINDIR}/.."# 添加如下 新增变量SERVER_JVMFLAGS:export SERVER_JVMFLAGS="-Djava.security.auth.login.config=../conf/zk_jaas.conf"4. 配置环境变量,启动zk服务

vim /etc/profile# zk

export PATH=/home/zookeeper/bin:$PATHsource /etc/profile# 启动服务zkServer.sh start && zkServer.sh status

5. 安装zkui图形界面管理zk

# 拉取代码git clone https://github.com/DeemOpen/zkui.git# 安装maven并配置阿里云源从这里下载:https://maven.apache.org/wget https://dlcdn.apache.org/maven/maven-3/3.9.4/binaries/apache-maven-3.9.4-bin.tar.gztar -zxvf apache-maven-3.9.4-bin.tar.gzecho 'export PATH=/home/apache-maven-3.9.4-bin:$PATH' >>/etc/profilesource /etc/profilemvn -vvim settings.xml找到</mirrors>节点添加即可<mirror><id>alimaven</id><name>aliyun maven</name><url>http://maven.aliyun.com/nexus/content/groups/public/</url><mirrorOf>central</mirrorOf></mirror>

-----------------------------------# 构建jar包cd zkui/ && mvn clean install -DskipTestsmkdir /data/zkui

cp zkui/target/zkui-2.0-SNAPSHOT-jar-with-dependencies.jar /data/zkui/

cp zkui/config.cfg /data/zkui/

cd /data/zkui

nohup java -jar zkui-2.0-SNAPSHOT-jar-with-dependencies.jar &

tail -n 100 -f nohup.out

-----------------------------------http://192.168.100.113:9090/login

账号:admin

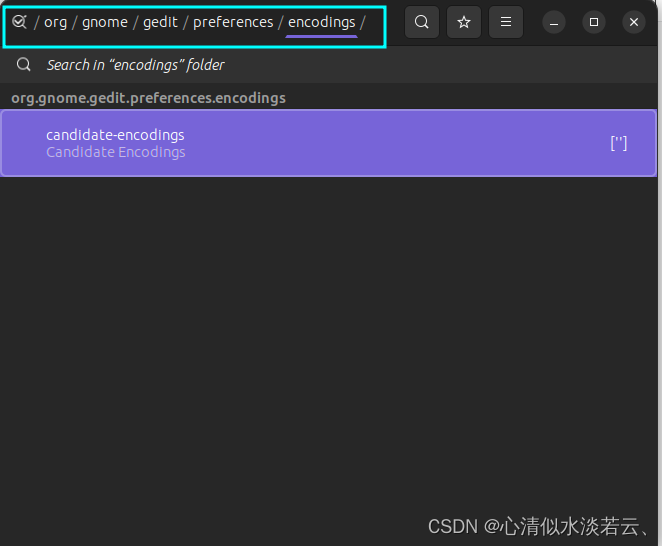

密码:manager基本操作 通过UI界面操作尽量规避掉人为操作的多种不确定性因素导致生产故障浏览器访问,下面的用户名和密码提示是config.cfg中loginMessage字段写死的生产中修改掉即可配置kafka sasl动态认证

SASL/SCRAM认证是把凭证(credential)存储在Zookeeper,使用kafka-configs.sh在Zookeeper中创建凭据。对于每个SCRAM机制,必须添加具有机制名称的配置来创建凭证,所以在启动Kafka broker之前需要创建代理间通信的凭据。

这里配置的 Kafka和生产者/消费者之间 采用SASL/PLAIN和SASL/SCRAM两种方式共同完成认证,授权使用ACL方式。PLAIN方式的用户是在jaas文件中写死的,不能动态的添加;SCRAM支持动态的添加用户。

1. 创建用户

配置SASL/SCRAM认证的第一步,是配置可以连接到kafka集群的用户。本案例创建了3个用户:admin,producer,consumer。kafka_server_admin用户用于broker之间的认证通信,producer用户用于生产者连接kafka,consumer用户用于消费者连接kafka 。

kafka-configs.sh --zookeeper 192.168.100.110:2181 --alter --add-config 'SCRAM-SHA-256=[iterations=8192,password=admin123],SCRAM-SHA-512=[password=admin123]' --entity-type users --entity-name adminkafka-configs.sh --zookeeper 192.168.100.110:2181 --alter --add-config 'SCRAM-SHA-256=[iterations=8192,password=admin123],SCRAM-SHA-512=[password=admin123]' --entity-type users --entity-name producerkafka-configs.sh --zookeeper 192.168.100.110:2181 --alter --add-config 'SCRAM-SHA-256=[iterations=8192,password=admin123],SCRAM-SHA-512=[password=admin123]' --entity-type users --entity-name consumerCompleted Updating config for entity: user-principal 'admin'. #正常情况打印信息这串信息。PS:用户 admin 这里配置admin用户用于实现broker间的通讯。2. 查看创建的用户信息

kafka-configs 脚本是用来设置主题级别参数的。其实,它的功能还有很多。比如在这个例子中,我们使用它来创建 SASL/SCRAM 认证中的用户信息。可以使用下列命令来查看刚才创建的用户数据。

kafka-configs.sh --zookeeper 192.168.100.110:2181 --describe --entity-type users #(可以单独指定某个用户 --entity-name producer,如下)

kafka-configs.sh --zookeeper 192.168.100.110:2181 --describe --entity-type users --entity-name producer输出示例如下:

Configs for user-principal 'producer' are SCRAM-SHA-512=salt=czVldW1mNDRlcTgzdnJydWxrOXB0YThxbw==,stored_key=Hjrex55CEcLSA2b1n8bvL5CfjziLPHD8EoduoCkNrT0xcVDthoQSi4hvt7szU55pJP/LTbpQkZdV66nueVzKmg==,server_key=OcXwU1KyxBU1tUdlu9ikpfwl+y+ne121iD4amN7zKl8I84KeBZlrwz1IKB1ICFFiAP9XoRRj0QMgHbCfhsL/wA==,iterations=4096,SCRAM-SHA-256=salt=NDJzZmZ0MmhxMDI0N2ZrbXh6bTQwYnZzcA==,stored_key=EIzpjfD4JzItzjeh16UvpQEGyYoZbesR0GRsQB58Als=,server_key=5LAvxe/KjCas7w4GM+KlkT/il99peOozXY/HPZeSF14=,iterations=8192

这段命令包含了 writer 用户加密算法 SCRAM-SHA-256 以及 SCRAM-SHA-512 对应的盐值 (Salt)、ServerKey 和 StoreKey,这些都是 SCRAM 机制的术语。

ZK客户端命令行查看:zkCli.sh -server 192.168.100.110:2181ls /config/users删除用户[producer]的SCRAM证书:kafka-configs.sh --zookeeper 192.168.100.110:2181 --alter --delete-config 'SCRAM-SHA-256' --entity-type users --entity-name producer3. 配置kafka jaas文件

配置了用户之后,我们需要为 Broker 创建一个对应的 JAAS 文件。在实际场景中,需要为每台单独的物理 Broker 机器都创建一份 JAAS 文件。

Kafka 的 jaas认证配置文件,配置的是登录类,超管密码和管理的帐号密码列表

vim kafka_server_jaas.confKafkaServer {org.apache.kafka.common.security.scram.ScramLoginModule requiredusername ="admin"password="admin123"user_admin="admin123"user_producer="producer123"user_consumer="consumer123";

};

KafkaClient {org.apache.kafka.common.security.scram.ScramLoginModule requiredusername="admin"password="admin123"user_producer="producer123"user_consumer="consumer123";

};

Client {org.apache.kafka.common.security.scram.ScramLoginModule requiredusername="kafka"password="kafka123";

};-----------------------------------KafkaServer中usename配置的是kafka服务端使用的账号和密码,后面的user_xxx事预设的普通帐号认证信息。中间部分配置的是PLAIN认证方式的账户和密码,其中producer1是账户名,producer123是密码。

Client配置了broker到Zookeeper的连接用户名密码,这里要和前面zookeeper配置中的zk_jaas.conf.conf 中 user_kafka 的账号和密码相同。关于这个文件内容,需要注意以下两点:1)不要忘记最后一行和倒数第二行结尾处的分号;2)JAAS 文件中不需要任何空格键。4. kafka 配置文件启用SASL认证

Kafka 服务配置文件 server.propertis,配置认证协议及认证实现类# -----------------节点1cat server.propertiesbroker.id=0

listeners=SASL_PLAINTEXT://:9092

advertised.listeners=SASL_PLAINTEXT://192.168.100.110:9092

sasl.enabled.mechanisms=SCRAM-SHA-256,PLAIN

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-256

security.inter.broker.protocol=SASL_PLAINTEXT

allow.everyone.if.no.acl.found=false

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

super.users=User:admin

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/data/kafka/datalogs

num.partitions=3

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=2

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.retention.bytes=1073741824

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

delete.topic.enable=true

auto.create.topics.enable=false

zookeeper.connect=192.168.100.110:2181,192.168.100.111:2181,192.168.100.112:2181

zookeeper.connection.timeout.ms=60000

group.initial.rebalance.delay.ms=0# -------------------节点2cat server.propertiesbroker.id=1

listeners=SASL_PLAINTEXT://:9092

advertised.listeners=SASL_PLAINTEXT://192.168.100.111:9092

sasl.enabled.mechanisms=SCRAM-SHA-256,PLAIN

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-256

security.inter.broker.protocol=SASL_PLAINTEXT

allow.everyone.if.no.acl.found=false

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

super.users=User:admin

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/data/kafka/datalogs

num.partitions=3

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=2

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.retention.bytes=1073741824

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

delete.topic.enable=true

auto.create.topics.enable=false

zookeeper.connect=192.168.100.110:2181,192.168.100.111:2181,192.168.100.112:2181

zookeeper.connection.timeout.ms=60000

group.initial.rebalance.delay.ms=0# -----------------------节点3

cat server.propertiesbroker.id=2

listeners=SASL_PLAINTEXT://:9092

advertised.listeners=SASL_PLAINTEXT://192.168.100.112:9092

sasl.enabled.mechanisms=SCRAM-SHA-256,PLAIN

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-256

security.inter.broker.protocol=SASL_PLAINTEXT

allow.everyone.if.no.acl.found=false

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

super.users=User:admin

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/data/kafka/datalogs

num.partitions=3

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=3

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.retention.bytes=1073741824

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

delete.topic.enable=true

auto.create.topics.enable=false

zookeeper.connect=192.168.100.110:2181,192.168.100.111:2181,192.168.100.112:2181

zookeeper.connection.timeout.ms=60000

group.initial.rebalance.delay.ms=05. kafka 启动脚本添加认证文件路径的环境变量

Kafka 安全认证可以直接通过环境变量 -Djava.security.auth.login.config 设置,修改 Kafka 启动脚本 kafka-start-server.sh 文件最后一行,增加一个参数指向 jaas 配置文件的绝对路径

vim kafka-server-start.sh#exec $base_dir/kafka-run-class.sh $EXTRA_ARGS kafka.Kafka "$@"

exec $base_dir/kafka-run-class.sh $EXTRA_ARGS -Djava.security.auth.login.config=/path-to-kafka/config/kafka_server_jaas.conf kafka.Kafka "$@"6. kafka客户端配置

1) 配置consumer.properties和producer.properties,都要加入以下配置

ecurity.protocol=SASL_PLAINTEXT

sasl.mechanism=SCRAM-SHA-5122) 生产者配置

使用kafka-console-producer.sh脚本测试生产者,由于开启安全认证和授权,此时使用console-producer脚本来尝试发送消息,那么消息会发送失败,原因是没有指定合法的认证用户,因此客户端需要做相应的配置,需要创建一个名为producer.conf的配置文件给producer程序使用。

config目录下创建一个producer.conf的文件,文件内容如下:

cat producer.confsecurity.protocol=SASL_PLAINTEXT sasl.mechanism=SCRAM-SHA-256 sasl.jaas.config=org.apache.kafka.common.security.scram.Scra mLoginModule required username="producer" password="producer123";注意:Topic设置写权限

3) 消费者配置

使用kafka-console-consumer.sh脚本测试生产者,由于开启安全认证和授权,因此客户端需要做相应的配置。需要为 consumer 用户创建consumer.conf给消费者程序,同时设置对topic的读权限。

config目录下创建一个consumer.conf的文件,文件内容如下:

vim consumer.confsecurity.protocol=SASL_PLAINTEXT sasl.mechanism=SCRAM-SHA-256 sasl.jaas.config=org.apache.kafka.common.security.scram.Scra mLoginModule required username="consumer" password="consumer123";注意:Topic设置读权限。

4) 在生产者和消费者启动脚本中引入JAAS文件

vim bin/kafka-console-producer.shif [ "x$KAFKA_HEAP_OPTS" = "x" ]; thenexport KAFKA_HEAP_OPTS="-Xmx512M"

fi# 添加这行

export KAFKA_OPTS="-Djava.security.auth.login.config=/path-to-kafka/config/kafka_server_jaas.conf"exec $(dirname $0)/kafka-run-class.sh kafka.tools.ConsoleProducer "$@"# vim bin/kafka-console-consumer.shif [ "x$KAFKA_HEAP_OPTS" = "x" ]; thenexport KAFKA_HEAP_OPTS="-Xmx512M"

fi# 添加这行

export KAFKA_OPTS="-Djava.security.auth.login.config=/path-to-kafka/config/kafka_server_jaas.conf"exec $(dirname $0)/kafka-run-class.sh kafka.tools.ConsoleConsumer "$@"启动kafka集群

nohup kafka-server-start.sh /path-to-kafka/config/server.properties &# 检查启动日志tail -n 100 -f nohup.out检查验证

zkCli.sh -server localhost:2181ls /brokers/ids1. 生产者测试

1) 创建一个测试主题test_topic

kafka-topics.sh --zookeeper 192.168.100.112:2181 --create --replication-factor 3 --partitions 3 --topic test_topic2)查看创建的Topic

kafka-topics.sh --list --zookeeper 192.168.100.112:2181 test_topickafka-topics.sh --describe --zookeeper 192.168.100.112:2181 --topic test_topic注:kafka开启认证后,当生产者往Topic写数据需要为主题配置权限(write),即对生产者赋予写的权限。

这里使用producer用户认证授权,通过ACL为producer 用户分配操作test_topic权限(下面两个命令二选一即可):

分配写的权限kafka-acls.sh --authorizer-properties zookeeper.connect=192.168.100.112:2181 --add --allow- principal User:producer --operation Write --topic 'test_topic'

启动生产者发送消息

特别注意:在生产者生产消息之前如果不设置生产者用户的ACL权限会报错:

kafka-console-producer.sh --broker-list 192.168.100.112:9092 --topic test_topic --producer.config /path-to-kafka/config/producer.conf>hello >world >end

2. 消费者测试

注:kafka开启认证后,当消费者拉取主题的消息时需要为Topic配置权限(read),即对生产者赋予写的权限。

这里使用consumer用户认证授权,通过ACL为consumer用户分配操作test_topic权限,同时需要对消费者组授权(给groupId配权),执行一下2个步骤:

1)分配读的权限kafka-acls.sh --authorizer-properties zookeeper.connect=192.168.100.112:2181 --add --allow-principal User:consumer--operation Read --topic 'test_topic'2)分配consumer的权限kafka-acls.sh --authorizer-properties zookeeper.connect=192.168.100.112:2181 --add --allow- principal User:consumer--consumer --topic test_topic --group test_group启动消费者消费消息:

读取消息前,如果对开启消费者用户读取topic权限,会报错:

#kafka-console-consumer.sh --bootstrap-server 192.xxx.xxx.112:9092,192.xxx.xxx.110:9092,192.xxx.xxx.111:9092 --topic test --group test-group --from-beginning --consumer.config /path-to-kafka/config/consumer.confkafka-console-consumer.sh --bootstrap-server 192.xxx.xxx.112:9092 --topic test_topic --group test-group --from-beginning --consumer.config /path-to-kafka/config/consumer.confhello world end

案例一则

1)创建Topic

kafka-topics.sh --zookeeper 192.168.100.110:2181 --create --partitions 2 --replication-factor 1 --topic test12)生产者端配置

#添加写权限

kafka-acls.sh --authorizer kafka.security.auth.SimpleAclAuthorizer --authorizer-properties zookeeper.connect=192.168.100.110:2181 --add --allow-principal User:producer --operation Write --topic test1#写入消息

kafka-console-producer.sh --broker-list 192.168.100.112:9092,192.168.100.111:9092,192.168.100.110:9092 --topic test1

--producer.config /path-to-kafka/config/producer.conf

>hello

>world3)消费者端配置

#添加读权限

kafka-acls.sh --authorizer kafka.security.auth.SimpleAclAuthorizer --authorizer-

properties zookeeper.connect=192.168.100.110:2181 --add --allow-principal User:consumer --operation Read --topic test1#添加消费者组权限

kafka-acls.sh --authorizer kafka.security.auth.SimpleAclAuthorizer --authorizer-

properties zookeeper.connect=192.168.100.110:2181 --add --allow-principal User:consumer --operation Read --group test-group#拉取消息

kafka-console-consumer.sh --bootstrap-server 192.168.100.112:9092,192.168.100.110:9092,192.168.100.111:9092

--topic test1 --from-beginning --consumer.config

/path-to-kafka/config/consumer.conf --group test-group

hello

World相关文章:

Apache zookeeper kafka 开启SASL安全认证 —— 筑梦之路

简介 Kafka是一个高吞吐量、分布式的发布-订阅消息系统。Kafka核心模块使用Scala语言开发,支持多语言(如Java、Python、Go等)客户端,它可以水平扩展和具有高吞吐量特性而被广泛使用,并与多类开源分布式处理系统进行集成…...

lintcode 1017 · 相似的RGB颜色【进制计算】

题目链接,题目描述 https://www.lintcode.com/problem/1017 在本题中,每个大写字母代表从“0”到“f”的一些十六进制数字。红绿蓝三元色#AABBCC可以简写为#ABC。 例如,#15c是颜色#1155cc的简写。现在,定义两种颜色#ABCDEF和#UV…...

全国首台!浙江机器人产业集团发布垂起固定翼无人机-机器人自动换电机巢

展示突破性创新技术,共话行业发展趋势。8月25日,全国首台垂起固定翼无人机-机器人自动换电机巢新品发布会暨“科创中国宁波”无人机产业趋势分享会在余姚市机器人小镇成功举行。 本次活动在宁波市科学技术协会、余姚市科学技术协会指导下,由浙…...

采用 UML 对软件系统进行建模的基本框架

UML 包括一些可以相互组合为图标的图形元素, 通过提供不同形式的图形来 表述从软件分析开始的软件开发全过程的描述,一个图就是系统架构在某个侧面的 表示,所有的图组成了系统的完整视图。UML 主要提供了以下五类图: ÿ…...

编译tiny4412 Linux 内核

工作环境 Ubuntu 22 交叉编译器 4.5.1 解压Linux内核源码,进入目录 将官方配置完好的defconfig文件作为配置文件 cp tiny4412_linux_defconfig .config由于内核版本较低,需要下载低版本的gcc,选择下载gcc-9与g9 sudo apt install gcc-9 g-…...

Ubuntu22.04安装中文输入法►由踩坑到上岸版◄

Ubuntu22.04安装中文输入法►由踩坑到上岸版◄ 了解入坑上岸 更新一发:Gedit中文乱码问题的解决 为了方便回忆和记录甚至后面继续重装系统,我还是写一下以便将来用到或参考~ 了解 安装Ubuntu22.04(截至2023年08月26日11ÿ…...

SpringBoot简单上手

spring boot 是spring快速开发脚手架,通过约定大于配置,优化了混乱的依赖管理,和复杂的配置,让我们用java-jar方式,运行启动java web项目 入门案例 创建工程 先创建一个空的工程 创建一个名为demo_project的项目,并且…...

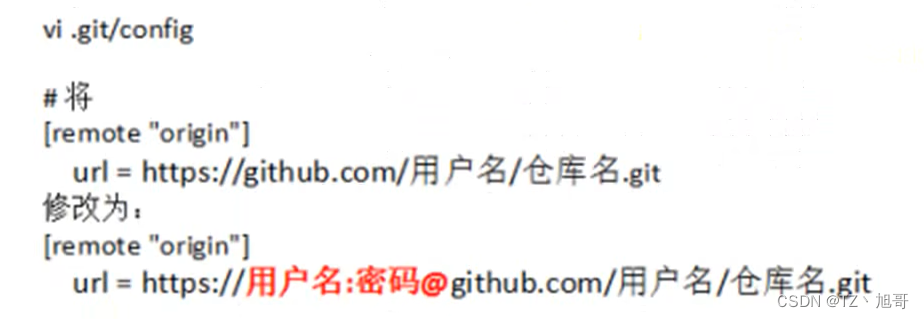

git及GitHub的使用

文章目录 git在本地仓库的使用github使用创建仓库https协议连接(不推荐,现在用起来比较麻烦)ssh连接(推荐)git分支操作冲突处理忽略文件 git在本地仓库的使用 1.在目标目录下右键打开git bash here 2.创建用户名和邮箱(注: 下载完…...

【考研数学】线性代数第四章 —— 线性方程组(1,基本概念 | 基本定理 | 解的结构)

文章目录 引言一、线性方程组的基本概念与表达形式二、线性方程组解的基本定理三、线性方程组解的结构写在最后 引言 继向量的学习后,一鼓作气,把线性方程组也解决了去。O.O 一、线性方程组的基本概念与表达形式 方程组 称为 n n n 元齐次线性方程组…...

使用Python写入数据到Excel:实战指南

在数据科学领域,Excel是一种广泛使用的电子表格工具,可以方便地进行数据管理和分析。然而,当数据规模较大或需要自动化处理时,手动操作Excel可能会变得繁琐。此时,使用Python编写程序将数据写入Excel文件是一个高效且便…...

接口测试总结分享(http与rpc)

接口测试是测试系统组件间接口的一种测试。接口测试主要用于检测外部系统与系统之间以及内部各个子系统之间的交互点。测试的重点是要检查数据的交换,传递和控制管理过程,以及系统间的相互逻辑依赖关系等。 一、了解一下HTTP与RPC 1. HTTP(H…...

数据结构(Java实现)LinkedList与链表(下)

** ** 结论 让一个指针从链表起始位置开始遍历链表,同时让一个指针从判环时相遇点的位置开始绕环运行,两个指针都是每次均走一步,最终肯定会在入口点的位置相遇。 LinkedList的模拟实现 单个节点的实现 尾插 运行结果如下: 也…...

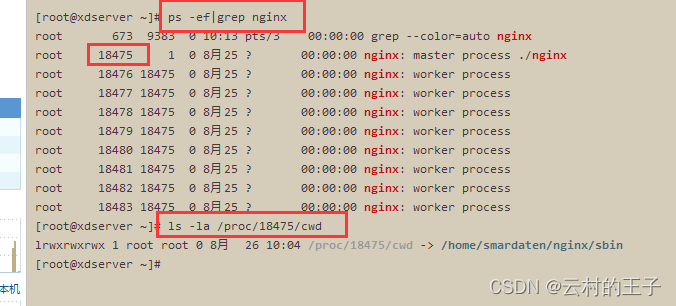

linux查看正在运行的nginx在哪个文件夹当中

1、查出Nginx进程PID ps -ef|grep nginx2、查看Nginx进程启动时的工作目录 ls -la /proc/<PID>/cwd将<PID>替换为第一步中列出的Nginx进程的PID。该命令会显示Nginx进程在启动时所在的工作目录(当前工作目录)...

Vue实现Excel表格中按钮增加小数位数,减少小数位数功能,多用于处理金融数据

效果图 <template><div><el-button click"increaseDecimals">A按钮</el-button><el-button click"roundNumber">B按钮</el-button><el-table :data"tableData" border><el-table-column v-for&q…...

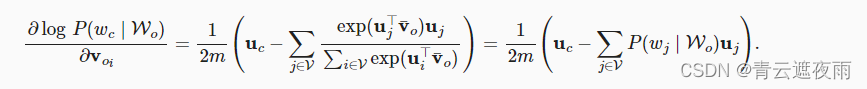

自然语言处理(一):词嵌入

词嵌入 词嵌入(Word Embedding)是自然语言处理(NLP)中的一种技术,用于将文本中的单词映射到一个低维向量空间中。它是将文本中的单词表示为实数值向量的一种方式。 在传统的文本处理中,通常使用独热编码&…...

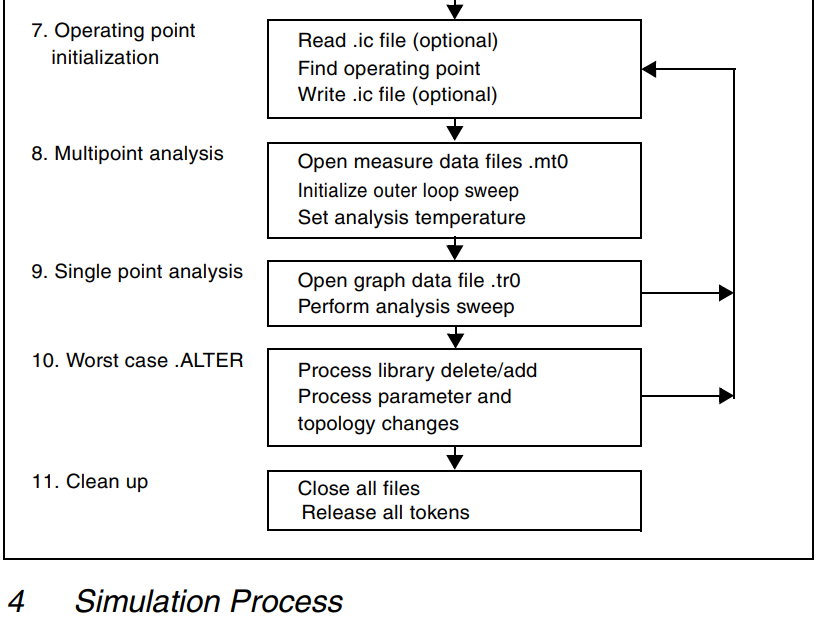

【HSPCIE仿真】HSPICE仿真基础

HSPICE概述 1. HSPICE简介3. 标准输入文件4. 标准输出文件3. HSPCIE仿真过程 1. HSPICE简介 SPICE (Simulation Program with IC Emphasis)是1972 年美国加利福尼亚大学柏克莱分校电机工程和计算机科学系开发 的用于集成电路性能分析的电路模拟程序。 …...

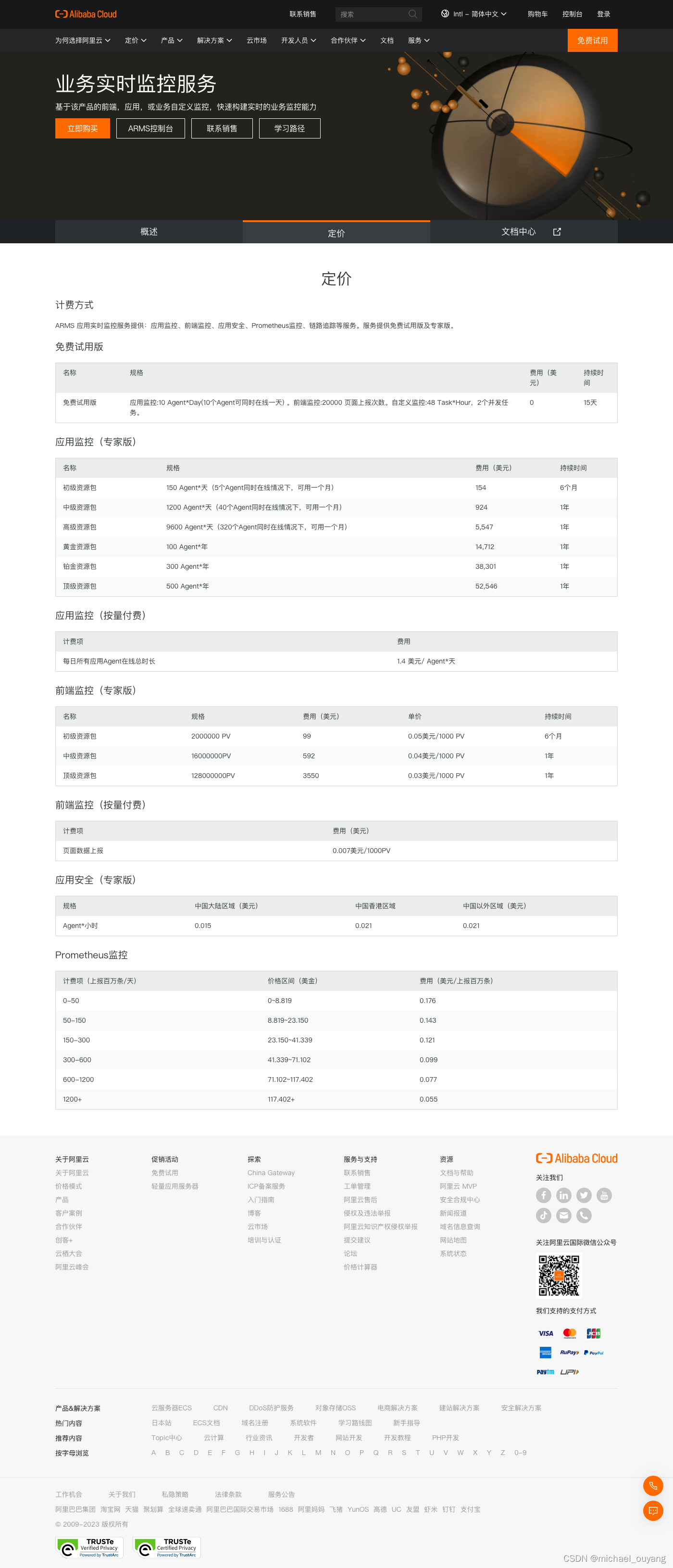

二、前端监控之方案调研

前端监控体系 一个完整的前端监控体系包括了日志采集、日志上报、日志存储、日志切分&计算、数据分析、告警等流程。 对于一名前端开发工程师来说,也就意味着工作不再局限于前端业务的开发工作,需要有Nginx服务运维能力、实时/离线分析能力、Node应…...

npm 创建 node.js 项目

package.json重要说明 package.json是创建任何node.js项目必须要有的一个文件。 因为在package.json文件中,有详细的项目描述, 包括: (1)项目名称:name (2)版本:version (3)依赖文件:dependencies 等…...

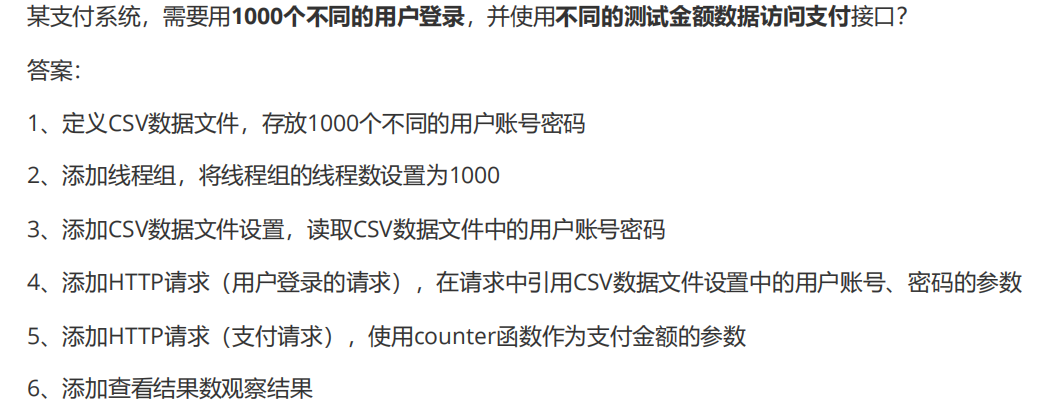

JMeter性能测试(上)

一、基础简介 界面 打开方式 双击 jmeter.bat双击 ApacheJMeter.jsr命令行输入 java -jar ApacheJMeter.jar 目录 BIN 目录:存放可执行文件和配置文件 docs目录:api文档,用于开发扩展组件 printable-docs目录:用户帮助手册 li…...

自定义date工具类 DateUtils.java

自定义date工具类 DateUtils.java 简介 Date日期类型的工具类。 api 日期格式化 format(Date date);日期格式化 format(Date date, String pattern);计算距离现在多久,非精确 getTimeBefore(Date date);计算距离现在多久,精确…...

SpringBoot-17-MyBatis动态SQL标签之常用标签

文章目录 1 代码1.1 实体User.java1.2 接口UserMapper.java1.3 映射UserMapper.xml1.3.1 标签if1.3.2 标签if和where1.3.3 标签choose和when和otherwise1.4 UserController.java2 常用动态SQL标签2.1 标签set2.1.1 UserMapper.java2.1.2 UserMapper.xml2.1.3 UserController.ja…...

AI-调查研究-01-正念冥想有用吗?对健康的影响及科学指南

点一下关注吧!!!非常感谢!!持续更新!!! 🚀 AI篇持续更新中!(长期更新) 目前2025年06月05日更新到: AI炼丹日志-28 - Aud…...

.Net框架,除了EF还有很多很多......

文章目录 1. 引言2. Dapper2.1 概述与设计原理2.2 核心功能与代码示例基本查询多映射查询存储过程调用 2.3 性能优化原理2.4 适用场景 3. NHibernate3.1 概述与架构设计3.2 映射配置示例Fluent映射XML映射 3.3 查询示例HQL查询Criteria APILINQ提供程序 3.4 高级特性3.5 适用场…...

大型活动交通拥堵治理的视觉算法应用

大型活动下智慧交通的视觉分析应用 一、背景与挑战 大型活动(如演唱会、马拉松赛事、高考中考等)期间,城市交通面临瞬时人流车流激增、传统摄像头模糊、交通拥堵识别滞后等问题。以演唱会为例,暖城商圈曾因观众集中离场导致周边…...

DAY 47

三、通道注意力 3.1 通道注意力的定义 # 新增:通道注意力模块(SE模块) class ChannelAttention(nn.Module):"""通道注意力模块(Squeeze-and-Excitation)"""def __init__(self, in_channels, reduction_rat…...

Opencv中的addweighted函数

一.addweighted函数作用 addweighted()是OpenCV库中用于图像处理的函数,主要功能是将两个输入图像(尺寸和类型相同)按照指定的权重进行加权叠加(图像融合),并添加一个标量值&#x…...

如何将联系人从 iPhone 转移到 Android

从 iPhone 换到 Android 手机时,你可能需要保留重要的数据,例如通讯录。好在,将通讯录从 iPhone 转移到 Android 手机非常简单,你可以从本文中学习 6 种可靠的方法,确保随时保持连接,不错过任何信息。 第 1…...

uniapp微信小程序视频实时流+pc端预览方案

方案类型技术实现是否免费优点缺点适用场景延迟范围开发复杂度WebSocket图片帧定时拍照Base64传输✅ 完全免费无需服务器 纯前端实现高延迟高流量 帧率极低个人demo测试 超低频监控500ms-2s⭐⭐RTMP推流TRTC/即构SDK推流❌ 付费方案 (部分有免费额度&#x…...

NLP学习路线图(二十三):长短期记忆网络(LSTM)

在自然语言处理(NLP)领域,我们时刻面临着处理序列数据的核心挑战。无论是理解句子的结构、分析文本的情感,还是实现语言的翻译,都需要模型能够捕捉词语之间依时序产生的复杂依赖关系。传统的神经网络结构在处理这种序列依赖时显得力不从心,而循环神经网络(RNN) 曾被视为…...

使用 SymPy 进行向量和矩阵的高级操作

在科学计算和工程领域,向量和矩阵操作是解决问题的核心技能之一。Python 的 SymPy 库提供了强大的符号计算功能,能够高效地处理向量和矩阵的各种操作。本文将深入探讨如何使用 SymPy 进行向量和矩阵的创建、合并以及维度拓展等操作,并通过具体…...