【HuggingFace】Transformers(V4.34.0 稳定)支持的模型

Transformer 4.43.40 版本是自然语言处理领域的一个重要工具包,为开发者提供了丰富的预训练模型资源,可以用于各种文本处理任务。在这个版本中,Transformer 支持了众多模型,每个模型都具有不同的优势和适用领域。下面是一个 Transformer 4.43.40 版本所支持的所有模型的目录,让您能够更好地了解这一工具包的功能和用途。

🚗🚓🚕🛺🚙🛻🚌🚐🚎🚑🚒🚚🚗🚓🚕🛺🚙🛻🚌🚐🚎🚑🚒🚚

- ALBERT(来自Google研究和芝加哥丰田技术研究所)与论文ALBERT:轻量级BERT用于自监督学习语言表示一起发布,作者为Zhenzhong Lan,Mingda Chen,Sebastian Goodman,Kevin Gimpel,Piyush Sharma,Radu Soricut。

- AltCLIP(来自BAAI)与Chen、Zhongzhi和Liu、Guang和Zhang、Bo-Wen和Ye、Fulong和Yang、Qinghong和Wu、Ledell的论文AltCLIP:修改CLIP中的语言编码器以扩展语言能力一起发布。

- Audio Spectrogram Transformer(来自MIT)与论文AST:Audio Spectrogram Transformer by Yuan Gong,Yu-An Chung,James Glass一起发布。

- BART(来自Facebook)与论文BART:Denoising Sequence-to-Sequence Pre-training for Natural Language Generation,Translation,and Comprehension by Mike Lewis,Yinhan Liu,Naman Goyal,Marjan Ghazvininejad,Abdelrahman Mohamed,Omer Levy,Ves Stoyanov和Luke Zettlemoyer一起发布。

- BARThez(来自École polytechnique)与论文BARThez:a Skilled Pretrained French Sequence-to-Sequence Model by Moussa Kamal Eddine,Antoine J.-P. Tixier,Michalis Vazirgiannis一起发布。

- BARTpho(来自VinAI Research)与论文BARTpho:Pre-trained Sequence-to-Sequence Models for Vietnamese by Nguyen Luong Tran,Duong Minh Le和Dat Quoc Nguyen一起发布。

- BEiT(来自Microsoft)与论文BEiT:BERT Pre-Training of Image Transformers by Hangbo Bao,Li Dong,Furu Wei一起发布。

- BERT(来自Google)与论文BERT:Pre-training of Deep Bidirectional Transformers for Language Understanding by Jacob Devlin,Ming-Wei Chang,Kenton Lee和Kristina Toutanova一起发布。

- BERT For Sequence Generation(来自Google)与论文Leveraging Pre-trained Checkpoints for Sequence Generation Tasks by Sascha Rothe,Shashi Narayan,Aliaksei Severyn一起发布。

- BERTweet(来自VinAI Research)与论文BERTweet:A pre-trained language model for English Tweets by Dat Quoc Nguyen,Thanh Vu和Anh Tuan Nguyen一起发布。

- BigBird-Pegasus(来自Google Research)与论文Big Bird:Transformers for Longer Sequences by Manzil Zaheer,Guru Guruganesh,Avinava Dubey,Joshua Ainslie,Chris Alberti,Santiago Ontanon,Philip Pham,Anirudh Ravula,Qifan Wang,Li Yang,Amr Ahmed一起发布。

- BigBird-RoBERTa(来自Google Research)与论文Big Bird:Transformers for Longer Sequences by Manzil Zaheer,Guru Guruganesh,Avinava Dubey,Joshua Ainslie,Chris Alberti,Santiago Ontanon,Philip Pham,Anirudh Ravula,Qifan Wang,Li Yang,Amr Ahmed一起发布。

- BioGpt(来自Microsoft Research AI4Science)与论文BioGPT:generative pre-trained transformer for biomedical text generation and mining by Renqian Luo,Liai Sun,Yingce Xia,Tao Qin,Sheng Zhang,Hoifung Poon和Tie-Yan Liu一起发布。

- BiT(来自Google AI)与论文Big Transfer(BiT):General Visual Representation Learning by Alexander Kolesnikov,Lucas Beyer,Xiaohua Zhai,Joan Puigcerver,Jessica Yung,Sylvain Gelly,Neil Houlsby一起发布。

- Blenderbot(来自Facebook)与论文Recipes for building an open-domain chatbot by Stephen Roller,Emily Dinan,Naman Goyal,Da Ju,Mary Williamson,Yinhan Liu,Jing Xu,Myle Ott,Kurt Shuster,Eric M. Smith,Y-Lan Boureau,Jason Weston一起发布。

- BlenderbotSmall(来自Facebook)与论文Recipes for building an open-domain chatbot by Stephen Roller,Emily Dinan,Naman Goyal,Da Ju,Mary Williamson,Yinhan Liu,Jing Xu,Myle Ott,Kurt Shuster,Eric M. Smith,Y-Lan Boureau,Jason Weston一起发布。

- BLIP(来自Salesforce)与论文BLIP:Bootstrapping Language-Image Pre-training for Unified Vision-Language Understanding and Generation by Junnan Li,Dongxu Li,Caiming Xiong,Steven Hoi一起发布。

- BLOOM(来自BigScience workshop)由BigScience Workshop发布。

- BORT(来自Alexa)与论文Optimal Subarchitecture Extraction For BERT by Adrian de Wynter and Daniel J. Perry一起发布。

- ByT5(来自Google Research)与论文ByT5:Towards a token-free future with pre-trained byte-to-byte models by Linting Xue,Aditya Barua,Noah Constant,Rami Al-Rfou,Sharan Narang,Mihir Kale,Adam Roberts,Colin Raffel一起发布。

- CamemBERT(来自Inria/Facebook/Sorbonne)与论文CamemBERT:a Tasty French Language Model by Louis Martin,Benjamin Muller,Pedro Javier Ortiz Suárez*,Yoann Dupont,Laurent Romary,Éric Villemonte de la Clergerie,Djamé Seddah和Benoît Sagot一起发布。

- CANINE(来自Google Research)与论文CANINE:Pre-training an Efficient Tokenization-Free Encoder for Language Representation by Jonathan H. Clark,Dan Garrette,Iulia Turc,John Wieting一起发布。

- Chinese-CLIP(来自OFA-Sys)与论文Chinese CLIP:Contrastive Vision-Language Pretraining in Chinese by An Yang,Junshu Pan,Junyang Lin,Rui Men,Yichang Zhang,Jingren Zhou和Chang Zhou一起发布。

- CLIP(来自OpenAI)与论文Learning Transferable Visual Models From Natural Language Supervision by Alec Radford,Jong Wook Kim,Chris Hallacy,Aditya Ramesh,Gabriel Goh,Sandhini Agarwal,Girish Sastry,Amanda Askell,Pamela Mishkin,Jack Clark,Gretchen Krueger,Ilya Sutskever一起发布。

- CLIPSeg(来自Göttingen大学)与论文Image Segmentation Using Text and Image Prompts by Timo Lüddecke and Alexander Ecker一起发布。

- CodeGen(来自Salesforce)与论文A Conversational Paradigm for Program Synthesis by Erik Nijkamp,Bo Pang,Hiroaki Hayashi,Lifu Tu,Huan Wang,Yingbo Zhou,Silvio Savarese,Caiming Xiong一起发布。

- Conditional DETR(来自Microsoft Research Asia)与论文Conditional DETR for Fast Training Convergence by Depu Meng,Xiaokang Chen,Zejia Fan,Gang Zeng,Houqiang Li,Yuhui Yuan,Lei Sun,Jingdong Wang一起发布。

- ConvBERT(来自YituTech)与论文ConvBERT:Improving BERT with Span-based Dynamic Convolution by Zihang Jiang,Weihao Yu,Daquan Zhou,Yunpeng Chen,Jiashi Feng,Shuicheng Yan一起发布。

- ConvNeXT(来自Facebook AI)与论文A ConvNet for the 2020s by Zhuang Liu,Hanzi Mao,Chao-Yuan Wu,Christoph Feichtenhofer,Trevor Darrell,Saining Xie一起发布。

- ConvNeXTV2(来自Facebook AI)与论文ConvNeXt V2:Co-designing and Scaling ConvNets with Masked Autoencoders by Sanghyun Woo,Shoubhik Debnath,Ronghang Hu,Xinlei Chen,Zhuang Liu,In So Kweon,Saining Xie一起发布。

- CPM(来自清华大学)与论文CPM:A Large-scale Generative Chinese Pre-trained Language Model by Zhengyan Zhang, Xu Han, Hao Zhou, Pei Ke, Yuxian Gu, Deming Ye, Yujia Qin, Yusheng Su, Haozhe Ji, Jian Guan, Fanchao Qi, Xiaozhi Wang, Yanan Zheng, Guoyang Zeng, Huanqi Cao, Shengqi Chen, Daixuan Li, Zhenbo Sun, Zhiyuan Liu, Minlie Huang, Wentao Han, Jie Tang, Juanzi Li, Xiaoyan Zhu, Maosong Sun一起发布。

- CTRL(来自Salesforce)与论文CTRL:A Conditional Transformer Language Model for Controllable Generation by Nitish Shirish Keskar, Bryan McCann, Lav R. Varshney, Caiming Xiong and Richard Socher一起发布。

- CvT(来自Microsoft)与论文CvT:Introducing Convolutions to Vision Transformers by Haiping Wu, Bin Xiao, Noel Codella, Mengchen Liu, Xiyang Dai, Lu Yuan, Lei Zhang一起发布。

- Data2Vec(来自Facebook)与论文Data2Vec:A General Framework for Self-supervised Learning in Speech, Vision and Language by Alexei Baevski, Wei-Ning Hsu, Qiantong Xu, Arun Babu, Jiatao Gu, Michael Auli一起发布。

- DeBERTa(来自Microsoft)与论文DeBERTa:Decoding-enhanced BERT with Disentangled Attention by Pengcheng He, Xiaodong Liu, Jianfeng Gao, Weizhu Chen一起发布。

- DeBERTa-v2(来自Microsoft)与论文DeBERTa:Decoding-enhanced BERT with Disentangled Attention by Pengcheng He,Xiaodong Liu,Jianfeng Gao,Weizhu Chen一起发布。

- Decision Transformer(来自Berkeley/Facebook/Google)与论文Decision Transformer:Reinforcement Learning via Sequence Modeling by Lili Chen,Kevin Lu,Aravind Rajeswaran,Kimin Lee,Aditya Grover,Michael Laskin,Pieter Abbeel,Aravind Srinivas,Igor Mordatch一起发布。

- Deformable DETR(来自SenseTime Research)与论文Deformable DETR:Deformable Transformers for End-to-End Object Detection by Xizhou Zhu,Weijie Su,Lewei Lu,Bin Li,Xiaogang Wang,Jifeng Dai一起发布。

- DeiT(来自Facebook)与论文Training data-efficient image transformers & distillation through attention by Hugo Touvron,Matthieu Cord,Matthijs Douze,Francisco Massa,Alexandre Sablayrolles,Hervé Jégou一起发布。

- DETR(来自Facebook)与论文End-to-End Object Detection with Transformers by Nicolas Carion,Francisco Massa,Gabriel Synnaeve,Nicolas Usunier,Alexander Kirillov,Sergey Zagoruyko一起发布。

- DialoGPT(来自Microsoft Research)与论文DialoGPT:Large-Scale Generative Pre-training for Conversational Response Generation by Yizhe Zhang,Siqi Sun,Michel Galley,Yen-Chun Chen,Chris Brockett,Xiang Gao,Jianfeng Gao,Jingjing Liu,Bill Dolan一起发布。

- DiNAT(来自SHI Labs)与论文Dilated Neighborhood Attention Transformer by Ali Hassani and Humphrey Shi一起发布。

- DistilBERT(来自HuggingFace),与论文DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter by Victor Sanh, Lysandre Debut and Thomas Wolf 一起发布。该方法也被应用于将GPT2压缩为DistilGPT2、RoBERTa压缩为DistilRoBERTa、Multilingual BERT压缩为DistilmBERT以及德语版本的DistilBERT。

- DiT(来自Microsoft Research)与论文DiT: Self-supervised Pre-training for Document Image Transformer by Junlong Li, Yiheng Xu, Tengchao Lv, Lei Cui, Cha Zhang, Furu Wei一起发布。

- Donut(来自NAVER),与论文OCR-free Document Understanding Transformer by Geewook Kim, Teakgyu Hong, Moonbin Yim, Jeongyeon Nam, Jinyoung Park, Jinyeong Yim, Wonseok Hwang, Sangdoo Yun, Dongyoon Han, Seunghyun Park一起发布。

- DPR(来自Facebook)与论文Dense Passage Retrieval for Open-Domain Question Answering by Vladimir Karpukhin,Barlas Oğuz,Sewon Min,Patrick Lewis,Ledell Wu,Sergey Edunov,Danqi Chen和Wen-tau Yih一起发布。

- DPT(来自Intel Labs)与论文Vision Transformers for Dense Prediction by René Ranftl,Alexey Bochkovskiy,Vladlen Koltun一起发布。

- ELECTRA(来自Google Research/Stanford University)与论文ELECTRA:Pre-training text encoders as discriminators rather than generators by Kevin Clark,Minh-Thang Luong,Quoc V. Le,Christopher D. Manning一起发布。

- EncoderDecoder(来自Google Research)与论文Leveraging Pre-trained Checkpoints for Sequence Generation Tasks by Sascha Rothe,Shashi Narayan,Aliaksei Severyn一起发布。

- ERNIE(来自Baidu)与论文ERNIE:Enhanced Representation through Knowledge Integration by Yu Sun,Shuohuan Wang,Yukun Li,Shikun Feng,Xuyi Chen,Han Zhang,Xin Tian,Danxiang Zhu,Hao Tian,Hua Wu一起发布。

- ESM(来自Meta AI)是transformer蛋白质语言模型。ESM-1b与论文Biological structure and function emerge from scaling unsupervised learning to 250 million protein sequences by Alexander Rives,Joshua Meier,Tom Sercu,Siddharth Goyal,Zeming Lin,Jason Liu,Demi Guo,Myle Ott,C. Lawrence Zitnick,Jerry Ma和Rob Fergus一起发布。ESM-1v与论文Language models enable zero-shot prediction of the effects of mutations on protein function by Joshua Meier,Roshan Rao,Robert Verkuil,Jason Liu,Tom Sercu和Alexander Rives一起发布。ESM-2和ESMFold与论文Language models of protein sequences at the scale of evolution enable accurate structure prediction by Zeming Lin,Halil Akin,Roshan Rao,Brian Hie,Zhongkai Zhu,Wenting Lu,Allan dos Santos Costa,Maryam Fazel-Zarandi,Tom Sercu,Sal Candido和Alexander Rives一起发布。

- FLAN-T5(来自Google AI)在google-research/t5x库中发布。作者包括Hyung Won Chung,Le Hou,Shayne Longpre,Barret Zoph,Yi Tay,William Fedus,Eric Li,Xuezhi Wang,Mostafa Dehghani,Siddhartha Brahma,Albert Webson,Shixiang Shane Gu,Zhuyun Dai,Mirac Suzgun,Xinyun Chen,Aakanksha Chowdhery,Sharan Narang,Gaurav Mishra,Adams Yu,Vincent Zhao,Yanping Huang,Andrew Dai,Hongkun Yu,Slav Petrov,Ed H. Chi,Jeff Dean,Jacob Devlin,Adam Roberts,Denny Zhou,Quoc V. Le和Jason Wei。

- FlauBERT(来自CNRS)与论文FlauBERT:Unsupervised Language Model Pre-training for French by Hang Le,Loïc Vial,Jibril Frej,Vincent Segonne,Maximin Coavoux,Benjamin Lecouteux,Alexandre Allauzen,Benoît Crabbé,Laurent Besacier和Didier Schwab一起发布。

- FLAVA(来自Facebook AI)与论文FLAVA:A Foundational Language And Vision Alignment Model by Amanpreet Singh,Ronghang Hu,Vedanuj Goswami,Guillaume Couairon,Wojciech Galuba,Marcus Rohrbach和Douwe Kiela一起发布。

- FNet(来自Google Research)与论文FNet:Mixing Tokens with Fourier Transforms by James Lee-Thorp, Joshua Ainslie, Ilya Eckstein, Santiago Ontanon一起发布。

- Funnel Transformer(来自CMU/Google Brain)与论文Funnel-Transformer: Filtering out Sequential Redundancy for Efficient Language Processing by Zihang Dai,Guokun Lai,Yiming Yang,Quoc V. Le一起发布。

- GIT(来自Microsoft Research)与论文GIT: A Generative Image-to-text Transformer for Vision and Language by Jianfeng Wang,Zhengyuan Yang,Xiaowei Hu,Linjie Li,Kevin Lin,Zhe Gan,Zicheng Liu,Ce Liu,Lijuan Wang一起发布。

- GLPN(来自KAIST)与论文Global-Local Path Networks for Monocular Depth Estimation with Vertical CutDepth by Doyeon Kim,Woonghyun Ga,Pyungwhan Ahn,Donggyu Joo,Sehwan Chun,Junmo Kim一起发布。

- GPT(来自OpenAI)与论文Improving Language Understanding by Generative Pre-Training by Alec Radford,Karthik Narasimhan,Tim Salimans和Ilya Sutskever一起发布。

- GPT Neo(来自EleutherAI)在存储库EleutherAI/gpt-neo中发布,作者为Sid Black,Stella Biderman,Leo Gao,Phil Wang和Connor Leahy。

- GPT NeoX(来自EleutherAI)与论文GPT-NeoX-20B: An Open-Source Autoregressive Language Model by Sid Black,Stella Biderman,Eric Hallahan,Quentin Anthony,Leo Gao,Laurence Golding,Horace He,Connor Leahy,Kyle McDonell,Jason Phang,Michael Pieler,USVSN Sai Prashanth,Shivanshu Purohit,Laria Reynolds,Jonathan Tow,Ben Wang和Samuel Weinbach一起发布

- GPT NeoX Japanese(来自ABEJA)由Shinya Otani、Takayoshi Makabe、Anuj Arora和Kyo Hattori发布。

- GPT-2(来自OpenAI)与论文Language Models are Unsupervised Multitask Learners by Alec Radford、Jeffrey Wu、Rewon Child、David Luan、Dario Amodei和Ilya Sutskever一起发布。

- GPT-J(来自EleutherAI)在存储库kingoflolz/mesh-transformer-jax中发布,作者为Ben Wang和Aran Komatsuzaki。

- GPT-Sw3(来自AI-Sweden)与论文Lessons Learned from GPT-SW3: Building the First Large-Scale Generative Language Model for Swedish by Ariel Ekgren、Amaru Cuba Gyllensten、Evangelia Gogoulou、Alice Heiman、Severine Verlinden、Joey Öhman、Fredrik Carlsson、Magnus Sahlgren一起发布。

- GroupViT(来自UCSD、NVIDIA)与论文GroupViT: Semantic Segmentation Emerges from Text Supervision by Jiarui Xu、Shalini De Mello、Sifei Liu、Wonmin Byeon、Thomas Breuel、Jan Kautz、Xiaolong Wang一起发布。

- Hubert(来自Facebook)与论文HuBERT: Self-Supervised Speech Representation Learning by Masked Prediction of Hidden Units by Wei-Ning Hsu、Benjamin Bolte、Yao-Hung Hubert Tsai、Kushal Lakhotia、Ruslan Salakhutdinov、Abdelrahman Mohamed一起发布。

- I-BERT(来自伯克利)与论文I-BERT: Integer-only BERT Quantization by Sehoon Kim、Amir Gholami、Zhewei Yao、Michael W. Mahoney、Kurt Keutzer一起发布。

- ImageGPT(来自OpenAI)与论文Generative Pretraining from Pixels by Mark Chen、Alec Radford、Rewon Child、Jeffrey Wu、Heewoo Jun、David Luan、Ilya Sutskever一起发布。

- Jukebox(来自OpenAI)与论文Jukebox: A Generative Model for Music by Prafulla Dhariwal、Heewoo Jun、Christine Payne、Jong Wook Kim、Alec Radford、Ilya Sutskever一起发布。

- LayoutLM(来自Microsoft Research Asia)与论文LayoutLM:文档图像理解的文本和布局预训练,作者为Yiheng Xu,Minghao Li,Lei Cui,Shaohan Huang,Furu Wei和Ming Zhou。

- LayoutLMv2(来自Microsoft Research Asia)与论文LayoutLMv2:用于视觉丰富文档理解的多模式预训练,作者为Yang Xu,Yiheng Xu,Tengchao Lv,Lei Cui,Furu Wei,Guoxin Wang,Yijuan Lu,Dinei Florencio,Cha Zhang,Wanxiang Che,Min Zhang和Lidong Zhou。

- LayoutLMv3(来自Microsoft Research Asia)与论文LayoutLMv3:使用统一文本和图像蒙版的文档AI预训练,作者为Yupan Huang,Tengchao Lv,Lei Cui,Yutong Lu和Furu Wei。

- LayoutXLM(来自Microsoft Research Asia)与论文LayoutXLM:用于多语言视觉丰富文档理解的多模式预训练,作者为Yiheng Xu,Tengchao Lv,Lei Cui,Guoxin Wang,Yijuan Lu,Dinei Florencio,Cha Zhang和Furu Wei。

- LED(来自AllenAI)与论文Longformer:长文档transformer,作者为Iz Beltagy,Matthew E. Peters和Arman Cohan。

- LeViT(来自Meta AI)与论文LeViT:ConvNet中的视觉变压器以实现更快的推理,作者为Ben Graham,Alaaeldin El-Nouby,Hugo Touvron,Pierre Stock,Armand Joulin,Hervé Jégou和Matthijs Douze。

- LiLT(来自华南理工大学)与论文LiLT:用于结构化文档理解的简单而有效的语言无关布局transformer,作者为Jiapeng Wang,Lianwen Jin和Kai Ding。

- Longformer(来自AllenAI)与论文Longformer:长文档transformer,作者为Iz Beltagy,Matthew E. Peters和Arman Cohan。

- LongT5(来自Google AI)与论文LongT5:用于长序列的高效文本到文本transformer,作者为Mandy Guo、Joshua Ainslie、David Uthus、Santiago Ontanon、Jianmo Ni、Yun-Hsuan Sung和Yinfei Yang。

- LUKE(来自Studio Ousia)与论文LUKE:具有实体感知自我注意力的深度上下文化实体表示,作者为Ikuya Yamada、Akari Asai、Hiroyuki Shindo、Hideaki Takeda和Yuji Matsumoto。

- LXMERT(来自UNC Chapel Hill)与论文LXMERT:从变压器中学习跨模态编码器表示以用于开放域问答,作者为Hao Tan和Mohit Bansal。

- M-CTC-T(来自Facebook)与论文Pseudo-Labeling For Massively Multilingual Speech Recognition by Loren Lugosch、Tatiana Likhomanenko、Gabriel Synnaeve和Ronan Collobert。

- M2M100(来自Facebook)与论文Beyond English-Centric Multilingual Machine Translation by Angela Fan、Shruti Bhosale、Holger Schwenk、Zhiyi Ma、Ahmed El-Kishky、Siddharth Goyal、Mandeep Baines、Onur Celebi、Guillaume Wenzek、Vishrav Chaudhary、Naman Goyal、Tom Birch、Vitaliy Liptchinsky、Sergey Edunov、Edouard Grave、Michael Auli和Armand Joulin。

- MarianMT使用OPUS数据训练的机器翻译模型由Jörg Tiedemann开发。Marian框架正在由Microsoft Translator团队开发。

- MarkupLM(来自Microsoft Research Asia)与论文MarkupLM:面向视觉丰富文档理解的文本和标记语言预训练,作者为Junlong Li、Yiheng Xu、Lei Cui和Furu Wei。

- Mask2Former(来自FAIR和UIUC)与论文Masked-attention Mask Transformer for Universal Image Segmentation by Bowen Cheng、Ishan Misra、Alexander G. Schwing、Alexander Kirillov和Rohit Girdhar。

- MaskFormer(来自Meta和UIUC)与论文Per-Pixel Classification is Not All You Need for Semantic Segmentation by Bowen Cheng、Alexander G. Schwing和Alexander Kirillov。

- mBART(来自Facebook)与论文Multilingual Denoising Pre-training for Neural Machine Translation by Yinhan Liu、Jiatao Gu、Naman Goyal、Xian Li、Sergey Edunov、Marjan Ghazvininejad、Mike Lewis、Luke Zettlemoyer。

- mBART-50(来自Facebook)与论文Multilingual Translation with Extensible Multilingual Pretraining and Finetuning by Yuqing Tang、Chau Tran、Xian Li、Peng-Jen Chen、Naman Goyal、Vishrav Chaudhary、Jiatao Gu和Angela Fan。

- Megatron-BERT(来自NVIDIA)与论文Megatron-LM:使用模型并行训练多十亿参数语言模型,作者为Mohammad Shoeybi、Mostofa Patwary、Raul Puri、Patrick LeGresley、Jared Casper和Bryan Catanzaro。

- Megatron-GPT2(来自NVIDIA)与论文Megatron-LM:使用模型并行性训练多十亿参数语言模型,作者为Mohammad Shoeybi,Mostofa Patwary,Raul Puri,Patrick LeGresley,Jared Casper和Bryan Catanzaro。

- mLUKE(来自Studio Ousia)与论文mLUKE:多语言预训练语言模型中实体表示的力量,作者为Ryokan Ri,Ikuya Yamada和Yoshimasa Tsuruoka。

- MobileBERT(来自CMU / Google Brain)与论文MobileBERT:面向资源有限设备的紧凑型任务不可知BERT,作者为Zhiqing Sun,Hongkun Yu,Xiaodan Song,Renjie Liu,Yiming Yang和Denny Zhou。

- MobileNetV1(来自Google Inc.)与论文MobileNets:用于移动视觉应用的高效卷积神经网络,作者为Andrew G. Howard,Menglong Zhu,Bo Chen,Dmitry Kalenichenko,Weijun Wang,Tobias Weyand,Marco Andreetto和Hartwig Adam。

- MobileNetV2(来自Google Inc.)与论文MobileNetV2:倒置残差和线性瓶颈,作者为Mark Sandler,Andrew Howard,Menglong Zhu,Andrey Zhmoginov和Liang-Chieh Chen。

- MobileViT(来自Apple)与论文MobileViT:轻量级、通用且移动友好的视觉变换器,作者为Sachin Mehta和Mohammad Rastegari。

- MPNet(来自Microsoft Research)与论文MPNet:用于语言理解的掩码和排列预训练,作者为Kaitao Song,Xu Tan,Tao Qin,Jianfeng Lu和Tie-Yan Liu。

- MT5(来自Google AI)与论文mT5:大规模多语言预训练文本到文本变换器,作者为Linting Xue,Noah Constant,Adam Roberts,Mihir Kale,Rami Al-Rfou,Aditya Siddhant,Aditya Barua和Colin Raffel。

- MVP(来自RUC AI Box)与论文MVP:用于自然语言生成的多任务监督预训练,作者为Tianyi Tang,Junyi Li,Wayne Xin Zhao和Ji-Rong Wen。

- NAT(来自SHI Labs)与论文Neighborhood Attention Transformer:作者为Ali Hassani、Steven Walton、Jiachen Li、Shen Li和Humphrey Shi。

- Nezha(来自华为诺亚方舟实验室)与论文NEZHA:用于中文语言理解的神经上下文表示,作者为Junqiu Wei,Xiaozhe Ren,Xiaoguang Li,Wenyong Huang,Yi Liao,Yasheng Wang,Jiashu Lin,Xin Jiang,Xiao Chen和Qun Liu。

- NLLB(来自Meta)与论文No Language Left Behind:NLLB团队扩展以人为中心的机器翻译。

- Nyströmformer(来自威斯康星大学 - 麦迪逊分校)与论文Nyströmformer:一种基于Nyström的算法,用于近似自我注意力,作者为Yunyang Xiong,Zhanpeng Zeng,Rudrasis Chakraborty,Mingxing Tan,Glenn Fung,Yin Li和Vikas Singh。

- OPT(来自Meta AI)与论文OPT:开放预训练变换器语言模型,作者为Susan Zhang,Stephen Roller,Naman Goyal,Mikel Artetxe,Moya Chen,Shuohui Chen等。

- OWL-ViT(来自Google AI)与论文Simple Open-Vocabulary Object Detection with Vision Transformers:Matthias Minderer、Alexey Gritsenko、Austin Stone、Maxim Neumann、Dirk Weissenborn、Alexey Dosovitskiy、Aravindh Mahendran、Anurag Arnab、Mostafa Dehghani、Zhuoran Shen、Xiao Wang、Xiaohua Zhai、Thomas Kipf和Neil Houlsby。

- Pegasus(来自Google)与论文PEGASUS:使用提取的间隙句子进行抽象汇总的预训练,作者为Jingqing Zhang、Yao Zhao、Mohammad Saleh和Peter J. Liu。

- PEGASUS-X(来自Google)与论文Investigating Efficiently Extending Transformers for Long Input Summarization:Jason Phang、Yao Zhao和Peter J. Liu。

- Perceiver IO(来自Deepmind)与论文Perceiver IO:用于结构化输入和输出的通用体系结构,作者为Andrew Jaegle、Sebastian Borgeaud、Jean-Baptiste Alayrac、Carl Doersch、Catalin Ionescu、David Ding、Skanda Koppula、Daniel Zoran、Andrew Brock、Evan Shelhamer、Olivier Hénaff、Matthew M. Botvinick、Andrew Zisserman、Oriol Vinyals和João Carreira。

- PhoBERT(来自VinAI Research)与论文PhoBERT:越南语预训练语言模型,作者为Dat Quoc Nguyen和Anh Tuan Nguyen。

- PLBart(来自UCLA NLP)与论文Unified Pre-training for Program Understanding and Generation:Wasi Uddin Ahmad,Saikat Chakraborty,Baishakhi Ray和Kai-Wei Chang。

- PoolFormer(来自Sea AI Labs)与论文MetaFormer is Actually What You Need for Vision,作者为Yu,Weihao和Luo,Mi和Zhou,Pan和Si,Chenyang和Zhou,Yichen和Wang,Xinchao和Feng,Jiashi和Yan,Shuicheng。

- ProphetNet(来自微软研究)与论文ProphetNet:用于序列到序列预训练的预测未来N-gram,作者为Yu Yan,Weizhen Qi,Yeyun Gong,Dayiheng Liu,Nan Duan,Jiusheng Chen,Ruofei Zhang和Ming Zhou。

- QDQBert(来自NVIDIA)与论文用于深度学习推断的整数量化:原理和实证评估,作者为Hao Wu,Patrick Judd,Xiaojie Zhang,Mikhail Isaev和Paulius Micikevicius。

- RAG(来自Facebook)与论文检索增强生成用于知识密集型NLP任务,作者为Patrick Lewis,Ethan Perez,Aleksandara Piktus,Fabio Petroni,Vladimir Karpukhin,Naman Goyal,Heinrich Küttler,Mike Lewis,Wen-tau Yih,Tim Rocktäschel,Sebastian Riedel和Douwe Kiela。

- REALM(来自Google Research)与论文REALM:检索增强语言模型预训练,作者为Kelvin Guu,Kenton Lee,Zora Tung,Panupong Pasupat和Ming-Wei Chang。

- Reformer(来自Google Research)与论文Reformer:高效Transformer,作者为Nikita Kitaev、Łukasz Kaiser、Anselm Levskaya。

- RegNet(来自META Platforms)与论文设计网络设计空间,作者为Ilija Radosavovic、Raj Prateek Kosaraju、Ross Girshick、Kaiming He、Piotr Dollár。

- RemBERT(来自Google Research)与论文在预训练语言模型中重新思考嵌入耦合,作者为Hyung Won Chung、Thibault Févry、Henry Tsai、M. Johnson、Sebastian Ruder。

- ResNet(来自微软研究)与论文Deep Residual Learning for Image Recognition,作者为Kaiming He、Xiangyu Zhang、Shaoqing Ren、Jian Sun。

- RoBERTa(来自Facebook),与论文RoBERTa:一种鲁棒优化的BERT预训练方法一起发布,作者为Yinhan Liu、Myle Ott、Naman Goyal、Jingfei Du、Mandar Joshi、Danqi Chen、Omer Levy、Mike Lewis、Luke Zettlemoyer、Veselin Stoyanov。

- RoBERTa-PreLayerNorm(来自Facebook)与论文fairseq:一种快速、可扩展的序列建模工具包,作者为Myle Ott、Sergey Edunov、Alexei Baevski、Angela Fan、Sam Gross、Nathan Ng、David Grangier和Michael Auli。

- RoCBert(来自WeChatAI)与论文RoCBert:具有多模态对比预训练的鲁棒中文Bert,作者为HuiSu、WeiweiShi、XiaoyuShen、XiaoZhou、TuoJi、JiaruiFang和JieZhou。

- RoFormer(来自ZhuiyiTechnology)与论文RoFormer:具有旋转位置嵌入的增强型Transformer,作者为Jianlin Su、Yu Lu、Shengfeng Pan、Bo Wen和Yunfeng Liu。

- SegFormer(来自NVIDIA)与论文SegFormer:用于语义分割的简单高效Transformer设计,作者为Enze Xie、Wenhai Wang、Zhiding Yu、Anima Anandkumar、Jose M. Alvarez和Ping Luo。

- SEW(来自ASAPP)与论文Performance-Efficiency Trade-offs in Unsupervised Pre-training for Speech Recognition,作者为Felix Wu、Kwangyoun Kim、Jing Pan、Kyu Han、Kilian Q. Weinberger和Yoav Artzi。

- SEW-D(来自ASAPP)与论文Performance-Efficiency Trade-offs in Unsupervised Pre-training for Speech Recognition,作者为Felix Wu、Kwangyoun Kim、Jing Pan、Kyu Han、Kilian Q. Weinberger和Yoav Artzi。

- SpeechToTextTransformer(来自Facebook)与论文fairseq S2T:使用fairseq进行快速语音转文本建模,作者为Changhan Wang、Yun Tang、Xutai Ma、Anne Wu、Dmytro Okhonko和Juan Pino。

- SpeechToTextTransformer2(来自Facebook)与论文用于大规模自监督学习的语音翻译,作者为Changhan Wang、Anne Wu、Juan Pino、Alexei Baevski、Michael Auli和Alexis Conneau。

- Splinter(来自特拉维夫大学)与论文Few-Shot Question Answering by Pretraining Span Selection,作者为Ori Ram、Yuval Kirstain、Jonathan Berant、Amir Globerson和Omer Levy。

- SqueezeBERT(来自伯克利)与论文SqueezeBERT:计算机视觉如何教NLP高效神经网络?作者为Forrest N. Iandola、Albert E. Shaw、Ravi Krishna和Kurt W. Keutzer。

- Swin Transformer(来自微软)与论文Swin Transformer:使用移动窗口的分层视觉Transformer,作者为Ze Liu、Yutong Lin、Yue Cao、Han Hu、Yixuan Wei、Zheng Zhang、Stephen Lin和Baining Guo。

- Swin Transformer V2(来自微软)与论文Swin Transformer V2:通过Ze Liu、Han Hu、Yutong Lin、Zhuliang Yao、Zhenda Xie、Yixuan Wei、Jia Ning、Yue Cao、Zheng Zhang、Li Dong、Furu Wei和Baining Guo扩展容量和分辨率。

- Swin2SR(来自Würzburg大学)与论文Swin2SR:用于压缩图像超分辨率和恢复的SwinV2 Transformer,作者为Marcos V. Conde、Ui-Jin Choi、Maxime Burchi和Radu Timofte。

- SwitchTransformers(来自Google)与论文Switch Transformers:使用简单高效的稀疏性扩展到万亿参数模型的规模,作者为William Fedus、Barret Zoph和Noam Shazeer。

- T5(来自Google AI)与论文探索统一的文本到文本Transformer的迁移学习极限,作者为Colin Raffel、Noam Shazeer、Adam Roberts、Katherine Lee、Sharan Narang、Michael Matena、Yanqi Zhou、Wei Li和Peter J. Liu。

- T5v1.1(来自Google AI)发布在google-research/text-to-text-transfer-transformer存储库中,作者为Colin Raffel、Noam Shazeer、Adam Roberts、Katherine Lee、Sharan Narang、Michael Matena、Yanqi Zhou、Wei Li和Peter J. Liu。

- Table Transformer(来自Microsoft Research)与论文PubTables-1M:从非结构化文档中提取全面表格,作者为Brandon Smock、Rohith Pesala和Robin Abraham。

- TAPAS(来自Google AI)与论文TAPAS:通过预训练进行弱监督表格解析,作者为Jonathan Herzig、Paweł Krzysztof Nowak、Thomas Müller、Francesco Piccinno和Julian Martin Eisenschlos。

- TAPEX(来自Microsoft Research)与论文TAPEX:通过学习神经SQL执行器进行表格预训练,作者为Qian Liu,Bei Chen,Jiaqi Guo,Morteza Ziyadi,Zeqi Lin,Weizhu Chen和Jian-Guang Lou。

- Time Series Transformer(来自HuggingFace)。

- TimeSformer(来自Facebook)与论文时空注意力是否足以实现视频理解?作者为Gedas Bertasius、Heng Wang和Lorenzo Torresani。

- Trajectory Transformer(来自加州大学伯克利分校)与论文离线强化学习作为一个大序列建模问题,作者为Michael Janner、Qiyang Li和Sergey Levine

- Transformer-XL(来自Google / CMU)与论文Transformer-XL:超出固定长度上下文的注意力语言模型,作者为Zihang Dai,Zhilin Yang,Yiming Yang,Jaime Carbonell,Quoc V. Le,Ruslan Salakhutdinov。

- TrOCR(来自Microsoft),与论文TrOCR:基于Transformer的光学字符识别预训练模型,作者为Minghao Li,Tengchao Lv,Lei Cui,Yijuan Lu,Dinei Florencio,Cha Zhang,Zhoujun Li和Furu Wei。

- UL2(来自Google Research)与论文统一语言学习范例,作者为Yi Tay,Mostafa Dehghani,Vinh Q. Tran,Xavier Garcia,Dara Bahri,Tal Schuster,Huaixiu Steven Zheng,Neil Houlsby,Donald Metzler

- UniSpeech(来自Microsoft Research)与论文UniSpeech:使用有标记和无标记数据的统一语音表示学习,作者为Chengyi Wang,Yu Wu,Qian Yao,Kenichi Kumatani,Shujie Liu,Furu Wei,Michael Zeng和Xuedong Huang。

- UniSpeechSat(来自Microsoft Research)与论文UNISPEECH-SAT:具有说话人感知的预训练的通用语音表示学习,作者为Sanyuan Chen、Yu Wu、Chengyi Wang、Zhengyang Chen、Zhuo Chen、Shujie Liu、Jian Wu、Yao Qian、Furu Wei、Jinyu Li和Xiangzhan Yu。

- UPerNet(来自北京大学)与论文Unified Perceptual Parsing for Scene Understanding,作者为Tete Xiao、Yingcheng Liu、Bolei Zhou、Yuning Jiang和Jian Sun。

- VAN(来自清华大学和南开大学)与论文Visual Attention Network,作者为Meng-Hao Guo、Cheng-Ze Lu、Zheng-Ning Liu、Ming-Ming Cheng和Shi-Min Hu。

- VideoMAE(来自南京大学多媒体计算组)与论文VideoMAE:Masked Autoencoders are Data-Efficient Learners for Self-Supervised Video Pre-Training,作者为Zhan Tong、Yibing Song、Jue Wang和Limin Wang。

- ViLT(来自NAVER AI Lab/Kakao Enterprise/Kakao Brain)与论文ViLT:Vision-and-Language Transformer Without Convolution or Region Supervision,作者为Wonjae Kim、Bokyung Son和Ildoo Kim。

- Vision Transformer(ViT)(来自Google AI)与论文An Image is Worth 16x16 Words:Transformers for Image Recognition at Scale,作者为Alexey Dosovitskiy、Lucas Beyer、Alexander Kolesnikov、Dirk Weissenborn、Xiaohua Zhai、Thomas Unterthiner、Mostafa Dehghani、Matthias Minderer、Georg Heigold、Sylvain Gelly、Jakob Uszkoreit和Neil Houlsby。

- VisualBERT(来自UCLA NLP)与论文VisualBERT:A Simple and Performant Baseline for Vision and Language,作者为Liunian Harold Li、Mark Yatskar、Da Yin、Cho-Jui Hsieh和Kai-Wei Chang。

- ViT Hybrid(来自Google AI)与论文An Image is Worth 16x16 Words:Transformers for Image Recognition at Scale,作者为Alexey Dosovitskiy、Lucas Beyer、Alexander Kolesnikov、Dirk Weissenborn、Xiaohua Zhai、Thomas Unterthiner、Mostafa Dehghani、Matthias Minderer、Georg Heigold、Sylvain Gelly、Jakob Uszkoreit和Neil Houlsby。

- ViTMAE(来自Meta AI)与论文Masked Autoencoders Are Scalable Vision Learners,作者为Kaiming He、Xinlei Chen、Saining Xie、Yanghao Li、Piotr Dollár和Ross Girshick。

- ViTMSN(来自Meta AI)与论文Masked Siamese Networks for Label-Efficient Learning,作者为Mahmoud Assran、Mathilde Caron、Ishan Misra、Piotr Bojanowski、Florian Bordes、Pascal Vincent、Armand Joulin、Michael Rabbat和Nicolas Ballas。

- Wav2Vec2(来自Facebook AI)与论文wav2vec 2.0:A Framework for Self-Supervised Learning of Speech Representations,作者为Alexei Baevski、Henry Zhou、Abdelrahman Mohamed和Michael Auli。

- Wav2Vec2-Conformer(来自Facebook AI)与论文FAIRSEQ S2T:Fast Speech-to-Text Modeling with FAIRSEQ,作者为Changhan Wang、Yun Tang、Xutai Ma、Anne Wu、Sravya Popuri、Dmytro Okhonko和Juan Pino。

- Wav2Vec2Phoneme(来自Facebook AI)与论文Simple and Effective Zero-shot Cross-lingual Phoneme Recognition,作者为Qiantong Xu、Alexei Baevski和Michael Auli。

- WavLM(来自Microsoft Research)与论文WavLM:Large-Scale Self-Supervised Pre-Training for Full Stack Speech Processing,作者为Sanyuan Chen、Chengyi Wang、Zhengyang Chen、Yu Wu、Shujie Liu、Zhuo Chen、Jinyu Li、Naoyuki Kanda、Takuya Yoshioka、Xiong Xiao、Jian Wu、Long Zhou、Shuo Ren、Yanmin Qian、Yao Qian、Jian Wu、Michael Zeng和Furu Wei。

- Whisper(来自OpenAI)与论文Robust Speech Recognition via Large-Scale Weak Supervision,作者为Alec Radford、Jong Wook Kim、Tao Xu、Greg Brockman和Christine McLeavey。

- X-CLIP(来自Microsoft Research)与论文Expanding Language-Image Pretrained Models for General Video Recognition,作者为Bolin Ni、Houwen Peng、Minghao Chen、Songyang Zhang、Gaofeng Meng、Jianlong Fu、Shiming Xiang和Haibin Ling。

- XGLM(来自Facebook AI)与论文Few-shot Learning with Multilingual Language Models,作者为Xi Victoria Lin、Todor Mihaylov、Mikel Artetxe、Tianlu Wang、、Shuohui Chen、、Daniel Simig、、Myle Ott、、Naman Goyal、、Shruti Bhosale、、Jingfei Du、、Ramakanth Pasunuru、、Sam Shleifer、、Punit Singh Koura、、Vishrav Chaudhary、、Brian O’Horo、、Jeff Wang、、Luke Zettlemoyer、、Zornitsa Kozareva、、Mona Diab和Veselin Stoyanov。

- XLM(来自Facebook)与论文Cross-lingual Language Model Pretraining,作者为Guillaume Lample和Alexis Conneau。

- XLM-ProphetNet(来自Microsoft Research)与论文ProphetNet:Predicting Future N-gram for Sequence-to-Sequence Pre-training,作者为Yu Yan、、Weizhen Qi、、Yeyun Gong、、Dayiheng Liu、、Nan Duan、、Jiusheng Chen、、Ruofei Zhang和Ming Zhou。

- XLM-RoBERTa(来自Facebook AI),与论文Unsupervised Cross-lingual Representation Learning at Scale,作者为Alexis Conneau、、Kartikay Khandelwal、、Naman Goyal、、Vishrav Chaudhary、、Guillaume Wenzek、、Francisco Guzmán、、Edouard Grave、、Myle Ott、、Luke Zettlemoyer和Veselin Stoyanov。

- XLM-RoBERTa-XL(来自Facebook AI),与论文Larger-Scale Transformers for Multilingual Masked Language Modeling,作者为Naman Goyal、、Jingfei Du、、Myle Ott、、Giri Anantharaman和Alexis Conneau。

- XLNet(来自Google/CMU)的论文《XLNet: Generalized Autoregressive Pretraining for Language Understanding》由Zhilin Yang、Zihang Dai、Yiming Yang、Jaime Carbonell、Ruslan Salakhutdinov和Quoc V.Le撰写,已发布。

- XLS-R(来自Facebook AI)的论文《XLS-R: Self-supervised Cross-lingual Speech Representation Learning at Scale》由Arun Babu、Changhan Wang、Andros Tjandra、Kushal Lakhotia、Qiantong Xu、Naman Goyal、Kritika Singh、Patrick von Platen、Yatharth Saraf、Juan Pino、Alexei Baevski、Alexis Conneau和Michael Auli撰写,已发布。

- XLSR-Wav2Vec2(来自Facebook AI)的论文《Unsupervised Cross-Lingual Representation Learning For Speech Recognition》由Alexis Conneau、Alexei Baevski、Ronan Collobert、Abdelrahman Mohamed和Michael Auli撰写,已发布。

- YOLOS(来自华中科技大学)的论文《You Only Look at One Sequence: Rethinking Transformer in Vision through Object Detection》由Yuxin Fang、Bencheng Liao、Xinggang Wang、Jiemin Fang、Jiyang Qi、Rui Wu、Jianwei Niu和Wenyu Liu撰写,已发布。

- YOSO(来自威斯康星大学 - 麦迪逊分校)的论文《You Only Sample (Almost) Once: Linear Cost Self-Attention Via Bernoulli Sampling》由Zhanpeng Zeng、Yunyang Xiong、Sathya N. Ravi、Shailesh Acharya、Glenn Fung和Vikas Singh撰写,已发布。

Transformer 4.43.40 版本支持的模型目录涵盖了自然语言处理领域的众多任务和应用,从文本分类到机器翻译,从命名实体识别到情感分析,以及许多其他领域。这些模型的广泛支持使得开发者可以根据不同的需求选择最合适的模型,从而加速自然语言处理项目的开发和部署。无论您是在研究、开发还是部署自然语言处理应用,Transformer 4.43.40 版本都提供了强大的工具和资源,助您取得更好的成果。不断更新的 Transformer 工具包将继续为自然语言处理领域的创新和进步做出贡献,为解决各种复杂的文本处理问题提供支持。

相关文章:

支持的模型)

【HuggingFace】Transformers(V4.34.0 稳定)支持的模型

Transformer 4.43.40 版本是自然语言处理领域的一个重要工具包,为开发者提供了丰富的预训练模型资源,可以用于各种文本处理任务。在这个版本中,Transformer 支持了众多模型,每个模型都具有不同的优势和适用领域。下面是一个 Trans…...

oracle 导入数据泵常用语句

oracle常用语句 window10 导出导入数据泵文件导入数据泵文件导出数据泵文件 oracle表空间查询、剩余空间查询查询表空间大小及对应文件查询各个表空间大小扩充表空间 window10 导出导入数据泵文件 导入数据泵文件 首先将数据泵文件放在oracle安装得对应位置,例如&…...

tensorflow中的常见方法

1.tf.argmax(input,axis) tf.argmax(input,axis)根据axis取值的不同返回每行或者每列最大值的索引。 axis 0: 比较每一列的元素,将每一列最大元素所在的索引记录下来,最后输出每一列最大元素所在的索引数组。 test[0] array([1, 2, 3]) test[1] …...

【周末闲谈】“PHP是最好的语言”这个梗是怎么来的?

个人主页:【😊个人主页】 系列专栏:【❤️周末闲谈】 系列目录 ✨第一周 二进制VS三进制 ✨第二周 文心一言,模仿还是超越? ✨第二周 畅想AR 文章目录 系列目录前言最早的出处关于PHP语言优点缺点网络评价 总结 前言 …...

四位十进制数字频率计VHDL,仿真视频、代码

名称:四位十进制数字频率计VHDL,quartus仿真 软件:Quartus 语言:VHDL 代码功能: 使用直接测频法测量信号频率,测频范围为1~9999Hz,具有超量程报警功能 演示视频:四位十进制数字频…...

Unity实现设计模式——策略模式

Unity实现设计模式——策略模式 策略模式是一种定义一些列算法的方法,这些所有的算法都是完成相同的工作,只是实现不同。它可以通过相同的方式调用所有的算法,减少各种算法类与使用算法类之间的耦合。 策略模式的 Strategy 类层次为 Contex…...

C++基础——数据类型

1 概述 在创建变量和常量的时候,都需要指定其数据类型,以便为其分配合适的内存空间。 其中宏常量不需要指定类型,是因为宏定义是字符替换。 2 整型 整型表示的是整数,C中的整型有以下几种: 数据类型占用空间取值范…...

文本自动输入/删除的加载动画效果

效果展示 CSS 知识点 绕矩形四周跑的光柱动画实现animation 属性的 steps 属性值运用 页面基础结构实现 <div class"loader"><!-- span 标签是围绕矩形四周的光柱 --><span></span><span></span><span></span>&l…...

PHP8的匿名类-PHP8知识详解

PHP8支持通过new class 来实例化一个匿名类。所谓匿名类,就是指没有名称的类,只能在创建时使用new语句来声明它们。 匿名类是一种没有命名的即时类,可以用于简单的对象封装和实现接口。 以下是PHP 8中匿名类的基本语法示例: $ob…...

WebKit Inside: CSS 样式表的匹配时机

WebKit Inside: CSS 的解析 介绍了 CSS 样式表的解析过程,这篇文章继续介绍 CSS 的匹配时机。 无外部样式表 内部样式表和行内样式表本身就在 HTML 里面,解析 HTML 标签构建 DOM 树时内部样式表和行内样式就会被解析完毕。因此如果 HTML 里面只有内部样式…...

<HarmonyOS第一课>从简单的页面开始——闯关习题及答案

加入鸿蒙应用开发公开课系统学习HarmonyOS应用开发 判断题 1.在Column容器中的子组件默认是按照从上到下的垂直方向布局的,其主轴的方向是垂直方向,在Row容器中的组件默认是按照从左到右的水平方向布局的,其主轴的方向是水平方向。ÿ…...

视频下载plus+:一款强大的视频下载小程序

引言 在当下,随着视频号的火爆和用户数量的不断增加,视频下载已经成为了众多用户追求的目标。尽管市面上有很多视频下载助手,但是很多人对于如何下载视频还是摸不着头脑。今天我将向大家推荐一款我自己使用并且非常好用的视频下载小程序——…...

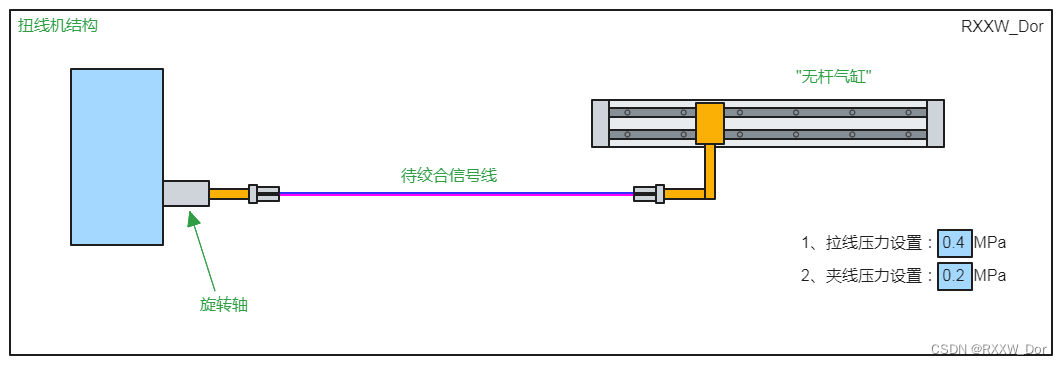

扭线机控制

扭线机属于线缆加工设备,线缆加工设备种类非常多。有用于网线绞合的单绞,双绞机等,有关单绞机相关算法介绍,大家可以查看专栏相关文章,有详细介绍,常用链接如下: 线缆行业单绞机控制算法&#…...

Android App启动优化之启动框架

android启动优化是个比较重要的部分,也是一大难题,一个优秀的app首先给人第一感觉就是启动速度,启动速度非常影响用户的体验,那么我们今天展开说说启动优化相关的问题。 我们先来简单分析一下启动过程、启动优化方向,…...

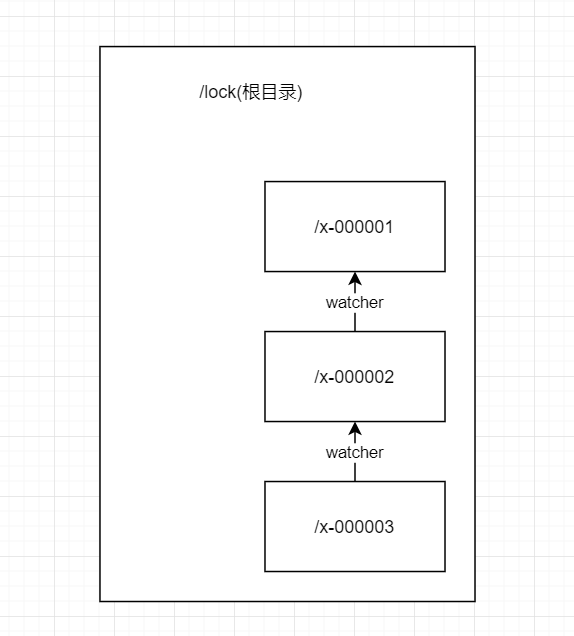

zookeeper入门篇之分布式锁

文章目录 前言非公平锁公平锁 前言 上一篇说过,zookeeper是一个类似文件系统的数据结构,每个节点都可以看做是一个文件目录,也就是说,我们所创建的节点是唯一的,那么分布式锁的原理就是基于这个来的。 代码仓库&…...

1297 - 1304 题)

leetcode解题思路分析(一百四十九)1297 - 1304 题

子串的最大出现次数 给你一个字符串 s ,请你返回满足以下条件且出现次数最大的 任意 子串的出现次数: 子串中不同字母的数目必须小于等于 maxLetters 。 子串的长度必须大于等于 minSize 且小于等于 maxSize 。 首先能想到的是从MinSize开始遍历查找&am…...

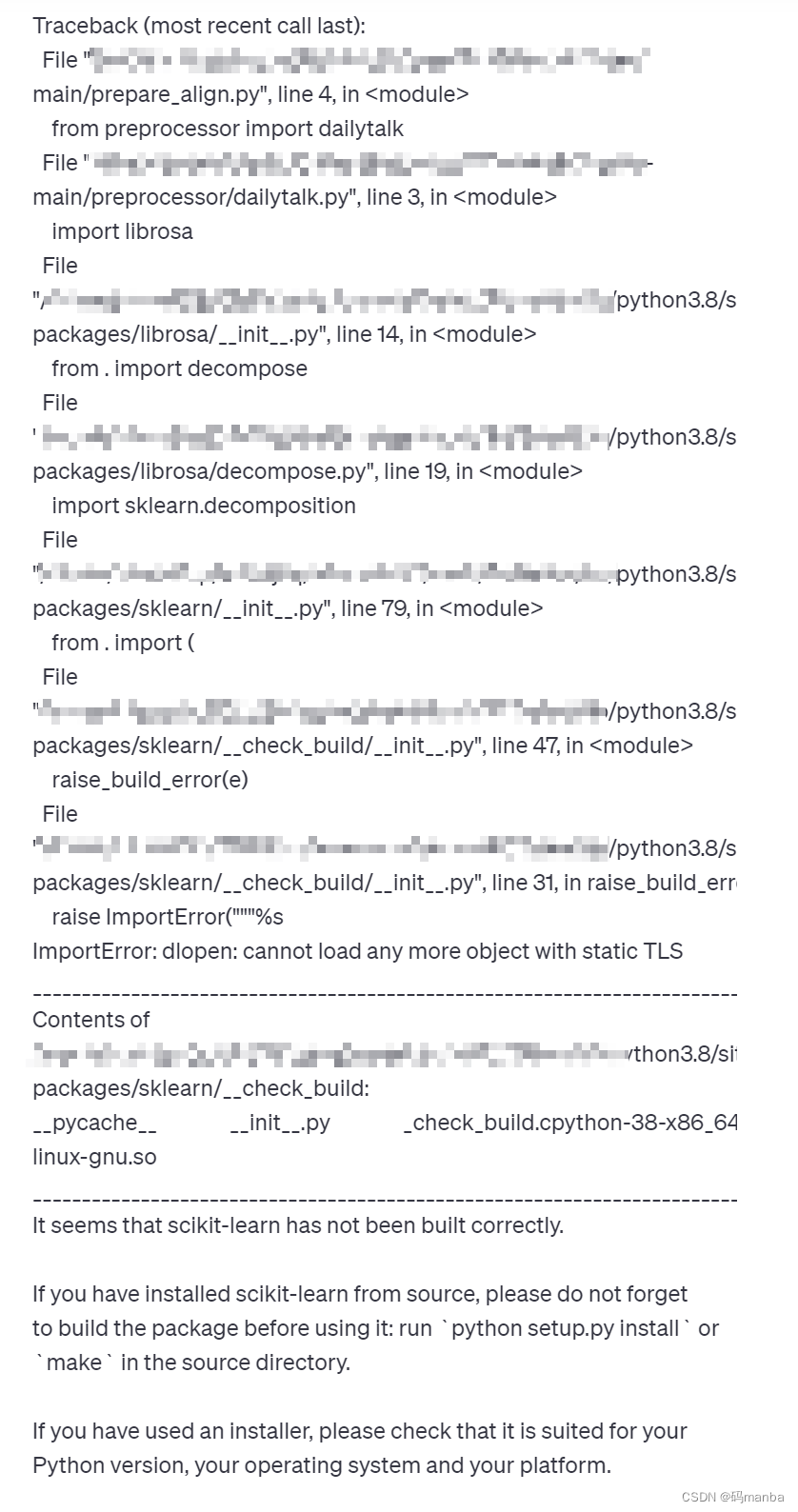

你的librosa和scikit-learn打架了吗?

被这个问题困扰好久!!!!!!!!!!!!!! 我的原来版本librosa0.7.1 和 scikit-learn1.3.1 一直拆了按,按…...

理解自动驾驶感知技术

理解自动驾驶感知技术 文章目录 什么是自动驾驶感知技术?自动驾驶感知技术的关键组成部分1. 雷达(Radar)2. 摄像头(Camera)3. 激光雷达(Lidar)4. 超声波传感器(Ultrasonic Sensors&a…...

一款简化Python自然语言处理的开源库

迷途小书童 读完需要 3分钟 速读仅需 1 分钟 1 简介 TextBlob 是一个 Python 库,用于处理文本数据的自然语言处理(NLP)任务。它提供了简单且易于使用的 API,使得对文本进行分析、情感分析、词性标注、名词短语提取等任务变得更加简…...

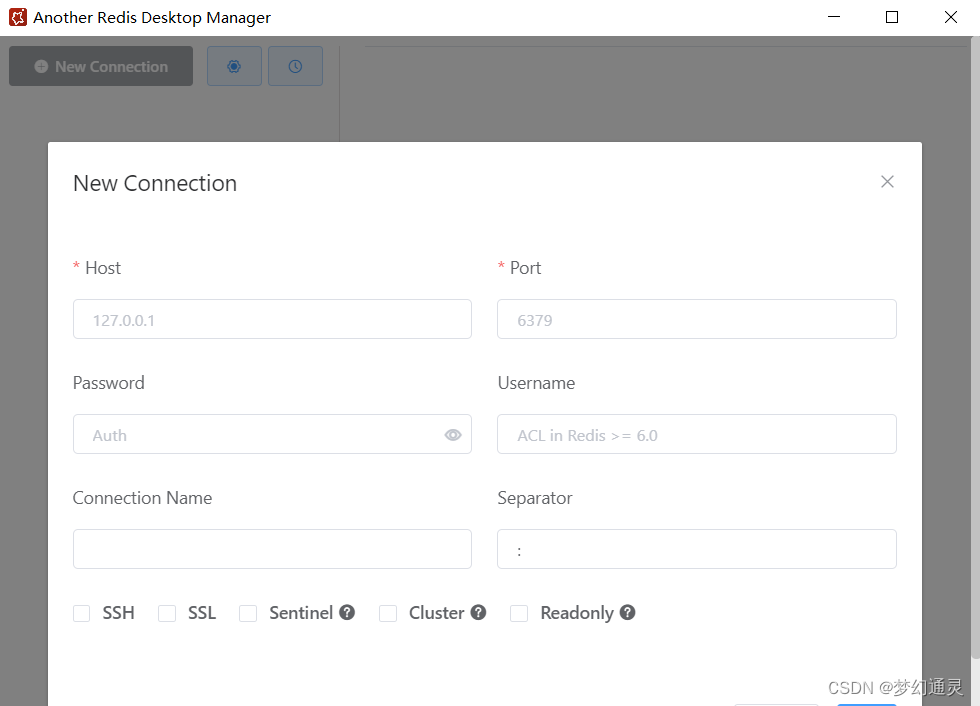

常用Redis界面化软件

对于Redis的操作,前期有过介绍【Centos 下安装 Redis 及命令行操作】。而在Redis的日常开发调试中,可使用可视化软件方便进行操作。 本篇主要介绍Redis可视化的两款工具:Redis Desktop Manager和AnotherRedisDesktopManager。 1、Redis Desk…...

.Net框架,除了EF还有很多很多......

文章目录 1. 引言2. Dapper2.1 概述与设计原理2.2 核心功能与代码示例基本查询多映射查询存储过程调用 2.3 性能优化原理2.4 适用场景 3. NHibernate3.1 概述与架构设计3.2 映射配置示例Fluent映射XML映射 3.3 查询示例HQL查询Criteria APILINQ提供程序 3.4 高级特性3.5 适用场…...

Linux相关概念和易错知识点(42)(TCP的连接管理、可靠性、面临复杂网络的处理)

目录 1.TCP的连接管理机制(1)三次握手①握手过程②对握手过程的理解 (2)四次挥手(3)握手和挥手的触发(4)状态切换①挥手过程中状态的切换②握手过程中状态的切换 2.TCP的可靠性&…...

蓝桥杯 2024 15届国赛 A组 儿童节快乐

P10576 [蓝桥杯 2024 国 A] 儿童节快乐 题目描述 五彩斑斓的气球在蓝天下悠然飘荡,轻快的音乐在耳边持续回荡,小朋友们手牵着手一同畅快欢笑。在这样一片安乐祥和的氛围下,六一来了。 今天是六一儿童节,小蓝老师为了让大家在节…...

1.3 VSCode安装与环境配置

进入网址Visual Studio Code - Code Editing. Redefined下载.deb文件,然后打开终端,进入下载文件夹,键入命令 sudo dpkg -i code_1.100.3-1748872405_amd64.deb 在终端键入命令code即启动vscode 需要安装插件列表 1.Chinese简化 2.ros …...

DIY|Mac 搭建 ESP-IDF 开发环境及编译小智 AI

前一阵子在百度 AI 开发者大会上,看到基于小智 AI DIY 玩具的演示,感觉有点意思,想着自己也来试试。 如果只是想烧录现成的固件,乐鑫官方除了提供了 Windows 版本的 Flash 下载工具 之外,还提供了基于网页版的 ESP LA…...

2025 后端自学UNIAPP【项目实战:旅游项目】6、我的收藏页面

代码框架视图 1、先添加一个获取收藏景点的列表请求 【在文件my_api.js文件中添加】 // 引入公共的请求封装 import http from ./my_http.js// 登录接口(适配服务端返回 Token) export const login async (code, avatar) > {const res await http…...

自然语言处理——Transformer

自然语言处理——Transformer 自注意力机制多头注意力机制Transformer 虽然循环神经网络可以对具有序列特性的数据非常有效,它能挖掘数据中的时序信息以及语义信息,但是它有一个很大的缺陷——很难并行化。 我们可以考虑用CNN来替代RNN,但是…...

AI书签管理工具开发全记录(十九):嵌入资源处理

1.前言 📝 在上一篇文章中,我们完成了书签的导入导出功能。本篇文章我们研究如何处理嵌入资源,方便后续将资源打包到一个可执行文件中。 2.embed介绍 🎯 Go 1.16 引入了革命性的 embed 包,彻底改变了静态资源管理的…...

React---day11

14.4 react-redux第三方库 提供connect、thunk之类的函数 以获取一个banner数据为例子 store: 我们在使用异步的时候理应是要使用中间件的,但是configureStore 已经自动集成了 redux-thunk,注意action里面要返回函数 import { configureS…...

混合(Blending))

C++.OpenGL (20/64)混合(Blending)

混合(Blending) 透明效果核心原理 #mermaid-svg-SWG0UzVfJms7Sm3e {font-family:"trebuchet ms",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-SWG0UzVfJms7Sm3e .error-icon{fill:#552222;}#mermaid-svg-SWG0UzVfJms7Sm3e .error-text{fill…...