HDFS Java API 操作

文章目录

- HDFS Java API操作

- 零、启动hadoop

- 一、HDFS常见类接口与方法

- 1、hdfs 常见类与接口

- 2、FileSystem 的常用方法

- 二、Java 创建Hadoop项目

- 1、创建文件夹

- 2、打开Java IDEA

- 1) 新建项目

- 2) 选择Maven

- 三、配置环境

- 1、添加相关依赖

- 2、创建日志属性文件

- 四、Java API操作

- 1、在HDFS上创建文件

- 2、在Java 上创建包

- 1) 编写`create1()`方法

- 2) 编写create2() 方法

- 3、在HDFS上写入文件

- 1) 将数据直接写入HDFS文件

- (1)编写write1() 方法

- 2) 将本地文件写入HDFS文件

- (1)、编写witer2() 方法

- (2)、编写write2_2() 方法

- 4、读取HDFS文件

- 1) 读取HDFS文件直接在控制台显示

- (1) 编写read1() 方法

- 2) 读取HDFS文件,保存为本地文件

- (1) 创建`read2()`方法

- 5、重命名目录或文件

- 1) 重命名目录

- (1) 编写`renameDir()` 方法

- 2) 重命名文件

- (1)编写renameFile() 方法

- 6、显示文件列表

- 1) 显示指定目录下文件全部信息

- (1)、编写list1() 方法

- 2) 显示指定目录下文件路径和长度信息

- (1) 编写list2() 方法

- 7、获取文件块信息

HDFS Java API操作

Hadoop是使用Java语言编写的,因此使用Java API操作Hadoop文件系统,HDFS Shell本质上就是对Java API的应用,通过编程的形式,操作HDFS,其核心是使用HDFS提供的Java API构造一个访问客户端对象,然后通过客户端对象对HDFS上的文件进行操作(增,删,改,查)

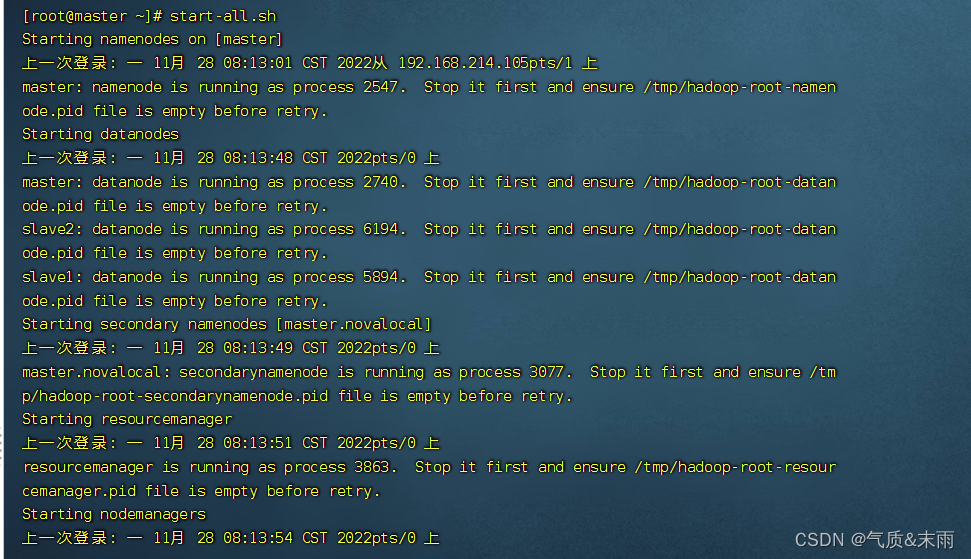

零、启动hadoop

一、HDFS常见类接口与方法

1、hdfs 常见类与接口

Hadoop 整合了众多文件系统,HDFS只是这个文件系统的一个实例

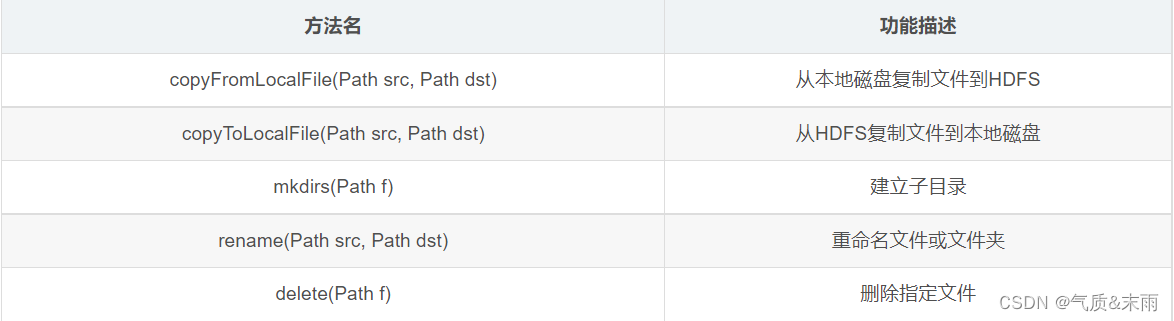

2、FileSystem 的常用方法

FileSystem 对象的一些方法可以对文件进行操作

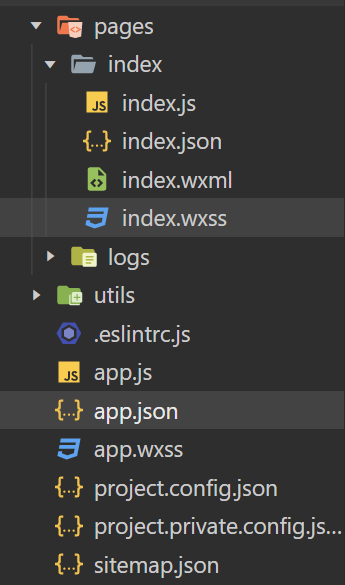

二、Java 创建Hadoop项目

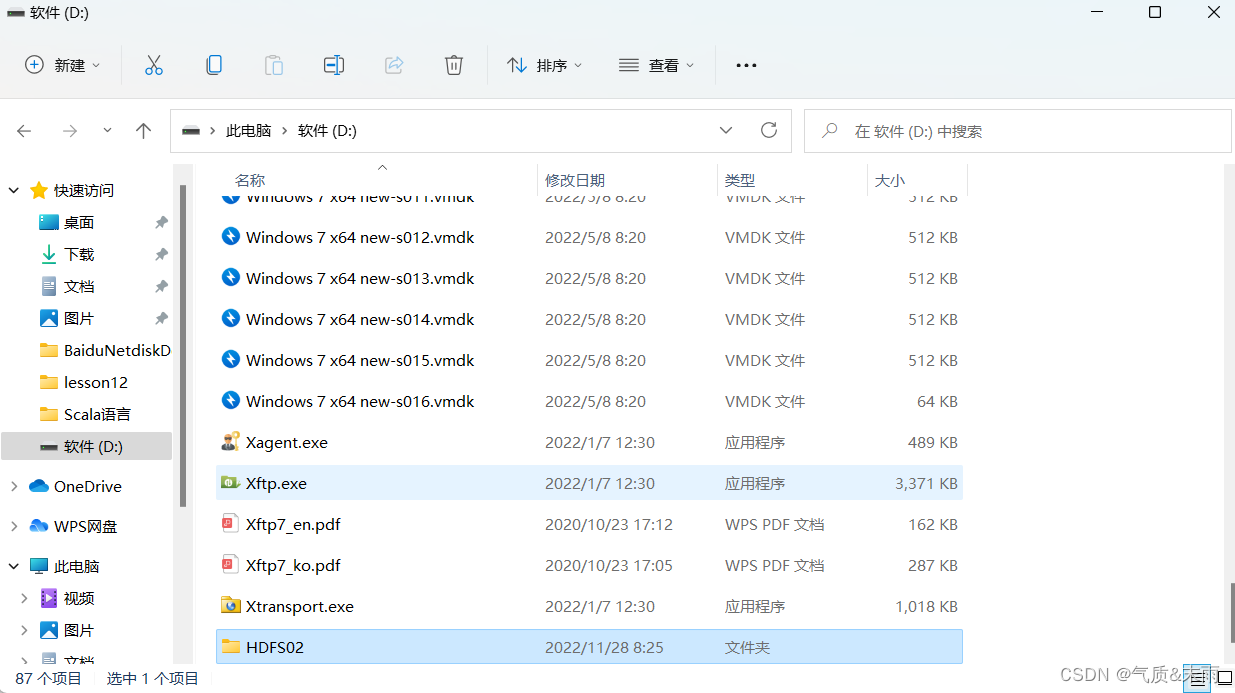

1、创建文件夹

现在D盘创建一个空的文件夹,HDFS02用来存放hadoop项目

2、打开Java IDEA

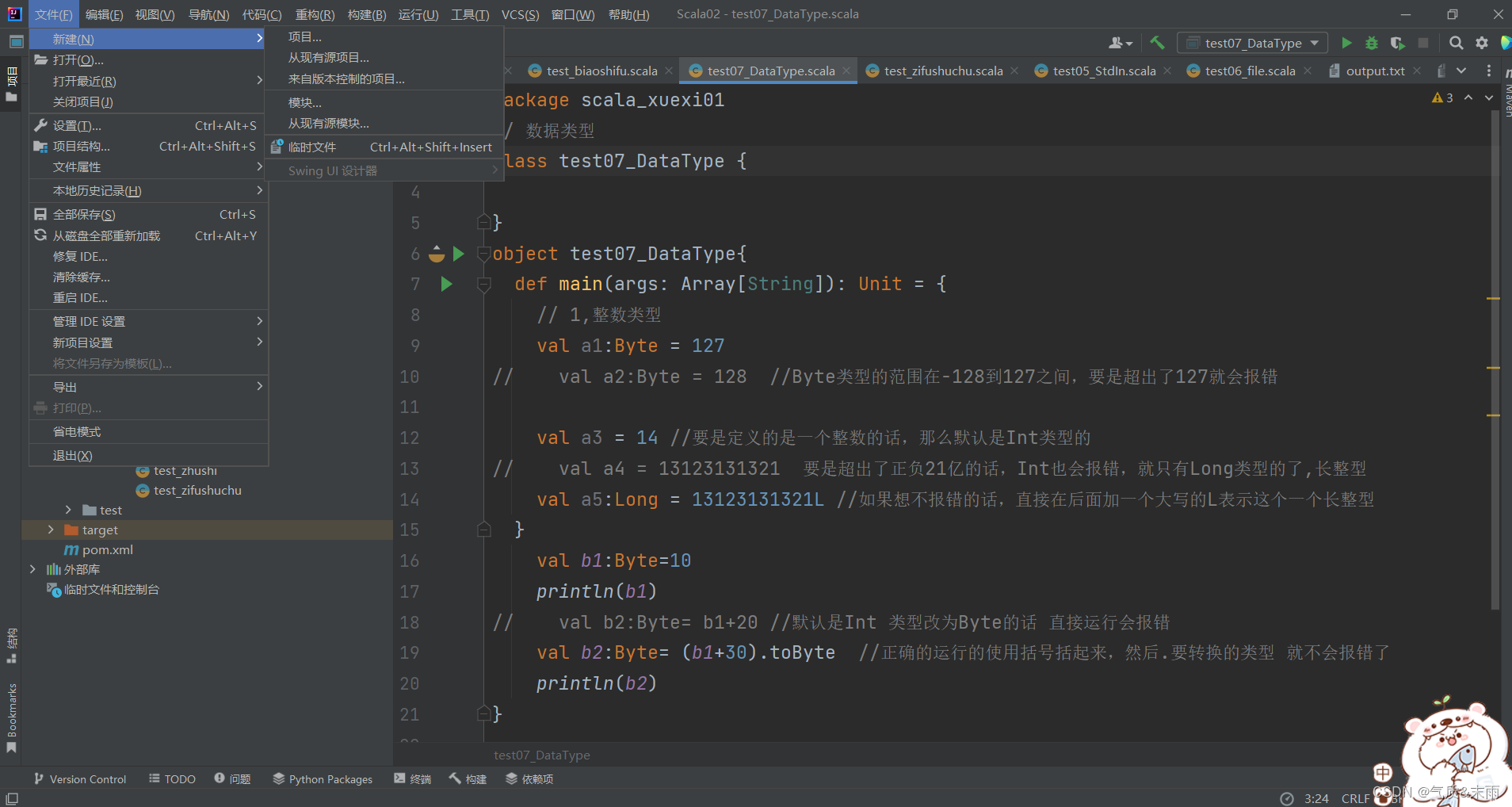

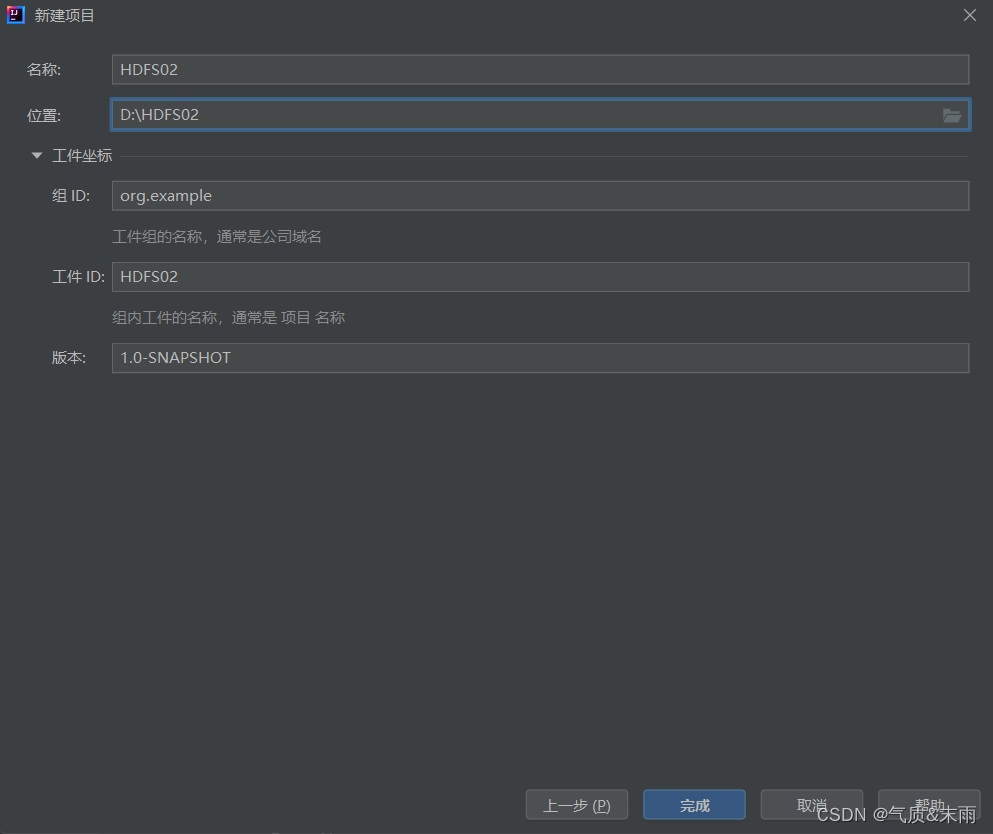

1) 新建项目

点击左上角,新建项目

2) 选择Maven

选择Maven包管理,记住一定是jdk1.8版本的,然后那个从archetype 不要选择

然后点击下一步,位置选择刚刚D盘创建的那个HDFS02文件夹,然后点击完成

三、配置环境

1、添加相关依赖

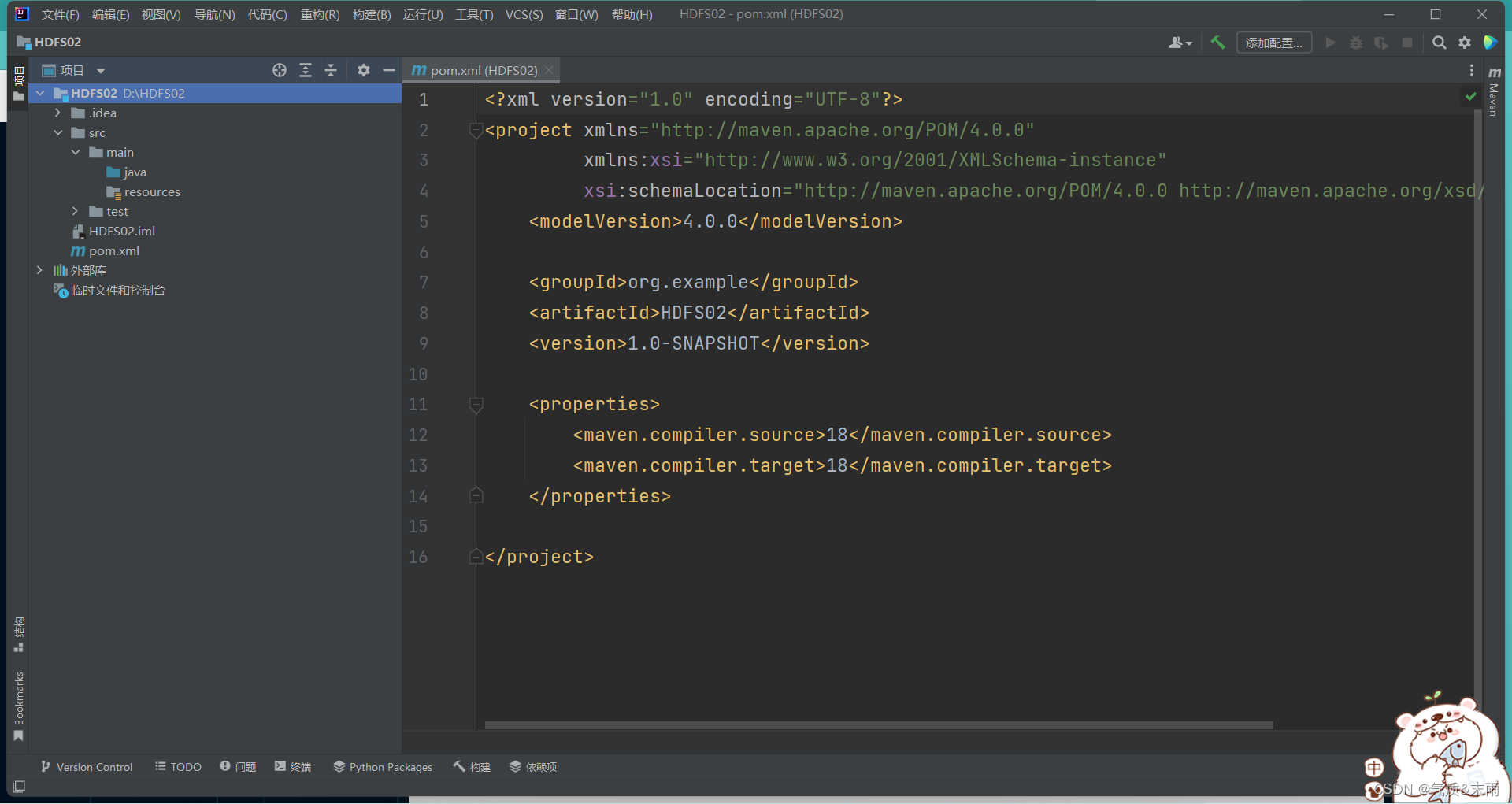

创建完成之后,进来是一个pom.xml文件

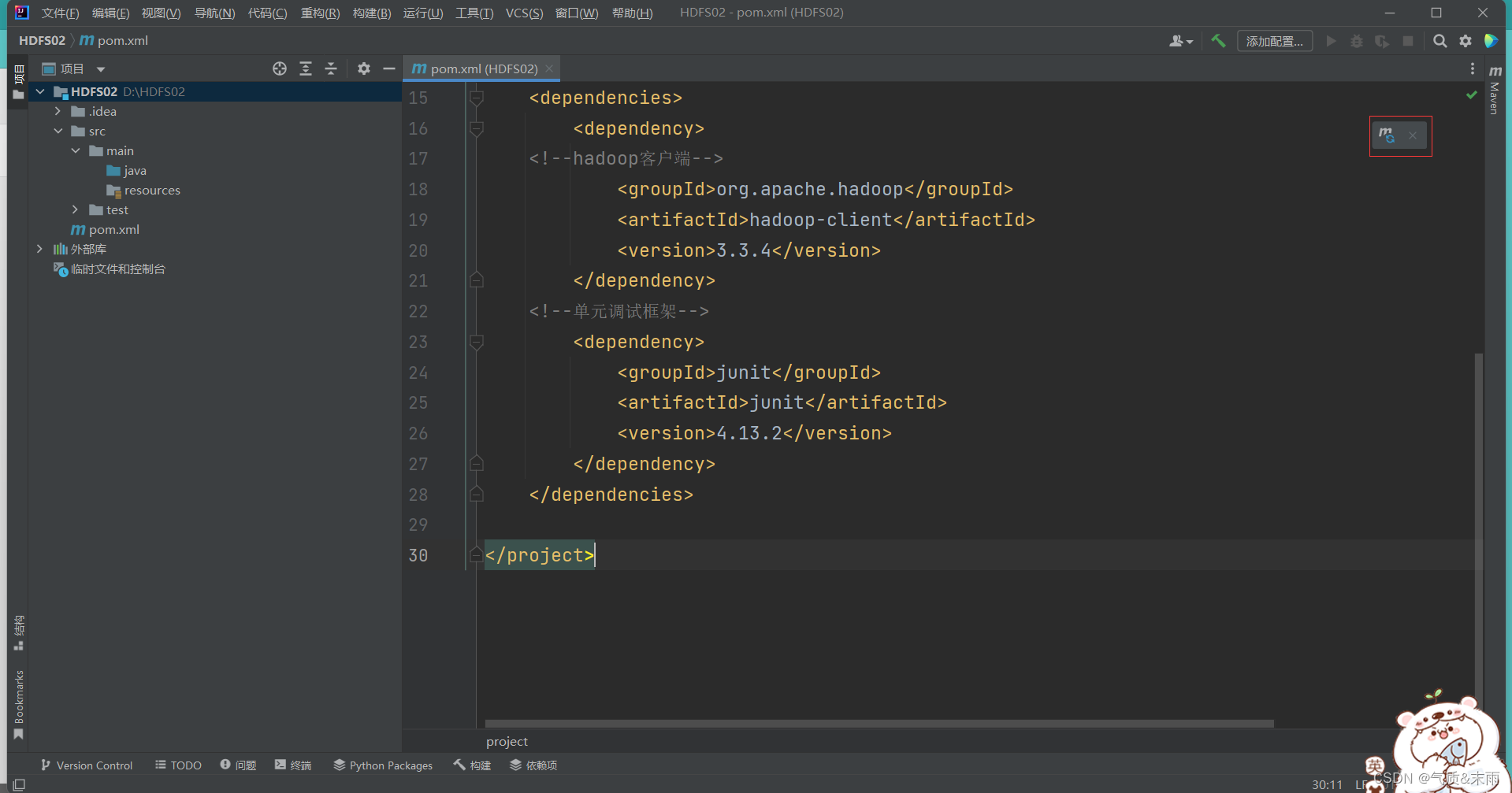

添加以下的相关的hadoop和junit依赖配置,其中大部分都是有的,主要是<dependencise></dependencise> 这个部分

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd"><modelVersion>4.0.0</modelVersion><groupId>org.example</groupId><artifactId>HDFS02</artifactId><version>1.0-SNAPSHOT</version><properties><maven.compiler.source>18</maven.compiler.source><maven.compiler.target>18</maven.compiler.target></properties><dependencies><dependency><!--hadoop客户端--><groupId>org.apache.hadoop</groupId><artifactId>hadoop-client</artifactId><version>3.3.4</version></dependency><!--单元调试框架--><dependency><groupId>junit</groupId><artifactId>junit</artifactId><version>4.13.2</version></dependency></dependencies></project>

然后右上角有一个m的图标,点击一下,加载配置文件,导入包,这个很关键,不然那些包都用不起

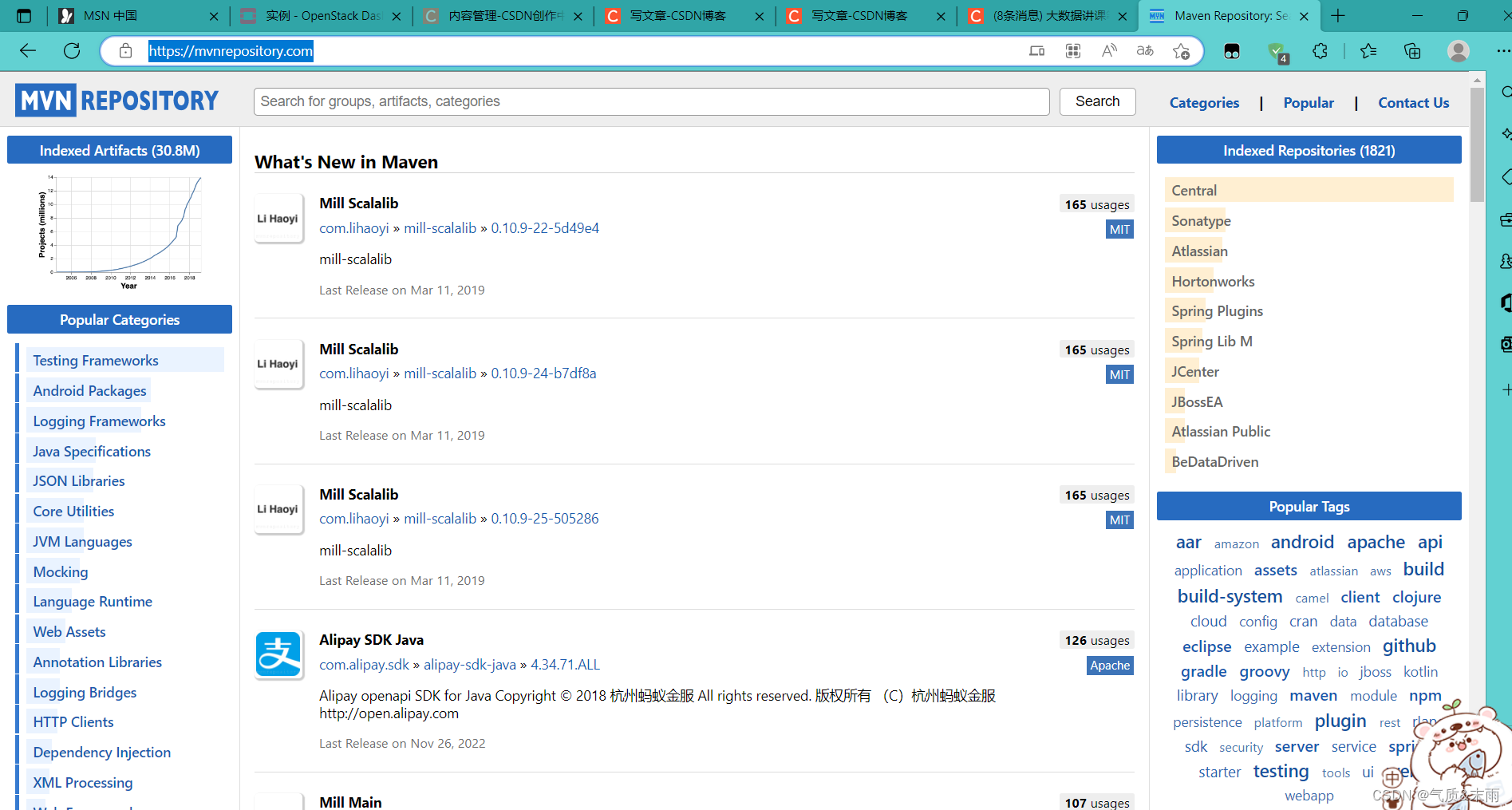

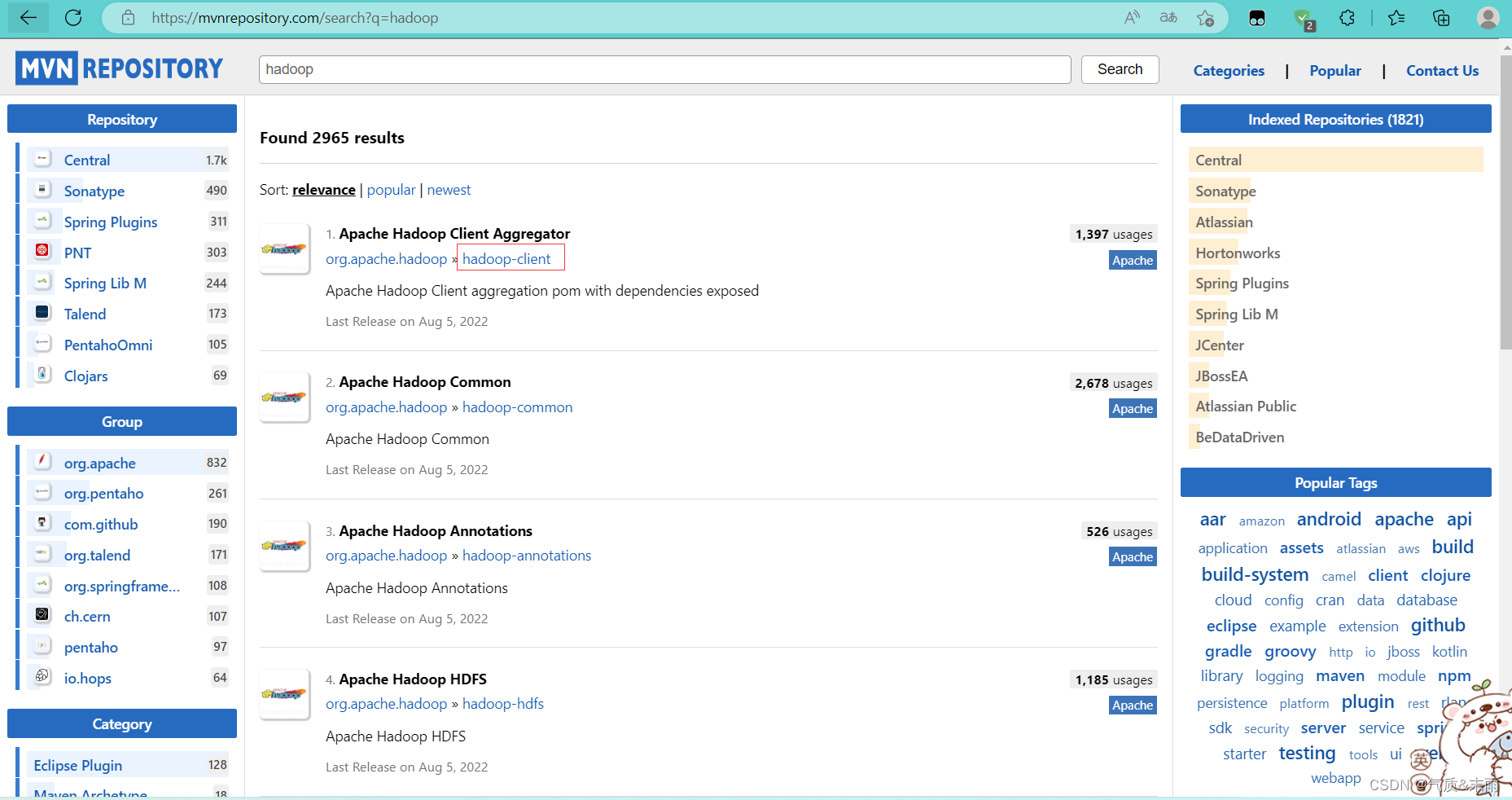

Manen Repository (Maven仓库) http://mvnrepository.com/

搜索 hadoop

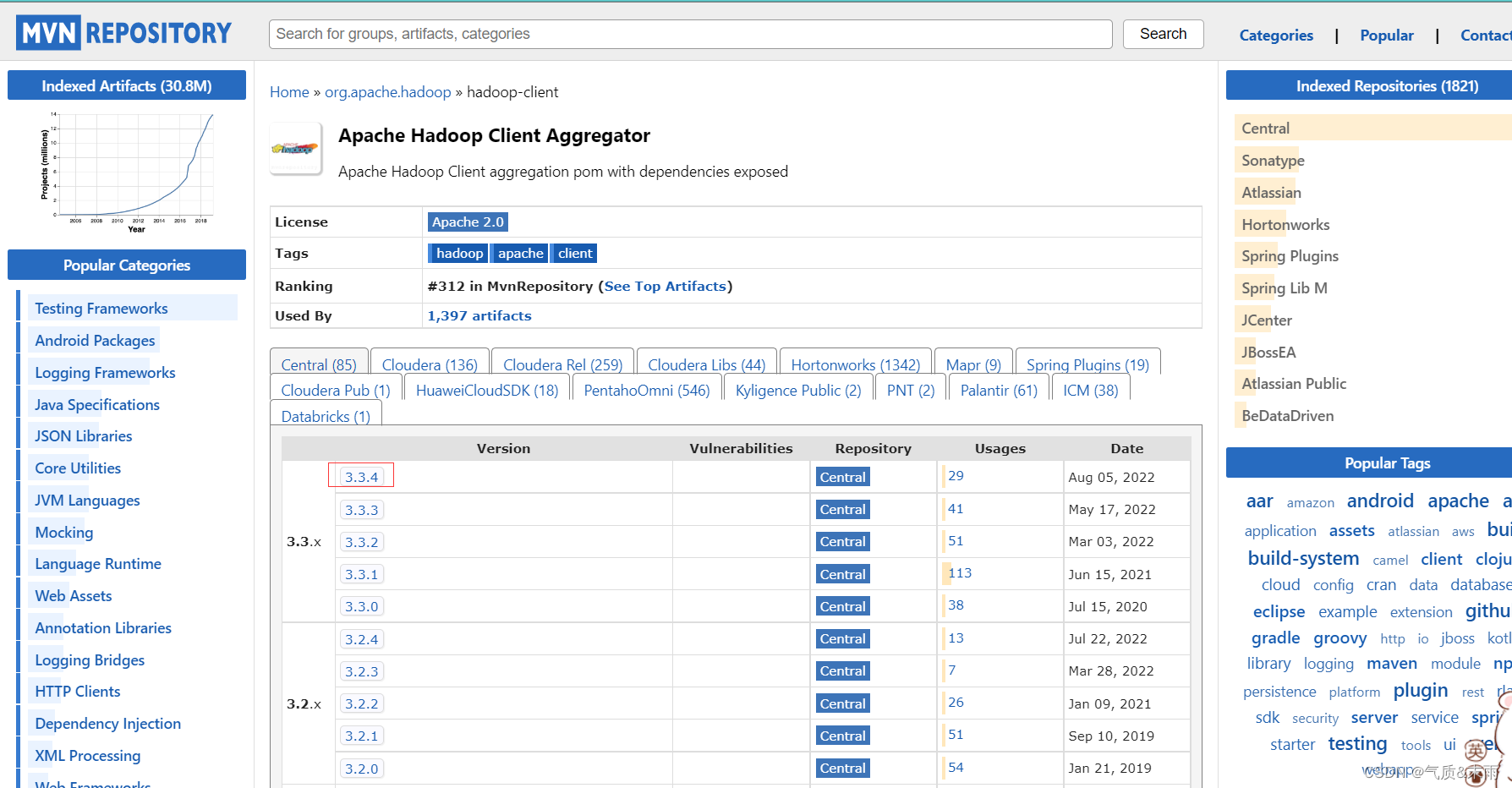

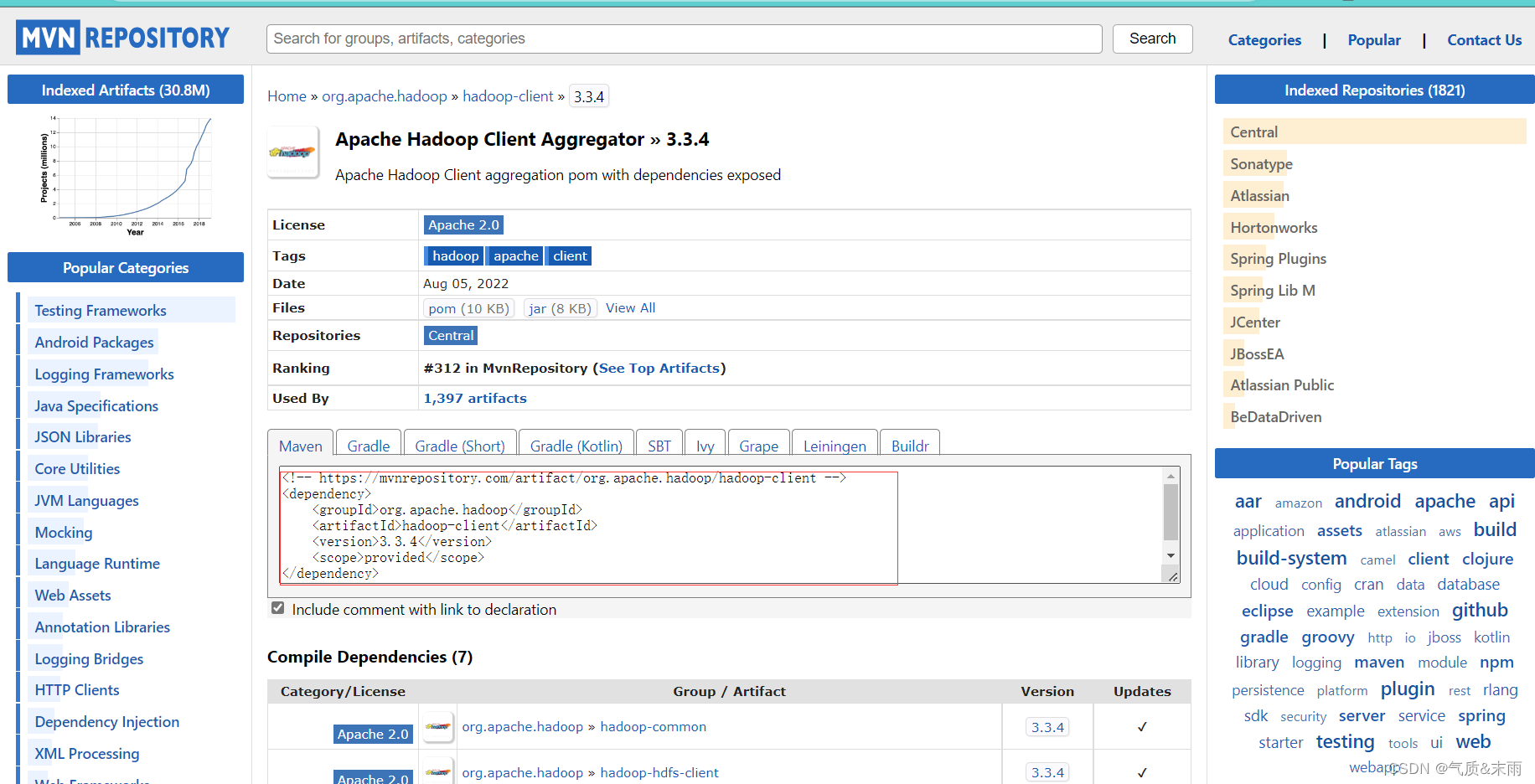

点击 hadoop-client 超链接,然后点击下面的3.3.4

就可以看到上面在Java里面配置的hadoop的依赖就是这个地方的

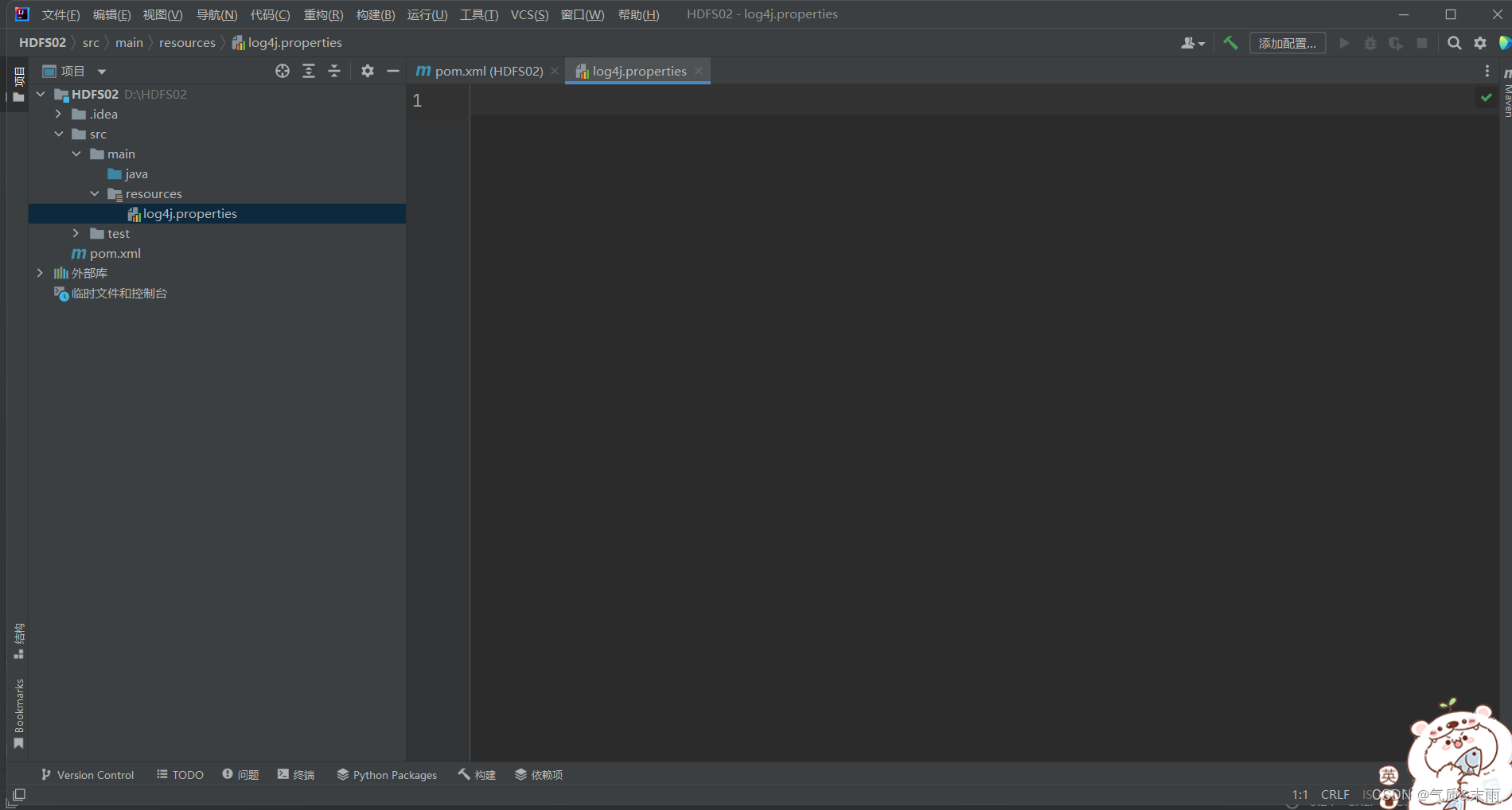

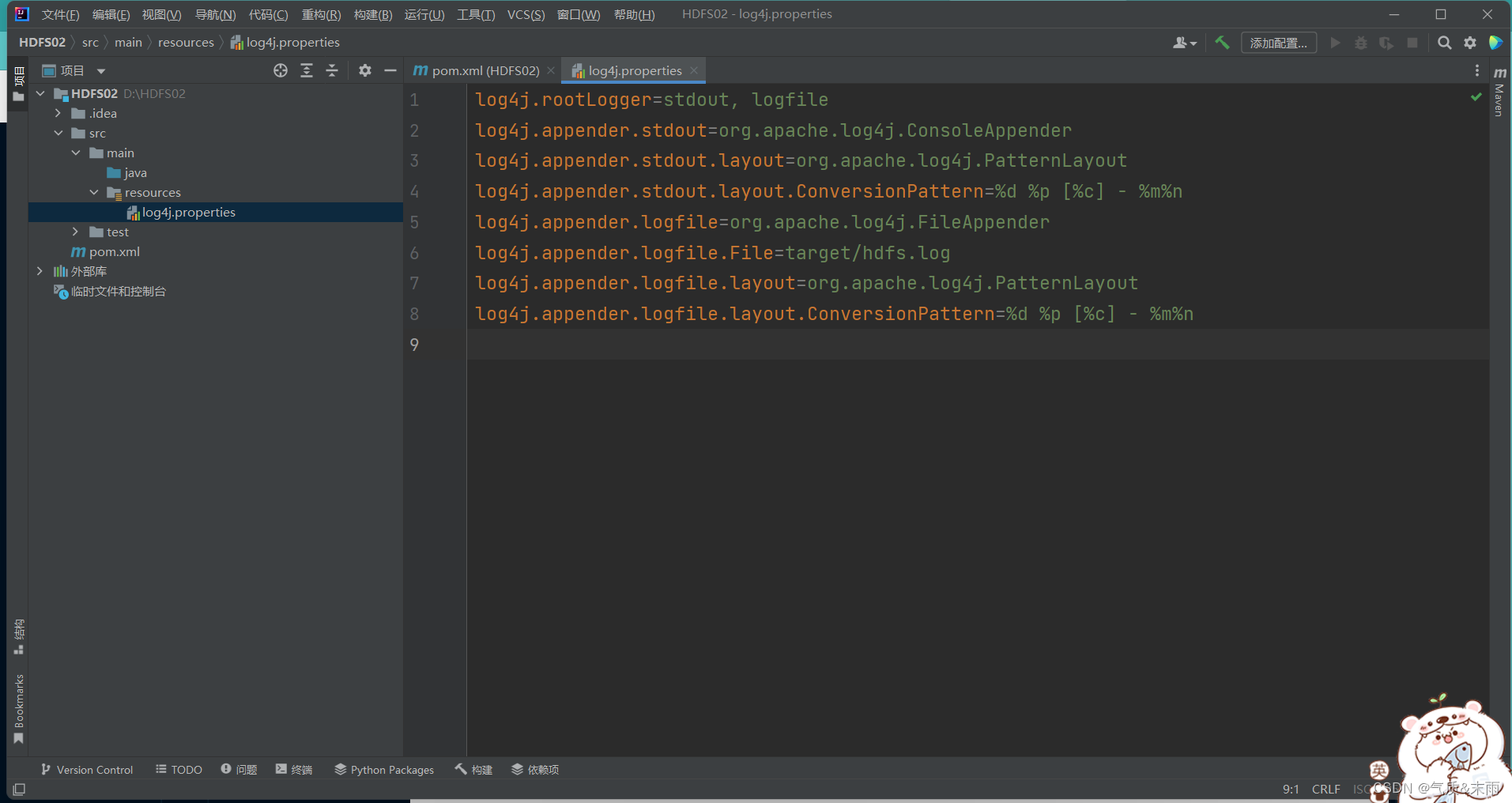

2、创建日志属性文件

在resources目录里创建log4j.properties文件

把下面的配置添加进去

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

四、Java API操作

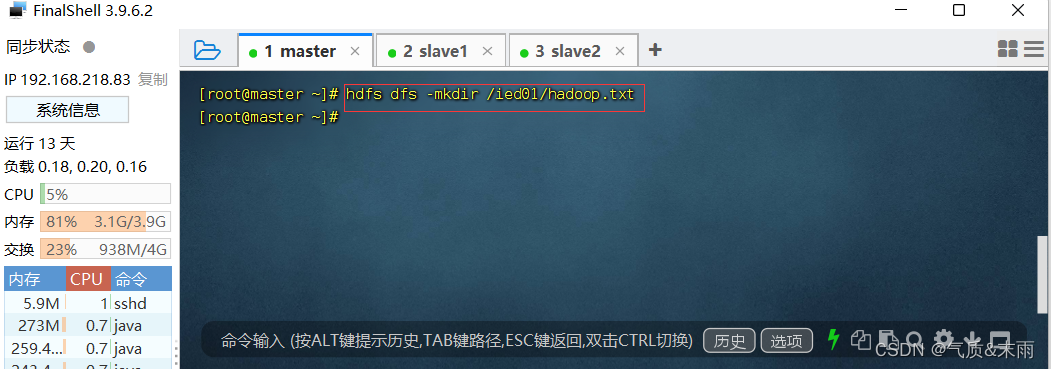

1、在HDFS上创建文件

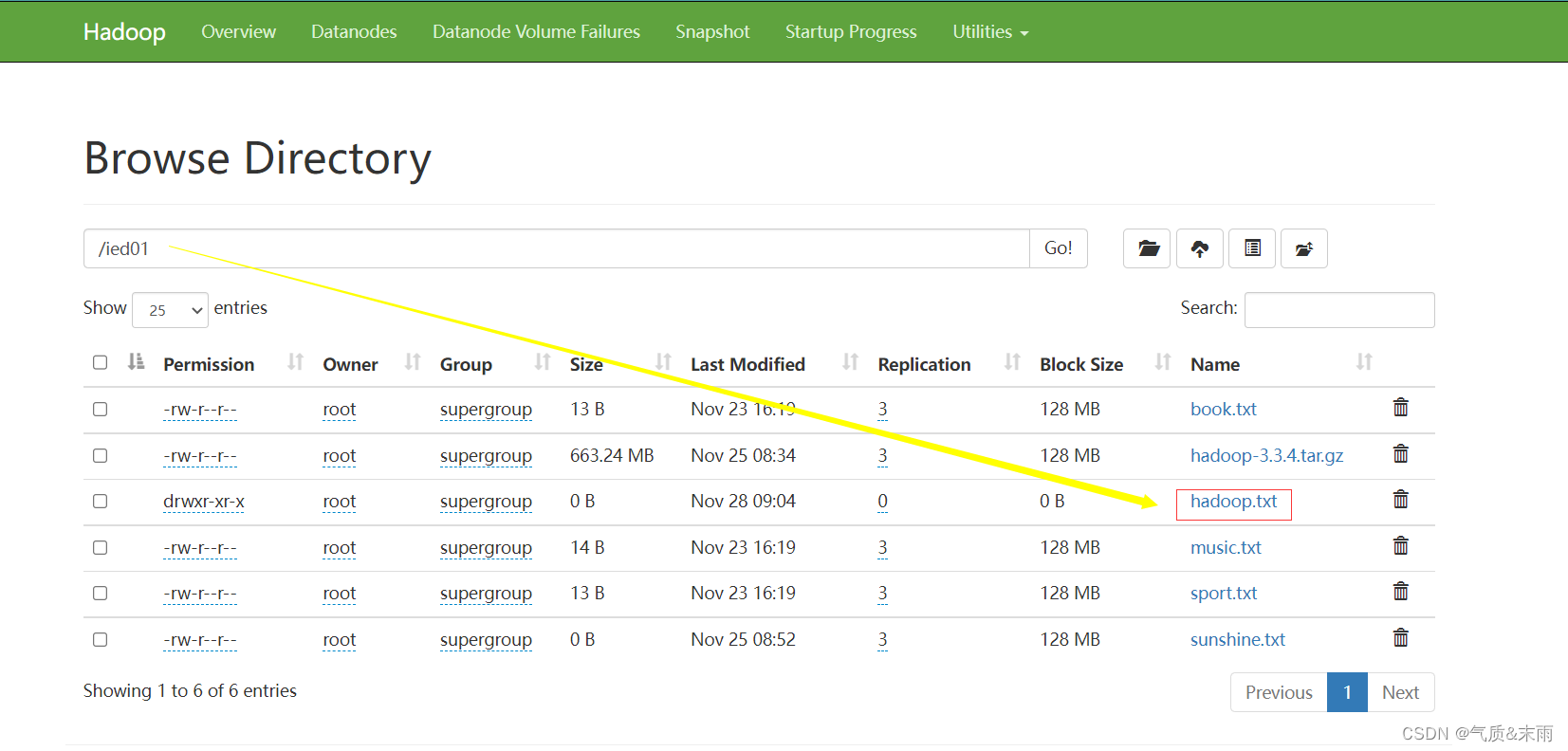

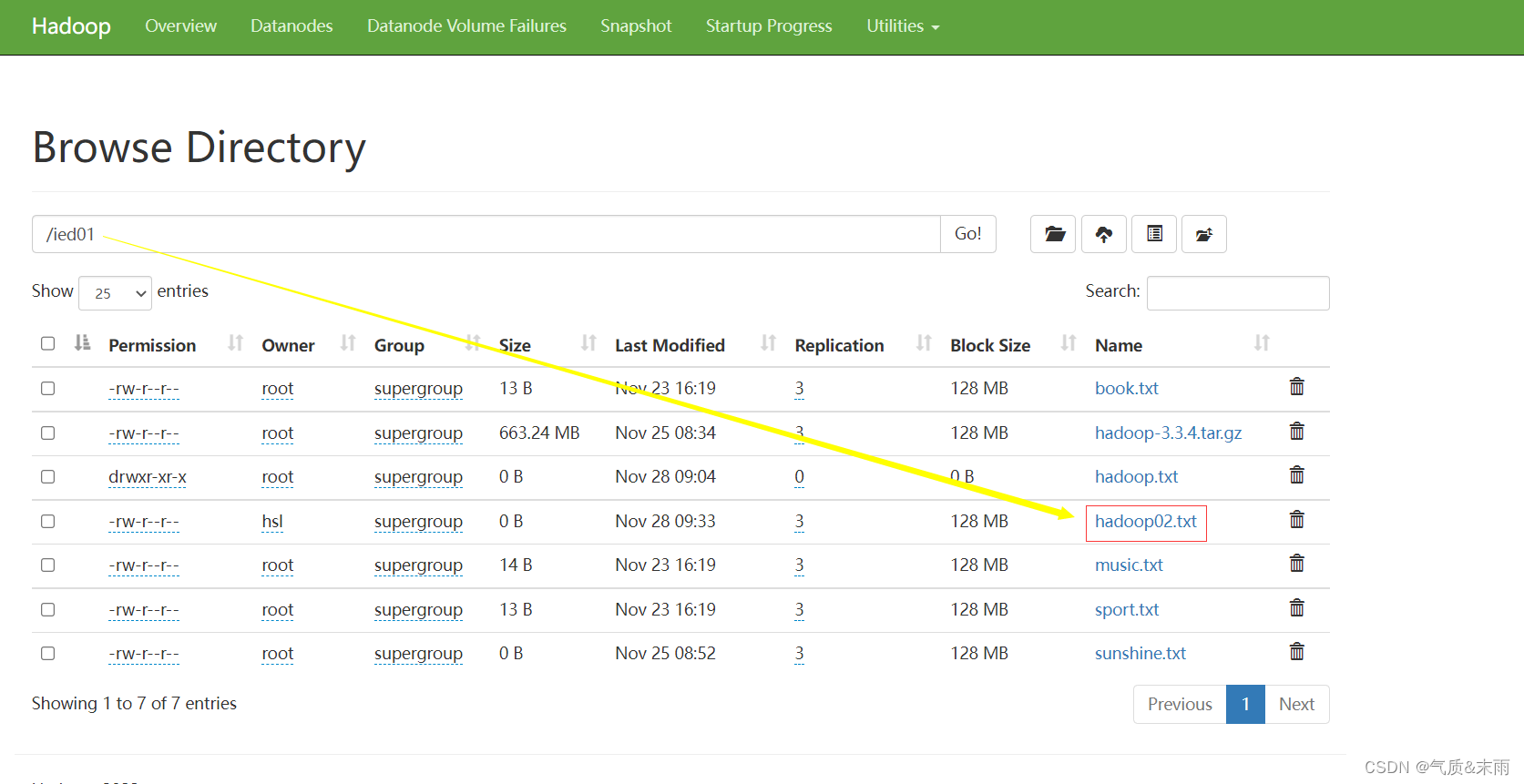

在 /ied01 目录里创建hadoop.txt 文件

输入命令:hdfs dfs -mkdir /ied01/hadoop.txt

在webUI界面进行查看

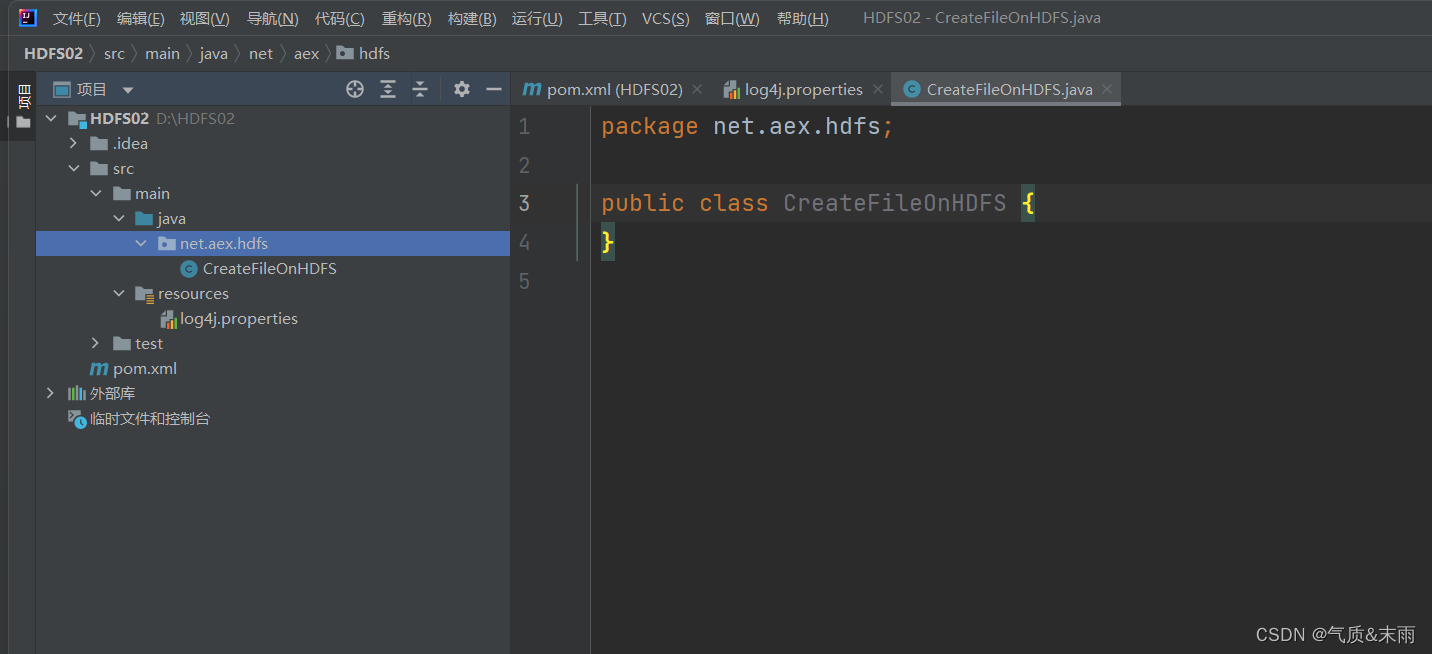

2、在Java 上创建包

创建net.aex.hdfs包,在包里创建CreateFileOnHDFS类

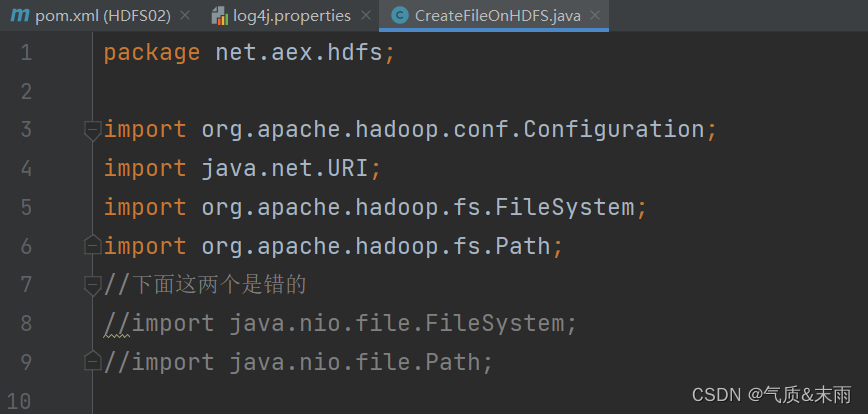

1) 编写create1()方法

注意导入包的时候一定不要导错了,有些很相似

package net.aex.hdfs;import org.apache.hadoop.conf.Configuration;

import java.net.URI;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

//下面这两个是错的

//import java.nio.file.FileSystem;

//import java.nio.file.Path;public class CreateFileOnHDFS {public static void create1() throws Exception{//创建配置对象Configuration conf = new Configuration();//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf);//创建路径对象Path path = new Path(uri + "/ied01/hadoop.txt");//基于路径对象创建文件boolean result = fs.createNewFile(path);//根据返回值判断文件是否创建成功if(result){System.out.println("文件[" + path + "创建成功]");}else{System.out.println("文件[" + path + "创建失败]");}}public static void main(String[] args) throws Exception{create1();}

}

下面使用main方法 对CreateFileOnHDFS 函数方法进行调用

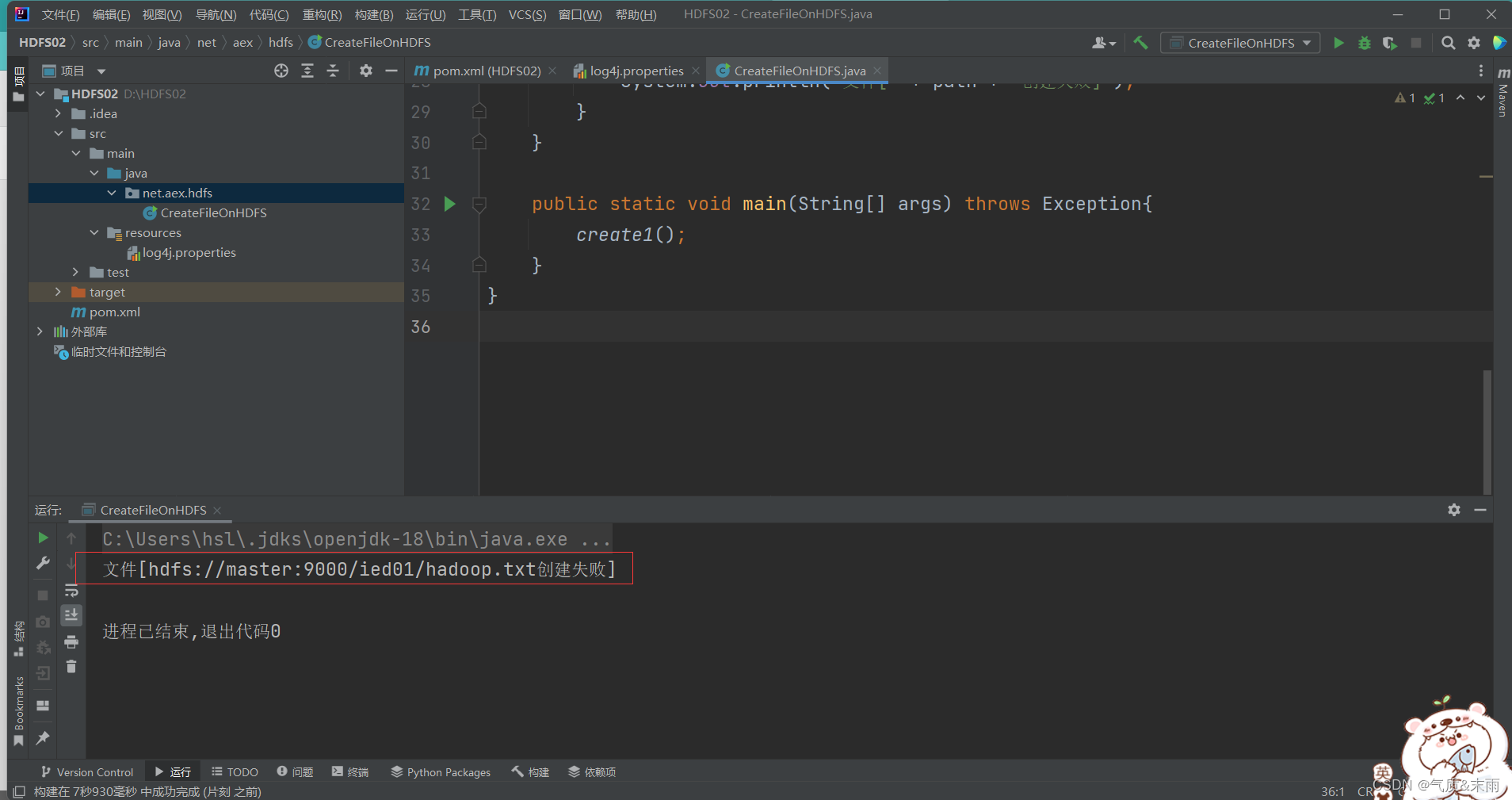

运行程序查看结果,创建失败,因为我们之前已经在linux本地 hdfs上创建了这个文件

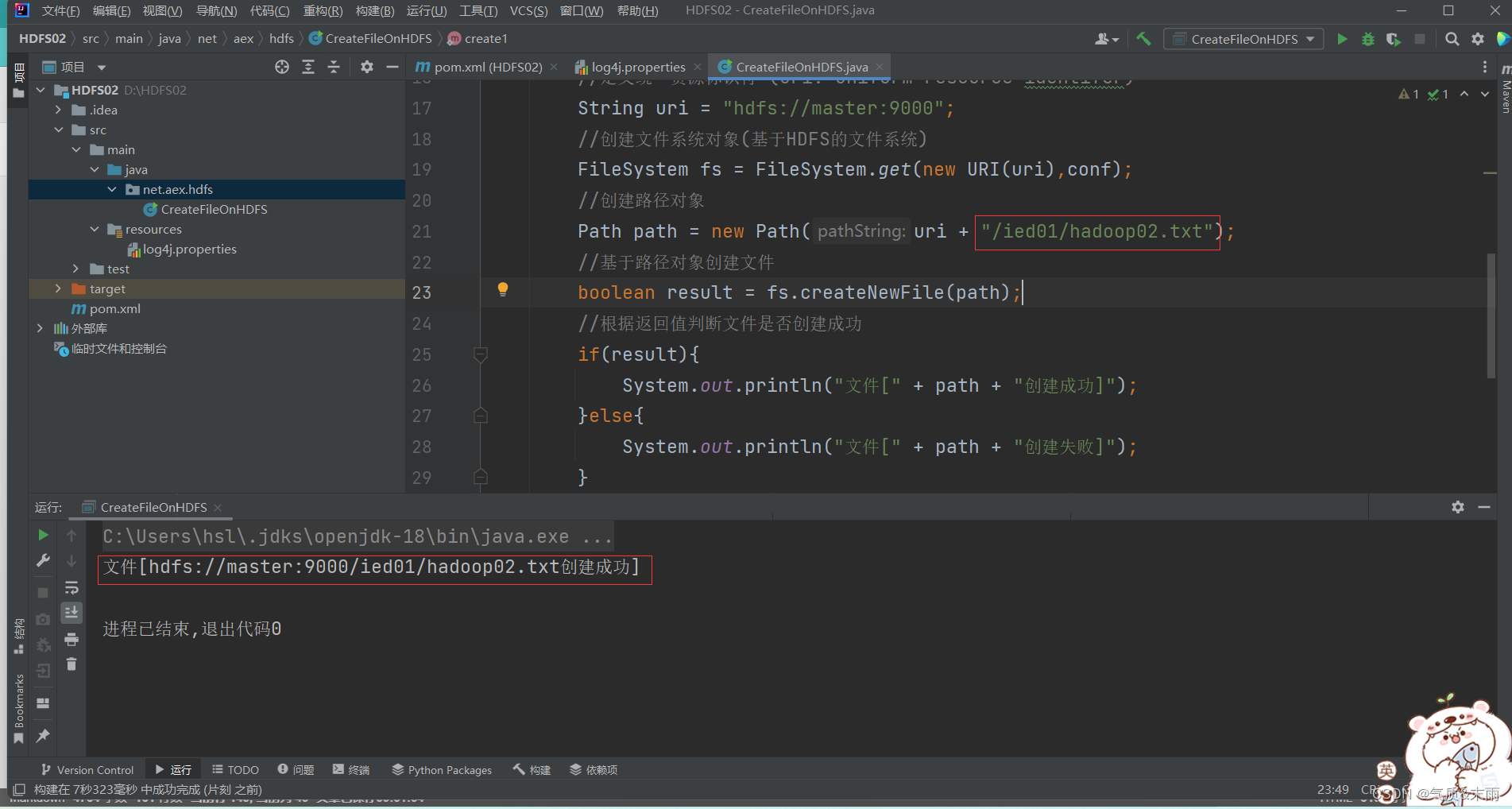

此时将这个创建的文件路径改为 /ied02/hadoop02.txt 就成功了

在webUI界面上进行查看

注意:在/ied01 目录里确实创建了一个0字节的hadoop02.txt文件,有点类似于Hadoop shell 里执行 hdfs dfs -touchz /ied01/hadoop02.txt 但是在linux上面重复执行不会失败,只是会不断改变这个文件的时间戳,但是在Java API里面操作,如果重复执行就会失败

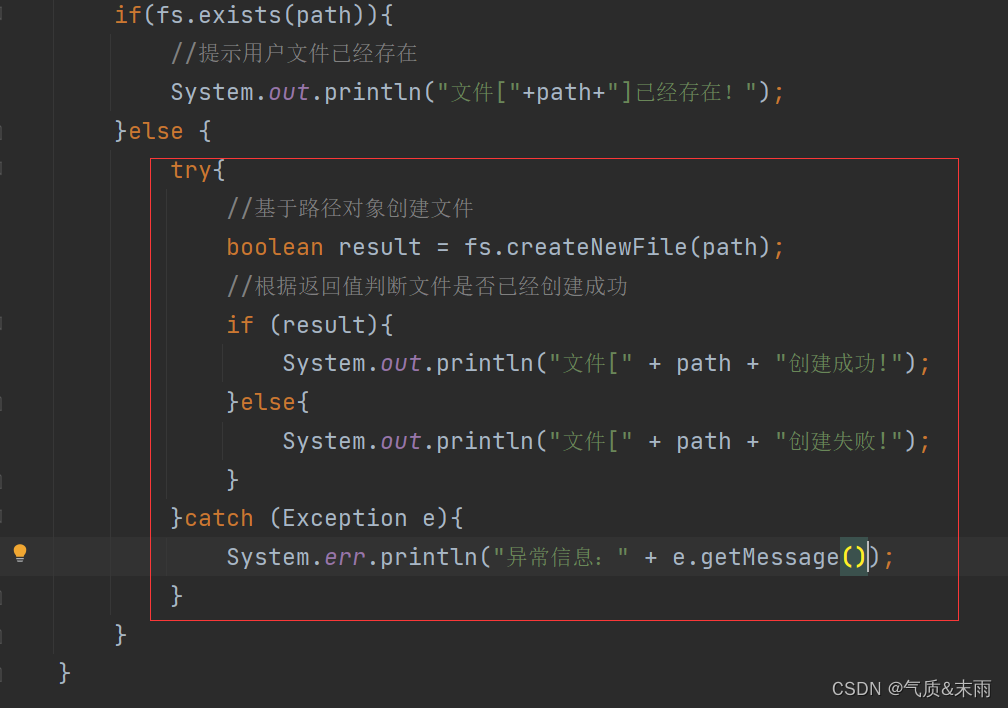

2) 编写create2() 方法

编写create2() 方法,事先判断文件是否已经存在

//create2public static void create2() throws Exception{//创建配置对象Configuration conf = new Configuration();//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf);//创建路径对象Path path = new Path(uri + "/ied01/hadoop.txt");//判断路径对象指定的文件是否已经存在if(fs.exists(path)){//提示用户文件已经存在System.out.println("文件["+path+"]已经存在!");}else {//基于路径对象创建文件boolean result = fs.createNewFile(path);//根据返回值判断文件是否已经创建成功if (result){System.out.println("文件[" + path + "创建成功!");}else{System.out.println("文件[" + path + "创建失败!");}}}

使用main方法调用create2() 函数方法,查看程序运行结果,提示文件已经存在

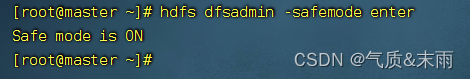

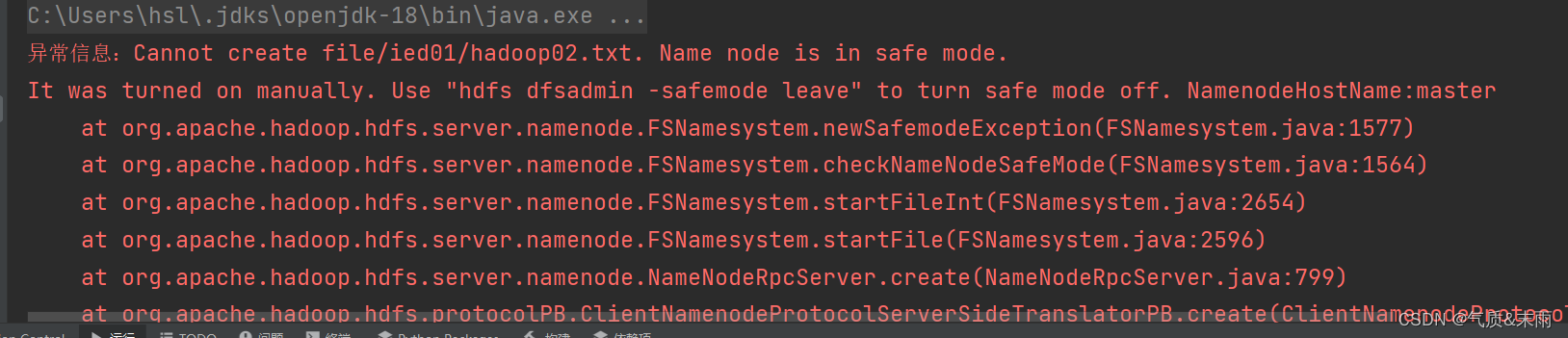

此时我们怎么才能出现文件创建失败的情况呢,我们故意让HDFS进入安全模式(只能读,不能写)

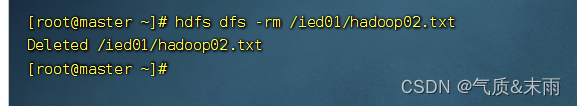

在linux上删除已经创建的/ied01/hadoop02.txt 文件

输入命令: hdfs dfs -rm /ied01/hadoop02.txt

输入命令:hdfs dfsadmin safemode enter 进入安全模式

此时,再运行程序,抛出SafeModelException 异常

修改程序,来处理这个可能会抛出的安全模式异常

使用try catch 来抛出捕获异常

运行程序,查看结果

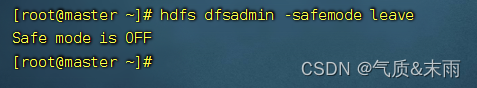

linux 输入命令:hdfs dfsadmin -safemode leave 关闭安全模式

再运行程序,查看结果 创建成功

3、在HDFS上写入文件

在net.aex.hdfs 包里创建WriteFileOnHDFS 类

1) 将数据直接写入HDFS文件

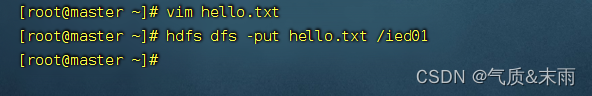

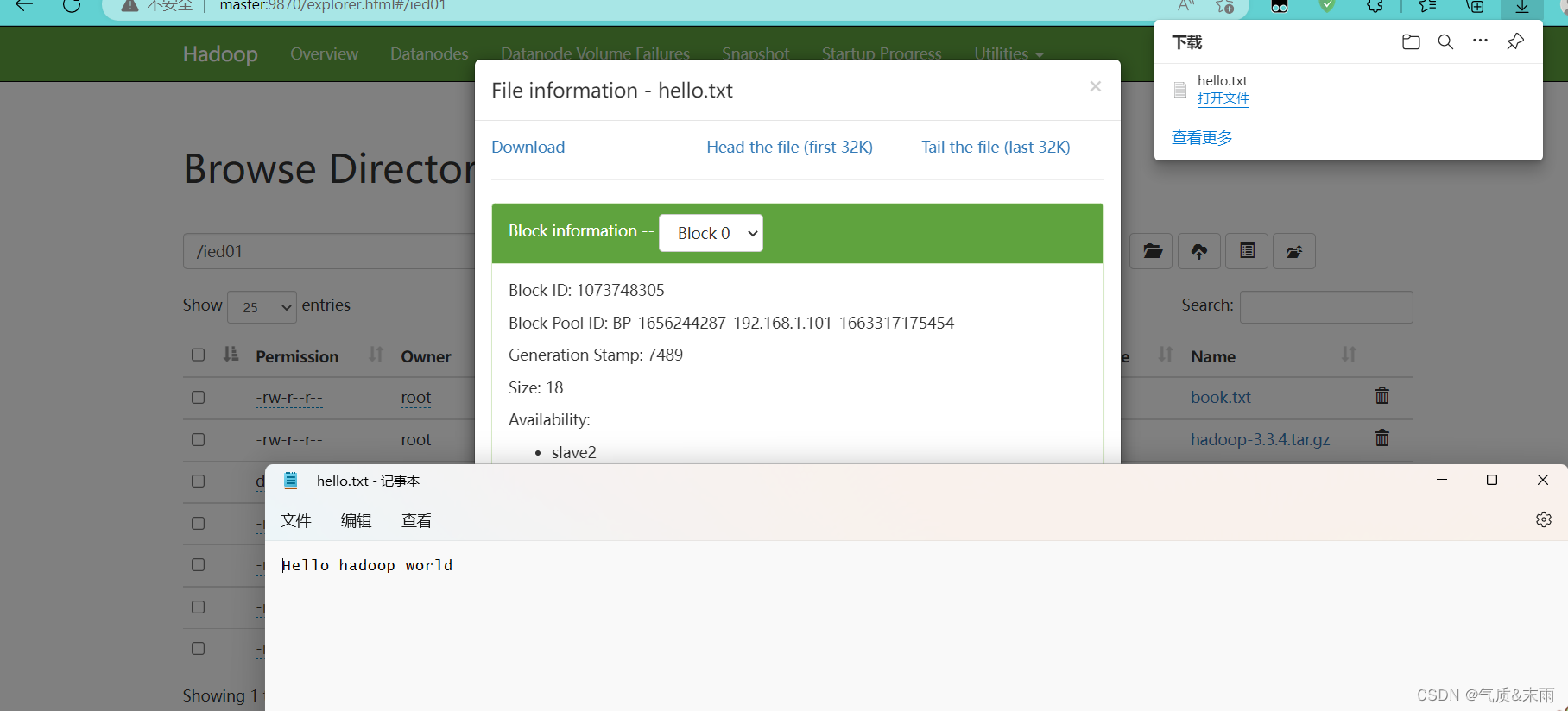

在linux本地 hdfs /ied01目录创建hello.txt文件

(1)编写write1() 方法

在Java 里创建 write1() 函数方法

package net.aex.hdfs;import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import java.net.URI;

import java.nio.charset.StandardCharsets;public class WriteFileOnHDFS {public static void write1() throws Exception{//创建配置对象Configuration conf = new Configuration();//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf);//创建路径对象Path path = new Path(uri + "/ied01/hello.txt");//创建文件系统数据字节输出流FSDataOutputStream out = fs.create(path);//通过字节输出流向文件写入数据out.write("Hello hadoop world".getBytes());//关闭输出流out.close();//关闭文件系统对象fs.close();}public static void main(String[] args) throws Exception{write1();}

}

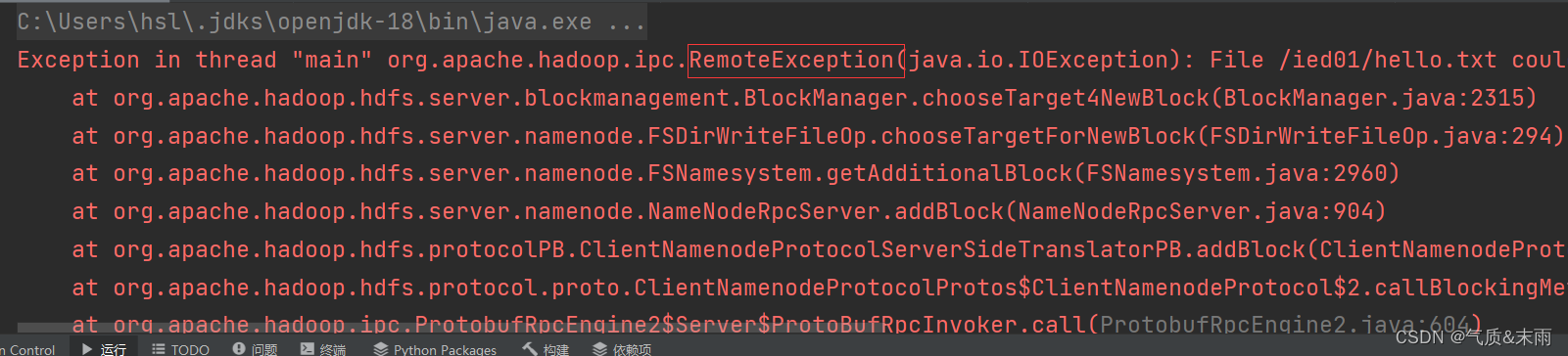

运行程序,查看结果,报错,没有数据节点可以写入数据

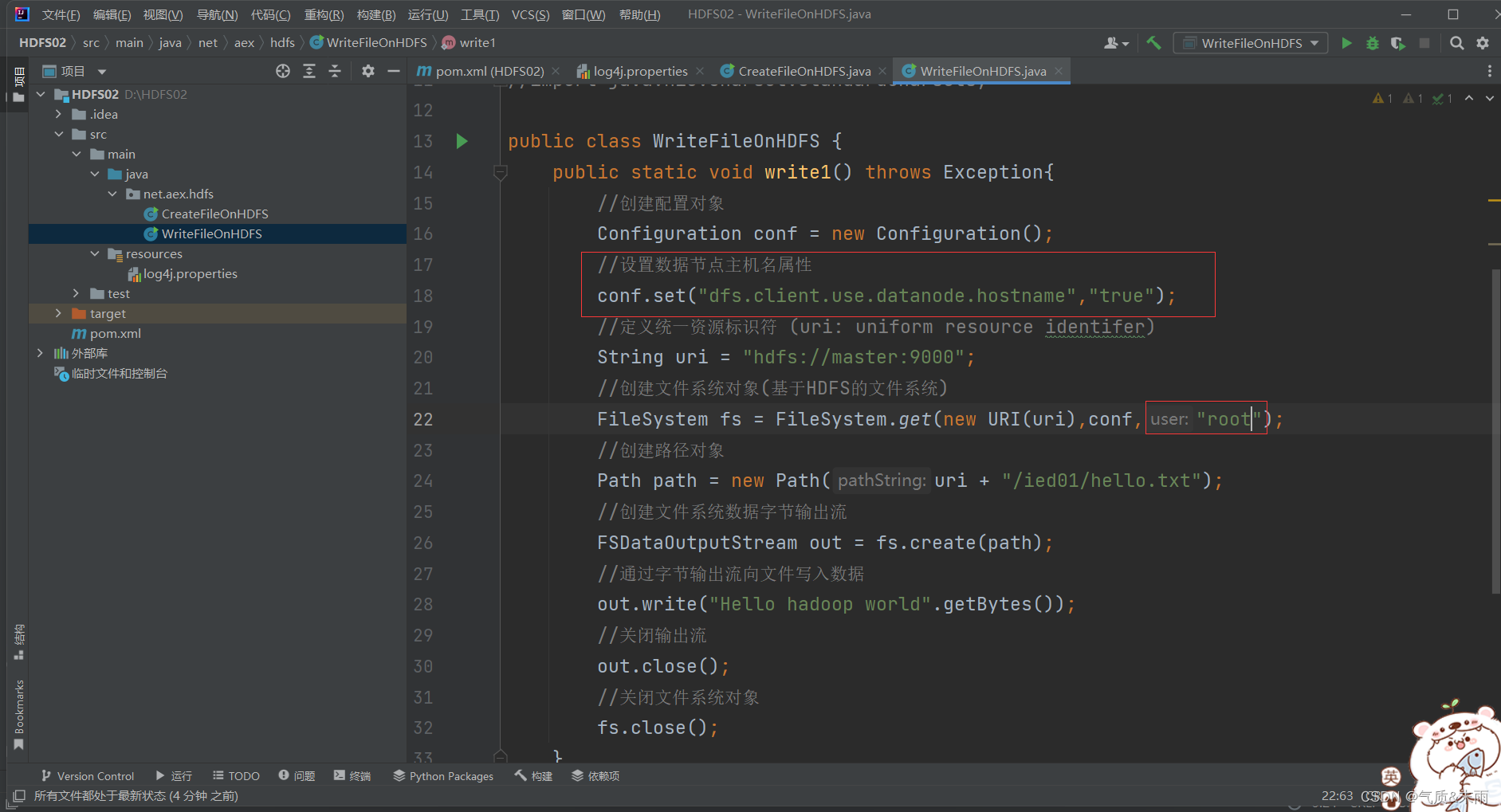

修改代码,添加一个 设置数据节点主机名属性

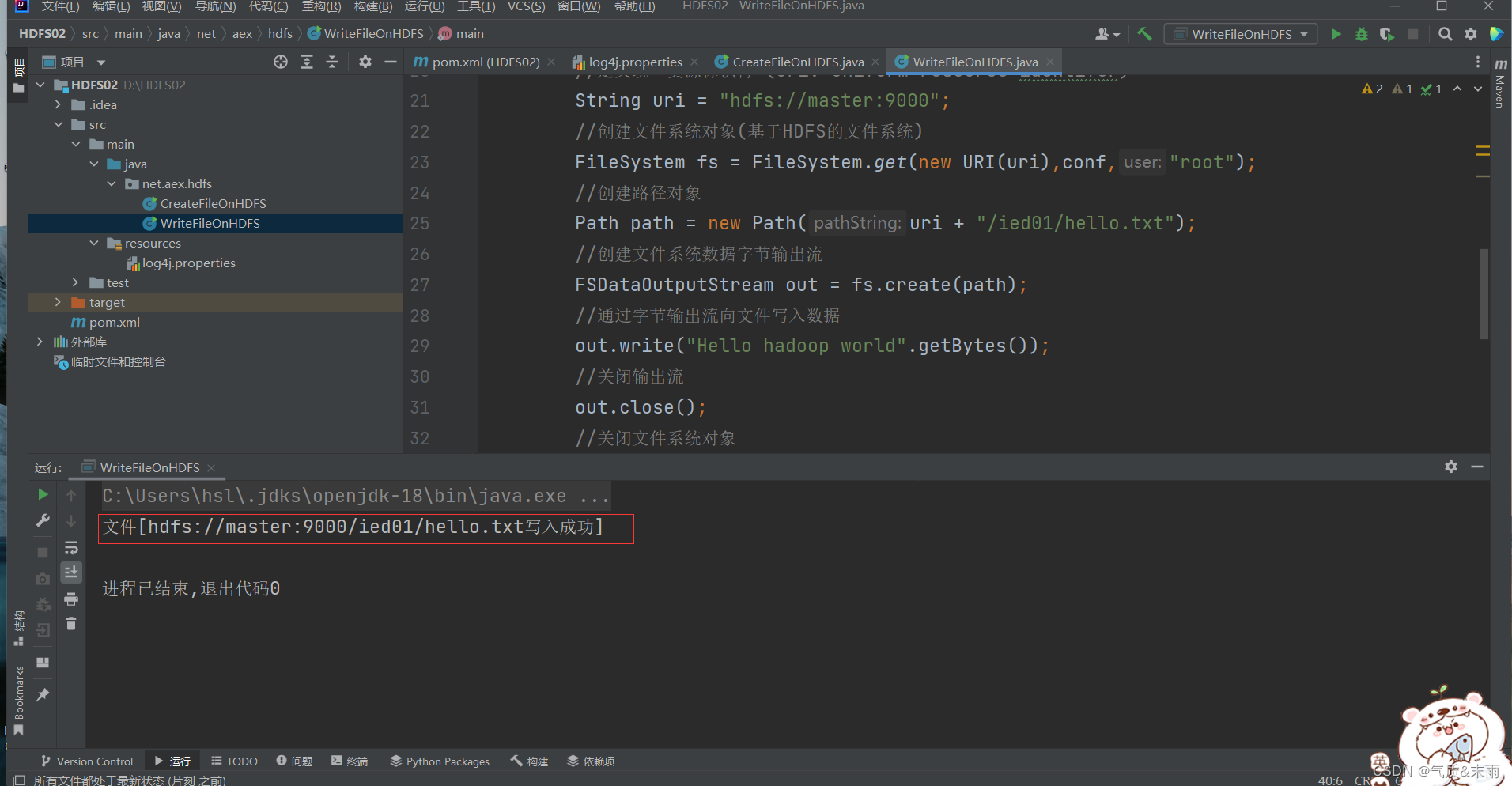

运行1程序,查看结果

在webUI界面上查看hello.txt 文件

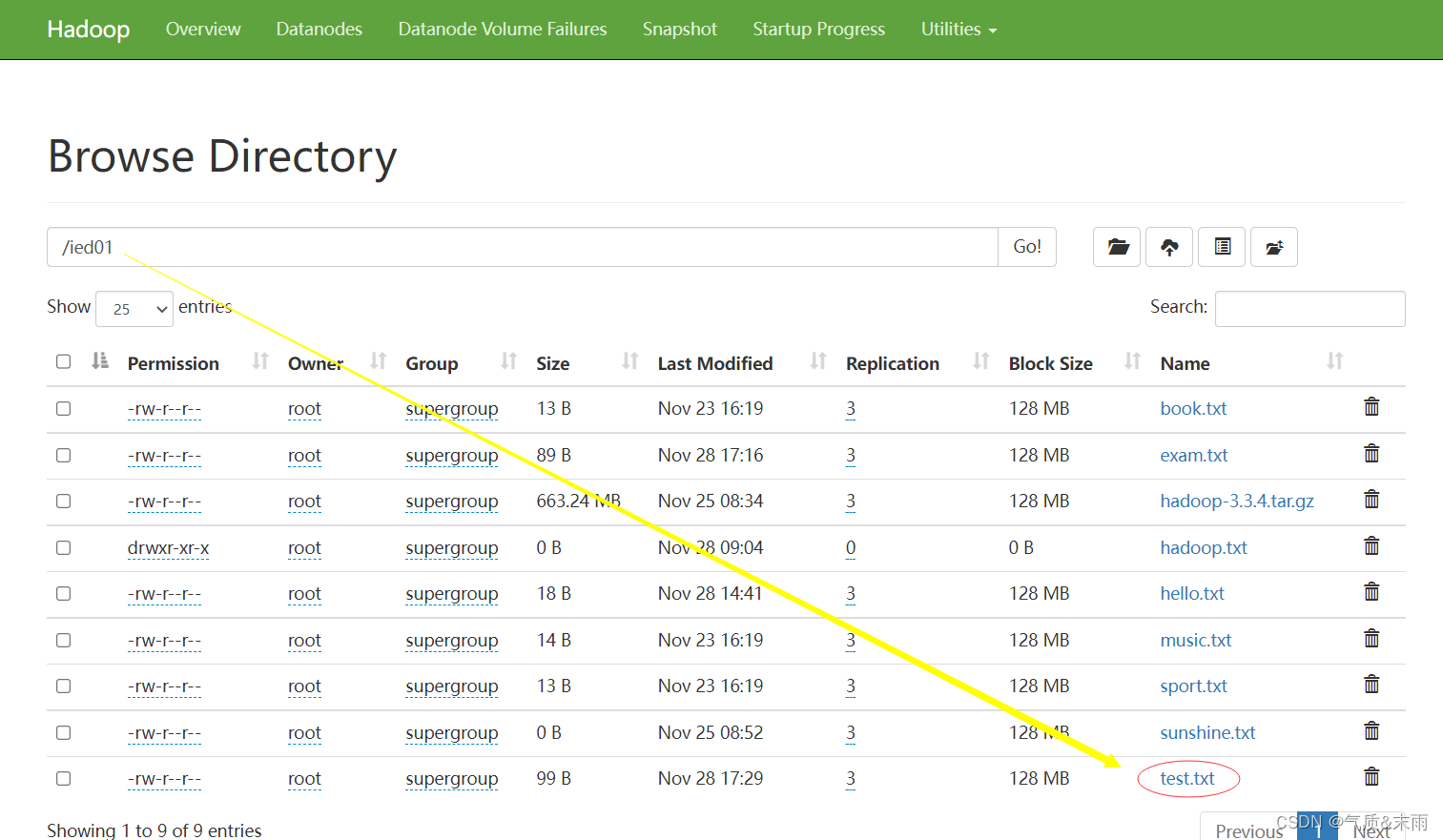

2) 将本地文件写入HDFS文件

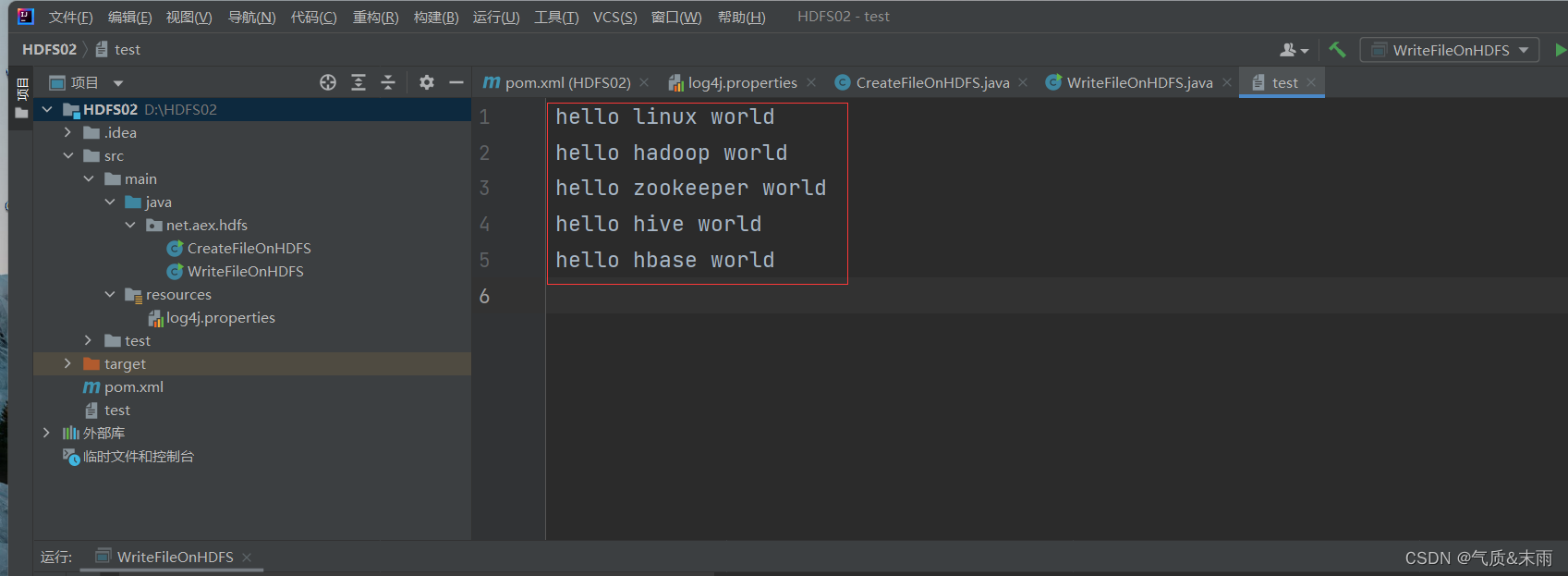

在Java项目根目录创建一个文本文件test.txt

(1)、编写witer2() 方法

在Java WriteFileOnHDFS类里面创建 write2函数方法

//write2public static void write2() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建路径对象Path path = new Path(uri + "/ied01/exam.txt");//创建文件系统数据字节输出流对象FSDataOutputStream out = fs.create(path);//创建文字字符输入流对象FileReader fr = new FileReader("test.txt");//创建缓冲字符输入流对象BufferedReader br = new BufferedReader(fr);//定义行字符串String nextLine = "";//通过循环读取缓冲字符输入流while ((nextLine=br.readLine()) != null){//在控制台输出读取的行System.out.println(nextLine);//通过文件系统数据字节输出流对象写入指定文件out.write(nextLine.getBytes());}//关闭文件系统字节输出流out.close();//关闭缓冲字符输入流br.close();//关闭文件字符输入流fr.close();//提示用户写入文件成功System.out.println("本地文件[test.txt]成功写入[" + path + "]!");}

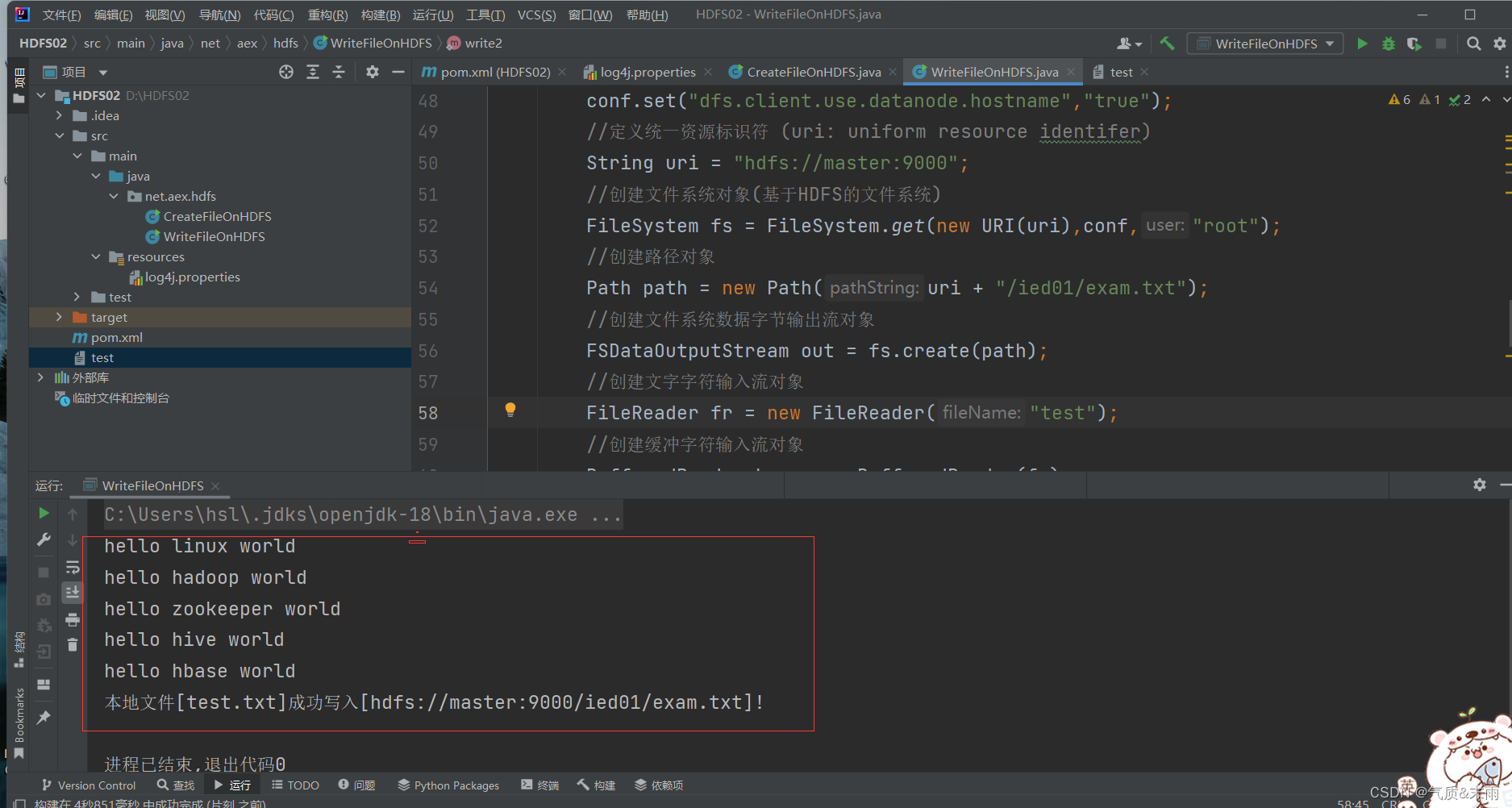

main函数调用write2() 方法,查看结果 写入成功

其实这个方法的功能就是将本地文件复制(上传)到HDFS,有更简单的处理方法,通过使用一个工具类IOUtils来完成文件的相关操作

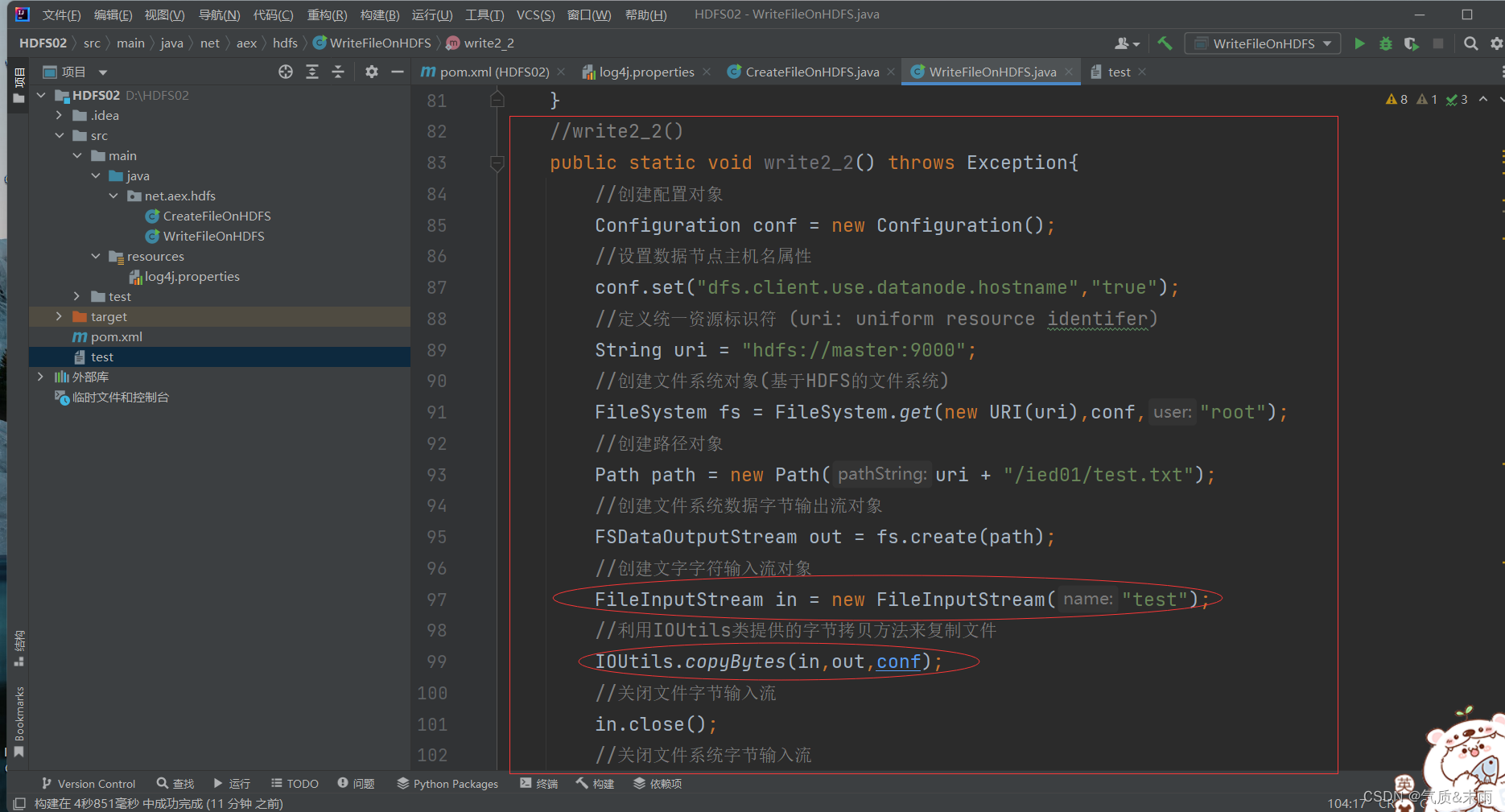

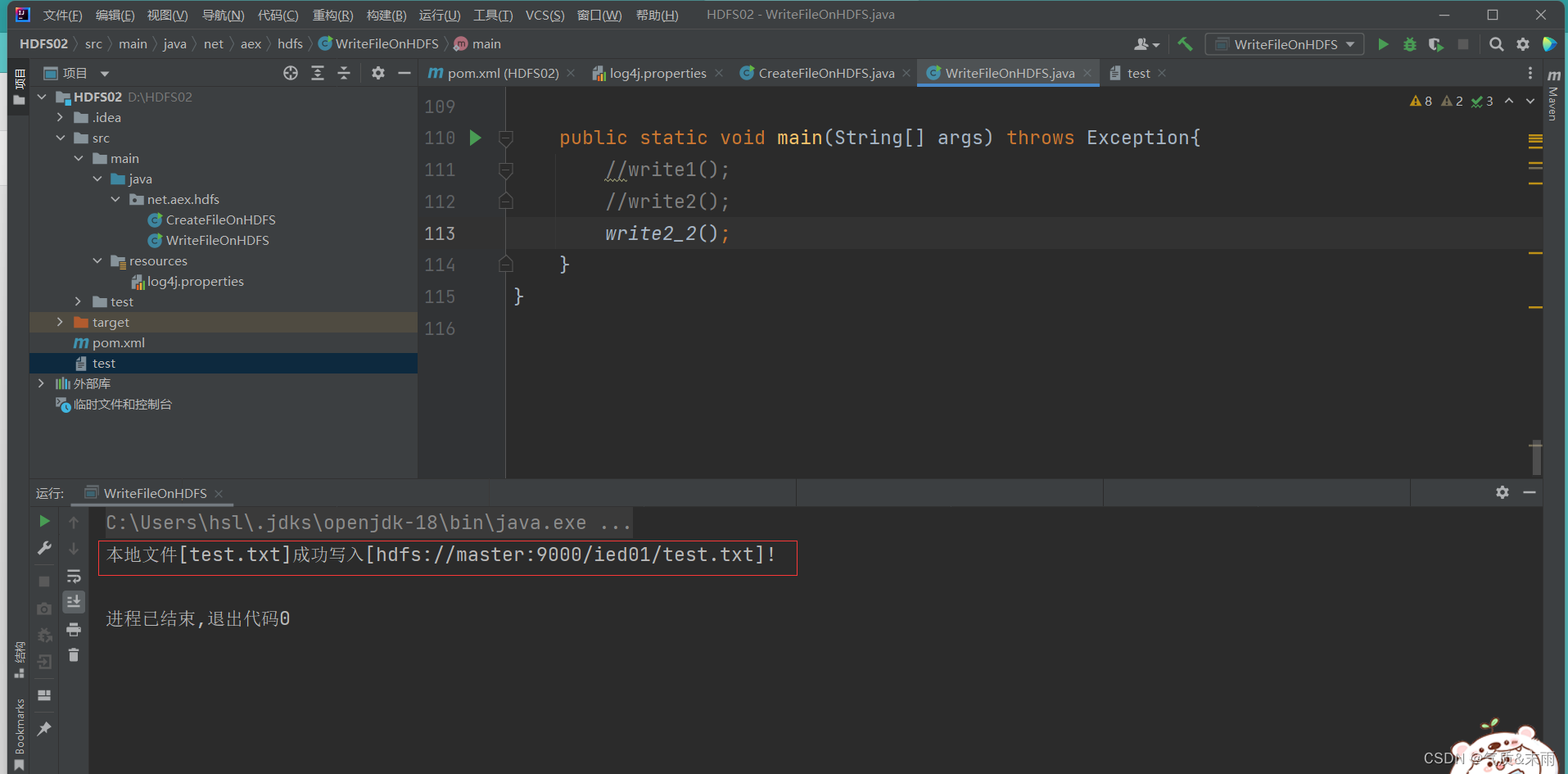

(2)、编写write2_2() 方法

//write2_2()public static void write2_2() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建路径对象Path path = new Path(uri + "/ied01/test.txt");//创建文件系统数据字节输出流对象FSDataOutputStream out = fs.create(path);//创建文字字符输入流对象FileInputStream in = new FileInputStream("test");//利用IOUtils类提供的字节拷贝方法来复制文件IOUtils.copyBytes(in,out,conf);//关闭文件字节输入流in.close();//关闭文件系统字节输入流out.close();//关闭文件系统fs.close();//提示用户写入文件成功System.out.println("本地文件[test.txt]成功写入[" + path + "]!");}

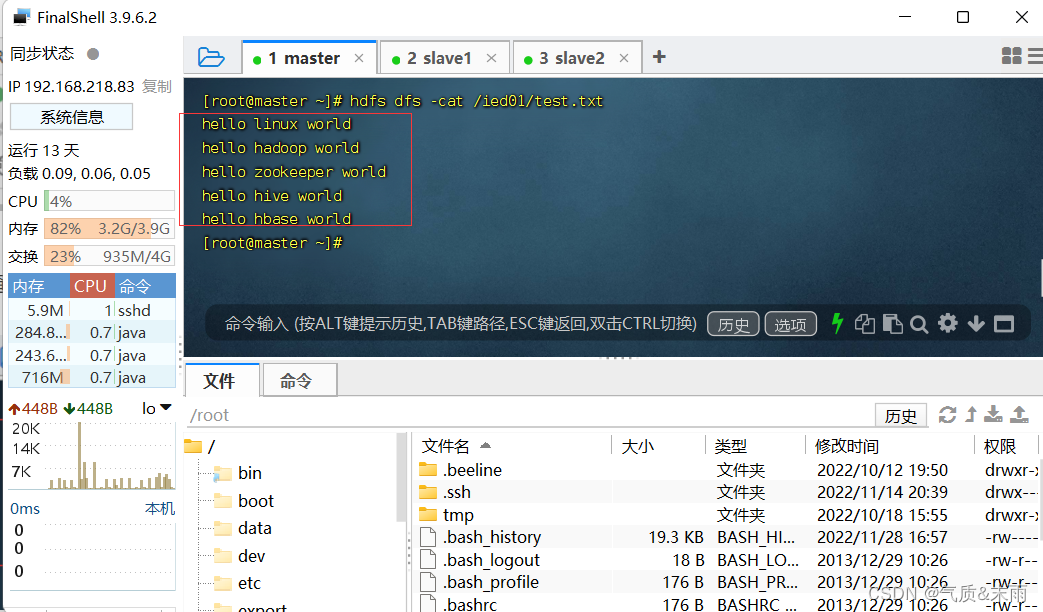

使用main方法,运行write2_2() 函数方法 查看结果 写入成功

在linux查看hdfs 目录 /ied01/test.txt内容

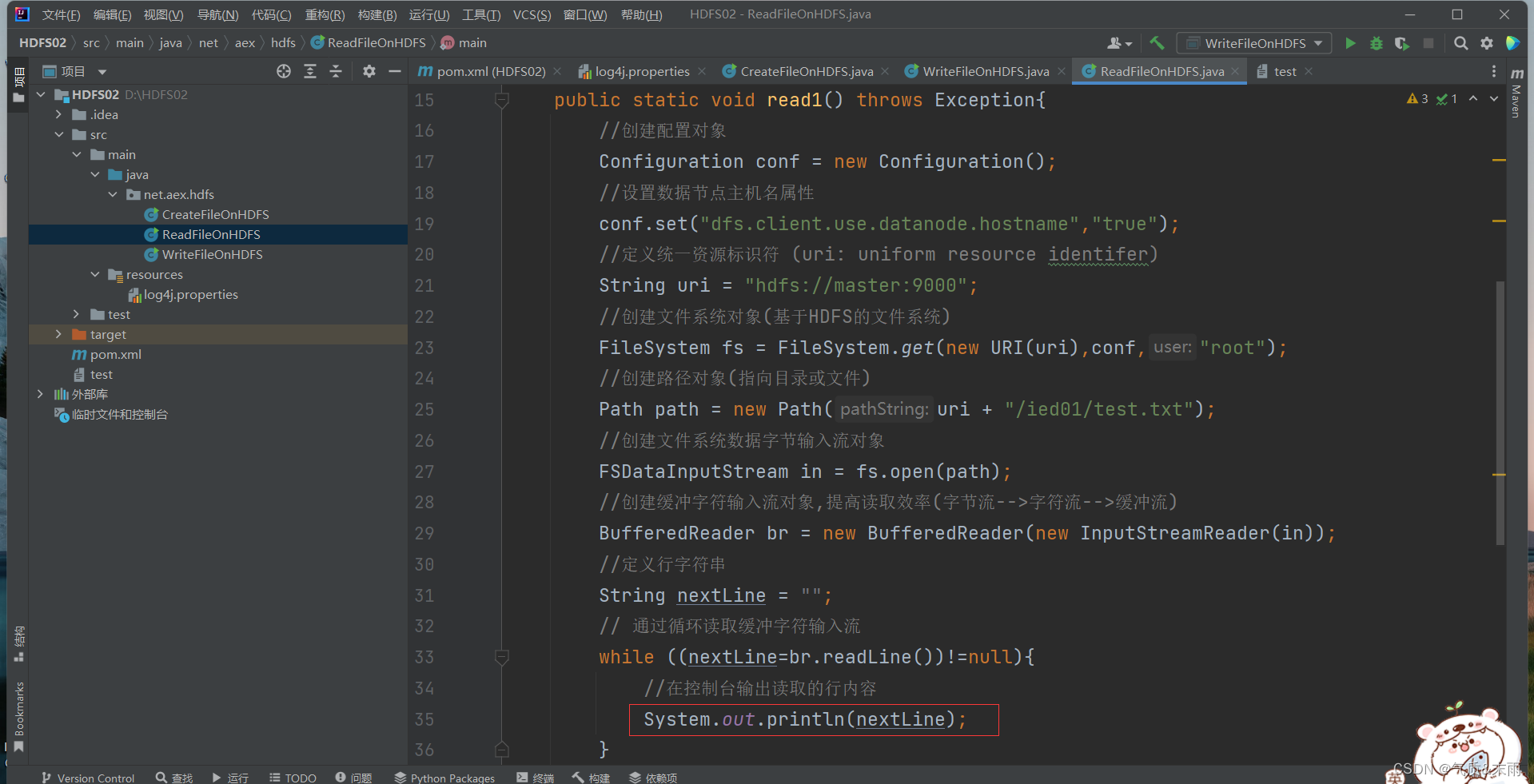

4、读取HDFS文件

相当于Shell里的两个命令:hdfs dfs -cat 和 hdfs dfs -get

在net.aex.hdfs包里创建ReadFileOnHDFS类

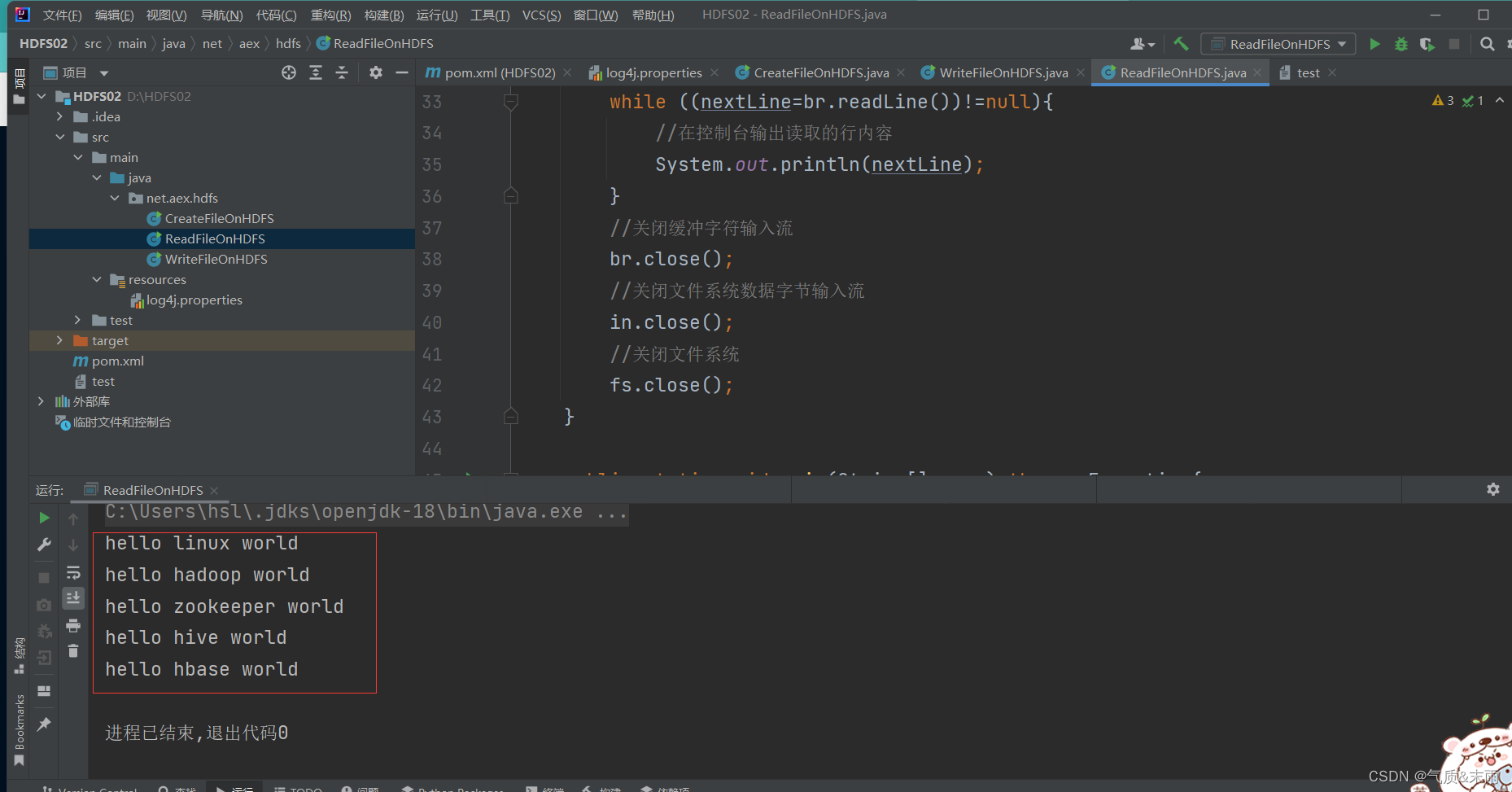

1) 读取HDFS文件直接在控制台显示

准备读取 /ied01/test.txt 文件

(1) 编写read1() 方法

package net.aex.hdfs;import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import java.io.BufferedReader;

import java.io.FileReader;

import java.io.InputStreamReader;

import java.net.URI;public class ReadFileOnHDFS {public static void read1() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建路径对象(指向目录或文件)Path path = new Path(uri + "/ied01/test.txt");//创建文件系统数据字节输入流对象FSDataInputStream in = fs.open(path);//创建缓冲字符输入流对象,提高读取效率(字节流-->字符流-->缓冲流)BufferedReader br = new BufferedReader(new InputStreamReader(in));//定义行字符串String nextLine = "";// 通过循环读取缓冲字符输入流while ((nextLine=br.readLine())!=null){//在控制台输出读取的行内容System.out.println(nextLine);}//关闭缓冲字符输入流br.close();//关闭文件系统数据字节输入流in.close();//关闭文件系统fs.close();}public static void main(String[] args) throws Exception{read1();}

}

使用main方法调用 read1() 函数方法 查看结果 将/ied01/test.txt里的文件读取出来了

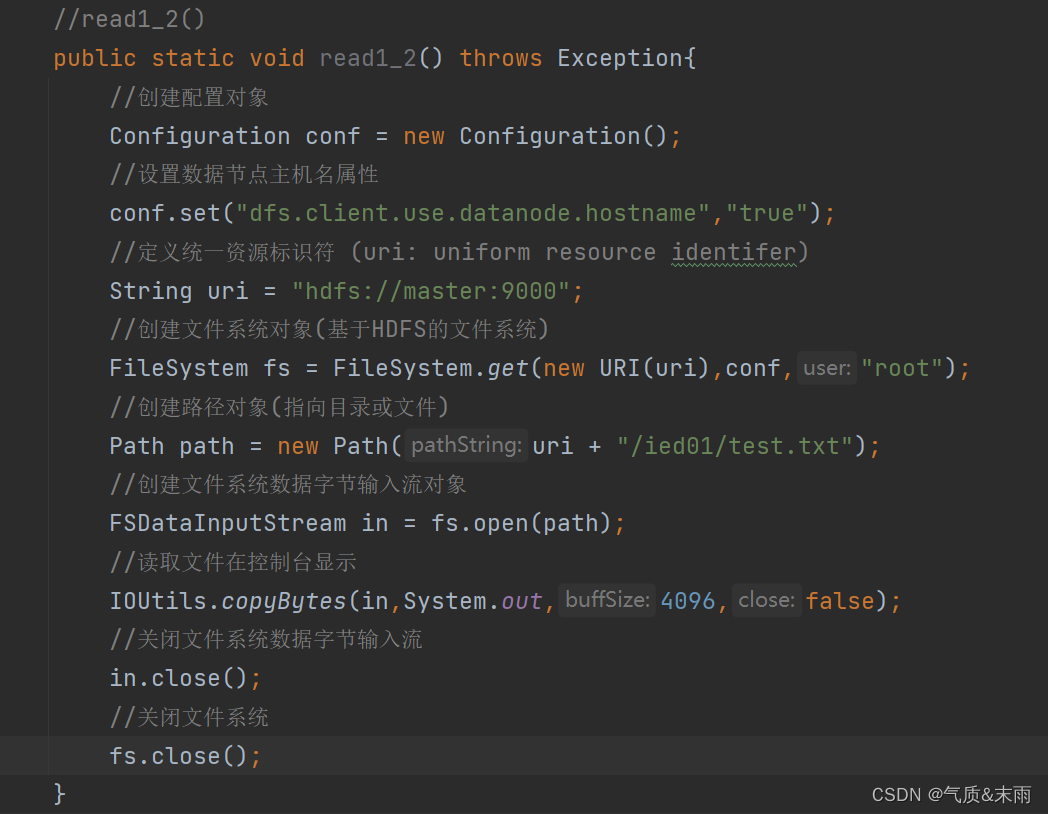

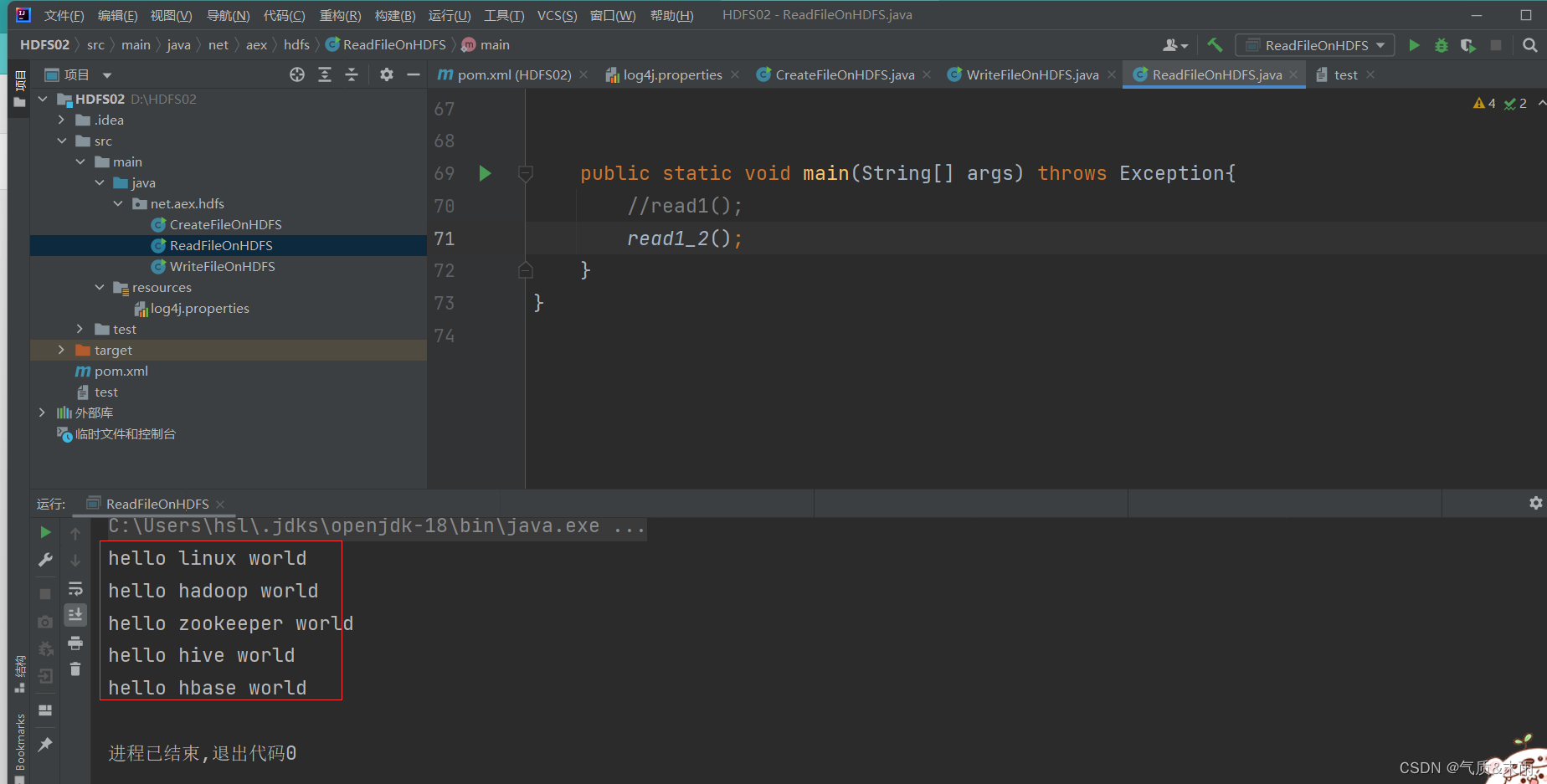

其实我们可以使用IOUtils类来简化代码,创建read_()函数方法

//read1_2()public static void read1_2() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建路径对象(指向目录或文件)Path path = new Path(uri + "/ied01/test.txt");//创建文件系统数据字节输入流对象FSDataInputStream in = fs.open(path);//读取文件在控制台显示IOUtils.copyBytes(in,System.out,4096,false);//关闭文件系统数据字节输入流in.close();//关闭文件系统fs.close();}

使用main方法,调用read1_2() 函数方法 查看结果

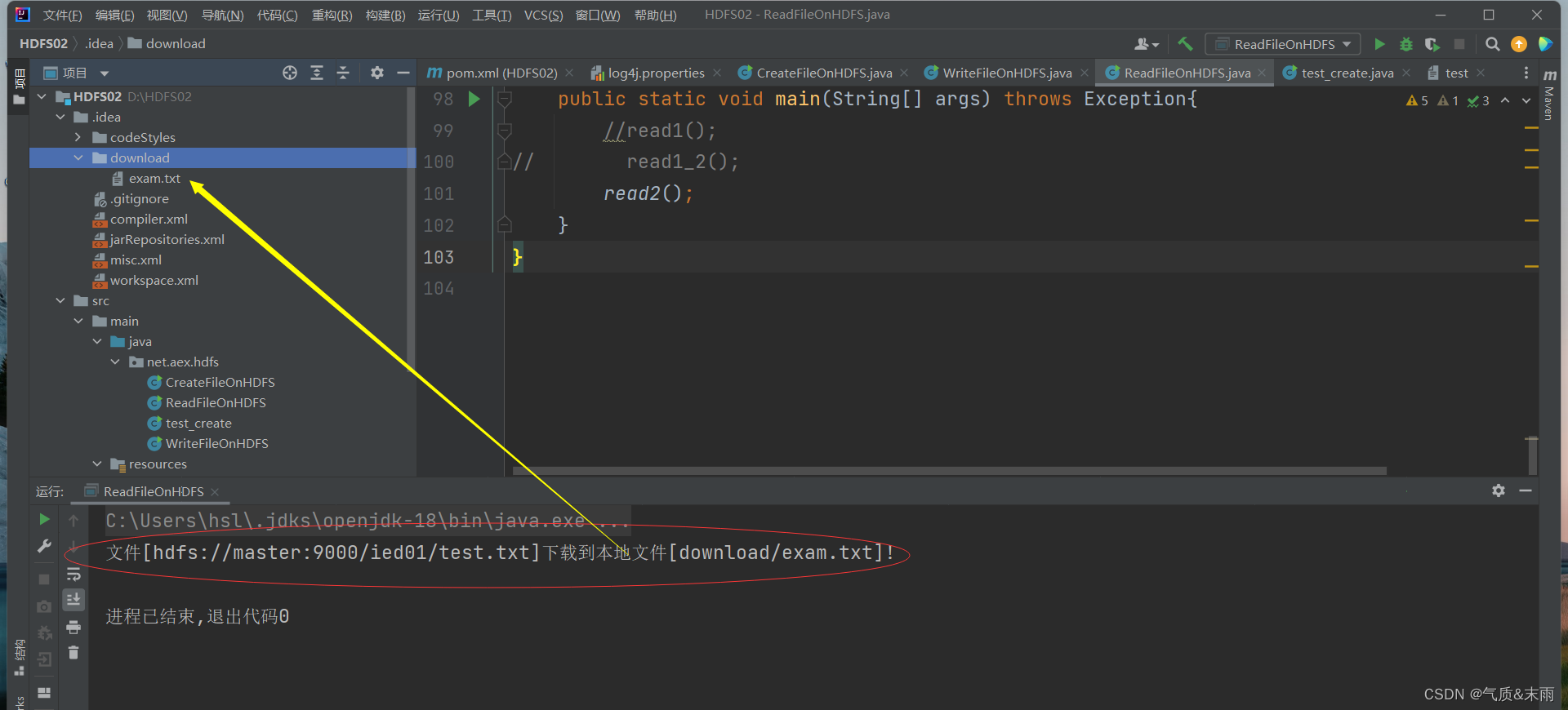

2) 读取HDFS文件,保存为本地文件

任务:将/ied01/test.txt 下载到项目下download目录里

(1) 创建read2()方法

//read2()public static void read2() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建路径对象(指向目录或文件)Path path = new Path(uri + "/ied01/test.txt");//创建文件系统数据字节输入流对象FSDataInputStream in = fs.open(path);//创建文件字节输出流FileOutputStream out = new FileOutputStream("D:\\HDFS02\\.idea\\download\\exam.txt");//读取HDFS文件(靠输入流),写入本地文件(靠输出流)IOUtils.copyBytes(in,out,conf);//关闭文件系统数据字节输入流in.close();//关闭文件字节输出流in.close();//关闭文件系统fs.close();//提示用户文件下载成功System.out.println("文件["+path+"]下载到本地文件[download/exam.txt]!");}

使用main方法,调用read2()函数,查看结果 exam.txt 文件已经下载到本地的download目录下了

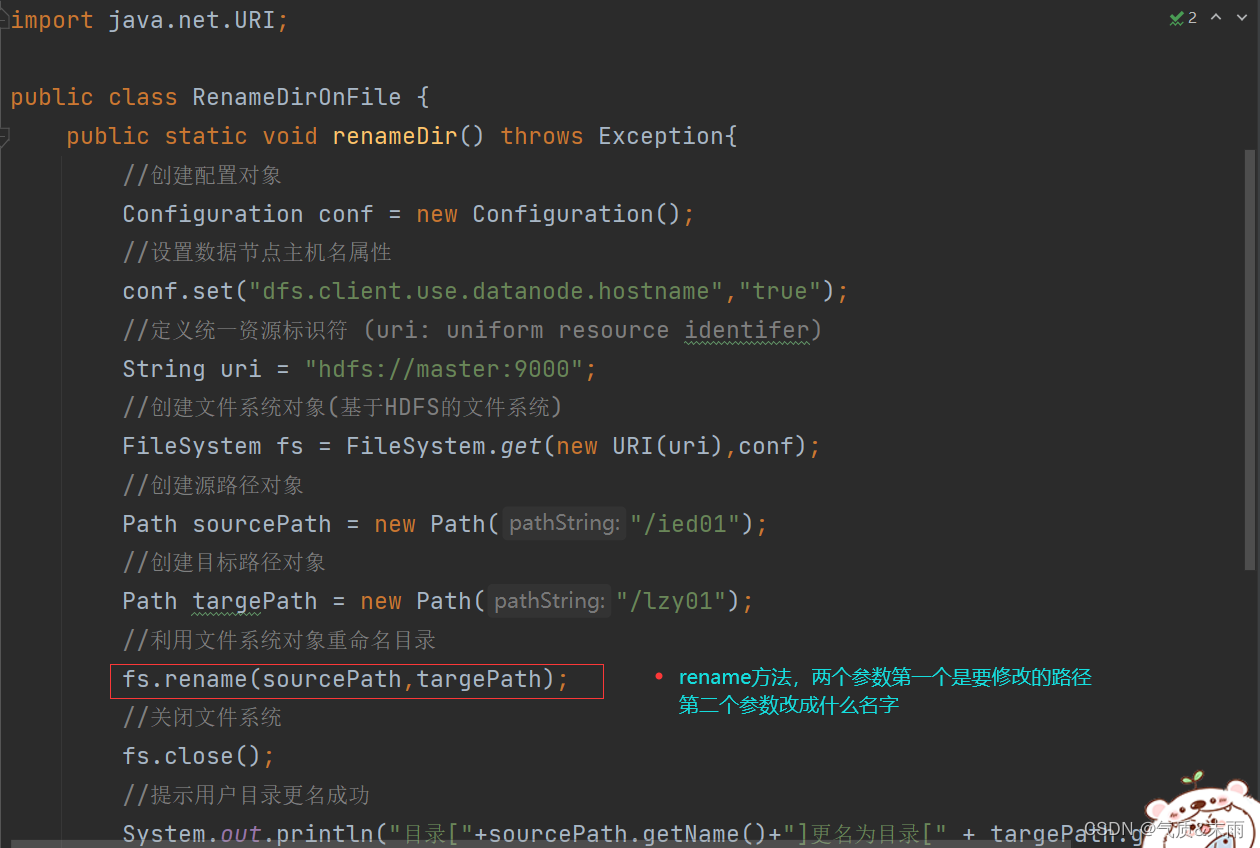

5、重命名目录或文件

1) 重命名目录

任务:将/ied01 目录更名为 /lzy01

(1) 编写renameDir() 方法

package net.aex.hdfs;import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import java.net.URI;public class RenameDirOnFile {public static void renameDir() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf);//创建源路径对象Path sourcePath = new Path("/ied01");//创建目标路径对象Path targePath = new Path("/lzy01");//利用文件系统对象重命名目录fs.rename(sourcePath,targePath);//关闭文件系统fs.close();//提示用户目录更名成功System.out.println("目录["+sourcePath.getName()+"]更名为目录[" + targePath.getName() + "]!");}public static void main(String[] args) throws Exception{renameDir();}

}

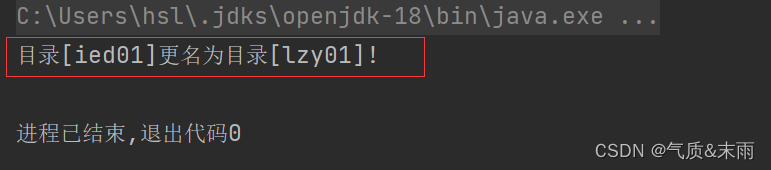

使用main方法调用renameDir()函数,查看结果 成功从/ied01 改为 lzy01

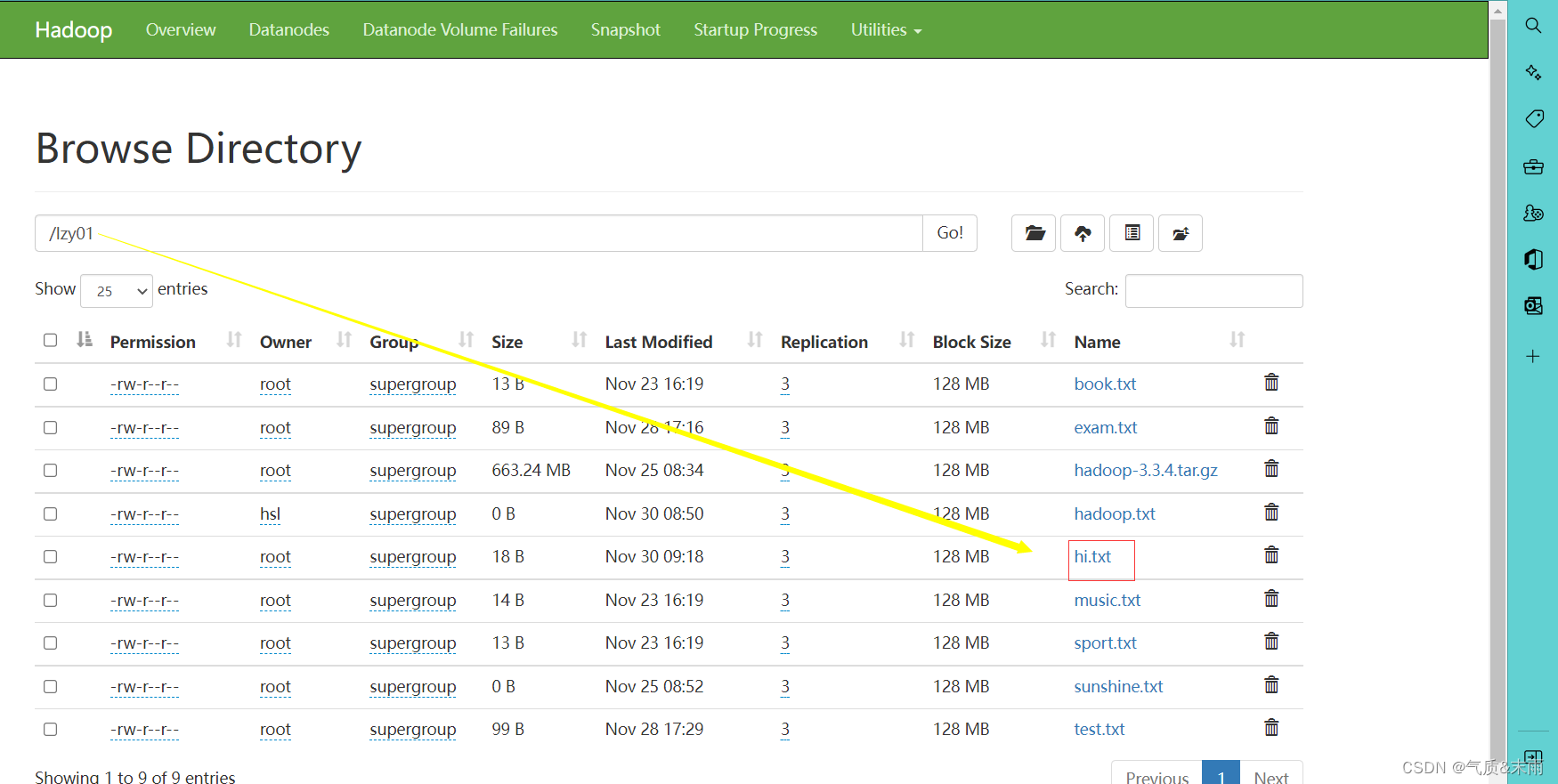

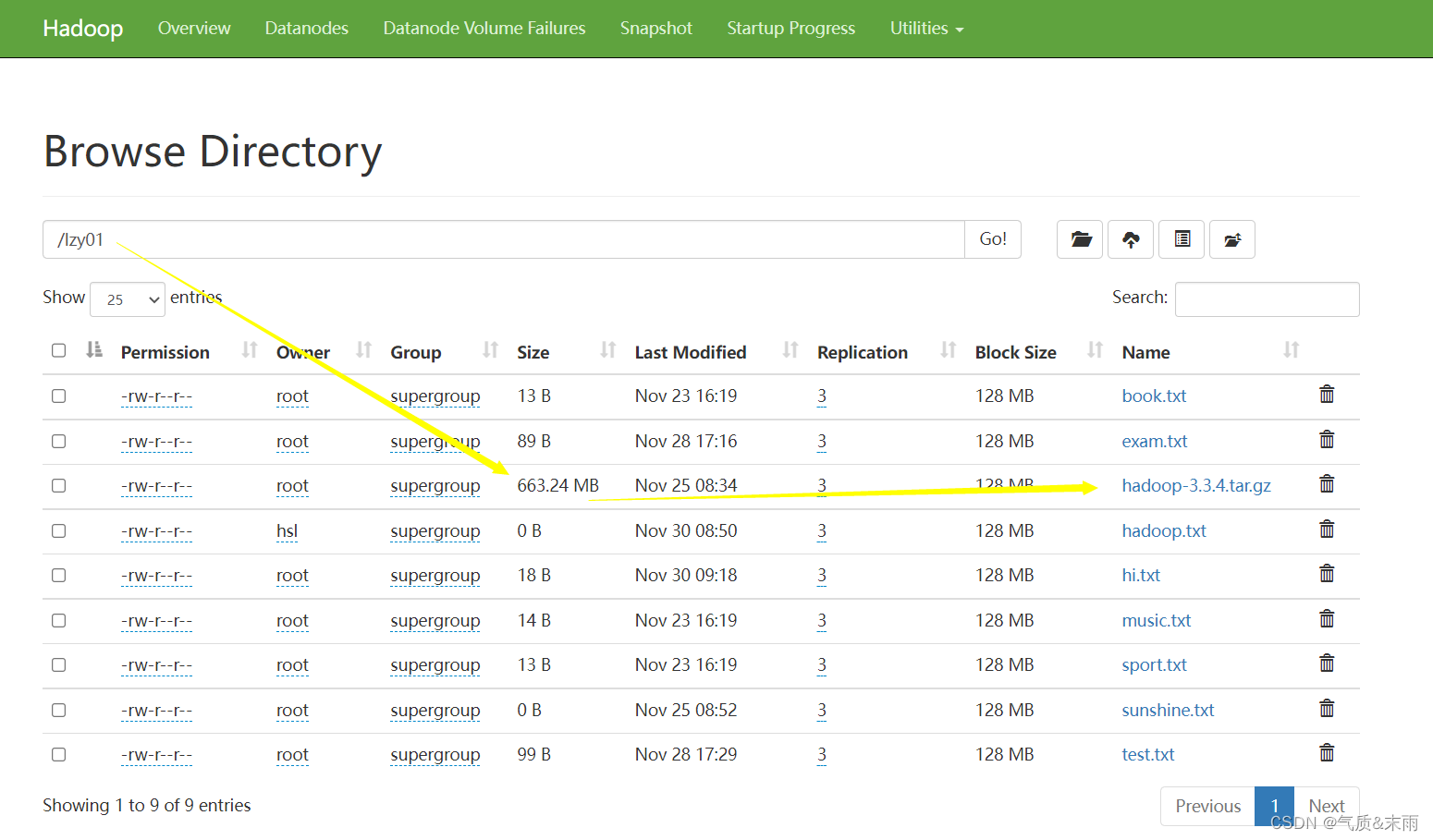

在webUI界面进行查看

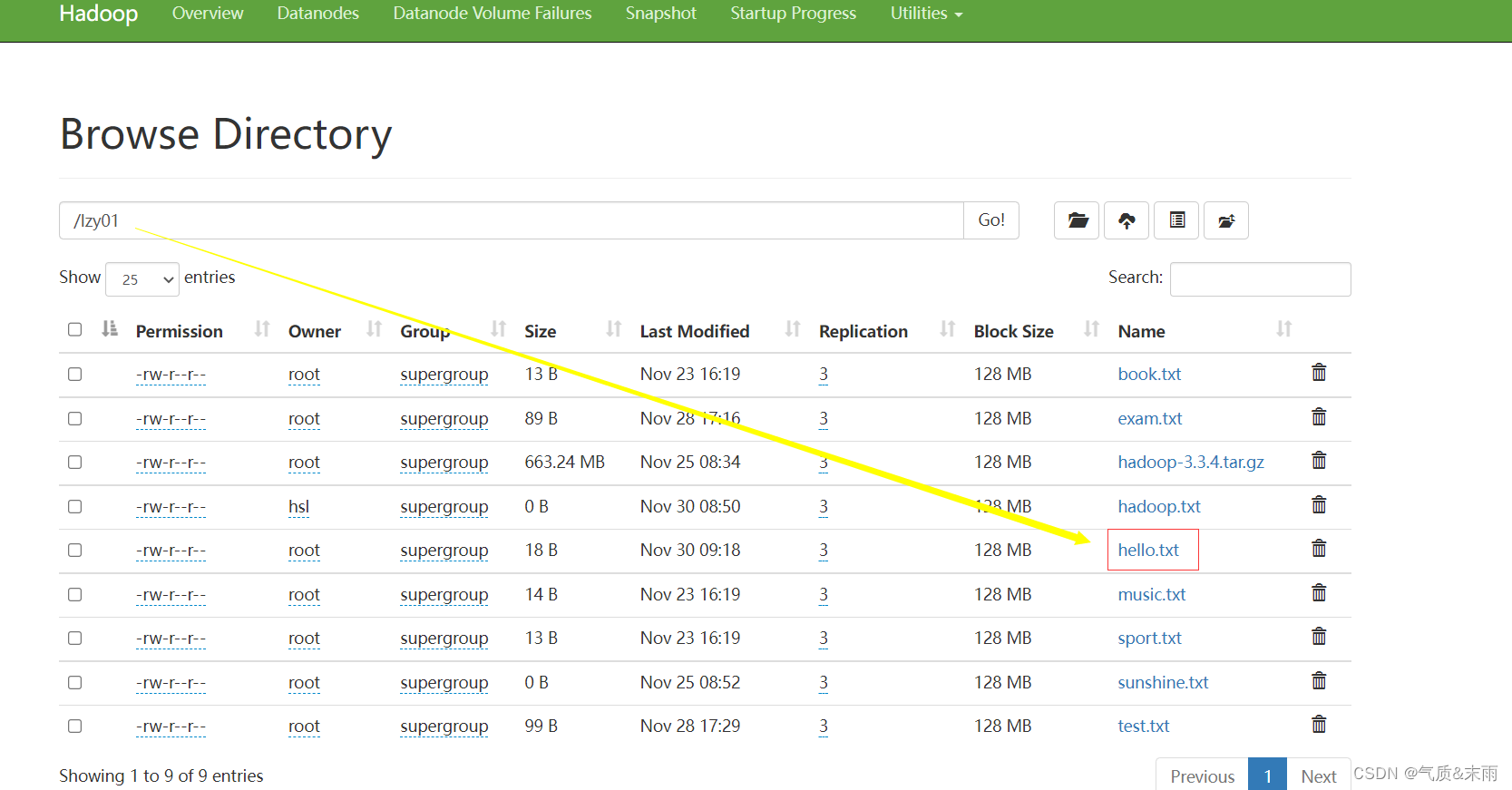

2) 重命名文件

任务:将/lzy01目录下的hello.txt重名为hi.txt

(1)编写renameFile() 方法

主要需要两个对象的路径然后通过文件系统.rename()方法,把两个文件路径放进去进行更改

public static void renameFile() throws Exception{//创建配置对象Configuration conf = new Configuration();//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf);//创建源路径对象Path sourcePath = new Path("/lzy01/hello.txt");//目标对象//创建目标路径对象(指向文件)Path targePath = new Path("/lzy01/hi.txt");//利用文件系统重命名文件fs.rename(sourcePath,targePath);//关闭文件系统fs.close();//提示用户更更名成功System.out.println("文件[" + sourcePath.getName() + "]更名文件[" + targePath.getName() + "]!");}

使用main方法调用renameFile()方法,查看结果 更名成功

6、显示文件列表

在net.aex.hdfs 包里创建ListHDFSFiles类

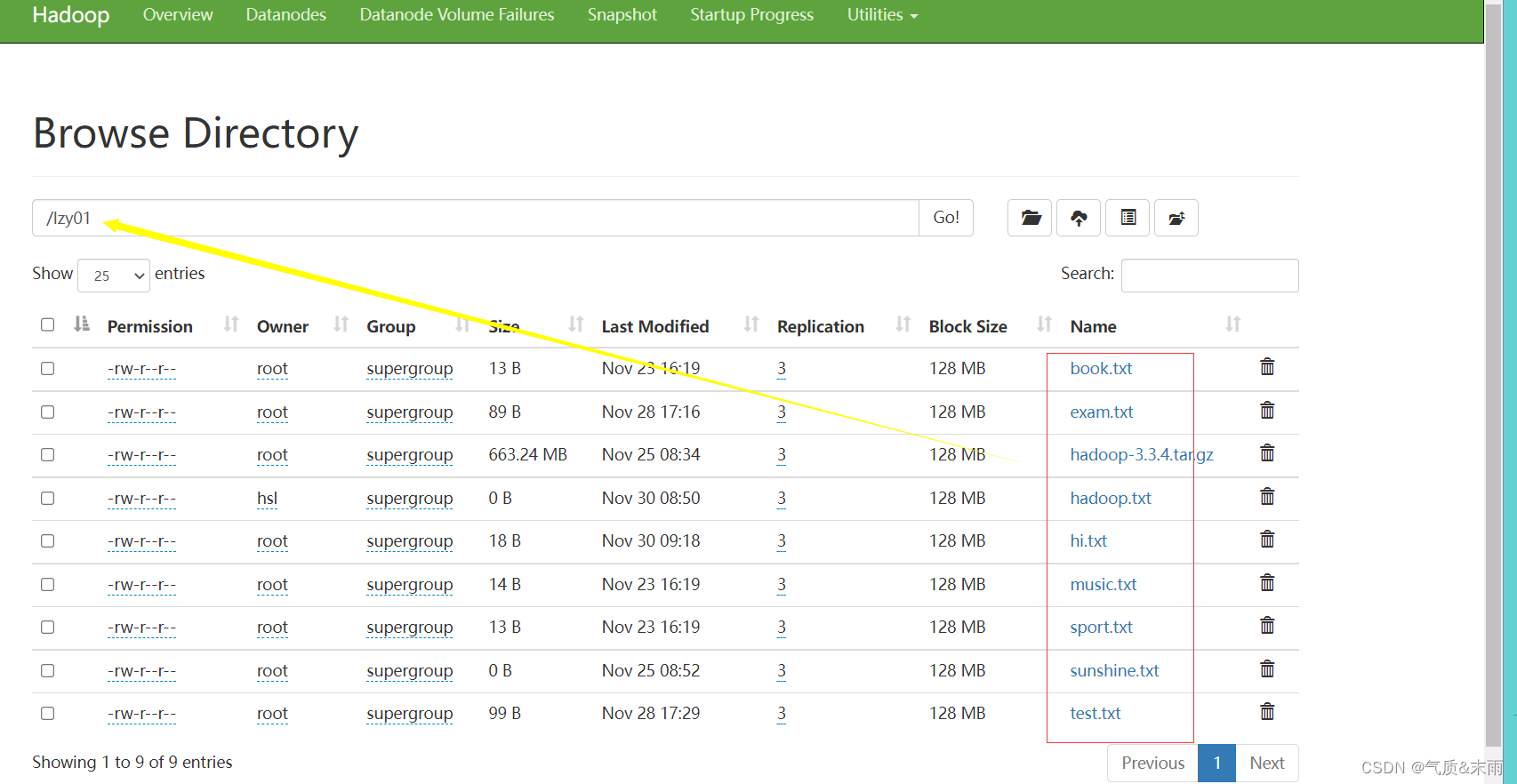

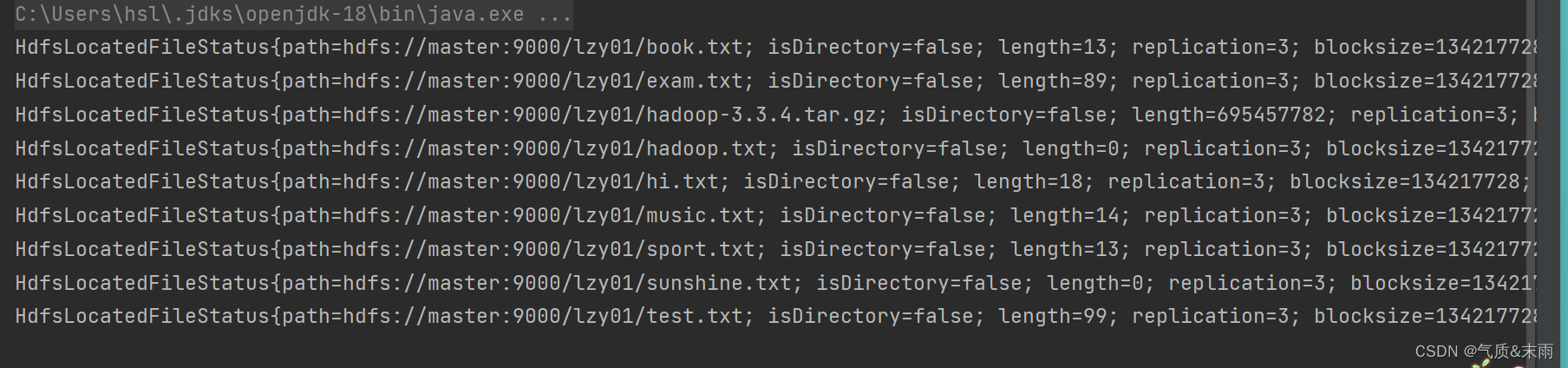

1) 显示指定目录下文件全部信息

任务:显示/lzy01 目录下的文件列表

(1)、编写list1() 方法

package net.aex.hdfs;import jdk.jshell.execution.LoaderDelegate;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.LocatedFileStatus;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.RemoteIterator;import java.net.URI;public class ListHDFSFile {public static void list1() throws Exception{//设置配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hostname","true");//定义统一资源标识符 (uri: uniform resource identifer)String uri = "hdfs://master:9000";//创建文件系统对象(基于HDFS的文件系统)FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建远程迭代器对象,泛型是位置文件状态类(相当于`hdfs dfs -ls -R /lzy01`)RemoteIterator<LocatedFileStatus> ri = fs.listFiles(new Path("/lzy01"),true);//遍历远程迭代器while (ri.hasNext()){System.out.println(ri.next());}}public static void main(String[] args) throws Exception{list1();}

}

使用main 方法,调用list1() 方法 查看结果 这些hdfs /lzy01 目录下的文件都读取出来了

上述文件状态对象封装的有关信息,可以通过相应的方法来获取,比如getPath() 方法就可以获取路径信息,getLen()方法就可以获取文件长度信息

上述文件状态对象封装的有关信息,可以通过相应的方法来获取,比如getPath() 方法就可以获取路径信息,getLen()方法就可以获取文件长度信息

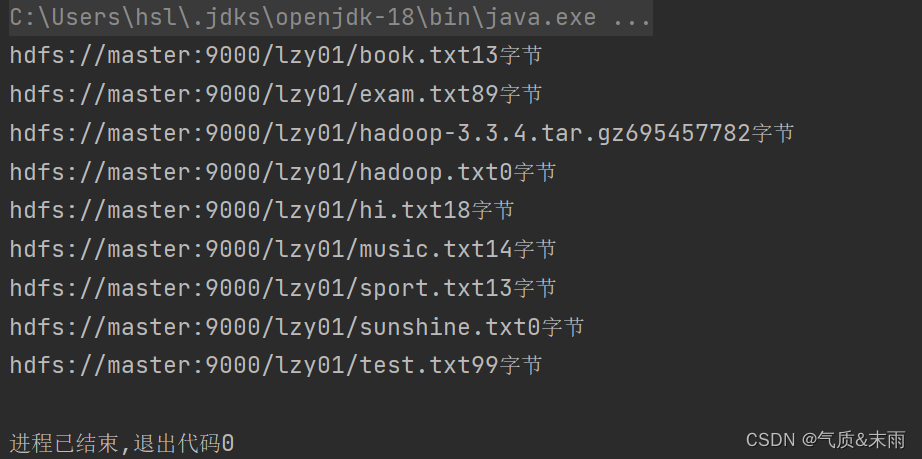

2) 显示指定目录下文件路径和长度信息

(1) 编写list2() 方法

//list2()public static void list2() throws Exception{//创建配置对象Configuration conf = new Configuration();//设置数据节点主机名属性conf.set("dfs.client.use.datanode.hosename","true");//定义uri字符串String uri = "hdfs://master:9000";//创建文件系统对象FileSystem fs = FileSystem.get(new URI(uri),conf,"root");//创建远程迭代器对象,泛型是位置文件状态类(相当于`hdfs dfs -ls -R /lzy01`)RemoteIterator<LocatedFileStatus> ri = fs.listFiles(new Path("/lzy01"),true);//遍历远程迭代器while (ri.hasNext()){LocatedFileStatus lfs = ri.next();System.out.println(lfs.getPath() + "" + lfs.getLen() + "字节");}}

使用main方法调用list2() 方法,查看结果 /lzy01目录下的文件的字节都显示出来了

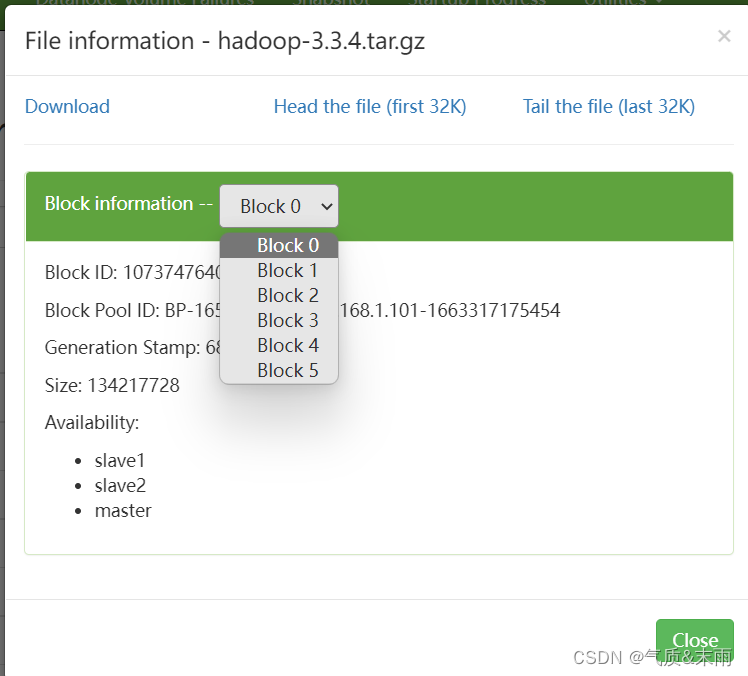

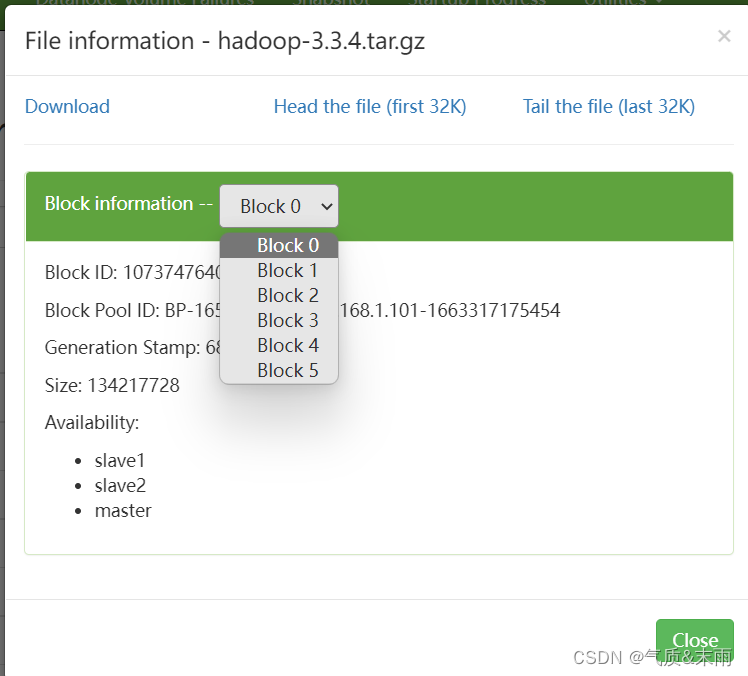

7、获取文件块信息

任务:获取/lzy01/hadoop-3.3.4.tar.gz文件块信息

hadoop压缩包会分割成6个文件块

在net.aex.hdfs包里创建GetBlockLocations类

相关文章:

HDFS Java API 操作

文章目录 HDFS Java API操作零、启动hadoop一、HDFS常见类接口与方法1、hdfs 常见类与接口2、FileSystem 的常用方法 二、Java 创建Hadoop项目1、创建文件夹2、打开Java IDEA1) 新建项目2) 选择Maven 三、配置环境1、添加相关依赖2、创建日志属性文件 四、Java API操作1、在HDF…...

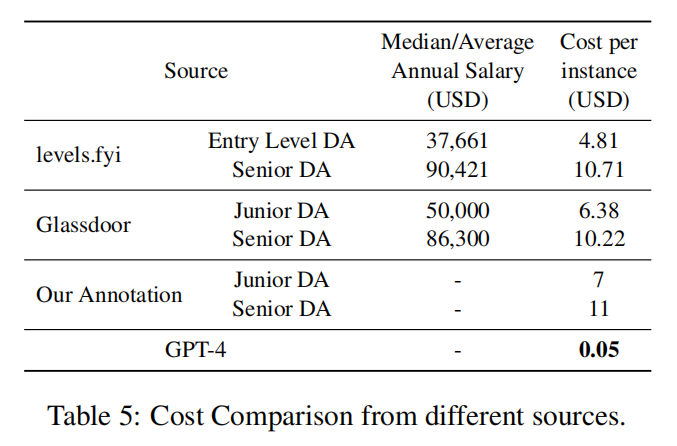

论文阅读之【Is GPT-4 a Good Data Analyst?(GPT-4是否是一位好的数据分析师)】

文章目录 论文阅读之【Is GPT-4 a Good Data Analyst?(GPT-4是否是一位好的数据分析师)】背景:数据分析师工作范围基于GPT-4的端到端数据分析框架将GPT-4作为数据分析师的框架的流程图 实验分析评估指标表1:GPT-4性能表现表2&…...

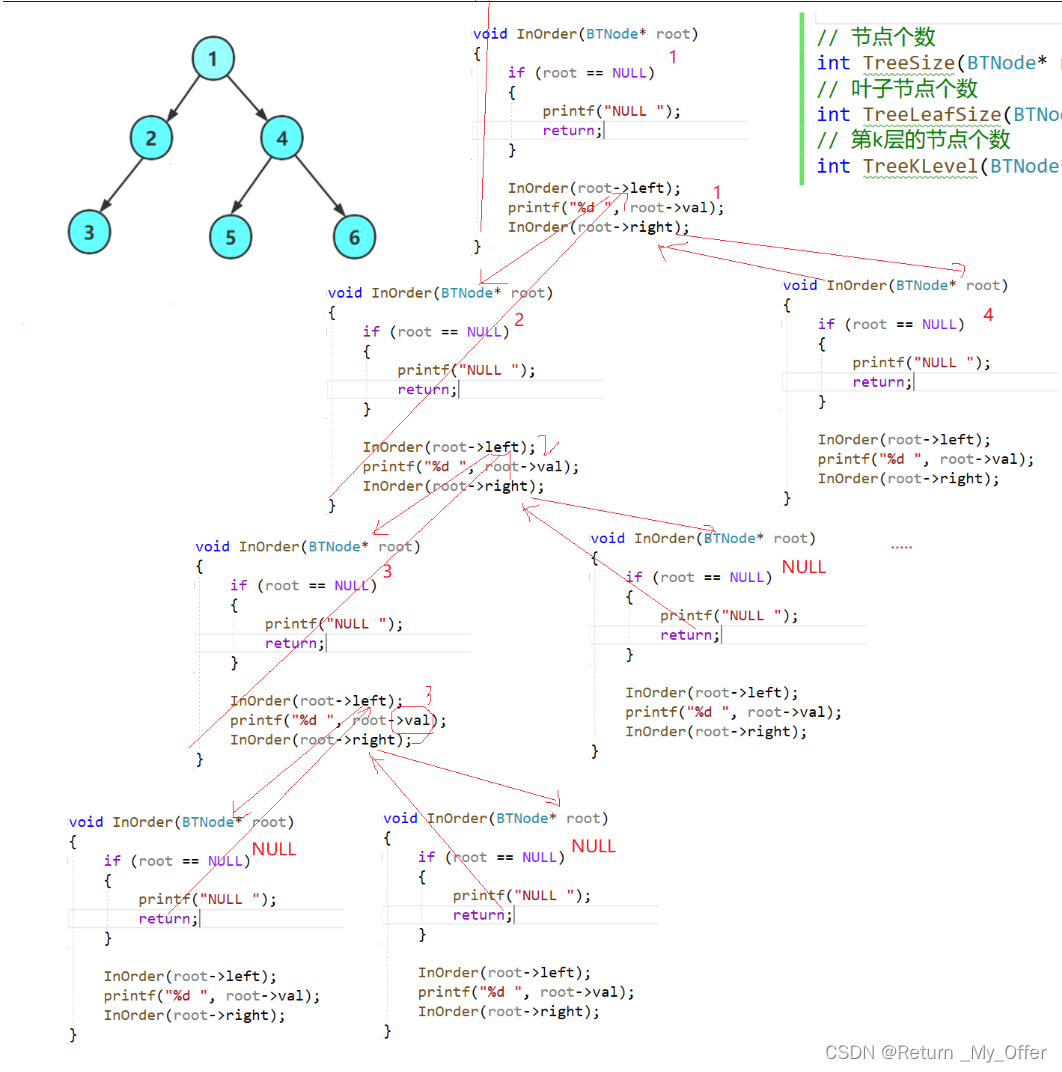

【数据结构】:二叉树与堆排序的实现

1.树概念及结构(了解) 1.1树的概念 树是一种非线性的数据结构,它是由n(n>0)个有限结点组成一个具有层次关系的集合把它叫做树是因为它看起来像一棵倒挂的树,也就是说它是根朝上,而叶朝下的有一个特殊的结点&#…...

纯css手写switch

CSS 手写switch 纯css手写switchcss变量 纯css手写switch 思路: switch需要的元素有:开关背景、开关按钮。点击按钮后,背景色变化,按钮颜色变化,呈现开关打开状态。 利用typecheckbox,来实现switch效果(修…...

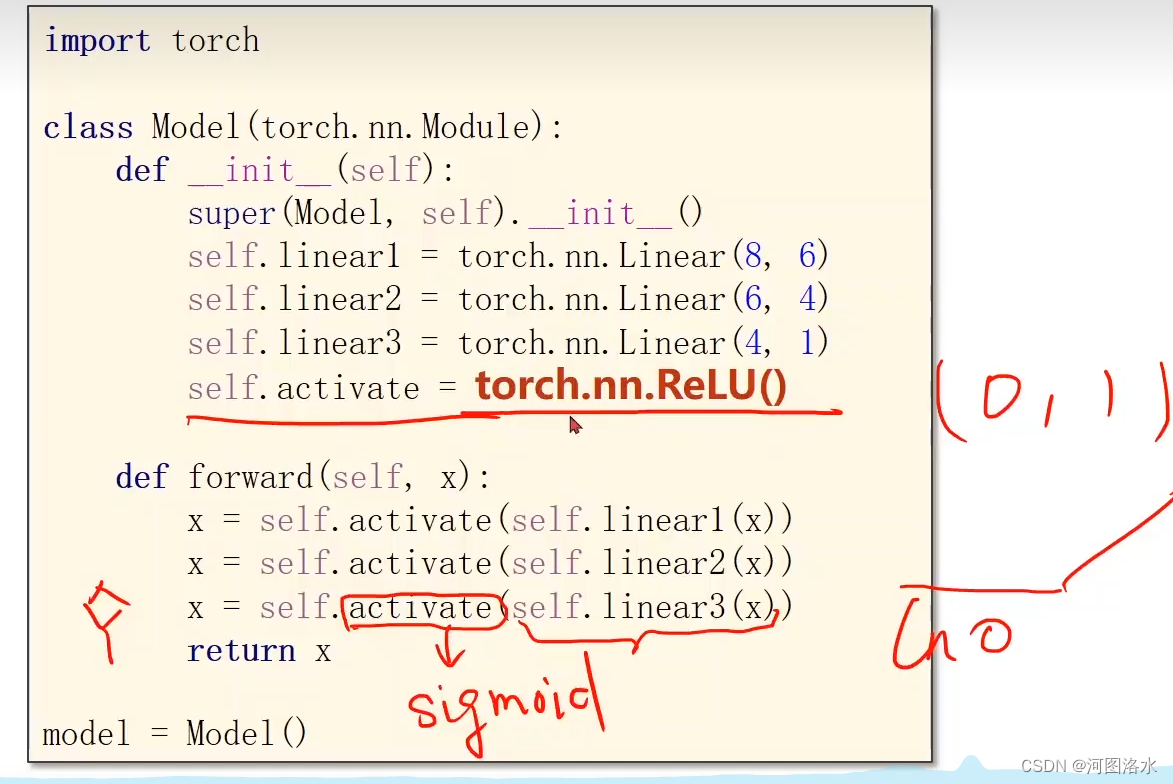

PyTorch 深度学习之处理多维特征的输入Multiple Dimension Input(六)

1.Multiple Dimension Logistic Regression Model 1.1 Mini-Batch (N samples) 8D->1D 8D->2D 8D->6D 1.2 Neural Network 学习能力太好也不行(学习到的是数据集中的噪声),最好的是要泛化能力,超参数尝试 Example, Arti…...

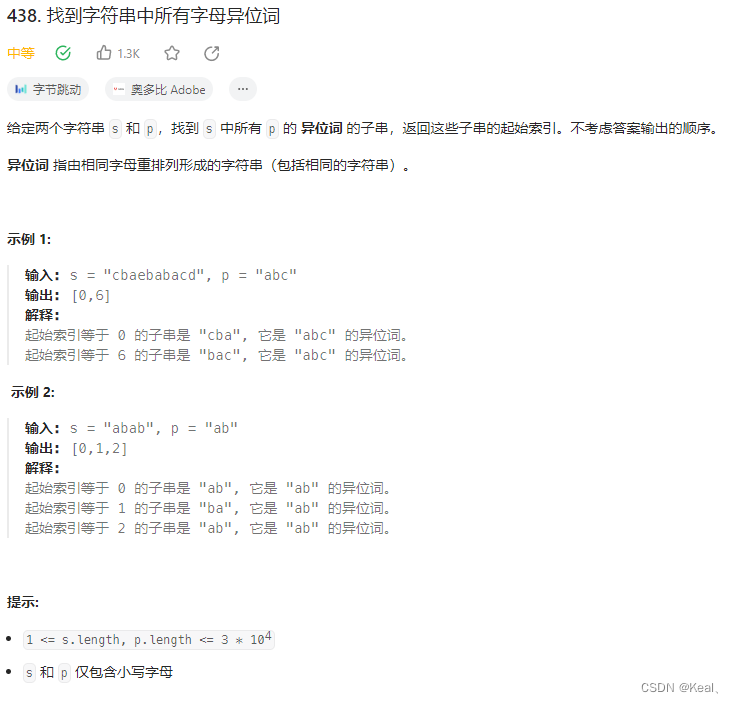

LeetCode【438】找到字符串中所有字母异位词

题目: 注意:下面代码勉强通过,每次都对窗口内字符排序。然后比较字符串。 代码: public List<Integer> findAnagrams(String s, String p) {int start 0, end p.length() - 1;List<Integer> result new ArrayL…...

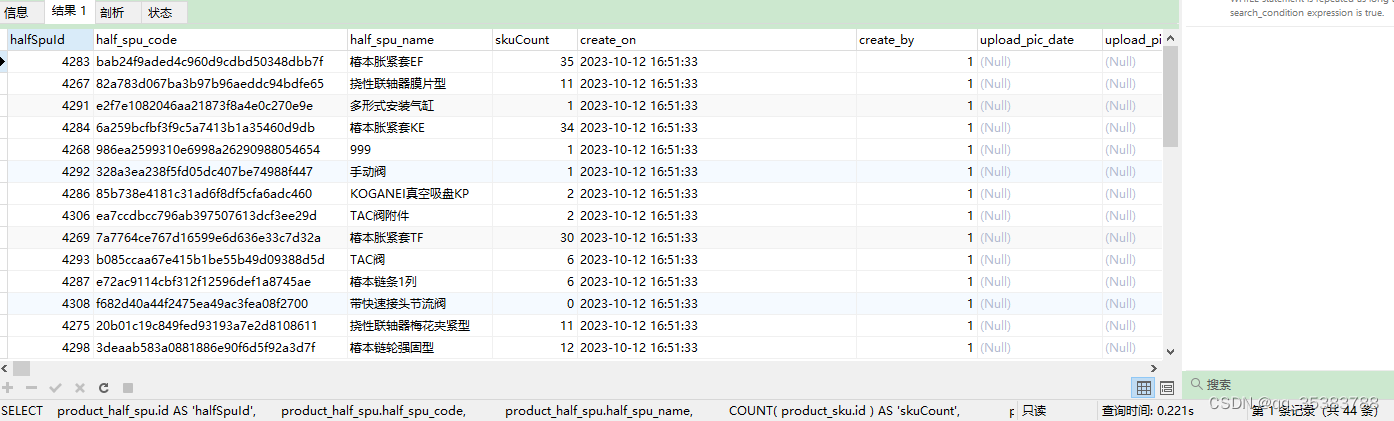

关于LEFT JOIN的一次理解

先看一段例子: SELECTproduct_half_spu.id AS halfSpuId,product_half_spu.half_spu_code,product_half_spu.half_spu_name,COUNT( product_sku.id ) AS skuCount,product_half_spu.create_on,product_half_spu.create_by,product_half_spu.upload_pic_date,produc…...

各报文段格式集合

数据链路层-- MAC帧 前导码8B:数据链路层将封装好的MAC帧交付给物理层进行发送,物理层在发送MAC帧前,还要在前面添加8字节的前导码(分为7字节的前同步码1字节的帧开始定界符)MAC地址长度6B数据长度46~1500B…...

【算法-动态规划】最长公共子序列

💝💝💝欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。 推荐:kuan 的首页,持续学…...

区块链游戏的开发流程

链游(Blockchain Games)的开发流程与传统游戏开发有许多相似之处,但它涉及到区块链技术的集成和智能合约的开发。以下是链游的一般开发流程,希望对大家有所帮助。北京木奇移动技术有限公司,专业的软件外包开发公司&…...

目标检测网络系列——YOLO V2

文章目录 YOLO9000better,更准batch Normalization高分辨率的训练使用anchor锚框尺寸的选择——聚类锚框集成改进——直接预测bounding box细粒度的特征图——passthrough layer多尺度训练数据集比对实验VOC 2007VOC 2012COCOFaster,更快网络模型——Darknet19训练方法Strong…...

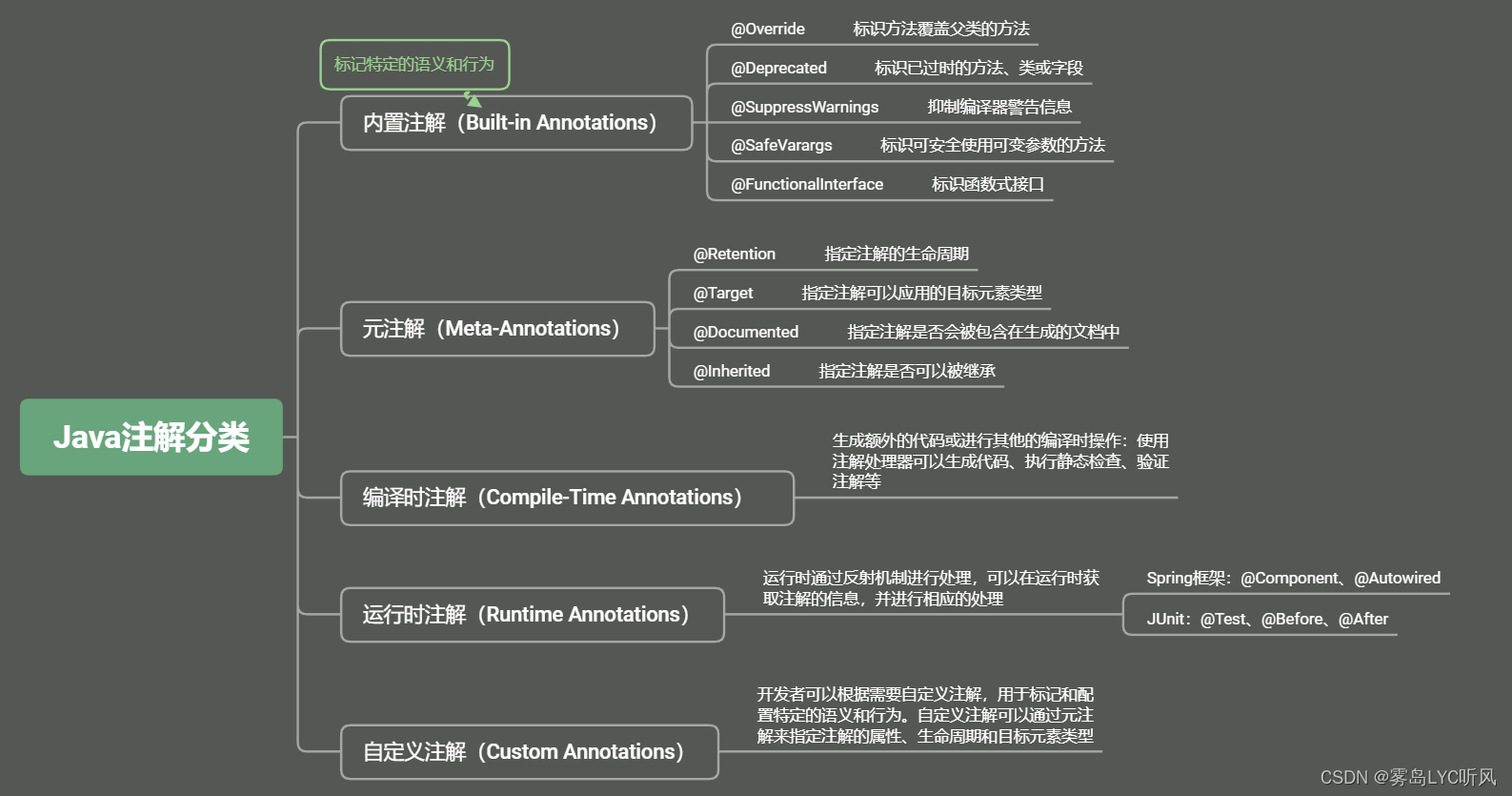

15. Java反射和注解

Java —— 反射和注解 1. 反射2. 注解 1. 反射 动态语言:变量的类型和属性可以在运行时动态确定,而不需要在编译时指定 常见动态语言:Python,JavaScript,Ruby,PHP,Perl;常见静态语言…...

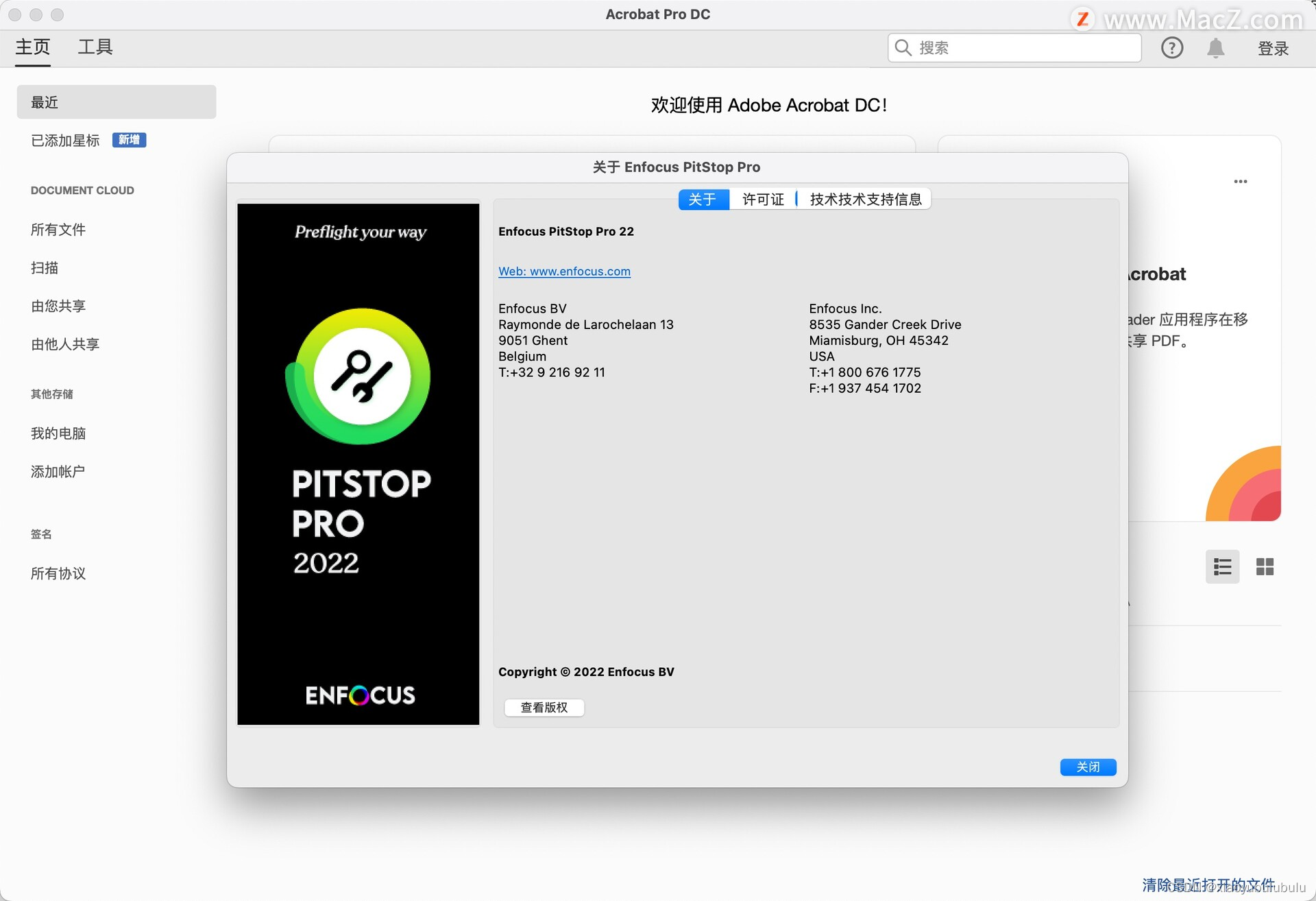

pdf处理工具 Enfocus PitStop Pro 2022 中文 for mac

Enfocus PitStop Pro 2022是一款专业的PDF预检和编辑软件,旨在帮助用户提高生产效率、确保印刷品质量并减少错误。以下是该软件的一些特色功能: PDF预检。PitStop Pro可以自动检测和修复常见的PDF文件问题,如缺失字体、图像分辨率低、颜色空…...

微信小程序入门开发教程

🎉🎉欢迎来到我的CSDN主页!🎉🎉 🏅我是Java方文山,一个在CSDN分享笔记的博主。📚📚 🌟推荐给大家我的专栏《微信小程序开发实战》。🎯Ἲ…...

php函数

1. strstr() 返回a在b中的第一个位置 2.substr() 截取字符串 3.PHP字符串函数parse_str(将字符串解析成多个变量)-CSDN博客 4.explode() 字符串分割为数组 5.trim() 1.去除字符串两边的 空白字符 2.去除指定字符 6.extract()函数从数组里…...

3.3 封装性

思维导图: 3.3.1 为什么要封装 ### 3.3.1 为什么要封装 **封装**,在Java的面向对象编程中,是一个核心的思想。它主要是为了保护对象的状态不被外部随意修改,确保数据的完整性和安全性。 #### **核心思想:** - 保护…...

Redis魔法:点燃分布式锁的奇妙实现

分布式锁是一种用于在分布式系统中控制对共享资源的访问的锁。它与传统的单机锁不同,因为它需要在多个节点之间协调以确保互斥访问。 本文将介绍什么是分布式锁,以及使用Redis实现分布式锁的几种方案。 一、前言 了解分布式锁之前,需要先了…...

iOS 项目避坑:多个分类中方法重复实现检测

#前言 在项目中,我们经常会使用分类 -> category。category在实际项目中一般有两个左右:1.给已有class增加方法,扩充起能力、2.将代码打散到多个文件中,避免因为一个类过于复杂而导致代码篇幅过长(应用于viewController中很好用) 但是 category 也有很多弊端~ **首…...

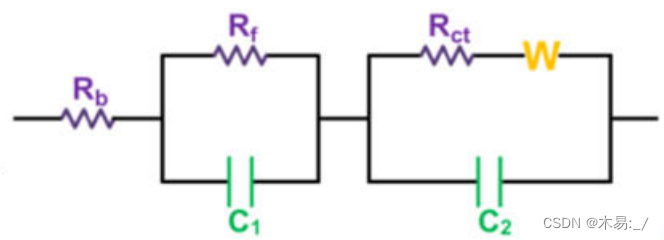

【003】EIS数据分析_#LIB

EIS数据分析 1. EIS测试及数据获取2. EIS数据分析2.1 EIS曲线划分 1. EIS测试及数据获取 点击查看往期介绍 2. EIS数据分析 2.1 EIS曲线划分 一般来说,实轴处的截获表示体电阻(Rb),它反映了电解质,隔膜和电极的电导率。高频区的半圆对应于…...

Sprint framework Day07:注解结合 xml 配置

前言 Spring注解结合XML配置是指在Spring应用中,使用注解和XML配置的方式来进行Bean的定义、依赖注入和其他配置。这种方式可以充分利用Spring框架的注解和XML配置两种不同的配置方式的特点。 在Spring框架中,我们可以使用注解来定义Bean,如…...

K8S认证|CKS题库+答案| 11. AppArmor

目录 11. AppArmor 免费获取并激活 CKA_v1.31_模拟系统 题目 开始操作: 1)、切换集群 2)、切换节点 3)、切换到 apparmor 的目录 4)、执行 apparmor 策略模块 5)、修改 pod 文件 6)、…...

从零实现富文本编辑器#5-编辑器选区模型的状态结构表达

先前我们总结了浏览器选区模型的交互策略,并且实现了基本的选区操作,还调研了自绘选区的实现。那么相对的,我们还需要设计编辑器的选区表达,也可以称为模型选区。编辑器中应用变更时的操作范围,就是以模型选区为基准来…...

【解密LSTM、GRU如何解决传统RNN梯度消失问题】

解密LSTM与GRU:如何让RNN变得更聪明? 在深度学习的世界里,循环神经网络(RNN)以其卓越的序列数据处理能力广泛应用于自然语言处理、时间序列预测等领域。然而,传统RNN存在的一个严重问题——梯度消失&#…...

苍穹外卖--缓存菜品

1.问题说明 用户端小程序展示的菜品数据都是通过查询数据库获得,如果用户端访问量比较大,数据库访问压力随之增大 2.实现思路 通过Redis来缓存菜品数据,减少数据库查询操作。 缓存逻辑分析: ①每个分类下的菜品保持一份缓存数据…...

多种风格导航菜单 HTML 实现(附源码)

下面我将为您展示 6 种不同风格的导航菜单实现,每种都包含完整 HTML、CSS 和 JavaScript 代码。 1. 简约水平导航栏 <!DOCTYPE html> <html lang"zh-CN"> <head><meta charset"UTF-8"><meta name"viewport&qu…...

什么?连接服务器也能可视化显示界面?:基于X11 Forwarding + CentOS + MobaXterm实战指南

文章目录 什么是X11?环境准备实战步骤1️⃣ 服务器端配置(CentOS)2️⃣ 客户端配置(MobaXterm)3️⃣ 验证X11 Forwarding4️⃣ 运行自定义GUI程序(Python示例)5️⃣ 成功效果

3-11单元格区域边界定位(End属性)学习笔记

返回一个Range 对象,只读。该对象代表包含源区域的区域上端下端左端右端的最后一个单元格。等同于按键 End 向上键(End(xlUp))、End向下键(End(xlDown))、End向左键(End(xlToLeft)End向右键(End(xlToRight)) 注意:它移动的位置必须是相连的有内容的单元格…...

稳定币的深度剖析与展望

一、引言 在当今数字化浪潮席卷全球的时代,加密货币作为一种新兴的金融现象,正以前所未有的速度改变着我们对传统货币和金融体系的认知。然而,加密货币市场的高度波动性却成为了其广泛应用和普及的一大障碍。在这样的背景下,稳定…...

代理篇12|深入理解 Vite中的Proxy接口代理配置

在前端开发中,常常会遇到 跨域请求接口 的情况。为了解决这个问题,Vite 和 Webpack 都提供了 proxy 代理功能,用于将本地开发请求转发到后端服务器。 什么是代理(proxy)? 代理是在开发过程中,前端项目通过开发服务器,将指定的请求“转发”到真实的后端服务器,从而绕…...

管理学院权限管理系统开发总结

文章目录 🎓 管理学院权限管理系统开发总结 - 现代化Web应用实践之路📝 项目概述🏗️ 技术架构设计后端技术栈前端技术栈 💡 核心功能特性1. 用户管理模块2. 权限管理系统3. 统计报表功能4. 用户体验优化 🗄️ 数据库设…...