Flink系列之:Table API Connectors之Debezium

Flink系列之:Table API Connectors之Debezium

- 一、Debezium

- 二、依赖

- 三、使用Debezium Format

- 四、可用元数据

- 五、Format参数

- 六、重复的变更事件

- 七、消费 Debezium Postgres Connector 产生的数据

- 八、数据类型映射

一、Debezium

Debezium 是一个 CDC(Changelog Data Capture,变更数据捕获)的工具,可以把来自 MySQL、PostgreSQL、Oracle、Microsoft SQL Server 和许多其他数据库的更改实时流式传输到 Kafka 中。 Debezium 为变更日志提供了统一的格式结构,并支持使用 JSON 和 Apache Avro 序列化消息。

Flink 支持将 Debezium JSON 和 Avro 消息解析为 INSERT / UPDATE / DELETE 消息到 Flink SQL 系统中。在很多情况下,利用这个特性非常的有用,例如

- 将增量数据从数据库同步到其他系统

- 日志审计

- 数据库的实时物化视图

- 关联维度数据库的变更历史,等等。

Flink 还支持将 Flink SQL 中的 INSERT / UPDATE / DELETE 消息编码为 Debezium 格式的 JSON 或 Avro 消息,输出到 Kafka 等存储中。 但需要注意的是,目前 Flink 还不支持将 UPDATE_BEFORE 和 UPDATE_AFTER 合并为一条 UPDATE 消息。因此,Flink 将 UPDATE_BEFORE 和 UPDATE_AFTER 分别编码为 DELETE 和 INSERT 类型的 Debezium 消息。

二、依赖

Debezium Avro

为了使用 Debezium 格式,使用构建自动化工具(例如 Maven 或 SBT)的项目和带有 SQL JAR 包的 SQL 客户端都需要以下依赖项。

<dependency><groupId>org.apache.flink</groupId><artifactId>flink-avro-confluent-registry</artifactId><version>1.18.0</version>

</dependency>

Debezium Json

为了使用 Debezium 格式,使用构建自动化工具(例如 Maven 或 SBT)的项目和带有 SQL JAR 包的 SQL 客户端都需要以下依赖项。

<dependency><groupId>org.apache.flink</groupId><artifactId>flink-json</artifactId><version>1.18.0</version>

</dependency>三、使用Debezium Format

Debezium 为变更日志提供了统一的格式,这是一个 JSON 格式的从 MySQL product 表捕获的更新操作的简单示例:

{"before": {"id": 111,"name": "scooter","description": "Big 2-wheel scooter","weight": 5.18},"after": {"id": 111,"name": "scooter","description": "Big 2-wheel scooter","weight": 5.15},"source": {...},"op": "u","ts_ms": 1589362330904,"transaction": null

}

MySQL 产品表有4列(id、name、description、weight)。上面的 JSON 消息是 products 表上的一条更新事件,其中 id = 111 的行的 weight 值从 5.18 更改为 5.15。假设此消息已同步到 Kafka 主题 products_binlog,则可以使用以下 DDL 来使用此主题并解析更改事件。

CREATE TABLE topic_products (-- schema 与 MySQL 的 products 表完全相同id BIGINT,name STRING,description STRING,weight DECIMAL(10, 2)

) WITH ('connector' = 'kafka','topic' = 'products_binlog','properties.bootstrap.servers' = 'localhost:9092','properties.group.id' = 'testGroup',-- 使用 'debezium-json' format 来解析 Debezium 的 JSON 消息-- 如果 Debezium 用 Avro 编码消息,请使用 'debezium-avro-confluent''format' = 'debezium-json' -- 如果 Debezium 用 Avro 编码消息,请使用 'debezium-avro-confluent'

)

在某些情况下,用户在设置 Debezium Kafka Connect 时,可能会开启 Kafka 的配置 ‘value.converter.schemas.enable’,用来在消息体中包含 schema 信息。然后,Debezium JSON 消息可能如下所示:

{"schema": {...},"payload": {"before": {"id": 111,"name": "scooter","description": "Big 2-wheel scooter","weight": 5.18},"after": {"id": 111,"name": "scooter","description": "Big 2-wheel scooter","weight": 5.15},"source": {...},"op": "u","ts_ms": 1589362330904,"transaction": null}

}

为了解析这一类信息,你需要在上述 DDL WITH 子句中添加选项 ‘debezium-json.schema-include’ = ‘true’(默认为 false)。通常情况下,建议不要包含 schema 的描述,因为这样会使消息变得非常冗长,并降低解析性能。

在将主题注册为 Flink 表之后,可以将 Debezium 消息用作变更日志源。

-- MySQL "products" 的实时物化视图

-- 计算相同产品的最新平均重量

SELECT name, AVG(weight) FROM topic_products GROUP BY name;-- 将 MySQL "products" 表的所有数据和增量更改同步到

-- Elasticsearch "products" 索引,供将来查找

INSERT INTO elasticsearch_products

SELECT * FROM topic_products;

四、可用元数据

以下格式元数据可以在表定义中公开为只读(虚拟)列。

注意 仅当相应的连接器转发格式元数据时,格式元数据字段才可用。目前,只有 Kafka 连接器能够公开其值格式的元数据字段。

| Key | Data Type | Description |

|---|---|---|

| schema | STRING NULL | 描述负载模式的 JSON 字符串。如果架构未包含在 Debezium 记录中,则为 Null。 |

| ingestion-timestamp | TIMESTAMP_LTZ(3) NULL | 连接器处理事件的时间戳。对应于 Debezium 记录中的 ts_ms 字段。 |

| source.timestamp | TIMESTAMP_LTZ(3) NULL | 源系统创建事件的时间戳。对应于 Debezium 记录中的 source.ts_ms 字段。 |

| source.database | STRING NULL | 原始数据库。对应于 Debezium 记录中的 source.db 字段(如果可用)。 |

| source.schema | STRING NULL | 原始数据库架构。对应于 Debezium 记录中的 source.schema 字段(如果可用)。 |

| source.table | STRING NULL | 原始数据库表。对应于 Debezium 记录中的 source.table 或 source.collection 字段(如果可用)。 |

| source.properties | MAP<STRING, STRING> NULL | 各种源属性的映射。对应于 Debezium 记录中的源字段。 |

以下示例展示了如何访问 Kafka 中的 Debezium 元数据字段:

CREATE TABLE KafkaTable (origin_ts TIMESTAMP(3) METADATA FROM 'value.ingestion-timestamp' VIRTUAL,event_time TIMESTAMP(3) METADATA FROM 'value.source.timestamp' VIRTUAL,origin_database STRING METADATA FROM 'value.source.database' VIRTUAL,origin_schema STRING METADATA FROM 'value.source.schema' VIRTUAL,origin_table STRING METADATA FROM 'value.source.table' VIRTUAL,origin_properties MAP<STRING, STRING> METADATA FROM 'value.source.properties' VIRTUAL,user_id BIGINT,item_id BIGINT,behavior STRING

) WITH ('connector' = 'kafka','topic' = 'user_behavior','properties.bootstrap.servers' = 'localhost:9092','properties.group.id' = 'testGroup','scan.startup.mode' = 'earliest-offset','value.format' = 'debezium-json'

);

五、Format参数

Flink 提供了 debezium-avro-confluent 和 debezium-json 两种 format 来解析 Debezium 生成的 JSON 格式和 Avro 格式的消息。 请使用 debezium-avro-confluent 来解析 Debezium 的 Avro 消息,使用 debezium-json 来解析 Debezium 的 JSON 消息。

Debezium Avro

| 参数 | 是否必选 | 默认值 | 类型 | 描述 |

|---|---|---|---|---|

| format | required | (none) | String | 指定使用什么格式,这里应该是“debezium-avro-confluence”。 |

| debezium-avro-confluent.basic-auth.credentials-source | optional | (none) | String | 架构注册表的基本身份验证凭据源 |

| debezium-avro-confluent.basic-auth.user-info | optional | (none) | String | 架构注册表的基本身份验证用户信息 |

| debezium-avro-confluent.bearer-auth.credentials-source | optional | (none) | String | 架构注册表的承载身份验证凭据源 |

| debezium-avro-confluent.bearer-auth.token | optional | (none) | String | 架构注册表的承载身份验证令牌 |

| debezium-avro-confluent.properties | optional | (none) | Map | 转发到底层架构注册表的属性映射。这对于未通过 Flink 配置选项正式公开的选项很有用。但请注意,Flink 选项具有更高的优先级。 |

| debezium-avro-confluent.ssl.keystore.location | optional | (none) | String | SSL 密钥库的位置/文件 |

| debezium-avro-confluent.ssl.keystore.password | optional | (none) | String | SSL 密钥库的密码 |

| debezium-avro-confluent.ssl.truststore.location | optional | (none) | String | |

| debezium-avro-confluent.ssl.truststore.password | optional | (none) | String | SSL 信任库的密码 |

| debezium-avro-confluent.schema | optional | (none) | String | 已在 Confluence 模式注册表中注册或将要注册的模式。如果没有提供 schema,Flink 会将表 schema 转换为 avro schema。提供的模式必须与 Debezium 模式匹配,Debezium 模式是可以为空的记录类型,包括字段“before”、“after”、“op”。 |

| debezium-avro-confluent.subject | optional | (none) | String | 融合模式注册表主题,在序列化期间注册此格式使用的模式。默认情况下,如果将此格式用作值或键格式,则“kafka”和“upsert-kafka”连接器使用“<topic_name>-value”或“<topic_name>-key”作为默认主题名称。但对于其他连接器(例如“文件系统”),用作接收器时需要主题选项。 |

| debezium-avro-confluent.url | required | (none) | String | 用于获取/注册模式的 Confluence 模式注册表的 URL。 |

Debezium Json

| 参数 | 是否必选 | 默认值 | 类型 | 描述 |

|---|---|---|---|---|

| format | 必选 | (none) | String | 指定要使用的格式,此处应为 ‘debezium-json’。 |

| debezium-json.schema-include | 可选 | false | Boolean | 设置 Debezium Kafka Connect 时,用户可以启用 Kafka 配置 ‘value.converter.schemas.enable’ 以在消息中包含 schema。此选项表明 Debezium JSON 消息是否包含 schema。 |

| debezium-json.ignore-parse-errors | 可选 | false | Boolean | 当解析异常时,是跳过当前字段或行,还是抛出错误失败(默认为 false,即抛出错误失败)。如果忽略字段的解析异常,则会将该字段值设置为null。 |

| debezium-json.timestamp-format.standard | 可选 | ‘SQL’ | String | 声明输入和输出的时间戳格式。当前支持的格式为’SQL’ 以及 ‘ISO-8601’:可选参数 ‘SQL’ 将会以 “yyyy-MM-dd HH:mm:ss.s{precision}” 的格式解析时间戳, 例如 ‘2020-12-30 12:13:14.123’,且会以相同的格式输出。可选参数 ‘ISO-8601’ 将会以 “yyyy-MM-ddTHH:mm:ss.s{precision}” 的格式解析输入时间戳, 例如 ‘2020-12-30T12:13:14.123’ ,且会以相同的格式输出。 |

| debezium-json.map-null-key.mode | 选填 | ‘FAIL’ | String | 指定处理 Map 中 key 值为空的方法. 当前支持的值有 ‘FAIL’, ‘DROP’ 和 ‘LITERAL’:Option ‘FAIL’ 将抛出异常,如果遇到 Map 中 key 值为空的数据。Option ‘DROP’ 将丢弃 Map 中 key 值为空的数据项。Option ‘LITERAL’ 将使用字符串常量来替换 Map 中的空 key 值。字符串常量的值由 ‘debezium-json.map-null-key.literal’ 定义。 |

| debezium-json.map-null-key.literal | 选填 | ‘null’ | String | 当 ‘debezium-json.map-null-key.mode’ 是 LITERAL 的时候,指定字符串常量替换 Map 中的空 key 值。 |

| debezium-json.encode.decimal-as-plain-number | 选填 | false | Boolean | 将所有 DECIMAL 类型的数据保持原状,不使用科学计数法表示。例:0.000000027 默认会表示为 2.7E-8。当此选项设为 true 时,则会表示为 0.000000027。 |

六、重复的变更事件

在正常的操作环境下,Debezium 应用能以 exactly-once 的语义投递每条变更事件。在这种情况下,Flink 消费 Debezium 产生的变更事件能够工作得很好。 然而,当有故障发生时,Debezium 应用只能保证 at-least-once 的投递语义。 这也意味着,在非正常情况下,Debezium 可能会投递重复的变更事件到 Kafka 中,当 Flink 从 Kafka 中消费的时候就会得到重复的事件。 这可能会导致 Flink query 的运行得到错误的结果或者非预期的异常。因此,建议在这种情况下,将作业参数 table.exec.source.cdc-events-duplicate 设置成 true,并在该 source 上定义 PRIMARY KEY。 框架会生成一个额外的有状态算子,使用该 primary key 来对变更事件去重并生成一个规范化的 changelog 流。

“table.exec.source.cdc-events-duplicate” 是 Flink 的一个配置选项,用于处理 Change Data Capture (CDC) 事件的重复数据。CDC 是一种常见的数据库技术,用于捕获数据库中的数据更改,并将其作为事件流进行处理。

在 Flink 中,“table.exec.source.cdc-events-duplicate” 选项用于指定如何处理 CDC 事件流中的重复数据。具体来说,它可以接受以下两个值:

-

“strict”:严格模式。如果启用了严格模式,Flink 会严格检查事件流中是否存在重复的 CDC 事件。如果检测到重复事件出现,Flink 会抛出一个异常并停止任务执行。

-

“lenient”:宽松模式。如果启用了宽松模式,Flink 会使用一个简单的算法来检测重复事件,并尽量过滤掉这些重复事件。但是,它不能保证完全消除重复事件的可能性。

使用时,可以在 Flink 的配置文件或在代码中通过设置相应的属性来指定 “table.exec.source.cdc-events-duplicate” 的值。例如,在 Flink 的配置文件中,可以添加以下行来启用宽松模式:

table.exec.source.cdc-events-duplicate: lenient

七、消费 Debezium Postgres Connector 产生的数据

如果你正在使用 Debezium PostgreSQL Connector 捕获变更到 Kafka,请确保被监控表的 REPLICA IDENTITY 已经被配置成 FULL 了,默认值是 DEFAULT。 否则,Flink SQL 将无法正确解析 Debezium 数据。

当配置为 FULL 时,更新和删除事件将完整包含所有列的之前的值。当为其他配置时,更新和删除事件的 “before” 字段将只包含 primary key 字段的值,或者为 null(没有 primary key)。 你可以通过运行 ALTER TABLE REPLICA IDENTITY FULL 来更改 REPLICA IDENTITY 的配置。

八、数据类型映射

目前,Debezium Format 使用 JSON Format 进行序列化和反序列化。

当前,JSON schema 将会自动从 table schema 之中自动推导得到。不支持显式地定义 JSON schema。

在 Flink 中,JSON Format 使用 jackson databind API 去解析和生成 JSON。

下表列出了 Flink 中的数据类型与 JSON 中的数据类型的映射关系。

| Flink SQL类型 | JSON类型 |

|---|---|

| CHAR/VARCHAR/STRING | string |

| BOOLEAN | boolean |

| BINARY/VARBINARY | string with encoding: base64 |

| DECIMAL | number |

| TINYINT | number |

| SMALLINT | number |

| INT | number |

| BIGINT | number |

| FLOAT | number |

| DOUBLE | number |

| DATE | string with format: date |

| TIME | string with format: time |

| TIMESTAMP | string with format: date-time |

| TIMESTAMP_WITH_LOCAL_TIME_ZONE | string with format: date-time (with UTC time zone) |

| INTERVAL | number |

| ARRAY | array |

| MAP / MULTISET | object |

| ROW | object |

相关文章:

Flink系列之:Table API Connectors之Debezium

Flink系列之:Table API Connectors之Debezium 一、Debezium二、依赖三、使用Debezium Format四、可用元数据五、Format参数六、重复的变更事件七、消费 Debezium Postgres Connector 产生的数据八、数据类型映射 一、Debezium Debezium 是一个 CDC(Chan…...

【Python基础】文件读写

文章目录 [toc]打开文件open()函数参数解析示例 文件路径绝对路径示例 相对路径示例 打开文件的模式常用模式 读文件示例 写文件示例 按行读写文件readline()示例 readlines()示例 writelines()示例 关闭文件示例finally语句示例 上下文管理器示例 自定义读写类示例 打开文件 …...

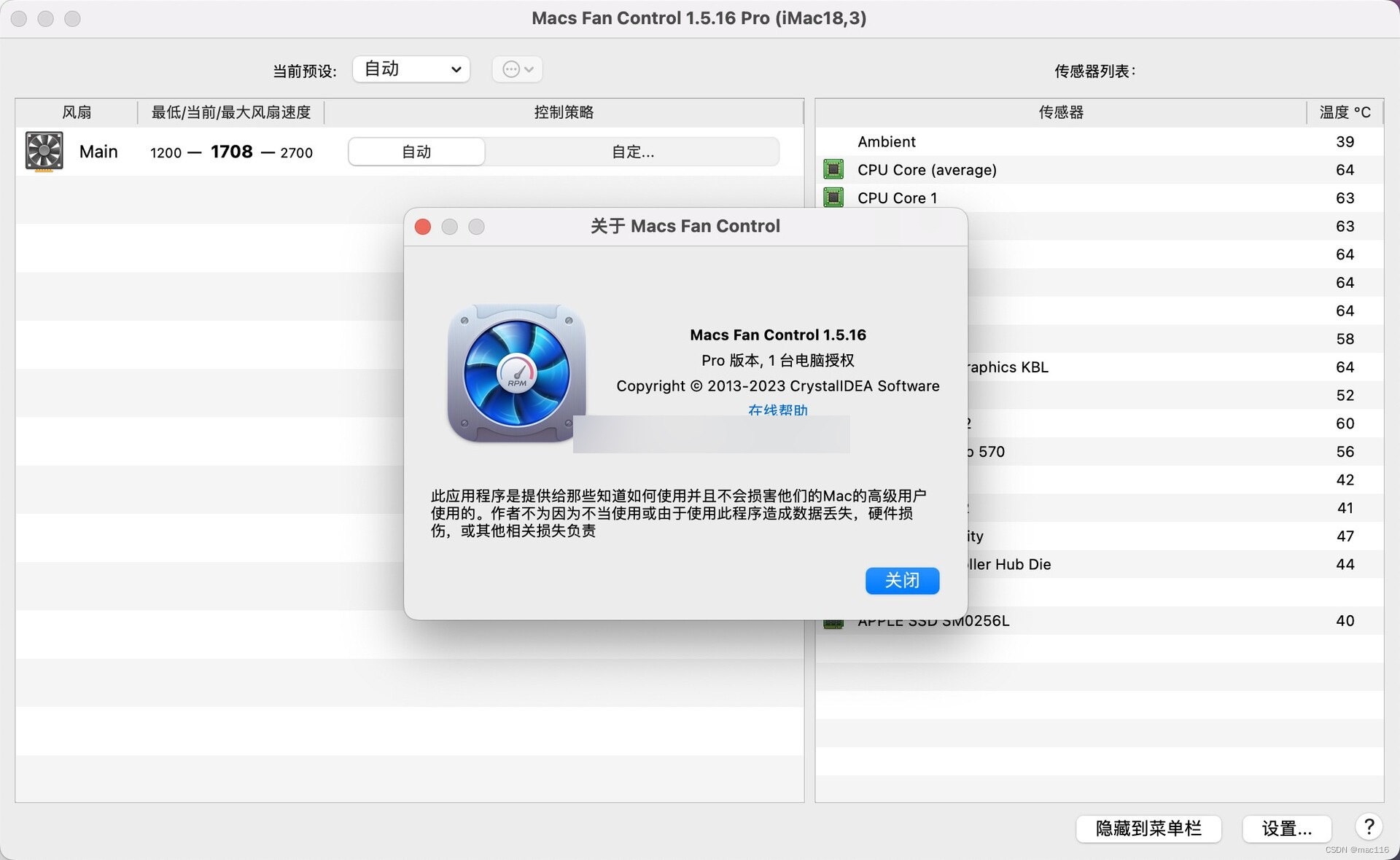

电脑风扇控制软件Macs Fan Control mac支持多个型号

Macs Fan Control mac是一款专门为 Mac 用户设计的软件,它可以帮助用户控制和监控 Mac 设备的风扇速度和温度。这款软件允许用户手动调整风扇速度,以提高设备的散热效果,减少过热造成的风险。 Macs Fan Control 可以在菜单栏上显示当前系统温…...

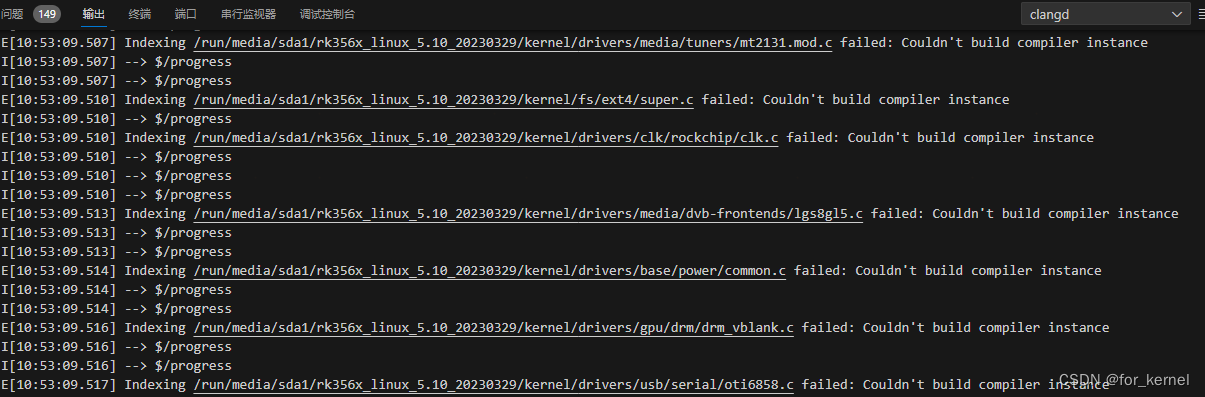

clangd:Couldn‘t build compiler instance

在使用vscode clangd 搭建RK3588 5.10版本linux内核代码开发环境时,使用bear生成 compile_commands.json时,clangd生成标签失败代码无法跳转,查看clangd日志,发现标签生成失败,失败原因:Couldnt build comp…...

Springboot启动出现Error to process server push response的解决方法

目录 前言1. 问题所示2. 原理分析3. 解决方法前言 注意,此篇博客只提供一种bug排查思路,毕竟每个项目引起的依赖包冲突都不一致! 1. 问题所示 启动Springboot的时候,5秒刷一次这个,大致如下: 2023-12-17 13:02:01.166 WARN 20196 --- [ main] o.s.boot.ac…...

P2P网络下分布式文件共享场景的测试

P2P网络介绍 P2P是Peer-to-Peer的缩写,“Peer”在英语里有“对等者、伙伴、对端”的意义。因此,从字面意思来看,P2P可以理解为对等网络。国内一些媒体将P2P翻译成“点对点”或者“端对端”,学术界则统一称为对等网络(Peer-to-Pee…...

计算机组成原理综合1

1、完整的计算机系统应包括______。D A. 运算器、存储器和控制器 B. 外部设备和主机 C. 主机和实用程序 D. 配套的硬件设备和软件系统 2、计算机系统中的存储器系统是指______。D A. RAM存储器 B. ROM存储器 C. 主存储器 …...

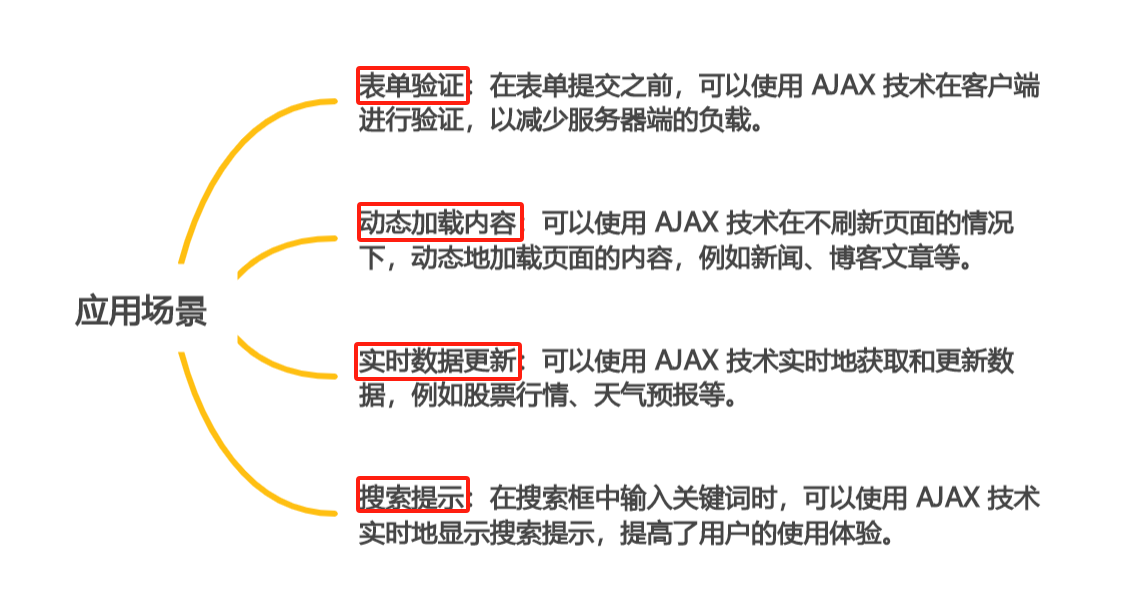

探秘 AJAX:让网页变得更智能的异步技术(下)

🤍 前端开发工程师(主业)、技术博主(副业)、已过CET6 🍨 阿珊和她的猫_CSDN个人主页 🕠 牛客高级专题作者、在牛客打造高质量专栏《前端面试必备》 🍚 蓝桥云课签约作者、已在蓝桥云…...

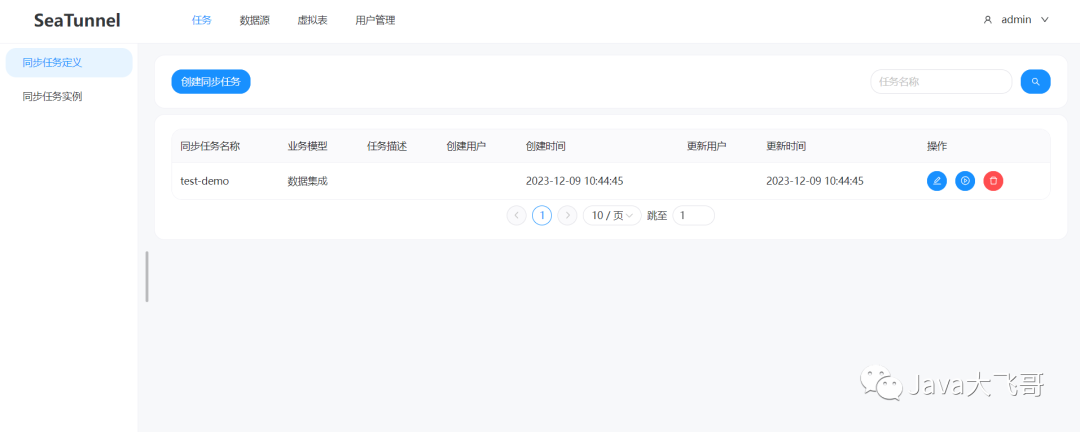

CentOs7.x安装部署SeaTunnelWeb遇到的坑

CentOs7.x安装部署SeaTunnelWeb遇到的坑 文章目录 1. 环境2. SeaTunnel安装部署2.1下载安装包2.2 设置环境变量2.3 安装连接器插件2.4 拷贝jar包到lib下2.5 启动命令2.6 执行官方client提交任务demo 3. SeaTunnel-Web安装部署3.1 下载安装包3.2 初始化数据库脚本或修改配置appl…...

Netlink通信

前言 Netlink 是 Linux 内核与用户空间进程之间进行通信的机制之一,一种特殊的进程间通信(IPC) 。它是一种全双工、异步的通信机制,允许内核与用户空间之间传递消息。Netlink 主要用于内核模块与用户空间程序之间进行通信,也被一些用户空间工具用于与内…...

Python打造简单而强大的聊天机器人:详解与实例代码

更多资料获取 📚 个人网站:ipengtao.com 聊天机器人在现代应用中扮演着重要的角色,能够与用户进行自然语言交互。本篇博客将带领读者通过Python,使用自然语言处理库构建一个简单而强大的聊天机器人。我们将深入讨论处理用户输入、…...

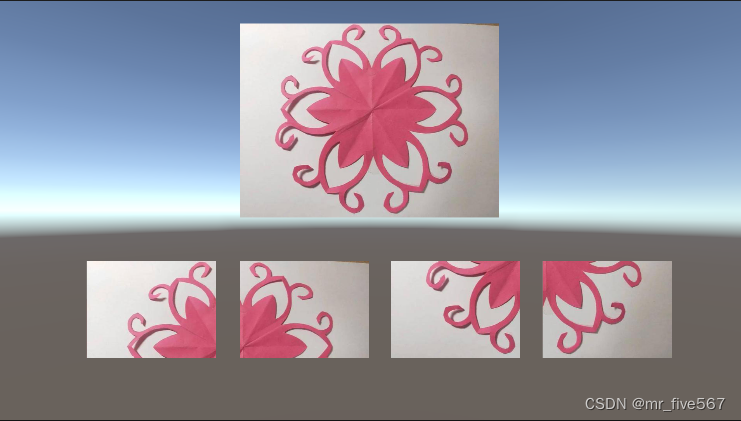

Unity 通过代码将一张大图切成多个小图的方法

在Unity 中要通过代码将一张贴图切割成多张小图,可以使用以下方法: /// <summary>/// 把一张图片切割成多张使用/// </summary>/// <param name"texture">原图</param>/// <param name"rows">切割的行…...

Spring Cloud Gateway请求路径修改指南:详解ServerWebExchange的完美解决方案及代码示例

🌷🍁 博主猫头虎 带您 Go to New World.✨🍁 🦄 博客首页——猫头虎的博客🎐 🐳《面试题大全专栏》 文章图文并茂🦕生动形象🦖简单易学!欢迎大家来踩踩~🌺 &a…...

AI+爬虫 爬虫宝

场景 在很多时候,有很多爬虫的需求,其实需求都是大同小异,不过是在某某网页上爬取某某东西。把这些东西给到业务。以往的做法是:每一个需求写一个c#或者python脚本或者应用,进行爬取,这相当的费时费力&…...

【matlab】绘制横状双组渐变柱状图

【matlab】绘制横状双组渐变柱状图...

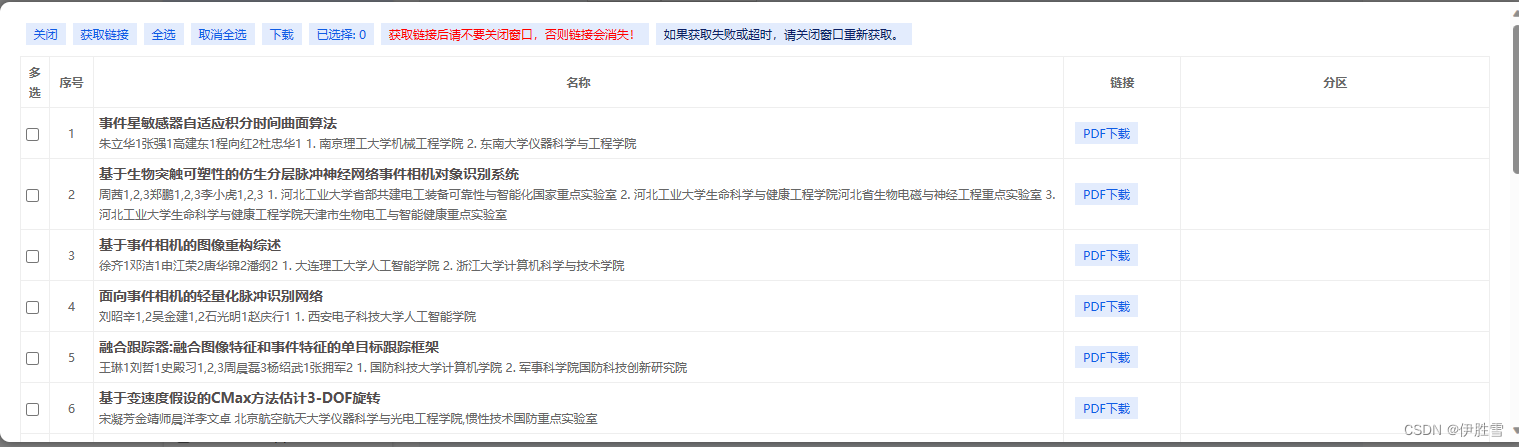

如何下载知网论文、专利的PDF格式

知网的论文格式有其特有的格式:CAJ。将CAJ格式转化为Word或者PDF非常麻烦,且会出现乱码的情况,直接用知网官方的CAJ浏览器也不太方便。为此,困扰了许久。 其实,知网可以直接下载PDF格式,只需在浏览器上安装…...

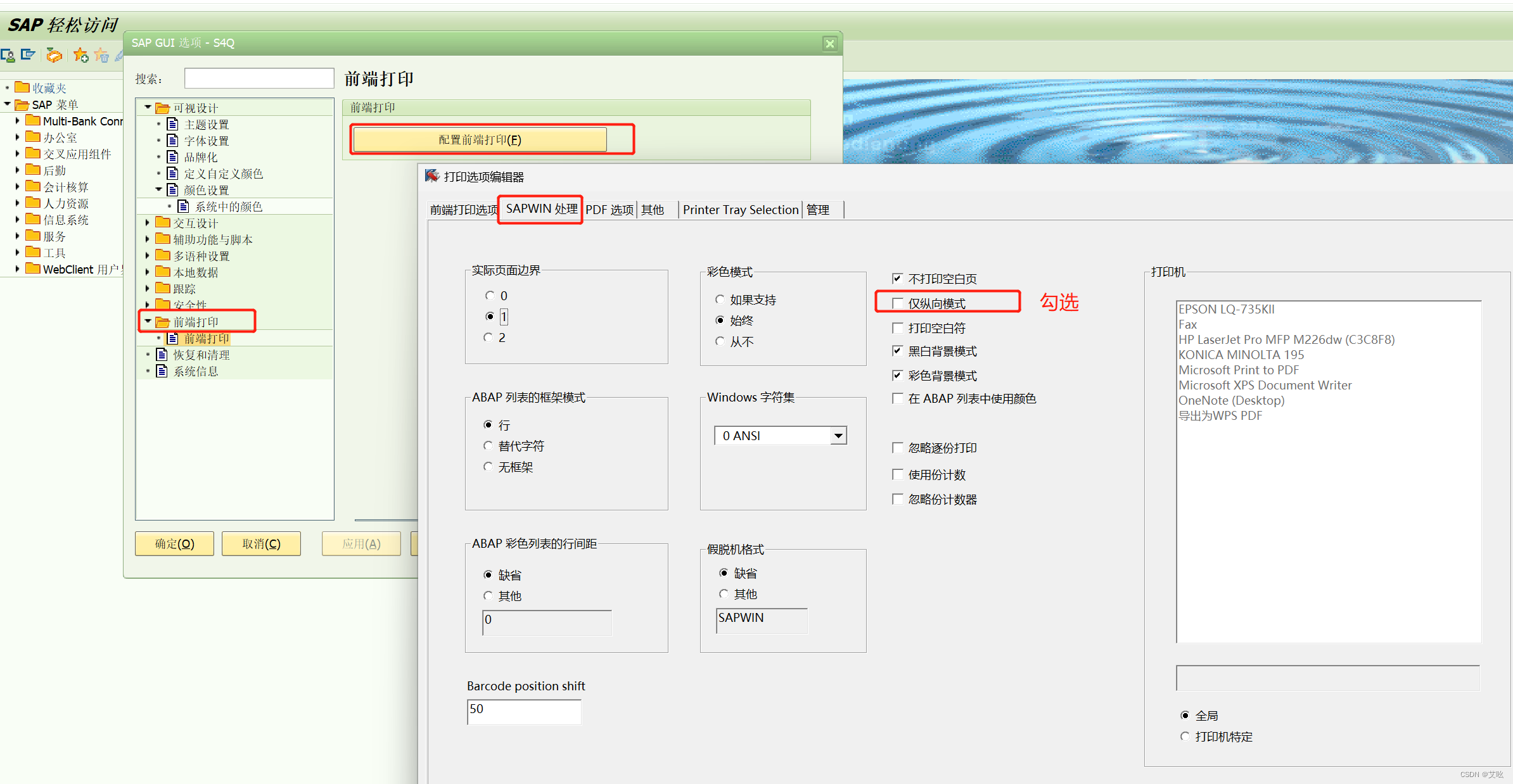

SMARTFORMS打印问题

一、问题概述 项目中碰到EPSON针式打印机,SAP打印出来的三单合一,是想横向打印,结果不管怎么设置打印出来都是纵向的; 二、调整 1、首先调整SMARTFORMS的打印方向,使用T-CODE:SMARTFORMS,如下图…...

uniapp组件和周期的知识点以及怎么使用

UniApp是一个使用Vue.js开发跨平台应用的框架,它可以将代码编译成微信小程序、支付宝小程序、H5、App等多个平台的应用。在UniApp中,组件是构建应用界面的基本单位,而生命周期则是组件在实例化、挂载、更新和销毁过程中的一系列方法。 以下是…...

【Java JVM】实例对象的创建

当我们涉及 Java 编程时, 对象的创建是一个基础而关键的概念。在 Java 中, 一切皆为对象, 而对象的创建方式直接影响代码的结构和性能。 本博客将探讨一下 Java 实例对象的创建过程。 1 创建对象的方法有哪些 在 Java 中如果要创建一个对象, 有哪些方式呢? 运用 new 关键字创…...

sectigo多域名通配符证书

多域名通配符SSL证书是一种特殊的SSL证书,它综合了多域名SSL证书和通配符SSL证书的特点,可以同时保护多个泛域名以及它的主域名,适合域名多,子域名也比较多的单个或多个站点使用。今天就随SSL盾小编了解Sectigo旗下的DV多域名通配…...

盘古信息PCB行业解决方案:以全域场景重构,激活智造新未来

一、破局:PCB行业的时代之问 在数字经济蓬勃发展的浪潮中,PCB(印制电路板)作为 “电子产品之母”,其重要性愈发凸显。随着 5G、人工智能等新兴技术的加速渗透,PCB行业面临着前所未有的挑战与机遇。产品迭代…...

Debian系统简介

目录 Debian系统介绍 Debian版本介绍 Debian软件源介绍 软件包管理工具dpkg dpkg核心指令详解 安装软件包 卸载软件包 查询软件包状态 验证软件包完整性 手动处理依赖关系 dpkg vs apt Debian系统介绍 Debian 和 Ubuntu 都是基于 Debian内核 的 Linux 发行版ÿ…...

(二)TensorRT-LLM | 模型导出(v0.20.0rc3)

0. 概述 上一节 对安装和使用有个基本介绍。根据这个 issue 的描述,后续 TensorRT-LLM 团队可能更专注于更新和维护 pytorch backend。但 tensorrt backend 作为先前一直开发的工作,其中包含了大量可以学习的地方。本文主要看看它导出模型的部分&#x…...

从深圳崛起的“机器之眼”:赴港乐动机器人的万亿赛道赶考路

进入2025年以来,尽管围绕人形机器人、具身智能等机器人赛道的质疑声不断,但全球市场热度依然高涨,入局者持续增加。 以国内市场为例,天眼查专业版数据显示,截至5月底,我国现存在业、存续状态的机器人相关企…...

【解密LSTM、GRU如何解决传统RNN梯度消失问题】

解密LSTM与GRU:如何让RNN变得更聪明? 在深度学习的世界里,循环神经网络(RNN)以其卓越的序列数据处理能力广泛应用于自然语言处理、时间序列预测等领域。然而,传统RNN存在的一个严重问题——梯度消失&#…...

Spring AI 入门:Java 开发者的生成式 AI 实践之路

一、Spring AI 简介 在人工智能技术快速迭代的今天,Spring AI 作为 Spring 生态系统的新生力量,正在成为 Java 开发者拥抱生成式 AI 的最佳选择。该框架通过模块化设计实现了与主流 AI 服务(如 OpenAI、Anthropic)的无缝对接&…...

拉力测试cuda pytorch 把 4070显卡拉满

import torch import timedef stress_test_gpu(matrix_size16384, duration300):"""对GPU进行压力测试,通过持续的矩阵乘法来最大化GPU利用率参数:matrix_size: 矩阵维度大小,增大可提高计算复杂度duration: 测试持续时间(秒&…...

涂鸦T5AI手搓语音、emoji、otto机器人从入门到实战

“🤖手搓TuyaAI语音指令 😍秒变表情包大师,让萌系Otto机器人🔥玩出智能新花样!开整!” 🤖 Otto机器人 → 直接点明主体 手搓TuyaAI语音 → 强调 自主编程/自定义 语音控制(TuyaAI…...

sipsak:SIP瑞士军刀!全参数详细教程!Kali Linux教程!

简介 sipsak 是一个面向会话初始协议 (SIP) 应用程序开发人员和管理员的小型命令行工具。它可以用于对 SIP 应用程序和设备进行一些简单的测试。 sipsak 是一款 SIP 压力和诊断实用程序。它通过 sip-uri 向服务器发送 SIP 请求,并检查收到的响应。它以以下模式之一…...

三分算法与DeepSeek辅助证明是单峰函数

前置 单峰函数有唯一的最大值,最大值左侧的数值严格单调递增,最大值右侧的数值严格单调递减。 单谷函数有唯一的最小值,最小值左侧的数值严格单调递减,最小值右侧的数值严格单调递增。 三分的本质 三分和二分一样都是通过不断缩…...