高级RAG:重新排名,从原理到实现的两种主流方法

原文地址:https://pub.towardsai.net/advanced-rag-04-re-ranking-85f6ae8170b1

2024 年 2 月 14 日

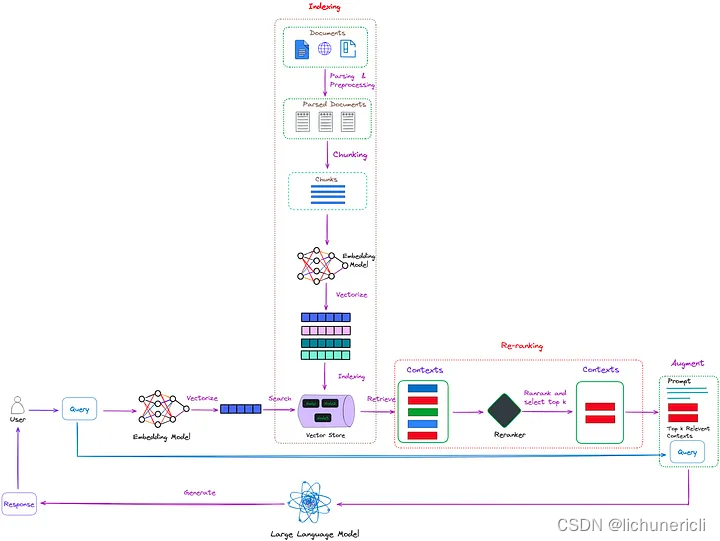

重新排序在检索增强生成(RAG)过程中起着至关重要的作用。在简单的 RAG 方法中,可以检索大量上下文,但并非所有上下文都一定与问题相关。重新排序允许对文档进行重新排序和过滤,将相关文档置于最前面,从而提高 RAG 的有效性。

本文介绍了 RAG 的重新排名技术,并演示了如何使用两种方法合并重新排名功能。

重新排序(Re-ranking)简介

图 1:RAG 中的重新排序,重新排序的任务是评估这些上下文的相关性,并优先考虑最有可能提供准确且相关答案的上下文(红色框)。

图 1:RAG 中的重新排序,重新排序的任务是评估这些上下文的相关性,并优先考虑最有可能提供准确且相关答案的上下文(红色框)。

如图1所示,重新排序的任务就像一个智能过滤器。当检索器从索引集合中检索多个上下文时,这些上下文可能与用户的查询具有不同的相关性。有些上下文可能非常相关(在图 1 中以红色框突出显示),而另一些上下文可能只是轻微相关甚至不相关(在图 1 中以绿色和蓝色框突出显示)。

重新排名的任务是评估这些上下文的相关性,并优先考虑最有可能提供准确且相关答案的上下文。这使得LLMs能够在生成答案时优先考虑这些排名靠前的上下文,从而提高响应的准确性和质量。

简单来说,重新排名就像开卷考试时帮助你从一堆学习材料中选择最相关的参考文献,以便你更高效、更准确地回答问题。

本文介绍的重排序方法主要可以分为以下两种:

- 重新排序模型:这些模型考虑文档和查询之间的交互特征,以更准确地评估它们的相关性。

- LLM:LLM的出现为重新排名开辟了新的可能性。通过彻底理解整个文档和查询,可以更全面地捕获语义信息。

使用重新排序模型作为重排器

重新排序模型与嵌入模型不同,它将查询和上下文作为输入,直接输出相似性得分而不是嵌入得分。值得注意的是,重新排序模型是利用交叉熵损失进行优化的,因此相关性得分不局限于特定范围,甚至可以是负分。

目前,可用的重新排序模型并不多。一种选择是 Cohere 提供的在线模型,可以通过 API 访问。此外,还有一些开源模型,如 bge-reranker-base 和 bge-reranker-large 等。

图 2 显示了使用命中率(Hit Rate)和平均倒数排名(Mean Reciprocal Rank,MRR)指标的评估结果:

从评估结果可以看出:

- 无论使用哪种嵌入模型,重新排序都能显示出更高的命中率和 MRR,这表明重新排序具有重大影响。

- 目前,最好的重新排名模型是 Cohere,但它是一项付费服务。开源的 bge-reranker-large 模型具有与 Cohere 相似的功能。

- 嵌入模型和重新排序模型的组合也会产生影响,因此开发人员可能需要在实际过程中尝试不同的组合。

本文将使用 bge-reranker-base 模型。

环境配置

导入相关库,设置环境变量和全局变量

import os

os.environ["OPENAI_API_KEY"] = "YOUR_OPENAI_KEY"from llama_index import VectorStoreIndex, SimpleDirectoryReader

from llama_index.postprocessor.flag_embedding_reranker import FlagEmbeddingReranker

from llama_index.schema import QueryBundledir_path = "YOUR_DIR_PATH"

目录中只有一个 PDF 文件,即 "TinyLlama: An Open Source Small Language Model"。

(py) Florian:~ Florian$ ls /Users/Florian/Downloads/pdf_test/ tinyllama.pdf

使用 LlamaIndex 构建一个简单的检索器

documents = SimpleDirectoryReader(dir_path).load_data()

index = VectorStoreIndex.from_documents(documents)

retriever = index.as_retriever(similarity_top_k = 3)

基本检索

query = "Can you provide a concise description of the TinyLlama model?"

nodes = retriever.retrieve(query)

for node in nodes:print('----------------------------------------------------')display_source_node(node, source_length = 500)

display_source_node 函数改编自 llama_index 源代码。原始函数是为 Jupyter notebook 设计的,因此修改如下:

from llama_index.schema import ImageNode, MetadataMode, NodeWithScore

from llama_index.utils import truncate_textdef display_source_node(source_node: NodeWithScore,source_length: int = 100,show_source_metadata: bool = False,metadata_mode: MetadataMode = MetadataMode.NONE,

) -> None:"""Display source node"""source_text_fmt = truncate_text(source_node.node.get_content(metadata_mode=metadata_mode).strip(), source_length)text_md = (f"Node ID: {source_node.node.node_id} \n"f"Score: {source_node.score} \n"f"Text: {source_text_fmt} \n")if show_source_metadata:text_md += f"Metadata: {source_node.node.metadata} \n"if isinstance(source_node.node, ImageNode):text_md += "Image:"print(text_md)# display(Markdown(text_md))# if isinstance(source_node.node, ImageNode) and source_node.node.image is not None:# display_image(source_node.node.image)

基本检索结果如下,表示重新排序前的前 3 个节点:

----------------------------------------------------

Node ID: 438b9d91-cd5a-44a8-939e-3ecd77648662

Score: 0.8706055408845863

Text: 4 Conclusion

In this paper, we introduce TinyLlama, an open-source, small-scale language model. To promote

transparency in the open-source LLM pre-training community, we have released all relevant infor-

mation, including our pre-training code, all intermediate model checkpoints, and the details of our

data processing steps. With its compact architecture and promising performance, TinyLlama can

enable end-user applications on mobile devices, and serve as a lightweight platform for testing a

w... ----------------------------------------------------

Node ID: ca4db90f-5c6e-47d5-a544-05a9a1d09bc6

Score: 0.8624531691777889

Text: TinyLlama: An Open-Source Small Language Model

Peiyuan Zhang∗Guangtao Zeng∗Tianduo Wang Wei Lu

StatNLP Research Group

Singapore University of Technology and Design

{peiyuan_zhang, tianduo_wang, @sutd.edu.sg">luwei}@sutd.edu.sg

guangtao_zeng@mymail.sutd.edu.sg

Abstract

We present TinyLlama, a compact 1.1B language model pretrained on around 1

trillion tokens for approximately 3 epochs. Building on the architecture and tok-

enizer of Llama 2 (Touvron et al., 2023b), TinyLlama leverages various advances

contr... ----------------------------------------------------

Node ID: e2d97411-8dc0-40a3-9539-a860d1741d4f

Score: 0.8346160605298356

Text: Although these works show a clear preference on large models, the potential of training smaller

models with larger dataset remains under-explored. Instead of training compute-optimal language

models, Touvron et al. (2023a) highlight the importance of the inference budget, instead of focusing

solely on training compute-optimal language models. Inference-optimal language models aim for

optimal performance within specific inference constraints This is achieved by training models with

more tokens...

重新排序

要对上述节点重新排序,请使用 bge-reranker-base 模型。

print('------------------------------------------------------------------------------------------------')

print('Start reranking...')reranker = FlagEmbeddingReranker(top_n = 3,model = "BAAI/bge-reranker-base",

)query_bundle = QueryBundle(query_str=query)

ranked_nodes = reranker._postprocess_nodes(nodes, query_bundle = query_bundle)

for ranked_node in ranked_nodes:print('----------------------------------------------------')display_source_node(ranked_node, source_length = 500)

重新排序后的结果如下:

------------------------------------------------------------------------------------------------

Start reranking...

----------------------------------------------------

Node ID: ca4db90f-5c6e-47d5-a544-05a9a1d09bc6

Score: -1.584416151046753

Text: TinyLlama: An Open-Source Small Language Model

Peiyuan Zhang∗Guangtao Zeng∗Tianduo Wang Wei Lu

StatNLP Research Group

Singapore University of Technology and Design

{peiyuan_zhang, tianduo_wang, @sutd.edu.sg">luwei}@sutd.edu.sg

guangtao_zeng@mymail.sutd.edu.sg

Abstract

We present TinyLlama, a compact 1.1B language model pretrained on around 1

trillion tokens for approximately 3 epochs. Building on the architecture and tok-

enizer of Llama 2 (Touvron et al., 2023b), TinyLlama leverages various advances

contr... ----------------------------------------------------

Node ID: e2d97411-8dc0-40a3-9539-a860d1741d4f

Score: -1.7028117179870605

Text: Although these works show a clear preference on large models, the potential of training smaller

models with larger dataset remains under-explored. Instead of training compute-optimal language

models, Touvron et al. (2023a) highlight the importance of the inference budget, instead of focusing

solely on training compute-optimal language models. Inference-optimal language models aim for

optimal performance within specific inference constraints This is achieved by training models with

more tokens... ----------------------------------------------------

Node ID: 438b9d91-cd5a-44a8-939e-3ecd77648662

Score: -2.904750347137451

Text: 4 Conclusion

In this paper, we introduce TinyLlama, an open-source, small-scale language model. To promote

transparency in the open-source LLM pre-training community, we have released all relevant infor-

mation, including our pre-training code, all intermediate model checkpoints, and the details of our

data processing steps. With its compact architecture and promising performance, TinyLlama can

enable end-user applications on mobile devices, and serve as a lightweight platform for testing a

w...

很明显,经过重新排序后,ID 为 ca4db90f-5c6e-47d5-a544-05a9a1d09bc6 的节点的排名从 2 变为 1,这意味着最相关的上下文被排在了第一位。

使用 LLM 作为重排器

现有的涉及 LLM 的重新排序方法大致可分为三类:利用重新排序任务对 LLM 进行微调、提示 LLM 进行重新排序以及在训练过程中使用 LLM 进行数据增强。

提示 LLM 重新排序的方法成本较低。下面是使用 RankGPT 进行的演示,它已被集成到 LlamaIndex 中。

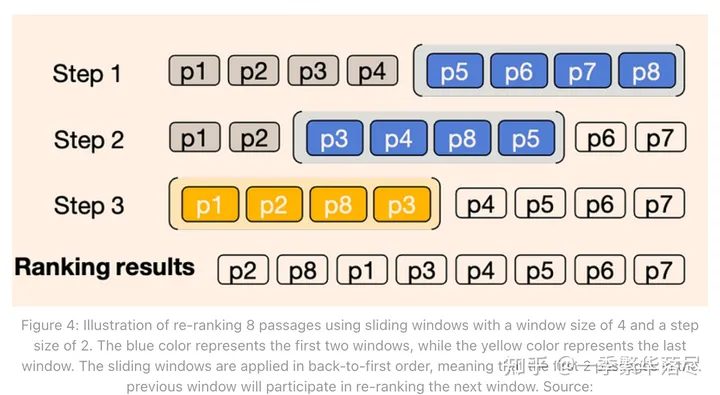

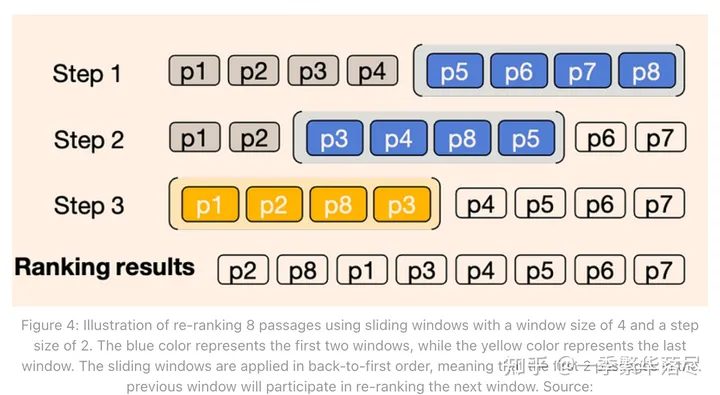

RankGPT 的理念是使用 LLM(如 ChatGPT 或 GPT-4 或其他 LLM)执行零样本列表式段落重新排序。它采用排列生成方法和滑动窗口策略来有效地对段落重新排序。

如图 3 所示,本文提出了三种可行的方法。

前两种方法是传统方法,即给每篇文档打分,然后根据分数对所有段落进行排序。

本文提出了第三种方法,即排列生成法。具体来说,该模型不依赖外部评分,而是直接对段落进行端到端排序。换句话说,它直接利用 LLM 的语义理解能力对所有候选段落进行相关性排序。

然而,候选文档的数量通常非常大,而 LLM 的输入却很有限。因此,通常无法一次性输入所有文本。

因此,如图 4 所示,我们引入了一种滑动窗口法,它沿用了冒泡排序的思想。每次只对前 4 个文本进行排序,然后移动窗口,对后面 4 个文本进行排序。在对整个文本进行反复排序后,我们就可以得到性能最好的文本。

请注意,要使用 RankGPT,您需要安装较新版本的 LlamaIndex。我之前安装的版本(0.9.29)不包含 RankGPT 所需的代码。因此,我用 LlamaIndex 0.9.45.post1 版本创建了一个新的 conda 环境。

代码非常简单,基于上一节的代码,只需将 RankGPT 设置为重选器即可。

from llama_index.postprocessor import RankGPTRerank

from llama_index.llms import OpenAI

reranker = RankGPTRerank(top_n = 3,llm = OpenAI(model="gpt-3.5-turbo-16k"),# verbose=True,

)

总体结果如下:

(llamaindex_new) Florian:~ Florian$ python /Users/Florian/Documents/rerank.py

----------------------------------------------------

Node ID: 20de8234-a668-442d-8495-d39b156b44bb

Score: 0.8703492815379594

Text: 4 Conclusion

In this paper, we introduce TinyLlama, an open-source, small-scale language model. To promote

transparency in the open-source LLM pre-training community, we have released all relevant infor-

mation, including our pre-training code, all intermediate model checkpoints, and the details of our

data processing steps. With its compact architecture and promising performance, TinyLlama can

enable end-user applications on mobile devices, and serve as a lightweight platform for testing a

w... ----------------------------------------------------

Node ID: 47ba3955-c6f8-4f28-a3db-f3222b3a09cd

Score: 0.8621633467539512

Text: TinyLlama: An Open-Source Small Language Model

Peiyuan Zhang∗Guangtao Zeng∗Tianduo Wang Wei Lu

StatNLP Research Group

Singapore University of Technology and Design

{peiyuan_zhang, tianduo_wang, @sutd.edu.sg">luwei}@sutd.edu.sg

guangtao_zeng@mymail.sutd.edu.sg

Abstract

We present TinyLlama, a compact 1.1B language model pretrained on around 1

trillion tokens for approximately 3 epochs. Building on the architecture and tok-

enizer of Llama 2 (Touvron et al., 2023b), TinyLlama leverages various advances

contr... ----------------------------------------------------

Node ID: 17cd9896-473c-47e0-8419-16b4ac615a59

Score: 0.8343984516104476

Text: Although these works show a clear preference on large models, the potential of training smaller

models with larger dataset remains under-explored. Instead of training compute-optimal language

models, Touvron et al. (2023a) highlight the importance of the inference budget, instead of focusing

solely on training compute-optimal language models. Inference-optimal language models aim for

optimal performance within specific inference constraints This is achieved by training models with

more tokens... ------------------------------------------------------------------------------------------------

Start reranking...

----------------------------------------------------

Node ID: 47ba3955-c6f8-4f28-a3db-f3222b3a09cd

Score: 0.8621633467539512

Text: TinyLlama: An Open-Source Small Language Model

Peiyuan Zhang∗Guangtao Zeng∗Tianduo Wang Wei Lu

StatNLP Research Group

Singapore University of Technology and Design

{peiyuan_zhang, tianduo_wang, @sutd.edu.sg">luwei}@sutd.edu.sg

guangtao_zeng@mymail.sutd.edu.sg

Abstract

We present TinyLlama, a compact 1.1B language model pretrained on around 1

trillion tokens for approximately 3 epochs. Building on the architecture and tok-

enizer of Llama 2 (Touvron et al., 2023b), TinyLlama leverages various advances

contr... ----------------------------------------------------

Node ID: 17cd9896-473c-47e0-8419-16b4ac615a59

Score: 0.8343984516104476

Text: Although these works show a clear preference on large models, the potential of training smaller

models with larger dataset remains under-explored. Instead of training compute-optimal language

models, Touvron et al. (2023a) highlight the importance of the inference budget, instead of focusing

solely on training compute-optimal language models. Inference-optimal language models aim for

optimal performance within specific inference constraints This is achieved by training models with

more tokens... ----------------------------------------------------

Node ID: 20de8234-a668-442d-8495-d39b156b44bb

Score: 0.8703492815379594

Text: 4 Conclusion

In this paper, we introduce TinyLlama, an open-source, small-scale language model. To promote

transparency in the open-source LLM pre-training community, we have released all relevant infor-

mation, including our pre-training code, all intermediate model checkpoints, and the details of our

data processing steps. With its compact architecture and promising performance, TinyLlama can

enable end-user applications on mobile devices, and serve as a lightweight platform for testing a

w...

请注意,由于使用了 LLM,重新排序后的分数并未更新。当然,这并不重要。

从结果可以看出,经过重新排序后,排在第一位的结果是包含答案的正确文本,这与前面使用重新排序模型得出的结果一致。

评估

reranker = FlagEmbeddingReranker(top_n = 3,model = "BAAI/bge-reranker-base",use_fp16 = False

)# or using LLM as reranker

# from llama_index.postprocessor import RankGPTRerank

# from llama_index.llms import OpenAI

# reranker = RankGPTRerank(

# top_n = 3,

# llm = OpenAI(model="gpt-3.5-turbo-16k"),

# # verbose=True,

# )query_engine = index.as_query_engine( # add reranker to query_enginesimilarity_top_k = 3, node_postprocessors=[reranker]

)

# query_engine = index.as_query_engine() # original query_engine

参考:https://ai.plainenglish.io/advanced-rag-03-using-ragas-llamaindex-for-rag-evaluation-84756b82dca7

结论

总之,本文介绍了重新排序的原则和两种主流方法。

另一方面,使用 LLM 的方法在多个基准测试中表现良好,但成本较高,而且仅在使用 ChatGPT 和 GPT-4 时表现良好,而在使用 FLAN-T5 和 Vicuna-13B 等其他开源模型时表现不佳。

相关文章:

高级RAG:重新排名,从原理到实现的两种主流方法

原文地址:https://pub.towardsai.net/advanced-rag-04-re-ranking-85f6ae8170b1 2024 年 2 月 14 日 重新排序在检索增强生成(RAG)过程中起着至关重要的作用。在简单的 RAG 方法中,可以检索大量上下文,但并非所有上下…...

使用logicflow流程图实例

一.背景 需要使用流程引擎开发项目,没有使用flowable、activiti这类的国外流程引擎,想使用国内的引擎二次开发,缺少单例模式的流程画图程序,都是vue、react、angluer的不适合,从网上找了antx6、logicflow、bpmn.js。感…...

Stable Diffusion 绘画入门教程(webui)-ControlNet(IP2P)

上篇文章介绍了深度Depth,这篇文章介绍下IP2P(InstructP2P), 通俗理解就是图生图,给原有图加一些效果,比如下图,左边为原图,右边为增加了效果的图: 文章目录 一、选大模型二、写提示词三、基础参…...

)

五力分析(Porter‘s Five Forces)

五力分析是一种用于评估竞争力的框架,由哈佛商学院教授迈克尔波特(Michael Porter)提出。它通过分析一个行业的五个关键力量(竞争对手、供应商、顾客、替代品和新进入者)来评估一个企业或行业的竞争环境。这个框架可以…...

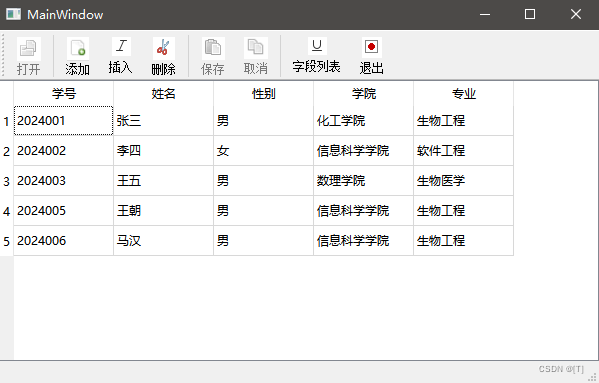

十一、Qt数据库操作

一、Sql介绍 Qt Sql模块包含多个类,实现数据库的连接,Sql语句的执行,数据获取与界面显示,数据与界面直接使用Model/View结构。1、使用Sql模块 (1)工程加入 QT sql(2)添加头文件 …...

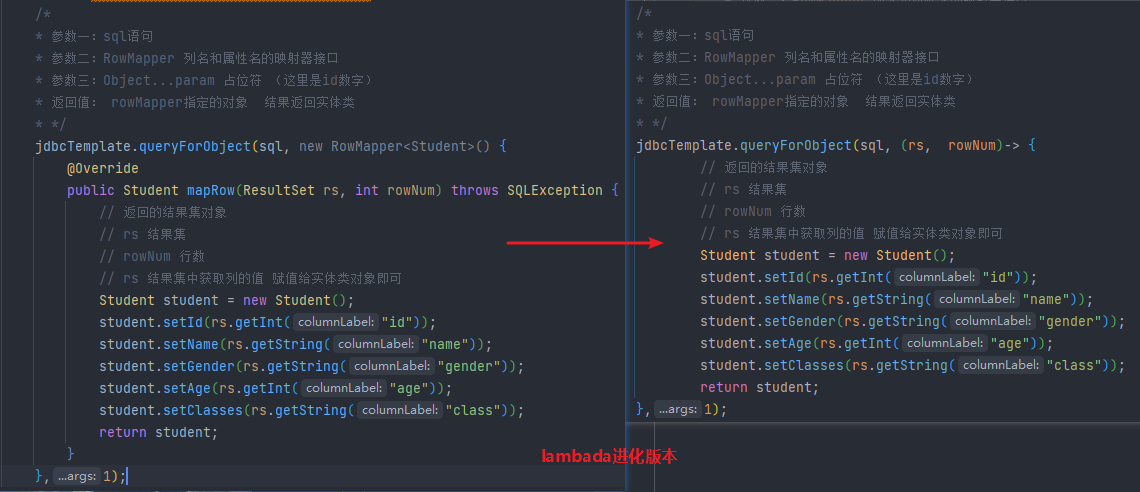

【Spring】IoC容器 控制反转 与 DI依赖注入 XML实现版本 第二期

文章目录 基于 XML 配置方式组件管理前置 准备项目一、 组件(Bean)信息声明配置(IoC):1.1 基于无参构造1.2 基于静态 工厂方法实例化1.3 基于非静态 工厂方法实例化 二、 组件(Bean)依赖注入配置…...

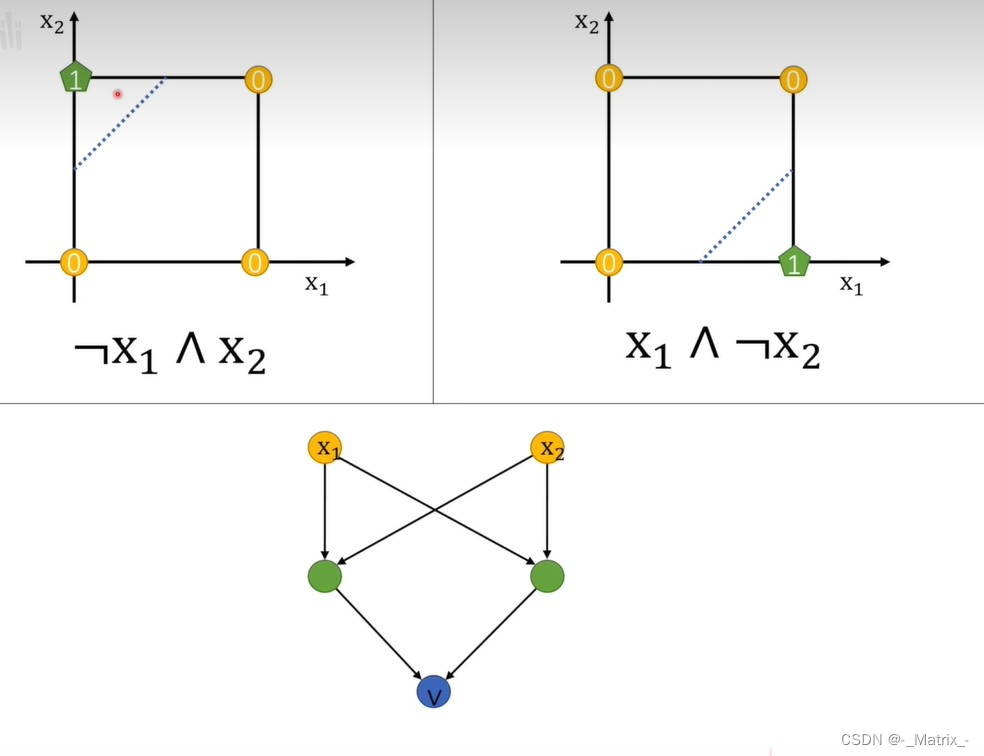

神经网络系列---感知机(Neuron)

文章目录 感知机(Neuron)感知机(Neuron)的决策函数可以表示为:感知机(Neuron)的学习算法主要包括以下步骤:感知机可以实现逻辑运算中的AND、OR、NOT和异或(XOR)运算。 感知机(Neuron) 感知机(Neuron)是一种简单而有效的二分类算法,用于将输入…...

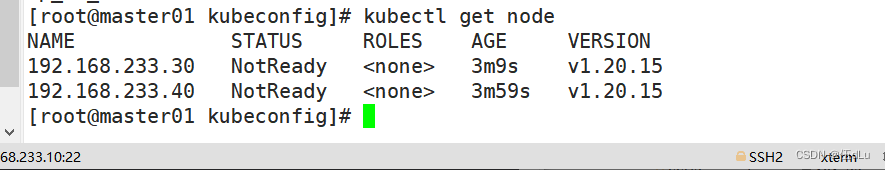

k8s(2)

目录 一.二进制部署k8s 常见的K8S安装部署方式: k8s部署 二进制与高可用的区别 二.部署k8s 初始化操作: 每台node安装docker: 在 master01 节点上操作; 准备cfssl证书生成工具:: 执行脚本文件: 拉入etcd压缩包…...

利用nginx内部访问特性实现静态资源授权访问

在nginx中,将静态资源设为internal;然后将前端的静态资源地址改为指向后端,在后端的响应头部中写上静态资源地址。 近期客户对我们项目做安全性测评,暴露出一些安全性问题,其中一个是有些静态页面(*.html&…...

fly-barrage 前端弹幕库(1):项目介绍

fly-barrage 是我写的一个前端弹幕库,由于经常在 Bilibili 上看视频,所以对网页的弹幕功能一直蛮感兴趣的,所以做了这个库,可以帮助前端快速的实现弹幕功能。 项目官网地址:https://fly-barrage.netlify.app/ÿ…...

jetcache如果一个主体涉及多个缓存时编辑或者删除时如何同时失效多个缓存

在实际使用过程中,可能会遇到这种情形:一个主体会有多个缓存,比如用户基础信息缓存、用户详情缓存,那么当删除用户信息后就需要同时失效多个缓存中该主体数据,那么jetcache支持这种应用场景么,答案是支持&a…...

uni-app 实现拍照后给照片加水印功能

遇到个需求需要实现,研究了一下后写了个demo 本质上就是把拍完照后的照片放到canvas里,然后加上水印样式然后再重新生成一张图片 代码如下,看注释即可~使用的话记得还是得优化下代码 <template><view class"content"&g…...

【ArcGIS】利用DEM进行水文分析:流向/流量等

利用DEM进行水文分析 ArcGIS实例参考 水文分析通过建立地表水文模型,研究与地表水流相关的各种自然现象,在城市和区域规划、农业及森林、交通道路等许多领域具有广泛的应用。 ArcGIS实例 某流域30m分辨率DEM如下: (1)…...

论文阅读笔记——PathAFL:Path-Coverage Assisted Fuzzing

文章目录 前言PathAFL:Path-Coverage Assisted Fuzzing1、解决的问题和目标2、技术路线2.1、如何识别 h − p a t h h-path h−path?2.2、如何减少 h − p a t h h-path h−path的数量?2.3、哪些h-path将被添加到种子队列?2.4、种…...

C语言中各种运算符用法

C语言中有许多不同的运算符,用于执行各种不同的操作。 以下是C语言中常见的运算符及其用法: 算术运算符: 加法运算符():用于将两个值相加。减法运算符(-):用于将一个值减…...

pythonJax小记(五):python: 使用Jax深度图像(正交投影和透视投影之间的转换)(持续更新,评论区可以补充)

python: 使用Jax深度图像(正交投影和透视投影之间的转换) 前言问题描述1. 透视投影2. 正交投影 直接上代码解释1. compute_projection_parameters 函数a. 参数解释b. 函数计算 2. ortho_to_persp 函数a. 计算投影参数:b. 生成像素坐标网格&am…...

web安全学习笔记【16】——信息打点(6)

信息打点-语言框架&开发组件&FastJson&Shiro&Log4j&SpringBoot等[1] #知识点: 1、业务资产-应用类型分类 2、Web单域名获取-接口查询 3、Web子域名获取-解析枚举 4、Web架构资产-平台指纹识别 ------------------------------------ 1、开源-C…...

145.二叉树的后序遍历

// 定义一个名为Solution的类,用于解决二叉树的后序遍历问题 class Solution { // 定义一个公共方法,输入是一个二叉树的根节点,返回一个包含后序遍历结果的整数列表 public List<Integer> postorderTraversal(TreeNode root) { /…...

ssh远程连接免密码访问

我们在远程登录的时候,经常需要输入密码,密码往往比较复杂,输入比较耗费时间,这种情况下可以使用ssh免密码登录。 一般的教程是需要生成ssh密钥后,然后把密钥复制到server端完成配置,这里提供一个简单的方…...

Vue-Json-Schema-Form: 如何基于模板定制前端页面

本人从事的是工业物联网, 面对工业设备的通讯难题是各大设备都有各自的通讯协议, 如果想要用一款硬件去和所有设备做通讯的话, 就得面对怎么把自己想要采集的配置下发给自己的采集器的问题, 以前都是采用各种模型去尝试构建配置项, 但是因为配置可能会有深层次嵌套, 而且…...

AI-调查研究-01-正念冥想有用吗?对健康的影响及科学指南

点一下关注吧!!!非常感谢!!持续更新!!! 🚀 AI篇持续更新中!(长期更新) 目前2025年06月05日更新到: AI炼丹日志-28 - Aud…...

)

Java 语言特性(面试系列2)

一、SQL 基础 1. 复杂查询 (1)连接查询(JOIN) 内连接(INNER JOIN):返回两表匹配的记录。 SELECT e.name, d.dept_name FROM employees e INNER JOIN departments d ON e.dept_id d.dept_id; 左…...

:OpenBCI_GUI:从环境搭建到数据可视化(下))

脑机新手指南(八):OpenBCI_GUI:从环境搭建到数据可视化(下)

一、数据处理与分析实战 (一)实时滤波与参数调整 基础滤波操作 60Hz 工频滤波:勾选界面右侧 “60Hz” 复选框,可有效抑制电网干扰(适用于北美地区,欧洲用户可调整为 50Hz)。 平滑处理&…...

反射获取方法和属性

Java反射获取方法 在Java中,反射(Reflection)是一种强大的机制,允许程序在运行时访问和操作类的内部属性和方法。通过反射,可以动态地创建对象、调用方法、改变属性值,这在很多Java框架中如Spring和Hiberna…...

Module Federation 和 Native Federation 的比较

前言 Module Federation 是 Webpack 5 引入的微前端架构方案,允许不同独立构建的应用在运行时动态共享模块。 Native Federation 是 Angular 官方基于 Module Federation 理念实现的专为 Angular 优化的微前端方案。 概念解析 Module Federation (模块联邦) Modul…...

)

【RockeMQ】第2节|RocketMQ快速实战以及核⼼概念详解(二)

升级Dledger高可用集群 一、主从架构的不足与Dledger的定位 主从架构缺陷 数据备份依赖Slave节点,但无自动故障转移能力,Master宕机后需人工切换,期间消息可能无法读取。Slave仅存储数据,无法主动升级为Master响应请求ÿ…...

AI书签管理工具开发全记录(十九):嵌入资源处理

1.前言 📝 在上一篇文章中,我们完成了书签的导入导出功能。本篇文章我们研究如何处理嵌入资源,方便后续将资源打包到一个可执行文件中。 2.embed介绍 🎯 Go 1.16 引入了革命性的 embed 包,彻底改变了静态资源管理的…...

在web-view 加载的本地及远程HTML中调用uniapp的API及网页和vue页面是如何通讯的?

uni-app 中 Web-view 与 Vue 页面的通讯机制详解 一、Web-view 简介 Web-view 是 uni-app 提供的一个重要组件,用于在原生应用中加载 HTML 页面: 支持加载本地 HTML 文件支持加载远程 HTML 页面实现 Web 与原生的双向通讯可用于嵌入第三方网页或 H5 应…...

LeetCode - 199. 二叉树的右视图

题目 199. 二叉树的右视图 - 力扣(LeetCode) 思路 右视图是指从树的右侧看,对于每一层,只能看到该层最右边的节点。实现思路是: 使用深度优先搜索(DFS)按照"根-右-左"的顺序遍历树记录每个节点的深度对于…...

拟合问题处理

在机器学习中,核心任务通常围绕模型训练和性能提升展开,但你提到的 “优化训练数据解决过拟合” 和 “提升泛化性能解决欠拟合” 需要结合更准确的概念进行梳理。以下是对机器学习核心任务的系统复习和修正: 一、机器学习的核心任务框架 机…...