基于python的百度资讯爬虫的设计与实现

研究背景

随着互联网和信息技术的飞速发展,网络已经成为人们获取信息的主要来源之一。特别是搜索引擎,作为信息检索的核心工具,极大地改变了人们获取信息的方式。其中,百度作为中国最受欢迎的搜索引擎之一,其新闻搜索功能为用户提供了丰富的实时信息。本文研究背景围绕利用爬虫技术从百度新闻中提取有价值的信息展开。

1. 网络爬虫的应用与重要性

网络爬虫(Web Crawler)是通过程序自动地从互联网上获取信息的技术。它广泛应用于搜索引擎的数据抓取、内容聚合、舆情监控、市场调研等领域。通过网络爬虫,可以快速、大规模地获取结构化和非结构化的数据,为数据分析和信息挖掘提供基础支持。

2. 百度新闻作为信息源的优势

百度新闻是百度搜索引擎的重要组成部分,它汇集了海量的新闻资源,涵盖了全球各地的实时新闻动态。由于其信息量大、更新速度快、内容覆盖广,百度新闻成为研究实时信息、公共舆情和新闻热点的宝贵数据源。

3. 爬取百度新闻的技术挑战

尽管百度新闻提供了丰富的信息,但直接从网页中提取数据存在一定的技术挑战。首先,百度新闻页面结构复杂,不同类型的新闻内容在HTML中呈现的方式各不相同。其次,百度会通过设置反爬机制(如频繁请求检测、验证码等)来防止恶意爬虫,这要求爬虫程序具备一定的随机性和智能性,以模拟真实用户的访问行为。

4. 研究目的与意义

本研究的目的在于设计并实现一个有效的网络爬虫,从百度新闻中自动提取相关的新闻标题、链接、内容摘要和来源信息。这不仅为研究人员提供了一种获取大规模新闻数据的有效手段,也为进一步的数据分析和挖掘提供了基础。例如,通过分析不同时间段的新闻热点,可以了解社会关注的焦点问题;通过舆情监控,可以及时捕捉并应对公共舆论的变化。

5. 方法概述

在具体实现上,本文采用Python语言编写爬虫程序,利用urllib.request模块发起HTTP请求,模拟浏览器访问百度新闻搜索页面。通过设置合适的请求头,避免被识别为爬虫。然后使用BeautifulSoup库解析HTML内容,提取所需的新闻信息。为了避免触发百度的反爬机制,程序在每次请求之间随机等待一段时间,以模拟正常用户的访问行为。

6. 预期成果

通过本研究,希望能够实现以下成果:

设计并实现一个能够高效稳定运行的百度新闻爬虫程序。

从百度新闻中自动提取大量有价值的新闻数据。

为后续的新闻数据分析和研究提供可靠的数据来源。

综上所述,利用网络爬虫从百度新闻中提取信息,不仅是对网络爬虫技术的应用和实践,更是为大数据时代的信息获取和分析提供了一种行之有效的方法。希望本研究能够在网络爬虫技术和数据挖掘应用方面有所贡献。

数据挖掘技术基础

查询网页源代码、获取User-Agent、获得请求网址的状态码以及从网页源代码中获取RequestURL,都是进行网页分析和抓取的重要步骤。以下是详细的步骤和方法:

1. 查询网页源代码

使用浏览器的开发者工具:

打开浏览器(例如Google Chrome)。

导航到你想查看源代码的网页。

右键点击页面,然后选择“检查”(Inspect)。

在弹出的开发者工具窗口中,选择“Elements”标签。这里可以看到网页的HTML源代码。如下图所示:

使用Python爬虫:

可以使用urllib.request和BeautifulSoup库来获取网页的源代码。

request = urllib.request.Request(url+str(i*10),headers=headers)

response = urllib.request.urlopen(request)

res=response.read().decode('utf-8')

print(res)

运行后结果如下图:

2. 获取User-Agent

使用浏览器的开发者工具:

打开开发者工具(同样使用“检查”选项)。

转到“Network”标签。

刷新页面。

在请求列表中选择任意一个请求。

在“Headers”选项中,可以找到该请求的User-Agent信息。如下图

也可以使用Python获取User-Agent:

import requests

response = requests.get('https://www.baidu.com/')

user_agent = response.request.headers['User-Agent']

print(user_agent)

3.获得请求网址的状态码

获取响应码,可以使用 response.getcode() 方法。代码如下:

request = urllib.request.Request(url+str(i*10),headers=headers)

response = urllib.request.urlopen(request)

status_code = response.getcode()

print(f"Response code for request {i}: {status_code}")

运行结果如下图:

4. 从网页源代码中获取RequestURL

需要从HTML源代码中提取某个特定的URL,比如从<a>标签或<img>标签中提取链接地址,可以使用BeautifulSoup。

使用Python的BeautifulSoup库的代码:

soup=BeautifulSoup(res,'lxml')

dw = soup.find_all('div', class_='result-op c-container xpath-log new-pmd')

for n in dw:

url0=n.find('a',class_='news-title-font_1xS-F').get('href')

运行后如下图:

5.判断是Get请求还是Post请求

要判断是GET请求还是POST请求,可以从以下几个方面入手:

HTTP方法:

GET请求:数据通过URL参数传递,使用查询字符串(query string)。

POST请求:数据通过请求主体(body)传递,通常不会显示在URL中。

数据位置:

GET请求:数据附加在URL后,以问号 ? 开始,多个参数用 & 分隔。例如:http://example.com/page?param1=value1¶m2=value2

POST请求:数据放在请求体中,不会出现在URL里。例如:在表单提交时,数据以键值对形式发送。

使用场景:

GET请求:一般用于请求数据,且不会对服务器上的资源产生副作用(例如:查询操作)。

POST请求:一般用于提交数据,可能会对服务器上的资源产生副作用(例如:提交表单,上传文件)。

安全性:

GET请求:因为数据在URL中明文显示,不适合传输敏感数据。

POST请求:数据在请求体中,虽然更安全,但仍需使用HTTPS确保数据传输安全。

示例

GET请求的特征:

URL包含查询字符串。

请求头中的HTTP方法为GET。

常用于检索数据而不改变服务器状态。

示例代码:

GET /search?q=example HTTP/1.1

Host: www.example.com

浏览器访问http://www.example.com/search?q=example时会发出这样的请求。

POST请求的特征:

数据在请求体中。

请求头中的HTTP方法为POST。

常用于提交数据,导致服务器状态改变。

示例代码:

POST /submit-form HTTP/1.1

Host: www.example.com

Content-Type: application/x-www-form-urlencoded

Content-Length: 27

name=JohnDoe&age=25

在HTML表单提交时,使用POST方法,表单数据被编码并放在请求体中发送到服务器。GET请求主要用于数据检索,数据通过URL传递;POST请求主要用于提交数据,数据通过请求体传递。选择使用哪种请求方式取决于具体的应用场景和数据传输的需求。请求头查询get请求或者post请求如下图

数据挖掘的网页信息获取

这个程序的目的是通过发送HTTP请求,获取百度资讯页面的内容,并解析页面中的特定数据项(如文章标题、内容、来源等)。下面详细描述如何从网页源代码中获取数据,并展示代码中每个数据项在网页源代码中的位置。

数据项在源代码中的位置如下图:

1. 发送请求

程序使用urllib.request库发送HTTP GET请求到指定URL,并获取响应。具体步骤如下:

构建请求对象:首先,程序构建一个包含URL和头部信息的请求对象。头部信息通常包括User-Agent和Cookie,以模拟真实的浏览器请求,防止被服务器识别为机器人并拒绝访问。

request = urllib.request.Request(url + str(i * 10), headers=headers)

发送请求:通过urllib.request.urlopen函数发送请求,并接收服务器的响应。响应包括状态码和响应体内容。

response = urllib.request.urlopen(request)

检查响应状态:程序获取响应的状态码,以确保请求成功。状态码200表示成功。

status_code = response.getcode()

print(f"Response code for request {i}: {status_code}")

读取响应内容:程序将响应体读取为字符串形式,以便后续解析。

res = response.read().decode('utf-8')

2. 解析响应

程序使用BeautifulSoup库解析响应的HTML内容,并提取所需的数据项。具体步骤如下:

创建BeautifulSoup对象:通过将HTML字符串传递给BeautifulSoup构造函数,并指定解析器(如lxml),程序创建一个BeautifulSoup对象。

soup = BeautifulSoup(res, 'lxml')

查找目标内容:使用find_all方法查找所有包含新闻结果的div标签,这些标签具有特定的类名result-op c-container xpath-log new-pmd。find_all方法返回一个包含所有匹配元素的列表。

dw = soup.find_all('div', class_='result-op c-container xpath-log new-pmd')

对应的网页位置如下图:

3. 提取数据

程序从HTML中提取特定的div、a、span等标签中的内容。具体步骤如下:

遍历新闻结果:程序遍历包含新闻结果的div列表,逐个提取每个新闻项的详细信息。

for n in dw:

提取新闻链接:通过查找包含新闻标题的a标签,并获取其href属性值,提取新闻链接。

url0 = n.find('a', class_='news-title-font_1xS-F').get('href')

对应的网页位置如下图:

提取新闻标题:通过查找包含新闻标题的a标签,并获取其aria-label属性值,提取新闻标题。

title = n.find('a', class_='news-title-font_1xS-F').get('aria-label')

对应的网页位置如下图:

提取新闻内容:通过查找包含新闻内容的span标签,并获取其文本内容,提取新闻内容。

neirong = n.find('span', class_='c-font-normal c-color-text').text

对应的网页位置如下图:

提取新闻来源:通过查找包含新闻来源的span标签,并获取其文本内容,提取新闻来源。

laiyuan = n.find('span', class_='c-color-gray').text

对应的网页位置如下图:

打印结果:程序将提取到的新闻链接、标题、内容和来源打印输出。

print(url0, title, neirong, laiyuan)

总结

通过上述详细步骤,程序实现了从指定网页获取数据的全过程。首先,程序通过urllib.request库发送HTTP GET请求获取网页内容。然后,使用BeautifulSoup库解析响应的HTML内容,并通过查找特定的标签和类名提取目标数据项。最后,程序将提取到的数据打印输出。通过这种方式,程序能够有效地从网页源代码中抓取所需的资讯信息。

数据挖掘所用到Python模块的特点及功能

urllib.request — 为打开url提供的可扩展类库

urllib.request模块定义了方法和类,帮助打开url(主要是HTTP)在一个复杂的世界——基本和摘要式身份验证,重定向,cookies等等。

————-urllib.request模块定义了以下功能:—————–

urllib.request.urlopen()

urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None)

打开网址URL,这可以是一个字符串或一个 Request对象。

数据必须是一个字节对象指定额外的数据发送到服务器或 None。如果没有这样的数据是必要的,数据也可能是一个iterable对象而且在这种情况下必须在最开始时指定内容的长度。目前HTTP是唯一一个这样请求数据的,当数据参数被提供时,HTTP请求将会执行POST请求而不是GET请求。

数据应该是一个缓冲的在标准应用程序中以 x-www-form-urlencoded的格式。 urllib.parse.urlencode()函数接受一个映射或序列集合,并返回一个ASCII文本字符串的格式。它应该在被用作数据参数之前,被编码为字节。

urllib.request 模块 使用 HTTP/1.1协议,并且包括请求 Connection:close在HTTP请求头。

可选的第二个超时参数timeout,用于阻塞操作,比如连接请求(如果未指定,全球将使用默认超时设置)。这实际上只适用于HTTP、HTTPS和FTP连接。

如果context被指定,它必须是一个 ssl.SSLContext实例描述各种SSL选项。点击HTTPSConnection查看更多细节。

可选cafile和capath参数指定一组被HTTPS请求信任的CA证书。cafile应该指向一个文件包含CA证书的包,而capath应该指向一个散列的证书文件的目录。点击ssl.SSLContext.load_verify_locations()查看更多的信息。

cadefault参数被忽略。

这个函数始终返回一个对象,像context(上下文) 管理者并提供这些方法

geturl()——返回URL的资源检索,常常重定向之后使用

info()——返回页面的元信息,如标题,组成 email.message_from_string(的)实例

getcode()——返回响应的HTTP状态代码。

为HTTP和HTTPS url,这个函数返回的一个 http.client.HTTPResponse对象略有不同。除了上面的三种新方法中,这个message属性包含相同的信息像reason属性——由服务器返回的原因——而不是响应头,因为它在文档中指定 HTTPResponse。

FTP、文件和数据请求url和显式地处理 URLopener和 FancyURLopener类,这个函数返回一个 urllib.response.addinfourl对象。

urllib.request.urlopen()会在 URLError中抛出协议错误。

urllib.request.install_opener(opener)

安装一个 OpenerDirector实例作为全球默认的opener 。安装一个opener 必要的,如果你想让urlopen使用这个opener ;否则,简单地调用 OpenerDirector.open()而不是 urlopen()。这样代码不会检查一个真实的 OpenerDirector并且任何类的适当的接口都可以运作。

urllib.request.build_opener([handler, …])

返回一个顺序的链的处理程序 OpenerDirector的实例。处理程序可以是BaseHandler的实例,或者 BaseHandler的子类(在这种情况下,必须调用没有参数的构造函数)。下面这些类的实例将提前处理程序,除非处理程序包含它们,或者它们子类的实例:ProxyHandler(如果检测到代理设置), UnknownHandler, HTTPHandler, HTTPDefaultErrorHandler, HTTPRedirectHandler, FTPHandler, FileHandler, HTTPErrorProcessor.

如果Python安装SSL支持(即如果 ssl模块可以被导入), HTTPSHandler也将被添加。

一个 BaseHandler子类也可以通过改变它的 handler_order属性来修改它再处理程序列表中的位置。

urllib.request.pathname2url(path)

将路径名转换成路径,从本地语法形式的路径中使用一个URL的路径组成部分。这不会产生一个完整的URL。它将返回引用 quote()函数的值。

urllib.request.url2pathname(path)

将路径组件转换为本地路径的语法。这个不接受一个完整的URL。这个函数使用 unquote()解码的通路。

urllib.request.getproxies()

这个helper函数返回一个日程表dictionary 去代理服务器的URL映射。扫描指定的环境变量 _proxy大小写不敏感的方法,对所有的操作系统,当它不能找到它,从Mac OS X的Mac OSX系统配置和Windows系统注册表中寻找代理信息。如果两个大写和小写环境变量存在(或不一样),小写优先。总的来说,特点及功能:

HTTP请求:该模块提供了发送HTTP请求(如GET和POST)的功能。

处理响应:能够处理HTTP响应,包括获取响应状态码和读取响应内容。

Header管理:允许设置请求头部信息(如User-Agent和Cookie),以模拟浏览器行为。

在代码中的作用:

构建请求对象:通过urllib.request.Request构建包含URL和头部信息的请求对象。

发送请求:使用urllib.request.urlopen发送请求并接收服务器响应。

获取响应内容:读取响应体内容并进行解码,以便后续解析。

BeautifulSoup 模块

简单来说,BeautifulSoup 就是 Python 的一个 HTML 或 XML 的解析库,我们可以用它来方便地从网页中提取数据,官方的解释如下:

BeautifulSoup 提供一些简单的、python 式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。BeautifulSoup 自动将输入文档转换为 Unicode 编码,输出文档转换为 utf-8 编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时你仅仅需要说明一下原始编码方式就可以了。BeautifulSoup 已成为和 lxml、html6lib 一样出色的 python 解释器,为用户灵活地提供不同的解析策略或强劲的速度。

总的来说,利用它我们可以省去很多繁琐的提取工作,提高解析效率。特点及功能:

HTML解析:提供了强大的HTML和XML解析功能,可以处理不规则的HTML文档。

元素查找:支持通过标签名、类名、ID等方式查找元素。

导航树结构:通过导航文档树结构,可以方便地提取所需的数据。如下图:

在代码中的作用:

创建解析对象:通过BeautifulSoup构造函数创建解析对象。

查找元素:使用find_all方法查找特定类名的div标签,获取新闻结果。

提取数据:通过标签和类名提取新闻链接、标题、内容和来源。

Time模块

time 模块提供各种时间相关的功能

在 Python 中,与时间处理有关的模块包括:time,datetime 以及 calendar

必要说明:

虽然这个模块总是可用,但并非所有的功能都适用于各个平台。

该模块中定义的大部分函数是调用 C 平台上的同名函数实现,所以各个平台上实现可能略有不同。

一些术语和约定的解释:

时间戳(timestamp)的方式:通常来说,时间戳表示的是从 1970 年 1 月 1 日 00:00:00 开始按秒计算的偏移量(time.gmtime(0))此模块中的函数无法处理 1970 纪元年以前的日期和时间或太遥远的未来(处理极限取决于 C 函数库,对于 32 位系统来说,是 2038 年)

UTC(Coordinated Universal Time,世界协调时)也叫格林威治天文时间,是世界标准时间。在中国为 UTC+8

DST(Daylight Saving Time)即夏令时的意思

一些实时函数的计算精度可能低于它们建议的值或参数,例如在大部分 Unix 系统,时钟一秒钟“滴答”50~100 次。总的来说,特点及功能:

时间管理:提供了各种与时间相关的功能,如获取当前时间、暂停执行、时间格式化等。

在代码中的作用:

暂停执行:使用time.sleep在循环中暂停几秒,以避免频繁请求触发服务器的反爬虫机制。

Random模块

特点及功能:

随机数生成:提供生成随机数的功能,可以生成随机整数、浮点数、随机选择等。

在代码中的作用:

生成随机延迟时间:使用random.randint生成随机整数,以确定暂停执行的时间间隔。

数据挖掘程序的编写

完整代码如下:

import time

import random

import urllib.request

from bs4 import BeautifulSoup

# 定义爬取的网址和请求头

url='https://www.baidu.com/s?rtt=1&bsst=1&cl=2&tn=news&ie=utf-8&word=%E7%99%BE%E5%BA%A6%E8%B5%84%E8%AE%AF&x_bfe_rqs=03E80&x_bfe_tjscore=0.100000&tngroupname=organic_news&newVideo=12&goods_entry_switch=1&rsv_dl=news_b_pn&pn='

headers={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.169 Safari/537.36',

'Cookie':'BIDUPSID=CA010A6B85040D048E120E50A51814A1; PSTM=1702542106; BAIDUID=CA010A6B85040D04A1D9EF39307C5A78:FG=1; BD_UPN=12314753; BDUSS=1Ec35aUWJiYjZkWTBydDRLZ21NUlB1ci01dXJ6NX5kQW9yTThRRTMzQ1RXQ2RtRVFBQUFBJCQAAAAAABAAAAEAAACwlCn7AAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAJPL~2WTy~9lck; BDUSS_BFESS=1Ec35aUWJiYjZkWTBydDRLZ21NUlB1ci01dXJ6NX5kQW9yTThRRTMzQ1RXQ2RtRVFBQUFBJCQAAAAAABAAAAEAAACwlCn7AAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAJPL~2WTy~9lck; BDORZ=FFFB88E999055A3F8A630C64834BD6D0; H_WISE_SIDS_BFESS=40303_40080_60140_60175; H_WISE_SIDS=40303_60175_60270_60289; H_PS_PSSID=60175_60270_60289_60296; BA_HECTOR=2ka10lag0k2l8h2kak05a0akc6c5221j4bhb11v; BAIDUID_BFESS=CA010A6B85040D04A1D9EF39307C5A78:FG=1; COOKIE_SESSION=2175793_0_4_0_12_6_1_2_4_2_0_2_2175949_0_158_0_1715848702_0_1715848544%7C9%230_0_1715848544%7C1; baikeVisitId=16491678-4d53-42a6-8473-07967a7d14b6; B64_BOT=1; BDRCVFR[C0p6oIjvx-c]=mk3SLVN4HKm; delPer=0; BD_CK_SAM=1; PSINO=1; BDRCVFR[K6RW1DeE3Dm]=mk3SLVN4HKm; sugstore=1; H_PS_645EC=ebabAVGfQoSOZqxgpnv4ZZuoXP9fJRqM5LurBezXuyAO7aiEtOJHLP67gRg4NQhBGHje%2Bg; BDSVRTM=0',

}

# 循环发起请求,这里只执行一次

for i in range(0,1):

# 构建请求对象,添加请求头

request = urllib.request.Request(url+str(i*10),headers=headers)

# 发起请求并获取响应

response = urllib.request.urlopen(request)

# 获取HTTP响应状态码

status_code = response.getcode()

# 打印响应状态码

print(f"Response code for request {i}: {status_code}")

# 读取响应内容并解码

res=response.read().decode('utf-8')

# 打印响应内容

print(res)

# 解析HTML内容

soup=BeautifulSoup(res,'lxml')

# 查找所有符合条件的div标签

dw = soup.find_all('div', class_='result-op c-container xpath-log new-pmd')

# 遍历找到的div标签

for n in dw:

# 提取新闻链接

url0=n.find('a',class_='news-title-font_1xS-F').get('href')

# 提取新闻标题

title=n.find('a',class_='news-title-font_1xS-F').get('aria-label')

# 提取新闻内容摘要

neirong=n.find('span',class_='c-font-normal c-color-text').text

# 提取新闻来源

laiyuan=n.find('span',class_='c-color-gray').text

# 打印提取的信息

print(url0,title,neirong,laiyuan)

# 随机等待3到5秒,以避免被封禁

time.sleep(random.randint(3,5))

代码解释

导入模块

import time

import random

import urllib.request

from bs4 import BeautifulSoup

time: 用于时间相关操作,如暂停脚本执行。

random: 用于生成随机数,避免请求过于频繁。

urllib.request: 用于发起HTTP请求。

BeautifulSoup: 用于解析HTML内容。

定义爬取的网址和请求头

url='https://www.baidu.com/s?...'

headers={'User-Agent':'Mozilla/5.0...','Cookie':'BIDUPSID=...'}

url: 要爬取的百度新闻搜索结果页面的基本URL。

headers: HTTP请求头信息,包括User-Agent和Cookie,以模拟真实用户请求。

循环发起请求

for i in range(0,1):

仅执行一次请求,但可以扩展为多页请求。

构建请求对象并发起请求

request = urllib.request.Request(url+str(i*10),headers=headers)

response = urllib.request.urlopen(request)

status_code = response.getcode()

print(f"Response code for request {i}: {status_code}")

构建包含URL和请求头的请求对象。

发起请求并获取响应。

打印HTTP响应状态码以确认请求成功。

读取和解析响应内容

res=response.read().decode('utf-8')

print(res)

soup=BeautifulSoup(res,'lxml')

读取响应内容并解码为UTF-8字符串。

打印响应内容(可选)。

使用BeautifulSoup解析HTML内容。

查找并提取新闻信息

dw = soup.find_all('div', class_='result-op c-container xpath-log new-pmd')

for n in dw:

url0=n.find('a',class_='news-title-font_1xS-F').get('href')

title=n.find('a',class_='news-title-font_1xS-F').get('aria-label')

neirong=n.find('span',class_='c-font-normal c-color-text').text

laiyuan=n.find('span',class_='c-color-gray').text

print(url0,title,neirong,laiyuan)

查找所有包含新闻信息的div标签。

遍历找到的div标签,并提取其中的新闻链接、标题、内容摘要和来源。

打印提取的信息。

随机等待一段时间

time.sleep(random.randint(3,5))

随机等待3到5秒,以避免请求过于频繁导致被封禁。

最后程序运行得到如下结果:

总结

总结

在当今信息爆炸的时代,如何快速有效地获取并处理大量的在线信息已成为研究与应用中的一大挑战。通过此次研究,我们设计并实现了一个基于Python语言的网络爬虫,专门用于从百度新闻搜索结果中提取相关的新闻信息。以下是对整个过程及其成果的总结。

1. 研究目的

本次研究的主要目标是开发一个能够自动化获取百度新闻数据的爬虫程序。具体而言,爬虫应能抓取新闻的标题、链接、摘要和来源等信息。这将为后续的新闻数据分析提供基础,并且有助于进一步的舆情监控和热点话题挖掘。

2. 方法与实现

在实现过程中,我们使用了Python语言,并借助了多个强大的库来完成任务。首先,使用urllib.request模块构建HTTP请求,模拟浏览器访问百度新闻搜索页面。通过设置合适的请求头信息,包括User-Agent和Cookie,我们避免了被百度的反爬机制直接识别和屏蔽。

爬虫的具体实现步骤如下:

构建请求对象:通过循环构建请求对象,针对不同的页面发送请求。请求头包含了模拟的用户代理和必要的Cookie信息,以绕过基本的反爬虫机制。

发起请求并获取响应:利用urllib.request.urlopen方法发送请求并获取响应。通过检查HTTP状态码来确认请求是否成功。

解析响应内容:使用BeautifulSoup库解析返回的HTML文档。通过分析百度新闻页面的结构,定位到包含新闻信息的特定div标签。

提取并打印信息:从定位到的div标签中提取新闻的标题、链接、摘要和来源。提取后的信息通过控制台打印出来,以便验证爬虫的有效性。

添加随机等待时间:在每次请求之间加入随机的等待时间(3到5秒),以模拟正常用户的浏览行为,进一步降低被反爬机制封禁的风险。

3. 成果与验证

通过本次研究,我们成功地实现了一个能够稳定运行的百度新闻爬虫。爬虫程序能够准确地从百度新闻搜索结果中提取出所需的新闻信息,并在控制台输出这些信息。通过多次测试,爬虫展示了良好的鲁棒性和有效性,能够处理不同页面结构的新闻内容。

4. 意义与应用

本次研究的成果不仅在技术上展示了如何构建一个有效的网络爬虫,更在实际应用中提供了获取大规模新闻数据的解决方案。通过进一步的扩展和优化,这一爬虫可以应用于实时新闻监控、舆情分析、市场调研等多个领域。研究人员和数据分析师可以利用这些爬取到的数据,进行深入的文本分析和数据挖掘,洞察社会关注热点和趋势。

5. 未来工作

尽管当前的爬虫程序已经实现了预期的功能,但仍有改进空间。未来的工作可以包括:

提升爬虫效率:通过并发处理提高爬虫的速度和效率。

增强反反爬机制:进一步研究并实现更多的反反爬策略,以应对更加复杂的反爬虫措施。

数据存储与管理:将提取的数据存储到数据库中,方便后续的数据分析和处理。

通过本次研究,我们不仅实现了从百度新闻中自动提取数据的技术方案,还为后续的新闻分析和应用提供了坚实的基础。希望这一研究能为更多的学术研究和实际应用带来启发。

相关文章:

基于python的百度资讯爬虫的设计与实现

研究背景 随着互联网和信息技术的飞速发展,网络已经成为人们获取信息的主要来源之一。特别是搜索引擎,作为信息检索的核心工具,极大地改变了人们获取信息的方式。其中,百度作为中国最受欢迎的搜索引擎之一,其新闻搜索…...

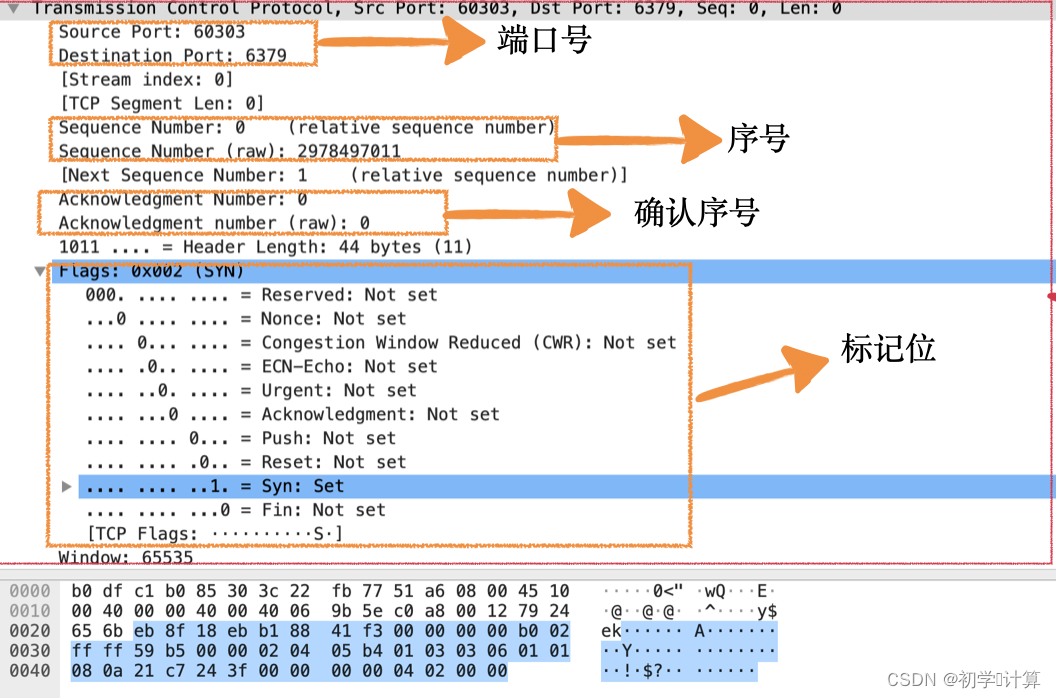

用 WireShark 抓住 TCP

Wireshark 是帮助我们分析网络请求的利器,建议每个同学都装一个。我们先用 Wireshark 抓取一个完整的连接建立、发送数据、断开连接的过程。 简单的介绍一下操作流程。 1、首先打开 Wireshark,在欢迎界面会列出当前机器上的所有网口、虚机网口等可以抓取…...

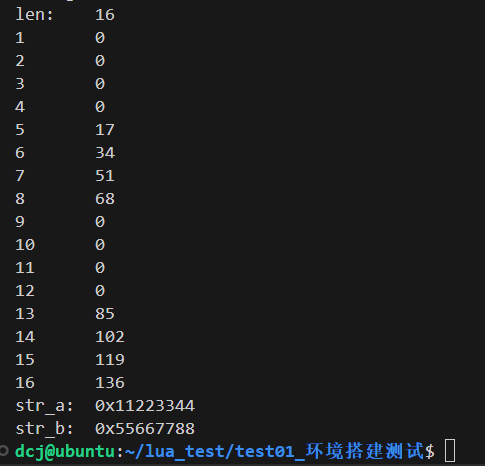

Lua基础知识入门

1 基础知识 标识符:标识符的定义和 C语言相同:字母和下划线_ 开头, 下划线_ 大写字母一般是lua保留字, 如_VERSION 全局变量:默认情况下,变量总是认为是全局的,不需要申明,给一个变…...

【机器学习实战】Datawhale夏令营2:深度学习回顾

#DataWhale夏令营 #ai夏令营 文章目录 1. 深度学习的定义1.1 深度学习&图神经网络1.2 机器学习和深度学习的关系 2. 深度学习的训练流程2.1 数学基础2.1.1 梯度下降法基本原理数学表达步骤学习率 α梯度下降的变体 2.1.2 神经网络与矩阵网络结构表示前向传播激活函数…...

开发扫地机器人系统时无法兼容手机解决方案

在开发扫地机器人系统时,遇到无法兼容手机的问题,可以从以下几个方面寻求解决方案: 一、了解兼容性问题根源 ① 操作系统差异:不同手机可能运行不同的操作系统(如iOS、Android),且即使是同一操…...

Elasticsearch 角色和权限管理

在大数据和云计算日益普及的今天,Elasticsearch 作为一款强大的开源搜索引擎和数据分析引擎,被广泛应用于日志分析、全文搜索、实时监控等领域。随着业务规模的扩大和数据敏感性的增加,对 Elasticsearch 的访问控制和权限管理也变得越来越重要…...

华为HCIP Datacom H12-821 卷42

42.填空题 如图所示,MSTP网络中SW1为总根,请将以下交换机与IST域根和主桥配对。 参考答案:主桥1468 既是IST域根又是主桥468 既不是又不是就是25 解析: 主桥1468 既是IST域根又是主桥468 既不是又不是就是25 43.填空题 网络有…...

【精品资料】物业行业BI大数据解决方案(43页PPT)

引言:物业行业BI(Business Intelligence,商业智能)大数据解决方案是专为物业管理公司设计的一套综合性数据分析与决策支持系统。该解决方案旨在通过集成、处理、分析及可视化海量数据,帮助物业企业提升运营效率、优化资…...

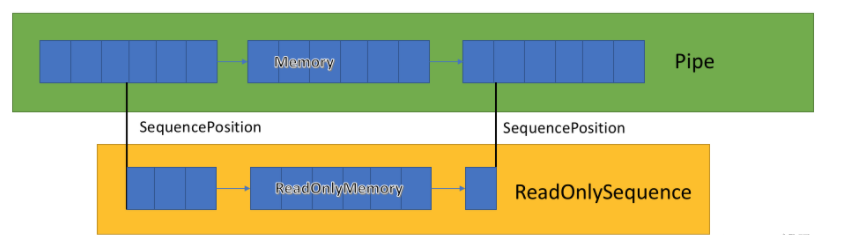

推荐一款处理TCP数据的架构--EasyTcp4Net

EasyTcp4Net是一个基于c# Pipe,ReadonlySequence的高性能Tcp通信库,旨在提供稳定,高效,可靠的tcp通讯服务。 基础的消息通讯 重试机制 超时机制 SSL加密通信支持 KeepAlive 流量背压控制 粘包和断包处理 (支持固定头处理,固定长度处理,固定字符处理) 日志支持Pipe &…...

2、电脑各部件品牌介绍 - 计算机硬件品牌系列文章

笔者是一个电脑IT达人,对于电脑硬件挺感兴趣,今天有必要讲讲关于电脑各部件的品牌问题。关于电脑硬件介绍,见博文版块:计算机硬件系列 。下面对电脑的各部件品牌等进行介绍,便于大家选购电脑的时候做参考。 1、 CPU&am…...

Git【撤销远程提交记录】

在实际开发中,你是否遇到过错误的提交了代码,想要删掉本次提交记录的情况,你可以按照如下方法实现。 1、使用 git revert 如果你想要保留历史记录,并且对远程仓库其他使用者的影响最小,你可以使用 git revert 命令。这…...

java基础学习:序列化之 - Fast serialization

在Java中,序列化是将对象的状态转换为字节流的过程,以便保存到文件、数据库或通过网络传输。Java标准库提供了java.io.Serializable接口和相应的机制来进行序列化和反序列化。然而,标准的Java序列化机制性能较低,并且生成的字节流…...

Microsoft Build 2024 推出 .NET 9:Tensor<T>、 OpenAI Collaboration和.NET Aspire

在 Microsoft Build 2024 上,.NET 9 4 发布,引入了用于深度学习的 Tensor 类型以及与 OpenAI Collaboration实现GPT4o和Assistants v2等功能。这些最新改进还带来了 .NET Aspire,简化了云原生应用开发。更新涵盖 ASP.NET Core、Blazor 和 .NE…...

【Neural signal processing and analysis zero to hero】- 2

Nonstationarities and effects of the FT course from youtube: 传送地址 why we need extinguish stationary and non-stationary signal, because most of neural signal is non-stationary. Welch’s method for smooth spectral decomposition Full FFT method y…...

好用的AI搜索引擎

1. 360AI 搜索 访问 360AI 搜索: https://www.huntagi.com/sites/1706642948656.html 360AI 搜索介绍: 360AI 搜索,新一代智能答案引擎,值得信赖的智能搜索伙伴,为复杂搜索提供专业支持,解锁更相关、更全面的答案。AI…...

十、Java集合 ★ ✔(模块18-20)【泛型、通配符、List、Set、TreeSet、自然排序和比较器排序、Collections、可变参数、Map】

day05 泛型,数据结构,List,Set 今日目标 泛型使用 数据结构 List Set 1 泛型 1.1 泛型的介绍 ★ 泛型是一种类型参数,专门用来保存类型用的 最早接触泛型是在ArrayList,这个E就是所谓的泛型了。使用ArrayList时,只要给E指定某一个类型…...

阿里云开源 Qwen2-Audio 音频聊天和预训练大型音频语言模型

Qwen2-Audio由阿里巴巴集团Qwen团队开发,它能够接受各种音频信号输入,对语音指令进行音频分析或直接文本回复。与以往复杂的层次标签不同,Qwen2-Audio通过使用自然语言提示简化了预训练过程,并扩大了数据量。 喜好儿网 Qwen2-Au…...

SpringBoot集成MQTT实现交互服务通信

引言 本文是springboot集成mqtt的一个实战案例。 gitee代码库地址:源码地址 一、什么是MQTT MQTT(Message Queuing Telemetry Transport,消息队列遥测传输协议),是一种基于发布/订阅(publish/subscribe&…...

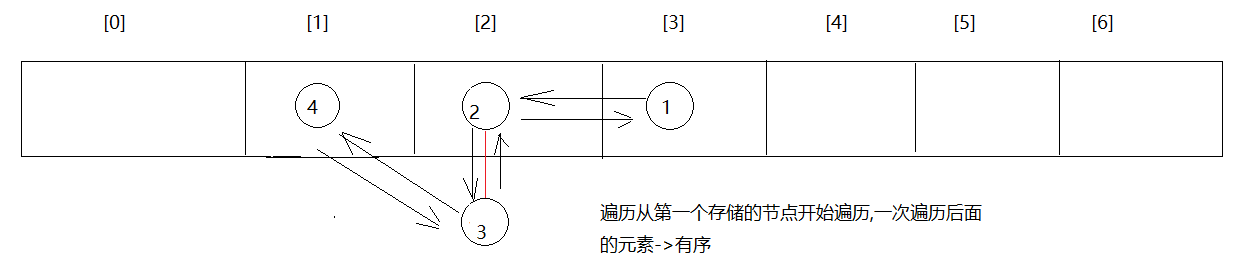

python实现插入排序、快速排序

python实现插入排序、快速排序 算法步骤: Python实现插入排序快速排序算法步骤: Python实现快速排序算法时间复杂度 插入排序是一种简单直观的排序算法。它的基本思想是通过构建有序序列,对于未排序数据,在已排序序列中从后向前扫…...

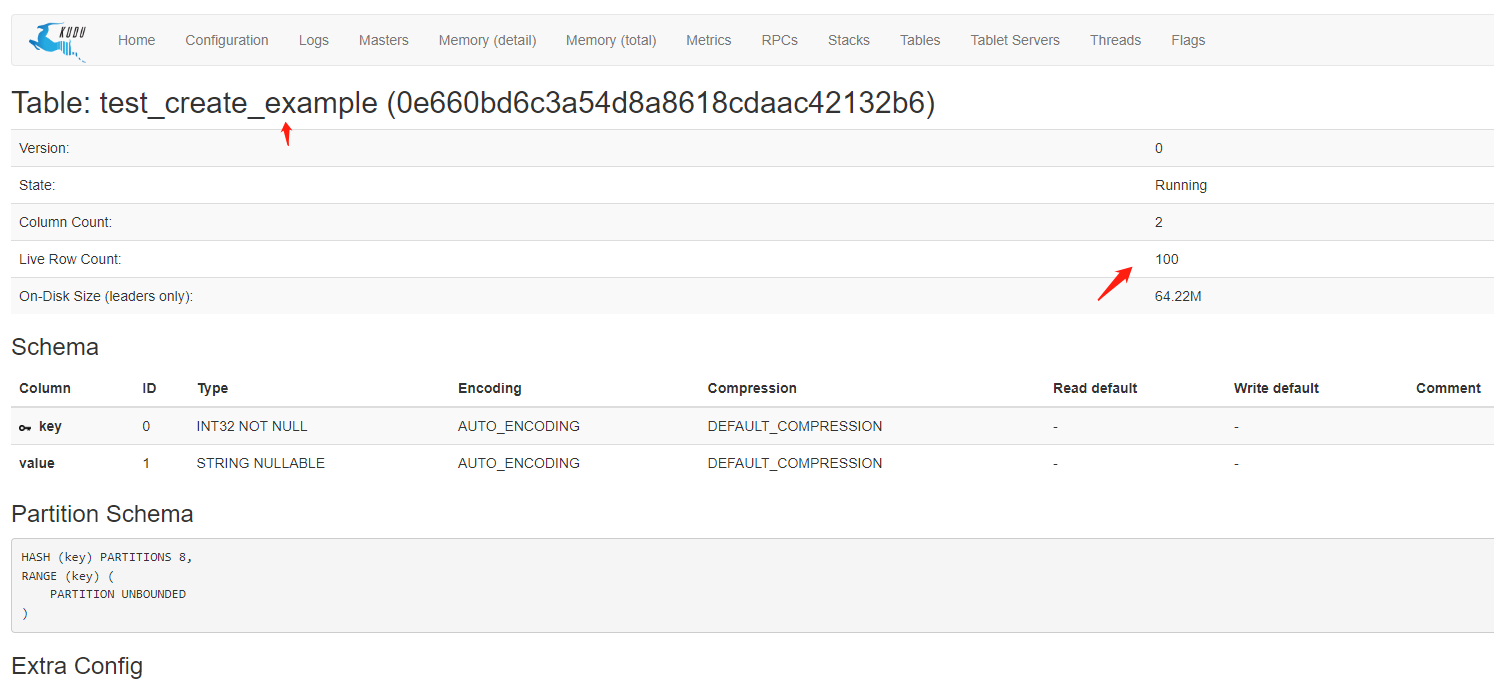

Spring Boot集成kudu快速入门Demo

1.什么是kudu 在Kudu出现前,由于传统存储系统的局限性,对于数据的快速输入和分析还没有一个完美的解决方案,要么以缓慢的数据输入为代价实现快速分析,要么以缓慢的分析为代价实现数据快速输入。随着快速输入和分析场景越来越多&a…...

深入剖析AI大模型:大模型时代的 Prompt 工程全解析

今天聊的内容,我认为是AI开发里面非常重要的内容。它在AI开发里无处不在,当你对 AI 助手说 "用李白的风格写一首关于人工智能的诗",或者让翻译模型 "将这段合同翻译成商务日语" 时,输入的这句话就是 Prompt。…...

23-Oracle 23 ai 区块链表(Blockchain Table)

小伙伴有没有在金融强合规的领域中遇见,必须要保持数据不可变,管理员都无法修改和留痕的要求。比如医疗的电子病历中,影像检查检验结果不可篡改行的,药品追溯过程中数据只可插入无法删除的特性需求;登录日志、修改日志…...

JVM垃圾回收机制全解析

Java虚拟机(JVM)中的垃圾收集器(Garbage Collector,简称GC)是用于自动管理内存的机制。它负责识别和清除不再被程序使用的对象,从而释放内存空间,避免内存泄漏和内存溢出等问题。垃圾收集器在Ja…...

如何为服务器生成TLS证书

TLS(Transport Layer Security)证书是确保网络通信安全的重要手段,它通过加密技术保护传输的数据不被窃听和篡改。在服务器上配置TLS证书,可以使用户通过HTTPS协议安全地访问您的网站。本文将详细介绍如何在服务器上生成一个TLS证…...

浅谈不同二分算法的查找情况

二分算法原理比较简单,但是实际的算法模板却有很多,这一切都源于二分查找问题中的复杂情况和二分算法的边界处理,以下是博主对一些二分算法查找的情况分析。 需要说明的是,以下二分算法都是基于有序序列为升序有序的情况…...

第 86 场周赛:矩阵中的幻方、钥匙和房间、将数组拆分成斐波那契序列、猜猜这个单词

Q1、[中等] 矩阵中的幻方 1、题目描述 3 x 3 的幻方是一个填充有 从 1 到 9 的不同数字的 3 x 3 矩阵,其中每行,每列以及两条对角线上的各数之和都相等。 给定一个由整数组成的row x col 的 grid,其中有多少个 3 3 的 “幻方” 子矩阵&am…...

网络编程(UDP编程)

思维导图 UDP基础编程(单播) 1.流程图 服务器:短信的接收方 创建套接字 (socket)-----------------------------------------》有手机指定网络信息-----------------------------------------------》有号码绑定套接字 (bind)--------------…...

OPENCV形态学基础之二腐蚀

一.腐蚀的原理 (图1) 数学表达式:dst(x,y) erode(src(x,y)) min(x,y)src(xx,yy) 腐蚀也是图像形态学的基本功能之一,腐蚀跟膨胀属于反向操作,膨胀是把图像图像变大,而腐蚀就是把图像变小。腐蚀后的图像变小变暗淡。 腐蚀…...

)

Android第十三次面试总结(四大 组件基础)

Activity生命周期和四大启动模式详解 一、Activity 生命周期 Activity 的生命周期由一系列回调方法组成,用于管理其创建、可见性、焦点和销毁过程。以下是核心方法及其调用时机: onCreate() 调用时机:Activity 首次创建时调用。…...

html css js网页制作成品——HTML+CSS榴莲商城网页设计(4页)附源码

目录 一、👨🎓网站题目 二、✍️网站描述 三、📚网站介绍 四、🌐网站效果 五、🪓 代码实现 🧱HTML 六、🥇 如何让学习不再盲目 七、🎁更多干货 一、👨…...