稀疏注意力:时间序列预测的局部性和Transformer的存储瓶颈

时间序列预测是许多领域的重要问题,包括对太阳能发电厂发电量、电力消耗和交通拥堵情况的预测。在本文中,提出用Transformer来解决这类预测问题。虽然在我们的初步研究中对其性能印象深刻,但发现了它的两个主要缺点:(1)位置不可知性:规范Transformer架构中的点积自关注对局部上下文不敏感,这可能使模型在时间序列中容易出现异常;(2)内存瓶颈:正则Transformer的空间复杂度随序列长度L呈二次增长,使得直接建模长时间序列变得不可行。

为了解决这两个问题,首先提出了卷积自注意力,通过使用因果卷积产生查询和键,以便更好地将本地上下文纳入注意机制。然后,提出了仅内存开销的LogSparse Transformer,在内存预算受限的情况下,提高了对细粒度、长期依赖性强的时间序列的预测精度。在合成数据和真实世界数据集上的实验表明,它比最先进的技术更有优势。

1. 引言

深度神经网络被提出作为另一种解决方案,其中递归神经网络(RNN)已被用于以自回归的方式对时间序列建模。然而,众所周知,RNN很难训练。由于梯度消失和爆炸问题。尽管出现了各种变体,包括LSTM和GRU(门控循环单元),问题仍然没有解决。如何对长期依赖关系进行建模成为实现良好性能的关键步骤。

规范Transformer的空间复杂度随输入长度L呈二次增长,这对直接建模细粒度长时间序列造成了内存瓶颈。 主要贡献:①成功地将Transformer架构应用于时间序列预测,并在合成数据集和真实数据集上进行了广泛的实验,以验证Transformer在处理长期依赖关系方面比基于RNN的模型更好的潜在价值。

②提出卷积自注意,通过使用因果卷积在自注意层产生查询和键。感知局部上下文(如形状)的查询键匹配可以帮助模型降低训练损失,进一步提高预测精度。

③提出LogSparse Transformer,只有空间复杂度来打破内存瓶颈,不仅使细粒度的长时间序列建模可行,而且与规范Transformer相比,使用更少的内存可以产生相当甚至更好的结果。

2. 相关工作

时间序列预测领域中不同方法的发展和挑战,并强调了几种主要的模型。首先,文章提到ARIMA模型,这是时间序列预测中非常著名的一种方法。ARIMA模型因其统计性质和Box-Jenkins方法论而备受推崇,后者是一种在模型选择过程中广泛使用的方法。因此,ARIMA模型通常是实践者在时间序列预测中首先尝试的工具。然而,ARIMA模型有一些局限性。它假设时间序列是线性的,这在处理更复杂的、非线性的时间序列时可能表现不佳。此外,ARIMA模型的扩展性有限,难以应用于大规模的预测任务,并且每个时间序列都必须独立拟合,这意味着无法在相似的时间序列之间共享信息。

相反,有些方法尝试通过矩阵分解的方法处理相关时间序列数据,把预测问题看作矩阵分解问题。另外,还有研究提出了分层贝叶斯方法,从图模型的角度来学习多个相关的计数时间序列。接着,文章介绍了深度神经网络在时间序列预测中的应用。这些模型可以捕捉相关时间序列之间的共享信息,从而提高预测的准确性。比如,有研究将传统的自回归(AR)模型与递归神经网络(RNN)结合起来,采用编码器-解码器的方式对概率分布进行建模。另一种方法使用RNN作为编码器,使用多层感知机(MLP)作为解码器,以解决误差累积问题,并且能够进行多步并行预测。此外,还有模型使用全局RNN来直接输出线性状态空间模型(SSM)的参数,目的是用局部线性片段来近似非线性动态。也有研究通过使用局部高斯过程来处理每个时间序列中的噪声,同时使用全局RNN来建模共享模式。另一些方法则试图结合AR模型和SSM的优势,保持复杂的潜在过程以进行多步并行预测。

Transformer在序列建模中取得了很大成功,并且已被广泛应用于翻译、语音、音乐和图像生成等领域。然而,当处理极长的序列时,注意力机制的计算复杂度会随着序列长度的增加而呈二次方增长,这在处理高粒度且具有强长期依赖性的时间序列时,成为了一个严重的问题。

3. 背景

3.1 问题定义

首先定义了一个时间序列预测的问题。在这个问题中,我们有一个包含N个相关单变量时间序列的集合,每个时间序列记为 ,表示从时间1到时间

的观测值。目标是预测这些时间序列未来的

个时间步的值,即

。此外,假设有一个与时间相关的协变量集合

,其维度为d,这些协变量可能包括诸如星期几、一天中的小时等已知信息。我们需要建模条件分布

,其中

是所有时间序列共享的可学习参数。

接着,问题被简化为学习一个一步预测模型,即 ,其中

表示模型的可学习参数。为了充分利用观测值和协变量,作者将它们连接起来,形成一个扩展矩阵

,然后通过

表示所有的观测数据和协变量的集合。接下来,研究探索了一个合适的模型

,用于预测给定

时

的分布。

然后,文章介绍了Transformer模型,并提出将其作为函数 f 的实例,因为Transformer通过多头自注意力机制能够捕捉到时间序列中的长短期依赖性。不同的注意力头可以专注于不同的时间模式,这使得Transformer在时间序列预测中成为一个很有潜力的候选模型。

在自注意力层中,多头自注意力子层同时将 Y 转换为H个不同的查询矩阵 、键矩阵

和值矩阵

,其中

。这些矩阵通过线性投影获得,它们的学习参数分别为

、

和

。在这些线性投影之后,缩放点积注意力机制计算出一系列的向量输出

,这些输出是通过公式

计算得到的。这里,掩码矩阵 MMM 被应用于过滤右侧的注意力,以避免未来信息泄露。然后,所有的

被连接起来并再次进行线性投影。最后,在注意力输出上叠加了一个由两层全连接网络和中间ReLU激活层组成的位置前馈子层。

4. 方法论

4.1 增强Transformer的局部性

时间序列中的模式可能由于各种事件(如假期和极端天气)随时间发生显著变化的现象。因此,判断一个观测点是异常点、变更点还是模式的一部分,很大程度上依赖于其周围的上下文。然而,在经典Transformer的自注意力层中,查询和键之间的相似性是基于它们逐点值来计算的,未能充分利用局部上下文信息(如形状)。这种对局部上下文不敏感的查询-键匹配可能会导致自注意力模块混淆观测值的性质,从而引发潜在的优化问题。

为了解决这个问题,提出了卷积自注意力机制。图1(c)和(d)展示了这种卷积自注意力的架构。不同于使用核大小为1且步幅为1的卷积(即矩阵乘法),采用核大小为k且步幅为1的因果卷积,将输入(经过适当的填充)转换为查询和键。因果卷积确保当前位置不会访问未来信息。通过使用因果卷积,生成的查询和键能够更加感知局部上下文,从而基于局部上下文信息(如局部形状)来计算相似性,而不是简单的逐点取值,这有助于提高预测的准确性。值得注意的是,当k=1时,卷积自注意力将退化为经典自注意力,因此它可以看作经典自注意力的一种广义形式。

因果卷积:具体来说,假设输入序列的长度为 T,卷积核的大小为 k。在因果卷积中,输入会在前面添加 k-1个零填充,这样卷积运算就只会考虑当前和之前的时间步,而不会涉及未来的时间步。这种方式保证了模型在训练和推理时遵循时间顺序,从而保持因果性。

图1展示了经典自注意力层和卷积自注意力层的比较。图1(a)显示了经典自注意力可能错误地逐点匹配输入的情况,图1(b)则展示了经典自注意力在Transformer中的应用。而图1(c)和(d)则展示了卷积自注意力如何通过形状匹配来正确匹配最相关的特征。

4.2 突破Transformer的内存瓶颈

首先对经典Transformer在traffic-f数据集上学习到的注意力模式进行了定性评估。traffic-f数据集包含旧金山湾区963条车道的占用率数据,每20分钟记录一次。在traffic-f数据集上训练了一个10层的经典Transformer,并对学习到的注意力模式进行了可视化。引入某种形式的稀疏性而不会显著影响性能。更重要的是,对于长度为 L 的序列,计算每对单元之间的注意力分数会导致 的内存使用量,使得对具有精细粒度和强长期依赖的长时间序列进行建模变得非常困难。

为了解决这个问题,提出了LogSparse Transformer,这种方法只需要计算每个单元在每层中的 个点积。此外,只需要堆叠最多

层,模型就能够访问每个单元的信息。因此,总的内存使用成本仅为

。我们将

定义为在第 k 层到第 k+1 层计算过程中,单元

表示可以访问的单元索引集。在标准的Transformer自注意力中,

,这意味着每个单元都可以访问其所有过去的单元及其自身,如图3(a)所示。

然而,这种算法在输入长度增加时会导致空间复杂度的二次增长。为了解决这个问题,提出选择 的一个子集

,使得

不会随着

的增加而增长得太快。选择索引的一个有效方法是

。

需要注意的是,单元 是在第 k 层中通过加权组合索引为

的单元生成的,并且可以将这些信息传递给下一层的后续单元。令

为包含所有到第 k 层为止传递给单元

的单元索引的集合。为了确保每个单元接收到所有之前的单元及其自身的信息,堆叠的层数

应满足

,即对于每个

和

,存在一个具有

条边的路径

,其中

。

通过允许每个单元仅以指数步长访问其之前的单元及其自身来提出LogSparse自注意力。即对于所有的 k 和 ,

,其中

表示向下取整运算,如图3(b)所示。

定理1表明,尽管每层的内存使用量从 减少到

,但信息仍然可以从任意单元流向另一个单元,只需稍微“加深”模型——将层数设为

。这意味着总体内存使用量为

,解决了Transformer在GPU内存限制下的扩展性瓶颈。此外,随着两个单元之间的距离增大,路径的数量会以

的超指数速率增加,这表明LogSparse Transformer在建模精细的长期依赖关系时能够实现丰富的信息流动。

4.3 Logparase注意力

LogSparse注意力是一种针对长序列时间复杂度和内存使用量进行优化的自注意力机制。它是对经典Transformer模型中自注意力机制的一种改进,旨在解决处理长序列时计算资源消耗过大的问题。

在传统的Transformer中,自注意力机制的计算复杂度是二次方的,即对于长度为 L 的序列,每个元素需要与其他 L-1个元素进行相互计算,导致整个序列的计算量和内存使用量为 。这种复杂度在处理长序列时会变得非常昂贵,尤其是在需要处理大量数据的情况下。

LogSparse注意力 通过以下方式优化了这一过程:

-

选择性注意力(Selective Attention):LogSparse注意力并不计算每个序列元素与所有其他元素之间的注意力得分,而是引入了一种稀疏化策略。具体来说,它允许每个元素只关注一小部分与其相关的元素,而不是所有元素。这些相关元素的选择是基于指数步长的,即每个元素只与其之前的少量元素进行注意力计算,这些元素之间的距离按对数规律增长。这意味着,如果当前元素是第

个,那么它只会与之前的一些元素进行计算,而这些元素的索引为

等。

-

对数级别的复杂度(Logarithmic Complexity):这种选择性注意力策略将原本的

复杂度降低到了

。因为每个元素只需计算

个注意力分数,而整个序列需要堆叠

层,以确保所有元素都能互相通信。

通过这种方法,LogSparse注意力在处理长序列时能够显著减少内存使用和计算时间,同时保留Transformer模型的强大建模能力,特别是对于长时间依赖关系的建模非常有效。

4.3.1 增强模型性能

如何在LogSparse自注意力机制的基础上进一步增强模型的性能,同时保持计算复杂度的控制?

-

局部注意力(Local Attention):在LogSparse Transformer中,虽然每个单元只需要访问先前的一些关键单元,但为了更好地捕捉局部信息(如趋势),可以让每个单元密集地关注其左侧邻近的单元,窗口大小为

。这样,每个单元可以利用更多的局部信息来进行当前步的预测。在这种局部窗口之外,仍然可以继续采用LogSparse注意力策略,如图3(c)所示。

-

重启注意力(Restart Attention):这个策略是将整个输入序列(长度为 L)分成多个子序列,每个子序列的长度为

,其中

。对每个子序列分别应用LogSparse注意力策略,类似于重新开始注意力计算的过程。这样可以减少模型处理每个子序列时的复杂性,并且每个子序列可以独立地进行信息处理,如图3(d)所示。

-

结合局部注意力和重启注意力:使用局部注意力和重启注意力不会改变LogSparse自注意力策略的计算复杂度,但会增加更多的信息路径,并减少路径中所需的边数。这意味着可以在不增加计算成本的情况下,提高模型对局部信息的捕捉能力和对长序列的处理能力。通过结合局部注意力和重启注意力,模型能够更有效地捕捉序列中的各种模式和趋势。

相关文章:

稀疏注意力:时间序列预测的局部性和Transformer的存储瓶颈

时间序列预测是许多领域的重要问题,包括对太阳能发电厂发电量、电力消耗和交通拥堵情况的预测。在本文中,提出用Transformer来解决这类预测问题。虽然在我们的初步研究中对其性能印象深刻,但发现了它的两个主要缺点:(1)位置不可知性:规范Tran…...

详谈系统中的环境变量

目录 前言1. 指令背后的本质2. 环境变量背后的本质3. 环境变量到底是什么4. 命令行参数5. 本地变量 与 内置命令6. 环境变量的相关命令 前言 相信在 it 行业学习或者工作的小伙伴们,基本都配置过环境变量(windows环境下),如果你也…...

RAG与LLM原理及实践(11)--- Milvus hybrid search 源码分析及思想

目录 背景 hybrid search 源码分析 WeightedRanker 源码 hybrid search 核心 参数详解 基本入参 扩展入参 aysnc方式代码调用案例 说明 源码逻辑 prepare 调用过程 stub 调用结果 stub 调用过程 blocking 与 async 调用方式 深入内部core weightedRanker 的ch…...

JavaScript模拟空调效果

JavaScript模拟空调效果https://www.bootstrapmb.com/item/15074 在JavaScript中模拟空调效果主要依赖于前端界面的交互和状态变化,因为实际的温度调节、风扇速度调整等硬件操作无法直接通过JavaScript在浏览器中实现。不过,我们可以通过JavaScript来模…...

14.2 Pandas数据处理

欢迎来到我的博客,很高兴能够在这里和您见面!欢迎订阅相关专栏: 工💗重💗hao💗:野老杂谈 ⭐️ 全网最全IT互联网公司面试宝典:收集整理全网各大IT互联网公司技术、项目、HR面试真题. ⭐️ AIGC时代的创新与未来:详细讲解AIGC的概念、核心技术、应用领域等内容。 ⭐…...

python学习7---多进程

一、介绍 多进程是指在同一程序中创建多个独立的进程来执行任务。每个进程都有自己独立的内存空间,相互之间不干扰。 因为GIL锁的存在,对于CPU密集型任务(例如计算密集型操作),使用多进程可以提高程序的效率。 优点&am…...

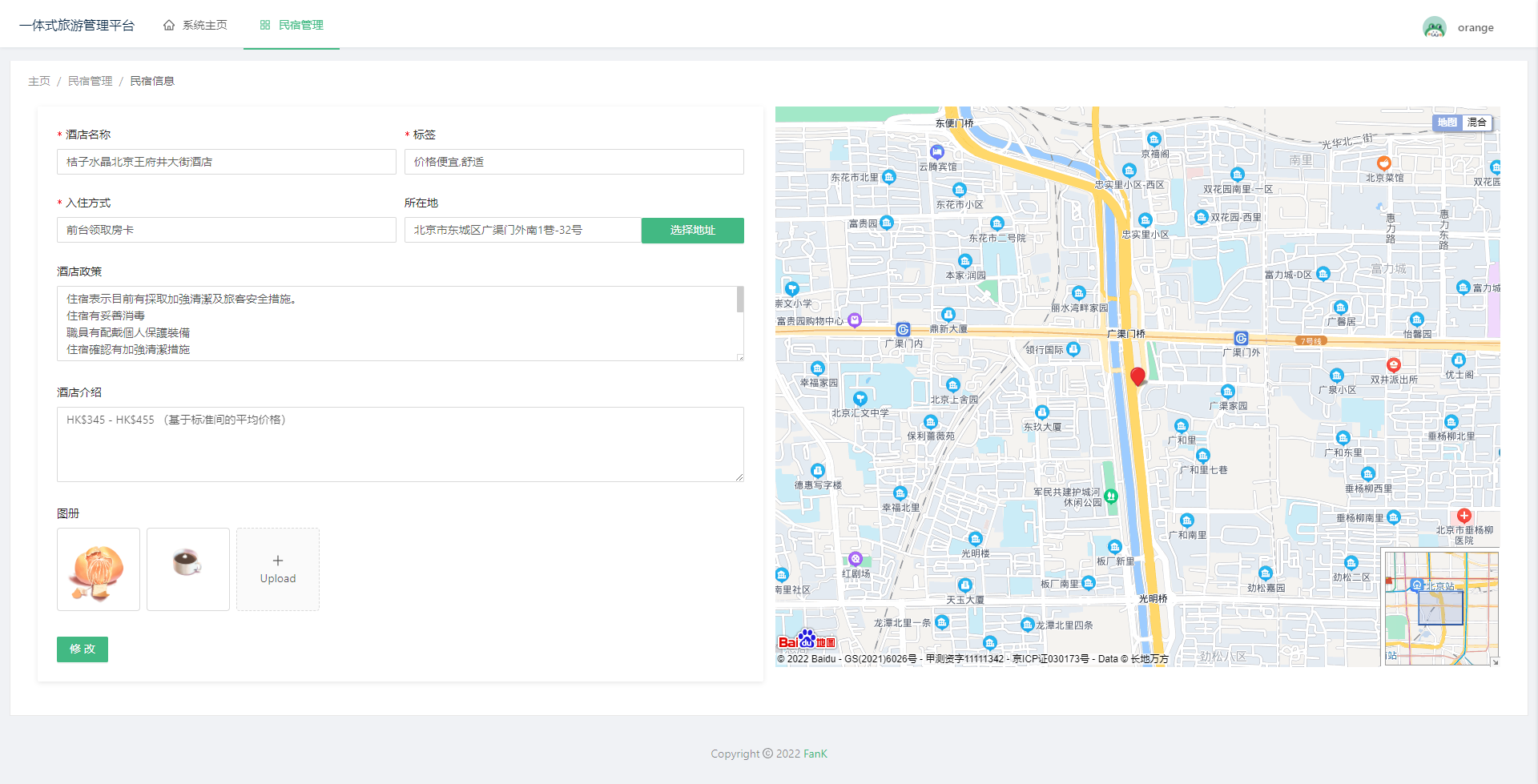

基于Spring + Vue的旅游景区项目+源代码+文档说明

文章目录 源代码下载地址项目介绍项目功能界面预览 项目备注源代码下载地址 源代码下载地址 点击这里下载源码 项目介绍 基于Spring Vue的旅游景区项目 项目功能 民宿管理员:订单数量统计,订单交易额统计,客房统计饼图,酒店…...

Java后端面试题

Redis缓存穿透、雪崩、击穿,布隆过滤器 一致性hash 一致性hash sharding-jdbc实现一致性hash #一致性hash, 应用在mysql数据库的分库分表上, 现在已经完成了分库分表, 现在的问题出现了, 需要继续新增数据库节点, 请…...

【Git】远程仓库新建分支后,拉到本地开发

1. 在远程仓库上创建分支 2. git fetch origin:在本地同步远程仓库的分支(获取远程仓库所有分支的所有修改) 3. git remote -a:查看所有分支(远程+本地) 4. git checkout -b 本地名 远程仓库…...

React H5设置企业级v6版本路由的配置

路由配置是项目开发的必要一环,尤其是目前流行SPA,下面看看如何使用v6版本路由进行合理的H5路由配置 一、基本页面结构(目录根据开发要求建,下面仅用于展示配置路由) 二、具体文件实现 1. index.tsx import React f…...

【微信小程序】全局配置

1. 全局配置文件及常用的配置项 2.window (1).小程序窗口的组成部分 (2). 了解 window 节点常用的配置项 (3). 设置导航栏的标题 (4). 设置导航栏的背景色 (5). 设置导航栏的标题颜色 (6). 全局开启下拉刷新功能 (7). 设置下拉刷新时窗口的背景色 (8).设置下拉刷新时 loading …...

25届秋招网络安全面试资料库

吉祥知识星球http://mp.weixin.qq.com/s?__bizMzkwNjY1Mzc0Nw&mid2247485367&idx1&sn837891059c360ad60db7e9ac980a3321&chksmc0e47eebf793f7fdb8fcd7eed8ce29160cf79ba303b59858ba3a6660c6dac536774afb2a6330#rd 《网安面试指南》http://mp.weixin.qq.com/s?…...

Adobe Dimension DN v4.0.2 解锁版下载安装教程 (专业的三维3D建模工具)

前言 Adobe Dimension(简称DN)是一款3D设计软件,三维合成和渲染工具,2D平面的二维转为3D立体的三维合成工具,用于3Dmax\C4D\MAYA等三维软件生成的效果图,在3D场景中排列对象、图形和光照。3D应用程序使用的…...

Python中*args 和 **kwargs作参数时有什么区别

*args 和 **kwargs 是 Python 函数定义中用于处理可变数量的参数的语法,初学者对于二者总是傻傻区分不了,今天我们就来详细解读一下这两个在参数传递时有什么不同。 首先要明白单个星号可以解包元组或者列表,两个星号可以解包字典。如&#…...

[CSS3]2D与3D变换技术详解

文章目录 2D变换(2D Transform)3D变换(3D Transform)结语 CSS3中的2D变换与3D变换是指通过transform属性对HTML元素进行几何操作,使其在二维或三维空间中进行移动、旋转、缩放和倾斜等变换。这些变换为前端开发者提供了…...

大恒相机通过Line2或Line3直接给出3.3V触发,形成分时曝光

大恒相机通过Line2或Line3直接给出3.3V触发,形成分时曝光 一、分时曝光需求二、3.3V信号分时曝光设计 写在前面 上班了,没多少时间再去精度论文了,大多是项目上的事情。 一、分时曝光需求 一般的12V光源通过光源控制器与大恒相机Line1线连接…...

electronjs实现打开的网页密码自动保存

在 Electron 中实现自动保存网页密码的功能涉及到几个步骤,以下是一个基本的实现思路: 1. 监听登录事件 首先,你需要监听用户的登录事件。当用户在一个网页上登录后,通常会有一个 POST 请求发送到服务器验证凭据。你可以监听这个…...

观测云的自动化监控:CRD 资源与自动发现

在云原生技术快速发展的今天,Kubernetes已成为企业容器化应用的中心舞台。随着应用的规模化和动态化,传统的监控方法已经难以满足需求。自动化监控,以其高效性和准确性,成为云原生监控的新趋势。观测云平台通过与Kubernetes的深度…...

九、OpenCVSharp 中的图像形态学操作

文章目录 简介一、腐蚀1. 腐蚀的原理和数学定义2. 结构元素的形状和大小选择3. 腐蚀操作的代码实现和效果展示二、膨胀1. 膨胀的概念和作用2. 与腐蚀的对比和组合使用(如开运算、闭运算)三、开运算1. 开运算的定义和用途(去除小的明亮区域)2. 开运算在去除噪声和分离物体方…...

http和websocket

http和websocket是什么 网络通信的协议 区别 http: 只能客户端发送,服务端接收。 websocket: 客户端和服务端都可以发送和接收数据。 链接...

日语AI面试高效通关秘籍:专业解读与青柚面试智能助攻

在如今就业市场竞争日益激烈的背景下,越来越多的求职者将目光投向了日本及中日双语岗位。但是,一场日语面试往往让许多人感到步履维艰。你是否也曾因为面试官抛出的“刁钻问题”而心生畏惧?面对生疏的日语交流环境,即便提前恶补了…...

Oracle查询表空间大小

1 查询数据库中所有的表空间以及表空间所占空间的大小 SELECTtablespace_name,sum( bytes ) / 1024 / 1024 FROMdba_data_files GROUP BYtablespace_name; 2 Oracle查询表空间大小及每个表所占空间的大小 SELECTtablespace_name,file_id,file_name,round( bytes / ( 1024 …...

LeetCode - 394. 字符串解码

题目 394. 字符串解码 - 力扣(LeetCode) 思路 使用两个栈:一个存储重复次数,一个存储字符串 遍历输入字符串: 数字处理:遇到数字时,累积计算重复次数左括号处理:保存当前状态&a…...

【机器视觉】单目测距——运动结构恢复

ps:图是随便找的,为了凑个封面 前言 在前面对光流法进行进一步改进,希望将2D光流推广至3D场景流时,发现2D转3D过程中存在尺度歧义问题,需要补全摄像头拍摄图像中缺失的深度信息,否则解空间不收敛…...

抖音增长新引擎:品融电商,一站式全案代运营领跑者

抖音增长新引擎:品融电商,一站式全案代运营领跑者 在抖音这个日活超7亿的流量汪洋中,品牌如何破浪前行?自建团队成本高、效果难控;碎片化运营又难成合力——这正是许多企业面临的增长困局。品融电商以「抖音全案代运营…...

376. Wiggle Subsequence

376. Wiggle Subsequence 代码 class Solution { public:int wiggleMaxLength(vector<int>& nums) {int n nums.size();int res 1;int prediff 0;int curdiff 0;for(int i 0;i < n-1;i){curdiff nums[i1] - nums[i];if( (prediff > 0 && curdif…...

Qt Http Server模块功能及架构

Qt Http Server 是 Qt 6.0 中引入的一个新模块,它提供了一个轻量级的 HTTP 服务器实现,主要用于构建基于 HTTP 的应用程序和服务。 功能介绍: 主要功能 HTTP服务器功能: 支持 HTTP/1.1 协议 简单的请求/响应处理模型 支持 GET…...

爬虫基础学习day2

# 爬虫设计领域 工商:企查查、天眼查短视频:抖音、快手、西瓜 ---> 飞瓜电商:京东、淘宝、聚美优品、亚马逊 ---> 分析店铺经营决策标题、排名航空:抓取所有航空公司价格 ---> 去哪儿自媒体:采集自媒体数据进…...

可以参考以下方法:)

根据万维钢·精英日课6的内容,使用AI(2025)可以参考以下方法:

根据万维钢精英日课6的内容,使用AI(2025)可以参考以下方法: 四个洞见 模型已经比人聪明:以ChatGPT o3为代表的AI非常强大,能运用高级理论解释道理、引用最新学术论文,生成对顶尖科学家都有用的…...

LangChain知识库管理后端接口:数据库操作详解—— 构建本地知识库系统的基础《二》

这段 Python 代码是一个完整的 知识库数据库操作模块,用于对本地知识库系统中的知识库进行增删改查(CRUD)操作。它基于 SQLAlchemy ORM 框架 和一个自定义的装饰器 with_session 实现数据库会话管理。 📘 一、整体功能概述 该模块…...