【扒代码】dave.py

COTR模型是一个用于少样本或零样本对象检测和计数的神经网络。它结合了特征提取、Transformer 编码器和解码器、密度图预测和边界框预测等多个组件。- 该模型特别适用于在只有少量标注数据或完全没有标注数据的情况下进行对象检测和计数任务。

- 通过使用 Transformer 架构,模型能够处理序列化的特征并捕捉长距离依赖关系。

- 模型采用了检测和验证的两阶段方法,首先生成高召回率的候选检测集,然后通过验证步骤识别和移除异常值,从而提高检测的准确性。

- 支持多种功能,如 CLIP 模型集成用于提示引导的学习、特征比较、聚类验证等,以提高模型在复杂场景下的性能。

class COTR(nn.Module):# ... 省略的初始化代码 ...if self.prompt_shot:# 如果模型配置为使用提示引导的学习方法(prompt-shot learning),# 则从 transformers 库导入 CLIPProcessor 和 CLIPModel 类。from transformers import CLIPProcessor, CLIPModel# 使用预训练的 'openai/clip-vit-large-patch14' 模型权重初始化 CLIP 模型。# CLIP(Contrastive Language-Image Pre-training)模型是一种多模态模型,# 能够处理图像和文本数据,实现图像与文本之间的关联学习。self.clip_model = CLIPModel.from_pretrained("openai/clip-vit-large-patch14")# 使用预训练的权重初始化 CLIP 处理器,用于图像和文本的预处理。self.clip_processor = CLIPProcessor.from_pretrained("openai/clip-vit-large-patch14")if num_encoder_layers > 0:# 如果配置的 Transformer 编码器层数大于 0,则初始化 Transformer 编码器。self.encoder = TransformerEncoder(# TransformerEncoder 的构造函数接受多个参数,用于定制编码器的行为:num_encoder_layers, # 编码器层数emb_dim, # 嵌入维度num_heads, # 注意力机制中的头数dropout, # dropout 比率,用于正则化layer_norm_eps, # LayerNorm 的 epsilon 值mlp_factor, # MLP(多层感知机)因子,影响 MLP 层的维度norm_first, # 是否先进行归一化再进行激活函数操作activation, # 激活函数模块norm # 是否使用归一化)# Transformer 编码器用于处理序列化的数据,通常用于提取特征表示。# 在 COTR 模型中,编码器可能用于提取图像特征或进行特征的进一步加工。# ... 省略的其余代码 ...COTR类是一个用于对象检测和计数任务的神经网络模型,其中集成了多种特征提取和处理技术。prompt_shot属性指示是否使用提示引导的学习方法。如果启用,将使用 CLIP 模型和处理器来增强模型对图像的理解,尤其是在零样本学习场景中。- CLIP 模型是一种结合了视觉和语言信息的模型,能够通过文本提示来改善图像内容的理解。

- Transformer 编码器是一个强大的序列特征提取工具,通常用于处理图像特征图或序列化的数据。在 COTR 模型中,编码器有助于捕获图像的全局上下文信息,提高检测和计数的准确性。

TransformerEncoder的参数允许详细定制 Transformer 编码器的行为,包括层数、嵌入维度、注意力头数等,以适应不同的任务需求。

这段代码展示了如何在神经网络模型中集成先进的多模态学习和特征提取技术,以提高模型在复杂视觉任务中的表现。

class COTR(nn.Module):# ... 省略的初始化代码 ...if num_decoder_layers > 0:# 如果配置的 Transformer 解码器层数大于 0,则初始化 Transformer 解码器。self.decoder = TransformerDecoder(num_layers=num_decoder_layers, # 解码器层数emb_dim=emb_dim, # 嵌入维度num_heads=num_heads, # 注意力机制中的头数dropout=0, # dropout 比率,这里设置为 0,表示不使用 dropoutlayer_norm_eps=layer_norm_eps, # LayerNorm 的 epsilon 值mlp_factor=mlp_factor, # MLP 因子,影响 MLP 层的维度norm_first=norm_first, # 是否先进行归一化再进行激活函数操作activation=activation, # 激活函数模块norm=norm, # 是否使用归一化attn1=not self.zero_shot and self.use_appearance # 如果不是零样本学习且使用外观特征,则启用 attn1)# Transformer 解码器用于处理序列化的数据,通常用于特征的进一步加工或生成。# 定义密度图回归头和辅助头,用于预测密度图。self.regression_head = DensityMapRegressor(emb_dim, reduction)# 密度图回归头用于从特征中预测密度图,是模型的输出部分。self.aux_heads = nn.ModuleList([DensityMapRegressor(emb_dim, reduction) for _ in range(num_decoder_layers - 1)])# 辅助头是一系列用于辅助训练的密度图回归头,通常用于多任务学习或模型的中间监督。self.box_predictor = FCOSHead(3584)# 边界框预测器用于从特征中预测边界框,这里使用的是 FCOSHead,一个用于边界框预测的网络头。self.idx = 0# 用于跟踪迭代或训练循环中的索引。self.pos_emb = PositionalEncodingsFixed(emb_dim)# 位置编码用于给模型提供关于特征在输入序列中位置的信息。if not self.det_train:# 如果不是检测训练模式,则初始化特征比较模块。self.feat_comp = Feature_Transform()# 特征比较模块用于比较和处理特征,以提取更有用的信息。# ... 省略的其余代码 ...COTR类是一个用于对象检测和计数任务的神经网络模型,其中集成了 Transformer 解码器、密度图回归头、边界框预测器和特征比较模块。TransformerDecoder是一个解码器模块,用于处理编码器的输出,通常用于生成任务或特征转换任务。在 COTR 中,解码器可能用于进一步处理特征或生成密度图。DensityMapRegressor是一个回归头,用于预测密度图,它将特征映射到密度图上,密度图表示对象在图像中的分布密度。FCOSHead是一个用于边界框预测的网络头,通常用于目标检测任务中,以预测对象的位置和大小。PositionalEncodingsFixed提供位置编码,这对于 Transformer 模型理解序列数据中的位置信息至关重要。Feature_Transform模块用于在非检测训练模式下处理特征,可能涉及到特征的比较、融合或其他转换操作。

LOCA的代码 一定要看人家怎么改的,怎么设计的

class COTR(nn.Module):# ... 省略的初始化代码 ...if self.use_objectness:# 如果模型配置为使用对象性(objectness)估计,即估计候选区域包含对象的概率。if not self.zero_shot:# 如果不是零样本学习场景,即模型在训练阶段可以看到所有类别的样本。self.objectness = nn.Sequential(# 使用 Sequential 容器来顺序堆叠多个层。nn.Linear(2, 64), # 第一个线性层,将输入特征从 2 维转换到 64 维。nn.ReLU(), # ReLU 激活函数,引入非线性。nn.Linear(64, emb_dim), # 第二个线性层,将特征从 64 维转换到嵌入维度 emb_dim。nn.ReLU(), # 再次使用 ReLU 激活函数。nn.Linear(emb_dim, self.kernel_dim ** 2 * emb_dim) # 第三个线性层,将特征从 emb_dim 转换到 kernel_dim^2 * emb_dim 维,以匹配卷积核的尺寸。)# 这个顺序模型用于学习候选区域的对象性表示。else:# 如果是零样本学习场景,即模型在训练阶段没有看到所有类别的样本。self.objectness = nn.Parameter(# 将对象性表示定义为一个可学习的参数,其形状为 (num_objects, kernel_dim^2, emb_dim)。torch.empty((self.num_objects, self.kernel_dim ** 2, emb_dim)))# 初始化这个参数为正态分布的随机值。nn.init.normal_(self.objectness)# ... 省略的其余代码 ...COTR类是一个用于对象检测和计数任务的神经网络模型,其中可以配置是否使用对象性估计。use_objectness属性指示是否使用对象性估计。对象性估计是一个辅助任务,用于评估候选区域包含目标对象的概率。- 在非零样本学习场景下,对象性估计通过一个顺序模型来实现,该模型由多个线性层和 ReLU 激活函数组成,用于从候选区域的特征学习对象性表示。

- 在零样本学习场景下,对象性表示被定义为一个可学习的参数,其初始化为正态分布的随机值。这允许模型在没有见过某些类别样本的情况下,通过学习的对象性参数来进行泛化。

kernel_dim是卷积核的尺寸,emb_dim是嵌入维度,num_objects是候选区域的数量。nn.Parameter将对象性表示作为模型的参数,使其可以在训练过程中更新。

def clip_check_clusters(self, img, bboxes, category, img_name=None):# 该函数使用CLIP模型来检查和分类图像中的聚类结果。bboxes = extend_bboxes(bboxes)# 扩展边界框,可能是为了调整大小或确保边界框的一致性。C, H, W = img[0].shape# 获取图像的通道数、高度和宽度。mask_tensor = np.zeros((H, W, C))# 创建一个与图像形状相同的全零掩码张量。for box in bboxes.long():x1, y1, x2, y2 = boxmask_tensor[y1:y2, x1:x2, :] = 1# 遍历边界框,将掩码张量中对应边界框的位置设置为1,以标记对象区域。img_ = img[0].cpu().permute(1, 2, 0).numpy()# 将图像数据从GPU移动到CPU,转换数据格式,并转换通道顺序,然后转换为NumPy数组。non_zero_rows = np.any(img_ != 0, axis=(1, 2))# 找出图像中至少有一个非零元素的行。non_zero_cols = np.any(img_ != 0, axis=(0, 2))# 找出图像中至少有一个非零元素的列。top, bottom = np.where(non_zero_rows)[0][[0, -1]]# 获取非零行的索引范围,即图像的有效高度范围。left, right = np.where(non_zero_cols)[0][[0, -1]]# 获取非零列的索引范围,即图像的有效宽度范围。img_ = img_ - np.min(img_)# 将图像数据标准化,减去最小值。img_ = img_ / np.max(img_)# 将图像数据标准化,除以最大值。img_ = img_ * mask_tensor# 将图像数据与掩码张量相乘,以便只保留对象区域内的像素值。img_ = img_[top:bottom + 1, left:right + 1]# 根据非零行和列的索引裁剪图像,去除空白边缘。img_ = Image.fromarray(np.uint8(img_ * 255))# 将裁剪后的图像数据转换为PIL Image对象,并乘以255进行缩放。inputs = self.clip_processor(text=[category[0]], images=img_, return_tensors="pt", padding=True).to(img.device)# 使用CLIP处理器对图像和文本类别进行预处理,并确保输入数据在正确的设备上。outputs = self.clip_model(**inputs)# 使用CLIP模型处理输入,获取模型的输出。logits_per_image = outputs.logits_per_image# 获取模型输出的图像logits,即分类概率。return logits_per_image[0]# 返回第一个图像的logits,作为该函数的结果。clip_check_clusters函数是一个利用CLIP模型对图像中的对象聚类结果进行分类的函数。- 该函数首先处理边界框,然后从图像中提取并裁剪出包含对象的区域。

- 使用CLIP模型对裁剪后的图像进行分类,以确定聚类是否正确。

- 函数返回CLIP模型输出的logits,这可以用于进一步的分析或作为聚类结果的分类概率

def generate_bbox(self, density_map, tlrb, gt_dmap=None):# 根据密度图和提供的边界框生成器(tlrb)生成边界框列表。# density_map: 输入的密度图,表示图像中对象的密度分布。# tlrb: 边界框生成器,用于定义边界框的边界。# gt_dmap: 可选的,如果提供,将使用这个作为真实的密度图。if gt_dmap is not None:density_map = gt_dmap# 如果提供了真实密度图,则使用它代替输入的密度图。bboxes = []# 初始化边界框列表。for i in range(density_map.shape[0]):density = np.array((density_map)[i][0].cpu())dmap = np.array((density_map)[i][0].cpu())# 应用阈值来过滤密度图中的低密度区域。mask = dmap < min(np.max(dmap) / self.d_t, self.s_t)dmap[mask] = 0a = skimage.feature.peak_local_max(dmap, exclude_border=0)# 在密度图中寻找局部最大值作为潜在的对象中心。boxes = []scores = []b, l, r, t = tlrb[i]# 根据局部最大值生成边界框,并计算得分。for x11, y11 in a:# 计算边界框的坐标。box = [y11 - b[x11][y11].item(), x11 - l[x11][y11].item(), y11 + r[x11][y11].item(), x11 + t[x11][y11].item()]boxes.append(box)# 计算边界框的得分,结合了密度和边界框的匹配度。scores.append((1 - math.fabs(density[max(0, int(box[1])): min(int(box[3]), dmap.shape[0]),max(int(box[0]), 0):min(int(box[2]), dmap.shape[1])].sum() - 1)) * self.d_s+ density[max(0, int(box[1])): min(int(box[3]), dmap.shape[0]),max(int(box[0]), 0):min(int(box[2]), dmap.shape[1])].max().item() * self.m_s)# 将边界框列表和得分转换为BoxList格式,并裁剪超出图像范围的边界框。b = BoxList(list(boxes), (density_map.shape[3], density_map.shape[2]))b.fields['scores'] = torch.tensor(scores, dtype=b.box.dtype)b = b.clip()# 如果设置了归一化得分,进行得分的归一化处理。if self.norm_s:b.fields['scores'] = torch.tensor([(float(i) - min(scores)) / (max(scores) - min(scores)) for i in b.fields['scores']])# 使用非极大值抑制(NMS)进一步筛选边界框,根据得分和IoU阈值。b = boxlist_nms(b, b.fields['scores'], self.i_thr)bboxes.append(b)# 将生成的边界框列表添加到最终列表中。return bboxes# 返回包含所有边界框的列表。generate_bbox函数是根据密度图来生成边界框的函数。它首先在密度图中寻找局部最大值,这些最大值可能表示对象的中心。- 然后,对于每个局部最大值,函数根据边界框生成器

tlrb来确定边界框的坐标。边界框的得分是根据密度图中对象的密度和边界框的匹配度计算的。 - 函数使用BoxList数据结构来存储边界框和它们的得分,并进行裁剪和非极大值抑制操作,以去除超出图像范围或重叠的边界框。

- 该函数最终返回一个边界框列表,每个边界框都附带一个得分,这可以用于评估边界框的质量或在后续步骤中选择最佳边界框。

def eigenDecomposition(self, A):# 该函数执行特征分解,用于谱聚类分析。# 参考了以下论文和教程:# - Self-tuning Spectral Clustering: https://papers.nips.cc/paper/2619-self-tuning-spectral-clustering.pdf# - A Tutorial on Spectral Clustering: http://www.kyb.mpg.de/fileadmin/user_upload/files/publications/attachments/Luxburg07_tutorial_4488%5b0%5d.pdfthreshold = self.egv# 设置特征值差距的阈值,用于确定聚类数目。L = csgraph.laplacian(A, normed=True)# 计算输入矩阵A的拉普拉斯矩阵,normed=True表示计算规范化的拉普拉斯矩阵。eigenvalues, eigenvectors = LA.eig(L)# 计算拉普拉斯矩阵L的特征值和特征向量。index_largest_gap = np.argsort(np.diff(eigenvalues))[::-1][:5]# 找到特征值差距最大的5个索引。diffs = np.diff(eigenvalues)# 计算连续特征值之间的差值。n_clusters = []for i in index_largest_gap:if diffs[i] > threshold:# 如果特征值差距大于阈值,则认为此处存在聚类边界。n_clusters.append(i)# 收集潜在的聚类数目。nb_clusters = np.array(n_clusters) + 1# 将潜在的聚类数目转换为聚类数目的数组。return nb_clusters[:2], eigenvalues, eigenvectors# 返回前两个聚类数目,以及特征值和特征向量。def compute_location(self, features):# 该函数计算特征图上每个位置的坐标。locations = []_, _, height, width = features.shape# 获取特征图的形状,忽略批次和通道维度。location_per_level = self.compute_location_per_level(height, width, 1, features.device)# 调用辅助函数计算每个像素位置的坐标。locations.append(location_per_level)# 将计算出的位置坐标添加到列表中。return locations# 返回包含位置坐标的列表。eigenDecomposition函数用于执行特征分解,这是谱聚类的一个关键步骤。该函数首先计算输入相似性矩阵的拉普拉斯矩阵,然后找到特征值差距最大的位置,这些位置表明了潜在的聚类边界。最终,函数返回了可能的聚类数目以及相关的特征值和特征向量。compute_location函数用于计算特征图上每个位置的坐标。这通常用于确定特征图中每个元素的空间位置,这些位置信息可以用于后续的注意力机制或空间相关性分析。

def compute_location_per_level(self, height, width, stride, device):# 该函数计算给定尺度(stride)下,特征图上每个位置的坐标。shift_x = torch.arange(0, width * stride, step=stride, dtype=torch.float32, device=device)# 在设备上创建一个从0开始、宽度乘以步长、步长固定的一维张量,表示列的偏移量。shift_y = torch.arange(0, height * stride, step=stride, dtype=torch.float32, device=device)# 在设备上创建一个从0开始、高度乘以步长、步长固定的一维张量,表示行的偏移量。shift_y, shift_x = torch.meshgrid(shift_y, shift_x)# 使用meshgrid函数生成二维网格,其中shift_y为行索引,shift_x为列索引。shift_x = shift_x.reshape(-1)# 将列索引的二维网格展平成一维张量。shift_y = shift_y.reshape(-1)# 将行索引的二维网格展平成一维张量。location = torch.stack((shift_x, shift_y), 1) + stride // 2# 将行索引和列索引合并为一个二维张量,其中每个位置的坐标是相对于其在网格中的位置加上步长的一半,# 这样做是为了将位置坐标调整到单元格的中心。return location# 返回包含调整后位置坐标的二维张量。compute_location_per_level函数用于计算特征图上每个单元格的中心坐标。这在视觉任务中很有用,尤其是在需要精确知道特征响应位置的场景下。- 函数首先使用

torch.arange创建两个一维张量shift_x和shift_y,分别表示列和行的偏移量。这些偏移量是基于给定的步长(stride)计算的。 - 然后,通过

torch.meshgrid生成网格,将行和列索引组合成一个二维网格。 - 接下来,将这个二维网格展平成一维张量,以便于后续处理。

- 最后,通过

torch.stack将行索引和列索引堆叠起来形成坐标对,并加上步长的一半,以将坐标调整到单元格的中心位置。

def predict_density_map(self, backbone_features, bboxes):# 预测密度图的函数,该函数接受骨干网络输出的特征和边界框作为输入。bs, _, bb_h, bb_w = backbone_features.size()# 获取骨干网络特征的尺寸:批量大小(bs),通道数,《特征图高度(bb_h),特征图宽度(bb_w)。# 准备编码器输入src = self.input_proj(backbone_features)# 使用输入投影层(input_proj)处理骨干网络特征,将其从骨干网络的通道数映射到嵌入维度(emb_dim)。bs, c, h, w = src.size()# 获取处理后特征的尺寸。pos_emb = self.pos_emb(bs, h, w, src.device).flatten(2).permute(2, 0, 1)# 创建并格式化位置嵌入(positional encodings),以匹配特征图的尺寸。src = src.flatten(2).permute(2, 0, 1)# 将特征图展平并调整维度,以适应编码器的输入格式。# 通过编码器传递特征if self.num_encoder_layers > 0:# 如果模型配置了编码器层数,则通过Transformer编码器处理特征。if backbone_features.shape[2] * backbone_features.shape[3] > 6000:# 如果特征图的总像素数超过6000,则在CPU上执行编码器以减少内存使用。enc = self.encoder.cpu()memory = enc(src.cpu(), pos_emb.cpu(), src_key_padding_mask=None, src_mask=None).to(backbone_features.device)else:memory = self.encoder(src, pos_emb, src_key_padding_mask=None, src_mask=None)else:memory = src# 准备解码器输入x = memory.permute(1, 2, 0).reshape(-1, self.emb_dim, bb_h, bb_w)# 调整编码器输出的内存特征以准备解码器输入。bboxes_ = torch.cat([# 准备边界框输入,通过扩展边界框以匹配每个对象的格式。torch.arange(bs, requires_grad=False).to(bboxes.device).repeat_interleave(self.num_objects).reshape(-1, 1),# 扩展边界框以匹配批量大小和对象数量。bboxes[:, :self.num_objects].flatten(0, 1),], dim=1)# 将扩展的边界框与批量索引连接起来,形成适合解码器的输入格式。# 函数的其余部分未显示,但这里应该是将解码器输入x和bboxes_传递给解码器,# 并使用解码器的输出来预测密度图。predict_density_map函数是用于预测对象在图像中的分布密度的函数。这通常用于目标检测和计数任务,尤其是在少样本或零样本学习场景中。- 函数首先从骨干网络获取特征图,并通过输入投影层将其映射到嵌入维度的空间。

- 然后,使用位置编码为特征提供位置信息,并通过Transformer编码器进一步处理特征。

- 根据骨干网络特征图的尺寸和像素数量,函数可能会选择在CPU上执行编码器以减少内存消耗。

- 接下来,函数准备解码器的输入,包括调整编码器的输出和格式化边界框信息。

- 最终,函数将使用解码器的输出来预测每个对象的密度图,这通常涉及到注意力机制和解码器层的输出。

这个函数是COTR模型中的关键部分,它利用Transformer架构的能力来处理图像特征,并预测对象的分布密度。通过这种方式,模型能够生成对目标检测和计数任务有用的密度图。

# 提取对象性(objectness)

if self.use_objectness and not self.zero_shot:# 如果模型配置为使用对象性估计,并且不是零样本学习场景,则执行以下操作。box_hw = torch.zeros(bboxes.size(0), bboxes.size(1), 2).to(bboxes.device)# 初始化一个张量,用于存储边界框的宽度和高度。box_hw[:, :, 0] = bboxes[:, :, 2] - bboxes[:, :, 0]# 计算边界框的宽度,即边界框的右边缘减去左边缘。box_hw[:, :, 1] = bboxes[:, :, 3] - bboxes[:, :, 1]# 计算边界框的高度,即边界框的下边缘减上去边缘。objectness = self.objectness(box_hw).reshape(bs, -1, self.kernel_dim ** 2, self.emb_dim).flatten(1, 2).transpose(0, 1)# 使用对象性网络(定义在模型初始化时)处理box_hw,然后调整张量的形状以匹配后续处理的需要。elif self.zero_shot:# 如果是零样本学习场景,则对象性估计采用不同的方式。objectness = self.objectness.expand(bs, -1, -1, -1).flatten(1, 2).transpose(0, 1)# 使用模型初始化时定义的对象性参数,扩展并调整张量形状。else:objectness = None# 如果模型没有配置使用对象性估计,或者在其他情况下,不进行对象性估计。# 如果不是零样本学习并且配置了使用外观特征,则添加外观特征

if not self.zero_shot and self.use_appearance:# 如果模型配置为使用外观特征,并且不是零样本学习场景,则执行以下操作。bboxes = torch.cat([torch.arange(bs, requires_grad=False).to(bboxes.device).repeat_interleave(self.num_objects).reshape(-1, 1),bboxes.flatten(0, 1),], dim=1)# 重新格式化边界框,以适应roi_align操作。appearance = roi_align(x,boxes=bboxes, output_size=self.kernel_dim,spatial_scale=1.0 / self.reduction, aligned=True).permute(0, 2, 3, 1).reshape(bs, self.num_objects * self.kernel_dim ** 2, -1).transpose(0, 1)# 使用roi_align操作从特征图x中提取与边界框相对应的特征,然后调整张量的形状。else:appearance = None# 如果模型没有配置使用外观特征,或者在其他情况下,不进行外观特征提取。- 这段代码负责提取对象性(objectness)和外观(appearance)特征,这些特征通常用于目标检测和实例分割任务中。

- 对象性特征表示候选区域包含目标对象的概率。在非零样本学习场景中,对象性特征是通过将边界框的宽度和高度作为输入,经过一个全连接网络来计算的。而在零样本学习场景中,对象性特征则是由模型初始化时定义的参数直接提供。

- 外观特征表示边界框内的视觉内容。在非零样本学习场景中,外观特征是通过将边界框与特征图对齐,然后使用

roi_align操作来提取的。这个操作会从特征图中提取出与边界框相对应的特征区域,以便于后续处理。 - 代码中的

self.use_objectness和self.use_appearance标志位控制是否提取对象性和外观特征。 - 这些特征的提取方式取决于模型是否处于零样本学习场景,以及模型的配置选项。

if self.use_query_pos_emb:# 如果模型配置为使用查询位置嵌入(query positional embeddings),则执行以下操作。query_pos_emb = self.pos_emb(bs, self.kernel_dim, self.kernel_dim, memory.device).flatten(2).permute(2, 0, 1).repeat(self.num_objects, 1, 1)# 使用位置嵌入模块生成查询位置嵌入,这些嵌入将为解码器提供位置信息。# 调整张量的形状以匹配解码器的输入要求,并重复以匹配每个对象。

else:query_pos_emb = None# 如果不使用查询位置嵌入,则将变量设置为None。if self.num_decoder_layers > 0:# 如果模型配置了解码器层数大于0,表示使用了解码器,则执行以下操作。weights = self.decoder(objectness if objectness is not None else appearance,appearance, memory, pos_emb, query_pos_emb)# 调用解码器模块,传入对象性特征(如果存在)或外观特征、外观特征、编码器的输出、# 位置嵌入和查询位置嵌入。解码器将生成权重,这些权重将用于后续的密度图预测。

else:if objectness is not None and appearance is not None:# 如果模型既使用对象性特征也使用外观特征,但未使用解码器,则执行以下操作。weights = (objectness + appearance).unsqueeze(0)# 将对象性特征和外观特征相加,增加一个维度以匹配后续操作的要求。else:weights = (objectness if objectness is not None else appearance).unsqueeze(0)# 如果只使用对象性特征或外观特征中的一个,将其增加一个维度。# 准备回归解码器的输入

x = memory.permute(1, 2, 0).reshape(-1, self.emb_dim, bb_h, bb_w)

# 将编码器的输出调整为回归解码器的输入格式。- 这段代码是神经网络模型中处理解码器的部分,用于生成用于密度图预测的权重。

use_query_pos_emb标志确定是否使用查询位置嵌入,这是一种为解码器提供位置信息的方式,有助于模型理解特征在空间上的分布。pos_emb和query_pos_emb提供了编码器和查询的位置信息,这些信息对于解码器来说是重要的,尤其是在处理图像特征时。num_decoder_layers指示模型中解码器的层数。如果使用了解码器,它将接收来自编码器的特征、外观特征、位置嵌入和查询位置嵌入,以生成预测所需的权重。weights是在解码器中生成的权重,这些权重将用于后续的回归解码器,以预测密度图。x是回归解码器的输入,它从编码器的输出memory中转换而来,调整为适合解码器处理的形状。

outputs_R = list()

# 初始化一个列表,用于存储每次迭代产生的输出。for i in range(weights.size(0)):# 遍历weights张量的第一个维度,weights是解码器的输出,表示每个对象的权重。kernels = weights[i, ...].permute(1, 0, 2).reshape(bs, self.num_objects, self.kernel_dim, self.kernel_dim, -1).permute(0, 1, 4, 2, 3).flatten(0, 2)[:, None, ...]# 取出第i个权重,重新排列和重塑张量形状,以匹配后续卷积操作的需要。# 首先permute调整维度顺序,reshape调整张量形状,再次permute以满足特定卷积实现的需求,# 最后flatten展平某些维度,并增加维度以符合卷积输入要求。if self.num_objects > 1 and not self.zero_shot:# 如果检测到多于一个的对象,并且不是零样本学习场景,则执行以下操作。correlation_maps = F.conv2d(# 使用F.conv2d进行二维卷积,输入是x(编码器的输出)和kernels(权重)。torch.cat([x for _ in range(self.num_objects)], dim=1).flatten(0, 1).unsqueeze(0),kernels,bias=None, # 卷积操作没有偏置项。padding=self.kernel_dim // 2, # 根据kernel_dim设置填充。groups=kernels.size(0) # 根据权重的数量设置分组卷积。).view(bs, self.num_objects, self.emb_dim, bb_h, bb_w)# 调整卷积结果的形状以匹配原始输入的批次大小、对象数量、嵌入维度、高度和宽度。softmaxed_correlation_maps = correlation_maps.softmax(dim=1)# 对每个对象的嵌入维度进行softmax操作,获取概率分布。correlation_maps = torch.mul(softmaxed_correlation_maps, correlation_maps).sum(dim=1)# 将softmax结果与原始correlation_maps相乘,并沿对象维度求和,得到相关性图。else:# 如果只检测到一个对象,或者处于零样本学习场景,则执行以下操作。correlation_maps = F.conv2d(# 与上述相同,进行二维卷积。torch.cat([x for _ in range(self.num_objects)], dim=1).flatten(0, 1).unsqueeze(0),kernels,bias=None,padding=self.kernel_dim // 2,groups=kernels.size(0)).view(bs, self.num_objects, self.emb_dim, bb_h, bb_w).max(dim=1)[0]# 调整卷积结果的形状,然后沿对象维度取最大值,得到最相关的特征图。# 将计算得到的相关性图添加到outputs_R列表中。outputs_R.append(correlation_maps)# 经过上述循环,outputs_R列表包含了每次迭代的相关性图,这些图可以用于后续的回归头处理。- 这段代码是神经网络模型中处理解码器输出的部分,用于生成相关性图,这些图表示了模型预测的对象分布。

weights变量包含了解码器的输出,每个元素代表一个对象的权重,这些权重通过卷积操作与编码器的输出x相结合,生成相关性图。- 根据对象的数量和是否处于零样本学习场景,相关性图的生成方式有所不同。在多对象场景中,使用softmax操作获取概率分布,并与原始相关性图相乘后求和。在单对象场景或零样本学习场景中,直接取最大值。

correlation_maps是最终生成的相关性图,它们可以反映对象在特征图上的位置和分布。- 最后,所有生成的相关性图存储在

outputs_R列表中,这个列表可以用于后续的回归解码器处理或其他任务。

# 发送至回归头进行处理

if i == weights.size(0) - 1:# 如果当前迭代是weights张量的第一个维度的最后一个元素,# 则将相关性图correlation_maps发送至主回归头进行处理。_x = self.regression_head(correlation_maps)# 将回归头的输出赋值给_x,这里_x可能表示最终的预测结果。outputR = self.regression_head(correlation_maps)# 将相同的回归头输出赋值给outputR,这里outputR用于存储最终的回归结果。

else:# 如果当前迭代不是最后一个元素,而是之前的某个阶段,# 则将相关性图correlation_maps发送至辅助回归头之一进行处理。_x = self.aux_heads[i](correlation_maps)# 将当前迭代的回归头输出_x添加到outputs_R列表中。

# outputs_R用于存储所有阶段的回归头输出。

outputs_R.append(_x)# 在循环结束后,返回以下内容:

# - correlation_maps:每次卷积操作生成的相关性图列表。

# - outputs_R:所有阶段的回归头输出列表。

# - outputR:最终阶段的主回归头输出。

return correlation_maps, outputs_R功能解释:

- 这段代码是神经网络模型中处理回归头的部分,用于生成密度图的预测。

weights变量包含了解码器的输出,每个元素代表一个对象的权重,这些权重通过卷积操作与编码器的输出相结合,生成相关性图。- 代码中的

if语句检查当前的迭代是否是weights张量的第一个维度的最后一个元素。如果是,表示已经完成了所有迭代,此时将使用主回归头处理相关性图。如果不是,表示还在迭代过程中,此时将使用辅助回归头之一处理相关性图。 self.regression_head是模型的主回归头,通常用于生成最终的密度图预测。而self.aux_heads是辅助回归头的列表,可能用于生成中间阶段的预测,以提供额外的监督信号或改善训练过程。_x是当前迭代回归头输出的预测结果,它可能用于后续的比较或分析。如果是最后一个元素,outputR将与_x相同,表示最终的预测结果。outputs_R列表存储了所有阶段的回归头输出,这可以用于分析模型在不同阶段的性能,或者作为集成学习的一部分。- 最后,函数返回相关性图列表、所有阶段的回归头输出列表和最终阶段的主回归头输出,这些返回值可以用于进一步的分析、可视化或后处理步骤。

def forward(self, x_img, bboxes, name='', dmap=None, classes=None):# 前向传播函数,定义了模型如何处理输入图像x_img和边界框bboxes,# 以及如何进行检测和验证阶段。self.num_objects = bboxes.shape[1]# 设置对象的数量,即边界框的数量。backbone_features = self.backbone(x_img)# 使用模型的主干网络backbone处理输入图像x_img,获取特征。bs, _, bb_h, bb_w = backbone_features.size()# 获取主干网络输出特征的尺寸:批量大小(bs),通道数,《特征图高度(bb_h),特征图宽度(bb_w)。###################### DETECTION STAGE###################### 使用LOCA少样本计数器进行密度图预测。# predict_density_map函数预测密度图,返回相关性图、各阶段的回归输出、最终的回归输出。correlation_maps, outputs_R, outputR = self.predict_density_map(backbone_features, bboxes)if self.det_train:# 如果模型处于检测训练模式,则执行以下操作。tblr = self.box_predictor(self.upscale(backbone_features), self.upscale(correlation_maps))# 使用box_predictor预测边界框。location = self.compute_location(tblr)# 计算预测边界框的位置。return outputs_R[-1], outputs_R[:-1], tblr, location# 返回最终的回归输出、中间的回归输出、预测的边界框和位置。# 根据特征图的尺寸决定是否在CPU上执行box_predictor以减少内存使用。if backbone_features.shape[2] * backbone_features.shape[3] > 8000:self.box_predictor = self.box_predictor.cpu()tblr = self.box_predictor(self.upscale(backbone_features.cpu()), self.upscale(correlation_maps.cpu()))else:tblr = self.box_predictor(self.upscale(backbone_features), self.upscale(correlation_maps))# 使用generate_bbox函数根据预测的密度图和tblr生成边界框。generated_bboxes = self.generate_bbox(outputR, tblr)[0]# 获取生成的边界框。bboxes_p = generated_bboxes.box# 获取预测边界框的坐标。# 准备用于后续处理的边界框张量bboxes_pred,包括边界框的索引和坐标。bboxes_pred = torch.cat([torch.arange(1, requires_grad=False).to(bboxes_p.device).repeat_interleave(len(bboxes_p)).reshape(-1, 1),bboxes_p,], dim=1).to(backbone_features.device)forward函数是模型的前向传播函数,它定义了模型如何处理输入数据(图像和边界框),并执行检测和验证阶段。- 函数首先通过主干网络提取特征,然后根据提取的特征和输入的边界框预测密度图。

- 在检测阶段,模型使用LOCA少样本计数器来预测密度图,这有助于确定图像中对象的分布。

- 如果模型处于检测训练模式,它将预测边界框并计算位置信息,然后返回这些信息。

- 如果不是检测训练模式,模型将根据预测的密度图和通过box_predictor得到的边界框信息生成最终的边界框。

- 函数还涉及一些条件判断,以决定是否将某些计算移至CPU以减少GPU内存的使用,这通常取决于特征图的尺寸。

- 最终,函数返回相关性图、各阶段的回归输出、预测的边界框和位置信息,这些信息可以用于后续的分析或进一步处理。

if not self.zero_shot:# 如果不是零样本学习模式,执行以下操作:bboxes_ = torch.cat([# 使用torch.arange生成一个与批次大小bs相同长度的序列,然后重复self.num_objects次,# 并将其转换为一维张量,与bboxes的前num_objects列展平后的张量在dim=1上进行拼接。torch.arange(bs, requires_grad=False).to(bboxes.device).repeat_interleave(self.num_objects).reshape(-1, 1),bboxes[:, :self.num_objects].flatten(0, 1),], dim=1)# 将上面生成的bboxes_与预测的边界框bboxes_pred在dim=0上进行拼接。bboxes_ = torch.cat([bboxes_, bboxes_pred], dim=0)

else:# 如果是零样本学习模式,直接使用预测的边界框作为bboxes_。bboxes_ = bboxes_pred# 使用roi_align从骨干网络特征backbone_features中提取与bboxes_对应的特征。

feat_vectors = roi_align(backbone_features,boxes=bboxes_, output_size=self.kernel_dim,spatial_scale=1.0 / self.reduction, aligned=True

).permute(0, 2, 3, 1).reshape(1, bboxes_.shape[0], 3, 3, -1

).permute(0, 1, 4, 2, 3)# 将feat_vectors通过feat_comp处理,然后重塑和排列以生成feat_pairs。

feat_pairs = self.feat_comp(feat_vectors.reshape(bs * bboxes_.shape[0], 3584, 3, 3))\.reshape(bs, bboxes_.shape[0], -1).permute(1, 0, 2)# 如果feat_pairs的长度超过500,为了加速处理,直接返回当前的输出。

if len(feat_pairs) > 500:return outputR, [], tblr, generated_bboxes# 下面被注释的代码是用于减少内存消耗的示例,通过计算feat_pairs之间的成对余弦相似度并构建距离矩阵dst_mtx。

# dst_mtx = np.zeros((feat_pairs.shape[0], feat_pairs.shape[0]))

# for f1, f2 in itertools.combinations(zip(feat_pairs, [i for i in range(feat_pairs.shape[0])]), 2):

# s=self.cosine_sim(f1[0], f2[0])

# dst_mtx[f1[1]][f2[1]] = s

# dst_mtx[f1[1]][f1[1]] = 1

# dst_mtx[f2[1]][f1[1]] = s# 使用cosine_sim计算feat_pairs的余弦相似度,并转换为numpy数组dst_mtx。

# 然后将dst_mtx中小于0的值设置为0。

feat_pairs = feat_pairs[:, 0]

dst_mtx = self.cosine_sim(feat_pairs[None, :], feat_pairs[:, None]).cpu().numpy()

dst_mtx[dst_mtx < 0] = 0- 这段代码是神经网络模型中特征提取和相似度计算的一部分,用于处理边界框和提取的特征。

- 首先,根据是否处于零样本学习模式,处理边界框

bboxes,以生成用于特征提取的边界框集合bboxes_。 - 使用

roi_align函数从骨干网络的输出特征中提取与bboxes_对应的特征,这些特征将用于后续的相似度计算。 feat_comp函数处理提取的特征,生成特征对feat_pairs。- 如果特征对的数量超过一定阈值(500),为了加速处理,直接返回当前的输出。

- 计算特征对之间的余弦相似度,构建距离矩阵

dst_mtx,并将负值设置为0,以避免影响后续的聚类或分类操作。 - 这些操作有助于模型在验证阶段识别和筛选出正确的对象边界框,提高检测的准确性。

if self.zero_shot and self.prompt_shot:# 如果模型处于零样本学习模式,并且启用了提示引导学习,则执行以下操作。preds = generated_bboxes# 将生成的边界框preds作为初始预测结果。k, _, _ = self.eigenDecomposition(dst_mtx)# 调用eigenDecomposition函数对dst_mtx进行特征分解,获取可能的聚类数目k。if len(k) > 1 or (len(k) > 1 and k[0] > 1):# 如果存在多个聚类或者聚类数目大于1,则执行聚类操作。n_clusters_ = max(k)# 选择最大的聚类数目作为聚类的数量。spectral = SpectralClustering(n_clusters=n_clusters_, affinity='precomputed')# 初始化谱聚类对象,使用预设的亲和矩阵。labels = spectral.fit_predict(dst_mtx)# 对dst_mtx进行聚类预测,labels为聚类标签。box_labels = labels# 将聚类标签分配给边界框。labels = box_labels[box_labels >= 0]# 筛选出非负的聚类标签。labels, counts = np.unique(np.array(labels), return_counts=True)# 获取唯一的聚类标签及其出现次数。correct_clusters = []probs = []# 初始化正确聚类列表和概率列表。for lab in labels:# 对每个聚类标签进行处理。mask = np.in1d(box_labels, lab).reshape(box_labels.shape)# 根据聚类标签创建掩码。probs.append(self.clip_check_clusters(x_img, bboxes_p[mask], classes, img_name=name).item())# 使用CLIP模型对当前聚类的边界框进行概率评估,并将结果添加到概率列表。correct_clusters.append(lab)# 将当前的聚类标签添加到正确聚类列表。thresh = max(probs) * 0.85# 根据最高概率设置阈值。correct = np.array(probs) > thresh# 根据阈值确定正确的聚类。correct_clusters = np.array(correct_clusters)[correct]# 筛选出超过阈值的正确聚类。mask = np.in1d(box_labels, correct_clusters).reshape(box_labels.shape)# 根据正确的聚类创建掩码。preds = generated_bboxes[mask]# 根据掩码更新预测的边界框。if len(preds) != len(generated_bboxes):# 如果更新后的预测边界框数量与原始数量不同,说明进行了筛选。outputR[0][0] = mask_density(outputR[0], preds)# 使用mask_density函数更新密度图。return outputR, [], tblr, preds# 返回更新后的输出结果,包括密度图、边界框列表、边界框预测器的输出和筛选后的预测边界框。- 这段代码是神经网络模型中处理零样本学习模式下的对象检测和聚类的一部分。

- 在零样本学习模式下,模型没有直接训练过目标类别的样本,但可以通过提示引导学习来识别和分类对象。

- 首先,使用生成的边界框作为初始预测结果。

- 然后,通过特征分解确定可能的聚类数目,并使用谱聚类对边界框进行聚类。

- 对每个聚类使用CLIP模型进行概率评估,根据评估结果筛选出正确的聚类。

- 根据筛选结果更新预测的边界框,并更新密度图。

elif self.zero_shot and not self.prompt_shot:# 如果模型处于零样本学习模式,并且没有启用提示引导学习,则执行以下操作。k, _, _ = self.eigenDecomposition(dst_mtx)# 调用eigenDecomposition函数对dst_mtx进行特征分解,以确定聚类数目。preds = generated_bboxes# 将生成的边界框preds作为初始预测结果。if len(k) > 1 or (len(k) > 1 and k[0] > 1):# 如果通过特征分解得到多于一个的聚类数目,或者聚类数目大于1,则执行聚类操作。n_clusters_ = max(k)# 选择最大的聚类数目作为聚类的数量。spectral = SpectralClustering(n_clusters=n_clusters_, affinity='precomputed')# 初始化谱聚类对象,使用预设的亲和矩阵。labels = spectral.fit_predict(dst_mtx)# 对dst_mtx进行聚类预测,labels为聚类标签。box_labels = labels# 将聚类标签分配给边界框。labels = box_labels[box_labels >= 0]# 筛选出非负的聚类标签。labels, counts = np.unique(np.array(labels), return_counts=True)# 获取唯一的聚类标签及其出现次数。max_count = np.max(counts)# 获取出现次数的最大值。proc_freq = counts / max_count# 计算每个聚类标签的相对频率。correct_class_labels = labels[proc_freq > 0.50]# 选择相对频率大于0.50的聚类标签作为正确分类的标签。mask = []# 初始化掩码列表,用于筛选正确的边界框。for iii, box in enumerate(generated_bboxes.box):# 遍历所有生成的边界框。if box_labels[iii] in correct_class_labels:# 如果边界框的聚类标签是正确分类的标签之一,则将其索引添加到掩码列表。mask.append(iii)preds = generated_bboxes[mask]# 根据掩码列表更新预测的边界框。outputR[0][0] = mask_density(outputR[0], preds)# 使用mask_density函数根据筛选后的预测边界框更新密度图。return outputR, [], tblr, preds# 返回更新后的输出结果,包括密度图、边界框列表、边界框预测器的输出和筛选后的预测边界框。- 这段代码是神经网络模型中处理零样本学习模式下的对象检测和聚类的一部分,但不使用提示引导学习。

- 首先,使用

eigenDecomposition函数对距离矩阵dst_mtx进行特征分解,以确定可能的聚类数目。 - 如果存在多个聚类或者聚类数目大于1,则使用谱聚类对边界框进行聚类。

- 根据聚类结果和每个聚类的出现次数,筛选出频率大于50%的聚类标签作为正确分类的标签。

- 根据筛选出的聚类标签,更新预测的边界框

preds。 - 使用

mask_density函数根据更新后的预测边界框preds调整密度图outputR。 - 最终,返回更新后的密度图、边界框列表、边界框预测器的输出和筛选后的预测边界框,这些结果可以用于后续的分析或进一步处理。

else:# 如果前面条件分支不满足,执行这里的代码。dst_mtx[dst_mtx < 0] = 0# 将dst_mtx中所有小于0的值设置为0,以消除负值的影响。k, _, _ = self.eigenDecomposition(dst_mtx)# 使用模型的eigenDecomposition函数对dst_mtx进行特征分解,获取可能的聚类数目。exemplar_bboxes = generated_bboxes# 将生成的边界框generated_bboxes作为初始的样例边界框exemplar_bboxes。mask = None# 初始化掩码变量为None,用于后续筛选操作。if len(k) > 1 or k[0] > 1:# 如果通过特征分解得到的聚类数目大于1,则执行聚类。n_clusters_ = max(k)# 确定聚类的数量为k中的最大值。spectral = SpectralClustering(n_clusters=n_clusters_, affinity='precomputed')# 初始化谱聚类对象,使用预设的亲和矩阵。labels = spectral.fit_predict(dst_mtx)# 对dst_mtx进行聚类预测,labels为聚类标签。correct_class_labels = list(np.unique(np.array(labels[:self.num_objects])))# 获取前self.num_objects个聚类标签,并筛选出不重复的标签列表。for i in range(len(bboxes_p)):# 遍历所有预测的边界框bboxes_p。box = bboxes_p[i]# 如果当前边界框与样例边界框有足够高的交并比(IoU),# 则将对应的聚类标签添加到正确类别标签列表中。if (box_iou(box.unsqueeze(0), bboxes_[:self.num_objects][:, 1:].cpu()) > 0.6).any():correct_class_labels.append(labels[i + self.num_objects])mask = np.in1d(labels, correct_class_labels).reshape(labels.shape)# 根据正确类别标签创建掩码,筛选出属于这些聚类的边界框。exemplar_bboxes = generated_bboxes[mask[self.num_objects:]]# 使用掩码从生成的边界框中筛选出样例边界框。if mask is not None and np.any(mask == False):# 如果掩码已创建,并且掩码中有False值(即不属于任何正确聚类的边界框),# 更新密度图outputR,以反映这些边界框的密度。outputR[0][0] = mask_density(outputR[0], exemplar_bboxes)# 返回模型的输出,包括:# outputR:最终的密度图,# []:这里可能是一个占位符,实际代码中可能需要返回其他信息,# tblr:边界框预测器的输出,# exemplar_bboxes:筛选后的样例边界框。return outputR, [], tblr, exemplar_bboxes- 这段代码是神经网络模型中处理边界框聚类和筛选的一部分,特别是在非零样本学习模式下。

- 首先,通过特征分解确定聚类数目,然后使用谱聚类对边界框进行聚类。

- 根据聚类结果和边界框的IoU关系,筛选出属于正确类别的边界框,并更新样例边界框

exemplar_bboxes。 - 如果聚类结果中包含不属于任何正确聚类的边界框,使用

mask_density函数更新密度图outputR。 - 最终,返回更新后的密度图、边界框预测器的输出和筛选后的样例边界框,这些结果可以用于后续的分析或进一步处理。

return COTR(image_size=args.image_size, # 512num_encoder_layers=args.num_enc_layers, # 3num_decoder_layers=args.num_dec_layers, # 3num_objects=args.num_objects, # 3zero_shot=args.zero_shot, # action='store_true'emb_dim=args.emb_dim, # 256num_heads=args.num_heads, # 8kernel_dim=args.kernel_dim, # 3backbone_name=args.backbone, # default='resnet18'swav_backbone=args.swav_backbone, # action='store_true'train_backbone=args.backbone_lr > 0, # default=0reduction=args.reduction, # default=8dropout=args.dropout, # default=0.1layer_norm_eps=1e-5, # meaning?mlp_factor=8, # meaning?norm_first=args.pre_norm, # action='store_true'activation=nn.GELU, # norm=True, # use_query_pos_emb=args.use_query_pos_emb, # action='store_true'use_objectness=args.use_objectness, # action='store_true'use_appearance=args.use_appearance, # action='store_true'd_s=args.d_s, # default=1.0m_s=args.m_s, # default=0.0i_thr=args.i_thr, # default=0.55 这东西叫啥啊?d_t=args.d_t, # default=3s_t=args.s_t, # default=0.008norm_s=args.norm_s, # action='store_true'egv=args.egv, # default=0.132prompt_shot=args.prompt_shot, # action='store_true'det_train=args.det_train # action='store_true')

这段代码是Python类的构造函数调用,用于创建COTR模型的一个实例。COTR模型可能是一个用于目标检测和计数任务的卷积神经网络,特别是在少样本或零样本学习场景中。以下是每个参数的含义:

image_size: 输入图像的大小,通常是一个正方形尺寸,如512x512。num_encoder_layers: 编码器(Transformer的编码部分)的层数,这里是3层。num_decoder_layers: 解码器(Transformer的解码部分)的层数,这里是3层。num_objects: 模型预期检测的对象数量,这里是3。zero_shot: 是否启用零样本学习模式,即模型是否在没有见过某些类别样本的情况下进行学习。emb_dim: 嵌入维度,用于表示特征的维度大小,这里是256维。num_heads: 注意力机制中的头数,这里是8个头。kernel_dim: 卷积核的尺寸,这里可能是3x3的卷积核。backbone_name: 主干网络的名称,如'resnet18',表示使用ResNet-18作为特征提取的主干网络。swav_backbone: 是否使用SWAV(SwAV Backbone)作为主干网络的一部分。train_backbone: 是否训练主干网络,如果args.backbone_lr大于0,则训练。reduction: 主干网络中的降采样因子,用于减少特征图的空间尺寸。dropout: dropout比率,用于正则化以防止过拟合,这里是0.1。layer_norm_eps: LayerNorm中的epsilon值,用于数值稳定性,这里是1e-5。mlp_factor: MLP(多层感知机)因子,影响MLP层的维度,这里是8。norm_first: 是否先进行归一化再进行激活函数操作。activation: 激活函数,这里使用nn.GELU,即高斯误差线性单元。norm: 是否使用归一化处理。use_query_pos_emb: 是否使用查询位置嵌入。use_objectness: 是否使用对象性估计。use_appearance: 是否使用外观特征。d_s: 用于得分计算的参数,可能与对象性得分有关。m_s: 另一个用于得分计算的参数。i_thr: 非极大值抑制(NMS)的阈值,用于过滤边界框,这里是0.55。d_t: 用于确定密度图中对象检测的密度阈值。s_t: 用于确定边界框大小的阈值。norm_s: 是否对得分进行归一化。egv: 用于特征分解的阈值,可能与聚类分析有关。prompt_shot: 是否启用提示引导学习模式。det_train: 是否训练检测部分。

相关文章:

【扒代码】dave.py

COTR 模型是一个用于少样本或零样本对象检测和计数的神经网络。它结合了特征提取、Transformer 编码器和解码器、密度图预测和边界框预测等多个组件。该模型特别适用于在只有少量标注数据或完全没有标注数据的情况下进行对象检测和计数任务。通过使用 Transformer 架构…...

一个人真正的成熟,体现在这六个字上

你好,我是腾阳。 在这个快节奏、高压力的社会中,我们每个人都在追求成长与进步,渴望成为一个更优秀的自己。 然而,成长的道路从不是一帆风顺,我们时常会面临自我怀疑、挫折感、外界的质疑和内心的挣扎。 但正是这些…...

【已成功EI检索】第五届新材料与清洁能源国际学术会议(ICAMCE 2024)

重要信息 会议官网:2024.icceam.com 接受/拒稿通知:投稿后1周内 收录检索:EI, Scopus 会议召开视频 见刊封面 EI检索页面 Scopus 检索页面 相关会议 第六届新材料与清洁能源国际学术会议(ICAMCE 2025) 大会官网&…...

介绍Python `AsyncIterable` 的使用方法和使用场景

介绍Python AsyncIterable 的使用方法和使用场景 一、什么是 AsyncIterable?二、如何使用 AsyncIterable三、使用场景四、总结 在Python异步编程中,AsyncIterable 是一个非常重要的概念,它代表了一个异步可迭代对象。异步可迭代对象允许我们在…...

抖音直播间通过星图风车跳转到微信小程序

注册并认证巨量星图账号:首先,你需要通过主体公司的资质注册巨量星图账号,并通过审核,以取得申请小风车链接跳转微信组件的资格。 使用链接生成工具:借助链接生成工具,如“省点外链”,生成一条…...

idea 修改背景图片教程

🌏个人博客主页:意疏-CSDN博客 希望文章能够给到初学的你一些启发~ 如果觉得文章对你有帮助的话,点赞 关注 收藏支持一下笔者吧~ 阅读指南: 开篇说明修改背景图片 开篇说明 给小白看得懂的修改图片教程&…...

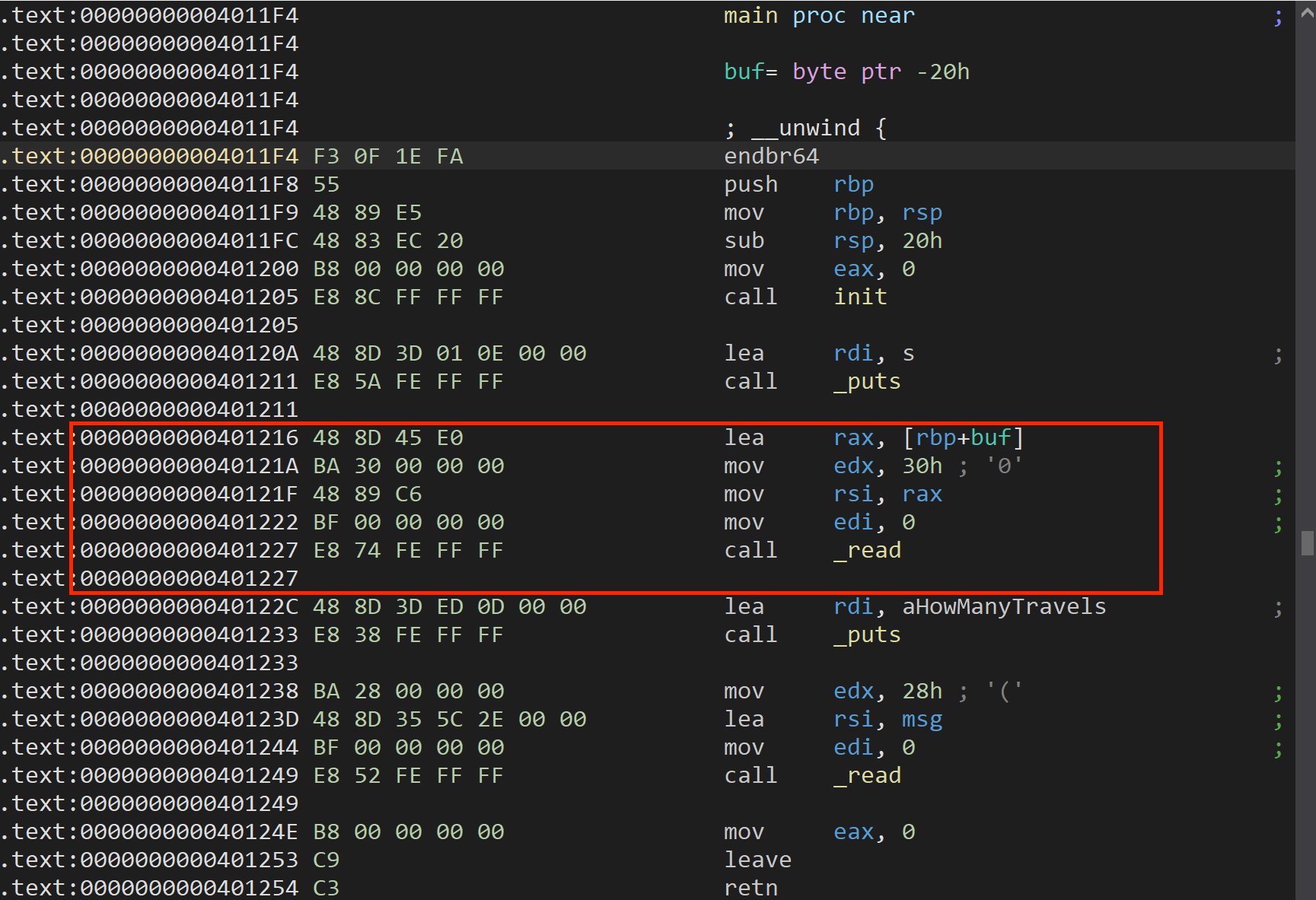

PWN练习---Stack_2

目录 srop源码分析exp putsorsys源码分析exp ret2csu_1源码分析exp traveler源码分析exp srop 题源:[NewStarCTF 2023 公开赛道]srop 考点:SROP 栈迁移 源码 首先从bss段利用 syscall 调用 write 读出数据信息,然后调用 syscall-read向栈中…...

springCloudAlibaba整合log4j2

文章目录 简介log4j2概述log4j2在springCloudAlibaba中的使用排除依赖引入log4j2依赖添加log4j配置文件修改项目配置文件中添加配置 对spring-cloud-alibaba相关组件比较感兴趣的小伙伴,可以看下spring-cloud-alibaba 练习项目 简介 日志主要是记录系统发生的动作&…...

你是如何克服编程学习中的挫折感的

一:心态调整 分解任务:将大的编程任务分解成小的可管理的部分,逐步完成每个部分,逐渐提升自信心。 接受挑战:挑战自己解决一些难题,这样可以提高技能并增强成就感。 寻找资源:利用网络资源、教…...

C++观察者模式:订阅博主~

目录 观察者模式步骤例子:订阅博主UML图1:定义观察者接口2:定义被观察者接口3:创建具体观察者类4:创建具体被观察者类5:使用执行结果 观察者模式 观察者模式允许我们定义一种订阅机制,可在对象…...

1-安装Elasticsearch

支持一览表 | Elastic 未完待续...

EmguCV学习笔记 VB.Net 4.2 二值化

版权声明:本文为博主原创文章,转载请在显著位置标明本文出处以及作者网名,未经作者允许不得用于商业目的。 教程VB.net版本请访问:EmguCV学习笔记 VB.Net 目录-CSDN博客 教程C#版本请访问:EmguCV学习笔记 C# 目录-CSD…...

Spark大数据分析案例

目录 案例概述环境搭建1. Spark单机环境2. Spark集群环境 数据集数据预处理 Spark作业编写提交Spark作业 数据可视化可能遇到的问题及解决方法结论 案例概述 本案例将介绍如何在单机和集群环境下使用Apache Spark进行大数据分析,最终使用Python实现数据的可视化。我…...

【数据结构】关于Java对象比较,以及优先级队列的大小堆创建你了解多少???

前言: 🌟🌟Hello家人们,这期讲解对象的比较,以及优先级队列堆,希望你能帮到屏幕前的你。 🌈上期博客在这里:http://t.csdnimg.cn/MSex7 🌈感兴趣的小伙伴看一看小编主页&…...

HQChart使用教程101-创建内置键盘精灵

HQChart使用教程101-创建内置键盘精灵 键盘精灵步骤1. 创建键盘精灵实例2. 设置事件回调3. 初始化键盘精灵4. 设置码表数据5. 监听"keydown","mousedown" 交流QQ群HQChart代码地址键盘精灵源码 完整实例 键盘精灵 键盘精灵是一种便捷操作软件的功能工具&a…...

nginx基础配置

1. https配置 首先在nginx.conf中配置https 2. 重定向 rewrite ^/(.*)$ https://www.sxl1.com/$1 permanent;3. 自动索引 autoindex on;4. 缓存 Nginx expire缓存配置: 缓存可以降低网站带宽,加速用户访问location ~ .*\.(gif|jpg|png)$ {expires 365d;roo…...

怿星科技与您相约——2024 Testing Expo

汽车测试及质量监控博览会(中国)Testing Expo China-Automotive 怿星科技展位路线 届时欢迎莅临2057号展台!...

mac本地搭建docker+k8s步骤

概览: * kubectl安装 * minikube安装 * dashboard安装 主机配置: * mac M2 (arm架构) 服务及版本概览: 服务名称版本 kubectl v1.29.2 Kubernetes v1.30.0 kicbase v0.0.44 dashboard v2.7.0 docker 26.…...

JS DOM、点击事件

JS DOM 加载事件onload js代码执行的时候,需要html&css的支持 onload在页面加载完之后执行 dom:用JS对html标签进行增删改查 元素节点获取 var name document.getElementById("userName"); var inputs document.getElementsByTagNam…...

预测模型及其Python和MATLAB实现)

长短期记忆网络(LSTM)预测模型及其Python和MATLAB实现

## 一、背景 长短期记忆(Long Short-Term Memory, LSTM)网络是由 Sepp Hochreiter 和 Jrgen Schmidhuber 在 1997 年提出的一种特殊的循环神经网络(RNN)结构。LSTM 旨在解决传统 RNN 在处理长序列数据时常见的梯度消失和梯度爆炸…...

测试微信模版消息推送

进入“开发接口管理”--“公众平台测试账号”,无需申请公众账号、可在测试账号中体验并测试微信公众平台所有高级接口。 获取access_token: 自定义模版消息: 关注测试号:扫二维码关注测试号。 发送模版消息: import requests da…...

生成xcframework

打包 XCFramework 的方法 XCFramework 是苹果推出的一种多平台二进制分发格式,可以包含多个架构和平台的代码。打包 XCFramework 通常用于分发库或框架。 使用 Xcode 命令行工具打包 通过 xcodebuild 命令可以打包 XCFramework。确保项目已经配置好需要支持的平台…...

)

rknn优化教程(二)

文章目录 1. 前述2. 三方库的封装2.1 xrepo中的库2.2 xrepo之外的库2.2.1 opencv2.2.2 rknnrt2.2.3 spdlog 3. rknn_engine库 1. 前述 OK,开始写第二篇的内容了。这篇博客主要能写一下: 如何给一些三方库按照xmake方式进行封装,供调用如何按…...

中南大学无人机智能体的全面评估!BEDI:用于评估无人机上具身智能体的综合性基准测试

作者:Mingning Guo, Mengwei Wu, Jiarun He, Shaoxian Li, Haifeng Li, Chao Tao单位:中南大学地球科学与信息物理学院论文标题:BEDI: A Comprehensive Benchmark for Evaluating Embodied Agents on UAVs论文链接:https://arxiv.…...

深入理解JavaScript设计模式之单例模式

目录 什么是单例模式为什么需要单例模式常见应用场景包括 单例模式实现透明单例模式实现不透明单例模式用代理实现单例模式javaScript中的单例模式使用命名空间使用闭包封装私有变量 惰性单例通用的惰性单例 结语 什么是单例模式 单例模式(Singleton Pattern&#…...

2025 后端自学UNIAPP【项目实战:旅游项目】6、我的收藏页面

代码框架视图 1、先添加一个获取收藏景点的列表请求 【在文件my_api.js文件中添加】 // 引入公共的请求封装 import http from ./my_http.js// 登录接口(适配服务端返回 Token) export const login async (code, avatar) > {const res await http…...

相机从app启动流程

一、流程框架图 二、具体流程分析 1、得到cameralist和对应的静态信息 目录如下: 重点代码分析: 启动相机前,先要通过getCameraIdList获取camera的个数以及id,然后可以通过getCameraCharacteristics获取对应id camera的capabilities(静态信息)进行一些openCamera前的…...

)

论文解读:交大港大上海AI Lab开源论文 | 宇树机器人多姿态起立控制强化学习框架(一)

宇树机器人多姿态起立控制强化学习框架论文解析 论文解读:交大&港大&上海AI Lab开源论文 | 宇树机器人多姿态起立控制强化学习框架(一) 论文解读:交大&港大&上海AI Lab开源论文 | 宇树机器人多姿态起立控制强化…...

C# 类和继承(抽象类)

抽象类 抽象类是指设计为被继承的类。抽象类只能被用作其他类的基类。 不能创建抽象类的实例。抽象类使用abstract修饰符声明。 抽象类可以包含抽象成员或普通的非抽象成员。抽象类的成员可以是抽象成员和普通带 实现的成员的任意组合。抽象类自己可以派生自另一个抽象类。例…...

PL0语法,分析器实现!

简介 PL/0 是一种简单的编程语言,通常用于教学编译原理。它的语法结构清晰,功能包括常量定义、变量声明、过程(子程序)定义以及基本的控制结构(如条件语句和循环语句)。 PL/0 语法规范 PL/0 是一种教学用的小型编程语言,由 Niklaus Wirth 设计,用于展示编译原理的核…...