【机器学习】ID3、C4.5、CART 算法

目录

常见的决策树算法

1. ID3

2. C4.5

3. CART

决策树的优缺点

优点:

缺点:

决策树的优化

常见的决策树算法

1. ID3

ID3(Iterative Dichotomiser 3)算法使用信息增益作为特征选择的标准。它是一种贪心算法,信息增益表示按某特征划分数据集前后信息熵的变化量,变化量越大,表示使用该特征划分的效果越好。但ID3偏向于选择取值较多的特征,可能导致过拟合。

以下是ID3算法的实现步骤:

1. 计算数据集的熵:熵是度量数据集无序程度的指标。

2. 计算每个属性的信息增益:信息增益是数据集的熵减去按照该属性分割后的条件熵。

3. 选择信息增益最大的属性:作为决策节点。

4. 分割数据集:根据选定的属性和它的值,将数据集分割成若干子集。

5. 递归构建决策树:对每个子集重复步骤1-4,直到所有数据都属于同一类别,或者已达到预设的最大深度。

以下是使用Python实现ID3算法的一个简单示例:

import numpy as np

import pandas as pd# 计算熵

def calc_entropy(target_col):entropy = -np.sum([len(target_col[target_col == val]) / len(target_col) * np.log2(len(target_col[target_col == val]) / len(target_col))for val in np.unique(target_col)])return entropy# 按照给定属性分裂数据集

def split_dataset(dataset, index, value):return dataset[dataset.iloc[:, index] == value]# 选择最好的数据集属性

def choose_best_feature_to_split(dataset):num_features = dataset.shape[1] - 1base_entropy = calc_entropy(dataset.iloc[:, -1])best_info_gain = 0.0best_feature = -1for i in range(num_features):feat_list = dataset.iloc[:, i]unique_vals = set(feat_list)new_entropy = 0.0for value in unique_vals:sub_dataset = split_dataset(dataset, i, value)prob = len(sub_dataset) / len(dataset)new_entropy += prob * calc_entropy(sub_dataset.iloc[:, -1])info_gain = base_entropy - new_entropyif info_gain > best_info_gain:best_info_gain = info_gainbest_feature = ireturn best_feature# 构建决策树

def create_tree(dataset, labels):# 检查数据集是否为空if len(dataset) == 0:return None# 检查数据集中的所有目标变量是否相同if len(set(dataset.iloc[:, -1])) <= 1:return dataset.iloc[0, -1]# 检查是否已达到最大深度或者没有更多的特征if len(dataset.columns) == 1 or len(set(dataset.iloc[:, -1])) == 1:return majority_cnt(dataset.iloc[:, -1])# 选择最好的数据集属性best_feat = choose_best_feature_to_split(dataset)best_feat_label = dataset.columns[best_feat]my_tree = {best_feat_label: {}}del(dataset[:, best_feat])unique_vals = set(dataset.iloc[:, -1])for value in unique_vals:sub_labels = best_feat_label + "_" + str(value)my_tree[best_feat_label][value] = create_tree(split_dataset(dataset, best_feat, value), sub_labels)return my_tree# 找到出现次数最多的目标变量值

def majority_cnt(class_list):class_count = {}for vote in class_list:if vote not in class_count.keys():class_count[vote] = 1else:class_count[vote] += 1sorted_class_count = sorted(class_count.items(), key=lambda item: item[1], reverse=True)return sorted_class_count[0][0]# 加载数据集

dataset = pd.read_csv("your_dataset.csv") # 替换为你的数据集路径

labels = dataset.iloc[:, -1].name

dataset = dataset.iloc[:, 0:-1] # 特征数据# 创建决策树

my_tree = create_tree(dataset, labels)

print(my_tree)注:这个实现是为了教学目的而简化的,实际应用中通常会使用更高级的库和算法,如 scikit-learn 中的 DecisionTreeClassifier。

2. C4.5

C4.5是ID3的改进版,使用信息增益比替代信息增益作为特征选择标准,从而克服了ID3倾向于选择多值特征的缺点。此外,C4.5还能处理连续型特征和缺失值。

实现C4.5算法可以通过多种编程语言,但这里我将提供一个简化的Python实现,使用Python的基本库来构建决策树。这个实现将包括计算信息熵、信息增益、信息增益比,并基于这些度量来构建决策树。

1. 计算信息熵

信息熵是度量数据集无序程度的指标,计算公式为:

![]()

其中 pi 是第 i 个类别的样本在数据集中的比例。

2. 计算信息增益

信息增益是度量在知道特征 A 的条件下,数据集 S 的熵减少的程度。计算公式为:

![]()

其中 Sv 是特征 A 值为 v 时的子集。

3. 计算信息增益比

信息增益比是信息增益与特征 A 的固有信息的比值,计算公式为:

![]()

其中,分裂信息 Split Information(S, A) 是度量特征 A 的值分布的熵:

![]()

4. 构建决策树

使用以上计算方法,我们可以构建一个简单的C4.5决策树:

import numpy as np

import pandas as pddef entropy(target_col):elements, counts = np.unique(target_col, return_counts=True)probabilities = counts / counts.sum()return -np.sum(probabilities * np.log2(probabilities))def information_gain(data, feature, target):total_entropy = entropy(data[target])values = data[feature].unique()weighted_entropy = 0.0for value in values:sub_data = data[data[feature] == value]weighted_entropy += (len(sub_data) / len(data)) * entropy(sub_data[target])return total_entropy - weighted_entropydef gain_ratio(data, feature, target):ig = information_gain(data, feature, target)split_info = entropy(data[feature])return ig / split_info if split_info != 0 else 0def choose_best_feature_to_split(data, features, target):best_feature = Nonemax_gain_ratio = -1for feature in features:gain_ratio_value = gain_ratio(data, feature, target)if gain_ratio_value > max_gain_ratio:max_gain_ratio = gain_ratio_valuebest_feature = featurereturn best_featuredef c45(data, features, target, tree=None, depth=0):if len(data[target].unique()) == 1:return data[target].mode()[0]if depth == 0:depth = 0elif depth > 10: # Limit the depth to avoid overfittingreturn data[target].mode()[0]best_feat = choose_best_feature_to_split(data, features, target)if best_feat is None:return data[target].mode()[0]if len(data[best_feat].unique()) == 1:return data[target].mode()[0]tree = tree if tree else {best_feat: {}}unique_vals = data[best_feat].unique()for value in unique_vals:subtree = c45(data[data[best_feat] == value], features, target, tree=tree, depth=depth+1)tree[best_feat][value] = subtreereturn tree# Example usage

data = pd.DataFrame({'Outlook': ['Sunny', 'Sunny', 'Overcast', 'Rain', 'Rain', 'Rain', 'Overcast', 'Sunny', 'Sunny', 'Rain', 'Sunny', 'Overcast', 'Overcast', 'Rain'],'Temperature': ['Hot', 'Hot', 'Hot', 'Mild', 'Cool', 'Cool', 'Cool', 'Mild', 'Cool', 'Mild', 'Mild', 'Mild', 'Hot', 'Mild'],'Humidity': ['High', 'High', 'High', 'High', 'Normal', 'Normal', 'Normal', 'High', 'Normal', 'Normal', 'Normal', 'High', 'Normal', 'High'],'Wind': ['Weak', 'Strong', 'Weak', 'Weak', 'Weak', 'Strong', 'Strong', 'Weak', 'Weak', 'Weak', 'Strong', 'Strong', 'Weak', 'Strong'],'PlayTennis': ['No', 'No', 'Yes', 'Yes', 'Yes', 'No', 'Yes', 'No', 'Yes', 'Yes', 'Yes', 'Yes', 'Yes', 'No']

})features = ['Outlook', 'Temperature', 'Humidity', 'Wind']

target = 'PlayTennis'tree = c45(data, features, target)

print(tree)注:这个实现是一个简化版,没有包括剪枝和处理连续变量的步骤。在实际应用中,你可能需要使用更复杂的数据结构和算法来优化性能和处理更复杂的情况。

3. CART

CART(分类与回归树)是一种既能用于分类也能用于回归的决策树算法。对于分类问题,CART使用基尼不纯度作为特征选择标准;对于回归问题,则使用方差作为分裂标准。CART构建的是二叉树,每个内部节点都是二元分裂。

以下是CART算法的基本步骤:

1. 选择最佳分割特征和分割点:使用基尼不纯度(Gini impurity)或均方误差(Mean Squared Error, MSE)作为分割标准,选择能够最大程度降低不纯度的特征和分割点。

2. 分割数据集:根据选定的特征和分割点,将数据集分割成两个子集。

3. 递归构建:对每个子集重复步骤1和2,直到满足停止条件(如达到最大深度、节点中的样本数量低于阈值或无法进一步降低不纯度)。

4. 剪枝:通过剪掉树的某些部分来简化树,以防止过拟合。

以下是一个简化的Python实现CART算法,使用基尼不纯度作为分割标准:

import numpy as np

import pandas as pddef gini_impurity(y):class_probabilities = y.mean(axis=0)return 1 - np.sum(class_probabilities ** 2)def best_split(data, target_column, features):best_feature = Nonebest_threshold = Nonebest_gini = float('inf')for feature in features:for idx in np.unique(data[feature]):threshold = (data[feature] < idx).mean()split_data = data[data[feature] < idx]gini = (len(data) - len(split_data)) / len(data) * gini_impurity(split_data[target_column]) + \len(split_data) / len(data) * gini_impurity(data[(data[target_column] == target_column.mode())[data[target_column] >= idx]][target_column])if gini < best_gini:best_gini = ginibest_feature = featurebest_threshold = thresholdreturn best_feature, best_thresholddef build_tree(data, target_column, features, depth=0, max_depth=None):if max_depth is None:max_depth = np.infif len(data[target_column].unique()) == 1 or len(data) == 1 or depth >= max_depth:return data[target_column].mode()[0]best_feature, best_threshold = best_split(data, target_column, features)tree = {best_feature: {}}features = [f for f in features if f != best_feature]split_function = lambda x: x[best_feature] < best_thresholdleft_indices = np.array([bool(split_function(row)) for row in data.itertuples()])right_indices = np.array([not bool(split_function(row)) for row in data.itertuples()])left_data = data[left_indices]right_data = data[right_indices]if not left_data.empty:tree[best_feature][0] = build_tree(left_data, target_column, features, depth+1, max_depth)if not right_data.empty:tree[best_feature][1] = build_tree(right_data, target_column, features, depth+1, max_depth)return tree# Example usage

data = pd.DataFrame({'Feature1': [1, 2, 4, 6, 8, 10],'Feature2': [2, 4, 6, 8, 10, 12],'Target': ['Yes', 'No', 'Yes', 'No', 'Yes', 'No']

})features = ['Feature1', 'Feature2']

target_column = 'Target'tree = build_tree(data, target_column, features)

print(tree)注:这个实现是一个简化的版本,没有包括剪枝步骤。在实际应用中,你可能需要使用更复杂的数据结构和算法来优化性能和处理更复杂的情况。此外,对于回归问题,需要使用均方误差(MSE)而不是基尼不纯度作为分割标准。

在实践中,通常会使用像scikit-learn这样的机器学习库来构建CART树,因为它们提供了更高效和更可靠的实现。例如,scikit-learn中的DecisionTreeClassifier和DecisionTreeRegressor类实现了CART算法。

决策树的优缺点

优点:

- 易于理解和解释。

- 可以处理数值和类别数据。

- 不需要数据标准化。

- 可以可视化。缺点:

- 容易过拟合。

- 对于某些数据集,构建的树可能非常大。

- 对于缺失数据敏感。决策树的优化

- 剪枝:通过减少树的大小来减少过拟合。

- 集成方法:如随机森林和梯度提升树,可以提高模型的泛化能力。

执笔至此,感触彼多,全文将至,落笔为终,感谢各位读者的支持,如果对你有所帮助,还请一键三连支持我,我会持续更新创作。

相关文章:

【机器学习】ID3、C4.5、CART 算法

目录 常见的决策树算法 1. ID3 2. C4.5 3. CART 决策树的优缺点 优点: 缺点: 决策树的优化 常见的决策树算法 1. ID3 ID3(Iterative Dichotomiser 3)算法使用信息增益作为特征选择的标准。它是一种贪心算法,信…...

UE5: Content browser工具编写02

DebugHeader.h 中的全局变量,已经在一个cpp file中被include了,如果在另一个cpp file中再include它,就会有一些conflicts。先全部给加一个static Add static keyword to debug functionsWrap all the functions inside of a namespaceprint …...

【ARM】MDK-当选择AC5时每次点击build都会全编译

【更多软件使用问题请点击亿道电子官方网站】 1、 文档目标 解决MDK中选择AC5时每次点击build都会全编译 2、 问题场景 在MDK中点击build时,正常会只进行增量编译,但目前每次点击的时候都会全编译。 3、软硬件环境 1 软件版本:Keil MDK 5.…...

使用ESPnet的 setup_anaconda.sh安装脚本一步到位,配置conda虚拟环境

使用ESPnet的 setup_anaconda.sh 安装脚本一步到位,配置conda虚拟环境 前言 ESPnet(End-to-End Speech Processing Toolkit)是一款用于语音识别、语音合成等任务的开源端到端语音处理工具包。为了在不同系统上快速配置ESPnet开发环境&#…...

9、论文阅读:无监督的感知驱动深水下图像增强

Perception-Driven Deep Underwater Image Enhancement Without Paired Supervision 前言引言相关工作UIE模型基于非物理模型基于物理模型基于深度学习质量度量在图像增强中的应用方法论问题表述PQR模型PDD网络生成器损失函数实验Enhancement Without Paired Supervision) 前言…...

谷歌收录查询工具,使用谷歌收录查询工具查询网站收录情况并优化内容的详细步骤

在数字营销和SEO领域,了解网站在谷歌搜索引擎中的收录情况至关重要。使用谷歌收录查询工具,可以有效地监测网站的索引状态,进而优化内容以提升网站排名和曝光度。以下是如何使用谷歌收录查询工具查询网站收录情况并优化内容的详细步骤&#x…...

代理中长效的长板在哪里

伙伴们,之前咱们讨论过了短效代理的用途,那么今天我们来聊一聊长效代理的多元化用途,大家也可以对比一下它们的区别,根据自身的需求针对性地去选择合适的哦。 在企业的网络安全保卫战中,长效代理像是一座坚不可摧的钢…...

VS code Jupyter notebook 导入文件目录问题

VS code Jupyter notebook 导入文件目录问题 引言正文引言 这几天被 VS code 中 Jupyter Notebook 中的文件导入折磨的死去活来。这里特来说明一下放置于不同文件夹下的模块该如何被导入。 正文 首先,我们需要按下 Ctrl + , 键打开设置,然后搜索 notebook file root。在如…...

【IDEA】将光标移动到您上一次编辑的地方

将光标移动到您上一次编辑的地方 使用 ctl <-- 似乎是回到上一个文件而 ctl shift Backspace 是回到上一次的光标,似乎更有用一些。Backspace 是删除按键,要非常小心。 快捷键快速回退到上一次编辑的位置 在 IntelliJ IDEA 中,您可以…...

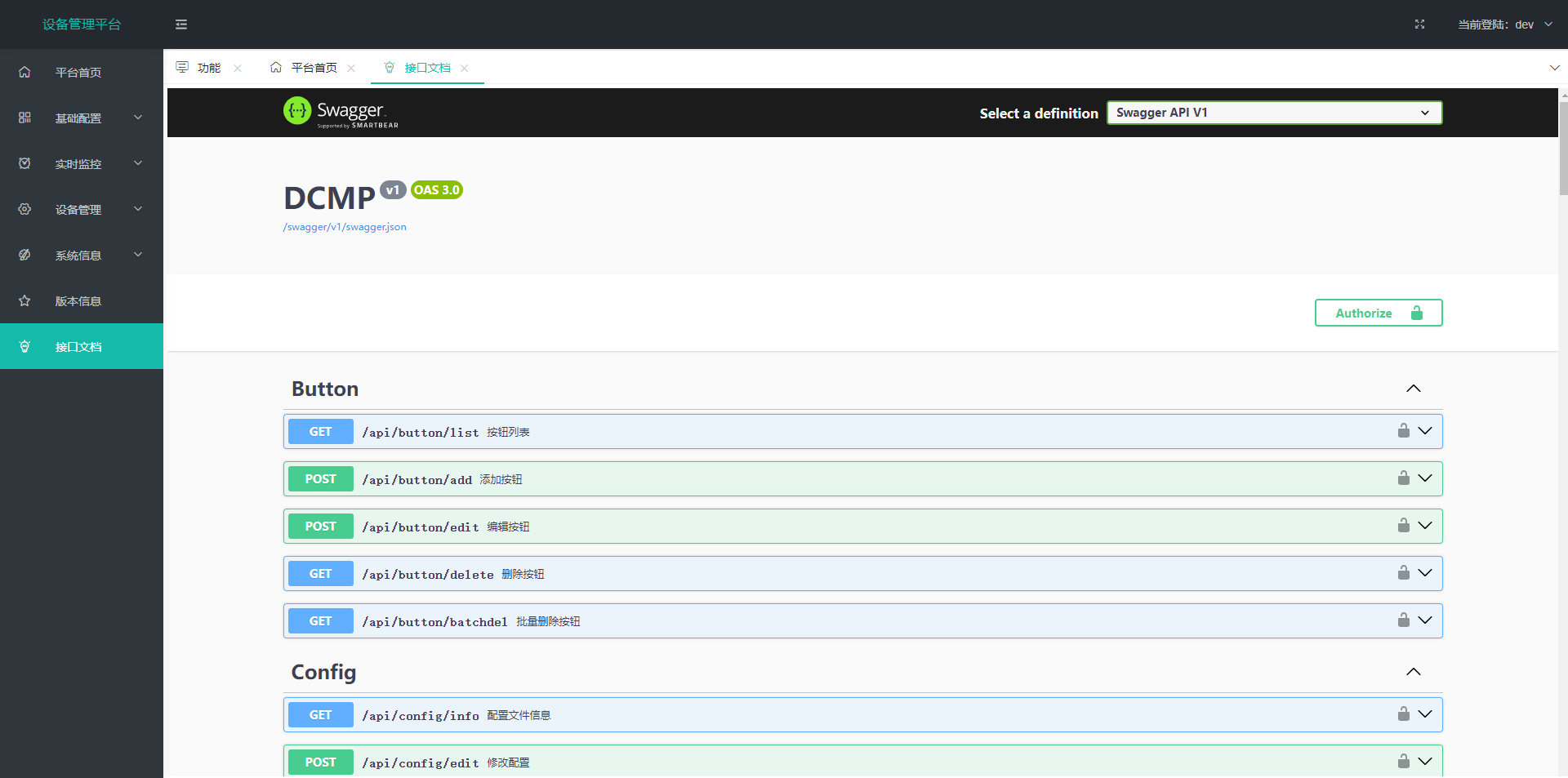

设备管理平台-支持快速开发

技术路线(同时支持前后端分离 / 前后端一体,可用于网关或者服务器部署) 前端:layui-v2.9.17 后端:Net8.0 使用组件 Swagger、Jwt、Freesql、MiniExcel、MemoryCache(存储登录用户信息,代替HttpContext.S…...

Vue项目开发注意事项

事项一:项目代码放在本地怎么运行起来 1、首先确定项目对应的node和npm版本 node下载地址 Index of /dist/https://nodejs.org/dist/ node 与 npm版本对应关系 Node.js — Node.js Releases 2、node卸载的时候,会自动把对应的npm卸载掉 情况1&…...

Vivado时序报告之CDC详解大全

目录 一、前言 二、Report CDC 2.1 Report CDC 2.2 配置界面 2.3 CDC报告 2.3.1 General Information 2.3.2 Summary 2.3.3 CDC Details 2.4 Waiver 2.4.1 设置Waiver 2.4.2 报告查看 2.4.3 去除Waiver设置 三、工程设计 四、参考资料 一、前言 前面已经针对…...

【研赛A题成品论文】24华为杯数学建模研赛A题成品论文+可运行代码丨免费分享

2024华为杯研究生数学建模竞赛A题精品成品论文已出! A题 风电场有功功率优化分配 一、问题分析 A题是一道工程建模与优化类问题,其目的是根据题目所给的附件数据资料分析风机主轴及塔架疲劳损伤程度,以及建立优化模型求解最优有功功率分配…...

华为OD机试 - 小明的幸运数(Python/JS/C/C++ 2024 E卷 100分)

华为OD机试 2024E卷题库疯狂收录中,刷题点这里 专栏导读 本专栏收录于《华为OD机试真题(Python/JS/C/C)》。 刷的越多,抽中的概率越大,私信哪吒,备注华为OD,加入华为OD刷题交流群,…...

嵌入式学习——进程间通信方式(3)—— 共享内存

一、基本概念 什么是共享内存,顾名思义,就是将共享一片内存空间,共享内存允许多个不同的进程访问同一片内存空间。他们对这个内存直接进行操作,不需要经过内核的处理,因此共享内存是IPC通信方式中效率最高的。那如何实…...

python开发讯飞星火

一、讯飞星火网址 星火认知大模型Web API文档 | 讯飞开放平台文档中心 二、pycharm安装 pip3 install --upgrade spark_ai_python...

)

自然语言处理(jieba库分词)

1、完全切分法、正向最大匹配算法、逆向最大匹配算法和双向最大匹配算法 一、实验内容 一个好的NLP系统一定要有完备的词典,用于判断算法分出的词是否是具有实际意义的词。自定义一个词典,比如dic ["项目", "研究", "目的&q…...

)

MYSQL-查看函数创建语句语法(五)

SHOW CREATE FUNCTION 语句 SHOW CREATE FUNCTION func_name此语句类似于 SHOW CREATE PROCEDURE 的方法,但用于存储过程。 mysql> show create function world.sum \G *************************** 1. row ***************************Function: sumsql_mode:…...

图解IRF

FW1 配置思路 ① 配置IRF优先级 确认设备的主次 ② 设置批量操作的接口方便后续操作 interface range name fw-irf interface GigabitEthernet1/0/2 to GigabitEthernet1/0/3 ③ 接口 showdown 关闭接口 ④ 创建的IRF 1/1 成员的对应的接口的是 GE1/0/2 GE/1/0/3 ⑤ 开放IRF对…...

关于Chrome浏览器F12调试,显示未连接到互联网的问题

情况说明 最近笔者更新下电脑的Chrome浏览器,在调试前端代码的时候,遇到下面一个情况: 发现打开调试面板后,页面上显示未连接到互联网,但实际电脑网络是没有问题的,关闭调试面板后,网页又能正…...

浅谈 React Hooks

React Hooks 是 React 16.8 引入的一组 API,用于在函数组件中使用 state 和其他 React 特性(例如生命周期方法、context 等)。Hooks 通过简洁的函数接口,解决了状态与 UI 的高度解耦,通过函数式编程范式实现更灵活 Rea…...

挑战杯推荐项目

“人工智能”创意赛 - 智能艺术创作助手:借助大模型技术,开发能根据用户输入的主题、风格等要求,生成绘画、音乐、文学作品等多种形式艺术创作灵感或初稿的应用,帮助艺术家和创意爱好者激发创意、提高创作效率。 - 个性化梦境…...

React 第五十五节 Router 中 useAsyncError的使用详解

前言 useAsyncError 是 React Router v6.4 引入的一个钩子,用于处理异步操作(如数据加载)中的错误。下面我将详细解释其用途并提供代码示例。 一、useAsyncError 用途 处理异步错误:捕获在 loader 或 action 中发生的异步错误替…...

CTF show Web 红包题第六弹

提示 1.不是SQL注入 2.需要找关键源码 思路 进入页面发现是一个登录框,很难让人不联想到SQL注入,但提示都说了不是SQL注入,所以就不往这方面想了 先查看一下网页源码,发现一段JavaScript代码,有一个关键类ctfs…...

【人工智能】神经网络的优化器optimizer(二):Adagrad自适应学习率优化器

一.自适应梯度算法Adagrad概述 Adagrad(Adaptive Gradient Algorithm)是一种自适应学习率的优化算法,由Duchi等人在2011年提出。其核心思想是针对不同参数自动调整学习率,适合处理稀疏数据和不同参数梯度差异较大的场景。Adagrad通…...

2025 后端自学UNIAPP【项目实战:旅游项目】6、我的收藏页面

代码框架视图 1、先添加一个获取收藏景点的列表请求 【在文件my_api.js文件中添加】 // 引入公共的请求封装 import http from ./my_http.js// 登录接口(适配服务端返回 Token) export const login async (code, avatar) > {const res await http…...

网络编程(UDP编程)

思维导图 UDP基础编程(单播) 1.流程图 服务器:短信的接收方 创建套接字 (socket)-----------------------------------------》有手机指定网络信息-----------------------------------------------》有号码绑定套接字 (bind)--------------…...

Java + Spring Boot + Mybatis 实现批量插入

在 Java 中使用 Spring Boot 和 MyBatis 实现批量插入可以通过以下步骤完成。这里提供两种常用方法:使用 MyBatis 的 <foreach> 标签和批处理模式(ExecutorType.BATCH)。 方法一:使用 XML 的 <foreach> 标签ÿ…...

在Mathematica中实现Newton-Raphson迭代的收敛时间算法(一般三次多项式)

考察一般的三次多项式,以r为参数: p[z_, r_] : z^3 (r - 1) z - r; roots[r_] : z /. Solve[p[z, r] 0, z]; 此多项式的根为: 尽管看起来这个多项式是特殊的,其实一般的三次多项式都是可以通过线性变换化为这个形式…...

4. TypeScript 类型推断与类型组合

一、类型推断 (一) 什么是类型推断 TypeScript 的类型推断会根据变量、函数返回值、对象和数组的赋值和使用方式,自动确定它们的类型。 这一特性减少了显式类型注解的需要,在保持类型安全的同时简化了代码。通过分析上下文和初始值,TypeSc…...