huggingface实现中文文本分类

目录

1 自定义数据集

2 分词

2.1 重写collate_fn方法¶

3 用BertModel加载预训练模型

4 模型试算

5 定义下游任务¶

6 训练

7 测试

#导包

import torch

from datasets import load_from_disk #用于加载本地磁盘的datasets文件1 自定义数据集

#自定义数据集

#需要继承 torch.utils.data.Dataset,

#并且实现__init__(self)/__len__(self)/__getitem__(self,i)这些方法

class Dataset(torch.utils.data.Dataset):def __init__(self, split):#加载本地磁盘的datasetsself.datasets = load_from_disk('../data/ChnSentiCorp') #self.datasets是一个字典,包含训练、校验、测试的datatsetself.dataset = self.datasets[split] #使用split来区分获取的是训练、校验、测试的datatset中的哪一个def __len__(self):return len(self.dataset)def __getitem__(self, i):"""让数据集像列表一样可以根据索引获取数据‘text’与“label”"""text = self.dataset[i]['text']label = self.dataset[i]['label']return text, labeldataset = Dataset(split='train')

dataset

<__main__.Dataset at 0x2afb31f03a0>

dataset.dataset

Dataset({features: ['text', 'label'],num_rows: 9600 })

len(dataset)9600

dataset[0]

('选择珠江花园的原因就是方便,有电动扶梯直接到达海边,周围餐馆、食廊、商场、超市、摊位一应俱全。酒店装修一般,但还算整洁。 泳池在大堂的屋顶,因此很小,不过女儿倒是喜欢。 包的早餐是西式的,还算丰富。 服务吗,一般',1)

2 分词

#分词工具导包

from transformers import BertTokenizer#加载字典和分词工具 huggingface自带的中文词典bert-base-chinese加载进来

tokenizer = BertTokenizer.from_pretrained(r'../data/bert-base-chinese/')

tokenizer

BertTokenizer(name_or_path='../data/bert-base-chinese/', vocab_size=21128, model_max_length=512, is_fast=False, padding_side='right', truncation_side='right', special_tokens={'unk_token': '[UNK]', 'sep_token': '[SEP]', 'pad_token': '[PAD]', 'cls_token': '[CLS]', 'mask_token': '[MASK]'}, clean_up_tokenization_spaces=True), added_tokens_decoder={0: AddedToken("[PAD]", rstrip=False, lstrip=False, single_word=False, normalized=False, special=True),100: AddedToken("[UNK]", rstrip=False, lstrip=False, single_word=False, normalized=False, special=True),101: AddedToken("[CLS]", rstrip=False, lstrip=False, single_word=False, normalized=False, special=True),102: AddedToken("[SEP]", rstrip=False, lstrip=False, single_word=False, normalized=False, special=True),103: AddedToken("[MASK]", rstrip=False, lstrip=False, single_word=False, normalized=False, special=True), }

2.1 重写collate_fn方法¶

自定义取数据的方法

def collate_fn(data):#从传入的数据集data(dataset)中分离出文本句子sents和标签labelssents = [i[0] for i in data]labels = [i[1] for i in data]#编码:完成句子的分词操作data = tokenizer.batch_encode_plus(batch_text_or_text_pairs=sents,truncation=True, #文本超过最大长度会被截断padding='max_length', #不足最大长度,补充《pad》return_tensors='pt', #返回的数据是pythorch类型return_length='True')#获取编码之后的数字 索引input_ids = data['input_ids']attention_mask = data['attention_mask']token_type_ids = data['token_type_ids']labels = torch.LongTensor(labels) #labels在pythorch中一般设置成long类型return input_ids, attention_mask, token_type_ids, labels#创建数据加载器

loader = torch.utils.data.DataLoader(dataset=dataset, #将数据集传进来batch_size=16, #一批数据16个collate_fn=collate_fn, #传入自定义的取数据的方法shuffle=True, #打乱数据drop_last=True #最后一批数据若不满足16个数据,就删除

)for i, (input_ids, attention_mask, token_type_ids, labels) in enumerate(loader):break #只完成赋值,不输出打印print(len(loader))600

print(input_ids.shape, attention_mask.shape, token_type_ids.shape, labels.shape)

torch.Size([16, 512]) torch.Size([16, 512]) torch.Size([16, 512]) torch.Size([16])

3 用BertModel加载预训练模型

#Bert模型导包

from transformers import BertModel#加载预训练模型

pretrained = BertModel.from_pretrained('../data/bert-base-chinese/')#固定bert的参数: 遍历参数,修改每一个参数的requires_grad_,使其不能进行求导、梯度下降

for param in pretrained.parameters():param.requires_grad_(False) #变量最右边添加下划线,表示直接修改变量的原始属性4 模型试算

out = pretrained(input_ids=input_ids, attention_mask=attention_mask, token_type_ids=token_type_ids)out.last_hidden_state.shape

#torch.Size([16, 512, 768])

#16:一批数据有16个

#512:一个句子的长度

#768:yincan#torch.Size([16, 512, 768])out.last_hidden_state[:, 0].shape #获取cls特殊词的输出结果#torch.Size([16, 768])5 定义下游任务¶

class Model(torch.nn.Module):def __init__(self, pretrained_model):super().__init__()#预训练模型层self.pretrained_model = pretrained_model#输出层:全连接层#768:表示将上一层预训练模型层768个的输出结果作为全连接层的输入数据#2:表示二分类问题就会有两个输出结果self.fc = torch.nn.Linear(768, 2)#前向传播def forward(self, input_ids, attention_mask, token_type_ids):with torch.no_grad():out = pretrained(input_ids=input_ids, attention_mask=attention_mask, token_type_ids=token_type_ids)#在Bert中,获取cls特殊词的输出结果来做分类任务out = self.fc(out.last_hidden_state[:, 0])out.softmax(dim=1)return out#声明模型

model = Model(pretrained)

#创建模型:输入参数

model(input_ids=input_ids, attention_mask=attention_mask, token_type_ids=token_type_ids).shape#torch.Size([16, 2]) 16个句子对,2个分类结果torch.Size([16, 2])

torch.cuda.is_available()True

#设置设备

device = torch.device('cuda:0' if torch.cuda.is_available() else 'cpu')

devicedevice(type='cuda', index=0)

6 训练

# AdamW 梯度下降的优化算法 在Adam的基础上稍微改进了一点

from transformers import AdamW #训练

optimizer = AdamW(model.parameters(), lr=5e-4) #设置优化器

#声明损失函数

loss = torch.nn.CrossEntropyLoss()#建模

model = Model(pretrained)

#模型训练

model.train()

#将模型传到设备上

model.to(device)

for i, (input_ids, attention_mask, token_type_ids, labels) in enumerate(loader):#把传入的数据都传到设备上input_ids = input_ids.to(device)attention_mask = attention_mask.to(device)token_type_ids = token_type_ids.to(device)labels = labels.to(device)out = model(input_ids=input_ids, attention_mask=attention_mask, token_type_ids=token_type_ids)#计算损失函数l = loss(out, labels) #out:预测值 labels:真实值#用损失函数来反向传播l.backward()#梯度更新optimizer.step()#梯度清零optimizer.zero_grad()#每隔5次,计算一下准确率if i % 5 == 0:out = out.argmax(dim=1) #计算预测值#计算准确率accuracy =(out == labels).sum().item() / len(labels) #item()是拿到求和之后的数字print(i, l.item(), accuracy)if i == 100:break

0 0.6882429718971252 0.5 5 0.7822732329368591 0.3125 10 0.7996063828468323 0.25 15 0.7967076301574707 0.3125 20 0.839418888092041 0.3125 25 0.6795901656150818 0.5625 30 0.7707732319831848 0.3125 35 0.6784831285476685 0.4375 40 0.728607177734375 0.375 45 0.7425007224082947 0.375 50 0.6188052892684937 0.5625 55 0.7185056805610657 0.375 60 0.8377469778060913 0.1875 65 0.7717736959457397 0.3125 70 0.7421607375144958 0.4375 75 0.7337921857833862 0.375 80 0.8023619651794434 0.3125 85 0.7294195890426636 0.5625 90 0.7909258008003235 0.3125 95 0.7105788588523865 0.4375 100 0.7786014676094055 0.5

7 测试

model.eval()用于将模型设置为评估模式。 在评估模式下,模型将关闭一些在训练过程中使用的特性,如Dropout和BatchNorm层的训练模式,以确保模型在推理时能够给出准确的结果。使用model.eval()可以帮助我们更好地评估模型的性能,并发现潜在的问题。

def test():model.eval()correct = 0total = 0loader_test = torch.utils.data.DataLoader(dataset = Dataset('validation'),batch_size = 32,collate_fn=collate_fn,shuffle=True,drop_last=True)for i, (input_ids, attention_mask, token_type_ids, labels) in enumerate(loader_test):#输入的数据传入到设备上input_ids = input_ids.to(device)attention_mask = attention_mask.to(device)token_type_ids = token_type_ids.to(device)labels = labels.to(device)if i == 5:breakprint(i)with torch.no_grad():out = model(input_ids=input_ids, attention_mask=attention_mask, token_type_ids=token_type_ids)out = out.argmax(dim=1)correct += (out==labels).sum().item()total += len(labels)print(correct / total)

test()

0 1 2 3 4 0.40625

相关文章:

huggingface实现中文文本分类

目录 1 自定义数据集 2 分词 2.1 重写collate_fn方法 3 用BertModel加载预训练模型 4 模型试算 5 定义下游任务 6 训练 7 测试 #导包 import torch from datasets import load_from_disk #用于加载本地磁盘的datasets文件 1 自定义数据集 #自定义数据集 #…...

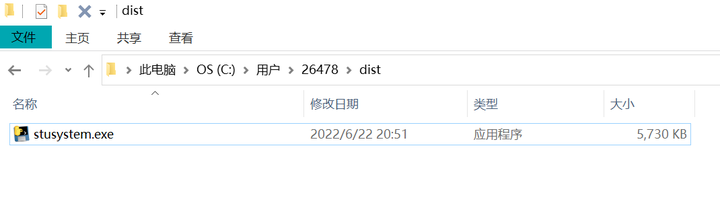

基于python+控制台+txt文档实现学生成绩管理系统(含课程实训报告)

目录 第一章 需求分析 第二章 系统设计 2.1 系统功能结构 2.1.1 学生信息管理系统的七大模块 2.1.2 系统业务流程 2.2 系统开发必备环境 第三章 主函数设计 3.1 主函数界面运行效果图 3.2 主函数的业务流程 3.3 函数设计 第四章 详细设计及实现 4.1 学生信息录入模块的设计与实…...

Spring Boot 整合MyBatis-Plus 实现多层次树结构的异步加载功能

文章目录 1,前言2,什么是多层次树结构?3,异步加载的意义4,技术选型与实现思路5,具体案例5.1,项目结构5.2,项目配置(pom.xml)5.3,配置文件…...

网络工程师指南:防火墙配置与管理命令大全,零基础入门到精通,收藏这一篇就够了

本指南详细介绍了防火墙的配置与管理命令,涵盖了防火墙的工作原理、常见配置命令、安全策略与访问控制、日志管理与故障排查,并通过实战案例展示了如何有效防御网络攻击。通过学习本指南,网络工程师能够系统掌握防火墙的配置与管理技能&#…...

英特尔终于找到了Raptor Lake处理器崩溃与不稳定问题的根源

技术背景 在过去的几个月里,一些用户报告称他们的第13代和第14代Intel Core“Raptor Lake”处理器遇到了系统崩溃和不稳定的情况。这些问题最初在2024年7月底被英特尔识别出来,并且初步的诊断显示,这些问题与微码有关,该微码使CP…...

Shp2pb:Shapefile转Protocol Buffers的高效工具

Shp2pb是一个实用工具,专门用于将Shapefile(shp)格式转换为Protocol Buffers(protobuf)文件。这对于以更高效、更紧凑的方式处理地理数据特别有用。以下是关于如何安装和使用Shp2pb工具的详细说明,以及一个…...

Elasticsearch使用Easy-Es + RestHighLevelClient实现深度分页跳页

注意!!!博主只在测试环境试了一下,没有发到生产环境跑。因为代码还没写完客户说不用弄了( •̩̩̩̩_•̩̩̩̩ ) 也好,少个功能少点BUG 使用from size的时候发现存在max_result_window10000的限制&…...

基于ASRPRO的语音应答

做这个的起因是为了送女朋友,而且这东西本身很简单,所以在闲暇之余尝试了一下。 这个工程很简单,只通过对ASRPRO进行编程即可。 先看效果。(没有展示所有效果,后续会列出来所有对话触发) 语音助手示例1 语音助手示例2 代码部分使用天文Block编辑,找了一圈好像只…...

3D看车汽车案例,车模一键换皮肤,开关车门,轴距,电池功能

3D 汽车案例 网址: http://car.douchuanwei.com/...

数据结构-4.栈与队列

本篇博客给大家带来的是栈和队列的知识点, 其中包括两道面试OJ题 用队列实现栈 和 用栈实现队列. 文章专栏: Java-数据结构 若有问题 评论区见 欢迎大家点赞 评论 收藏 分享 如果你不知道分享给谁,那就分享给薯条, 如果分享不成功, 那我就会回你一下,那样你就分享成功啦. 你们的…...

芝士AI写作有什么特色? 大模型支撑,智能改写续写,让写作更轻松

又到了一年的毕业季,大学四年眨眼间匆匆就过去了,毕业,求职,考研,工作,升学,但是在这之前,我们必须要完成论文的写作,这也是每一位大学生都必须要面对~ 芝士AI官网&…...

【计网】从零开始学习http协议 --- http的请求与应答

如果你不能飞,那就跑; 如果跑不动,那就走; 实在走不了,那就爬。 无论做什么,你都要勇往直前。 --- 马丁路德金 --- 从零开始学习http协议 1 什么是http协议2 认识URL3 http的请求和应答3.1 服务端设计…...

记录linux环境下搭建本地MQTT服务器实现mqtt的ssl加密通讯

1、ubuntu安装mosquitto sudo apt-get update//安装服务端 sudo apt-get install mosquitto//安装客户端 sudo apt-get install mosquitto-clients 2、安装openssl 3、mqtts/tls加密传输 mosquitto原生支持了TLS加密,TLS(传输层安全)是SSL&…...

基于python+django+vue的电影数据分析及可视化系统

作者:计算机学姐 开发技术:SpringBoot、SSM、Vue、MySQL、JSP、ElementUI、Python、小程序等,“文末源码”。 专栏推荐:前后端分离项目源码、SpringBoot项目源码、Vue项目源码、SSM项目源码 精品专栏:Java精选实战项目…...

HJ50-四则运算:栈的运用、中缀表达式转后缀表达式并计算结果

文章目录 题目一、分析1.1表达式预处理1.2中缀表达式转后缀1.3 后缀表达式计算结果 二、答案 题目 一、分析 通过利用栈将中缀表达式转换为后缀表达式,在根据后缀表达式计算运算结果。由于包含负数操作数的情况,并且操作数位数不固定为1,因此…...

C++编程:实现简单的高精度时间日志记录小程序

0. 概述 为了检查是否存在系统时间跳变,本文使用C实现了一个简单的高精度时间日志记录小程序。该程序能够每隔指定时间(默认40毫秒)记录一次系统时间到文件中,并具备以下功能: 自定义时间间隔和文件名:通…...

QQ机器人搭建

使用QQ官方机器人Python SDK和三方框架搭建QQ群聊机器人 文章目录 使用QQ官方机器人Python SDK和三方框架搭建QQ群聊机器人前言编写机器人代码机器人监听群聊进行文字回复机器人监听群聊进行图片回复机器人监听群聊进行文件发送机器人监听群聊进行视频发送机器人监听群聊进行语…...

flink设置保存点和恢复保存点

增加了hdfs package com.qyt;import org.apache.flink.api.java.functions.KeySelector; import org.apache.flink.api.java.tuple.Tuple2;import org.apache.flink.runtime.state.storage.FileSystemCheckpointStorage;import org.apache.flink.streaming.api.datastream.Dat…...

使用python获取百度一下,热搜TOP数据详情

一、查找对应链接 # 警告:以下代码仅供学习和交流使用,严禁用于任何违法活动。 # 本代码旨在帮助理解和学习编程概念,不得用于侵犯他人权益或违反法律法规的行为。 1、打开百度页面 百度一下,你就知道 2、点击F12 或 右键鼠标…...

Go conc库学习与使用

文章目录 主要功能和特点conc 的安装典型使用场景示例代码并行执行多个 Goroutines错误处理限制并发 Goroutines 数量使用 context.Context 进行任务控制 常见问题1. **任务中发生 panic**原因:解决方法: 2. **conc.Group 重复调用 Wait()**原因…...

以下是对华为 HarmonyOS NETX 5属性动画(ArkTS)文档的结构化整理,通过层级标题、表格和代码块提升可读性:

一、属性动画概述NETX 作用:实现组件通用属性的渐变过渡效果,提升用户体验。支持属性:width、height、backgroundColor、opacity、scale、rotate、translate等。注意事项: 布局类属性(如宽高)变化时&#…...

解决Ubuntu22.04 VMware失败的问题 ubuntu入门之二十八

现象1 打开VMware失败 Ubuntu升级之后打开VMware上报需要安装vmmon和vmnet,点击确认后如下提示 最终上报fail 解决方法 内核升级导致,需要在新内核下重新下载编译安装 查看版本 $ vmware -v VMware Workstation 17.5.1 build-23298084$ lsb_release…...

【解密LSTM、GRU如何解决传统RNN梯度消失问题】

解密LSTM与GRU:如何让RNN变得更聪明? 在深度学习的世界里,循环神经网络(RNN)以其卓越的序列数据处理能力广泛应用于自然语言处理、时间序列预测等领域。然而,传统RNN存在的一个严重问题——梯度消失&#…...

测试markdown--肇兴

day1: 1、去程:7:04 --11:32高铁 高铁右转上售票大厅2楼,穿过候车厅下一楼,上大巴车 ¥10/人 **2、到达:**12点多到达寨子,买门票,美团/抖音:¥78人 3、中饭&a…...

Robots.txt 文件

什么是robots.txt? robots.txt 是一个位于网站根目录下的文本文件(如:https://example.com/robots.txt),它用于指导网络爬虫(如搜索引擎的蜘蛛程序)如何抓取该网站的内容。这个文件遵循 Robots…...

【开发技术】.Net使用FFmpeg视频特定帧上绘制内容

目录 一、目的 二、解决方案 2.1 什么是FFmpeg 2.2 FFmpeg主要功能 2.3 使用Xabe.FFmpeg调用FFmpeg功能 2.4 使用 FFmpeg 的 drawbox 滤镜来绘制 ROI 三、总结 一、目的 当前市场上有很多目标检测智能识别的相关算法,当前调用一个医疗行业的AI识别算法后返回…...

Hive 存储格式深度解析:从 TextFile 到 ORC,如何选对数据存储方案?

在大数据处理领域,Hive 作为 Hadoop 生态中重要的数据仓库工具,其存储格式的选择直接影响数据存储成本、查询效率和计算资源消耗。面对 TextFile、SequenceFile、Parquet、RCFile、ORC 等多种存储格式,很多开发者常常陷入选择困境。本文将从底…...

VM虚拟机网络配置(ubuntu24桥接模式):配置静态IP

编辑-虚拟网络编辑器-更改设置 选择桥接模式,然后找到相应的网卡(可以查看自己本机的网络连接) windows连接的网络点击查看属性 编辑虚拟机设置更改网络配置,选择刚才配置的桥接模式 静态ip设置: 我用的ubuntu24桌…...

20个超级好用的 CSS 动画库

分享 20 个最佳 CSS 动画库。 它们中的大多数将生成纯 CSS 代码,而不需要任何外部库。 1.Animate.css 一个开箱即用型的跨浏览器动画库,可供你在项目中使用。 2.Magic Animations CSS3 一组简单的动画,可以包含在你的网页或应用项目中。 3.An…...

免费PDF转图片工具

免费PDF转图片工具 一款简单易用的PDF转图片工具,可以将PDF文件快速转换为高质量PNG图片。无需安装复杂的软件,也不需要在线上传文件,保护您的隐私。 工具截图 主要特点 🚀 快速转换:本地转换,无需等待上…...