Spark 的容错机制:保障数据处理的稳定性与高效性

Spark 的介绍与搭建:从理论到实践_spark环境搭建-CSDN博客

Spark 的Standalone集群环境安装与测试-CSDN博客

PySpark 本地开发环境搭建与实践-CSDN博客

Spark 程序开发与提交:本地与集群模式全解析-CSDN博客

Spark on YARN:Spark集群模式之Yarn模式的原理、搭建与实践-CSDN博客

Spark 中 RDD 的诞生:原理、操作与分区规则-CSDN博客

Spark 中的 RDD 分区的设定规则与高阶函数、Lambda 表达式详解-CSDN博客

RDD 算子全面解析:从基础到进阶与面试要点-CSDN博客

PySpark 数据处理实战:从基础操作到案例分析-CSDN博客

目录

一、Spark 容错机制概述

1、各个软件为了防止数据丢失的解决方案

2、Spark如何保障数据的安全

二、RDD 持久化机制

(一)cache 算子

(二)persist 算子

(三)unpersist 算子

(四)示例代码分析

三、RDD 检查点机制

(一)功能与原理

(二)适用场景

四、RDD 的 cache、persist 持久化机制和 checkpoint 检查点机制的区别

五、将日志分析案例进行优化

六、总结

在大数据处理领域,Spark 作为一款强大的分布式计算框架,面临着数据丢失和性能优化的双重挑战。为了确保数据的安全性和处理效率,Spark 构建了一套完善的容错机制。本文将深入探讨 Spark 的容错机制,包括 RDD 的持久化机制(persist 和 cache 算子)以及检查点机制(checkpoint),并分析它们的特点、适用场景以及相互之间的区别。

一、Spark 容错机制概述

1、各个软件为了防止数据丢失的解决方案

操作日志:

将内存变化操作日志追加记录在一个文件中,下一次读取文件对内存重新操作

- NAMENODE:元数据的操作日志记录在edits

- MySQL:日志记录binlog ()

副本机制:将数据构建多份冗余副本

- HDFS:构建每个数据块的3个副本

依赖关系:每份数据保留与其他数据之间的一个转换关系

- RDD:保留RDD与其他RDD之间的依赖关系

2、Spark如何保障数据的安全

每个RDD在构建数据时,会根据自己来源一步步导到数据来源,然后再一步步开始构建RDD数据。

问题:如果一个RDD被触发多次,这个RDD就会按照依赖关系被构建多次,性能相对较差,怎么解决?

例如:日志分析的时候,三个问题,tupleRdd 之前的所有操作都要执行三次,每次读取100M多的数据,效率非常的低

- 第一次:一定会通过血脉构建这个RDD的数据

- 希望从第二次开始,就不要重复构建,直接使用第一个构建的内容

- 实现:Spark持久化机制:主动将RDD进行保存,供多次使用,避免重复构建

二、RDD 持久化机制

(一)cache 算子

- 功能:将 RDD 缓存在内存中,以便后续多次使用时无需重新计算。

- 语法:

cache()。 - 本质:底层实际调用的是

persist(StorageLevel.MEMORY_ONLY),即只尝试将 RDD 缓存在内存。但如果内存资源不足,缓存操作可能会失败。 - 场景:适用于资源充足且确定 RDD 只需在内存中缓存的情况,例如对于一些频繁使用且数据量较小能够完全容纳在内存中的 RDD,可以使用 cache 算子提高数据读取速度。

(二)persist 算子

- 功能:能够将 RDD(包含其依赖关系)进行缓存,并且可以根据需求自行指定缓存的级别,这是它与 cache 算子的主要区别。

- 语法:

persist(StorageLevel)。 - 级别:

- 将 RDD 缓存在磁盘中:

StorageLevel.DISK_ONLY = StorageLevel(True, False, False, False):将庞大且暂时不急需使用的 RDD 放入磁盘,释放 Executor 内存。StorageLevel.DISK_ONLY_2 = StorageLevel(True, False, False, False, 2):在磁盘中多存储一个缓存副本,提高数据的冗余性和可用性。StorageLevel.DISK_ONLY_3 = StorageLevel(True, False, False, False, 3):类似地,存储三个副本。StorageLevel.DISK_ONLY = StorageLevel(True, False, False, False) StorageLevel.DISK_ONLY_2 = StorageLevel(True, False, False, False, 2) StorageLevel.DISK_ONLY_3 = StorageLevel(True, False, False, False, 3)

- 将 RDD 缓存在内存中:

StorageLevel.MEMORY_ONLY = StorageLevel(False, True, False, False):仅使用内存进行缓存,常用于高频使用且数据量不大能适应内存容量的 RDD。StorageLevel.MEMORY_ONLY_2 = StorageLevel(False, True, False, False, 2):增加一个内存缓存副本。StorageLevel.MEMORY_ONLY = StorageLevel(False, True, False, False) StorageLevel.MEMORY_ONLY_2 = StorageLevel(False, True, False, False, 2)

- 将 RDD 优先缓存在内存中,如果内存不足,就缓存在磁盘中:

StorageLevel.MEMORY_AND_DISK = StorageLevel(True, True, False, False):对于高频使用的大 RDD 较为合适,先利用内存缓存,当内存空间不足时,自动将多余数据溢出到磁盘。StorageLevel.MEMORY_AND_DISK_2 = StorageLevel(True, True, False, False, 2):多一个缓存副本。StorageLevel.MEMORY_AND_DISK = StorageLevel(True, True, False, False) StorageLevel.MEMORY_AND_DISK_2 = StorageLevel(True, True, False, False, 2)

- 使用堆外内存:

StorageLevel.OFF_HEAP = StorageLevel(True, True, True, False, 1):提供了除内存和磁盘之外的存储选择,可利用堆外内存资源。StorageLevel.OFF_HEAP = StorageLevel(True, True, True, False, 1) - 使用序列化:

StorageLevel.MEMORY_AND_DISK_DESER = StorageLevel(True, True, False, True):在内存和磁盘缓存时采用序列化方式,有助于减少内存占用,但在读取时需要进行反序列化操作,会有一定性能开销。StorageLevel.MEMORY_AND_DISK_DESER = StorageLevel(True, True, False, True)

- 将 RDD 缓存在磁盘中:

- 场景:根据实际的资源状况,灵活地将 RDD 缓存在不同的存储介质中或者设置多个缓存副本,以平衡内存使用、数据读取速度和数据安全性。例如在内存和磁盘资源都较为充裕但内存使用较为紧张的情况下,可以选择

MEMORY_AND_DISK级别进行缓存,既能保证数据的快速读取,又能在内存不足时利用磁盘空间。

- 总结:Spark的StorageLevel共有9个缓存级别

DISK_ONLY:缓存入硬盘。这个级别主要是讲那些庞大的Rdd,之后仍需使用但暂时不用的,放进磁盘,腾出Executor内存。

DISK_ONLY_2:多一个缓存副本。

MEMORY_ONLY:只使用内存进行缓存。这个级别最为常用,对于马上用到的高频rdd,推荐使用。

MEMORY_ONLY_2:多一个缓存副本。

MEMORY_AND_DISK:先使用内存,多出来的溢出到磁盘,对于高频的大rdd可以使用。

MEMORY_AND_DISK_2:多一个缓存副本。

OFF_HEAP:除了内存、磁盘,还可以存储在OFF_HEAP常用的:

项目中经常使用

MEMORY_AND_DISK_2

MEMORY_AND_DISK_DESER

(三)unpersist 算子

- 功能:释放已缓存的 RDD,回收缓存占用的资源。

- 语法:

unpersist,还可以使用unpersist(blocking=True),表示等待 RDD 释放完资源后再继续执行下一步操作。 - 场景:当确定某个 RDD 不再被使用,且后续还有大量代码需要执行时,及时调用 unpersist 算子将其数据从缓存中释放,避免资源的浪费。需要注意的是,如果不手动释放缓存,在 Spark 程序结束时,系统也会自动清理该程序中的所有缓存内存。

(四)示例代码分析

以下是一个简单的 Spark 程序示例,展示了如何使用 cache 、 persist 和 unpersist 算子:

import os

import time# 导入pyspark模块

from pyspark import SparkContext, SparkConf

from pyspark.storagelevel import StorageLevelif __name__ == '__main__':# 配置环境os.environ['JAVA_HOME'] = 'C:/Program Files/Java/jdk1.8.0_241'# 配置Hadoop的路径,就是前面解压的那个路径os.environ['HADOOP_HOME'] = 'D:/hadoop-3.3.1'# 配置base环境Python解析器的路径os.environ['PYSPARK_PYTHON'] = 'C:/ProgramData/Miniconda3/python.exe' # 配置base环境Python解析器的路径os.environ['PYSPARK_DRIVER_PYTHON'] = 'C:/ProgramData/Miniconda3/python.exe'# 获取 conf 对象# setMaster 按照什么模式运行,local bigdata01:7077 yarn# local[2] 使用2核CPU * 你本地资源有多少核就用多少核# appName 任务的名字conf = SparkConf().setMaster("local[*]").setAppName("spark的持久化机制")# 假如我想设置压缩# conf.set("spark.eventLog.compression.codec","snappy")# 根据配置文件,得到一个SC对象,第一个conf 是 形参的名字,第二个conf 是实参的名字sc = SparkContext(conf=conf)print(sc)fileRdd = sc.textFile("../resources/1.dat")# cache 是转换算子#cacheRdd = fileRdd.cache()cacheRdd = fileRdd.persist(StorageLevel.MEMORY_AND_DISK_2)print(type(cacheRdd))cacheRdd.foreach(lambda x: print(x))time.sleep(20)cacheRdd.unpersist(blocking=True)time.sleep(10)# 使用完后,记得关闭sc.stop()# unpersist(blocking=True):等RDD释放完再继续下一步

# blocking = True:阻塞 在上述代码中,首先配置了 Spark 运行所需的环境变量,然后创建了 SparkConf 和 SparkContext 对象。通过 textFile 方法读取文本文件创建了 fileRdd,接着使用 persist 算子将其缓存到内存和磁盘,并设置了两个副本。之后对缓存的 cacheRdd 进行了遍历操作,模拟了对 RDD 的使用。在暂停 20 秒后,调用 unpersist 算子释放缓存,最后关闭 SparkContext。

三、RDD 检查点机制

(一)功能与原理

- 功能:将 RDD 的数据(不包含 RDD 依赖关系)存储在可靠的存储系统(如 HDFS)中。可以将其类比为虚拟机中的快照,作为数据处理过程中的一个重要里程碑。

- 设置与使用:

- 首先需要设置一个检查点目录,例如:

sc.setCheckpointDir("../datas/chk/chk1")。 - 然后对需要设置检查点的 RDD 调用

checkpoint()方法,如:rs_rdd.checkpoint()。需要注意的是,一定要在触发该 RDD 的算子之前调用checkpoint()方法,否则检查点中可能没有数据。

- 首先需要设置一个检查点目录,例如:

- 注意事项:启用检查点机制后,在代码执行过程中会专门多一个 job,用于将 RDD 数据持久化存储到 HDFS 中。

(二)适用场景

适用于对 RDD 数据安全性要求极高,但对性能要求相对不那么苛刻的场景。例如在一些数据处理任务中,数据的准确性和完整性至关重要,不容许因为任何故障导致数据丢失或错误,即使这可能会带来一定的性能开销,如在金融数据处理、关键业务数据分析等领域。

四、RDD 的 cache、persist 持久化机制和 checkpoint 检查点机制的区别

- 存储位置:

- persist:可以将 RDD 缓存在内存或者磁盘中,根据指定的缓存级别灵活选择存储介质。

- checkpoint:将 RDD 的数据存储在文件系统磁盘(通常是 HDFS)中,提供更可靠的持久化存储。

- 生命周期:

- persist:当代码中遇到了

unpersist算子调用或者整个 Spark 程序结束时,缓存会被自动清理,释放资源。 - checkpoint:检查点的数据不会被自动清理,需要手动删除,这使得数据在长时间内都能保持可用状态,有利于数据的长期保存和回溯。

- persist:当代码中遇到了

- 存储内容:

- persist:会保留 RDD 的血脉关系,即与其他 RDD 的依赖关系。这样在缓存丢失时,可以依据依赖关系重新构建 RDD,恢复数据。

- checkpoint:会斩断 RDD 的血脉关系,仅存储 RDD 的数据本身。这意味着一旦检查点数据可用,就不再依赖之前的 RDD 依赖链,简化了数据恢复过程,但也失去了基于依赖关系的灵活重建能力。

五、将日志分析案例进行优化

对前文的一个案例进行优化

import os

import re# 导入pyspark模块

from pyspark import SparkContext, SparkConf

import jieba

from pyspark.storagelevel import StorageLevelif __name__ == '__main__':# 配置环境os.environ['JAVA_HOME'] = 'D:/Program Files/Java/jdk1.8.0_271'# 配置Hadoop的路径,就是前面解压的那个路径os.environ['HADOOP_HOME'] = 'D:/hadoop-3.3.1/hadoop-3.3.1'# 配置base环境Python解析器的路径os.environ['PYSPARK_PYTHON'] = 'C:/ProgramData/Miniconda3/python.exe' # 配置base环境Python解析器的路径os.environ['PYSPARK_DRIVER_PYTHON'] = 'C:/ProgramData/Miniconda3/python.exe'# 获取 conf 对象# setMaster 按照什么模式运行,local bigdata01:7077 yarn# local[2] 使用2核CPU * 你本地资源有多少核就用多少核# appName 任务的名字conf = SparkConf().setMaster("local[*]").setAppName("第一个Spark程序")# 假如我想设置压缩# conf.set("spark.eventLog.compression.codec","snappy")# 根据配置文件,得到一个SC对象,第一个conf 是 形参的名字,第二个conf 是实参的名字sc = SparkContext(conf=conf)fileRdd = sc.textFile("../datas/sogou.tsv")print(fileRdd.count())print(fileRdd.first())listRdd = fileRdd.map(lambda line: re.split("\\s+", line))filterList = listRdd.filter(lambda l1: len(l1) == 6)# 这个结果只获取而来时间 uid 以及热词,热词将左右两边的[] 去掉了tupleRdd = filterList.map(lambda l1: (l1[0], l1[1], l1[2][1:-1]))# 将tupleRdd 缓存到内存中tupleRdd.cache()#tupleRdd.persist(storageLevel=StorageLevel.MEMORY_AND_DISK)# 求热词wordRdd = tupleRdd.flatMap(lambda t1: jieba.cut_for_search(t1[2]))filterRdd2 = wordRdd.filter(lambda word: len(word.strip()) != 0 and word != "的").filter(lambda word: re.fullmatch("[\u4e00-\u9fa5]+", word) is not None)# filterRdd2.foreach(print)result = filterRdd2.map(lambda word: (word, 1)).reduceByKey(lambda sum, num: sum + num).sortBy(keyfunc=lambda tup: tup[1], ascending=False).take(10)for ele in result:print(ele)# 第二问: ((uid,"功夫") 10)# [(time,uid,"中华人民"),()]def splitWord(tupl):li1 = jieba.cut_for_search(tupl[2]) # 中国 中华 共和国li2 = list()for word in li1:li2.append(((tupl[1], word),1))return li2newRdd = tupleRdd.flatMap(splitWord)#newRdd.foreach(print)reduceByUIDAndWordRdd = newRdd.reduceByKey(lambda sum,num : sum + num)# reduceByUIDAndWordRdd.foreach(print)valList =reduceByUIDAndWordRdd.values()print(valList.max())print(valList.min())print(valList.mean()) # 中位数print(valList.sum() / valList.count()) ## 第三问 统计一天每小时点击量并按照点击量降序排序reductByKeyRDD = tupleRdd.map(lambda tup: (tup[0][0:2],1)).reduceByKey(lambda sum,num : sum + num)sortRdd = reductByKeyRDD.sortBy(keyfunc=lambda tup:tup[1],ascending=False)listNum = sortRdd.take(24)for ele in listNum:print(ele)tupleRdd.unpersist(blocking=True)# 使用完后,记得关闭sc.stop()

将任务运行,运行过程中,发现内存中存储了50M的缓存数据

适用场景:RDD需要多次使用,或者RDD是经过非常复杂的转换过程所构建。

一般缓存的RDD都是经过过滤,经过转换之后重复利用的rdd,可以添加缓存,否则不要加。

六、总结

Spark 的容错机制通过多种方式保障了数据处理的稳定性和高效性。RDD 的持久化机制(包括 cache 和 persist 算子)为频繁使用的 RDD 提供了灵活的缓存策略,能够有效减少重复计算,提高处理效率。而检查点机制则侧重于数据的高安全性存储,在面对可能的缓存丢失或系统故障时,确保数据的完整性和可用性。在实际应用中,需要根据数据处理任务的特点、资源状况以及对数据安全性和性能的要求,合理选择使用持久化机制和检查点机制,以充分发挥 Spark 框架的优势,构建可靠高效的大数据处理应用。

相关文章:

Spark 的容错机制:保障数据处理的稳定性与高效性

Spark 的介绍与搭建:从理论到实践_spark环境搭建-CSDN博客 Spark 的Standalone集群环境安装与测试-CSDN博客 PySpark 本地开发环境搭建与实践-CSDN博客 Spark 程序开发与提交:本地与集群模式全解析-CSDN博客 Spark on YARN:Spark集群模式…...

TCP可靠连接的建立和释放,TCP报文段的格式,UDP简单介绍

TCP连接的建立(三次握手) 建立连接使用的三报文 SYN 报文仅用于 TCP 三次握手中的第一个和第二个报文(SYN 和 SYN-ACK),用于初始化连接的序列号。数据传输阶段不再使用 SYN 标志。 SYN 报文通常只携带连接请求信息&a…...

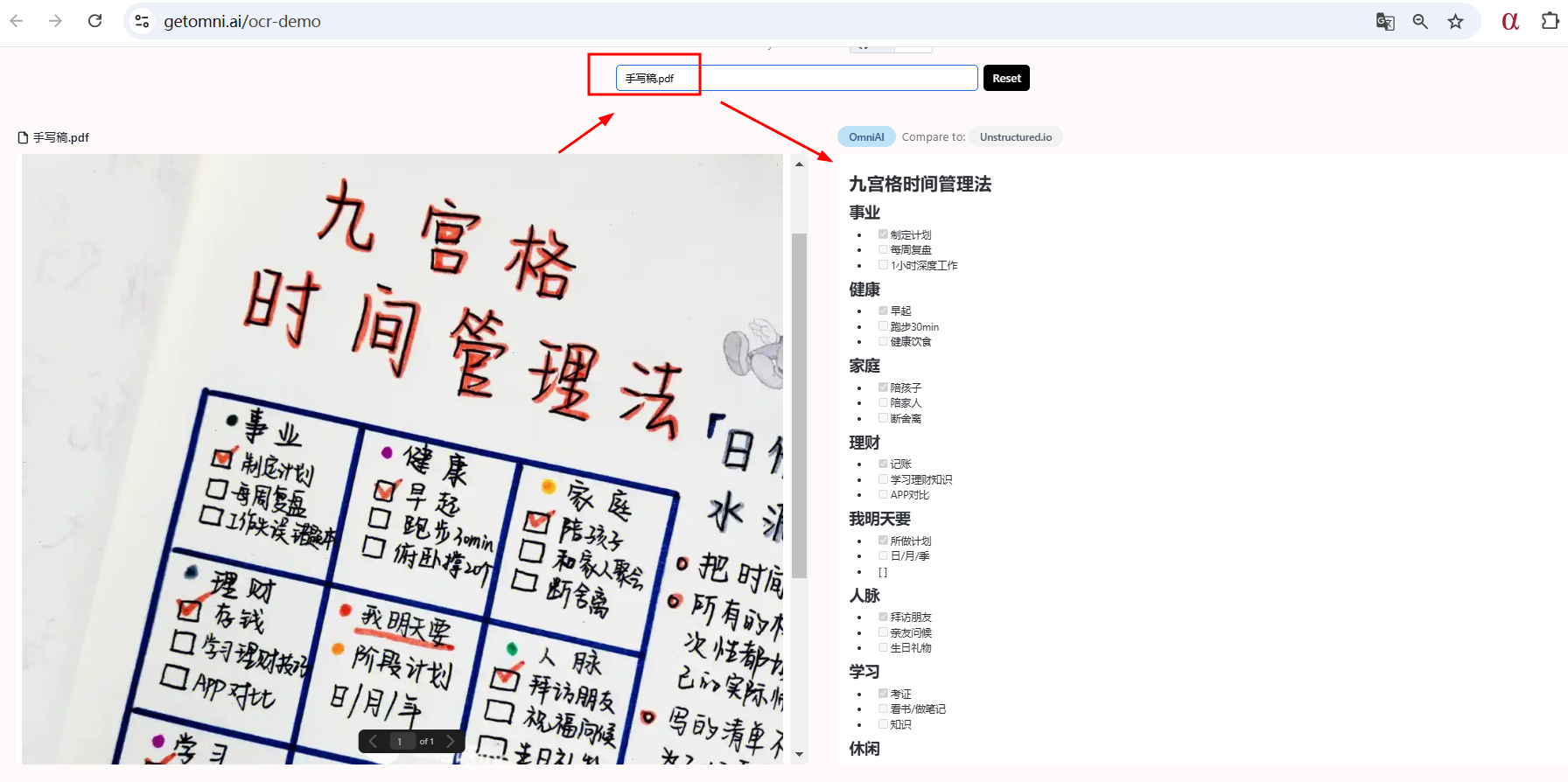

LLMs之PDF:zeroX(一款PDF到Markdown 的视觉模型转换工具)的简介、安装和使用方法、案例应用之详细攻略

LLMs之PDF:zeroX(一款PDF到Markdown 的视觉模型转换工具)的简介、安装和使用方法、案例应用之详细攻略 目录 zeroX的简介 1、支持的文件类型 zeroX的安装和使用方法 T1、Node.js 版本: 安装 使用方法 使用文件 URL: 使用本地路径&…...

部署方案)

开源数据库 - mysql - mysql-server-8.4(gtid主主同步+ keepalived热切换)部署方案

前置条件 假设主从信息 mysqlhostport主192.168.1.13306从192.168.1.23306vip192.168.1.3 部署流程 导出测试环境表结构与数据 使用mysqldump ./mysqldump -ulzzc -p -S /tmp/mysql3306.sock --single-transaction --database lzzc > databaseLZZCxxxx.sql查看gtid号 …...

Java全栈体系路线

Java全栈体系路线 摘要 Java 是一门广泛应用于企业级开发的语言,具有强大的生态系统和丰富的工具支持。成为一名 Java 全栈开发工程师不仅需要掌握后端开发技能,还需要具备前端开发和数据库管理的能力。本文将详细介绍 Java 全栈开发的学习路线&#x…...

【Unity基础】Unity中如何导入字体?

在Unity中,不能像其他软件一样直接使用字体文件,需要通过FontAssetCreator将其转换成Texture的Asset文件,然后才能使用。 本文介绍了使用FontAssetCreator导入字体的过程,并对其参数设置进行了说明。 Font Asset Creator 是 Uni…...

使用NVIDIA GPU加速FFmpeg视频压制:完全指南

引言 在视频处理领域,FFmpeg是一个强大的工具。结合NVIDIA的硬件编码器NVENC,我们可以实现快速高效的视频压制。本文将详细解析一个实用的视频压制命令,帮助你理解每个参数的作用。 核心命令 ffmpeg -i input.mp4 -vf scale640:360 -c:v h…...

Python学习:scipy是什么?

文章目录 一、Scipy简介二、Scipy的组成部分1. 基础功能:2. 特殊函数:3. 优化:4. 积分:5. 插值:6. 信号处理:7. 图像处理:8. 统计分布:9. 空间数据结构和算法:10. 稀疏矩…...

spark的学习-05

SparkSql 结构化数据与非结构化数据 结构化数据就类似于excel表中的数据(统计的都是结构化的数据)一般都使用sparkSql处理结构化的数据 结构化的文件:JSON、CSV【以逗号分隔】、TSV【以制表符分隔】、parquet、orc 结构化的表:…...

详解)

SQL注入(SQL Injection)详解

SQL注入(SQL Injection)是一种代码注入技术,它通过在应用程序的输入字段中插入或“注入”恶意的SQL语句,从而操控后端数据库服务器执行非预期的命令。这种攻击方式常用于绕过应用程序的安全措施,未经授权地访问、修改或…...

深入解析 OpenHarmony 构建系统-2-目录结构与核心组件

引言 OpenHarmony作为一款面向全场景的分布式操作系统,其构建系统在开发过程中扮演着至关重要的角色。本文将详细介绍OpenHarmony构建系统的目录结构和核心组件,帮助开发者更好地理解和使用这一强大的工具。 目录结构概览 以下是OpenHarmony构建系统的目录结构,每个目录和…...

)

网络安全应急响应(归纳)

目录 一、概述二、理论 系统排查 系统基本信息 windowsLinux用户信息 WindowsLinux启动项:开机系统在前台或者后台运行的程序,是病毒等实现持久化驻留的常用方法。 WindowsLinux任务计划:由于很多计算机都会自动加载“任务计划”,…...

【网络协议栈】网络层(上)网络层的基本理解、IP协议格式、网络层分组(内附手画分析图 简单易懂)

绪论 “It does not matter how slowly you go as long as you do not stop.”。本章是自上而下的进入网络协议栈的第三个篇幅–网络层–,本章我将带你了解网络层,以及网络层中非常重要的IP协议格式和网络层的分片组装问题,后面将持续更新网…...

数据库类型介绍

1. 关系型数据库(RDBMS) 关系型数据库是最常见的一类数据库,它们通过表(Table)来存储数据,表之间通过关系(如主键和外键)来关联。 • MySQL:开源的关系型数据库管理系统&…...

一步一步从asp.net core mvc中访问asp.net core WebApi

"从asp.net core mvc中访问asp.net core WebApi"看到这个标题是不是觉得很绕口啊,但的确就是要讲一讲这样的访问。前面我们介绍了微信小程序访问asp.net core webapi(感兴趣的童鞋可以看看前面的博文有关WEBAPI的搭建),这里我们重点不关心如何…...

linux中kubectl命令使用

一.命令介绍 kubectl 是 Kubernetes 集群管理的命令行工具,用于与 Kubernetes API 交互。你可以通过它来管理和操作 Kubernetes 集群中的资源,如 Pod、Deployment、Service 等。下面是如何在不同操作系统上下载和使用 kubectl 的方法。 二.下载 kubect…...

Linux 系统结构

Linux系统一般有4个主要部分:内核、shell、文件系统和应用程序。内核、shell和文件系统一起形成了基本的操作系统结构,它们使得用户可以运行程序、管理文件并使用系统。 1. linux内核 内核是操作系统的核心,具有很多最基本功能,它…...

ESP32-S3设备智能化升级,物联网无线AI语音交互,让生活更加便捷和有趣

在人工智能和物联网技术的推动下,无线AI语音交互技术正在成为智能设备的新选择。这种技术的发展,不仅改变了我们与设备的沟通方式,更开启了一个新的智能交互方案。 想象一下,通过简单的语音指令,就能控制家中的灯光、…...

Python的函数(补充浅拷贝和深拷贝)

一、定义 函数的定义:实现【特定功能】的代码块。 形参:函数定义时的参数,没有实际意义 实参:函数调用/使用时的参数,有实际意义 函数的作用: 简化代码提高代码重用性便于维护和修改提高代码的可扩展性…...

oracle查询字段类型长度等字段信息

1.查询oracle数据库的字符集 SELECT * FROM NLS_DATABASE_PARAMETERS WHERE PARAMETER NLS_CHARACTERSET; 2.查询字段长度类型 SELECT * FROM user_tab_columns WHERE table_name user AND COLUMN_NAME SNAME 请确保将user替换为您想要查询的表名。sname为字段名 这里的字…...

多模态2025:技术路线“神仙打架”,视频生成冲上云霄

文|魏琳华 编|王一粟 一场大会,聚集了中国多模态大模型的“半壁江山”。 智源大会2025为期两天的论坛中,汇集了学界、创业公司和大厂等三方的热门选手,关于多模态的集中讨论达到了前所未有的热度。其中,…...

基于大模型的 UI 自动化系统

基于大模型的 UI 自动化系统 下面是一个完整的 Python 系统,利用大模型实现智能 UI 自动化,结合计算机视觉和自然语言处理技术,实现"看屏操作"的能力。 系统架构设计 #mermaid-svg-2gn2GRvh5WCP2ktF {font-family:"trebuchet ms",verdana,arial,sans-…...

深入剖析AI大模型:大模型时代的 Prompt 工程全解析

今天聊的内容,我认为是AI开发里面非常重要的内容。它在AI开发里无处不在,当你对 AI 助手说 "用李白的风格写一首关于人工智能的诗",或者让翻译模型 "将这段合同翻译成商务日语" 时,输入的这句话就是 Prompt。…...

java调用dll出现unsatisfiedLinkError以及JNA和JNI的区别

UnsatisfiedLinkError 在对接硬件设备中,我们会遇到使用 java 调用 dll文件 的情况,此时大概率出现UnsatisfiedLinkError链接错误,原因可能有如下几种 类名错误包名错误方法名参数错误使用 JNI 协议调用,结果 dll 未实现 JNI 协…...

抖音增长新引擎:品融电商,一站式全案代运营领跑者

抖音增长新引擎:品融电商,一站式全案代运营领跑者 在抖音这个日活超7亿的流量汪洋中,品牌如何破浪前行?自建团队成本高、效果难控;碎片化运营又难成合力——这正是许多企业面临的增长困局。品融电商以「抖音全案代运营…...

linux 错误码总结

1,错误码的概念与作用 在Linux系统中,错误码是系统调用或库函数在执行失败时返回的特定数值,用于指示具体的错误类型。这些错误码通过全局变量errno来存储和传递,errno由操作系统维护,保存最近一次发生的错误信息。值得注意的是,errno的值在每次系统调用或函数调用失败时…...

[Java恶补day16] 238.除自身以外数组的乘积

给你一个整数数组 nums,返回 数组 answer ,其中 answer[i] 等于 nums 中除 nums[i] 之外其余各元素的乘积 。 题目数据 保证 数组 nums之中任意元素的全部前缀元素和后缀的乘积都在 32 位 整数范围内。 请 不要使用除法,且在 O(n) 时间复杂度…...

【碎碎念】宝可梦 Mesh GO : 基于MESH网络的口袋妖怪 宝可梦GO游戏自组网系统

目录 游戏说明《宝可梦 Mesh GO》 —— 局域宝可梦探索Pokmon GO 类游戏核心理念应用场景Mesh 特性 宝可梦玩法融合设计游戏构想要素1. 地图探索(基于物理空间 广播范围)2. 野生宝可梦生成与广播3. 对战系统4. 道具与通信5. 延伸玩法 安全性设计 技术选…...

基于matlab策略迭代和值迭代法的动态规划

经典的基于策略迭代和值迭代法的动态规划matlab代码,实现机器人的最优运输 Dynamic-Programming-master/Environment.pdf , 104724 Dynamic-Programming-master/README.md , 506 Dynamic-Programming-master/generalizedPolicyIteration.m , 1970 Dynamic-Programm…...

Python 包管理器 uv 介绍

Python 包管理器 uv 全面介绍 uv 是由 Astral(热门工具 Ruff 的开发者)推出的下一代高性能 Python 包管理器和构建工具,用 Rust 编写。它旨在解决传统工具(如 pip、virtualenv、pip-tools)的性能瓶颈,同时…...