大模型Tuning方法详解

1. 引言

大模型与Tuning的重要性

随着人工智能和深度学习技术的快速发展,大规模预训练模型(Large Pre-trained Models,简称大模型)在自然语言处理、计算机视觉等领域取得了显著的效果。大模型如GPT-4、BERT、T5和DALL-E等具备强大的通用性和扩展性,能够很好地处理不同领域的任务。然而,尽管大模型能够提供高质量的生成和理解能力,直接应用大模型往往难以满足特定任务的需求。这种情况下,Tuning(调优)技术的重要性就凸显出来了。

Tuning是一种通过调整大模型的参数或使用附加策略,提升其在特定任务上表现的过程。它不仅能有效缩小任务特定需求和通用模型之间的差距,还能帮助大模型更好地利用已有的知识,从而在数据相对稀缺的任务中取得更优的表现。Tuning技术的应用在行业中极为广泛,涵盖了如文本分类、情感分析、机器翻译、图像生成等多个任务。

Tuning技术的概述和应用场景

Tuning技术的基本思路是以大模型为基础,通过少量的特定任务数据或微调策略,使模型能够在目标任务上获得更高的表现。目前常见的Tuning技术主要有以下几种:

- 参数微调(Fine-tuning):对整个模型的参数进行调整,以适应特定任务需求。Fine-tuning在任务表现上效果显著,但计算成本高、数据需求大。

- Prompt Tuning:通过对输入提示(Prompt)的优化来引导模型产生特定输出。Prompt Tuning适用于少样本甚至零样本学习,能够在不修改模型参数的情况下提升性能。

- 高效Tuning(Efficient Tuning):如Adapter、Prefix Tuning和LoRA等方法,这些技术在不大幅增加计算量的前提下,达到类似Fine-tuning的效果,尤其适合资源受限的场景。

主要应用场景

- 自然语言处理:文本分类、命名实体识别、情感分析、机器翻译、问答系统等场景都可以通过Tuning技术优化表现。

- 计算机视觉:图像分类、目标检测、图像分割等任务上,Tuning技术有助于模型在小数据集上取得较好表现。

- 多模态任务:如图文生成、视频生成等多模态任务,Tuning技术可以帮助大模型更好地适应跨模态的需求。

2. Tuning方法概览

随着大模型在各种任务中的广泛应用,研究者们开发了多种Tuning方法,以优化模型在特定任务上的表现。这些方法各有侧重,适用于不同的数据量和资源条件。以下是几种主要的Tuning方法概览。

1. 参数微调(Fine-tuning)

参数微调是一种传统的Tuning方法,即在特定任务的数据集上对整个大模型的参数进行调整。Fine-tuning的核心思想是利用预训练模型的通用知识,在特定任务数据上进一步优化模型,使其更符合任务需求。它通常适用于数据量充足、需要高精度输出的任务。

优点:

- 能够充分利用预训练模型的知识,获得较高的精度。

- 对于目标任务的数据分布有较强的适应性。

缺点:

- 需要大量计算资源,尤其是在大模型参数较多的情况下。

- 易产生过拟合问题,尤其是在数据量有限的情况下。

应用场景:

Fine-tuning常用于文本分类、情感分析、图像分类等需要高精度和稳定性的任务。

2. 少样本学习(Few-shot Learning)

少样本学习是一种在极少的数据量下依然能够有效进行Tuning的技术。它利用大模型的通用知识,通过极少的标注数据实现对新任务的快速适应。少样本学习通常需要设计有效的输入模板或示例,让模型能够在较少的任务示例下学习到新的任务特性。

优点:

- 对数据需求较少,适合数据标注困难的场景。

- 能够快速适应新任务,适用于动态环境中的任务调整。

缺点:

- 精度较低,难以在高精度场景中完全替代Fine-tuning。

- 需要合理的示例选择和模板设计,否则性能会大打折扣。

应用场景:

少样本学习适用于数据稀缺的任务,如小规模的情感分析、新语言的翻译模型等。

3. 零样本学习(Zero-shot Learning)

零样本学习是一种不依赖特定任务数据的学习方式。它通过大模型在预训练阶段中学习到的通用知识,直接进行预测。在零样本学习中,模型利用任务描述或目标输出示例来推断任务特征,从而完成任务。这种方法不需要在目标任务上进行训练,直接通过任务描述来完成任务。

优点:

- 完全不依赖任务数据,适用于数据完全缺乏的场景。

- 能够支持大模型的跨任务迁移,拓展模型应用范围。

缺点:

- 性能通常不如Fine-tuning和Few-shot Learning。

- 对模型的预训练质量要求较高,尤其需要大量的通用知识。

应用场景:

零样本学习常用于跨任务和跨领域的场景,如未标注数据的分类、初步探索任务的新应用等。

4. 提示学习(Prompt Tuning)

提示学习是一种通过设计输入提示(Prompt)来引导模型输出目标结果的Tuning方法。Prompt Tuning并不对模型的参数进行调整,而是通过改变输入的方式(如在输入中加入提示词)来引导模型输出符合任务需求的结果。近年来,Prompt Tuning在语言模型中表现出良好的效果,尤其适用于自然语言处理领域。

优点:

- 无需改变模型参数,适合在大模型上快速部署。

- Prompt设计灵活,能适应多种任务需求,适合少样本和零样本学习。

缺点:

- 对Prompt设计要求较高,若Prompt不佳,模型表现可能较差。

- Prompt的通用性不高,往往需要针对每个任务单独设计。

应用场景:

Prompt Tuning适用于文本生成、问答系统、文本分类等NLP任务。

5. 高效Tuning(Efficient Tuning)

高效Tuning方法包括Adapter Tuning、Prefix Tuning、LoRA(Low-Rank Adaptation)等,这些方法旨在通过引入小规模参数模块或局部参数微调,提升模型的任务表现,同时减少对计算资源的需求。高效Tuning非常适合计算资源受限的环境,能够在不修改模型大部分参数的前提下实现特定任务的优化。

- Adapter Tuning:在模型特定层之间添加适应模块,来实现任务特定的微调。

- Prefix Tuning:在输入序列的前部加入特定前缀,以引导模型关注特定任务。

- LoRA:通过对模型参数进行低秩分解,只微调部分参数,从而降低计算开销。

优点:

- 高效节省计算资源,适合大模型的快速适应性训练。

- 无需大规模修改模型结构,便于集成和部署。

缺点:

- 精度可能略低于全参数微调。

- 高效Tuning方法相较于传统Tuning方法,需要对特定任务设计合理的适配策略。

应用场景:

高效Tuning广泛应用于资源受限的场景,如在嵌入式设备上应用大模型、低计算资源服务器上的特定任务Tuning等。

3. Fine-tuning 技术详解

Fine-tuning技术是大模型Tuning方法中的核心之一,主要通过在特定任务的数据集上进一步训练大模型,使其能够更好地适应该任务。Fine-tuning方法主要分为全参数微调和部分参数微调,并结合参数共享与冻结策略来优化训练效率。以下是对Fine-tuning技术的详细解析。

1. 全参数微调(Full Parameter Tuning)

全参数微调是Fine-tuning的标准方法,即对模型的所有参数进行调整,以适应目标任务。这种方法能够最大化模型的调整能力,使其尽可能地从目标任务数据中学习特定特征,从而获得更高的准确率。

实现过程:

- 将大模型加载并初始化。

- 使用目标任务的数据集进行训练。

- 逐步调整所有模型参数,直至达到满意的任务表现。

优点:

- 精度高:因为所有参数都参与训练,因此模型能够更充分地学习任务特征,提升任务的准确度。

- 灵活性高:适用于各种任务,无论数据量大小,都能通过参数调整获得较好的表现。

缺点:

- 计算开销大:对于具有数亿或数十亿参数的大模型,进行全参数微调需要大量的计算资源。

- 易过拟合:在数据量较少的情况下,可能出现过拟合问题,影响模型的泛化能力。

应用场景:

全参数微调适用于任务需求精度高、数据量充足且资源充裕的场景,如大型文本分类、机器翻译等任务。

2. 部分参数微调(Partial Parameter Tuning)

部分参数微调是一种资源友好的微调方式,它只对模型的部分参数进行调整,而冻结其余参数。这种方法通常只微调模型的后几层(如Transformer中的最后几层),以适应特定任务需求。这种策略既能够保留大模型的通用性知识,又能够降低计算成本。

实现过程:

- 将模型加载并初始化。

- 冻结模型中的大部分参数,只对目标任务相关层的参数进行微调。

- 使用目标任务的数据进行训练,优化被微调的层。

优点:

- 计算资源节省:只对少量参数进行调整,大大降低了计算和内存开销。

- 过拟合风险较低:通过保留通用知识,模型在小数据集上的表现更稳健。

缺点:

- 精度有限:由于只微调部分参数,模型在特定任务上的表现可能略低于全参数微调。

- 需要选定合适的微调层次,否则模型效果可能不明显。

应用场景:

部分参数微调适用于资源有限、数据量小、任务变化不大的情况,如用户行为分析、情感分类等轻量级任务。

3. 参数共享与冻结策略

参数共享与冻结策略是部分参数微调的核心思想之一,通过在模型中保留部分共享参数,避免全模型的频繁调整,从而提升Fine-tuning的效率和稳健性。冻结策略可以针对大模型的不同层次,实现逐层解冻或者选择性解冻,以此实现性能的平衡。

实现方式:

- 逐层解冻:逐步解冻模型的层,先解冻靠近输出的层,然后逐渐解冻靠近输入的层。这种策略适用于需要较高精度的任务。

- 选择性冻结:只冻结某些层的参数,如模型前几层或中间层,允许其他层进行调整。这种策略适用于任务特性较为独特的情况。

优点:

- 提高训练效率:减少了需要调整的参数量,节省计算资源。

- 更稳健的泛化能力:冻结部分参数可以保留模型的通用性特征,降低过拟合风险。

缺点:

- 需要任务特性分析:冻结的层数和位置需要根据任务特点进行合理选择,否则可能影响模型效果。

应用场景:

参数共享与冻结策略适用于需要适应多种任务的大模型,尤其在多任务学习或迁移学习场景中。

4. Fine-tuning的优势与局限性

优势

- 精度高:Fine-tuning能够让大模型更贴合目标任务,在精度上往往优于其他Tuning方法。

- 灵活性强:Fine-tuning适用于各种任务,尤其在大数据量、高精度需求的任务上效果显著。

- 模型通用性强:通过对特定任务的适应性微调,模型的表现更加稳健,尤其在部分参数微调或冻结策略下,模型的通用性更强。

局限性

- 计算资源高:Fine-tuning对计算资源要求较高,尤其是全参数微调,需要大量GPU或TPU支持。

- 易过拟合:对于小数据集或任务特性变化大的情况,Fine-tuning可能导致模型过拟合,泛化能力不足。

- 实现复杂:Fine-tuning过程需要设计适配策略,如逐层解冻、选择性解冻等,这使得其实现较为复杂。

4. Prompt Tuning 技术详解

Prompt Tuning是一种不需要直接修改模型参数,而是通过设计特定的输入提示(Prompt)来引导模型生成符合任务需求输出的技术。这种方法近年来在自然语言处理领域中表现出色,特别适合少样本和零样本的任务。以下是Prompt Tuning的详细解析。

1. 基本原理与操作流程

Prompt Tuning的基本原理是通过在输入中加入提示语,引导模型关注特定的任务需求。大模型在预训练时积累了大量通用知识,通过适当的Prompt设计,能够激活这些知识,实现对特定任务的适应。与Fine-tuning相比,Prompt Tuning无需更改模型参数,因此非常适合大模型的快速适配。

操作流程:

- 定义任务需求:首先明确需要完成的任务类型(如分类、生成、情感分析等)。

- 设计Prompt:根据任务需求,设计相应的Prompt,将其与输入文本组合,使模型理解任务的意图。

- 生成输出:将组合后的输入文本输入大模型,生成模型输出。

- 优化Prompt:根据初始输出结果,调整Prompt内容和结构,提升任务表现。

这种流程简单且无需修改模型内部参数,但Prompt的设计质量对模型输出的质量有重要影响。

2. Prompt Engineering

Prompt Engineering是Prompt Tuning的核心步骤,通过构建有效的Prompt,引导模型输出符合任务需求的结果。Prompt设计需要考虑任务目标、模型的预训练数据分布以及输入的上下文。

常用Prompt设计策略:

- 模板化Prompt:设计一套固定模板,将任务的不同输入嵌入模板中,例如“文本分类”任务可以使用模板“这段话的情感是:___”。

- 填空式Prompt:使用填空句式,引导模型在空格位置生成答案,这种方式特别适合分类任务,例如“该新闻属于___类别”。

- 问答式Prompt:将任务转换为问答形式,引导模型生成答案。适合需要生成具体信息的任务。

- 指令式Prompt:直接在Prompt中给予明确的指令,帮助模型理解具体的输出需求,如“请给出这段文字的主要观点”。

Prompt Engineering需要不断实验和调整,以找到最佳的Prompt结构和内容,使模型能更好地理解任务需求并给出准确的结果。

3. 针对任务的Prompt设计

不同任务类型对Prompt的设计有不同的要求,设计合适的Prompt可以提升模型在特定任务上的表现。以下是常见任务的Prompt设计示例:

-

分类任务:分类任务中,Prompt可以采用填空式或指令式结构。例如,对于情感分类任务,Prompt可以设计为“这段话的情感是:___”。如果需要模型从“积极”和“消极”中选择,则可以在Prompt后提供选项,如“请选择:积极/消极”。

-

文本生成任务:文本生成任务需要更具创意的Prompt设计,以便模型输出的内容贴合特定需求。例如,为了生成一篇关于科技创新的文章,可以使用Prompt“请撰写一篇关于未来科技发展的文章”。

-

问答任务:问答任务的Prompt设计需要直接反映问题的需求。可以使用问答式结构,如“问题:大数据的主要特点是什么?回答:___”。

-

翻译任务:Prompt可以直接指示模型进行翻译操作,例如“请将这段话翻译成英文:___”。这种指令式Prompt能帮助模型明确任务目标。

针对不同任务的Prompt设计,不仅要包含任务的核心信息,还要让Prompt尽可能符合模型的语言理解习惯和预训练语境。

4. 优化Prompt Tuning的策略

Prompt Tuning的表现与Prompt的质量密切相关,以下是优化Prompt Tuning的策略,以便提升模型的输出准确性和稳定性:

-

多次试验和迭代:初始的Prompt设计往往不是最优的,需要多次实验和反馈,根据输出结果不断优化Prompt。可以通过更换关键词、调整句式等方式改善Prompt效果。

-

使用任务特定关键词:根据任务需求选择合适的关键词可以提升Prompt效果。例如,对于情感分析任务,可以在Prompt中加入“积极”“消极”等词,帮助模型聚焦于情感特征。

-

提供示例:如果模型支持,可以在Prompt中提供示例,让模型通过示例学习特定任务格式。例如,可以在Prompt中加入类似的情感句子示例,引导模型生成更符合情感分析的结果。

-

组合式Prompt:对于复杂任务,可以尝试组合多个Prompt,以便模型在不同的Prompt提示下生成更丰富的输出。例如在问答任务中,先让模型生成回答大纲,然后再生成具体答案。

-

少样本示例(Few-shot Example):对于少样本学习,Prompt中可以加入几个示例答案,帮助模型快速适应任务需求。这种Few-shot Example能够在有限数据情况下提升Prompt Tuning效果。

-

动态Prompt调整:在某些情境下,基于生成的初始结果实时调整Prompt内容,动态优化Prompt。尤其是在多步生成任务中,逐步调整Prompt可以引导模型完成更准确的生成。

5. 高效Tuning方法

高效Tuning方法旨在通过较小的计算开销和参数调整,提升大模型在特定任务上的表现。与传统的Fine-tuning不同,高效Tuning方法通常只对少量参数进行微调,避免全模型的计算负担,因此适用于计算资源有限或需要快速适配的场景。以下是几种主要的高效Tuning方法的解析。

1. Adapter Tuning

Adapter Tuning是一种通过在模型内部插入“适配器”模块来实现Tuning的方法。这种模块通常是轻量的线性层或小规模的网络结构,放置于模型的特定层中,并仅对该模块进行微调,而原始模型的参数保持不变。通过训练这些适配器模块,模型能够快速适应特定任务。

优点:

- 资源节省:只训练适配器模块,减少了全模型微调的计算成本。

- 灵活性:适配器模块易于增加或删除,可以为每个任务创建独立的适配器模块。

缺点:

- 表现依赖模块设计:适配器模块的设计直接影响模型表现,选择合适的适配器结构至关重要。

应用场景:

Adapter Tuning适用于多任务学习、迁移学习和跨领域任务中,尤其在需要频繁调整和适配的任务上表现出色。

2. LoRA(Low-Rank Adaptation)

LoRA(低秩适配)是一种通过低秩分解来进行Tuning的高效方法。LoRA的核心思想是将模型的权重矩阵分解为低秩矩阵,从而在减少计算量的前提下进行微调。这种方法可以让模型保持原始权重结构,仅调整低秩矩阵的参数以适应任务需求。

优点:

- 高效资源利用:通过低秩分解,仅对少量参数进行调整,降低了内存和计算开销。

- 避免模型结构复杂化:不增加额外的模块或层,结构上保持简单。

缺点:

- 任务表现有时不及全参数微调:在某些任务中,LoRA的表现可能略逊于全参数微调。

应用场景:

LoRA适用于对性能要求较高、计算资源有限的场景,特别是在自然语言处理、图像生成等需要频繁Tuning的大模型中效果显著。

3. Prefix Tuning

Prefix Tuning是一种通过在输入序列前面添加特定的“前缀”来实现Tuning的方法。这些前缀通常是一些额外的上下文提示词,它们会影响模型的生成过程,从而引导模型更符合目标任务的需求。Prefix Tuning常用于语言模型的生成任务中,通过前缀引导模型生成具有特定风格或内容的输出。

优点:

- 高效轻量:只需对前缀部分进行训练,保持了主模型的整体结构。

- 灵活适应性:通过设计不同的前缀可以快速适应不同任务,适用于多任务场景。

缺点:

- 对生成任务依赖较强:适用于生成类任务,对于分类等任务效果较有限。

应用场景:

Prefix Tuning主要用于文本生成任务,例如文本摘要、对话生成和内容生成。它在语言模型中表现出色,能够帮助模型生成特定语气或主题的内容。

4. BitFit技术

BitFit(Bitwise Fine-tuning)是一种极其轻量的Tuning方法,仅微调模型中的偏置参数(bias),而不调整权重参数。通过这种方法,模型在保持主结构不变的情况下,能够进行快速适配。BitFit操作简单,适合在资源受限的设备上进行快速Tuning。

优点:

- 极低计算开销:只调整偏置参数,减少了显存和计算资源的消耗。

- 适应性强:可以在少量数据上实现快速微调,适合轻量任务。

缺点:

- 调优效果有限:由于只微调偏置参数,对于复杂任务可能效果不如全参数或部分参数微调。

应用场景:

BitFit适合轻量级的任务,如设备受限环境中的文本分类、情感分析等基础任务。

5. 高效Tuning的实际应用案例

高效Tuning方法在多种应用场景中表现出色,以下是一些实际应用案例:

-

多任务学习平台:在多任务学习平台中,可以使用Adapter Tuning为每个任务加载特定的适配器模块,而不影响其他任务的表现。这种方式在需要频繁切换任务的系统中广泛应用。

-

文本生成和对话系统:在文本生成任务中,Prefix Tuning能够帮助模型生成符合特定风格的对话和文本,例如为客服系统生成友好语气的回复、在写作助手中生成创意内容等。

-

低资源设备的快速Tuning:在边缘设备上使用BitFit可以快速适应模型的目标任务,例如在手机上的情感分类、短文本识别等应用场景中。

-

跨领域的图像生成:在图像生成任务中,LoRA可以在保持模型整体权重结构不变的情况下,通过低秩分解实现跨领域的图像生成任务,如将通用图像生成模型适应到医学影像生成任务中。

6. 超参数优化

超参数优化是机器学习和深度学习中至关重要的一步,因为超参数的选择会显著影响模型的表现。通过选择合适的超参数设置,模型可以在特定任务上达到最优性能。以下是超参数优化的详细介绍。

1. 常见的超参数种类

超参数是指在模型训练过程中需要手动设置的参数,而不是通过数据训练学习得到的参数。根据模型类型和任务需求,不同的超参数会对模型性能产生不同的影响。常见的超参数包括:

- 学习率(Learning Rate):控制模型更新参数的速度,学习率过高会导致模型不收敛,过低则收敛速度缓慢。

- 批次大小(Batch Size):每次更新模型参数时处理的数据样本数量,较大的批次大小可能更稳定,而较小的批次大小可以增加模型的泛化能力。

- 正则化参数(Regularization Parameters):包括L1和L2正则化系数,防止模型过拟合,提高泛化能力。

- 层数和神经元数量:特别是对于神经网络,层数和每层的神经元数量会影响模型的复杂度和表现力。

- 激活函数(Activation Function):如ReLU、Sigmoid、Tanh等选择的不同会影响模型的非线性特征表示能力。

- 优化器(Optimizer):例如SGD、Adam、RMSprop等,优化器的选择会影响模型的收敛速度和稳定性。

2. 超参数调优方法

超参数调优是寻找最优超参数组合的过程。由于模型的性能对超参数非常敏感,超参数的选择需要通过实验不断验证。常用的超参数调优方法有以下几种:

-

网格搜索(Grid Search):

- 网格搜索是一种穷举搜索方法,通过定义一组超参数值的集合,并遍历所有组合,最终找到性能最佳的组合。

- 优点:易于实现、适用于超参数范围有限的情况。

- 缺点:计算开销大,尤其是超参数组合多时,效率低下。

- 适用场景:小型模型、超参数范围明确的场景。

-

随机搜索(Random Search):

- 随机搜索在超参数空间中随机选择超参数组合进行训练和验证,通常比网格搜索更高效。

- 优点:效率较高,能够找到近似最优解。

- 缺点:可能会错过最优解,尤其是对于低概率分布的参数组合。

- 适用场景:超参数组合较多、时间受限的场景。

-

贝叶斯优化(Bayesian Optimization):

- 贝叶斯优化是一种通过构建超参数的概率模型来找到最优解的调优方法。它根据之前的实验结果来选择下一组超参数,逐步逼近最优解。

- 优点:比网格搜索和随机搜索更高效,适用于高维度的超参数空间。

- 缺点:实现较复杂,对计算资源有一定需求。

- 适用场景:计算资源有限、需要高效优化的任务。

-

进化算法(Evolutionary Algorithms):

- 使用遗传算法或粒子群优化等进化算法,在超参数空间中模拟“进化”过程,不断选择最优的超参数组合。

- 优点:在高维度空间中表现优异,适用于复杂超参数优化。

- 缺点:计算开销较大,尤其在大规模模型中耗时。

- 适用场景:超参数空间复杂、维度较高的任务。

-

超参数搜索框架:如Optuna、Hyperopt和Ray Tune等工具框架,可以自动化管理和执行超参数优化过程,极大简化超参数优化流程。

3. 超参数对模型性能的影响

超参数的选择会显著影响模型的表现。以下是几种关键超参数对模型性能的影响:

-

学习率:学习率是最关键的超参数之一。学习率过高会导致模型震荡,难以收敛;学习率过低则可能导致模型收敛速度过慢。在实践中,通常采用学习率衰减或学习率调度来提升训练效果。

-

批次大小:批次大小的选择会影响训练速度和模型表现。较小的批次大小有助于提高泛化能力,但可能使得模型训练不稳定;较大的批次大小有助于加速训练,但容易出现过拟合。

-

正则化参数:L1正则化可以产生稀疏特征选择,L2正则化则有助于抑制模型的复杂度。合适的正则化参数可以有效防止模型过拟合,提升泛化性能。

-

模型结构:如神经网络的层数和神经元数量,层数和神经元数量过多会增加模型的表达能力,但也增加了过拟合的风险。适当的结构可以使模型在特定任务上表现更好。

-

激活函数:不同的激活函数适用于不同类型的任务。例如,ReLU适用于深层神经网络,而Sigmoid通常用于二分类任务。选择合适的激活函数能够提升模型的表现力。

-

优化器:优化器的选择影响模型的收敛速度和稳定性。例如,Adam优化器在处理稀疏梯度时效果较好,而SGD在收敛稳定性上更优。对于不同任务和数据分布,选择合适的优化器有助于模型达到最佳性能。

7. 自动化Tuning工具

自动化Tuning工具可以帮助我们更高效地调优超参数和模型配置,极大地简化了模型优化过程。以下是几种常见的自动化Tuning工具的介绍、优缺点对比以及使用示例。

1. 常见的自动化Tuning工具介绍

-

Optuna:Optuna是一款开源的自动化超参数优化库,支持贝叶斯优化、随机搜索、网格搜索等多种调优策略。Optuna的独特之处在于其“pruning”机制,能够在训练早期去掉效果不佳的超参数组合,从而节省计算资源。

-

Hyperopt:Hyperopt是一个用于分布式异步超参数优化的Python库,支持贝叶斯优化(TPE算法)、随机搜索等。Hyperopt灵活且支持多种超参数优化算法,适合各种规模的调优任务。

-

Ray Tune:Ray Tune是基于Ray框架的自动化调优工具,支持多种优化算法(如贝叶斯优化、进化算法、PBT等),具有分布式计算能力,适合处理大规模模型的分布式训练。

-

Scikit-Optimize:基于Scikit-Learn的超参数优化库,支持贝叶斯优化、随机搜索和网格搜索。Scikit-Optimize简单易用,适合初学者和小规模调优任务。

-

Keras Tuner:Keras Tuner是专为Keras和TensorFlow设计的超参数优化库,支持随机搜索、贝叶斯优化、超参数带宽搜索等算法。它集成度高,适合TensorFlow用户。

2. 各工具的优缺点对比

| 工具 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| Optuna | 支持多种优化算法;支持早期停止机制;灵活性强 | 分布式能力有限 | 适合中小规模任务和资源有限的环境 |

| Hyperopt | 支持TPE贝叶斯优化;可并行计算;适用于多种任务 | 使用复杂,需配置计算环境 | 适合分布式计算和大规模任务 |

| Ray Tune | 分布式能力强;支持多种优化算法和并行计算;可扩展性强 | 配置复杂,依赖Ray框架 | 适合大规模和分布式计算环境 |

| Scikit-Optimize | 简单易用,适合小规模调优;与Scikit-Learn无缝集成 | 功能有限,分布式能力差 | 适合小规模实验和快速原型设计 |

| Keras Tuner | 集成于TensorFlow/Keras;支持多种优化算法;易于使用 | 仅适用于Keras和TensorFlow生态 | 适合TensorFlow用户 |

3. 使用示例与实战经验

以下是各工具的使用示例,以帮助理解它们的实际应用场景:

示例1:Optuna使用示例

Optuna支持贝叶斯优化和随机搜索,并且可以通过其pruning机制加速搜索过程。以下是Optuna在优化深度学习模型中的应用示例:

import optuna

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_iris

from sklearn.metrics import accuracy_score# 定义目标函数

def objective(trial):# 超参数定义n_estimators = trial.suggest_int("n_estimators", 10, 100)max_depth = trial.suggest_int("max_depth", 2, 10)# 构建模型并训练model = RandomForestClassifier(n_estimators=n_estimators, max_depth=max_depth)model.fit(X_train, y_train)# 验证集上的准确率accuracy = accuracy_score(y_valid, model.predict(X_valid))return accuracy# 数据集准备

data = load_iris()

X_train, X_valid, y_train, y_valid = train_test_split(data.data, data.target, test_size=0.2)# Optuna优化

study = optuna.create_study(direction="maximize")

study.optimize(objective, n_trials=50)# 输出最佳结果

print("Best trial:", study.best_trial.params)

实战经验:

- Optuna在小规模调优中表现优异,适合通过快速迭代找到最佳超参数。

- 使用pruning机制能够显著减少不必要的计算,适合在资源有限的环境中使用。

示例2:Ray Tune使用示例

Ray Tune适用于大规模模型和分布式环境,以下是使用Ray Tune进行深度学习模型调优的示例:

import ray

from ray import tune

from ray.tune.schedulers import ASHAScheduler

from ray.tune.integration.keras import TuneReportCallback

from tensorflow.keras.datasets import mnist

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Flatten# 定义模型

def create_model(config):model = Sequential([Flatten(input_shape=(28, 28)),Dense(config["units"], activation="relu"),Dense(10, activation="softmax")])model.compile(optimizer="adam", loss="sparse_categorical_crossentropy", metrics=["accuracy"])return model# 定义训练函数

def train_mnist(config):(X_train, y_train), (X_test, y_test) = mnist.load_data()model = create_model(config)model.fit(X_train, y_train, epochs=5, validation_data=(X_test, y_test),callbacks=[TuneReportCallback({"accuracy": "accuracy"})])# 设置调优参数

config = {"units": tune.choice([32, 64, 128, 256]),

}# 调优

tune.run(train_mnist,config=config,num_samples=10,scheduler=ASHAScheduler(metric="accuracy", mode="max")

)

实战经验:

- Ray Tune非常适合在分布式环境中进行复杂模型的调优。利用Ray Tune的分布式计算特性,可以有效地加快超参数搜索的进程。

- Ray Tune支持多种调优算法和调度器,可以在资源充足的环境中实现高效的调优。

示例3:Hyperopt使用示例

Hyperopt通过TPE算法实现贝叶斯优化,适用于并行和分布式调优。以下是Hyperopt优化深度学习模型的简单示例:

from hyperopt import fmin, tpe, hp, Trials

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from sklearn.datasets import load_digits# 定义目标函数

def objective(params):model = GradientBoostingClassifier(**params)model.fit(X_train, y_train)accuracy = accuracy_score(y_valid, model.predict(X_valid))return -accuracy# 定义搜索空间

space = {"n_estimators": hp.choice("n_estimators", range(50, 200)),"max_depth": hp.quniform("max_depth", 2, 10, 1),"learning_rate": hp.uniform("learning_rate", 0.01, 0.2)

}# 数据集准备

data = load_digits()

X_train, X_valid, y_train, y_valid = train_test_split(data.data, data.target, test_size=0.2)# 超参数优化

trials = Trials()

best = fmin(objective, space, algo=tpe.suggest, max_evals=50, trials=trials)

print("Best parameters:", best)

实战经验:

- Hyperopt的TPE算法适合高维搜索空间和大规模任务。

- 适合在分布式环境下进行长时间的调优,尤其在使用多台机器时表现出色。

不同的自动化Tuning工具适合不同的调优任务和资源条件。Optuna和Scikit-Optimize适合小规模调优,Ray Tune适合大规模分布式调优,而Hyperopt则兼具灵活性和高效性。选择合适的工具不仅能节省计算资源,还能帮助找到最优超参数组合,提高模型的性能。

8. 实际案例分析

在不同任务中,Tuning技术有着不同的应用效果。以下是几个实际案例的Tuning应用,涵盖自然语言处理、图像识别等领域。

案例1:自然语言处理中的Tuning

任务:情感分类

Tuning方法:Fine-tuning和Prompt Tuning

案例分析:

- 成功案例:使用Fine-tuning在GPT模型上进行情感分类,通过调整模型最后几层的参数,模型能够准确地识别文本情感。在数据量充足的情况下,Fine-tuning表现优异。

- 失败案例:尝试使用Prompt Tuning在小数据集上进行情感分类,Prompt设计不合理导致分类效果不佳。优化Prompt的结构后,性能得到提升,但总体效果仍不如Fine-tuning。

总结:自然语言处理任务中,Tuning的效果高度依赖于数据量和任务设计。对于小数据集任务,合理设计Prompt可以减少对模型参数的调整,但在高精度需求下,Fine-tuning表现更稳定。

案例2:图像识别中的Tuning

任务:医学影像分类

Tuning方法:LoRA和Adapter Tuning

案例分析:

- 成功案例:在ImageNet上预训练的ResNet模型上应用LoRA,通过低秩分解进行微调,在医学影像数据集上取得较好的分类效果,避免了过拟合。

- 失败案例:尝试直接Fine-tuning整个ResNet模型,导致过拟合问题严重,验证集表现较差。转而采用Adapter Tuning,通过微调适配器模块显著提高了泛化能力。

总结:图像识别任务中,尤其是小样本的医学影像数据,使用LoRA或Adapter Tuning可以避免全参数微调带来的过拟合问题。

案例3:文本生成中的Tuning

任务:客服回复生成

Tuning方法:Prefix Tuning

案例分析:

- 成功案例:通过在输入前加入特定前缀引导模型生成友好和专业的客服回复,使模型更贴合业务需求。

- 失败案例:在Prefix设计不合理的情况下,模型生成的回复不符合要求,通过调整前缀内容,使模型更符合预期。

总结:文本生成任务中,合理的前缀设计能够显著影响生成内容的风格和语气,Prefix Tuning在这类任务中表现突出。

9. 大模型Tuning的挑战与未来发展

Tuning技术面临的主要挑战

-

计算资源消耗:大模型的Fine-tuning需要大量计算资源,对于普通用户或小型公司而言,难以负担。因此,资源友好的Tuning方法(如LoRA和Adapter Tuning)逐渐受到青睐。

-

数据依赖:许多任务的Tuning需要大量的标注数据,但在某些领域数据难以获取,导致模型训练效果受限。如何在少样本数据情况下保证Tuning效果是一个重要挑战。

-

泛化与过拟合问题:Tuning在适配特定任务时可能导致模型过拟合,降低泛化能力。如何平衡模型的特定任务适应性和泛化能力,依然是Tuning技术面临的难题。

-

Prompt设计复杂性:在Prompt Tuning中,不同任务需要不同的Prompt设计,且优化Prompt结构依然需要大量实验。如何自动化生成和优化Prompt,是Prompt Tuning的挑战之一。

未来趋势与研究方向

-

轻量级Tuning方法的发展:未来将出现更多资源友好、高效的Tuning方法,如基于部分参数微调的策略,将进一步降低计算需求,使得大模型Tuning更具普适性。

-

Prompt Tuning自动化:随着Prompt Tuning的发展,自动化生成Prompt的工具和方法将成为研究热点,尤其是在自然语言处理任务中,自动化生成和优化Prompt能够显著提升效率。

-

多任务学习和跨领域Tuning:未来的研究可能会集中在多任务学习和跨领域Tuning上,开发出能够适应多个任务的统一模型,并且在跨领域任务中无需大量重新训练,实现更高效的Tuning。

-

Tuning工具与框架的优化:自动化Tuning工具的持续发展,将为研究者和开发者提供更高效的调优环境,同时增强分布式调优、智能调度等功能,提高调优效率。

10. 总结

Tuning技术的重要性总结

Tuning技术是提升大模型在特定任务上表现的关键方法。通过Tuning,大模型能够适应不同任务的需求,从而在更广泛的应用中展现其价值。无论是参数微调、Prompt Tuning还是高效Tuning技术,各类Tuning方法都在帮助大模型实现特定任务适应性上扮演着重要角色。

对大模型应用的影响与展望

未来,随着Tuning技术的不断发展,大模型在各行业和领域中的应用将更加广泛。从医学影像分析到智能客服,从情感分析到内容生成,大模型的Tuning方法正在推动AI技术的进一步落地。同时,自动化Tuning工具的普及与轻量级方法的发展,将使Tuning技术更加高效、普适。总体而言,Tuning技术在大模型应用中的重要性将继续增长,为AI领域的发展带来新的机遇和可能性。

相关文章:

大模型Tuning方法详解

1. 引言 大模型与Tuning的重要性 随着人工智能和深度学习技术的快速发展,大规模预训练模型(Large Pre-trained Models,简称大模型)在自然语言处理、计算机视觉等领域取得了显著的效果。大模型如GPT-4、BERT、T5和DALL-E等具备强…...

爬虫策略与反爬机制——爬虫常见策略

随着网络爬虫技术的日益发展,反爬机制也变得越来越复杂,网站和服务商不断加强对爬虫行为的监控和限制,开发者需要采取一系列有效的爬虫策略来提高爬虫的效率并规避反爬措施。本章将介绍一些常见的爬虫策略,帮助开发者应对不同情况…...

Linux基础(十七)——Linux 帐号管理与 ACL 权限设置

Linux 帐号管理与 ACL 权限设置 1.UID与GID2./etc/passwd3./etc/shadow4./etc/group5./etc/gshadow6.有效群组和初始群组7.账号管理7.1 增加、修改、删除账户7.2 增加、修改、删除群组7.3 实例 8.ACL使用8.1 ACL定义8.2 查询与设置ACL 9.用户切换9.1 su9.2 .sudo 10. 使用者的特…...

【HarmonyOS】鸿蒙系统在租房项目中的项目实战(二)

从今天开始,博主将开设一门新的专栏用来讲解市面上比较热门的技术 “鸿蒙开发”,对于刚接触这项技术的小伙伴在学习鸿蒙开发之前,有必要先了解一下鸿蒙,从你的角度来讲,你认为什么是鸿蒙呢?它出现的意义又是…...

11.16 Vue element

Ajax 概念:Asynchronous JavaScript Anderson XML,异步的JavaScript和XML。 作用: 数据交换:通过Ajax 可以给服务器发送请求,并收取服务器相应的数据。异步交互:可以在不重新加载整个页面的情况下&#…...

Gin 框架中的路由

1、路由概述 路由(Routing)是由一个 URI(或者叫路径)和一个特定的 HTTP 方法(GET、POST 等) 组成的,涉及到应用如何响应客户端对某个网站节点的访问。 RESTful API 是目前比较成熟的一套互联网应用程序的 API 设计理论,所以我们设计我们的路 由的时候建议参考 …...

在MATLAB中实现自适应滤波算法

自适应滤波算法是一种根据信号特性自动调整滤波参数的数字信号处理方法,其可以有效处理噪声干扰和信号畸变问题。在许多实时数据处理系统中,自适应滤波算法得到了广泛应用。在MATLAB中,可以使用多种方法实现自适应滤波算法。本文将介绍自适应…...

linux文件与重定向

目录 一、共识原理 二、回顾C语言文件函数 1.fopen 2.fwrite 3.fclose 三、文件系统调用 1.open 2.write 3.访问文件的本质 4.stdin&&stdout&&stderror 5.文件的引用计数 四、重定向 1.文件描述符的分配规则 2. 输出重定向 3.重定向系统调用 4.…...

基于Python的仓库管理系统设计与实现

背景: 基于Python的仓库管理系统功能介绍 本仓库管理系统采用Python语言开发,利用Django框架和MySQL数据库,实现了高效、便捷的仓库管理功能。 用户管理: 支持员工和管理员角色的管理。 用户注册、登录和权限分配功能&#x…...

【Pikachu】URL重定向实战

人生在世只有一次,不必勉强选择自己不喜欢的路,随性而生或随性而死都没关系,不过无论选择哪条路,都不要忘记自己的初心。 1.不安全的url跳转实战 首先点击页面上的链接,观察url 直接修改url为https://www.baidu.com进…...

C语言实现3D动态爱心图形的绘制与动画效果

**标题:C语言实现3D动态爱心图形的绘制与动画效果** --- ### 一、引言 在计算机图形学中,三维图形的绘制和动画处理是一个重要且有趣的研究方向。通过数学公式描述的几何体可以在计算机屏幕上展示出丰富多彩的动态效果,其中“爱心”图形作…...

深入理解Nginx:从基础配置到高级优化

什么是Nginx? Nginx(发音为“Engine-X”)是一个高性能的HTTP和反向代理服务器,同时也可以作为邮件代理服务器和通用的TCP/UDP代理服务器。Nginx以其高并发处理能力、稳定性和灵活的配置闻名,是现代Web开发和部署的核心…...

ONLYOFFICE8.2版本测评,团队协作的办公软件

文章目录 引言ONLYOFFICE产品简介功能与特点1. 实时协作2. 兼容性3. 模板库4. 评论和修订5. 安全性 体验与测评功能测试 邀请用户使用项目介绍结尾了解更多 引言 在数字化办公的浪潮中,效率和协作成为了工作的核心。ONLYOFFICE作为一个强大的办公套件,正…...

spring 和 grpc 的整合

spring 和 grpc 的整合 首先我们要知道 grpc 中我们在使用的时候用到了 grpc 的那些东西 dil 的编写serverimplserverbuilder addService 客户端的 stub 编写 这里面我们看一下我们那些地方可能需要 spring 帮我们管理,那些地方我们需要自己来管理呢?…...

企业项目级IDEA设置类注释、方法注释模板(仅增加@author和@date)

文章目录 前言一 设置类注释1.1 添加模板1.2 复制配置 二 设置方法注释2.1 添加模版2.2 设置模版2.3 设置参数变量2.4 配置对应快捷键2.5 配置对应作用域2.6 使用方式 说明 前言 公司代码规范中,需要在标准JavaDoc注释的基础上加上作者和日期。网上虽然有很多现成的…...

1 设计模式原则之开闭原则

一、开闭原则 1.定义 开闭原则:对扩展开放,对修改关闭。 2.具体用法 在程序需要进行拓展的时候,不能去修改原有的代码,实现一个热插拔的效果。简言之,是为了使程序的扩展性好,易于维护和升级。 想要达到这…...

前端大环境

需求增长: 数字化转型推动:企业和组织的数字化转型进程不断加快,对前端开发的需求持续增加。无论是企业官网、电子商务平台、在线办公系统还是各种移动端应用,都需要专业的前端开发来打造良好的用户界面和交互体验。新兴技术和平台…...

Electron: 主进程和渲染进程之间通信

// 渲染进程 向 主进程 异步通信// preload.js 预加载 const {ipcRenderer} require(electron) ipcRenderer.send(on-send-event, 这里是需要传递的参数) // 第一步ipcRenderer.on(on-resend-event, (e, data) > {console.log(data) // 打印的是ipcMain.on传递过来的参数&a…...

社交电商的优势及其与 AI 智能名片小程序、S2B2C 商城系统的融合发展

摘要:本文深入分析了社交电商相较于传统电商的优势,包括门槛低、易操作、更生活化和可团队化运作等特点。同时,探讨了 AI 智能名片小程序和 S2B2C 商城系统在社交电商发展中的作用,以及它们与社交电商融合所带来的新机遇和发展前景…...

蓝桥杯c++算法学习【4】之简单数论(阶乘约数、求值、循环小数、等差数列、最大比例:::非常典型的必刷例题!!!)

别忘了请点个赞收藏关注支持一下博主喵!!!! 关注博主,更多蓝桥杯nice题目静待更新:) 简单数论 一、阶乘约数 【问题描述】 定义阶乘n!123...n。 请问100! (100 的阶乘)有多少个正约数。 【答案提交】 这…...

Qt/C++开发监控GB28181系统/取流协议/同时支持udp/tcp被动/tcp主动

一、前言说明 在2011版本的gb28181协议中,拉取视频流只要求udp方式,从2016开始要求新增支持tcp被动和tcp主动两种方式,udp理论上会丢包的,所以实际使用过程可能会出现画面花屏的情况,而tcp肯定不丢包,起码…...

大数据零基础学习day1之环境准备和大数据初步理解

学习大数据会使用到多台Linux服务器。 一、环境准备 1、VMware 基于VMware构建Linux虚拟机 是大数据从业者或者IT从业者的必备技能之一也是成本低廉的方案 所以VMware虚拟机方案是必须要学习的。 (1)设置网关 打开VMware虚拟机,点击编辑…...

镜像里切换为普通用户

如果你登录远程虚拟机默认就是 root 用户,但你不希望用 root 权限运行 ns-3(这是对的,ns3 工具会拒绝 root),你可以按以下方法创建一个 非 root 用户账号 并切换到它运行 ns-3。 一次性解决方案:创建非 roo…...

2025 后端自学UNIAPP【项目实战:旅游项目】6、我的收藏页面

代码框架视图 1、先添加一个获取收藏景点的列表请求 【在文件my_api.js文件中添加】 // 引入公共的请求封装 import http from ./my_http.js// 登录接口(适配服务端返回 Token) export const login async (code, avatar) > {const res await http…...

tree 树组件大数据卡顿问题优化

问题背景 项目中有用到树组件用来做文件目录,但是由于这个树组件的节点越来越多,导致页面在滚动这个树组件的时候浏览器就很容易卡死。这种问题基本上都是因为dom节点太多,导致的浏览器卡顿,这里很明显就需要用到虚拟列表的技术&…...

省略号和可变参数模板

本文主要介绍如何展开可变参数的参数包 1.C语言的va_list展开可变参数 #include <iostream> #include <cstdarg>void printNumbers(int count, ...) {// 声明va_list类型的变量va_list args;// 使用va_start将可变参数写入变量argsva_start(args, count);for (in…...

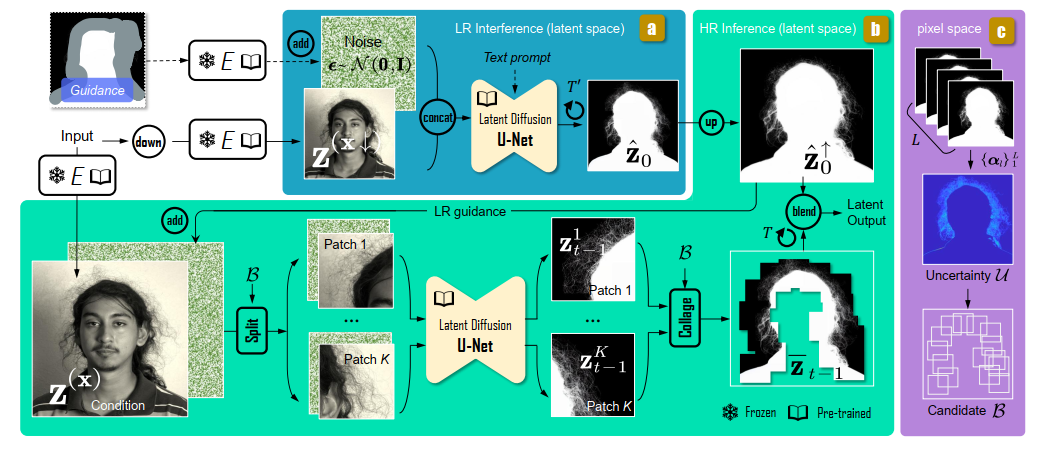

论文阅读:Matting by Generation

今天介绍一篇关于 matting 抠图的文章,抠图也算是计算机视觉里面非常经典的一个任务了。从早期的经典算法到如今的深度学习算法,已经有很多的工作和这个任务相关。这两年 diffusion 模型很火,大家又开始用 diffusion 模型做各种 CV 任务了&am…...

goreplay

1.github地址 https://github.com/buger/goreplay 2.简单介绍 GoReplay 是一个开源的网络监控工具,可以记录用户的实时流量并将其用于镜像、负载测试、监控和详细分析。 3.出现背景 随着应用程序的增长,测试它所需的工作量也会呈指数级增长。GoRepl…...

02-性能方案设计

需求分析与测试设计 根据具体的性能测试需求,确定测试类型,以及压测的模块(web/mysql/redis/系统整体)前期要与相关人员充分沟通,初步确定压测方案及具体的性能指标QA完成性能测试设计后,需产出测试方案文档发送邮件到项目组&…...

Spring是如何实现无代理对象的循环依赖

无代理对象的循环依赖 什么是循环依赖解决方案实现方式测试验证 引入代理对象的影响创建代理对象问题分析 源码见:mini-spring 什么是循环依赖 循环依赖是指在对象创建过程中,两个或多个对象相互依赖,导致创建过程陷入死循环。以下通过一个简…...