C#构建一个简单的循环神经网络,模拟对话

循环神经网络(Recurrent Neural Network, RNN)是一种用于处理序列数据的神经网络模型。与传统的前馈神经网络不同,RNN具有内部记忆能力,可以捕捉到序列中元素之间的依赖关系。这种特性使得RNN在自然语言处理、语音识别、时间序列预测等需要考虑上下文信息的任务中表现出色。

RNN的基本结构

RNN的基本结构包括输入层、隐藏层和输出层。在处理序列数据时,RNN会按照序列的时间顺序逐个处理每个元素。对于序列中的每一个时间步,RNN不仅会接收该时间步的输入,还会接收上一个时间步的隐藏状态作为输入。这样,通过将之前的信息传递给后续的处理步骤,RNN能够利用历史信息来影响当前的输出。

方法

InitializeWeightsAndBiases():使用随机值初始化权重矩阵和偏置向量。Sigmoid():激活函数,用于隐藏层的非线性变换。RandomMatrix():生成指定大小的随机矩阵,用于权重的初始化。Softmax():通常用于多分类问题中的输出层,将输出转换为概率分布。Forward():前向传播方法,根据输入数据计算每个时间步的输出。它会更新隐藏状态,并最终返回所有时间步的输出列表。Backward():反向传播方法,用于根据预测输出与目标输出之间的差异调整模型参数。它计算梯度并更新权重和偏置。UpdateWeights():根据计算出的梯度更新模型的权重和偏置。Train():训练模型的方法,通过多次迭代(epoch)对输入数据进行前向传播和反向传播,以优化模型参数。Predict():预测方法,根据输入数据返回每个时间步的预测结果索引,即输出概率最高的类别。

说明

这只是一个基础的 RNN 模型实现,实际应用中可能需要考虑更多的优化技术,比如使用长短期记忆网络(LSTM)、门控循环单元(GRU)等更复杂的架构来改善性能。

using System;

using System.Linq;

using System.Collections.Generic;namespace Project.NeuralNetwork

{/// <summary>/// 构建神经网络/// </summary>public class RnnModel{/// <summary>/// 输入层大小/// </summary>private readonly int _inputSize;/// <summary>/// 隐藏层大小/// </summary>private readonly int _hiddenSize;/// <summary>/// 输出层大小/// </summary>private readonly int _outputSize;/// <summary>/// 输入到隐藏层的权重/// </summary>private double[,] _weightsInputHidden;/// <summary>/// 隐藏层到隐藏层的权重/// </summary>private double[,] _weightsHiddenHidden;/// <summary>/// 隐藏层到输出层的权重/// </summary>private double[,] _weightsHiddenOutput;/// <summary>/// 隐藏层偏置/// </summary>private double[] _biasHidden;/// <summary>/// 输出层偏置/// </summary>private double[] _biasOutput;/// <summary>/// 隐藏层状态/// </summary>private double[] _hiddenState;/// <summary>/// 初始化模型的构造函数/// </summary>/// <param name="inputSize"></param>/// <param name="hiddenSize"></param>/// <param name="outputSize"></param>public RnnModel(int inputSize, int hiddenSize, int outputSize){_inputSize = inputSize;_hiddenSize = hiddenSize;_outputSize = outputSize;InitializeWeightsAndBiases();}/// <summary>/// 初始化权重和偏置/// </summary>private void InitializeWeightsAndBiases(){_weightsInputHidden = RandomMatrix(_inputSize, _hiddenSize);_weightsHiddenHidden = RandomMatrix(_hiddenSize, _hiddenSize);_weightsHiddenOutput = RandomMatrix(_hiddenSize, _outputSize);_biasHidden = new double[_hiddenSize];_biasOutput = new double[_outputSize];}/// <summary>/// 激活函数/// </summary>/// <param name="x"></param>/// <returns></returns>private double Sigmoid(double x){return 1 / (1 + Math.Exp(-x));}/// <summary>/// 生成随机矩阵/// </summary>/// <param name="rows"></param>/// <param name="cols"></param>/// <returns></returns>private double[,] RandomMatrix(int rows, int cols){var matrix = new double[rows, cols];var random = new Random();for (int i = 0; i < rows; i++){for (int j = 0; j < cols; j++){matrix[i, j] = random.NextDouble() * 2 - 1; // [-1, 1]}}return matrix;}/// <summary>/// 前向传播/// </summary>/// <param name="inputs"></param>/// <returns></returns>public List<double[]> Forward(List<double[]> inputs){_hiddenState = new double[_hiddenSize];var outputs = new List<double[]>();foreach (var input in inputs){var hidden = new double[_hiddenSize];for (int h = 0; h < _hiddenSize; h++){hidden[h] = _biasHidden[h];for (int i = 0; i < _inputSize; i++){hidden[h] += _weightsInputHidden[i, h] * input[i];}for (int hh = 0; hh < _hiddenSize; hh++){hidden[h] += _weightsHiddenHidden[hh, h] * _hiddenState[hh];}hidden[h] = Sigmoid(hidden[h]);}_hiddenState = hidden;var output = Output(hidden);outputs.Add(output);}return outputs;}/// <summary>/// 输出层/// </summary>/// <param name="h"></param>/// <returns></returns>private double[] Output(double[] h){double[] y = new double[_outputSize];for (int i = 0; i < _outputSize; i++){double sum = _biasOutput[i];for (int j = 0; j < _hiddenSize; j++){sum += h[j] * _weightsHiddenOutput[j, i];}y[i] = sum;}return Softmax(y);}/// <summary>/// 输出层的激活函数/// </summary>/// <param name="x"></param>/// <returns></returns>private double[] Softmax(double[] x){double max = x.Max();double expSum = x.Select(xi => Math.Exp(xi - max)).Sum();return x.Select(xi => Math.Exp(xi - max) / expSum).ToArray();}/// <summary>/// 反向传播/// </summary>/// <param name="inputs"></param>/// <param name="targets"></param>/// <param name="outputs"></param>/// <param name="learningRate"></param>private void Backward(List<double[]> inputs, List<double[]> targets, List<double[]> outputs, double learningRate){//输入到隐藏层的梯度double[,] dWeightsInputHidden = new double[_inputSize, _hiddenSize];//隐藏层到隐藏层的梯度double[,] dWeightsHiddenHidden = new double[_hiddenSize, _hiddenSize];//隐藏层到输出层的梯度double[,] dWeightsHiddenOutput = new double[_hiddenSize, _outputSize];//隐藏层的偏置double[] dBiasHidden = new double[_hiddenSize];//输出层的偏置double[] dBiasOutput = new double[_outputSize];for (int t = inputs.Count - 1; t >= 0; t--){double[] targetVector = new double[_outputSize];Array.Copy(targets[t], targetVector, _outputSize);// 计算输出层的误差for (int o = 0; o < _outputSize; o++){dBiasOutput[o] = outputs[t][o] - targetVector[o];}// 计算隐藏层到输出层的梯度for (int o = 0; o < _outputSize; o++){for (int h = 0; h < _hiddenSize; h++){dWeightsHiddenOutput[h, o] += dBiasOutput[o] * _hiddenState[h];}}// 计算隐藏层的偏置double[] dh = new double[_hiddenSize];for (int h = 0; h < _hiddenSize; h++){double error = 0;for (int o = 0; o < _outputSize; o++){error += dBiasOutput[o] * _weightsHiddenOutput[h, o];}dh[h] = error * (_hiddenState[h] * (1 - _hiddenState[h]));}for (int h = 0; h < _hiddenSize; h++){dBiasHidden[h] += dh[h];}//计算输入到隐藏层的梯度for (int h = 0; h < _hiddenSize; h++){for (int i = 0; i < _inputSize; i++){dWeightsInputHidden[i, h] += dh[h] * inputs[t][i];}}// 计算输入到隐藏层的梯度if (t > 0){for (int h = 0; h < _hiddenSize; h++){for (int hh = 0; hh < _hiddenSize; hh++){dWeightsHiddenHidden[hh, h] += dh[h] * _hiddenState[hh];}}}}// 更新权重和偏置UpdateWeights(dWeightsInputHidden, dWeightsHiddenHidden, dWeightsHiddenOutput, dBiasHidden, dBiasOutput, learningRate);}/// <summary>/// 更新权重/// </summary>/// <param name="dWxh"></param>/// <param name="dWhh"></param>/// <param name="dWhy"></param>/// <param name="dbh"></param>/// <param name="dby"></param>/// <param name="learningRate"></param>private void UpdateWeights(double[,] dWeightsInputHidden, double[,] dWeightsHiddenHidden, double[,] dWeightsHiddenOutput, double[] dBiasHidden, double[] dBiasOutput, double learningRate){// 更新输入到隐藏层的权重for (int i = 0; i < _inputSize; i++){for (int h = 0; h < _hiddenSize; h++){_weightsInputHidden[i, h] -= learningRate * dWeightsInputHidden[i, h];}}//更新隐藏层到隐藏层的权重for (int h = 0; h < _hiddenSize; h++){for (int hh = 0; hh < _hiddenSize; hh++){_weightsHiddenHidden[h, hh] -= learningRate * dWeightsHiddenHidden[h, hh];}}//更新隐藏层到输出层的权重for (int h = 0; h < _hiddenSize; h++){for (int o = 0; o < _outputSize; o++){_weightsHiddenOutput[h, o] -= learningRate * dWeightsHiddenOutput[h, o];}}//更新隐藏层的偏置for (int h = 0; h < _hiddenSize; h++){_biasHidden[h] -= learningRate * dBiasHidden[h];}//更新输出层的偏置for (int o = 0; o < _outputSize; o++){_biasOutput[o] -= learningRate * dBiasOutput[o];}}/// <summary>/// 训练/// </summary>/// <param name="inputs"></param>/// <param name="targets"></param>/// <param name="epochs"></param>/// <param name="learningRate"></param>public void Train(List<List<double[]>> inputs, List<List<double[]>> targets, double learningRate, int epochs){for (int epoch = 0; epoch < epochs; epoch++){for (int i = 0; i < inputs.Count; i++){List<double[]> input = inputs[i];List<double[]> target = targets[i];List<double[]> outputs = Forward(input);Backward(input, target, outputs, learningRate);}}}/// <summary>/// 预测/// </summary>/// <param name="inputs"></param>/// <returns></returns>public int[] Predict(List<double[]> inputs){var output = Forward(inputs);var predictedIndices = output.Select(o => Array.IndexOf(o, o.Max())).ToArray();return predictedIndices;}}

}- 准备训练数据

- 训练网络

- 测试并输出结果

public static void Rnn_Predict()

{// 定义数据集var data = new List<Tuple<string[], string[]>>{Tuple.Create(new string[] { "早安" }, new string[] { "早上好" }),Tuple.Create(new string[] { "午安" }, new string[] { "中午好" }),Tuple.Create(new string[] { "晚安" }, new string[] { "晚上好" }),Tuple.Create(new string[] { "你好吗?" }, new string[] { "我很好,谢谢。" })};// 创建词汇表var allWords = data.SelectMany(t => t.Item1.Concat(t.Item2)).Distinct().ToList();var wordToIndex = allWords.ToDictionary(word => word, word => allWords.IndexOf(word));// 将字符串转换为one-hot编码List<List<double[]>> inputsData = new List<List<double[]>>();List<List<double[]>> targetsData = new List<List<double[]>>();foreach (var item in data){var inputSequence = item.Item1.Select(word => OneHotEncode(word, wordToIndex)).ToList();var targetSequence = item.Item2.Select(word => OneHotEncode(word, wordToIndex)).ToList();inputsData.Add(inputSequence);targetsData.Add(targetSequence);}double[] OneHotEncode(string word, Dictionary<string, int> wordToIndex){var encoding = new double[wordToIndex.Count];encoding[wordToIndex[word]] = 1;return encoding;}//开始训练int inputSize = allWords.Count;int hiddenSize = allWords.Count;int outputSize = allWords.Count;RnnModel model = new RnnModel(inputSize, hiddenSize, outputSize);int epochs = 10000;double learningRate = 0.1;model.Train(inputsData, targetsData, learningRate, epochs);//预测while (true){Console.Write("你: ");string userInput = Console.ReadLine();if (userInput.ToLower() == "exit"){break;}if (!allWords.Contains(userInput)){Console.WriteLine("对不起,我不认识这些词。");continue;}var testInput = new List<double[]> { OneHotEncode(userInput, wordToIndex) };var prediction = model.Predict(testInput);var predictedWords = prediction.Select(index => allWords[index]).ToArray();Console.WriteLine($"机器人: {string.Join(", ", predictedWords)}");}

}相关文章:

C#构建一个简单的循环神经网络,模拟对话

循环神经网络(Recurrent Neural Network, RNN)是一种用于处理序列数据的神经网络模型。与传统的前馈神经网络不同,RNN具有内部记忆能力,可以捕捉到序列中元素之间的依赖关系。这种特性使得RNN在自然语言处理、语音识别、时间序列预…...

Linux上安装单机版Kibana6.8.1

1. 下载安装包 kibana-6.8.1-linux-x86_64.tar.gz 链接:https://pan.baidu.com/s/1b4kION9wFXIVHuWDn2J-Aw 提取码:rdrc 2. Kibana启动不能使用root用户,使用ES里创建的elsearch用户,进行赋权: chown -R elsearch:els…...

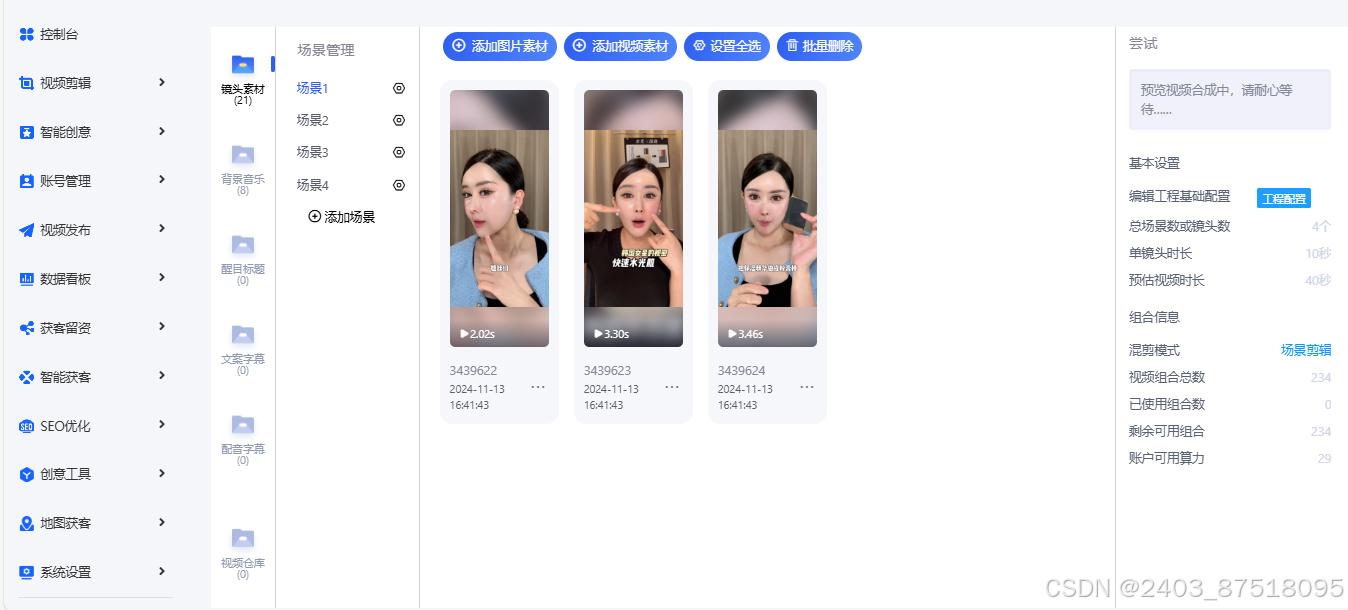

短视频矩阵矩阵,矩阵号策略

随着数字媒体的迅猛发展,短视频平台已经成为企业和个人品牌推广的核心渠道。在这一背景下,短视频矩阵营销策略应运而生,它通过高效整合和管理多个短视频账号,实现资源的最优配置和营销效果的最大化。本文旨在深入探讨短视频矩阵的…...

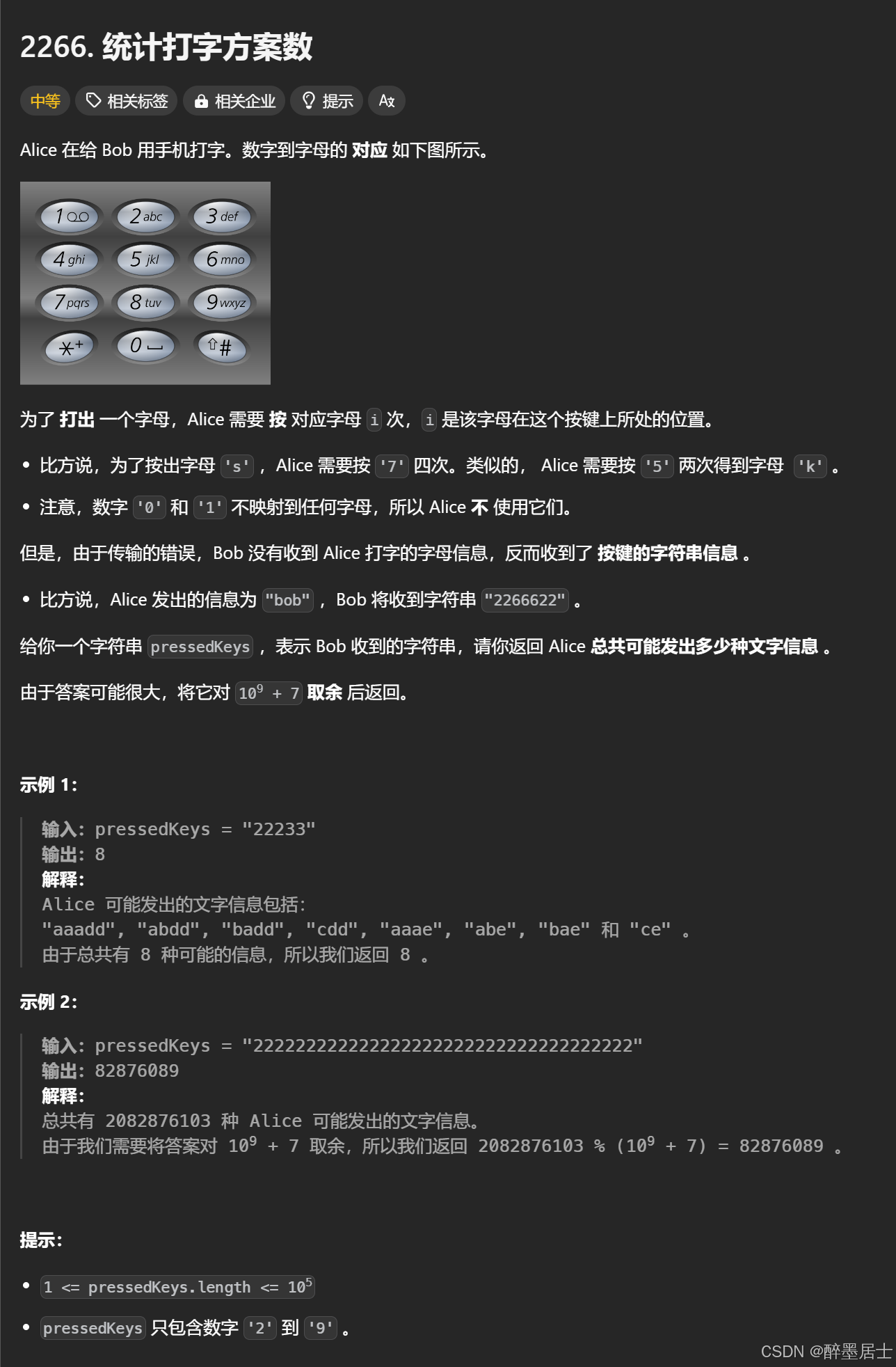

Rust 力扣 - 2266. 统计打字方案数

文章目录 题目描述题解思路题解代码题目链接 题目描述 题解思路 这题可以先求按了多少次相同连续的按钮,所有的连续相同按钮表示的方案数的乘积就是本题答案 我们的关键问题就转换成了按n个连续相同按钮表示的方案数 设f(i)表示按i个连续相同按钮表示的方案数 如…...

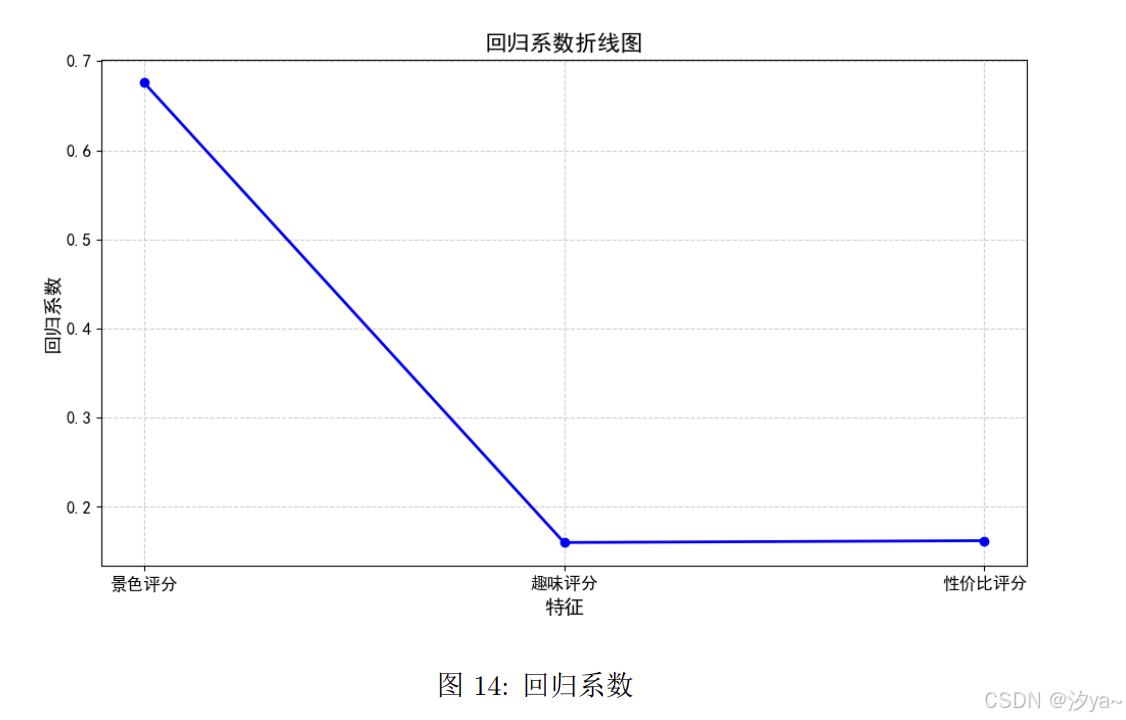

【大数据技术与开发实训】携程景点在线评论分析

景点在线评论分析 题目要求实验目标技术实现数据采集获取所有相关景点页面的 URL获取所有相关景点对应的 poiId 及其他有用信息通过 poiId 获取所有景点的全部评论数据采集结果 数据预处理景点信息的数据预处理查看数据基本信息缺失值处理 用户评论的数据处理缺失值处理分词、去…...

46.坑王驾到第十期:vscode 无法使用 tsc 命令

点赞收藏加关注,你也能住大别墅! 一、问题重现 上一篇帖子记录了我昨天在mac上安装typescript及调试的过程。今天打开vscode准备开干的时候,发现tsc命令又无法使用了,然后按照昨天的方法重新安装调试后又能用了,但是关…...

postman 调用 下载接口(download)使用默认名称(response.txt 或随机名称)

官网地址:https://www.postman.com 介绍 Postman 是一款流行的 API 开发和测试工具,用于发送 HTTP 请求、测试接口、调试服务器响应以及进行 API 文档管理。它支持多种请求类型(如 GET、POST、PUT、DELETE 等),并且功能…...

单片机_简单AI模型训练与部署__从0到0.9

IDE: CLion MCU: STM32F407VET6 一、导向 以求知为导向,从问题到寻求问题解决的方法,以兴趣驱动学习。 虽从0,但不到1,剩下的那一小步将由你迈出。本篇主要目的是体验完整的一次简单AI模型部署流程&#x…...

对撞双指针(七)三数之和

15. 三数之和 给你一个整数数组 nums ,判断是否存在三元组 [nums[i], nums[j], nums[k]] 满足 i ! j、i ! k 且 j ! k ,同时还满足 nums[i] nums[j] nums[k] 0 。请你返回所有和为 0 且不重复的三元组。 注意:答案中不可以包含重复的三元组…...

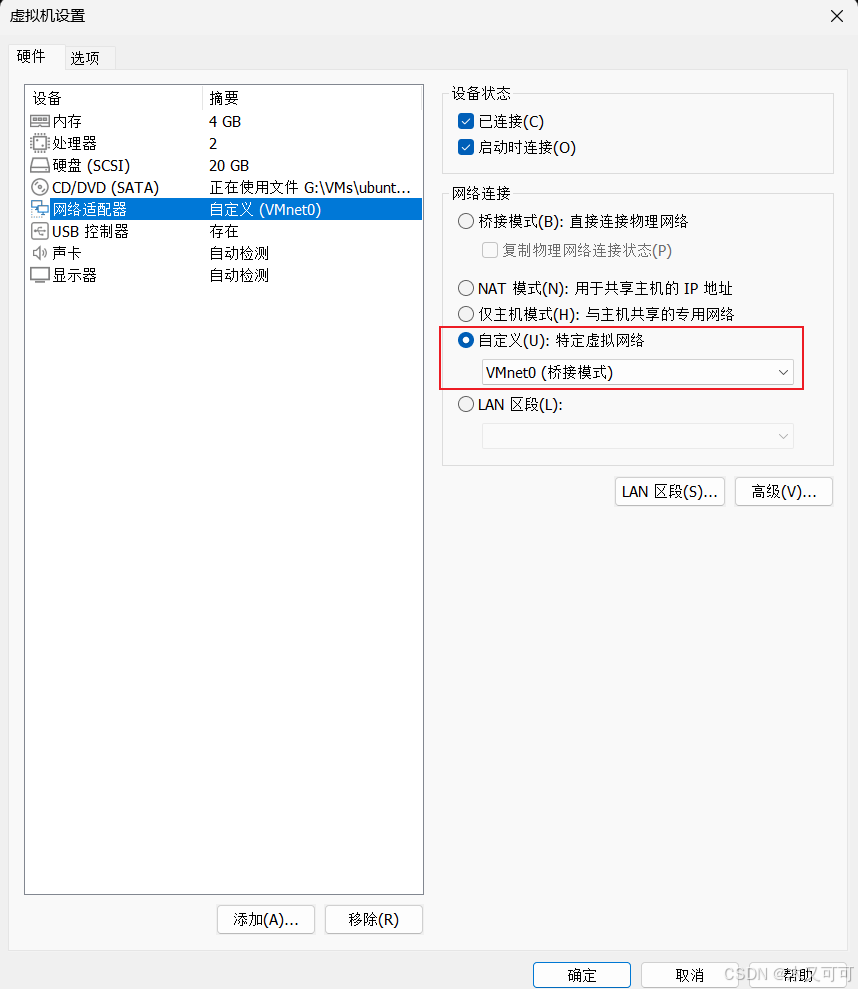

【Ubuntu24.04】服务部署(虚拟机)

目录 0 背景1 安装虚拟机1.1 下载虚拟机软件1.2 安装虚拟机软件1.2 安装虚拟电脑 2 配置虚拟机2.1 配置虚拟机网络及运行初始化脚本2.2 配置服务运行环境2.2.1 安装并配置JDK172.2.2 安装并配置MySQL8.42.2.3 安装并配置Redis 3 部署服务4 总结 0 背景 你的服务部署在了你的计算…...

timm库加载的模型可视化

在深度学习中,模型的可视化有助于了解模型的结构和层级关系。以下是几种方式来可视化使用 timm 库加载的模型: 打印模型结构 torch.nn.Module 的子类(包括 timm 的模型)可以通过 print() 查看其结构:import timm# 加…...

服务限流、降级、熔断-SpringCloud

本文所使用的组件:Nacos(服务中心和注册中心)、OpenFeign(服务调用)、Sentinel(限流、降级)、Hystrix(熔断) 项目结构: service-provider:提供服…...

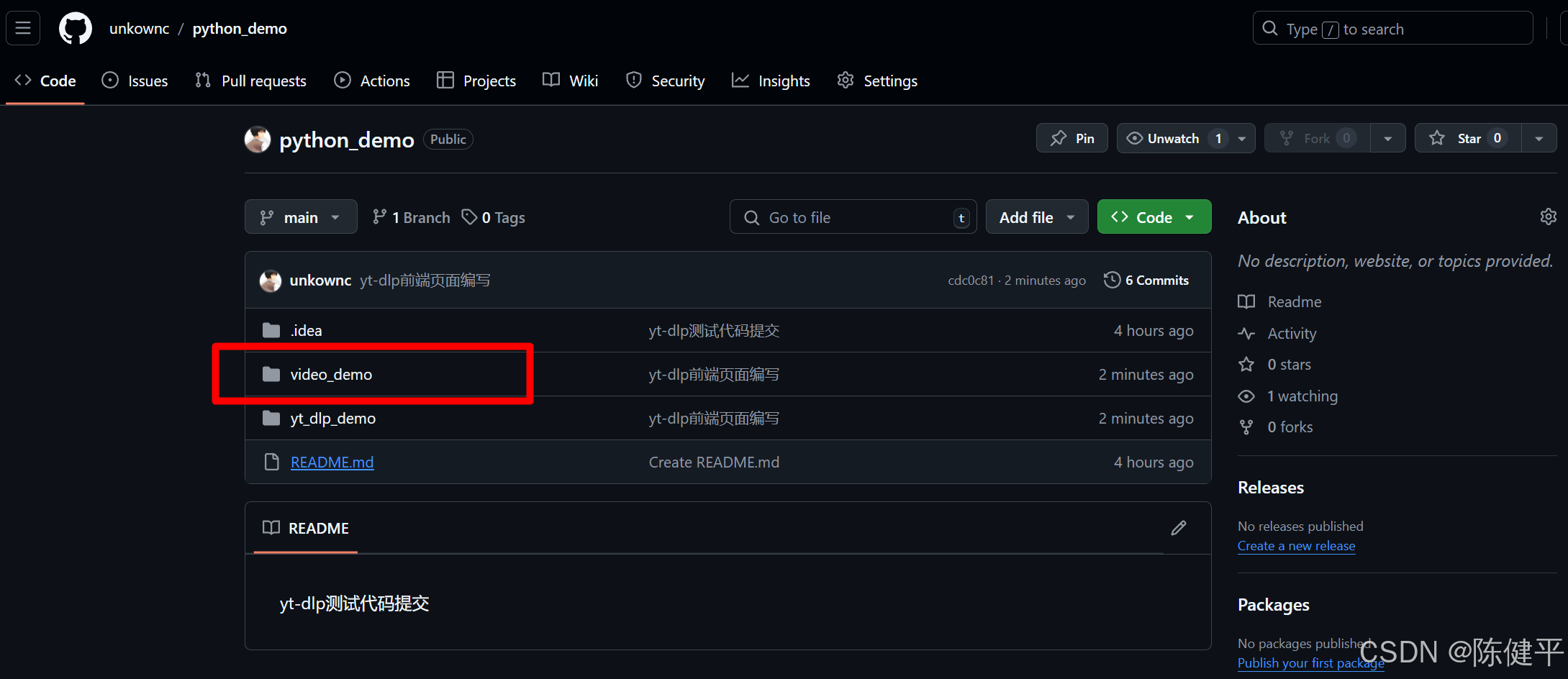

2024最新YT-DLP使用demo网页端渲染

2024最新YT-DLP使用demo网页端渲染 前提摘要1.使用python的fastapi库和jinjia2库进行前端渲染2.代码实现1)目录结构2)代码style.cssindex.htmlresult.htmlmain.pyrun.py 3)运行测试命令端运行 3.项目下载地址 前提摘要 2024最新python使用yt…...

《第十部分》1.STM32之通信接口《精讲》之IIC通信---介绍

经过近一周的USART学习,我深刻体会到通信对单片机的重要性。它就像人类的手脚和大脑,只有掌握了通信技术,单片机才能与外界交互,展现出丰富多彩的功能,变得更加强大和实用。 单片机最基础的“语言”是二进制。可惜&am…...

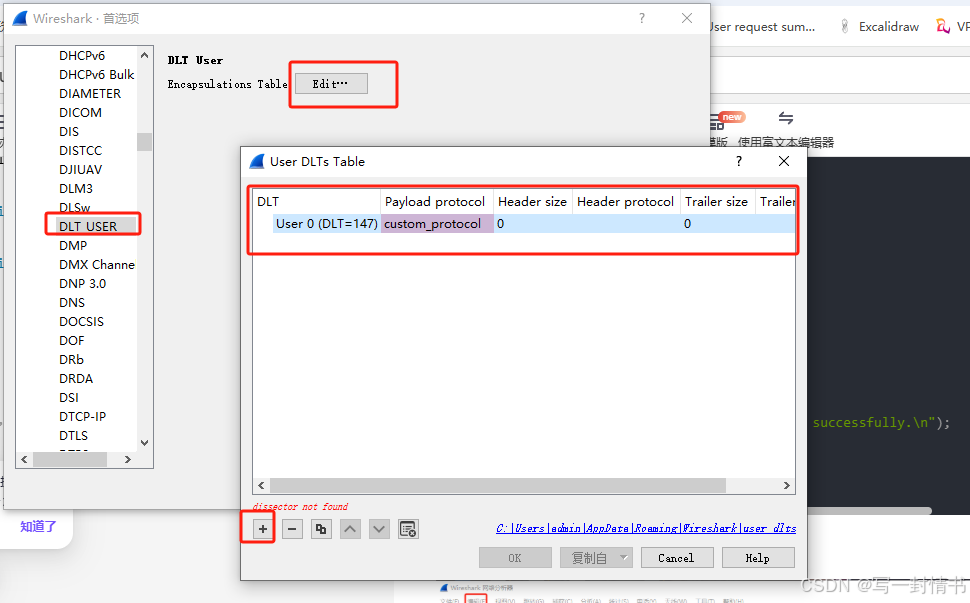

wireshark使用lua解析自定义协议

wireshark解析自定义协议 1.自定义的lua放入路径2.修改init.lua2.1 开启lua2.2 init.lua文件最后加入自己的lua文件位置,这里需要确保与自己的文件名相同 3.编写lua4.编写c抓包5.wireshark添加自定义协议如何加调试信息 1.自定义的lua放入路径 一般是自己软件的安装…...

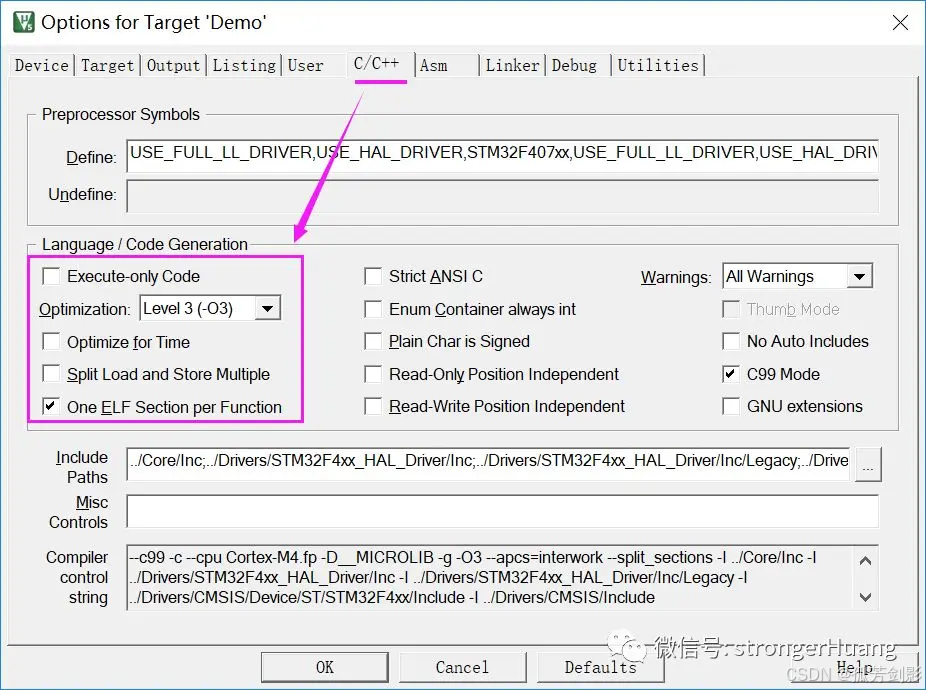

(Keil)MDK-ARM各种优化选项详细说明、实际应用及拓展内容

参考 MDK-ARM各种优化选项详细说明、实际应用及拓展内容 本文围绕MDK-ARM优化选项,以及相关拓展知识(微库、实际应用、调试)进行讲述,希望对你今后开发项目有所帮助。 1 总述 我们所指的优化,主要两方面: 1.代码大小(Size) 2.代码性能(运行时间) 在MDK-ARM中,优…...

Qt实现可拖拽的矩形

之前项目上需要用Qt来绘制可拖拽改变形状的矩形。看了Qt Graphics相关的内容,虽然对Qt怎么添加图元的有了些了解,但是具体如何实现拖拽效果,一时也没有什么好的想法。还好网上有人分享的例子,很受启发。后来又回顾了一下这部分的代…...

,B服务器下载A服务器文件(下载))

CentOS:A服务器主动给B服务器推送(上传),B服务器下载A服务器文件(下载)

Linux:常识(bash: ip command not found )_bash: ip: command not found-CSDN博客 rsync 中断后先判断程序是否自动重连:ps aux | grep rsync 查看目录/文件是否被使用(查询线程占用):lsof /usr/local/bin/mongodump/.B_database1.6uRCTp 场景:MongoDB中集合非常大需要…...

Oracle 执行计划查看方法汇总及优劣对比

在 Oracle 数据库中,查看执行计划是优化 SQL 语句性能的重要工具。以下是几种常用的查看执行计划的方法及其优劣比较: 1. 使用 EXPLAIN PLAN FOR 和 DBMS_XPLAN.DISPLAY 方法 执行 EXPLAIN PLAN FOR 语句: EXPLAIN PLAN FOR SELECT * FROM …...

TCL大数据面试题及参考答案

Mysql 索引失效的场景 对索引列进行运算或使用函数:当在索引列上进行数学运算、函数操作等,索引可能失效。例如,在存储年龄的列上建立了索引,若查询语句是 “SELECT * FROM table WHERE age + 1 = 20”,这里对索引列 age 进行了加法运算,数据库会放弃使用索引而进行全表扫…...

装饰模式(Decorator Pattern)重构java邮件发奖系统实战

前言 现在我们有个如下的需求,设计一个邮件发奖的小系统, 需求 1.数据验证 → 2. 敏感信息加密 → 3. 日志记录 → 4. 实际发送邮件 装饰器模式(Decorator Pattern)允许向一个现有的对象添加新的功能,同时又不改变其…...

【Python】 -- 趣味代码 - 小恐龙游戏

文章目录 文章目录 00 小恐龙游戏程序设计框架代码结构和功能游戏流程总结01 小恐龙游戏程序设计02 百度网盘地址00 小恐龙游戏程序设计框架 这段代码是一个基于 Pygame 的简易跑酷游戏的完整实现,玩家控制一个角色(龙)躲避障碍物(仙人掌和乌鸦)。以下是代码的详细介绍:…...

深入剖析AI大模型:大模型时代的 Prompt 工程全解析

今天聊的内容,我认为是AI开发里面非常重要的内容。它在AI开发里无处不在,当你对 AI 助手说 "用李白的风格写一首关于人工智能的诗",或者让翻译模型 "将这段合同翻译成商务日语" 时,输入的这句话就是 Prompt。…...

golang循环变量捕获问题

在 Go 语言中,当在循环中启动协程(goroutine)时,如果在协程闭包中直接引用循环变量,可能会遇到一个常见的陷阱 - 循环变量捕获问题。让我详细解释一下: 问题背景 看这个代码片段: fo…...

Oracle查询表空间大小

1 查询数据库中所有的表空间以及表空间所占空间的大小 SELECTtablespace_name,sum( bytes ) / 1024 / 1024 FROMdba_data_files GROUP BYtablespace_name; 2 Oracle查询表空间大小及每个表所占空间的大小 SELECTtablespace_name,file_id,file_name,round( bytes / ( 1024 …...

Linux简单的操作

ls ls 查看当前目录 ll 查看详细内容 ls -a 查看所有的内容 ls --help 查看方法文档 pwd pwd 查看当前路径 cd cd 转路径 cd .. 转上一级路径 cd 名 转换路径 …...

2.Vue编写一个app

1.src中重要的组成 1.1main.ts // 引入createApp用于创建应用 import { createApp } from "vue"; // 引用App根组件 import App from ./App.vue;createApp(App).mount(#app)1.2 App.vue 其中要写三种标签 <template> <!--html--> </template>…...

五年级数学知识边界总结思考-下册

目录 一、背景二、过程1.观察物体小学五年级下册“观察物体”知识点详解:由来、作用与意义**一、知识点核心内容****二、知识点的由来:从生活实践到数学抽象****三、知识的作用:解决实际问题的工具****四、学习的意义:培养核心素养…...

Springcloud:Eureka 高可用集群搭建实战(服务注册与发现的底层原理与避坑指南)

引言:为什么 Eureka 依然是存量系统的核心? 尽管 Nacos 等新注册中心崛起,但金融、电力等保守行业仍有大量系统运行在 Eureka 上。理解其高可用设计与自我保护机制,是保障分布式系统稳定的必修课。本文将手把手带你搭建生产级 Eur…...

uniapp微信小程序视频实时流+pc端预览方案

方案类型技术实现是否免费优点缺点适用场景延迟范围开发复杂度WebSocket图片帧定时拍照Base64传输✅ 完全免费无需服务器 纯前端实现高延迟高流量 帧率极低个人demo测试 超低频监控500ms-2s⭐⭐RTMP推流TRTC/即构SDK推流❌ 付费方案 (部分有免费额度&#x…...