Rook入门:打造云原生Ceph存储的全面学习路径(下)

文章目录

- 六.Rook部署云原生CephFS文件系统

- 6.1 部署cephfs storageclass

- 6.2 创建容器所需cephfs文件系统

- 6.3创建容器pod使用rook-cephfs提供pvc

- 6.4 查看pod是否使用rook-cephfs

- 七.Ceph Dashboard界面

- 7.1 启用dashboard开关

- 7.2 ceph-dashboard配置外部访问

- 7.3 Dashboard web admin密码查看

- 7.4 dashboard web登录查看

- 八.Prometheus监控

- 8.1 查看rook-ceph-mgr metrics监控指标

- 8.2部署prometheus-operator

- 8.3 部署prometheus实例

- 8.4部署grafana

- 8.5配置grafana监控ceph模板

- 8.6 在grafana上查看ceph集群状态

- 九.常见故障排查

- 9.1 ceph集群出现警告mgr modules have recently crashed

- 9.2 ceph集群出现警告 mons are allowing insecure global_id reclaim

- 9.3 rook部署ceph集群某个pod异常或者pending状态

- 9.4 PVC处于pending状态

- 9.5 rook-ceph osd down格式化硬盘重新挂载

- 十.ceph集群常用命令

- 10.1查看集群状态命令

- 10.2 Ceph mds命令

- 10.3 ceph osd命令

- 10.4 ceph pg命令

- 10.5 ceph osd pool命令

- 10.6 rados命令

六.Rook部署云原生CephFS文件系统

6.1 部署cephfs storageclass

cephfs文件系统与RBD服务类似,要想在kubernetes pod里使用cephfs,需要创建一个cephfs-provisioner storageclass服务,在rook代码里已有资源文件,单独部署即可[root@node1 examples]#

kubectl create -f deploy/examples/csi/cephfs/storageclass.yaml查看cephfs storageclass名称

[root@node1 examples]# kubectl get storageclasses.storage.k8s.io | grep rook-cephfs

rook-cephfs rook-ceph.cephfs.csi.ceph.com Delete Immediate true 21d

[root@node1 examples]#

6.2 创建容器所需cephfs文件系统

创建容器所需pvc指定rook部署rook-cephfs存储类名称

[root@node1 cephfs]# cat pvc.yaml

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:name: cephfs-pvc

spec:accessModes:- ReadWriteOnceresources:requests:storage: 1GistorageClassName: rook-cephfs

[root@node1 cephfs]#

[root@node1 cephfs]# kubectl apply -f pvc.yaml查看pvc所提供是rook-cephfs

[root@node1 cephfs]# kubectl get pvc | grep cephfs-pvc

cephfs-pvc Bound pvc-da18c8f9-00c1-4c39-8c53-68a628fa8bdd 1Gi RWO rook-cephfs 21drook-cephfs 7d23h

[root@node1 cephfs]#

6.3创建容器pod使用rook-cephfs提供pvc

[root@node1 cephfs]# cat pod.yaml

---

apiVersion: v1

kind: Pod

metadata:name: csicephfs-demo-pod

spec:containers:- name: web-serverimage: nginx:latestvolumeMounts:- name: mypvcmountPath: /var/lib/www/htmlvolumes:- name: mypvcpersistentVolumeClaim:claimName: cephfs-pvcreadOnly: false

[root@node1 cephfs]#

[root@node1 cephfs]# kubectl apply -f pod.yaml查看pod运行状况

[root@node1 cephfs]# kubectl get pod | grep cephfs

csicephfs-demo-pod 1/1 Running 0 21d

[root@node1 cephfs]#

6.4 查看pod是否使用rook-cephfs

[root@node1 cephfs]# kubectl exec -it csicephfs-demo-pod -- bash

root@csicephfs-demo-pod:/# df -hT | grep csi-vol

10.68.91.46:6789,10.68.110.0:6789,10.68.225.251:6789:/volumes/csi/csi-vol-50d5c216-3e2a-11ed-9773-9a6110af61d6/f4e696bf-757d-4793-b2c2-3091d38ccec5 ceph 1.0G 0 1.0G 0% /var/lib/www/html

root@csicephfs-demo-pod:/#

root@csicephfs-demo-pod:/# echo "cephfs" > /var/lib/www/html/index.html

root@csicephfs-demo-pod:/# cat /var/lib/www/html/index.html

cephfs

root@csicephfs-demo-pod:/#

注:登录相应pod容器可以看到pod已经挂载cephfs文件系统地址,可以在相应挂载目录创建内容。

七.Ceph Dashboard界面

ceph有一个dashboard web管理界面,通过web界面在可以查看集群的状态,包括总体运行状态,mgr、osd、rgw等服务状态,还可以查看ceph pool池及pg状态等相关信息。

7.1 启用dashboard开关

在cluster.yaml文件中,dashboard.enable=true即可。rookoperator就会启用ceph-mgr dashboard模块,默认已启用。Ceph-dashboard默认会通过service的方式将服务暴露给外部,通过8443的https端口进行访问。

[root@node1 examples]# kubectl get svc -n rook-ceph | grep rook-ceph-mgr-dashboard

rook-ceph-mgr-dashboard ClusterIP 10.68.218.45 <none> 8443/TCP 24d

[root@node1 examples]#

7.2 ceph-dashboard配置外部访问

Dashboard web界面外部访问可以通过ingress或者NodePort方式,这里使用NodePort方式将dashboard服务暴露给kubernetes集群外部访问,外部通过nodeport端口访问dashboard服务。

Dashboard-external-https资源文件应用

[root@node1 examples]# kubectl apply -f dashboard-external-https.yaml查看dashboard nodeport端口32367

[root@node1 examples]# kubectl get svc -n rook-ceph | grep rook-ceph-mgr-dashboard

rook-ceph-mgr-dashboard ClusterIP 10.68.218.45 <none> 8443/TCP 24d

rook-ceph-mgr-dashboard-external-https NodePort 10.68.104.233 <none> 8443:32367/TCP 22d

[root@node1 examples]#

7.3 Dashboard web admin密码查看

用户名默认是admin,密码通过下面方式查看

[root@node1 examples]# kubectl -n rook-ceph get secret rook-ceph-dashboard-password -o jsonpath="{['data']['password']}" | base64 --decode && echo ""

Z(M(@>GBC4TUZXQgT6%$

[root@node1 examples]#

7.4 dashboard web登录查看

Dashboard web界面访问https://node_ip:32367

登录后dashboard界面,ceph集群状态,hosts、monitors、osds、rgw、pools、block等相关信息。

八.Prometheus监控

rook部署ceph集群默认没有安装prometheus监控服务,这里我们使用prometheus以容器化运行在kubernetes中,使用prometheus-operator部署方式。

prometheus监控系统包括组件:

Exporter:监控agent端,用于上报,ceph-mgr默认已提供内置监控指标

Prometheus:服务端用于存储监控数据、提供查询、告警等

Grafana:展示监控信息,通常从prometheus获取监控指标通过模板来展示图表信息

8.1 查看rook-ceph-mgr metrics监控指标

[root@node1 examples]# kubectl get svc -n rook-ceph | grep rook-ceph-mgr

rook-ceph-mgr ClusterIP 10.68.33.103 <none> 9283/TCP 24d

Ceph-mgr metrics监控指标访问

[root@node1 examples]# curl http://10.68.33.103:9283/metrics# HELP ceph_health_status Cluster health status

# TYPE ceph_health_status untyped

ceph_health_status 0.0

# HELP ceph_mon_quorum_status Monitors in quorum

# TYPE ceph_mon_quorum_status gauge

ceph_mon_quorum_status{ceph_daemon="mon.b"} 1.0

ceph_mon_quorum_status{ceph_daemon="mon.c"} 1.0

ceph_mon_quorum_status{ceph_daemon="mon.d"} 1.0

# HELP ceph_fs_metadata FS Metadata

# TYPE ceph_fs_metadata untyped

ceph_fs_metadata{data_pools="5",fs_id="1",metadata_pool="4",name="myfs"} 1.0

# HELP ceph_mds_metadata MDS Metadata

# TYPE ceph_mds_metadata untyped

ceph_mds_metadata{ceph_daemon="mds.myfs-b",fs_id="1",hostname="10.255.82.25",public_addr="172.20.166.175:6801/2538469664",rank="0",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

ceph_mds_metadata{ceph_daemon="mds.myfs-a",fs_id="1",hostname="10.255.82.27",public_addr="172.20.135.49:6801/1468538095",rank="0",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

# HELP ceph_mon_metadata MON Metadata

# TYPE ceph_mon_metadata untyped

ceph_mon_metadata{ceph_daemon="mon.b",hostname="10.255.82.25",public_addr="10.68.225.251",rank="0",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

ceph_mon_metadata{ceph_daemon="mon.c",hostname="10.255.82.26",public_addr="10.68.91.46",rank="1",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

ceph_mon_metadata{ceph_daemon="mon.d",hostname="10.255.82.27",public_addr="10.68.243.187",rank="2",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

# HELP ceph_mgr_metadata MGR metadata

# TYPE ceph_mgr_metadata gauge

ceph_mgr_metadata{ceph_daemon="mgr.b",hostname="10.255.82.25",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

ceph_mgr_metadata{ceph_daemon="mgr.a",hostname="10.255.82.27",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

# HELP ceph_mgr_status MGR status (0=standby, 1=active)

# TYPE ceph_mgr_status gauge

ceph_mgr_status{ceph_daemon="mgr.b"} 0.0

ceph_mgr_status{ceph_daemon="mgr.a"} 1.0

# HELP ceph_mgr_module_status MGR module status (0=disabled, 1=enabled, 2=auto-enabled)

# TYPE ceph_mgr_module_status gauge

ceph_mgr_module_status{name="alerts"} 0.0

ceph_mgr_module_status{name="balancer"} 2.0

ceph_mgr_module_status{name="cephadm"} 0.0

ceph_mgr_module_status{name="crash"} 2.0

ceph_mgr_module_status{name="dashboard"} 1.0

ceph_mgr_module_status{name="devicehealth"} 2.0

ceph_mgr_module_status{name="diskprediction_local"} 0.0

ceph_mgr_module_status{name="influx"} 0.0

ceph_mgr_module_status{name="insights"} 0.0

ceph_mgr_module_status{name="iostat"} 1.0

ceph_mgr_module_status{name="k8sevents"} 0.0

ceph_mgr_module_status{name="localpool"} 0.0

ceph_mgr_module_status{name="mds_autoscaler"} 0.0

ceph_mgr_module_status{name="mirroring"} 0.0

ceph_mgr_module_status{name="nfs"} 1.0

ceph_mgr_module_status{name="orchestrator"} 2.0

ceph_mgr_module_status{name="osd_perf_query"} 0.0

ceph_mgr_module_status{name="osd_support"} 0.0

ceph_mgr_module_status{name="pg_autoscaler"} 2.0

ceph_mgr_module_status{name="progress"} 2.0

ceph_mgr_module_status{name="prometheus"} 1.0

ceph_mgr_module_status{name="rbd_support"} 2.0

ceph_mgr_module_status{name="restful"} 1.0

ceph_mgr_module_status{name="rook"} 0.0

ceph_mgr_module_status{name="selftest"} 0.0

ceph_mgr_module_status{name="snap_schedule"} 0.0

ceph_mgr_module_status{name="stats"} 0.0

ceph_mgr_module_status{name="status"} 2.0

ceph_mgr_module_status{name="telegraf"} 0.0

ceph_mgr_module_status{name="telemetry"} 2.0

ceph_mgr_module_status{name="test_orchestrator"} 0.0

ceph_mgr_module_status{name="volumes"} 2.0

ceph_mgr_module_status{name="zabbix"} 0.0

# HELP ceph_mgr_module_can_run MGR module runnable state i.e. can it run (0=no, 1=yes)

# TYPE ceph_mgr_module_can_run gauge

ceph_mgr_module_can_run{name="alerts"} 1.0

ceph_mgr_module_can_run{name="balancer"} 1.0

ceph_mgr_module_can_run{name="cephadm"} 1.0

ceph_mgr_module_can_run{name="crash"} 1.0

ceph_mgr_module_can_run{name="dashboard"} 1.0

ceph_mgr_module_can_run{name="devicehealth"} 1.0

ceph_mgr_module_can_run{name="diskprediction_local"} 1.0

ceph_mgr_module_can_run{name="influx"} 0.0

ceph_mgr_module_can_run{name="insights"} 1.0

ceph_mgr_module_can_run{name="iostat"} 1.0

ceph_mgr_module_can_run{name="k8sevents"} 1.0

ceph_mgr_module_can_run{name="localpool"} 1.0

ceph_mgr_module_can_run{name="mds_autoscaler"} 1.0

ceph_mgr_module_can_run{name="mirroring"} 1.0

ceph_mgr_module_can_run{name="nfs"} 1.0

ceph_mgr_module_can_run{name="orchestrator"} 1.0

ceph_mgr_module_can_run{name="osd_perf_query"} 1.0

ceph_mgr_module_can_run{name="osd_support"} 1.0

ceph_mgr_module_can_run{name="pg_autoscaler"} 1.0

ceph_mgr_module_can_run{name="progress"} 1.0

ceph_mgr_module_can_run{name="prometheus"} 1.0

ceph_mgr_module_can_run{name="rbd_support"} 1.0

ceph_mgr_module_can_run{name="restful"} 1.0

ceph_mgr_module_can_run{name="rook"} 1.0

ceph_mgr_module_can_run{name="selftest"} 1.0

ceph_mgr_module_can_run{name="snap_schedule"} 1.0

ceph_mgr_module_can_run{name="stats"} 1.0

ceph_mgr_module_can_run{name="status"} 1.0

ceph_mgr_module_can_run{name="telegraf"} 1.0

ceph_mgr_module_can_run{name="telemetry"} 1.0

ceph_mgr_module_can_run{name="test_orchestrator"} 1.0

ceph_mgr_module_can_run{name="volumes"} 1.0

ceph_mgr_module_can_run{name="zabbix"} 1.0

# HELP ceph_osd_metadata OSD Metadata

# TYPE ceph_osd_metadata untyped

ceph_osd_metadata{back_iface="",ceph_daemon="osd.0",cluster_addr="172.20.166.156",device_class="hdd",front_iface="",hostname="10.255.82.25",objectstore="bluestore",public_addr="172.20.166.156",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

ceph_osd_metadata{back_iface="",ceph_daemon="osd.1",cluster_addr="172.20.104.37",device_class="hdd",front_iface="",hostname="10.255.82.26",objectstore="bluestore",public_addr="172.20.104.37",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

ceph_osd_metadata{back_iface="",ceph_daemon="osd.2",cluster_addr="172.20.135.32",device_class="hdd",front_iface="",hostname="10.255.82.27",objectstore="bluestore",public_addr="172.20.135.32",ceph_version="ceph version 17.2.3 (dff484dfc9e19a9819f375586300b3b79d80034d) quincy (stable)"} 1.0

# HELP ceph_disk_occupation Associate Ceph daemon with disk used

.....

.....

.....

[root@node1 examples]#

8.2部署prometheus-operator

[root@node1 examples]#

kubectl apply -f https://raw.githubusercontent.com/coreos/prometheus-operator/v0.40.0/bundle.yamlPrometheus-operator部署后以容器方式运行

[root@node1 examples]# kubectl get pod | grep prometheus-operator

prometheus-operator-5944b5f9dd-5r789 1/1 Running 0 8d

[root@node1 examples]#

8.3 部署prometheus实例

[root@node1 monitoring]# pwd

/opt/rook/deploy/examples/monitoring

[root@node1 monitoring]#

[root@node1 monitoring]# kubectl apply -f prometheus.yaml -f prometheus-service.yaml -f service-monitor.yamlprometheus默认提供了9090端口访问,这里更改nodeport类型方式访问[root@node1 monitoring]# kubectl get svc -n rook-ceph | grep rook-prometheus

rook-prometheus NodePort 10.68.232.216 <none> 9090:30900/TCP 8d

[root@node1 monitoring]#prometheus访问地址http://node_ip:30900

8.4部署grafana

grafana是一个数据展示的平台,数据展示主要依赖后端的数据源。这里使用prometheus作为数据源,grafana作为展示。grafana部署在kubernetes中,参考grafana on kubernetes官方yaml文件。地址如下,根据自己需求进行修改。

https://grafana.com/docs/grafana/latest/setup-grafana/installation/kubernetes/

Grafana.yaml部署资源文件

---apiVersion: v1kind: PersistentVolumeClaimmetadata:name: grafana-pvcspec:accessModes:- ReadWriteOnceresources:requests:storage: 1Gi---apiVersion: apps/v1kind: Deploymentmetadata:labels:app: grafananame: grafanaspec:selector:matchLabels:app: grafanatemplate:metadata:labels:app: grafanaspec:securityContext:fsGroup: 472supplementalGroups:- 0containers:- name: grafanaimage: grafana/grafana:9.1.0imagePullPolicy: IfNotPresentports:- containerPort: 3000name: http-grafanaprotocol: TCPreadinessProbe:failureThreshold: 3httpGet:path: /robots.txtport: 3000scheme: HTTPinitialDelaySeconds: 10periodSeconds: 30successThreshold: 1timeoutSeconds: 2livenessProbe:failureThreshold: 3initialDelaySeconds: 30periodSeconds: 10successThreshold: 1tcpSocket:port: 3000timeoutSeconds: 1resources:requests:cpu: 250mmemory: 750MivolumeMounts:- mountPath: /var/lib/grafananame: grafana-pvvolumes:- name: grafana-pvpersistentVolumeClaim:claimName: grafana-pvc---apiVersion: v1kind: Servicemetadata:name: grafanaspec:ports:- port: 3000protocol: TCPtargetPort: http-grafanaselector:app: grafanasessionAffinity: Nonetype: LoadBalancer# kubectl apply -f grafana.yaml查看grafana运行状态,grafana对外访问使用nodeport形式。

[root@node1 rook]# kubectl get pod,svc | grep grafana

pod/grafana-b8b88d68-z8qpf 1/1 Running 2 (8d ago) 8d

service/grafana NodePort 10.68.99.199 <none> 3000:30780/TCP 8d

[root@node1 rook]#grafana访问地址如下,默认用户名和密码均为admin。登录后需要修改密码。

http://node_ip:30780

8.5配置grafana监控ceph模板

通常下面模板已满足ceph集群监控信息

ceph-cluster模板ID:2842

ceph-osd 模板ID:5336

ceph-pool 模板ID:5342

导入模板ID步骤1

导入模板ID步骤2,输入ID载入即可

8.6 在grafana上查看ceph集群状态

九.常见故障排查

9.1 ceph集群出现警告mgr modules have recently crashed

解决方法:

# kubectl exec -it rook-ceph-tools-5d8c78cd5b-kr6m9 -n rook-ceph -- bashbash-4.4$ ceph crash ls-new

ID ENTITY NEW

bash-4.4$ ceph crash archive 2022-09-30T07:59:23.681099Z_31814cfb-a08d-423e-b8dd-b5f0fd4fb097

bash-4.4$bash-4.4$ ceph health

HEALTH_OK

bash-4.4$

9.2 ceph集群出现警告 mons are allowing insecure global_id reclaim

解决方法:

ceph config set mon auth_allow_insecure_global_id_reclaim false

9.3 rook部署ceph集群某个pod异常或者pending状态

解决问题思路:

1.查看pod log查看容器内部异常日志信息

2.通过describe查看pod事件异常信息

9.4 PVC处于pending状态

解决问题思路:

1.集群中确认是否有OSD

2.CSI配置程序pod未运行或者未响应配置存储的请求

9.5 rook-ceph osd down格式化硬盘重新挂载

// 重新格式化硬盘准备

# yum -y install gdisk

# kubectl -n rook-ceph scale deployment rook-ceph-operator --replicas=0

deployment.apps/rook-ceph-operator scaled// 查询osd的状态,找到要移除的osd id

# ceph osd status// ID为2的osd标识为out,此时会进⾏元数据的同步

# ceph osd out osd.2

# ceph osd purge 2 --yes-i-really-mean-it// 删除ID为2的OSD

# ceph auth del osd.2

entity osd.2 does not exist// 删除相关osd节点的deployment

# kubectl delete deploy -n rook-ceph rook-ceph-osd-2

deployment.apps "rook-ceph-osd-2" deleted// 删除硬盘分区信息

# sgdisk --zap-all /dev/sdb

Creating new GPT entries.

GPT data structures destroyed! You may now partition the disk using fdisk or

other utilities.// 清理硬盘数据(hdd硬盘使用dd,ssd硬盘使用blkdiscard,二选一)

# dd if=/dev/zero of="/dev/sdb" bs=1M count=500000 oflag=direct,dsync

500000+0 records in

500000+0 records out

524288000000 bytes (524 GB) copied, 258.146 s, 2.0 GB/s// ssd硬盘选择此命令

# blkdiscard /dev/sdb// 删除原osd的lvm信息(如果单个节点有多个osd,那么就不能用*拼配模糊删除,而根据lsblk -f查询出明确的lv映射信息再具体删除)

ls /dev/mapper/ceph-* | xargs -I% -- dmsetup remove %

rm -rf /dev/ceph-*

lsblk -f// 恢复rook的operator,使检测到格式化后的osd硬盘,osd启动后ceph集群会自动平衡数据

kubectl -n rook-ceph scale deployment rook-ceph-operator --replicas=1

deployment.aps/rook-ceph-operator scaled

十.ceph集群常用命令

10.1查看集群状态命令

ceph -v //查看ceph的版本

ceph -s //查看集群的状态

ceph -w //监控集群的实时更改|查看正在操作的动作

ceph osd tree #查看osd目录树

ceph osd df //详细列出集群每块磁盘的使用情况|查看osd的使用信息

ceph osd stat #查看osd状态

ceph mon stat //查看mon状态

ceph mds stat # 检查 MDS 状态

ceph osd find osd.o//查看osd.0节点ip和主机名

ceph auth get client.admin # 查看ceph授权信息

10.2 Ceph mds命令

ceph mds

ceph mds stat #查看msd状态

ceph mds dump #msd的映射信息

ceph mds rm 0 mds.node1#删除一个mds节点

10.3 ceph osd命令

ceph osd stat #查看osd状态

ceph osd dump #osd的映射信息

ceph osd tree#查看osd目录树

ceph osd down 0 #down掉osd.0节点

ceph osd rm 0#集群删除一个osd硬盘

ceph osd crush remove osd.4#删除标记

ceph osd getmaxosd#查看最大osd个数

ceph osd setmaxosd 10#设置osd的个数

ceph osd out osd.3#把一个osd节点逐出集群

ceph osd in osd.3#把逐出的osd加入集群

ceph osd pause#暂停osd (暂停后整个集群不再接收数据)

ceph osd unpause#再次开启osd (开启后再次接收数据)

ceph osd df //查看osd的使用信息

要定位对象,只需要对象名和存储池名字即可,例如:

ceph osd map {poolname} {object-name}

10.4 ceph pg命令

ceph pg stat#查看pg状态

ceph pg dump#查看pg组的映射信息

ceph pg map 0.3f#查看一个pg的map //查看单个pg和osd的映射信息

ceph pg 0.26 query#查看pg详细信息

ceph pg dump --format plain#显示一个集群中的所有的pg统计

ceph pg {pg-id} query //获取pg的详细信息

10.5 ceph osd pool命令

ceph osd lspools #查看ceph集群中的pool数量

创建和删除存储池

ceph osd pool create myPoolName 100#创建一个pool 这里的100指的是PG组

ceph osd pool delete myPoolName myPoolName --yes-i-really-really-mean-it #删除,集群名字需要重复两次

rados df#显示集群中pool的详细信息

ceph osd pool get data pg_num #查看data池的pg数量

ceph osd pool set data target_max_bytes 100000000000000#设置data池的最大存储空间为100T(默认是1T)

ceph osd pool set data size 3 #设置data池的副本数是3

ceph osd pool set data min_size 2 #设置data池能接受写操作的最小副本为2

ceph osd pool set data pg_num 100#设置一个pool的pg数量

ceph osd pool set data pgp_num 100#设置一个pool的pgp数量

ceph osd pool ls //查看集群中的存储池名称

ceph osd pool ls detail //查看池的的详细信息

ceph osd pool stats //查看池的IO情况

10.6 rados命令

rados lspools#查看ceph集群中有多少个pool (只是查看pool)

rados df #查看存储池使用情况:多少个pool,每个pool容量及利用情况

rados mkpool test#创建一个pool,名字:test

rados create testobject -p testpool#testpool中创建一个对象testobject

rados rm test-object-1 -p test#删除(test存储池的)一个对象object

rados -p test ls #查看存储池test的对象

相关文章:

Rook入门:打造云原生Ceph存储的全面学习路径(下)

文章目录 六.Rook部署云原生CephFS文件系统6.1 部署cephfs storageclass6.2 创建容器所需cephfs文件系统6.3创建容器pod使用rook-cephfs提供pvc6.4 查看pod是否使用rook-cephfs 七.Ceph Dashboard界面7.1 启用dashboard开关7.2 ceph-dashboard配置外部访问7.3 Dashboard web ad…...

RabbitMQ消息可靠性保证机制6--可靠性分析

在使用消息中间件的过程中,难免会出现消息错误或者消息丢失等异常情况。这个时候就需要有一个良好的机制来跟踪记录消息的过程(轨迹溯源),帮助我们排查问题。 在RabbitMQ中可以使用Firehose实现消息的跟踪,Firehose可…...

k8s容器存储接口 CSI 相关知识

容器存储接口 CSI 相关知识 参考: https://blog.csdn.net/lovely_nn/article/details/122880876 https://developer.aliyun.com/article/783464 https://www.cnblogs.com/varden/p/15139819.html存储商需实现 CSI 插件的 NodeGetVolumeStats 接口,Kube…...

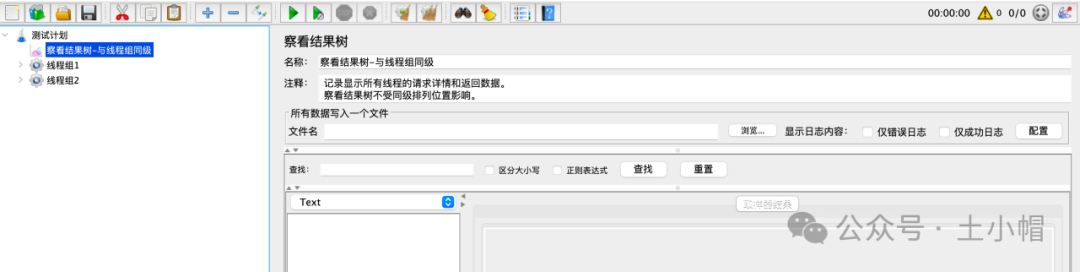

jmeter基础_打开1个jmeter脚本(.jmx文件)

课程大纲 方法1.菜单栏“打开” 菜单栏“文件” - “打开” (或快捷键,mac为“⌘ O”),打开文件选择窗口 - 选择脚本文件,点击“open”,即可打开脚本。 方法2.工具栏“打开”图标 工具栏点击“打开”图标&…...

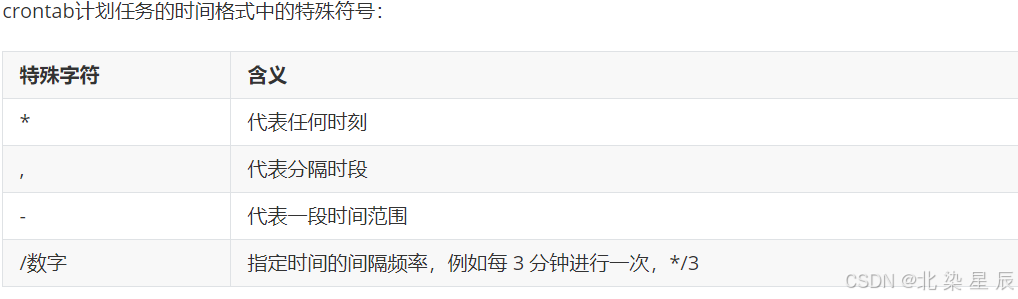

Linux---对时/定时服务

文章目录 目录 文章目录 前言 一.对时服务 服务端配置 客户端配置 二.定时服务 单次定时任务 循环定时任务 前言 在当今信息化高速发展的时代,时间的准确性和任务的定时执行对于各种系统和服务来说至关重要。Linux操作系统,凭借其强大的功能和灵活的…...

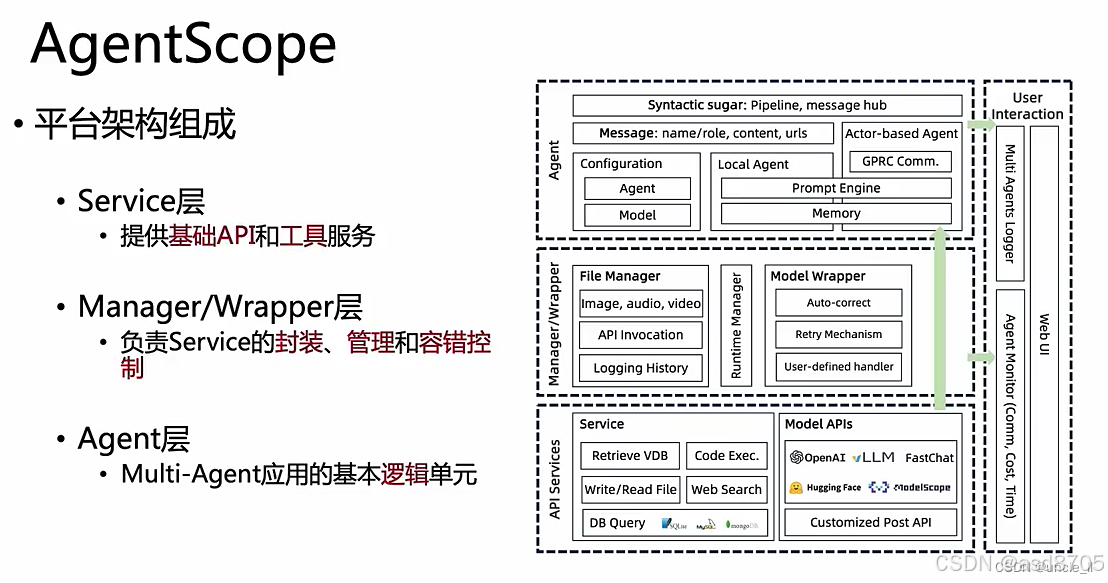

Agent

Agent核心 1、自主性 2、交互性 3、适应性 4、目的性 ReAct Reasoning and Acting范式 模型的推理过程分为 推理 Reason 和行动 Action 两个步骤,交替执行,直至获得最终结果。 推理 Reason 生成分析步骤,解释当前任务的上下文或状态…...

Oracle 数据库执行增删改查命令的原理与过程

摘要: 本文深入探讨当向 Oracle 数据库发送一个增删改查(CRUD)命令时,数据库内部的执行机制与详细过程。从用户发起命令开始,逐步剖析命令在 Oracle 数据库体系结构各组件中的流转、解析、优化以及执行路径,…...

HBase难点

查询优化 一次Scan会返回大量数据,客户端向HBase发送一次Scan请求,实际上并不会将所有数据加载到本地,而是通过多次RPC请求进行加载,防止客户端OOM。禁止缓存优化:批量读取数据时会全表扫描一次业务表,这种…...

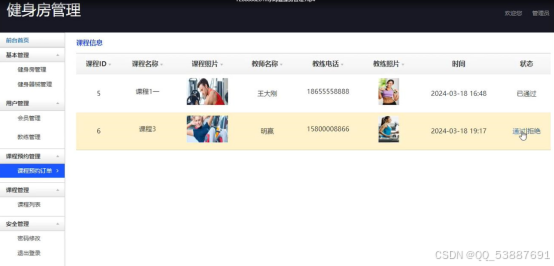

Y20030023 PHP+thinkphp+MYSQL+LW+基于PHP的健身房管理系统的设计与实现 源代码 配置 初稿

基于PHP的健身房管理系统 1.项目摘要2. 系统开发的背景及意义3.项目功能4.界面展示5.源码获取 1.项目摘要 近年来,随着社会发展和科技进步,人们越来越重视健康养生并关注电子商务对日常交流方式的影响。随着健身行业消费人群的增加,竞争变得…...

mongodb下载与使用

下载地址: Install MongoDB Community Kubernetes Operator | MongoDB 1、安装MongoDB (5.0.30) 将压缩包移动到C:\Program Files 下,然后解压创建C:\data\db目录,mongodb 会将数据默认保存在这个文件夹以mongodb 中 bin目录作为工作目录&…...

【Linux基础】Linux基本指令

目录 1、pwd 指令 2、clear 指令 3、ls 指令 1、ls 显示当前路径下的文件或者目录名称 2、ls -l 显示当前路径下的文件或者目录的更详细的属性信息 3、ls -a :显示所有文件,包括隐藏文件 4、ls -d 将目录像文件一样显示,而不是显示其…...

【RISC-V CPU debug 专栏 3 -- Debugging RISC-V Cores】

文章目录 RISC-V 调试规范开源与多样性挑战调试规范的重要性外部调试支持的主要组件调试功能Lauterbach 的贡献RISC-V 调试规范 调试 RISC-V 内核涉及许多独特的挑战,这是由 RISC-V 的开源特性和多样化的生态系统所决定的。为了避免专有调试接口的泛滥,RISC-V 基金会内的工作…...

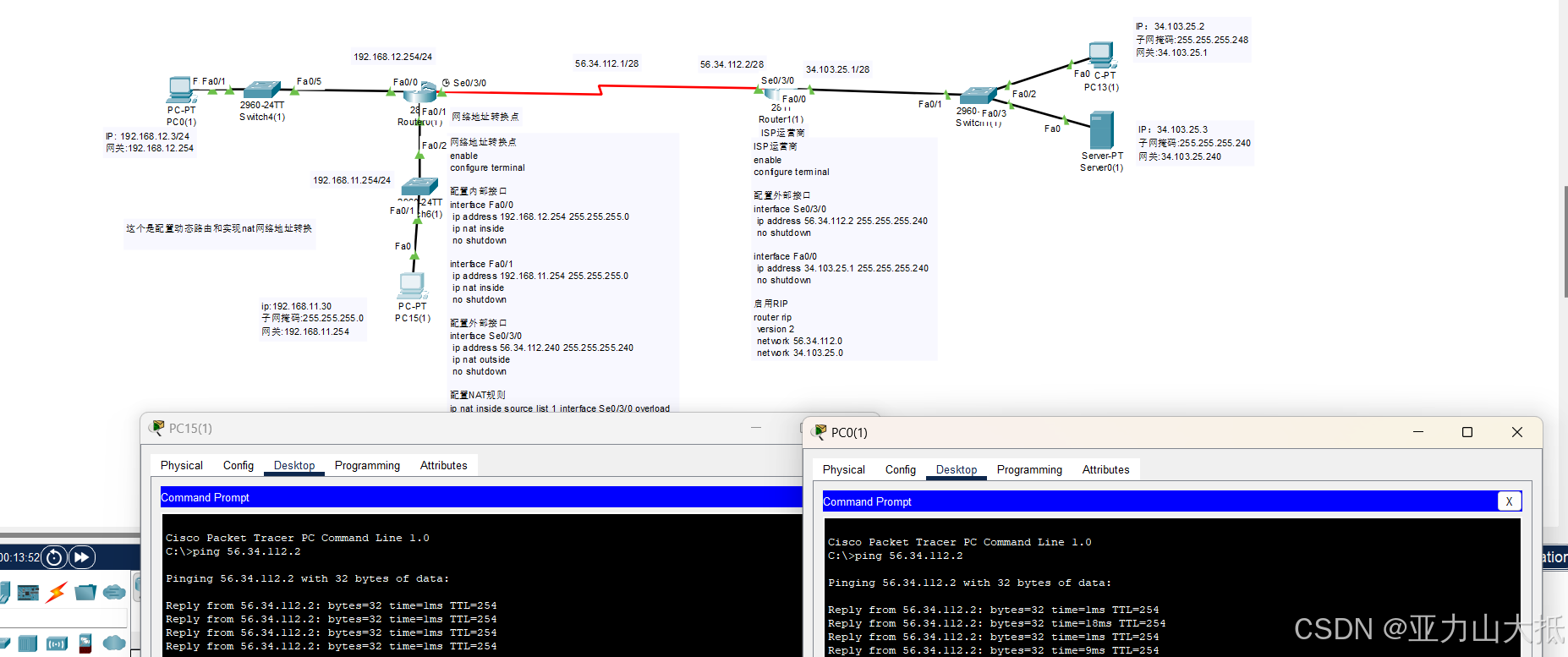

思科实现网络地址转换(NAT)和访问控制列表(ACL)和动态路由配置并且区分静态路由和动态路由配置。

实验拓扑(分为静态路由和动态路由两种) 静态路由互通 动态路由互通 实验背景 这个是想实现外网与内网的连接跟网络的探讨,最终实现互通以及使用并且在网络地址转换后能使用网络然后再这个基础上再配置访问控制列表和网络地址转换的的学习过程。 实验需了解的知识…...

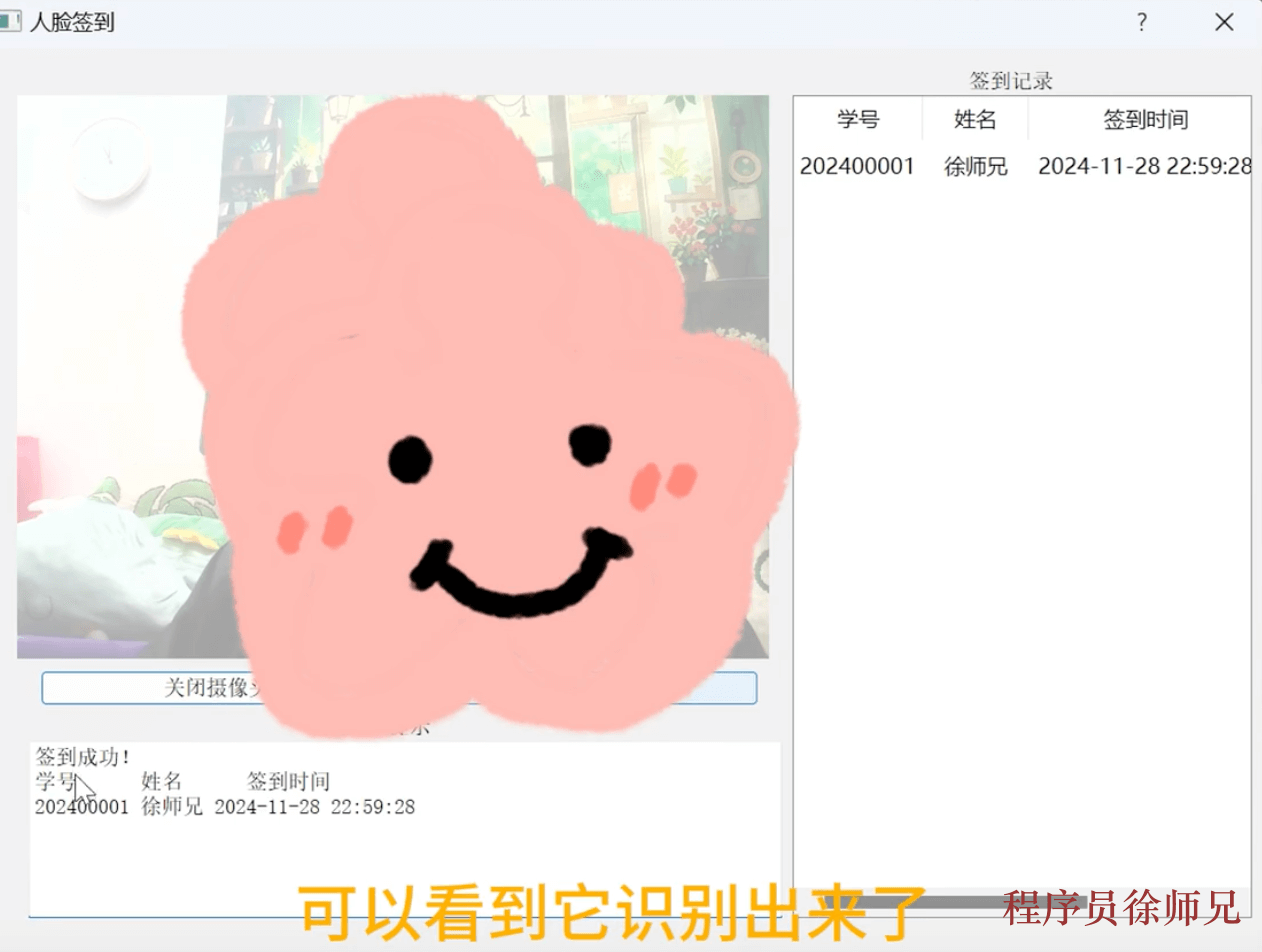

基于 Python、OpenCV 和 PyQt5 的人脸识别上课打卡系统

大家好,我是Java徐师兄,今天为大家带来的是基于 Python、OpenCV 和 PyQt5 的人脸识别上课签到系统。该系统采用 Python 语言开发,开发过程中采用了OpenCV框架,Sqlite db 作为数据库,系统功能完善 ,实用性强…...

MySQL 复合查询

实际开发中往往数据来自不同的表,所以需要多表查询。本节我们用一个简单的公司管理系统,有三张表EMP,DEPT,SALGRADE 来演示如何进行多表查询。表结构的代码以及插入的数据如下: DROP database IF EXISTS scott; CREATE database IF NOT EXIST…...

【Leetcode】19. 删除链表的第N个节点

【Leetcode】19. 删除链表的第N个节点 1. 题目介绍2. 方法一:计算链表长度逻辑流程:代码复杂度分析 1. 题目介绍 题目描述 给你一个链表,删除链表的倒数第 n 个结点,并且返回链表的头结点。 示例 1: 输入:head [1,2,…...

flutter底部导航栏中间按钮凸起,导航栏中间部分凹陷效果

关键代码: Scaffold中设置floatingActionButtonLocation: FloatingActionButtonLocation.centerDocked和extendBody: true, BottomAppBar中设置shape: const CircularNotchedRectangle() Scaffold(extendBody: true,//body是否延伸脚手架底部,在底部导航…...

<项目代码>YOLOv8 红绿灯识别<目标检测>

YOLOv8是一种单阶段(one-stage)检测算法,它将目标检测问题转化为一个回归问题,能够在一次前向传播过程中同时完成目标的分类和定位任务。相较于两阶段检测算法(如Faster R-CNN),YOLOv8具有更高的…...

HTMLHTML5革命:构建现代网页的终极指南 - 4. 使用元素

HTML&HTML5革命:构建现代网页的终极指南 4. 使用元素 大家好,我是莫离老师。 到目前为止,我们已经了解了 HTML 和 HTML5 的基础概念,并且选择了适合自己的开发工具。 今天,我们将迈出实际开发的第一步,…...

使用 Selenium 和 Python 爬取腾讯新闻:从基础到实践

使用 Selenium 和 Python 爬取腾讯新闻:从基础到实践 在这篇博客中,我们将介绍如何利用 Selenium 和 Python 爬取腾讯新闻的内容,并将结果保存到 CSV 文件中。本教程包含以下内容: 项目简介依赖安装实现功能的代码实现中的关键技…...

【人工智能】神经网络的优化器optimizer(二):Adagrad自适应学习率优化器

一.自适应梯度算法Adagrad概述 Adagrad(Adaptive Gradient Algorithm)是一种自适应学习率的优化算法,由Duchi等人在2011年提出。其核心思想是针对不同参数自动调整学习率,适合处理稀疏数据和不同参数梯度差异较大的场景。Adagrad通…...

《Qt C++ 与 OpenCV:解锁视频播放程序设计的奥秘》

引言:探索视频播放程序设计之旅 在当今数字化时代,多媒体应用已渗透到我们生活的方方面面,从日常的视频娱乐到专业的视频监控、视频会议系统,视频播放程序作为多媒体应用的核心组成部分,扮演着至关重要的角色。无论是在个人电脑、移动设备还是智能电视等平台上,用户都期望…...

MFC内存泄露

1、泄露代码示例 void X::SetApplicationBtn() {CMFCRibbonApplicationButton* pBtn GetApplicationButton();// 获取 Ribbon Bar 指针// 创建自定义按钮CCustomRibbonAppButton* pCustomButton new CCustomRibbonAppButton();pCustomButton->SetImage(IDB_BITMAP_Jdp26)…...

大模型多显卡多服务器并行计算方法与实践指南

一、分布式训练概述 大规模语言模型的训练通常需要分布式计算技术,以解决单机资源不足的问题。分布式训练主要分为两种模式: 数据并行:将数据分片到不同设备,每个设备拥有完整的模型副本 模型并行:将模型分割到不同设备,每个设备处理部分模型计算 现代大模型训练通常结合…...

Android 之 kotlin 语言学习笔记三(Kotlin-Java 互操作)

参考官方文档:https://developer.android.google.cn/kotlin/interop?hlzh-cn 一、Java(供 Kotlin 使用) 1、不得使用硬关键字 不要使用 Kotlin 的任何硬关键字作为方法的名称 或字段。允许使用 Kotlin 的软关键字、修饰符关键字和特殊标识…...

有限自动机到正规文法转换器v1.0

1 项目简介 这是一个功能强大的有限自动机(Finite Automaton, FA)到正规文法(Regular Grammar)转换器,它配备了一个直观且完整的图形用户界面,使用户能够轻松地进行操作和观察。该程序基于编译原理中的经典…...

C++:多态机制详解

目录 一. 多态的概念 1.静态多态(编译时多态) 二.动态多态的定义及实现 1.多态的构成条件 2.虚函数 3.虚函数的重写/覆盖 4.虚函数重写的一些其他问题 1).协变 2).析构函数的重写 5.override 和 final关键字 1&#…...

并发编程 - go版

1.并发编程基础概念 进程和线程 A. 进程是程序在操作系统中的一次执行过程,系统进行资源分配和调度的一个独立单位。B. 线程是进程的一个执行实体,是CPU调度和分派的基本单位,它是比进程更小的能独立运行的基本单位。C.一个进程可以创建和撤销多个线程;同一个进程中…...

【学习笔记】erase 删除顺序迭代器后迭代器失效的解决方案

目录 使用 erase 返回值继续迭代使用索引进行遍历 我们知道类似 vector 的顺序迭代器被删除后,迭代器会失效,因为顺序迭代器在内存中是连续存储的,元素删除后,后续元素会前移。 但一些场景中,我们又需要在执行删除操作…...

error)

【前端异常】JavaScript错误处理:分析 Uncaught (in promise) error

在前端开发中,JavaScript 异常是不可避免的。随着现代前端应用越来越多地使用异步操作(如 Promise、async/await 等),开发者常常会遇到 Uncaught (in promise) error 错误。这个错误是由于未正确处理 Promise 的拒绝(r…...