kubernetes教程 --Pod调度

Pod调度

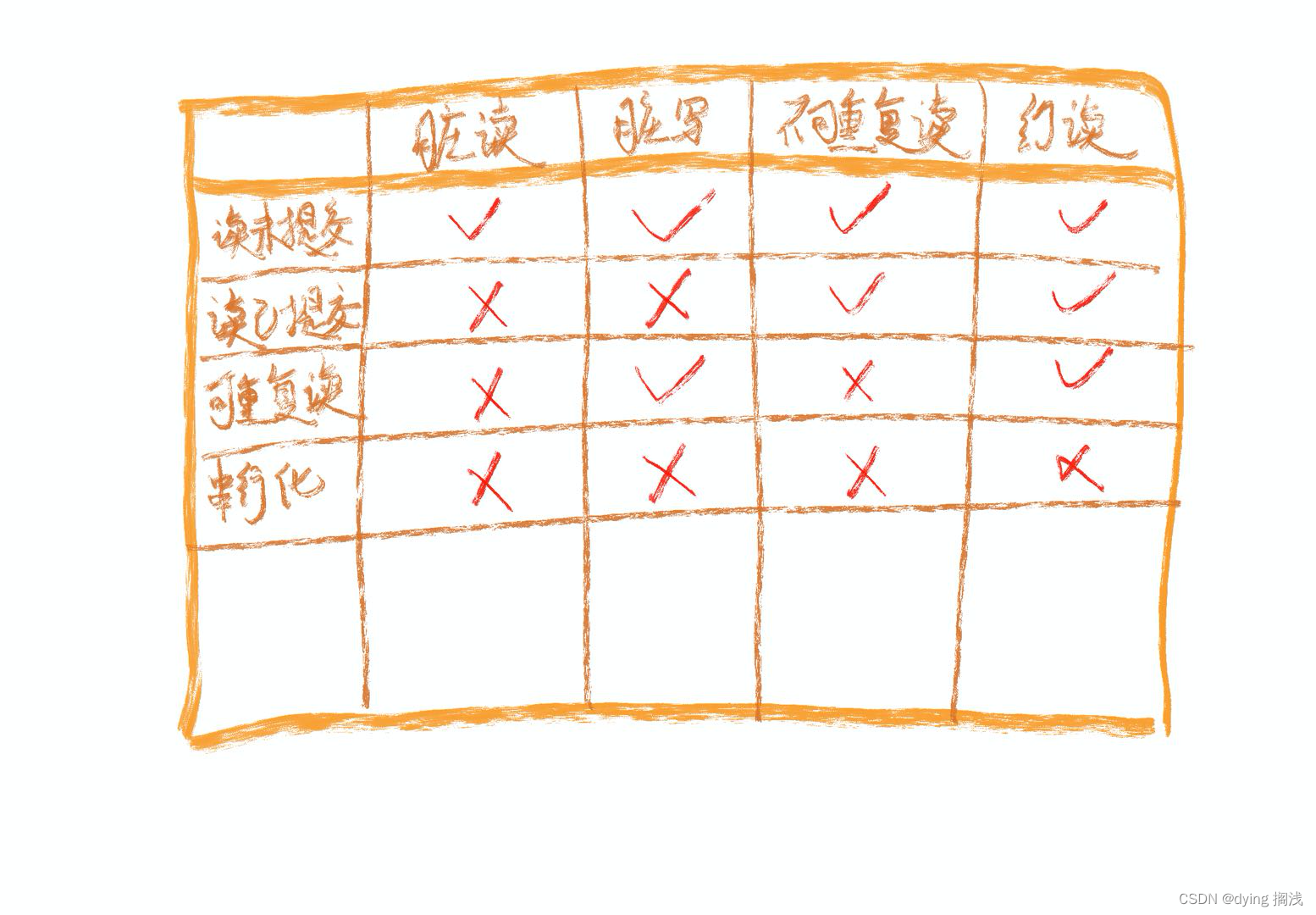

在默认情况下,一个Pod在哪个Node节点上运行,是由Scheduler组件采用相应的算法计算出来的,这个过程是不受人工控制的。但是在实际使用中,这并不满足的需求,因为很多情况下,我们想控制某些Pod到达某些节点上,那么应该怎么做呢?这就要求了解kubernetes对Pod的调度规则,kubernetes提供了四大类调度方式:

- 自动调度:运行在哪个节点上完全由Scheduler经过一系列的算法计算得出

- 定向调度:NodeName、NodeSelector

- 亲和性调度:NodeAffinity、PodAffinity、PodAntiAffinity

- 污点(容忍)调度:Taints、Toleration

定向调度

定向调度,指的是利用在pod上声明nodeName或者nodeSelector,以此将Pod调度到期望的node节点上。注意,这里的调度是强制的,这就意味着即使要调度的目标Node不存在,也会向上面进行调度,只不过pod运行失败而已。

NodeName

NodeName用于强制约束将Pod调度到指定的Name的Node节点上。这种方式,其实是直接跳过Scheduler的调度逻辑,直接将Pod调度到指定名称的节点。

接下来,实验一下:创建一个pod-nodename.yaml文件

使用 kubectl get node 来查看当前节点

apiVersion: v1

kind: Pod

metadata:name: pod-nodenamenamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1nodeName: node1 # 指定调度到node1节点上

#创建Pod

[root@k8s-master01 ~]# kubectl create -f pod-nodename.yaml

pod/pod-nodename created#查看Pod调度到NODE属性,确实是调度到了node1节点上

[root@k8s-master01 ~]# kubectl get pods pod-nodename -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE ......

pod-nodename 1/1 Running 0 56s 10.244.1.87 node1 ...... # 接下来,删除pod,修改nodeName的值为node3(并没有node3节点)

[root@k8s-master01 ~]# kubectl delete -f pod-nodename.yaml

pod "pod-nodename" deleted

[root@k8s-master01 ~]# vim pod-nodename.yaml

[root@k8s-master01 ~]# kubectl create -f pod-nodename.yaml

pod/pod-nodename created#再次查看,发现已经向Node3节点调度,但是由于不存在node3节点,所以pod无法正常运行

[root@k8s-master01 ~]# kubectl get pods pod-nodename -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE ......

pod-nodename 0/1 Pending 0 6s <none> node3 ......

NodeSelector

NodeSelector用于将pod调度到添加了指定标签的node节点上。它是通过kubernetes的label-selector机制实现的,也就是说,在pod创建之前,会由scheduler使用MatchNodeSelector调度策略进行label匹配,找出目标node,然后将pod调度到目标节点,该匹配规则是强制约束。

接下来,实验一下:

1 首先分别为node节点添加标签

[root@k8s-master01 ~]# kubectl label nodes node1 nodeenv=pro

node/node2 labeled

[root@k8s-master01 ~]# kubectl label nodes node2 nodeenv=test

node/node2 labeled

2 创建一个pod-nodeselector.yaml文件,并使用它创建Pod

apiVersion: v1

kind: Pod

metadata:name: pod-nodeselectornamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1nodeSelector: nodeenv: pro # 指定调度到具有nodeenv=pro标签的节点上

#创建Pod

[root@k8s-master01 ~]# kubectl create -f pod-nodeselector.yaml

pod/pod-nodeselector created#查看Pod调度到NODE属性,确实是调度到了node1节点上

[root@k8s-master01 ~]# kubectl get pods pod-nodeselector -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE ......

pod-nodeselector 1/1 Running 0 47s 10.244.1.87 node1 ......# 接下来,删除pod,修改nodeSelector的值为nodeenv: xxxx(不存在打有此标签的节点)

[root@k8s-master01 ~]# kubectl delete -f pod-nodeselector.yaml

pod "pod-nodeselector" deleted

[root@k8s-master01 ~]# vim pod-nodeselector.yaml

[root@k8s-master01 ~]# kubectl create -f pod-nodeselector.yaml

pod/pod-nodeselector created#再次查看,发现pod无法正常运行,Node的值为none

[root@k8s-master01 ~]# kubectl get pods -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE

pod-nodeselector 0/1 Pending 0 2m20s <none> <none># 查看详情,发现node selector匹配失败的提示

[root@k8s-master01 ~]# kubectl describe pods pod-nodeselector -n dev

.......

Events:Type Reason Age From Message---- ------ ---- ---- -------Warning FailedScheduling <unknown> default-scheduler 0/3 nodes are available: 3 node(s) didn't match node selector.

亲和性调度

上一节,介绍了两种定向调度的方式,使用起来非常方便,但是也有一定的问题,那就是如果没有满足条件的Node,那么Pod将不会被运行,即使在集群中还有可用Node列表也不行,这就限制了它的使用场景。

基于上面的问题,kubernetes还提供了一种亲和性调度(Affinity)。它在NodeSelector的基础之上的进行了扩展,可以通过配置的形式,实现优先选择满足条件的Node进行调度,如果没有,也可以调度到不满足条件的节点上,使调度更加灵活。

Affinity主要分为三类:

- nodeAffinity(node亲和性): 以node为目标,解决pod可以调度到哪些node的问题

- podAffinity(pod亲和性) : 以pod为目标,解决pod可以和哪些已存在的pod部署在同一个拓扑域中的问题

- podAntiAffinity(pod反亲和性) : 以pod为目标,解决pod不能和哪些已存在pod部署在同一个拓扑域中的问题

关于亲和性(反亲和性)使用场景的说明:

亲和性:如果两个应用频繁交互,那就有必要利用亲和性让两个应用的尽可能的靠近,这样可以减少因网络通信而带来的性能损耗。

反亲和性:当应用的采用多副本部署时,有必要采用反亲和性让各个应用实例打散分布在各个node上,这样可以提高服务的高可用性。

NodeAffinity

首先来看一下NodeAffinity的可配置项:

pod.spec.affinity.nodeAffinityrequiredDuringSchedulingIgnoredDuringExecution Node节点必须满足指定的所有规则才可以,相当于硬限制nodeSelectorTerms 节点选择列表matchFields 按节点字段列出的节点选择器要求列表matchExpressions 按节点标签列出的节点选择器要求列表(推荐)key 键values 值operat or 关系符 支持Exists, DoesNotExist, In, NotIn, Gt, LtpreferredDuringSchedulingIgnoredDuringExecution 优先调度到满足指定的规则的Node,相当于软限制 (倾向)preference 一个节点选择器项,与相应的权重相关联matchFields 按节点字段列出的节点选择器要求列表matchExpressions 按节点标签列出的节点选择器要求列表(推荐)key 键values 值operator 关系符 支持In, NotIn, Exists, DoesNotExist, Gt, Ltweight 倾向权重,在范围1-100。

关系符的使用说明:- matchExpressions:- key: nodeenv # 匹配存在标签的key为nodeenv的节点operator: Exists- key: nodeenv # 匹配标签的key为nodeenv,且value是"xxx"或"yyy"的节点operator: Invalues: ["xxx","yyy"]- key: nodeenv # 匹配标签的key为nodeenv,且value大于"xxx"的节点operator: Gtvalues: "xxx"

接下来首先演示一下requiredDuringSchedulingIgnoredDuringExecution ,

创建pod-nodeaffinity-required.yaml

apiVersion: v1

kind: Pod

metadata:name: pod-nodeaffinity-requirednamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1affinity: #亲和性设置nodeAffinity: #设置node亲和性requiredDuringSchedulingIgnoredDuringExecution: # 硬限制nodeSelectorTerms:- matchExpressions: # 匹配env的值在["xxx","yyy"]中的标签- key: nodeenvoperator: Invalues: ["xxx","yyy"]# 创建pod

[root@k8s-master01 ~]# kubectl create -f pod-nodeaffinity-required.yaml

pod/pod-nodeaffinity-required created# 查看pod状态 (运行失败)

[root@k8s-master01 ~]# kubectl get pods pod-nodeaffinity-required -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE ......

pod-nodeaffinity-required 0/1 Pending 0 16s <none> <none> ......# 查看Pod的详情

# 发现调度失败,提示node选择失败

[root@k8s-master01 ~]# kubectl describe pod pod-nodeaffinity-required -n dev

......Warning FailedScheduling <unknown> default-scheduler 0/3 nodes are available: 3 node(s) didn't match node selector.Warning FailedScheduling <unknown> default-scheduler 0/3 nodes are available: 3 node(s) didn't match node selector.#接下来,停止pod

[root@k8s-master01 ~]# kubectl delete -f pod-nodeaffinity-required.yaml

pod "pod-nodeaffinity-required" deleted# 修改文件,将values: ["xxx","yyy"]------> ["pro","yyy"]

[root@k8s-master01 ~]# vim pod-nodeaffinity-required.yaml# 再次启动

[root@k8s-master01 ~]# kubectl create -f pod-nodeaffinity-required.yaml

pod/pod-nodeaffinity-required created# 此时查看,发现调度成功,已经将pod调度到了node1上

[root@k8s-master01 ~]# kubectl get pods pod-nodeaffinity-required -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE ......

pod-nodeaffinity-required 1/1 Running 0 11s 10.244.1.89 node1 ......

接下来再演示一下requiredDuringSchedulingIgnoredDuringExecution ,

创建pod-nodeaffinity-preferred.yaml

apiVersion: v1

kind: Pod

metadata:name: pod-nodeaffinity-preferrednamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1affinity: #亲和性设置nodeAffinity: #设置node亲和性preferredDuringSchedulingIgnoredDuringExecution: # 软限制- weight: 1preference:matchExpressions: # 匹配env的值在["xxx","yyy"]中的标签(当前环境没有)- key: nodeenvoperator: Invalues: ["xxx","yyy"]

# 创建pod

[root@k8s-master01 ~]# kubectl create -f pod-nodeaffinity-preferred.yaml

pod/pod-nodeaffinity-preferred created# 查看pod状态 (运行成功)

[root@k8s-master01 ~]# kubectl get pod pod-nodeaffinity-preferred -n dev

NAME READY STATUS RESTARTS AGE

pod-nodeaffinity-preferred 1/1 Running 0 40sNodeAffinity规则设置的注意事项:1 如果同时定义了nodeSelector和nodeAffinity,那么必须两个条件都得到满足,Pod才能运行在指定的Node上2 如果nodeAffinity指定了多个nodeSelectorTerms,那么只需要其中一个能够匹配成功即可3 如果一个nodeSelectorTerms中有多个matchExpressions ,则一个节点必须满足所有的才能匹配成功4 如果一个pod所在的Node在Pod运行期间其标签发生了改变,不再符合该Pod的节点亲和性需求,则系统将忽略此变化

PodAffinity

PodAffinity主要实现以运行的Pod为参照,实现让新创建的Pod跟参照pod在一个区域的功能。

首先来看一下PodAffinity的可配置项:

pod.spec.affinity.podAffinityrequiredDuringSchedulingIgnoredDuringExecution 硬限制namespaces 指定参照pod的namespacetopologyKey 指定调度作用域labelSelector 标签选择器matchExpressions 按节点标签列出的节点选择器要求列表(推荐)key 键values 值operator 关系符 支持In, NotIn, Exists, DoesNotExist.matchLabels 指多个matchExpressions映射的内容preferredDuringSchedulingIgnoredDuringExecution 软限制podAffinityTerm 选项namespaces topologyKeylabelSelectormatchExpressions key 键values 值operatormatchLabels weight 倾向权重,在范围1-100

topologyKey用于指定调度时作用域,例如:如果指定为kubernetes.io/hostname,那就是以Node节点为区分范围如果指定为beta.kubernetes.io/os,则以Node节点的操作系统类型来区分

接下来,演示下requiredDuringSchedulingIgnoredDuringExecution,

1)首先创建一个参照Pod,pod-podaffinity-target.yaml:

apiVersion: v1

kind: Pod

metadata:name: pod-podaffinity-targetnamespace: devlabels:podenv: pro #设置标签

spec:containers:- name: nginximage: nginx:1.17.1nodeName: node1 # 将目标pod名确指定到node1上

# 启动目标pod

[root@k8s-master01 ~]# kubectl create -f pod-podaffinity-target.yaml

pod/pod-podaffinity-target created# 查看pod状况

[root@k8s-master01 ~]# kubectl get pods pod-podaffinity-target -n dev

NAME READY STATUS RESTARTS AGE

pod-podaffinity-target 1/1 Running 0 4s

2)创建pod-podaffinity-required.yaml,内容如下:

apiVersion: v1

kind: Pod

metadata:name: pod-podaffinity-requirednamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1affinity: #亲和性设置podAffinity: #设置pod亲和性requiredDuringSchedulingIgnoredDuringExecution: # 硬限制- labelSelector:matchExpressions: # 匹配env的值在["xxx","yyy"]中的标签- key: podenvoperator: Invalues: ["xxx","yyy"]topologyKey: kubernetes.io/hostname

上面配置表达的意思是:新Pod必须要与拥有标签nodeenv=xxx或者nodeenv=yyy的pod在同一Node上,显然现在没有这样pod,接下来,运行测试一下。

# 启动pod

[root@k8s-master01 ~]# kubectl create -f pod-podaffinity-required.yaml

pod/pod-podaffinity-required created# 查看pod状态,发现未运行

[root@k8s-master01 ~]# kubectl get pods pod-podaffinity-required -n dev

NAME READY STATUS RESTARTS AGE

pod-podaffinity-required 0/1 Pending 0 9s# 查看详细信息

[root@k8s-master01 ~]# kubectl describe pods pod-podaffinity-required -n dev

......

Events:Type Reason Age From Message---- ------ ---- ---- -------Warning FailedScheduling <unknown> default-scheduler 0/3 nodes are available: 2 node(s) didn't match pod affinity rules, 1 node(s) had taints that the pod didn't tolerate.# 接下来修改 values: ["xxx","yyy"]----->values:["pro","yyy"]

# 意思是:新Pod必须要与拥有标签nodeenv=xxx或者nodeenv=yyy的pod在同一Node上

[root@k8s-master01 ~]# vim pod-podaffinity-required.yaml# 然后重新创建pod,查看效果

[root@k8s-master01 ~]# kubectl delete -f pod-podaffinity-required.yaml

pod "pod-podaffinity-required" de leted

[root@k8s-master01 ~]# kubectl create -f pod-podaffinity-required.yaml

pod/pod-podaffinity-required created# 发现此时Pod运行正常

[root@k8s-master01 ~]# kubectl get pods pod-podaffinity-required -n dev

NAME READY STATUS RESTARTS AGE LABELS

pod-podaffinity-required 1/1 Running 0 6s <none>

关于PodAffinity的 preferredDuringSchedulingIgnoredDuringExecution,这里不再演示。

PodAntiAffinity

PodAntiAffinity主要实现以运行的Pod为参照,让新创建的Pod跟参照pod不在一个区域中的功能。

它的配置方式和选项跟PodAffinty是一样的,这里不再做详细解释,直接做一个测试案例。

1)继续使用上个案例中目标pod

[root@k8s-master01 ~]# kubectl get pods -n dev -o wide --show-labels

NAME READY STATUS RESTARTS AGE IP NODE LABELS

pod-podaffinity-required 1/1 Running 0 3m29s 10.244.1.38 node1 <none>

pod-podaffinity-target 1/1 Running 0 9m25s 10.244.1.37 node1 podenv=pro

2)创建pod-podantiaffinity-required.yaml,内容如下:

apiVersion: v1

kind: Pod

metadata:name: pod-podantiaffinity-requirednamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1affinity: #亲和性设置podAntiAffinity: #设置pod亲和性requiredDuringSchedulingIgnoredDuringExecution: # 硬限制- labelSelector:matchExpressions: # 匹配podenv的值在["pro"]中的标签- key: podenvoperator: Invalues: ["pro"]topologyKey: kubernetes.io/hostname

上面配置表达的意思是:新Pod必须要与拥有标签nodeenv=pro的pod不在同一Node上,运行测试一下。

# 创建pod

[root@k8s-master01 ~]# kubectl create -f pod-podantiaffinity-required.yaml

pod/pod-podantiaffinity-required created# 查看pod

# 发现调度到了node2上

[root@k8s-master01 ~]# kubectl get pods pod-podantiaffinity-required -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE ..

pod-podantiaffinity-required 1/1 Running 0 30s 10.244.1.96 node2 ..

污点和容忍

污点(Taints)

前面的调度方式都是站在Pod的角度上,通过在Pod上添加属性,来确定Pod是否要调度到指定的Node上,其实我们也可以站在Node的角度上,通过在Node上添加污点属性,来决定是否允许Pod调度过来。

Node被设置上污点之后就和Pod之间存在了一种相斥的关系,进而拒绝Pod调度进来,甚至可以将已经存在的Pod驱逐出去。

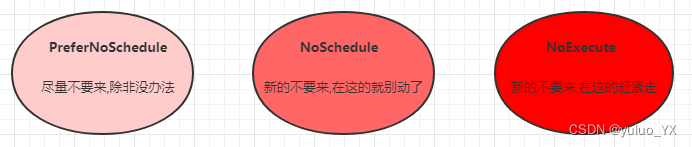

污点的格式为:key=value:effect, key和value是污点的标签,effect描述污点的作用,支持如下三个选项:

- PreferNoSchedule:kubernetes将尽量避免把Pod调度到具有该污点的Node上,除非没有其他节点可调度

- NoSchedule:kubernetes将不会把Pod调度到具有该污点的Node上,但不会影响当前Node上已存在的Pod

- NoExecute:kubernetes将不会把Pod调度到具有该污点的Node上,同时也会将Node上已存在的Pod驱离

使用kubectl设置和去除污点的命令示例如下:

# 设置污点

kubectl taint nodes node1 key=value:effect# 去除污点

kubectl taint nodes node1 key:effect-# 去除所有污点

kubectl taint nodes node1 key-

接下来,演示下污点的效果:

- 准备节点node1(为了演示效果更加明显,暂时停止node2节点)

- 为node1节点设置一个污点:

tag=heima:PreferNoSchedule;然后创建pod1( pod1 可以 ) - 修改为node1节点设置一个污点:

tag=heima:NoSchedule;然后创建pod2( pod1 正常 pod2 失败 ) - 修改为node1节点设置一个污点:

tag=heima:NoExecute;然后创建pod3 ( 3个pod都失败 )

# 为node1设置污点(PreferNoSchedule)

[root@k8s-master01 ~]# kubectl taint nodes node1 tag=heima:PreferNoSchedule# 创建pod1

[root@k8s-master01 ~]# kubectl run taint1 --image=nginx:1.17.1 -n dev

[root@k8s-master01 ~]# kubectl get pods -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE

taint1-7665f7fd85-574h4 1/1 Running 0 2m24s 10.244.1.59 node1 # 为node1设置污点(取消PreferNoSchedule,设置NoSchedule)

[root@k8s-master01 ~]# kubectl taint nodes node1 tag:PreferNoSchedule-

[root@k8s-master01 ~]# kubectl taint nodes node1 tag=heima:NoSchedule# 创建pod2

[root@k8s-master01 ~]# kubectl run taint2 --image=nginx:1.17.1 -n dev

[root@k8s-master01 ~]# kubectl get pods taint2 -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE

taint1-7665f7fd85-574h4 1/1 Running 0 2m24s 10.244.1.59 node1

taint2-544694789-6zmlf 0/1 Pending 0 21s <none> <none> # 为node1设置污点(取消NoSchedule,设置NoExecute)

[root@k8s-master01 ~]# kubectl taint nodes node1 tag:NoSchedule-

[root@k8s-master01 ~]# kubectl taint nodes node1 tag=heima:NoExecute# 创建pod3

[root@k8s-master01 ~]# kubectl run taint3 --image=nginx:1.17.1 -n dev

[root@k8s-master01 ~]# kubectl get pods -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED

taint1-7665f7fd85-htkmp 0/1 Pending 0 35s <none> <none> <none>

taint2-544694789-bn7wb 0/1 Pending 0 35s <none> <none> <none>

taint3-6d78dbd749-tktkq 0/1 Pending 0 6s <none> <none> <none>

小提示:使用kubeadm搭建的集群,默认就会给master节点添加一个污点标记,所以pod就不会调度到master节点上.

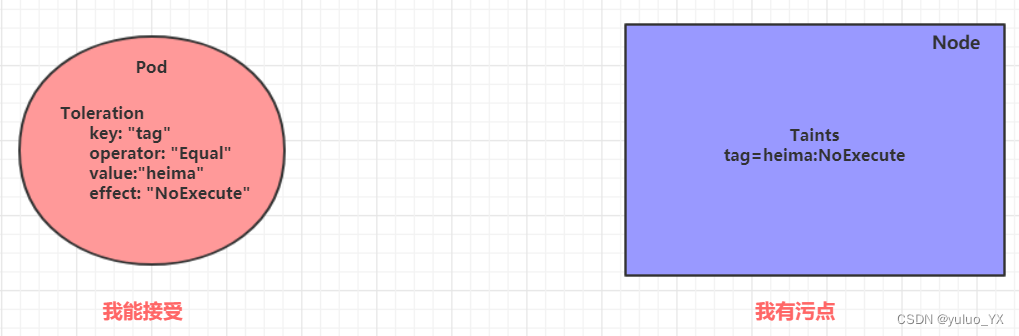

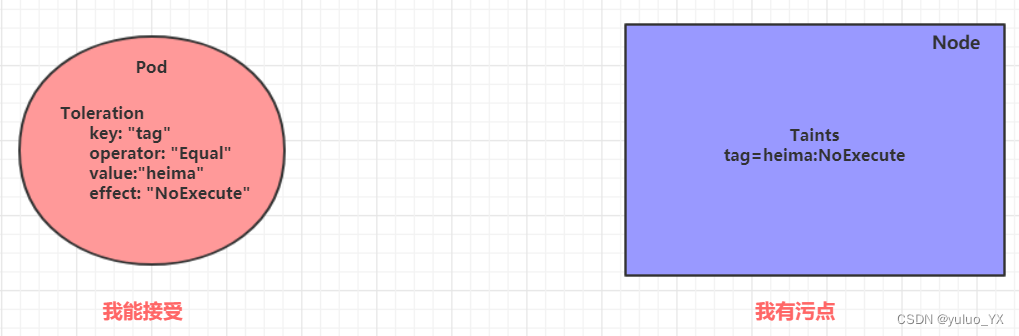

容忍(Toleration)

上面介绍了污点的作用,我们可以在node上添加污点用于拒绝pod调度上来,但是如果就是想将一个pod调度到一个有污点的node上去,这时候应该怎么做呢?这就要使用到容忍。

污点就是拒绝,容忍就是忽略,Node通过污点拒绝pod调度上去,Pod通过容忍忽略拒绝

下面先通过一个案例看下效果:

- 上一小节,已经在node1节点上打上了

NoExecute的污点,此时pod是调度不上去的 - 本小节,可以通过给pod添加容忍,然后将其调度上去

创建pod-toleration.yaml,内容如下

apiVersion: v1

kind: Pod

metadata:name: pod-tolerationnamespace: dev

spec:containers:- name: nginximage: nginx:1.17.1tolerations: # 添加容忍- key: "tag" # 要容忍的污点的keyoperator: "Equal" # 操作符value: "heima" # 容忍的污点的valueeffect: "NoExecute" # 添加容忍的规则,这里必须和标记的污点规则相同

# 添加容忍之前的pod

[root@k8s-master01 ~]# kubectl get pods -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED

pod-toleration 0/1 Pending 0 3s <none> <none> <none> # 添加容忍之后的pod

[root@k8s-master01 ~]# kubectl get pods -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED

pod-toleration 1/1 Running 0 3s 10.244.1.62 node1 <none>

下面看一下容忍的详细配置:

[root@k8s-master01 ~]# kubectl explain pod.spec.tolerations

......

FIELDS:key # 对应着要容忍的污点的键,空意味着匹配所有的键value # 对应着要容忍的污点的值operator # key-value的运算符,支持Equal和Exists(默认)effect # 对应污点的effect,空意味着匹配所有影响tolerationSeconds # 容忍时间, 当effect为NoExecute时生效,表示pod在Node上的停留时间

相关文章:

kubernetes教程 --Pod调度

Pod调度 在默认情况下,一个Pod在哪个Node节点上运行,是由Scheduler组件采用相应的算法计算出来的,这个过程是不受人工控制的。但是在实际使用中,这并不满足的需求,因为很多情况下,我们想控制某些Pod到达某…...

功率放大器科普知识(晶体管功率放大器的注意事项)

虽然功率放大器是电子实验室的常用仪器,但是很多人对于它却没有清晰的认识,下面就让安泰电子来为大家介绍功率放大器的科普内容以及使用注意事项,希望大家可以对功率放大器有清晰的认识。功率放大器可以把输入信号的功率放大,以满…...

CentOS 7转化系统为阿里龙蜥Anolis OS 7

转载:原社区CentOS 7迁移Anolis OS 7迁移手册 一、注意事项 Anolis OS 7生态上和依赖管理上保持跟CentOS7.x兼容,一键式迁移脚本centos2anolis.py,实现CentOS7.x到Anolis OS 7的平滑迁移。 使用迁移脚本前需要注意如下事项: 迁…...

【快速复习】一文看懂 Mysql 核心存储 隔离级别 锁 MVCC 机制

一文看懂 Mysql 核心存储 & 隔离级别 & 锁 & MVCC 机制 Mysql InnoDB 引擎下核心存储 数据&索引存储 IBD 文件 mysql 实际存储采用 B 树结构。 B 树是一种多路搜索树,其搜索性能高于 B 树 所有叶节点在同一深度,保证搜索效率仅叶节…...

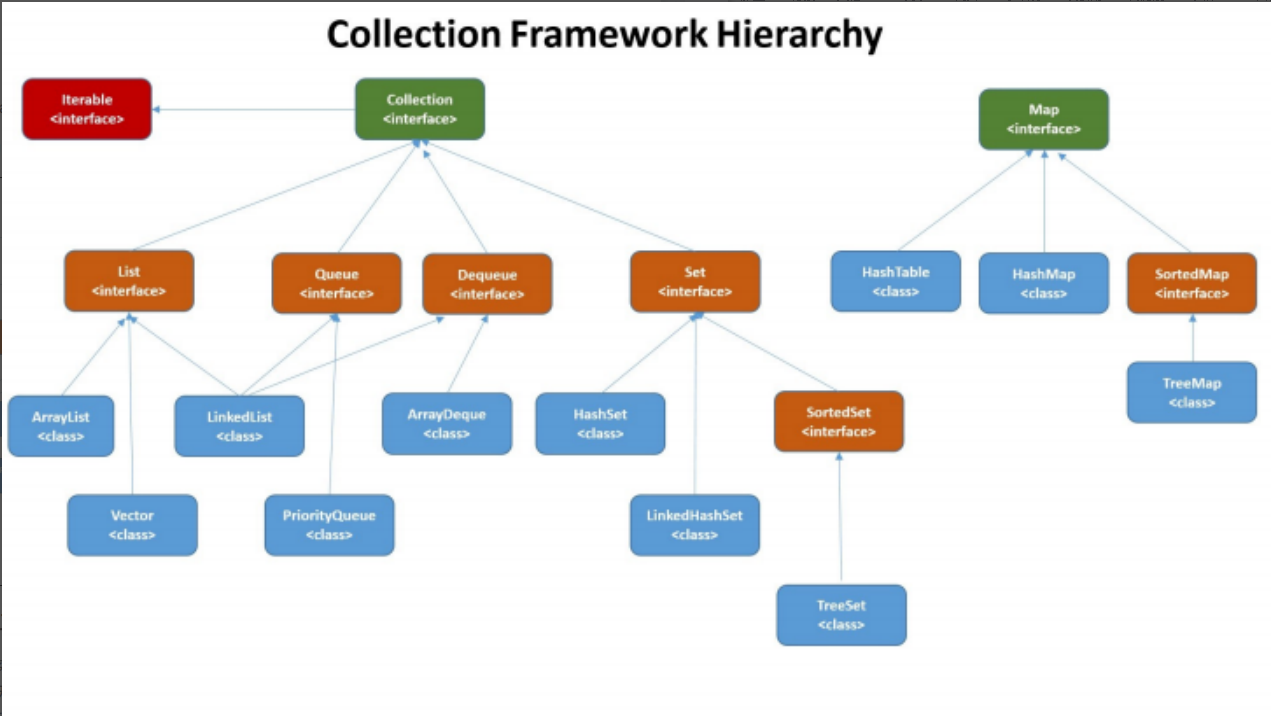

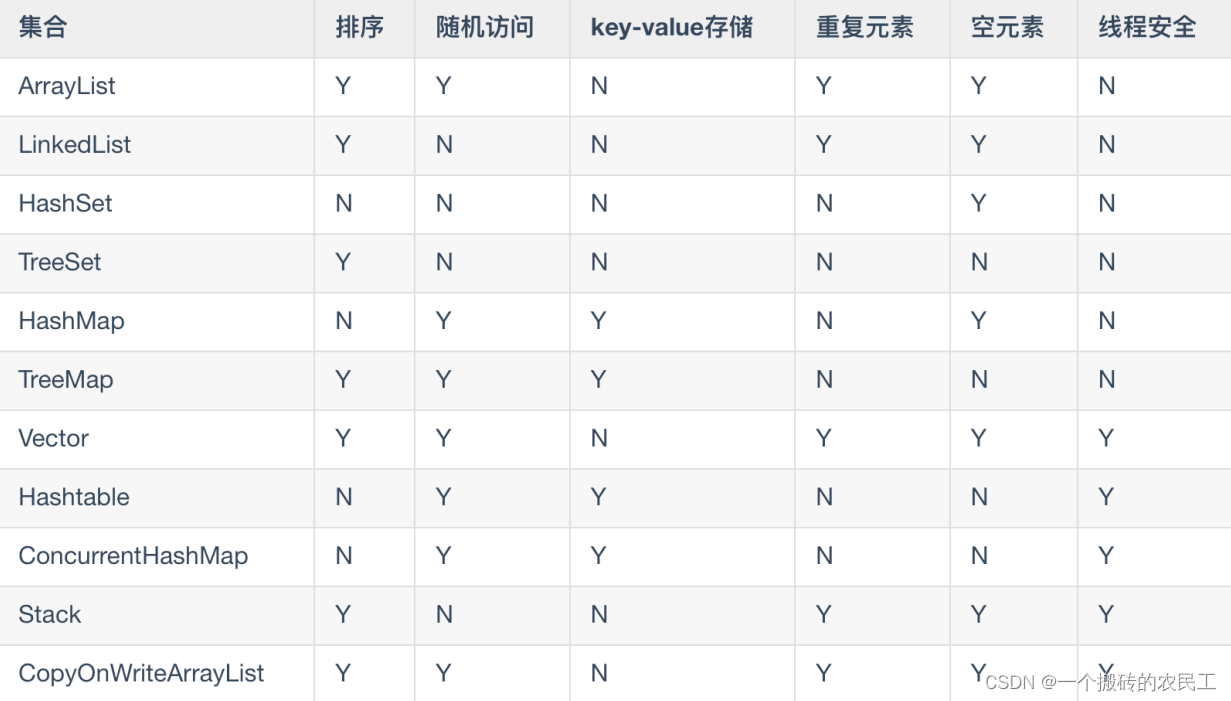

面试题----集合

概述 从上图可以看出,在Java 中除了以 Map 结尾的类之外, 其他类都实现了 Collection 接⼝。 并且,以 Map 结尾的类都实现了 Map 接⼝List,Set,Map List (对付顺序的好帮⼿): 存储的元素是有序的、可重复的。 Set (注重独⼀⽆⼆…...

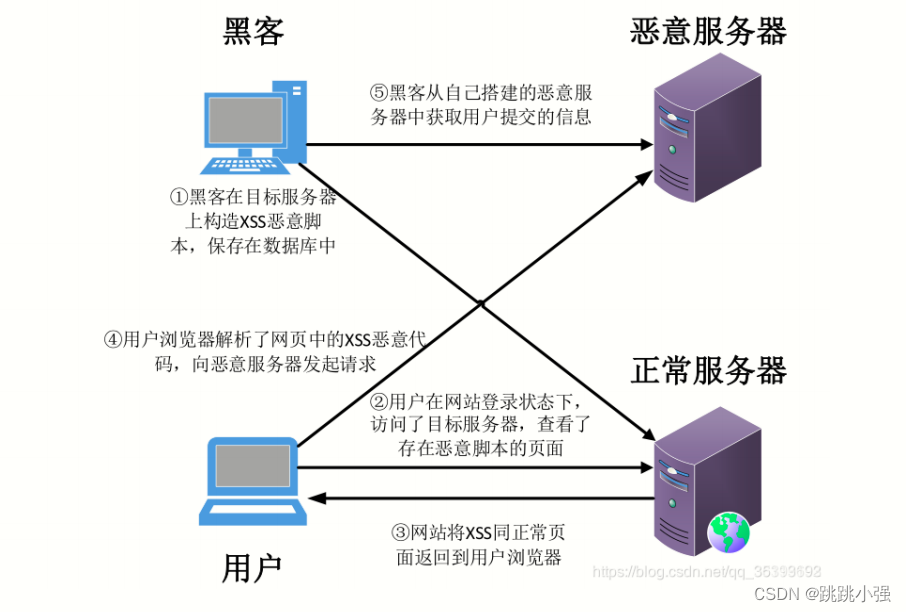

XSS注入基础入门篇

XSS注入基础入门篇1.XSS基础概念2. XSS的分类以及示例2.1 反射型XSS2.1.1 示例1:dvwa low 级别的反射型XSS2.1.2 攻击流程2.2 DOM型XSS2.2.1 示例2:DOM型XSS注入1.环境部署2.基础版本3.进阶绕过2.3 存储型XSS2.3.1 示例1:dvwa low示例2.3.2 攻…...

链表)

刷题 - 数据结构(二)链表

1. 链表 1.1 题目:合并两个有序链表 链表的建立与插入:关键在于留出头部,创建迭代指针。 ListNode* head new ListNode; // 通过new 创建了一个数据类型为ListNode的数据 并把该数据的地址赋值给ListNodeListNode* p 0; // 再创建一个数据…...

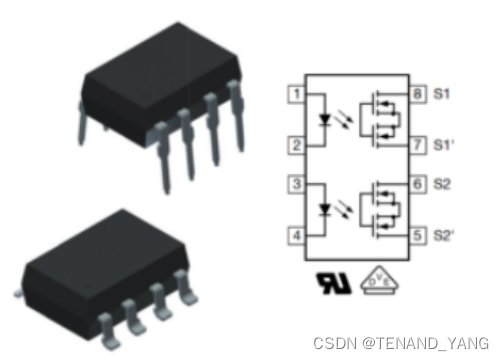

用于隔离PWM的光耦合器选择和使用

光耦合器(或光隔离器)是一种将电路电隔离的器件,不仅在隔离方面非常出色,而且允许您连接到具有不同接地层或在不同电压电平下工作的电路。光耦合器具有“故障安全”功能,因为如果受到高于最大额定值的电压,…...

面试完阿里,字节,腾讯的测试岗,复盘以及面试总结

前段时间由于某些原因辞职了,最近一直在面试。面试这段时间,经历过不同业务类型的公司(电商、酒店出行、金融、新能源、银行),也遇到了很多不同类型的面试官。 参加完三家大厂的面试聊聊我对面试的一些看法࿰…...

分享一个外贸客户案例

春节期间一个外贸人收到了客户的回复,但因为自己的处理方式造成了一个又一个问题,我们可以从中学到一些技巧和知识。“上次意大利的客人询价后,一直没回复(中间有打过电话,对方说口语不行,我写过邮件跟进过…...

【Kubernetes】第二篇 - 购买阿里云 ECS 实例

一,前言 上一篇,简单介绍了 CI/CD 的概念以及 ECS 服务规划,搭建整套服务需要三台服务器,配置如下: ECS 配置启动服务说明2核4GJenkins Nexus Dockerci-server2核4GDocker Kubernetesk8s-master1核1GDocker Kube…...

数影周报:据传国内45亿条快递数据泄露,聆心智能完成Pre-A轮融资

本周看点:据传国内45亿条快递数据泄露;消息称微软解雇150 名云服务销售;消息称TikTok计划在欧洲再开两个数据中心;衣服长时间放购物车被淘宝客服嘲讽;聆心智能完成Pre-A轮融资......数据安全那些事据传国内45亿条快递数…...

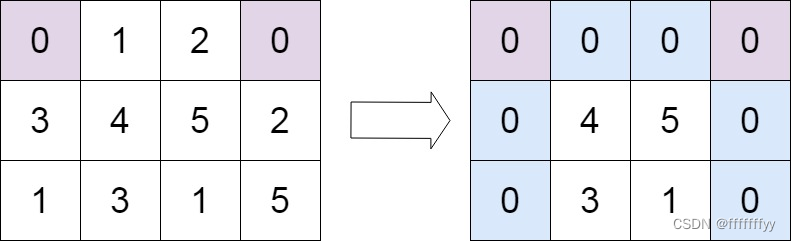

Leetcode力扣秋招刷题路-0073

从0开始的秋招刷题路,记录下所刷每道题的题解,帮助自己回顾总结 73. 矩阵置零 给定一个 m x n 的矩阵,如果一个元素为 0 ,则将其所在行和列的所有元素都设为 0 。请使用 原地 算法。 示例 1: 输入:mat…...

遥感数字图像处理

遥感数字图像处理 来源:慕课北京师范大学朱文泉老师的课程 遥感应用:遥感制图、信息提取 短期内了解知识结构–>有选择的剖析经典算法原理–>系统化知识结构、并尝试实践应用 跳出算法(尤其是数学公式) 关注原理及解决问…...

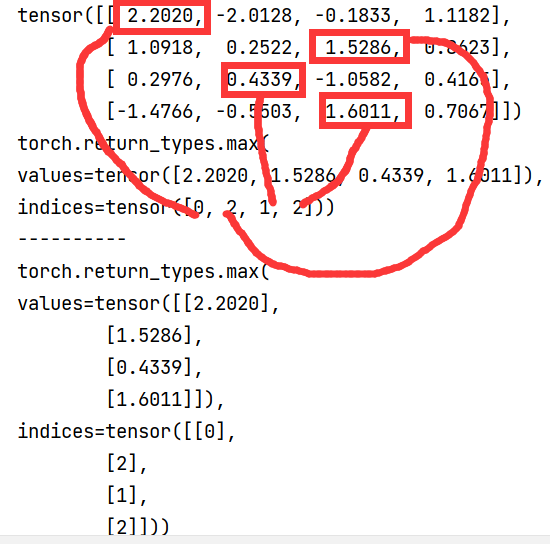

深度学习常用的python函数(一)

由于我只简单的学过python和pytorch,其中有很多函数的操作都还是一知半解的,其中有些函数经常见到,所以就打算记录下来。 1.zip zip(*a):针对单个可迭代对象压缩成n个元组,元组数量n等于min(a中元素的最小长度) a [(1, 2), (3…...

2023年美国大学生数学建模A题:受干旱影响的植物群落建模详解+模型代码(一)

目录 前言 一、题目理解 背景 解析: 要求 二、建模 1.相关性分析 2.相关特征权重 只希望各位以后遇到建模比赛可以艾特认识一下我,我可以提供免费的思路和部分源码,以后的数模比赛只要我还有时间肯定会第一时间写出免费开源思路&…...

PPS文件如何转换成PPT?附两种方法

在工作中,PPS文件的使用还是很广泛的,因为作为幻灯片放映文件,点击后就能直接播放,十分方便。但如果想要修改PPS里的内容,PPS是无法编辑的,我们需要把文件转换成PPT,再进行修改。 那PPS文件如何…...

ParallelsDesktop安装【亲测可行】

我这边安装的是macos最新系统 (Ventura13.2) 本文参考这篇文章安装,但是你完全按照这篇文章会报错,具体可行操作记录如下 一、下载软件和补丁 1、点这里去下载补丁18.0.1 2、点这里去下载对应版本的ParallelsDesktop18.0.1,安装上到试用这里…...

在 Python 中只接受数字作为用户输入

只接受数字作为用户输入: 使用 while True 循环进行循环,直到用户输入一个数字。使用 float() 类尝试将值转换为浮点数。如果用户输入了一个数字,请使用 break 语句跳出循环。 while True:try:# 👇️ use int() instead of floa…...

【集合】JAVA基础篇(二)

目录一、java常用集合1、Java集合接口的作用2、Java集合常用实现类的作用二、Collection 常用的方法三、List 集合接口1、ArrayList类的常用方法2、LinkList类中的方法3、Vector4、ArrayList 类和 LinkedList 类的区别四、Set 集合1、HashSet 类2、TreeSet 类3、HashSet 和 Tre…...

3.3.1_1 检错编码(奇偶校验码)

从这节课开始,我们会探讨数据链路层的差错控制功能,差错控制功能的主要目标是要发现并且解决一个帧内部的位错误,我们需要使用特殊的编码技术去发现帧内部的位错误,当我们发现位错误之后,通常来说有两种解决方案。第一…...

FastAPI 教程:从入门到实践

FastAPI 是一个现代、快速(高性能)的 Web 框架,用于构建 API,支持 Python 3.6。它基于标准 Python 类型提示,易于学习且功能强大。以下是一个完整的 FastAPI 入门教程,涵盖从环境搭建到创建并运行一个简单的…...

跨链模式:多链互操作架构与性能扩展方案

跨链模式:多链互操作架构与性能扩展方案 ——构建下一代区块链互联网的技术基石 一、跨链架构的核心范式演进 1. 分层协议栈:模块化解耦设计 现代跨链系统采用分层协议栈实现灵活扩展(H2Cross架构): 适配层…...

c#开发AI模型对话

AI模型 前面已经介绍了一般AI模型本地部署,直接调用现成的模型数据。这里主要讲述讲接口集成到我们自己的程序中使用方式。 微软提供了ML.NET来开发和使用AI模型,但是目前国内可能使用不多,至少实践例子很少看见。开发训练模型就不介绍了&am…...

IoT/HCIP实验-3/LiteOS操作系统内核实验(任务、内存、信号量、CMSIS..)

文章目录 概述HelloWorld 工程C/C配置编译器主配置Makefile脚本烧录器主配置运行结果程序调用栈 任务管理实验实验结果osal 系统适配层osal_task_create 其他实验实验源码内存管理实验互斥锁实验信号量实验 CMISIS接口实验还是得JlINKCMSIS 简介LiteOS->CMSIS任务间消息交互…...

Java 二维码

Java 二维码 **技术:**谷歌 ZXing 实现 首先添加依赖 <!-- 二维码依赖 --><dependency><groupId>com.google.zxing</groupId><artifactId>core</artifactId><version>3.5.1</version></dependency><de…...

腾讯云V3签名

想要接入腾讯云的Api,必然先按其文档计算出所要求的签名。 之前也调用过腾讯云的接口,但总是卡在签名这一步,最后放弃选择SDK,这次终于自己代码实现。 可能腾讯云翻新了接口文档,现在阅读起来,清晰了很多&…...

Monorepo架构: Nx Cloud 扩展能力与缓存加速

借助 Nx Cloud 实现项目协同与加速构建 1 ) 缓存工作原理分析 在了解了本地缓存和远程缓存之后,我们来探究缓存是如何工作的。以计算文件的哈希串为例,若后续运行任务时文件哈希串未变,系统会直接使用对应的输出和制品文件。 2 …...

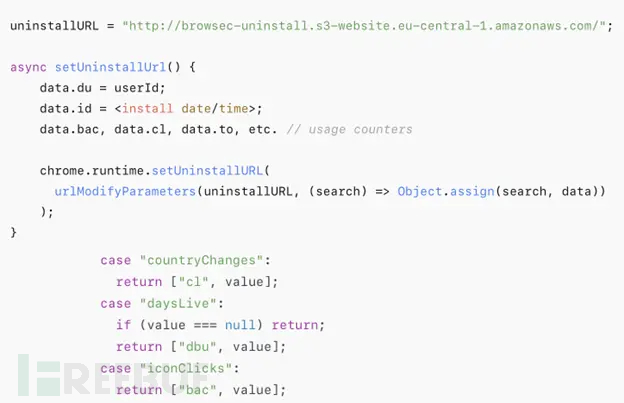

热门Chrome扩展程序存在明文传输风险,用户隐私安全受威胁

赛门铁克威胁猎手团队最新报告披露,数款拥有数百万活跃用户的Chrome扩展程序正在通过未加密的HTTP连接静默泄露用户敏感数据,严重威胁用户隐私安全。 知名扩展程序存在明文传输风险 尽管宣称提供安全浏览、数据分析或便捷界面等功能,但SEMR…...

数据结构第5章:树和二叉树完全指南(自整理详细图文笔记)

名人说:莫道桑榆晚,为霞尚满天。——刘禹锡(刘梦得,诗豪) 原创笔记:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊) 上一篇:《数据结构第4章 数组和广义表》…...