BD就业复习第二天

Hbase

1. 架构

HBase(Hadoop Database)是一个开源的分布式、面向列族(Column Family)的NoSQL数据库,它是构建在Hadoop之上的。HBase的架构设计旨在处理大规模的数据,特别适用于需要快速读写和随机访问大量数据的应用场景,如日志处理、在线实时分析等。下面是HBase的详细架构解析:

-

HBase数据模型:

- 表(Table):HBase中的数据存储在表中,每个表可以看作是多行多列的键值对集合。

- 行键(Row Key):每个表中的数据行都有一个唯一的行键,用于快速检索和访问数据。

- 列族(Column Family):列族是列的集合,每个列族可以包含任意数量的列。列族在表创建时需要定义,但列不需要提前定义。

- 列(Column):列是表中的数据单元,由列族和列标识符(Qualifier)组成。

-

HBase架构组件:

- HMaster:HMaster是HBase的主控制器,负责管理和协调集群中的Region Servers,处理表的元数据(例如表的创建、删除、列族的修改等)。

- Region Server:Region Server是HBase中的数据存储节点,每个Region Server管理多个数据区域(Region),每个数据区域对应一个表的一部分数据。

- ZooKeeper:ZooKeeper用于协调分布式系统中的各个组件,包括HBase。它用于维护集群的状态信息和元数据。

- HDFS:HDFS(Hadoop Distributed File System)用于存储HBase表的数据。HBase的数据文件以HFile的形式存储在HDFS中。

-

数据存储:

- HBase数据存储在分布式的数据区域(Region)中,每个Region负责存储一个表的某个部分数据。Region是按照表的行范围划分的,当数据量增加时,Region会自动划分成更小的子Region,以实现负载均衡和横向扩展。

- 数据以HFile的形式存储在HDFS上,HFile是一个高效的、面向列族的存储格式,有助于快速随机访问。

-

数据访问:

- 客户端通过HBase客户端API访问数据。客户端可以根据行键进行读写操作,也可以进行范围扫描。

- 数据读取操作通常很快,因为HBase支持高效的随机访问,而写入操作也可以通过批量写入进行优化。

-

一致性和容错性:

- HBase采用了强一致性模型,确保数据的一致性和可靠性。

- 数据的复制和备份可以通过Hadoop的机制来实现,以提供容错性和数据冗余。

-

分布式查询和过滤:

- HBase支持分布式查询和过滤操作,可以在大规模数据集上执行各种复杂的查询。

- 过滤器(Filter)可以用于在服务器端执行数据过滤,减少网络传输量和客户端计算。

总之,HBase是一个分布式、高性能、面向列族的NoSQL数据库,它的架构设计允许处理大规模数据,提供了强一致性和高可用性。它在处理需要快速读写和随机访问的大规模数据时具有显著的优势,常被用于日志处理、实时分析等应用场景。

2. 特点/优点

特点:

-

分布式存储:HBase数据存储在分布式的Region Server中,可以水平扩展以处理大规模数据。

-

面向列族:HBase表采用列族(Column Family)来组织数据,使得表的结构更加灵活。列族可以在表创建后动态修改,而列不需要提前定义。

-

高吞吐量:HBase的设计追求高吞吐量的数据访问,适用于需要快速读写和随机访问大量数据的应用场景。

-

强一致性:HBase提供强一致性模型,确保数据的可靠性和一致性,适用于需要高度可靠性的应用。

-

水平扩展:通过添加更多的Region Server节点,可以简单地水平扩展HBase集群,以满足增加的负载需求。

-

自动分区:HBase自动划分数据区域(Region),实现负载均衡和数据分布的自动管理。

-

支持复杂查询:HBase支持分布式查询和过滤操作,可以在大规模数据集上执行复杂的查询。

-

数据复制和备份:HBase可以配置数据的复制和备份,提供容错性和数据冗余。

优点:

-

适用于大数据:HBase是为大规模数据设计的,适用于存储和处理PB级别的数据。

-

高可扩展性:HBase的水平扩展能力使其能够轻松应对数据量的增长。

-

高吞吐量:HBase提供了高吞吐量的读写操作,适合需要快速访问数据的应用。

-

强一致性:HBase的强一致性模型使其适合于需要高度可靠性和数据一致性的应用。

-

灵活的数据模型:面向列族的数据模型允许应用根据需要动态添加列,适应不断变化的数据结构。

-

与Hadoop生态系统集成:HBase紧密集成了Hadoop生态系统,可以与Hadoop、Hive等组件无缝协作。

缺点:

-

复杂性:HBase的配置和管理相对复杂,需要专业知识和经验。

-

不适合小规模数据:对于小规模数据集,使用HBase可能会过于繁琐,不划算。

-

不适合复杂事务:HBase不支持复杂的事务处理,因此不适合需要ACID事务支持的应用。

-

写入延迟:虽然HBase在读取方面表现出色,但写入延迟可能相对较高,尤其在负载较重时。

使用场景:

-

日志处理:HBase适用于存储和分析大规模的日志数据,如服务器日志、网络日志等。

-

实时分析:对于需要实时分析数据的应用,如监控系统、实时推荐系统,HBase提供了快速的读取和查询能力。

-

在线数据存储:HBase可用于存储在线应用所需的数据,如社交媒体、电子商务平台等。

-

时间序列数据:HBase适用于存储时间序列数据,如传感器数据、股票市场数据等。

-

元数据存储:HBase常用于存储大数据平台的元数据,如Hive表的元数据信息。

-

图数据存储:尽管不是最佳选择,但HBase也可以用于存储和查询图数据,如社交网络关系图。

需要注意的是,HBase并不适合所有的应用场景。在选择使用HBase之前,需要仔细考虑数据规模、一致性需求、写入和读取模式以及复杂性等因素,并根据具体需求进行权衡和决策。

3. rowkey设计原则

在HBase中,RowKey的设计是非常重要的,因为它直接影响到数据的存储和检索效率。以下是一些HBase中RowKey设计的原则和最佳实践:

-

唯一性原则:RowKey必须是唯一的。每一行都必须具有唯一的RowKey,因为它用于唯一标识和检索数据行。唯一性通常通过在RowKey中包含唯一标识符或者在RowKey中加入时间戳等方法来实现。

-

顺序性原则:RowKey的设计应该追求有序性,即相关的数据应该被存储在相邻的地方,以提高读取性能。有序性的设计有助于降低随机I/O的数量。例如,可以使用时间戳或者数字范围来设计RowKey,使得相关数据按照时间或者数值顺序排列。

-

长度原则:RowKey的长度应该控制在一个合理的范围内,通常不宜过长。较长的RowKey会增加存储和索引的开销,同时可能导致性能下降。通常,RowKey的长度应该在10到100字节之间。

-

避免随机分布:尽量避免在RowKey中使用随机分布的值,因为这会导致数据分布不均匀,影响负载均衡和集群性能。如果使用随机值,可以考虑对其进行哈希处理来增加有序性。

-

避免频繁更新:RowKey的设计应该避免频繁更新,因为HBase的存储引擎是面向列族(Column Family)的,如果需要频繁更新同一行的数据,可能会导致性能问题。

-

考虑查询模式:RowKey的设计应该根据查询模式进行优化。如果知道常用的查询模式,可以将查询的字段或条件包含在RowKey中,以减少过滤操作的需求。

-

字典序排序:RowKey在HBase中是按字典序排序的,因此在设计RowKey时要考虑字典序的影响。例如,如果需要按时间范围查询数据,可以将时间戳作为RowKey的一部分,并以逆序存储,以便更容易获取最新的数据。

-

数据类型选择:RowKey可以是任何字节序列,但通常是字符串或字节数组。根据具体需求,选择合适的数据类型来表示RowKey。

-

前缀设计:在某些情况下,可以将RowKey划分为前缀和后缀,前缀用于表示某种类别或分区,后缀用于表示唯一性。这样的设计可以提高查询性能。

-

压缩和编码:考虑使用压缩和编码技术来减小RowKey的存储空间,从而减少存储和传输开销。

RowKey的设计需要根据具体的应用需求来进行权衡和优化。不同的应用场景可能需要不同的RowKey设计策略,因此在设计RowKey时要仔细考虑数据的读写模式、查询需求和性能要求。同时,随着数据的增长和应用的变化,可能需要调整RowKey的设计以适应新的需求。

4. 热点问题

HBase中的热点问题是指在分布式存储系统中,部分Region Server或Region接收到比其他Region更多的负载或流量,导致性能不均衡的情况。这可能会导致某些Region Server过载,而其他Region Server处于相对空闲状态。热点问题可能对HBase的可用性和性能产生负面影响。以下是HBase中热点问题的详细讨论以及如何应对这些问题:

1. 写入热点问题:

- 问题描述:当某个特定的RowKey范围接收到频繁的写入操作时,这个范围的Region可能会成为写入热点。这会导致该Region的写入性能下降,并可能影响整个集群的性能。

- 解决方法:

- 使用合适的RowKey设计:设计RowKey时,尽量避免将所有写入操作都聚焦在一个小范围内。

- 随机化RowKey:通过在RowKey中引入随机元素,分散写入负载,减轻写入热点问题。

- 使用预分区:根据业务需求预先划分数据范围,将数据均匀分布在不同的Region中,减少写入热点的发生。

2. 读取热点问题:

- 问题描述:某些特定的RowKey范围可能会接收到频繁的读取请求,导致该范围的Region成为读取热点。这可能会导致该Region的读取性能下降。

- 解决方法:

- 合理设计RowKey:设计RowKey时,考虑查询模式,将热点数据分散到不同的Region中。

- 缓存热点数据:使用缓存技术(如HBase的BlockCache或外部缓存)来缓存热点数据,减轻Region Server的读取压力。

- 使用负载均衡器:HBase通常配备了负载均衡器,可以在Region Server之间平衡读取负载。

3. 单一Region Server热点问题:

- 问题描述:在一个多Region Server的HBase集群中,某个Region Server可能会接收到比其他Region Server更多的负载,导致该Region Server成为热点。

- 解决方法:

- 均匀分布Region:通过自动或手动划分Region,确保Region在不同的Region Server之间均匀分布。

- 使用负载均衡器:HBase提供了负载均衡机制,可以自动将Region迁移到负载较低的Region Server上。

4. 副本热点问题:

- 问题描述:在HBase中,每个Region通常有多个副本(Replica),如果所有读取请求都集中在某一个副本上,会导致该副本成为热点,而其他副本相对闲置。

- 解决方法:

- 使用随机访问策略:在客户端随机选择要读取的副本,而不是总是选择主副本,以分散读取压力。

- 使用负载均衡器:HBase中的负载均衡器可以帮助均匀分布读取请求到各个副本。

总之,热点问题在HBase中是一个常见的挑战,但可以通过合理的RowKey设计、数据预分区、负载均衡和缓存等策略来缓解和解决。在设计和管理HBase集群时,需要综合考虑数据分布、读写负载以及查询模式,以确保数据访问的平衡和性能。

5. 你公司的rowkey怎么组成的

RowKey的设计取决于具体的业务需求和数据访问模式,不同的公司和应用可能会有不同的RowKey设计。以下是一个示例,假设某个公司正在使用HBase来存储其在线电子商务平台的订单数据。

在这个示例中,我们将设计订单数据的RowKey,考虑到该公司的需求和查询模式:

-

唯一性原则:RowKey必须保证唯一性,因此我们可以将订单号作为RowKey的一部分。

-

顺序性原则:订单数据通常按照订单创建时间有序排列,因此我们可以将时间戳作为RowKey的一部分,以便按时间范围查询数据。

-

长度原则:RowKey的长度应该控制在一个合理的范围内,不宜过长。在这个示例中,我们可以考虑使用订单号和时间戳作为RowKey的组成部分。

-

字典序排序:为了方便按照时间范围查询数据,我们可以将时间戳以逆序方式存储,这样最新的订单会排在前面,更容易获取。

-

避免频繁更新:订单数据通常不需要频繁更新,因此RowKey的设计可以考虑不涉及频繁更新的字段。

根据以上原则,一个可能的RowKey设计可以如下:

[订单号(OrderID)逆序][时间戳(Timestamp)逆序]

例如,假设某个订单的订单号是 "20230921001",创建时间戳为 "2023-09-21 15:30:45",那么该订单的RowKey可以是:

1001092323153045

这个RowKey的设计具备以下特点:

- 唯一性:订单号和时间戳的组合保证了唯一性。

- 顺序性:订单按照创建时间有序排列,方便按照时间范围查询订单历史。

- 长度合理:RowKey长度合理,不会过长。

- 字典序排序:时间戳以逆序方式存储,使得最新的订单在前面,方便获取最新数据。

需要注意的是,具体的RowKey设计还取决于其他因素,如表的分区策略、查询需求的复杂性等。因此,在实际应用中,RowKey的设计可能会更加复杂,需要综合考虑各种因素来进行优化。此示例仅用于说明可能的RowKey设计思路。

clickhouse

1. ClickHouse

ClickHouse 是一个开源的列式数据库管理系统,专门设计用于高性能分析和数据仓库工作负载。以下是关于 ClickHouse 的一些优缺点以及适用场景:

优点:

-

高性能: ClickHouse 针对大规模数据分析工作负载进行了优化,可以处理数十亿行数据的快速查询。它的列式存储引擎和数据压缩技术使其在查询性能方面表现出色。

-

扩展性: ClickHouse 支持水平扩展,可以轻松地添加更多的服务器节点来处理大量数据。这种扩展性使其能够适应不断增长的数据需求。

-

实时分析: ClickHouse 支持实时数据注入,可以用于处理实时数据分析工作负载。它能够快速处理新数据并提供实时的查询结果。

-

灵活的查询语言: ClickHouse 使用 SQL 查询语言,使用户可以使用熟悉的语法进行查询和分析。它还支持复杂的分析函数和数据转换操作。

-

数据压缩: ClickHouse 使用多种数据压缩技术,可降低存储开销,减少磁盘和内存使用,从而提高性能。

缺点:

-

复杂性: ClickHouse 的配置和维护可能相对复杂,特别是对于不熟悉列式数据库的用户来说。需要一定的学习曲线。

-

实时数据写入: 虽然 ClickHouse 支持实时数据注入,但其主要优势在于数据分析。对于大规模的实时数据写入工作负载,可能不是最佳选择。

-

不适用于事务处理: ClickHouse 主要针对数据仓库和分析工作负载,不支持复杂的事务处理操作。如果需要支持事务处理的数据库,应考虑其他选项。

使用场景:

-

大规模数据分析: ClickHouse 的高性能和列式存储引擎使其成为处理大规模数据分析工作负载的理想选择。它适用于数据仓库、报告生成、业务智能和数据挖掘等场景。

-

实时分析: ClickHouse 可以用于实时数据分析,特别是需要快速查询实时数据的应用,如监控系统和实时报表。

-

日志分析: ClickHouse 适用于存储和分析大量日志数据,例如网络流量日志、应用程序日志和服务器日志。

-

时序数据: ClickHouse 对于处理时序数据非常有效,因此可以用于监控、IoT 数据分析和时间序列数据库应用。

-

数据存档: ClickHouse 可以用于长期数据存档,将历史数据存储在低成本的存储介质上,并支持需要时的快速检索。

总之,ClickHouse 是一个强大的列式数据库管理系统,适用于需要高性能分析和大规模数据处理的场景,但不适合事务处理或实时数据写入工作负载。使用前需要仔细评估其优缺点以确保满足特定应用的需求。

2. 项目中常见表引擎

ClickHouse 是一个开源的列式数据库管理系统,主要用于高性能数据分析和数据仓库工作负载。与传统的关系型数据库不同,ClickHouse 专注于列式存储和高度优化的查询性能。在 ClickHouse 项目中,通常使用以下两种主要的表引擎:

-

MergeTree 引擎: MergeTree 引擎是 ClickHouse 最常见的表引擎之一,用于存储大量的时序数据或事件日志。它支持水平分区和数据分片,适用于高度并发的数据写入和快速查询。

- MergeTree 表: MergeTree 表支持数据按时间排序并分区。数据在写入时根据时间戳自动排序,这使得查询特定时间范围内的数据非常高效。此引擎的典型应用包括日志分析、监控系统、IoT 数据存储等。

-

Distributed 引擎: Distributed 引擎是 ClickHouse 用于分布式数据处理的表引擎。它允许将数据分布在多个物理节点上,并以分布式方式进行查询。这使得 ClickHouse 能够处理更大规模的数据。

- Distributed 表: Distributed 表是一个逻辑表,将数据分布在集群中的多个 MergeTree 表之间。查询分发到各个节点,各节点执行局部查询,然后结果被汇总返回给用户。这使得 ClickHouse 能够水平扩展以处理大型数据集。

此外,ClickHouse 还支持其他一些引擎,如 Aggregating、Replacing、Versioned、TinyLog 和 Log 引擎,用于特定用例或查询模式。每种引擎都有其独特的性能特点和适用场景。

总结一下,在 ClickHouse 项目中,MergeTree 引擎用于存储时序数据和事件日志,而 Distributed 引擎用于分布式数据处理和水平扩展。选择引擎应根据项目需求、数据模型和性能目标进行仔细评估。这些引擎的组合和灵活性使 ClickHouse 成为一个强大的数据分析工具。

3. 为什么快(重点需要深入)

ClickHouse 之所以快,有很多深层次的技术原因,这些原因使其成为高性能数据分析和数据仓库系统。以下是 ClickHouse 之所以快的关键因素:

-

列式存储引擎: ClickHouse 使用列式存储引擎,与传统的行式数据库相比,它将数据以列的方式存储在磁盘上,而不是以行的方式。这意味着查询时只需读取所需列的数据,而不必读取整行数据,从而减少了磁盘 I/O 操作和数据传输。这种列式存储方式在分析工作负载中效率更高,因为通常只需要查询和分析部分列数据。

-

数据压缩: ClickHouse 使用多种数据压缩技术,如 LZ4、Delta、T64 等,以减小存储占用和减少数据传输的开销。压缩减小了磁盘上的数据量,提高了磁盘 I/O 性能,并降低了网络传输成本,使查询更快速。

-

向量化查询执行: ClickHouse 使用向量化查询执行,这是一种高效的查询处理方式,允许批量操作列数据而不是单个元素。这种方法减少了 CPU 指令的开销,提高了查询处理速度。

-

分区和数据合并: ClickHouse 支持数据分区,可以将数据分布在多个物理节点上,以便并行处理查询。同时,ClickHouse 能够有效地合并和压缩分区中的数据,减少了查询时需要扫描的数据量,从而提高了性能。

-

多级合并: ClickHouse 使用多级合并(MergeTree 表引擎),在后台周期性地合并和优化数据分区。这有助于维护数据的紧凑性,减少了查询时需要扫描的数据量,提高了查询性能。

-

分布式架构: ClickHouse 支持分布式架构,可以将数据分布在多个节点上,允许水平扩展。这意味着它可以处理大规模数据集,同时保持高性能,因为查询可以并行处理。

-

延迟插入: ClickHouse 支持延迟插入,允许数据在后台批量处理,而不会影响查询性能。这对于高吞吐量的数据写入非常有用,因为它不会阻塞查询操作。

-

高效索引: ClickHouse 使用稀疏索引和部分索引来加速查询操作,以降低内存和磁盘开销。

总之,ClickHouse 之所以快,是因为它充分利用了列式存储、数据压缩、向量化查询执行、分区合并和分布式架构等多种技术,以提供卓越的性能和处理大规模数据集的能力。这些特性使得 ClickHouse 成为处理数据分析和数据仓库工作负载的理想选择。

4. 并发量

ClickHouse 是一个高度可扩展的列式数据库管理系统,能够处理大规模数据分析和查询工作负载,并且在并发性能方面表现出色。以下是关于 ClickHouse 并发量的一些关键信息:

-

高并发查询: ClickHouse 被设计用于支持高并发查询。它能够同时处理多个查询请求,并有效地使用硬件资源以提供快速响应时间。这对于多用户或多应用程序同时访问数据库的场景非常重要。

-

水平扩展: ClickHouse 可以通过添加更多的物理节点来水平扩展,从而增加了并发处理能力。每个节点可以独立处理查询请求,因此随着节点数量的增加,系统的并发性能也会线性增加。

-

分布式架构: ClickHouse 支持分布式架构,可以将数据分布在多个物理节点上。这有助于均衡查询负载,并允许系统在大规模数据集上分布并行查询。分布式部署还提供了容错性,以防某个节点故障。

-

复制: ClickHouse 支持数据复制,可以将数据复制到多个节点,提高查询的可用性和容错性。复制也有助于分担查询负载,因为查询可以在多个复制的副本之间分布。

-

向量化查询执行: ClickHouse 使用向量化查询执行,允许批量处理列数据。这种方法减少了 CPU 指令的开销,提高了查询处理速度,尤其适合并发查询。

-

资源控制: ClickHouse 允许管理员配置并控制资源限制,如内存使用和查询并发数。这有助于防止某个查询占用过多的系统资源,影响其他查询的性能。

-

异步查询执行: ClickHouse 支持异步查询执行,允许查询在后台运行,不会阻塞其他查询。这对于处理长时间运行的查询或在高并发环境中提供一致的性能非常有用。

总的来说,ClickHouse 通过使用列式存储、分布式架构、向量化查询执行和资源控制等技术,以及支持水平扩展和数据复制,提供了出色的并发性能。这使得它成为处理大规模数据分析和数据仓库工作负载的强大工具,可以应对高并发的查询需求。

Flink

1. 水位线

Apache Flink中的水位线(Watermark)是一种关键的时间概念,用于处理事件时间数据流。水位线在流式处理中非常重要,因为它们帮助系统确定事件时间进展到何种程度,从而影响窗口的触发和处理。

以下是关于Flink水位线的详细说明:

-

事件时间(Event Time):

- 事件时间是事件实际发生的时间戳,与数据生成时间无关。它通常是从事件中提取的一个字段,例如日志的时间戳。

-

水位线(Watermark):

- 水位线是一种特殊类型的事件,它表示事件时间已经达到的最大值或进展。水位线是一个时间戳,它告诉系统在事件时间轴上的当前进度。

-

水位线的作用:

- 水位线在流式处理中的主要作用是为时间窗口的触发提供依据。当水位线达到或超过窗口的结束时间时,Flink系统知道可以触发该窗口进行计算,因为不会再有属于该窗口的事件到达。

-

水位线的生成:

- 通常,水位线由数据源(如Kafka、Kinesis等)生成,并与事件一起传递。生成水位线的方式可以是基于事件时间的周期性生成,也可以是根据数据的特定属性计算生成。

-

水位线的传播:

- 水位线随着事件一起传递到操作符和窗口函数中。Flink会跟踪每个水位线,以便在达到某个窗口的结束时间时,触发窗口计算。

-

延迟处理:

- 水位线的延迟会影响处理的准确性和延迟。如果水位线比实际的事件时间晚到达,那么一些事件可能会被错误地视为迟到的事件。因此,水位线的生成和传播需要根据系统和应用程序的需求进行调整。

-

处理迟到事件:

- Flink提供了处理迟到事件的机制,可以通过窗口配置来控制。迟到事件是指那些事件时间晚于窗口的结束时间但仍然在水位线之前到达的事件。Flink允许你配置是否允许处理迟到事件,以及如何处理它们(丢弃、放入特殊窗口等)。

总的来说,Flink的水位线是一种重要的时间概念,用于确保流式处理中的事件按照事件时间进行正确的处理和分组。水位线的正确生成和管理对于处理有序事件流以及处理迟到事件非常关键。通过正确使用水位线,可以构建高度准确和鲁棒的流式处理应用程序。

2. 精准一次消费

精确一次消费(Exactly Once Processing)是Apache Flink中流处理应用程序的一种语义保证,用于确保在处理事件流时不会丢失任何事件,并且不会重复处理相同的事件。这是流处理系统中的一种强一致性保证,通常与事件时间处理和检查点机制结合使用。

以下是关于Flink的精确一次消费的详细说明:

-

语义保证:

- 精确一次消费是一种强一致性语义,它确保在流处理中每个事件都会被处理一次且仅一次。这意味着不会发生事件的丢失或多次处理。

-

事件时间处理:

- 要实现精确一次消费,Flink通常使用事件时间处理,即按照事件实际发生的时间进行处理。这需要在事件中包含时间戳,并根据这些时间戳对事件进行排序和分配。

-

检查点机制:

- Flink使用检查点机制来实现精确一次消费。检查点是应用程序状态的一致性快照,用于记录处理进度和事件处理状态。Flink周期性地生成检查点,并将其存储在可靠的分布式存储中。

-

状态管理:

- 精确一次消费要求应用程序状态的一致性管理。Flink将状态(如键控状态、窗口状态等)与检查点相结合,以确保在发生故障时能够从最近一次检查点恢复并继续处理。

-

Exactly Once Sink:

- 在将数据写入外部系统时,确保精确一次消费是一个挑战。Flink提供了一种称为"Exactly Once Sink"的机制,用于确保将数据仅写入外部系统一次。这通常需要外部系统本身支持幂等写入操作。

-

幂等性处理:

- 为了实现精确一次消费,应用程序中的处理逻辑通常需要设计为幂等操作,即多次执行相同操作不会产生不同结果。这确保了即使在发生故障后,也可以安全地多次重播事件。

-

恢复和容错性:

- 精确一次消费还依赖于Flink的容错机制,包括检查点和故障恢复。如果应用程序发生故障,Flink可以从最近的检查点恢复,并确保事件处理的一致性。

总之,精确一次消费是流处理中的一种强一致性保证,它要求按照事件时间处理事件、使用检查点机制来保证状态一致性、将外部写入操作设计为幂等,并结合Flink的容错性来确保事件不会丢失且不会重复处理。这是构建可靠和准确流处理应用程序的关键特性。

3. Checkpoint barrier

Flink中的Checkpoint Barrier(检查点屏障)是与检查点机制密切相关的一个重要概念。检查点是流处理中用于保证容错性和一致性的关键机制,而检查点屏障则用于确保在生成检查点时所有操作符都处于一致的状态。下面详细介绍Flink中的Checkpoint Barrier。

-

检查点背景:

- 检查点是Flink中的一种容错机制,用于在事件流处理中创建应用程序状态的一致性快照。检查点允许Flink在发生故障时从上一个检查点恢复应用程序状态,以确保处理的正确性和一致性。检查点通常包括保存的状态以及事件流的位置信息。

-

检查点屏障作用:

- 在Flink中,检查点是异步生成的,因为生成检查点可能会导致一些操作符暂停,等待状态的快照完成。为了确保在生成检查点时所有操作符都处于一致的状态,Flink引入了检查点屏障。

- 检查点屏障是特殊的事件记录,其作用是通知流中的所有操作符暂停处理,等待所有操作符都能够安全地生成检查点。检查点屏障的发送标志着生成检查点的开始。

-

检查点屏障传播:

- 检查点屏障会随着事件流一起传播到所有操作符。当操作符收到检查点屏障时,它会执行以下操作:

- 停止处理输入事件,以确保当前状态的一致性。

- 等待确认所有先前的输入事件都已成功处理完毕,这样可以确保操作符状态的完整性。

- 生成本地状态的检查点,并将其发送到持久化存储(如分布式文件系统)。

- 检查点屏障会随着事件流一起传播到所有操作符。当操作符收到检查点屏障时,它会执行以下操作:

-

操作符确认:

- 一旦操作符确认其状态已被检查点屏障包括的事件更新,它会向下游操作符发送确认消息,告诉它们可以继续处理事件。这确保了所有操作符都在同一时间点生成了一致的检查点。

-

检查点完成:

- 当所有操作符都确认并完成了检查点生成后,Flink将检查点标记为完成,并通知协调者检查点生成成功。协调者会将检查点的元数据保存在可靠的存储中,以便在发生故障时进行恢复。

总的来说,Checkpoint Barrier在Flink中用于协调操作符生成检查点的过程,以确保所有操作符都在一致的状态下生成检查点。这是保障Flink应用程序容错性和一致性的关键机制之一。通过Checkpoint Barrier,Flink可以实现非常快速和可靠的检查点生成,使应用程序能够在发生故障时高效地恢复到一致的状态。

4. 窗口机制

Apache Flink的窗口机制是流处理应用程序中的关键概念,它允许您在有限的事件流上执行聚合和分析操作。窗口允许您将事件流划分为有限的、有界的数据块,以便对这些数据块执行计算。以下是关于Flink窗口机制的详细说明:

-

窗口类型:

- Flink支持多种类型的窗口,其中一些常见的包括:

- 时间窗口(Time Windows):基于事件时间或处理时间的时间段内的数据。

- 滑动窗口(Sliding Windows):按时间滑动的窗口,允许数据同时属于多个窗口。

- 会话窗口(Session Windows):在一段时间内观察事件,并在事件间隙达到一定时间后关闭窗口。

- Flink支持多种类型的窗口,其中一些常见的包括:

-

窗口分配:

- 窗口分配是将事件分配到不同窗口的过程。在Flink中,您可以使用窗口分配器(Window Assigner)来指定如何将事件分配到窗口中,例如基于时间戳、键值等。

-

窗口计算:

- 一旦事件被分配到窗口中,Flink允许您在窗口内执行各种计算操作,如聚合、求和、平均值等。这些计算通常由窗口函数(Window Function)来定义,窗口函数在窗口关闭时执行。

-

窗口触发:

- 窗口触发规定了何时关闭窗口并执行窗口函数。常见的触发方式包括:

- 基于元素数量触发:当窗口中的元素数量达到一定阈值时触发。

- 基于时间触发:当窗口中的事件时间或处理时间达到一定时间点时触发。

- 自定义触发:根据特定的业务逻辑触发窗口。

- 窗口触发规定了何时关闭窗口并执行窗口函数。常见的触发方式包括:

-

窗口合并:

- 在分布式环境中,Flink允许窗口合并来减少通信开销。窗口合并是将多个窗口合并成一个更大的窗口,以减少计算和通信的成本。合并窗口时,Flink确保窗口函数只会被调用一次。

-

迟到事件处理:

- 由于事件可能会迟到到达,Flink提供了机制来处理迟到事件。您可以配置窗口允许一定的迟到时间,迟到的事件将被放入特殊的迟到窗口,以便稍后处理。

-

窗口状态:

- 窗口可以有自己的状态,例如窗口中的累加器或其他中间结果。这些状态在窗口函数执行期间可用,用于跟踪和计算窗口的聚合结果。

-

事件时间处理:

- 窗口通常与事件时间处理结合使用,以确保对事件的处理是基于事件的实际发生时间而不是接收时间。

总之,Flink的窗口机制是实现流式处理的关键组成部分,它允许您对无限流数据进行有界、有意义的处理。通过合适的窗口分配、窗口计算、触发策略以及迟到事件处理,您可以构建出高效、可靠且准确的流处理应用程序。窗口机制在数据分析、实时监控和实时报表等领域都有广泛的应用。

5. 检查点超时

在Apache Flink中,检查点(Checkpoint)是一种用于实现容错性的关键机制,它可以保证应用程序在发生故障时能够从某个状态快照进行恢复。检查点超时是指在生成检查点时设置一个最大时间限制,如果在此时间内检查点无法成功完成,则会触发超时处理。以下是关于Flink检查点超时的详细说明:

-

检查点概述:

- 检查点是Flink中用于容错性的机制,用于创建应用程序状态的一致性快照。生成检查点时,Flink会保存应用程序的状态信息,以便在发生故障时能够恢复到检查点状态并继续处理数据。

-

检查点超时的背景:

- 通常,生成检查点需要一些时间,特别是在处理大量数据的情况下。如果不控制生成检查点的时间,可能会导致应用程序长时间阻塞,从而影响处理的实时性。因此,引入检查点超时机制可以确保生成检查点不会无限期地阻塞应用程序。

-

检查点超时的设置:

- 在Flink中,您可以通过配置来设置检查点超时时间。这是通过

execution.checkpoint.timeout参数来完成的,该参数表示检查点的最大持续时间,以毫秒为单位。如果生成检查点的时间超过了这个阈值,Flink会将其视为检查点超时。

- 在Flink中,您可以通过配置来设置检查点超时时间。这是通过

-

检查点超时的处理:

- 当发生检查点超时时,Flink可以执行不同的操作,具体取决于您的配置。常见的处理方式包括:

- 报警和记录:Flink可以记录警告信息,以便运维团队能够了解到检查点超时的情况。

- 取消检查点:Flink可以取消当前正在生成的检查点,并继续处理数据流。这可以防止长时间的检查点生成导致应用程序停滞。

- 终止应用程序:在某些情况下,如果检查点无法成功生成,可以选择终止应用程序,以避免不一致的状态被保存。

- 当发生检查点超时时,Flink可以执行不同的操作,具体取决于您的配置。常见的处理方式包括:

-

检查点超时的调优:

- 调优检查点超时时间是非常重要的,因为它影响了应用程序的容错性和实时性。您需要根据应用程序的需求和数据规模来设置合适的超时时间。太短的超时时间可能导致检查点无法完成,而太长的超时时间可能导致延迟较高的检查点生成。

总的来说,检查点超时是Flink中用于控制检查点生成时间的重要机制。通过适当地设置检查点超时时间和选择合适的处理策略,可以确保应用程序在容错性和实时性之间达到合理的平衡,从而使流处理应用程序更加可靠。

6. 双流Join

Flink的双流Join是一种流处理操作,它允许您将两个流数据集合并在一起,以便在两个流之间执行联接操作。这是一种有用的操作,用于将两个流中的相关事件合并,以进行进一步的分析、计算或处理。以下是关于Flink双流Join的详细说明:

-

双流Join的背景:

- 在实际的流处理应用中,常常需要将两个或多个流中的事件关联在一起。例如,您可能有一个包含订单信息的流和一个包含产品信息的流,希望将订单事件与相应的产品事件进行关联。

-

双流Join操作:

- 双流Join是指将两个流中的事件基于某个关联条件合并在一起。在Flink中,您可以使用

join操作来执行双流Join。此操作允许您定义如何匹配两个流中的事件以进行联接,以及在匹配成功时执行的操作。

- 双流Join是指将两个流中的事件基于某个关联条件合并在一起。在Flink中,您可以使用

-

匹配条件:

- 在双流Join中,您需要定义一个匹配条件,以确定两个事件是否应该被关联在一起。匹配条件通常基于某些共同的属性或键,例如订单ID、产品ID等。

-

窗口和时间条件:

- 双流Join通常与窗口操作结合使用,以便在一定时间范围内执行联接操作。您可以使用时间窗口或者其他类型的窗口来控制事件的匹配和关联。

-

Join类型:

- Flink支持不同类型的Join操作,包括:

- 内连接(Inner Join):只保留在两个流中都有匹配的事件。

- 左连接(Left Join):保留左流中的所有事件,并将右流中匹配的事件合并。

- 右连接(Right Join):保留右流中的所有事件,并将左流中匹配的事件合并。

- 全连接(Full Outer Join):保留两个流中的所有事件,并将匹配的事件合并。

- Flink支持不同类型的Join操作,包括:

-

时间属性处理:

- 在双流Join中,通常需要考虑事件时间(Event Time)和处理时间(Processing Time)。Flink允许您在Join操作中使用事件时间以确保事件按照实际时间顺序匹配。

-

状态管理:

- 双流Join涉及到状态管理,因为要跟踪两个流中的事件以进行匹配和关联。Flink会自动管理状态以支持Join操作。

-

性能考虑:

- 双流Join可能涉及大量的状态管理和事件匹配,因此在设计应用程序时需要考虑性能和扩展性。一些技术,如窗口合并和分布式状态,可以用来提高性能。

总之,Flink的双流Join是一种强大的流处理操作,可用于将两个流中的相关事件合并在一起,以进行更深入的分析和计算。通过定义匹配条件、选择适当的Join类型和窗口操作,您可以根据应用程序需求执行各种Join操作。这在实时数据分析、事件关联和数据合并等场景中非常有用。

7. 状态

Apache Flink中的状态(State)是流处理应用程序中的关键概念之一,它用于存储和管理应用程序的状态信息。状态允许应用程序跟踪和维护有关数据的信息,以支持处理、聚合和分析操作。以下是关于Flink状态的详细说明:

-

状态的作用:

- 在流处理应用程序中,状态用于保存与事件处理有关的信息,如聚合计数、累积结果、窗口状态等。状态允许应用程序在处理无限数据流时保持有限状态,以便实现更复杂的计算逻辑。

-

状态类型:

- Flink支持不同类型的状态,包括:

- 键控状态(Keyed State):与特定键相关联的状态,通常用于按键进行分组的操作符。

- 窗口状态(Window State):与时间窗口相关联的状态,用于窗口操作。

- 算子状态(Operator State):与操作符相关联的全局状态,通常用于在操作符之间共享状态信息。

- Flink支持不同类型的状态,包括:

-

状态访问:

- Flink中的状态可以通过状态句柄(State Handle)进行访问。状态句柄是一个抽象概念,允许应用程序代码读取和写入状态数据,而不必关心状态是如何存储和管理的。

-

状态管理:

- Flink自动管理状态的生命周期、分区和一致性。状态的分区是根据键(Key)来定义的,每个分区包含具有相同键的事件。Flink确保状态的容错性和一致性,以便在发生故障时能够恢复状态。

-

状态的保存和恢复:

- Flink通过检查点(Checkpoint)机制来保存状态,将状态数据周期性地写入持久化存储中,以便在发生故障时进行恢复。检查点还用于实现精确一次消费(Exactly Once Processing)语义。

-

状态的使用场景:

- 状态在流处理应用程序中有多种用途,包括窗口操作、聚合计算、模式匹配、事件关联等。状态还允许应用程序在处理事件时跟踪和更新上下文信息。

-

状态的生命周期:

- 状态的生命周期通常与应用程序的生命周期一致,但可以根据需要手动清除或重置。状态的生命周期包括创建、读取、更新和删除等操作。

-

状态的分布式处理:

- 在分布式流处理环境中,状态的管理和处理可能涉及到跨多个任务和节点的数据交换。Flink通过分布式状态后端(State Backend)来管理和存储状态数据,以支持分布式处理。

总之,Flink的状态是流处理应用程序中的关键组成部分,它允许应用程序在处理无限数据流时保持有限状态,以支持更复杂的计算和分析操作。状态的自动管理、容错性和一致性使其成为构建可靠和强大的实时数据处理应用程序的基础。

详细文档见:02Flink.pdf

8. 反压是什么

在Apache Flink中,反压(Backpressure)是一种流处理系统中的重要概念,用于解决生产者和消费者之间速度不匹配的问题。当生产者产生数据的速度远远快于消费者处理数据的速度时,可能会导致数据在系统中堆积,进而影响应用程序的稳定性和性能。反压机制旨在解决这个问题,以确保数据流在系统内的平衡。

以下是有关Flink中反压的详细说明:

-

反压概念:

- 反压是指在流处理系统中,当数据生产速率超过消费速率时,系统可以通过某种方式通知生产者减慢数据生成速度,以避免数据积压和系统不稳定性。

-

反压的需要:

- 在流处理中,生产者和消费者通常由不同的组件或任务执行。如果生产者生成数据的速度远远快于消费者处理数据的速度,数据将不断积压在系统中,导致内存压力增大,可能会导致系统崩溃或性能下降。

-

反压实现:

- Flink使用两种主要的方式来实现反压:

- 网络反压:Flink的任务管理器(TaskManager)可以向JobManager报告其处理数据的速度,并且JobManager可以将这些信息聚合并推送给生产者任务,以通知它们减慢生成速度。

- 内部队列大小:Flink任务之间的数据交换通常使用内部队列。队列的大小可以被动态调整,以确保消费者可以跟上数据的速度。

- Flink使用两种主要的方式来实现反压:

-

反压的作用:

- 反压机制的主要作用是确保系统的稳定性。当数据流量过大时,反压可以防止任务运行时出现内存溢出或系统崩溃的情况,从而提高应用程序的可靠性。

- 反压还有助于防止数据积压,提高应用程序的性能,因为数据不会无限制地积压在系统中,导致资源浪费。

-

适用场景:

- 反压通常在生产者和消费者速度差异较大的情况下使用。这种情况可能在外部系统向Flink中导入数据,或者在Flink中的不同算子之间产生速度差异时出现。

-

注意事项:

- 反压机制可能引入一定的延迟,因为生产者需要等待消费者赶上。因此,在设计应用程序时,需要仔细考虑反压的配置和调优。

总之,反压是流处理系统中的一项关键机制,用于解决生产者和消费者速度不匹配的问题。在Flink中,通过网络反压和内部队列大小调整等方式实现反压,以确保数据流在系统中能够平衡,提高应用程序的稳定性和性能。

9. 解决方案

解决流处理中的反压问题通常需要综合考虑多个因素,并采用一系列策略和技术。以下是一些解决方案和最佳实践,可帮助您处理反压问题:

-

调整并行度:

- 如果某个操作符的生产速度远快于下游操作符的处理速度,可以考虑调整操作符的并行度。增加下游操作符的并行度可以提高其处理能力,以更好地跟上数据生成速度。

-

使用合适的时间窗口:

- 在窗口操作中,选择合适的时间窗口大小可以帮助控制数据流的速度。较小的窗口可以减少数据积压,但可能会增加计算成本。根据应用程序的需求进行权衡和调整。

-

实施数据分流:

- 在数据分流时,可以将数据按键或其他属性分发到多个下游操作符,以均衡处理负载。这有助于避免单个操作符的压力。

-

设置流速限制:

- 在某些情况下,您可以在生产者端或Flink任务管理器上设置流速限制,以控制数据生成速度。这可以通过调整事件生成速度、限制发送速率或使用外部调度工具来实现。

-

使用异步操作:

- 异步操作可以帮助在处理速度不匹配时减小压力。例如,可以将某些操作异步化,以便在处理较慢的数据时不会阻塞整个流。

-

监控和调优:

- 定期监控应用程序的性能和资源使用情况,以及检查反压情况。根据监控结果进行调优,以优化应用程序的性能。

-

利用Flink的反压机制:

- Flink本身具有一些反压机制,可以自动管理任务之间的数据流速率。您可以利用Flink的网络反压和内部队列大小来确保任务之间的平衡。

-

事件时间处理:

- 在流式处理中,事件时间处理通常优于处理时间(Processing Time),因为它可以更好地控制数据流速度,并允许您处理有序的事件。

最终,解决反压问题是一个复杂的任务,需要根据具体的应用程序和数据流量情况进行定制化的处理。通过组合使用上述策略和监控工具,您可以更好地应对反压问题,确保流处理应用程序的稳定性和性能。

10. 延迟数据解决

在Apache Flink中,出现延迟数据(Latency)的情况是很常见的,这是因为流处理系统的复杂性和多样性数据流的特性所导致的。延迟数据可能会影响应用程序的实时性和性能,因此需要采取一些策略来解决这个问题。

以下是一些导致延迟数据的常见原因以及解决方法:

-

网络传输延迟:

- 数据在不同的任务之间传输需要时间,特别是在分布式环境下。这可能导致数据在流中的延迟增加。

- 解决方法:可以通过调整并行度、减小任务之间的网络距离、使用高性能网络等方式来降低网络传输延迟。

-

计算延迟:

- 复杂的计算操作可能需要较长的时间来处理事件。如果某个算子的处理速度较慢,就会导致延迟数据。

- 解决方法:可以通过优化算法、提高计算资源、合理分布任务负载等方式来减少计算延迟。

-

窗口操作:

- 在窗口操作中,数据需要等到窗口关闭后才能进行处理,这可能导致一些数据在流中积压,直到窗口关闭。

- 解决方法:可以调整窗口大小、使用滑动窗口或会话窗口等方式,以更及时地处理数据。

-

数据倾斜:

- 当数据流中的某些键具有远高于其他键的数据量时,会导致数据倾斜,即某些任务处理的数据量远大于其他任务。

- 解决方法:可以采用键分区策略、重新分布数据、使用随机前缀或均匀分布键等方法来减轻数据倾斜问题。

-

故障和重启:

- Flink应用程序中的任务故障和重启可能会导致一些数据丢失或产生延迟。

- 解决方法:通过使用Flink的检查点机制和精确一次消费语义来确保在故障和重启后不丢失数据,以及尽量减少恢复时间。

-

资源限制:

- 资源限制(如CPU和内存)可能导致任务无法及时处理数据。

- 解决方法:增加计算资源、优化代码以降低资源消耗、调整并行度以更好地利用资源等。

-

流水线优化:

- Flink支持流水线优化,但如果操作符的优化过于复杂,可能会导致流水线被打破,从而引入延迟。

- 解决方法:简化操作符链、合并多个操作符以减少流水线段数,以提高流水线优化的效率。

总之,延迟数据是流处理系统中常见的挑战之一。要解决延迟数据问题,需要综合考虑应用程序的拓扑结构、并行度设置、数据分布、算法复杂性和资源配置等多个因素。通过监控和性能调优,以及使用Flink的一致性保证机制,可以减少延迟数据的影响,提高流处理应用程序的实时性。

11. 优化

优化Apache Flink应用程序是确保其性能、稳定性和可伸缩性的关键步骤。Flink优化涵盖了多个方面,从程序代码、并行度、状态管理到资源配置等各个层面都需要综合考虑。以下是一些详细的Flink优化技巧和最佳实践:

-

合理设置并行度:

- 并行度是决定Flink应用程序性能的一个关键因素。合理设置并行度可以充分利用计算资源,减少任务之间的数据传输,并提高性能。

- 了解应用程序中每个操作符的负载情况,选择合适的并行度,通常可以通过监控和性能测试来找到最佳值。

-

状态管理:

- Flink中的状态管理是关键性能因素之一。状态数据的存储和检索可能会成为性能瓶颈。可以采取以下措施来优化状态管理:

- 使用RocksDB作为状态后端,以提高状态的持久性和性能。

- 选择合适的状态数据结构,如ValueState、ListState等,以避免状态过于臃肿。

- 定期清理不再需要的状态,以减小状态大小。

- Flink中的状态管理是关键性能因素之一。状态数据的存储和检索可能会成为性能瓶颈。可以采取以下措施来优化状态管理:

-

窗口操作:

- 对于窗口操作,合理选择窗口大小和滑动间隔是关键。窗口太小可能导致频繁的窗口触发,而窗口太大可能导致状态过大。

- 使用追踪窗口数据的方式来识别潜在的性能问题,并进行调整。

-

数据分区:

- 数据分区策略可以影响应用程序的性能。选择合适的键分区策略和数据分布方式,以确保数据均匀地分布到任务之间。

- 如果数据倾斜问题出现,可以考虑使用均匀分布键或重新分布数据来解决。

-

网络通信:

- Flink中的数据传输通常需要通过网络,网络通信的性能对应用程序性能至关重要。

- 优化网络传输包括选择高性能的网络硬件、减少数据传输、合并多个任务之间的数据传输等。

-

异步IO:

- 对于需要进行IO操作的任务,可以考虑使用异步IO来提高性能。异步IO可以减少任务之间的等待时间,从而提高整体吞吐量。

-

流水线优化:

- Flink支持流水线优化,允许将多个操作符连接在一起形成流水线。但是,如果操作符过于复杂,可能会破坏流水线优化。

- 简化操作符链、合并多个操作符以减少流水线段数,以提高流水线优化的效率。

-

检查点配置:

- 检查点是实现容错性的关键。合理配置检查点参数,如检查点间隔、最大并行度、最大并行异步检查点等,以确保系统的稳定性和性能。

-

监控和调优:

- 使用Flink的监控工具(如Flink Web UI、Prometheus、Grafana等)来实时监控应用程序的性能和资源使用情况,及时发现和解决性能问题。

-

资源管理:

- 有效地管理计算资源,包括CPU、内存、磁盘等,以确保应用程序具有足够的资源来运行。可以使用YARN、Kubernetes等资源管理器来管理资源。

-

日志和异常处理:

- 优化日志记录级别,减少不必要的日志输出,以减少日志对性能的影响。

- 实现良好的异常处理和故障恢复策略,以提高应用程序的健壮性和可维护性。

-

版本升级:

- 定期升级到最新的Flink版本,以获得性能改进、bug修复和新特性。新版本通常会提供更好的性能和稳定性。

综合考虑上述优化技巧,可以帮助您更好地调优和管理Apache Flink应用程序,以获得更好的性能、稳定性和可伸缩性。不同应用程序的优化需求可能会有所不同,因此建议根据具体情况进行调整和改进。

相关文章:

BD就业复习第二天

Hbase 1. 架构 HBase(Hadoop Database)是一个开源的分布式、面向列族(Column Family)的NoSQL数据库,它是构建在Hadoop之上的。HBase的架构设计旨在处理大规模的数据,特别适用于需要快速读写和随机访问大量…...

大数据Flink(八十五):Window TVF 支持多维数据分析

文章目录 Window TVF 支持多维数据分析 一、Grouping Sets 二、Rollup...

css-边框原理教程

1. CSS中边框原理 他不是一条直线,根据盒子原理,当边框宽度大于元素的长和宽时,呈现一个梯形和三角形的形状,用如下的代码来实地理解一下边框画法实现的原理 注:学习网址: CSS画几种图形的方法_css画图_老…...

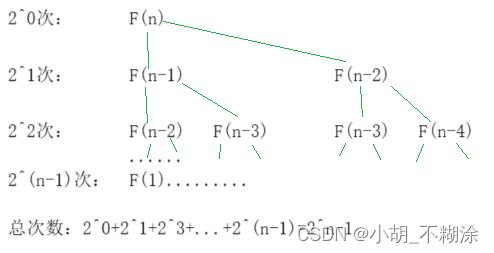

【数据结构】时间、空间复杂度

⭐ 作者:小胡_不糊涂 🌱 作者主页:小胡_不糊涂的个人主页 📀 收录专栏:浅谈数据结构 💖 持续更文,关注博主少走弯路,谢谢大家支持 💖 时间、空间复杂度 1. 算法效率3. 时…...

Databend 开源周报第 111 期

Databend 是一款现代云数仓。专为弹性和高效设计,为您的大规模分析需求保驾护航。自由且开源。即刻体验云服务:https://app.databend.cn 。 Whats On In Databend 探索 Databend 本周新进展,遇到更贴近你心意的 Databend 。 理解 SHARE END…...

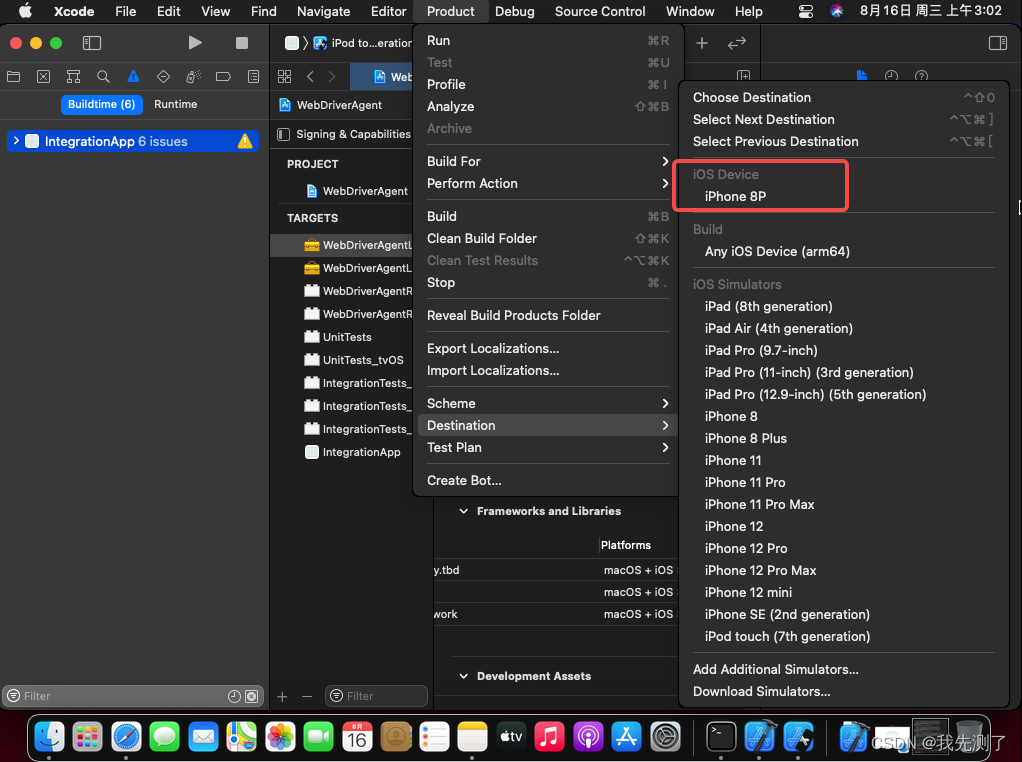

iOS自动化测试方案(一):MacOS虚拟机保姆级安装Xcode教程

文章目录 一、环境准备二、基础软件三、扩展:usb拓展插件 一、环境准备 1、下载VMware虚拟机的壳子,安装并注册软件(可以百度注册码),最新版本:v17 2、下MacOS系统iOS镜像文件,用于vmware虚拟机安装,当前镜…...

vue3 - Vue 项目处理GitHub Pages 部署后 _plugin-vue_export-helper.js 404

GitHub Demo 地址 在线预览 vue3项目打包后部署到github pages 后,预览网站提示下划线开头的一个文件_plugin-vue_export-helper访问不到,网络请求显示404 处理GitHub Pages 部署 _plugin-vue_export-helper.js 404 https://github.com/rollup/rollup/b…...

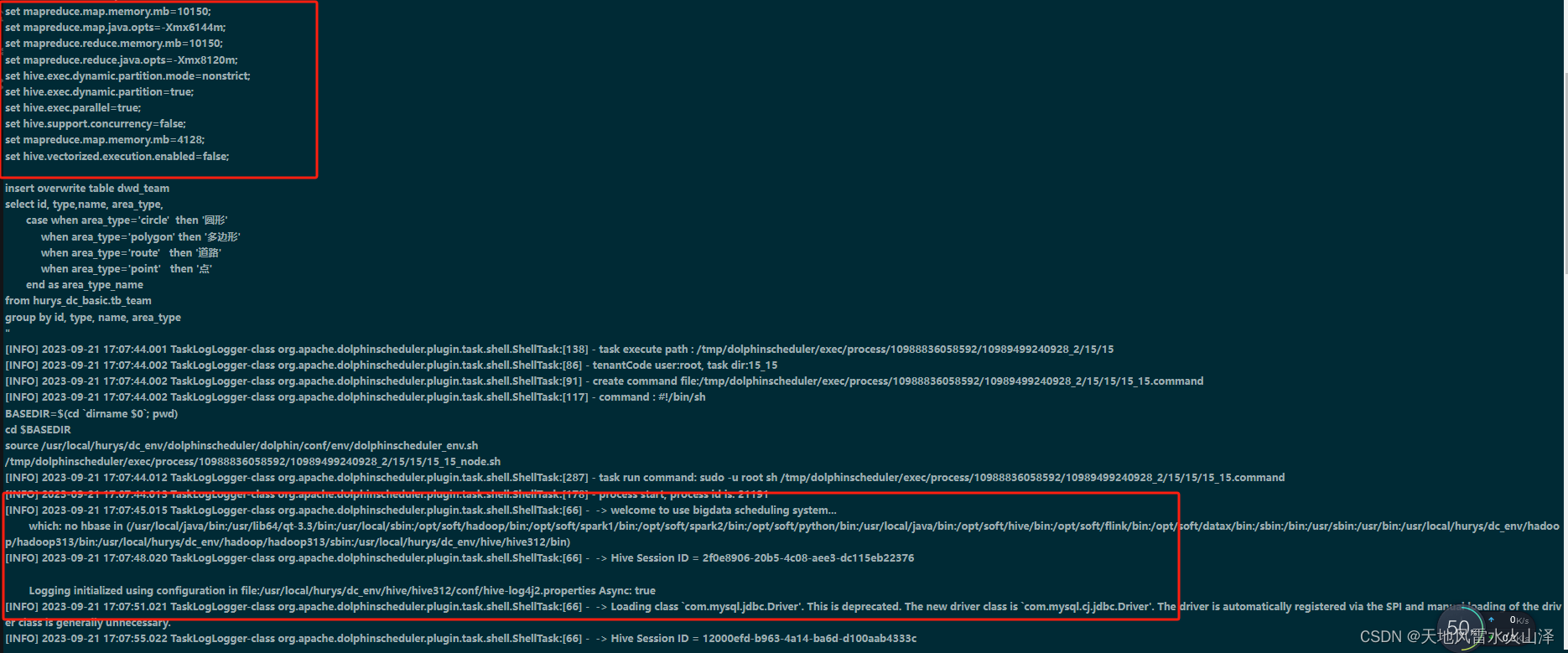

一百八十一、Hive——海豚调度HiveSQL任务时当Hive的计算引擎是mr或spark时脚本的区别(踩坑,附截图)

一、目的 当Hive的计算引擎是spark或mr时,发现海豚调度HQL任务的脚本并不同,mr更简洁 二、Hive的计算引擎是Spark时 (一)海豚调度脚本 #! /bin/bash source /etc/profile nowdatedate --date0 days ago "%Y%m%d" y…...

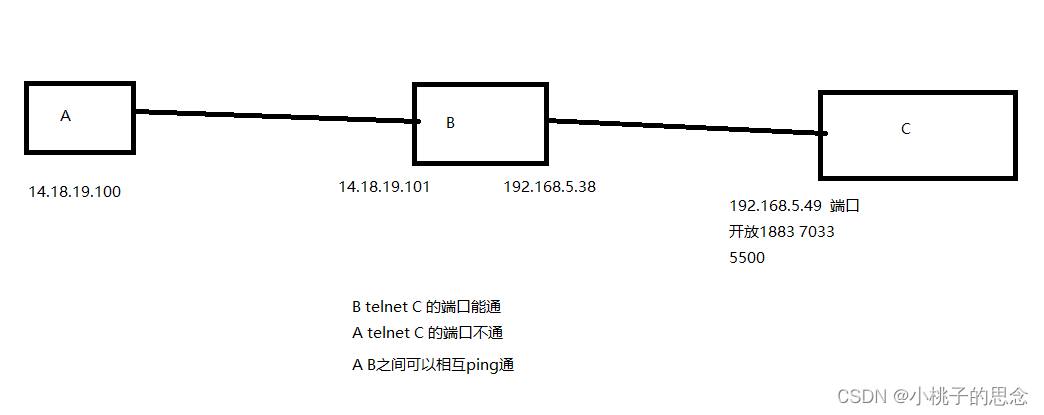

Linux 隔离网段下端口转发

设备在隔离网段下,设置端口转发。使A设备可访问C设备的服务 #!/bin/bash #输出成绩脚本 echo -n "请输入外网服务器的IP地址:" read score sudo iptables -t nat -A PREROUTING -p tcp --dport 1883 -j DNAT --to-destination $score:1883 s…...

【CDN和UDN】CDN和UDN技术特点以及使用场景

内容分发网络(CDN)和用户自定义网络(UDN)是两种不同的网络技术,在选择时,往往不能准备把握具不同的技术特点和应用场景。CDN 主要用于加速内容分发,而 UDN 则主要用于支持用户自定义的网络需求。…...

【Linux】改变缓存路径、清理缓存

写在前面 在做项目的过程中,服务器base路径下空间不足,准备在另一个目录下创建虚拟环境,但在安装的过程中,发现base路径下的空间还是在减少,后来经过学习了解到,pip安装下载依赖包时,会先下载缓…...

python+opencv寻找图片或视频中颜色进行追踪之HSV颜色处理

pythonopencv寻找图片或视频中颜色进行追踪之HSV颜色处理 1.颜色空间转换 import cv2img cv2.imread(1.jpg) # 转换为灰度图 img_gray cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)cv2.imshow(img, img) cv2.imshow(gray, img_gray) cv2.waitKey(0)cv2.cvtColor()用来进行颜色模…...

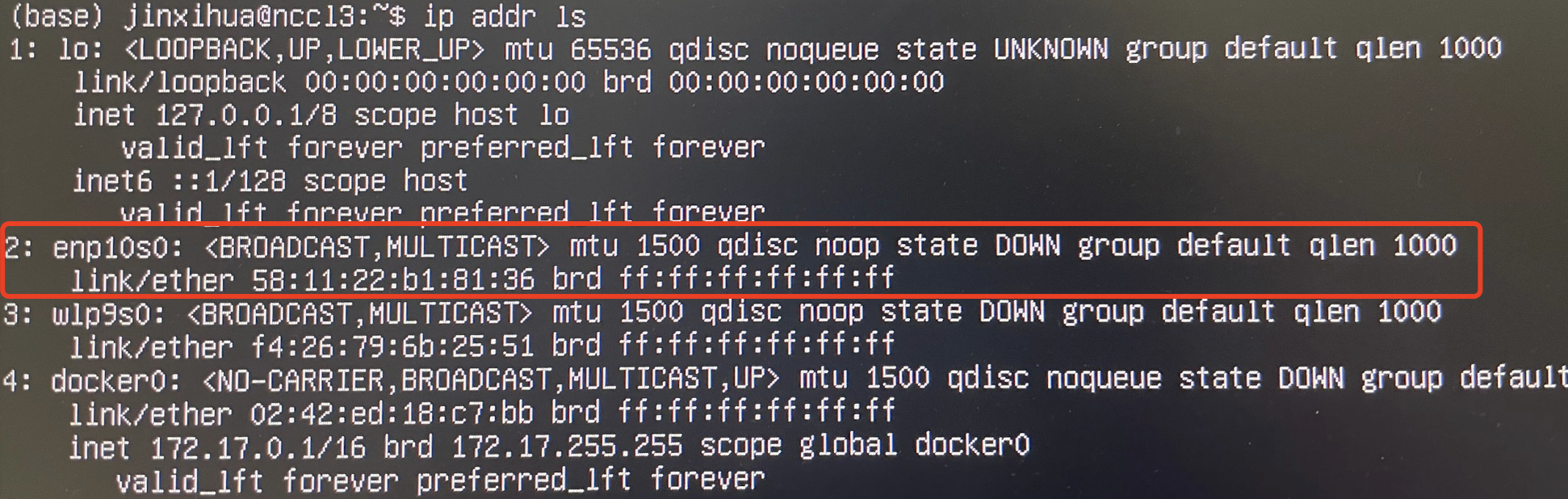

ubuntu 22.04 服务器网卡无IP地址

ssh连接服务器连接不上,提示如下; 连接显示器,ip addr ls 命令查看IP地址,有网卡但没有IP地址 solution: sudo dhclient enp10s0用于通过 DHCP 协议获取网络配置信息并为名为 enp10s0 的网络接口分配 IP 地址,enp1…...

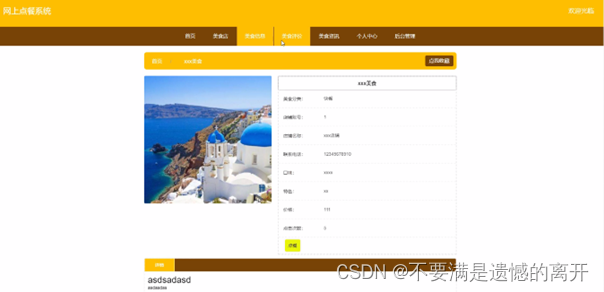

基于SpringBoot的网上点餐系统

目录 前言 一、技术栈 二、系统功能介绍 用户功能模块 管理员功能模块 美食店功能模块 前台首页功能模块 三、核心代码 1、登录模块 2、文件上传模块 3、代码封装 前言 系统管理也都将通过计算机进行整体智能化操作,对于网上点餐系统所牵扯的管理及数据保存…...

浅谈xss

XSS 简介 XSS,全称Cross Site Scripting,即跨站脚本攻击,是最普遍的Web应用安全漏洞。这类漏洞能够使得攻击者嵌入恶意脚本代码到正常用户会访问到的页面中,当正常用户访问该页面时,则可导致嵌入的恶意脚本代码的执行,从而达到恶意攻击用户的目的。需要强调的是,XSS不仅…...

悬崖边:企业如何应对网络安全漏洞趋势

在本文中,我们将讨论企业在处理漏洞时面临的挑战,解释安全漏洞是如何引发网络攻击的,以及为什么它会导致不可接受的事件。我们还将分享我们在识别趋势性漏洞方面的经验。 现代信息安全方法正在成为企业的工作流程。例如,不久前&a…...

MyBatis 动态 SQL、MyBatis 标签、MyBatis关联查询

MyBatis 动态 SQL、MyBatis 标签、MyBatis关联查询 1、MyBatis动态 sql 的特性2、MyBatis 标签2.1、if 标签:条件判断2.2、whereif 标签2.3、set 标签2.4、choose(when,otherwise) 语句2.5、trim2.6、MyBatis foreach 标签 3、整合案例3.1、XML3.2、测试类 4、sql 标…...

在Vue中使用Immutable.js

在Vue3中使用Immutable.js 以下是如何在Vue.js中使用Immutable.js的步骤: 首先,需要安装immutable.js。你可以通过npm或yarn来安装: npm install immutable或者 yarn add immutable在你的Vue组件中导入Immutable: import { Ma…...

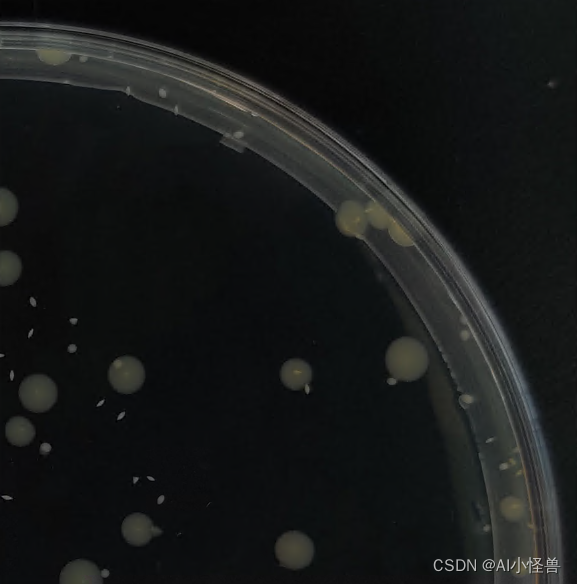

基于Yolov8的工业端面小目标计数检测(1)

1.端面小目标计数数据集介绍 工业端面小目标计数类别:一类,类别名object 数据集大小:训练集864张,验证集98张 缺陷特点:小目标计数,检测难度大,如下图所示; 1.1 小目标定义 1)以物体检测领域的通用数据集COCO物体定义为例,小目标是指小于3232个像素点(中物体是指…...

1.什么是jwt?jwt的作用是什么?2.jwt的三个部分是什么?三者之间的关系如何?3.JWT运行的流程是什么

1. **什么是JWT?JWT的作用是什么?** JWT(JSON Web Token)是一种用于在不同系统或组件之间传输信息的紧凑且安全的标准。它的作用主要有两个方面: - **身份验证(Authentication)**…...

多模态2025:技术路线“神仙打架”,视频生成冲上云霄

文|魏琳华 编|王一粟 一场大会,聚集了中国多模态大模型的“半壁江山”。 智源大会2025为期两天的论坛中,汇集了学界、创业公司和大厂等三方的热门选手,关于多模态的集中讨论达到了前所未有的热度。其中,…...

智能在线客服平台:数字化时代企业连接用户的 AI 中枢

随着互联网技术的飞速发展,消费者期望能够随时随地与企业进行交流。在线客服平台作为连接企业与客户的重要桥梁,不仅优化了客户体验,还提升了企业的服务效率和市场竞争力。本文将探讨在线客服平台的重要性、技术进展、实际应用,并…...

三体问题详解

从物理学角度,三体问题之所以不稳定,是因为三个天体在万有引力作用下相互作用,形成一个非线性耦合系统。我们可以从牛顿经典力学出发,列出具体的运动方程,并说明为何这个系统本质上是混沌的,无法得到一般解…...

Java 二维码

Java 二维码 **技术:**谷歌 ZXing 实现 首先添加依赖 <!-- 二维码依赖 --><dependency><groupId>com.google.zxing</groupId><artifactId>core</artifactId><version>3.5.1</version></dependency><de…...

NPOI Excel用OLE对象的形式插入文件附件以及插入图片

static void Main(string[] args) {XlsWithObjData();Console.WriteLine("输出完成"); }static void XlsWithObjData() {// 创建工作簿和单元格,只有HSSFWorkbook,XSSFWorkbook不可以HSSFWorkbook workbook new HSSFWorkbook();HSSFSheet sheet (HSSFSheet)workboo…...

比较数据迁移后MySQL数据库和OceanBase数据仓库中的表

设计一个MySQL数据库和OceanBase数据仓库的表数据比较的详细程序流程,两张表是相同的结构,都有整型主键id字段,需要每次从数据库分批取得2000条数据,用于比较,比较操作的同时可以再取2000条数据,等上一次比较完成之后,开始比较,直到比较完所有的数据。比较操作需要比较…...

聚六亚甲基单胍盐酸盐市场深度解析:现状、挑战与机遇

根据 QYResearch 发布的市场报告显示,全球市场规模预计在 2031 年达到 9848 万美元,2025 - 2031 年期间年复合增长率(CAGR)为 3.7%。在竞争格局上,市场集中度较高,2024 年全球前十强厂商占据约 74.0% 的市场…...

命令行关闭Windows防火墙

命令行关闭Windows防火墙 引言一、防火墙:被低估的"智能安检员"二、优先尝试!90%问题无需关闭防火墙方案1:程序白名单(解决软件误拦截)方案2:开放特定端口(解决网游/开发端口不通)三、命令行极速关闭方案方法一:PowerShell(推荐Win10/11)方法二:CMD命令…...

从实验室到产业:IndexTTS 在六大核心场景的落地实践

一、内容创作:重构数字内容生产范式 在短视频创作领域,IndexTTS 的语音克隆技术彻底改变了配音流程。B 站 UP 主通过 5 秒参考音频即可克隆出郭老师音色,生成的 “各位吴彦祖们大家好” 语音相似度达 97%,单条视频播放量突破百万…...

【QT控件】显示类控件

目录 一、Label 二、LCD Number 三、ProgressBar 四、Calendar Widget QT专栏:QT_uyeonashi的博客-CSDN博客 一、Label QLabel 可以用来显示文本和图片. 核心属性如下 代码示例: 显示不同格式的文本 1) 在界面上创建三个 QLabel 尺寸放大一些. objectName 分别…...