问 ChatGPT 关于GPT的事情:扩展篇

一、GPT预训练有什么节省显存和算力的技巧吗?我如何拿四块A100完成175B模型的预训练?

对于GPT预训练,有一些技巧可以帮助节省显存和算力。以下是一些常用的技巧:

按批次截断:在较长的文本序列中,将其切割成较短的子序列进行处理。这样可以减少每个批次的序列长度,节省显存和算力。

动态掩码:对于较长的序列,可以动态地将一部分标记设置为特殊的掩码标记,从而减少计算量和显存使用。

梯度累积:将多个小批次的梯度累积并一起更新模型参数。这样可以减少显存需求,并使得模型更加稳定。

混合精度训练:使用混合精度训练可以减少显存使用,并提高模型训练速度。

至于如何使用四块A100来完成175B模型的预训练,这取决于模型架构和所使用的训练框架。然而,通常情况下,可以采用数据并行训练的策略,其中不同的GPU处理不同的数据子集,并定期同步以更新模型参数。具体的实现方法可以参考相关的训练框架和文档。

完全没有提扩展的事情。

二、我现在有一个6B的GPT小模型,我想把它训练成一个175B的大模型,该怎么做?请给出具体步骤。

对于将一个6B的GPT小模型训练成一个175B的大模型,需要进行以下步骤:

数据准备:确保你有足够的高质量文本数据来训练大模型。这些数据应包含多样化的主题和语言风格,以提高模型的泛化能力。

训练环境准备:由于目标是训练一个大模型,需要强大的计算资源和适当的训练环境。建议使用具备高性能GPUs或TPUs的云服务提供商,以加快训练速度。

扩展模型架构:将模型架构从6B扩展到175B。这涉及到增加模型的层数、隐藏单元数以及其他相关参数。这一步需要进行仔细的设计和调整,以确保模型能够适应更大的规模。

参数初始化:使用预训练的6B模型的权重作为初始参数,并根据扩展后的模型架构进行适当的调整。

数据并行训练:由于内存限制,无法将整个数据集加载到内存中进行训练。因此,使用数据并行训练技术,将数据集分成小批次进行并行训练。

学习率调度:在训练过程中,使用适当的学习率调度策略,例如逐渐降低学习率或使用动态学习率调整方法,以优化训练效果并加快收敛速度。

训练时间和迭代次数:由于模型的规模增大,训练时间和所需的迭代次数可能会显著增加。根据实际情况,分配足够的时间来完成训练,并确保模型达到收敛。

请问还有其他问题吗?

三、假设我有一个12层的GPT模型,我想把它扩展到24层,每层的结构不变,参数尽可能复用,请给出PyTorch 代码。

要将一个12层的GPT模型扩展到24层,并且保持每层结构不变,可以通过复制模型的前12层来实现。下面是使用PyTorch的代码示例:

import torch

import torch.nn as nnclass GPT(nn.Module):def __init__(self, num_layers):super(GPT, self).__init__()self.num_layers = num_layersself.layers = nn.ModuleList([nn.Linear(768, 768) for _ in range(num_layers)]) # 假设输入维度为768def forward(self, x):for i in range(self.num_layers):x = self.layers[i](x)return x# 创建12层GPT模型

model = GPT(num_layers=12)# 复制前12层来构建24层GPT模型

new_model = GPT(num_layers=24)

for i in range(model.num_layers):new_model.layers[i] = model.layers[i]# 打印新模型的层数

print(new_model.num_layers) # 输出: 24

这样完全不对,后12的参数显然是没有初始化的。

四、假设我有一个12层的GPT模型,我想把它扩展到24层,采用copy.deepcopy实现,请给出PyTorch 代码。

要将一个12层的GPT模型扩展到24层,可以使用copy.deepcopy来实现。以下是使用PyTorch的代码示例:

import torch

import copyclass GPTModel(torch.nn.Module):def __init__(self, num_layers):super(GPTModel, self).__init__()self.layers = torch.nn.ModuleList([torch.nn.Linear(768, 768) for _ in range(num_layers)])def forward(self, x):for layer in self.layers:x = layer(x)return x# 创建一个12层的GPT模型

gpt_model_12_layers = GPTModel(num_layers=12)# 使用copy.deepcopy将其扩展到24层

gpt_model_24_layers = copy.deepcopy(gpt_model_12_layers)

gpt_model_24_layers.layers.extend(copy.deepcopy(gpt_model_12_layers.layers))# 打印模型结构,可以看到已经扩展到24层

print(gpt_model_24_layers)

这回对了一半,但显然每层复制一份插到后面才是最优的扩展策略,再试试。

五、假设我有一个12层的GPT模型,我想把它扩展到24层,每层复制一份插入到他的后面,采用copy.deepcopy实现,请给出PyTorch 代码。

你可以使用以下代码将一个12层的GPT模型扩展到24层,并在每一层后面插入复制的层:

import copy

import torchclass GPTModel(torch.nn.Module):def __init__(self, num_layers):super(GPTModel, self).__init__()self.layers = torch.nn.ModuleList([torch.nn.Linear(768, 768) for _ in range(num_layers)])def forward(self, x):for layer in self.layers:x = layer(x)return xnum_layers = 12

gpt_model = GPTModel(num_layers)# 将模型扩展为24层

for _ in range(num_layers):layer_copy = copy.deepcopy(gpt_model.layers[_])gpt_model.layers.append(layer_copy)print(gpt_model)

这段代码中,我们定义了一个 GPTModel 类,其中包含一个由线性层组成的 layers 列表。通过使用 torch.nn.ModuleList,我们可以将层添加到模型中。然后,我们使用 copy.deepcopy 复制每一层,并将复制的层添加到 layers 列表中。

这样还是不对,新添加的层还是放到了最后。

正确版本是

gpt_model.layers = torch.nn.ModuleList(sum([[l, copy.deepcopy(l)] for l in gpt_model.layers ], []))

六、这次试试一次性提供所有信息,看看能不能写对。

假设我有一个GPT模型

gpt,gpt.layers是每一个GPT层,请写一段Python代码,使用copy.deepcopy()将每一层复制一份,插入到该层后面,并将复制后的层传回gpt。

要将每一层复制一份并插入到该层后面,可以使用循环遍历gpt.layers,并使用copy.deepcopy()进行深拷贝。然后将复制后的层插入到原来的层之后。下面是实现这个过程的Python代码:

import copydef duplicate_layers(gpt):new_layers = []for layer in gpt.layers:new_layer = copy.deepcopy(layer)new_layers.append(layer)new_layers.append(new_layer)gpt.layers = new_layersreturn gpt

上述代码首先创建一个新的空列表new_layers,然后使用循环遍历每一个层layer。对于每一层,我们使用copy.deepcopy()进行深拷贝,得到一个副本new_layer。接着,将原来的层和副本层依次添加到new_layers中。最后,将new_layers赋值给gpt.layers,即将复制后的层传回gpt。

除了没加

torch.nn.ModuleList都对了。

七、现在我有两个PyTorch 模块mod1和mod2,它们的参数结构完全一样,请写一段Python代码,合并这两个模块的参数,新的参数取它们的平均。

可以使用PyTorch的state_dict()方法获取模型的参数字典,然后将两个模块的参数字典合并并取平均,最后加载回新的模型中。下面是一个示例代码:

import torch# 获取模块的参数字典

mod1_params = mod1.state_dict()

mod2_params = mod2.state_dict()# 合并参数字典并取平均

merged_params = {}

for key in mod1_params.keys():merged_params[key] = (mod1_params[key] + mod2_params[key]) / 2# 加载新的参数到模型中

mod1.load_state_dict(merged_params)

这个一次性回答对。

八、假设我有一个GPT模型gpt,gpt.layers是它的每一层,请写一段代码,使用state_dict()把每两层合并成一层,新的层的参数取两个层的均值,之后将合并后的层放入gpt。

很高兴回答你的问题!下面是代码示例,用于合并gpt模型的每两层,并将合并后的层放入gpt:

import torch# 获取模型的层列表

layers = list(gpt.layers)# 定义新的层列表

new_layers = []# 合并每两层

for i in range(0, len(layers), 2):if i + 1 < len(layers):# 获取两个层的参数params1 = layers[i].state_dict()params2 = layers[i + 1].state_dict()# 计算参数的均值merged_params = {}for key in params1.keys():merged_params[key] = (params1[key] + params2[key]) / 2# 创建新的合并层merged_layer = type(layers[i])(**merged_params)new_layers.append(merged_layer)else:# 如果模型层数为奇数,最后一层保持不变new_layers.append(layers[i])# 将合并后的层放入模型

gpt.layers = torch.nn.ModuleList(new_layers)

希望这段代码对你有帮助!如果你有任何其他问题,请随时提问。

这次一次性答对,但是如果不提示

state_dict()就完全想不到。

相关文章:

问 ChatGPT 关于GPT的事情:扩展篇

一、GPT预训练有什么节省显存和算力的技巧吗?我如何拿四块A100完成175B模型的预训练? 对于GPT预训练,有一些技巧可以帮助节省显存和算力。以下是一些常用的技巧: 按批次截断:在较长的文本序列中,将其切割…...

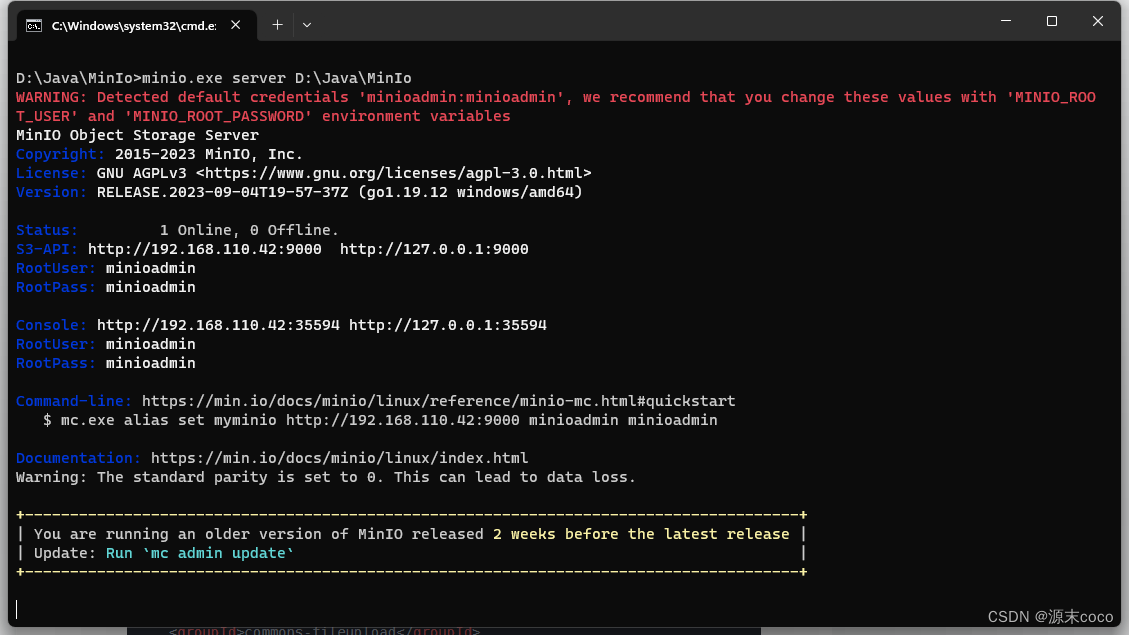

Spring Boot 集成 MinIO 实现文件上传、下载和删除

MinIO 是一种开源的对象存储服务,它基于云原生架构构建,并提供了高性能、易于扩展和安全的存储解决方案。 一.安装和配置 MinIO 服务器 为了演示方便,本文采用Windows安装 1.在官方网站下载MinIO 安装文件,地址:ht…...

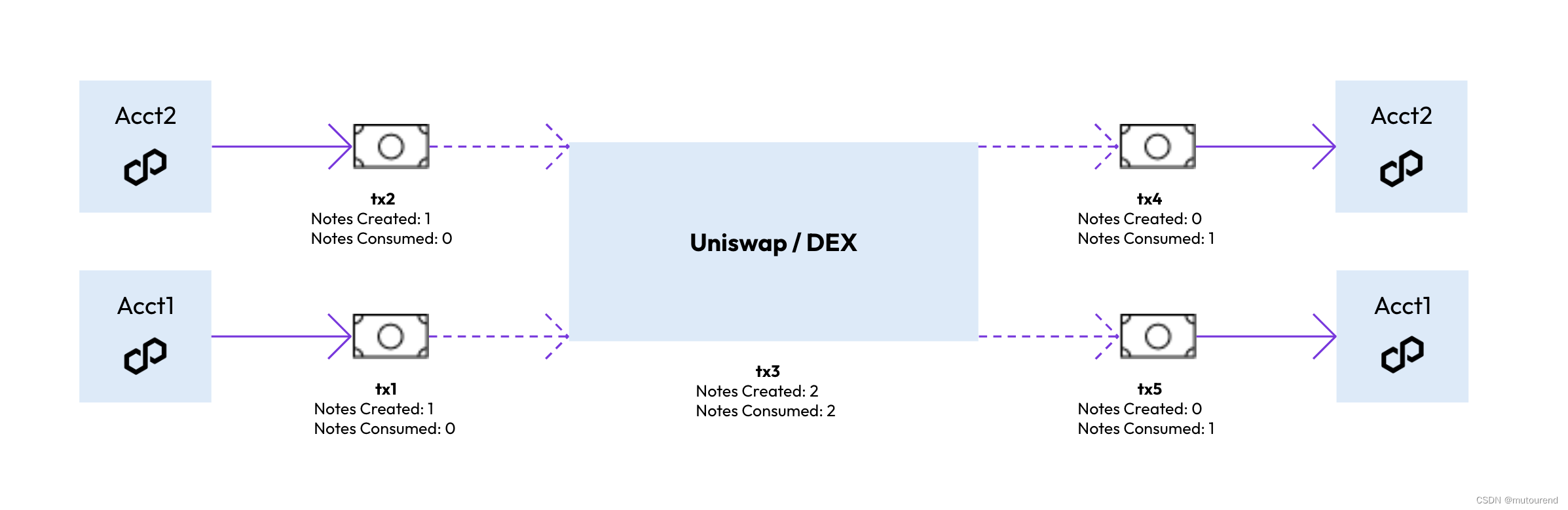

Polygon Miden交易模型:Actor模式 + ZKP => 并行 + 隐私

1. 引言 前序博客: Polygon Miden:扩展以太坊功能集的ZK-optimized rollupPolygon Miden zkRollup中的UTXO账户混合状态模型 Polygon Miden为: ZK-optimized rollup由客户端生成证明完善Polygon ZK系列解决方案,致力于成为网络…...

)

Java流的体系结构(二)

文章目录 一、对象流的使用1.概念2.序列化机制3.代码案例:序列化过程:将内存中的java对象保存到磁盘中或通过通络传输出去4.反序列化,将磁盘文件中的对象还原为内存中的一个java对象 二、RandomAccessFile的使用1.说明2.代码案例 提示&#x…...

python计算阶层

阶层(Factorial)是指从1到一个正整数n的所有整数相乘,即n! 1 2 3 … n。下面是Python代码计算阶层: def factorial(n):"""计算阶层:param n: 正整数:return: n的阶层"""if n 1 or n 0:retu…...

前端架构师之01_ES6_基础

1 初识ES6 简单来说,ECMAScript是JavaScript语言的国际标准,JavaScript是实现ECMAScript标准的脚本语言。 2011年,ECMA国际标准化组织在发布ECMAScript 5.1版本之后,就开始着手制定第6版规范。 存在的问题:这个版本…...

银行卡号识别

# 导入工具包 from imutils import contours import numpy as np import argparse import cv2 import myutils# 设置参数 # ap = argparse.ArgumentParser() # ap.add_argument("-i", "--image", required=True, # help="path to input image")…...

【Idea】idea、datagrip设置输入法

https://github.com/RikudouPatrickstar/JetBrainsRuntime-for-Linux-x64/releases/tag/jbr-release-17.0.6b829.5https://github.com/RikudouPatrickstar/JetBrainsRuntime-for-Linux-x64/releases/tag/jbr-release-17.0.6b829.5 下载后解压并重命名为 jbr, 然后替换对应 ide…...

回归预测 | MATLAB实现基于RF-Adaboost随机森林结合AdaBoost多输入单输出回归预测

回归预测 | MATLAB实现基于RF-Adaboost随机森林结合AdaBoost多输入单输出回归预测 目录 回归预测 | MATLAB实现基于RF-Adaboost随机森林结合AdaBoost多输入单输出回归预测预测效果基本介绍模型描述程序设计参考资料 预测效果 基本介绍 1.MATLAB实现基于RF-Adaboost随机森林结合…...

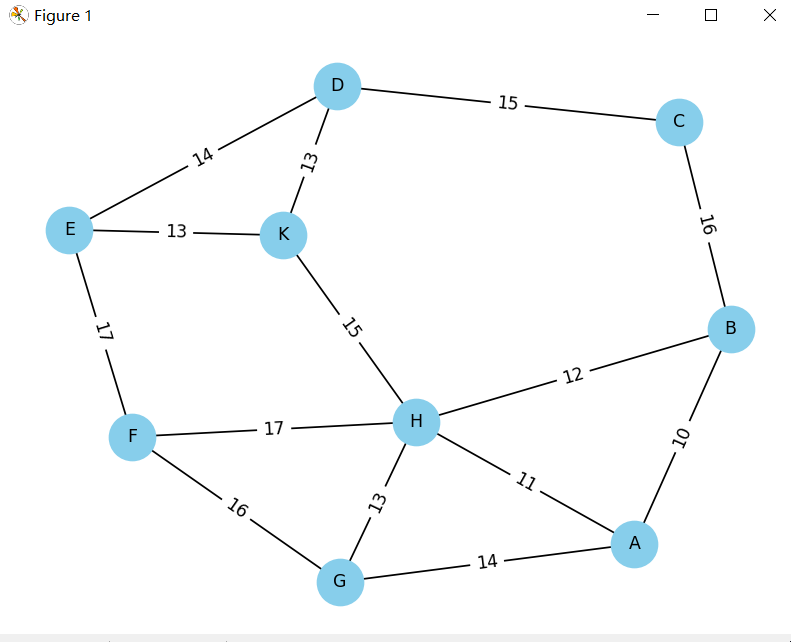

最小生成树 | 市政道路拓宽预算的优化 (Minimum Spanning Tree)

任务描述: 市政投资拓宽市区道路,本着执政为民,节省纳税人钱的目的,论证是否有必要对每一条路都施工拓宽? 这是一个连问带答的好问题。项目制学习可以上下半场,上半场头脑风暴节省投资的所有可行的思路&a…...

Java实现使用多线程,实现复制文件到另一个目录,起不一样的名字,创建100万个数据

目录 1 需求2 实现 1 需求 我现在有一个300MB 的文件,想要根据这个文件,创建100万个大小一样的,名称不一样,如何实现,如何比较快点实现 2 实现 1 先准备好这个文件 2 准备好目录 3 写代码 private static void crea…...

uni-app:canvas-图形实现1

效果 代码 <template><view><!-- 创建了一个宽度为300像素,高度为200像素的canvas元素。canvas-id属性被设置为"firstCanvas",可以用来在JavaScript中获取该canvas元素的上下文对象。 --><canvas style"width:200p…...

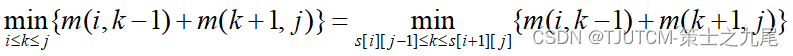

【算法分析与设计】动态规划(下)

目录 一、最长公共子序列1.1 最长公共子序列的结构1.2 子问题的递归结构1.3 计算最优值1.4 举例说明1.5 算法的改进 二、最大子段和2.1 代码2.2 最大子段和问题的分治算法2.3 代码2.4 分治算法的时间复杂度2.5 最大子段和问题的动态规划算法 三、凸多边形最优三角剖分3.1 三角剖…...

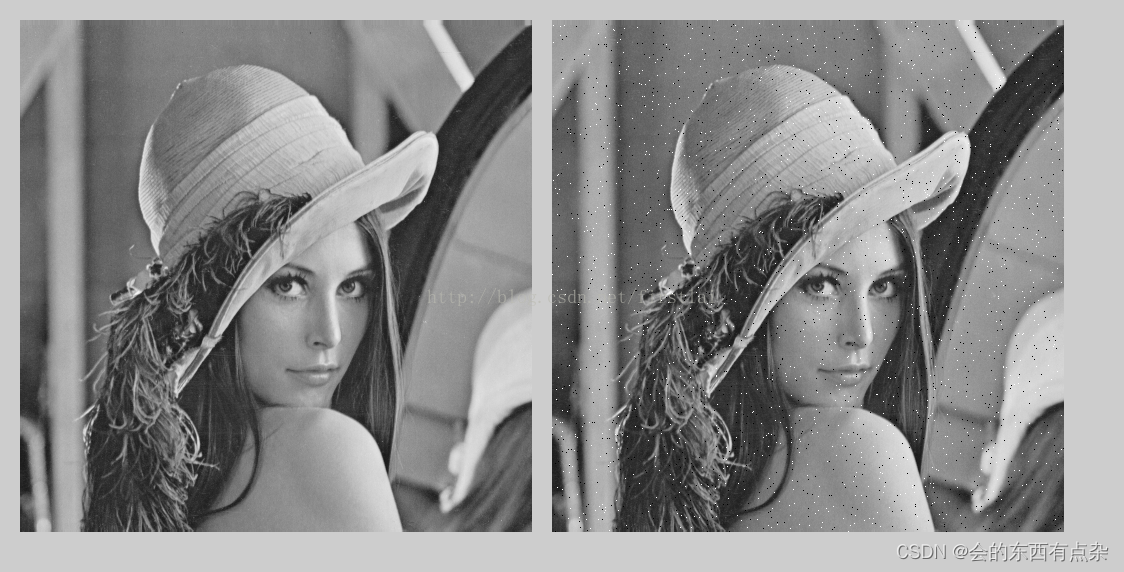

计算机图像处理-均值滤波

均值滤波 线性滤波器的原始数据与滤波结果是一种算术运算,即用加减乘除等运算实现,如均值滤波器(模板内像素灰度值的平均值)、高斯滤波器(高斯加权平均值)等。由于线性滤波器是算术运算,有固定…...

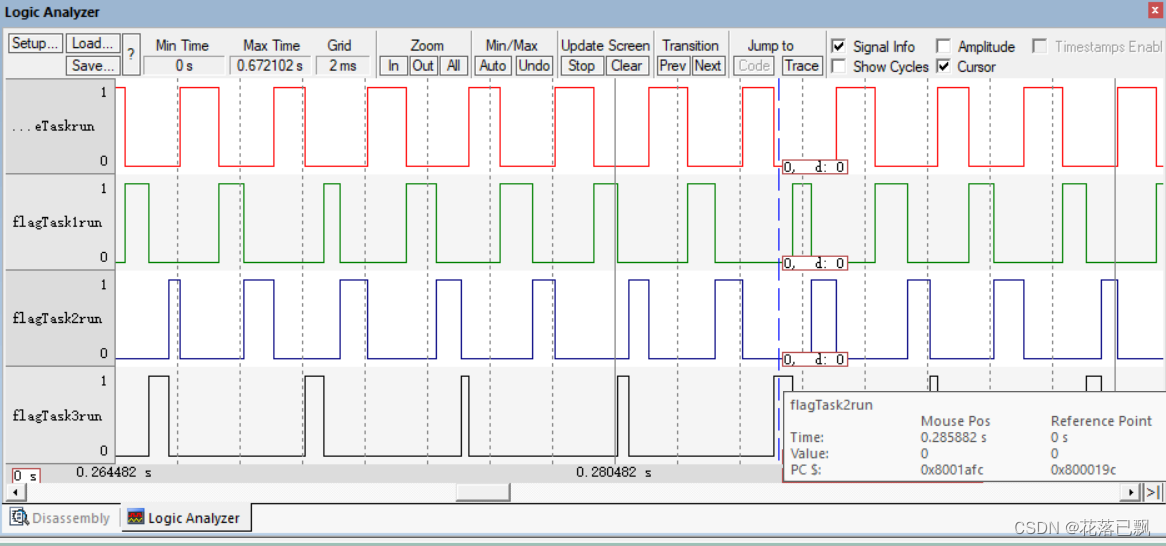

FreeRTOS入门教程(空闲任务和钩子函数及任务调度算法)

文章目录 前言一、空闲任务概念二、钩子函数概念三、任务调度算法四、任务调度算法实验1.实验代码2.是否抢占3.时间片是否轮转4.空闲任务让步 总结 前言 本篇文章将带大家学习一下什么是空闲任务以及钩子函数,以及学习FreeRTOS中的任务调度算法,了解在F…...

Javascript真的是10天内做出来的吗?

我曾听说,Javascript 之所以有这么多缺点,是因为它的第一个版本是在短短十天内完成的。我很好奇:1)这是否属实;2)这是否能解释这种语言的缺陷。 经过一番研究,我可以不自信地说:是的…...

picoctf_2018_got_shell

picoctf_2018_got_shell Arch: i386-32-little RELRO: Partial RELRO Stack: No canary found NX: NX enabled PIE: No PIE (0x8048000)32位,只开了NX int __cdecl __noreturn main(int argc, const char **argv, const char **envp) {_DWOR…...

作用域 CSS 回来了

几年前,消失的作用域 CSS,如今它回来了,而且比以前的版本要好得多。 更好的是,W3C规范基本稳定,现在Chrome中已经有一个工作原型。我们只需要社区稍微关注一下,引诱其他浏览器构建它们的实现,并…...

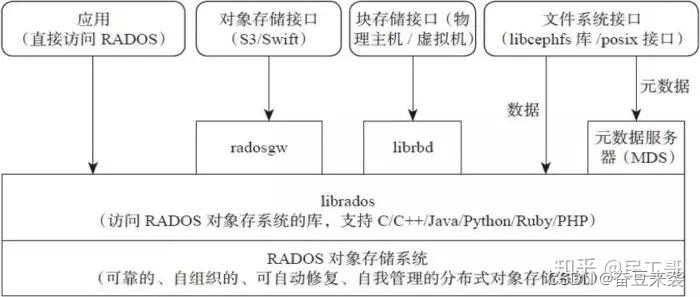

简述ceph文件储存系统

Ceph 是一个统一的分布式存储系统和共享机制,它定义了数据如何存储在一个或多个节点上并呈现给其他机器以供文件访问。 Ceph特点 高性能 a. 摒弃了传统的集中式存储元数据寻址的方案,采用CRUSH算法,数据分布均衡,并行度高。 b.考…...

计算机图像处理:椒盐噪声和高斯噪声

图像滤波 图像滤波,即在尽量保留图像细节特征的条件下对目标图像的噪声进行抑制,同时会造成图像一定程度上的模糊,这也叫做平滑或者低通滤波。无论是均衡化直方图和图像滤波,都一定程度上降低了图像阈值分割的难度,直…...

: K8s 核心概念白话解读(上):Pod 和 Deployment 究竟是什么?)

云原生核心技术 (7/12): K8s 核心概念白话解读(上):Pod 和 Deployment 究竟是什么?

大家好,欢迎来到《云原生核心技术》系列的第七篇! 在上一篇,我们成功地使用 Minikube 或 kind 在自己的电脑上搭建起了一个迷你但功能完备的 Kubernetes 集群。现在,我们就像一个拥有了一块崭新数字土地的农场主,是时…...

)

Spring Boot 实现流式响应(兼容 2.7.x)

在实际开发中,我们可能会遇到一些流式数据处理的场景,比如接收来自上游接口的 Server-Sent Events(SSE) 或 流式 JSON 内容,并将其原样中转给前端页面或客户端。这种情况下,传统的 RestTemplate 缓存机制会…...

JavaScript 中的 ES|QL:利用 Apache Arrow 工具

作者:来自 Elastic Jeffrey Rengifo 学习如何将 ES|QL 与 JavaScript 的 Apache Arrow 客户端工具一起使用。 想获得 Elastic 认证吗?了解下一期 Elasticsearch Engineer 培训的时间吧! Elasticsearch 拥有众多新功能,助你为自己…...

DAY 47

三、通道注意力 3.1 通道注意力的定义 # 新增:通道注意力模块(SE模块) class ChannelAttention(nn.Module):"""通道注意力模块(Squeeze-and-Excitation)"""def __init__(self, in_channels, reduction_rat…...

(二)原型模式

原型的功能是将一个已经存在的对象作为源目标,其余对象都是通过这个源目标创建。发挥复制的作用就是原型模式的核心思想。 一、源型模式的定义 原型模式是指第二次创建对象可以通过复制已经存在的原型对象来实现,忽略对象创建过程中的其它细节。 📌 核心特点: 避免重复初…...

使用van-uploader 的UI组件,结合vue2如何实现图片上传组件的封装

以下是基于 vant-ui(适配 Vue2 版本 )实现截图中照片上传预览、删除功能,并封装成可复用组件的完整代码,包含样式和逻辑实现,可直接在 Vue2 项目中使用: 1. 封装的图片上传组件 ImageUploader.vue <te…...

令牌桶 滑动窗口->限流 分布式信号量->限并发的原理 lua脚本分析介绍

文章目录 前言限流限制并发的实际理解限流令牌桶代码实现结果分析令牌桶lua的模拟实现原理总结: 滑动窗口代码实现结果分析lua脚本原理解析 限并发分布式信号量代码实现结果分析lua脚本实现原理 双注解去实现限流 并发结果分析: 实际业务去理解体会统一注…...

Linux-07 ubuntu 的 chrome 启动不了

文章目录 问题原因解决步骤一、卸载旧版chrome二、重新安装chorme三、启动不了,报错如下四、启动不了,解决如下 总结 问题原因 在应用中可以看到chrome,但是打不开(说明:原来的ubuntu系统出问题了,这个是备用的硬盘&a…...

听写流程自动化实践,轻量级教育辅助

随着智能教育工具的发展,越来越多的传统学习方式正在被数字化、自动化所优化。听写作为语文、英语等学科中重要的基础训练形式,也迎来了更高效的解决方案。 这是一款轻量但功能强大的听写辅助工具。它是基于本地词库与可选在线语音引擎构建,…...

【JVM面试篇】高频八股汇总——类加载和类加载器

目录 1. 讲一下类加载过程? 2. Java创建对象的过程? 3. 对象的生命周期? 4. 类加载器有哪些? 5. 双亲委派模型的作用(好处)? 6. 讲一下类的加载和双亲委派原则? 7. 双亲委派模…...