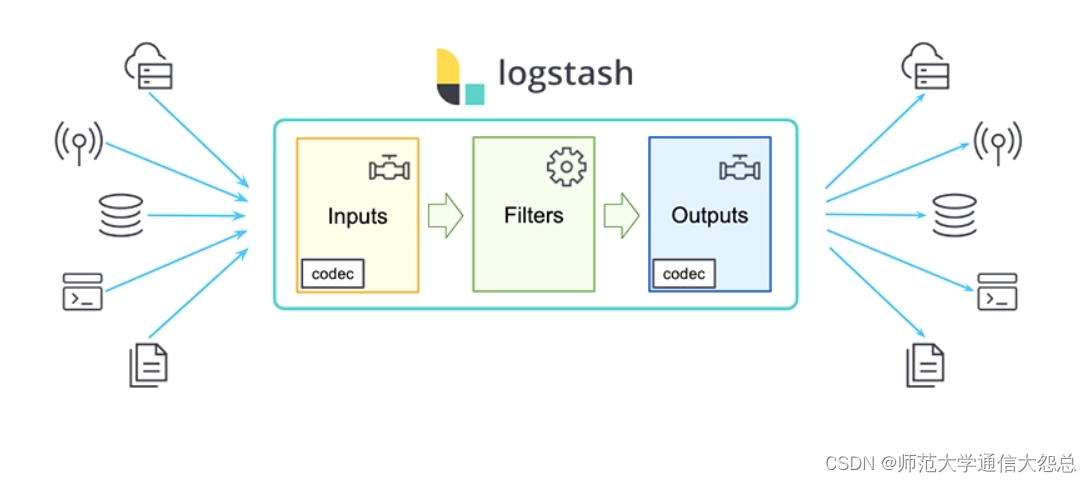

logstash插件简单介绍

logstash插件

输入插件(input)

Input:输入插件。

Input plugins | Logstash Reference [8.11] | Elastic

-

所有输入插件都支持的配置选项

| Setting | Input type | Required | Default | Description |

|---|---|---|---|---|

| add_field | hash | No | {} | 添加一个字段到一个事件 |

| codec | codec | No | plain | 用于输入数据的编解码器 |

| enable_metric | boolean | No | true | |

| id | string | No | 添加一个ID插件配置,如果没有指定ID,则Logstash将生成一个ID。强烈建议配置此ID,当两个或多个相同类型的插件时,这个非常有用的。例如,有两个文件输入,添加命名标识有助于监视 | |

| tags | array | No | 添加任意数量的标签,有助于后期处理 | |

| type | string | No | 为输入处理的所有事件添加一个字段,自已随便定义,比如linux系统日志,定义为syslog |

stdin

-

标准输入

# cat /etc/logstash/config.d/stdtest.conf

input {stdin {

}

}

filter {

}

output {stdout {}

}

file

-

从文件中读取内容

File input plugin | Logstash Reference [8.11] | Elastic

| Setting | Input type | Required | Default | Description |

|---|---|---|---|---|

| close_older | number | No | 3600 | 单位秒,打开文件多长时间关闭 |

| delimiter | string | No | \n | 每行分隔符 |

| discover_interval | number | No | 15 | 单位秒,多长时间检查一次path选项是否有新文件 |

| exclude | array | No | 排除监听的文件,跟path一样,支持通配符 | |

| max_open_files | number | No | 打开文件最大数量 | |

| path | array | YES | 输入文件的路径,可以使用通配符 例如/var/log/*/.log,则会递归搜索 | |

| sincedb_path | string | No | sincedb数据库文件的路径,用于记录被监控的日志文件当前位置 | |

| sincedb_write_interval | number | No | 15 | 单位秒,被监控日志文件当前位置写入数据库的频率 |

| start_position | string, one of ["beginning", "end"] | No | end | 指定从什么位置开始读取文件:开头或结尾。默认从结尾开始,如果要想导入旧数据,将其设置为begin。如果sincedb记录了此文件位置,那么此选项不起作用 |

| stat_interval | number | No | 1 | 单位秒,统计文件的频率,判断是否被修改。增加此值会减少系统调用次数。 |

# cat /etc/logstash/conf.d/filetest.conf

input {file {path => "/var/log/messages"}

}

filter {

}

output {stdout {}

}

TCP

-

通过TCP套接字读取事件,即接收数据。与标准输入和文件输入一样,每个事件都被定位一行文本。

# cat /etc/logstash/conf.d/tcptest.conf

input {tcp {port => 12345}

}

filter {

}

output {stdout{}

}

在其他主机上安装nc工具,对logstash发送信息,即可被读取出来。

[root@vm4 ~]# yum -y install nc

[root@vm4 ~]# nc 10.1.1.13 12345

haha

在vm3上验证查看

{"@version" => "1","@timestamp" => 2019-07-02T15:28:00.301Z,"port" => 33778,"type" => "nc","message" => "haha","host" => "vm4.cluster.com"

}

Beats

-

从Elastic Beats框架接收事件

logstash配置文件

# cat /etc/logstash/conf.d/filebeattest.conf

input {beats {port => 5044host => "0.0.0.0"}

}filter {}

output {stdout { }

}

filebeat配置文件 filebeat.prospectors:- type: logpaths:- /var/log/messagestags: ["system-log","123"]fields:level: debug output.logstash:hosts: ['127.0.0.1:5044']

过滤插件(filter)

参考: Filter plugins | Logstash Reference [8.11] | Elastic

Filter:过滤,将日志格式化。

有丰富的过滤插件:

-

Grok正则捕获

-

date时间处理

-

JSON编解码

-

数据修改Mutate

-

geoip等。

所有的过滤器插件都支持以下配置选项:

| Setting | Input type | Required | Default | Description |

|---|---|---|---|---|

| add_field | hash | No | {} | 如果过滤成功,添加任何field到这个事件。例如:add_field => [ "foo_%{somefield}", "Hello world, from %{host}" ],如果这个事件有一个字段somefiled,它的值是hello,那么我们会增加一个字段foo_hello,字段值则用%{host}代替。 |

| add_tag | array | No | [] | 过滤成功会增加一个任意的标签到事件例如:add_tag => [ "foo_%{somefield}" ] |

| enable_metric | boolean | No | true | |

| id | string | No | ||

| periodic_flush | boolean | No | false | 定期调用过滤器刷新方法 |

| remove_field | array | No | [] | 过滤成功从该事件中移除任意filed。例:remove_field => [ "foo_%{somefield}" ] |

| remove_tag | array | No | [] | 过滤成功从该事件中移除任意标签,例如:remove_tag => [ "foo_%{somefield}" ] |

json(关注)

-

JSON解析过滤器,接收一个JSON的字段,将其展开为Logstash事件中的实际数据结构。

示例: 将原信息转成一个大字段,key-value做成大字段中的小字段

# cat /etc/logstash/conf.d/jsontest.conf

input {stdin {}

}

filter {json {source => "message"target => "content"}

}

output {stdout {}

}

对标准输入的内容进行json格式输出

把输出内容定向到target指定的content

[root@vm3 bin]# ./logstash --path.settings /etc/logstash -r -f /etc/logstash/conf.d/jsontest.conf

输入测试数据

{"ip":"10.1.1.1","hostname":"vm3.cluster.com"}

输出测试数据

{"content" => {"hostname" => "vm3.cluster.com","ip" => "10.1.1.1"},"@timestamp" => 2019-07-02T11:57:36.398Z,"@version" => "1","host" => "vm3.cluster.com","message" => "{\"ip\":\"10.1.1.1\",\"hostname\":\"vm3.cluster.com\"}"

}

示例: 直接将原信息转成各个字段

# cat /etc/logstash/conf.d/jsontest.conf

input {stdin {}

}

filter {json {source => "message"}

}

output {stdout {}

}

[root@vm3 bin]# ./logstash --path.settings /etc/logstash -r -f /etc/logstash/conf.d/jsontest.conf

输入测试数据

{"ip":"10.1.1.1","hostname":"vm3.cluster.com"}

输出测试数据

{"port" => 39442,"@version" => "1","@timestamp" => 2019-09-19T09:07:03.800Z,"hostname" => "vm3.cluster.com","host" => "vm4.cluster.com","ip" => "10.1.1.1","message" => "{\"ip\":\"10.1.1.1\",\"hostname\":\"vm3.cluster.com\"}"

}

kv

-

自动解析为key=value。

-

也可以任意字符串分割数据。

-

field_split 一串字符,指定分隔符分析键值对

URL查询字符串拆分参数示例

# cat /etc/logstash/conf.d/kvtest.conf

input {stdin {}

}

filter {kv {field_split => "&?"}

}

output {stdout {

}

}

文件中的列以&或?进行分隔

执行

[root@vm3 bin]# ./logstash --path.settings /etc/logstash -r -f /etc/logstash/conf.d/kvtest.conf

输入数据

address=www.abc.com?pid=123&user=abc

输出数据

{"user" => "abc","@timestamp" => 2019-07-02T12:05:23.143Z,"host" => "vm3.cluster.com","@version" => "1","message" => "address=www.abc.com?pid=123&abc=user","address" => "www.abc.com","pid" => "123"

}

使用正则也可以匹配

[root@vm3 bin]# cat /etc/logstash/conf.d/kvtest.conf

input {stdin {}

}

filter {kv {field_split_pattern => ":+"}

}

output {stdout {

}

}

grok(关注)

-

grok是将非结构化数据解析为结构化

-

这个工具非常适于系统日志,mysql日志,其他Web服务器日志以及通常人类无法编写任何日志的格式。

-

默认情况下,Logstash附带约120个模式。也可以添加自己的模式(patterns_dir)

-

模式后面对应正则表达式

-

查看模式地址:https://github.com/logstash-plugins/logstash-patterns-core/tree/master/patterns

-

包含字段如下

| Setting | Input type | Required | Default | Description |

|---|---|---|---|---|

| break_on_match | boolean | No | true | |

| keep_empty_captures | No | false | 如果true将空保留为事件字段 | |

| match | hash | No | {} | 一个hash匹配字段=>值 |

| named_captures_only | boolean | No | true | 如果true,只存储 |

| overwrite | array | No | [] | 覆盖已存在的字段的值 |

| pattern_definitions | No | {} | ||

| patterns_dir | array | No | [] | 自定义模式 |

| patterns_files_glob | string | No | * | Glob模式,用于匹配patterns_dir指定目录中的模式文件 |

| tag_on_failure | array | No | _grokparsefailure | tags没有匹配成功时,将值附加到字段 |

| tag_on_timeout | string | No | _groktimeout | 如果Grok正则表达式超时,则应用标记 |

| timeout_millis | number | 30000 | 正则表达式超时时间 |

grok模式语法

格式:%{SYNTAX:SEMANTIC}

-

SYNTAX 模式名称

-

SEMANTIC 匹配文本的标识符

例如:%{NUMBER:duration} %{IP:client}

# vim /etc/logstash/conf.d/groktest.conf

input {stdin {}

}

filter {grok {match => {"message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}"}}

}

output {stdout {

}

}

虚构http请求日志抽出有用的字段

55.3.244.1 GET /index.html 15824 0.043

输出结果

{"client" => "55.3.244.1","duration" => "0.043","message" => "55.3.244.1 GET /index.html 15824 0.043","method" => "GET","bytes" => "15824","@version" => "1","@timestamp" => 2019-07-03T12:24:47.596Z,"host" => "vm3.cluster.com","request" => "/index.html"

}

自定义模式

如果默认模式中没有匹配的,可以自己写正则表达式。

# vim /opt/patterns

ID [0-9]{3,5}

配置文件中应包含如下内容

filter {grok {patterns_dir =>"/opt/patterns"match => {"message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration} %{ID:id}" }}

}

完整文件内容

[root@vm3 ~]# cat /etc/logstash/conf.d/groktest.conf

input {stdin {}

}

filter {grok {patterns_dir =>"/opt/patterns"match => {"message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration} %{ID:id}"}}

}

output {stdout {}

}

#执行

[root@vm3 bin]# ./logstash --path.settings /etc/logstash -r -f /etc/logstash/conf.d/groktest.conf

输入测试数据

55.3.244.1 GET /index.html 15824 0.043 6666

输出测试数据

{"client" => "55.3.244.1","host" => "vm3.cluster.com","request" => "/index.html","@timestamp" => 2019-07-02T12:34:11.906Z,"bytes" => "15824","method" => "GET","message" => "55.3.244.1 GET /index.html 15824 0.043 15BF7F3ABB","@version" => "1","id" => "666","duration" => "0.043"

}

geoip(关注)

-

开源IP地址库

-

GeoLite2 Free Geolocation Data | MaxMind Developer Portal

下载IP地址库 [root@vm3 ~]# wget https://geolite.maxmind.com/download/geoip/database/GeoLite2-City.tar.gz [root@vm3 ~]# tar xf GeoLite2-City.tar.gz [root@vm3 ~]# cp GeoLite2-City_20190625/GeoLite2-City.mmdb /opt

# cat /etc/logstash/conf.d/geoiptest.conf

input {stdin {}

}

filter {grok {match => {"message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}"}}geoip {source => "client"database => "/opt/GeoLite2-City.mmdb"}

}

output {stdout {

}

}

执行

[root@vm3 bin]# ./logstash --path.settings /etc/logstash -r -f /etc/logstash/conf.d/geoiptest.conf

输入测试数据

202.106.0.20 GET /index.html 123 0.331

输出结果

{"method" => "GET","client" => "202.106.0.20","bytes" => "123","request" => "/index.html","geoip" => {"country_code2" => "CN","country_name" => "China","region_code" => "BJ","longitude" => 116.3883,"latitude" => 39.9289,"timezone" => "Asia/Shanghai","location" => {"lon" => 116.3883,"lat" => 39.9289},"country_code3" => "CN","ip" => "202.106.0.20","continent_code" => "AS","region_name" => "Beijing"},"duration" => "0.331","host" => "vm3.cluster.com","message" => "202.106.0.20 GET /index.html 123 0.331","@timestamp" => 2019-07-02T12:15:29.384Z,"@version" => "1"

}

[root@vm3 bin]# cat /etc/logstash/conf.d/geoiptest2.conf

input {stdin {}

}

filter {grok {match => {"message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}"

}}geoip {source => "client"database => "/opt/GeoLite2-City.mmdb"target => "geoip"fields => ["city_name", "country_code2", "country_name","region_name"]}

}

output {stdout {codec => rubydebug}

}

执行

[root@vm3 bin]# ./logstash --path.settings /etc/logstash -r -f /etc/logstash/conf.d/geoiptest2.conf

输入测试数据

110.226.4.6 GET /home.html 518 0.247

输出结果

{"host" => "vm3.cluster.com","duration" => "0.247","request" => "/home.html","@version" => "1","client" => "110.226.4.6","message" => "110.226.4.6 GET /home.html 518 0.247","method" => "GET","bytes" => "518","@timestamp" => 2019-07-02T12:22:22.458Z,"geoip" => {"country_name" => "India","country_code2" => "IN"}

}

输出插件(output)

Output:输出,输出目标可以是Stdout、ES、Redis、File、TCP等。

ES

| Setting | Input type | Required | Default | Description |

|---|---|---|---|---|

| hosts | URL | No | ||

| index | string | No | logstash-%{+YYYY.MM.dd} | 将事件写入索引。默认按日期划分。 |

| user | string | No | ES集群用户 | |

| password | password | No | ES集群密码 |

input {file {path => ["/var/log/messages"]type => "system"tags => ["syslog","test"]start_position => "beginning"}file {path => ["/var/log/audit/audit.log"]type => "system"tags => ["auth","test"]start_position => "beginning"}

}

filter {

}

output {if [type] == "system" {if [tags][0] == "syslog" {elasticsearch {hosts => ["http://es1:9200","http://es2:9200","http://es3:9200"]index => "logstash-system-syslog-%{+YYYY.MM.dd}"}stdout { codec=> rubydebug }}else if [tags][0] == "auth" {elasticsearch {hosts => ["http://es1:9200","http://es2:9200","http://es3:9200"]index => "logstash-system-auth-%{+YYYY.MM.dd}"}stdout { codec=> rubydebug }}}

}

相关文章:

logstash插件简单介绍

logstash插件 输入插件(input) Input:输入插件。 Input plugins | Logstash Reference [8.11] | Elastic 所有输入插件都支持的配置选项 SettingInput typeRequiredDefaultDescriptionadd_fieldhashNo{}添加一个字段到一个事件codeccodecNoplain用于输入数据的…...

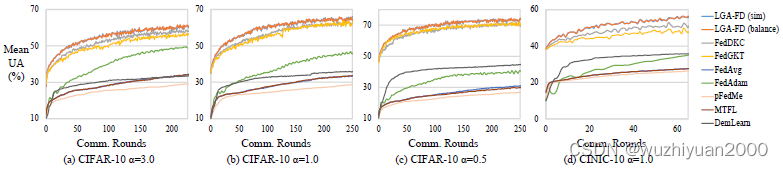

联邦多任务蒸馏助力多接入边缘计算下的个性化服务 | TPDS 2023

联邦多任务蒸馏助力多接入边缘计算下的个性化服务 | TPDS 2023 随着移动智能设备的普及和人工智能技术的发展,越来越多的分布式数据在终端被产生与收集,并以多接入边缘计算(MEC)的形式进行处理和分析。但是由于用户的行为模式与服务需求的多样,不同设备上的数据分布…...

【python爬虫】设计自己的爬虫 3. 文件数据保存封装

考虑到爬取的多媒体文件要保存到本地,因此封装了一个类来专门处理这样的问题,下面看代码: class FileStore:def __init__(self, file_path, read_file_moder,write_file_modewb):"""初始化 FileStore 实例Parameters:- file_…...

pta模拟题——7-34 刮刮彩票

“刮刮彩票”是一款网络游戏里面的一个小游戏。如图所示: 每次游戏玩家会拿到一张彩票,上面会有 9 个数字,分别为数字 1 到数字 9,数字各不重复,并以 33 的“九宫格”形式排布在彩票上。 在游戏开始时能看见一个位置上…...

【补题】 1

蓝桥杯小白赛 3.小蓝的金牌梦【算法赛】 - 蓝桥云课 (lanqiao.cn) 数组长度为质数,最大的子数组和 素数 前缀和 #include "bits/stdc.h" using namespace std; #define int long long #define N 100010 int ans[N];int s[N];vector&l…...

IP地址定位技术为网络安全建设提供全新方案

随着互联网的普及和数字化进程的加速,网络安全问题日益引人关注。网络攻击、数据泄露、欺诈行为等安全威胁层出不穷,对个人隐私、企业机密和社会稳定构成严重威胁。在这样的背景下,IP地址定位技术应运而生,为网络安全建设提供了一…...

Redis中HyperLogLog的使用

目录 前言 HyperLogLog 前言 在学习HyperLogLog之前,我们需要先学习两个概念 UV:全称Unique Visitor,也叫独立访客量,是指通过互联网访问、浏览这个网页的自然人。1天内同一个用户多次访问该网站,只记录1次。PV&am…...

新版Spring Security6.2架构 (一)

Spring Security 新版springboot 3.2已经集成Spring Security 6.2,和以前会有一些变化,本文主要针对官网的文档进行一些个人翻译和个人理解,不对地方请指正。 整体架构 Spring Security的Servlet 支持是基于Servelet过滤器,如下…...

名字的漂亮度

给出一个字符串,该字符串仅由小写字母组成,定义这个字符串的“漂亮度”是其所有字母“漂亮度”的总和。 每个字母都有一个“漂亮度”,范围在1到26之间。没有任何两个不同字母拥有相同的“漂亮度”。字母忽略大小写。给出多个字符串࿰…...

机器学习基本概念2

资料来源: https://www.youtube.com/watch?vYe018rCVvOo&listPLJV_el3uVTsMhtt7_Y6sgTHGHp1Vb2P2J&index1 https://www.youtube.com/watch?vbHcJCp2Fyxs&listPLJV_el3uVTsMhtt7_Y6sgTHGHp1Vb2P2J&index2 分三步 1、 定义function b和w是需要透…...

—— Spring Cloud Alibaba 之 Nacos 2.3.0 史上最大更新版本发布)

Spring Cloud 与微服务学习总结(19)—— Spring Cloud Alibaba 之 Nacos 2.3.0 史上最大更新版本发布

Nacos 一个用于构建云原生应用的动态服务发现、配置管理和服务管理平台,由阿里巴巴开源,致力于发现、配置和管理微服务。说白了,Nacos 就是充当微服务中的的注册中心和配置中心。 Nacos 2.3.0 新特性 1. 反脆弱插件 Nacos 2.2.0 版本开始加入反脆弱插件,从 2.3.0 版本开…...

八、C#笔记

/// <summary> /// 第十三章:创建接口和定义抽象类 /// </summary> namespace Chapter13 { class Program { static void Main(string[] args) { //13.1理解接口 ///13.1.1定义接口 ///…...

利用Node.js和cpolar实现远程访问,无需公网IP和路由器设置的完美解决方案

文章目录 前言1.安装Node.js环境2.创建node.js服务3. 访问node.js 服务4.内网穿透4.1 安装配置cpolar内网穿透4.2 创建隧道映射本地端口 5.固定公网地址 前言 Node.js 是能够在服务器端运行 JavaScript 的开放源代码、跨平台运行环境。Node.js 由 OpenJS Foundation࿰…...

C++如何通过调用ffmpeg接口对H264文件进行编码和解码

C可以通过调用FFmpeg的API来对H264文件进行编码和解码。下面是一个简单的例子。 首先需要在代码中包含FFmpeg的头文件: extern "C" { #include <libavcodec/avcodec.h> #include <libavformat/avformat.h> #include <libswscale/swscale…...

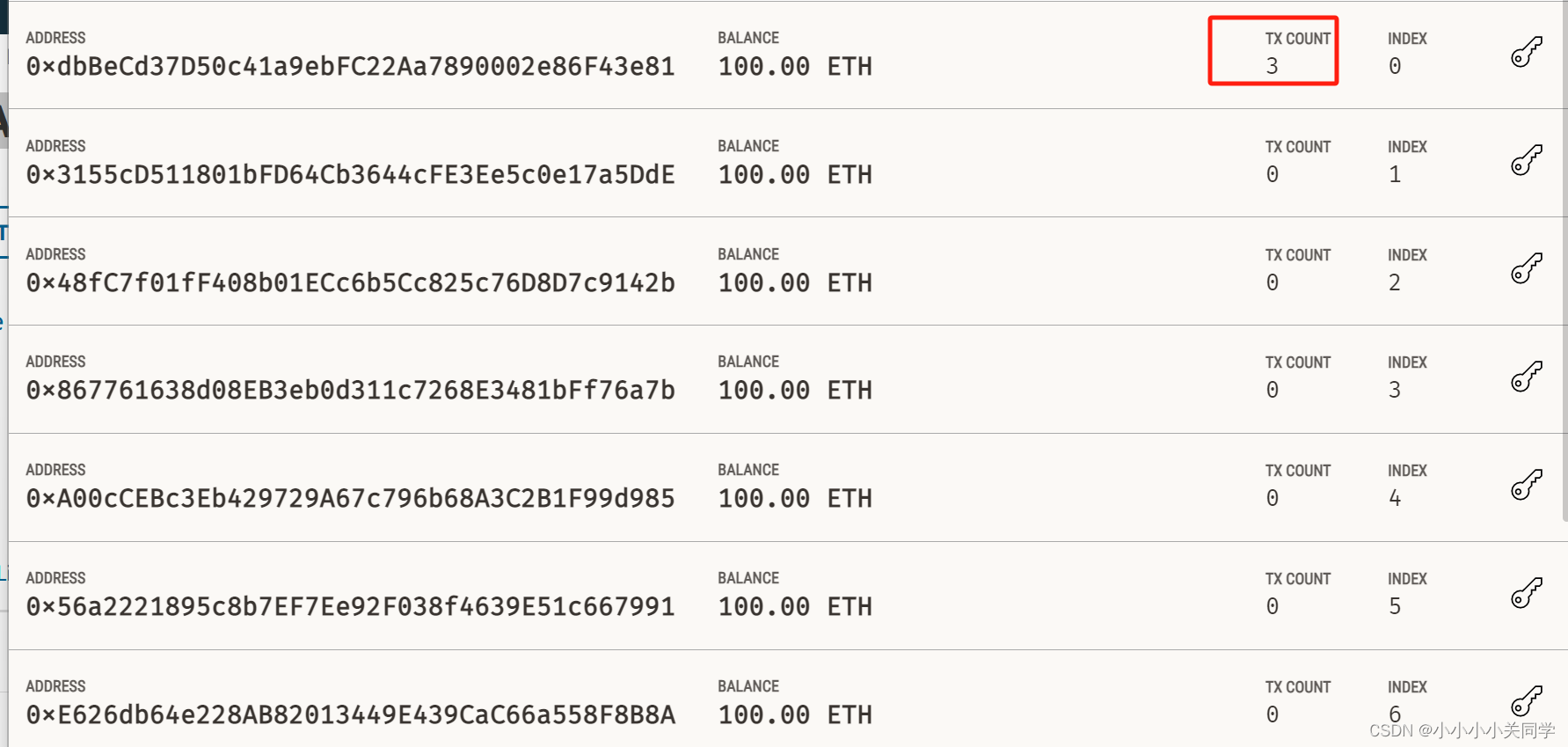

使用MetaMask + Ganache搭建本地私有网络并实现合约部署与互动

我使用Remix编写合约,MetaMask钱包工具和Ganache搭建了一个私有网络,并且实现了合约的部署和互动。 在前面的博客中提到了 Remix在线环境及钱包申请 以及 Solidity的基本语法 ,没看过的小伙伴可以点击链接查看一下,都是在本专栏下…...

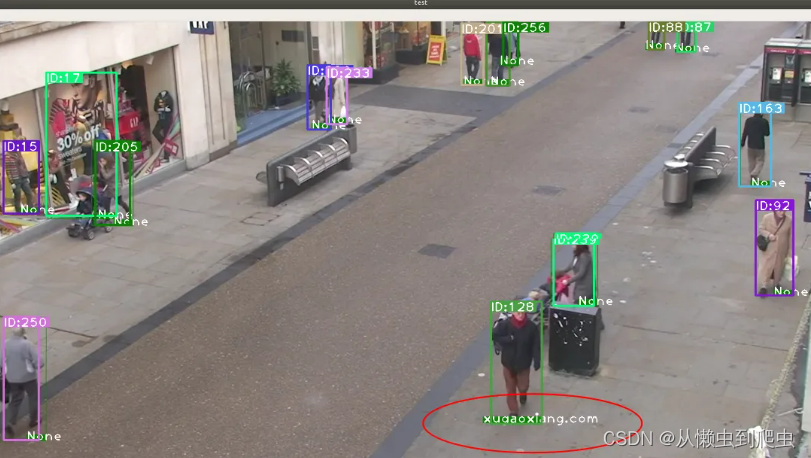

目标检测、目标跟踪、重识别

文章目录 环境前言项目复现特征提取工程下载参考资料 环境 ubuntu 18.04 64位yolov5deepsortfastreid 前言 基于YOLOv5和DeepSort的目标跟踪 介绍过针对行人的检测与跟踪。本文介绍另一个项目,结合 FastReid 来实现行人的检测、跟踪和重识别。作者给出的2个主…...

高防IP防御效果怎么样,和VPN有区别吗

高防IP主要是用于防御网络攻击,可以抵御各种类型的DDoS攻击,隐藏源IP地址,提高网络安全性和用户体验。主要目的是解决外部网络攻击问题,保护网络安全,避免因攻击而导致的业务中断和数据泄露等问题。 而VPN则是一种可以…...

探秘MSSQL存储过程:功能、用法及实战案例

在现代软件开发中,高效地操作数据库是至关重要的。而MSSQL(Microsoft SQL Server)作为一款强大的关系型数据库管理系统,为我们提供了丰富的功能和工具来处理数据。其中,MSSQL存储过程是一项强大而又常用的功能…...

我们常说的流应用到底是什么?

流应用是DCloud公司开发的一种可以让手机App安装包实现边用边下的技术。基于HTML5规范的即点即用应用,开发者按照HTML5规范开发的应用,可以在支持HTML5流应用的发行渠道实现即点即用的效果。 流应用是基于 HTML5规范的即点即用应用,开发者按照…...

ELK 日志解决方案

ELK 是目前最流行的集中式日志解决方案,提供了对日志收集、存储、展示等一站式的解决方案。 ELK 分别指 Elasticsearch、Logstash、Kibana。 Elasticsearch:分布式数据搜索引擎,基于 Apache Lucene 实现,可集群,提供…...

idea大量爆红问题解决

问题描述 在学习和工作中,idea是程序员不可缺少的一个工具,但是突然在有些时候就会出现大量爆红的问题,发现无法跳转,无论是关机重启或者是替换root都无法解决 就是如上所展示的问题,但是程序依然可以启动。 问题解决…...

C++初阶-list的底层

目录 1.std::list实现的所有代码 2.list的简单介绍 2.1实现list的类 2.2_list_iterator的实现 2.2.1_list_iterator实现的原因和好处 2.2.2_list_iterator实现 2.3_list_node的实现 2.3.1. 避免递归的模板依赖 2.3.2. 内存布局一致性 2.3.3. 类型安全的替代方案 2.3.…...

大话软工笔记—需求分析概述

需求分析,就是要对需求调研收集到的资料信息逐个地进行拆分、研究,从大量的不确定“需求”中确定出哪些需求最终要转换为确定的“功能需求”。 需求分析的作用非常重要,后续设计的依据主要来自于需求分析的成果,包括: 项目的目的…...

java调用dll出现unsatisfiedLinkError以及JNA和JNI的区别

UnsatisfiedLinkError 在对接硬件设备中,我们会遇到使用 java 调用 dll文件 的情况,此时大概率出现UnsatisfiedLinkError链接错误,原因可能有如下几种 类名错误包名错误方法名参数错误使用 JNI 协议调用,结果 dll 未实现 JNI 协…...

Linux相关概念和易错知识点(42)(TCP的连接管理、可靠性、面临复杂网络的处理)

目录 1.TCP的连接管理机制(1)三次握手①握手过程②对握手过程的理解 (2)四次挥手(3)握手和挥手的触发(4)状态切换①挥手过程中状态的切换②握手过程中状态的切换 2.TCP的可靠性&…...

为什么需要建设工程项目管理?工程项目管理有哪些亮点功能?

在建筑行业,项目管理的重要性不言而喻。随着工程规模的扩大、技术复杂度的提升,传统的管理模式已经难以满足现代工程的需求。过去,许多企业依赖手工记录、口头沟通和分散的信息管理,导致效率低下、成本失控、风险频发。例如&#…...

JDK 17 新特性

#JDK 17 新特性 /**************** 文本块 *****************/ python/scala中早就支持,不稀奇 String json “”" { “name”: “Java”, “version”: 17 } “”"; /**************** Switch 语句 -> 表达式 *****************/ 挺好的ÿ…...

优选算法第十二讲:队列 + 宽搜 优先级队列

优选算法第十二讲:队列 宽搜 && 优先级队列 1.N叉树的层序遍历2.二叉树的锯齿型层序遍历3.二叉树最大宽度4.在每个树行中找最大值5.优先级队列 -- 最后一块石头的重量6.数据流中的第K大元素7.前K个高频单词8.数据流的中位数 1.N叉树的层序遍历 2.二叉树的锯…...

GC1808高性能24位立体声音频ADC芯片解析

1. 芯片概述 GC1808是一款24位立体声音频模数转换器(ADC),支持8kHz~96kHz采样率,集成Δ-Σ调制器、数字抗混叠滤波器和高通滤波器,适用于高保真音频采集场景。 2. 核心特性 高精度:24位分辨率,…...

如何在网页里填写 PDF 表格?

有时候,你可能希望用户能在你的网站上填写 PDF 表单。然而,这件事并不简单,因为 PDF 并不是一种原生的网页格式。虽然浏览器可以显示 PDF 文件,但原生并不支持编辑或填写它们。更糟的是,如果你想收集表单数据ÿ…...