spark:RDD编程(Python版)

RDD运行原理

RDD设计背景

许多选代目前的MapReduce框架都是把中间结果写入到稳定存储 (比如磁盘)中带来了大量的数据复制、磁盘IO和序列化开销

RDD就是为了满足这种需求而出现的,它提供了一个抽象的数据架构,我们不必担心底层数据的分布式特性,只需将具体的应用逻辑表达为一系列转换处理,不同RDD之间的转换操作形成依赖关系,可以实现管道化,避免中间数据存储。

RDD概念

-

一个RDD就是一个分布式对象集合,本质上是一个只读的分区记录集合,每个RDD可分成多个分区,每个分区就是一个数据集片段,并且一个RDD的不同分区可以被保存到集群中不同的节点上,从而可以在集群中的不同节点上进行并行计算

-

RDD提供了一种高度受限的共享内存模型,即RDD是只读的记录分区的集合,不能直接修改,只能基于稳定的物理存储中的数据集创建RDD,或者通过在其他RDD上执行确定的转换操作(如map、join和group by) 而创建得到新的RDD

-

RDD提供了一组丰富的操作以支持常见的数据运算,分为“动作”(Action)和“转换” (Transformation)两种类型

-

RDD提供的转换接口都非常简单,都是类似map、filter、groupBy、join等粗粒度的数据转换操作,而不是针对某个数据项的细粒度修改(不适合网页爬虫)

-

表面上RDD的功能很受限、不够强大,实际上RDD已经被实践证明可以高效地表达许多框架的编程模型(比如MapReduce、SQL、Pregel)

-

Spark提供了RDD的API,程序员可以通过调用API实现对RDD的各种操作

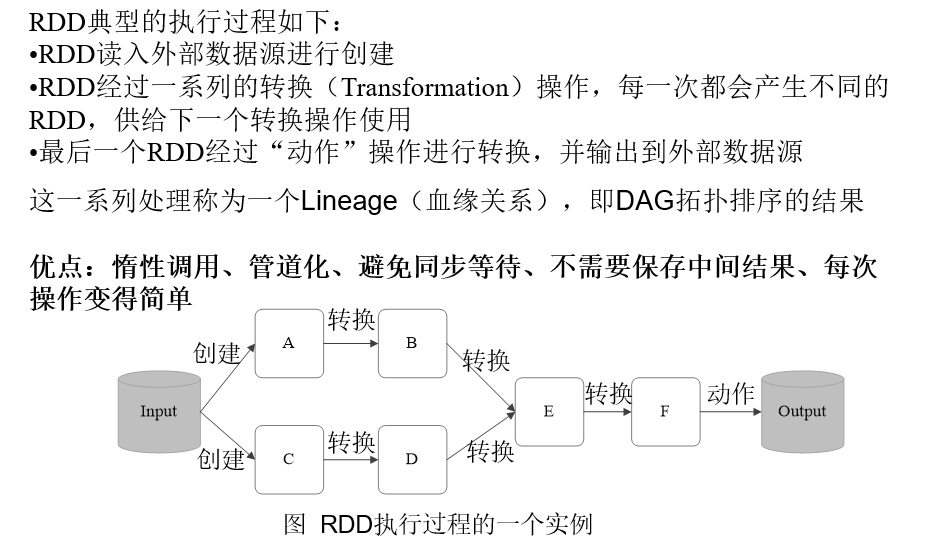

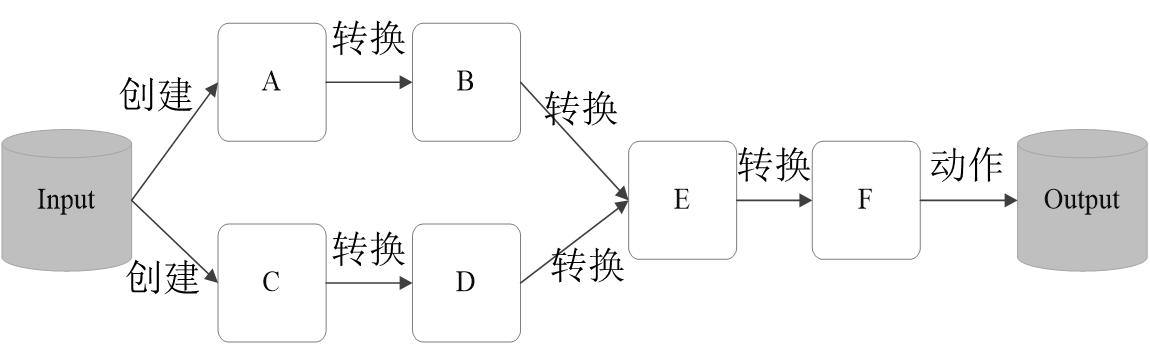

RDD运行过程

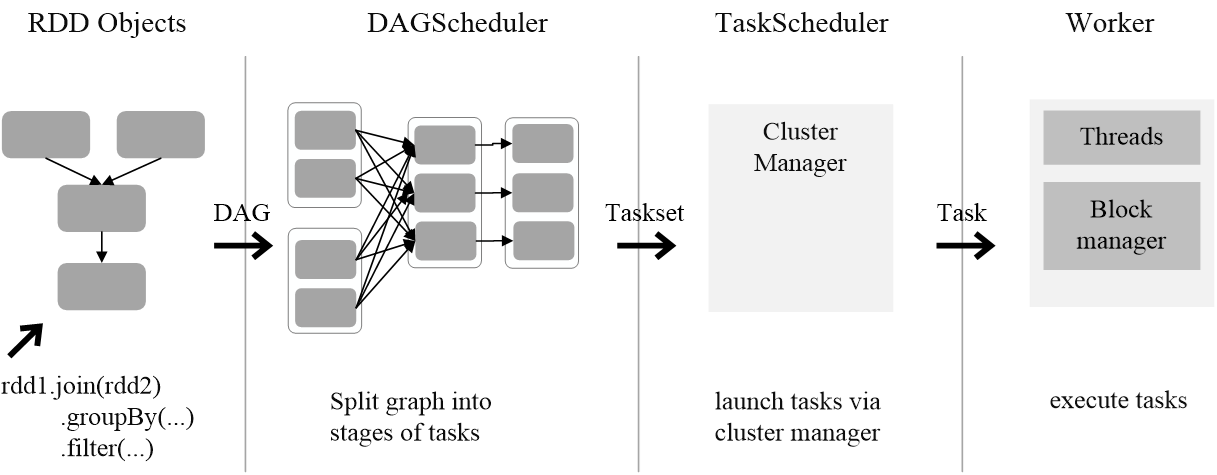

通过上述对RDD概念、依赖关系和Stage划分的介绍,结合之前介绍的Spark运行基本流程,再总结一下RDD在Spark架构中的运行过程:

(1)创建RDD对象;

(2)SparkContext负责计算RDD之间的依赖关系,构建DAG;

(3)DAGScheduler负责把DAG图分解成多个Stage,每个Stage中包含了多个Task,每个Task会被TaskScheduler分发给各个WorkerNode上的Executor去执行。

RDD编程基础

1. RDD创建

- 从文件系统中加载数据创建RDD

>>> lines = sc.textFile("file:///opt/spark/mycode/rdd/word.txt")

>>> lines.foreach(print)

Hadoop is good

Spark is fast

Spark is better

- 从分布式文件系统HDFS中加载数据

>>>lines = sc.textFile("hdfs://localhost:9000/user/hadoop/word.txt")

>>>lines = sc.textFile("/user/hadoop/word.txt")

>>>lines = sc.textFile("word.txt")

三条语句等价

- 通过并行集合(列表)创建RDD

可以调用SparkContext的parallelize方法,在Driver中一个已经存在的集合(列表)上创建。

>>>array = [1, 2, 3, 4, 5]

>>>rdd = sc.parallelize(array)

>>>rdd.foreach(print)

1

2

3

4

5

2. RDD操作

1. 转换操作

对于RDD而言,每一次转换操作都会产生不同的RDD,供给下一个“转换”使用。

转换得到的RDD是惰性求值的,也就是说,整个转换过程只是记录了转换的轨迹,并不会发生真正的计算,只有遇到行动操作时,才会发生真正的计算,开始从血缘关系源头开始,进行物理的转换操作。

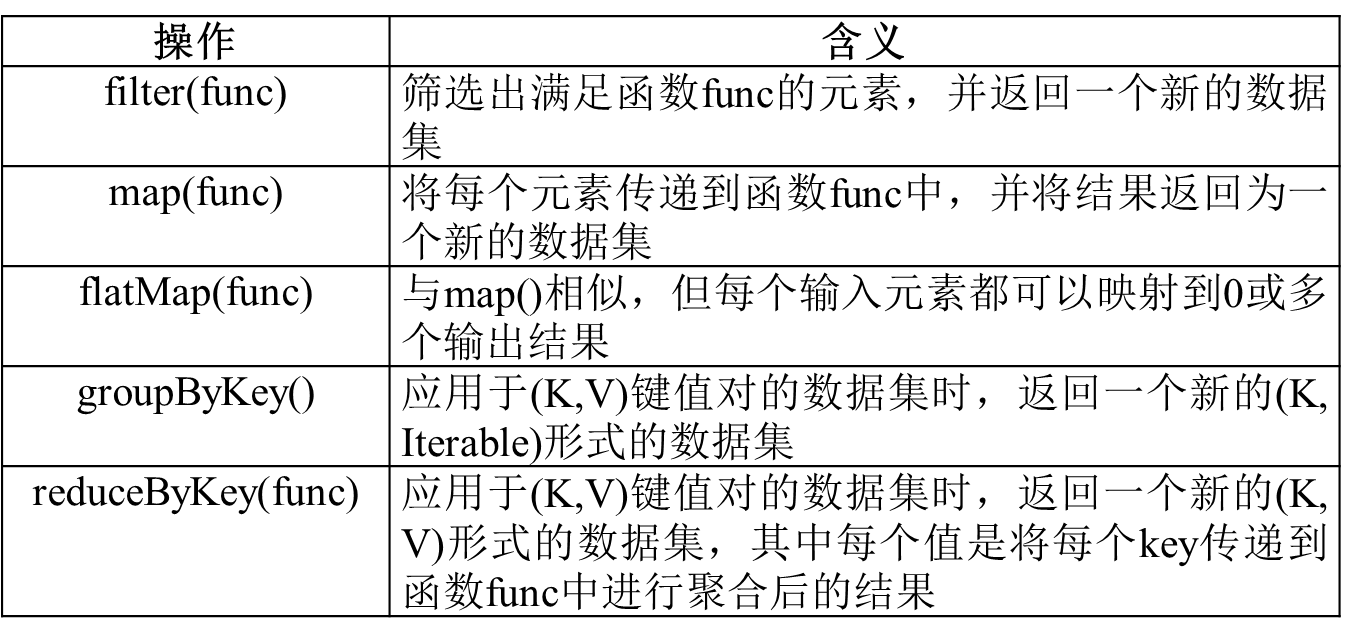

常用的RDD转换操作API:

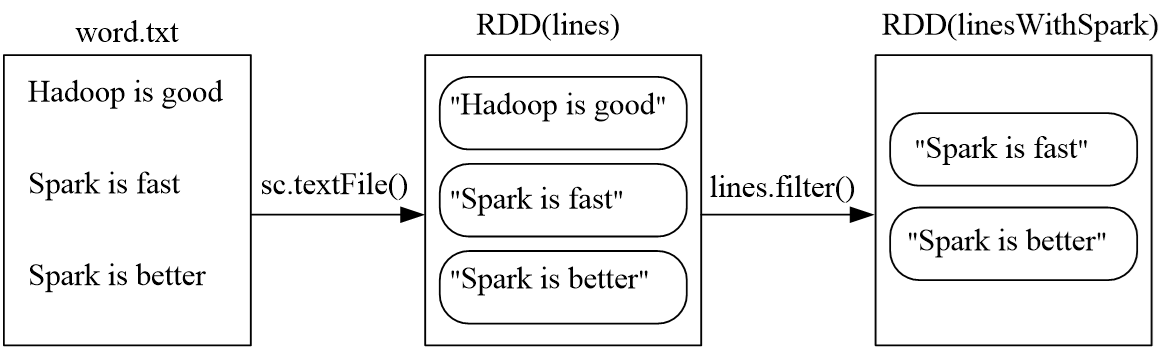

· filter(func):筛选出满足函数func的元素,并返回一个新的数据集

>>>lines = sc.textFile("file:///opt/spark/mycode/rdd/word.txt")

>>>linesWithSpark = lines.filter(lambda line: "Spark" in line)

>>>linesWithSpark.foreach(print)

Spark is better

Spark is fast

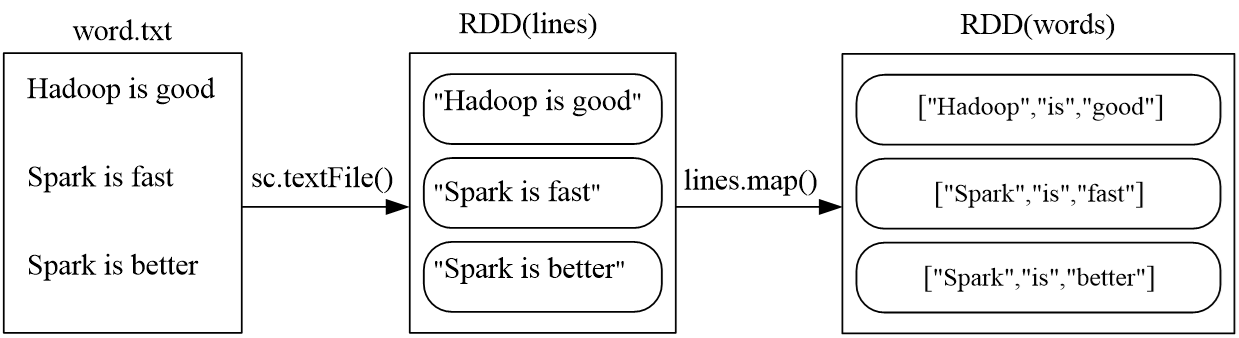

· map(func):将每个元素传递到函数func中,并将结果返回为一个新的RDD

>>>data = [1, 2, 3, 4, 5]

>>>rdd1 = sc.parallelize(data)

>>>rdd2 = rdd1.map(lambda x:x+10)

>>>rdd2.foreach(print)

11

13

12

14

15

>>>lines = sc.textFile("file:///opt/spark/mycode/rdd/word.txt")

>>>words = lines.map(lambda line:line.split(" "))

>>>words.foreach(print)

['Hadoop', 'is', 'good']

['Spark', 'is', 'fast']

['Spark', 'is', 'better']

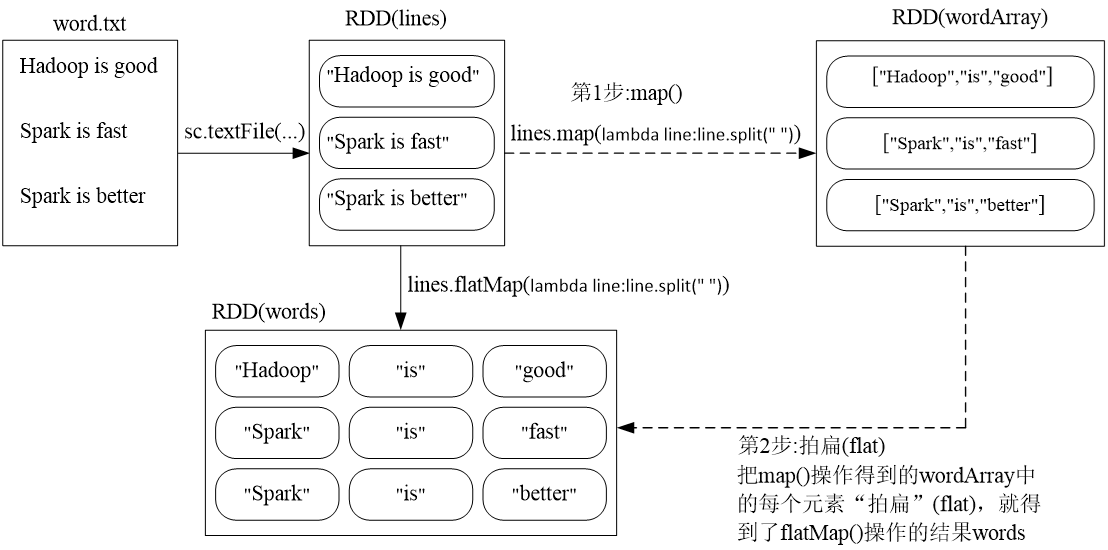

· flatMap(func):

>>>lines =sc.textFile("file:///opt/spark/mycode/rdd/word.txt")

>>>words = lines.flatMap(lambda line:line.split(" "))

>>>words.foreach(print)

Hadoop

is

good

Spark

is

fast

Spark

is

better

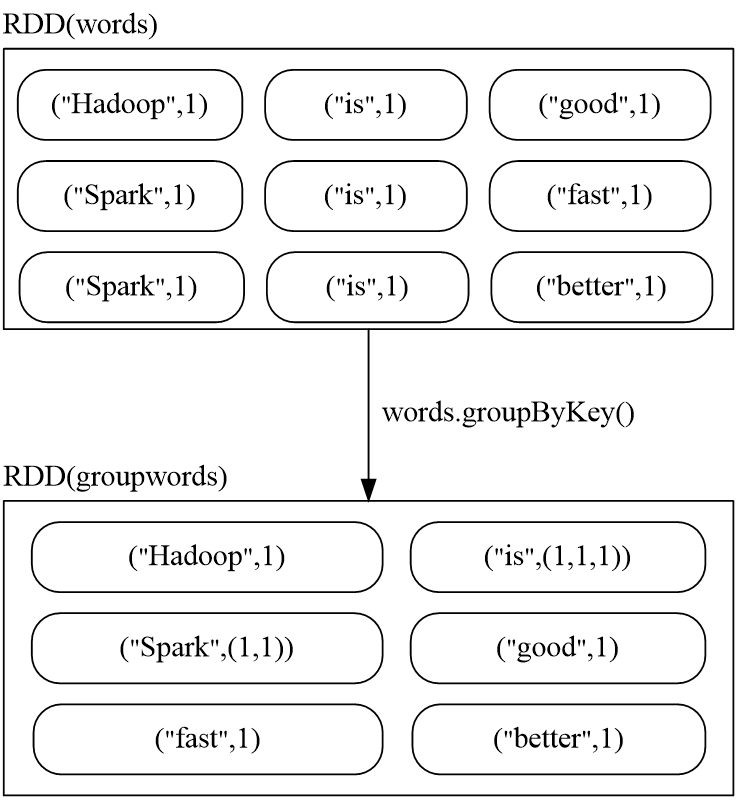

· groupByKey():应用于(K, V)键值对数据集时,返回一个新的(k, Iterable)形式的数据集

>>>words = sc.parallelize([("Hadoop",1), ("is",1), ("good", 1), ("Spark",1),\

...("is",1), ("fast",1), ("Spark",1), ("is",1), ("better",1)])

>>>words1 = words.groupByKey()

>>>words1.foreach(print)

('Hadoop', <pyspark.resultiterable.Resultlterable object at 0x7fb210552c88>)

('better', <pyspark.resultiterable.Resultlterable object at 0x7fb210552e80>)

('fast', <pyspark.resultiterable.Resultlterable object at 0x7fb210552c88>)

('good', <pyspark.resultiterable.Resultlterable object at 0x7fb210552c88>)

('Spark', <pysparkresultiterable.Resultlterable object at 0x7fb210552f98>)

('is', <pyspark.resultiterable.Resultlterable object at 0x7fb210552e10>)

· reduceByKey(func) 应用于(K, V)键值对的数据集时,返回一个新的(K, V)形式的数据集,其中的每个值是将每个Key传递到函数func中进行聚合后得到的结果

>>>words = sc.parallelize([("Hadoop",1),("is",1),("good",1),("Spark",1),\

...("is",1),("fast",1),("Spark",1),("is",1),("better",1)])

>>>words1 = words.reduceByKey(lambda a,b:a+b)

>>>words1.foreach(print)

('good', 1)

('Hadoop', 1)

('better', 1)

('Spark', 2)

('fast', 1)

('is', 3)

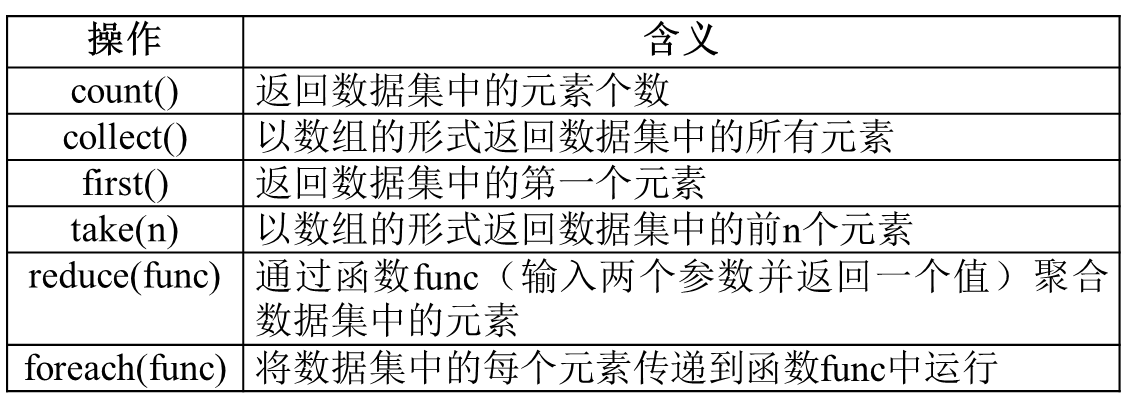

2. 行动操作

行动操作是真正触发计算的地方。Spark程序执行到行动操作时,才会执行真正的计算,从文件中加载数据,完成一次又-次转换操作,最终,完成行动操作得到结果。

常用的RDD行动操作API:

>>>rdd = sc.parallelize([1,2,3,4,5])

>>>rdd.count()

5

>>>rdd.first()

1

>>>rdd.take(3)

[1, 2, 3]

>>>rdd.reduce(lambda a,b:a+b)

15

>>>rdd.collect()

[1, 2, 3, 4, 5]

>>>rdd.foreach(lambda elem:print(elem))

1

2

3

4

5

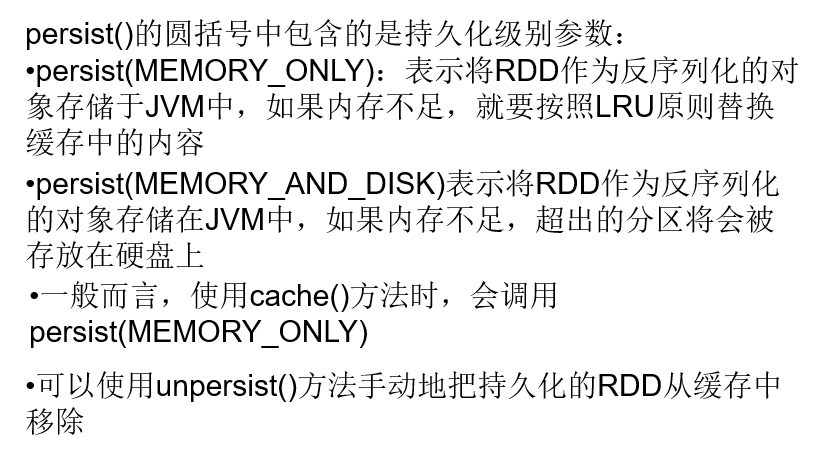

3. 持久化

惰性机制:所谓的“惰性机制”是指,整个转换过程只是记录了转换的轨迹,并不会发生真正的计算,只有遇到行动操作时,才会触发“从头到尾”的真正的计算这里给出一段简单的语句来解释Spark的惰性机制

在Spark中,RDD采用惰性求值的机制,每次遇到行动操作,都会从头开始执行计算。每次调用行动操作,都会触发一次从头开始的计算。这对于迭代计算而言,代价是很大的,迭代计算经常需要多次重复使用同一组数据

下面就是多次计算同一个RDD的例子:

>>>list = ["Hadoop","Spark","Hive"]

>>>rdd = sc.parallelize(list)

>>>print(rdd.count()) //行动操作,触发一次真正从头到尾的计算

>>>print(','.join(rdd.collect())) //行动操作,触发一次真正从头到尾的计算

可以通过持久化(缓存)机制避免这种重复计算的开销

可以使用persist0)方法对一个RDD标记为持久化

之所以说“标记为持久化”,是因为出现persist)语句的地方,并不会马上计算生成RDD并把它持久化,而是要等到遇到第一个行动操作触发真正计算以后,才会把计算结果进行持久化

持久化后的RDD将会被保留在计算节点的内存中被后面的行动操作重复使用

针对上面的实例,增加持久化语句以后的执行过程如下:

>>>list =["Hadoop", "Spark", "Hive"]

>>>rdd = sc.parallelize(list)

>>>rdd.cache()#会调用persist(MEMORY ONLY),但是,语句执行到这里并不会缓存rdd,因为这时rdd还没有被计算生成

>>>print(rdd.count()) #第一次行动操作,触发一次真正从头到尾的计算,这时上面的rdd.cache()才会被执行,把这个rdd放到缓存中

3

>>> print(','.join(rdd.collect()))#第二次行动操作,不需要触发从头到尾的计算,只需要重复使用上面缓存中的rdd

Hadoop,Spark,Hive

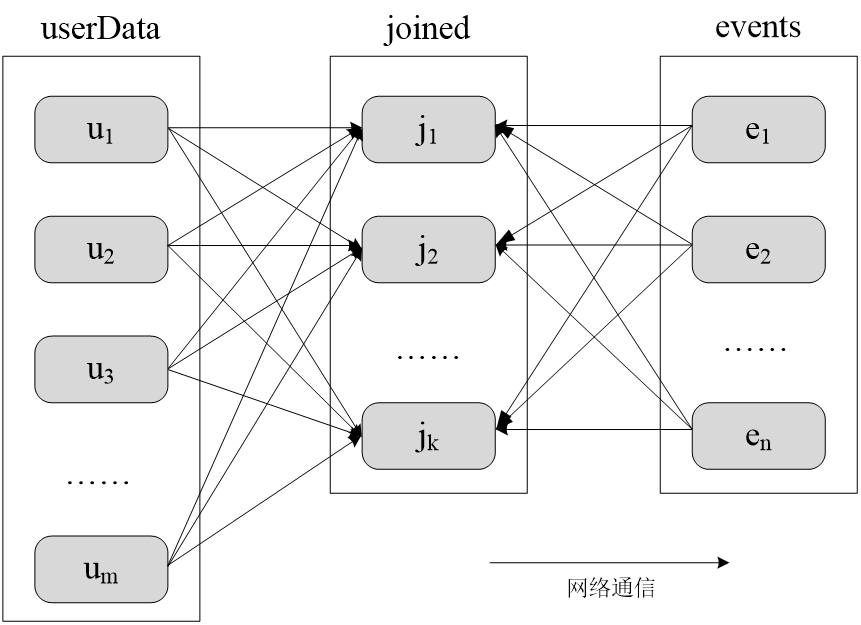

4. 分区

RDD是弹性分布式数据集,通常RDD很大,会被分成很多个分区,分别保存在不同的节点上

- 分区的作用

(1) 增加并行度

(2) 减少通讯开销

有两个表:

UserData (Userld,Userlnfo)

Events (UserlD,LinkInfo)

UserData 和 Events 表进行连接操作,获得(UserlD,Userlnfo,Linklnfo)

未分区时对UserData和Events两个表进行连接操作:

采用分区后对UserData和Events两个表进行连接操作:

- RDD分区原则

RDD分区的一个原则是使得分区的个数尽量等于集群中的CPU核心(core)数目

对于不同的Spark部署模式而言 (本地模式、Standalone模式、YARN模式、Mesos模式),都可以通过设置spark.default.parallelism这个参数的值,来配置默认的分区数目,一般而言:

(1)本地模式:默认为本地机器的CPU数目,若设置了local[N],则默认为N

(2)Apache Mesos:默认的分区数为8

(3)Standalone或YARN:在 “集群中所有CPU核心数目总和” 和 “2” 二者中取较大值作为默认值

- 设置分区的个数

(1) 创建RDD时手动指定分区个数

在调用textFile0和parallelize0方法的时候手动指定分区个数即可,语法格式如下:

sc.textFile(path,partitionNum)

>>>list =[1,2,3,4,5]

>>>rdd =sc.parallelize(list,2) #设置两个分区

(2) 使用reparititon方法重新设置分区个数

通过转换操作得到新 RDD 时,直接调用 repartition 方法即可。例如:

>>>data = sc.parallelize([1,2,3,4,5], 2)

>>>len(data.glom().collect()) #显示data这个RDD的分区数量

2

>>>data.glom().collect() #显示分区为2的情况

[[1, 2], [3, 4, 5]]

>>>rdd = data.repartition(1) #对data这个RDD进行重新分区

>>>len(rdd.glom().collect()) #显示rdd这个RDD的分区数量

1

>>>rdd.glom().collect()

[[1, 2, 3, 4, 5]] #显示分区为1的情况

- 自定义分区方法

Spark提供了自带的HashPartitioner(哈希分区)与RangePartitioner(区域分区),能够满足大多数应用场景的需求。与此同时,Spark也支持自定义分区方式,即通过提供一个自定义的分区函数来控制RDD的分区方式,从而利用领域知识进一步减少通信开销

>>>data = sc.parallelize(range(10), 5)

>>>data.glom().collect()

>>>[[0, 1], [2, 3], [4, 5], [6, 7], [8, 9]]>>>rdd = data.map(lambda x:(x,1)).partitionBy(10,lambda x:0).map(lambda x:x[0])

>>>rdd.glom().collect() # 分到第一区

[[0, 1, 2, 3, 4, 5, 6, 7, 8, 9], [], [], [], [], [], [], [], [], []]>>>rdd = data.map(lambda x:(x,1)).partitionBy(10,lambda x:2).map(lambda x:x[0])

>>>rdd.glom().collect() # 分到第三区

[[], [], [0, 1, 2, 3, 4, 5, 6, 7, 8, 9], [], [], [], [], [], [], []]>>>rdd = data.map(lambda x:(x,1)).partitionBy(10,lambda x:x).map(lambda x:x[0])

>>>rdd.glom().collect() # 分到各自的key区

>>>[[0], [1], [2], [3], [4], [5], [6], [7], [8], [9]]>>>rdd = data.map(lambda x:(x,1)).partitionBy(10,lambda x:(x+1)%10).map(lambda x:x[0])

>>>rdd.glom().collect() # 分到各自的(key+1)区(环式,舍去%效果一样)

>>>[[9], [0], [1], [2], [3], [4], [5], [6], [7], [8]]

3. 键值对RDD

1. 键值对RDD的创建

(1)第一种创建方式:从文件中加载

可以采用多种方式创建RDD,其中一种主要方式是使用 map() 函数来实现

>>>lines = sc.textFile("file:///opt/spark/mycode/pairrdd/word.txt")

>>>pairRDD = lines.flatMap(lambda line:line.split(" ")).map(lambda word:(word, 1))

>>>pairRDD.foreach(print)

('I', 1)

('love', 1)

('Hadoop', 1)

(2) 第二种创建方式:通过并行集合(列表)创建RDD

>>>list =["Hadoop", "Spark", "Hive", "Spark"]

>>>rdd = sc.parallelize(list)

>>>pairRDD =rdd.map(lambda word:(word,1))

>>>pairRDD.foreach(print)

('Hadoop', 1)

('Spark', 1)

('Hive', 1)

('Spark', 1)

2. 常用的键值对RDD转换操作

- reduceByKey(func)

- groupByKey()

- keys

- values

- sortByKey()

- mapValues(func)

- join

- combineByKey

· reduceByKey(func):使用func函数合并具有相同键的值

>>>pairRDD = sc.parallelize([("Hadoop",1),("Spark",1),("Hive",1),("Spark",1)])

>>>pairRDD.reduceByKey(lambda a,b:a+b).foreach(print)

('Spark', 2)

('Hive', 1)

('Hadoop', 1)

· groupByKey():对具有相同键的值进行分组

比如,对四个键值对(“spark”,1)、(“spark”,2)、(“hadoop”,3)和(“hadoop”,5)采用groupByKey()后得到的结果是: (“spark”,(1,2)) 和 (“hadoop”,(3,5))

>>>list =[("spark",1),("spark",2),("hadoop",3),("hadoop",5)]

>>>pairRDD = sc.parallelize(list)

>>>pairRDD.groupByKey()

PythonRDD[251] at RDD at PythonRDD.scala:53

>>>pairRDD.groupByKey().foreach(print)

('hadoop', <pyspark.resultiterable.Resultlterable object at0x7f2c1093ecf8>)

('spark',<pyspark.resultiterable.Resultlterable object at 0x7f2c1093ecf8>)

reduceByKey(func) 和 groupByKey

reduceByKey 用于对每个 key 对应的多个 value 进行 merge 操作,最重要的是它能够在本地先进行merge操作,并且merge操作可以通过函数自定义

groupByKey 也是对每个 key 进行操作,但只生成一个 sequence,groupByKey 本身不能自定义函数,需要先用groupByKey生成 RDD,然后才能对此 RDD 通过map进行自定义函数操作

>>>words =["one","two","two","three","three","three"]

>>>wordPairsRDD = sc.parallelize(words).map(lambda word:(word,1))

>>>wordCountsWithReduce = wordPairsRDD.reduceByKey(lambda a,b:a+b)

>>>wordCountsWithReduce.foreach(print)

('one', 1)

('two', 2)

('three', 3)

>>>wordCountsWithGroup = wordPairsRDD.groupByKey().map(lambda t:(t[0],sum(t[1])))

>>>wordCountsWithGroup.foreach(print)

('two', 2)

('three', 3)

('one', 1)

上面得到的 wordCountsWithReduce 和 wordCountsWithGroup 是完全一样的,但是,它们的内部运算过程是不同的

· keys:把Pair RDD中 key 返回形成一个新的RDD

>>>list = [("Hadoop",1),("Spark",1),("Hive",1),("Spark",1)]

>>>pairRDD = sc.parallelize(list)

>>>pairRDD.keys().foreach(print)

Hadoop

Spark

Hive

Spark

· valuse:把Pair RDD中 value 返回形成一个新的RDD

>>>list = [("Hadoop",1),("Spark",1),("Hive",1),("Spark",1)]

>>>pairRDD = sc.parallelize(list)

>>>pairRDD.valuse().foreach(print)

1

1

1

1

· sortByKey():返回一个根据键排序的RDD

>>>list = [("Hadoop",1),("Spark",1),("Hive",1),("Spark",1)]

>>>pairRDD = sc.parallelize(list)

>>>pairRDD.foreach(print)

('Hadoop', 1)

('Spark', 1)

('Hive', 1)

('Spark', 1)

>>>pairRDD.sortByKey().foreach(print)

('Hadoop', 1)

('Hive', 1)

('Spark', 1)

('Spark', 1)

sortByKey() 和 sortBy(func)

使用sortByKey():

>>>d1 = sc.parallelize([("c",8),("b",25),("c",17),("a",42),\

...("b",4),("d",9),("e",17),("c",2),("f",29),("g",21),("b",9)])

>>>d1.reduceByKey(lambda a,b:a+b).sortByKey(False).collect()

[('g', 21), ('f', 29), ('e', 17), ('d', 9), ('c', 27), ('b', 38), ('a', 42)]

使用sortBy(func):

>>>d1 = sc.parallelize([("c",8),("b",25),("c",17),("a",42),\

...("b",4),("d",9),("e",17),("c",2),("f",29),("g",21),("b",9)])

>>>d1.reduceByKey(lambda a,b:a+b).sortBy(lambda x:x,False).collect()

[('g', 21), ('f', 29), ('e', 17), ('d', 9), ('c', 27), ('b', 38), ('a', 42)]

>>>d1.reduceByKey(lambda a,b:a+b).sortBy(lambda x:x[0],False).collect()

[('g', 21), ('f', 29), ('e', 17), ('d', 9), ('c', 27), ('b', 38), ('a', 42)]

>>>d1.reduceByKey(lambda a,b:a+b).sortBy(lambda x:x[1],False).collect()

[('a', 42), ('b', 38), ('f', 29), ('c', 27), ('g', 21), ('e', 17), ('d', 9)]

· mapValues(func):对键值对RDD中的每个value都应用一个函数,但是,key不会发生变化

>>>list =[("Hadoop",1),("Spark",1),("Hive",1),("Spark",1)]

>>>pairRDD = sc.parallelize(list)

>>>pairRDD1 = pairRDD.mapValues(lambda x:x+1)

>>>pairRDD1.foreach(print)

('Hadoop', 2)

('Spark', 2)

('Hive', 2)

('Spark', 2)

mapValues(func) 和 map(func)

使用mapValues(func):

>>>rdd = sc.parallelize([("spark",2),("hadoop",6),("hadoop",4),("spark",6)])

>>>rdd.mapValues(lambda x:(x,1)).\

...reduceByKey(lambda x,y:(x[0]+y[0],x[1]+y[1])).\

...mapValues(lambda x:x[0]/x[1]).collect()

[('hadoop', 5.0), ('spark', 4.0)]

使用map(func):

>>>rdd = sc.parallelize([("spark",2),("hadoop",6),("hadoop",4),("spark",6)])

>>>rdd.map(lambda x:(x[0], (x[1],1))).\

...reduceByKey(lambda x,y:(x[0]+y[0],x[1]+y[1])).\

...map(lambda x:(x[0], (x[1][0]/x[1][1]))).collect()

[('hadoop', 5.0), ('spark', 4.0)]

· join:join就表示内连接。对于内连接,对于给定的两个输入数据集(K,V1)和(K,V2),只有在两个数据集中都存在的key才会被输出,最终得到一个(K,(V1,V2))类型的数据集。

>>>pairRDD1=sc.parallelize([("spark",1),("spark",2),("hadoop",3),("hadoop",5)])

>>>pairRDD2 =sc.parallelize([("spark","fast")])

>>>pairRDD3 = pairRDD1.join(pairRDD2)

>>>pairRDD3.foreach(print)

('spark', (1, 'fast'))

('spark', (2, 'fast'))

相关文章:

spark:RDD编程(Python版)

RDD运行原理 RDD设计背景 许多选代目前的MapReduce框架都是把中间结果写入到稳定存储 (比如磁盘)中带来了大量的数据复制、磁盘IO和序列化开销 RDD就是为了满足这种需求而出现的,它提供了一个抽象的数据架构,我们不必担心底层数据的分布式特性…...

中国元宇宙论坛暨常孝元宇宙发布会即将在京举行

中国元宇宙论坛暨常孝元宇宙发布会将于2024年1月9日在北京科技会堂盛大开启。本次论坛汇聚业内顶尖专家、学者和企业代表,共同探讨中国元宇宙、常孝元宇宙《神由都城》的未来发展、技术创新和应用场景。此次发布会将颠覆我们对数字世界的认知,带来前所未有的体验。 《神由都城》…...

华为认证 | 云计算方向HCIE有效期多久?实验报名费多少?

云计算技术已经成为了企业和个人发展的重要网络技术支撑。 而在这个领域中,华为HCIE云计算证书也成为了越来越多人追求的敲门砖。 然而,很多人对于这个证书的有效期以及实验报名费并不清楚。 下面将为你详细解答这些问题。 01 云计算方向HCIE有效期多…...

动物分类识别教程+分类释义+界面展示

1.项目简介 动物分类教程分类释义界面展示 动物分类是生物学中的一个基础知识,它是对动物进行分类、命名和描述的科学方法。本教程将向您介绍动物分类的基本原则和方法,并提供一些常见的动物分类释义。 动物分类的基本原则 动物分类根据动物的形态、…...

【Java动态代理如何实现】

✅Java动态代理如何实现 ✅JDK动态代理和Cglib动态代理的区别 ✅拓展知识仓✅静态代理和动态代理的区别✅动态代理的用途✅Spring AOP的实现方式📑JDK 动态代理的代码段📑Cglib动态代理的代码块 ✅注意事项: 在Java中,实现动态代理…...

)

数据库(部分函数)

函数: 单行函数:会对查询中的每一数据进行处理 字符函数 length(列名) select name, 日期函数: now() 年月日时分秒 curdate() 年月日 curtime()时分秒 …...

基于Vite+Vue3 给项目引入Axios

基于ViteVue3 给项目引入Axios,方便与后端进行通信。 系列文章指路👉 系列文章-基于Vue3创建前端项目并引入、配置常用的库和工具类 文章目录 安装依赖新建src/config/config.js 用于存放常用配置进行简单封装解决跨域问题调用尝试 安装依赖 npm install axios …...

为什么查企业的时候有的公司没有显示注册资金?

我们在查询企业信息时,有时候会遇到某一家企业没有注册资金的情况,但是该企业又不是已经注销的。出现这种情况是什么原因呢? 1.该公司是一家分公司,分公司没有独立法人资格,因此没有注册资金。 2.有些情况下…...

DataProcess-VOC数据图像和标签一起进行Resize

VOC数据图像和标签一起进行Resize 参加检测比赛的时候,很多时候工业原始数据尺度都比较大,如果对数据不提前进行处理,会导致数据在加载进内存时花费大量的时间,所以在执行训练程序之前需要将图像提前进行预处理。对于目标检测的数…...

MultiValueMap

MultiValueMap是Spring框架中提供的一个接口,它继承了Map接口,用于存储键值对,但与普通的Map不同的是,MultiValueMap中一个键可以对应多个值,因此它也可以被称为“多值Map”。 MultiValueMap的使用场景一般是在需要存…...

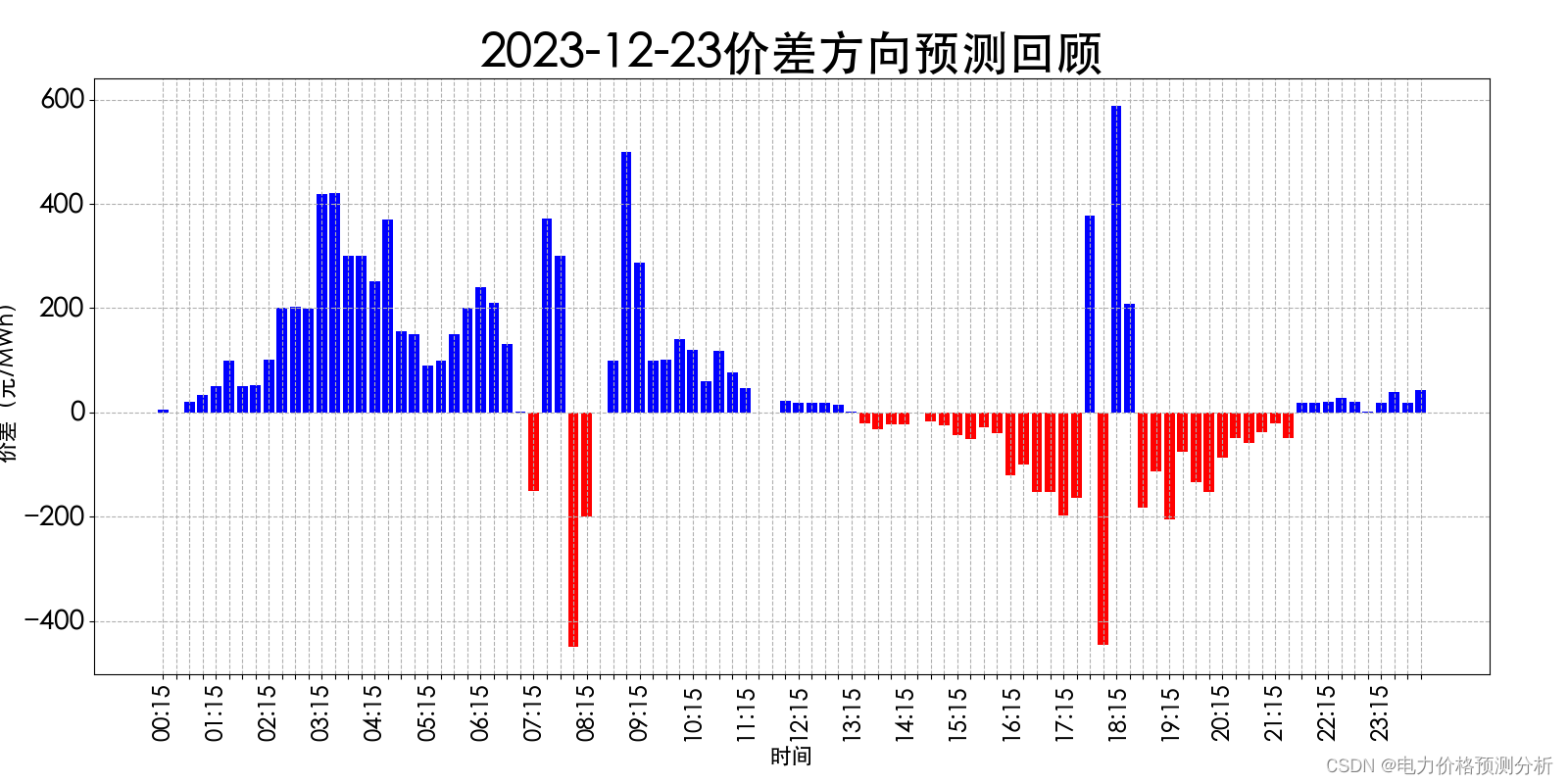

山西电力市场日前价格预测【2023-12-25】

日前价格预测 预测说明: 如上图所示,预测明日(2023-12-25)山西电力市场全天平均日前电价为469.89元/MWh。其中,最高日前电价为1048.40元/MWh,预计出现在08:30。最低日前电价为252.77元/MWh,预计…...

【华为OD机试真题2023CD卷 JAVAJS】5G网络建设

华为OD2023(C&D卷)机试题库全覆盖,刷题指南点这里 5G网络建设 时间限制:4s 空间限制:256MB 限定语言:不限 题目描述: 现需要在某城市进行5G网络建设,已经选取N个地点设置5G基站,编号固定为1到N,接下来需要各个基站之间使用光纤进行连接以确保基站能互联互通,不同…...

OSI 七层参考模型及TCP/IP 四层模型

OSI 七层参考模型 七层模型,亦称 OSI ( Open System Interconnection )参考模型,即开放式系统互联。参考模型是国际标准化组织(ISO )制定的一个用于计算机或通信系统间互联的标准体系,一般称为…...

【面向对象】对比JavaScript、Go、Ada、Python、C++、Java、PHP的访问限制。

在不同编程语言中,控制成员(变量、方法、类等)可见性的机制不尽相同。以下是对比JavaScript、Go、Ada、Python、C、Java、PHP所使用的访问限制关键字和约定: 一、JavaScript ### JavaScript访问限制 早期的JavaScript并没有类似…...

第26题删除有序数组中的重复项(Python))

力扣(leetcode)第26题删除有序数组中的重复项(Python)

26.删除有序数组的重复项 题目链接:26.删除有序数组的重复项 给你一个非严格递增排列 的数组 nums ,请你 原地 删除重复出现的元素,使每个元素 只出现一次 ,返回删除后数组的新长度。元素的 相对顺序 应该保持 一致 。然后返回 …...

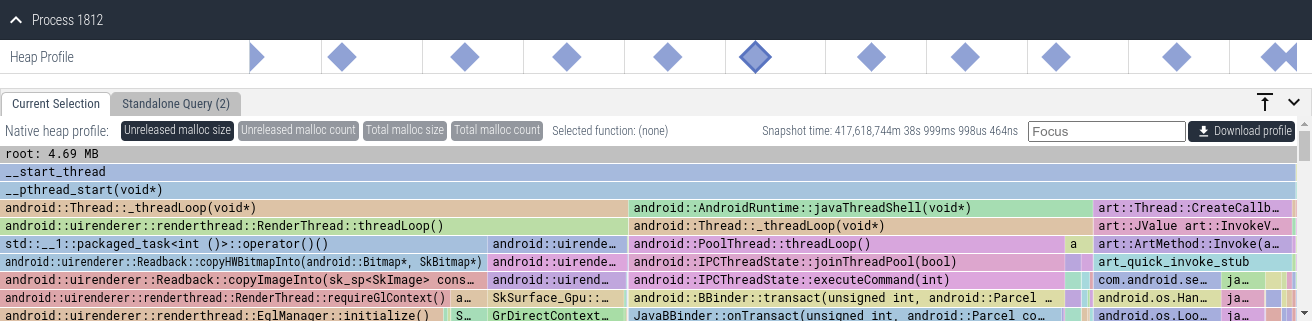

【内存泄漏】内存泄漏及常见的内存泄漏检测工具介绍

内存泄漏介绍 什么是内存泄漏 内存泄漏是指程序分配了一块内存(通常是动态分配的堆内存),但在不再需要这块内存的情况下未将其释放。内存泄漏会导致程序浪费系统内存资源,持续的内存泄漏还导致系统内存的逐渐耗尽,最…...

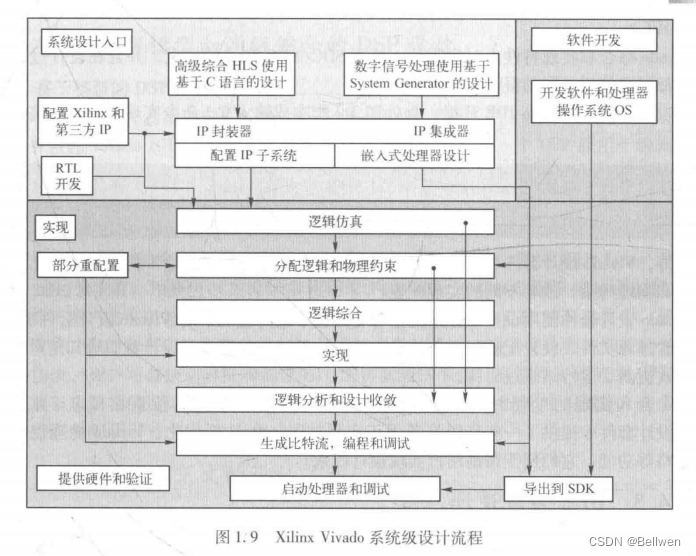

FPGA-ZYNQ-7000 SoC在嵌入式系统中的优势

FPGA-ZYNQ-7000 SoC在嵌入式系统中的优势 本章节主要参考书籍《Xilinx Zynq-7000 嵌入式系统设计与实现 基于ARM Cortex-A9双核处理器和Vivado的设计方法 (何宾,张艳辉编著)》 本章节主要讲述FPGA-ZYNQ-7000 SoC在嵌入式系统中的优势,学习笔…...

如何在Vue3中实现无缝热重载:提升你的开发效率

Vue3中的热重载(Hot Module Replacement,简称HMR)是一种开发时的功能,它允许开发者在不刷新整个页面的情况下,实时替换、添加或删除模块。这意味着当你对Vue组件进行修改并保存时,这些更改会立即反映在浏览…...

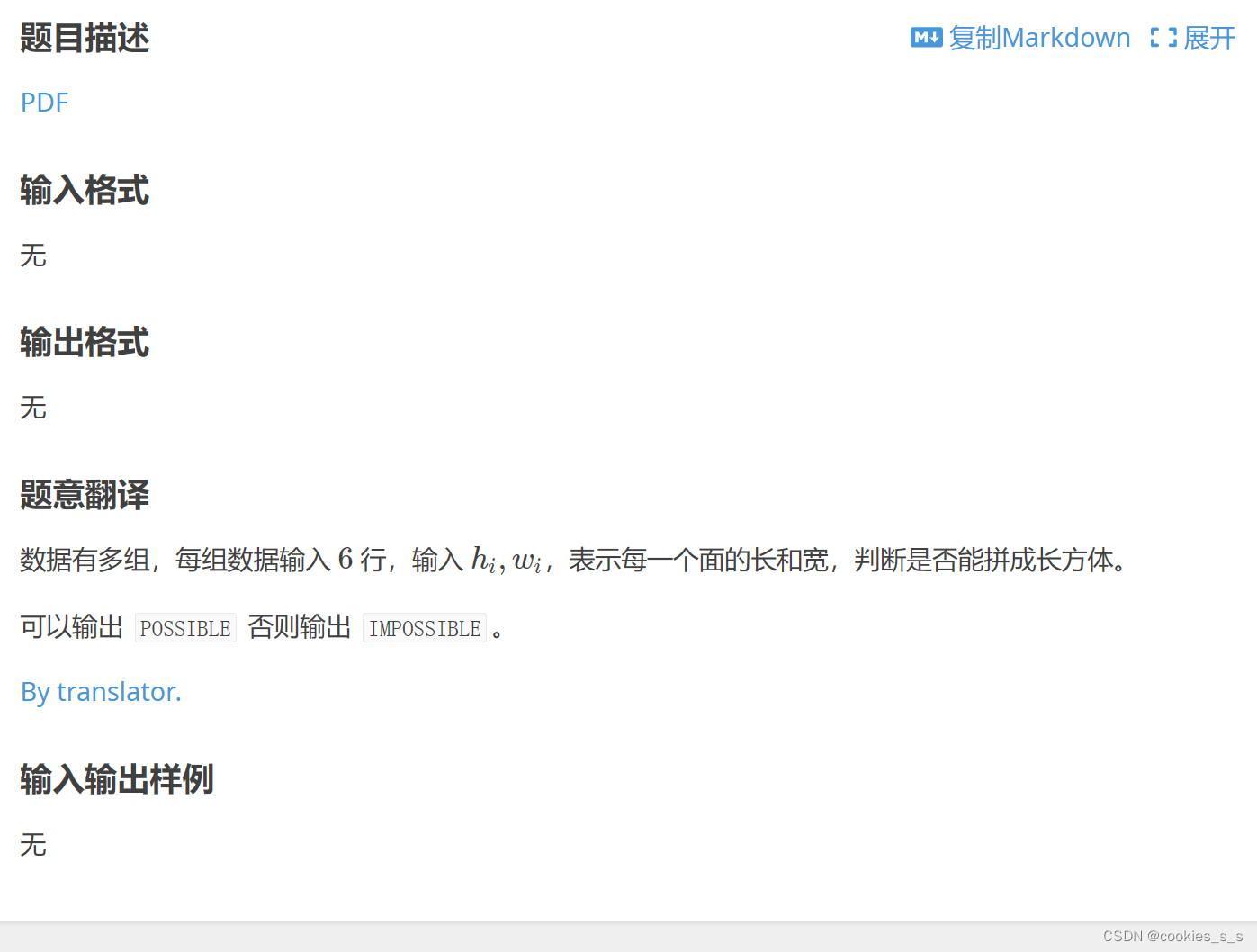

盒子 Box

UVa1587 思路: 1.输入每个面的长宽并将每个面较长的一边放在前面 2.判断是否存在三对面分别相等 3.判断是否存在三组四棱相等 #include <stdio.h> #include <stdlib.h> #define maxn 100int cmp(const void* e1, const void* e2) {return (int)(*(d…...

uni-app附件下载预览 并解决打开附件时黑屏

// 预览附件perviewFile(file) {console.log(点击附件, file)var strfile.previewUrlvar filTypestr.split(.)console.log(filType,filType)uni.downloadFile({url: success: function(res) {console.log(打开文档成功, res);if (res.statusCode 200) {uni.saveFile({tempFile…...

变量 varablie 声明- Rust 变量 let mut 声明与 C/C++ 变量声明对比分析

一、变量声明设计:let 与 mut 的哲学解析 Rust 采用 let 声明变量并通过 mut 显式标记可变性,这种设计体现了语言的核心哲学。以下是深度解析: 1.1 设计理念剖析 安全优先原则:默认不可变强制开发者明确声明意图 let x 5; …...

Docker 离线安装指南

参考文章 1、确认操作系统类型及内核版本 Docker依赖于Linux内核的一些特性,不同版本的Docker对内核版本有不同要求。例如,Docker 17.06及之后的版本通常需要Linux内核3.10及以上版本,Docker17.09及更高版本对应Linux内核4.9.x及更高版本。…...

Vue记事本应用实现教程

文章目录 1. 项目介绍2. 开发环境准备3. 设计应用界面4. 创建Vue实例和数据模型5. 实现记事本功能5.1 添加新记事项5.2 删除记事项5.3 清空所有记事 6. 添加样式7. 功能扩展:显示创建时间8. 功能扩展:记事项搜索9. 完整代码10. Vue知识点解析10.1 数据绑…...

stm32G473的flash模式是单bank还是双bank?

今天突然有人stm32G473的flash模式是单bank还是双bank?由于时间太久,我真忘记了。搜搜发现,还真有人和我一样。见下面的链接:https://shequ.stmicroelectronics.cn/forum.php?modviewthread&tid644563 根据STM32G4系列参考手…...

《用户共鸣指数(E)驱动品牌大模型种草:如何抢占大模型搜索结果情感高地》

在注意力分散、内容高度同质化的时代,情感连接已成为品牌破圈的关键通道。我们在服务大量品牌客户的过程中发现,消费者对内容的“有感”程度,正日益成为影响品牌传播效率与转化率的核心变量。在生成式AI驱动的内容生成与推荐环境中࿰…...

智能在线客服平台:数字化时代企业连接用户的 AI 中枢

随着互联网技术的飞速发展,消费者期望能够随时随地与企业进行交流。在线客服平台作为连接企业与客户的重要桥梁,不仅优化了客户体验,还提升了企业的服务效率和市场竞争力。本文将探讨在线客服平台的重要性、技术进展、实际应用,并…...

selenium学习实战【Python爬虫】

selenium学习实战【Python爬虫】 文章目录 selenium学习实战【Python爬虫】一、声明二、学习目标三、安装依赖3.1 安装selenium库3.2 安装浏览器驱动3.2.1 查看Edge版本3.2.2 驱动安装 四、代码讲解4.1 配置浏览器4.2 加载更多4.3 寻找内容4.4 完整代码 五、报告文件爬取5.1 提…...

【开发技术】.Net使用FFmpeg视频特定帧上绘制内容

目录 一、目的 二、解决方案 2.1 什么是FFmpeg 2.2 FFmpeg主要功能 2.3 使用Xabe.FFmpeg调用FFmpeg功能 2.4 使用 FFmpeg 的 drawbox 滤镜来绘制 ROI 三、总结 一、目的 当前市场上有很多目标检测智能识别的相关算法,当前调用一个医疗行业的AI识别算法后返回…...

智能AI电话机器人系统的识别能力现状与发展水平

一、引言 随着人工智能技术的飞速发展,AI电话机器人系统已经从简单的自动应答工具演变为具备复杂交互能力的智能助手。这类系统结合了语音识别、自然语言处理、情感计算和机器学习等多项前沿技术,在客户服务、营销推广、信息查询等领域发挥着越来越重要…...

处理vxe-table 表尾数据是单独一个接口,表格tableData数据更新后,需要点击两下,表尾才是正确的

修改bug思路: 分别把 tabledata 和 表尾相关数据 console.log() 发现 更新数据先后顺序不对 settimeout延迟查询表格接口 ——测试可行 升级↑:async await 等接口返回后再开始下一个接口查询 ________________________________________________________…...