用通俗易懂的方式讲解:大模型 RAG 在 LangChain 中的应用实战

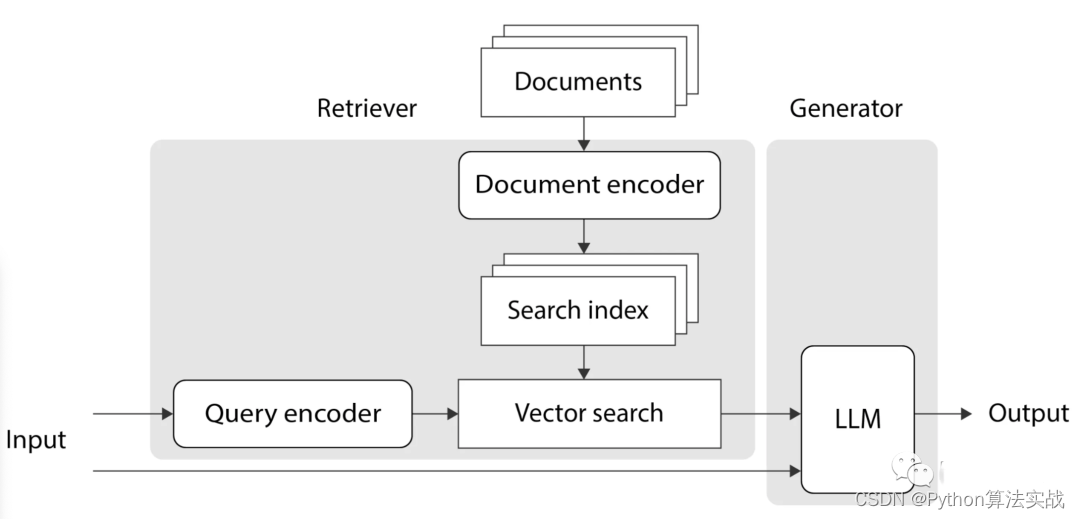

Retrieval-Augmented Generation(RAG)是一种强大的技术,能够提高大型语言模型(LLM)的性能,使其能够从外部知识源中检索信息以生成更准确、具有上下文的回答。

本文将详细介绍 RAG 在 LangChain 中的应用,以及如何构建一个简单的 RAG 管道。

LangChain 是什么

LangChain 是一个强大的自然语言处理工具,提供了丰富的功能来简化文本处理和信息检索任务。它的强大之处在于可以无缝集成不同的组件,从而构建复杂的文本处理管道。

RAG 是什么

RAG 的核心思想是将语言模型(LLM)与检索模块结合起来,使其能够利用外部知识源的信息。这有助于生成更加准确和上下文相关的回答,从而减少幻觉(hallucination)的风险。

RAG 工作原理分为两个主要阶段:

索引阶段

该阶段是信息检索系统中的一个关键步骤,旨在将原始数据(例如文档、文本等)进行处理和组织,以便后续能够更快速、有效地检索和获取相关信息。

以下是索引阶段的主要组成部分:

-

索引: 数据被处理成一个索引结构,其中特定的信息块被赋予唯一的标识符或值。索引结构充当后续检索操作的入口,加速信息查找的过程。

-

文档加载器: 负责从各种来源(如私有S3存储桶、信息网站、社交平台等)获取原始数据。文档加载器的任务是将原始数据导入系统,以便进行后续的处理和索引。

-

文档转换器: 对原始文档进行处理,将其转换成更容易处理的形式。这可能包括将大型文档分解为小块,准备文档以便后续的信息检索。

-

文本嵌入模型: 一旦文档被转换,系统会使用文本嵌入模型为文本创建嵌入。嵌入捕捉文本的潜在语义含义,使得后续的检索可以更准确地匹配用户查询。

-

向量存储: 为了存储处理后的数据和相应的嵌入,系统提供与多种向量存储的连接。

检索和生成阶段

该阶段是信息检索系统中的两个关键步骤,涉及根据用户的查询检索相关信息并生成自然语言响应。以下是的主要组成部分:

-

检索: 在用户提出问题时,系统使用检索器从存储中获取与用户需求相关的信息。这类似于搜索引擎,系统寻找匹配用户问题的数据片段。

-

生成: 获取所需信息后,ChatModel 或大语言模型(LLM)介入,通过将用户的问题与获取的数据结合,生成自然而直接相关的响应。

RAG 的工作流程

RAG 的工作流程主要分为三个步骤:检索、增强和生成。

-

检索: 使用用户查询从外部知识源中检索相关上下文。将用户查询嵌入到向量空间中,与向量数据库中的附加上下文进行相似性搜索,返回前 N 个最接近的数据对象。

-

增强: 使用用户查询和检索到的附加上下文填充提示模板。

-

生成: 将经过检索增强的提示传递给LLM。

通俗易懂讲解大模型系列

-

用通俗易懂的方式讲解:一文讲清大模型 RAG 技术全流程

-

用通俗易懂的方式讲解:如何提升大模型 Agent 的能力?

-

用通俗易懂的方式讲解:使用 Mistral-7B 和 Langchain 搭建基于PDF文件的聊天机器人

-

用通俗易懂的方式讲解:ChatGPT 开放的多模态的DALL-E 3功能,好玩到停不下来!

-

用通俗易懂的方式讲解:结合检索和重排序模型,改善大模型 RAG 效果明显

-

用通俗易懂的方式讲解:基于扩散模型(Diffusion),文生图 AnyText 的效果太棒了

-

用通俗易懂的方式讲解:在 CPU 服务器上部署 ChatGLM3-6B 模型

-

用通俗易懂的方式讲解:ChatGLM3-6B 功能原理解析

-

用通俗易懂的方式讲解:使用 LangChain 和大模型生成海报文案

-

用通俗易懂的方式讲解:一个强大的 LLM 微调工具 LLaMA Factory

-

用通俗易懂的方式讲解:ChatGLM3-6B 部署指南

-

用通俗易懂的方式讲解:LangChain Agent 原理解析

-

用通俗易懂的方式讲解:HugggingFace 推理 API、推理端点和推理空间使用详解

-

用通俗易懂的方式讲解:使用 LangChain 封装自定义的 LLM,太棒了

-

用通俗易懂的方式讲解:使用 FastChat 部署 LLM 的体验太爽了

-

用通俗易懂的方式讲解:基于 Langchain 和 ChatChat 部署本地知识库问答系统

-

用通俗易懂的方式讲解:使用 Docker 部署大模型的训练环境

-

用通俗易懂的方式讲解:在 Ubuntu 22 上安装 CUDA、Nvidia 显卡驱动、PyTorch等大模型基础环境

-

用通俗易懂的方式讲解:Llama2 部署讲解及试用方式

-

用通俗易懂的方式讲解:LangChain 知识库检索常见问题及解决方案

-

用通俗易懂的方式讲解:基于 LangChain 和 ChatGLM2 打造自有知识库问答系统

-

用通俗易懂的方式讲解:代码大模型盘点及优劣分析

-

用通俗易懂的方式讲解:Prompt 提示词在开发中的使用

-

用通俗易懂的方式讲解:万字长文带你入门大模型

技术交流

技术要学会分享、交流,不建议闭门造车。一个人可以走的很快、一堆人可以走的更远。

相关资料、数据、技术交流提升,均可加我们的交流群获取,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友。

方式①、添加微信号:mlc2060,备注:来自CSDN + 技术交流

方式②、微信搜索公众号:机器学习社区,后台回复:加群

配置与准备

在开始使用 LangChain 之前,首先需要安装必要的依赖。以下是配置OpenAI 环境和安装所需依赖项的代码:

!pip install openai --quiet

!pip install langchain --quiet

!pip install docx2txt --quiet

!pip install weaviate-client --quiet

然后,配置 OpenAI 环境的代码如下:

import os# 设置OpenAI API密钥

os.environ["OPENAI_API_KEY"] = "YOUR_OPENAI_API_KEY"

文档处理与分段

接下来,加载并处理示例文档。这包括使用文档加载器加载文档,然后将其分成较小的段落。

from langchain.document_loaders import Docx2txtLoader

from langchain.text_splitter import CharacterTextSplitter# 加载文档

document_path = "文件路径"

loader = Docx2txtLoader(document_path)

documents = loader.load()# 分割文档

text_splitter = CharacterTextSplitter(chunk_size=300, chunk_overlap=0)

texts = text_splitter.split_documents(documents)

文本嵌入与向量存储

现在,使用 LangChain 进行文本嵌入和向量存储,以便后续的检索操作。

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.vectorstores import Weaviate# 初始化 OpenAI 嵌入模型

embeddings = OpenAIEmbeddings()# 创建Weaviate向量数据库

vectorstore = Weaviate.from_documents(client=weaviate.Client(embedded_options=EmbeddedOptions()),documents=texts,embedding=embeddings,by_text=False

)

检索链的创建

接下来,将演示如何在 LangChain 中创建检索链。使用一个示例文档,并将其分段以便进行更有效的检索。

基于文档填充的检索链

from langchain.chains import RetrievalQA# 创建 RetrievalQA 检索链

retriever = vectorstore.as_retriever()

qa = RetrievalQA.from_chain_type(llm=ChatOpenAI(model_name="gpt-3.5-turbo", temperature=0), chain_type="stuff", retriever=retriever)# 运行查询

query = "这文档里都有什么内容?"result = qa_map_reduce.run(query)

print(result)

Map-Reduce 文档链

from langchain.chains import RetrievalQA# 构建 Map-Reduce文档链

retriever = vectorstore.as_retriever()

qa_map_reduce = RetrievalQA.from_chain_type(llm=OpenAI(), chain_type="map_reduce", retriever=retriever)# 运行查询

query = "这文档里都有什么内容?"result = qa_map_reduce.run(query)

print(result)

优化文档链

from langchain.chains import RetrievalQA# 构建优化文档链

retriever = vectorstore.as_retriever()

qa_refine = RetrievalQA.from_chain_type(llm=OpenAI(), chain_type="refine", retriever=retriever)# 运行查询

query = "这文档里都有什么内容?"result = qa_refine.run(query)

print(result)

RAG 实现示例

1. 基础设置和文档处理:通过 LangChain 处理文本数据,将其嵌入为向量,并通过 Weaviate 向量数据库,为文本搜索或相似性匹配提供支持。

import requests

from weaviate import Weaviate, Client, EmbeddedOptions

from weaviate.language_embedding.vectorization import OpenAIEmbeddings

from weaviate.util import CharacterTextSplitter, TextLoader

import dotenv# 加载环境变量

dotenv.load_dotenv()# 下载数据

url = "https://raw.githubusercontent.com/langchain-ai/langchain/master/docs/docs/modules/state_of_the_union.txt"

res = requests.get(url)

with open("state_of_the_union.txt", "w") as f:f.write(res.text)# 使用 TextLoader 加载文本

loader = TextLoader('./state_of_the_union.txt')

documents = loader.load()# 使用 CharacterTextSplitter 拆分文本成小块

text_splitter = CharacterTextSplitter(chunk_size=500, chunk_overlap=50)

chunks = text_splitter.split_documents(documents)# 初始化 Weaviate 客户端

client = Client(embedded_options=EmbeddedOptions())# 在 Weaviate 中创建向量存储

vectorstore = Weaviate.from_documents(client=client,documents=chunks,embedding=OpenAIEmbeddings(),by_text=False

)

2. 构建 RAG Pipline:使用 RAG 模型进行问答对话,通过检索上下文信息来支持生成更精准的回答。

from langchain.prompts import ChatPromptTemplate

from langchain.chat_models import ChatOpenAI

from langchain.schema.runnable import RunnablePassthrough

from langchain.schema.output_parser import StrOutputParser# 定义检索器

retriever = vectorstore.as_retriever()# 准备中文prompt模板

template = """你是一个用于问答任务的助手。

使用以下检索到的上下文片段来回答问题。

如果你不知道答案,只需说你不知道。

最多使用三句话,保持回答简洁。

问题: {question}

上下文: {context}

回答:

"""

prompt = ChatPromptTemplate.from_template(template)# 定义LLM

llm = ChatOpenAI(model_name="gpt-3.5-turbo", temperature=0)# 构建RAG链

rag_chain = ({"context": retriever, "question": RunnablePassthrough()} | prompt | llm| StrOutputParser()

)# 运行RAG链

query = "总结内容并列出关键词."

result = rag_chain.invoke(query)

print(result)

以上就是一个简单的 RAG Pipline 的构建和运行过程。通过这种方式,LangChain 提供了一种方便而强大的方法来实现检索增强生成任务,使得语言模型能够更好地利用外部知识源来提高其性能。

总结

LangChain 提供了丰富的组件和功能,使得 RAG 的实现变得简单而灵活。通过检索增强生成,使我们能够充分利用大语言模型和外部知识源,生成更加准确和具有上下文的回答,从而提高自然语言处理任务的性能。

引用

- https://github.com/langchain-ai/langchain

- https://python.plainenglish.io/rag-using-langchain-c371fcd02d13

- https://towardsdatascience.com/retrieval-augmented-generation-rag-from-theory-to-langchain-implementation-4e9bd5f6a4f2

相关文章:

用通俗易懂的方式讲解:大模型 RAG 在 LangChain 中的应用实战

Retrieval-Augmented Generation(RAG)是一种强大的技术,能够提高大型语言模型(LLM)的性能,使其能够从外部知识源中检索信息以生成更准确、具有上下文的回答。 本文将详细介绍 RAG 在 LangChain 中的应用&a…...

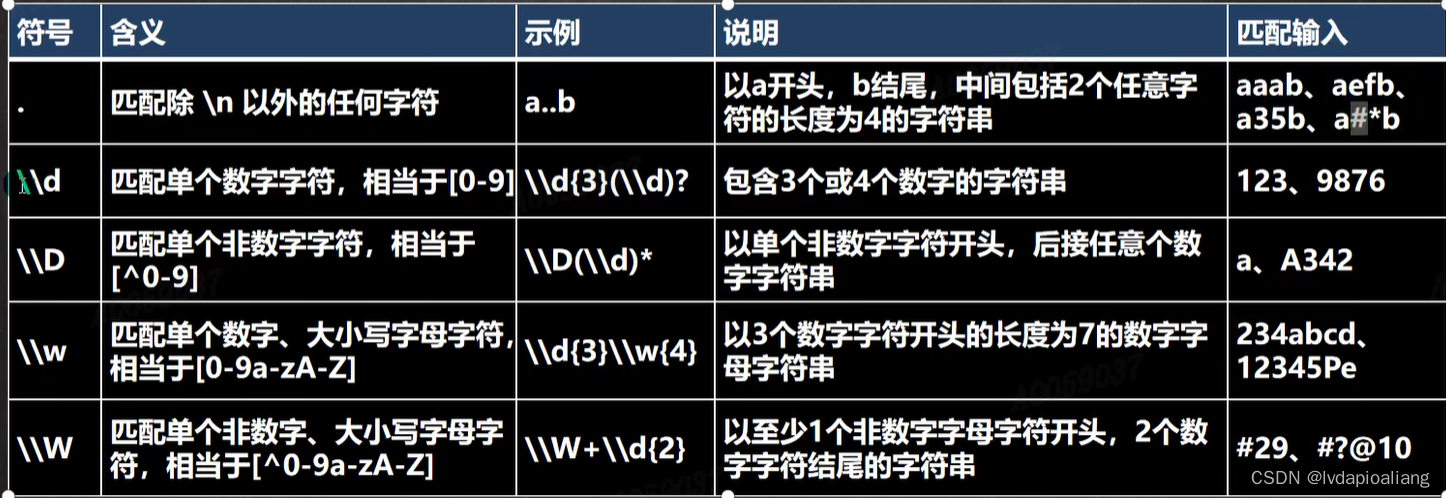

正则表达式的语法

如果要想灵活的运用正则表达式,必须了解其中各种元素字符的功能,元字符从功能上大致分为: 限定符 选择匹配符 分组组合和反向引用符 特殊字符 字符匹配符 定位符 我们先说一下元字符的转义号 元字符(Metacharacter)-转义号 \\ \\ 符号…...

MyBatis分页插件的实现原理

MyBatis 分页插件的实现原理是通过拦截器(Interceptor)来实现的。拦截器可以在 SQL 执行前后对 SQL 进行拦截和处理。 简单来说,就是通过在查询语句中添加额外的参数和逻辑,以支持分页功能。它的核心思想是将分页参数传递给插件&…...

Winform、WPF如何解决前端卡死问题

在WinForms和WPF中,前端卡死问题通常是由于长时间的计算或阻塞操作导致的。以下是一些解决前端卡死问题的常见方法: 使用异步操作:将长时间的计算或阻塞操作放在后台线程中执行,以避免阻塞UI线程。可以使用Task、async/await等异步…...

python内app自动化测试的局限性,该如何破局?

Python在App自动化测试方面非常流行,尤其对于移动应用(Android和iOS)的测试,可以借助于像Appium、Robot Framework等工具进行跨平台自动化。然而,即使使用Python这样的强大语言,App自动化测试也存在一些局限…...

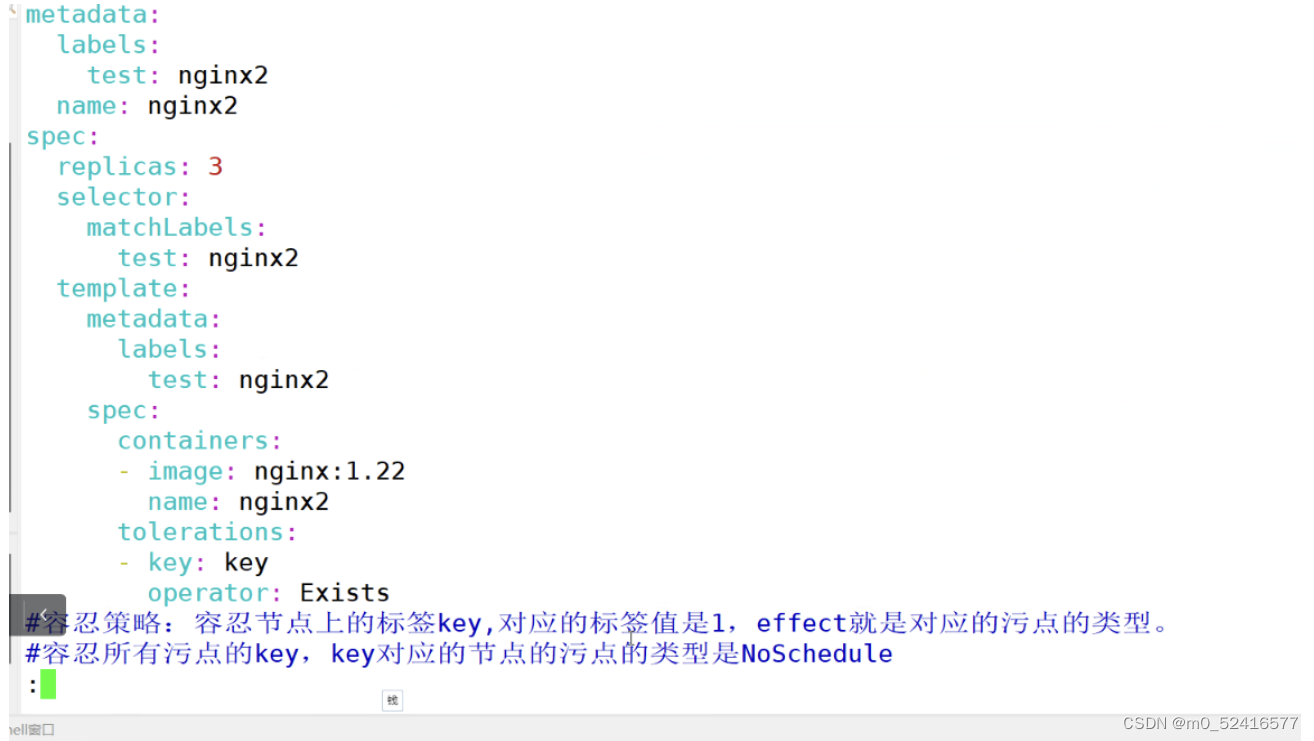

k8s的node亲和性和pod亲和性和反亲和性 污点 cordon drain

node亲和性和pod亲和性和反亲和性 污点 cordon drain 集群调度: schedule的调度算法 预算策略 过滤出合适的节点 优先策略 选择部署的节点 nodeName:硬匹配,不走调度策略,node01 nodeSelector:根据节点的标签选择,会走调度的算法 只…...

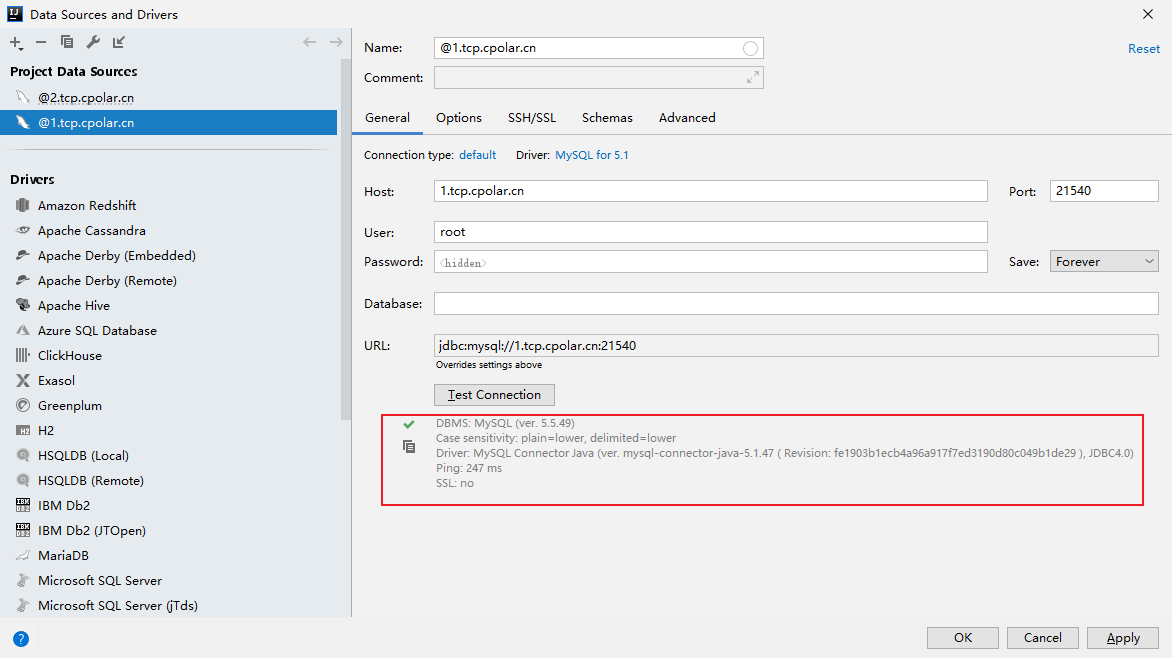

IntelliJ IDEA如何使用固定地址公网远程访问本地Mysql数据库

文章目录 1. 本地连接测试2. Windows安装Cpolar3. 配置Mysql公网地址4. IDEA远程连接Mysql小结 5. 固定连接公网地址6. 固定地址连接测试 IDEA作为Java开发最主力的工具,在开发过程中需要经常用到数据库,如Mysql数据库,但是在IDEA中只能连接本…...

GIT - 清除历史 Commit 瘦身仓库

目录 一.引言 二.仓库清理 ◆ 创建一个船新分支 ◆ 提交最新代码 ◆ 双指针替换分支 三.总结 一.引言 由于项目运行时间较长,分支较多,且分支内包含很多不同的大文件,随着时间的推移,历史 Git 库的容量日渐增发,…...

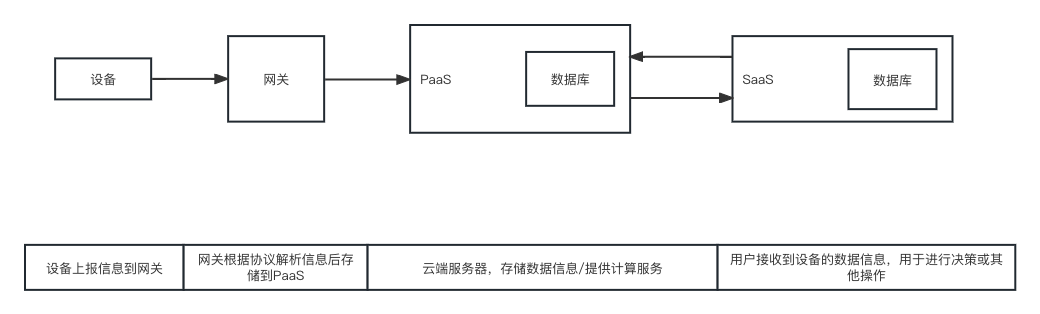

物联网产品中,终端、网关、协议、PaaS、SaaS之间的关系

在互联网产品中,经常提到的终端、网关、协议、PaaS、SaaS之间,到底有什么关系呢? 一、基本概念 在百度/其他地方搜集的信息中,对于终端、网关、协议、PaaS、SaaS的解释各有不同,整理如下: 终端࿱…...

6款实用的Git可视化管理工具

前言 俗话说得好“工欲善其事,必先利其器”,合理的选择和使用可视化的管理工具可以降低技术入门和使用门槛。我们在团队开发中统一某个开发工具能够降低沟通成本,提高协作效率。今天给大家分享6款实用的Git可视化管理工具。 Git是什么&…...

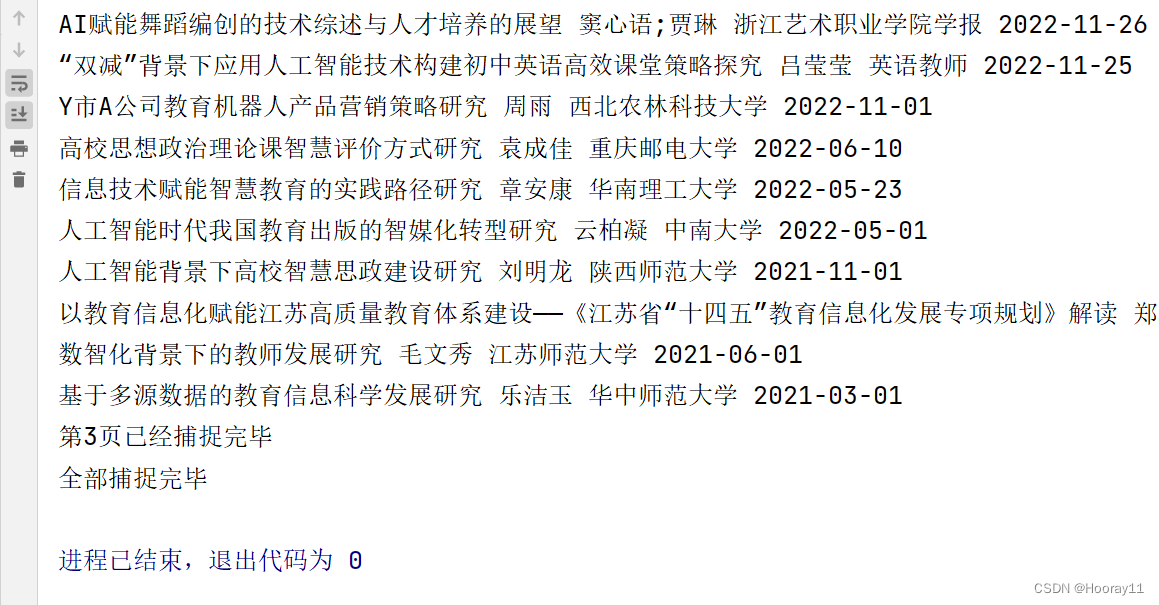

python_selenium零基础爬虫学习案例_知网文献信息

案例最终效果说明: 去做这个案例的话是因为看到那个博主的分享,最后通过努力,我基本实现了进行主题、关键词、更新时间的三个筛选条件去获取数据,并且遍历数据将其导出到一个CSV文件中,代码是很简单的,没有…...

MindSpore Serving基于昇腾910B实现大模型部署

一、Why MindSpore Serving 大模型时代,作为一个开发人员更多的是关注一个大模型如何训练好、如何调整模型参数、如何才能得到一个更高的模型精度。而作为一个整体项目,只有项目落地才能有其真正的价值。那么如何才能够使得大模型实现落地?如…...

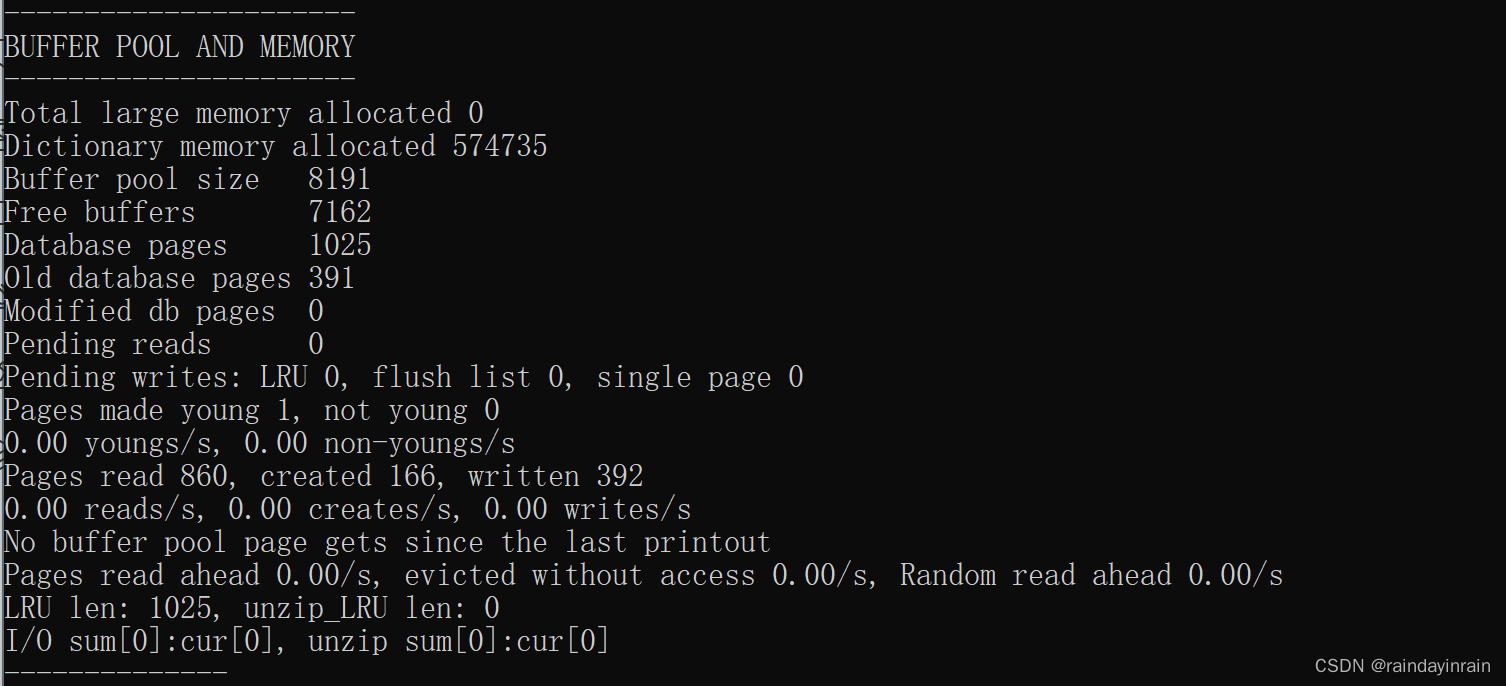

mysql原理--InnoDB的Buffer Pool

1.缓存的重要性 对于使用 InnoDB 作为存储引擎的表来说,不管是用于存储用户数据的索引(包括聚簇索引和二级索引),还是各种系统数据,都是以 页 的形式存放在 表空间 中的,而所谓的 表空间 只不过是 InnoDB 对…...

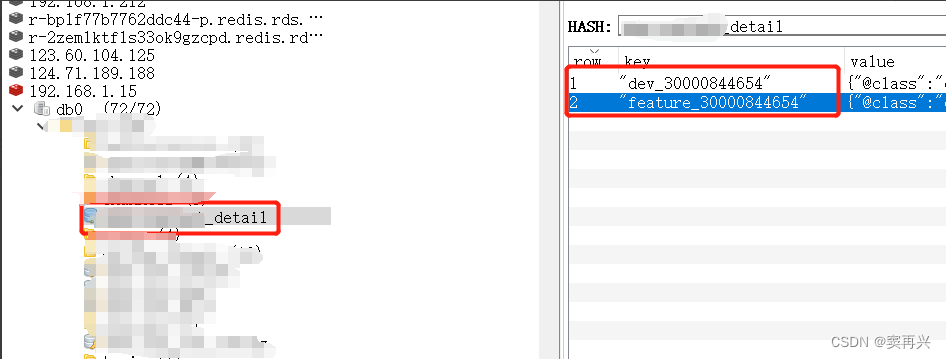

Redis不同环境缓存同一条数据,数据内部值不同

背景 现实中,本地环境(dev)和开发环境(feature)会共同使用相同的中间件(本篇拿Redis举例),对于不同环境中的,图片、视频、语音等资源类型的预览地址url,需要配…...

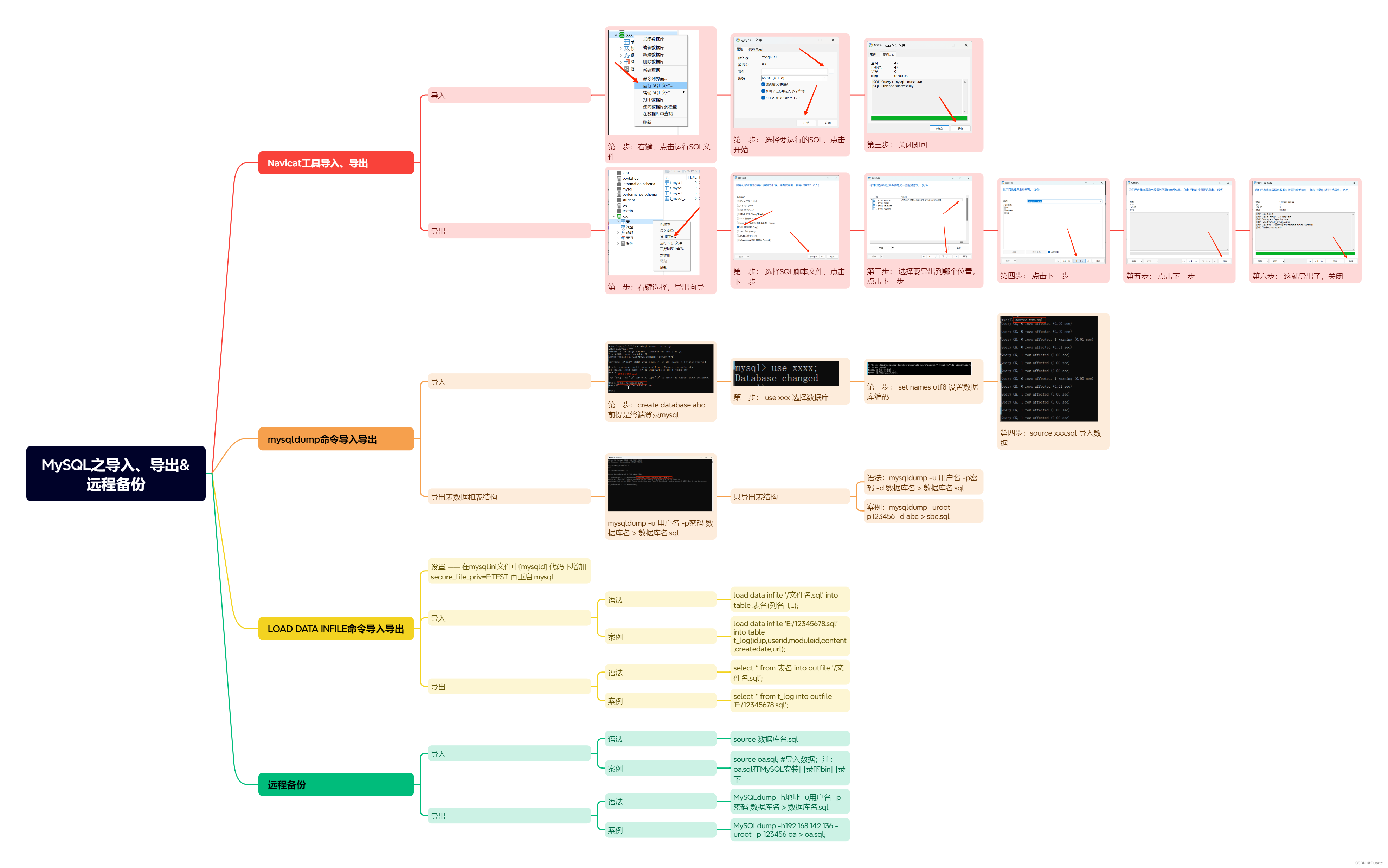

MySQL之导入、导出远程备份

一、Navicat工具导入、导出 1.1 导入 第一步: 右键,点击运行SQL文件 第二步: 选择要运行的SQL,点击开始 第三步: 关闭即可 1.2 导出 第一步: 右键选择,导出向导 第二步: 选择SQL脚…...

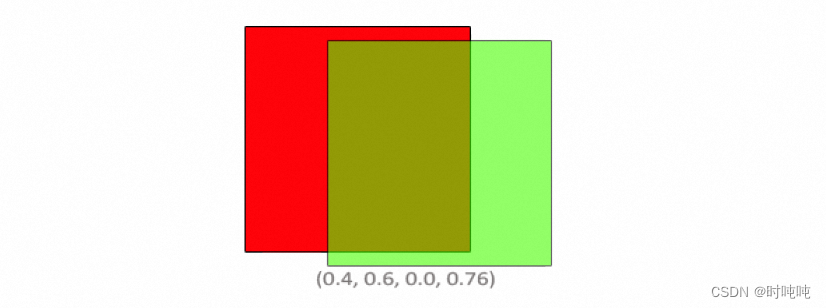

OpenGL学习笔记-Blending

混合方程中,Csource是片段着色器输出的颜色向量(the color output of the fragment shader),其权重为Fsource。Cdestination是当前存储在color buffer中的颜色向量(the color vector that is currently stored in the …...

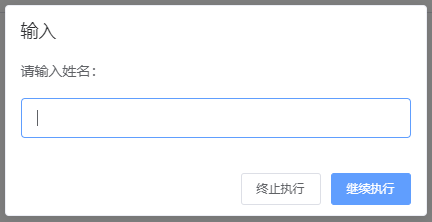

支持 input 函数的在线 python 运行环境 - 基于队列

支持 input 函数的在线 python 运行环境 - 基于队列 思路两次用户输入三次用户输入 实现前端使用 vue element uiWindows 环境的执行器子进程需要执行的代码 代码仓库参考 本文提供了一种方式来实现支持 input 函数,即支持用户输的在线 python 运行环境。效果如下图…...

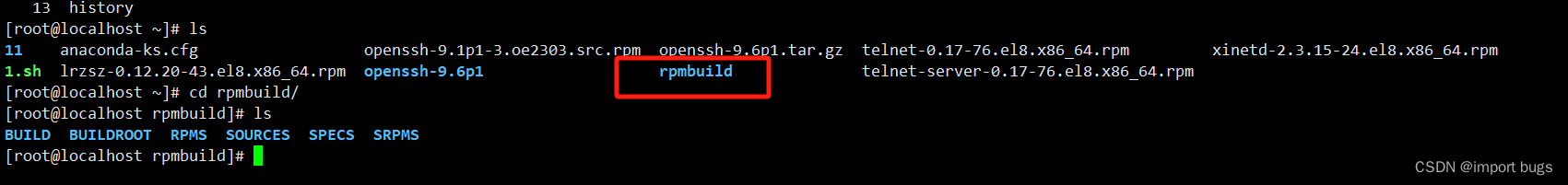

欧拉Euler release 21.10 (LTS-SP2)升级openssh至9版本记录

背景:安扫漏洞,需要对openssh经行升级 1.先查看升级前的openssh版本 2.避免升级失败断开远程登录,先开启telnt服务用于远程连接(这步可查看其他博客) 3.从欧拉官网下载rpm包,https://www.openeuler.org/zh…...

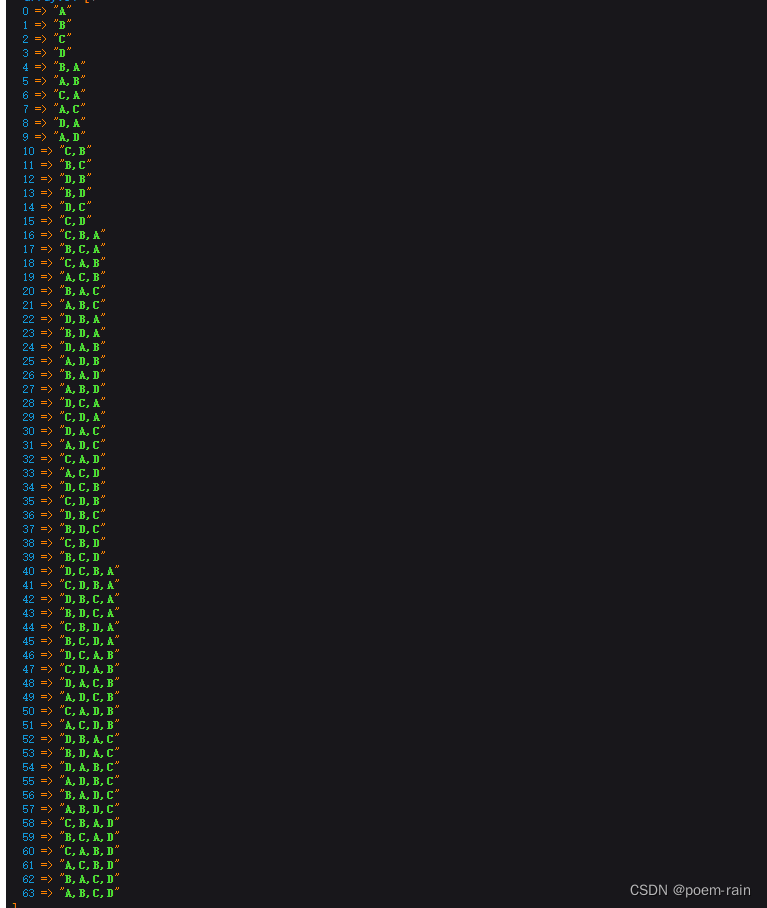

php 数组中的元素进行排列组合

需求背景:计算出数组[A,B,C,D]各种排列组合,希望得到的是数据如下图 直接上代码: private function finish_combination($array, &$groupResult [], $splite ,){$result [];$finish_result [];$this->diffArrayItems($array, $…...

Python从入门到网络爬虫(OS模块详解)

前言 本章介绍python自带模块os,os为操作系统 operating system 的简写,意为python与电脑的交互。os 模块提供了非常丰富的方法用来处理文件和目录。通过使用 os 模块,一方面可以方便地与操作系统进行交互,另一方面页可以极大增强…...

java_网络服务相关_gateway_nacos_feign区别联系

1. spring-cloud-starter-gateway 作用:作为微服务架构的网关,统一入口,处理所有外部请求。 核心能力: 路由转发(基于路径、服务名等)过滤器(鉴权、限流、日志、Header 处理)支持负…...

智慧工地云平台源码,基于微服务架构+Java+Spring Cloud +UniApp +MySql

智慧工地管理云平台系统,智慧工地全套源码,java版智慧工地源码,支持PC端、大屏端、移动端。 智慧工地聚焦建筑行业的市场需求,提供“平台网络终端”的整体解决方案,提供劳务管理、视频管理、智能监测、绿色施工、安全管…...

LeetCode - 394. 字符串解码

题目 394. 字符串解码 - 力扣(LeetCode) 思路 使用两个栈:一个存储重复次数,一个存储字符串 遍历输入字符串: 数字处理:遇到数字时,累积计算重复次数左括号处理:保存当前状态&a…...

pam_env.so模块配置解析

在PAM(Pluggable Authentication Modules)配置中, /etc/pam.d/su 文件相关配置含义如下: 配置解析 auth required pam_env.so1. 字段分解 字段值说明模块类型auth认证类模块,负责验证用户身份&am…...

将对透视变换后的图像使用Otsu进行阈值化,来分离黑色和白色像素。这句话中的Otsu是什么意思?

Otsu 是一种自动阈值化方法,用于将图像分割为前景和背景。它通过最小化图像的类内方差或等价地最大化类间方差来选择最佳阈值。这种方法特别适用于图像的二值化处理,能够自动确定一个阈值,将图像中的像素分为黑色和白色两类。 Otsu 方法的原…...

Keil 中设置 STM32 Flash 和 RAM 地址详解

文章目录 Keil 中设置 STM32 Flash 和 RAM 地址详解一、Flash 和 RAM 配置界面(Target 选项卡)1. IROM1(用于配置 Flash)2. IRAM1(用于配置 RAM)二、链接器设置界面(Linker 选项卡)1. 勾选“Use Memory Layout from Target Dialog”2. 查看链接器参数(如果没有勾选上面…...

《基于Apache Flink的流处理》笔记

思维导图 1-3 章 4-7章 8-11 章 参考资料 源码: https://github.com/streaming-with-flink 博客 https://flink.apache.org/bloghttps://www.ververica.com/blog 聚会及会议 https://flink-forward.orghttps://www.meetup.com/topics/apache-flink https://n…...

html css js网页制作成品——HTML+CSS榴莲商城网页设计(4页)附源码

目录 一、👨🎓网站题目 二、✍️网站描述 三、📚网站介绍 四、🌐网站效果 五、🪓 代码实现 🧱HTML 六、🥇 如何让学习不再盲目 七、🎁更多干货 一、👨…...

JVM虚拟机:内存结构、垃圾回收、性能优化

1、JVM虚拟机的简介 Java 虚拟机(Java Virtual Machine 简称:JVM)是运行所有 Java 程序的抽象计算机,是 Java 语言的运行环境,实现了 Java 程序的跨平台特性。JVM 屏蔽了与具体操作系统平台相关的信息,使得 Java 程序只需生成在 JVM 上运行的目标代码(字节码),就可以…...

MySQL JOIN 表过多的优化思路

当 MySQL 查询涉及大量表 JOIN 时,性能会显著下降。以下是优化思路和简易实现方法: 一、核心优化思路 减少 JOIN 数量 数据冗余:添加必要的冗余字段(如订单表直接存储用户名)合并表:将频繁关联的小表合并成…...