python爬虫------- Selenium下篇(二十三天)

🎈🎈作者主页: 喔的嘛呀🎈🎈

🎈🎈所属专栏:python爬虫学习🎈🎈

✨✨谢谢大家捧场,祝屏幕前的小伙伴们每天都有好运相伴左右,一定要天天开心哦!✨✨

目录

十、处理动态内容

十一、处理验证码

十二、模拟登录

十三、跨页面操作

十四、异常处理

十五、数据存储

存储到文件(例如 CSV 文件)

存储到数据库(例如 SQLite)

存储到其他存储介质(例如 MongoDB)

十六、反爬虫策略

十七、性能优化

十八、定时任务:

十九、 与其他库和工具的集成

helllo,兄弟姐妹们!今天我们接着把第二十二天剩下的十个知识点学完(从第十个开始)。

十、处理动态内容

处理动态加载内容的常见方法是通过模拟用户操作来触发页面加载新内容。对于需要滚动页面加载的情况,可以使用 Selenium 的 execute_script 方法来执行 JavaScript 代码,从而实现滚动页面的效果。下面是一个示例代码,演示如何使用 Selenium 模拟滚动页面来加载更多内容:

from selenium import webdriver

import time# 启动浏览器

driver = webdriver.Chrome()# 打开网页

driver.get('<https://example.com>')# 模拟滚动页面

scroll_pause_time = 2 # 每次滚动后等待时间

screen_height = driver.execute_script("return window.screen.height;") # 获取屏幕高度i = 1

while True:# 记录滚动前页面高度last_height = driver.execute_script("return document.body.scrollHeight;")# 模拟滚动到页面底部driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")# 等待页面加载time.sleep(scroll_pause_time)# 计算新的页面高度new_height = driver.execute_script("return document.body.scrollHeight;")# 如果新的页面高度和上次相同,则说明已经滚动到底部if new_height == last_height:break# 打印滚动次数print(f"Scrolling {i} times")i += 1# 获取页面数据

data = driver.page_source# 关闭浏览器

driver.quit()# 处理页面数据,如解析数据等在这个示例中,我们首先启动 Chrome 浏览器,并打开了一个示例网页。然后,我们通过执行 JavaScript 代码来模拟滚动页面到底部的效果。在每次滚动后,我们等待了2秒钟以确保页面有足够的时间加载新内容。如果页面高度不再增加,说明已经滚动到了页面底部,循环就会结束。最后,我们获取了页面的 HTML 源码,并可以继续处理数据,如解析数据等操作。

请注意,这只是一个简单的示例。实际情况可能会更复杂,具体取决于要爬取的网站和其动态加载数据的机制。

十一、处理验证码

处理网页中的验证码通常需要结合 Selenium 和图像识别技术。下面是一个使用 Selenium 和 pytesseract 库来处理网页中简单验证码的示例:

首先,安装 Pillow、pytesseract 和 pytesseract 库:

pip install Pillow pytesseract selenium然后,下载并安装 Tesseract OCR,并将其添加到系统路径中。

接下来,使用以下代码示例:

from PIL import Image

import pytesseract

from selenium import webdriver

from selenium.webdriver.common.by import By

import time

import requests

from io import BytesIO# 设置 Tesseract OCR 路径

pytesseract.pytesseract.tesseract_cmd = r'C:\\Program Files\\Tesseract-OCR\\tesseract.exe'# 启动浏览器

driver = webdriver.Chrome()# 打开网页

driver.get('<https://example.com>')# 找到验证码图片元素

captcha_element = driver.find_element(By.XPATH, '//img[@id="captcha-image"]')# 获取验证码图片的链接

captcha_image_url = captcha_element.get_attribute('src')# 下载验证码图片

response = requests.get(captcha_image_url)

captcha_image = Image.open(BytesIO(response.content))# 识别验证码

captcha_text = pytesseract.image_to_string(captcha_image)# 输入验证码

captcha_input = driver.find_element(By.XPATH, '//input[@id="captcha-input"]')

captcha_input.send_keys(captcha_text)# 提交表单

submit_button = driver.find_element(By.XPATH, '//button[@id="submit-button"]')

submit_button.click()# 等待页面加载

time.sleep(2)# 获取页面数据

data = driver.page_source# 关闭浏览器

driver.quit()# 处理页面数据,如解析数据等在这个示例中,我们首先设置了 Tesseract OCR 的路径。然后,使用 Selenium 打开了一个示例网页,并找到了验证码图片元素。我们通过请求验证码图片的链接,并使用 pytesseract 库识别验证码中的文本。最后,我们将识别结果填写到验证码输入框中,并提交表单。

请注意,这只适用于简单的验证码。对于复杂的验证码,可能需要使用更复杂的技术和工具。

注意:

Tesseract OCR(Optical Character Recognition)是一个开源的光学字符识别引擎,由 Google 开发并维护。它能够将图像中的文字转换为可编辑的文本。Tesseract 能够识别超过100种语言的文字,并且支持许多图像格式。Tesseract 的最新版本是4.x,具有比较高的准确性和性能。

使用 Tesseract OCR 进行文本识别通常涉及以下步骤:

-

安装 Tesseract OCR:根据您的操作系统下载并安装 Tesseract OCR。对于 Windows 系统,可以从 GitHub Release 页面下载安装包进行安装。对于 macOS 和 Linux 系统,可以通过包管理器(如 Homebrew 或 apt)安装。

-

安装 pytesseract:pytesseract 是一个 Python 模块,用于与 Tesseract OCR 进行交互。您可以使用 pip 安装 pytesseract:

bashCopy code pip install pytesseract -

使用 pytesseract 进行图像文本识别:下面是一个简单的示例代码,演示如何使用 pytesseract 对图像进行文本识别:

from PIL import Image import pytesseract# 读取图像文件 image = Image.open('example.png')# 使用 pytesseract 进行文本识别 text = pytesseract.image_to_string(image)# 打印识别结果 print(text)

Tesseract OCR 对于特定字体、大小和质量的图像效果可能会有所不同。在实际使用中,我们需要调整图像预处理和 Tesseract 的参数来获得最佳的识别结果。

十二、模拟登录

要使用 Selenium 模拟登录网站并爬取需要登录才能访问的页面,我们可以按照以下步骤进行:

- 启动浏览器并打开登录页面。

- 填写登录表单,包括用户名和密码。

- 点击登录按钮。

- 等待登录完成。

- 访问需要登录才能访问的页面,提取数据或进行其他操作。

下面是一个示例代码,演示如何使用 Selenium 模拟登录网站并爬取需要登录才能访问的页面:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.common.keys import Keys

import time# 启动浏览器

driver = webdriver.Chrome()# 打开登录页面

driver.get('<https://example.com/login>')# 填写用户名和密码

username_input = driver.find_element(By.ID, 'username')

password_input = driver.find_element(By.ID, 'password')username_input.send_keys('your_username')

password_input.send_keys('your_password')# 提交登录表单

password_input.send_keys(Keys.RETURN)# 等待登录完成,这里假设登录成功后会跳转到首页

time.sleep(2)# 访问需要登录才能访问的页面

driver.get('<https://example.com/protected_page>')# 提取页面数据或进行其他操作

data_element = driver.find_element(By.XPATH, '//div[@class="data"]')

data = data_element.text

print('Protected Page Data:', data)# 关闭浏览器

driver.quit()请注意,在实际使用中,我们需要替换示例中的 '<https://example.com/login'、'your_username'> 和 'your_password' 为实际的登录页面 URL、用户名和密码。同时,确保我们的行为符合网站的使用条款和规定,以免触发反爬虫措施。

十三、跨页面操作

处理需要跨页面操作的情况通常需要在页面之间进行导航和交互。使用 Selenium 可以模拟用户在网页上的操作,包括点击链接跳转到另一个页面。下面是一个示例代码,演示如何在一个页面点击链接跳转到另一个页面进行数据提取:

from selenium import webdriver

from selenium.webdriver.common.by import By

import time# 启动浏览器

driver = webdriver.Chrome()# 打开第一个页面

driver.get('<https://example.com/page1>')# 点击页面上的链接

link_element = driver.find_element(By.XPATH, '//a[@id="link-to-page2"]')

link_element.click()# 等待页面加载

time.sleep(2)# 在第二个页面提取数据

data_element = driver.find_element(By.XPATH, '//div[@id="data-on-page2"]')

data = data_element.textprint('Data on page 2:', data)# 关闭浏览器

driver.quit()在这个示例中,我们首先启动了 Chrome 浏览器,并打开了第一个页面。然后,我们找到了第一个页面上的链接元素,并使用 click() 方法点击了该链接。随后,我们等待了2秒钟,以确保第二个页面加载完成。最后,我们找到了第二个页面上的数据元素,并提取了其文本内容。

需要注意的是,实际情况可能更复杂,具体取决于网站的结构和交互方式。在处理跨页面操作时,确保等待页面加载完成并处理可能的异常情况是很重要的。

十四、异常处理

在爬取过程中,可能会出现各种异常情况,如超时、元素未找到等。为了确保爬虫的稳定性和可靠性,需要对这些异常情况进行处理。下面是一个示例代码,演示如何使用 try-except 语句来处理这些异常情况:

from selenium import webdriver

from selenium.common.exceptions import TimeoutException, NoSuchElementException

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC# 启动浏览器

driver = webdriver.Chrome()try:# 设置页面加载超时时间为10秒driver.set_page_load_timeout(10)# 打开网页driver.get('<https://example.com>')# 显式等待10秒,直到元素加载完成WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH, '//div[@id="content"]')))# 提取数据content_element = driver.find_element(By.XPATH, '//div[@id="content"]')content = content_element.textprint('Content:', content)except TimeoutException:print('页面加载超时')except NoSuchElementException:print('元素未找到')finally:# 关闭浏览器driver.quit()在这个示例中,我们使用了 try-except 语句来捕获可能出现的 TimeoutException(超时异常)和 NoSuchElementException(元素未找到异常)。在 try 代码块中,我们设置了页面加载超时时间为10秒,并使用显式等待来等待页面元素加载完成。如果页面加载超时或元素未找到,则会相应地捕获并处理异常。最后,无论是否发生异常,我们都会在 finally 代码块中关闭浏览器。

通过合理地处理异常情况,可以使爬虫在遇到问题时能够优雅地处理,并继续执行其他操作。

十五、数据存储

提取到的数据存储到文件、数据库或其他存储介质中是网页爬取的重要步骤之一。具体的存储方式取决于您的需求和项目的要求。以下是几种常见的数据存储方式示例:

存储到文件(例如 CSV 文件)

import csvdata = [{'name': 'Alice', 'age': 25}, {'name': 'Bob', 'age': 30}]with open('data.csv', mode='w', newline='') as file:writer = csv.DictWriter(file, fieldnames=['name', 'age'])writer.writeheader()for row in data:writer.writerow(row)存储到数据库(例如 SQLite)

import sqlite3data = [{'name': 'Alice', 'age': 25}, {'name': 'Bob', 'age': 30}]conn = sqlite3.connect('data.db')

cursor = conn.cursor()cursor.execute('''CREATE TABLE IF NOT EXISTS users(id INTEGER PRIMARY KEY, name TEXT, age INTEGER)''')for row in data:cursor.execute('INSERT INTO users (name, age) VALUES (?, ?)', (row['name'], row['age']))conn.commit()

conn.close()存储到其他存储介质(例如 MongoDB)

from pymongo import MongoClientdata = [{'name': 'Alice', 'age': 25}, {'name': 'Bob', 'age': 30}]client = MongoClient('mongodb://localhost:27017/')

db = client['mydatabase']

collection = db['users']for row in data:collection.insert_one(row)client.close()这些示例展示了如何将提取到的数据存储到不同的存储介质中。您可以根据项目的需要选择适合的存储方式。

十六、反爬虫策略

反爬虫策略是网站为防止被爬虫程序恶意抓取数据而采取的一系列措施。常见的反爬虫策略包括:

- User-Agent检测:网站会检查请求中的 User-Agent 字段,如果发现是爬虫程序常用的 User-Agent,则可能拒绝服务或返回特定响应。

- IP地址限制:网站可能会限制同一IP地址的访问频率,过高频率的访问会被视为异常行为。

- 验证码:网站可能会在某些操作前要求用户输入验证码,以确认访问者是人类而不是爬虫程序。

- 动态加载内容:网站使用JavaScript等技术来动态加载内容,使得只有通过真正执行页面脚本才能获取到完整内容。

- 频率限制:限制同一用户或IP地址在一定时间内的请求频率,过高频率的请求会被拒绝。

- 页面结构变化:定期改变页面结构,使得爬虫程序难以适应变化而失效。

应对这些反爬虫策略的方法包括:

- 设置合理的User-Agent:模拟浏览器行为,避免使用常见的爬虫User-Agent。

- 使用代理IP:使用代理IP来隐藏真实IP地址,避免被网站封禁。

- 处理验证码:使用验证码识别技术自动处理验证码。

- 限制访问频率:设置合理的访问间隔时间,避免过高频率的访问。

- 使用随机延迟:在请求之间添加随机延迟,模拟人类操作。

- 动态解析页面:使用动态解析技术获取动态加载的内容。

- 定期监测网站变化:定期检查网站结构的变化,及时调整爬取策略。

- 遵守robots.txt规范:遵守网站的robots.txt文件中的规定,不访问被禁止的页面。

综上所述,应对反爬虫策略需要综合考虑网站的具体情况和采取合适的应对策略。

十七、性能优化

当涉及性能优化时,代码中的优化通常是特定于应用程序和场景的。下面是一些常见的Python爬虫代码优化技巧示例:

(1)减少不必要的等待时间:避免使用固定的等待时间,而是根据需要进行动态等待。示例代码:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as ECdriver = webdriver.Chrome()

driver.get("<https://example.com>")try:element = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, "myElement")))

finally:driver.quit()(2)合理使用隐式等待:在创建WebDriver实例时设置隐式等待时间,而不是在每个操作中都设置等待时间。示例代码:

from selenium import webdriverdriver = webdriver.Chrome()

driver.implicitly_wait(10) # 设置隐式等待时间为10秒driver.get("<https://example.com>")

element = driver.find_element(By.ID, "myElement")(3)使用多线程/异步处理:使用**concurrent.futures**模块进行异步处理。示例代码:

from concurrent.futures import ThreadPoolExecutor

from selenium import webdriverdef scrape(url):driver = webdriver.Chrome()driver.get(url)# 爬取逻辑driver.quit()urls = ['<https://example.com/page1>', '<https://example.com/page2>', '<https://example.com/page3>']with ThreadPoolExecutor(max_workers=5) as executor:executor.map(scrape, urls)(4)避免重复请求:使用缓存来存储已经爬取过的数据。示例代码:

import requests

import hashlibcache = {}def get_data(url):if url in cache:return cache[url]response = requests.get(url)data = response.textcache[url] = datareturn dataurl = '<https://example.com>'

data = get_data(url)这些示例代码演示了一些常见的Python爬虫代码优化技巧,但实际的优化策略应根据具体的爬虫应用程序和场景进行调整和优化。

十八、定时任务:

要将爬虫任务设置为定时执行,可以使用Python的**schedule库来实现。schedule库可以帮助我们在指定的时间间隔内定期运行任务。以下是一个简单的示例代码,演示如何使用schedule**库来定时执行爬虫任务:

import schedule

import timedef crawl():# 在这里编写爬虫逻辑print("开始爬取数据...")# 每小时执行一次爬虫任务

schedule.every().hour.do(crawl)# 在这里可以设置其他定时任务,如每天、每周等# 保持程序运行,直到手动终止

while True:schedule.run_pending()time.sleep(1)在这个示例中,**crawl函数是我们的爬虫逻辑。使用schedule.every().hour.do(crawl)来设置每小时执行一次爬虫任务。您还可以使用其他schedule.every()**方法来设置其他的定时任务,如每天、每周等。

请注意,为了保持程序持续运行,我们使用了一个**while True循环来不断检查是否有定时任务需要执行,并使用time.sleep(1)**来让程序每秒钟检查一次。这样可以确保定时任务能够按照预期执行。

十九、 与其他库和工具的集成

将Selenium与其他库和工具集成可以实现更强大的功能,比如使用BeautifulSoup解析页面内容、使用pandas处理数据等。以下是一个示例代码,演示了如何将Selenium与BeautifulSoup和pandas集成:

pythonCopy code

from selenium import webdriver

from bs4 import BeautifulSoup

import pandas as pd# 启动浏览器

driver = webdriver.Chrome()# 打开网页

driver.get('<https://example.com>')# 获取页面源码

html = driver.page_source# 使用BeautifulSoup解析页面

soup = BeautifulSoup(html, 'html.parser')# 提取需要的数据

data = []

for item in soup.find_all('div', class_='item'):name = item.find('h2').textprice = item.find('span', class_='price').textdata.append({'name': name, 'price': price})# 将数据转换为DataFrame

df = pd.DataFrame(data)# 关闭浏览器

driver.quit()# 打印数据

print(df)在这个示例中,我们首先使用Selenium打开了一个网页,并获取了页面的源码。然后,我们使用BeautifulSoup解析了页面,并提取了需要的数据。最后,我们使用pandas将数据转换为DataFrame,并进行打印输出。这样,就实现了将Selenium与BeautifulSoup和pandas集成的功能。

好了,今天的学习就到这里了,第二十四天会带来几个案例将上面的知识点运用起来。敬请期待!拜拜啦!

相关文章:

python爬虫------- Selenium下篇(二十三天)

🎈🎈作者主页: 喔的嘛呀🎈🎈 🎈🎈所属专栏:python爬虫学习🎈🎈 ✨✨谢谢大家捧场,祝屏幕前的小伙伴们每天都有好运相伴左右,一定要天天…...

)

获取字符串的全排列(去除字符串中2个字符相同时造成的重复)

一、概念 现有一个字符串,要打印出该字符串中字符的全排列。 以字符串abc为例,输出的结果为:abc、acb、bac、bca、cab、cba。 以字符串aab为例,输出的结果为:aab、aba、baa。 二、代码 public class Permutation {pub…...

HTML5新增的多媒体标签

在网页中加入音乐 <audio></audio> src 设置音乐文件名以及路径,<audio>标记支持MP3、WAV及OGG 3种音乐格式 autoplay:是否自动播放,加入autopaly属性表示自动播放 controls: 是否显示播放面板,加入controls属性表示显示播放面板 …...

温湿度传感器(DHT11)以及光照强度传感器(BH1750)的使用

前言 对于一些单片机类的环境检测或者智能家居小项目中,温湿度传感器(DHT11)以及光照强度传感器(BH1750)往往是必不可少的两个外设,下面我们来剖析这两个外设的原理,以及使用。 1. 温湿度传感…...

ActiveMQ 04 Linux下安装

Active MQ 04 Linux下安装 下载 解压 在init.d下建立软连接 ln -s /usr/local/activemq/bin/activemq ./设置开启启动 chkconfig activemq on 服务管理 service activemq start service activemq status service activemq stopNIO配置 默认配置为tcp,使用的…...

.pyc 文件是什么?是否有必要同步到 GitHub 远程仓库?

git status 时发现有很多 .pyc 的没有被 add (env) username:~/path/to/project$ git status On branch main Your branch is up to date with origin/main.Changes to be committed:(use "git restore --staged <file>..." to unstage)new file: xxx.pyCha…...

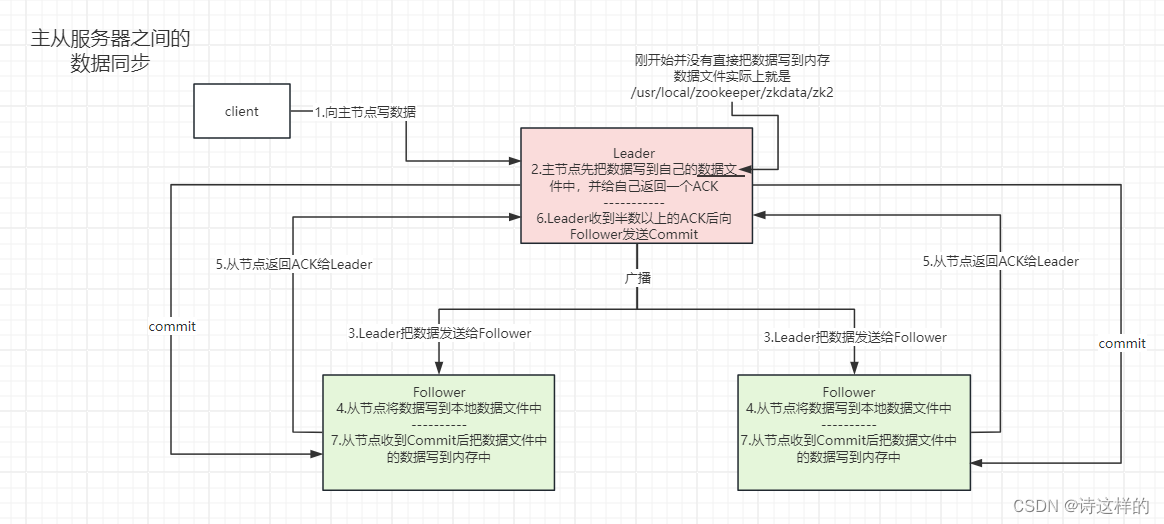

Zookeeper的集群搭建和ZAB协议详解

Zookeeper的集群搭建 1)zk集群中的角色 Zookeeper集群中的节点有三个角色: Leader:处理集群的所有事务请求,集群中只有一个LeaderFollwoer:只能处理读请求,参与Leader选举Observer:只能处理读…...

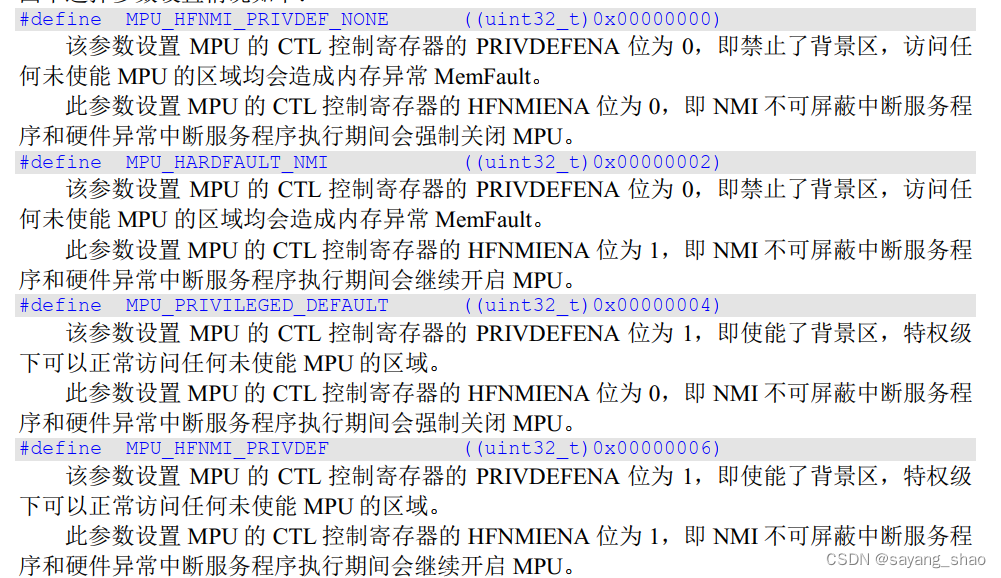

STM32 MPU配置参数

TXE LEVEL一般只用MPU_TEX_LEVEL0 1 - 1 - 1 -0性能最强(TEX - C - B- S). #define MPU_TEX_LEVEL0 ((uint8_t)0x00) #define MPU_TEX_LEVEL1 ((uint8_t)0x01) #define MPU_TEX_LEVEL2 ((uint8_t)0x02) 基于上表进行常用配置 ÿ…...

Kafka概述

目录 1、为什么需要消息队列(MQ) 2、使用消息队列的好处 3、消息队列的两种模式 4、Kafka 定义 5、Kafka 简介 6、Kafka 的特性 7、Kafka 系统架构 8、Partation 数据路由规则 9、分区的原因 1、为什么需要消息队列(MQ) …...

OpenHarmony编译构建系统

这篇来聊聊OpenHarmony的编译构建,经过前面的实践,再来看编译构建。 编译构建概述 在官网中提到了,OpenHarmony编译子系统是以GN和Ninja构建为基座,对构建和配置粒度进行部件化抽象、对内建模块进行功能增强、对业务模块进行功能…...

Qt5 编译oracle数据库驱动

库文件 1、Qt源码目录:D:\Qt5\5.15.2\Src\qtbase\src\plugins\sqldrivers\oci 2、oracle客户端SDK: https://www.oracle.com/database/technologies/instant-client/winx64-64-downloads.html 下载各版本中的如下压缩包,一定要版本相同的 将两个压缩包…...

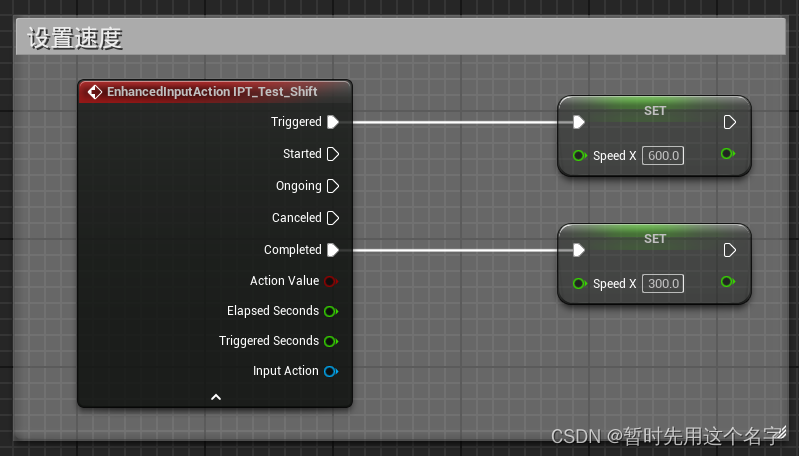

UE5学习日记——实现自定义输入及监听输入,组合出不同的按键输入~

UE5的自定义按键和UE4有所不同,在这里记录一下。 本文主要是记录如何设置UE5的自定义按键,重点是学会原理,实际开发时结合实际情况操作。 输入映射 1. 创建输入操作 输入操作并不是具体的按键映射,而是按键的激活方式࿰…...

为什么把script标签放在div下面?

放在底部可以优先加载页面的内容结构,提升页面渲染速度。只有等到HTML解析完成后,才会开始执行main.js,避免JS阻塞页面解析, 同时main.js里可能会操作DOM,如果放头部,可能会找不到节点而报错 <body><div id"root"><App></App>&l…...

Git 自定义命令

前言 在使用 hexo 搭建个人博客时,共两种部署的方法。分别为: 本地利用 hexo 的插件 hexo-deployer-git 来实现部署,缺点是需要多敲几个命令行且不方便对源码进行云端备份使用 Github Action 的 workflow 自动化部署,优势就是可…...

SpringBoot多数据源配置及使用

1.application.properties数据配置 首先现在配置文件中定义三个数据库相关信息 # 数据库1 targetLibraryMain.datasource.url jdbc:kingbase8://127.0.0.1:54321/DATA_ONE?useUnicodetrue&characterEncodingutf8&serverTimezoneGMT%2B8&allowMultiQueriestrue …...

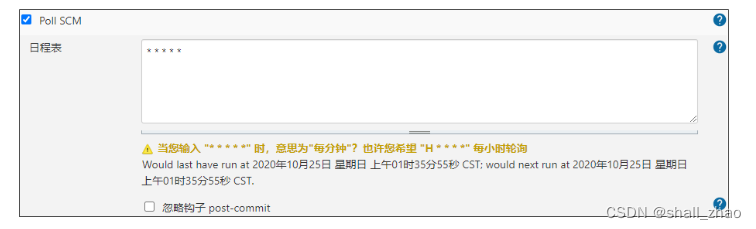

12-项目部署_持续集成

项目部署_持续集成 1 今日内容介绍 1.1 什么是持续集成 持续集成( Continuous integration , 简称 CI )指的是,频繁地(一天多次)将代码集成到主干 持续集成的组成要素 一个自动构建过程, 从…...

文献阅读:LESS: Selecting Influential Data for Targeted Instruction Tuning

文献阅读:LESS: Selecting Influential Data for Targeted Instruction Tuning 1. 文章简介2. 方法介绍 1. Overview2. 原理说明 1. SGD上的定义2. Adam上的定义 3. 具体实现 1. Overview1. LoRA使用2. 数据选择3. LESS-T 3. 实验考察 & 结论 1. 实验设计2. 主…...

应对中年危机-高效学习

兴致勃勃的打开一本书,从第一行,第一个字开始,十分钟later……两眼皮一塌,哎,想睡觉了,真助眠。但其实我并不懒啊。 过去我是上诉这样,现在有了改善。如果你也是这样,希望看完了本文…...

Java二叉树(2)

一、二叉树的链式存储 二叉树的存储分为顺序存储和链式存储 (本文主要讲解链式存储) 二叉树的链式存储是通过一个一个节点引用起来的,常见的表示方式有二叉三叉 // 孩子表示法 class Node { int val; // 数据域 Node left; // 左孩子的引用…...

关于AG32 MCU的一些奇思妙想

1、AG32VF103的网口是100M还是10M? RE: 都是100M的。 2、用FPGA能不能再仿出一个网口?有些产品用到两个网口。 理论上可以,但是要考虑,一个是cpld实现难度,一个是需要的逻辑单元。因为mac逻辑多,内置的2KL…...

浅谈 React Hooks

React Hooks 是 React 16.8 引入的一组 API,用于在函数组件中使用 state 和其他 React 特性(例如生命周期方法、context 等)。Hooks 通过简洁的函数接口,解决了状态与 UI 的高度解耦,通过函数式编程范式实现更灵活 Rea…...

深度学习在微纳光子学中的应用

深度学习在微纳光子学中的主要应用方向 深度学习与微纳光子学的结合主要集中在以下几个方向: 逆向设计 通过神经网络快速预测微纳结构的光学响应,替代传统耗时的数值模拟方法。例如设计超表面、光子晶体等结构。 特征提取与优化 从复杂的光学数据中自…...

C++_核心编程_多态案例二-制作饮品

#include <iostream> #include <string> using namespace std;/*制作饮品的大致流程为:煮水 - 冲泡 - 倒入杯中 - 加入辅料 利用多态技术实现本案例,提供抽象制作饮品基类,提供子类制作咖啡和茶叶*//*基类*/ class AbstractDr…...

详解:相对定位 绝对定位 固定定位)

css的定位(position)详解:相对定位 绝对定位 固定定位

在 CSS 中,元素的定位通过 position 属性控制,共有 5 种定位模式:static(静态定位)、relative(相对定位)、absolute(绝对定位)、fixed(固定定位)和…...

自用)

css3笔记 (1) 自用

outline: none 用于移除元素获得焦点时默认的轮廓线 broder:0 用于移除边框 font-size:0 用于设置字体不显示 list-style: none 消除<li> 标签默认样式 margin: xx auto 版心居中 width:100% 通栏 vertical-align 作用于行内元素 / 表格单元格ÿ…...

python报错No module named ‘tensorflow.keras‘

是由于不同版本的tensorflow下的keras所在的路径不同,结合所安装的tensorflow的目录结构修改from语句即可。 原语句: from tensorflow.keras.layers import Conv1D, MaxPooling1D, LSTM, Dense 修改后: from tensorflow.python.keras.lay…...

2025年渗透测试面试题总结-腾讯[实习]科恩实验室-安全工程师(题目+回答)

安全领域各种资源,学习文档,以及工具分享、前沿信息分享、POC、EXP分享。不定期分享各种好玩的项目及好用的工具,欢迎关注。 目录 腾讯[实习]科恩实验室-安全工程师 一、网络与协议 1. TCP三次握手 2. SYN扫描原理 3. HTTPS证书机制 二…...

腾讯云V3签名

想要接入腾讯云的Api,必然先按其文档计算出所要求的签名。 之前也调用过腾讯云的接口,但总是卡在签名这一步,最后放弃选择SDK,这次终于自己代码实现。 可能腾讯云翻新了接口文档,现在阅读起来,清晰了很多&…...

华为OD机试-最短木板长度-二分法(A卷,100分)

此题是一个最大化最小值的典型例题, 因为搜索范围是有界的,上界最大木板长度补充的全部木料长度,下界最小木板长度; 即left0,right10^6; 我们可以设置一个候选值x(mid),将木板的长度全部都补充到x,如果成功…...

全面解析数据库:从基础概念到前沿应用

在数字化时代,数据已成为企业和社会发展的核心资产,而数据库作为存储、管理和处理数据的关键工具,在各个领域发挥着举足轻重的作用。从电商平台的商品信息管理,到社交网络的用户数据存储,再到金融行业的交易记录处理&a…...