大数据面试题之HDFS

目录

HDFS文件写入和读取流程

HDFS组成架构

介绍下HDFS,说下HDFS优缺点,以及使用场景

HDFS作用

HDFS的容错机制

HDFS的存储机制

HDFS的副本机制

HDFS的常见数据格式,列式存储格式和行存储格式异同点,列式存储优点有哪些?

HDFS如何保证数据不丢失?

HDFS NameNode高可用如何实现?需要哪些角色?

HDFS的文件结构?

HDFS的默认副本数?为什么是这个数量?如果想修改副本数怎么修改?

介绍下HDFS的Block

HDFS的块默认大小,64M和128M是在哪个版本更换的?怎么修改默认块大小?

HDFS的block为什么是128M?增大或减小有什么影响?

HDFS HA怎么实现?是个什么架构?

导入大文件到HDFS时如何自定义分片?

HDFS的mapper和reducer的个数如何确定?reducer的个数依据是什么?

HDSF通过那个中间组件去存储数据

HDFS跨节点怎么进行数据迁移

HDFS的数据-致性靠什么保证?

HDFS怎么保证数据安全

HDFS中向DataNode写数据失败了怎么办

Hadoop2.xHDFS快照

HDFS文件存储的方式?

HDFS写数据过程,写的过程中有哪些故障,分别会怎么处理?

NameNode存数据吗?

使用NameNode的好处

HDFS中DataNode怎么存储数据的

直接将数据文件上传到HDFS的表目录中,如何在表中查询到该数据?

HDFS文件写入和读取流程

HDFS(Hadoop Distributed File System)的文件写入和读取流程如下:文件写入流程:

客户端请求:客户端通过Distributed FileSystem API向NameNode发出文件写入请求。

权限检查与元数据更新:NameNode检查文件是否已存在以及目标目录的权限,如果一切正常,

则创建新文件的记录,并返回给客户端一个唯一的文件标识符以及数据块的存储策略。

数据块分配:客户端请求第一个数据块的存储位置,NameNode根据数据块的复制策略(默认为3副本)

选择合适的DataNode(考虑机架感知策略),并将这些DataNode的位置信息返回给客户端。

Pipeline(管道)写入:客户端按照DataNode列表的顺序,建立一个数据写入的pipeline。

客户端首先将数据写入第一个DataNode(DN1),DN1收到数据后,立即转发给第二个DataNode(DN2),

DN2再转发给第三个DataNode(DN3),形成一个数据流动的管道,每个DN节点在接收到数据后都会进行校验并存储。

数据包传输与确认:客户端将数据切分成多个Packet(数据包)进行传输,每个Packet在pipeline中流动时,

DN节点会向客户端发送ACK确认信息。客户端收到所有DN的ACK后,才会继续发送下一个Packet。

写入完成:当所有数据块都按照这种方式写入完成后,客户端向NameNode报告写入完成,NameNode更新元数

据,标记文件写入结束。

文件读取流程:

打开文件:客户端通过Distributed FileSystem API向NameNode发起读取文件的请求,提供文件路径。

元数据获取:NameNode根据文件路径查找元数据,验证文件是否存在及客户端是否有权限读取,并返回该文件所

有数据块的位置信息。

数据块定位:客户端根据DataNode列表选择最近或最合适的DataNode开始读取数据块(考虑数据的局部性)。

数据读取:客户端直接与DataNode建立连接,逐个读取数据块。如果数据块的副本分布在不同的节点上,客户端

可以根据网络状况选择最优的副本进行读取,以优化读取性能。

数据合并:对于大文件,客户端可能需要从多个DataNode读取不同的数据块,并在客户端侧将这些数据块合并,

以还原完整的文件内容。

读取完成:一旦所有数据块都被成功读取,客户端完成文件读取操作。

这两个流程体现了HDFS在分布式环境下如何高效地存储和检索数据,确保数据的可靠性和高效性。HDFS组成架构

HDFS(Hadoop Distributed File System)的组成架构主要由四个核心部分组成,它们分别是:HDFS Client(客户端):

负责进行文件切分。当文件上传到HDFS时,Client会将文件切分成多个Block(数据块)进行存储。

与NameNode交互,获取文件的位置信息。

与DataNode交互,读取或写入数据。

提供命令来管理HDFS,如启动或关闭HDFS。

可以通过命令访问HDFS。

NameNode(名称节点):

作为Master节点,管理HDFS的名称空间(文件目录树)。用户看到的目录结构与Window和Linux文件系统类似。

管理数据块(Block)映射信息及副本信息。包括每个文件对应的块的名字、块被存储在哪里,以及每个文件的备份数量。

处理客户端的读写请求。

DataNode(数据节点):

作为Slave节点,实际存储数据块。

根据NameNode的命令执行数据块的读/写操作。

Secondary NameNode(辅助名称节点):

并非NameNode的热备,当NameNode故障时,它不能立即替换NameNode并提供服务。

辅助NameNode分担其工作量。

定期合并FsImage和Edits,并推送给NameNode。

在紧急情况下,可辅助恢复NameNode。

HDFS是一个高度容错性的系统,设计用来部署在低廉的硬件上,并提供高吞吐量的数据访问,非常适合大规模数

据集上的应用。其采用了主从(Master/Slave)结构模型,一个HDFS集群由一个NameNode和若干个DataNode组成。此外,HDFS放宽了POSIX的约束,以实现流式读取文件系统数据的目的。在HDFS中,文件的存储是以Block为单位进行的,每个Block的大小通常是固定的(如128MB)。当一个文件被上

传到HDFS时,Client会将其切分成多个Block,并将这些Block存储到不同的DataNode上。NameNode负责维

护文件与Block之间的映射关系,以便客户端能够准确地找到所需的数据。介绍下HDFS,说下HDFS优缺点,以及使用场景

Hadoop分布式文件系统(HDFS, Hadoop Distributed File System)是Apache Hadoop项目的核心组件

之一,专为大规模数据集上的应用设计。HDFS能够运行在通用硬件之上,提供高容错性、高吞吐量的数据访问能

力,特别适合处理和存储PB级别的大数据集。下面是HDFS的详细介绍以及它的优缺点和典型使用场景:HDFS简介

HDFS采用了主从架构,核心包括两个主要组件:NameNode和DataNode。NameNode负责管理文件系统的命名空

间和存储块的映射关系,而DataNode则负责实际存储数据块。数据在HDFS中被切分为固定大小的数据块,默认为

128MB或256MB,并且每个数据块会在不同的DataNode上保存多个副本(通常为3份),以此来提高数据的可靠性

和容错能力。HDFS的优点

高容错性:通过在不同节点上保存数据块的多个副本,HDFS能自动检测和恢复数据丢失,确保数据安全。

扩展性:HDFS设计支持水平扩展,可以通过增加更多的节点来线性增加存储容量和计算能力。

成本效益:Hadoop并不依赖昂贵的硬件设备,可以运行在低成本的商用硬件上,降低了总体拥有成本。

高性能:针对大数据集进行了优化,提供高吞吐量的数据访问,尤其适合流式读取。

适合大数据处理:能够高效处理GB到PB级别的数据集,支持百万级别以上的文件数量和大规模的节点集群。

HDFS的缺点

延迟问题:HDFS优化了大数据的批量处理,但对于低延迟数据访问和实时处理能力有限。

小文件问题:处理大量小文件时效率较低,会增加NameNode的元数据管理压力,且可能导致存储空间利用率下降。

单点故障:尽管可以通过设置备份NameNode来缓解,但NameNode仍是潜在的单点故障源。

不适合随机读写:HDFS更适合顺序读写,对于频繁的随机读写操作性能不佳。

使用场景

大规模数据存储:适用于存储和管理海量数据,如互联网公司的日志文件、图像和视频等。

大数据处理分析:与Hadoop生态系统中的MapReduce、Spark等工具集成,进行离线数据分析、数据挖掘和机器学习任务。

备份与归档:作为数据备份和长期归档的存储平台,利用其高容错性和低成本优势。

内容分发网络:支持流媒体服务,如视频点播、在线音乐服务等,通过HDFS高效存储和分发大文件内容。

综上,HDFS是大数据处理领域中不可或缺的基础组件,特别适用于需要处理和分析大规模数据集的场景,但也需要根据具体需求权衡其优缺点,合理选择和配置。HDFS作用

HDFS(Hadoop 分布式文件系统)具有以下重要作用:

大规模数据存储:能够存储海量的数据,PB 级甚至 EB 级的数据规模都可以应对。

高容错性:通过数据冗余备份(通常默认是 3 份),即使某些节点出现故障,数据仍然可用,保证了系统的可靠

性。

分布式处理支持:与 Hadoop 的计算框架(如 MapReduce)紧密结合,为大规模数据的并行处理提供数据存储

基础。

成本效益:可以利用普通的商用服务器构建大规模存储集群,降低了硬件成本。

顺序访问优化:对于大规模数据的顺序读取和写入进行了优化,适用于数据批处理等场景。

数据一致性保障:保证了数据在整个集群中的一致性,确保各个节点看到的数据是相同的。

横向扩展:能够轻松地通过添加新的节点来扩展存储容量和计算能力,而无需停机。

总之,HDFS 为大数据处理提供了可靠、高效、可扩展的数据存储解决方案。HDFS的容错机制

Hadoop Distributed File System (HDFS) 的容错机制是其能够在分布式环境中可靠存储数据的关键特

性。以下是HDFS容错机制的主要组成部分:数据副本(Replication):HDFS通过在整个集群中的不同节点上复制数据块来实现容错。默认情况下,每个数

据块会被复制三次,存储在不同的节点上,包括一个本地节点和两个远程节点(通常位于不同的机架上)。这样,

即使某个节点或机架发生故障,数据依然可以从其他副本中恢复。

故障检测机制:HDFS通过心跳机制来监控数据节点(DataNodes)的状态。每个数据节点定期向名称节点

(NameNode)发送心跳信号,报告其健康状况和数据块信息。如果NameNode在预定时间内未收到某个节点的心

跳信号,它会标记该节点为宕机。

心跳信息和数据块报告:心跳信号除了包含存活证明外,还会携带该节点存储的数据块信息,帮助NameNode维护

整个文件系统的元数据准确性。

读写容错:在读取数据时,如果请求的数据块副本所在的节点不可用,客户端会自动尝试从其他副本所在的节点读

取数据。写入数据时,HDFS确保数据至少被写入一个副本后才确认写操作成功,保证数据的持久化。

数据节点(DN)失效处理:当检测到数据节点故障后,NameNode会启动数据恢复过程,重新复制丢失的副本到健

康的节点上,以确保数据块的预定副本数。

容错目录:虽然不是HDFS标准术语,但HDFS确实维护了一个元数据目录,跟踪数据块及其副本的位置信息,这有

助于在节点故障时迅速定位并访问数据的其他副本。

数据恢复:HDFS会自动检测数据块的完整性和一致性,如果发现某个副本损坏或不一致,系统会根据其他健康副

本重新复制该数据块,确保数据的完整性。

通过这些机制,HDFS能够有效应对节点故障、网络中断等常见问题,保证数据的高可用性和可靠性,是处理和存

储大规模数据集的理想选择。HDFS的存储机制

HDFS的存储机制主要基于其分布式文件系统的设计原理,以下是HDFS存储机制的关键点:文件切割与存储块(Block):

HDFS对要存储的大文件进行切割,切割后的文件片段存放在存储块(Block)中。

Block是HDFS的基本存储单元,默认大小是64MB(这个大小可以根据集群的特性和需求进行配置)。

集群组成与节点角色:

一个HDFS集群由两类节点组成:NameNode和DataNode。

NameNode是集群的管理者(Master),它负责维护HDFS中全部的文件及内容数据的元数据,如文件的目录结

构、文件和块的映射关系等,并处理来自客户端的文件访问请求。

DataNode是集群的工作者(Slave),它们存储实际的文件数据块。HDFS集群中可以有多个DataNode,它们以

分布式的方式存储数据,提供数据的高可靠性和高可用性。

副本机制:

为了提高数据的可靠性和容错性,HDFS会对每个数据块进行多副本备份。

默认情况下,每个数据块至少会被复制到3个不同的DataNode上,这样即使某个DataNode出现故障,也不会导致

数据丢失。

数据读写流程:

读取数据时,客户端会向NameNode请求文件的数据块位置信息,然后根据这些信息直接从DataNode上读取数

据。

写入数据时,客户端会先将数据写入一个本地文件,然后请求NameNode分配数据块,并将数据块写入到指定的

DataNode上。当数据块写入完成后,客户端会通知NameNode更新元数据。

容错与恢复:

当DataNode出现故障时,HDFS会自动进行容错处理,从其他健康的DataNode上读取副本数据,以保证数据的可

用性。

同时,HDFS还提供了数据恢复机制,如通过Secondary NameNode定期合并FsImage和Edits文件,以防止

NameNode单点故障导致的数据丢失。

存储类型与策略:

从Hadoop 2.6开始,HDFS支持异构存储,允许在DataNode上使用不同类型的存储介质(如RAM_DISK、SSD、

DISK等),以提高存储性能和降低成本。

用户可以根据数据的访问模式和存储需求,选择合适的存储类型和存储策略。

优化性能:

为了提高数据传输和存储性能,用户可以调整HDFS的配置参数,如块大小、副本数量、心跳间隔等。

使用更高效的网络和硬件设备、数据压缩、数据本地化等技术也可以进一步优化HDFS的性能。

总结来说,HDFS的存储机制通过文件切割、分布式存储、多副本备份等技术手段,实现了对大规模数据集的高效、可靠、容错的存储和管理。同时,通过灵活的配置和优化手段,用户可以根据实际需求调整HDFS的性能和存

储策略。HDFS的副本机制

Hadoop Distributed File System (HDFS) 的副本机制是为了保证数据的可靠性和高可用性而设计的。以

下是HDFS副本机制的关键特点和工作流程:默认副本数:HDFS默认为每个数据块(Block)创建三个副本。这个副本数量可以通过配置参数dfs.replication在hdfs-site.xml中进行调整。

副本放置策略:

第一个副本:首选存储在客户端正在上传数据的DataNode上,如果客户端不在集群内,则随机选择一个磁盘不太

忙、CPU使用率不高且有足够空间的节点。

第二个副本:放置在与第一个副本不同的机架上的DataNode上,以确保数据在物理上分散,减少机架故障带来的

风险。

第三个副本:通常放置在第二个副本所在的机架上的另一个DataNode上,进一步平衡数据分布,同时保持跨机架

冗余。

额外副本:如果有更多的副本需求(超过三个),后续副本的放置则随机选择节点,可能位于任何机架。

机架感知:HDFS实现了机架感知功能,要求管理员在配置时指定每个DataNode所属的机架信息,以便系统在放置

副本时做出更智能的决策,优化数据分布和故障恢复速度。

动态复制:虽然原始的HDFS副本放置是在文件写入时确定的,但现代HDFS支持动态复制,这意味着在文件写入

后,副本的数量和位置可以根据集群的实际情况(如新节点加入、节点故障等)动态调整。

副本管理:NameNode负责维护所有数据块及其副本的元数据信息,监控DataNode状态,并在检测到副本丢失或

DataNode故障时,触发副本的重新复制,确保数据的完整性。

通过这种精心设计的副本机制,HDFS能够有效地处理硬件故障,提供高可用性和数据持久性,确保即使在部分硬

件失效的情况下,数据仍然可以快速访问和恢复。HDFS的常见数据格式,列式存储格式和行存储格式异同点,列式存储优点有哪些?

HDFS支持多种数据格式,以下是一些常见的数据格式:SequenceFile:一种二进制格式,存储键值对,适合结构简单的数据,如日志文件。

Avro文件:提供了一种数据序列化格式,支持数据模式演化,适用于存储半结构化数据。

Parquet文件:列式存储格式,适用于大量结构化数据,支持高效压缩和列式存储,提升查询性能。

ORC文件:列式存储格式,与Parquet类似,但在某些场景下性能更佳,特别针对Hive优化。

TextFile:简单的文本文件格式,适合存储文本数据,但不适用于大规模数据查询。

RCFile:行列混合存储格式,数据按行分块,每块内部按列存储,适用于Hive,结合了行存储和列存储的优点。行存储格式与列存储格式的异同点:相同点:都是数据存储的方式,用于在HDFS上组织和保存数据。

不同点:

数据组织:行存储将一条记录的所有字段连续存放,适合事务处理和随机访问;列存储则将同一列的数据聚集存

放,适合分析查询。

读取效率:行存储适合读取整个记录,而列存储允许仅读取查询所涉及的列,减少I/O,提高分析查询效率。

压缩效率:列存储因数据类型相同,易于高效压缩,节省存储空间。

更新效率:行存储对记录的更新更为高效,列存储对列数据的批量更新更优。

适用场景:行存储常用于事务型数据库(如MySQL),列存储更适合数据仓库和分析系统(如Hive、Impala)。列式存储的优点:高效查询:只需读取相关列,减少I/O操作,显著提升查询速度,特别是在处理大数据分析任务时。

高压缩比:由于同一列数据类型相同,可以使用更高效的列级压缩算法,减少存储空间需求。

优化数据扫描:对于只涉及少数几列的查询,列式存储可以避免全表扫描,提高处理效率。

更适合统计分析:列式存储天然适合聚合操作,比如SUM、AVG等,因为数据已经按列排列。

减少内存占用:在处理大规模数据时,只加载需要的列到内存,可以有效降低内存使用。HDFS如何保证数据不丢失?

HDFS通过一系列机制来确保数据的可靠性和不丢失,以下是HDFS保证数据不丢失的主要方法:数据冗余(数据备份):HDFS将数据分块存储在多个节点上,并在每个块上创建多个副本。默认情况下,每个数据块会有3个副本(但这一

数字可以根据集群的特性和需求进行配置)。

即使某个节点发生故障,数据仍然可以从其他节点的副本中恢复,从而确保数据的可靠性和可用性。容错目录:HDFS具有称为容错目录的特殊目录,保存有关数据块副本的信息。

如果一个数据节点故障,HDFS将使用容错目录中的信息找到该数据块的其他副本,并将其复制到新的数据节点

上。心跳检测:HDFS中的数据节点(DataNode)会定期向主节点(NameNode)发送心跳信号,以表示其存活状态。

如果主节点没有收到某个数据节点的心跳信号,则认为该数据节点已经故障,并将其标记为不可用。随后,

NameNode会触发数据恢复过程,将数据块的副本复制到其他健康的数据节点上。数据恢复:当某个节点上的数据块丢失或损坏时,HDFS会自动启动数据恢复过程。

该过程将丢失的数据块副本复制到其他数据节点上,以确保数据的完整性。数据完整性检查:HDFS提供了数据完整性检查工具,如fsck命令,可以用来检查数据块的完整性,并修复损坏的数据块。自动故障恢复:HDFS监控节点的健康状态,并在发现节点故障时自动将数据块复制到其他节点上,以实现数据的动态平衡和故障恢复。副本重平衡:HDFS会定期检查每个计算节点上的数据块数量,如果某个节点上的数据块数量偏多或偏少,会触发副本重平衡操

作。

副本重平衡会将数据块从数量过多的节点移动到数量过少的节点上,以平衡整个集群的负载和数据分布,进一步提

高数据的可靠性和可用性。

通过上述机制,HDFS能够在分布式环境中有效地保证数据的不丢失,并支持大数据处理和存储的需求。HDFS NameNode高可用如何实现?需要哪些角色?

Hadoop Distributed File System (HDFS) 的 NameNode 高可用性(High Availability, HA)机

制旨在解决单点故障问题,确保即使主 NameNode 出现故障,HDFS 也能继续运行。HDFS NameNode 的高可

用实现主要依赖以下几个关键角色和技术组件:活动 NameNode (Active NameNode):任何时候,集群中只有一个活动的 NameNode 负责处理客户端的读写

请求,维护文件系统的命名空间信息,并处理文件系统的元数据更新。

备用 NameNode (Standby NameNode):与活动 NameNode 并存,保持与活动 NameNode 的元数据同步。

当活动 NameNode 故障时,备用 NameNode 能够快速接管成为新的活动 NameNode,从而最小化服务中断时

间。

ZooKeeper Failover Controller (ZKFC):每个 NameNode 节点上运行一个 ZKFC 进程,它与

ZooKeeper 集群通信,负责监控 NameNode 的健康状态,并在检测到主 NameNode 故障时,通过

ZooKeeper 协调 NameNode 的故障转移。

共享存储系统:用于保存 NameNode 的元数据,确保 Active 和 Standby NameNode 之间的元数据同步。

常见的共享存储实现包括 Quorum Journal Manager (QJM) 或者基于 NFS/BookKeeper 的共享存储。

QJM 使用一组称为 JournalNodes 的守护进程来存储和管理 EditLog,确保元数据的一致性。

Fencing 机制:在故障转移过程中,为了防止脑裂情况(即两个 NameNode 同时认为自己是 Active),会实

施隔离(Fencing)措施,确保只有一个是真正的活动 NameNode。这通常通过网络隔离、存储锁定或其他机制

实现。实现步骤大致如下:配置共享存储:设置JournalNodes,确保EditLog能被两个NameNode访问和同步。

部署ZooKeeper集群:ZooKeeper用于协调故障转移和管理主备状态。

配置ZKFC:在每个NameNode上安装并配置ZooKeeper Failover Controller。

配置NameNode HA:在Hadoop配置文件中设置NameNode的HA模式,指定Active和Standby NameNode的地

址,以及它们对应的ZKFC信息。

测试故障转移:通过模拟故障或手动触发故障转移,验证HA机制是否生效。

通过上述组件和机制的协同工作,HDFS NameNode的高可用性得以实现,大大提高了整个Hadoop集群的稳定性

和可靠性。HDFS的文件结构?

HDFS的文件结构主要基于其分布式文件系统的设计,以下是对HDFS文件结构的清晰描述:1. 文件切分与存储块(Block)

HDFS将大文件切分成固定大小的块(Block)进行存储。

默认情况下,每个Block的大小是64MB(这个大小可以根据集群的特性和需求进行配置)。2. 命名空间(Namespace)

HDFS的命名空间类似于Unix文件系统的树形结构,每个节点代表一个文件或目录。

通过命名空间,用户可以快速地查找和访问HDFS中的文件和目录。3. 集群组成与节点角色

NameNode:

是集群的管理者(Master),负责维护HDFS中全部的文件及内容数据的元数据。

存储了文件的目录结构、文件和块的映射关系等信息。

是访问HDFS的唯一入口。

DataNode:

是集群的工作者(Slave),负责存储实际的文件数据块。

每个DataNode可以存储多个Block,并且Block可以分布在不同的DataNode上。4. 副本机制

为了提高数据的可靠性和容错性,HDFS会对每个数据块进行多副本备份。

默认情况下,每个数据块至少会有3个副本(但这一数字可以根据集群的特性和需求进行配置)。5. 文件访问流程

当客户端需要访问HDFS中的文件时,它会向NameNode请求文件的元数据。

NameNode返回文件的Block位置信息给客户端。

客户端根据这些信息直接从DataNode上读取数据。6. 文件操作

HDFS支持常见的文件操作,如创建、读取、写入、删除等。

但需要注意的是,HDFS被设计成适合批量处理的,而不是用户交互式的。重点是在数据吞吐量,而不是数据访问

的反应时间。7. 元数据管理

NameNode维护和管理文件系统元数据,包括名称空间目录树结构、文件和块的位置信息、访问权限等信息。

NameNode内部通过内存和磁盘文件两种方式管理元数据。磁盘上的元数据文件包括fsimage(内存元数据镜像文

件)和edits log(编辑日志)。8. 索引机制

HDFS中使用了索引来加速数据块的查找和读取。

主要有两种类型的索引:命名空间索引和块索引。这些索引可以帮助HDFS快速定位到所需的数据块或命名空间。综上所述,HDFS的文件结构是基于分布式文件系统的设计原理,通过文件切分、命名空间、节点角色、副本机制、文件访问流程、文件操作、元数据管理和索引机制等多个方面来确保数据的高效、可靠和容错存储。HDFS的默认副本数?为什么是这个数量?如果想修改副本数怎么修改?

HDFS(Hadoop Distributed File System)的默认副本数是3。这个数量的选择是基于几个关键因素:可靠性:通过在不同节点上存储三个副本,即使在一个或两个节点发生故障的情况下,数据仍然可用。这确保了高

数据持久性和可靠性。

性能:其中一个副本会被存储在本地机架的节点上,另一个在同一机架的不同节点上,第三个副本则存储在不同机

架的节点上。这样的策略既减少了机架间的数据传输,提高了写操作的效率,又能在读取数据时利用本地或机架内

副本,加快读取速度。

成本与效益平衡:虽然更多的副本会增加数据的可靠性,但也会增加存储成本和网络带宽的使用。3个副本被认为

是在可靠性和成本之间的合理折衷。

如果你想修改HDFS的默认副本数,可以通过以下步骤进行:编辑配置文件:修改Hadoop配置文件hdfs-site.xml中的dfs.replication参数。例如,要将副本数改为2,

可以添加或修改如下配置行:<property><name>dfs.replication</name><value>2</value>

</property>重启HDFS服务:保存配置更改后,需要重启HDFS相关的服务(通常是NameNode和DataNodes)以使配置生效。验证修改:可以使用命令hdfs dfsadmin -report查看HDFS的配置信息,确认副本数已更改。另外,通过上传

一个新文件到HDFS并使用hdfs fsck /path/to/yourfile -files -blocks检查文件的副本数,也是验证

修改是否生效的好方法。

请注意,修改副本数需要权衡存储资源的使用、数据可靠性及系统性能,应根据实际的集群规模和业务需求谨慎调

整。介绍下HDFS的Block

HDFS(Hadoop Distributed File System)的Block是HDFS中数据存储的基本单元。以下是关于HDFS Block的详细介绍:1. Block的概念

HDFS将大文件切分成多个固定大小的块(Block)进行存储。每个Block是一个独立的存储单元,可以在HDFS集

群的不同DataNode之间进行复制和移动。2. Block的大小

默认情况下,HDFS Block的大小是128MB(在Hadoop 2.x及更高版本中)。然而,这个大小可以根据集群的特

性、存储需求和性能要求进行配置。选择较大的Block大小可以减少NameNode上元数据的大小,因为每个文件只需要存储少量的Block信息。同时,

较大的Block大小也可以减少客户端与NameNode之间的交互次数,提高性能。3. Block的副本

为了确保数据的可靠性和容错性,HDFS会对每个Block进行多副本备份。默认情况下,每个Block会有3个副本,

但这一数字可以根据集群的特性和需求进行配置。

这些副本会分布在HDFS集群的不同DataNode上,以确保在部分节点故障时数据仍然可用。4. Block的寻址

当客户端需要读取或写入数据时,它会首先与NameNode进行交互,获取所需数据的Block位置信息。

NameNode会返回包含所需数据的Block的DataNode列表给客户端。

客户端然后根据这些信息直接从DataNode上读取或写入数据。5. Block的替换和恢复

如果某个DataNode上的Block损坏或丢失,HDFS会自动从其他健康的DataNode上的副本中复制一个新的Block

到该DataNode上,以确保数据的完整性和可靠性。

当DataNode出现故障时,HDFS也会自动进行容错处理,从其他健康的DataNode上读取副本数据,并将数据块复

制到新的DataNode上。6. Block的存储和读取

在HDFS中,数据是以Block为单位进行存储和读取的。客户端在读取数据时,会按照Block为单位从DataNode上

读取数据,并在本地进行缓存以提高读取性能。

当客户端写入数据时,HDFS会先将数据写入本地文件系统的一个临时文件中,并在数据写入完成后通知NameNode。NameNode会分配Block的位置信息给客户端,并将数据块复制到指定的DataNode上。7. Block与文件的关系

在HDFS中,一个文件由一个或多个Block组成。文件的大小可能小于或等于一个Block的大小,也可能大于一个

Block的大小。如果文件的大小小于Block的大小,那么该文件只会占用一个Block的部分空间。如果文件的大小

大于一个Block的大小,那么该文件会被切分成多个Block进行存储。总结

HDFS的Block是HDFS中数据存储的基本单元,通过切分大文件为多个固定大小的Block,并在不同的DataNode

上进行复制和移动,HDFS实现了对大规模数据集的高效、可靠和容错存储。同时,通过多副本机制、自动容错处

理和Block的寻址等机制,HDFS确保了数据的可靠性和可用性。HDFS的块默认大小,64M和128M是在哪个版本更换的?怎么修改默认块大小?

HDFS的块默认大小从64MB更换到128MB发生在Apache Hadoop的2.x版本中。具体来说,在Hadoop 2.3版本

时,这一改变被引入以更好地适应大数据处理的需求,提高大规模数据处理的效率。如果你想修改HDFS的默认块大小,可以通过以下步骤操作:编辑配置文件:打开Hadoop的配置文件hdfs-site.xml。

修改配置参数:在hdfs-site.xml中找到或添加如下配置行,设置你希望的块大小。例如,如果你想将块大小设

置为256MB,可以这样配置:<property><name>dfs.blocksize</name><value>268435456</value> <!-- 256MB in bytes -->

</property>保存并关闭文件:保存对hdfs-site.xml所做的修改。

重启Hadoop服务:为了使更改生效,你需要重启HDFS相关的服务,主要是NameNode和DataNodes。

请注意,这个修改只会影响之后写入HDFS的新文件,已存在的文件的块大小不会因此改变。此外,调整块大小是

一个重要的决策,因为它影响存储效率、I/O性能以及内存使用等因素,应当根据你的具体工作负载和硬件环境仔

细考虑。HDFS的block为什么是128M?增大或减小有什么影响?

HDFS的block设置为128M是综合考虑了性能、存储效率和可靠性等多方面的因素。以下是关于为什么HDFS的

block大小设置为128M以及增大或减小block大小可能带来的影响的详细解释:为什么设置为128M性能和存储效率:

HDFS的平均寻址时间大约为10ms。当寻址时间为传输时间的1%时,被认为是最佳状态。假设磁盘的传输速率为

100MB/s,那么最佳传输时间为1s。因此,最佳block大小应为100MB/s * 1s = 100MB。然而,为了保持一

定的灵活性,实际中常选择略大于100MB的值,即128MB。较大的block大小可以减少HDFS的元数据开销。每个block都有一个元数据,包括块的大小、块的位置等信息。

当HDFS中有大量的小块时,元数据的数量会非常庞大,这会导致HDFS的元数据管理成为一个瓶颈。而较大的

block大小可以减少元数据的数量,从而提高HDFS的性能。较大的block大小可以提高数据传输效率。在HDFS中,数据是以block为单位进行传输的。当block的大小较小

时,数据传输的效率会受到限制,因为每个block都需要进行一次网络传输。而当block的大小较大时,数据传输

的效率会得到提高,因为每个block可以进行多次网络传输,从而充分利用网络带宽。可靠性:

较大的block大小可以减少数据块的数量,从而减少数据块的复制次数。在HDFS中,为了保证数据的可靠性,每

个数据块都会进行多次复制。当block的大小较小时,数据块的数量会非常庞大,这会导致数据块的复制次数也非

常多,从而增加了HDFS的存储开销。而当block的大小较大时,数据块的数量会减少,从而减少了数据块的复制

次数,降低了HDFS的存储开销。增大或减小block大小的影响增大block大小:

优点:

减少NameNode的元数据开销,提高性能。

提高数据传输效率,充分利用网络带宽。

减少数据块的复制次数,降低存储开销。

缺点:

如果block过大,MapReduce中的map任务处理时间会增加,因为map任务通常一次只处理一个block中的数据。

如果block过大,可能会导致数据传输时间变长,影响程序的处理速度。减小block大小:

优点:

对于小文件存储更为灵活,可以减少空间浪费。

对于某些特定的应用,如实时分析,可能需要更小的block大小来支持更细粒度的数据处理。

缺点:

会导致NameNode中的元数据数量激增,增加了元数据管理的负担,可能导致性能下降。

每个block都需要进行一次网络传输,小block可能导致数据传输效率降低,无法充分利用网络带宽。

数据块的复制次数增加,增加了存储开销。综上所述,HDFS的block大小设置为128M是权衡了性能、存储效率和可靠性等因素的结果。在实际应用中,可以

根据集群的特性、存储需求和性能要求来选择合适的block大小。HDFS HA怎么实现?是个什么架构?

HDFS HA(High Availability)通过一种特殊的设计架构来实现,其主要目标是确保在NameNode(HDFS的

主节点)出现故障时,文件系统仍然能够继续提供服务。以下是HDFS HA的实现方式和架构的详细介绍:实现方式双NameNode架构:HDFS HA使用两个NameNode实例,一个处于Active状态(Active NameNode),另一个处于Standby状态

(Standby NameNode)。

Active NameNode处理文件系统的所有写操作和读请求,而Standby NameNode则处于备用状态,不对外提供

服务,仅同步Active NameNode的状态。共享存储系统:

HDFS HA使用了共享的编辑日志(Edit Log)和镜像(Image)文件来保持Active NameNode和Standby

NameNode之间的状态同步。

Edit Log记录了对文件系统的所有变更操作,而Image文件则包含了文件系统的当前状态。ZooKeeper协调服务:

ZooKeeper是一个分布式协调服务,用于协调Active NameNode和Standby NameNode之间的状态切换。

在HDFS HA中,ZooKeeper确保只有一个NameNode处于Active状态,并在发生故障时自动触发状态切换。架构组成

NameNode:

Active NameNode:处理文件系统的读写请求,并维护文件系统的元数据。

Standby NameNode:实时同步Active NameNode的状态,并在Active NameNode故障时接管其角色。

共享存储系统:

包含了Edit Log和Image文件,用于同步两个NameNode的状态。

ZooKeeper集群:

提供主备选举支持,确保只有一个NameNode处于Active状态。

在NameNode故障时,自动触发状态切换。

DataNode:

负责存储实际的数据块,并向NameNode报告数据块的位置信息。

DataNode会同时向Active NameNode和Standby NameNode上报数据块的位置信息,以便在故障切换后能够

迅速恢复服务。

ZKFailoverController(ZKFC):

作为独立的进程运行,对NameNode的主备切换进行总体控制。

能够及时检测到NameNode的健康状况,并在主NameNode故障时借助ZooKeeper实现自动的主备选举和切换。总结

HDFS HA通过使用双NameNode架构、共享存储系统和ZooKeeper协调服务来实现文件系统的高可用性。当

Active NameNode出现故障时,Standby NameNode能够迅速接管其角色,确保文件系统能够继续提供服务。

这种架构的设计充分考虑了数据的可靠性、可用性和容错性,使得HDFS能够在大规模分布式环境中稳定运行。导入大文件到HDFS时如何自定义分片?

在导入大文件到Hadoop Distributed File System (HDFS) 时,自定义分片(或者称为数据块大小)可以

通过编程方式实现,而不是直接修改HDFS的默认块大小配置。这是因为HDFS的块大小是在文件写入时由系统自动

处理的,而不是在文件上传过程中由用户直接控制每个文件的具体分片。但是,你可以通过编写自定义的上传程序

来实现按需分片上传大文件。以下是基本的步骤和概念:使用Hadoop API自定义分片上传

引入依赖:首先,确保你的项目中包含了必要的Hadoop客户端库,例如hadoop-client。

创建HDFS客户端:使用Configuration对象配置HDFS连接参数,然后创建一个FileSystem实例来与HDFS交

互。Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);定义分片逻辑:在上传文件之前,你需要决定如何将文件切分为多个片段。这通常涉及到读取本地文件,然后按你

设定的大小将其分割成多个部分。你可以使用FileInputStream读取文件,然后使用FileChannel或

ByteArrayOutputStream等工具按指定大小读取数据块。

逐分片上传:对于每个分片,使用FSDataOutputStream将数据写入HDFS。你可以选择直接上传为独立的文件,

或者在HDFS上组装为一个逻辑上的大文件。FSDataOutputStream outputStream = fs.create(new Path("/path/to/hdfs/file.partX"));byte[] buffer = new byte[customBlockSize]; // 自定义的分片大小

int bytesRead;

while ((bytesRead = inputStream.read(buffer)) != -1) {outputStream.write(buffer, 0, bytesRead);// 根据需要处理读取和写入逻辑,比如跟踪当前分片编号或总进度

}

outputStream.close();文件合并(可选):如果你希望在HDFS上呈现为一个完整的文件而非多个分片,可以在上传所有分片后,使用

Hadoop的文件合并功能或者自定义逻辑来合并这些分片。

使用其他工具或框架

除了直接使用Hadoop API,还可以考虑使用像Apache Spark、MapReduce作业或专门的文件上传工具(如

FastDFS、Flume等),这些工具或框架通常也提供了自定义上传逻辑的能力,尤其是处理大文件和分片上传时。注意事项

确保自定义的分片逻辑不会导致数据不完整或损坏。

考虑到HDFS的设计初衷,即通过较大的默认块大小优化大数据处理性能,过度细分文件可能会降低整体系统效

率。

如果目的只是提高上传效率,考虑网络和硬件优化可能比自定义分片更有效。HDFS的mapper和reducer的个数如何确定?reducer的个数依据是什么?

HDFS的Mapper和Reducer的个数确定涉及到Hadoop的MapReduce编程模型。以下是关于Mapper和Reducer个

数确定的详细解释:Mapper的个数确定

Mapper的个数主要由以下几个因素决定:输入文件的大小和数量:

如果输入文件的大小小于或等于HDFS的block大小(默认为128MB),则每个文件通常会被视为一个split,从而

对应一个Mapper。

如果输入文件的大小大于HDFS的block大小,文件会被切分成多个split,每个split对应一个Mapper。split

的大小由dfs.block.size(HDFS块大小)、mapred.min.split.size(split的最小大小)和

mapred.max.split.size(split的最大大小)等参数共同决定。文件的数量也会影响Mapper的数量。如果文件数量很多但每个文件都很小,可能会产生大量的Mapper。InputFormat的使用:

Hadoop的InputFormat决定了如何将输入数据切分为split,并传递给Mapper。不同的InputFormat可能会

有不同的切分策略。

用户设置:

尽管Hadoop框架会根据输入数据自动计算Mapper的数量,但用户也可以通过设置mapreduce.job.maps参数来

指定Mapper的数量。然而,这个设置通常只是一个提示,Hadoop可能会根据集群的实际情况进行调整。

Reducer的个数确定

Reducer的个数主要由以下几个因素决定:用户设置:

用户可以通过job.setNumReduceTasks(x)方法直接设置Reducer的数量,其中x是Reducer的个数。如果没

有设置,则默认为1。

数据倾斜:

在设计MapReduce作业时,需要考虑数据倾斜的问题。如果某个key的数据量远大于其他key,可能需要增加

Reducer的数量来平衡负载。

集群资源:

Reducer的数量也受到集群资源的限制。如果集群中的资源不足以支持大量的Reducer并行运行,那么即使设置

了较多的Reducer,也可能无法充分利用集群的并行处理能力。总结

Mapper和Reducer的个数确定需要综合考虑输入数据、集群资源、作业需求等多个因素。在实际应用中,需要根

据具体情况进行调整和优化,以达到最佳的性能和效率。HDSF通过那个中间组件去存储数据

HDFS(Hadoop Distributed File System)通过其核心组件之一DataNode去存储数据。DataNode是

HDFS中实际负责存储文件块(Blocks)的服务器节点。在HDFS的架构中,文件被分成多个块,每个块都会被复

制到多个DataNode上(默认是3个副本),以此来实现数据的分布式存储和高可用性。DataNode不仅存储数据

块,还会定期向NameNode发送心跳信号和块报告,保持与NameNode的通信,以便NameNode能够实时了解整个

集群的存储状态和数据块的位置信息。因此,当客户端需要读取或写入数据时,NameNode会指引客户端与相应的

DataNode进行交互,从而完成数据的存储或检索过程。HDFS跨节点怎么进行数据迁移

HDFS(Hadoop Distributed File System)跨节点的数据迁移通常是指在不同的HDFS集群之间或者同一集

群的不同节点间移动数据。最常用的工具是DistCp(Distributed Copy),它是Hadoop生态系统中一个强大

的数据复制工具,设计用于大规模数据集的分布复制。以下是使用DistCp进行数据迁移的基本步骤和注意事项:使用DistCp进行数据迁移评估数据量:首先,使用命令如hdfs dfs -du -h /来查看各目录的数据量,帮助规划迁移策略和时间。规划迁移节奏:根据数据量和业务需求,决定是否需要分批次、分时段迁移数据,以减少对现有业务的影响。选择迁移工具:DistCp是首选工具,因为它可以并行复制数据,且能处理失败重试、数据校验等问题。配置DistCp命令:基本的DistCp命令格式如下,用于从源集群复制数据到目标集群:hadoop distcp hdfs://source-namenode:port/path/to/source hdfs://destination-namenode:port/path/to/destination如果涉及到安全集群(如启用了Kerberos认证),可能需要额外的参数,例如允许简化认证模式:hadoop distcp -D ipc.client.fallback-to-simple-auth-allowed=true hdfs://source... hdfs://destination...执行迁移:在源集群或目标集群中的任意节点上执行上述DistCp命令,开始数据迁移过程。监控迁移过程:迁移过程中,可以通过DistCp的日志和Hadoop的Web界面监控迁移状态和进度。数据校验:迁移完成后,可使用DistCp的校验功能(通过-skipcrccheck false禁用CRC校验跳过)来验证数据的一致性。权限和属性迁移:默认情况下,DistCp会尝试保留文件的权限和属性,但复杂ACLs可能需要额外处理。注意事项

带宽管理:迁移大量数据时,注意控制迁移速率,避免占用过多网络带宽影响其他服务。

资源分配:确保参与迁移任务的节点有足够的计算和存储资源。

错误处理:DistCp支持重试机制,但大迁移中可能遇到的错误需要人工干预。

安全性:在跨安全集群迁移时,正确配置Kerberos认证和相关安全设置。综上所述,DistCp是实现HDFS跨节点数据迁移的有效工具,通过精心规划和配置,可以高效、安全地完成大规模

数据迁移任务。HDFS的数据-致性靠什么保证?

HDFS(Hadoop Distributed File System)的数据一致性主要通过以下几个方面来保证:副本机制:

HDFS使用副本机制来保证数据的一致性。当写入数据时,HDFS会将数据划分为多个数据块(默认为128MB一个

block),并将每个数据块复制到多个数据节点(DataNode)上,形成多个副本。默认情况下,每个数据块会有3个副本,这个数量可以在配置文件中进行调整。这种多副本的方式可以确保在部分DataNode出现故障时,数据的可靠性和一致性不会受到影响。主节点的元数据管理:

HDFS使用一个主节点(NameNode)来管理文件系统的元数据,包括文件的目录结构、文件的副本位置信息等。当客户端进行写入操作时,NameNode会将数据块的位置信息记录在元数据中,并将这些信息传递给DataNode进

行数据的复制和更新。

NameNode会定期与DataNode进行心跳检测,以确保副本的一致性,并在副本出现异常情况时进行修复。数据节点的同步机制:

HDFS中的DataNode负责存储和管理数据块。它们之间通过心跳机制和块报告机制来保持数据的一致性。

DataNode会定期向NameNode发送心跳信号,NameNode通过心跳信号了解DataNode的状态,并根据需要进行数

据的复制和迁移。

DataNode还会定期向NameNode发送块报告,报告当前存储的数据块信息,以便NameNode进行数据块的管理和

一致性的维护。写入和读取的一致性:

在HDFS中,写入和读取操作的一致性是通过协议来保证的。

在写入数据时,客户端会先将数据写入到本地的缓冲区中,然后通过网络将数据发送给DataNode进行复制和更

新。这个过程保证了写入数据的一致性。

在读取数据时,客户端会与DataNode建立连接,并通过网络接收DataNode发送的数据块。由于有多个副本存

在,客户端可以选择从最近的、健康的DataNode读取数据,从而保证了读取数据的一致性。数据复制策略:

HDFS的数据复制策略通过数据冗余技术来实现,每个数据块通常被复制到多个DataNode上。

HDFS会根据一定的策略将块的副本放置在不同的DataNode上,以防止某一个机架或DataNode发生故障时数据的

丢失。

HDFS还会定期检查每个数据块的副本数是否达到预设的值,如果某个数据块的副本数小于预设值,HDFS会自动将

缺少的副本复制到其他DataNode上,以保证数据的冗余和可靠性。故障恢复机制:

当某个DataNode或NameNode出现故障时,HDFS的故障恢复机制会启动,自动将故障节点上的数据块复制到其他

健康的DataNode上,以保证数据的可用性和一致性。

综上所述,HDFS通过副本机制、主节点的元数据管理、数据节点的同步机制、写入和读取的一致性、数据复制策

略以及故障恢复机制等多个方面来保证数据的一致性。HDFS怎么保证数据安全

HDFS(Hadoop Distributed File System)通过一系列措施来保证数据的安全性。以下是HDFS在数据安全

方面的主要增强措施:数据备份:

HDFS通过数据块的备份机制来保证数据的可靠性和可恢复性。每个数据块默认会有3个副本存储在不同的节点上,

以防止数据丢失。这种多副本的存储方式确保了数据的冗余性,即使部分节点出现故障,也能从其他节点恢复数

据。访问控制:

HDFS支持基于权限的访问控制,可以通过设置文件和目录的权限来控制用户对数据的访问权限,包括读、写、执

行等。这种权限控制机制可以确保只有授权的用户才能访问和操作数据。安全传输:

HDFS支持通过SSL/TLS加密协议来保证数据在传输过程中的安全性,防止数据被中间人攻击或窃听。通过使用加

密协议,HDFS能够在数据传输时进行加密和解密,确保数据在传输过程中的保密性。数据完整性校验:

HDFS在数据块的写入和读取过程中会对数据进行校验和计算,以确保数据的完整性,防止数据被篡改。通过在数

据的读写过程中加入校验机制,HDFS能够及时发现并修复数据损坏或篡改的情况。安全认证:

HDFS支持Kerberos等安全认证机制,可以确保用户身份的合法性,避免未经授权的用户访问数据。通过

Kerberos等认证机制,HDFS能够对用户进行身份验证和授权,确保只有合法的用户才能访问和操作数据。数据加密:

HDFS支持对数据进行加密存储,可以保护数据在磁盘上的安全性,防止数据泄露。HDFS提供了两种加密方式:传

输加密和数据加密。传输加密通过SSL/TLS协议在数据传输过程中对数据进行加密;数据加密则是在数据存储的过

程中对数据进行加密,确保数据在磁盘上的安全性。安全审计:

HDFS可以记录并跟踪用户对数据的操作,包括读、写、删除等,以便及时发现异常操作并进行应对。这种安全审

计机制能够帮助管理员监控和追踪数据的使用情况,及时发现潜在的安全威胁。HDFS通过数据备份、访问控制、安全传输、数据完整性校验、安全认证、数据加密和安全审计等多种措施来保证

数据的安全性。这些措施共同构成了HDFS强大的数据安全体系,确保了数据在HDFS中的安全存储和传输。HDFS中向DataNode写数据失败了怎么办

在HDFS(Hadoop Distributed File System)中,如果向DataNode写数据失败,可以按照以下步骤尝试解

决问题:重试写操作:客户端通常会自动尝试重新连接到同一个DataNode并重试写操作,因为这种失败可能是由于网络瞬

时问题或DataNode的临时故障引起的。检查和修复网络问题:确认网络连接是否稳定,特别是如果写入失败与网络中断有关,需要修复网络连接。寻找其他副本:如果直接重试失败,客户端会与NameNode通信,获取该块的其他副本(如果有)的位置信息,并

尝试连接到这些副本所在的数据节点,继续写入操作。故障转移:HDFS在写数据时使用管道(Pipeline)机制,如果Pipeline中的某个DataNode失败,系统会关闭

这条Pipeline,并将未确认的数据包重新排队,确保数据不丢失。同时,当前正常工作的DataNode会获得新的

数据块版本号,使得故障恢复后的旧版本数据会被删除,避免数据不一致。检查和调整配置:

检查dfs.client.block.write.replace-datanode-on-failure.enable配置项,如果设为true(默认

值),则客户端在写入失败时会尝试切换到其他健康节点。如果集群较小,可能需要考虑将其设置为false,避免

因无其他节点可切换而持续失败。确认dfs.datanode.failed.volumes.tolerated配置是否适当,如果DataNode因磁盘故障导致无法写入,

可以考虑增加此值以提高容忍度,但这需要根据实际情况判断。排查和替换故障硬件:如果某个DataNode频繁出现问题,可能是因为硬件故障。需要检查该节点的磁盘状态,并

考虑更换故障磁盘或整个节点。监控和日志分析:查看相关日志文件(如NameNode和DataNode的日志),以获取更详细的错误信息,这对于诊断

问题至关重要。资源与负载管理:确保集群中的DataNode没有过载,资源充足,包括CPU、内存和磁盘空间。联系集群管理员:如果以上措施都不能解决问题,可能需要集群管理员介入,进行深入的故障排查和系统级别的维护。综上,通常可以有效地解决向DataNode写数据失败的问题,保证HDFS的稳定运行和数据的可靠性。Hadoop2.xHDFS快照

Hadoop 2.x HDFS快照是HDFS文件系统在某一时间点的只读拷贝,主要用于数据备份、恢复以及防止用户错误

性操作等场景。以下是关于Hadoop 2.x HDFS快照的详细介绍:快照概述

定义:快照是HDFS文件系统的基于某时间点的只读拷贝,它可以针对某个文件夹或整个文件系统创建。

应用场景:主要用于数据备份,以防止用户错误或灾难恢复。快照的高效性实现

即时创建:快照能够即时创建,耗时仅为O(1)(不包括inode查找时间)。

内存消耗:只有当涉及到快照文件夹的改动被运行时,才会产生额外的内存消耗。内存消耗为O(M),其中M是被改

动的文件或文件夹数。

无数据拷贝:创建快照时,block块并不会被拷贝。快照文件中仅记录了block列表和文件大小,不会进行任何数

据拷贝。快照的管理

设置可快照目录:使用hdfs dfsadmin -allowSnapshot <path>命令可以将某个目录设置为可快照目录。

取消可快照目录:使用hdfs dfsadmin -disallowSnapshot <path>命令可以取消目录的可快照属性。

生成快照:使用hdfs dfs -createSnapshot <path> [<snapshotName>]命令可以为指定目录生成快照。

删除快照:使用hdfs dfs -deleteSnapshot <path> <snapshotName>命令可以删除指定的快照。快照的限制和注意事项

快照数量限制:一个目录最多可以创建65536个快照。

不允许嵌套的快照目录:如果一个目录被设置为可快照,那么它的父目录和子目录都不能被设置为可快照。

快照路径:快照被存放在一个名为.snapshot的文件夹中。例如,对于/foo这个可快照目录,如果对/foo创建一

个名为s0的快照,那么/foo/.snapshot/s0就是/foo目录在s0快照时间点的状态。

快照不是数据的简单拷贝:快照不保存实际的数据,而是记录数据的元数据和变更信息,因此快照的生成非常迅

速。

总结

Hadoop 2.x HDFS快照是一个强大的工具,可以在不影响正常HDFS操作的情况下,快速、高效地创建数据的只

读拷贝,用于数据备份和恢复。通过合理的管理和使用,可以大大提高数据的安全性和可靠性。HDFS文件存储的方式?

HDFS(Hadoop Distributed File System)采用了一种分布式、高度容错性的文件存储方式,主要特点和

存储流程如下:文件切分:HDFS将大文件自动切分成多个固定大小的数据块(Block),默认块大小历史上从64MB逐渐调整到了

128MB(具体版本变更如前所述)。即使文件大小小于默认块大小,也会作为一个单独的块存储。块的大小是可以

根据需求配置的。分布式存储:每个数据块都会被复制到多个DataNode上(默认是3份),这些DataNode可以分布在不同的物理机

器上,从而实现数据的分布式存储。这种冗余策略提高了数据的可靠性和系统的容错能力。命名空间管理:HDFS使用一个中心化的NameNode来管理文件系统的命名空间(包括目录、文件的创建、删除、重

命名等元数据操作)。NameNode并不存储实际的数据块,而是维护着文件到数据块映射关系及每个数据块的位置

信息。数据写入流程:

客户端向NameNode请求写入文件,NameNode检查权限并确认文件不存在后,为文件分配一个新的文件ID,并返

回给客户端可以写入数据的DataNode列表。

客户端按顺序将数据块写入第一个DataNode,该DataNode会进一步复制数据块到其他副本所在的DataNode,

形成数据块的多个副本。写操作使用流水线(Pipeline)方式,客户端直接将数据写入第一个DataNode,然后由第一个DataNode向第

二个、第三个DataNode依次转发数据,减少了数据在网络中的往返次数,提高了写入效率。数据读取流程:

客户端向NameNode请求文件的元数据信息,NameNode返回文件的第一个数据块的位置信息。

客户端直接与存储数据块的最近或最适合的DataNode建立连接,读取数据。如果数据块有多个副本,客户端会选

择网络距离最近或响应最快的副本读取。

对于文件的后续数据块,客户端重复上述过程,直到读取完所有数据块。

存储策略:HDFS还支持多种存储策略,如冷热数据分离,可以将不同重要性或访问频率的数据存储在不同类型的

存储媒介上,如SSD、HDD或甚至内存(通过LAZY_PERSIST存储策略)。

通过这样的存储方式,HDFS能够高效地处理大规模数据存储需求,同时保证数据的高可用性和访问的高吞吐量。HDFS写数据过程,写的过程中有哪些故障,分别会怎么处理?

HDFS写数据的过程涉及多个关键步骤和潜在的故障处理机制,下面将详细解释这一过程,并列举可能出现的故障

及其处理方式:HDFS写数据过程请求上传:

客户端通过DistributedFileSystem模块向NameNode请求上传文件。权限与目录检查:

NameNode收到请求后,会检查该用户是否有上传权限、以及检查目录结构(目录是否存在)。

如果权限和目录结构都满足,NameNode会返回客户端可以上传文件的信息。文件切分:

客户端根据文件的大小进行切分,默认128MB一块。请求数据块位置:

客户端向NameNode发送请求,询问第一个block块上传到哪些服务器上。分配数据块:

NameNode根据网络拓扑和机架感知以及副本机制进行文件分配,返回可用的DataNode的地址给Client客户端。

默认情况下,每个数据块会有3个副本。建立传输通道:

客户端与第一个DataNode建立连接,并逐级建立与其他DataNode的连接,形成传输管道。数据写入:

客户端以packet为单位开始向DataNode发送数据,每个DataNode在收到数据后会继续传递给下一个

DataNode。传输完成与确认:

当一个block传输完成后,客户端会重复上述过程,直到所有block上传完成。

最后,客户端关闭流对象,并通知NameNode文件写入成功。可能的故障及处理方式权限或目录结构错误:

如果用户没有上传权限或目录结构不存在,NameNode会直接报错,并终止写操作。DataNode故障:

如果在写入过程中某个DataNode挂掉,NameNode不会重新分配DataNode,而是将已经写好的数据放置到队列的顶端,并继续将数据写入到剩余的DataNode中。数据校验错误:

HDFS会对数据进行校验和计算,以确保数据在传输和存储过程中的完整性。

如果发现数据损坏或丢失,HDFS可以通过校验和信息从其他副本中恢复数据。写入确认失败:

如果写入过程中没有达到指定数量的副本节点成功写入,HDFS会进行回滚操作,确保数据的一致性。网络故障:

对于网络故障,HDFS会依赖底层的网络通信协议来处理。如果某个DataNode长时间不响应,NameNode会将其标

记为不可用,并尝试将数据块复制到其他DataNode上。磁盘故障:

如果DataNode的磁盘出现故障,NameNode会检测到该DataNode不可用,并触发数据块的重新复制和恢复机

制。通过上述机制,HDFS能够确保数据在写入过程中的可靠性和完整性,有效处理可能出现的错误和异常情况。NameNode存数据吗?

HDFS(Hadoop Distributed File System)中的NameNode并不存储用户的具体数据或数据集。相反,它主

要负责存储和管理文件系统的元数据。元数据是指关于数据的数据,具体包括:文件和目录的命名空间信息:文件系统的目录树结构、文件名、目录结构等。文件的属性信息:如文件的创建时间、修改时间、访问权限、所有权等。数据块(Block)的映射信息:每个文件被分成多个数据块,NameNode记录每个数据块的ID、大小及其在各个

DataNode上的存储位置。文件的副本信息:由于HDFS采用数据复制策略,默认情况下,每个数据块会有三个副本,NameNode跟踪这些副本

的位置。简而言之,尽管NameNode不直接存储用户上传的实际文件内容,但它存储了查找和访问这些文件所需的所有关键

信息。这些元数据对于文件系统的正常运作至关重要,它们通常被保存在内存中以加快访问速度,并通过编辑日志

(edits log)和fsimage等文件在硬盘上持久化,以确保系统重启后能够恢复元数据状态。使用NameNode的好处

使用NameNode作为Hadoop Distributed File System (HDFS)的核心组件,带来了以下几个显著好处:集中式元数据管理:NameNode集中管理文件系统的命名空间和元数据,包括文件的目录结构、文件属性(如权

限、所有权)、文件到数据块的映射关系等。这种集中管理简化了系统的架构,使得对文件系统的查询和修改操作

更加高效。高效的数据定位:客户端在读写文件时,只需要与NameNode交互获取所需数据块的位置信息,然后直接与相关的

DataNode通信,大大减少了查找数据所需的网络往返次数,提升了数据访问速度。高可靠性保障:NameNode通过维护文件的多个副本(默认为3份)在不同的DataNode上,确保了数据的高可用

性。即使个别节点发生故障,也能从其他副本中恢复数据,保证了数据的完整性和服务连续性。动态适应性:NameNode能够根据DataNode的健康状况和系统负载动态调整数据块的存放位置,优化数据分布,

提升整体系统性能和稳定性。资源与负载管理:虽然NameNode不直接参与数据传输,但它通过管理文件系统的整体视图,能够辅助进行集群资

源的合理分配,避免数据倾斜和热点问题,使整个集群运行更加均衡。安全与权限控制:NameNode负责实施文件系统的访问控制,确保只有合法用户能够访问相应的文件和目录,提供

了基础的安全保障机制。易于扩展和维护:随着数据量的增长,尽管单个NameNode可能会成为瓶颈,但Hadoop生态系统提供了高可用

(HA)和联邦(Federation)等解决方案,允许通过增加NameNode实例来横向扩展,提高系统的可维护性和扩

展性。综上所述,NameNode在HDFS中扮演着至关重要的角色,它确保了大数据存储的高效、可靠和安全性,是构建大规

模分布式存储系统的基础。HDFS中DataNode怎么存储数据的

在HDFS(Hadoop Distributed File System)中,DataNode负责实际存储文件数据块(Block)。下面是

DataNode存储数据的具体方式:数据块存储格式:每个数据块在DataNode上以文件形式存储在磁盘上,并且每个数据块实际上是由两个文件组

成:一个是数据本身,另一个是元数据文件(通常以.meta为后缀)。元数据文件包含数据块的长度、校验和

(Checksum)、时间戳等信息,确保数据的完整性。存储目录:DataNode可以在配置的多个存储目录下存储数据块,这有助于分散I/O负载和提高存储效率。默认的

存储路径可以根据集群配置而定,例如在某些环境中,可能设置为${BIGDATA_DATA_HOME}/hadoop/dataN/dn/datadir,其中N表示数据存放目录的编号。数据块复制:为了保证数据的可靠性,HDFS默认为每个数据块创建多个副本(通常是3个),这些副本分布在不同

的DataNode上。这种策略可以防止单点故障导致数据丢失,增强了系统的容错能力。块池目录结构:DataNode的数据存储目录具有特定的层次结构,通常包括块池目录(BP目录),里面包含着与特

定块池相关的元数据文件(VERSION文件),该文件记录了文件系统布局版本、HDFS集群ID和创建时间等信息,

以及最终存储数据块的子目录。心跳与块报告:DataNode周期性地向NameNode发送心跳信号,表明其活跃状态,并在心跳过程中上报其存储的

所有数据块信息(BlockReport)。这些信息帮助NameNode维护整个集群的数据块分布图,以便于数据的分配、

复制和恢复。数据写入流程:在写入数据时,客户端首先与NameNode交互确定数据块的存储位置,然后直接与对应的

DataNode通信,执行实际的数据写入操作。数据写入可能采用流水线复制的方式,即数据先写入第一个

DataNode,再由该节点转发给其他副本所在的DataNode,以减少网络传输延迟。通过上述机制,DataNode实现了数据的分布式、冗余存储,确保了HDFS的高可用性和数据的持久性。直接将数据文件上传到HDFS的表目录中,如何在表中查询到该数据?

直接将数据文件上传到HDFS的表目录中,并不能直接使得该数据在Hive或HBase等数据仓库系统中的表中可见,

因为这些系统需要进行额外的步骤来识别和加载数据。下面是针对Hive和HBase的一些建议:Hive:

创建外部表:如果你之前已经创建了一个指向该HDFS目录的Hive外部表,那么上传的新数据理论上应该可以直接

通过查询外部表来访问。但是,对于分区表,你可能需要手动添加分区或者使用MSCK REPAIR TABLE命令来检测

并添加缺失的分区。ALTER TABLE your_table ADD PARTITION (partition_column='value');

或者

MSCK REPAIR TABLE your_table;非外部表:如果是一个管理表(非外部表),直接向其HDFS目录上传文件通常不是推荐的做法,因为这可能导致

Hive元数据与实际数据不一致。正确的做法是使用LOAD DATA语句或者INSERT INTO语句来导入数据。HBase:

导入工具:HBase不直接基于HDFS目录创建表或加载数据,而是通过特定的API或工具(如importtsv或hbck工

具的-loadIncrementalHFiles选项)来导入HFile格式的数据。你需要先创建表,然后使用这些工具将HDFS

上的文件导入到表中。MapReduce导入:也可以使用MapReduce作业(如ImportTsv或自定义MapReduce程序)来读取HDFS上的文件

并导入到HBase表中。总之,直接将文件上传到HDFS目录后,需要根据所使用的数据管理系统(如Hive或HBase)的规则和工具来正确

地注册或加载这些数据,才能在表中查询到它们。引用:https://www.nowcoder.com/discuss/353159520220291072

通义千问、文心一言、豆包

相关文章:

大数据面试题之HDFS

目录 HDFS文件写入和读取流程 HDFS组成架构 介绍下HDFS,说下HDFS优缺点,以及使用场景 HDFS作用 HDFS的容错机制 HDFS的存储机制 HDFS的副本机制 HDFS的常见数据格式,列式存储格式和行存储格式异同点,列式存储优点有哪些? …...

(9)农作物喷雾器

文章目录 前言 1 必要的硬件 2 启用喷雾器 3 配置水泵 4 参数说明 前言 Copter 包括对农作物喷雾器的支持。该功能允许自动驾驶仪连接到一个 PWM 操作的泵和(可选)旋转器,根据飞行器速度控制液体肥料的流动速度。 稍微过时的视频显示了…...

智慧互联:Vatee万腾平台展现科技魅力

随着科技的迅猛发展,我们的生活正逐渐变得智能化、互联化。在这个信息爆炸的时代,一个名为Vatee万腾的平台正以其独特的魅力,引领我们走向一个更加智能的未来。 Vatee万腾,这个名字本身就充满了对科技未来的憧憬与期待。作为一家专…...

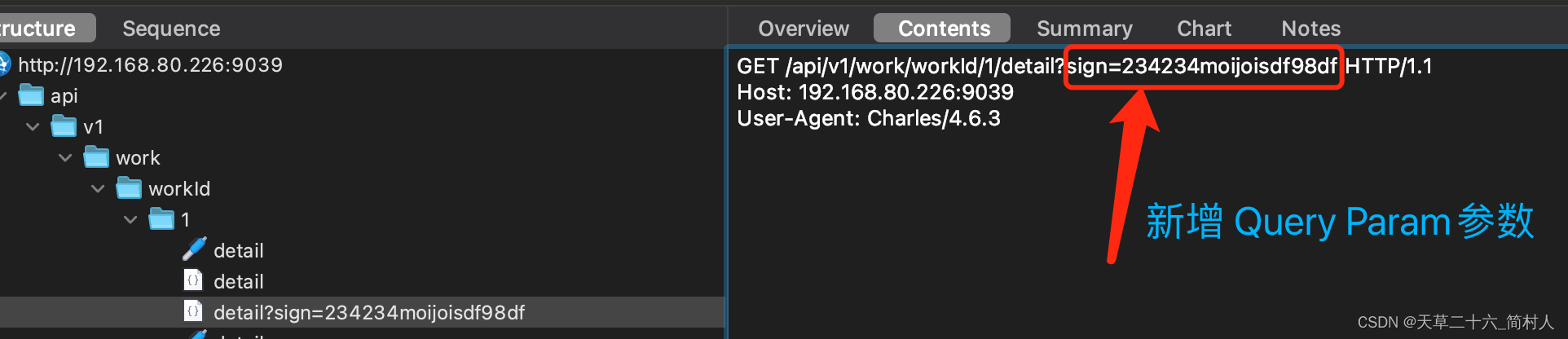

Charles抓包工具系列文章(四)-- Rewrite 重写工具

一、背景 这是一款比Map Local/Remote 还强大的工具,更加灵活,体现在以下几点: 重写request报文重写response报文header 字段的增删改query param 字段的增删改重写 body 字段改写http 响应状态status重写host/url/path 从这也可以看出其强…...

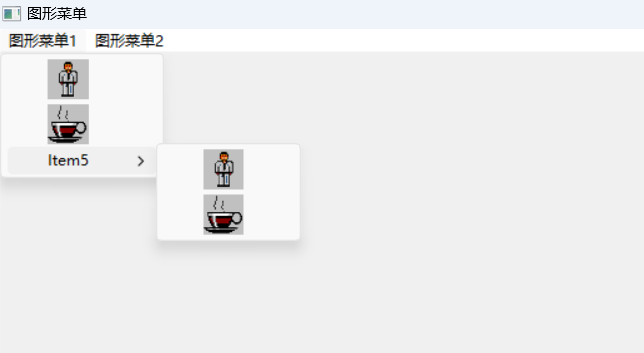

【PB案例学习笔记】-24创建一个窗口图形菜单

写在前面 这是PB案例学习笔记系列文章的第24篇,该系列文章适合具有一定PB基础的读者。 通过一个个由浅入深的编程实战案例学习,提高编程技巧,以保证小伙伴们能应付公司的各种开发需求。 文章中设计到的源码,小凡都上传到了gite…...

环境配置的相关问题

一、shap安装踩坑 遇到错误: A module that was compiled using NumPy 1.x cannot be run in NumPy 2.0.0 as it may crash. To support both 1.x and 2.x versions of NumPy, modules must be compiled with NumPy 2.0. Some module may need to rebuild instead…...

github配置可拉取项目到本地

首先配置用户名和邮箱: git config --global user.name 自己的名字git config --global user.email 自己的邮箱配置完之后检查一下: git config --global user.namegit config --global user.email如果提示的是自己配置好的名字和邮箱就Ok 然后拉取githu…...

Snippet-AndroidFontWeight

常用FontWeight值 <?xml version"1.0" encoding"utf-8"?> <resources><integer name"font_weight_Thin">100</integer><integer name"font_weight_ExtraLight">200</integer><integer name…...

选择合适的分类评价指标:传统指标与自定义指标的权衡

这里写目录标题 选择合适的分类评价指标:传统指标与自定义指标的权衡传统评价指标**准确率(Accuracy)****精确度(Precision)和召回率(Recall)****F1分数(F1 Score)** 自定…...

数据结构-线性表的链式表示

目录 前言一、线性表的链式表示和实现1.1 线性表的表示1.2 基本操作的实现1.3 线性表的链式表示的优缺点 总结 前言 本篇文章主要介绍线性表的链式表示 一、线性表的链式表示和实现 1.1 线性表的表示 线性表的链式表示又称为链式存储结构或链式映像 链式存储定义࿱…...

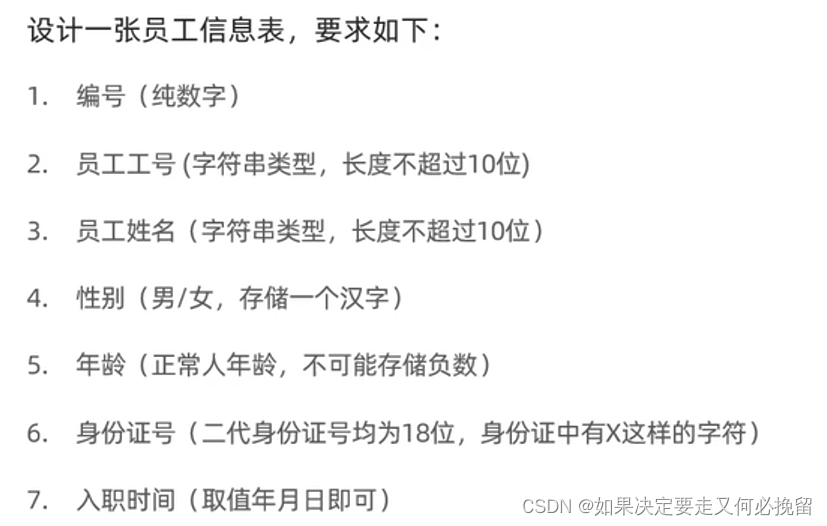

DDL-表操作-数据类型

一.DDL-表操作-数据类型 MySQL中的数据类型有很多,主要分为三类:数值类型,字符串类型,日期类型。 二.关系表 注意: 无符号和有符号的取值范围不是一样的,无符号需要加上UNSIGNED范围。 BLOB:用来描述二进制数据 TEXT:用来描述字符串 三.定长字符串和变长字符串 c…...

python实例代码 - 多层感知机预测销售情况

多层感知器预测销售情况 将一种广告投放到TV、newspaper、radio上时不同组合的情况会对应不同的销售量。 # -*- coding:utf-8 -*- # PredicateAdvertise.py # 多层感知器预测销售情况 # 将一种广告投放到TV、newspaper、radio上时不同组合的情况会对应不同的销售量。 import …...

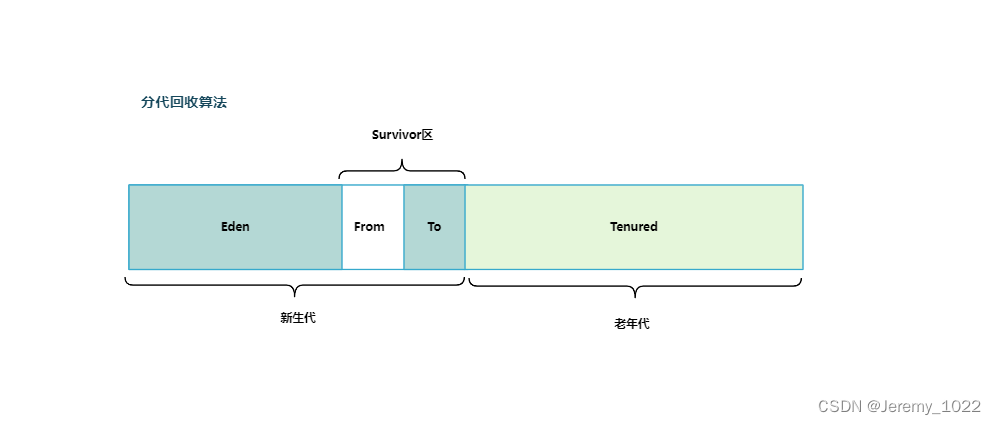

JVM专题十:JVM中的垃圾回收机制

在JVM专题九:JVM分代知识点梳理中,我们主要介绍了JVM为什么采用分代算法,以及相关的概念,本篇我们将详细拆分各个算法。 垃圾回收的概念 垃圾回收(Garbage Collection,GC)确实是计算机编程中的…...

MySQL入门学习-索引.创建索引

索引是 MySQL 中用于加速查询的一种数据结构。它通过在表的列上创建索引来加快数据的检索速度。 一、索引的概念 索引类似于书的目录,可以快速定位到表中的数据。当在表中的列上创建索引后,MySQL 会根据索引列的值对数据进行排序,并建立一个…...

ChatGPT智能对话绘画系统 带完整的安装源代码包以及搭建教程

系统概述 ChatGPT 智能对话绘画系统是一款集智能语言处理和绘画创作于一体的综合性系统。它利用了深度学习和自然语言处理技术,能够理解用户的意图和需求,并通过与用户的交互,生成富有创意的绘画作品。该系统的核心是一个强大的人工智能模型…...

巴中市红色旅游地管理系统

摘 要 随着红色旅游的兴起,越来越多的人开始对巴中市的红色旅游地产生兴趣。巴中市作为中国革命的重要发源地之一,具有丰富的红色旅游资源。然而,目前巴中市红色旅游地的管理仍然存在许多问题,如信息不对称、资源利用效率低等。为…...

ROS2从入门到精通2-2:详解机器人3D可视化工具Rviz2与案例分析

目录 0 专栏介绍1 什么是Rviz2?2 Rviz2基本界面3 Rviz2基本数据类型4 数据可视化案例4.1 实例1:显示USB摄像头数据4.2 实例2:显示球体 0 专栏介绍 本专栏旨在通过对ROS2的系统学习,掌握ROS2底层基本分布式原理,并具有…...

国企:2024年6月中国铁路相关招聘信息,6.27截止

中国铁路济南局集团有限公司2024年度 招聘普通高校本科及以上学历毕业生公告(三) 中国铁路济南局集团有限公司根据企业发展需要,拟招聘普通高等院校本科及以上学历毕业生,现将有关事项公告如下: 一、招聘计划 本次招聘岗位均为生产一线操作技能岗位,具体岗位、专业要求…...

React+TS前台项目实战(十九)-- 全局常用组件封装:带加载状态和清除等功能的Input组件实现

文章目录 前言Input组件1. 功能分析2. 代码详细注释3. 使用方式4. 效果展示 总结 前言 今天我们来封装一个input输入框组件,并提供一些常用的功能,你可以选择不同的 尺寸、添加前缀、显示加载状态、触发回调函数、自定义样式 等等。这些功能在这个项目中…...

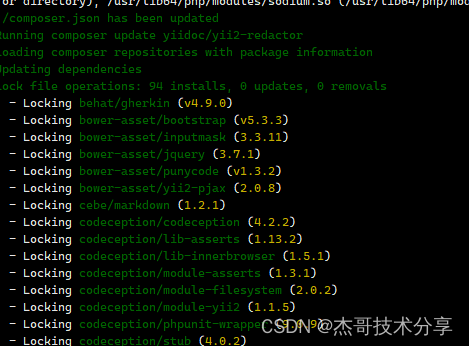

php composer 报错

引用文章: Composer设置国内镜像_composer 国内源-CSDN博客 php composer.phar require --prefer-dist yiidoc/yii2-redactor "*" A connection timeout was encountered. If you intend to run Composer without connecting to the internet, run the …...

Mac软件卸载指南,简单易懂!

刚和Adobe分手,它却总在Library里给你写"回忆录"?卸载的Final Cut Pro像电子幽灵般阴魂不散?总是会有残留文件,别慌!这份Mac软件卸载指南,将用最硬核的方式教你"数字分手术"࿰…...

【Java学习笔记】BigInteger 和 BigDecimal 类

BigInteger 和 BigDecimal 类 二者共有的常见方法 方法功能add加subtract减multiply乘divide除 注意点:传参类型必须是类对象 一、BigInteger 1. 作用:适合保存比较大的整型数 2. 使用说明 创建BigInteger对象 传入字符串 3. 代码示例 import j…...

基于PHP的连锁酒店管理系统

有需要请加文章底部Q哦 可远程调试 基于PHP的连锁酒店管理系统 一 介绍 连锁酒店管理系统基于原生PHP开发,数据库mysql,前端bootstrap。系统角色分为用户和管理员。 技术栈 phpmysqlbootstrapphpstudyvscode 二 功能 用户 1 注册/登录/注销 2 个人中…...

GraphQL 实战篇:Apollo Client 配置与缓存

GraphQL 实战篇:Apollo Client 配置与缓存 上一篇:GraphQL 入门篇:基础查询语法 依旧和上一篇的笔记一样,主实操,没啥过多的细节讲解,代码具体在: https://github.com/GoldenaArcher/graphql…...

医疗AI模型可解释性编程研究:基于SHAP、LIME与Anchor

1 医疗树模型与可解释人工智能基础 医疗领域的人工智能应用正迅速从理论研究转向临床实践,在这一过程中,模型可解释性已成为确保AI系统被医疗专业人员接受和信任的关键因素。基于树模型的集成算法(如RandomForest、XGBoost、LightGBM)因其卓越的预测性能和相对良好的解释性…...

当下AI智能硬件方案浅谈

背景: 现在大模型出来以后,打破了常规的机械式的对话,人机对话变得更聪明一点。 对话用到的技术主要是实时音视频,简称为RTC。下游硬件厂商一般都不会去自己开发音视频技术,开发自己的大模型。商用方案多见为字节、百…...

解决MybatisPlus使用Druid1.2.11连接池查询PG数据库报Merge sql error的一种办法

目录 前言 一、问题重现 1、环境说明 2、重现步骤 3、错误信息 二、关于LATERAL 1、Lateral作用场景 2、在四至场景中使用 三、问题解决之道 1、源码追踪 2、关闭sql合并 3、改写处理SQL 四、总结 前言 在博客:【写在创作纪念日】基于SpringBoot和PostG…...

Spring Boot 中实现 HTTPS 加密通信及常见问题排查指南

Spring Boot 中实现 HTTPS 加密通信及常见问题排查指南 在金融行业安全审计中,未启用HTTPS的Web应用被列为高危漏洞。通过正确配置HTTPS,可将中间人攻击风险降低98%——本文将全面解析Spring Boot中HTTPS的实现方案与实战避坑指南。 一、HTTPS 核心原理与…...

鸿蒙APP测试实战:从HDC命令到专项测试

普通APP的测试与鸿蒙APP的测试有一些共同的特征,但是也有一些区别,其中共同特征是,它们都可以通过cmd的命令提示符工具来进行app的性能测试。 其中区别主要是,对于稳定性测试的命令的区别,性能指标获取方式的命令的区…...

【计算机网络】SDN

SDN这种新型网络体系结构的核心思想:把网络的控制层面与数据层面分离,而让控制层面利用软件来控制数据层面中的许多设备。 OpenFlow协议可以被看成是SDN体系结构中控制层面与数据层面之间的通信接口。 在SDN中取代传统路由器中转发表的是“流表”&…...