【docker综合篇】关于我用docker搭建了6个应用服务的事

最近一直在捣鼓docker,利用测试服务器,本着犯错就重来(重装系统)的大无畏精神,不断尝试,总结经验,然后在网上搜寻一些关于docker有关的服务镜像,并搭建起来。看着一个个服务在我的服务器跑起来,那种成功的喜悦真是一件值得让人高兴的事。总结一下,我成功运行的docker镜像服务觉得不错的有dnmp,kaillinux,Lsky Pro,shipyard,ollama,ward,vocechat,下面就跟随我一起来了解这些服务吧。

目录

1.前言温故知新

2.docker镜像源

3.6大应用服务

3.1 DNMP集成web

3.2 Docker容器管理shipyard

3.3 Lsky Pro图床

3.4 服务器监控ward

3.5 聊天应用VoceChat

3.6 ollama大模型

4.从零开始实操篇

4.1 安装dnmp

4.2 大模型ollama

4.3 docker可视化shipyard

4.4 Ward、Lsky Pro、VoceChat

5.总结畅想

1.前言温故知新

关于docker,我接触的不多,从lz的历史博客中也能看出来,最初的接触也是因为搭建一个自己的php+nginx的web服务,所以,一切故事的开始就要从这个web服务dnmp说起了。

DNMP:基于docker搭建集成LNMP(nginx+mysql+php)-CSDN博客

玩转Docker:Lsky pro图床+私有化部署大模型(Ollama+Openwebui)-CSDN博客

所谓的dnmp,就是docker+nginx+mysql+php的集成环境,前面两篇博客已经做了汇总了。并且为了方便,lz还做了一键集成脚本。 通过 bash dnmp.sh 运行脚本,这里是基于lz的服务器系统为Ubuntu 22.04.4。会在当前目录下生成一个dnmp目录(tips:记住这个dnmp目录,里面有一个配置文件很关键,后面会用到)。

相当于安装了docker,docker-compose,git,并构建了对应的dnmp容器。

不出意外的话,当你访问 http://IP地址 就能看到提示dnmp安装成功的页面。

dnmp.sh

#!/bin/bash

#wget http://114.116.118.165/dnmp.sh && bash dnmp.sh

# 定义颜色代码

RED='\033[0;31m'

GREEN='\033[0;32m'

NC='\033[0m' # 无颜色# 第一步:安装 Docker、Docker Compose 和 Git

function install_tools() {echo "开始安装 Docker、Docker Compose 和 Git..."# 更新软件包列表sudo apt update# 安装 Dockerif ! sudo apt install -y docker.io; thenecho -e "${RED}Docker 安装失败,请检查错误并重试。${NC}"exit 1fi# 安装 Docker Composeif ! curl -K -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose; thenecho -e "${RED}Docker Compose 下载失败,请检查错误并重试。${NC}"exit 1fiif ! sudo chmod +x /usr/local/bin/docker-compose; thenecho -e "${RED}Docker Compose 权限修改失败,请检查错误并重试。${NC}"exit 1fi# 安装 Gitif ! sudo apt install -y git; thenecho -e "${RED}Git 安装失败,请检查错误并重试。${NC}"exit 1fiecho -e "${GREEN}Docker、Docker Compose 和 Git 安装完成。${NC}"

}# 第二步:通过 Git 克隆 DNMP 项目

function clone_dnmp() {echo "开始克隆 DNMP 项目..."if ! git clone https://gitee.com/yeszao/dnmp.git; thenecho -e "${RED}Git 克隆失败,请检查错误并重试。${NC}"exit 1fiecho -e "${GREEN}DNMP 项目克隆成功。${NC}"

}# 第三步:复制配置文件并进入项目目录

function setup_dnmp() {echo "开始设置 DNMP 项目..."dnmp_dir="dnmp" # 假设 dnmp 目录相对于当前脚本的路径# 确保 dnmp 目录存在if [ ! -d "$dnmp_dir" ]; thenecho "dnmp 目录不存在: $dnmp_dir"exit 1fi# 进入 dnmp 目录并执行命令(cd "$dnmp_dir" && {# 复制环境变量文件if ! cp env.sample .env; thenecho -e "${RED}复制 env.sample 失败,请检查错误并重试。${NC}"exit 1fi# 复制 docker-compose 配置文件if ! cp docker-compose.sample.yml docker-compose.yml; thenecho -e "${RED}复制 docker-compose.sample.yml 失败,请检查错误并重试。${NC}"exit 1fi# 启动 docker-composeif ! docker-compose up -d; thenecho -e "${RED}docker-compose up 失败,请检查错误并重试。${NC}"exit 1fiecho -e "${GREEN}DNMP 项目设置完成,docker-compose 启动成功。${NC}"}) || {echo "在 dnmp 目录中执行命令失败"exit 1}

}# 主函数,按顺序执行上述步骤

function main() {install_toolsclone_dnmpsetup_dnmpecho "所有操作已完成,DNMP集成环境搭建并启动成功!"

}# 执行主函数

main当然,什么事都不是一帆风顺的,在运行这个脚本命令的过程中,你可能会遇到问题:

这个脚本命令大概的运行流程就是:

安装docker——> 安装docker-compose——>安装git——>git克隆dnmp代码——>cd dnmp代码目录——>复制docker-compose文件——>开始docker-compose up构建并运行容器

如果前面三步都进行不下去,可能是因为你的系统是centos的,命令不支持;ssl 握手失败;连接超时失败;谁知道呢!这里你就要想其他办法去安装了。

如果前面三步顺利的情况下,你的服务器是国内的服务器,在进行docker-compse up时大概率可能会出现拉取镜像超时的问题。因为国内的docker很多被禁了,所以这里要找到能用的镜像源进行配置才行。

2.docker镜像源

国内的很多大厂镜像源基本都无法访问了,有的就算能访问,但是镜像也不全,在进行docker pull时可能会出现镜像不存在的问题。

关于这个,大致有两种解决办法:

1.找对应服务器商提供的镜像加速地址

2.寻找第三方可用镜像源地址

再不行,就网上找吧,总有能用的。这里以lz的镜像源配置为例:

服务器版本配置:华为云 Ubuntu 22.04.4 LTS 2H4G 100GB (华为测试,一核更比六核强)

vi /etc/docker/daemon.json没有daemon.json文件,就手动创建 touch daemon.json

{"registry-mirrors": ["https://2cc2e98fbd5b4ca482a3faf3884425e2.mirror.swr.myhuaweicloud.com","https://docker.anyhub.us.kg","https://dockerhub.jobcher.com","https://dockerhub.icu"]

}然后使用 systemctl restart docker命令重启Docker即可。然后使用docker info命令查看镜像仓库信息,如果出现你所配置的源地址,就说明成功了。之后可以继续去执行脚本命令bash dnmp.sh去构建了。

还有一个问题,就是在利用apt下载docke和git时,可能会很慢,这就是apt源的问题,也要进行更换。配置文件地址在:/etc/apt/sources.list

清华大学开源软件镜像站

阿里巴巴开源镜像站-OPSX镜像站-阿里云开发者社区

网易镜像开源Ubuntu镜像使用帮助

中科大开源镜像站

找到你服务器对应的版本,配置之后,执行apt update 更新下即可。

#更新本地包索引:

sudo apt update#升级已安装的软件包:

sudo apt upgrade清理本地存储的已删除软件包的存档:

sudo apt autoremove清理下载的软件包缓存:

sudo apt clean3.6大应用服务

前面的DNMP服务已经讲了,接下来下面说一下lz为什么要选择这几个应用服务,明明有那么多镜像。lz选择这几个自然有他的道理。下面会大致介绍并给出应用服务展示效果。

3.1 DNMP集成web

一个web站点离不开web服务器,更离不开数据库,再考虑到支持它的开发语言运行环境,还有ssl证书配置,Redis数据缓存等等各种服务,更遑论他们之间要产生关联的配置。试问让你一个个安装,你就不会出错吗?不会?那好,当我没说,你直接跳过看下一个吧。

而DNMP一键集成Docker+php多版本控制+nginx+mysql多版本+ssl+Redis配置。我只能说很香

3.2 Docker容器管理shipyard

shipyard是一个开源的docker管理平台,shipyard主要是把多个 Docker host上的 containers 统一管理(支持跨越多个host)意思就是可以做集群化管理,Shipyard是在Docker Swarm实现对容器、镜像、docker集群、仓库、节点进行管理的web系统。界面简洁友好,缺点是涉及的镜像服务有点多,不像其他的几个docker容器管理可视化,安装一个镜像就够了。

3.3 Lsky Pro图床

Lsky Pro(也称:兰空图床),是一个基于PHP 8.0+和Laravel框架开发的云端相册程序。它允许用户上传、管理和分享图片,并提供了多种强大的功能。Lsky Pro支持多种第三方云储存服务,如AWS S3、阿里云OSS、腾讯云COS等,还提供了图片审核、水印、分享、商业化等多种功能。用户可以根据自己的需求选择开源版或付费版,享受简单且实用的图片管理体验。

3.4 服务器监控ward

Ward是一个简单而优雅的解决方案,用于实时查看服务器的关键信息。它以适应性设计系统为特色,支持黑暗模式,让你的监控面板充满现代感。非常轻量,就一个web页面,能实时监控CPU,内存和存储使用状态。

3.5 聊天应用VoceChat

VoceChat 是一款支持独立部署的个人云社交媒体聊天服务。15MB 的大小可部署在任何的服务器上,部署简单,很少需要维护。前端可以内嵌到自己的网站下,作为网页装饰提供客服咨询应用场景,数据完全由用户自己掌握,传输过程加密。支持创建聊天频道,添加好友私聊等功能。

3.6 ollama大模型

ollama是一款可以使用本地的大型语言模型。启动并运行大型语言模型。运行Llama 2、Code Llama和其他模型。自定义并创建您自己的模型,一般配合Openwebui可视化一起使用。支持多种模型库选择,包括并不局限以下几种:

(ollama run gemma)安装谷歌gemma大模型

(ollama run llama2)安装Meta llama2大模型

(ollama run qwen)安装阿里的qwen大模型

缺点是比较吃内存,要运行以上几种大模型,最好确保你本地服务器内存8G以上,当然,也可以选择小一点的模型,lz的服务器2G内存,运行的模型时ollama run qwen2:0.5b 就是感觉不太聪明的样子

4.从零开始实操篇

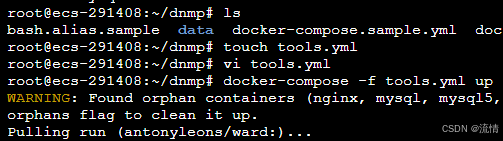

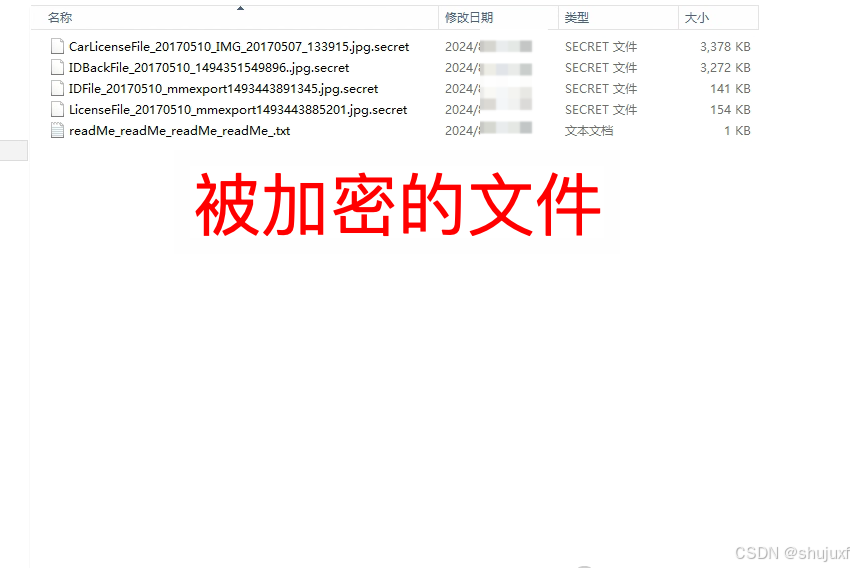

这里从头到尾实操一下,lz买的是华为云的测试服务器:华为云 Ubuntu 22.04.4 LTS 2H4G 100GB。因为也只有这个配置才能带的动6个应用服务啊。当然,在座的各位按需安装即可。因为我是无脑一路安装,可能用的都是弱密码,应用服务太多等原因,导致被攻击了。索性只是测试服务器,lz直接重装系统即可。

不过这也算是给我们提了个醒,不要忽视安全问题。在安装dnmp时,别忘了改数据库默认密码,另外git不用后就给卸载,lz看网上说也有因为这个没设置账号密码的问题。好了,题外话不多说,正好趁着重装系统,一切从零开始。

4.1 安装dnmp

我们一步步来。第一步,先安装dnmp,进入终端,直接运行dnmp.sh脚本输入:

# 因为lz把脚本放到了线上站点,所以可以直接拉取运行。也可以本地创建运行

wget http://114.116.118.165/dnmp.sh && bash dnmp.sh

进行到docker-compose up报错了,找不到镜像nginx,这个时候就是我前面说的要修改镜像源,当然也别忘了修改apt源。把这两个源都修改后,我们再执行一次脚本。

顺序为:先配置apt源-》执行脚本生成docker-》再配置docker镜像源-》再执行一次脚本

这里没有运行docker-compose up命令,说明docker-compose安装失败,我们手动安装下就行:

curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose && sudo chmod +x /usr/local/bin/docker-compose然后,在进入dnmp目录,重新构建下容器:docker-compose up -d

最后,访问 http:服务器IP 能看到页面就说明搞定了,至此,开头最难的就搞定了。

后面的应用服务的安装都是基于docker、docker-compose 安装好的基础上~

4.2 大模型ollama

这个没啥好说的,就两行命令。不过要记得量力而行啊。执行下面两行命令后,再安装模型就行了,具体的可以去看我前面的博客。

###docker下载ollama部署

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama --restart always ollama/ollama##使用docker部署webUi页面,${inner_ip}替换为你的本地ip

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://${inner_ip}:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main4.3 docker可视化shipyard

这个安装有点麻烦,因为涉及的镜像有点过。不过lz找到一篇脚本安装的教程。直接脚本安装就简单了。

进入dnmp目录下,创建脚本文件 shipyard.sh,然后执行 bash shipyard.sh 就行了

shipyard.sh

if [ "$1" != "" ] && [ "$1" = "-h" ]; thenecho "Shipyard Deploy uses the following environment variables:"echo " ACTION: this is the action to use (deploy, upgrade, node, remove)"echo " DISCOVERY: discovery system used by Swarm (only if using 'node' action)"echo " IMAGE: this overrides the default Shipyard image"echo " PREFIX: prefix for container names"echo " SHIPYARD_ARGS: these are passed to the Shipyard controller container as controller args"echo " TLS_CERT_PATH: path to certs to enable TLS for Shipyard"echo " PORT: specify the listen port for the controller (default: 8080)"echo " IP: specify the address at which the controller or node will be available (default: eth0 ip)"echo " PROXY_PORT: port to run docker proxy (default: 2375)"exit 1

fiif [ -z "`which docker`" ]; thenecho "You must have the Docker CLI installed on your \$PATH"echo " See http://docs.docker.com for details"exit 1

fiACTION=${ACTION:-deploy}

IMAGE=${IMAGE:-dockerclub/shipyard:latest}

PREFIX=${PREFIX:-shipyard}

SHIPYARD_ARGS=${SHIPYARD_ARGS:-""}

TLS_CERT_PATH=${TLS_CERT_PATH:-}

CERT_PATH="/etc/shipyard"

PROXY_PORT=${PROXY_PORT:-2376}

SWARM_PORT=3375

SHIPYARD_PROTOCOL=http

SHIPYARD_PORT=${PORT:-8080}

SHIPYARD_IP=${IP}

DISCOVERY_BACKEND=etcd

DISCOVERY_PORT=4001

DISCOVERY_PEER_PORT=7001

ENABLE_TLS=0

CERT_FINGERPRINT=""

LOCAL_CA_CERT=""

LOCAL_SSL_CERT=""

LOCAL_SSL_KEY=""

LOCAL_SSL_CLIENT_CERT=""

LOCAL_SSL_CLIENT_KEY=""

SSL_CA_CERT=""

SSL_CERT=""

SSL_KEY=""

SSL_CLIENT_CERT=""

SSL_CLIENT_KEY=""show_cert_help() {echo "To use TLS in Shipyard, you must have existing certificates."echo "The certs must be named ca.pem, server.pem, server-key.pem, cert.pem and key.pem"echo "If you need to generate certificates, see https://github.com/ehazlett/certm for examples."

}check_certs() {if [ -z "$TLS_CERT_PATH" ]; thenreturnfiif [ ! -e $TLS_CERT_PATH ]; thenecho "Error: unable to find certificates in $TLS_CERT_PATH"show_cert_helpexit 1fiif [ "$PROXY_PORT" = "2375" ]; thenPROXY_PORT=2376fiSWARM_PORT=3376SHIPYARD_PROTOCOL=httpsLOCAL_SSL_CA_CERT="$TLS_CERT_PATH/ca.pem"LOCAL_SSL_CERT="$TLS_CERT_PATH/server.pem"LOCAL_SSL_KEY="$TLS_CERT_PATH/server-key.pem"LOCAL_SSL_CLIENT_CERT="$TLS_CERT_PATH/cert.pem"LOCAL_SSL_CLIENT_KEY="$TLS_CERT_PATH/key.pem"SSL_CA_CERT="$CERT_PATH/ca.pem"SSL_CERT="$CERT_PATH/server.pem"SSL_KEY="$CERT_PATH/server-key.pem"SSL_CLIENT_CERT="$CERT_PATH/cert.pem"SSL_CLIENT_KEY="$CERT_PATH/key.pem"CERT_FINGERPRINT=$(openssl x509 -noout -in $LOCAL_SSL_CERT -fingerprint -sha256 | awk -F= '{print $2;}')if [ ! -e $LOCAL_SSL_CA_CERT ] || [ ! -e $LOCAL_SSL_CERT ] || [ ! -e $LOCAL_SSL_KEY ] || [ ! -e $LOCAL_SSL_CLIENT_CERT ] || [ ! -e $LOCAL_SSL_CLIENT_KEY ]; thenecho "Error: unable to find certificates"show_cert_helpexit 1fiENABLE_TLS=1

}# container functions

start_certs() {ID=$(docker run \-ti \-d \--restart=always \--name $PREFIX-certs \-v $CERT_PATH \alpine \sh)if [ $ENABLE_TLS = 1 ]; thendocker cp $LOCAL_SSL_CA_CERT $PREFIX-certs:$SSL_CA_CERTdocker cp $LOCAL_SSL_CERT $PREFIX-certs:$SSL_CERTdocker cp $LOCAL_SSL_KEY $PREFIX-certs:$SSL_KEYdocker cp $LOCAL_SSL_CLIENT_CERT $PREFIX-certs:$SSL_CLIENT_CERTdocker cp $LOCAL_SSL_CLIENT_KEY $PREFIX-certs:$SSL_CLIENT_KEYfi

}remove_certs() {docker rm -fv $PREFIX-certs > /dev/null 2>&1

}get_ip() {if [ -z "$SHIPYARD_IP" ]; thenSHIPYARD_IP=`docker run --rm --net=host alpine ip route get 8.8.8.8 | awk '{ print $7; }'`fi

}start_discovery() {get_ipID=$(docker run \-ti \-d \-p 4001:4001 \-p 7001:7001 \--restart=always \--name $PREFIX-discovery \microbox/etcd:latest -addr $SHIPYARD_IP:$DISCOVERY_PORT -peer-addr $SHIPYARD_IP:$DISCOVERY_PEER_PORT)

}remove_discovery() {docker rm -fv $PREFIX-discovery > /dev/null 2>&1

}start_rethinkdb() {ID=$(docker run \-ti \-d \--restart=always \--name $PREFIX-rethinkdb \rethinkdb)

}remove_rethinkdb() {docker rm -fv $PREFIX-rethinkdb > /dev/null 2>&1

}start_proxy() {TLS_OPTS=""if [ $ENABLE_TLS = 1 ]; thenTLS_OPTS="-e SSL_CA=$SSL_CA_CERT -e SSL_CERT=$SSL_CERT -e SSL_KEY=$SSL_KEY -e SSL_SKIP_VERIFY=1"fi# Note: we add SSL_SKIP_VERIFY=1 to skip verification of the client# certificate in the proxy image. this will pass it to swarm that# does verify. this helps with performance and avoids certificate issues# when running through the proxy. ultimately if the cert is invalid# swarm will fail to return.ID=$(docker run \-ti \-d \-p $PROXY_PORT:$PROXY_PORT \--hostname=$HOSTNAME \--restart=always \--name $PREFIX-proxy \-v /var/run/docker.sock:/var/run/docker.sock \-e PORT=$PROXY_PORT \--volumes-from=$PREFIX-certs $TLS_OPTS\shipyard/docker-proxy:latest)

}remove_proxy() {docker rm -fv $PREFIX-proxy > /dev/null 2>&1

}start_swarm_manager() {get_ipTLS_OPTS=""if [ $ENABLE_TLS = 1 ]; thenTLS_OPTS="--tlsverify --tlscacert=$SSL_CA_CERT --tlscert=$SSL_CERT --tlskey=$SSL_KEY"fiEXTRA_RUN_OPTS=""if [ -z "$DISCOVERY" ]; thenDISCOVERY="$DISCOVERY_BACKEND://discovery:$DISCOVERY_PORT"EXTRA_RUN_OPTS="--link $PREFIX-discovery:discovery"fiID=$(docker run \-ti \-d \--restart=always \--name $PREFIX-swarm-manager \--volumes-from=$PREFIX-certs $EXTRA_RUN_OPTS \swarm:latest \m --replication --addr $SHIPYARD_IP:$SWARM_PORT --host tcp://0.0.0.0:$SWARM_PORT $TLS_OPTS $DISCOVERY)

}remove_swarm_manager() {docker rm -fv $PREFIX-swarm-manager > /dev/null 2>&1

}start_swarm_agent() {get_ipif [ -z "$DISCOVERY" ]; thenDISCOVERY="$DISCOVERY_BACKEND://discovery:$DISCOVERY_PORT"EXTRA_RUN_OPTS="--link $PREFIX-discovery:discovery"fiID=$(docker run \-ti \-d \--restart=always \--name $PREFIX-swarm-agent $EXTRA_RUN_OPTS \swarm:latest \j --addr $SHIPYARD_IP:$PROXY_PORT $DISCOVERY)

}remove_swarm_agent() {docker rm -fv $PREFIX-swarm-agent > /dev/null 2>&1

}start_controller() {#-v $CERT_PATH:/etc/docker:ro \TLS_OPTS=""if [ $ENABLE_TLS = 1 ]; thenTLS_OPTS="--tls-ca-cert $SSL_CA_CERT --tls-cert=$SSL_CERT --tls-key=$SSL_KEY --shipyard-tls-ca-cert=$SSL_CA_CERT --shipyard-tls-cert=$SSL_CERT --shipyard-tls-key=$SSL_KEY"fiID=$(docker run \-ti \-d \--restart=always \--name $PREFIX-controller \--link $PREFIX-rethinkdb:rethinkdb \--link $PREFIX-swarm-manager:swarm \-p $SHIPYARD_PORT:$SHIPYARD_PORT \--volumes-from=$PREFIX-certs \$IMAGE \--debug \server \--listen :$SHIPYARD_PORT \-d tcp://swarm:$SWARM_PORT $TLS_OPTS $SHIPYARD_ARGS)

}wait_for_available() {set +e IP=$1PORT=$2echo Waiting for Shipyard on $IP:$PORTdocker pull ehazlett/curl > /dev/null 2>&1TLS_OPTS=""if [ $ENABLE_TLS = 1 ]; thenTLS_OPTS="-k"fiuntil $(docker run --rm ehazlett/curl --output /dev/null --connect-timeout 1 --silent --head --fail $TLS_OPTS $SHIPYARD_PROTOCOL://$IP:$PORT/ > /dev/null 2>&1); doprintf '.'sleep 1 doneprintf '\n'

}remove_controller() {docker rm -fv $PREFIX-controller > /dev/null 2>&1

}if [ "$ACTION" = "deploy" ]; thenset -echeck_certsget_ip echo "Deploying Shipyard"echo " -> Starting Database"start_rethinkdbecho " -> Starting Discovery"start_discoveryecho " -> Starting Cert Volume"start_certsecho " -> Starting Proxy"start_proxyecho " -> Starting Swarm Manager"start_swarm_managerecho " -> Starting Swarm Agent"start_swarm_agentecho " -> Starting Controller"start_controllerwait_for_available $SHIPYARD_IP $SHIPYARD_PORTecho "Shipyard available at $SHIPYARD_PROTOCOL://$SHIPYARD_IP:$SHIPYARD_PORT"if [ $ENABLE_TLS = 1 ] && [ ! -z "$CERT_FINGERPRINT" ]; thenecho "SSL SHA-256 Fingerprint: $CERT_FINGERPRINT"fiecho "Username: admin Password: shipyard"elif [ "$ACTION" = "node" ]; thenset -eif [ -z "$DISCOVERY" ]; thenecho "You must set the DISCOVERY environment variable"echo "with the discovery system used with Swarm"exit 1ficheck_certsecho "Adding Node"echo " -> Starting Cert Volume"start_certsecho " -> Starting Proxy"start_proxyecho " -> Starting Swarm Manager"start_swarm_manager $DISCOVERYecho " -> Starting Swarm Agent"start_swarm_agentecho "Node added to Swarm: $SHIPYARD_IP"elif [ "$ACTION" = "upgrade" ]; thenset -echeck_certsget_ipecho "Upgrading Shipyard"echo " -> Pulling $IMAGE"docker pull $IMAGEecho " -> Upgrading Controller"remove_controllerstart_controllerwait_for_available $SHIPYARD_IP $SHIPYARD_PORTecho "Shipyard controller updated"elif [ "$ACTION" = "remove" ]; then# ignore errorsset +eecho "Removing Shipyard"echo " -> Removing Database"remove_rethinkdbecho " -> Removing Discovery"remove_discoveryecho " -> Removing Cert Volume"remove_certsecho " -> Removing Proxy"remove_proxyecho " -> Removing Swarm Agent"remove_swarm_agentecho " -> Removing Swarm Manager"remove_swarm_managerecho " -> Removing Controller"remove_controllerecho "Done"

elseecho "Unknown action $ACTION"exit 1

fi

安装完成后,访问:http:服务器ip:8080 默认账号密码:admin/shipyard (控制台可修改)

[root@docker]-[~/docker-ui]-#docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

2308552f63a9 dockerclub/shipyard:latest "/bin/controller --d…" About an hour ago Up About an hour 0.0.0.0:8080->8080/tcp, :::8080->8080/tcp shipyard-controller

1676327a4e5a swarm:latest "/swarm j --addr 10.…" About an hour ago Up About an hour 2375/tcp shipyard-swarm-agent

2f368d9f81df swarm:latest "/swarm m --replicat…" About an hour ago Up About an hour 2375/tcp shipyard-swarm-manager

c38108f757c5 shipyard/docker-proxy:latest "/usr/local/bin/run" About an hour ago Up About an hour 2375/tcp, 0.0.0.0:2376->2376/tcp, :::2376->2376/tcp shipyard-proxy

e610645dfe8e alpine "sh" About an hour ago Up About an hour shipyard-certs

c444c7df39f4 microbox/etcd:latest "/bin/etcd -addr 10.…" About an hour ago Up About an hour 0.0.0.0:4001->4001/tcp, :::4001->4001/tcp, 0.0.0.0:7001->7001/tcp, :::7001->7001/tcp shipyard-discovery

307b4cec4659 rethinkdb "rethinkdb --bind all" About an hour ago Up About an hour 8080/tcp, 28015/tcp, 29015/tcp shipyard-rethinkdb----------------------------------------------------------------------------------------

1)RethinkDB

deploy首先启动的就是RethinkDB容器,shipyard采用RethinkDB作为数据库来保存用户等信息

2)Discovery

为了使用Swarm,我们需要一个外部的密钥值存储群容器,shipyard默认是采用了etcd。

3)shipyard_certs

证书管理容器,实现证书验证功能

4)Proxy

默认情况下,Docker引擎只监听Socket,我们可以重新配置引擎使用TLS或者使用一个代理容器,转发请求从TCP到Docker监听的UNIX Socket。

5)Swarm Manager

Swarm管理器

6)Swarm Agent

Swarm代理,运行在每个节点上。

7)Controller

shipyard控制器,Remote API的实现和web的实现。4.4 Ward、Lsky Pro、VoceChat

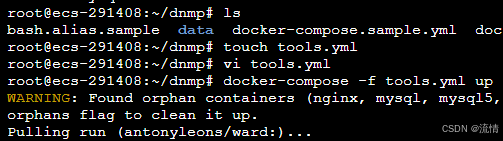

这三个的安装更简单了,因为都是单个镜像的应用服务,所以直接走docker-compose.yml配置项就好,再通过docker-compose up一次性构建就行。为了不影响之前的dnmp配置。这里我们构建时采用别名的方式。

进入dnmp目录,创建一个tools.yml配置文件,输入执行命令:

docker-compose -f tools.yml up

tools.yml

#vocechat:多人聊天,端口3019

#lsky-pro:兰空图床,端口7791

#ward:服务器监控工具,端口4000version: '3.3'

services:run:restart: unless-stoppedcontainer_name: wardports:- '4000:4000'environment:- WARD_PORT=4000- WARD_THEME=dark- WARD_NAME=leons-serverprivileged: trueimage: antonyleons/wardvocechat:restart: alwaysports:- '3019:3000' # 冒号左边可以改成自己服务器未被占用的端口container_name: vocechat-servervolumes:- './data:/home/vocechat-server/data' # 冒号左边可以改路径,现在是表示把数据存放在在当前文件夹下的 data 文件夹中image: privoce/vocechat-server:latestlsky-pro:container_name: lsky-proimage: dko0/lsky-prorestart: alwaysvolumes:- ./data/html:/var/www/html #映射到本地ports:- 7791:80environment:- MYSQL_HOST=mysql- MYSQL_DATABASE=lsky-pro- MYSQL_USER=lsky-pro- MYSQL_PASSWORD=lsky-pro5.总结畅想

细心的人可能发现了,文章开头说的kaillinux这里没有提及。倒不是说lz没有搭建。只不过kaillinux作为专用渗透,正经开发过程中基本也不咋会用到。而且kaillinux可用的工具包,如nmap,sqlmap,hydra等等,这些一时半会也是说不完的。另外lz也在了解学习中,等了解差不多了。后面会专门开一篇博客来说明。从安装到使用,尽量从新手的角度来进行解说。

学吧,学无止境!随着互联网浪潮的到来,希望各位都能乘风破浪~书写自己的传奇!

他强任他强,清风拂山岗;他卷任他卷,读书破万卷

相关文章:

【docker综合篇】关于我用docker搭建了6个应用服务的事

最近一直在捣鼓docker,利用测试服务器,本着犯错就重来(重装系统)的大无畏精神,不断尝试,总结经验,然后在网上搜寻一些关于docker有关的服务镜像,并搭建起来。看着一个个服务在我的服务器跑起来,…...

【sgCreateAPIFunction】自定义小工具:敏捷开发→自动化生成API接口方法代码片段脚本(接口方法代码生成工具)

sgCreateAPIFunction源码 <template><!-- 前往https://blog.csdn.net/qq_37860634/article/details/141159084 查看使用说明 --><div :class"$options.name"><div class"sg-head">接口方法生成工具<el-dropdown:show-timeou…...

)

Vue2图片懒加载(vue-lazyload)

参考文档:vue-lazyload 安装插件 npm install vue-lazyload # or yarn add vue-lazyload # or pnpm add vue-lazyload使用 使用方式 一: 所有懒加载图片的占位图使用同一张默认图片 引入并注册 // main.js import VueLazyload from vue-lazyload Vue…...

Jenkins-拉取代码

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言一、Jenkins环境配置(一)配置Maven环境(1)Maven下载(2)将Maven上传服务器(3&…...

深度解析:.secret勒索病毒如何加密你的数据并勒索赎金

引言: 在当今这个数字化、信息化的时代,网络安全已成为一个不容忽视的重要议题。随着互联网的普及和技术的飞速发展,我们的生活、工作乃至整个社会的运转都越来越依赖于各种计算机系统和网络。然而,这种高度依赖也为我们带来了前…...

测试岗位应该学什么

以下是测试岗位需要学习的一些关键内容: 1. 测试理论和方法 - 了解不同类型的测试,如功能测试、性能测试、压力测试、安全测试、兼容性测试等。 - 掌握测试策略和测试计划的制定。 2. 编程语言 - 至少熟悉一种编程语言,如 Python、Java…...

【RISC-V设计-12】- RISC-V处理器设计K0A之验证环境

【RISC-V设计-12】- RISC-V处理器设计K0A之验证环境 文章目录 【RISC-V设计-12】- RISC-V处理器设计K0A之验证环境1.简介2.验证顶层3.顶层代码4.模型结构4.1 地址映射4.2 特殊功能寄存器 5.模型代码6.运行脚本7.总结 1.简介 在前几篇文章中,分别介绍了各个模块的设…...

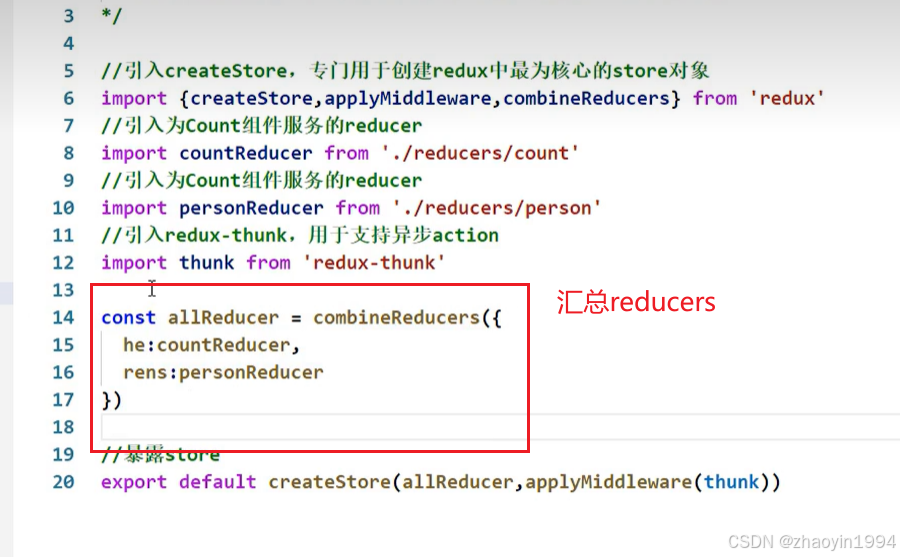

react-redux的使用

关于react-redux 首先:react-redux和redux并不是一个东西,redux是一个独立的东西,react-redux是react官方根据市场偏好redux推出的react插件库。 了解react-redux的原理图: 安装:npm i react-redux redux的ui组件和…...

大模型在chat bi 场景下的优化思路

文章目录 背景提示词模版表结构注释示例数据给出示例答案语法验证外挂知识库 背景 大模型的出现使chat bi 成为一种可能,自然语句的交互,极大的提高了数据分析的效率,也极大的降低了用户使用的门槛。下面主要列出几点提高自然语句转成SQL的技…...

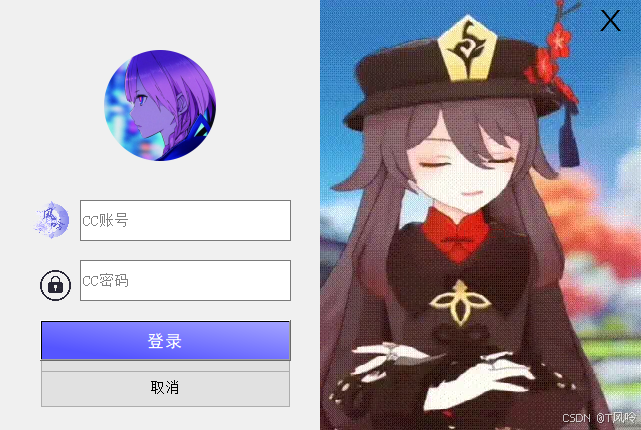

Qt登录窗口

#include "widget.h" #include "ui_widget.h"Widget::Widget(QWidget *parent): QWidget(parent), ui(new Ui::Widget),btn(new QPushButton("取消", this)),login_btn(new QPushButton("登录", this)) { ui->setupUi(this);thi…...

Zookeeper的在Ubuntu20.04上的集群部署

安装资源 官方安装包下载地址:https://zookeeper.apache.org/releases.html 懒得找版本的可以移步下载zookeeper3.84稳定版本: https://download.csdn.net/download/qq_43439214/89646735 安装方法 创建安装路径&&解压安装包 # 创建路径 m…...

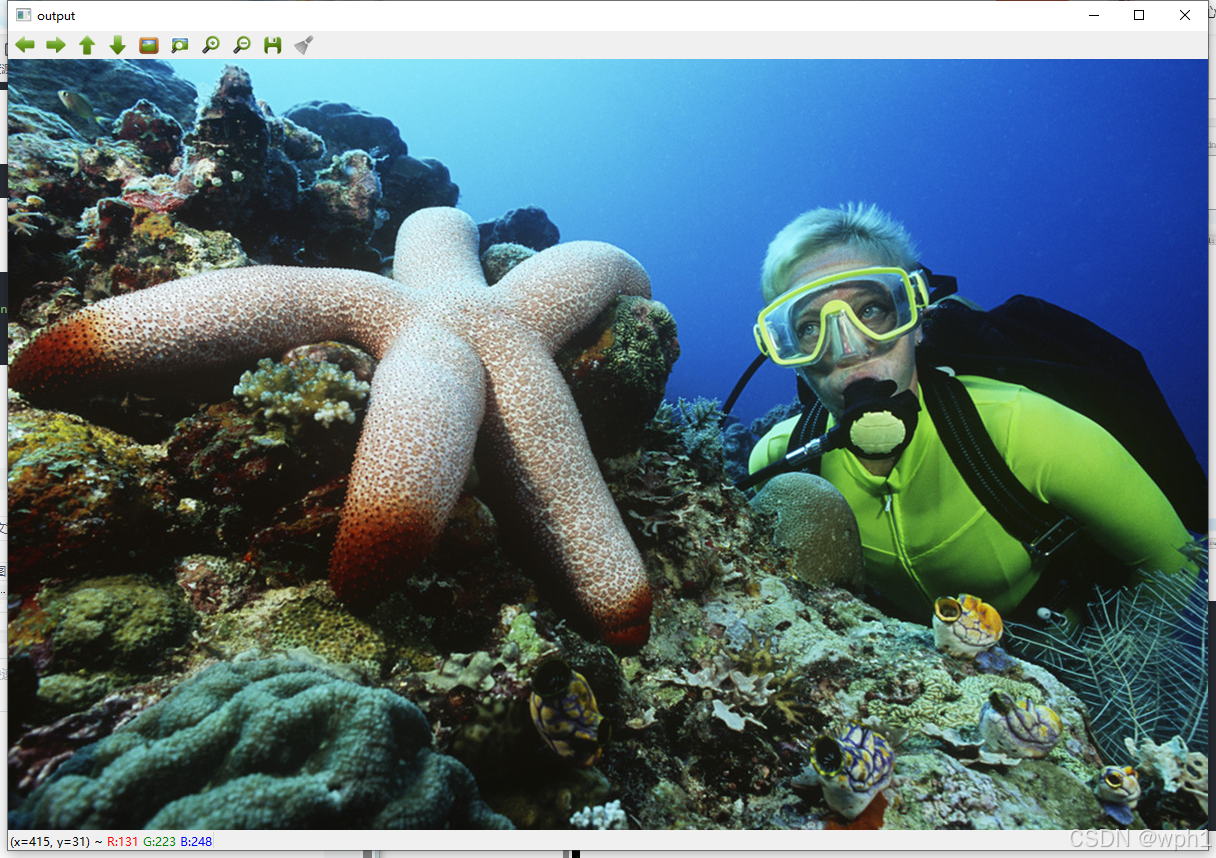

Qt+OpenCV配置和测试

一、前言 OpenCV作为比较大众化的跨平台计算机视觉开源库,可以运行在多种操作系统上,通过与Qt的结合,能够轻松的是实现一些图像处理和识别的任务,本文在Windows操作系统的基础上具体讲解Qt和OpenCV的配置和环境搭建方法ÿ…...

Ruby GUI宝典:探索顶级图形界面库

标题:Ruby GUI宝典:探索顶级图形界面库 Ruby,这门以优雅和简洁著称的语言,不仅在服务器端编程中大放异彩,其在图形用户界面(GUI)开发上同样拥有不可忽视的地位。本文将带领大家深入了解Ruby的G…...

探索Jinja2的神秘力量:Python模板引擎的魔法之旅

文章目录 探索Jinja2的神秘力量:Python模板引擎的魔法之旅1. 背景:为何选择Jinja2?2. 什么是Jinja2?3. 安装Jinja2:一键启程4. 基础用法:Jinja2的五大法宝5. 实战演练:Jinja2在场景中的应用6. 常…...

Vue3小兔仙电商项目实战

Vue3小兔仙电商项目实战 项目技术栈 create-vuePiniaElementPlusVue3-SetupVue-RouterVueUse 项目规模 项目亮点: 基于业务逻辑的组件拆分思想 长页面吸顶交互实现SKU电商组件封装图片懒加载指令封装通用逻辑函数封装面板插槽组件等业务通用组件封装路由缓存问题…...

)

MATLAB基础应用精讲-【数模应用】肯德尔协调系数(附MATLAB、R语言和python代码实现)

目录 前言 几个高频面试题目 肯德尔协调系数低原因? 知识储备 相关性分析对比 1 相关分析 2 Cochrans Q 检验 3 Kappa一致性检验 4 Kendall协调系数 5 组内相关系数 算法原理 数学模型 SPSSPRO:Kendall一致性检验 1、作用 2、输入输出描述 3、案例示例 4、案…...

计算函数(c语言)

1.描述 //小乐乐学会了自定义函数,BoBo老师给他出了个问题,根据以下公式计算m的值。 // //其中 max3函数为计算三个数的最大值,如: max3(1, 2, 3) 返回结果为3。 //输入描述: //一行,输入三个整数ÿ…...

Linux 7 x86平台上安装达梦8数据库

1、环境描述 2、安装前准备 2.1 操作系统信息调研 Linux平台需要通过命令查看操作系统版本、位数、磁盘空间、内存等信息。 CPU信息 [rootray1 ~]# cat /proc/cpuinfo | grep -E "physical id|core id|cpu cores|siblings|cpu MHz|model name|cache size"|tail -n…...

【老张的程序人生】我命由我不由天:我的计算机教师中级岗之旅

在计算机行业的洪流中,作为一名20年计算机专业毕业的博主,我深知这几年就业的坎坷与辉煌。今天,我想与大家分享我的故事,一段关于梦想、挑战与坚持的计算机教师中级岗之旅。希望我的经历能为大家提供一个发展方向,在计…...

1.Linux_常识

UNIX、Linux、GNU 1、UNIX UNIX是一个分时操作系统,特点是多用户、多任务 实时操作系统:来了请求就去解决请求 分时操作系统:来了请求先存着,通过调度轮到执行时执行 2、Linux Linux是一个操作系统内核 发行版本࿱…...

网络六边形受到攻击

大家读完觉得有帮助记得关注和点赞!!! 抽象 现代智能交通系统 (ITS) 的一个关键要求是能够以安全、可靠和匿名的方式从互联车辆和移动设备收集地理参考数据。Nexagon 协议建立在 IETF 定位器/ID 分离协议 (…...

docker详细操作--未完待续

docker介绍 docker官网: Docker:加速容器应用程序开发 harbor官网:Harbor - Harbor 中文 使用docker加速器: Docker镜像极速下载服务 - 毫秒镜像 是什么 Docker 是一种开源的容器化平台,用于将应用程序及其依赖项(如库、运行时环…...

2024年赣州旅游投资集团社会招聘笔试真

2024年赣州旅游投资集团社会招聘笔试真 题 ( 满 分 1 0 0 分 时 间 1 2 0 分 钟 ) 一、单选题(每题只有一个正确答案,答错、不答或多答均不得分) 1.纪要的特点不包括()。 A.概括重点 B.指导传达 C. 客观纪实 D.有言必录 【答案】: D 2.1864年,()预言了电磁波的存在,并指出…...

如何在看板中有效管理突发紧急任务

在看板中有效管理突发紧急任务需要:设立专门的紧急任务通道、重新调整任务优先级、保持适度的WIP(Work-in-Progress)弹性、优化任务处理流程、提高团队应对突发情况的敏捷性。其中,设立专门的紧急任务通道尤为重要,这能…...

涂鸦T5AI手搓语音、emoji、otto机器人从入门到实战

“🤖手搓TuyaAI语音指令 😍秒变表情包大师,让萌系Otto机器人🔥玩出智能新花样!开整!” 🤖 Otto机器人 → 直接点明主体 手搓TuyaAI语音 → 强调 自主编程/自定义 语音控制(TuyaAI…...

mac 安装homebrew (nvm 及git)

mac 安装nvm 及git 万恶之源 mac 安装这些东西离不开Xcode。及homebrew 一、先说安装git步骤 通用: 方法一:使用 Homebrew 安装 Git(推荐) 步骤如下:打开终端(Terminal.app) 1.安装 Homebrew…...

【JavaSE】多线程基础学习笔记

多线程基础 -线程相关概念 程序(Program) 是为完成特定任务、用某种语言编写的一组指令的集合简单的说:就是我们写的代码 进程 进程是指运行中的程序,比如我们使用QQ,就启动了一个进程,操作系统就会为该进程分配内存…...

【网络安全】开源系统getshell漏洞挖掘

审计过程: 在入口文件admin/index.php中: 用户可以通过m,c,a等参数控制加载的文件和方法,在app/system/entrance.php中存在重点代码: 当M_TYPE system并且M_MODULE include时,会设置常量PATH_OWN_FILE为PATH_APP.M_T…...

毫米波雷达基础理论(3D+4D)

3D、4D毫米波雷达基础知识及厂商选型 PreView : https://mp.weixin.qq.com/s/bQkju4r6med7I3TBGJI_bQ 1. FMCW毫米波雷达基础知识 主要参考博文: 一文入门汽车毫米波雷达基本原理 :https://mp.weixin.qq.com/s/_EN7A5lKcz2Eh8dLnjE19w 毫米波雷达基础…...

SQL Server 触发器调用存储过程实现发送 HTTP 请求

文章目录 需求分析解决第 1 步:前置条件,启用 OLE 自动化方式 1:使用 SQL 实现启用 OLE 自动化方式 2:Sql Server 2005启动OLE自动化方式 3:Sql Server 2008启动OLE自动化第 2 步:创建存储过程第 3 步:创建触发器扩展 - 如何调试?第 1 步:登录 SQL Server 2008第 2 步…...