深度学习(七)深度强化学习:融合创新的智能之路(7/10)

一、深度强化学习的崛起

深度强化学习在人工智能领域的重要地位

深度强化学习作为一种融合了深度学习和强化学习的新技术,在人工智能领域占据着至关重要的地位。它结合了深度学习强大的感知能力和强化学习优秀的决策能力,能够处理复杂的任务和环境。例如,在游戏领域,深度强化学习模型如 AlphaGo 等在围棋领域战胜了世界冠军,展现出了超越人类的智能水平。在机器人控制方面,深度强化学习可以让机器人通过与环境的交互,学习到优化的控制策略,从而在复杂环境下执行任务和决策,为工业自动化和智能家居等领域带来了新的发展机遇。

深度强化学习的发展趋势

随着计算能力的不断提高和数据的不断积累,深度强化学习的发展趋势十分乐观。一方面,算法优化将持续进行。研究人员将不断改进深度强化学习算法,提高模型的准确性、稳定性和可解释性。例如,通过引入新的神经网络结构或优化奖励机制,使模型能够更快地收敛到最优策略。另一方面,深度强化学习将与其他技术进行更深入的融合。如与迁移学习结合,让模型能够利用已有的知识快速适应新的任务和环境;与元学习结合,使模型能够学会如何学习,提高其在不同任务中的泛化能力。此外,深度强化学习的应用领域也将不断扩展,除了游戏、机器人控制等传统领域,还将在医疗诊断、自然语言处理和智能推荐等领域发挥重要作用。

二、深度学习与强化学习的结合原理

(一)深度学习基础

深度学习是人工智能的一个重要分支,它采用多层神经网络模型来处理数据和任务。这种模型能够有效地捕捉输入数据的复杂特征,从而实现更好的预测和分类。深度学习模型通常包括多层神经网络,可以自动学习特征表示。其主要组件有:

- 神经网络:一种模拟人脑神经元的计算模型,可以学习表示。通过大量的数据进行训练,神经网络可以自动提取数据中的特征,从而实现对数据的分类、预测等任务。

- 损失函数:用于衡量模型预测与真实值之间差异的函数。常见的损失函数有均方误差、交叉熵等。损失函数的值越小,说明模型的预测结果与真实值越接近。

- 优化算法:用于更新模型参数的方法。常见的优化算法有梯度下降、随机梯度下降、Adam 等。优化算法通过不断调整模型的参数,使得损失函数的值最小化,从而提高模型的性能。

(二)强化学习基础

强化学习是一种学习决策策略的方法,通过与环境的互动来学习,以最大化累积收益。强化学习问题通常包括以下几个组件:

- 状态:环境的描述,可以是数字或连续值。状态是强化学习系统对环境的感知,它反映了环境的当前情况。

- 动作:强化学习系统可以采取的行为。动作是强化学习系统对环境的影响,它决定了环境的下一个状态。

- 奖励:环境给出的反馈,表示当前行为的好坏。奖励是强化学习系统的目标,它反映了环境对动作的评价。

- 策略:强化学习系统采取行为的规则。策略是强化学习系统的决策机制,它决定了在不同的状态下采取什么动作。

(三)结合的目标与方式

结合深度学习和强化学习的主要目标是利用深度学习的表示能力,提高强化学习的决策性能。具体来说,我们可以将深度学习模型作为强化学习系统的价值网络或策略网络,以实现更强大的智能决策。

- 价值网络:使用深度神经网络作为价值网络,将状态映射到价值。价值网络通过学习状态与价值之间的关系,为强化学习系统提供决策依据。例如,在深度 Q 学习中,价值网络用于估计 Q 值,即状态动作对的价值。

- 策略网络:使用深度神经网络作为策略网络,将状态映射到动作概率。策略网络通过学习状态与动作概率之间的关系,为强化学习系统提供决策策略。例如,在策略梯度方法中,策略网络用于直接优化策略,通过梯度下降来更新策略参数。

三、核心算法与实例

(一)深度 Q 学习

深度 Q 学习是一种结合了深度学习和 Q 学习的方法,它使用神经网络来表示 Q 值函数,以估计连续状态空间下每个动作的期望回报。其操作步骤如下:

- 初始化神经网络参数,通常随机初始化。

- 从当前状态中随机选择一个动作,执行该动作,得到下一个状态和奖励。

- 使用当前状态和奖励计算目标 Q 值。

- 使用当前模型预测当前状态下各个动作的 Q 值。

- 计算模型预测值与目标值之间的差值,并使用梯度下降法更新模型参数。

- 重复步骤 2 - 5,直到模型参数收敛。

数学模型公式为: ,其中, 表示状态 下执行动作 的累积奖励, 是折现因子, 是时刻 的奖励。

以解决 CartPole 问题为例,以下是深度 Q 学习的应用代码展示:

import gymnasium as gym

import torch

import torch.nn as nn

import torch.nn.functional as F

import randomclass ReplayMemory:def __init__(self, capacity):self.capacity = capacityself.memory = []def push(self, state, action, reward, next_state, done):self.memory.append((state, action, reward, next_state, done))if len(self.memory) > self.capacity:self.memory.pop(0)def sample(self, batch_size):return random.sample(self.memory, batch_size)def __len__(self):return len(self.memory)class DQN(nn.Module):def __init__(self, input_size, output_size):super(DQN, self).__init__()self.fc1 = nn.Linear(input_size, 64)self.fc2 = nn.Linear(64, 64)self.fc3 = nn.Linear(64, output_size)def forward(self, x):x = F.relu(self.fc1(x))x = F.relu(self.fc2(x))return self.fc3(x)class Agent:def __init__(self, state_size, action_size, device):self.state_size = state_sizeself.action_size = action_sizeself.device = deviceself.q_network = DQN(state_size, action_size).to(device)self.optimizer = torch.optim.Adam(self.q_network.parameters(), lr=0.001)def act(self, state):state = torch.tensor(state, dtype=torch.float).unsqueeze(0).to(self.device)return self.q_network(state).max(1)[1].item()def learn(self, states, actions, rewards, next_states, dones):states = torch.stack(states).to(self.device)actions = torch.tensor(actions).to(self.device)rewards = torch.tensor(rewards).to(self.device)next_states = torch.stack(next_states).to(self.device)dones = torch.tensor(dones).to(self.device)q_values = self.q_network(states).gather(1, actions.unsqueeze(-1)).squeeze(-1)next_q_values = self.q_network(next_states).max(1)[0].detach()targets = rewards + (1 - dones) * 0.99 * next_q_valuesloss = torch.mean((q_values - targets)**2)self.optimizer.zero_grad()loss.backward()self.optimizer.step()return loss.item()def train_dqn(agent, num_episodes, memory, batch_size):rewards = []for episode in range(num_episodes):state, _ = env.reset()state = torch.tensor(state, dtype=torch.float).unsqueeze(0)done = Falsetotal_reward = 0while not done:action = agent.act(state)next_state, reward, done, _, _ = env.step(action)next_state = torch.tensor(next_state, dtype=torch.float).unsqueeze(0)memory.push(state, action, reward, next_state, done)state = next_statetotal_reward += rewardif len(memory) > batch_size:states, actions, rewards, next_states, dones = memory.sample(batch_size)loss = agent.learn(states, actions, rewards, next_states, dones)rewards.append(total_reward)return rewardsenv = gym.make("CartPole-v1")

n_observations = env.observation_space.shape[0]

n_actions = env.action_space.n

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

agent = Agent(n_observations, n_actions, device)

memory = ReplayMemory(10000)

num_episodes = 500

batch_size = 32

rewards = train_dqn(agent, num_episodes, memory, batch_size)(二)策略梯度方法

策略梯度方法是一种直接优化策略的算法,通过梯度下降来优化策略。操作步骤如下:

- 初始化策略参数。

- 选择一个随机的初始状态。

- 根据当前策略选择一个动作。

- 执行动作并得到奖励。

- 更新策略参数。

- 重复步骤 2 - 5,直到收敛。

数学模型公式为: ,其中, 表示策略价值函数, 表示策略, 表示累积奖励。

以 CartPole 问题为例,代码展示如下:

import gym

import torch

import torch.nn as nn

import torch.optim as optimclass PolicyNetwork(nn.Module):def __init__(self, input_size, output_size):super(PolicyNetwork, self).__init__()self.fc1 = nn.Linear(input_size, 64)self.fc2 = nn.Linear(64, output_size)def forward(self, x):x = torch.relu(self.fc1(x))return torch.softmax(self.fc2(x), dim=-1)env = gym.make("CartPole-v1")

observation_space = env.observation_space.shape[0]

action_space = env.action_space.npolicy_net = PolicyNetwork(observation_space, action_space)

optimizer = optim.Adam(policy_net.parameters(), lr=0.01)def select_action(state):state_tensor = torch.FloatTensor(state)action_probs = policy_net(state_tensor)return torch.multinomial(action_probs, 1).item()def update_policy(rewards):discounted_rewards = []R = 0for r in reversed(rewards):R = r + 0.99 * Rdiscounted_rewards.insert(0, R)discounted_rewards = torch.FloatTensor(discounted_rewards)discounted_rewards = (discounted_rewards - discounted_rewards.mean()) / (discounted_rewards.std() + 1e-5)optimizer.zero_grad()for i, log_prob in enumerate(log_probs):loss = -log_prob * discounted_rewards[i]loss.backward()optimizer.step()for episode in range(1000):state = env.reset()[0]log_probs = []rewards = []done = Falsewhile not done:action = select_action(state)next_state, reward, done, _, _ = env.step(action)log_prob = torch.log(policy_net(torch.FloatTensor(state))[action])log_probs.append(log_prob)rewards.append(reward)state = next_stateupdate_policy(rewards)(三)基于价值的方法

基于价值的方法的操作步骤如下:

- 初始化价值函数的参数。

- 根据当前价值函数选择动作。

- 执行动作并观察新的状态和奖励。

- 更新价值函数的参数,使得价值函数更准确地估计状态的价值。

- 重复步骤 2 - 4,直到价值函数收敛。

数学模型公式通常基于贝尔曼方程,例如在状态价值函数 的更新中, ,其中 是在状态 下选择动作 的概率, 是在状态 下执行动作 的奖励, 是折扣因子, 是下一个状态。

以 CartPole 问题为例,代码如下:

import gym

import numpy as npenv = gym.make("CartPole-v1")

num_states = env.observation_space.shape[0]

num_actions = env.action_space.n

gamma = 0.99

learning_rate = 0.1value_function = np.zeros((num_states, num_actions))def select_action(state):return np.argmax(value_function[state])for episode in range(1000):state = env.reset()[0]done = Falsewhile not done:action = select_action(state)next_state, reward, done, _, _ = env.step(action)value_function[state][action] += learning_rate * (reward + gamma * np.max(value_function[next_state]) - value_function[state][action])state = next_state四、在游戏领域的应用

(一)游戏行业的需求与机遇

游戏行业作为一个充满活力和创新的领域,一直在不断寻求新的技术来提升游戏体验和开发效率。近年来,游戏市场规模不断扩大,游戏类型也日益多样化。据统计,2023 年全球游戏市场规模将达到 400 亿美元,其中移动游戏市场规模将占据 60% 以上。

随着游戏行业的发展,玩家对游戏的品质和智能性要求越来越高。传统的游戏开发方法已经难以满足这些需求,而深度强化学习的出现为游戏行业带来了新的机遇。深度强化学习可以通过与游戏环境的交互,自动学习最优的游戏策略,从而提升游戏性能和玩家体验。

例如,在游戏 AI 开发中,深度强化学习可以训练游戏内的机器人和 NPC,使其行为更加智能和自然。传统的游戏内机器人和 NPC 通常采用基于规则的行为树来实现,这种方法存在策略单一、难以覆盖完整游戏周期等问题。而深度强化学习可以让机器人和 NPC 通过不断试错和学习,适应不同的游戏场景和玩家行为,从而提高游戏的可玩性和挑战性。

此外,深度强化学习还可以应用于游戏关卡设计、游戏平衡调整和游戏推荐系统等方面。通过学习大量的游戏数据,深度强化学习可以自动设计出具有挑战性和趣味性的游戏关卡,调整游戏的平衡性,以及根据玩家的兴趣和行为推荐最适合的游戏内容,提升玩家的游戏体验。

(二)具体应用场景

- 提升游戏性能

深度强化学习可以通过优化游戏策略,提升游戏的性能。例如,在策略游戏中,深度强化学习可以帮助玩家制定最优的战略决策,提高游戏的胜率。在动作游戏中,深度强化学习可以训练游戏角色的动作控制,使其更加灵活和高效。

- 优化游戏内机器人和 NPC

如前文所述,深度强化学习可以训练游戏内的机器人和 NPC,使其行为更加智能和自然。通过与玩家的交互和学习,机器人和 NPC 可以适应不同的玩家风格和游戏场景,提供更加丰富和有趣的游戏体验。

2.游戏关卡设计

深度强化学习可以通过学习大量的游戏数据,自动设计出具有挑战性和趣味性的游戏关卡。这种自动生成关卡的方法可以提高游戏的可玩性和重复性,同时也可以减轻游戏开发者的工作负担。

3.游戏平衡调整

深度强化学习可以通过学习玩家的行为和反馈,自动调整游戏的平衡性。通过优化游戏的难度和奖励机制,深度强化学习可以提高游戏的平衡性和可持续性,吸引更多的玩家参与游戏。

4.游戏推荐系统

深度强化学习可以通过学习玩家的游戏偏好和行为,构建个性化的游戏推荐系统。这种推荐系统可以根据玩家的兴趣和需求,推荐最适合的游戏内容,提升玩家的游戏体验。

五、在自动驾驶领域的应用

(一)自动驾驶的挑战与深度强化学习的优势

自动驾驶面临的挑战

自动驾驶技术的发展被认为是未来交通领域的一大趋势,但与此同时,它也面临着一系列的挑战和难题。这些挑战不仅来自技术层面,还涉及法律、伦理、社会适应性等多个方面。

- 技术挑战:自动驾驶技术的研发需要高度精密的传感器、实时数据处理和人工智能等多方面的支持。然而,目前仍存在着许多技术问题,如在复杂天气条件下的识别、紧急情况下的反应等。尽管已经取得了很大进展,但要实现真正完全自动驾驶仍然面临巨大的挑战。据统计,目前在恶劣天气条件下,自动驾驶系统的准确率会下降 10% - 30% 不等。

- 安全问题:安全一直是自动驾驶技术的最大关切点。人们对于自动驾驶车辆是否能够在各种复杂环境下保持安全驾驶存有疑虑。特别是在遇到紧急情况时,自动驾驶车辆是否能够做出最正确的判断,避免事故发生,这是一个巨大的挑战。例如,当面临突然出现的障碍物或行人时,自动驾驶系统需要在极短的时间内做出反应,其反应时间通常需要在几十毫秒以内。

- 道德困境:自动驾驶车辆在遇到危险时需要做出道德判断,如遇到无法避免的事故时应该保护乘客还是行人。这涉及到伦理和道德问题,同时也需要与法律相结合,但这个问题并没有一个明确的解决方案。

- 法律和法规:自动驾驶技术的应用涉及到一系列法律和法规的制定和修订。目前,很多国家的法律法规并未完全适应自动驾驶技术的发展,尤其是在事故责任、保险等方面的规定还需要进一步明确。

- 社会适应性:自动驾驶技术的普及也需要考虑社会的适应性。人们是否愿意乘坐自动驾驶车辆?他们对于自动驾驶技术的信任程度如何?这些问题都需要考虑。调查显示,目前只有约 40% 的消费者表示愿意乘坐自动驾驶车辆。

- 数据隐私和安全:自动驾驶车辆需要实时获取大量的数据来进行决策,这也带来了数据隐私和安全问题。如果这些数据被不当利用或者遭到黑客攻击,可能会带来严重的后果。

- 基础设施要求:实现自动驾驶技术的商业化应用,需要相应的基础设施支持,包括高精度地图、智能交通管理系统等。这需要各方的合作和投入。

- 社会变革:自动驾驶技术的应用将会对社会产生深远的影响,包括交通、城市规划、就业等方面。如何引导这些变革,使其产生积极的影响,也是一个挑战。

深度强化学习在自动驾驶中的优势

- 提高驾驶安全性:深度强化学习可以通过大量的数据和训练来提高自动驾驶系统的感知、规划和控制能力,从而减少人为驾驶错误和事故风险。它可以更好地应对复杂的交通场景和突发变化,提高驾驶的安全性。例如,通过学习大量的实际驾驶数据,深度强化学习模型可以准确预测其他车辆的行为,提前做出相应的决策,避免碰撞事故的发生。

- 提升驾驶舒适度:深度强化学习可以学习到更加智能和高效的驾驶策略,使驾驶过程更加平稳和舒适。通过优化驾驶决策和控制,自动驾驶车辆可以更好地适应不同的驾驶环境,提供更好的驾驶体验。例如,在行驶过程中,深度强化学习模型可以根据路况和交通流量自动调整车速和行驶路线,减少颠簸和急刹车的情况。

- 促进交通效率:深度强化学习可以提高自动驾驶系统的感知和规划能力,使其能够更好地预测和应对交通流量变化。通过智能的驾驶决策和控制,自动驾驶车辆可以减少交通拥堵,提高交通效率。例如,在交通高峰期,深度强化学习模型可以自动选择最优的行驶路线,避免拥堵路段,从而缩短行驶时间。

(二)具体应用环节

感知与识别

深度增强学习可以学习和提取车辆周围环境的特征,包括道路、车辆、行人等。通过深度神经网络,系统可以获得更准确和鲁棒的感知能力。在复杂的交通场景中,深度增强学习可以帮助自动驾驶系统更好地理解和分析环境信息。例如,利用深度强化学习算法对摄像头采集的图像数据进行处理,可以准确识别出道路上的各种交通标志和标线,以及其他车辆和行人的位置和运动状态。同时,深度强化学习还可以结合激光雷达、毫米波雷达等传感器的数据,实现多模态信息融合,提高感知的准确性和可靠性。

规划与决策

深度增强学习可以结合增强学习算法,通过大量的模拟和实际驾驶数据来训练自动驾驶车辆的规划与决策模型。通过不断地优化,自动驾驶系统可以学习到更加智能和高效的驾驶策略。例如,在多车道变道、交叉口通行等复杂场景中,深度增强学习可以帮助自动驾驶车辆做出更准确和安全的决策。具体来说,深度强化学习模型可以根据当前的交通状况和车辆状态,预测未来的交通变化趋势,从而制定出最优的行驶路线和速度策略。同时,深度强化学习还可以考虑其他车辆和行人的行为,做出更加合理的决策,提高行驶的安全性和效率。

控制与执行

深度增强学习可以将感知和规划的结果转化为具体的控制指令和动作执行。通过学习和模拟训练,自动驾驶系统可以学会如何精确地控制车辆的加速、制动和转向等操作。深度增强学习可以帮助自动驾驶系统更好地适应不同的驾驶环境,提高驾驶的稳定性和安全性。例如,在行驶过程中,深度强化学习模型可以根据当前的车速、路况和车辆状态,自动调整油门、刹车和方向盘的控制力度,实现平稳的加速、减速和转向操作。同时,深度强化学习还可以结合车辆的动力学模型,优化控制策略,提高车辆的操控性能和行驶稳定性。

六、未来展望

深度强化学习的挑战

尽管深度强化学习在游戏、自动驾驶等领域取得了显著的成就,但它仍然面临着一些挑战。

- 数据需求:深度强化学习需要大量的数据来训练模型,这在某些领域可能是难以获取的。例如,在自动驾驶领域,获取真实的驾驶数据需要大量的时间和成本,而且数据的质量也难以保证。此外,深度强化学习模型对数据的分布也非常敏感,如果数据分布发生变化,模型的性能可能会受到很大影响。

- 计算资源:深度强化学习需要大量的计算资源来训练模型,这对于一些资源受限的环境来说可能是不可行的。例如,在移动设备上运行深度强化学习模型可能会受到计算能力和电池寿命的限制。此外,深度强化学习模型的训练时间也非常长,这对于一些实时性要求较高的应用来说可能是不可接受的。

- 可解释性:深度强化学习模型通常是黑盒模型,这意味着我们很难理解模型的决策过程。这对于一些需要解释性的应用来说可能是不可接受的,例如医疗决策、金融风险管理等。此外,深度强化学习模型的决策过程也可能受到数据偏差和噪声的影响,这可能会导致模型做出错误的决策。

- 安全性和鲁棒性:深度强化学习模型在训练过程中可能会受到攻击和干扰,这可能会导致模型的性能下降甚至失效。例如,攻击者可以通过修改输入数据或者模型参数来影响模型的决策过程。此外,深度强化学习模型在面对未知的环境和情况时也可能会表现出不稳定性和脆弱性,这可能会导致模型做出错误的决策。

深度强化学习的未来发展方向

尽管深度强化学习面临着一些挑战,但它仍然具有巨大的潜力。未来,深度强化学习可能会在以下几个方面取得进一步的发展。

- 更高效的模型:研究人员将寻求设计更轻量级、更有效的神经网络结构,以减少模型的计算量和参数数量。例如,元学习、联邦学习等技术可以帮助模型在资源受限的环境中进行训练和部署。此外,研究人员还将探索如何利用模型压缩和量化等技术来减少模型的存储和计算需求。

- 跨领域应用:深度强化学习将继续向更多现实世界场景拓展,例如医疗决策、能源管理、气候变化预测等。这需要解决更为复杂的环境和长期回报的问题,同时也需要考虑模型的可解释性和安全性。例如,在医疗决策领域,深度强化学习模型需要能够解释其决策过程,以便医生和患者能够理解和信任模型的建议。

- 连续动作空间处理:在许多实际任务中,行动不是离散的,而是连续的,因此研究将关注如何更好地处理高维连续动作空间的学习。例如,在自动驾驶领域,车辆的控制动作是连续的,包括加速、制动、转向等。深度强化学习模型需要能够学习到如何在连续的动作空间中做出最优的决策,以提高驾驶的安全性和舒适性。

- 安全性和鲁棒性:随着深度强化学习在关键领域的应用增加,保证学习过程的安全性和系统对扰动的鲁棒性变得尤为重要。研究人员将探索如何利用对抗训练、鲁棒优化等技术来提高模型的安全性和鲁棒性。例如,在自动驾驶领域,深度强化学习模型需要能够抵御来自外部的攻击和干扰,以确保车辆的安全行驶。

- 解释性和可追溯性:为了提高用户信任和接受度,研究方向可能还会涉及到强化学习算法的透明度和可理解性。研究人员将探索如何利用可视化、解释性学习等技术来提高模型的可解释性和可追溯性。例如,在医疗决策领域,深度强化学习模型需要能够解释其决策过程,以便医生和患者能够理解和信任模型的建议。

深度强化学习的应用前景

深度强化学习具有广阔的应用前景,未来它可能会在更多领域发挥重要作用。

- 游戏领域:深度强化学习将继续在游戏领域发挥重要作用,例如游戏 AI 开发、游戏关卡设计、游戏平衡调整等。未来,深度强化学习可能会与虚拟现实、增强现实等技术结合,为玩家带来更加沉浸式的游戏体验。

- 自动驾驶领域:深度强化学习将在自动驾驶领域发挥重要作用,例如感知与识别、规划与决策、控制与执行等。未来,深度强化学习可能会与其他技术结合,例如传感器融合、高精度地图、智能交通管理系统等,为自动驾驶车辆提供更加准确和可靠的感知和决策能力。

- 医疗领域:深度强化学习可能会在医疗领域发挥重要作用,例如疾病诊断、治疗方案推荐、医疗资源分配等。未来,深度强化学习可能会与其他技术结合,例如医学影像分析、基因测序、电子病历等,为医生提供更加准确和个性化的医疗建议。

- 能源管理领域:深度强化学习可能会在能源管理领域发挥重要作用,例如智能电网调度、能源需求预测、能源存储管理等。未来,深度强化学习可能会与其他技术结合,例如物联网、大数据分析、人工智能等,为能源管理提供更加智能和高效的解决方案。

- 气候变化预测领域:深度强化学习可能会在气候变化预测领域发挥重要作用,例如气候模型优化、气候变化预测、气候变化应对策略等。未来,深度强化学习可能会与其他技术结合,例如地球系统模型、大数据分析、人工智能等,为气候变化预测和应对提供更加准确和有效的解决方案。

总之,深度强化学习虽然面临着一些挑战,但它仍然具有巨大的潜力。未来,深度强化学习可能会在更多领域发挥重要作用,为人类社会带来更多的福利。

七、文章总结和代码案例

文章总结

深度强化学习作为一种融合了深度学习和强化学习的技术,在游戏、自动驾驶等领域展现出了巨大的潜力。它结合了深度学习的强大感知能力和强化学习的优秀决策能力,能够处理复杂的任务和环境。然而,深度强化学习仍然面临着一些挑战,如数据需求、计算资源、可解释性和安全性等。未来,研究人员将致力于解决这些挑战,推动深度强化学习的发展,使其在更多领域发挥重要作用。

3 个经典代码案例

1.猜数字游戏

<!DOCTYPE html>

<html lang="en">

<head><meta charset="UTF-8"><meta http-equiv="X-UA-Compatible" content="IE=edge"><meta name="viewport" content="width=device-width, initial-scale=1.0"><title>猜数字</title>

</head>

<body><h3>请输入要猜的数字: </h3><input type="text"><div>已经猜的次数: <span id="guessCount">0</span></div><div>结果是: <span id="result"></span></div><button>猜</button><script>//0. 获取到需要的元素let input = document.querySelector('input');let button = document.querySelector('button');let guessCount = document.querySelector('#guessCount');let result = document.querySelector('#result');// 1. 在页面加载的时候, 要生成 1 - 100 之间随机的整数let toGuess = parseInt(Math.random()*100)+1;console.log(toGuess);//2. 给 猜 这个按钮加上个点击事件. button.onclick=function(){// a) 获取到输入框里的值. let value = parseInt(input.value);// b) 和当前的生成的数字进行对比. if(value < toGuess){result.innerHTML ='低了';}else if(value > toGuess){result.innerHTML ='高了';}else{result.innerHTML ='猜对了!';}// c) 每点击一次提交, 就让 猜 的次数, 加1!let guessCountValue = parseInt(guessCount.innerHTML);guessCount.innerHTML = guessCountValue +1;</script>

</body>

</html>这个代码案例通过随机生成一个数字,让用户进行猜测,并根据用户的输入给出提示,展示了基本的用户交互和逻辑判断。

2.表白墙

<!DOCTYPE html>

<html lang="en">

<head><meta charset="UTF-8"><meta http-equiv="X-UA-Compatible" content="IE=edge"><meta name="viewport" content="width=device-width, initial-scale=1.0"><title>表白墙</title>

</head>

<body><style>.container{width: 400px;/* margin 外边距. 第一个数字上下外边距, 第二个数字表示水平外边距. 如果水平设置成 auto 表示元素就水平居中~~ */margin:0 auto;}h1{text-align: center;}p{text-align: center;color: #666;}.row{height: 40px;display: flex;/* 水平居中 */justify-content: center;/* 垂直居中 */align-items: center;}.row span{width: 100px;}.row input{width: 200px;height: 30px;}.row button{width: 306px;height: 40px;color: white;background: orange;border: none;}.row button:active{background-color: #666;}</style><div class="container"><h1>表白墙</h1><p>输入后点击提交, 就会把信息显示在表格中</p><div class="row"><span>谁: </span><input type="text"></div><div class="row"><span>对谁: </span><input type="text"></div><div class="row"><span>说: </span><input type="text"></div><div class="row"><button>提交</button></div></div><script>let container = document.querySelector('.container');let button = document.querySelector('button');button.onclick=function(){//1. 获取到输入框的内容let inputs = document.querySelectorAll('input');let from = inputs[0].value;let to = inputs[1].value;let message = inputs[2].value;if(from ==''|| to ==''|| message ==''){alert('当前输入框内容为空!');return;}console.log(from +", "+ to +", "+ message);//2. 能够构造出新的 div, 用来保存用户提交的内容let rowDiv = document.createElement('div');rowDiv.className ='row';rowDiv.innerHTML = from +" 对 "+ to +" 说: "+ message;container.appendChild(rowDiv);//3. 提交完之后, 清空输入框的内容for(let i =0; i < inputs.length; i++){inputs[i].value ='';}}</script>

</body>

</html>这个代码案例实现了一个简单的表白墙功能,用户可以输入表白信息并提交,信息会显示在页面上。它展示了如何动态创建和添加元素到页面中。

3.待办事项

<!DOCTYPE html>

<html lang="en">

<head><meta charset="UTF-8"><meta http-equiv="X-UA-Compatible" content="IE=edge"><meta name="viewport" content="width=device-width, initial-scale=1.0">

</head>

<body><input type="text"><button>添加待办事项</button><ul></ul><script>let input = document.querySelector('input');let button = document.querySelector('button');let ul = document.querySelector('ul');button.onclick = function() {if(input.value === '') {return;}let li = document.createElement('li');li.textContent = input.value;ul.appendChild(li);input.value = '';}</script>

</body>

</html>这个代码案例实现了一个简单的待办事项列表功能,用户可以输入待办事项并添加到列表中。它展示了如何动态创建和管理列表元素。

八、学习资源

(一)在线课程平台

在当今数字化时代,有许多在线课程平台提供关于深度强化学习的课程,这些课程可以帮助学习者系统地了解和掌握深度强化学习的知识和技能。

- Coursera:Coursera 与世界知名高校和机构合作,提供了一系列高质量的深度强化学习课程。例如,某大学开设的 “深度强化学习基础” 课程,涵盖了深度学习和强化学习的基础知识,以及深度强化学习的核心算法和应用。该课程通过视频讲解、编程作业和项目实践等方式,帮助学习者深入理解深度强化学习的原理和应用。

- Udemy:Udemy 上有众多由专业人士和教育机构制作的深度强化学习课程。这些课程内容丰富,涵盖了从入门到高级的不同层次,适合不同水平的学习者。例如,“深度强化学习实战” 课程,通过实际案例和项目实践,让学习者掌握深度强化学习的实际应用技能。

- edX:edX 也是一个知名的在线课程平台,提供了来自全球顶尖高校的课程。其中,一些关于人工智能和机器学习的课程中也涉及到深度强化学习的内容。例如,某大学的 “人工智能与机器学习” 课程,在讲解机器学习的基础上,深入介绍了深度强化学习的概念和应用。

(二)学术论文和研究报告

学术论文和研究报告是了解深度强化学习最新进展和研究成果的重要途径。通过阅读这些文献,学习者可以了解深度强化学习的前沿技术和发展趋势,同时也可以学习到其他研究者的研究方法和经验。

- 学术数据库:如 IEEE Xplore、ACM Digital Library、ScienceDirect 等学术数据库中收录了大量关于深度强化学习的学术论文。学习者可以通过关键词搜索,找到与自己感兴趣的领域相关的论文进行阅读。例如,在 IEEE Xplore 中搜索 “深度强化学习”,可以找到许多关于深度强化学习在不同领域应用的论文。

- 研究机构和实验室网站:许多知名的研究机构和实验室都会在其网站上发布最新的研究成果和报告。例如,OpenAI、DeepMind 等机构的网站上经常会发布关于深度强化学习的研究论文和技术报告。学习者可以关注这些机构的网站,及时了解深度强化学习的最新进展。

(三)开源代码库和项目

开源代码库和项目是学习深度强化学习的宝贵资源。通过研究和分析这些开源代码,学习者可以了解深度强化学习的实际应用和实现方法,同时也可以借鉴其他开发者的经验和技巧。

- GitHub:GitHub 是全球最大的开源代码托管平台,上面有许多关于深度强化学习的开源项目和代码库。例如,OpenAI Baselines 是一个广泛使用的深度强化学习开源库,包含了多种深度强化学习算法的实现。学习者可以通过克隆这些项目,学习其代码结构和实现方法,并进行实践和改进。

- 其他开源平台:除了 GitHub 之外,还有一些其他的开源平台也提供了深度强化学习的相关资源。例如,Google 的 TensorFlow 和 PyTorch 等深度学习框架中也包含了一些深度强化学习的示例和教程。学习者可以利用这些资源,深入学习深度强化学习的实现和应用。

(四)社区论坛和交流群

参与社区论坛和交流群是与其他深度强化学习爱好者和专业人士交流和学习的好方法。在这些社区中,学习者可以提出问题、分享经验、讨论技术难题,从而加深对深度强化学习的理解和掌握。

- Reddit:Reddit 上有许多关于深度强化学习的社区和讨论组,如 r/deeplearning、r/reinforcementlearning 等。学习者可以在这些社区中与其他爱好者交流,了解深度强化学习的最新动态和技术趋势。

- Stack Overflow:Stack Overflow 是一个知名的技术问答社区,上面有许多关于深度强化学习的问题和解答。学习者可以在上面搜索自己遇到的问题,或者提出自己的问题,获得其他专业人士的帮助和解答。

- 交流群:加入深度强化学习的交流群也是一个不错的学习方法。例如,在 QQ、微信等社交平台上,有许多深度强化学习的交流群。学习者可以在群里与其他爱好者交流,分享学习经验和资源,共同进步。

通过利用这些学习资料,学习者可以更加系统地学习深度学习的知识和技术,提高自己的实践能力和创新能力。同时,也可以与其他学习者进行交流和互动,共同推动深度学习领域的发展。

博主还写跟本文相关的文章,邀请大家批评指正:

1、深度学习(一)基础:神经网络、训练过程与激活函数(1/10)

2、深度学习(二)框架与工具:开启智能未来之门(2/10)

3、深度学习(三)在计算机视觉领域的璀璨应用(3/10)

4、深度学习(四):自然语言处理的强大引擎(4/10)

5、深度学习(五):语音处理领域的创新引擎(5/10)

6、深度学习(六)CNN:图像处理的强大工具(6/10)

7、深度学习(七)深度强化学习:融合创新的智能之路(7/10)

相关文章:

深度学习(七)深度强化学习:融合创新的智能之路(7/10)

一、深度强化学习的崛起 深度强化学习在人工智能领域的重要地位 深度强化学习作为一种融合了深度学习和强化学习的新技术,在人工智能领域占据着至关重要的地位。它结合了深度学习强大的感知能力和强化学习优秀的决策能力,能够处理复杂的任务和环境。例如…...

mac电脑通过 npm 安装 @vue/cli脚手架超时问题;

npm 安装 vue/cli遇到的问题步骤 一、安装 Homebrew 如果你还没有安装 Homebrew,首先需要安装它。Homebrew 是 macOS 上的一款包管理工具,它允许你通过简单的命令行指令安装、更新和卸载软件包。; 1, 打开终端(Terminal…...

【52 机器学习 | 基于KNN近邻和随机森林模型对用户转化进行分析与预测】

文章目录 🏳️🌈 1. 导入模块🏳️🌈 2. Pandas数据处理2.1 读取数据2.2 查看数据信息2.3 字段说明2.4 删除重复值2.5 删除空值 🏳️🌈 3. 数据分析-特征分析3.1 年龄及转化率分析3.2 各营销渠道人数及…...

【Linux】Zookeeper 部署

Zookeeper 搭建方式 单机模式:Zookeeper只运行在一台服务器上,适合测试环境伪集群模式:就是在一台物理机上运行多个Zookeeper 实例;集群模式:Zookeeper运行于一个集群上,适合生产环境,这个计算…...

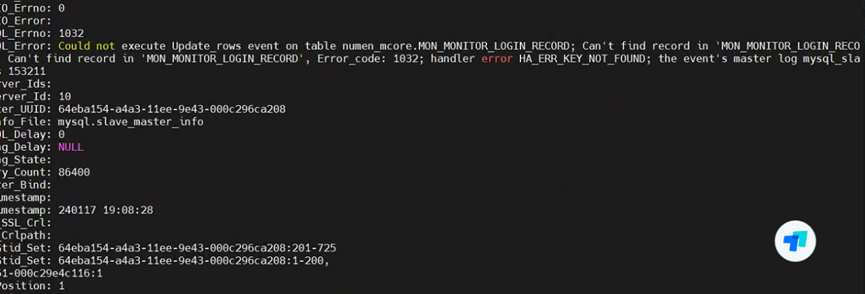

配置mysql 主主模式 GTID

文章目录 一、前提二、修改my.cnf主1 10.255.131.9主2 10.255.131.10 三、配置主主3.1 配置主 10.255.131.93.2 配置从 10.255.131.103.3 配置主 10.255.131.103.4 配置从 10.255.131.9 四、验证五、同步问题排查以及恢复5.1 查看同步状态5.2 查看同步是否数据一致性࿰…...

推荐一款多显示器屏幕亮度调节工具:Twinkle Tray

Twinkle Tray中文版使您可以轻松管理多台显示器的亮度级别。 尽管 Windows 10 能够调节大多数显示器的背光,但它通常不支持外部显示器。 Windows 还缺乏管理多台显示器的亮度的任何功能。 该应用程序将一个新图标插入系统托盘,您可以在其中单击以立即访问…...

第十一章 Shiro会话管理和加密

学习目标 11.1 会话管理11.1.1 会话相关API一、获取会话二、会话属性管理三、会话信息获取四、会话控制五、会话监听六、会话DAO七、会话验证 11.2 缓存一、缓存接口二、内置缓存实现三、配置缓存四、使用缓存五、缓存清理六、注意事项 前面两章我们已经掌握了Shiro四大基石的认…...

DDR4单个DQ仿真实战(一)

目录 引言1、新建Workspace2、导入brd文件3、在SiPro中打开Layout:查看并编辑叠层4、PCB剪裁(可选)5、创建SiPro6、创建分析模型7、查看分析结果8、创建原理图9、系统行为级仿真 引言 DDR4仿真将按照以下几个步骤进行: 新建Work…...

Android Studio插件版本与Gradle 版本对应关系

一、背景 Android Studio 构建系统以 Gradle 为基础,并且 Android Gradle 插件添加了几项专用于构建 Android 应用的功能。 虽然 Android 插件通常会与 Android Studio 的更新步调保持一致,但插件(以及 Gradle 系统的其余部分)可…...

Uni-App-01

HBuilder安装卸载 安装 官网地址:https://www.dcloud.io/hbuilderx.html 下载HBuilder最新版 解压到安装目录,路径中不要有中文和空格 在桌面上增加快捷方式 卸载 执行reset.bat 删除HBuilder文件夹(如果提示文件被占用࿰…...

Java版本鸿鹄工程项目管理系统源码概述

项目背景 随着企业规模的扩大和业务的复杂化,传统的工程项目管理方式已经无法满足高效、准确、实时的管理需求。为了提高工程管理效率、优化资源配置、降低风险并控制成本,企业决定通过数字化转型,构建一个基于Spring Cloud、Spring Boot、M…...

基于echarts、php、Mysql开发的数据可视化大屏

大屏效果展示 管理员进入数据可视化页面将看到数据可视化大屏。大屏内容包括两个条形图,用于统计当前网站所有用户的MBTI 16型人格分布;玫瑰图,用于展示当前网站用户MBTI四个维度,八个字母的占比;折线图,用…...

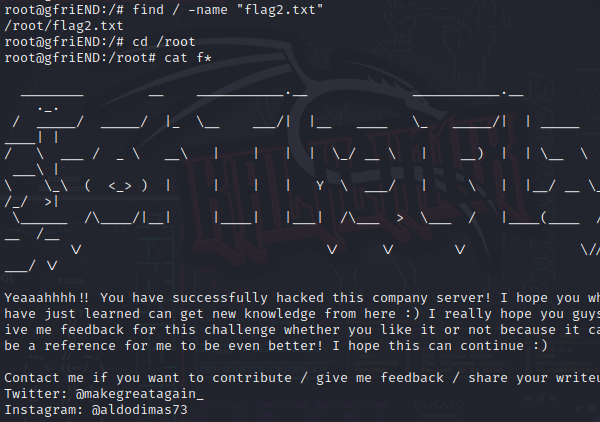

Me-and-My-Girlfriend-1

Me-and-My-Girlfriend-1 解题 信息收集 nmap扫描存活主机 我的虚拟机为131 所以发现130为目标靶机。 查看网站,找到可利用点 使用浏览器查看,使用xff伪造本地用户。 注册用户cat,观察url有url_id,改为5,发现alice用户。 将…...

)

R语言实现GWAS meta分析(1)

1、基于数据集的Meta分析 datafilenamec("data1.txt","data2.txt"), setwd(workdir) library(Metalgwas) a1 name1c() for(i in datafilename){ assign(paste("file",a,sep""),data.table::fread(paste(getwd(),"/","…...

Kafka-代码示例

一、构建开发环境 File > New > Project 选择一个最简单的模板 项目和坐标命名 配置maven路径 添加maven依赖 <dependencies><!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka-clients --><dependency><groupId>org.apache.kaf…...

LLVM - 编译器前端-llvm 基本块、指令、函数 的关系

一:基础概念: 在 LLVM 中,基本块、指令和函数是构建中间表示(IR)的核心概念,它们之间有着紧密的关系,首先了解下基本概念。 1. 基本块(Basic Block) 定义:基本块是一个不包含任何跳转指令的线性代码段,执行顺序是从头到尾。每个基本块至少有一个入口和一个出口。特…...

探索人工智能在自然语言处理中的应用

探索人工智能在自然语言处理中的应用 前言1. 机器翻译2. 情感分析3. 智能客服4. 文本生成未来展望 结语 前言 在信息爆炸的时代,自然语言处理(NLP)作为人工智能(AI)的一个重要分支,正以前所未有的速度改变着…...

IFC模型文本的含义

以下代码是一个STEP文件(ISO-10303-21标准),它是一种用于表示产品数据的国际标准。STEP文件通常用于在不同的计算机辅助设计(CAD)系统之间交换数据。下面是对这段代码的逐行解释: HEADER部分: …...

构建高效评奖系统:SpringBoot在教育领域的应用

摘要 随着信息技术在管理上越来越深入而广泛的应用,管理信息系统的实施在技术上已逐步成熟。本文介绍了学生评奖评优管理系统的开发全过程。通过分析学生评奖评优管理系统管理的不足,创建了一个计算机管理学生评奖评优管理系统的方案。文章介绍了学生评奖…...

「二叉树进阶题解:构建、遍历与结构转化全解析」

文章目录 根据二叉树创建字符串思路代码 二叉树的层序遍历思路代码 二叉树的最近公共祖先思路代码 二叉搜索树与双向链表思路代码 从前序与中序遍历序列构造二叉树思路代码 总结 根据二叉树创建字符串 题目: 样例: 可以看见,唯一特殊的就…...

[特殊字符] 智能合约中的数据是如何在区块链中保持一致的?

🧠 智能合约中的数据是如何在区块链中保持一致的? 为什么所有区块链节点都能得出相同结果?合约调用这么复杂,状态真能保持一致吗?本篇带你从底层视角理解“状态一致性”的真相。 一、智能合约的数据存储在哪里…...

观成科技:隐蔽隧道工具Ligolo-ng加密流量分析

1.工具介绍 Ligolo-ng是一款由go编写的高效隧道工具,该工具基于TUN接口实现其功能,利用反向TCP/TLS连接建立一条隐蔽的通信信道,支持使用Let’s Encrypt自动生成证书。Ligolo-ng的通信隐蔽性体现在其支持多种连接方式,适应复杂网…...

未来机器人的大脑:如何用神经网络模拟器实现更智能的决策?

编辑:陈萍萍的公主一点人工一点智能 未来机器人的大脑:如何用神经网络模拟器实现更智能的决策?RWM通过双自回归机制有效解决了复合误差、部分可观测性和随机动力学等关键挑战,在不依赖领域特定归纳偏见的条件下实现了卓越的预测准…...

【SQL学习笔记1】增删改查+多表连接全解析(内附SQL免费在线练习工具)

可以使用Sqliteviz这个网站免费编写sql语句,它能够让用户直接在浏览器内练习SQL的语法,不需要安装任何软件。 链接如下: sqliteviz 注意: 在转写SQL语法时,关键字之间有一个特定的顺序,这个顺序会影响到…...

C++ 基础特性深度解析

目录 引言 一、命名空间(namespace) C 中的命名空间 与 C 语言的对比 二、缺省参数 C 中的缺省参数 与 C 语言的对比 三、引用(reference) C 中的引用 与 C 语言的对比 四、inline(内联函数…...

python如何将word的doc另存为docx

将 DOCX 文件另存为 DOCX 格式(Python 实现) 在 Python 中,你可以使用 python-docx 库来操作 Word 文档。不过需要注意的是,.doc 是旧的 Word 格式,而 .docx 是新的基于 XML 的格式。python-docx 只能处理 .docx 格式…...

【Web 进阶篇】优雅的接口设计:统一响应、全局异常处理与参数校验

系列回顾: 在上一篇中,我们成功地为应用集成了数据库,并使用 Spring Data JPA 实现了基本的 CRUD API。我们的应用现在能“记忆”数据了!但是,如果你仔细审视那些 API,会发现它们还很“粗糙”:有…...

k8s业务程序联调工具-KtConnect

概述 原理 工具作用是建立了一个从本地到集群的单向VPN,根据VPN原理,打通两个内网必然需要借助一个公共中继节点,ktconnect工具巧妙的利用k8s原生的portforward能力,简化了建立连接的过程,apiserver间接起到了中继节…...

C# winform教程(二)----checkbox

一、作用 提供一个用户选择或者不选的状态,这是一个可以多选的控件。 二、属性 其实功能大差不差,除了特殊的几个外,与button基本相同,所有说几个独有的 checkbox属性 名称内容含义appearance控件外观可以变成按钮形状checkali…...

React核心概念:State是什么?如何用useState管理组件自己的数据?

系列回顾: 在上一篇《React入门第一步》中,我们已经成功创建并运行了第一个React项目。我们学会了用Vite初始化项目,并修改了App.jsx组件,让页面显示出我们想要的文字。但是,那个页面是“死”的,它只是静态…...