理解Parquet文件和Arrow格式:从Hugging Face数据集的角度出发

parquet发音:美 [pɑrˈkeɪ] 镶木地板;拼花木地板

理解Parquet文件和Arrow格式:从Hugging Face数据集的角度出发

引言

在机器学习和大数据处理中,数据的存储和传输格式对于性能至关重要。两种广泛使用的格式是 Parquet 和 Arrow。它们在数据存储、传输和处理上都有各自的优势,尤其是在大规模数据集的使用中尤为重要。

在这篇博客中,我们将探讨 Parquet 和 Arrow 格式的基本概念、它们的优势以及它们在Hugging Face(HF)数据集中的应用。我们还将结合实际示例,展示如何使用这些格式,并解释为什么在HF上下载的Parquet格式数据集会变成Arrow文件。

什么是Parquet格式?

Parquet 是一种开源的列式存储格式,专为大数据处理和分析任务设计。它是由Apache软件基金会开发的,并且是Hadoop生态系统的一部分。Parquet格式能够高效地存储结构化和半结构化数据,特别适合大规模数据集的存储和查询。

Parquet格式的特点

- 列式存储:数据以列而不是行的方式存储,这意味着只读取需要的列时,I/O效率大大提高,尤其是对于大数据集。

- 高效压缩:由于数据是按列存储的,类似类型的数据会被压缩在一起,从而减少存储空间。

- 支持复杂数据类型:Parquet能够支持嵌套的数据结构,如数组、映射等。

- 跨语言支持:Parquet支持多种编程语言,如Java、Python、C++等,适用于跨平台的数据处理。

为什么Hugging Face使用Parquet格式?

Hugging Face平台上提供的数据集通常使用Parquet格式进行存储,这是因为:

- 高效存储:Parquet的列式存储特性能够提高数据存储和读取效率。

- 大规模数据支持:Parquet在处理大规模数据时,能够节省大量的存储空间,同时提升数据处理速度。

- 与大数据工具兼容:Parquet文件与许多大数据处理框架(如Apache Spark、Apache Hive)兼容,因此适用于大规模数据处理任务。

什么是Arrow格式?

Arrow 是一个跨语言的数据交换格式,主要用于内存中的数据存储和数据传输。它由Apache Arrow项目开发,旨在优化数据的传输效率,尤其是在不同程序之间交换数据时。Arrow格式的特点包括:

- 列式内存格式:Arrow在内存中采用列式存储,能够提高大数据处理中的查询和计算效率。

- 零拷贝数据共享:Arrow支持零拷贝传输,允许多个进程或系统之间共享数据而无需复制数据,极大提高了性能。

- 跨平台支持:Arrow支持多种编程语言,包括Python、C++、Java等,适用于多种数据处理框架和大数据平台。

- 高效的内存布局:Arrow的内存布局设计优化了数据处理效率,特别是在并行计算和数据分析中具有显著的性能提升。

Arrow和Parquet的关系

- Parquet格式 是一种用于数据持久化存储的格式,而 Arrow格式 是一种高效的内存存储和传输格式。

- Parquet格式的文件通常是基于Arrow格式的数据结构来存储的。因此,Arrow和Parquet格式是密切相关的,尤其是在Hugging Face的

datasets库中,Parquet文件经常会被加载为Arrow格式的内存对象。

为什么在Hugging Face上下载的Parquet文件变成Arrow文件?

在Hugging Face上,你会发现许多数据集以Parquet格式存储。这里为什么会使用Parquet格式呢?我们已经讨论过它的存储优势,但你可能会注意到,当你通过datasets库下载这些数据集时,文件变成了Arrow格式。

这主要是因为 Hugging Face的datasets库 使用了 Arrow格式 作为其数据加载和处理的底层格式。尽管数据集存储为Parquet文件,但当你下载数据集时,datasets库会将这些Parquet文件解码成Arrow格式,并将数据加载到内存中。原因如下:

-

高效的内存操作:Arrow格式是专为内存操作设计的,它能够在内存中高效地表示和操作数据,特别适合大规模数据处理。通过将数据加载为Arrow格式,

datasets库能够更快地进行数据操作和处理。 -

兼容性和跨平台支持:Arrow支持多种编程语言和数据框架,因此它能够确保Hugging Face平台上的数据集能够跨平台、高效地共享和处理。

-

零拷贝数据访问:Arrow支持零拷贝的数据访问,这意味着在加载数据时,避免了不必要的数据复制,从而加速了数据处理的速度。

示例代码:如何加载和使用Parquet和Arrow格式的数据

1. 使用Hugging Face datasets库加载Parquet格式的数据集

from datasets import load_dataset# 加载一个Hugging Face上的Parquet格式数据集

dataset = load_dataset('your_dataset_name')# 查看数据集的结构

print(dataset)

通过上述代码,datasets库会自动处理文件格式的转换,并将Parquet文件转换为内存中的Arrow格式对象。

比如执行如下代码:

from datasets import Dataset, load_dataset, load_from_disk

# dataset = load_dataset("allenai/tulu-v2-sft-mixture")

dataset = load_dataset("allenai/tulu-3-sft-mixture")

dataset

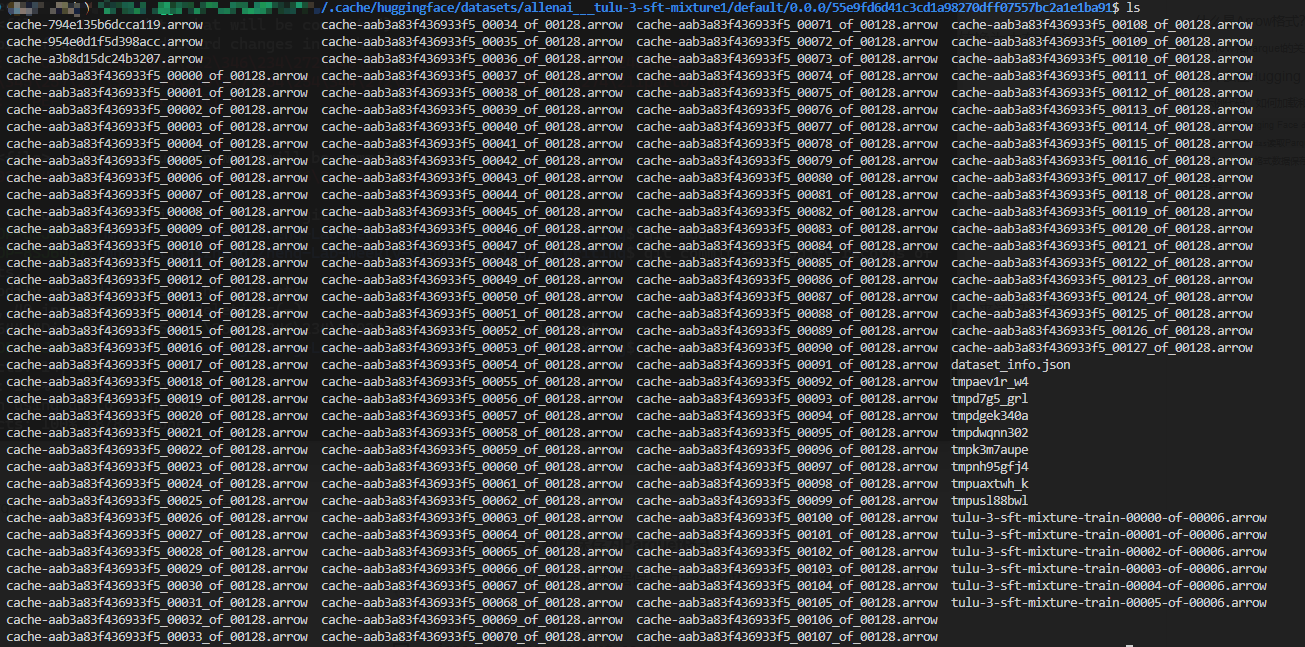

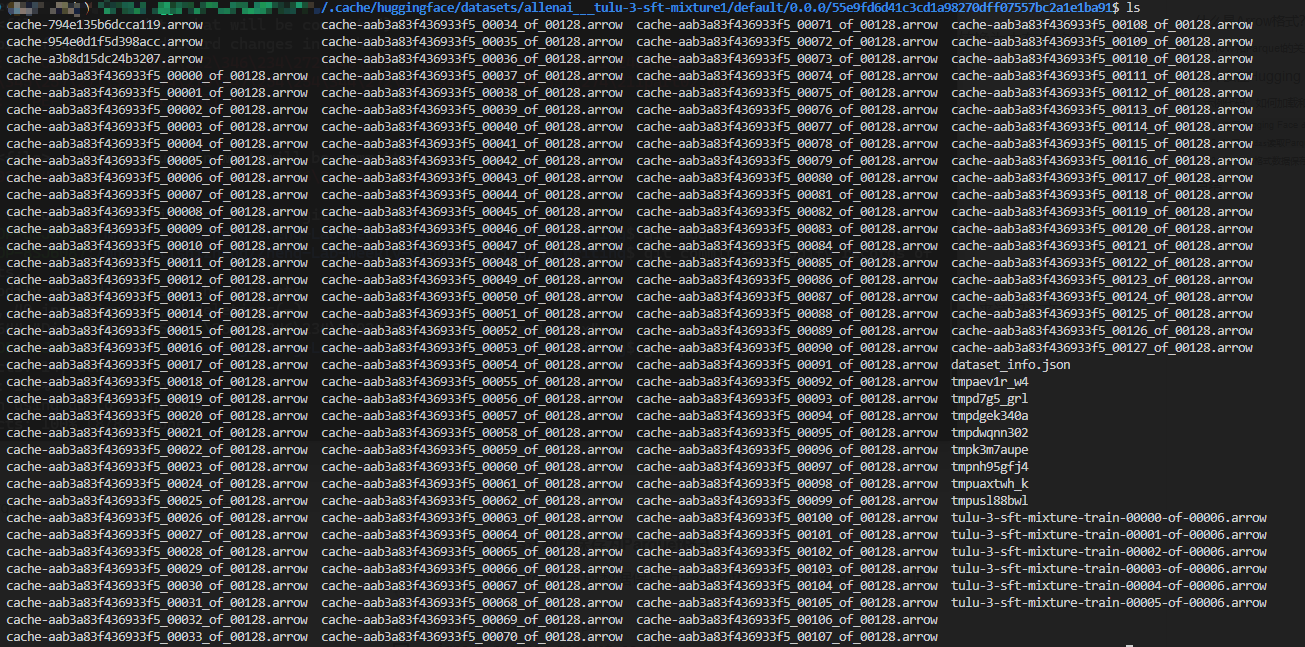

会得到如此多的arrow文件

2. 使用pandas读取Parquet文件

如果你直接从Hugging Face或其他地方下载了Parquet文件,可以使用pandas来读取该文件:

import pandas as pd# 读取本地的Parquet文件

df = pd.read_parquet('your_file.parquet')# 查看数据

print(df.head())

3. 将Arrow格式数据保存为Parquet格式

如果你想将Arrow格式的数据保存为Parquet格式,可以使用pyarrow库:

import pyarrow as pa

import pyarrow.parquet as pq# 假设arrow_table是一个Arrow格式的数据表

arrow_table = pa.Table.from_pandas(df)# 保存为Parquet格式

pq.write_table(arrow_table, 'your_file.parquet')

总结

在本文中,我们讨论了 Parquet格式 和 Arrow格式 的基本概念,并结合Hugging Face的实际应用案例,说明了为什么Hugging Face使用Parquet格式存储数据集,并将其加载为Arrow格式。我们还通过示例代码展示了如何加载、读取和转换这两种格式。

- Parquet格式 适用于高效的数据存储,特别是在大数据处理场景中,而 Arrow格式 则更适合高效的内存操作和跨平台数据交换。

- Hugging Face使用Parquet格式来存储数据集,同时利用Arrow格式来加载和处理数据,以确保高效的内存操作和跨平台兼容性。

通过理解这两种格式的区别和用途,我们可以更好地理解如何处理大规模数据集,以及如何利用Hugging Face平台来进行高效的机器学习和数据处理工作。

Understanding Parquet Files and Arrow Format: A Guide with Hugging Face Datasets

Introduction

In the world of machine learning and big data processing, the format in which data is stored and transferred plays a critical role in performance. Two widely used formats in this context are Parquet and Arrow. Both formats offer significant advantages in terms of data storage, transfer, and processing, especially when dealing with large-scale datasets.

In this blog post, we will explore the basic concepts of Parquet and Arrow formats, their advantages, and their usage in Hugging Face (HF) datasets. We will also provide practical examples, showing how to work with these formats, and explain why Parquet files downloaded from HF are converted into Arrow files.

What is the Parquet Format?

Parquet is an open-source columnar storage format designed for big data processing and analytics. It was developed by the Apache Software Foundation as part of the Hadoop ecosystem. Parquet is efficient for storing both structured and semi-structured data, making it ideal for large-scale datasets.

Key Features of Parquet Format

- Columnar Storage: Data is stored in columns rather than rows. This significantly improves I/O performance when only specific columns are needed, especially for large datasets.

- Efficient Compression: Similar types of data in a column are stored together, enabling better compression rates and reducing storage costs.

- Support for Complex Data Types: Parquet can handle nested data structures like arrays and maps.

- Cross-Language Support: Parquet is supported by various programming languages such as Java, Python, and C++, making it compatible with a wide range of data processing tools.

Why Does Hugging Face Use Parquet Format?

Hugging Face stores many datasets in the Parquet format for several reasons:

- Efficient Storage: Parquet’s columnar storage format leads to more efficient storage and faster access to the data, especially when dealing with large datasets.

- Support for Large-Scale Data: Parquet is optimized for storing and querying large volumes of data, making it an ideal choice for machine learning and NLP tasks.

- Compatibility with Big Data Tools: Parquet files are compatible with big data frameworks like Apache Spark and Apache Hive, allowing for seamless integration into large-scale data processing pipelines.

What is Arrow Format?

Arrow is a cross-language data exchange format designed for in-memory data storage and data transfer. It was developed by the Apache Arrow project, aimed at optimizing the performance of data transfer between systems and processing frameworks.

Key Features of Arrow Format

- Columnar In-Memory Format: Similar to Parquet, Arrow uses a columnar storage format but is specifically designed for in-memory operations, enhancing performance in data processing tasks.

- Zero-Copy Data Sharing: Arrow enables zero-copy data sharing, which means that multiple processes or systems can share data without needing to copy it, drastically improving performance.

- Cross-Platform Support: Arrow supports multiple programming languages, including Python, C++, and Java, making it highly versatile across various data processing frameworks.

- Optimized Memory Layout: Arrow’s memory layout is designed to optimize data processing, particularly in parallel computation and analytics.

The Relationship Between Arrow and Parquet

- Parquet is a format used for persistent storage of data, while Arrow is used for efficient in-memory storage and data transfer.

- Parquet files are often structured based on Arrow’s data model, meaning that when you load a Parquet file into memory (like in Hugging Face), it is typically converted into an Arrow table.

Why Do Hugging Face Datasets Convert Parquet to Arrow?

While many datasets on Hugging Face are stored in Parquet format, when you download these datasets using the datasets library, the files are automatically converted into Arrow format for processing. This happens for several reasons:

-

Efficient Memory Operations: Arrow is designed for in-memory operations, making it much faster for data manipulation and processing than Parquet. Hugging Face uses Arrow for efficient handling of datasets once they are loaded into memory.

-

Cross-Platform and Framework Compatibility: Arrow is designed to be cross-platform and compatible with various data frameworks. This allows Hugging Face datasets to be processed across different environments seamlessly.

-

Zero-Copy Data Access: Arrow’s zero-copy data sharing capability allows multiple processes or systems to access the same data without duplication, improving performance and reducing memory usage.

Example Code: How to Work with Parquet and Arrow Files

1. Loading a Parquet Dataset from Hugging Face

from datasets import load_dataset# Load a dataset from Hugging Face (in Parquet format)

dataset = load_dataset('your_dataset_name')# Check the structure of the dataset

print(dataset)

With the datasets library, you can load Parquet datasets, which are internally converted to Arrow format for faster data processing.

2. Reading a Parquet File Using pandas

If you download a Parquet file from Hugging Face or another source, you can read it directly using pandas:

import pandas as pd# Read a Parquet file locally

df = pd.read_parquet('your_file.parquet')# View the first few rows

print(df.head())

3. Saving Arrow Data as Parquet

If you want to save Arrow-format data back as a Parquet file, you can use the pyarrow library:

import pyarrow as pa

import pyarrow.parquet as pq# Assume arrow_table is an Arrow table

arrow_table = pa.Table.from_pandas(df)# Save as a Parquet file

pq.write_table(arrow_table, 'your_file.parquet')

Summary

In this post, we’ve explored the Parquet and Arrow formats, explained their key features, and discussed why Hugging Face uses them for its datasets.

- Parquet is used for efficient storage of large datasets, especially in big data environments, while Arrow is optimized for high-speed in-memory operations and data transfer.

- Hugging Face stores datasets in Parquet format but uses Arrow for in-memory data manipulation to take advantage of its efficiency and cross-platform capabilities.

By understanding these formats and how they are used, you’ll be better equipped to handle large-scale datasets in your own machine learning and data processing workflows.

后记

2024年11月29日12点12分于上海,在GPT4o辅助下完成。

相关文章:

理解Parquet文件和Arrow格式:从Hugging Face数据集的角度出发

parquet发音:美 [pɑrˈkeɪ] 镶木地板;拼花木地板 理解Parquet文件和Arrow格式:从Hugging Face数据集的角度出发 引言 在机器学习和大数据处理中,数据的存储和传输格式对于性能至关重要。两种广泛使用的格式是 Parquet 和 Arr…...

下载 M3U8 格式的视频

要下载 M3U8 格式的视频(通常是 HLS 视频流),可以尝试以下几种方法: 方法 1:使用下载工具(推荐) 1. IDM(Internet Download Manager): 安装 IDM 并启用浏…...

Tomcat使用教程

下载地址:https://tomcat.apache.org/ 配置环境变量 变量名: CATALINA_HOME 变量值: D:\tools\apache-tomcat-9.0.97 Path: %CATALINA_HOME%\bin 启动Tomcat(打开命令提示符) startup.bat 解决乱码问题(打开conf\logging.properties) java.util.logging.Conso…...

LabVIEW氢气纯化控制系统

基于LabVIEW的氢气纯化控制系统满足氢气纯化过程中对精确控制的需求,具备参数设置、过程监控、数据记录和报警功能,体现了LabVIEW在复杂工业控制系统中的应用效能。 项目背景 在众多行业中,尤其是石油化工和航天航空领域,氢气作为…...

现在的电商风口已经很明显了

随着电商行业的不断发展,直播带货的热潮似乎正逐渐降温,而货架电商正成为新的焦点。抖音等平台越来越重视货架电商,强调搜索功能的重要性,预示着未来的电商中心将转向货架和搜索。 在这一转型期,AI技术与电商的结合为…...

Uniapp触底刷新

在你的代码中,使用了 scroll-view 来实现一个可滚动的评论区域,并且通过监听 scrolltolower 事件来触发 handleScrollToLower 函数,以实现“触底更新”或加载更多评论的功能。 关键部分分析: scroll-view 组件: scroll-view 是一…...

开源项目 - face parsing 人脸区域分割 人像区域分割 人脸分割 人像区域分割 BiSeNet

开源项目 - face parsing 人脸区域分割 人像区域分割 人脸分割 人像区域分割 BiSeNet 项目地址:GitHub - XIAN-HHappy/face_parsing: face_parsing 脸部分割 示例: 助力快速掌握数据集的信息和使用方式。 数据可以如此美好!...

python游戏设计---飞机大战

1.前言 上次做飞机大战游戏有人这么说: 好好好!今天必须整一个,今天我们来详细讲解一下,底部找素材文件下载!!! 2.游戏制作 目录如下: 1.导入的包 import pygame import sys imp…...

13TB的StarRocks大数据库迁移过程

公司有一套StarRocks的大数据库在大股东的腾讯云环境中,通过腾讯云的对等连接打通,通过dolphinscheduler调度datax离线抽取数据和SQL计算汇总,还有在大股东的特有的Flink集群环境,该环境开发了flink开发程序包部署,实时…...

HTTP代理有那些常见的安全协议?

在数据采集领域,HTTP代理扮演着至关重要的角色,它不仅帮助我们访问互联网资源,还涉及到数据的安全传输。了解HTTP代理中常见的安全协议对于保护数据安全、提高数据采集效率至关重要。那么,有哪些安全协议是在HTTP代理中常用的呢&a…...

Kylin Server V10 下基于Kraft模式搭建Kafka集群

一、Kraft 模式与 ZooKeeper 模式简介 在Kafka 2.8 之前,Kafka 重度依赖 ZooKeeper 集群做元数据管理、Controller 的选举等(统称为共识服务);当ZooKeeper 集群性能发生抖动时,Kafka 的性能也会受到很大的影响。如下图所示: 在 Kafka 2.8 之后,引入了基于 Raft …...

tauri使用github action打包编译多个平台arm架构和inter架构包踩坑记录

这些error的坑,肯定是很多人不想看到的,我的开源软件PakePlus是使用tauri开发的,PakePlus是一个界面化将任何网站打包为轻量级跨平台软件的程序,利用Tauri轻松构建轻量级多端桌面应用和多端手机应用,为了实现发布的时候…...

)

Python爬虫与窗口实现翻译小工具(仅限学习交流)

Python爬虫与窗口实现翻译小工具(仅限学习交流) 在工作中,遇到一个不懂的单词时,就会去网页找对应的翻译,我们可以用Python爬虫与窗口配合,制作一个简易的翻译小工具,不需要打开网页,自动把翻译结果显示出来。 整个过程比较简单。 # This is a sample Python script. …...

紫光展锐联合上汽海外发布量产车型,赋能汽车智能化

当前,智能汽车产业迎来重大变局,随着人工智能、5G、大数据等新一代信息技术的迅猛发展,智能网联汽车正呈现强劲发展势头。 11月26日,在2024紫光展锐全球合作伙伴大会汽车电子生态论坛上,紫光展锐与上汽海外出行联合发…...

Maven 打包出现问题解决方案

我执行 mvn install 报如下错误 可是我在 web 模块中能正确引用到 common 的类,于是我把 web 引用到的 common 中的类先移动到 web 模块中,然后把 common 模块的类都删掉,然后再次执行 mvn install,结果报错如下: [ERROR] Faile…...

第四话:JS中的eval函数

theme: channing-cyan 1.不要使用eval! 如果你从来都没有用到过eval这个函数,甚至你都不知道这个函数的作用。那么我只能说:你做了一件正确的事情 o.O 虽然我这篇文章要说一下eval函数的一些能力和注意点,但是我希望࿰…...

歇一歇,写写段子

无聊的日子都在写段子1.0 中学的时候喜欢看意林之类的杂志, 里面的作者用乱七八糟的理由跑去旅游,然后说“阻碍你脚步的永远只有逃离的勇气和对生活的热爱”, 我觉得太对了,可惜 12306 付款方式里没有勇气和热爱,不…...

TypeScript (一)运行环境配置,数据类型,可选类型,联合类型,type与interface,交叉类型,断言as,字面量类型,类型缩小

文章目录 一、认识TS1.1 JS 存在的问题1.2 TS的出现1.3 TS运行环境运行ts的三种方式 1.4 变量声明1.5 类型推断 二、数据类型2.1 JS数据类型(1) 数组Array(2) 对象Object(3) 其他类型 2.2 TS特有数据类型(1) any类型(2) unknown类型(3) void类型(4) never (了解)(5) tuple类型 …...

Linux Find 命令详情解释

文件查找 普通查询find /etc -maxdepth 1 -type f -name "pa*"命令 目录... 查找深度 类型 文件名称包含 # -type文件类型:f表示文件,不指定类型的话,文件和目录都会查找# -maxdepth查找深度:目录层级的意思࿰…...

2024年认证杯SPSSPRO杯数学建模A题(第一阶段)保暖纤维的保暖能力全过程文档及程序

2024年认证杯SPSSPRO杯数学建模 A题 保暖纤维的保暖能力 原题再现: 冬装最重要的作用是保暖,也就是阻挡温暖的人体与寒冷环境之间的热量传递。人们在不同款式的棉衣中会填充保暖材料,从古已有之的棉花、羽绒到近年来各种各样的人造纤维。不…...

利用ngx_stream_return_module构建简易 TCP/UDP 响应网关

一、模块概述 ngx_stream_return_module 提供了一个极简的指令: return <value>;在收到客户端连接后,立即将 <value> 写回并关闭连接。<value> 支持内嵌文本和内置变量(如 $time_iso8601、$remote_addr 等)&a…...

遍历 Map 类型集合的方法汇总

1 方法一 先用方法 keySet() 获取集合中的所有键。再通过 gey(key) 方法用对应键获取值 import java.util.HashMap; import java.util.Set;public class Test {public static void main(String[] args) {HashMap hashMap new HashMap();hashMap.put("语文",99);has…...

基于Flask实现的医疗保险欺诈识别监测模型

基于Flask实现的医疗保险欺诈识别监测模型 项目截图 项目简介 社会医疗保险是国家通过立法形式强制实施,由雇主和个人按一定比例缴纳保险费,建立社会医疗保险基金,支付雇员医疗费用的一种医疗保险制度, 它是促进社会文明和进步的…...

FastAPI 教程:从入门到实践

FastAPI 是一个现代、快速(高性能)的 Web 框架,用于构建 API,支持 Python 3.6。它基于标准 Python 类型提示,易于学习且功能强大。以下是一个完整的 FastAPI 入门教程,涵盖从环境搭建到创建并运行一个简单的…...

【C语言练习】080. 使用C语言实现简单的数据库操作

080. 使用C语言实现简单的数据库操作 080. 使用C语言实现简单的数据库操作使用原生APIODBC接口第三方库ORM框架文件模拟1. 安装SQLite2. 示例代码:使用SQLite创建数据库、表和插入数据3. 编译和运行4. 示例运行输出:5. 注意事项6. 总结080. 使用C语言实现简单的数据库操作 在…...

视觉slam十四讲实践部分记录——ch2、ch3

ch2 一、使用g++编译.cpp为可执行文件并运行(P30) g++ helloSLAM.cpp ./a.out运行 二、使用cmake编译 mkdir build cd build cmake .. makeCMakeCache.txt 文件仍然指向旧的目录。这表明在源代码目录中可能还存在旧的 CMakeCache.txt 文件,或者在构建过程中仍然引用了旧的路…...

)

C++课设:简易日历程序(支持传统节假日 + 二十四节气 + 个人纪念日管理)

名人说:路漫漫其修远兮,吾将上下而求索。—— 屈原《离骚》 创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊) 专栏介绍:《编程项目实战》 目录 一、为什么要开发一个日历程序?1. 深入理解时间算法2. 练习面向对象设计3. 学习数据结构应用二、核心算法深度解析…...

c++第七天 继承与派生2

这一篇文章主要内容是 派生类构造函数与析构函数 在派生类中重写基类成员 以及多继承 第一部分:派生类构造函数与析构函数 当创建一个派生类对象时,基类成员是如何初始化的? 1.当派生类对象创建的时候,基类成员的初始化顺序 …...

MySQL:分区的基本使用

目录 一、什么是分区二、有什么作用三、分类四、创建分区五、删除分区 一、什么是分区 MySQL 分区(Partitioning)是一种将单张表的数据逻辑上拆分成多个物理部分的技术。这些物理部分(分区)可以独立存储、管理和优化,…...

comfyui 工作流中 图生视频 如何增加视频的长度到5秒

comfyUI 工作流怎么可以生成更长的视频。除了硬件显存要求之外还有别的方法吗? 在ComfyUI中实现图生视频并延长到5秒,需要结合多个扩展和技巧。以下是完整解决方案: 核心工作流配置(24fps下5秒120帧) #mermaid-svg-yP…...