kafka-6-python单线程操作kafka

使用Python操作Kafka:KafkaProducer、KafkaConsumer

Python kafka-python API的帮助文档

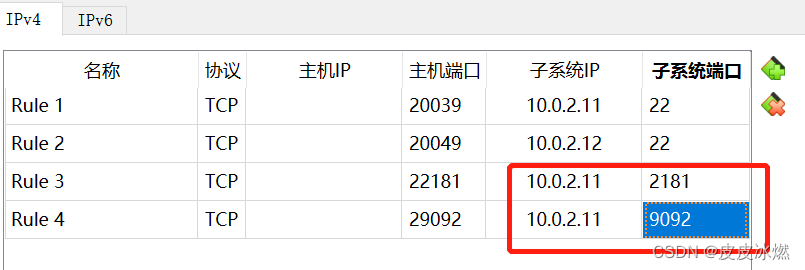

1 kafka tools连接

(1)/usr/local/kafka_2.13-3.4.0/config/server.properties

listeners = PLAINTEXT://myubuntu:9092

advertised.listeners=PLAINTEXT://192.168.1.8:29092(2)/etc/hosts

10.0.2.11 myubuntu其中192.168.1.8是宿主机外网地址

其中10.0.2.11是虚拟机内网地址

192.168.1.8:29092映射到了10.0.2.11:9092。

2 单线程生产者

说是单线程,其实并不是,你启动一个生产者其实是2个线程,后台有一个IO线程用于真正发送消息出去,前台有一个线程用于把消息发送到本地缓冲区。

KafkaProducer是发布消息到Kafka集群的客户端,它是线程安全的并且共享单一生产者实例。生产者包含一个带有缓冲区的池,用于保存还没有传送到Kafka集群的消息记录以及一个后台IO线程,该线程将这些留在缓冲区的消息记录发送到Kafka集群中。

2.1 KafkaProducer构造函数参数

(1)acks

0表示发送不理睬发送是否成功;

1表示需要等待leader成功写入日志才返回;

all表示所有副本都写入日志才返回(2)buffer_memory

默认33554432也就是32M,该参数用于设置producer用于缓存消息的缓冲区大小,

如果采用异步发送消息,那么生产者启动后会创建一个内存缓冲区用于存放待发送的消息,

然后由专属线程来把放在缓冲区的消息进行真正发送,

如果要给生产者要给很多分区发消息那么就需要考虑这个参数的大小防止过小降低吞吐量(3)compression_type

是否启用压缩,默认是none,可选类型为gzip、lz4、snappy三种。

压缩会降低网络IO但是会增加生产者端的CPU消耗。

另外如果broker端的压缩设置和生产者不同那么也会给broker带来重新解压缩和重新压缩的CPU负担。(4)retries

重试次数,当消息发送失败后会尝试几次重发。

默认为0,一般考虑到网络抖动或者分区的leader切换,

而不是服务端真的故障所以可以设置重试3次。(5)retry_backoff_ms

每次重试间隔多少毫秒,默认100毫秒。(6)max_in_flight_requests_per_connection

生产者会将多个发送请求缓存在内存中,默认是5个,

如果你开启了重试,也就是设置了retries参数,

那么将可能导致针对于同一分区的消息出现顺序错乱。

为了防止这种情况需要把该参数设置为1,来保障同分区的消息顺序。(7)batch_size

对于调优生产者吞吐量和延迟性能指标有重要的作用。

buffer_memeory可以看做池子,而这个batch_size可以看做池子里装有消息的小盒子。

这个值默认16384也就是16K,其实不大。生产者会把发往同一个分区的消息放在一个batch中,

当batch满了就会发送里面的消息,但是也不一定非要等到满了才会发。这个数值大那么生产者吞吐量高但是性能低,

因为盒子太大占用内存发送的时候这个数据量也就大。如果你设置成1M,那么显然生产者的吞吐量要比16K高的多。(8)linger_ms

上面说batch没有填满也可以发送,那显然有一个时间控制,就是这个参数,

默认是0毫秒,这个参数就是用于控制消息发送延迟多久的。

默认是立即发送,无需关系batch是否填满。

大多数场景我们希望立即发送,但是这也降低了吞吐量。(9)max_request_size

最大请求大小,可以理解为一条消息记录的最大大小,默认是1048576字节,1M。(10)request_timeout_ms

生产者发送消息后,broker需要在规定时间内将处理结果返回给生产者,

那个这个时间长度就是这个参数控制的,默认30000,也就是30秒。如果broker在30秒内没有给生产者响应,那么生产者就会认为请求超时,

并在回调函数中进行特殊处理,或者进行重试。

2.2 示例代码

# -*- coding: utf-8 -*-

import time

import random

import sysfrom kafka import KafkaProducer

from kafka.errors import KafkaError, KafkaTimeoutError

import jsonclass Producer(object):def __init__(self, KafkaServerList=['127.0.0.1:9092'], ClientId="Procucer01", Topic='Test'):self._kwargs = {"bootstrap_servers": KafkaServerList,"client_id": ClientId,"acks": 1,"buffer_memory": 33554432,'compression_type': None,"retries": 3,"batch_size": 1048576,"linger_ms": 100,"key_serializer": lambda m: json.dumps(m).encode('utf-8'),"value_serializer": lambda m: json.dumps(m).encode('utf-8'),}self._topic = Topictry:self._producer = KafkaProducer(**self._kwargs)except Exception as err:print(err)def _onSendSucess(self, record_metadata):"""异步发送成功回调函数,也就是真正发送到kafka集群且成功才会执行。发送到缓冲区不会执行回调方法。:param record_metadata::return:"""print("发送成功")print("被发往的主题:", record_metadata.topic)print("被发往的分区:", record_metadata.partition)print("队列位置:", record_metadata.offset) # 这个偏移量是相对偏移量,也就是相对起止位置,也就是队列偏移量。def _onSendFailed(self):print("发送失败")def sendMessage(self, value=None, partition=None):if not value:return None# 发送的消息必须是序列化后的,或者是字节# value = json.dumps(value, encoding='utf-8', ensure_ascii=False)# value 必须为字节或者被序列化为字节,# 由于之前我们初始化时已经通过value_serializer来做了,所以我上面的语句就注释了# key 与value对应的键,可选,也就是把一个键关联到这个消息上,# KEY相同就会把消息发送到同一分区上,所以如果有这个要求就可以设置KEY,也需要序列化# partition 发送到哪个分区,整型。如果不指定将会自动分配。kwargs = {"value": value,"key": None,"partition": partition}try:# 异步发送,发送到缓冲区,同时注册两个回调函数,一个是发送成功的回调,一个是发送失败的回调。# send函数是有返回值的是RecordMetadata,也就是记录的元数据,包括主题、分区、偏移量future = self._producer.send(self._topic, **kwargs)future.add_callback(self._onSendSucess)future.add_errback(self._onSendFailed)print("发送消息:", value)except KafkaTimeoutError as err:print(err)except Exception as err:print(err)def closeConnection(self, timeout=None):# 关闭生产者,可以指定超时时间,也就是等待关闭成功最多等待多久。self._producer.close(timeout=timeout)def sendNow(self, timeout=None):# 调用flush()函数可以将所有在缓冲区的消息记录立即发送,即使ligner_ms值大于0.# 这时候后台发送消息线程就会开始立即发送消息并且阻塞在这里,等待消息发送成功,当然是否阻塞取决于acks的值。# 如果不调用flush函数,那么什么时候发送消息取决于ligner_ms或者batch任意一个条件满足就会发送。try:self._producer.flush(timeout=timeout)except KafkaTimeoutError as err:print(err)except Exception as err:print(err)def main():p = Producer(KafkaServerList=["127.0.0.1:29092"], ClientId="Procucer01", Topic="test")for i in range(10):time.sleep(1)closePrice = random.randint(1, 500)msg = {"Publisher": "Procucer01","股票代码": 60000 + i,"昨日收盘价": closePrice,"今日开盘价": 0,}p.sendMessage(value=msg)p.closeConnection()if __name__ == "__main__":try:main()finally:sys.exit()

3 单线程消费者

初始化一个消费者实例,消费者不是线程安全的,所以建议一个线程实现一个消费者,而不是一个消费者让多个线程共享。

下面这些是可选参数,可以在初始化KafkaConsumer实例的时候传递进去:

enable_auto_commit 是否自动提交,默认是trueauto_commit_interval_ms 自动提交间隔毫秒数auto_offset_reset="earliest"

重置偏移量,earliest移到最早的可用消息,latest最新的消息,默认为latest

3.1 手动拉取消息

# -*- coding: utf-8 -*-

import sys

from kafka import KafkaConsumer

import jsonclass Consumer(object):def __init__(self, KafkaServerList=['127.0.0.1:9092'], GroupID='TestGroup11', ClientId="Test", Topics=['Test', ]):"""用于设置消费者配置信息,这些配置项可以从源码中找到,下面为必要参数。:param KafkaServerList: kafka服务器IP:PORT 列表:param GroupID: 消费者组ID:param ClientId: 消费者名称:param Topic: 主题 列表"""self._kwargs = {"bootstrap_servers": KafkaServerList,"client_id": ClientId,"group_id": GroupID,"enable_auto_commit": False,"auto_offset_reset": "earliest","key_deserializer": lambda m: json.loads(m.decode('utf-8')),"value_deserializer": lambda m: json.loads(m.decode('utf-8')),}try:self._consumer = KafkaConsumer(**self._kwargs)self._consumer.subscribe(topics=(Topics))except Exception as err:print("Consumer init failed, %s" % err)def consumeMsg(self):try:while True:data = self._consumer.poll(timeout_ms=1000, max_records=100) # 拉取消息,字典类型print(data)if data:for key in data:for consumerrecord in data.get(key):# 返回的是ConsumerRecord对象,可以通过字典的形式获取内容。if consumerrecord != None:# 消息消费逻辑message = {"Topic": consumerrecord.topic,"Partition": consumerrecord.partition,"Offset": consumerrecord.offset,"Key": consumerrecord.key,"Value": consumerrecord.value}print(message)# 消费逻辑执行完毕后在提交偏移量self._consumer.commit()else:print("%s consumerrecord is None." % key)except Exception as err:print(err)def main():try:c = Consumer(KafkaServerList=['127.0.0.1:29092'], Topics=['test'])c.consumeMsg()except Exception as err:print(err)if __name__ == "__main__":try:main()finally:sys.exit()

3.2 非手动拉取消息

# -*- coding: utf-8 -*-import sys

from kafka import KafkaConsumer

import jsonclass Consumer(object):def __init__(self, KafkaServerList=['172.16.48.171:9092'], GroupID='TestGroup111', ClientId="Test", Topics=['Test', ]):"""用于设置消费者配置信息,这些配置项可以从源码中找到,下面为必要参数。:param KafkaServerList: kafka服务器IP:PORT 列表:param GroupID: 消费者组ID:param ClientId: 消费者名称:param Topic: 主题"""self._kwargs = {"bootstrap_servers": KafkaServerList,"client_id": ClientId,"group_id": GroupID,"enable_auto_commit": False,"auto_offset_reset": "earliest","key_deserializer": lambda m: json.loads(m.decode('utf-8')),"value_deserializer": lambda m: json.loads(m.decode('utf-8')),}try:self._consumer = KafkaConsumer(**self._kwargs)self._consumer.subscribe(topics=(Topics))except Exception as err:print("Consumer init failed, %s" % err)def consumeMsg(self):try:while True:for consumerrecord in self._consumer:if consumerrecord:message = {"Topic": consumerrecord.topic,"Partition": consumerrecord.partition,"Offset": consumerrecord.offset,"Key": consumerrecord.key,"Value": consumerrecord.value}print(message)# 消费逻辑执行完毕后在提交偏移量self._consumer.commit()except Exception as err:print(err)def main():try:c = Consumer(KafkaServerList=['127.0.0.1:29092'], Topics=['test'])c.consumeMsg()except Exception as err:print(err)if __name__ == "__main__":try:main()finally:sys.exit()4 消费者

4.1 简单demo

启动后消费者可以从kafka服务器获取数据.

from kafka import KafkaConsumer# 参数为接收主题和kafka服务器地址

consumer = KafkaConsumer('test',bootstrap_servers=['127.0.0.1:29092'])# 这是一个永久堵塞的过程,生产者消息会缓存在消息队列中,并且不删除,

# 所以每个消息在消息队列中都有偏移

# consumer是一个消息队列,当后台有消息时,这个消息队列就会自动增加.

# 所以遍历也总是会有数据,当消息队列中没有数据时,就会堵塞等待消息带来

for msg in consumer:print("{}:{}:{}: key={} value={}".format(msg.topic, msg.partition,msg.offset, msg.key,msg.value))

4.2 消费者组

启动多个消费者,只有其中某一个成员可以消费到,满足要求,消费组可以横向扩展提高处理能力。

from kafka import KafkaConsumer

# 使用group,对于同一个group的成员只有一个消费者实例可以读取数据

consumer = KafkaConsumer('test',group_id='my-group',bootstrap_servers=['127.0.0.1:29092'])

for msg in consumer:print("{}:{}:{}: key={} value={}".format(msg.topic,msg.partition,msg.offset,msg.key,msg.value))

4.3 读取目前最早可读的消息

auto_offset_reset:重置偏移量,earliest移到最早的可用消息,latest最新的消息,默认为latest。源码定义:{‘smallest’: ‘earliest’, ‘largest’: ‘latest’}

from kafka import KafkaConsumer

# 使用group,对于同一个group的成员只有一个消费者实例可以读取数据

consumer = KafkaConsumer('test',auto_offset_reset='earliest',bootstrap_servers=['127.0.0.1:29092'])

for msg in consumer:print("{}:{}:{}: key={} value={}".format(msg.topic,msg.partition,msg.offset,msg.key,msg.value))

4.4 手动设置偏移量

from kafka import KafkaConsumer

from kafka.structs import TopicPartition

# ==========读取指定位置消息===============

consumer = KafkaConsumer('test',bootstrap_servers=['127.0.0.1:29092'])print(consumer.partitions_for_topic("test")) # 获取test主题的分区信息

print(consumer.topics()) # 获取主题列表

print(consumer.subscription()) # 获取当前消费者订阅的主题

print(consumer.assignment()) # 获取当前消费者topic、分区信息

print(consumer.beginning_offsets(consumer.assignment())) # 获取当前消费者可消费的偏移量

consumer.seek(TopicPartition(topic='test', partition=0), 5) # 重置偏移量,从第5个偏移量消费for msg in consumer:print("{}:{}:{}: key={} value={}".format(msg.topic,msg.partition,msg.offset,msg.key,msg.value))

4.5 订阅多个主题

from kafka import KafkaConsumer

from kafka.structs import TopicPartitionconsumer = KafkaConsumer('test',bootstrap_servers=['127.0.0.1:29092'])# 订阅要消费的主题

consumer.subscribe(topics=('test','test0'))

print(consumer.topics())#获取当前主题的最新偏移量

print(consumer.position(TopicPartition(topic='test', partition=0))) for msg in consumer:print("{}:{}:{}: key={} value={}".format(msg.topic,msg.partition,msg.offset,msg.key,msg.value))

4.6 手动拉取消息

from kafka import KafkaConsumer

import timeconsumer = KafkaConsumer('test',bootstrap_servers=['127.0.0.1:29092'])# 订阅要消费的主题

consumer.subscribe(topics=('test','test0'))

while True:msg = consumer.poll(timeout_ms=5) # 从kafka获取消息print(msg)time.sleep(2)

4.7 消息挂起与恢复

# ==============消息恢复和挂起===========from kafka import KafkaConsumer

from kafka.structs import TopicPartition

import timeconsumer = KafkaConsumer(bootstrap_servers=['127.0.0.1:29092'])consumer.subscribe(topics=('test'))

consumer.topics()# pause执行后,consumer不能读取,直到调用resume后恢复

consumer.pause(TopicPartition(topic=u'test', partition=0))

num = 0

while True:print(num)print(consumer.paused()) # 获取当前挂起的消费者msg = consumer.poll(timeout_ms=5)print(msg)time.sleep(2)num = num + 1if num == 10:print("resume...")consumer.resume(TopicPartition(topic='test', partition=0))print("resume......")

相关文章:

kafka-6-python单线程操作kafka

使用Python操作Kafka:KafkaProducer、KafkaConsumer Python kafka-python API的帮助文档 1 kafka tools连接 (1)/usr/local/kafka_2.13-3.4.0/config/server.properties listeners PLAINTEXT://myubuntu:9092 advertised.listenersPLAINTEXT://192.168.1.8:2909…...

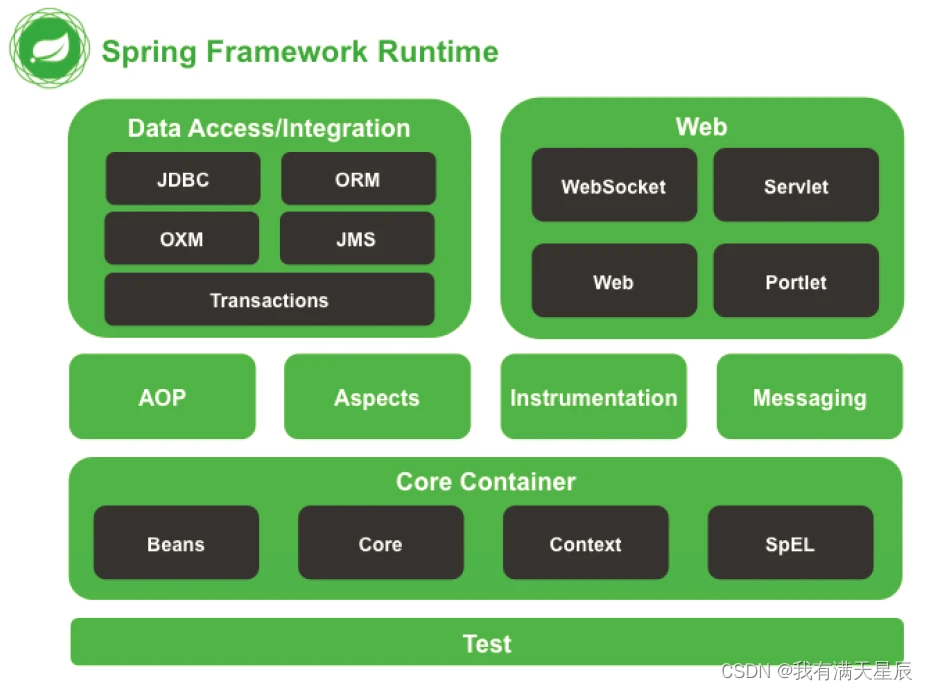

【Spring教程】1.Spring概述

1、概述 1.1、Spring是什么? Spring 是一款主流的 Java EE 轻量级开源框架 ,Spring 由“Spring 之父”Rod Johnson 提出并创立,其目的是用于简化 Java 企业级应用的开发难度和开发周期。Spring的用途不仅限于服务器端的开发。从简单性、可测…...

设计模式-代理模式

控制和管理访问 玩过扮白脸,扮黑脸的游戏吗?你是一个白脸,提供很好且很友善的服务,但是你不希望每个人都叫你做事,所以找了黑脸控制对你的访问。这就是代理要做的:控制和管理对象。 监视器编码 需求&…...

)

DPDK — MALLOC(librte_malloc,Memory Manager,内存管理组件)

目录 文章目录 目录MALLOC(librte_malloc,Memory Manager,内存管理组件)rte_malloc() 接口malloc_heap 结构体malloc_elem 结构体内存初始化流程内存申请流程内存释放流程MALLOC(librte_malloc,Memory Manager,内存管理组件) MALLOC 库基于 hugetlbfs 内核文件系统来实…...

【Java开发】Spring 12 :Spring IOC控制反转和依赖注入(解决单接口多实现类调用)

IOC 是 Inversion of Control 的简写,译为“控制反转”,Spring 通过 IOC 容器来管理所有 Java 对象的实例化和初始化,控制对象与对象之间的依赖关系。我们将由 IOC 容器管理的 Java 对象称为 Spring Bean,它与使用关键字 new 创建…...

【C++学习】基础语法(三)

众所周知C语言是面向过程的编程语言,关注的是过程;解决问题前,需要分析求解的步骤,然后编辑函数逐步解决问题。C是基于面向对象的,关注的是对象,将一件事拆分成不同的对象,不同对象间交互解决问…...

k8s自动化安装脚本(kubeadm-1.23.7)

文章目录介绍软件架构版本介绍更新内容2023-02-192023-02-152023-02-142023-02-102022-10-202022-08-06准备部署包操作步骤环境准备结构备注解压部署包修改host文件脚本使用方式初始化环境验证ansible配置安装k8s集群登录master的节点添加node节点master节点状态检查组件安装安…...

面试题记录

Set与Map的区别 map是键值对,set是值的集合。键,值可以是任何类型map可以通过get获取,map不能。都能通过迭代器进行for…of遍历set的值是唯一的,可以做数组去重,map,没有格式限制,可以存储数据…...

链式前向星介绍以及原理

1 链式前向星 1.1 简介 链式前向星可用于存储图,本质上是一个静态链表。 一般来说,存储图常见的两种方式为: 邻接矩阵邻接表 邻接表的实现一般使用数组实现,而链式前向星就是使用链表实现的邻接表。 1.2 出处 出处可参考此…...

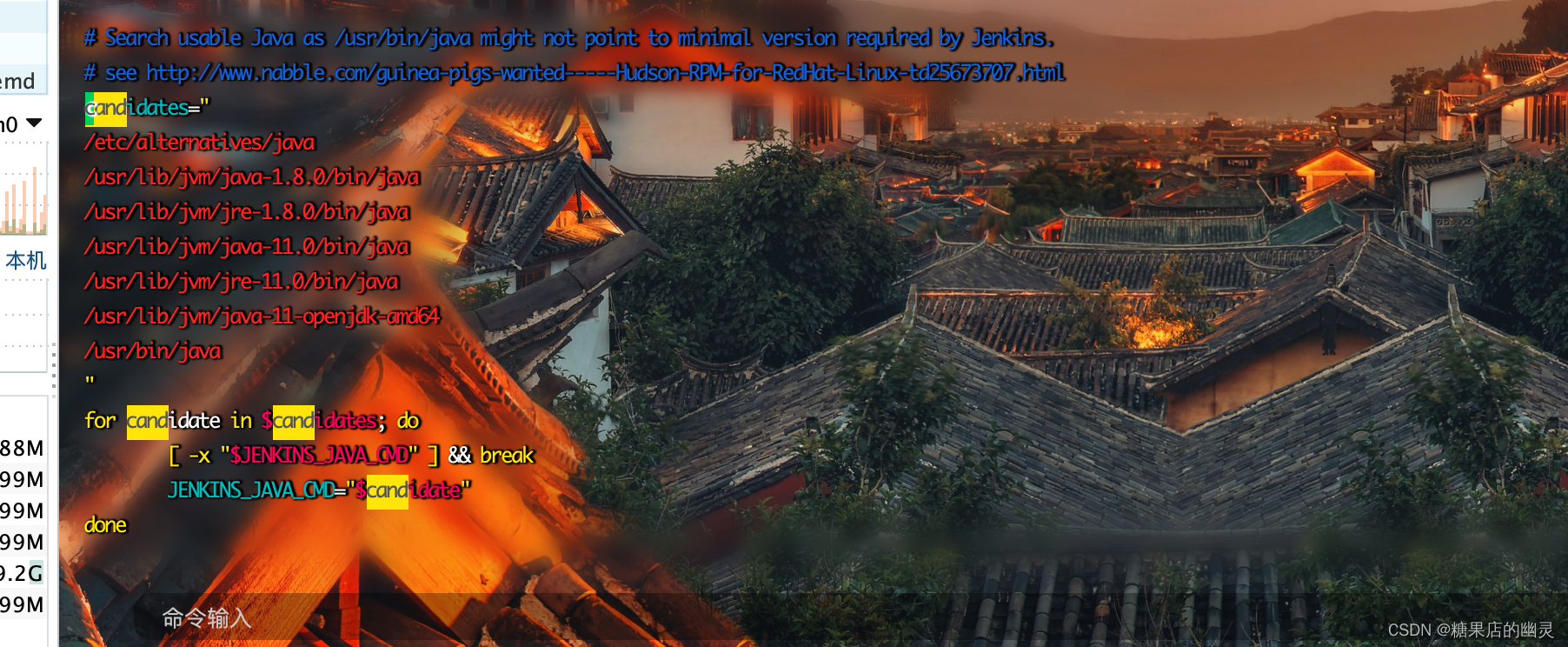

jenkins 安装 -适用于在线安装 后续写个离线安装的

jenkins安装1.下载jenkins2.安装启动3.附件卸载jdk的命令4.配置jenkins一、在jenkins配置文件中配置jdk环境变量二、修改jenkins默认的操作用户1.下载jenkins jenkins官网下载 https://www.jenkins.io/ 点击下载 我是centos系统所以选择centos,点击后按着官方提供…...

【C++】再谈vscode界面调试C++程序(linux) - 知识点目录

再谈vscode界面调试C程序(linux) 配套文档:vscode界面调试C程序(linux) 命令解释 g -g ../main.cpp 编译main.cpp文件; -g:生成调试信息。编译器会在可执行文件中嵌入符号表和源代码文件名&…...

蚂蚁感冒---第五届蓝桥杯真题

目录 题目链接 题目描述 分析: 代码: y总综合 666 题目链接 1211. 蚂蚁感冒 - AcWing题库 题目描述 分析: y总真牛逼,掉头等价于穿过,以第一个点为分界点,分别判断 代码: (自…...

常见排序算法--Java实现

常见排序算法--Java实现插入排序直接插入排序折半插入排序希尔排序交换排序冒泡排序快速排序选择排序直接选择排序堆排序归并排序基数排序各种排序方法比较在网上找了些排序算法的资料。此篇笔记本人总结比较,简单注释,觉得比较好理解,且相对…...

算法笔记(九)—— 暴力递归

暴力递归(尝试) 1. 将问题转化为规模缩小了的同类问题子问题 2. 有明确的不需要的继续递归的条件 3. 有当得到子问题结果之后的决策过程 4. 不记录每一个子问题的解 Question:经典汉诺塔问题 1. 理解清楚,基础三个圆盘的移动…...

Flask框架学习记录

Flask项目简要 项目大致结构 flaskDemo1 ├─static ├─templates └─app.py app.py # 从flask这个包中导入Flask类 from flask import Flask# 使用Flask类创建一个app对象 # __name__:代表当前app.py这个模块 # 1.以后出现bug,可以帮助快速定位 # 2.对于寻找…...

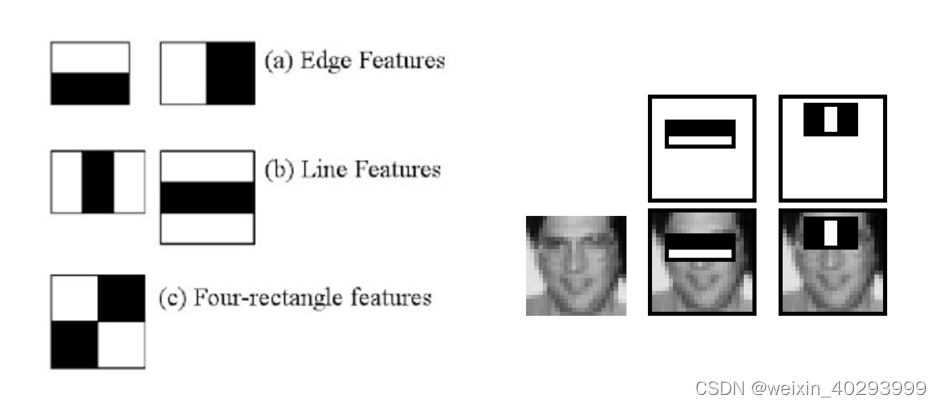

【Opencv 系列】 第6章 人脸检测(Haar/dlib) 关键点检测

本章内容 1.人脸检测,分别用Haar 和 dlib 目标:确定图片中人脸的位置,并画出矩形框 Haar Cascade 哈尔级联 核心原理 (1)使用Haar-like特征做检测 (2)Integral Image : 积分图加速特征计算 …...

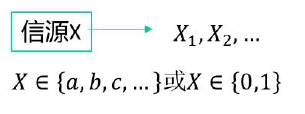

信源分类及数学模型

本专栏包含信息论与编码的核心知识,按知识点组织,可作为教学或学习的参考。markdown版本已归档至【Github仓库:information-theory】,需要的朋友们自取。或者公众号【AIShareLab】回复 信息论 也可获取。 文章目录信源分类按照信源…...

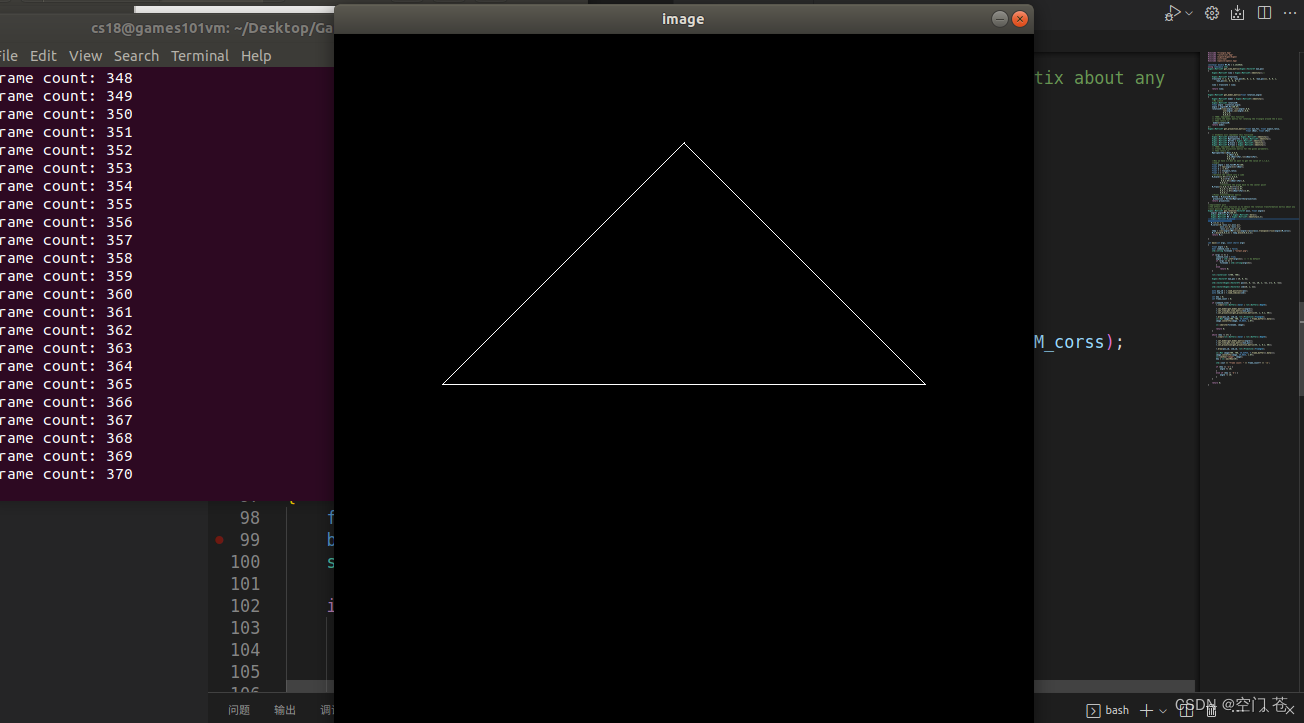

Games101-202作业1

一. 将模型从模型空间变换到世界空间下 在这个作业下,我们主要进行旋转的变换。 二.视图变换 ,将相机移动到坐标原点,同时保证物体和相机进行同样的变换(这样对形成的图像没有影响) 在这个作业下我们主要进行摄像机的平移变换&am…...

Linux系统之终端管理命令的基本使用

Linux系统之终端管理命令的基本使用一、检查本地系统环境1.检查系统版本2.检查系统内核版本二、终端介绍1.终端简介2.Linux终端简介3.终端的发展三、终端的相关术语1.终端模拟器2.tty终端3.pts终端4.pty终端5.控制台终端四、终端管理命令ps1.直接使用ps命令2.列出登录详细信息五…...

【Mongoose笔记】MQTT 服务器

【Mongoose笔记】MQTT 服务器 简介 Mongoose 笔记系列用于记录学习 Mongoose 的一些内容。 Mongoose 是一个 C/C 的网络库。它为 TCP、UDP、HTTP、WebSocket、MQTT 实现了事件驱动的、非阻塞的 API。 项目地址: https://github.com/cesanta/mongoose学习 下面…...

.Net框架,除了EF还有很多很多......

文章目录 1. 引言2. Dapper2.1 概述与设计原理2.2 核心功能与代码示例基本查询多映射查询存储过程调用 2.3 性能优化原理2.4 适用场景 3. NHibernate3.1 概述与架构设计3.2 映射配置示例Fluent映射XML映射 3.3 查询示例HQL查询Criteria APILINQ提供程序 3.4 高级特性3.5 适用场…...

【SQL学习笔记1】增删改查+多表连接全解析(内附SQL免费在线练习工具)

可以使用Sqliteviz这个网站免费编写sql语句,它能够让用户直接在浏览器内练习SQL的语法,不需要安装任何软件。 链接如下: sqliteviz 注意: 在转写SQL语法时,关键字之间有一个特定的顺序,这个顺序会影响到…...

Axios请求超时重发机制

Axios 超时重新请求实现方案 在 Axios 中实现超时重新请求可以通过以下几种方式: 1. 使用拦截器实现自动重试 import axios from axios;// 创建axios实例 const instance axios.create();// 设置超时时间 instance.defaults.timeout 5000;// 最大重试次数 cons…...

数据库分批入库

今天在工作中,遇到一个问题,就是分批查询的时候,由于批次过大导致出现了一些问题,一下是问题描述和解决方案: 示例: // 假设已有数据列表 dataList 和 PreparedStatement pstmt int batchSize 1000; // …...

Web后端基础(基础知识)

BS架构:Browser/Server,浏览器/服务器架构模式。客户端只需要浏览器,应用程序的逻辑和数据都存储在服务端。 优点:维护方便缺点:体验一般 CS架构:Client/Server,客户端/服务器架构模式。需要单独…...

渗透实战PortSwigger靶场:lab13存储型DOM XSS详解

进来是需要留言的,先用做简单的 html 标签测试 发现面的</h1>不见了 数据包中找到了一个loadCommentsWithVulnerableEscapeHtml.js 他是把用户输入的<>进行 html 编码,输入的<>当成字符串处理回显到页面中,看来只是把用户输…...

【堆垛策略】设计方法

堆垛策略的设计是积木堆叠系统的核心,直接影响堆叠的稳定性、效率和容错能力。以下是分层次的堆垛策略设计方法,涵盖基础规则、优化算法和容错机制: 1. 基础堆垛规则 (1) 物理稳定性优先 重心原则: 大尺寸/重量积木在下…...

Axure 下拉框联动

实现选省、选完省之后选对应省份下的市区...

深入浅出WebGL:在浏览器中解锁3D世界的魔法钥匙

WebGL:在浏览器中解锁3D世界的魔法钥匙 引言:网页的边界正在消失 在数字化浪潮的推动下,网页早已不再是静态信息的展示窗口。如今,我们可以在浏览器中体验逼真的3D游戏、交互式数据可视化、虚拟实验室,甚至沉浸式的V…...

python打卡第47天

昨天代码中注意力热图的部分顺移至今天 知识点回顾: 热力图 作业:对比不同卷积层热图可视化的结果 def visualize_attention_map(model, test_loader, device, class_names, num_samples3):"""可视化模型的注意力热力图,展示模…...