【OpenVINOSharp】在英特尔® 开发者套件爱克斯开发板使用OpenVinoSharp部署Yolov8模型

在英特尔® 开发者套件爱克斯开发板使用OpenVinoSharp部署Yolov8模型

- 一、英特尔开发套件 AIxBoard 介绍

- 1. 产品定位

- 2. 产品参数

- 3. AI推理单元

- 二、配置 .NET 环境

- 1. 添加 Microsoft 包存储库

- 2. 安装 SDK

- 3. 测试安装

- 4. 测试控制台项目

- 三、安装 OpenVINO Runtime

- 1. 下载 OpenVINO Runtime

- 2. 解压安装包

- 3. 安装依赖

- 4. 配置环境变量

- 四、配置 AlxBoard_deploy_yolov8 项目

- 1. 创建 AlxBoard_deploy_yolov8 项目

- 2. 添加 OpenVINOSharp 依赖

- 3. 添加OpenCvSharp

- 五、运行AlxBoard_deploy_yolov8 项目

- 1. 编译运行 Yolov8-det 模型

- 2. 编译运行 Yolov8-cls 模型

- 3. 编译运行 Yolov8-pose 模型

- 4. 编译运行 Yolov8-seg 模型

- 六、模型运行时间

- 七、总结

英特尔发行版 OpenVINO™工具套件基于oneAPI 而开发,可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,适用于从边缘到云的各种英特尔平台上,帮助用户更快地将更准确的真实世界结果部署到生产系统中。通过简化的开发工作流程, OpenVINO™可赋能开发者在现实世界中部署高性能应用程序和算法。

C#是由C和C++衍生出来的一种安全的、稳定的、简单的、优雅的面向对象编程语言。C#综合了VB简单的可视化操作和C++的高运行效率,以其强大的操作能力、优雅的语法风格、创新的语言特性和便捷的面向组件编程的支持成为.NET开发的首选语言。然而 OpenVINO™未提供C#语言接口,这对在C#中使用 OpenVINO™带来了很多麻烦,在之前的工作中,我们推出了OpenVinoSharp,旨在推动 OpenVINO™在C#领域的应用,目前已经成功在Window平台实现使用。在本文中,我们将介绍如何在 AIxBoard开发板上基于Linux系统实现OpenVinoSharp。

项目中所使用的代码已上传至OpenVinoSharp仓库中,GitHub网址为:

https://github.com/guojin-yan/OpenVINOSharp/blob/openvinosharp3.0/tutorial_examples/AlxBoard_deploy_yolov8/Program.cs

技术文档首发网址:在英特尔® 开发者套件上使用 OpenVINOSharp 部署 YOLOv8 模型 | 开发者实战

一、英特尔开发套件 AIxBoard 介绍

1. 产品定位

英特尔开发套件 AIxBoard(爱克斯板)是英特尔开发套件官方序列中的一员,专为入门级人工智能应用和边缘智能设备而设计。爱克斯板能完美胜人工智能学习、开发、实训、应用等不同应用场景。该套件预装了英特尔OpenVINO™工具套件、模型仓库和演示案例,便于您轻松快捷地开始应用开发。

套件主要接口与Jetson Nano载板兼容,GPIO与树莓派兼容,能够最大限度地复用成熟的生态资源。这使得套件能够作为边缘计算引擎,为人工智能产品验证和开发提供强大支持;同时,也可以作为域控核心,为机器人产品开发提供技术支撑。

使用AIxBoard(爱克斯板)开发套件,您将能够在短时间内构建出一个出色的人工智能应用应用程序。无论是用于科研、教育还是商业领域,爱克斯板都能为您提供良好的支持。借助 OpenVINO™ 工具套件,CPU、iGPU 都具备强劲的 AI 推理能力,支持在图像分类、目标检测、分割和语音处理等应用中并行运行多个神经网络。

2. 产品参数

| 主控 | 英特尔赛扬N5105 2.0-2.9GHz (formerly Jasper Lake) |

|---|---|

| 内存 | 板载LPDDR4x 2933MHz, 4GB/6GB/8GB |

| 存储 | 板载 64GB eMMC存储 |

| 存储扩展 | 1个M.2 Key-M 2242扩展槽, 支持SATA&NVME协议 |

| BIOS | AMI UEFI BIOS |

| 系统支持 | Ubuntu20.04 LTS |

| Winodws 10/11 |

3. AI推理单元

借助OpenVINO工具,能够实现CPU+iGPU异构计算推理,IGPU算力约为0.6TOPS

| CPU | INT8/FP16/FP32 |

|---|---|

| iGPU | INT8/FP16 0.6TOPS |

| GNA | 高斯及神经加速器 |

二、配置 .NET 环境

.NET 是一个免费的跨平台开源开发人员平台 ,用于构建多种应用程序。下面将演示 AIxBoard 如何在 Ubuntu 20.04 上安装 .NET环境,支持 .NET Core 2.0-3.1 系列 以及.NET 5-8 系列 ,如果你的 AIxBoard 使用的是其他Linux系统,你可以参考在 Linux 发行版上安装 .NET - .NET | Microsoft Learn。

1. 添加 Microsoft 包存储库

使用 APT 进行安装可通过几个命令来完成。 安装 .NET 之前,请运行以下命令,将 Microsoft 包签名密钥添加到受信任密钥列表,并添加包存储库。

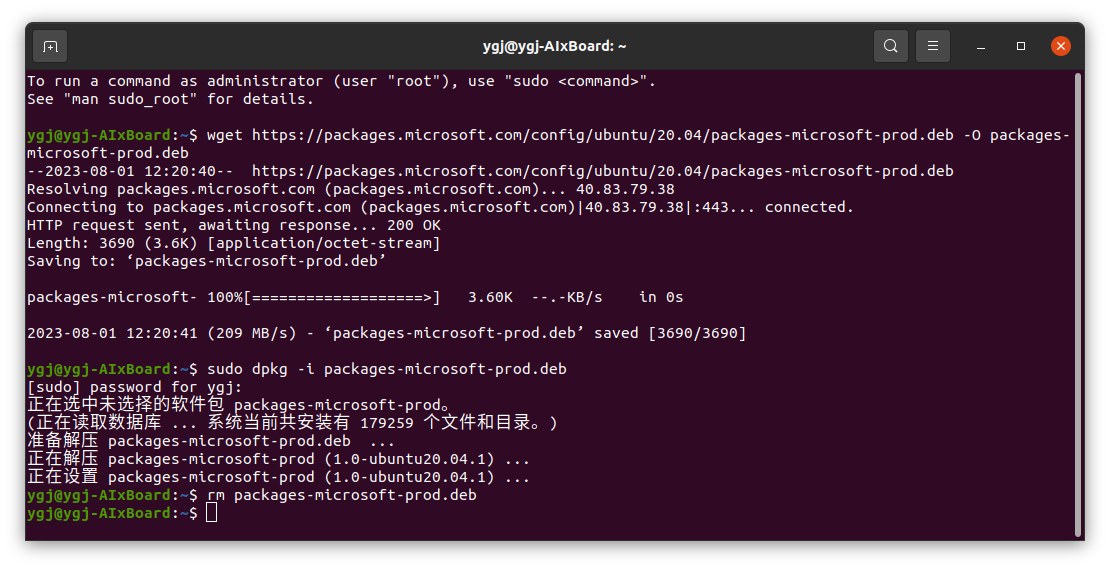

打开终端并运行以下命令:

wget https://packages.microsoft.com/config/ubuntu/20.04/packages-microsoft-prod.deb -O packages-microsoft-prod.deb

sudo dpkg -i packages-microsoft-prod.deb

rm packages-microsoft-prod.deb

下图为输入上面命令后控制台的输出:

2. 安装 SDK

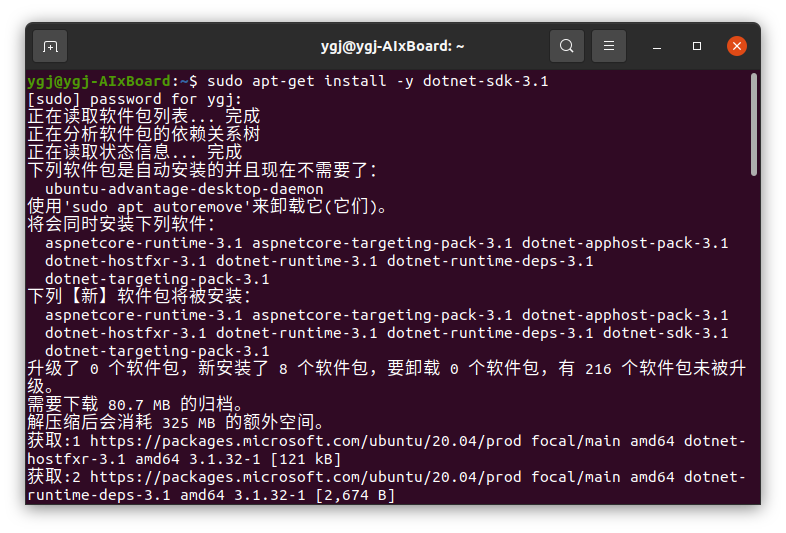

.NET SDK 使你可以通过 .NET 开发应用。 如果安装 .NET SDK,则无需安装相应的运行时。 若要安装 .NET SDK,请运行以下命令:

sudo apt-get update

sudo apt-get install -y dotnet-sdk-3.1

下图为安装后控制台的输出:

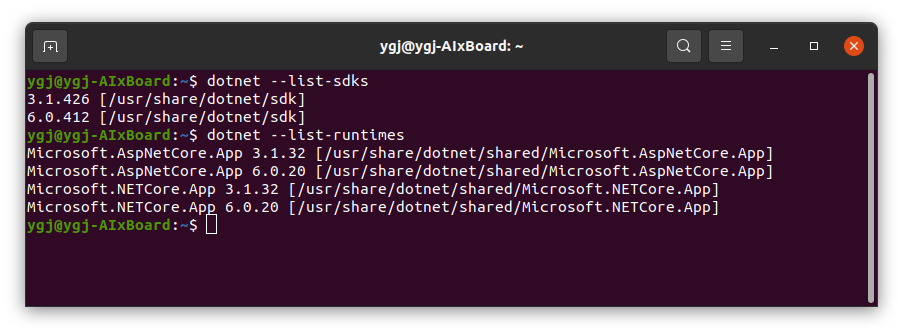

3. 测试安装

通过命令行可以检查 SDK 版本以及Runtime时版本。

dotnet --list-sdks

dotnet --list-runtimes

下图为输入测试命令后控制台的输出:

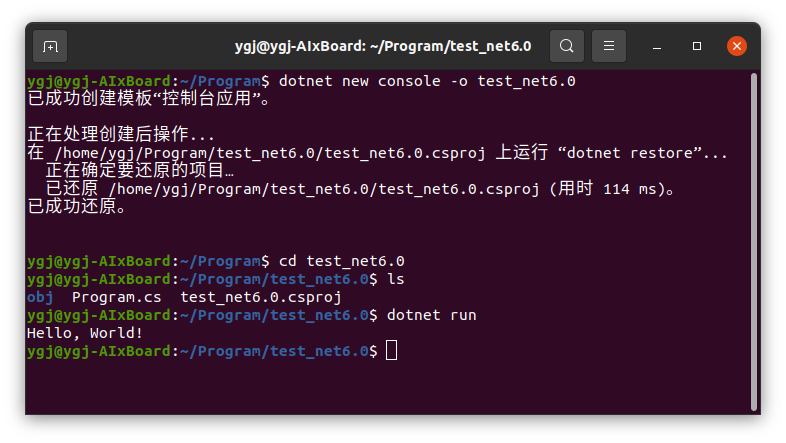

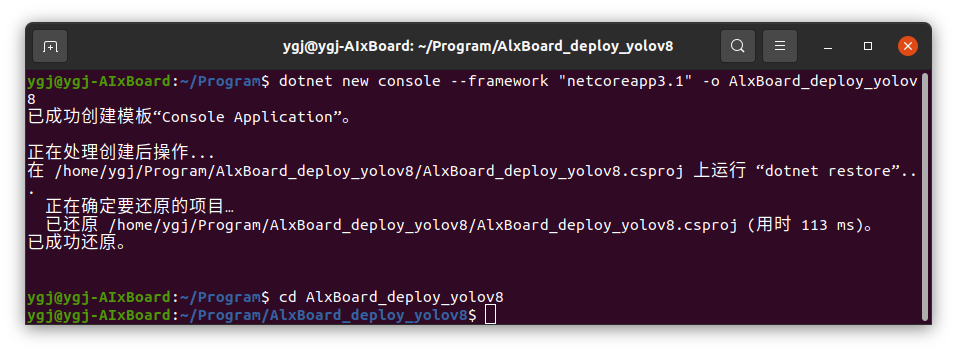

4. 测试控制台项目

在linux环境下,我们可以通过dotnet命令来创建和编译项目,项目创建命令为:

dotnet new <project_type> -o <project name>

此处我们创建一个简单测试控制台项目:

dotnet new console -o test_net6.0

cd test_net6.0

dotnet run

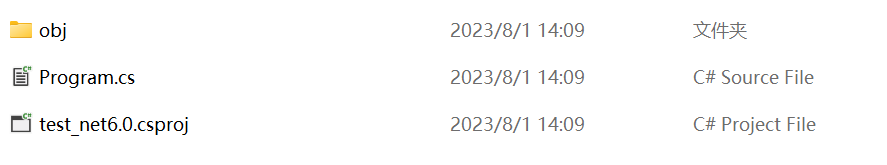

下图为输入测试命令后控制台的输出以及项目文件夹文件情况,C#项目会自动创建一个Program.cs程序文件,里面包含了程序运行入口主函数,同时还会创建一个***.csproj**文件,负责指定项目编译中的一些配置。

以上就是.NET环境的配置步骤,如果你的环境与本文不匹配,可以通过.NET 文档 | Microsoft Learn 获取更多安装步骤。

三、安装 OpenVINO Runtime

OpenVINO™ 有两种安装方式: OpenVINO Runtime和OpenVINO Development Tools。OpenVINO Runtime包含用于在处理器设备上运行模型部署推理的核心库。OpenVINO Development Tools是一组用于处理OpenVINO和OpenVINO模型的工具,包括模型优化器、OpenVINO Runtime、模型下载器等。在此处我们只需要安装OpenVINO Runtime即可。

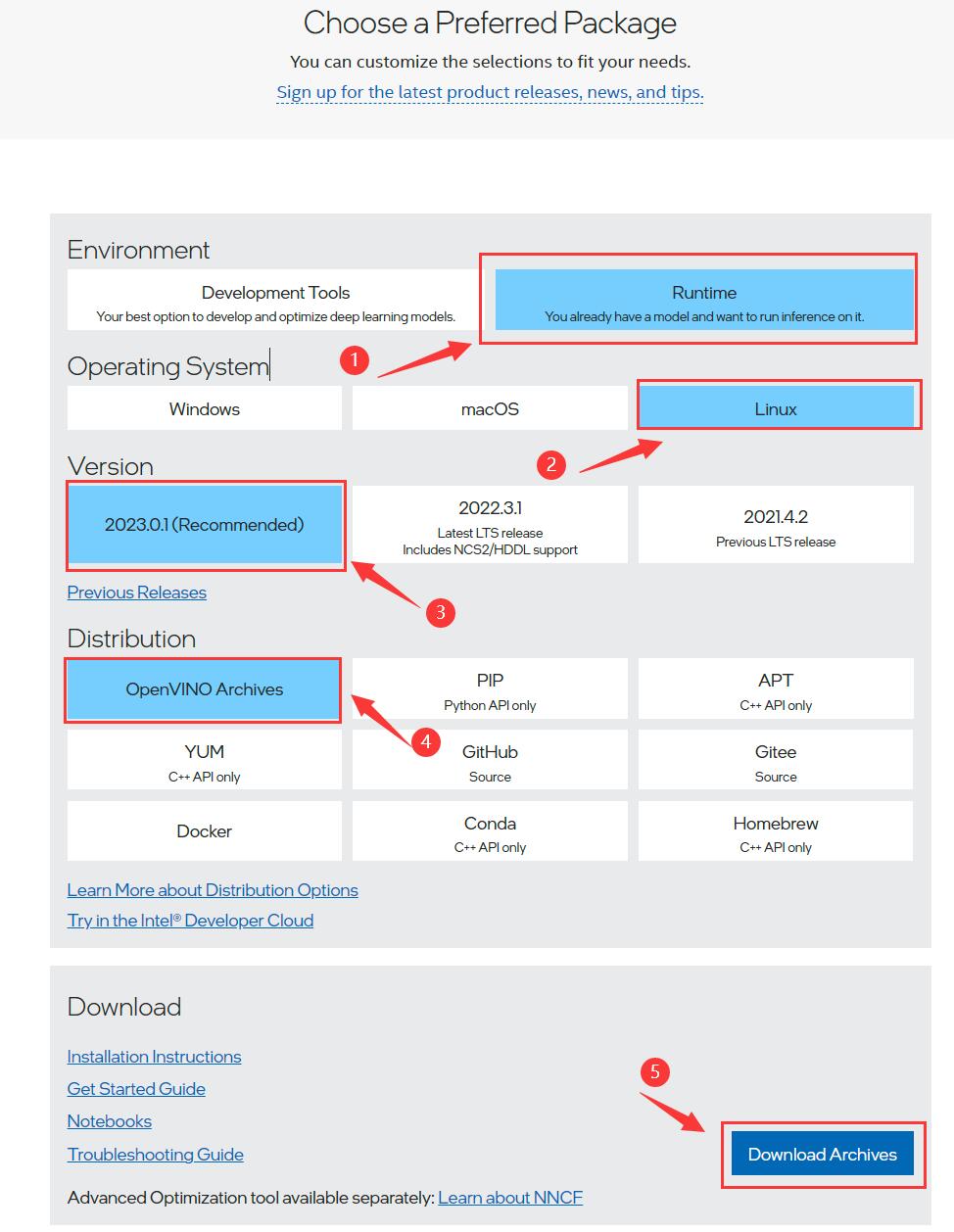

1. 下载 OpenVINO Runtime

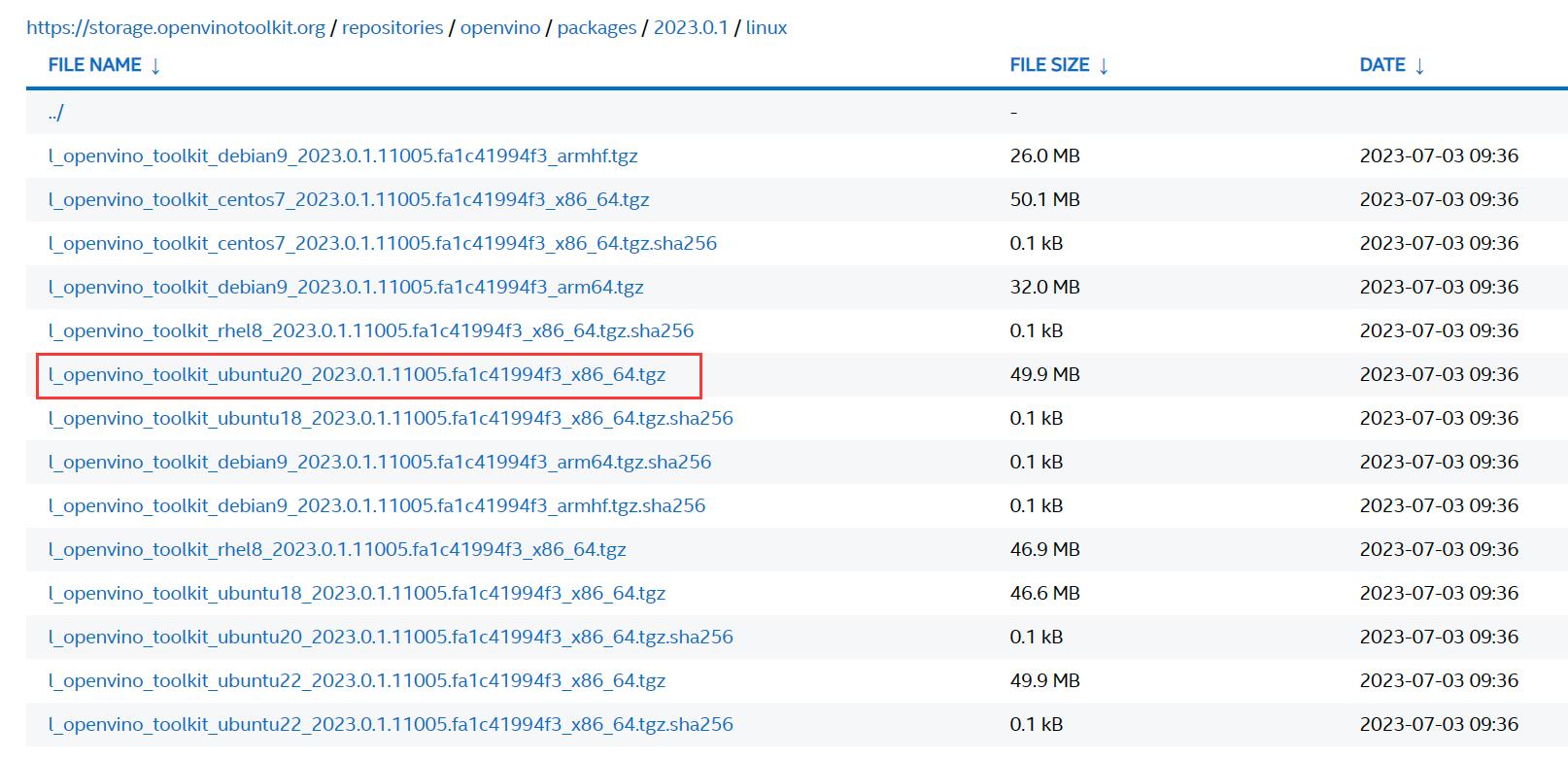

访问Download the Intel Distribution of OpenVINO Toolkit页面,按照下面流程选择相应的安装选项,在下载页面,由于我们的设备使用的是Ubuntu20.04,因此下载时按照指定的编译版本下载即可。

2. 解压安装包

我们所下载的 OpenVINO Runtime 本质是一个C++依赖包,因此我们把它放到我们的系统目录下,这样在编译时会根据设置的系统变量获取依赖项。首先在系统文件夹下创建一个文件夹:

sudo mkdir -p /opt/intel

然后解压缩我们下载的安装文件,并将其移动到指定文件夹下:

tar -xvzf l_openvino_toolkit_ubuntu20_2023.0.1.11005.fa1c41994f3_x86_64.tgz

sudo mv l_openvino_toolkit_ubuntu20_2023.0.1.11005.fa1c41994f3_x86_64 /opt/intel/openvino_2022.3.0

3. 安装依赖

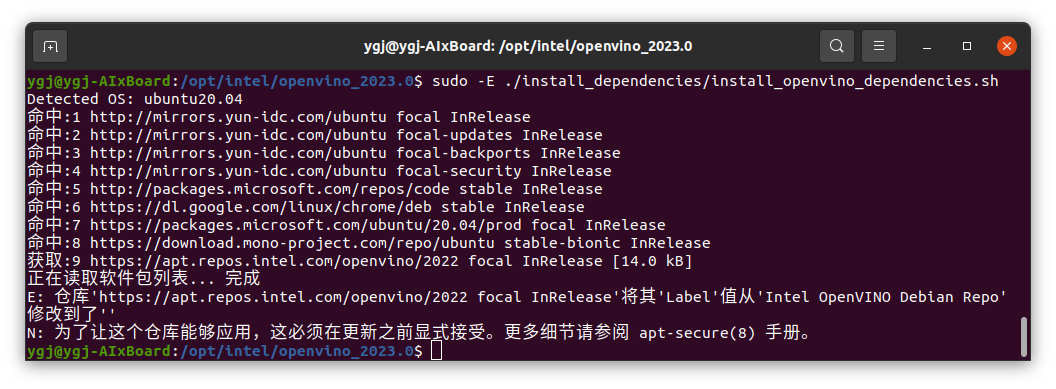

接下来我们需要安装 OpenVINO Runtime 所许雅的依赖项,通过命令行输入以下命令即可:

cd /opt/intel/openvino_2022.3.0/

sudo -E ./install_dependencies/install_openvino_dependencies.sh

4. 配置环境变量

安装完成后,我们需要配置环境变量,以保证在调用时系统可以获取对应的文件,通过命令行输入以下命令即可:

source /opt/intel/openvino_2022.3.0/setupvars.sh

以上就是 OpenVINO Runtime 环境的配置步骤,如果你的环境与本文不匹配,可以通过Install OpenVINO™ Runtime — OpenVINO™ documentation — Version(2023.0)获取更多安装步骤。

四、配置 AlxBoard_deploy_yolov8 项目

项目中所使用的代码已经放在GitHub仓库AlxBoard_deploy_yolov8,大家可以根据情况自行下载和使用,下面我将会从头开始一步步构建AlxBoard_deploy_yolov8项目。

1. 创建 AlxBoard_deploy_yolov8 项目

在该项目中,我们需要使用OpenCvSharp,该依赖目前在Ubutun平台最高可以支持.NET Core 3.1,因此我们此处创建一个.NET Core 3.1的项目,使用Terminal输入以下指令创建并打开项目文件:

dotnet new console --framework "netcoreapp3.1" -o AlxBoard_deploy_yolov8

cd AlxBoard_deploy_yolov8

创建完项目后,将AlxBoard_deploy_yolov8的代码内容替换到创建的项目中的Program.cs文件中.

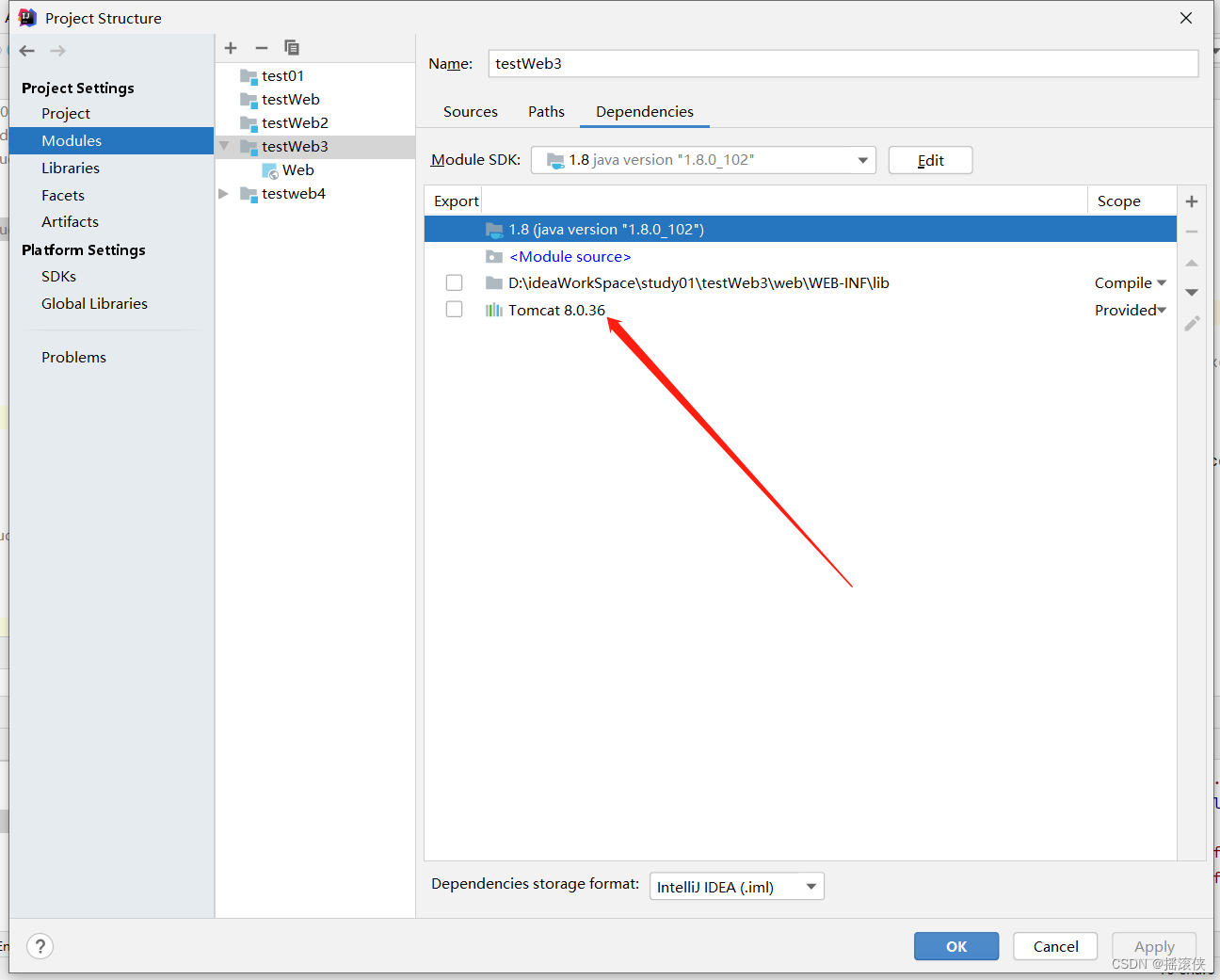

2. 添加 OpenVINOSharp 依赖

由于OpenVINOSharp 当前正处于开发阶段,还未创建Linux版本的NuGet Package,因此需要通过下载项目源码以项目引用的方式使用。

-

下载源码

通过Git下载项目源码,新建一个Terminal,并输入以下命令克隆远程仓库,将该项目放置在AlxBoard_deploy_yolov8同级目录下。

git clone https://github.com/guojin-yan/OpenVINOSharp.git cd OpenVINOSharp本文的项目目录为:

Program--|-AlxBoard_deploy_yolov8|-OpenVINOSharp -

修改OpenVINO™ 依赖

由于项目源码的OpenVINO™ 依赖与本文设置不同,因此需要修改OpenVINO™ 依赖项的路径,主要通过修改

OpenVINOSharp/src/OpenVINOSharp/native_methods/ov_base.cs文件即可,修改内容如下:private const string dll_extern = "./openvino2023.0/openvino_c.dll"; ---修改为---> private const string dll_extern = "libopenvino_c.so"; -

添加项目依赖

在Terminal输入以下命令,即可将OpenVINOSharp添加到AlxBoard_deploy_yolov8项目引用中。

dotnet add reference ./../OpenVINOSharp/src/OpenVINOSharp/OpenVINOSharp.csproj -

添加环境变量

该项目需要调用OpenVINO™动态链接库,因此需要在当前环境下增加OpenVINO™动态链接库路径:

export LD_LIBRARY_PATH=/opt/intel/openvino_2023.0/runtime/lib/intel64

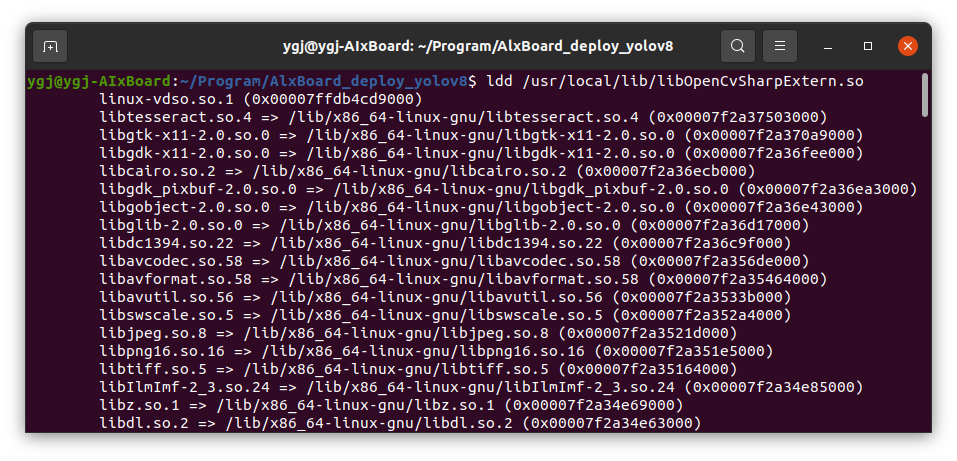

3. 添加OpenCvSharp

-

安装NuGet Package

OpenCvSharp可以通过NuGet Package安装,只需要在Terminal输入以下命令:

dotnet add package OpenCvSharp4_.runtime.ubuntu.20.04-x64 dotnet add package OpenCvSharp4 -

添加环境变量

将以下路径添加到环境变量中:

export LD_LIBRARY_PATH=/home/ygj/Program/OpenVINOSharp/tutorial_examples/AlxBoard_deploy_yolov8/bin/Debug/netcoreapp3.1/runtimes/ubuntu.20.04-x64/native/bin/Debug/netcoreapp3.1/runtimes/ubuntu.20.04-x64/native是AlxBoard_deploy_yolov8编译后生成的路径,该路径下存放了libOpenCvSharpExtern.so文件,该文件主要是封装的OpenCV中的各种接口。也可以将该文件拷贝到项目运行路径下。 -

检测libOpenCvSharpExtern依赖

由于libOpenCvSharpExtern.so是在其他环境下编译好的动态链接库,本机电脑可能会缺少相应的依赖,因此可以通过

ldd命令检测。ldd libOpenCvSharpExtern.so

如果输出内容中没有

no found的,说明不缺少依赖,如果存在,则需要安装缺少的依赖项才可以正常使用。

添加完项目依赖以及NuGet Package后,项目的配置文件内容为:

<Project Sdk="Microsoft.NET.Sdk"><ItemGroup><ProjectReference Include="..\OpenVINOSharp\src\OpenVINOSharp\OpenVINOSharp.csproj" /></ItemGroup><ItemGroup><PackageReference Include="OpenCvSharp4" Version="4.8.0.20230708" /><PackageReference Include="OpenCvSharp4_.runtime.ubuntu.20.04-x64" Version="4.8.0.20230708" /></ItemGroup><PropertyGroup><OutputType>Exe</OutputType><TargetFramework>netcoreapp3.1</TargetFramework></PropertyGroup></Project>

五、运行AlxBoard_deploy_yolov8 项目

该项目测试所使用的模型与文件都可以在OpenVINOSharp中找到,因此下面我们通过OpenVINOSharp 仓库下的模型与文件进行测试。

通过dotnet运行,只需要运行以下命令即可

dotnet run <args>

<args>参数设指的是模型预测类型、模型路径、图片文件路径参数,预测类型输入包括: ‘det’、‘seg’、‘pose’、‘cls’ 四种类型;默认推理设备设置为’AUTO’,对于’det’、'seg’预测,可以设置<path_to_lable>参数,如果设置该参数,会将结果绘制到图片上,如果未设置,会通过控制台打印出来

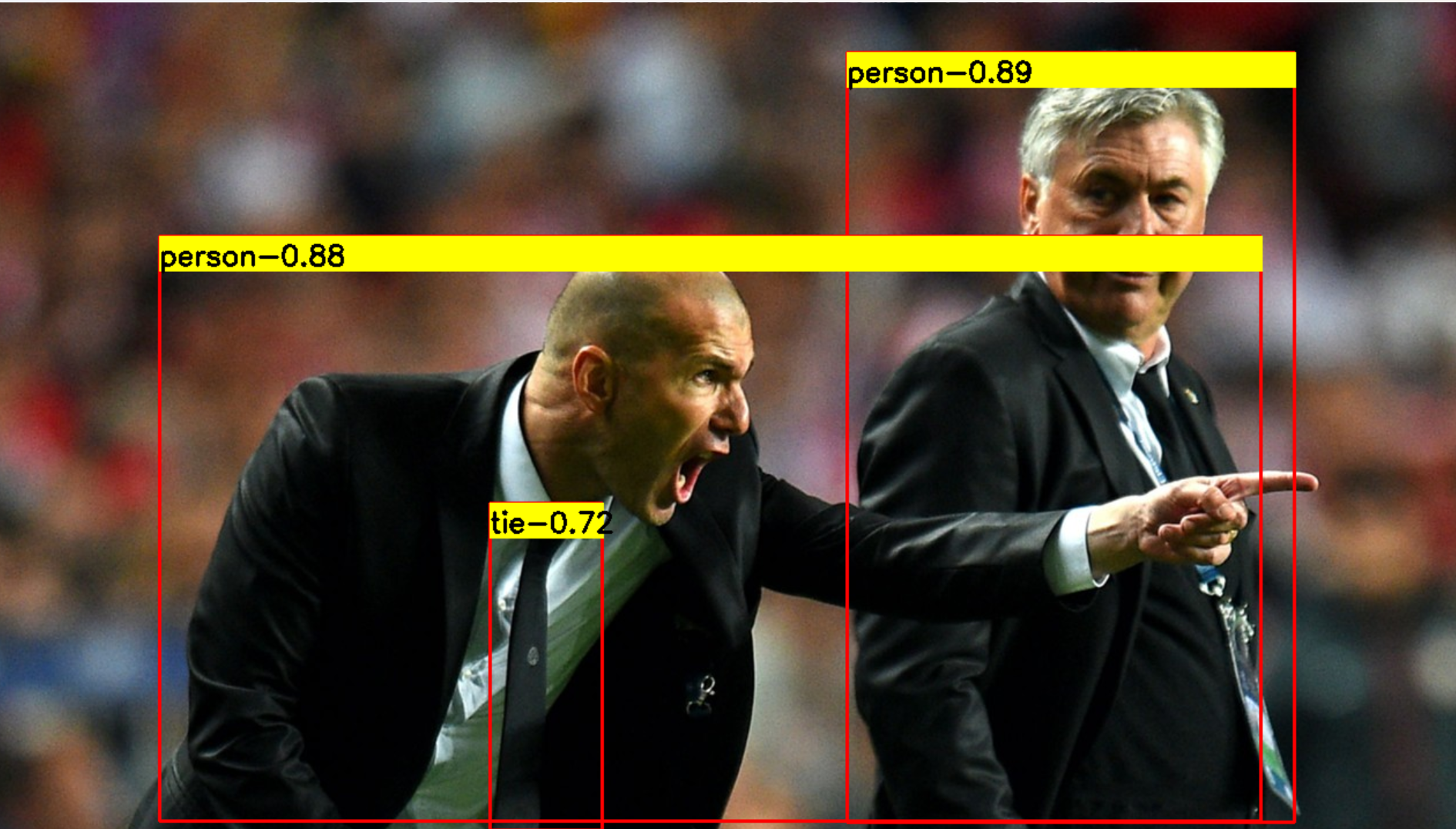

1. 编译运行 Yolov8-det 模型

编译运行命令为:

dotnet run det /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s.xml /home/ygj/Program/OpenVINOSharp/dataset/image/demo_2.jpg GPU.0 /home/ygj/Program/OpenVINOSharp/dataset/lable/COCO_lable.txt

模型推理输出结果为:

---- OpenVINO INFO----

Description : OpenVINO Runtime

Build number: 2023.0.1-11005-fa1c41994f3-releases/2023/0

Set inference device GPU.0.

[INFO] Loading model files: /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s.xml

[INFO] model name: torch_jit

[INFO] inputs:

[INFO] input name: images

[INFO] input type: f32

[INFO] input shape: Shape : [1, 3, 640, 640]

[INFO] outputs:

[INFO] output name: output0

[INFO] output type: f32

[INFO] output shape: Shape : [1, 84, 8400]

[INFO] Read image files: /home/ygj/Program/OpenVINOSharp/dataset/image/demo_2.jpgDetection result : 1: 0 0.89 (x:744 y:43 width:388 height:667)

2: 0 0.88 (x:149 y:202 width:954 height:507)

3: 27 0.72 (x:435 y:433 width:98 height:284)

2. 编译运行 Yolov8-cls 模型

编译运行命令为:

dotnet run cls /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s-cls.xml /home/ygj/Program/OpenVINOSharp/dataset/image/demo_7.jpg GPU.0

模型推理输出结果为:

---- OpenVINO INFO----

Description : OpenVINO Runtime

Build number: 2023.0.1-11005-fa1c41994f3-releases/2023/0

Set inference device GPU.0.

[INFO] Loading model files: /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s-cls.xml

[INFO] model name: torch_jit

[INFO] inputs:

[INFO] input name: images

[INFO] input type: f32

[INFO] input shape: Shape : [1, 3, 224, 224]

[INFO] outputs:

[INFO] output name: output0

[INFO] output type: f32

[INFO] output shape: Shape : [1, 1000]

[INFO] Read image files: /home/ygj/Program/OpenVINOSharp/dataset/image/demo_7.jpgClassification Top 10 result : classid probability

------- -----------

294 0.992173

269 0.002861

296 0.002111

295 0.000714

270 0.000546

276 0.000432

106 0.000159

362 0.000147

260 0.000078

272 0.000070

3. 编译运行 Yolov8-pose 模型

编译运行命令为:

dotnet run pose /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s-pose.xml /home/ygj/Program/OpenVINOSharp/dataset/image/demo_9.jpg GPU.0

模型推理输出结果为:

---- OpenVINO INFO----

Description : OpenVINO Runtime

Build number: 2023.0.1-11005-fa1c41994f3-releases/2023/0

Set inference device GPU.0.

[INFO] Loading model files: /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s-pose.xml

[INFO] model name: torch_jit

[INFO] inputs:

[INFO] input name: images

[INFO] input type: f32

[INFO] input shape: Shape : [1, 3, 640, 640]

[INFO] outputs:

[INFO] output name: output0

[INFO] output type: f32

[INFO] output shape: Shape : [1, 56, 8400]

[INFO] Read image files: /home/ygj/Program/OpenVINOSharp/dataset/image/demo_9.jpgClassification result : 1: 1 0.94 (x:104 y:22 width:152 height:365) Nose: (188 ,60 ,0.93) Left Eye: (192 ,53 ,0.83) Right Eye: (180 ,54 ,0.90) Left Ear: (196 ,53 ,0.50) Right Ear: (167 ,56 ,0.76) Left Shoulder: (212 ,92 ,0.93) Right Shoulder: (151 ,93 ,0.94) Left Elbow: (230 ,146 ,0.90) Right Elbow: (138 ,142 ,0.93) Left Wrist: (244 ,199 ,0.89) Right Wrist: (118 ,187 ,0.92) Left Hip: (202 ,192 ,0.97) Right Hip: (168 ,193 ,0.97) Left Knee: (184 ,272 ,0.96) Right Knee: (184 ,276 ,0.97) Left Ankle: (174 ,357 ,0.87) Right Ankle: (197 ,354 ,0.88)

4. 编译运行 Yolov8-seg 模型

编译运行命令为:

dotnet run seg /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s-seg.xml /home/ygj/Program/OpenVINOSharp/dataset/image/demo_2.jpg GPU.0 /home/ygj/Program/OpenVINOSharp/dataset/lable/COCO_lable.txt

模型推理输出结果为:

---- OpenVINO INFO----

Description : OpenVINO Runtime

Build number: 2023.0.1-11005-fa1c41994f3-releases/2023/0

Set inference device GPU.0.

[INFO] Loading model files: /home/ygj/Program/OpenVINOSharp/model/yolov8/yolov8s-seg.xml

47

[INFO] model name: torch_jit

[INFO] inputs:

[INFO] input name: images

[INFO] input type: f32

[INFO] input shape: Shape : [1, 3, 640, 640]

[INFO] outputs:

[INFO] output name: output0

[INFO] output type: f32

[INFO] output shape: Shape : [1, 116, 8400]

[INFO] Read image files: /home/ygj/Program/OpenVINOSharp/dataset/image/demo_2.jpgSegmentation result : 1: 0 0.90 (x:745 y:42 width:403 height:671)

2: 0 0.86 (x:121 y:196 width:1009 height:516)

3: 27 0.69 (x:434 y:436 width:90 height:280)

六、模型运行时间

AIxBoard开发板板载了英特尔赛扬N5105 CPU以及英特尔11代集成显卡,此处对CPU、GPU的推理情况做了一个简单测试,主要检测了模型推理时间,并使用英特尔幻影峡谷进行了同步测试,测试结果如表所示.

| Device | CPU: N5105 | GPU: Intel 11th 集显 | CPU: i7-1165G7 | GPU: lntel® Iris® Xe Graphics |

|---|---|---|---|---|

| Yolov8-det | 586.3ms | 83.1ms | 127.1ms | 19.5ms |

| Yolov8-seg | 795.6ms | 112.5ms | 140.1ms | 25.0ms |

| Yolov8-pose | 609.8ms | 95.1ms | 117.2ms | 23.3ms |

| Yolov8-cls | 33.1ms | 9.2ms | 6.1ms | 2.7ms |

可以看出,英特尔赛扬N5105 CPU在模型推理性能是十分强大的,且搭配的英特尔11代集成显卡,将推理速度提升了6倍左右,针对Yolov8模型,平均处理速度可以达到10FPs。而相比于幻影峡谷的推理速度,AIxBoard开发板推理性能大约为其五分之一,这相比一般的开发板,AIxBoard开发板的算力还是十分强大的。

七、总结

在该项目中,我们基于Ubutn 20.04 系统,成功实现了在C#环境下调用OpenVINO™部署深度学习模型,验证了在Linux环境下OpenVINOSharp项目的的可行性,这对后面在Linux环境下开发OpenVINOSharp具有很重要的意义。

除此之外,我们还使用OpenVINOSharp检验了AIxBoard开发板的模型推理能力,最总针对Yolov8模型,平均处理速度可以达到10FPs,这对目前大多数开发板来说,已经达到了很高的推理速度。后续我还会将继续使用OpenVINOSharp在AIxBoard开发板部署更多的深度学习模型。

相关文章:

【OpenVINOSharp】在英特尔® 开发者套件爱克斯开发板使用OpenVinoSharp部署Yolov8模型

在英特尔 开发者套件爱克斯开发板使用OpenVinoSharp部署Yolov8模型 一、英特尔开发套件 AIxBoard 介绍1. 产品定位2. 产品参数3. AI推理单元 二、配置 .NET 环境1. 添加 Microsoft 包存储库2. 安装 SDK3. 测试安装4. 测试控制台项目 三、安装 OpenVINO Runtime1. 下载 OpenVINO…...

Django的模型层

Django的模型层1.Model的开发流程2.定义Model模型3.Model模型的实例4.Model模型的实战操作笔记开发流程1.在models.py中定义模型类,要求继承自models.Model2.生成迁移文件3.执行迁移5.定义属性1.字段类型2.字段选项3.关系模型实例1.类的属性2.创建对象3.实例的属性模…...

idea 新建servlet 访问提示404 WebServlet注解找不到包 报错

检查访问路径是否设置正确 如果设置为name “/testServlet”,则会404 WebServlet注解报错找不到包 检查是否引入了tomcat依赖包...

【EA-ISET协会】Elsevier|2区智慧农业类SCIEI, 进展顺,3个月左右录用~

一、期刊简介 2区智慧农业类SCI&EI 【期刊简介】IF: 3.0-4.0, JCR2区, 中科院4区; 【检索情况】SCI&EI双检,正刊; 【终审周期】走期刊部系统,3个月左右录用; 二、征稿范围 大数据和遥感技术在智慧农业中…...

Class类getName获取类名方法详细说明

1.说明 在java.lang.Class类中有一个获取类名的方法: public String getName() 其返回的是该对象表示的类或接口的名称。 返回由这个Class对象表示的实体的字符串名称, 这个实体可以是: class, interface, array class, primitive type, vo…...

凉而不冷 柔而不弱 三菱重工海尔舒适风科技助您整夜安眠

古人云:安寝乃人生乐事。可随着夏天的到来,昼长夜短,家里的老人、儿童、父母都存在不同的入睡苦恼。对于儿童来说,空调温度调的太低容易踢被子着凉,温度调的高又怕孩子满头大汗;父母自身也会因为半夜帮孩子…...

YOLOv5基础知识入门(7)— NMS(非极大值抑制)原理解析

前言:Hello大家好,我是小哥谈。NMS是指非极大值抑制(non maximum suppression),它是一种常用于物体检测任务的算法。在物体检测中,通常会有多个预测框(bounding box)被提议出来&…...

Gpt微信小程序搭建的前后端流程 - 后端基础框架的搭建(三)

Gpt微信小程序搭建的前后端流程 - 后端基础框架的搭建(三) Gpt微信小程序 只需要几个API,API上一小节也有讲到。直接用 gin 或者 beego 简单搭web服务器就够了。我们这里还用 go-micro微服务 去搭建,主要也是为了学以致用,把之前go-micro系列…...

jstat(JVM Statistics Monitoring Tool):虚拟机统计信息监视工具

jstat(JVM Statistics Monitoring Tool):虚拟机统计信息监视工具 用于监视虚拟机各种运行状态信息的命令行工具。 它可以显示本地或者远程虚拟机进程中的类加载、内存、垃圾收集、即时编译等运行时数据,在没有GUI图形界面、只提…...

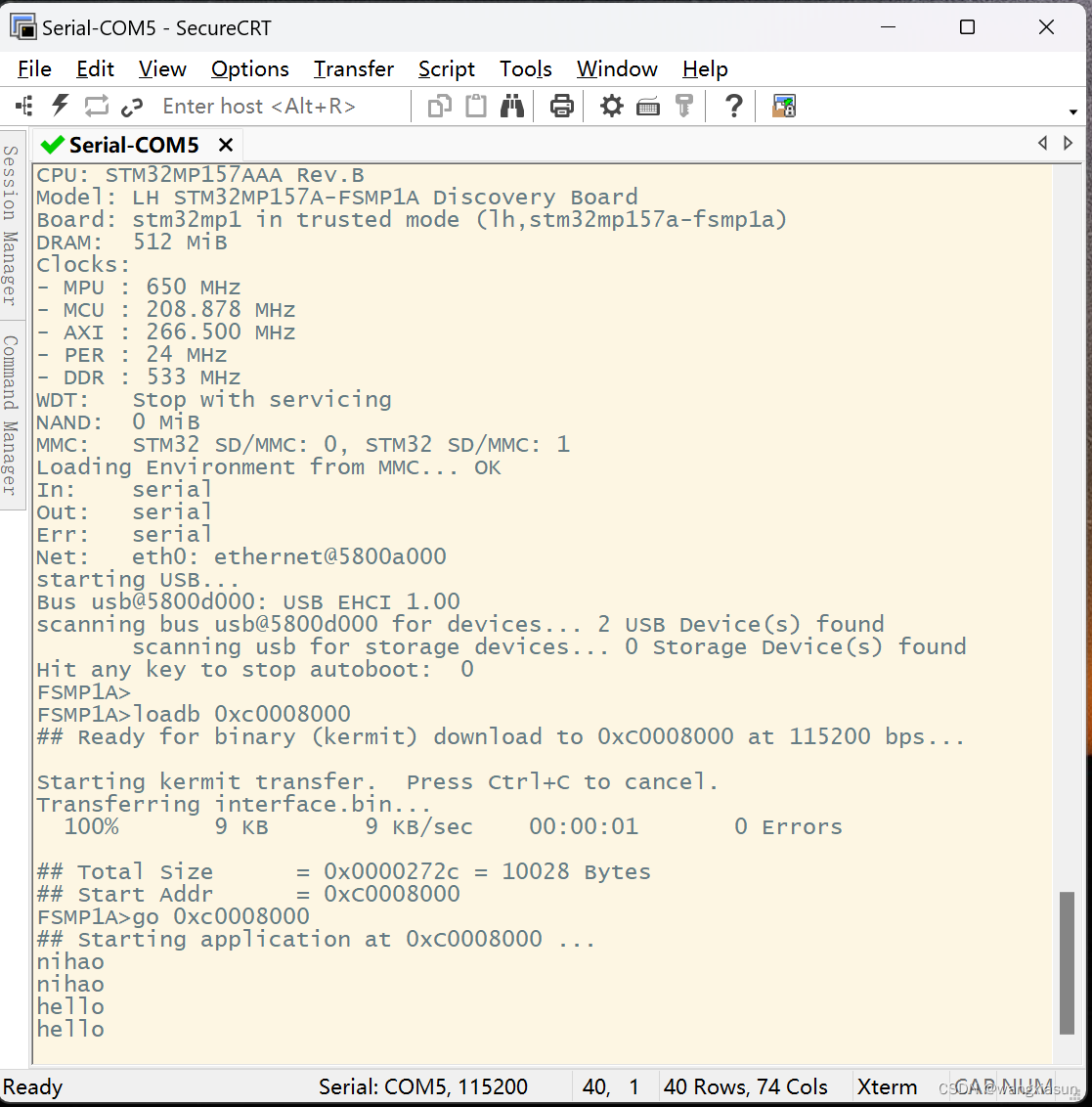

【ARM】Day6 cotex-A7核UART总线实验

cotex-A7核UART总线实验 1. 键盘输入一个字符‘a’,串口工具显示‘b’ 2. 键盘输入一个字符串"nihao",串口工具显示“nihao” uart.h #ifndef __UART4_H__ #define __UART4_H__#include "stm32mp1xx_rcc.h" #include "stm3…...

HTTPS代理搭建技巧分享

今天我们来分享一下如何搭建一个能够实现中间人 检测和防护的HTTPS代理。保护我们的网络通信安全是至关重要的,让我们一起学习如何构建一个安全可靠的HTTPS代理吧! 什么是中间人 ? 首先,让我们来了解一下什么是中间人 。中间人 是…...

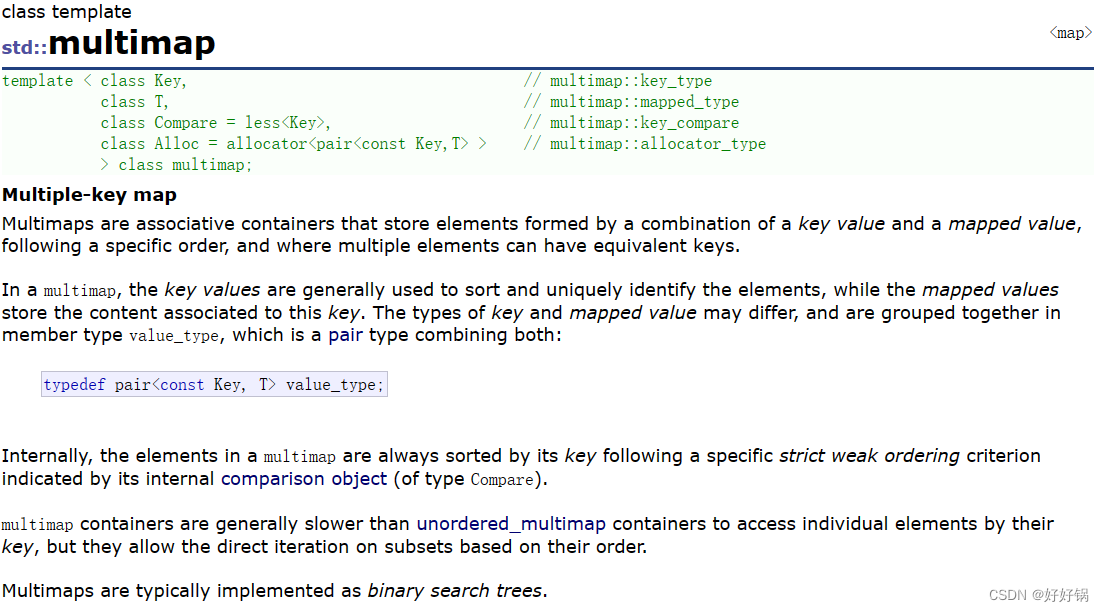

第四章:树形结构的关联式容器(map+set)

系列文章目录 文章目录 系列文章目录前言1、关联式容器与序列式容器1.1 键值对 2、set的介绍3、multiset的介绍3.1 接口count与容器multiset 4、map的介绍4.1 接口insert4.2 operator[]和at 5、multimap的介绍 前言 根据应用场景的不桶,STL总共实现了两种不同结构的…...

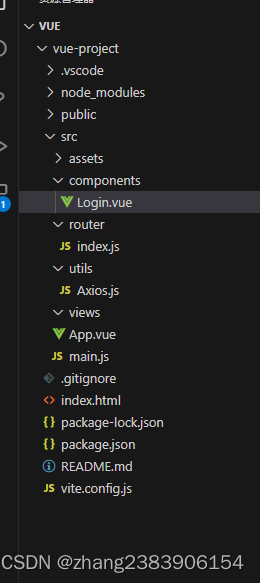

SpringBoot +Vue3 简单的前后端交互

前端:Vue3 创建项目: npm create vuelatest > cd <your-project-name> > npm install > npm run dev 项目结构图如下: 1、查看入口文件内容:main.js 代码如下: import ./assets/main.css impor…...

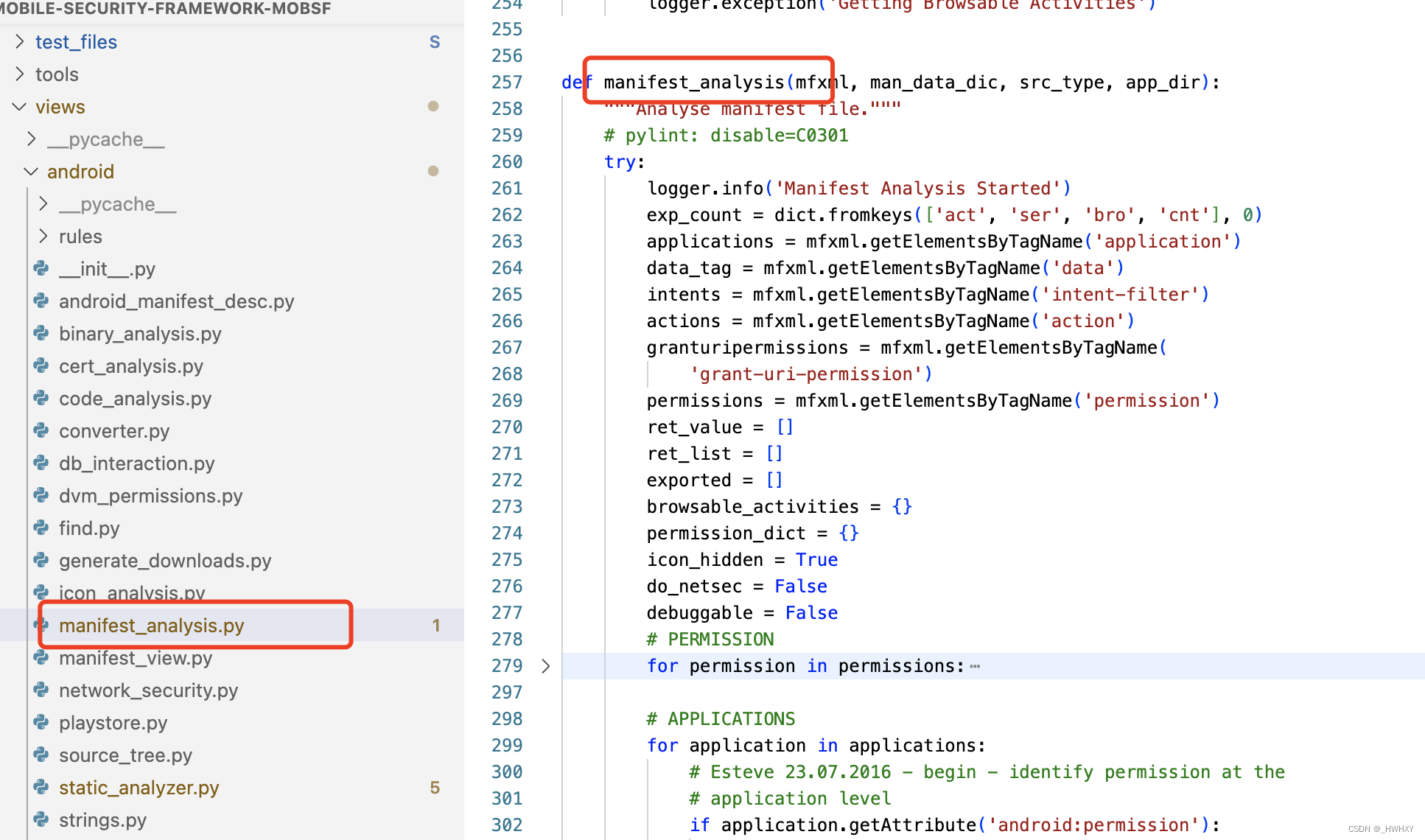

【Android】Mobile-Security-Framework-MobSF Manifest 静态扫描规则

前言 移动安全框架(MobSF)是一个自动化的一体化移动应用程序(Android/iOS/Windows)测试、恶意软件分析和安全评估框架,能够执行静态和动态分析。MobSF支持移动应用程序二进制文件(APK、XAPK、IPA和APPX&am…...

【C++】初谈迭代器

文章目录 前言一、什么是迭代器二、迭代器的分类三、迭代器的用法总结 前言 迭代器是一种可以访问和遍历容器中元素的对象,它类似于指针,但是具有更多的功能和灵活性。本文将介绍C迭代器的基本概念、分类、用法和注意事项。 一、什么是迭代器 迭代器&a…...

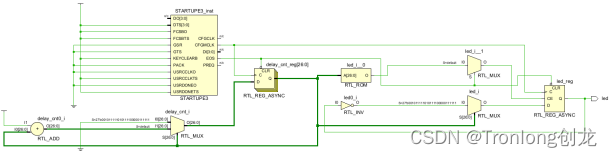

PL端案例开发手册

目 录 前 言 1 工程编译、程序加载方法 1.1 工程编译 1.2 程序加载 2 led-flash 2.1 案例说明 2.2 操作说明 2.3 关键代码 更多帮助 前 言 本文主要介绍PL端案例的使用说明,适用开发环境:Windows 7/10 64bit、Xilinx Unified 20…...

华为OD-整数对最小和

题目描述 给定两个整数数组array1、array2,数组元素按升序排列。假设从array1、array2中分别取出一个元素可构成一对元素,现在需要取出k对元素,并对取出的所有元素求和,计算和的最小值 代码实现 # coding:utf-8 class Solution:…...

Ubuntu 22LTS 配置静态IP

可行方法,需界面配置 转载自:哔哩哔哩链接地址 命令行配置:待补充...

【Python】Python爬虫:网络数据的提取利器

随着互联网的快速发展,网络数据已经成为了一项重要的资源。如何从海量的网络数据中提取出我们需要的信息,就成为了各个行业都需要解决的问题。而Python爬虫,就是解决这个问题的利器。 首先,让我们了解一下什么是Python爬虫。Pyth…...

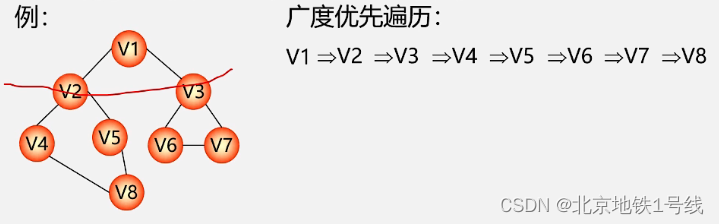

20.图的遍历

目录 一. 深度优先遍历 二. 广度优先遍历 图的遍历算法和二叉树不同的是,图中可能存在回路,且图的任一顶点都可能与其它顶点相通,在访问完某个顶点之后可能会沿着某些边又回到了曾经访问过的顶点。为了避免重复访问,我们的解决思…...

华为云AI开发平台ModelArts

华为云ModelArts:重塑AI开发流程的“智能引擎”与“创新加速器”! 在人工智能浪潮席卷全球的2025年,企业拥抱AI的意愿空前高涨,但技术门槛高、流程复杂、资源投入巨大的现实,却让许多创新构想止步于实验室。数据科学家…...

STM32标准库-DMA直接存储器存取

文章目录 一、DMA1.1简介1.2存储器映像1.3DMA框图1.4DMA基本结构1.5DMA请求1.6数据宽度与对齐1.7数据转运DMA1.8ADC扫描模式DMA 二、数据转运DMA2.1接线图2.2代码2.3相关API 一、DMA 1.1简介 DMA(Direct Memory Access)直接存储器存取 DMA可以提供外设…...

【快手拥抱开源】通过快手团队开源的 KwaiCoder-AutoThink-preview 解锁大语言模型的潜力

引言: 在人工智能快速发展的浪潮中,快手Kwaipilot团队推出的 KwaiCoder-AutoThink-preview 具有里程碑意义——这是首个公开的AutoThink大语言模型(LLM)。该模型代表着该领域的重大突破,通过独特方式融合思考与非思考…...

2025 后端自学UNIAPP【项目实战:旅游项目】6、我的收藏页面

代码框架视图 1、先添加一个获取收藏景点的列表请求 【在文件my_api.js文件中添加】 // 引入公共的请求封装 import http from ./my_http.js// 登录接口(适配服务端返回 Token) export const login async (code, avatar) > {const res await http…...

Matlab | matlab常用命令总结

常用命令 一、 基础操作与环境二、 矩阵与数组操作(核心)三、 绘图与可视化四、 编程与控制流五、 符号计算 (Symbolic Math Toolbox)六、 文件与数据 I/O七、 常用函数类别重要提示这是一份 MATLAB 常用命令和功能的总结,涵盖了基础操作、矩阵运算、绘图、编程和文件处理等…...

学校时钟系统,标准考场时钟系统,AI亮相2025高考,赛思时钟系统为教育公平筑起“精准防线”

2025年#高考 将在近日拉开帷幕,#AI 监考一度冲上热搜。当AI深度融入高考,#时间同步 不再是辅助功能,而是决定AI监考系统成败的“生命线”。 AI亮相2025高考,40种异常行为0.5秒精准识别 2025年高考即将拉开帷幕,江西、…...

基于 TAPD 进行项目管理

起因 自己写了个小工具,仓库用的Github。之前在用markdown进行需求管理,现在随着功能的增加,感觉有点难以管理了,所以用TAPD这个工具进行需求、Bug管理。 操作流程 注册 TAPD,需要提供一个企业名新建一个项目&#…...

【从零学习JVM|第三篇】类的生命周期(高频面试题)

前言: 在Java编程中,类的生命周期是指类从被加载到内存中开始,到被卸载出内存为止的整个过程。了解类的生命周期对于理解Java程序的运行机制以及性能优化非常重要。本文会深入探寻类的生命周期,让读者对此有深刻印象。 目录 …...

push [特殊字符] present

push 🆚 present 前言present和dismiss特点代码演示 push和pop特点代码演示 前言 在 iOS 开发中,push 和 present 是两种不同的视图控制器切换方式,它们有着显著的区别。 present和dismiss 特点 在当前控制器上方新建视图层级需要手动调用…...

Python+ZeroMQ实战:智能车辆状态监控与模拟模式自动切换

目录 关键点 技术实现1 技术实现2 摘要: 本文将介绍如何利用Python和ZeroMQ消息队列构建一个智能车辆状态监控系统。系统能够根据时间策略自动切换驾驶模式(自动驾驶、人工驾驶、远程驾驶、主动安全),并通过实时消息推送更新车…...