ICASSP 2023论文模型开源|语音分离Mossformer

人类能在复杂的多人说话环境中轻易地分离干扰声音,选择性聆听感兴趣的主讲人说话。但这对机器却不容易,如何构建一个能够媲美人类听觉系统的自动化系统颇具挑战性。

本文将详细解读ICASSP2023本届会议收录的单通道语音分离模型Mossformer论文,以及如何基于开发者自有数据进行该模型的调优训练。

▏语音分离模型能做什么?

由于麦克风采集的音频信号中除了主说话人之外,通常还包括噪声、其他人说话的声音、混响等干扰。语音分离的目标即是把独立的目标语音信号从混合的音频信号中分离出来。其应用范围不仅包括听力假体、移动通信、鲁棒的自动语音以及说话人识别等,最近也被广泛应用在各个语音方向的机器学习场景中。

根据干扰的不同,语音分离任务可以是单纯的多说话人分离,也可以包括噪声消除和解混响等附加任务。在没有噪声和混响的情况下,单纯的语音分离任务已经被研究了几十年,从最初的传统信号处理算法如独立分量分析(ICA)和非负矩阵分解(NMF),到最近的基于端到端深度神经网络(DNN)算法,算法的分离性能有了明显的进步。至今,语音分离仍然是一个高度活跃的研究领域,我们最新推出的MossFormer语音分离模型,是在现有深度学习算法的基础上,通过融入更先进的门控注意力机制和带记忆的深度卷积网络,从而更有效地对长语音序列进行建模和学习,大幅提升深度学习分离算法的性能。

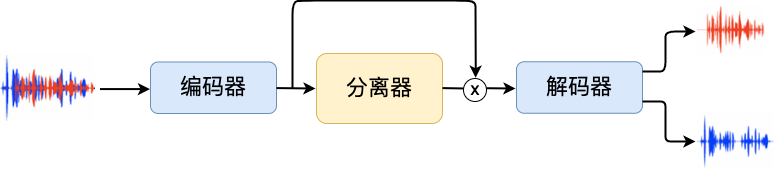

目前比较流行的语音分离模型架构一般由三个主要组成模块:编码器、分离器和解码器。编码器的作用是将原始的语音信号转换为高维的表示,类似于傅立叶变换后的频谱信息,但使用的转换不是预先设定好的,而是通过训练模型自己学习到的。分离器的作用是根据输入的高维表示来估计语音的分量,并将其分离成多个独立的语音信号。解码器的作用是将分离出的语音信号重新编码成原始语音信号的形式。下图给出的是语音分离模型架构的示意图:

图1. 语音分离模型架构示意图

分离器模块是影响语音分离性能的关键模块,主要的架构包括深度卷积网络(例如:Conv-TasNet)、循环神经网络(例如:DPRNN),和Transformer(例如:SepFormer)等,其中基于自注意力机制的Transformer架构在最近的研究中表现出了很好的性能。利用自注意力机制可以有效地捕捉长距离的依赖关系,从而更好地建模语音信号。

与传统的循环神经网络相比,Transformer可以并行计算,提高了计算效率,同时也可以更好地避免梯度消失的问题。基于Transformer的架构在单声道语音分离任务中获得了显著的性能改进,但和最近给出的分离Cramer-Rao上限相比,仍存在明显差距,主要原因在于,由于注意力计算的二次复杂度,Transformer架构的自注意力受限于上下文长度。为了能够处理极长的输入序列,当前的Transformer模型使用双路径框架,将输入序列分成较小的块并分别处理块内和块间的信息,跨块的长距离信息依赖需要通过中间状态隐式建模,这一事实可能对长距离建模能力产生负面影响,导致模型次优表现。

▏2023 ICASSP-MossFormer模型

为了有效解决双路径架构中跨块间的间接元素交互问题,我们提出了一种基于联合自注意力的带门控单头Transformer语音分离模型架构,并使用卷积增强模块,命名为MossFormer(Monaural speech separation Transformer)。

MossFormer采用联合局部和全局自注意力架构,同时对局部段执行完整自注意力运算和对全局执行线性化低成本自注意力运算。联合注意力使MossFormer模型能够直接处理全序列元素交互,真正有效地捕捉长距离的依赖关系,解决双路径模型在远程元素交互的建模能力问题。此外,我们采用了强大的带注意力门控机制,可以使用大幅简化的单头自注意力,MossFormer除了关注长距离建模外,还使用深度卷积来帮助模型更好地处理局部的特征,从而提高模型的性能。相关工作已被语音顶会ICASSP 2023录用。

模型架构

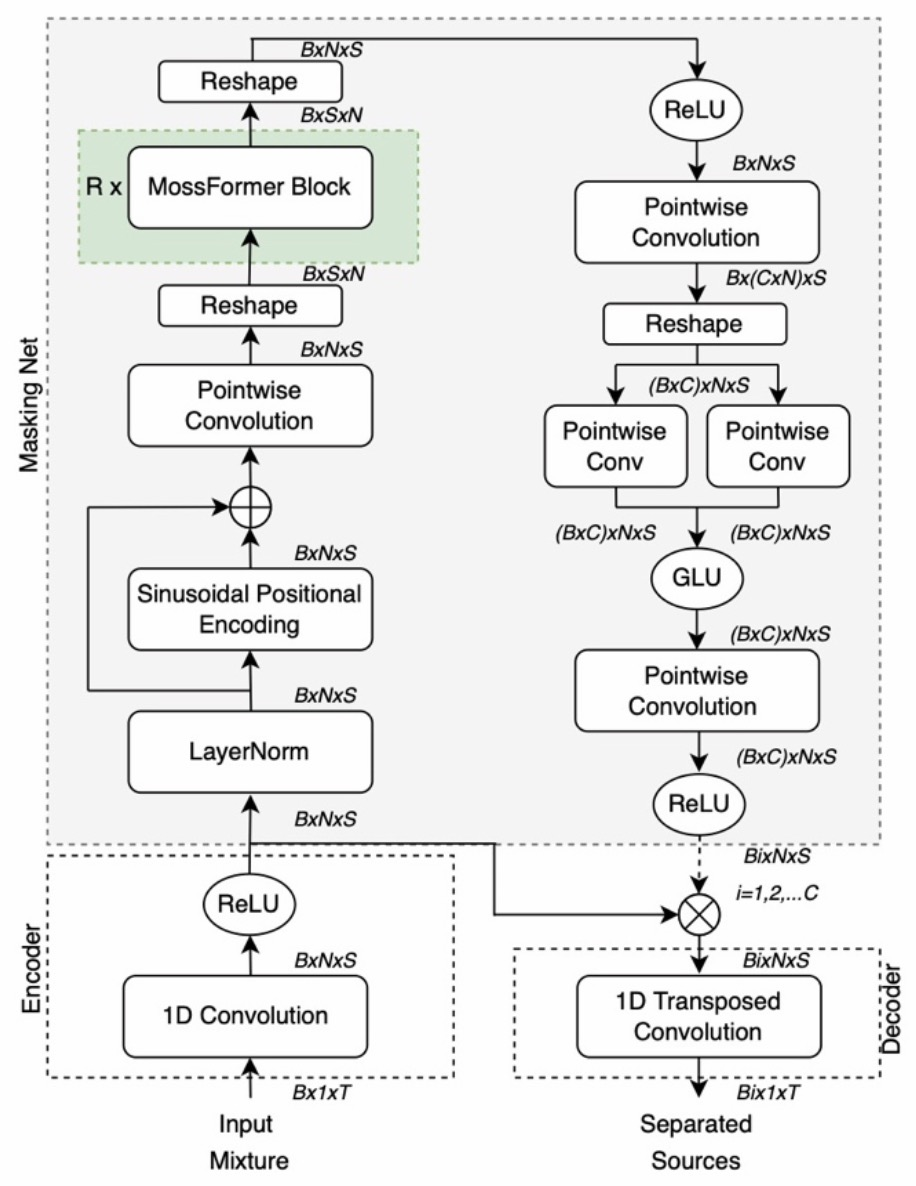

MossFormer语音分离模型由一个卷积编码器-解码器结构和一个掩蔽网络组成(见图2)。编码器-解码器结构负责特征提取和波形重建,其中,编码器负责特征提取,由一维 (1D) 卷积层 (Conv1D) 和整流线性单元 (ReLU) 组成,后者将编码输出限制为非负值。解码器是一维转置卷积层,它使用与编码器相同的内核大小和步幅。

图2. MossFormer模型整体结构示意图

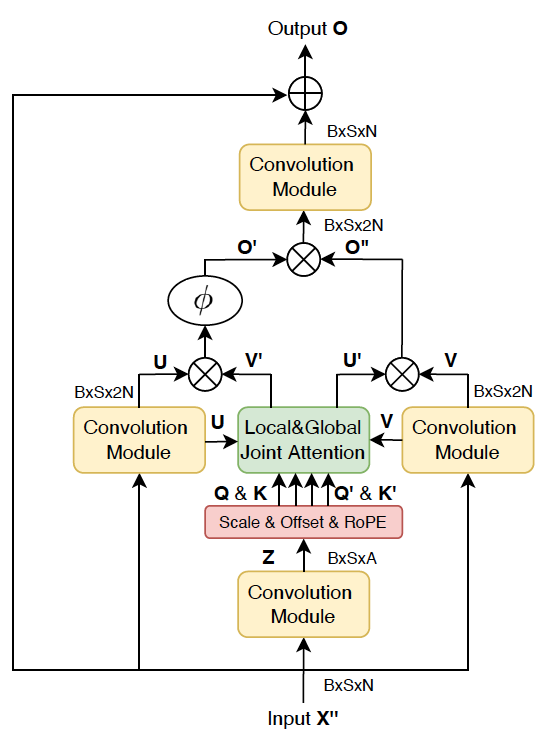

掩码网络执行从编码器输出到𝐶组掩码的非线性映射,掩码网络的主组成部分是MossFormer模块,该模块是基于带卷积增强联合自注意力(convolution-augmented joint self-attentions)的门控单头自注意力架构(gated single-head transformer architecture )开发出来的。具体的,一个MossFormer 模块由四个卷积模块、缩放和偏移操作、联合局部和全局单头自注意力(SHSA)以及三个门控操作组成,负责进行长序列的处理。详细模块结构见图3。在MossFormer模块中,序列由卷积模块和注意力门控机制进行处理。卷积模块使用线性投影和深度卷积来处理序列。注意力门控机制执行联合局部和全局自注意力和门控操作。MossFormer模块仅学习残差部分并应用跳跃连接从输入连接到输出以提升训练效率。当前MossFormer块的输出被输入到下一个MossFormer块中。该过程被重复R次。

图3. MossFormer模块架构示意图

模型性能

我们在公开数据集WSJ0-2/3mix 和 WHAM!/WHAMR!上对模型进行了性能对比验证。WSJ0-2/3mix数据集是基于WSJ0数据语料库生成的。包括30小时的训练数据集、10小时的验证数据集、和5小时的测试集,混合语音是由随机选择的不同说话者的语音混合而成,混合语音按照-5 dB和5 dB随机信噪比(SNR)进行混合。该数据集包含2个和3个说话人,为纯净数据集,不含噪声和混响。

WHAM!数据集是在WSJ0-2mix数据集的基础上,通过进一步添加独特的环境噪声生成的,环境噪声主要包括从餐厅、咖啡馆、酒吧和公园录制的噪声。WHAMR! 数据集进一步扩展了WHAM!数据集,除了环境噪声之外,还为语音信号添加了人工混响效果。

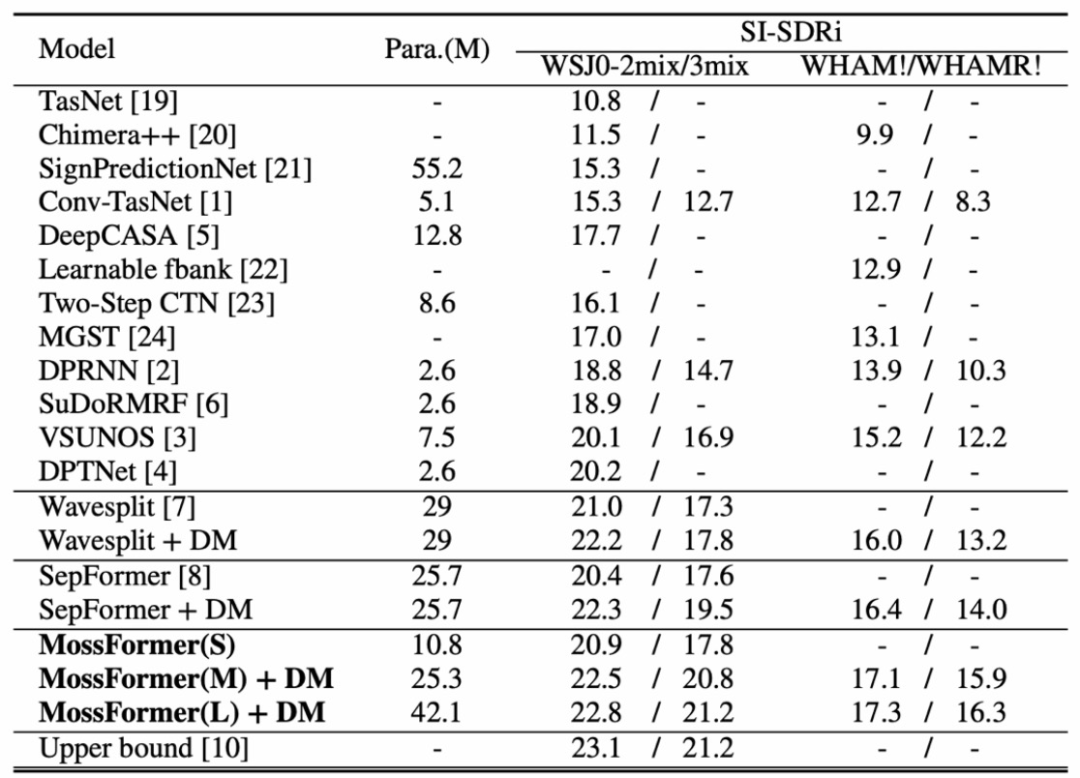

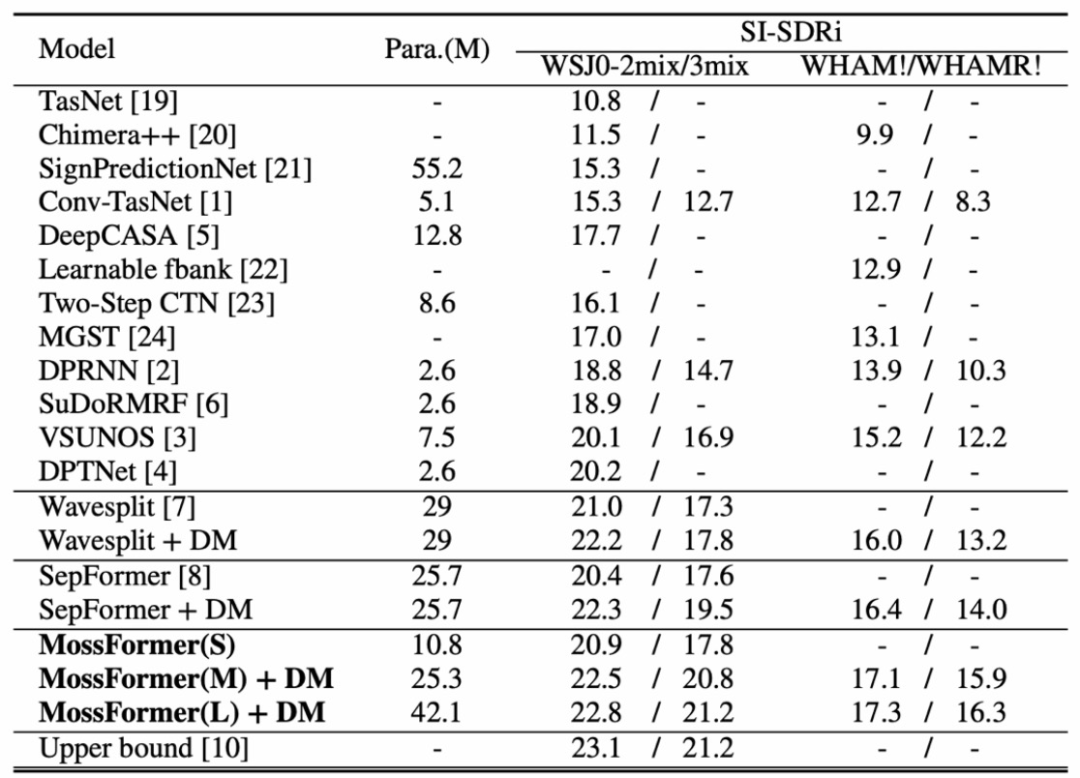

MossFormer模型与其它SOTA模型在公开数据集WSJ0-2mix/3mix和WHAM!/WHAMR!上的对比结果如下表 (模型算法引用标注沿用发表的论文引用顺序):

SI-SNR (Scale Invariant Signal-to-Noise Ratio) 尺度不变信噪比,是在普通信噪比基础上通过正则化消减信号变化导致的影响,是针对宽带噪声失真的语音增强算法的常规衡量方法。SI-SNRi (SI-SNR improvement) 是衡量对比原始混合语音,SI-SNR在分离后语音上的提升量。

DM (Dynamic Mixing)是一种动态混合数据增强算法,用来补充训练数据的不足和提升模型训练的泛化能力。

结果对比

我们分别给出了小模型MossFormer(S)、中等模型MossFormer(M)、和大模型MossFormer(L)的结果。在WSJ0-2/3mix数据集上,除了具有10M参数的MossFormer(S)在WSJ0-2mix上表现稍差于具有29M参数的Wavesplit以外,我们的MossFormer模型结果优于之前所有模型的表现。使用数据增强后,MossFormer(L)在WSJ0-2mix/3mix上分别达到了22.8 dB和21.2 dB。不仅达到了Cramer-Rao分离上限,而且在WSJ0-2mix/3mix上取得了最新的SOTA结果。

在带噪和混响WHAM!到WHAMR!数据集上,MossFormer(M)和MossFormer(L)比以前的模型表现出更大的优势,MossFormer(L)分别在WHAM!和WHAMR!上取得了最新的SOTA结果。例如,MossFormer(L)相比于SepFormer,分别提升了0.9 dB和2.3 dB。由于WHAM!/WHAMR!数据集是在WSJ0-2mix的基础上引入额外的噪声和混响来构建的,因此,在WHAM!/WHAMR!上的分离任务变得更加困难,因为模型不仅需要处理语音分离,还需要进行降噪和去混响处理。我们观察到,混响对Wavesplit和SepFormer的影响比对MossFormer的影响更大,显示MossFormer得益于独特的联合自注意力架构和深度卷积处理,可以更好的学习局部特征模式和全局长距离依赖性,从而获得更佳的分离性能。

理论上,MossFormer模型框架可以支持任意多说话人和任意环境下的语音分离任务,我们在ModelScope上首先开放的是基于两个说话人的纯语音分离模型,其目的是让用户可以在较简单的分离任务上,更快速的搭建和测试我们的模型平台。

▏如何训练自有的语音分离模型?

第一步:训练您的模型

环境准备

ModelScope网站官方提供的Notebook环境已经安装好了所有依赖,能够直接开始训练。如果您要在自己的设备上训练,可以参考模型主页上的环境准备步骤操作。环境准备完成后建议运行模型主页上推理示例代码验证模型可以正常工作。

数据准备

魔搭社区上开放的模型使用约30小时2人混合语音作为训练数据。混合语音是基于WSJ0数据集生成的,由于WSJ0的License问题无法在这里分享。我们在ModelScope上提供了基于LibriSpeech数据集生成的混合音频,以便您快速开始训练。其中训练集包含约42小时语音,共13900条,大小约7G。请访问官网页面了解数据集详情,链接在文章末尾。

模型训练

以下列出的为训练示例代码,其中work_dir可以替换成您需要的路径。

数据训练一遍为一个epoch,默认共训练120个epoch,需要约10天。

import osfrom datasets import load_datasetfrom modelscope.metainfo import Trainersfrom modelscope.msdatasets import MsDatasetfrom modelscope.preprocessors.audio import AudioBrainPreprocessorfrom modelscope.trainers import build_trainerfrom modelscope.utils.audio.audio_utils import to_segmentwork_dir = './train_dir'if not os.path.exists(work_dir):os.makedirs(work_dir)train_dataset = MsDataset.load('Libri2Mix_8k', split='train').to_torch_dataset(preprocessors=[AudioBrainPreprocessor(takes='mix_wav:FILE', provides='mix_sig'),AudioBrainPreprocessor(takes='s1_wav:FILE', provides='s1_sig'),AudioBrainPreprocessor(takes='s2_wav:FILE', provides='s2_sig')],to_tensor=False)eval_dataset = MsDataset.load('Libri2Mix_8k', split='validation').to_torch_dataset(preprocessors=[AudioBrainPreprocessor(takes='mix_wav:FILE', provides='mix_sig'),AudioBrainPreprocessor(takes='s1_wav:FILE', provides='s1_sig'),AudioBrainPreprocessor(takes='s2_wav:FILE', provides='s2_sig')],to_tensor=False)kwargs = dict(model='damo/speech_mossformer_separation_temporal_8k',train_dataset=train_dataset,eval_dataset=eval_dataset,work_dir=work_dir)trainer = build_trainer(Trainers.speech_separation, default_args=kwargs)trainer.train()

第二步:评估你的模型

以下列出的为模型评估代码,其中work_dir必须是您训练时指定的路径。程序会搜索路径下的最佳模型并自动加载。

import osfrom datasets import load_datasetfrom modelscope.metainfo import Trainersfrom modelscope.msdatasets import MsDatasetfrom modelscope.preprocessors.audio import AudioBrainPreprocessorfrom modelscope.trainers import build_trainerfrom modelscope.utils.audio.audio_utils import to_segmentwork_dir = './train_dir'if not os.path.exists(work_dir):os.makedirs(work_dir)train_dataset = Noneeval_dataset = MsDataset.load('Libri2Mix_8k', split='test').to_torch_dataset(preprocessors=[AudioBrainPreprocessor(takes='mix_wav:FILE', provides='mix_sig'),AudioBrainPreprocessor(takes='s1_wav:FILE', provides='s1_sig'),AudioBrainPreprocessor(takes='s2_wav:FILE', provides='s2_sig')],to_tensor=False)kwargs = dict(model='damo/speech_mossformer_separation_temporal_8k',train_dataset=train_dataset,eval_dataset=eval_dataset,work_dir=work_dir)trainer = build_trainer(Trainers.speech_separation, default_args=kwargs)trainer.model.load_check_point(device=trainer.device)print(trainer.evaluate(None))

相关链接

语音分离模型地址:https://modelscope.cn/models/damo/speech_mossformer_separation_temporal_8k/summary

LibriSpeech 2人混合8K音频数据集:

https://modelscope.cn/datasets/modelscope/Libri2Mix_8k/summary

WSJ0数据集:

https://catalog.ldc.upenn.edu/LDC93s6a

WSJ0-mix脚本:

https://github.com/mpariente/pywsj0-mix

References

Shengkui Zhao and Bin Ma, “MossFormer: Pushing the Performance Limit of Monaural Speech Separation using Gated Single-head Transformer with Convolution-augmented Joint Self-Attentions”, accepted by ICASSP 2023.

相关文章:

ICASSP 2023论文模型开源|语音分离Mossformer

人类能在复杂的多人说话环境中轻易地分离干扰声音,选择性聆听感兴趣的主讲人说话。但这对机器却不容易,如何构建一个能够媲美人类听觉系统的自动化系统颇具挑战性。 本文将详细解读ICASSP2023本届会议收录的单通道语音分离模型Mossformer论文࿰…...

vs2019 更改工程项目名称

本地 解决方案所在的位置为:D:\Projcet 解决方案名称:hello.sln 位置:D:\Projcet\hello.sln 工程项目名称:test 位置:D:\Projcet\test (文件夹中包含头文件,源文件) 工程包含的文件: fun.h …...

FusionCompute安装和配置步骤

1. 先去华为官网下载FusionCompute的镜像 下载地址:https://support.huawei.com/enterprise/zh/distributed-storage/fusioncompute-pid-8576912/software/251713663?idAbsPathfixnode01%7C22658044%7C7919788%7C9856606%7C21462752%7C8576912 下载后放在D盘中&am…...

makefile 参数和基本使用

make 常用选项make[-f file] [options] [target]make 默认在当前目录中查找GUNmakefile、makefile 及 Makefile 文件作为make的输入文件-f 指定文件作为输入文件-v 显示版本号-n 只输出命令不执行, 一般作为测试-s 执行命令不显示命令,-w 显示执行前和执…...

golang 占位符还傻傻分不清?

xdm ,写 C/C 语言的时候有格式控制符,例如 %s , %d , %c , %p 等等 在写 golang 的时候,也是有对应的格式控制符,也叫做占位符,写这个占位符,需要有对应的数据与之对应,不能瞎搞 基本常见常用…...

manacher算法详解

例题 求一个字符串的最长回文子串的长度 O(N2)O(N^2)O(N2)的解法很容易想,就是从每个字符位置向左右同时拓展,然后检查当前是不是回文,更新长度,可以简单写一下代码 int solve(string &ss){int ans 0;int n ss.length();s…...

要做一个关于DDD的内部技术分享,记录下用到的资源,学习笔记(未完)

最后更新于2023年3月10日 14:28:08 问题建模》软件分层》具体结构,是层层递进的关系。有了问题建模,才能进行具体的软件分层的讨论,再有了分层,才能讨论在domain里面应该怎么实现具体结构。 1、问题建模:Domain、Mod…...

KDZD互感器二次负载测试仪

一、概述 电能计量综合误差过大是电能计量中普遍存在的一个关键问题。电压互感器二次回路压降引起的计量误差往往是影响电能计量综合误差的因素。所谓电压互感器二次压降引起的误差,就是指电压互感器二次端子和负载端子之间电压的幅值差相对于二次实际电压的百分数…...

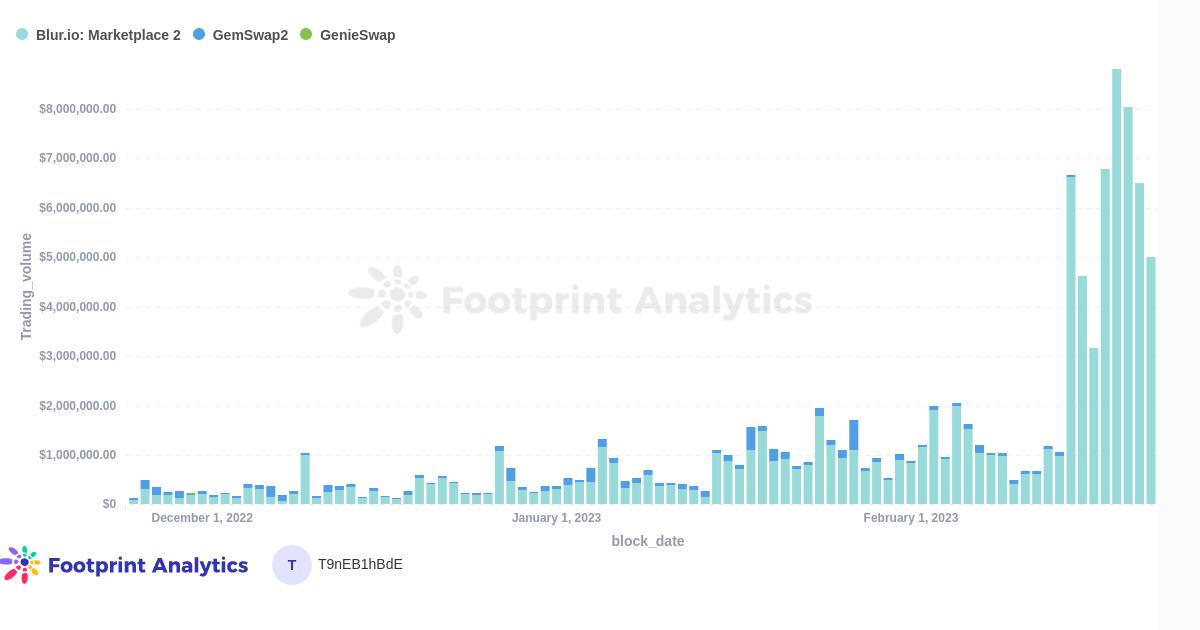

在空投之后,Blur能否颠覆OpenSea的主导地位?

Mar. 2023, Daniel数据源: NFT Aggregators Overview & Aggregator Statistics Overview & Blur Airdrop一年前,通过聚合器进行的NFT交易量开始像滚雪球一样增长,有时甚至超过了直接通过市场平台的交易量。虽然聚合器的使用量从10月到…...

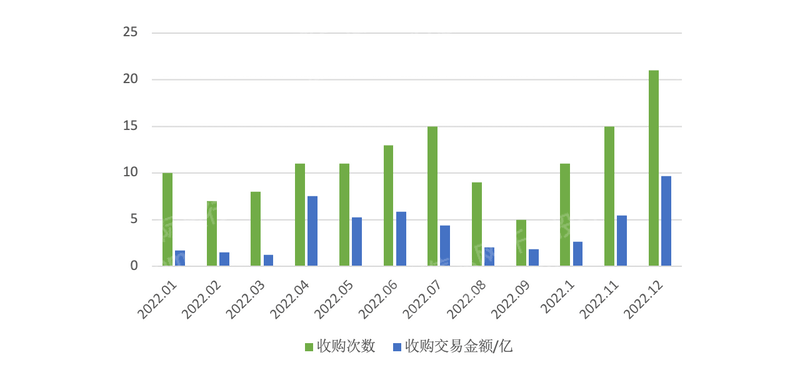

2023年新三板产品及服务研究报告

第一章 概述 全国中小企业股份转让系统(英语:National Equities Exchange and Quotations,缩写NEEQ),简称股转系统,是第三家全国性证券交易场所,因挂牌企业均为高科技企业而不同于原转让系统内…...

张力控制之开环模式

张力控制的相关知识也可以参看专栏的其它文章,链接如下: 张力闭环控制之传感器篇(精密调节气阀应用)_RXXW_Dor的博客-CSDN博客跳舞轮对应张力调节范围,我们可以通过改变气缸的气压方式间接改变,张力跳舞轮在收放卷闭环控制上的详细应用,可以参看下面的文章链接,这里我…...

python的django框架从入门到熟练【保姆式教学】第二篇

在上一篇博客中,我们介绍了Django的基础知识,并创建了一个简单的Web应用程序。在本篇教程中,我们将深入探讨Django的模型层(Model),它是Django应用程序的核心组件之一。 模型层 Django的模型层是一个对象…...

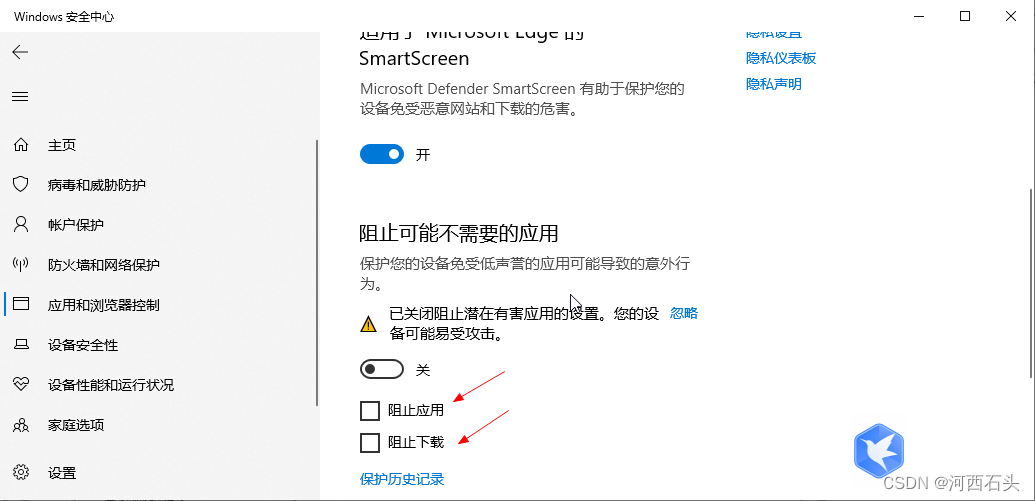

解决win10的过度保护导致文件下载不了程序不能打开运行

win7看来大概是要离我们远去了,虽然我们还能看见她的背影,但大势所趋,我们也只能慢慢的接受win10进入到我们的日常生活。但win10很多时候过度的保护却给我们带来了不便。这里列举两个最常见的问题,当然我这里也给出了解决方案。 文…...

扬帆优配|业务量大突破,这个行业发展明显向好

近期上市的新股,大都在招股阐明书里公布了本年第一季度成绩预告。 我国快递事务量本年已达200亿件 国家邮政局监测数据显现,到3月8日,本年我国快递事务量已到达200.9亿件,比2019年到达200亿件提前了72天,比2022年提前…...

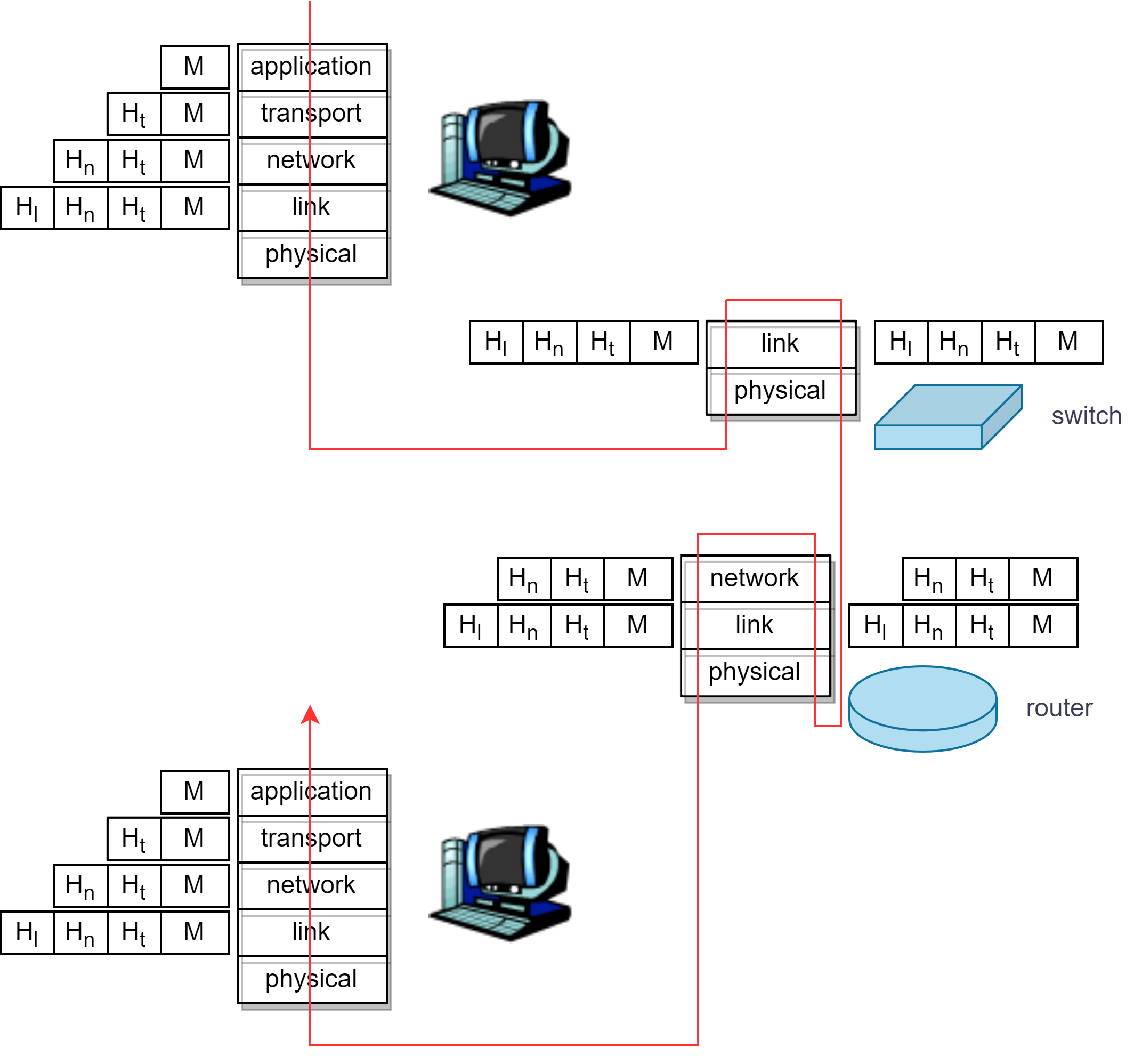

DJ1-4 计算机网络和因特网

目录 一、协议层及其服务模型 ISO/OSI 七层参考模型 TCP/IP 参考模型 1. 网际协议栈(protocol stack) 2. 分层:逻辑通信 3. 协议分层与数据 二、攻击威胁下的网络 1. 植入恶意软件 2. 攻击服务器和网络基础设施 3. 嗅探分组 4. 伪…...

Nginx根据$host及请求的URI规则重定向rewrite

项目背景: 将域名请求从默认的80端口转发到443 ssl。本项目特殊之处是一个端口监听多个域名,某些域名还有跳转到特定的地址。 普通情况: server { listen 80; #默认的80端口,非…...

人工智能实验一:使用搜索算法实现罗马尼亚问题的求解

1.任务描述 本关任务: 了解有信息搜索策略的算法思想;能够运用计算机语言实现搜索算法;应用A*搜索算法解决罗马尼亚问题; 2.相关知识 A*搜索 算法介绍 A*算法常用于 二维地图路径规划,算法所采用的启发式搜索可以…...

Spring Security基础入门

基础概念 什么是认证 认证:用户认证就是判断一个用户的身份身份合法的过程,用户去访问系统资源的时候系统要求验证用户的身份信息,身份合法方可继续访问,不合法则拒绝访问。常见的用户身份认证方式有:用户密码登录&am…...

dnsresolver-limit

文件OperationLimiter.h功能DnsResolver是andnroid中提供DNS能力的小型DNS解析器,limit是其中的一个小模块,支持全局、基于key(UID)的DNS请求限制。DnsResolver是多线程模型,单个DNS请求最多启动3个线程(传统DNS)。在网…...

使用 YoctoProject集成Qt6

By Toradex胡珊逢在嵌入式领域中Qt 作为普遍选择的 UI 方案目前已经发布 Qt6 版本。本文将介绍如何为 Toradex 的计算机模块使用 Yocto Project 将 Qt6 集成到镜像里。首先根据这里的说明,准备好Yocto Project 的编译环境。这里我们选择 Toradex 最新的 Linux BSP V…...

渲染学进阶内容——模型

最近在写模组的时候发现渲染器里面离不开模型的定义,在渲染的第二篇文章中简单的讲解了一下关于模型部分的内容,其实不管是方块还是方块实体,都离不开模型的内容 🧱 一、CubeListBuilder 功能解析 CubeListBuilder 是 Minecraft Java 版模型系统的核心构建器,用于动态创…...

ServerTrust 并非唯一

NSURLAuthenticationMethodServerTrust 只是 authenticationMethod 的冰山一角 要理解 NSURLAuthenticationMethodServerTrust, 首先要明白它只是 authenticationMethod 的选项之一, 并非唯一 1 先厘清概念 点说明authenticationMethodURLAuthenticationChallenge.protectionS…...

sqlserver 根据指定字符 解析拼接字符串

DECLARE LotNo NVARCHAR(50)A,B,C DECLARE xml XML ( SELECT <x> REPLACE(LotNo, ,, </x><x>) </x> ) DECLARE ErrorCode NVARCHAR(50) -- 提取 XML 中的值 SELECT value x.value(., VARCHAR(MAX))…...

MySQL 8.0 OCP 英文题库解析(十三)

Oracle 为庆祝 MySQL 30 周年,截止到 2025.07.31 之前。所有人均可以免费考取原价245美元的MySQL OCP 认证。 从今天开始,将英文题库免费公布出来,并进行解析,帮助大家在一个月之内轻松通过OCP认证。 本期公布试题111~120 试题1…...

代理篇12|深入理解 Vite中的Proxy接口代理配置

在前端开发中,常常会遇到 跨域请求接口 的情况。为了解决这个问题,Vite 和 Webpack 都提供了 proxy 代理功能,用于将本地开发请求转发到后端服务器。 什么是代理(proxy)? 代理是在开发过程中,前端项目通过开发服务器,将指定的请求“转发”到真实的后端服务器,从而绕…...

python报错No module named ‘tensorflow.keras‘

是由于不同版本的tensorflow下的keras所在的路径不同,结合所安装的tensorflow的目录结构修改from语句即可。 原语句: from tensorflow.keras.layers import Conv1D, MaxPooling1D, LSTM, Dense 修改后: from tensorflow.python.keras.lay…...

面向无人机海岸带生态系统监测的语义分割基准数据集

描述:海岸带生态系统的监测是维护生态平衡和可持续发展的重要任务。语义分割技术在遥感影像中的应用为海岸带生态系统的精准监测提供了有效手段。然而,目前该领域仍面临一个挑战,即缺乏公开的专门面向海岸带生态系统的语义分割基准数据集。受…...

解读《网络安全法》最新修订,把握网络安全新趋势

《网络安全法》自2017年施行以来,在维护网络空间安全方面发挥了重要作用。但随着网络环境的日益复杂,网络攻击、数据泄露等事件频发,现行法律已难以完全适应新的风险挑战。 2025年3月28日,国家网信办会同相关部门起草了《网络安全…...

WebRTC从入门到实践 - 零基础教程

WebRTC从入门到实践 - 零基础教程 目录 WebRTC简介 基础概念 工作原理 开发环境搭建 基础实践 三个实战案例 常见问题解答 1. WebRTC简介 1.1 什么是WebRTC? WebRTC(Web Real-Time Communication)是一个支持网页浏览器进行实时语音…...

AI语音助手的Python实现

引言 语音助手(如小爱同学、Siri)通过语音识别、自然语言处理(NLP)和语音合成技术,为用户提供直观、高效的交互体验。随着人工智能的普及,Python开发者可以利用开源库和AI模型,快速构建自定义语音助手。本文由浅入深,详细介绍如何使用Python开发AI语音助手,涵盖基础功…...