论文翻译:Large Language Models for Education: A Survey and Outlook

https://arxiv.org/abs/2403.18105

目录

- 教育领域的大型语言模型:一项调查和展望

- 摘要

- 1. 引言

- 2. 教育应用中的LLM

- 2.1 概述

- 2.2 学习辅助

- 2.2.1 问题解决(QS)

- 2.2.2 错误纠正(EC)

- 2.2.3 困惑助手(CH)

- 2.3 教学辅助

- 2.3.1 问题生成(QG)

- 2.3.2 自动评分(AG)

- 2.3.3 教学材料创作(MC)

- 2.4 适应性学习

- 2.4.1 知识追踪(KT)

- 2.4.2 内容个性化(CP)

- 2.5 教育工具包

- 2.5.1 聊天机器人

- 2.5.2 内容创作

- 2.5.3 教学辅助

- 2.5.4 测验生成器

- 2.5.5 协作工具

- 3. 数据集和基准测试

- 4. 风险和潜在挑战

- 4.1 公平性和包容性

- 4.2 可靠性与安全性

- 4.3 透明度与可问责性

- 4.4 隐私与安全

- 4.5 对LLMs的过度依赖

- 5. 未来方向

- 5.1 与教育学兴趣一致的LLMs

- 5.2 LLM-多代理教育系统

- 5.3 多模态和多语言支持

- 5.4 边缘计算与效率

- 5.5 专业模型的高效训练

- 5.6 伦理和隐私考虑

- 6. 结论

教育领域的大型语言模型:一项调查和展望

摘要

大型语言模型(LLMs)的出现为教育领域带来了新的可能性时代。这篇综述论文从多方面的角度总结了LLMs在教育环境中的各类技术,包括学生和教师的辅助、自适应学习和商业工具。我们系统性地回顾了每个角度的技术进步,整理了相关的数据集和基准测试,并识别了在教育中部署LLMs所面临的风险和挑战。此外,我们概述了未来的研究方向,突出了潜在的有希望的方向。我们的调查旨在为教育工作者、研究人员和政策制定者提供一个全面技术图景,利用LLMs的力量来彻底改变教育实践,并促进更有效的个性化学习环境的形成。

1. 引言

在过去的几十年里,教育领域的人工智能(AI)已经引起了极大的兴趣,并已经被应用于各种教育场景(Chen等人,2020年;Maghsudo等人,2021年;Chiu等人,2023年;Denny等人,2024年;Li等人,2024d;Latif等人,2023年)。具体来说,教育数据挖掘方法已经在诸如认知诊断、知识追踪、内容推荐以及学习分析等多个方面得到广泛应用(Romero和Ventura,2007年,2010年,2013年;Koedinger等人,2015年;Romero和Ventura,2020年;Batool等人,2023年;Xiong等人,2024年)。

随着大型语言模型(LLMs)在不同领域成为强大的范式(Fan等人,2023b;Zeng等人,2023年;Jin等人,2024年;Chen等人,2023a),它们在多个教育场景中也取得了最先进的表现(Li等人,2023a;Kasneci等人,2023年;Yan等人,2024年)。现有研究发现,LLMs能够在标准化测试中实现学生水平的表现(OpenAI,2023),在包括物理、计算机科学在内的各种数学科目中,无论是多项选择题还是自由回答题(Malinka等人,2023;Susnjak,2022)。此外,实证研究表明,LLMs可以作为教育的写作或阅读助手。最近的一项研究(Susnjak,2022)揭示了ChatGPT能够跨学科生成逻辑一致的答案,平衡了深度和广度。另一项定量分析(Malinka等人,2023)表明,使用ChatGPT的学生(通过保留或完善LLMs的结果作为自己的答案)在计算机安全领域的某些课程中的表现优于平均水平的学生。最近,几篇观点论文(Tan等人,2023;Kamalov和Gurrib,2023)也探讨了LLMs在课堂教学中的各种应用场景,如师生合作、个性化学习和评估自动化。然而,LLMs在教育中的应用可能导致一系列实际问题,例如抄袭、AI生成内容的潜在偏见、过度依赖LLMs,以及非英语人士的不公平访问(Kasneci等人,2023)。

为了为研究人员提供该领域的广泛概述,已经提出了许多探索性和综述性论文。例如,Qadir(2023年);Rahman和Watanobe(2023年)和Rahman和Watanobe(2023年)通过分析ChatGPT对相关教育问题的回答,总结了ChatGPT在工程教育中的应用。Jeon和Lee(2023年)和Mogavi等人(2023年)通过面对面访谈、在线帖子回复和用户日志收集了不同ChatGPT用户群体的意见,例如教育工作者、学习者、研究人员,并总结了LLMs在教育场景中的实际应用。Baidoo-Anu和Owusu Ansah(2023年)和Zhang和Tur(2023年)关注已发表论文的文献综述,并用结构化的表格总结了该领域的进展。尽管上述工作已经涵盖了LLMs在教育场景中的广泛现有应用,并为未来的研究提供了他们的长期愿景,但我们认为,没有任何文献从技术角度系统性地总结了教育的LLMs。为了弥补这一空白,本综述旨在提供一份全面的技术性回顾,为教育的LLMs提供一种新的以技术为中心的分类和现有公开可用数据集及基准测试的总结。此外,我们还总结了当前的挑战以及进一步的研究机会,以促进对LLMs教育动态和不断发展的格局的创新和理解。总结来说,我们的贡献在于以下三个主要部分:

-

全面且最新的调查。我们提供了一份全面且最新的LLMs在广泛教育领域的调查,包括学术研究、商业工具和相关数据集及基准测试。

-

以技术为中心的新分类法。我们提供了一种新的分类法,从技术角度对教育的LLMs进行了全面分析,包括学生和教师辅助、自适应学习和商业工具。

-

当前挑战和未来研究方向。我们讨论了当前的风险和挑战,并强调了未来的研究机会和方向,敦促研究人员深入研究这一激动人心的领域。

2. 教育应用中的LLM

2.1 概述

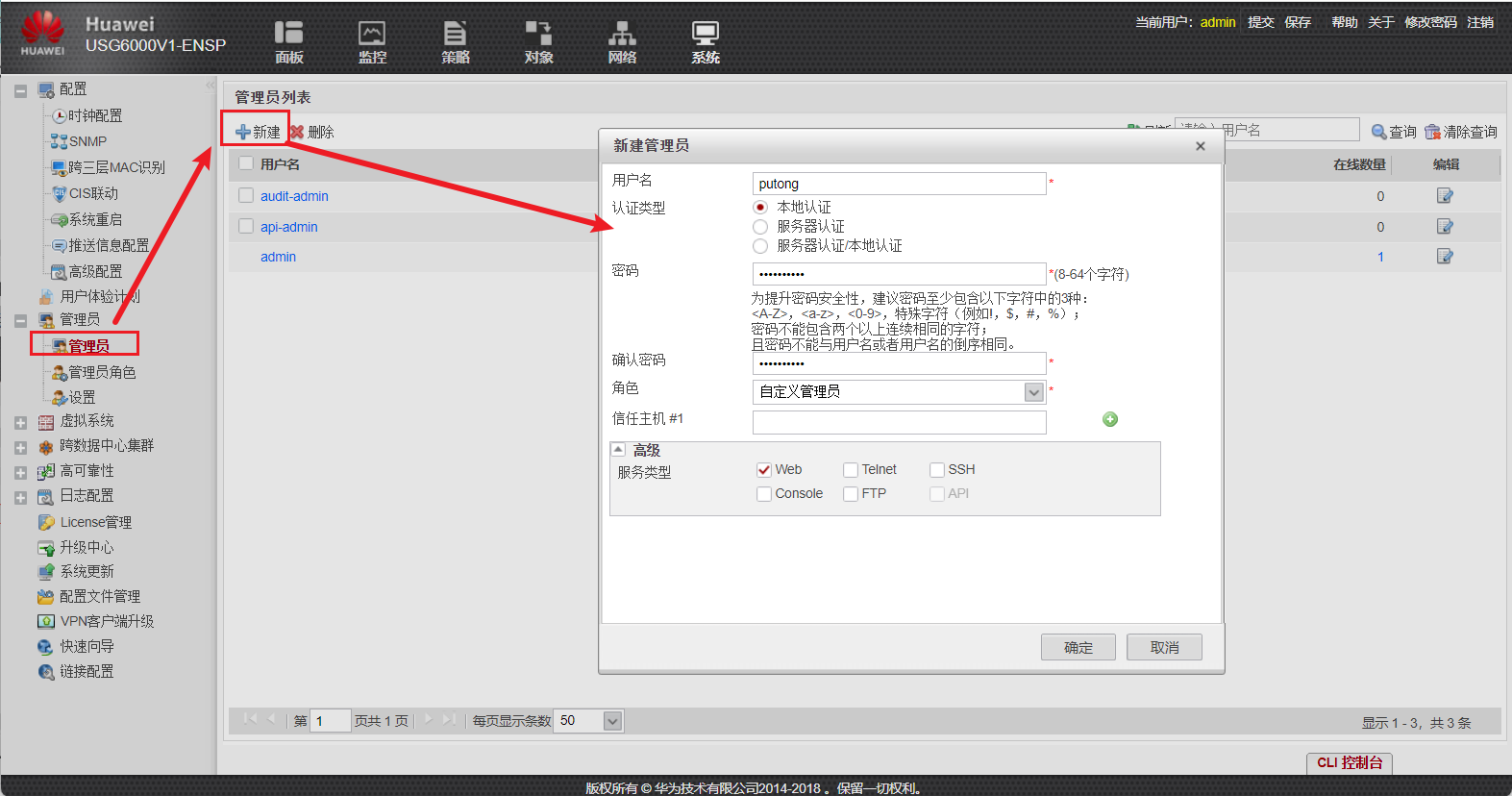

教育应用可以根据用户在教育中的角色以及在教育中的使用场景进行分类。在本文中,我们总结了LLMs在不同应用中的表现,并讨论了与原始方法相比LLMs带来的优势。我们使用图1中说明的分类法,对LLMs的教育应用进行了初步总结。

2.2 学习辅助

为学生提供及时的学习支持已被广泛认为是提高学生在独立学习期间的参与度和学习效率的关键因素(Dewhurst等人,2000)。由于以往算法在生成固定形式回答方面的局限性,许多现有的学习辅助方法在现实世界的应用场景中面临较差的泛化挑战(König等人,2023)。幸运的是,LLMs的出现为这一领域带来了革命性的变化。利用经过微调的LLMs(Ouyang等人,2022)生成类人回答,近期基于LLM的教育支持研究已经展现出了有希望的结果。这些研究通过帮助学生解决具有挑战性的问题、纠正错误以及为困惑的领域提供解释或提示,提供了对学生的实时辅助。

2.2.1 问题解决(QS)

得益于LLMs大规模的参数量以及预训练阶段使用的庞大且多样化的网络语料库,LLMs已被证明是一个强大的零样本问题解决器,能够解决从数学(Yuan等人,2023;Wu等人,2023d)、法律(Bommarito II和Katz,2022;Cui等人,2023)、医学(Thirunavukarasu等人,2023;Liévin等人,2023)、金融(Wu等人,2023c;Yang等人,2023)、编程(Kazemitabaar等人,2023;Savelka等人,2023)、语言理解(Zhang等人,2024;Achiam等人,2023)等广泛学科领域提出的问题。此外,为了在面对复杂问题时进一步提高LLM的问题解决性能,已有多种研究被积极提出。例如,Wei等人(2022)提出了一种思维链(Chain-of-Thought, CoT)提示方法,该方法通过将复杂问题分解为更简单的顺序步骤来指导LLM解决问题。其他工作(Sun,2023;Wang等人,2023)利用LLMs强大的上下文学习能力,提出了先进的少样本示例选择算法,以提高LLM解决一般问题的性能。Chen等人(2022)和Gao等人(2023a)利用外部编程工具来避免在原始LLMs的文本问题解决过程中引入的计算错误。Wu等人(2023a)将聊天优化的LLM视为强大的代理,并设计了一个多代理对话,通过协作过程解决这些复杂问题。Cobbe等人(2021)和Zhou等人(2024b)提出了外部验证器模块,在生成过程中纠正中间错误,这提高了LLM解决具有挑战性的数学问题的性能。总体而言,随着所有这些新设计的提出,LLMs用于问题解决的使用已经取得了令人印象深刻的进展。此外,学生可以及时找到对他们阻塞问题的高质量答案。

2.2.2 错误纠正(EC)

错误纠正专注于在学生学习过程中对其错误提供即时反馈。这对初期阶段学习的学生很有帮助。张等人(2023b)探索了使用四种提示策略:零样本、零样本思维链(CoT)、少样本和少样本思维链来纠正中文和英文文本中的常见语法错误。从他们的实验中,他们发现LLMs在纠正任务上有着巨大的潜力,一些简单的拼写错误已经被当前的LLMs完美解决了。GrammarGPT(范等人,2023a)利用LLM来解决中文母语者的语法错误。通过使用混合注释数据集对开源LLMs进行微调,该数据集涉及人工注释和ChatGPT生成,所提出的框架在中文母语语法错误纠正方面表现有效。张等人(2022)提议使用像Codex这样的代码训练的大型语言模型来构建一个自动程序修复(APR)系统——MMARP——用于初级Python编程作业。通过将MMARP评估在真实的学生程序上,并与之前最先进的Python语法修复引擎进行比较,作者发现MMARP平均能修复更多的程序,并产生更小的补丁。越南度和马尔科夫(2023)开发了一个少样本示例生成流程,涉及代码摘要生成和代码修改以创建少样本示例。通过生成的少样本示例,LLMs在学生程序上的bug修复性能得到了显著提升。

2.2.3 困惑助手(CH)

与问题解决(QS)和错误纠正(EC)不同,困惑助手方向的研究避免直接提供正确的问题解决方案。相反,这些工作的目标是使用LLMs生成教学指导或提示,帮助学生自己解决问题。施里德哈尔等人([无日期])基于输入条件和强化学习提出了各种引导问题生成方案,并探索了LLMs生成顺序问题以指导解决数学文字问题的能力。普里哈尔等人(2023)探索了使用LLMs以两种方式为数学问题生成解释:总结与问题相关的辅导聊天日志和从现有解释文本中学习一些示例。基于他们的实验,他们发现合成解释无法超越教师编写的解释,因为学生可能不知道某些术语,而且建议有时过于笼统。帕尔多斯和班达里(2023)评估了ChatGPT和人类导师生成的代数提示之间的学习收益差异。通过观察受控组之间参与者的前测和后测成绩的变化,作者得出了类似的结论,即LLMs生成的提示在指导学生找到解决方案方面效果较差。巴尔塞等人(2023)评估了使用LLMs生成解释学生计算机编程作业中逻辑错误的文本的有效性。通过将合成解释与课程助教撰写的解释进行排名,作者发现合成解释与人工生成的结果具有竞争力,但在正确性和信息缺失问题上存在不足。鲁因等人(2023)尝试为不同群体的学生生成适应性解释。通过在教学提示中引入控制条件,如年龄组、教育水平和详细程度,所提出的方法适应了具有不同学习档案的学生生成的解释。

2.3 教学辅助

得益于LLM前所未有的逻辑推理和问题解决能力,开发基于LLM的教学辅助模型已成为近期教育研究中的另一个热门话题。借助这些辅助算法的帮助,教师们能够摆脱以往的繁琐日常工作负担,将注意力集中在如课堂指导这类现有机器学习模型无法替代的任务上。

2.3.1 问题生成(QG)

由于在教学实践中的频繁使用,问题生成(QG)已成为LLMs教育应用中最受欢迎的研究主题之一。肖等人(2023)利用LLMs生成阅读理解问题,首先用补充阅读材料和教科书练习段落对其进行微调,然后采用即插即用式的可控文本生成方法,引导经过微调的LLMs基于指定的主题关键词生成更加连贯的段落。道蒂等人(2024)分析了LLM(GPT-4)生成与高等教育中Python编程课程特定学习目标(LO)一致的多项选择题(MCQs)的能力。通过将几个生成控制模块与提示组装过程整合,所提出的框架能够生成语言清晰、有一个正确选项和高质量干扰项的MCQs。李等人(2023a)专注于使用二维矩阵结构框架对提示问题和阅读理解分类学进行对齐。使用对齐的提示,LLM问题可以以平衡的方式涵盖广泛的题型和难度级别。周等人(2023)致力于生成多样化的数学文字问题,并实现对问题方程的隐式多样性控制,达到生成高质量多样化问题的目标。

2.3.2 自动评分(AG)

自动作业评分器的研究比LLMs的近期出现要早得多。然而,由于以往模型在学习能力上的限制,大多数现有的自动评分算法(刘等人,2019)专注于探索标准解决方案和学生回答之间的语义比较,这忽略了手动评分过程中的逻辑考量。除此之外,所提供解决方案的质量严重影响结果,因此以往作品的应用被限制在一些有良好注释的问题上。幸运的是,随着LLMs的出现,上述挑战变得容易解决。杨西等人(2023)和品托等人(2023)首次探索了使用LLMs进行开放式问题和写作论文的自动评分,使用提示调整算法。通过包含全面上下文、清晰的评分标准和高质量的示例,LLMs在两项评分任务上都展示了令人满意的性能。肖等人(2024)进一步将CoT整合到评分过程中。这种方法指导LLMs在做出最终评分决定之前,先分析并解释所提供的材料。有了这样的修改,LLMs不仅会生成分数结果,还会对学生的回答提供详细评论,这有助于学生了解如何为下次改进。李等人(2024b)将评分对象从学生的文字回答扩展到包含手写回答的评分。使用先进的多模态LLM框架,例如CLIP和BLIP,这项工作展示了将学生的文本和图像以及问题的文本和图像结合起来,可以提高模型的评分性能。船山等人(2023)提出了一种跨提示的预微调方法,以学习不同评分标准和注释示例之间的共享关系,然后通过在目标评分任务上进一步微调预微调的LLMs,在标记样本的限制下,模型可以实现相当的表现。

2.3.3 教学材料创作(MC)

尽管已有上述任务,开创性的研究者也发现了LLMs在帮助教师创造高质量教学材料方面的巨大潜力。例如,Leiker等人(2023)提出了一项关于在异步课程创作中使用LLMs的调查,特别是在成人学习、培训和技能提升的背景下。为了确保生成内容的准确性和清晰度,作者将LLMs与强大的人工介入流程相结合。Koraishi(2023)利用GPT-4和零样本提示策略来优化英语作为外语(EFL)课程的材料。在他们的探索中,作者考察了如何在教学材料开发中使用ChatGPT,简化了创造吸引人的、与个体学习者需求相关的、具有上下文相关性的资源的过程,以及其它更一般的用途。Jury等人(2024)提出了一个新工具’WorkedGen’,它使用LLMs生成交互式例题。通过使用提示链和一次性学习等策略来优化输出,生成的例题从学生那里获得了积极的反馈。

2.4 适应性学习

根据所提出方法解决的具体问题,现有的适应性学习工作可以分为两类:知识追踪(Abdelrahman等人,2023)和内容个性化(Naumov等人,2019)。具体来说,知识追踪旨在根据学生在学习过程中对问题回答的正确性来估计学生的知识掌握状态。内容个性化侧重于根据学生的个性化因素(如学习状态、偏好和目标)提供定制化的学习内容。在过去几十年中,不同的研究探索了包括传统统计方法(Kučak等人,2018)和先进的深度学习模型(Lin等人,2023)在内的各种机器学习算法,并且在这两个问题上都取得了一些有希望的结果(Liu等人,2017)。随着功能强大的LLMs在各种应用中的最近激增,这些方向的研究也出现了新的机会。

2.4.1 知识追踪(KT)

目前LLMs在知识追踪中的使用集中在为问题文本和学生记录数据生成辅助信息。在Ni等人(2023)最近的研究中,作者使用LLM为学生-问题响应图中的每个问题文本提取知识关键词。由于LLM强大的处理未见文本的能力,所提出的框架在解决以有限学生问题练习数据为特征的冷启动场景中特别有利。此外,Lee等人(2023b)提出了一个框架DCL4KT+LLM,该框架基于问题干文本和与LLM相关联的知识概念来预测问题的难度。利用预测的問題难度,DCL4KT+LLM克服了现有知识追踪算法在面对未见问题或概念时缺失难度信息的问题。最后,Sonkar和Baraniuk(2023)探索了LLM在扭曲事实的逻辑推理中的能力。通过利用研究设计的提示,LLMs展示了在给定学生适当的知识档案时模拟学生错误响应的可能性。

2.4.2 内容个性化(CP)

由于大多数先进的LLMs是生成性模型,因此在许多近期的教育研究中探索了使用LLMs创造个性化学习内容。例如,Kuo等人(2023)尝试根据学生最近的知识掌握诊断结果为学生生成动态学习路径。Kabir和Lin(2023)在生成过程中融入了知识概念结构。具体来说,如果学生掌握了给定学习对象(LO)的主题,就会自动生成下一个LO的问题。Yadav等人(2023)探索了LLMs在根据学生兴趣创建上下文化的代数问题方面的潜力。通过对少样本学习方法进行迭代提示工程,系统能够很好地适应TikTok和NBA等新颖兴趣,将其融入到生成的问题干文本中,这有助于提高学生在研究期间的参与度和成果。除了生成内容,其他研究(Abu-Rasheed等人,2024)也尝试利用基于聊天的LLMs生成学习推荐解释。通过使用知识图谱(KGs)作为上下文信息的来源,该方法展示了其为对ITS系统推荐的学习路径有疑问的学习者生成令人信服答案的能力。

2.5 教育工具包

除了利用LLMs来增强学术界精心构建的教育应用外,一些由LLM驱动的商业教育工具也已经在行业中开发出来。特别是,它们可以被归类为五个类别,包括聊天机器人、内容创作、教学辅助、测验生成器和协作工具。

2.5.1 聊天机器人

将大型语言模型(LLM)聊天机器人作为教育工具使用,提供了一系列的优势和机会。LLM聊天机器人可以将其响应适应于学习者个人的需求,提供个性化的反馈和支持。这种定制可以适应不同的学习风格、速度和偏好。它们提供全天候的可用性,使学习在任何时间、任何地点都可以进行。这对于处于不同时区或有不同时间安排的学习者尤其有益。聊天机器人的互动特性可以使学习更加吸引人和有趣。它们可以模拟对话、创建互动学习场景,并提供即时反馈,这可能比被动学习方法更有效。聊天机器人可以同时处理数千个查询,使它们成为教育机构支持大量学习者而不需要相应增加教学人员的可扩展解决方案。它们可以自动化重复性教学任务,如评分测验或提供基本反馈,允许教育者专注于更复杂和创造性的教学职责。一些代表性的聊天机器人包括ChatGPT(OpenAI,2024年)、Bing Chat(Microsoft,2024年)、Google Bard(Google,2024年)、Perplexity(Perplexity AI,2024年)、Pi Pi.ai(2024年)。

2.5.2 内容创作

Curipod(Curipod,2024年)接受用户输入的主题,并生成包含投票、词云、开放式问题和绘图工具的互动幻灯片。Diffit(Diffit,2024年)提供了一个平台,用户可以在该平台上为几乎任何主题找到分级资源。它使教师能够调整现有材料以适应任何读者,创建任何主题的定制资源,然后编辑并与学生分享这些材料。MagicSchool(MagicSchool.ai,2024年)是一个由LLM驱动的教育平台,旨在通过自动化课程规划、评分和创建教育内容等任务来帮助教师节省时间。它提供了40多种AI工具,可以通过关键词搜索,并按规划、学生支持、生产力和社区工具等类别进行组织。Education Copilot(Copilot,2024年)提供LLM生成的模板,用于各种教育需求,包括课程计划、写作提示、讲义、学生报告、项目大纲等,简化了教育者的准备过程。Nolej(Nolej,2024年)专注于创建包括全面课程、互动视频、评估和即插即用内容在内的广泛互动教育内容,以增强学习体验。Eduaide.ai(Eduaide.ai,2024年)是一个由LLM驱动的教学助手,旨在支持教师在课程规划、教学设计和教育内容创作方面的工作。它具有资源生成器、教学助手、反馈机器人和AI聊天功能,为教育者提供全面的帮助。Khanmigo(Khanmigo,2024年),由Khan Academy开发,是一个由LLM驱动的学习工具,充当虚拟导师和辩论伙伴。它还可以协助教师生成课程计划和处理各种行政任务,增强学习和教学体验。Copy.ai(Copy.ai,2024年)是一个由LLM驱动的写作工具,使用机器学习来制作各种类型的内容,如博客标题、电子邮件、社交媒体帖子和网页文案。

2.5.3 教学辅助

gotFeedback(gotFeedback,2024年)是为了帮助教师向学生提供更加个性化和及时的反馈而开发的,它与gotLearning平台无缝集成。该工具基于研究,强调有效的反馈应该是目标参照的、具体透明的、可执行的、用户友好的、及时的、持续的和一致的,确保它能有效满足学生的需求。Grammarly(Grammarly,2024年)作为一个在线写作助手,利用LLM帮助学生撰写大胆、清晰、无错误的文本。Grammarly的AI会细致检查语法、拼写、风格、语调等,确保你的写作简洁且专业。Goblin Tools(Tools,2024年)提供了一套专为神经多样性个体设计的简单单任务工具,以帮助他们应对可能压倒性或具有挑战性的任务。这个系列包括Magic ToDo、Formalizer、Judge、Estimator和Compiler,每种工具针对不同的需求,简化日常任务,提高生产力和便利性。ChatPDF(PDF,2024年)是一个由LLM驱动的工具,设计使用户能够通过会话界面与PDF文档交互。这种创新方法使导航和与PDF内容的交互更加容易,使其更加易于访问和用户友好。

2.5.4 测验生成器

QuestionWell(Que,2024年)是一个基于LLM的工具,可以生成无限的题目供应,允许教师专注于最重要的事情。通过输入阅读材料,AI可以创建关键问题、学习目标和对齐的多项选择题,简化了准备教育内容和评估的过程。Formative(AI,2024a)是一个平台,支持各种类型的问题,现在通过整合ChatGPT增强了其能力。这一新增功能使系统能够生成新的标准对齐问题、学习者的提示和学生的反馈,利用LLM的力量丰富教育体验并支持定制化学习路径。Quizizz AI(AI,2024b)是一个由LLM驱动的功能,专门生成多项选择题,它能够根据提供的内容自动决定生成问题的合适数量。此外,Quizizz AI可以通过其增强功能修改现有测验,允许定制活动以满足学生的特定需求。Conker(Conker,2024年)是一个工具,可以创建针对不同层次学生在特定主题上的多项选择、读后回应和填空测验。它还支持使用用户输入的文本生成测验,使其成为教育者高效评估和加强学生学习的多功能资源。Twee(Twee,2024年)是一个由LLM驱动的工具,旨在简化英语教师的课程规划,生成包括问题、对话、故事、信件、文章、多项选择题和是非陈述等教育内容。这种全面的支持帮助教师丰富他们的课程计划,并用各种学习材料吸引学生。

2.5.5 协作工具

summarize.tech(summarize.tech,2024年)是一个由ChatGPT驱动的工具,可以总结任何长YouTube视频,如讲座、现场活动或政府会议。Parlay Genie(Genie,2024年)充当讨论提示生成器,根据特定主题、YouTube视频或文章为班级创建高阶思维问题。它利用ChatGPT的能力生成引人入胜且发人深省的提示,促进学生之间深入讨论和批判性思维。

3. 数据集和基准测试

LLMs通过实现广泛的文本丰富的下游任务,彻底改变了自然语言处理(NLP)领域,这些任务利用了LLMs内部嵌入的广泛知识和语言理解,以执行需要理解、生成或文本转换的特定功能。因此,许多数据集和基准测试是为文本丰富的教育下游任务而构建的。大多数数据集和基准测试都涉及问题解决(QS)、错误纠正(EC)、问题生成(QG)和自动评分(AG)等任务,这些任务涵盖了不同的用户、学科、水平和语言的使用案例。其中一些数据集主要惠及学生,而另一些则帮助教师。

教育应用的数据集和基准测试在范围和目的上差异很大,针对教育过程的不同方面,例如学生表现数据(Ray等人,2003年)、文本和资源数据库(Brooke等人,2015年)、在线学习数据(Ruipérez-Valiente等人,2022年)、语言学习数据库(Tiedemann,2020年)、教育游戏数据(Liu等人,2020年)、人口统计和社会经济数据(Cooper等人,2020年)、学习管理系统(LMS)数据(Conijn等人,2016年)、特殊教育和需求数据(Morningstar等人,2017年)。具体来说,问题解决的数据集(Cobbe等人,2021年;Hendrycks等人,2020年;Huang等人,2016年;Wang等人,2017年;Zhao等人,2020年;Amini等人,2019年;Miao等人,2021年;Lu等人,2021年b;Kim等人,2018年;Lu等人,2021年a;Chen等人,2023年b)在教育和NLP领域都是一项重要且普遍的任务。特别是,许多数据集(Cobbe等人,2021年;Hendrycks等人,2020年;Huang等人,2016年;Wang等人,2017年;Zhao等人,2020年;Amini等人,2019年;Miao等人,2021年;Lu等人,2021年b)为数学问题解决而构建,旨在从叙述性描述中提供一个抽象的表达。一些数据集还考虑了图像(Miao等人,2021年;Kim等人,2018年;Lu等人,2021年a;Kembhavi等人,2016年)和表格(Lu等人,2021年b)。另一方面,另一组数据集和基准测试(Kim等人,2018年;Kembhavi等人,2016年;Chen等人,2023年b)是为科学教科书问题解决而构建的,这需要全面理解教科书并提供与问题中关键信息相对应的答案。还有大量的数据集和基准测试是为错误纠正而构建的。它们用于外语培训(Rothe等人,2021年;Ng等人,2014年;Bryant等人,2019年;Tseng等人,2015年;Zhao等人,2022年;Xu等人,2022年b;Du等人,2023年;Náplava等人,2022年;Rozovskaya和Roth,2019年;Grundkiewicz和Junczys-Dowmunt,2014年;Davidson等人,2020年;Syvokon和Nahorna,2021年;Cotet等人,2020年)和计算机科学编程语言培训(Just等人,2014年;Le Goues等人,2015年;Lin等人,2017年;Tufano等人,2019年;Li等人,2022年;Guo等人,2024年)。外语培训的数据集和基准测试包含了需要识别和纠正的语法错误和拼写错误。编程培训的数据集和基准测试包括几个代码错误,这些错误需要足够的编码理解才能正确纠正。另一方面,还有一些数据集和基准测试是为教师辅助任务而构建的。(Welbl等人,2017年;Lai等人,2017年;Xu等人,2022年a;Chen等人,2018年;Gong等人,2022年;Hadifar等人,2023年;Liang等人,2018年;Bitew等人,2022年)为问题构建任务而构建,旨在评估LLM从给定上下文中生成教育问题的能力。(Yang等人,2023年;Tigina等人,2023年;Blanchard等人,2013年;Stab和Gurevych,2014年)为自动评分学生作业而构建。我们在附录1的表1中总结了评估LLMs在教育应用上常用的公开可用数据集和基准测试。

4. 风险和潜在挑战

本节讨论了随着生成性AI和LLMs的兴起而带来的风险和挑战,并总结了一些早期关于实施防护措施和负责任AI的提议。鉴于教育作为一个至关重要的领域的重要性,在实施LLMs的影响时应更加谨慎。一个建立良好的负责任AI框架(Microsoft,2024年)概述了六个基础要素:公平性、包容性、可靠性与安全性、隐私与安全、透明度和可问责性。除此之外,对于教育领域,过度依赖也是一个主要问题,因为过度依赖LLMs将损害学生的一些关键能力,如批判性思维、学术写作甚至创造力。

4.1 公平性和包容性

受限于LLM训练数据,特定群体的个体和社会刻板印象可能占主导地位,可能会产生偏见(Zhuo等人,2023年)。Li等人(Li等人,2024a)总结指出,在教育领域,关键的LLM公平性讨论基于人口统计偏差和反事实问题。Fenu等人(Fenu等人,2022年)介绍了一些存在偏见的LLM,这些模型未能为在数据中未被代表的群体生成同样多的有用内容。同样令人关注的是,某些人口统计群体的人可能无法平等地获得质量相当的教育模型。Weidinger等人(Weidinger等人,2021年)展示了LLM在生成未被选为训练的语言群体的内容方面的能力不足。Oketunji等人(Oketunji等人,2023年)认为LLMs天生会产生偏见,并提出了一个大型语言模型偏见指数来量化和解决偏见,提高LLMs的可靠性。Li等人(Li和Zhang,2023年)介绍了一种系统性的方法来评估LLMs可能显示的公平性和偏见,其中将一些有偏见的提示输入LLMs,并计算出表明个体和群体公平性水平的概率度量。在教育领域,加强的陈述如“你应该对敏感特征(实验中的种族或性别)保持公正”有助于减少LLMs的偏见反应。Chhikara等人(Chhikara等人,2024年)展示了LLMs中的一些性别偏见,并探索了使用少样本学习和增强检索生成的可能解决方案。Caliskan等人(Caliskan和Zhu,[n. d.])通过评估LLMs(llama 2、Yi、Tulu等)对各种输入提示的反应,来检查学者中的社会偏见,并认为微调是维持公平性的最有效方法。Li等人(Li等人,2024e)认为LLMs经常呈现主导观点,同时忽视了在训练数据中未被充分代表的少数群体的替代观点,导致潜在的偏见。他们提出了一个FAIRTHINKING流程,自动生成角色,使LLMs能够表达多样化的观点,以实现公平表达。Li等人(Li等人,2024c)分析了教育和卫生保健决策系统中的推理偏见,并设计了一个包含提示选择机制的引导去偏见框架。

4.2 可靠性与安全性

LLMs遇到了可靠性问题,包括幻觉、产生有害输出以及回答中的不一致性。这些挑战在教育领域尤为严重。幻觉,即LLMs生成虚构内容,是Ji等人(Ji等人,2023年)强调的一个关键问题。Zhuo等人(Zhuo等人,2023年)概述了关于LLMs可能创建包含冒犯性语言和明确材料内容的伦理考量。Cheng等人(Cheng等人,2024年)讨论了LLM数据版本中的时间不对齐问题,引入了一种新的追踪器来追踪知识截止日期。Shoaib等人(Shoaib等人,2023年)强调了通过看似真实的内容传播错误信息和虚假信息的风险,建议采纳网络健康教育以提高公众的意识和适应能力。Liu等人(Liu等人,2024年)探索了像Sora这样的文本到视频模型的应用,作为模拟现实世界场景的工具。然而,他们提醒说,尽管这些模型功能先进,但由于它们在准确表示现实物理和复杂的时空环境方面的限制,有时会使学生感到困惑或误导。为了提高LLMs的可靠性,Tan等人(Tan等人,2024年)开发了一种元认知策略,使LLMs能够自主识别和纠正错误。这种方法旨在尽可能少地人工干预下检测不准确性,并在需要调整时发出信号。此外,Gao等人和Zhao等人确定使用检索增强生成(RAG)是解决幻觉和回答不一致问题的有效方法,提高了LLMs在内容生成方面的可靠性和准确性(Gao等人,2024b;Zhao等人,2024年)。

4.3 透明度与可问责性

LLM按设计运行为一个黑箱机制,因此它带来了透明度和可问责性方面的问题。Milano等人(Milano等人,2023a)和BaHammam等人(BaHammam等人,2023年)提出了LLM对高等教育的多项挑战,包括抄袭、不准确报告、考试作弊,以及其他一些操作性、财务性、教育性问题。作为对使用生成性AI进行作业或考试的学生的进一步思考,Macneil等人(MacNeil等人,2024年)讨论了对传统评估方法的影响,并认为我们教育者应该提出新的评估框架,以考虑使用类似Chat-GPT工具的使用。Zhou等人(Zhou等人,2024a)提出了特别使教师和学生感到困惑的学术诚信伦理问题,并呼吁重新考虑政策制定。作为具体措施,Gao等人(Gao等人,2024a)引入了一种称为mixcase的新概念,代表涉及机器生成和人为生成的混合文本形式,并开发了能够区分人为和机器文本的探测器。为了解决LLM在知识产权侵犯方面的伦理问题,Huang等人(Huang和Chang,2023年)提议在训练LLM时加入引用,这可能有助于提高内容透明度和可验证性。Finlayson等人(Finlayson等人,2024年)开发了一个系统框架,以高效地发现LLM的隐藏大小,获取全词汇量输出,检测和区分不同的模型更新,这可能有助于用户通过追踪模型变化来追究提供者的可问责性,从而增强可问责性。

4.4 隐私与安全

随着LLMs的兴起,隐私和安全保护已成为越来越重要的主题,特别是在教育领域,它们值得更严格的审查。Latham等人(Latham和Goltz,2019年)进行了一个案例研究,探讨了公众对教育中AI的看法,揭示了尽管研究主要集中在AI的有效性上,但学习者对跟踪和分析算法的认知和接受度等关键领域仍未充分探索。这强调了对教育中AI的伦理和法律方面进行更多研究的必要性。Das等人(Das等人,2024年)对LLM使用背景下保护个人可识别信息的挑战进行了广泛的回顾,突出了普遍存在的安全和隐私问题。Shoaib等人(Shoaib等人,2023年)解决了由深度伪造内容对个人隐私构成的威胁,提出了使用检测算法和实施标准协议等解决方案来加强保护。Ke等人(Ke等人,2024年)对在心理研究中使用LLMs的数据隐私和伦理含义表示担忧,强调了在研究项目中保护参与者隐私的重要性。这强调了研究人员理解LLMs的局限性、遵守伦理标准并考虑其使用潜在后果的必要性。Suraworachet等人(Suraworachet等人,2024年)提供了使用LLMs与传统方法披露学生信息的比较分析。他们的发现指向了在有效评估、尊重隐私以及在使用LLMs评估学生表现时缺乏有意义的交互方面的挑战。在缓解策略方面,Hicke等人(Hicke等人,2023年)建议结合检索增强生成(RAG)和微调技术的框架,以增强隐私保护。同时,Masikisiki等人(Masikisiki等人,2023年)强调了为用户提供删除其交互的选项的重要性,强调了用户对个人数据控制的重要性。

4.5 对LLMs的过度依赖

鉴于LLMs生成能力的出色表现,人们非常担忧学生可能会盲目依赖LLMs完成大部分工作,导致他们独立思考的能力消失。Milano等人(Milano等人,2023a)讨论了由类似Chat-GPT的应用引起的过度依赖问题,学生可能会用这些应用来撰写文章和学术出版物,而没有提高他们的写作技能,这对于培养批判性思维至关重要。这种担忧可能对外语学生或在教育上处于不利地位的学生影响更大,因为他们在学习如何撰写写得好文本方面重视不够。Krupp等人(Krupp等人,2023年)讨论了教育中对LLMs过度依赖的挑战,并提出了一些适度的方法来减轻这种影响。同样,Zuber等人(Zuber和Gogoll,2023年)讨论了过度依赖可能对民主带来的风险,并建议培养孩子的思考技能,培养连贯的思维形成能力,并区分机器生成的输出和真正的能力。他们认为,LLMs应该被用来增强而不是替代人类的思维能力。Adewumi等人(Adewumi等人,2023年)也提出了学生倾向于依赖LLMs写作文而不是自己写作的场景,并展示了使用探询思维链工具可以大大激发与LLMs相伴的批判性思维。

5. 未来方向

在这里,我们讨论了LLMs在教育中的未来机会,并在图3中总结了有希望的方向。对于每个方向,我们讨论了基于高级LLMs的技术的潜在应用,并得出了它们对未来教育的影响。

5.1 与教育学兴趣一致的LLMs

尽管像GPT-4这样的先进LLMs在教育领域的实验应用中展示了有希望的表现,但将LLMs直接应用于现实世界的教学仍然具有挑战性,因为提供高质量的教育是一项涉及多学科知识和行政约束的复杂任务(Milano等人,2023b)。为解决这些问题,未来研究者可以利用如检索增强生成(RAG)这样的先进技术(Gao等人,2023b),向LLMs提供必要的先验信息,并引导LLMs生成与教育学兴趣一致的结果。除此之外,从现实世界的教学场景中收集大量教学指导数据集,并对现有LLMs进行微调以符合人类教师的行为,也将是未来研究的一个有趣方向。通过学习人类教师的偏好,LLMs可以在其参数空间内编码教育约束和知识模式,并在不需要太多外部信息干预的情况下生成与教育学兴趣一致的结果。

5.2 LLM-多代理教育系统

LLMs在语言理解、推理、规划和编程方面的广泛使用启发了如AutoGen(Wu等人,2023a)等工作,这些工作正在开发一个涉及多个LLMs通过对话形式程序解决复杂任务的协作框架。同样,教育中的问题通常涉及多步骤处理逻辑,这非常适合使用基于多代理的LLMs系统。Yang等人(2024年)最近的工作展示了多代理框架在评分任务上的巨大潜力。在这项工作中,通过利用多个基于LLM的评分代理和评论代理,实现了类似人类的评分程序,并通过小组讨论程序纠正了个别评委的差错。对于未来这个方向的研究,可以包括更多类型的基于LLM的代理,它们的功能可能从特定的命令执行者扩展到高级计划制定者。更重要的是,被视为系统中特殊代理的人类教师也可以直接参与LLMs的交互,并灵活地为系统提供任何必要的干预。

5.3 多模态和多语言支持

不同人类语言之间的高度相似性自然使LLMs能够有效支持多语言任务。此外,最近关于多模态和语言标记之间对齐的发现(Wu等人,2023b)进一步将LLMs从文本分析扩展到多模态学习分析。通过接受多样化的输入,LLMs可以利用不同数据资源之间的相互信息,为教育中的具有挑战性任务提供高级支持。对于未来多模态方向的工作,可以更多地关注开发能够解释和整合这些不同数据源的LLMs,为学生参与、理解力和学习风格提供更细致的见解。这样的进步可以为高度个性化和适应性学习体验铺平道路,这些体验是根据每个学生的独特需求量身定制的。另一方面,多语言LLMs为每个人提供了使用其熟练语言方便地获取高质量全球教育资源的机会。通过开发不仅能够翻译,而且能够理解文化细微差别、口语表达和地区教育标准的稳健模型,这个方向上的研究将帮助全世界的学习者以他们的母语从LLMs中受益,并显著提高全球教育的公平性和包容性。

5.4 边缘计算与效率

将LLMs与边缘计算结合是一个有前景的途径,可以提高教育技术的效率和可访问性。通过在靠近最终用户的地方处理数据,边缘计算可以减少延迟,提高内容传递速度,并实现教育资源的离线访问。未来的努力可以探索为边缘部署优化LLMs,专注于保持高性能的同时最小化计算资源的轻量级模型,这在互联网连接有限的地区尤其有益,确保了教育工具的公平访问。此外,本地处理数据减少了通过互联网传输敏感信息的需求,增强了隐私和安全。边缘计算可能是一个潜在的框架,可以在遵守严格的数据保护标准的同时利用LLMs。

5.5 专业模型的高效训练

开发针对特定教育领域或学科的专业LLMs代表了未来研究的一个重要机会。这个方向涉及创建不仅理解通用语言,还拥有数学、科学或文学等领域的深厚知识的模型。关键是,专业LLMs可以实现对特定学科的深入理解,提供高度相关和准确的见解和支持,同时更具成本效益。挑战在于这些模型的高效训练,这需要在数据收集、模型架构和训练方法上进行创新。专业模型可以提供更准确和情境相关的帮助,改善学生和教育者的体验。

5.6 伦理和隐私考虑

随着LLMs越来越多地融入教育环境,伦理和隐私问题成为中心舞台。未来的研究必须解决LLMs的负责任使用,包括与数据安全、学生隐私和偏见减轻相关的问题。为教育中LLMs的道德部署制定框架和指导方针至关重要。这包括确保模型训练过程的透明度、保护敏感信息,并创建反映学生群体多样性的包容性模型。解决这些问题对于建立信任和确保教育中负责任地使用LLMs至关重要。

6. 结论

LLMs的快速发展已经彻底改变了教育。在这项调查中,我们从多方面的分类法提供了对LLMs在各种教育场景中应用的全面回顾,包括学生和教师辅助、自适应学习和各种工具。此外,我们还总结了相关数据集和基准测试,以及当前挑战和未来方向。我们希望我们的调查能够促进并激发教育领域LLMs的更多创新工作。

相关文章:

论文翻译:Large Language Models for Education: A Survey and Outlook

https://arxiv.org/abs/2403.18105 目录 教育领域的大型语言模型:一项调查和展望摘要1. 引言2. 教育应用中的LLM2.1 概述2.2 学习辅助2.2.1 问题解决(QS) 2.2.2 错误纠正(EC)2.2.3 困惑助手(CH)…...

)

python为什么慢?(自用)

《Cython系列》1. Cython 是什么?为什么要有 Cython?为什么我们要用 Cython? - 古明地盆 - 博客园 (cnblogs.com) 古明地盆的主页 - 博客园 (cnblogs.com) 我原本认为,python慢的原因是“逐行解释程序并执行”,那么我…...

压缩感知3——重构算法正交匹配追踪算法

算法流程 问题的实质是:AX Y 求解(A是M维,Y是N维且N>>M并且稀疏度K<M)明显X有无穷多解,重构过程是M次采样得到的采样值升维的过程。OMP算法的具体步骤:(1)用X表示信号,初始化残差e0 …...

“好物”推荐+Xshell连接实例+使用Conda创建独立的Python环境

目录 主题:好易智算平台推荐RTX 4090DGPU实例租用演示安装配置torch1.9.1cuda11.1.1环境引言:算力的新时代平台介绍:技术与信任的结晶使用案例:实际使用展示创建实例开始使用连接实例(下文演示使用Xshell连接ÿ…...

浪潮天启防火墙TQ2000远程配置方法SSL-V偏、L2xx 配置方法

前言 本次设置只针对配置V偏,其他防火墙配置不涉及。建议把防火墙内外网都调通后再进行V偏配置。 其他配置可参考:浪潮天启防火墙配置手册 配置SSLVxx 在外网端口开启SSLVxx信息 开启SSLVxx功能 1、勾选 “启用SSL-Vxx” 2、设置登录端口号࿰…...

java八股文面试题

Java八股文面试题通常涵盖了Java语言的基础知识、高级特性、框架应用、数据库操作等多个方面。以下是一些常见的Java面试题及其详细回答,按照不同的主题进行分类: 一、Java基础 面向对象的特征有哪些? 抽象:忽略与当前目标无关的…...

【服务器】在Linux查看运行的Python程序,并找到特定的Python程序

在Linux查看运行的Python程序并找到特定的Python程序 写在最前面1. 使用ps命令查看所有Python进程查看详细信息 2. 使用pgrep命令查找Python进程ID 3. 使用top或htop命令使用top命令使用htop命令 4. 使用lsof命令查找Python进程打开的文件 5. 使用nvidia-smi命令查看GPU使用情况…...

安全防御---防火墙实验1

安全防御—防火墙实验1 一、实验拓扑与要求 要求: 1、DMZ区内的服务器,办公区仅能在办公时间内(9:00-18:00)可以访问,生产区的设备全天可以访问 2、生产区不允许访问互联网,办公区和游客区允许访问互联网 …...

SpringBoot配置Swagger开启页面访问限制

在Spring Boot项目中配置Swagger时,开启页面访问限制通常意味着你希望控制哪些用户或角色可以访问Swagger UI文档页面。由于Swagger UI是一个静态资源,它本身并不直接支持基于角色的访问控制(RBAC)。但是,你可以通过Sp…...

前端代码基本逻辑-vue3

前端vue建立过程 安装nodejs 官网下载安装,并且记住安装路径,记得配置系统变量Path 安装VUE/CLI npm install -g vue/cli --全局安装vue 使用VUE/CLI生成代码框架 vue create your-project-name --我的your-project-name为web 运行项目 cd your-…...

怎么用PPT录制微课?详细步骤解析!

随着信息技术的不断发展,微课作为一种新型的教学形式,因其短小精悍、针对性强等特点,在教育领域得到了广泛的应用。而PPT作为一款常用的演示工具,不仅可以用来制作课件,还可以利用其内置的录屏功能或结合专业的录屏软件…...

Git使用方法

Git是一种分布式版本控制系统,它可以记录和管理软件开发过程中的变更。 Git的基本概念包括以下几个部分: 仓库(Repository):Git用仓库来存储项目的代码和历史记录。一个仓库可以包含多个分支。 分支(Bran…...

HTTP的请求报文和响应报文是怎样的,有哪些常见字段?

http报文分为请求报文和响应报文 请求报文包含:请求行、请求头、空行、、请求体 请求行包含: 方法:即要执行的操作,如get,post、put、delet 资源路径:请求的资源的URL HTTP版本:使用的http协议…...

自注意力简介

在注意力机制中,每个查询都会关注所有的键值对并生成一个注意力输出。如果查询q,键k和值v都来自于同一组输入,那么这个注意力就被称为是自注意力(self-attention)。自注意力这部分理论,我觉得台大李宏毅老师…...

【GameFramework框架】7-2、GameFramework框架是否“过度设计”?

推荐阅读 CSDN主页GitHub开源地址Unity3D插件分享简书地址QQ群:398291828大家好,我是佛系工程师☆恬静的小魔龙☆,不定时更新Unity开发技巧,觉得有用记得一键三连哦。 一、前言 【GameFramework框架】系列教程目录: https://blog.csdn.net/q764424567/article/details/1…...

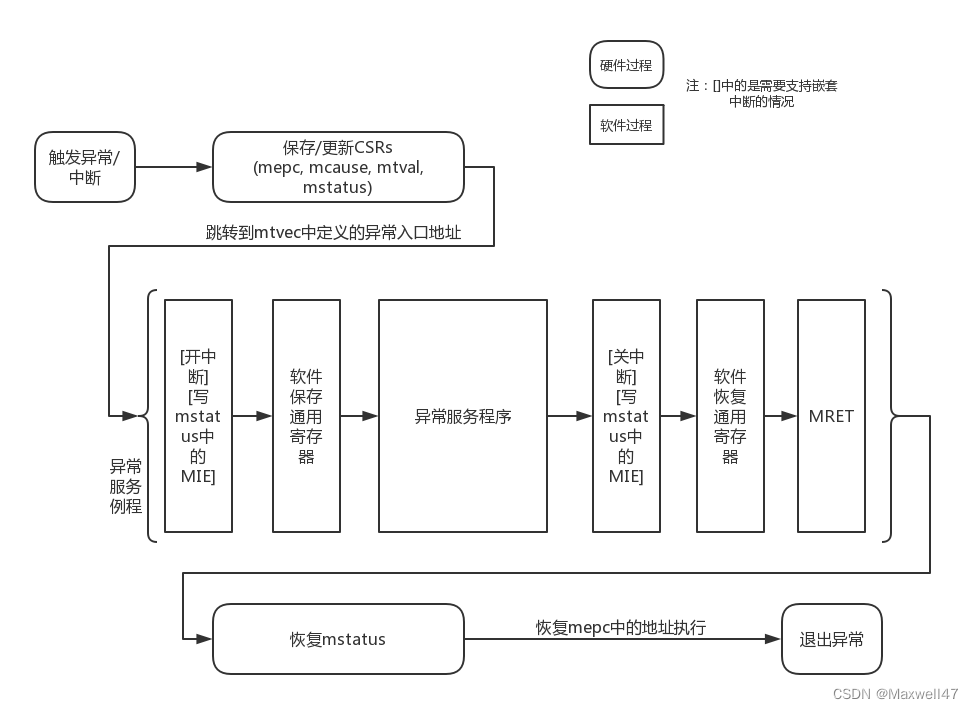

RISC-V异常处理流程概述(2):异常处理机制

RISC-V异常处理流程概述(2):异常处理机制 一、异常处理流程和异常委托1.1 异常处理流程1.2 异常委托二、RISC-V异常处理中软件相关内容2.1 异常处理准备工作2.2 异常处理函数2.3 Opensbi系统调用的注册一、异常处理流程和异常委托 1.1 异常处理流程 发生异常时,首先需要执…...

Unity3D中如何降低游戏的Drawcall详解

在Unity3D游戏开发中,Drawcall是一个至关重要的性能指标,它指的是CPU通知GPU绘制一个物体的命令次数。过多的Drawcall会导致游戏性能下降,因此优化Drawcall的数量是提高游戏性能的关键。本文将详细介绍Unity3D中降低Drawcall的几种主要方法&a…...

小程序-设置环境变量

在实际开发中,不同的开发环境,调用的接口地址是不一样的 例如:开发环境需要调用开发版的接口地址,生产环境需要正式版的接口地址 这时候,我们就可以使用小程序提供了 wx.getAccountInfoSync() 接口,用来获取…...

【RabbitMQ】一文详解消息可靠性

目录: 1.前言 2.生产者 3.数据持久化 4.消费者 5.死信队列 1.前言 RabbitMQ 是一款高性能、高可靠性的消息中间件,广泛应用于分布式系统中。它允许系统中的各个模块进行异步通信,提供了高度的灵活性和可伸缩性。然而,这种通…...

RuntimeError: Unexpected error from cudaGetDeviceCount

RuntimeError: Unexpected error from cudaGetDeviceCount 0. 引言1. 临时解决方法 0. 引言 使用 vllm-0.4.2 部署时,多卡正常运行。升级到 vllm-0.5.1 时,报错如下: (VllmWorkerProcess pid30692) WARNING 07-12 08:16:22 utils.py:562] U…...

使用VSCode开发Django指南

使用VSCode开发Django指南 一、概述 Django 是一个高级 Python 框架,专为快速、安全和可扩展的 Web 开发而设计。Django 包含对 URL 路由、页面模板和数据处理的丰富支持。 本文将创建一个简单的 Django 应用,其中包含三个使用通用基本模板的页面。在此…...

智慧工地云平台源码,基于微服务架构+Java+Spring Cloud +UniApp +MySql

智慧工地管理云平台系统,智慧工地全套源码,java版智慧工地源码,支持PC端、大屏端、移动端。 智慧工地聚焦建筑行业的市场需求,提供“平台网络终端”的整体解决方案,提供劳务管理、视频管理、智能监测、绿色施工、安全管…...

【开发技术】.Net使用FFmpeg视频特定帧上绘制内容

目录 一、目的 二、解决方案 2.1 什么是FFmpeg 2.2 FFmpeg主要功能 2.3 使用Xabe.FFmpeg调用FFmpeg功能 2.4 使用 FFmpeg 的 drawbox 滤镜来绘制 ROI 三、总结 一、目的 当前市场上有很多目标检测智能识别的相关算法,当前调用一个医疗行业的AI识别算法后返回…...

Mysql中select查询语句的执行过程

目录 1、介绍 1.1、组件介绍 1.2、Sql执行顺序 2、执行流程 2.1. 连接与认证 2.2. 查询缓存 2.3. 语法解析(Parser) 2.4、执行sql 1. 预处理(Preprocessor) 2. 查询优化器(Optimizer) 3. 执行器…...

R语言速释制剂QBD解决方案之三

本文是《Quality by Design for ANDAs: An Example for Immediate-Release Dosage Forms》第一个处方的R语言解决方案。 第一个处方研究评估原料药粒径分布、MCC/Lactose比例、崩解剂用量对制剂CQAs的影响。 第二处方研究用于理解颗粒外加硬脂酸镁和滑石粉对片剂质量和可生产…...

日常一水C

多态 言简意赅:就是一个对象面对同一事件时做出的不同反应 而之前的继承中说过,当子类和父类的函数名相同时,会隐藏父类的同名函数转而调用子类的同名函数,如果要调用父类的同名函数,那么就需要对父类进行引用&#…...

webpack面试题

面试题:webpack介绍和简单使用 一、webpack(模块化打包工具)1. webpack是把项目当作一个整体,通过给定的一个主文件,webpack将从这个主文件开始找到你项目当中的所有依赖文件,使用loaders来处理它们&#x…...

【Redis】Redis从入门到实战:全面指南

Redis从入门到实战:全面指南 一、Redis简介 Redis(Remote Dictionary Server)是一个开源的、基于内存的键值存储系统,它可以用作数据库、缓存和消息代理。由Salvatore Sanfilippo于2009年开发,因其高性能、丰富的数据结构和广泛的语言支持而广受欢迎。 Redis核心特点:…...

华为云Flexus+DeepSeek征文 | MaaS平台避坑指南:DeepSeek商用服务开通与成本控制

作者简介 我是摘星,一名专注于云计算和AI技术的开发者。本次通过华为云MaaS平台体验DeepSeek系列模型,将实际使用经验分享给大家,希望能帮助开发者快速掌握华为云AI服务的核心能力。 目录 作者简介 前言 一、技术架构概览 1.1 整体架构设…...

python打卡day47

昨天代码中注意力热图的部分顺移至今天 知识点回顾: 热力图 作业:对比不同卷积层热图可视化的结果 import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import D…...