【人工智能】全景解析:【机器学习】【深度学习】从基础理论到应用前景的【深度探索】

目录

1. 人工智能的基本概念

1.1 人工智能的定义与发展

1.1.1 人工智能的定义

1.1.2 人工智能的发展历史

1.2 人工智能的分类

1.2.1 弱人工智能

1.2.2 强人工智能

1.2.3 超人工智能

1.3 人工智能的关键组成部分

1.3.1 数据

1.3.2 算法

1.3.3 计算能力

2. 机器学习基础

2.1 机器学习的定义与工作原理

2.1.1 定义

2.1.2 工作原理

2.1.3 机器学习的类型

2.2 监督学习

2.2.1 定义

2.2.2 分类任务

2.4.3 强化学习的应用

3.1.2 DNN的工作原理

3.1.3 DNN的应用

3.2.2 CNN的工作原理

3.2.3 CNN的应用

3.3.2 RNN的工作原理

3.3.3 RNN的应用

3.4.2 GAN的工作原理

3.4.3 GAN的应用

5.1.2 偏见与歧视

5.1.3 决策透明性

5.2 人工智能的社会影响

5.2.1 AI对就业的影响

5.2.2 数字鸿沟

6. 未来展望与总结

6.1 AI的技术趋势与挑战

6.1.1 自监督学习

6.1.2 量子计算与AI

6.2 人工智能与人类的未来关系

6.2.1 共生发展

6.2.2 伦理框架的建立

6.3 结论

2.2.3 回归任务

2.3 无监督学习

2.3.1 定义

2.3.2 聚类任务

2.3.3 降维任务

2.4 强化学习

2.4.1 定义

2.4.2 强化学习的基本概念

3. 深度学习:人工智能的核心

3.1 深度神经网络(DNN)

3.1.1 定义与结构

3.2 卷积神经网络(CNN)

3.2.1 定义与结构

3.3 递归神经网络(RNN)

3.3.1 定义与结构

3.4 生成对抗网络(GAN)

3.4.1 定义与结构

4. 人工智能的应用案例

4.1 医疗领域

4.1.1 医疗影像分析

4.2 自动驾驶

4.2.1 自动驾驶技术

4.3 金融领域

4.3.1 金融市场预测

4.4 教育领域

4.4.1 个性化教育

5. 人工智能的伦理与社会影响

5.1 人工智能的伦理问题

5.1.1 隐私问题

前几天偶然发现了一个超棒的人工智能学习网站,内容通俗易懂,讲解风趣幽默,简直让人欲罢不能。忍不住分享给大家,点击这里立刻跳转,开启你的AI学习之旅吧!

前言 – 人工智能教程

https://www.captainbed.cn/lzx

1. 人工智能的基本概念

1.1 人工智能的定义与发展

1.1.1 人工智能的定义

- 人工智能(AI) 是计算机科学的一个分支,旨在创造智能机器,能够模仿和执行类似人类的智能任务。AI涵盖了广泛的子领域,包括机器学习、自然语言处理、计算机视觉和机器人学。

1.1.2 人工智能的发展历史

- 早期历史:20世纪40年代和50年代,人工智能作为一个学术研究领域开始发展。图灵测试是AI概念的早期代表。

- 60年代到80年代:AI研究逐步细化,出现了基于规则的专家系统,如DENDRAL和MYCIN。

- 90年代到2000年代:随着计算能力和数据量的增加,机器学习开始成为AI研究的核心。

- 2010年代到现在:深度学习的兴起推动了人工智能的发展,使得AI在图像识别、自然语言处理等领域取得了突破性进展。

1.2 人工智能的分类

1.2.1 弱人工智能

- 定义:弱人工智能(Narrow AI)指的是专注于特定任务的AI系统,这些系统没有通用智能,无法超出其设计范围执行任务。

- 实例:语音助手(如Siri、Alexa)只能在特定范围内执行任务,如设置闹钟、播放音乐等。

1.2.2 强人工智能

- 定义:强人工智能(General AI)是指具有通用智能的AI系统,能够理解、学习、适应和执行任何智能任务,类似于人类。

- 挑战:目前强人工智能仍然处于理论阶段,其实现面临诸多技术和伦理挑战。

1.2.3 超人工智能

- 定义:超人工智能(Superintelligent AI)是一种假设中的AI,其智能水平超过最聪明的人类。这种AI可能在所有领域(包括科学、艺术、技术等)中表现出超凡的智能。

- 伦理问题:超人工智能引发了关于AI安全性、控制权和道德影响的重大讨论。

1.3 人工智能的关键组成部分

1.3.1 数据

- 重要性:数据是人工智能的基础,AI系统需要大量的数据来训练模型,以实现准确的预测和决策。

- 数据处理:包括数据收集、清洗、特征提取和数据增强等步骤。

- 实例:在训练语音识别系统时,系统需要成千上万小时的音频数据以及对应的文本数据进行训练。

1.3.2 算法

- 定义:算法是AI系统进行学习和推理的核心。不同类型的算法适用于不同的任务,如分类、回归、聚类等。

- 常见算法:线性回归、决策树、支持向量机、神经网络等。

- 实例:在分类任务中,使用支持向量机算法可以有效地将数据点分为不同的类别。

1.3.3 计算能力

- 硬件支持:高效的AI计算需要强大的计算资源,如GPU、TPU等。计算能力的提升直接推动了AI算法的复杂性和模型的精度。

- 实例:深度学习中的大规模神经网络训练通常需要数天甚至数周的时间,并需要使用数百个GPU并行处理。

2. 机器学习基础

2.1 机器学习的定义与工作原理

2.1.1 定义

- 机器学习(ML) 是人工智能的一个子领域,它使得计算机能够从数据中自动学习,并在没有明确编程的情况下进行预测或决策。机器学习的核心在于模型的训练与推理。

2.1.2 工作原理

- 模型训练:通过输入数据(特征)和输出标签(目标),模型学习如何将输入映射到输出。这个过程通过优化算法(如梯度下降)来最小化预测误差。

- 模型验证:使用独立的数据集来验证模型的性能,避免过拟合。

- 模型测试:在全新数据上测试模型,以评估其泛化能力。

2.1.3 机器学习的类型

- 监督学习:基于已知输入和输出对进行训练。

- 无监督学习:使用未标注的数据寻找模式和结构。

- 半监督学习:结合少量标注数据和大量未标注数据进行训练。

- 强化学习:通过与环境的交互学习最佳策略。

2.2 监督学习

2.2.1 定义

- 监督学习 是一种机器学习类型,模型通过学习输入数据和输出标签之间的关系,来预测新的输入数据的输出。

2.2.2 分类任务

2.4.3 强化学习的应用

3.1.2 DNN的工作原理

3.1.3 DNN的应用

3.2.2 CNN的工作原理

3.2.3 CNN的应用

3.3.2 RNN的工作原理

3.3.3 RNN的应用

3.4.2 GAN的工作原理

3.4.3 GAN的应用

5.1.2 偏见与歧视

5.1.3 决策透明性

5.2 人工智能的社会影响

5.2.1 AI对就业的影响

5.2.2 数字鸿沟

6. 未来展望与总结

6.1 AI的技术趋势与挑战

6.1.1 自监督学习

6.1.2 量子计算与AI

6.2 人工智能与人类的未来关系

6.2.1 共生发展

6.2.2 伦理框架的建立

6.3 结论

- 任务说明:分类任务的目标是将输入数据分为离散的类别。

- 算法:K近邻(KNN)、决策树、支持向量机(SVM)等。

- 实例:使用鸢尾花数据集进行分类,代码示例如下:

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.neighbors import KNeighborsClassifier from sklearn.metrics import accuracy_score# 加载数据集 iris = load_iris() X = iris.data y = iris.target# 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建KNN分类器 knn = KNeighborsClassifier(n_neighbors=3) knn.fit(X_train, y_train)# 进行预测 y_pred = knn.predict(X_test)# 计算准确率 accuracy = accuracy_score(y_test, y_pred) print(f"分类准确率: {accuracy * 100:.2f}%")2.2.3 回归任务

- 任务说明:回归任务的目标是预测连续的输出值。

- 算法:线性回归、岭回归、决策树回归等。

- 实例:使用房价预测模型,代码示例如下:

import numpy as np import matplotlib.pyplot as plt from sklearn.linear_model import LinearRegression from sklearn.model_selection import train_test_split# 模拟数据 np.random.seed(0) X = 2 * np.random.rand(100, 1) y = 4 + 3 * X + np.random.randn(100, 1)# 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 创建线性回归模型 model = LinearRegression() model.fit(X_train, y_train)# 进行预测 y_pred = model.predict(X_test)# 绘制结果 plt.scatter(X_test, y_test, color='black') plt.plot(X_test, y_pred, color='blue', linewidth=3) plt.show()2.3 无监督学习

2.3.1 定义

- 无监督学习 是一种机器学习类型,模型在没有标注数据的情况下,通过识别数据中的模式和结构进行学习。

-

2.3.2 聚类任务

- 任务说明:聚类任务的目标是将数据点分组,使得同一组的数据点在某种意义上彼此相似。

- 算法:K-means、层次聚类、DBSCAN等。

- 实例:使用K-means聚类分析,代码示例如下:

from sklearn.datasets import make_blobs from sklearn.cluster import KMeans import matplotlib.pyplot as plt# 生成模拟数据 X, _ = make_blobs(n_samples=300, centers=4, cluster_std=0.60, random_state=0)# 使用KMeans聚类 kmeans = KMeans(n_clusters=4) kmeans.fit(X) y_kmeans = kmeans.predict(X)# 绘制聚类结果 plt.scatter(X[:, 0], X[:, 1], c=y_kmeans, s=50, cmap='viridis') centers = kmeans.cluster_centers_ plt.scatter(centers[:, 0], centers[:, 1], c='red', s=200, alpha=0.75) plt.show()2.3.3 降维任务

- 任务说明:降维任务的目标是将高维数据映射到低维空间,保留尽可能多的有用信息。

- 算法:主成分分析(PCA)、t-SNE等。

- 实例:使用PCA进行降维,代码示例如下:

from sklearn.decomposition import PCA from sklearn.datasets import load_iris import matplotlib.pyplot as plt# 加载数据集 iris = load_iris() X = iris.data y = iris.target# 使用PCA降维 pca = PCA(n_components=2) X_pca = pca.fit_transform(X)# 绘制降维结果 plt.scatter(X_pca[:, 0], X_pca[:, 1], c=y) plt.xlabel('First Principal Component') plt.ylabel('Second Principal Component') plt.show()2.4 强化学习

2.4.1 定义

- 强化学习 是一种通过与环境的交互来学习策略的机器学习方法。智能体通过试探和错误来最大化长期累积奖励。

-

2.4.2 强化学习的基本概念

- 智能体:做出决策的主体。

- 环境:智能体所处的外部世界,提供反馈信号。

- 案例说明:在游戏AI中,智能体通过不断尝试找到击败对手的最佳策略。

- 实例:使用OpenAI Gym和Q-learning进行CartPole游戏的强化学习,代码示例如下:

- 奖励:环境对智能体行动的评价,通常是数值形式。

- 策略:智能体根据环境状态选择行动的规则。

import gym import numpy as npenv = gym.make('CartPole-v1') n_actions = env.action_space.n n_states = env.observation_space.shape[0]q_table = np.zeros((n_states, n_actions)) learning_rate = 0.1 discount_factor = 0.99 epsilon = 1.0 epsilon_decay = 0.99 episodes = 1000for episode in range(episodes):state = env.reset()done = Falsewhile not done:if np.random.rand() < epsilon:action = np.random.choice(n_actions)else:action = np.argmax(q_table[state])next_state, reward, done, _ = env.step(action)best_next_action = np.argmax(q_table[next_state])q_table[state, action] += learning_rate * (reward + discount_factor * q_table[next_state, best_next_action] - q_table[state, action])state = next_stateepsilon *= epsilon_decayprint("训练完成!")

3. 深度学习:人工智能的核心

3.1 深度神经网络(DNN)

3.1.1 定义与结构

- 深度神经网络(DNN) 是由多个层次的神经元组成的神经网络模型,每一层的输出作为下一层的输入。其核心思想是通过多层抽象提取数据中的高级特征。

- 结构:输入层、隐藏层、输出层。每一层中的神经元通过加权求和、激活函数和反向传播算法进行学习和优化。

- 前向传播:输入数据通过网络层层传播,产生输出。

- 案例说明:DNN广泛应用于图像识别、语音识别、自然语言处理等领域。

- 实例:使用TensorFlow构建一个简单的DNN模型进行手写数字识别(MNIST数据集),代码示例如下:

- 反向传播:通过计算误差并将其反向传播到各个层,更新权重,以最小化误差。

- 损失函数:衡量预测结果与真实结果之间的差异,常用的有均方误差(MSE)、交叉熵等。

import tensorflow as tf from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.datasets import mnist from tensorflow.keras.utils import to_categorical# 加载数据集 (X_train, y_train), (X_test, y_test) = mnist.load_data() X_train = X_train.reshape(60000, 784).astype('float32') / 255 X_test = X_test.reshape(10000, 784).astype('float32') / 255 y_train = to_categorical(y_train, 10) y_test = to_categorical(y_test, 10)# 创建DNN模型 model = Sequential([Dense(128, activation='relu', input_shape=(784,)),Dense(64, activation='relu'),Dense(10, activation='softmax') ])# 编译模型 model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])# 训练模型 model.fit(X_train, y_train, epochs=10, batch_size=32, validation_data=(X_test, y_test))3.2 卷积神经网络(CNN)

3.2.1 定义与结构

- 卷积神经网络(CNN) 是一种特殊的神经网络,主要用于处理具有网格结构的数据,如图像。CNN通过卷积层提取局部特征,并通过池化层减少计算量和防止过拟合。

- 结构:卷积层、池化层、全连接层。卷积层通过滤波器对输入数据进行卷积操作,池化层通过降采样减少数据维度,全连接层用于输出最终分类结果。

- 卷积操作:通过多个滤波器扫描输入数据,并生成特征图。

- 案例说明:CNN在图像分类、目标检测、语义分割等任务中表现卓越,广泛应用于自动驾驶、医疗影像分析等领域。

- 实例:使用Keras构建一个简单的CNN模型进行CIFAR-10图像分类,代码示例如下:

- 池化操作:通过最大池化或平均池化缩减特征图的尺寸,减少计算复杂度。

- 全连接层:将卷积和池化后的特征图展平成一维向量,并通过全连接层进行分类。

from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense from tensorflow.keras.datasets import cifar10 from tensorflow.keras.utils import to_categorical# 加载数据集 (X_train, y_train), (X_test, y_test) = cifar10.load_data() X_train = X_train.astype('float32') / 255 X_test = X_test.astype('float32') / 255 y_train = to_categorical(y_train, 10) y_test = to_categorical(y_test, 10)# 创建CNN模型 model = Sequential([Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),MaxPooling2D(pool_size=(2, 2)),Conv2D(64, (3, 3), activation='relu'),MaxPooling2D(pool_size=(2, 2)),Flatten(),Dense(64, activation='relu'),Dense(10, activation='softmax') ])# 编译模型 model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])# 训练模型 model.fit(X_train, y_train, epochs=10, batch_size=32, validation_data=(X_test, y_test))3.3 递归神经网络(RNN)

3.3.1 定义与结构

- 递归神经网络(RNN) 是一种用于处理序列数据的神经网络模型,它在输入序列中的每一个元素上都施加相同的操作,并将先前的计算结果作为下一次计算的输入。

- 结构:RNN包含一个隐藏层状态,它在时间步之间共享参数,使得模型能够处理序列数据的时间依赖性。

- 时间步:RNN在每个时间步上对输入数据进行处理,并更新隐藏状态。

- 案例说明:RNN在自然语言处理、时间序列预测、语音识别等任务中表现出色。

- 实例:使用TensorFlow构建一个简单的RNN模型进行文本情感分析,代码示例如下:

- 序列处理:RNN能够通过时间步的循环处理整个序列,并在最后一个时间步生成输出。

import tensorflow as tf from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Embedding, SimpleRNN, Dense from tensorflow.keras.datasets import imdb from tensorflow.keras.preprocessing import sequence# 加载数据集 max_features = 10000 maxlen = 500 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=max_features) X_train = sequence.pad_sequences(X_train, maxlen=maxlen) X_test = sequence.pad_sequences(X_test, maxlen=maxlen)# 创建RNN模型 model = Sequential([Embedding(max_features, 32),SimpleRNN(32),Dense(1, activation='sigmoid') ])# 编译模型 model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])# 训练模型 model.fit(X_train, y_train, epochs=10, batch_size=32, validation_data=(X_test, y_test))3.4 生成对抗网络(GAN)

3.4.1 定义与结构

- 生成对抗网络(GAN) 由一个生成器和一个判别器组成,通过两个网络之间的对抗学习,使生成器能够生成以假乱真的数据。

- 结构:生成器负责生成数据,判别器负责区分真实数据和生成数据。

- 序列处理:RNN能够通过时间步的循环处理整个序列,并在最后一个时间步生成输出。

- 对抗训练:生成器生成数据,并通过判别器判断其真实性。生成器通过误导判别器逐渐提高生成数据的质量。

- 案例说明:GAN广泛应用于图像生成、图像修复、风格迁移等领域。

- 实例:使用PyTorch构建一个简单的GAN模型生成手写数字图像,代码示例如下:

- 生成器与判别器的平衡:训练的目标是使生成器生成的数据难以被判别器识别为假数据。

import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader# 数据处理 transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))]) mnist = datasets.MNIST(root='./data', train=True, download=True, transform=transform) dataloader = DataLoader(mnist, batch_size=64, shuffle=True)# 生成器模型 class Generator(nn.Module):def __init__(self):super(Generator, self).__init__()self.main = nn.Sequential(nn.Linear(100, 256),nn.ReLU(True),nn.Linear(256, 512),nn.ReLU(True),nn.Linear(512, 1024),nn.ReLU(True),nn.Linear(1024, 28*28),nn.Tanh())def forward(self, x):return self.main(x).view(-1, 1, 28, 28)# 判别器模型 class Discriminator(nn.Module):def __init__(self):super(Discriminator, self).__init__()self.main = nn.Sequential(nn.Linear(28*28, 1024),nn.LeakyReLU(0.2, inplace=True),nn.Linear(1024, 512),nn.LeakyReLU(0.2, inplace=True),nn.Linear(512, 256),nn.LeakyReLU(0.2, inplace=True),nn.Linear(256, 1),nn.Sigmoid())def forward(self, x):return self.main(x.view(-1, 28*28))# 初始化模型 generator = Generator() discriminator = Discriminator()# 损失函数和优化器 criterion = nn.BCELoss() optimizer_g = optim.Adam(generator.parameters(), lr=0.0002) optimizer_d = optim.Adam(discriminator.parameters(), lr=0.0002)# 训练GAN for epoch in range(100):for i, (real_images, _) in enumerate(dataloader):# 训练判别器optimizer_d.zero_grad()real_labels = torch.ones(real_images.size(0), 1)fake_labels = torch.zeros(real_images.size(0), 1)real_outputs = discriminator(real_images)d_loss_real = criterion(real_outputs, real_labels)d_loss_real.backward()z = torch.randn(real_images.size(0), 100)fake_images = generator(z)fake_outputs = discriminator(fake_images)d_loss_fake = criterion(fake_outputs, fake_labels)d_loss_fake.backward()optimizer_d.step()# 训练生成器optimizer_g.zero_grad()z = torch.randn(real_images.size(0), 100)fake_images = generator(z)fake_outputs = discriminator(fake_images)g_loss = criterion(fake_outputs, real_labels)g_loss.backward()optimizer_g.step()print(f'Epoch [{epoch+1}/100], d_loss: {d_loss_real.item() + d_loss_fake.item()}, g_loss: {g_loss.item()}')

4. 人工智能的应用案例

-

4.1 医疗领域

4.1.1 医疗影像分析

- 背景:AI在医疗影像分析中的应用显著提高了诊断准确率。通过深度学习模型,AI可以检测X光片、CT扫描中的异常,辅助医生诊断疾病。

- 案例说明:利用卷积神经网络(CNN)分析肺癌CT影像。

- 实例:使用TensorFlow进行肺癌影像分析,代码示例如下:

# 省略的代码用于数据加载和预处理,后续构建和训练CNN模型 # 模型结构与前述CNN示例类似,但数据集和目标任务不同4.2 自动驾驶

4.2.1 自动驾驶技术

- 背景:自动驾驶汽车依赖于AI技术来感知环境、规划路径和执行驾驶操作。卷积神经网络(CNN)和强化学习(RL)在自动驾驶系统中起到了关键作用。

- 案例说明:使用深度强化学习训练自动驾驶智能体。

- 实例:使用OpenAI Gym进行自动驾驶模拟,代码示例如下:

# 省略的代码用于定义和训练深度Q网络(DQN)模型,自动驾驶任务环境为CarRacing-v04.3 金融领域

4.3.1 金融市场预测

- 背景:AI通过分析历史数据和市场趋势,可以预测股票价格、识别交易机会。机器学习模型如LSTM在处理时间序列数据方面表现出色。

- 案例说明:利用LSTM模型预测股票价格。

- 实例:使用TensorFlow进行股票价格预测,代码示例如下:

# 省略的代码用于加载时间序列数据、构建和训练LSTM模型4.4 教育领域

4.4.1 个性化教育

- 背景:AI在教育中的应用包括个性化学习路径推荐、学生表现预测等。通过数据分析,AI可以为学生提供量身定制的学习计划。

- 案例说明:使用机器学习预测学生考试成绩。

- 实例:使用Scikit-learn进行学生成绩预测,代码示例如下:

# 省略的代码用于数据加载、特征工程和模型训练

5. 人工智能的伦理与社会影响

5.1 人工智能的伦理问题

5.1.1 隐私问题

- 讨论:AI技术的广泛应用带来了严重的隐私问题,如数据收集、监控和个人信息的滥用。如何在保护隐私的同时发挥AI的潜力是一个重大挑战。

- 实例:面部识别技术在公共场所的应用,引发了关于隐私保护的争议。

- 生成器与判别器的平衡:训练的目标是使生成器生成的数据难以被判别器识别为假数据。

- 讨论:AI系统中的偏见和歧视问题广受关注,特别是在决策系统中,如招聘、贷款审批等。AI模型可能因训练数据中的偏见而做出不公平的决策。

- 实例:银行贷款审批系统中的种族偏见问题。

- 讨论:AI决策过程的黑箱问题使得结果难以解释,尤其是在深度学习模型中。这引发了对AI决策透明性的呼吁,要求提高模型的可解释性。

- 实例:医疗AI系统中的决策透明性问题。

- 讨论:AI自动化技术可能导致某些岗位的失业,同时也会创造新的工作机会。如何应对AI对就业市场的冲击是一个重要的社会议题。

- 实例:自动化生产线对制造业就业的影响。

- 讨论:AI技术的迅速发展可能加剧数字鸿沟,使得技术资源丰富的群体与资源匮乏的群体之间的差距进一步扩大。

- 实例:发展中国家与发达国家在AI技术应用上的差距。

- 背景:自监督学习是一种无需大量标注数据的学习方法,近年来在自然语言处理和计算机视觉领域取得了显著进展。

- 讨论:自监督学习模型如BERT、SimCLR的成功,以及它们在减少数据依赖方面的潜力。

- 背景:量子计算具有极大的计算潜力,可能会彻底改变AI领域。量子计算能够快速解决经典计算难以处理的问题,如大规模优化、模拟和加密。

- 讨论:量子计算在机器学习中的应用前景,以及当前的技术挑战。

- 背景:随着AI技术的发展,强人工智能的安全问题成为关注的焦点。如何保证AI技术的安全性和可控性,是实现强人工智能的前提。

- 讨论:AI安全领域的前沿研究,包括AI伦理、控制论和技术监管。

- 讨论:AI技术应与人类社会共生发展,创造协同增效的局面。通过合理设计和管理,AI可以成为增强人类能力的工具,而不是替代人类的威胁。

- 实例:人机协作系统在制造业中的应用。

- 讨论:建立全球一致的AI伦理框架,以确保AI技术的发展符合人类社会的价值观和利益。

- 实例:欧盟提出的AI伦理准则及其全球影响。

- 总结:人工智能作为当今科技领域的前沿,正在迅速改变各行各业。尽管AI带来了前所未有的机遇,但也伴随着重大挑战。人类社会需要在推动AI技术发展的同时,谨慎应对其可能带来的风险和问题。

- 展望:未来,随着技术的进一步成熟和完善,AI将以更智能、更安全的方式融入人类生活,推动社会进步和人类福祉。

相关文章:

【人工智能】全景解析:【机器学习】【深度学习】从基础理论到应用前景的【深度探索】

目录 1. 人工智能的基本概念 1.1 人工智能的定义与发展 1.1.1 人工智能的定义 1.1.2 人工智能的发展历史 1.2 人工智能的分类 1.2.1 弱人工智能 1.2.2 强人工智能 1.2.3 超人工智能 1.3 人工智能的关键组成部分 1.3.1 数据 1.3.2 算法 1.3.3 计算能力 2. 机器学习…...

MySQL与PostgreSQL语法区别

1. 数据类型差异 a. 整型 ● MySQL中的text数据类型最大存储容量为64KB,PostgreSQL中的text类型没有此限制。 ● MySQL中使用tinyint、mediumint和int表示不同大小的整数,PostgreSQL使用smallint、int和bigint。 b. 浮点数类型 ● MySQL提供了float和…...

vue2+OpenLayers 天地图上凸显出当前地理位置区域(4)

凸显出当前区域 需要当前地方的json数据 这个可以在阿里的这个阿里 看下效果图 遮盖层的逃命都是可以调的 引入 下面一段代码 import sx from "/views/json/sx1.json"; // 下载的json import GeoJSON from "ol/format/GeoJSON"; // ol的一些方法 imp…...

基于Python、Django开发Web计算器

1、创建项目 创建Django项目参照https://blog.csdn.net/qq_42148307/article/details/140798249,其中项目名为compute,并在该项目下创建一个名为app的应用,并且进行基本的配置。 2、导入Bootstrap前端框架 Bootstrap的使用参照https://blo…...

高性能并行计算面试-核心概念-问题理解

目录 1.什么是并行计算?高性能从哪些方面体现? 2.CPU常见的并行技术 3.GPU并行 4.并发与并行 5.常见的并行计算模型 6.如何评估并行程序的性能? 7.描述Am达尔定律和Gustafson定律,并解释它们对并行计算性能的影响 8.并行计…...

java-activiti笔记

版本:activiti7 <dependency><groupId>org.activiti</groupId><artifactId>activiti-json-converter</artifactId><version>7.0.0.Beta2</version><exclusions><exclusion><groupId>org.mybatis</g…...

Layui——隐藏表单项后不再进行验证

目录 修改后的部分代码 修改后的完整代码 我编辑用户信息和添加新用户用的是同一个表单,不同的是编辑用户信息里没有密码项和确认密码项,但是把它们隐藏后仍然要进行验证,也就是说它们俩的验证并没有随着表单项的隐藏而关闭。原因…...

Github Copilot 使用技巧

🎯目标读者 本文不包含如何安装 Github Copilot本文介绍了 Github Copilot 使用方法和一些技巧 本人已经使用 Github Copilot 2 年了,交了 3 次年费,每年 100$ 着实心痛,但是用着确实爽歪歪 但是感觉一直只用了一小部分功能&am…...

【实现100个unity特效之20】用unity实现物品悬浮和发光像素粒子特效

最终效果 文章目录 最终效果新增飞升粒子效果光圈效果修改不同颜色完结 新增飞升粒子效果 效果 光圈效果 效果 修改不同颜色 完结 赠人玫瑰,手有余香!如果文章内容对你有所帮助,请不要吝啬你的点赞评论和关注,你的每一次支持…...

GPT-4o mini发布,轻量级大模型如何颠覆AI的未来?

从巨无霸到小巨人:GPT-4o Mini的创新之路 ©作者|潇潇 来源|神州问学 引言 随着人工智能技术的飞速进步,AI领域的竞争日益激烈,大型模型的发布几乎成为常态。然而,这些庞大的模型通常需要大量的计算资源和存储空间ÿ…...

高性能的 C++ Web 开发框架 CPPCMS + WebSocket 模拟实现聊天与文件传输案例。

1. 项目结构 2. config.json {"service": {"api": "http","port": 8080,"ip": "0.0.0.0"},"http": {"script": "","static": "/static"} }3. CMakeLists.txt…...

合合信息OCR支持30类国内常见票据一站式分类识别,支持医疗发票、数电票识别

合合信息TextIn平台明星产品——国内通用票据识别,重磅更新! 产品支持票据类型扩展到23大类、30小类,覆盖场景更全面,同时升级优化了多款票据识别模型,平均识别率较前版本提升11.5%,整体识别速度提升21.9%…...

LeetCode-day40-3151. 特殊数组 I

LeetCode-day40-3151. 特殊数组 I 题目描述示例示例1:示例2:示例3: 思路代码 题目描述 如果数组的每一对相邻元素都是两个奇偶性不同的数字,则该数组被认为是一个 特殊数组 。 Aging 有一个整数数组 nums。如果 nums 是一个 特殊…...

技术研究:Redis 数据结构与 I/O 模型

数据结构 Redis之所以“快”,一方面因为它是内存数据库,所有操作都在内存上完成,内存的访问速度本来就快。另一方面则是因为高效的数据结构,使得操作键值效率较高。总体来说,Redis使用了一个用来保存每个Key/Value的全…...

46-扇孔的处理及铺铜以及布线

1.先连信号线 2.电源管脚,以如下方式处理: 引线打孔处理...

LVS实验的三模式总结

文章目录 LVS的概念叙述NAT工作模式实战案例**思想:**NAT工作模式的优点NAT工作模式的缺点 NAT工作模式的应用场景大致配置 route:打开路由内核功能 部署DR模式集群案例工作思想:大致工作图如下思路模型 具体配置与事实步骤补充 防火墙标签解…...

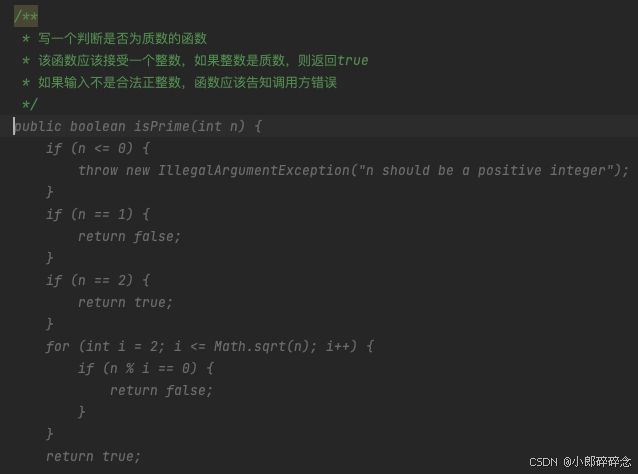

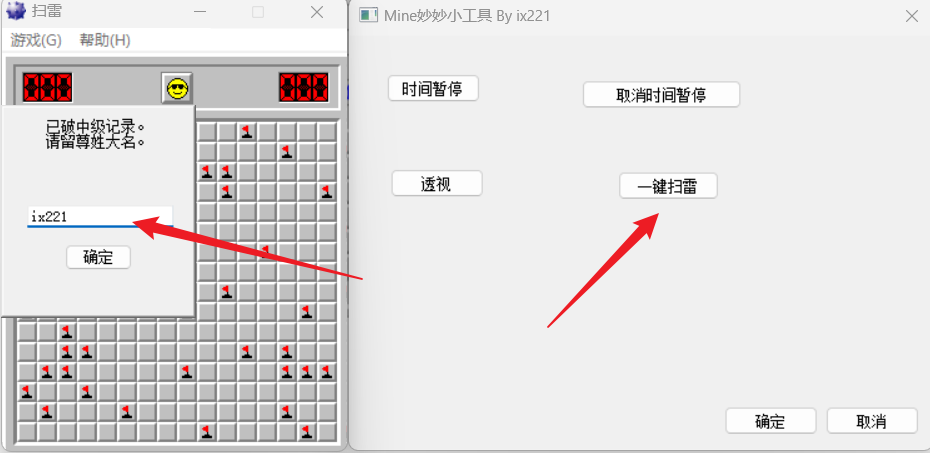

游戏安全入门-扫雷分析远程线程注入

前言 无论学习什么,首先,我们应该有个目标,那么入门windows游戏安全,脑海中浮现出来的一个游戏 – 扫雷,一款家喻户晓的游戏,虽然已经被大家分析的不能再透了,但是我觉得自己去分析一下还是极好…...

bert-base-chinese模型的完整训练、推理和一些思考

前言 使用google-bert/bert-base-chinese模型进行中文文本分类任务,使用THUCNews中文数据集进行训练,训练完成后,可以导出模型,进行预测。 项目详细介绍和数据下载 数据集下载地址 Github完整代码 现记录训练过程中的一些感悟…...

)

JS基础5(JS的作用域和JS预解析)

JS的作用域 1. 全局作用域 全局作用域是在代码的任何地方都能访问到的最外层作用域。在浏览器环境下,全局作用域就是window对象,因此所有在全局作用域中声明的变量和函数都会成为window对象的属性和方法。 var globalVar "I am global"; …...

)

Doris 夺命 30 连问!(中)

导言 抱歉,作为从 S2 开始的骨灰级玩家看到 EDGUZI 官宣首发上线,兴奋之余忘了写文档 - -||,还望各位看官老爷见谅,这次错了,下次还敢 ^_^ 这是继上次的 30 问上篇的中篇,也是 10 个问题,有些…...

以下是对华为 HarmonyOS NETX 5属性动画(ArkTS)文档的结构化整理,通过层级标题、表格和代码块提升可读性:

一、属性动画概述NETX 作用:实现组件通用属性的渐变过渡效果,提升用户体验。支持属性:width、height、backgroundColor、opacity、scale、rotate、translate等。注意事项: 布局类属性(如宽高)变化时&#…...

Debian系统简介

目录 Debian系统介绍 Debian版本介绍 Debian软件源介绍 软件包管理工具dpkg dpkg核心指令详解 安装软件包 卸载软件包 查询软件包状态 验证软件包完整性 手动处理依赖关系 dpkg vs apt Debian系统介绍 Debian 和 Ubuntu 都是基于 Debian内核 的 Linux 发行版ÿ…...

最新SpringBoot+SpringCloud+Nacos微服务框架分享

文章目录 前言一、服务规划二、架构核心1.cloud的pom2.gateway的异常handler3.gateway的filter4、admin的pom5、admin的登录核心 三、code-helper分享总结 前言 最近有个活蛮赶的,根据Excel列的需求预估的工时直接打骨折,不要问我为什么,主要…...

)

postgresql|数据库|只读用户的创建和删除(备忘)

CREATE USER read_only WITH PASSWORD 密码 -- 连接到xxx数据库 \c xxx -- 授予对xxx数据库的只读权限 GRANT CONNECT ON DATABASE xxx TO read_only; GRANT USAGE ON SCHEMA public TO read_only; GRANT SELECT ON ALL TABLES IN SCHEMA public TO read_only; GRANT EXECUTE O…...

中关于正整数输入的校验规则)

Element Plus 表单(el-form)中关于正整数输入的校验规则

目录 1 单个正整数输入1.1 模板1.2 校验规则 2 两个正整数输入(联动)2.1 模板2.2 校验规则2.3 CSS 1 单个正整数输入 1.1 模板 <el-formref"formRef":model"formData":rules"formRules"label-width"150px"…...

《C++ 模板》

目录 函数模板 类模板 非类型模板参数 模板特化 函数模板特化 类模板的特化 模板,就像一个模具,里面可以将不同类型的材料做成一个形状,其分为函数模板和类模板。 函数模板 函数模板可以简化函数重载的代码。格式:templa…...

08. C#入门系列【类的基本概念】:开启编程世界的奇妙冒险

C#入门系列【类的基本概念】:开启编程世界的奇妙冒险 嘿,各位编程小白探险家!欢迎来到 C# 的奇幻大陆!今天咱们要深入探索这片大陆上至关重要的 “建筑”—— 类!别害怕,跟着我,保准让你轻松搞…...

多模态图像修复系统:基于深度学习的图片修复实现

多模态图像修复系统:基于深度学习的图片修复实现 1. 系统概述 本系统使用多模态大模型(Stable Diffusion Inpainting)实现图像修复功能,结合文本描述和图片输入,对指定区域进行内容修复。系统包含完整的数据处理、模型训练、推理部署流程。 import torch import numpy …...

【p2p、分布式,区块链笔记 MESH】Bluetooth蓝牙通信 BLE Mesh协议的拓扑结构 定向转发机制

目录 节点的功能承载层(GATT/Adv)局限性: 拓扑关系定向转发机制定向转发意义 CG 节点的功能 节点的功能由节点支持的特性和功能决定。所有节点都能够发送和接收网格消息。节点还可以选择支持一个或多个附加功能,如 Configuration …...

电脑桌面太单调,用Python写一个桌面小宠物应用。

下面是一个使用Python创建的简单桌面小宠物应用。这个小宠物会在桌面上游荡,可以响应鼠标点击,并且有简单的动画效果。 import tkinter as tk import random import time from PIL import Image, ImageTk import os import sysclass DesktopPet:def __i…...