离线数据开发流程小案例-图书馆业务数据

参考

https://blog.csdn.net/m53931422/article/details/103633452

https://www.cnblogs.com/jasonlam/p/7928179.html

https://cwiki.apache.org/confluence/display/Hive/LanguageManual+UDF

https://medium.com/@jackgoettle23/building-a-hive-user-defined-function-f6abe92f6e56

https://blog.csdn.net/qq_73339471/article/details/140763754

https://blog.csdn.net/cuichunchi/article/details/109772461

https://blog.csdn.net/weixin_35852328/article/details/86509506

https://cn.vuejs.org/

https://element.eleme.cn/#/zh-CN

https://echarts.apache.org/zh/index.html

https://spring.io/

https://baomidou.com/

本文的视频版本:https://www.bilibili.com/video/BV1itYLe1E8y,讲解更详细

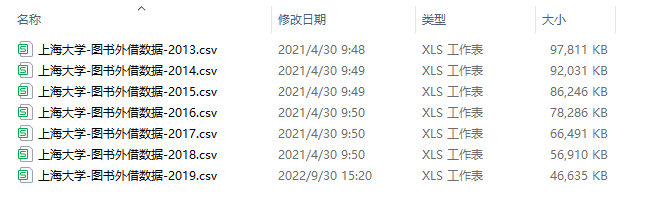

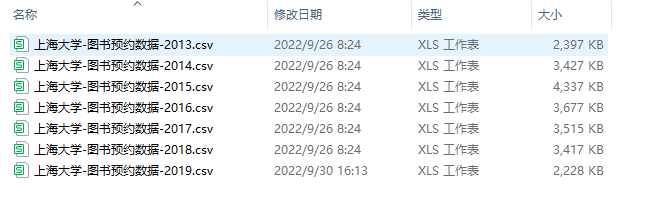

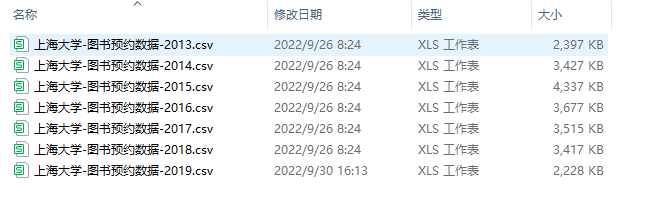

数据

| 图书外借数据 | 图书预约数据 | 读者入馆数据 | ||||||

|---|---|---|---|---|---|---|---|---|

| 字段 | 说明 | 备注 | 字段 | 说明 | 备注 | 字段 | 说明 | 备注 |

| UNIVERSITY_ID | 学校代码 | 10280 | UNIVERSITY_ID | 学校代码 | UNIVERSITY_ID | 学校代码 | 10280 | |

| PATRON_ID | 读者ID | PATRON_ID | 读者ID | PATRON_ID | 读者ID | |||

| STUDENT_GRADE | 学生年级 | STUDENT_GRADE | 学生年级 | STUDENT_GRADE | 学生年级 | |||

| PATRON_DEPT | 读者所在院系 | PATRON_DEPT | 读者所在院系 | PATRON_DEPT | 读者所在院系 | |||

| PATRON_TYPE | 读者类型 | PATRON_TYPE | 读者类型 | PATRON_TYPE | 读者类型 | |||

| LOAN_DATE | 外借日期 | 20130422 | OPEN_DATE | 预约日期 | 20131231 | VISIT_TIME | 入馆时间 | 2013-03-2520:54:42 |

| LOAN_HOUR | 外借时间 | 1506 | OPEN_HOUR | 预约时间 | 1015 | VISIT_SUBLIBRARY | 入馆地点 | 01、02、03、04 - 宝山校区 |

| 05、06 - 延长校区 | ||||||||

| 07、08、09 - 嘉定校区 | ||||||||

| DUE_DATE | 到期日期 | 20130522 | REQUEST_DATE | 预约兴趣期开始日期 | 20131231 | VISIT_TYPE | 出馆/入馆 | 无该字段 |

| DUE_HOUR | 到期时间 | 2400 | END_REQUEST_DATE | 预约兴趣期结束日期 | 20140228 | |||

| RETURNED_DATE | 归还日期 | 20130427 | HOLD_DATE | 预约满足日期 | 20140102 | |||

| RETURNED_HOUR | 归还时间 | 1512 | END_HOLD_DATE | 预约保留日期 | 20140109 | |||

| RETURNED_LOCATION | 归还地点 | 无该字段 | RECALL_STATUS | 预约催还状态 | 无该字段 | |||

| RENEWAL_NO | 续借次数 | RECALL_DATE | 催还日期 | 无该字段 | ||||

| LASTRENEW_DATE | 最后续借日期 | PROCESSING_DAYS | 满足时间长度 | 无该字段 | ||||

| RECALL_DATE | 催还日期 | EVENT_TYPE | 预约类型 | 无该字段 | ||||

| RECALL_DUE_DATE | 催还后应还日期 | FULFILLED | 预约需求是否满足 | Y - 等待中 | ||||

| N - 已满足 | ||||||||

| HOLD_DAYS | 外借天数 | 无该字段 | PICKUP_LOCATION | 取书点 | 详见附录1 | |||

| OVERDUE_DAYS | 逾期天数 | 无该字段 | SUBLIBRARY | 图书所在分馆/馆藏地 | 详见附录1 | |||

| SUBLIBRARY | 图书所在分馆/馆藏地 | 详见附录1 | ITEM_ID | 单册唯一记录号 | ||||

| ITEM_ID | 单册唯一记录号 | ITEM_STATUS | 单册状态 | 详见附录2 | ||||

| ITEM_STATUS | 单册状态 | 详见附录2 | ITEM_CALLNO | 单册索书号 | ||||

| ITEM_CALLNO | 单册索书号 | PUBLISH_YEAR | 图书出版年 | |||||

| PUBLISH_YEAR | 图书出版年 | AUTHOR | 图书作者 | |||||

| AUTHOR | 图书作者 | TITLE | 图书题名 | |||||

| TITLE | 图书题名 | PRESS | 图书出版社 | |||||

| PRESS | 图书出版社 | ISBN | 图书ISBN号 | |||||

| ISBN | ISBN号 | ID | 自动生成序号,主键 | |||||

| ID | 自动生成序号,主键 |

共 1.25G

共 512MB

共 22.4 MB

乱码和字段乱序缺失

2019 年的外借数据的字符集为非 UTF-8,

在 Linux 上:

[jxd@102 lend_out]$ file -i lend_out_2019.csv

lend_out_2019.csv: text/plain; charset=unknown-8bitvim 文件后,:set fileencoding=utf-8 设置文件的编码[jxd@102 lend_out]$ file -i lend_out_2019.csv

lend_out_2019.csv: text/plain; charset=utf-8

发现没有解决,不是 Linux 上的乱码,经过排查,其它所有文件在 windows 环境下都为 utf-8 格式,这个文件为 GB2312 编码,使用 notepad++ 打开,设置编码为 utf-8,拷贝全文,新建一个 csv 文件,粘贴,新的 csv 文件的格式就为 utf-8 了。

2019 年外借数据存在缺失 id 字段、字段乱序的情况,导入到 MySQL 中,添加 id 字段,并置为 null (id 字段没有用),以新的字段顺序查询并将依据结果创建新表,再将数据导出为 csv 即可。

2019 年预约数据存在字段乱序情况,用上面的方法处理即可。

csv 的表头问题

每一个 csv 文件的表头都是字段名,导入到 Hive 中会被当作数据,需要删除,在 Linux 中,使用如下命令删除文件的第一行:

sed -i '1d' <fileName>

建表以及加载数据

create database shanghai_edu location '/warehouse/shanghai_edu';// 创建时间维度表

CREATE EXTERNAL TABLE `dim_date`

(`date_key` STRING COMMENT 'id',`date_ymd` STRING COMMENT '日期 yy-MM-dd',`date_ch` STRING COMMENT '中文日期',`dim_year` STRING COMMENT '年',`quarter_id` TINYINT COMMENT '季度数字',`quarter_ch` STRING COMMENT '中文季度',`year_month` STRING comment '年月',`dim_month` STRING comment '月份',`dim_day` STRING COMMENT '一年中的第几天',`dim_month_day` STRING COMMENT '一个月中的第几天',`dim_week` STRING COMMENT '一年中的第几周 星期一是星期的第一天',`year_week` STRING COMMENT '年周',`dim_week1` STRING COMMENT '一年中的第几周 星期天是星期的第一天',`dim_year1` STRING COMMENT '对应 dim_week1 的年份',`dim_weekday` STRING COMMENT '一周的中的第几天',`weekday_ch` STRING COMMENT '星期几',`holiday_name` STRING COMMENT '节假日名称',`is_day_off` TINYINT COMMENT '是否放假 1表示放假,0表示不放假 2表示调班'

) COMMENT '时间维度表'ROW FORMAT SERDE 'org.apache.hadoop.hive.serde2.OpenCSVSerde'location '/warehouse/shanghai_edu/dim/dim_date';load data local inpath '/opt/project/shanghai_edu/data/dim/dim_date.csv' into table shanghai_edu.dim_date;// 创建分场馆维度表

CREATE EXTERNAL TABLE if not exists shanghai_edu.dim_sub_library

(`sub_library_or_pickup_location` STRING COMMENT 'sub_library 或 pickup_location',`sub_library_location_name` STRING COMMENT '分场馆所在地址'

) COMMENT '分场馆维度表'

STORED AS PARQUET

LOCATION '/warehouse/shanghai_edu/dim/dim_sub_library';

// 创建一张存储格式为 csv 的临时表

CREATE TABLE shanghai_edu.csv_table

(sub_library_or_pickup_location STRING,sub_library_location_name STRING

)

ROW FORMAT DELIMITEDFIELDS TERMINATED BY ','LINES TERMINATED BY '\n'

STORED AS TEXTFILE;

// 将数据导入到临时表

load data local inpath '/opt/project/shanghai_edu/data/dim/dim_sublibrary.csv' into table shanghai_edu.csv_table;

INSERT overwrite TABLE shanghai_edu.dim_sub_library

SELECT * FROM shanghai_edu.csv_table;

drop table shanghai_edu.csv_table;// 创建入馆表

CREATE external table `ods_enter`

(`university_id` varchar(100) comment '学校代码 10280',`patron_id` varchar(100) comment '读者ID',`student_grade` varchar(100) comment '学生年级',`patron_dept` varchar(100) comment '读者所在院系',`patron_type` varchar(100) comment '读者类型',`visit_time` varchar(100) comment '入馆时间',`visit_sub_library` varchar(100) comment '入馆地点'

)COMMENT '入馆表'partitioned by (`year` string)ROW FORMAT SERDE 'org.apache.hadoop.hive.serde2.OpenCSVSerde'WITH SERDEPROPERTIES ("separatorChar" = ",","quoteChar" = "\"","escapeChar" = "\\")location '/warehouse/shanghai_edu/ods/ods_enter';load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2013.csv' into table shanghai_edu.ods_enter partition (year = '2013');

load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2014.csv' into table shanghai_edu.ods_enter partition (year = '2014');

load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2015.csv' into table shanghai_edu.ods_enter partition (year = '2015');

load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2016.csv' into table shanghai_edu.ods_enter partition (year = '2016');

load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2017.csv' into table shanghai_edu.ods_enter partition (year = '2017');

load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2018.csv' into table shanghai_edu.ods_enter partition (year = '2018');

load data local inpath '/opt/project/shanghai_edu/data/enter/enter_2019.csv' into table shanghai_edu.ods_enter partition (year = '2019');// 创建外借表

CREATE external TABLE `ods_lend_out`

(`university_id` varchar(100) comment '学校代码 10280',`item_id` varchar(100) comment '单册唯一记录号',`loan_date` varchar(100) comment '外借日期',`sub_library` varchar(100) comment '图书所在分馆/馆藏地',`due_date` varchar(100) comment '到期日期',`loan_hour` varchar(100) comment '外借时间',`due_hour` varchar(100) comment '到期时间',`returned_date` varchar(100) comment '归还日期',`item_status` varchar(100) comment '单册状态',`returned_hour` varchar(100) comment '归还时间',`last_renew_date` varchar(100) comment '最后续借日期',`renewal_no` varchar(100) comment '续借次数',`recall_date` varchar(100) comment '催还日期',`item_call_no` varchar(100) comment '单册索书号',`recall_due_date` varchar(100) comment '催还后应还日期',`author` varchar(100) comment '图书作者',`publish_year` varchar(100) comment '图书出版年',`press` varchar(100) comment '图书出版社',`title` varchar(100) comment '图书题名',`ISBN` varchar(100) comment 'isbn',`patron_id` varchar(100) comment '读者ID',`patron_type` varchar(100) comment '读者类型',`student_grade` varchar(100) comment '学生年级',`id` varchar(100) comment 'id',`patron_dept` varchar(100) comment '读者所在院系'

)COMMENT '外借表'partitioned by (`year` string)ROW FORMAT SERDE 'org.apache.hadoop.hive.serde2.OpenCSVSerde'WITH SERDEPROPERTIES ("separatorChar" = ",","quoteChar" = "\"","escapeChar" = "\\")location '/warehouse/shanghai_edu/ods/ods_lend_out';load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2013.csv' into table shanghai_edu.ods_lend_out partition (year = '2013');

load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2014.csv' into table shanghai_edu.ods_lend_out partition (year = '2014');

load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2015.csv' into table shanghai_edu.ods_lend_out partition (year = '2015');

load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2016.csv' into table shanghai_edu.ods_lend_out partition (year = '2016');

load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2017.csv' into table shanghai_edu.ods_lend_out partition (year = '2017');

load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2018.csv' into table shanghai_edu.ods_lend_out partition (year = '2018');

load data local inpath '/opt/project/shanghai_edu/data/lend_out/lend_out_2019.csv' into table shanghai_edu.ods_lend_out partition (year = '2019');// 创建预约表

CREATE external table ods_subscribe

(`university_id` varchar(100) comment '学校代码 10280',`open_date` varchar(100) comment '预约日期',`open_hour` varchar(100) comment '预约时间',`end_request_date` varchar(100) comment '预约兴趣期结束日期',`request_date` varchar(100) comment '预约兴趣期开始日期',`end_hold_date` varchar(100) comment '预约保留日期',`hold_date` varchar(100) comment '预约满足日期',`pickup_location` varchar(100) comment '取书点',`item_status` varchar(100) comment '单册状态',`sub_library` varchar(100) comment '图书所在分馆/馆藏地',`fulfilled` varchar(100) comment '预约需求是否满足',`item_call_no` varchar(100) comment '单册索书号',`item_id` varchar(100) comment '单册唯一记录号',`author` varchar(100) comment '图书作者',`publish_year` varchar(100) comment '图书出版年',`press` varchar(100) comment '图书出版社',`title` varchar(100) comment '图书题名',`ISBN` varchar(100) comment '图书 ISBN 号',`patron_id` varchar(100) comment '读者 ID',`patron_type` varchar(100) comment '读者类型',`student_grade` varchar(100) comment '学生年级',`id` varchar(100) comment 'id',`patron_dept` varchar(100) comment '读者所在院系'

) COMMENT '预约表'partitioned by (`year` string)ROW FORMAT SERDE 'org.apache.hadoop.hive.serde2.OpenCSVSerde'WITH SERDEPROPERTIES ("separatorChar" = ",","quoteChar" = "\"","escapeChar" = "\\")location '/warehouse/shanghai_edu/ods/ods_subscribe';load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2013.csv' into table shanghai_edu.ods_subscribe partition (year = '2013');

load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2014.csv' into table shanghai_edu.ods_subscribe partition (year = '2014');

load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2015.csv' into table shanghai_edu.ods_subscribe partition (year = '2015');

load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2016.csv' into table shanghai_edu.ods_subscribe partition (year = '2016');

load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2017.csv' into table shanghai_edu.ods_subscribe partition (year = '2017');

load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2018.csv' into table shanghai_edu.ods_subscribe partition (year = '2018');

load data local inpath '/opt/project/shanghai_edu/data/subscribe/subscribe_2019.csv' into table shanghai_edu.ods_subscribe partition (year = '2019');

使用 SQL 分析数据

外借次数、外借时间和用户类型的关系

CREATE EXTERNAL TABLE if not exists shanghai_edu.adm_lo_cnt_time_with_type_dd

(`patron_type` STRING COMMENT '读者类型',`lend_out_cnt` bigint COMMENT '借出数',`avg_lend_out_cnt` double comment '平均借出数',`min_duration` double comment '最小借出时间',`avg_duration` double comment '平均借出时间',`max_duration` double comment '最大借出时间'

) COMMENT '外借次数、外借时间和用户类型的关系'STORED AS PARQUETLOCATION '/warehouse/shanghai_edu/adm/adm_lo_cnt_time_with_type_dd';insert overwrite table shanghai_edu.adm_lo_cnt_time_with_type_dd

select patron_type, count(*) lend_out_cnt, round(count(*) / count(DISTINCT (patron_id)), 2) avg_lend_out_cnt, round(min((unix_timestamp(returned_date, 'yyyyMMdd') - unix_timestamp(loan_date, 'yyyyMMdd')) /(60 * 60 * 24)), 2) min_duration -- 单位为天, round(AVG((unix_timestamp(returned_date, 'yyyyMMdd') - unix_timestamp(loan_date, 'yyyyMMdd')) /(60 * 60 * 24)), 2) avg_duration, round(MAX((unix_timestamp(returned_date, 'yyyyMMdd') - unix_timestamp(loan_date, 'yyyyMMdd')) /(60 * 60 * 24)), 2) max_duration

from shanghai_edu.ods_lend_out

group by patron_type;

入馆次数、预约次数和读者类型的关系

CREATE EXTERNAL TABLE if not exists shanghai_edu.adm_ent_subscribe_cnt_with_type

(`patron_type` STRING COMMENT '读者类型',`enter_cnt` bigint COMMENT '总入馆次数/预约次数',`avg_lend_out_cnt` double comment '平均入馆次数/平均预约次数'

) COMMENT '入馆次数、预约次数和读者类型的关系'partitioned by (stat_type STRING COMMENT '统计类型(enter/subscribe)')STORED AS PARQUETLOCATION '/warehouse/shanghai_edu/adm/adm_ent_subscribe_cnt_with_type';set hive.exec.dynamic.partition.mode=nonstrict;

insert overwrite table shanghai_edu.adm_ent_subscribe_cnt_with_type partition (stat_type)

select patron_type,count(*) enter_cnt,round(count(*) / count(DISTINCT (patron_id)), 2) avg_enter_cnt,'enter' stat_type

from shanghai_edu.ods_enter

group by patron_type

union all

select patron_type,count(*) sub_cnt,round(count(*) / count(DISTINCT (patron_id)), 2) avg_sub_cnt,'subscribe' stat_type

from shanghai_edu.ods_subscribe

group by patron_type

;

各分馆各年份的预约不满足率

CREATE EXTERNAL TABLE if not exists shanghai_edu.adm_subscribe_no_satisfy_lib_year_stat

(`no_fulfilled_ratio` double COMMENT '预约不满足率',`sub_library_location_name` string COMMENT '分馆位置',`subscribe_year` string comment '预约年份'

) COMMENT '各分馆各年份的预约不满足率统计表'STORED AS PARQUETLOCATION '/warehouse/shanghai_edu/adm/adm_subscribe_no_satisfy_lib_year_stat';insert overwrite table shanghai_edu.adm_subscribe_no_satisfy_lib_year_stat

select round(sum(if(fulfilled = '不满足', 1, 0)) / count(1), 4) no_fulfilled_ratio, sub_library_location_name, subscribe_year

from (// @formatter:offselectCASEWHEN fulfilled = 'N' THEN '不满足'WHEN fulfilled = 'Y' THEN '满足'ELSE '不知道'END AS fulfilled,coalesce(b.sub_library_location_name, '-') sub_library_location_name,coalesce(substr(open_date, 1, 4), '-') subscribe_yearfrom shanghai_edu.ods_subscribe aleft join shanghai_edu.dim_sub_library bon a.sub_library = b.sub_library_or_pickup_location// @formatter:on) tb_tmp

GROUP BY sub_library_location_name, subscribe_year

with cube;

预约不到的 top10 书籍

CREATE EXTERNAL TABLE if not exists shanghai_edu.adm_subscribe_no_satisfy_top

(`ISBN` string COMMENT 'isbn',`cnt` bigint COMMENT '预约不到次数'

) COMMENT '预约不到的 top10 书籍'STORED AS PARQUETLOCATION '/warehouse/shanghai_edu/adm/adm_subscribe_no_satisfy_top';insert overwrite table shanghai_edu.adm_subscribe_no_satisfy_top

selectISBN,count(1) cnt

from shanghai_edu.ods_subscribe

where fulfilled = 'N' and ISBN != ''

group by ISBN

order by cnt desc

limit 10

;

入馆时间分布

CREATE FUNCTION parseHour AS 'com.jxd.udf.ParseHour' USING JAR 'hdfs:///udf/yelp-udf-1.0-SNAPSHOT.jar';

reload function;

show functions;

drop function if exists formatVisitTime;

DESCRIBE FUNCTION formatVisitTime;CREATE FUNCTION formatVisitTime AS 'com.jxd.udf.FormatVisitTime' USING JAR 'hdfs:///udf/yelp-udf-1.0-SNAPSHOT.jar';CREATE EXTERNAL TABLE if not exists shanghai_edu.adm_enter_time_stat

(`holiday_name` string COMMENT '节日名称',`visit_hour` string COMMENT '入馆时间(小时)',`cnt` bigint comment '入馆数量'

) COMMENT '入馆时间分布统计表'

STORED AS PARQUET

LOCATION '/warehouse/shanghai_edu/adm/adm_enter_time_stat';// @formatter:off

insert overwrite table shanghai_edu.adm_enter_time_stat

select holiday_name, visit_hour, count(1) cnt

from

(select if(b.holiday_name is not null and b.holiday_name != '', b.holiday_name, '非节假日') holiday_name, parseHour(a.visit_time) visit_hourfrom shanghai_edu.ods_enter aleft join shanghai_edu.dim_date b on formatVisitTime(a.visit_time) = b.date_key

) tb_tmp

GROUP BY holiday_name, visit_hour

with cube;

;

hive udf

使用 java 编写一个 hive 的 udf,打包。

将 jar 包上传到 hdfs 上:

hadoop fs -mkdir /udf

hadoop fs -put yelp-udf-1.0-SNAPSHOT.jar /udf/

进入 hive 终端中,使用如下命令创建永久函数:

CREATE FUNCTION upper_case_udf AS 'com.jxd.udf.UpperCaseUDF' USING JAR 'hdfs:///udf/yelp-udf-1.0-SNAPSHOT.jar';

hive 终端当前所处的数据库就是这个函数的默认存放数据库,例如:default,如果是在 default 数据库中创建的 udf,在 default 数据库中使用 udf 就可以不携带数据库前缀,如果是在其他数据库中使用这个函数,就需要使用指定这个函数所在的数据库前缀来使用这个函数,比如:select default.upper_case_udf(‘aaa’);

upper_case_udf 是函数名,com.jxd.udf.UpperCaseUDF 是这个 udf 的类全限定名,最后是 jar 包对应的 hdfs 地址。

可以使用如下命令刷新函数:

RELOAD FUNCTION;

使用如下命令查询某个 udf 的描述:

DESCRIBE FUNCTION <function_name>;

使用如下命令删除函数:

DROP FUNCTION upper_case_udf;

如何在 datagrip 中更新函数:

- 执行删除函数的命令:

DROP FUNCTION upper_case_udf;

- 关闭项目,File -> Close Project

- 重新创建函数

CREATE FUNCTION upper_case_udf AS 'com.jxd.udf.UpperCaseUDF' USING JAR 'hdfs:///udf/yelp-udf-1.0-SNAPSHOT.jar';

导出 hive 数据到 mysql

本次使用 sqoop 将数据导出到 mysql:

bin/sqoop export \

--connect "jdbc:mysql://node112:3306/shanghai_edu?useUnicode=true&characterEncoding=utf-8" \

--username root \

--password 123456 \

--table adm_lo_cnt_time_with_type_dd \

--num-mappers 1 \

--hcatalog-database shanghai_edu \

--hcatalog-table adm_lo_cnt_time_with_type_dd

--hive-partition-key <partition_key> \

--warehouse-dir <hdfs_path_to_hive_table>

导出分区表的所有数据:

bin/sqoop export \

--connect "jdbc:mysql://node112:3306/shanghai_edu?useUnicode=true&characterEncoding=utf-8" \

--username root \

--password 123456 \

--table adm_ent_subscribe_cnt_with_type \

--num-mappers 1 \

--hcatalog-database shanghai_edu \

--hcatalog-table adm_ent_subscribe_cnt_with_type

--hive-partition-key stat_type \

--warehouse-dir /warehouse/shanghai_edu/adm/adm_ent_subscribe_cnt_with_type

问题

windows 上的中文文件名的文件上传到 centos 后变成乱码

原因在于,Windows 的文件名中文编码默认为 GBK,压缩或者上传后,文件名还会是 GBK 编码,而 Linux 中默认文件名编码为 UTF8,由于编码不一致所以导致了文件名乱码的问题,解决这个问题需要对文件名进行转码。

安装 convmv:

yum install convmv

使用 convmv 将当前文件夹下的所有文件名转为 udf-8 编码:

convmv -f gbk -t utf-8 --notest -r ./

相关文章:

离线数据开发流程小案例-图书馆业务数据

参考 https://blog.csdn.net/m53931422/article/details/103633452 https://www.cnblogs.com/jasonlam/p/7928179.html https://cwiki.apache.org/confluence/display/Hive/LanguageManualUDF https://medium.com/jackgoettle23/building-a-hive-user-defined-function-f6abe9…...

GPT-5:未来已来,你准备好了吗

GPT-5:未来已来,你准备好了吗? 在人工智能的浩瀚星空中,自然语言处理(NLP)技术如同璀璨星辰,不断引领着技术革新的浪潮。而在这股浪潮中,OpenAI的GPT(Generative Pre-tr…...

白骑士的Matlab教学高级篇 3.2 并行计算

系列目录 上一篇:白骑士的Matlab教学高级篇 3.1 高级编程技术 并行计算是一种通过同时执行多个计算任务来加速程序运行的方法。在MATLAB中,并行计算工具箱(Parallel Computing Toolbox)提供了丰富的并行计算功能,使用…...

JS中【解构赋值】知识点解读

解构赋值(Destructuring Assignment)是 JavaScript 中一种从数组或对象中提取数据的简便方法,可以将其赋值给变量。这种语法可以让代码更加简洁、清晰。下面我会详细讲解解构赋值的相关知识点。 1. 数组解构赋值 数组解构赋值允许你通过位置…...

【Pyspark-驯化】一文搞懂Pyspark中对json数据处理使用技巧:get_json_object

【Pyspark-驯化】一文搞懂Pyspark中对json数据处理使用技巧:get_json_object 本次修炼方法请往下查看 🌈 欢迎莅临我的个人主页 👈这里是我工作、学习、实践 IT领域、真诚分享 踩坑集合,智慧小天地! 🎇 …...

第10章 无持久存储的文件系统 (1)

目录 前言 10.1 proc文件系统 10.1.1 /proc 内容 本专栏文章将有70篇左右,欢迎关注,查看后续文章。 前言 即存在于内存中的文件系统。如: proc: sysfs: 即/sys目录。 内容不一定是ASCII文本,可能是二进…...

如何把命令行创建python虚拟环境与pycharm项目管理更好地结合起来

1. 问题的提出 我在linux或windows下的某个目录如“X”下使用命令行的方式创建了一个python虚拟环境(参考文章),对应的目录为myvenv, 现在我想使用pycharm创建python项目myproject,并且利用虚拟环境myvenv,怎么办&…...

keepalived+lvs高可用负载均衡集群配置方案

配置方案 一、配置主备节点1. 在主备节点上安装软件2. 编写配置文件3. 启动keepalived服务 二、配置web服务器1. 安装并启动http服务2. 编写主页面3.配置虚拟地址4. 配置ARP 三、测试 服务器IP: 主负载均衡服务器 master 192.168.152.71备负载均衡服务器 backup 192…...

Azure OpenAI Swagger Validation Failure with APIM

题意:Azure OpenAI Swagger 验证失败与 APIM 问题背景: Im converting the Swagger for Azure OpenAI API Version 2023-07-01-preview from json to yaml 我正在将 Azure OpenAI API 版本 2023-07-01-preview 的 Swagger 从 JSON 转换为 YAML。 My S…...

haproxy高级功能配置

介绍HAProxy高级配置及实用案例 一.基于cookie会话保持 cookie value:为当前server指定cookie值,实现基于cookie的会话黏性,相对于基于 source 地址hash 调度算法对客户端的粒度更精准,但同时也加大了haproxy负载,目前此模式使用…...

XXL-JOB分布式定时任务框架快速入门

文章目录 前言定时任务分布式任务调度 1、XXL-JOB介绍1.1 XXL-JOB概述1.2 XXL-JOB特性1.3 整体架构 2、XXL-JOB任务中心环境搭建2.1 XXL-JOB源码下载2.2 IDEA导入xxljob工程2.3 初始化数据库2.4 Docker安装任务管理中心 3、XXL-JOB任务注册测试3.1 引入xxl-job核心依赖3.2 配置…...

直流电机及其驱动

直流电机是一种将电能转换为机械能的装置,有两个电极,当电极正接时,电机正转,当电极反接时,电机反转。 直流电机属于大功率器件,GPIO口无法直接驱动,需要配合电机驱动电路来操作 TB6612是一款双…...

Java-判断一个字符串是否为有效的JSON字符串

在 Java 中判断一个字符串是否为有效的 JSON 字符串,可以使用不同的库来进行验证。常见的库 包括 org.json、com.google.gson 和 com.alibaba.fastjson 等。这里我将展示如何使用 com.alibaba.fastjson 库来实现一个简单的工具类,用于判断给定的字符串…...

FPGA开发板的基本知识及应用

FPGA开发板是一种专门设计用于开发和测试现场可编程门阵列(Field-Programmable Gate Array, FPGA)的硬件平台。FPGA是一种高度可配置的集成电路,能够在制造后被编程以执行各种数字逻辑功能。FPGA开发板通常包含一个FPGA芯片以及一系列支持电路和接口,以便…...

JVM知识总结(性能调优)

文章收录在网站:http://hardyfish.top/ 文章收录在网站:http://hardyfish.top/ 文章收录在网站:http://hardyfish.top/ 文章收录在网站:http://hardyfish.top/ 性能调优 何时进行JVM调优? 遇到以下情况,…...

基于Ascend C的Matmul算子性能优化最佳实践

矩阵乘法是深度学习计算中的基础操作,对于提升模型训练和推理速度至关重要。昇腾AI处理器是一款专门面向AI领域的AI加速器,其AI Core采用达芬奇架构,以高性能Cube计算引擎为基础,针对矩阵运算进行加速,可大幅提高单位面…...

SQL注入之EVAL长度限制突破技巧

要求: PHP Eval函数参数限制在16个字符的情况下 ,如何拿到Webshell? widows小皮环境搭建: 使用phpstudy搭建一个网站。 随后在该eval文件夹下创建一个webshell.php文件,并在其输入代码环境 解题思路: 通…...

稀疏注意力:时间序列预测的局部性和Transformer的存储瓶颈

时间序列预测是许多领域的重要问题,包括对太阳能发电厂发电量、电力消耗和交通拥堵情况的预测。在本文中,提出用Transformer来解决这类预测问题。虽然在我们的初步研究中对其性能印象深刻,但发现了它的两个主要缺点:(1)位置不可知性:规范Tran…...

详谈系统中的环境变量

目录 前言1. 指令背后的本质2. 环境变量背后的本质3. 环境变量到底是什么4. 命令行参数5. 本地变量 与 内置命令6. 环境变量的相关命令 前言 相信在 it 行业学习或者工作的小伙伴们,基本都配置过环境变量(windows环境下),如果你也…...

RAG与LLM原理及实践(11)--- Milvus hybrid search 源码分析及思想

目录 背景 hybrid search 源码分析 WeightedRanker 源码 hybrid search 核心 参数详解 基本入参 扩展入参 aysnc方式代码调用案例 说明 源码逻辑 prepare 调用过程 stub 调用结果 stub 调用过程 blocking 与 async 调用方式 深入内部core weightedRanker 的ch…...

Appium+python自动化(十六)- ADB命令

简介 Android 调试桥(adb)是多种用途的工具,该工具可以帮助你你管理设备或模拟器 的状态。 adb ( Android Debug Bridge)是一个通用命令行工具,其允许您与模拟器实例或连接的 Android 设备进行通信。它可为各种设备操作提供便利,如安装和调试…...

UE5 学习系列(三)创建和移动物体

这篇博客是该系列的第三篇,是在之前两篇博客的基础上展开,主要介绍如何在操作界面中创建和拖动物体,这篇博客跟随的视频链接如下: B 站视频:s03-创建和移动物体 如果你不打算开之前的博客并且对UE5 比较熟的话按照以…...

DIY|Mac 搭建 ESP-IDF 开发环境及编译小智 AI

前一阵子在百度 AI 开发者大会上,看到基于小智 AI DIY 玩具的演示,感觉有点意思,想着自己也来试试。 如果只是想烧录现成的固件,乐鑫官方除了提供了 Windows 版本的 Flash 下载工具 之外,还提供了基于网页版的 ESP LA…...

【配置 YOLOX 用于按目录分类的图片数据集】

现在的图标点选越来越多,如何一步解决,采用 YOLOX 目标检测模式则可以轻松解决 要在 YOLOX 中使用按目录分类的图片数据集(每个目录代表一个类别,目录下是该类别的所有图片),你需要进行以下配置步骤&#x…...

CMake 从 GitHub 下载第三方库并使用

有时我们希望直接使用 GitHub 上的开源库,而不想手动下载、编译和安装。 可以利用 CMake 提供的 FetchContent 模块来实现自动下载、构建和链接第三方库。 FetchContent 命令官方文档✅ 示例代码 我们将以 fmt 这个流行的格式化库为例,演示如何: 使用 FetchContent 从 GitH…...

学校时钟系统,标准考场时钟系统,AI亮相2025高考,赛思时钟系统为教育公平筑起“精准防线”

2025年#高考 将在近日拉开帷幕,#AI 监考一度冲上热搜。当AI深度融入高考,#时间同步 不再是辅助功能,而是决定AI监考系统成败的“生命线”。 AI亮相2025高考,40种异常行为0.5秒精准识别 2025年高考即将拉开帷幕,江西、…...

【生成模型】视频生成论文调研

工作清单 上游应用方向:控制、速度、时长、高动态、多主体驱动 类型工作基础模型WAN / WAN-VACE / HunyuanVideo控制条件轨迹控制ATI~镜头控制ReCamMaster~多主体驱动Phantom~音频驱动Let Them Talk: Audio-Driven Multi-Person Conversational Video Generation速…...

浪潮交换机配置track检测实现高速公路收费网络主备切换NQA

浪潮交换机track配置 项目背景高速网络拓扑网络情况分析通信线路收费网络路由 收费汇聚交换机相应配置收费汇聚track配置 项目背景 在实施省内一条高速公路时遇到的需求,本次涉及的主要是收费汇聚交换机的配置,浪潮网络设备在高速项目很少,通…...

Java毕业设计:WML信息查询与后端信息发布系统开发

JAVAWML信息查询与后端信息发布系统实现 一、系统概述 本系统基于Java和WML(无线标记语言)技术开发,实现了移动设备上的信息查询与后端信息发布功能。系统采用B/S架构,服务器端使用Java Servlet处理请求,数据库采用MySQL存储信息࿰…...

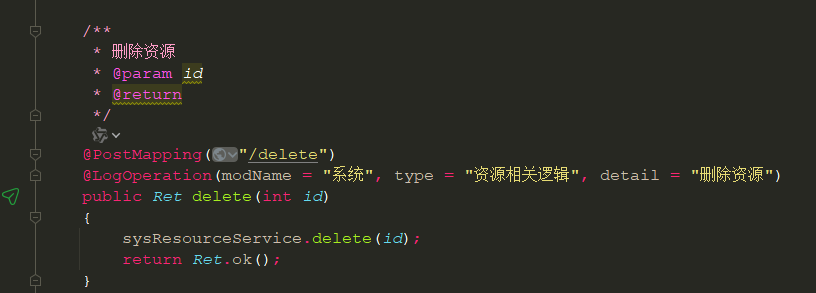

springboot 日志类切面,接口成功记录日志,失败不记录

springboot 日志类切面,接口成功记录日志,失败不记录 自定义一个注解方法 import java.lang.annotation.ElementType; import java.lang.annotation.Retention; import java.lang.annotation.RetentionPolicy; import java.lang.annotation.Target;/***…...