Coppelia Sim (v-REP)仿真 机器人3D相机手眼标定与实时视觉追踪 (二)

coppelia sim[V-REP]仿真实现 机器人于3D相机手眼标定与实时视觉追踪 二

- zmq API接口python调用

- python获取3D相机的数据

- 获取彩色相机的数据

- 获取深度相机的数据

- 用matpolit显示

- python控制机器人运动

- 直接控制轴的位置

- 用IK运动学直接移动到末端姿态

- 相机内参的标定

- 记录拍照点的位置

- 标定板大小的及坐标的设置

- 初始化获取相关的资源句柄

- 机器人运动参数设置

- 进行拍照和内参标定

- 内参标定结果及标定板的姿态显示

- 进行手眼标定

- 参数说明

- 标定结果说明

Coppelia Sim (v-REP)仿真 机器人3D相机手眼标定与实时视觉追踪 (一)

zmq API接口python调用

在官方提供的例子里面已经包含了调用的例子程序,把coppeliasim_zmqremoteapi_client 文件夹拷贝过来就直接可以用

import time

# from zmqRemoteApi import RemoteAPIClient

from coppeliasim_zmqremoteapi_client import RemoteAPIClientdef myFunc(input1, input2):print('Hello', input1, input2)return 21print('Program started')client = RemoteAPIClient()

sim = client.require('sim')# Create a few dummies and set their positions:

handles = [sim.createDummy(0.01, 12 * [0]) for _ in range(50)]

for i, h in enumerate(handles):sim.setObjectPosition(h, -1, [0.01 * i, 0.01 * i, 0.01 * i])# Run a simulation in asynchronous mode:

sim.startSimulation()

while (t := sim.getSimulationTime()) < 3:s = f'Simulation time: {t:.2f} [s] (simulation running asynchronously '\'to client, i.e. non-stepping)'print(s)sim.addLog(sim.verbosity_scriptinfos, s)

python获取3D相机的数据

获取彩色相机的数据

visionSensorHandle = sim.getObject('/UR5/3D_camera')img, [resX, resY] = sim.getVisionSensorImg(visionSensorHandle)img = np.frombuffer(img, dtype=np.uint8).reshape(resY, resX, 3)# In CoppeliaSim images are left to right (x-axis), and bottom to top (y-axis)# (consistent with the axes of vision sensors, pointing Z outwards, Y up)# and color format is RGB triplets, whereas OpenCV uses BGR:img = cv2.flip(cv2.cvtColor(img, cv2.COLOR_BGR2RGB), 0)

获取深度相机的数据

deepSensorHandle = sim.getObject('/UR5/3D_camera/depth')# 获取深度图像Deepdate = sim.getVisionSensorDepth(deepSensorHandle, 1)# 解包为浮点数数组num_floats = Deepdate[1][0] * Deepdate[1][1]depth_data = struct.unpack(f'{num_floats}f', Deepdate[0])# 将数据转为 numpy 数组depth_array = np.array(depth_data)depth_image = depth_array.reshape((Deepdate[1][1], Deepdate[1][0]))depth_image = np.flipud(depth_image)deepcolor = encoding.FloatArrayToRgbImage(depth_image, scale_factor=256*3.5*1000)

用matpolit显示

class ImageStreamDisplay:def __init__(self, resolution):# 创建一个包含两个子图的图形self.fig, (self.ax1, self.ax2) = plt.subplots(1, 2, figsize=(10, 6)) # 1行2列# 设置子图的标题self.ax1.set_title('RGB img')self.ax2.set_title('Depth img')# 初始化两个图像显示对象,使用零数组作为占位符,并设置animated=True以启用动画self.im_display1 = self.ax1.imshow(np.zeros([resolution[1], resolution[0], 3]), animated=True)self.im_display2 = self.ax2.imshow(np.zeros([resolution[1], resolution[0]]), animated=True, cmap='gray', vmin=0, vmax=3.5)# 自动调整子图布局以避免重叠self.fig.tight_layout()# 开启交互模式plt.ion()# 显示图形plt.show()def displayUpdated(self, rgbBuffer1, rgbBuffer2):# 更新两个图像显示对象# 注意:对于imshow,通常使用set_data而不是set_arrayself.im_display1.set_data(rgbBuffer1)self.im_display2.set_data(rgbBuffer2)# plt.colorbar()# 刷新事件并暂停以更新显示self.fig.canvas.flush_events()plt.pause(0.01) # 暂停一小段时间以允许GUI更新display = ImageStreamDisplay([640, 480])display.displayUpdated(img, depth_image)

显示的效果

python控制机器人运动

直接控制轴的位置

def moveToConfig(robotColor, handles, maxVel, maxAccel, maxJerk, targetConf):sim = robotColorcurrentConf = []for i in range(len(handles)):currentConf.append(sim.getJointPosition(handles[i]))params = {}params['joints'] = handlesparams['targetPos'] = targetConfparams['maxVel'] = maxVelparams['maxAccel'] = maxAccelparams['maxJerk'] = maxJerk# one could also use sim.moveToConfig_init, sim.moveToConfig_step and sim.moveToConfig_cleanupsim.moveToConfig(params)

用IK运动学直接移动到末端姿态

def MovetoPose(robothandle, maxVel, maxAccel, maxJerk, targetpost):sim = robothandleparams['ik'] = {'tip': tipHandle, 'target': targetHandle}# params['object'] = targetHandleparams['targetPose'] = targetpostparams['maxVel'] = maxVelparams['maxAccel'] = maxAccelparams['maxJerk'] = maxJerksim.moveToPose(params)

相机内参的标定

记录拍照点的位置

targetjoinPos1 = [0 * math.pi / 180, 45 * math.pi / 180, -60 *math.pi / 180, 0 * math.pi / 180, 90 * math.pi / 180, 0 * math.pi / 180]

targetPos = []targetPos1 = [-0.1100547923916193, -0.01595811170705489, 0.8466254222789784,0.560910589456253, -0.5609503047415633, 0.4305463900323013, 0.43051582116844406]

targetPos2 = [-0.16595811170705488, -0.01595811170705487, 0.8216254222789784,0.5417925804901749, -0.4495188049772251, 0.575726166263469, 0.415852167455231]

targetPos3 = [-0.1100547923916193, -0.01595811170705487, 0.8216254222789784,3.21292597227468e-05, 0.7932742610364036, -0.6088644721541127, 1.7127530004424877e-05]

targetPos4 = [-0.1100547923916193, -0.01595811170705489, 0.9216254222789784,1.4077336111962496e-05, 0.7932754374087434, -0.608862940314109, 1.085602215830202e-05]

targetPos5 = [-0.1100547923916193, -0.015958111707054884, 0.8216254222789784,0.579152193496431, -0.5416388515007398, 0.4546027806731813, 0.40564319680902283]

targetPos6 = [-0.1100547923916193, -0.015958111707054884, 0.8216254222789784,0.5415953148716405, -0.5791980963813808, 0.4056650408034863, 0.45457667640033966]

targetPos7 = [-0.2100547923916193, -0.015958111707054898, 0.8816254222789784,0.5212515544329563, -0.5212938037943111, 0.4777945964218841, 0.47776763259657323]

targetPos8 = [-0.15000547923916193, -0.015958111707054898, 0.8016254222789784,0.5212515544329563, -0.5212938037943111, 0.4777945964218841, 0.47776763259657323]

targetPos9 = [-0.15000547923916193, -0.015958111707054898, 0.8016254222789784,0.5212515544329563, -0.5212938037943111, 0.4777945964218841, 0.47776763259657323]

targetPos10 = [-0.1010000547923916193, -0.015958111707054898, 0.8016254222789784,0.5212515544329563, -0.5212938037943111, 0.4777945964218841, 0.47776763259657323]

targetPos11 = []

targetPos12 = []

targetPos.append(targetPos1)

targetPos.append(targetPos2)

targetPos.append(targetPos3)

targetPos.append(targetPos4)

targetPos.append(targetPos5)

targetPos.append(targetPos6)

targetPos.append(targetPos7)

targetPos.append(targetPos8)

targetPos.append(targetPos9)

targetPos.append(targetPos10)

标定板大小的及坐标的设置

# 设置棋盘格规格(内角点的数量)

chessboard_size = (10, 7)# 3D 世界坐标的点准备(标定板的真实物理尺寸)

square_size = 0.015 # 假设每个格子的边长是15毫米(可以根据实际情况调整)

objp = np.zeros((chessboard_size[0]*chessboard_size[1], 3), np.float32)

objp[:, :2] = np.mgrid[0:chessboard_size[0],0:chessboard_size[1]].T.reshape(-1, 2) * square_size# 储存所有图片的3D点和2D点

objpoints = [] # 3D 点 (真实世界空间坐标)

imgpoints = [] # 2D 点 (图像平面中的点)

robot_poses_R = [] # 10 个旋转矩阵

robot_poses_t = [] # 10 个平移向量

camera_poses_R = [] # 10 个相机的旋转矩阵

camera_poses_t = [] # 10 个相机的平移向量

初始化获取相关的资源句柄

targetHandle = sim.getObject('/UR5/Target')

tipHandle = sim.getObject('/UR5/Tip')

robotHandle = sim.getObject('/UR5')visionSensorHandle = sim.getObject('/UR5/3D_camera')

deepSensorHandle = sim.getObject('/UR5/3D_camera/depth')

chessboardHandle = sim.getObject('/Plane')jointHandles = []

for i in range(6):jointHandles.append(sim.getObject('/UR5/joint', {'index': i}))

机器人运动参数设置

jvel = 310 * math.pi / 180

jaccel = 100 * math.pi / 180

jjerk = 80 * math.pi / 180jmaxVel = [jvel, jvel, jvel, jvel, jvel, jvel]

jmaxAccel = [jaccel, jaccel, jaccel, jaccel, jaccel, jaccel]

jmaxJerk = [jjerk, jjerk, jjerk, jjerk, jjerk, jjerk]vel = 30

accel = 1.0

jerk = 1maxVel = [vel, vel, vel, vel]

maxAccel = [accel, accel, accel, accel]

maxJerk = [jerk, jerk, jerk, jerk]

进行拍照和内参标定

print('------Perform camera calibration------')

# 初始拍照位置

moveToConfig(sim, jointHandles, jmaxVel, jmaxAccel, jmaxJerk, targetjoinPos1)

index = 0

for i in range(10):goalTr = targetPos[i].copy()params = {}params['ik'] = {'tip': tipHandle, 'target': targetHandle}# params['object'] = targetHandleparams['targetPose'] = goalTrparams['maxVel'] = maxVelparams['maxAccel'] = maxAccelparams['maxJerk'] = maxJerksim.moveToPose(params)# 这里是尝试转动角度的# EulerAngles=sim.getObjectOrientation(targetHandle,tipHandle)# # EulerAngles[1]+=15* math.pi / 180# EulerAngles[0]+=25* math.pi / 180# sim.setObjectOrientation(targetHandle,EulerAngles,tipHandle)# goalTr=sim.getObjectPose(targetHandle,robotHandle)# # goalTr[0]=goalTr[1]-0.15# params = {}# params['ik'] = {'tip': tipHandle, 'target': targetHandle}# # params['object'] = targetHandle# params['targetPose'] = goalTr# params['maxVel'] = maxVel# params['maxAccel'] = maxAccel# params['maxJerk'] = maxJerk# sim.moveToPose(params)img, [resX, resY] = sim.getVisionSensorImg(visionSensorHandle)img = np.frombuffer(img, dtype=np.uint8).reshape(resY, resX, 3)# In CoppeliaSim images are left to right (x-axis), and bottom to top (y-axis)# (consistent with the axes of vision sensors, pointing Z outwards, Y up)# and color format is RGB triplets, whereas OpenCV uses BGR:img = cv2.flip(cv2.cvtColor(img, cv2.COLOR_BGR2RGB), 0)# img=cv2.cvtColor(img, cv2.COLOR_BGR2RGB)gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)# 找到棋盘格的角点ret, corners = cv2.findChessboardCorners(gray, chessboard_size, None)# 如果找到角点,添加到点集if ret == True:objpoints.append(objp)imgpoints.append(corners)# 显示角点img = cv2.drawChessboardCorners(img, chessboard_size, corners, ret)# 使用 solvePnP 获取旋转向量和平移向量# ret, rvec, tvec = cv2.solvePnP(objpoints, imgpoints, camera_matrix, dist_coeffs)# 获取深度图像Deepdate = sim.getVisionSensorDepth(deepSensorHandle, 1)# 解包为浮点数数组num_floats = Deepdate[1][0] * Deepdate[1][1]depth_data = struct.unpack(f'{num_floats}f', Deepdate[0])# 将数据转为 numpy 数组depth_array = np.array(depth_data)depth_image = depth_array.reshape((Deepdate[1][1], Deepdate[1][0]))depth_image = np.flipud(depth_image)deepcolor = encoding.FloatArrayToRgbImage(depth_image, scale_factor=256*3.5*1000)display.displayUpdated(img, depth_image)# 进行相机标定

ret, mtx, dist, rvecs, tvecs = cv2.calibrateCamera(objpoints, imgpoints, gray.shape[::-1], None, None)# 计算标定的误差

total_error = 0

errors = []

# 遍历每张图像

for objp, imgp, rvec, tvec in zip(objpoints, imgpoints, rvecs, tvecs):# 将三维物体点转换为相机坐标系下的二维图像点projected_imgpoints, _ = cv2.projectPoints(objp, rvec, tvec, mtx, dist)# 计算原始 imgpoints 和 projected_imgpoints 之间的误差error = cv2.norm(imgp, projected_imgpoints, cv2.NORM_L2) / \len(projected_imgpoints)errors.append(error)total_error += error# 计算所有图像的平均误差

mean_error = total_error / len(objpoints)# 打印每幅图像的误差

for i, error in enumerate(errors):print(f"图像 {i+1} 的误差: {error}")# 打印平均误差

print(f"所有图像的平均误差: {mean_error}")# 打印相机内参和畸变系数

print("Camera Matrix:\n", mtx)

print("Distortion Coefficients:\n", dist)

print('camera carlibraed Done')fig = plt.figure()

ax = fig.add_subplot(111, projection='3d')

内参标定结果及标定板的姿态显示

------Perform camera calibration------

图像 1 的误差: 0.02561960222938916

图像 2 的误差: 0.029812235820557646

图像 3 的误差: 0.025746131185086674

图像 4 的误差: 0.026949289915749124

图像 5 的误差: 0.02779773110640927

图像 6 的误差: 0.02970027985427542

图像 7 的误差: 0.02793374910087122

图像 8 的误差: 0.025625364208011148

图像 9 的误差: 0.02599937961290829

图像 10 的误差: 0.028105922281836906

所有图像的平均误差: 0.027328968531509484

Camera Matrix:[[581.55412313 0. 317.88732972][ 0. 581.24563369 240.0350863 ][ 0. 0. 1. ]]

Distortion Coefficients:[[-0.0309966 0.15304087 0.00125555 -0.00093788 -0.27333318]]

camera carlibraed Done

进行手眼标定

参数说明

相机坐标系下的点可以根据内参标定的结果,使用solvePnP,获取棋盘格在相机坐标下的3D点,用sim.getObjectPose获取到机器人的姿态

print('------Perform hand-eye calibration------')

# 初始拍照位置

moveToConfig(sim, jointHandles, jmaxVel, jmaxAccel, jmaxJerk, targetjoinPos1)for i in range(10):goalTr = targetPos[i].copy()# goalTr[2] = goalTr[2] - 0.2params = {}params['ik'] = {'tip': tipHandle, 'target': targetHandle}# params['object'] = targetHandleparams['targetPose'] = goalTrparams['maxVel'] = maxVelparams['maxAccel'] = maxAccelparams['maxJerk'] = maxJerksim.moveToPose(params)img, [resX, resY] = sim.getVisionSensorImg(visionSensorHandle)img = np.frombuffer(img, dtype=np.uint8).reshape(resY, resX, 3)# In CoppeliaSim images are left to right (x-axis), and bottom to top (y-axis)# (consistent with the axes of vision sensors, pointing Z outwards, Y up)# and color format is RGB triplets, whereas OpenCV uses BGR:img = cv2.flip(cv2.cvtColor(img, cv2.COLOR_BGR2RGB), 0)# img=cv2.cvtColor(img, cv2.COLOR_BGR2RGB)gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)# 找到棋盘格的角点ret, corners = cv2.findChessboardCorners(gray, chessboard_size, None)# 如果找到角点,添加到点集if ret == True:# 使用 solvePnP 获取旋转向量和平移向量ret, rvec, tvec = cv2.solvePnP(objp, corners, mtx, dist)# 将 rvec 转换为旋转矩阵R, _ = cv2.Rodrigues(rvec)camera_tvec_matrix = tvec.reshape(-1)# 获取到机器人夹爪的姿态Targetpost = sim.getObjectPose(tipHandle)pose_matrix = sim.poseToMatrix(Targetpost)# 提取旋转矩阵 (3x3)robot_rotation_matrix = np.array([[pose_matrix[0], pose_matrix[1], pose_matrix[2]],[pose_matrix[4], pose_matrix[5], pose_matrix[6]],[pose_matrix[8], pose_matrix[9], pose_matrix[10]]])# 提取平移向量 (P0, P1, P2)robot_tvec_matrix = np.array([pose_matrix[3], pose_matrix[7], pose_matrix[11]])# 加入到手眼标定数据robot_poses_R.append(robot_rotation_matrix)robot_poses_t.append(robot_tvec_matrix)camera_poses_R.append(R)camera_poses_t.append(camera_tvec_matrix)img = draw_axes(img, mtx, dist, rvec, tvec, 0.015*7)# 获取深度图像Deepdate = sim.getVisionSensorDepth(deepSensorHandle, 1)# 解包为浮点数数组num_floats = Deepdate[1][0] * Deepdate[1][1]depth_data = struct.unpack(f'{num_floats}f', Deepdate[0])# 将数据转为 numpy 数组depth_array = np.array(depth_data)depth_image = depth_array.reshape((Deepdate[1][1], Deepdate[1][0]))depth_image = np.flipud(depth_image)deepcolor = encoding.FloatArrayToRgbImage(depth_image, scale_factor=256*3.5*1000)display.displayUpdated(img, depth_image)print("开始手眼标定...")

R_cam2gripper, t_cam2gripper = cv2.calibrateHandEye(robot_poses_R, robot_poses_t, camera_poses_R, camera_poses_t, method=cv2.CALIB_HAND_EYE_TSAI

)camera_pose_intip = sim.getObjectPose(visionSensorHandle, tipHandle)

camera_matrix_intip = sim.poseToMatrix(camera_pose_intip)

eulerAngles = sim.getEulerAnglesFromMatrix(camera_matrix_intip)print("相机到机器人末端的旋转矩阵:\n", R_cam2gripper)

print("相机到机器人末端的平移向量:\n", t_cam2gripper)

标定结果说明

开始手眼标定...

相机到机器人末端的旋转矩阵:[[ 0.00437374 -0.99998866 0.00188594][ 0.99998691 0.00436871 -0.00266211][ 0.00265384 0.00189756 0.99999468]]

相机到机器人末端的平移向量:[[ 0.04918588][-0.00012231][ 0.00194761]]

手眼标定完成

在虚拟环境中量出的结果和相机的标定结果,由于图像的坐标系和Sim的坐标系的坐标轴是相差90°,所有顺序不一样

接下来使用标定好的结果进行跟踪标定板的位置

相关文章:

Coppelia Sim (v-REP)仿真 机器人3D相机手眼标定与实时视觉追踪 (二)

coppelia sim[V-REP]仿真实现 机器人于3D相机手眼标定与实时视觉追踪 二 zmq API接口python调用python获取3D相机的数据获取彩色相机的数据获取深度相机的数据用matpolit显示 python控制机器人运动直接控制轴的位置用IK运动学直接移动到末端姿态 相机内参的标定记录拍照点的位置…...

苏州金龙技术创新赋能旅游新质生产力

2024年10月23日,备受瞩目的“2024第六届旅游出行大会”在云南省丽江市正式开幕。作为客车行业新质生产力标杆客车,苏州金龙在大会期间现场展示了新V系V12商旅版、V11和V8E纯电车型,为旅游出行提供全新升级方案。 其中,全新15座V1…...

ceph pg stale 恢复

问题 如果 ceph -s 看到 ceph 有类似如下状态的 pg data:volumes: 1/1 healthypools: 5 pools, 113 pgsobjects: 6.94k objects, 22 GiBusage: 24 GiB used, 33 TiB / 33 TiB availpgs: 0.885% pgs not active366/13880 objects degraded (2.637%)...

Openlayers高级交互(8/20):选取feature,平移feature

本示例介绍如何在vue+openlayers中使用Translate,选取feature,平移feature。选择的时候需要按住shift。Translate 功能通常是指在地图上平移某个矢量对象的位置。在 OpenLayers 中,可以通过修改矢量对象的几何位置来实现这一功能。 效果图 配置方式 1)查看基础设置:http…...

uniapp renderjs页面传值

scrip标签里加 lang“renderjs” ,可以使用原生js的dom,但是我在使用中发现以下问题,导致数据不能动态获取 1. onLoad获取上级页面传值 // APP不会触发,h5可以 2. props不会触发 解决办法添加 script 逻辑层数据传入渲染层 ren…...

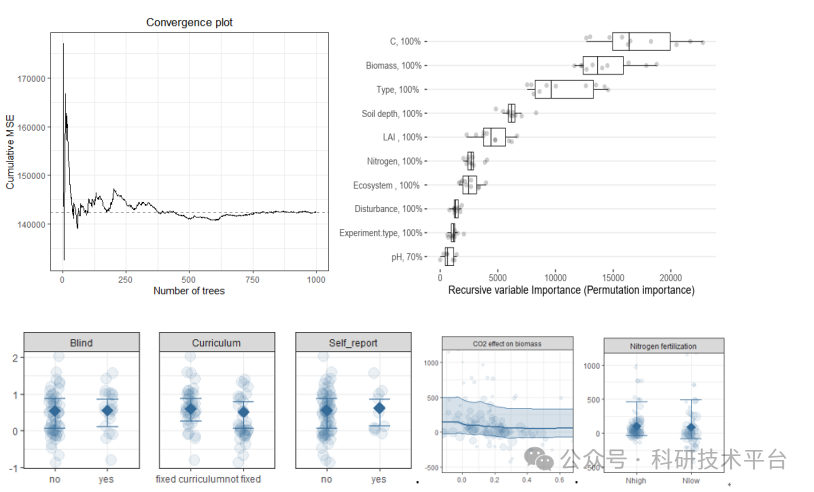

AI赋能R-Meta分析核心技术:从热点挖掘到高级模型、助力高效科研与论文发表

Meta分析是针对某一科研问题,根据明确的搜索策略、选择筛选文献标准、采用严格的评价方法,对来源不同的研究成果进行收集、合并及定量统计分析的方法,现已广泛应用于农林生态,资源环境等方面,成为Science、Nature论文的…...

AMD锐龙8845HS+780M核显 虚拟机安装macOS 15 Sequoia 15.0.1 (2024.10)

最近买了机械革命无界14X,CPU是8845HS,核显是780M,正好macOS 15也出了正式版,试试兼容性,安装过程和之前差不多,这次我从外网获得了8核和16核openCore,分享一下。 提前发一下ISO镜像地址和open…...

当事人单方委托专业机构或个人出具的书面意见,证据效力如何认定?

裁判要旨:当事人就专门性问题单方自行委托专业机构或者个人出具的书面意见,虽然不属于民事诉讼法上所称的由人民法院经由司法鉴定程序所获得的鉴定意见,但法律并未排除其作为证据的资格。对一方当事人就专门性问题自行委托有关机构或者人员出…...

AUTOSAR CP 中 BswM 模块功能与使用介绍(2/2)

三、 AUTOSAR BswM 模块详解及 ARXML 示例 BswM 模块的主要功能 BswM(Basic Software Mode Manager)模块在 AUTOSAR 架构中扮演着模式管理的核心角色。它负责管理车辆的各种模式(如启动、运行、停车等),并根据不同的…...

PCB电路板为什么大多是绿色的

PCB电路板为什么大多是绿色的 1.绿色油墨为什么最常用?1.1.性能角度1.2.经济和历史角度1.3.人文和环保角度 2.误区:黑色PCB板更高端?3.总结 PCB电路板上面的绿色是一层阻焊油墨(solder mask),主要作用&…...

Golang | Leetcode Golang题解之第508题出现次数最多的子树元素和

题目: 题解: func findFrequentTreeSum(root *TreeNode) (ans []int) {cnt : map[int]int{}maxCnt : 0var dfs func(*TreeNode) intdfs func(node *TreeNode) int {if node nil {return 0}sum : node.Val dfs(node.Left) dfs(node.Right)cnt[sum]if…...

【安全解决方案】深入解析:如何通过CDN获取用户真实IP地址

一、业务场景 某大型互联网以及电商公司为了防止客户端获取到真实的ip地址,以及达到保护后端业务服务器不被网站攻击,同时又可以让公安要求留存网站日志和排查违法行为,以及打击犯罪的时候,获取不到真实的ip地址,发现…...

git 免密的方法

方法一: 通过生成credential配置 git config --global credential.helper store 查看.gitconfig文件,发现多了一行 [credential] helper store 方法二: 修改仓库中.git/config文件 url http://账号:密码git.test.com.cn/test/xx.git或者带…...

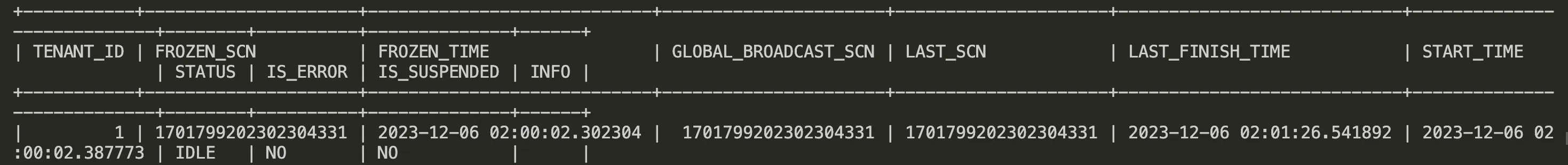

如何用 obdiag 排查 OceanBase数据库的卡合并问题——《OceanBase诊断系列》14

1. 背景 卡合并在OceanBase中是一个复杂的问题,其产生可能源于多种因素。目前,对于卡合并的明确界定尚不存在统一标准,一方面,我们界定超过36小时未完成合并为合并超时,此时RS会记录ERROR日志;另一方面&am…...

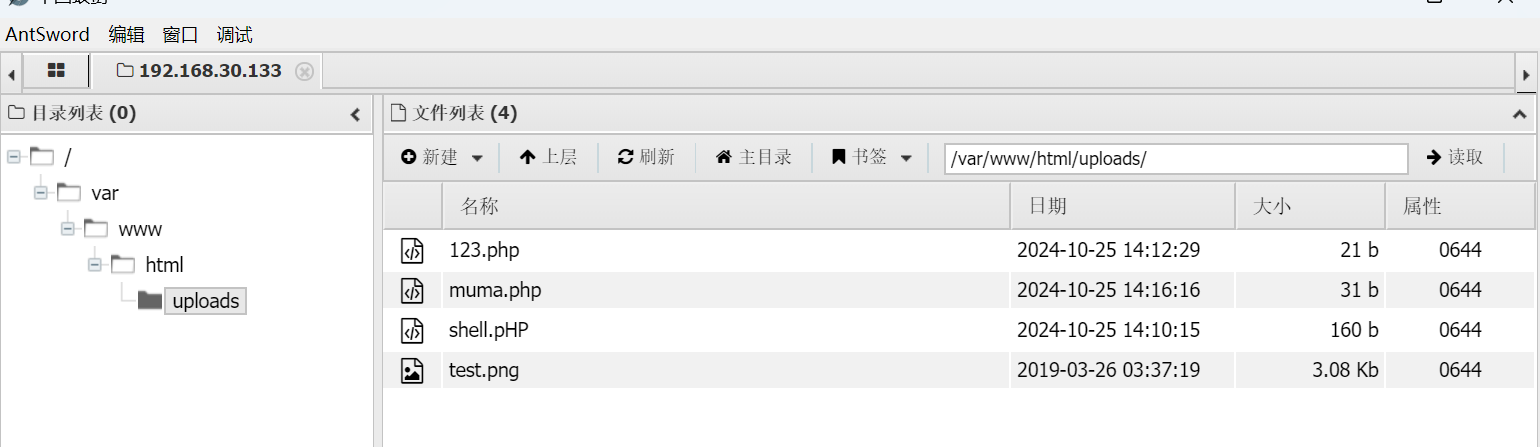

hackme靶机渗透流程

一,搭建环境 本次测试使用hackme的靶机 攻击为kali(192.168.30.130)与物理机 二,信息收集 1.确定IP 先确定mac信息,再搭配主机扫描确定靶机的IP地址 00:0C:29:D0:F5:74 确定靶机地址为 192.168.30.133 2.扫描靶机…...

uniapp 常用的地区行业各种多选多选,支持回显,复制粘贴可使用

uniapp 常用的地区行业各种多选多选,支持回显 必须导入uni-popup 弹出层 该组件 1.目前项目开发中使用到这类似挺多的,记录一下,方便以后是使用 2.使用前提,目前不做无限级,只支持二维数组,模板里只循环了两…...

iOS 本地存储地址(位置)

前言: UserDefaults 存在沙盒的 Library --> Preferences--> .plist文件 CoreData 存在沙盒的 Library --> Application Support--> xx.sqlite 一个小型数据库里 (注:Application Support 这个文件夹已开始是没有的,只有当你写了存储代码,运行之后,目录里才会出…...

小程序调取微信支付)

uni.showLoading 时禁止点击(防止表单重复提交) 小程序调取微信支付

在使用 uni.showLoading 时,如果需要禁用点击事件,可以在调用 uni.showLoading 之前设置全局的触摸事件为禁用状态,然后在 uni.hideLoading 之后再重新启用。 mask 选项是 uni.showLoading 的一个参数,当设置为 true 时,会显示遮罩,此时用户不能点击底层的任何内容。 // …...

OpenClash与Tailscale冲突得问题

1.问题描述:开了openclash之后,tailscale就用不了。tailscale ping XXX.XXX.XXX.XXX 可以成功。但是用cmd的ping就不通。 2.tailscale登录得时候,加上这两个参数:--accept-dnsfalse 和 --netfilter-modeoff 。 示例:t…...

day02|计算机网络重难点之HTTP请求报文和响应报文

day02|计算机网络重难点之HTTP请求报文和响应报文 3.HTTP请求报文和响应报文是怎样的,有哪些常见的字段? 3.HTTP请求报文和响应报文是怎样的,有哪些常见的字段? HTTP请求报文主要是由 请求行、请求头部、空行和请求体 四部分组成…...

eNSP-Cloud(实现本地电脑与eNSP内设备之间通信)

说明: 想象一下,你正在用eNSP搭建一个虚拟的网络世界,里面有虚拟的路由器、交换机、电脑(PC)等等。这些设备都在你的电脑里面“运行”,它们之间可以互相通信,就像一个封闭的小王国。 但是&#…...

day52 ResNet18 CBAM

在深度学习的旅程中,我们不断探索如何提升模型的性能。今天,我将分享我在 ResNet18 模型中插入 CBAM(Convolutional Block Attention Module)模块,并采用分阶段微调策略的实践过程。通过这个过程,我不仅提升…...

8k长序列建模,蛋白质语言模型Prot42仅利用目标蛋白序列即可生成高亲和力结合剂

蛋白质结合剂(如抗体、抑制肽)在疾病诊断、成像分析及靶向药物递送等关键场景中发挥着不可替代的作用。传统上,高特异性蛋白质结合剂的开发高度依赖噬菌体展示、定向进化等实验技术,但这类方法普遍面临资源消耗巨大、研发周期冗长…...

《用户共鸣指数(E)驱动品牌大模型种草:如何抢占大模型搜索结果情感高地》

在注意力分散、内容高度同质化的时代,情感连接已成为品牌破圈的关键通道。我们在服务大量品牌客户的过程中发现,消费者对内容的“有感”程度,正日益成为影响品牌传播效率与转化率的核心变量。在生成式AI驱动的内容生成与推荐环境中࿰…...

鸿蒙中用HarmonyOS SDK应用服务 HarmonyOS5开发一个医院查看报告小程序

一、开发环境准备 工具安装: 下载安装DevEco Studio 4.0(支持HarmonyOS 5)配置HarmonyOS SDK 5.0确保Node.js版本≥14 项目初始化: ohpm init harmony/hospital-report-app 二、核心功能模块实现 1. 报告列表…...

数据链路层的主要功能是什么

数据链路层(OSI模型第2层)的核心功能是在相邻网络节点(如交换机、主机)间提供可靠的数据帧传输服务,主要职责包括: 🔑 核心功能详解: 帧封装与解封装 封装: 将网络层下发…...

Map相关知识

数据结构 二叉树 二叉树,顾名思义,每个节点最多有两个“叉”,也就是两个子节点,分别是左子 节点和右子节点。不过,二叉树并不要求每个节点都有两个子节点,有的节点只 有左子节点,有的节点只有…...

nnUNet V2修改网络——暴力替换网络为UNet++

更换前,要用nnUNet V2跑通所用数据集,证明nnUNet V2、数据集、运行环境等没有问题 阅读nnU-Net V2 的 U-Net结构,初步了解要修改的网络,知己知彼,修改起来才能游刃有余。 U-Net存在两个局限,一是网络的最佳深度因应用场景而异,这取决于任务的难度和可用于训练的标注数…...

聚六亚甲基单胍盐酸盐市场深度解析:现状、挑战与机遇

根据 QYResearch 发布的市场报告显示,全球市场规模预计在 2031 年达到 9848 万美元,2025 - 2031 年期间年复合增长率(CAGR)为 3.7%。在竞争格局上,市场集中度较高,2024 年全球前十强厂商占据约 74.0% 的市场…...

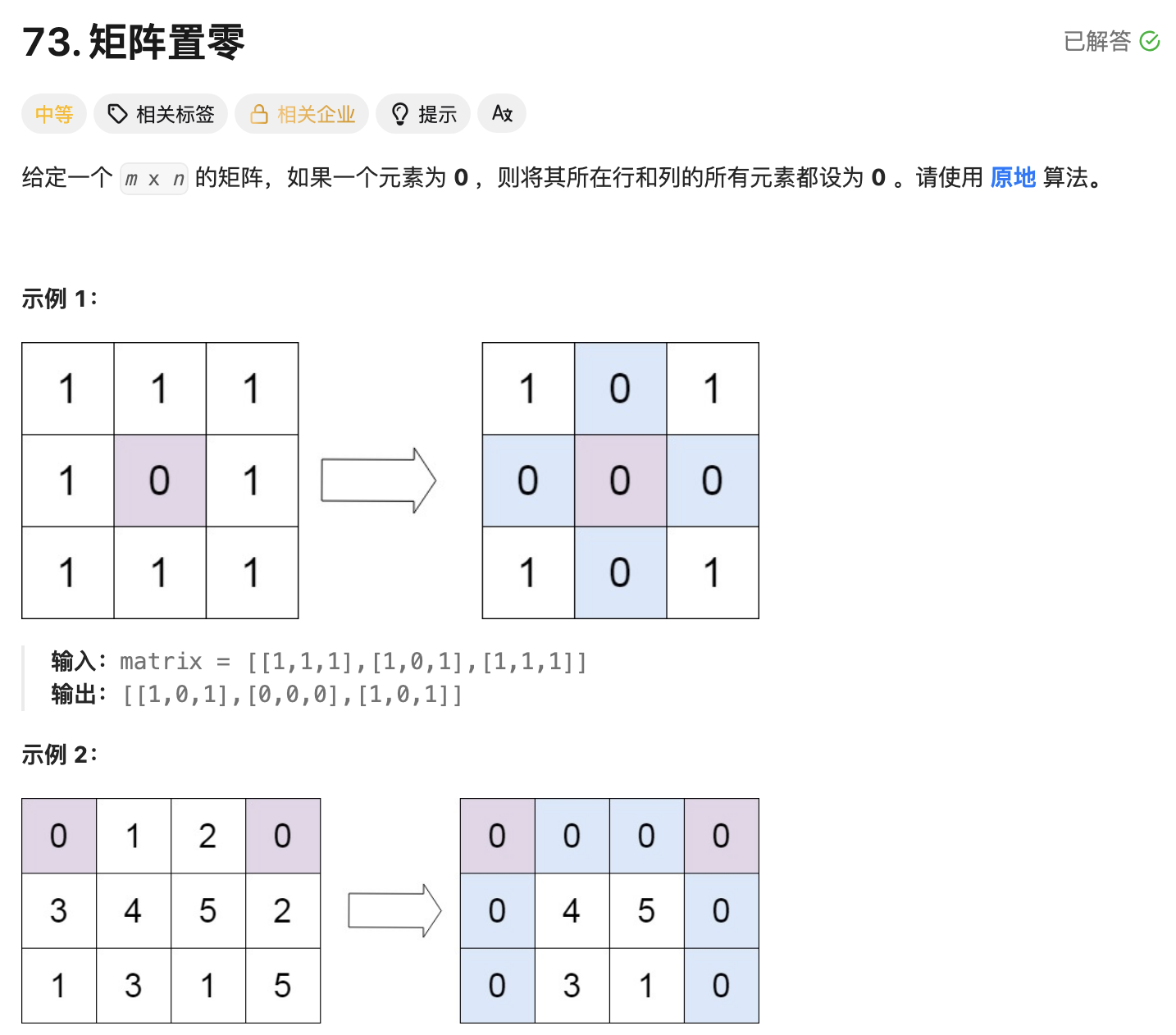

leetcode73-矩阵置零

leetcode 73 思路 记录 0 元素的位置:遍历整个矩阵,找出所有值为 0 的元素,并将它们的坐标记录在数组zeroPosition中置零操作:遍历记录的所有 0 元素位置,将每个位置对应的行和列的所有元素置为 0 具体步骤 初始化…...