运维实用脚本整理

运维实用脚本整理

- 本文脚本仅供参考

- 运维排查问题思路

- 运维排查问题的方法和命令

- (1)尽可能搞清楚问题的前因后果

- (2)有谁在?

- (3)之前发生了什么?

- (4) 现在在运行的进程是啥?

- (5)监听的网络服务

- (6)CPU 和内存

- (7)硬件

- (8) IO 性能

- (9) 挂载点 和 文件系统

- (10) 内核、中断和网络

- (11) 系统日志和内核消息

- (12) 定时任务

- (13) 应用系统日志

- Linux运维日常巡检脚本

- 系统指标巡检脚本

- 日常命令

- 性能相关的命令

- 进程相关的命令

- javadump.sh

- 常用运维加固脚本

- 根据PID过滤进程所有信息

- 根据进程名过滤进程信息

- 常用工具一键部署安装

- 常用lib库安装

- 系统检查脚本

- SPN 日常巡查脚本

- ffmpeg脚本

- 打开进程,并判断进程数量

- 关闭进程

- java jar包启动-剔除Pom中依赖

- Java jar包通用启动脚本

- 查看centos配置信息脚本

- Jenkins项目打包发布脚本

- 注意:SQL Server以下脚本目前还不完善(AlwaysOn相关 到 Agent作业备份)

- AlwaysOn相关

- 节点切换监控

- 节点切换作业控制

- SQL Server 邮件脚本

- Mysql-使用脚本进行分库分表备份

- 数据库-数据备份

- 备份作业

- 数据一致性检查

- Agent作业备份

- 监控某个目录是否被更改

- 确保本机能连上shell脚本中指定的smtp服务器的25好端口

- 下面开始测试

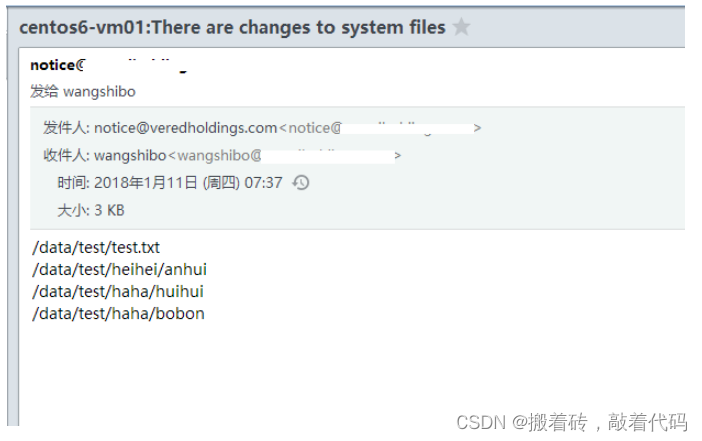

- 查看邮件,就能看到/data/test目录下变动的文件或子目录信息了

- 通过crontab定时任务,每5分钟执行一次检查:

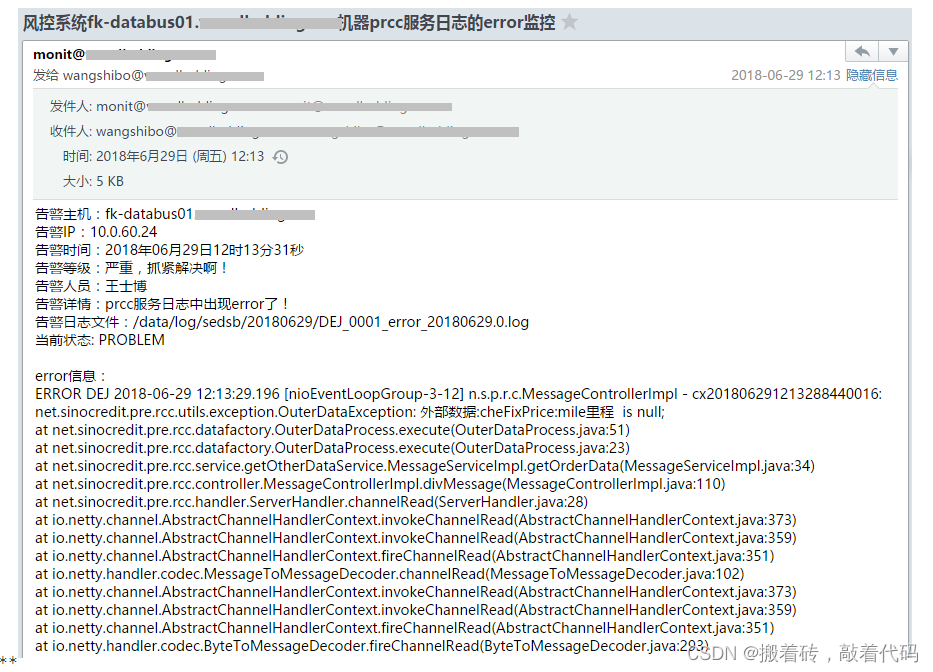

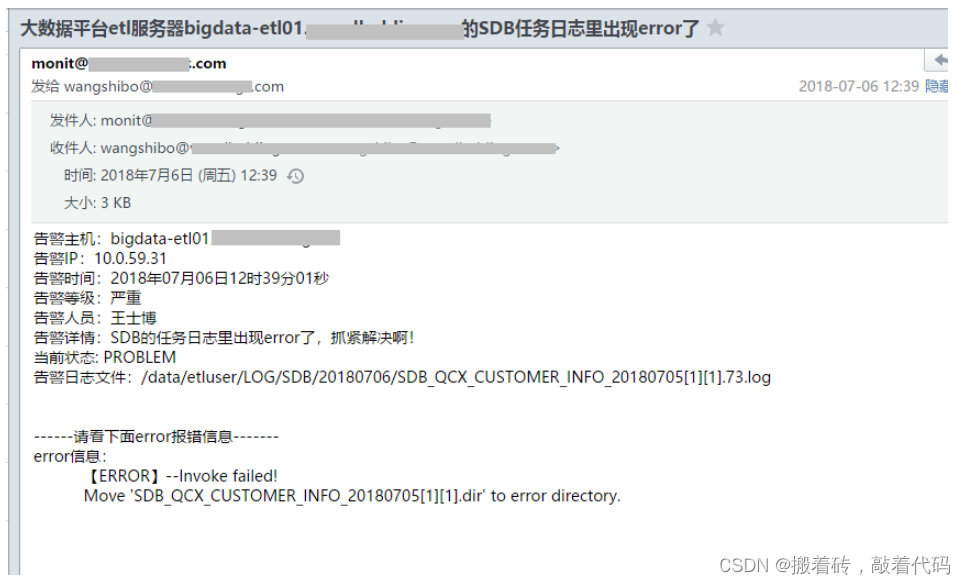

- 日志文件ERROR监控报警

- 1)第一类日志

- 2)第二类日志

- 3)第三类日志

- 基于Ping和Telnet/NC的监控脚本案例分析

- 通过shell脚本,判断172.16.60.0/24网络里,当前在线的ip有哪些?能ping通则认为在线。

- 案例一:单纯地对某些ip进行ping监控

- 案例二:对/etc/hosts列表里的ip映射关系进行ping监控报警

- 案例三:通过nc工具对/etc/hosts列表里的ip的443端口跟本机通信是否正常进行探测

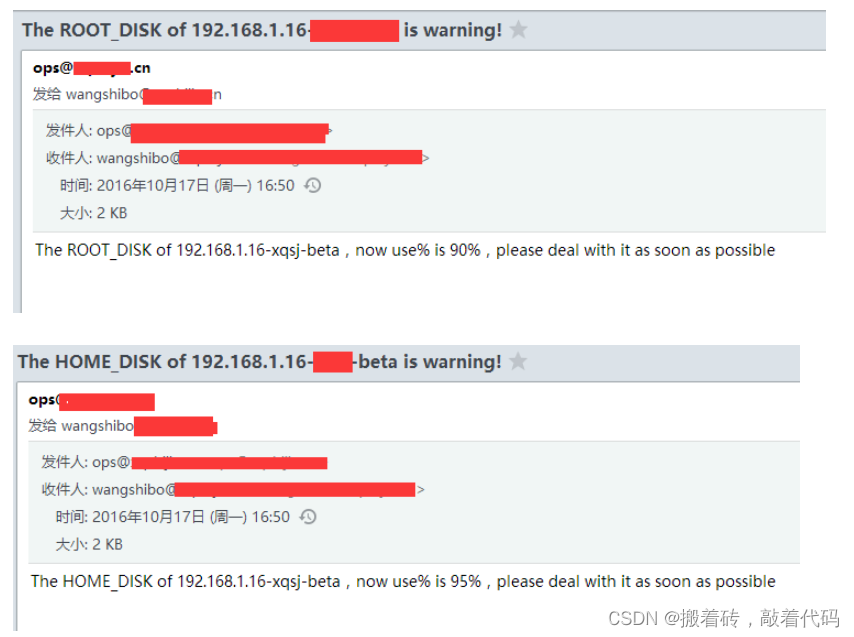

- 监控磁盘的监控脚本

- 监控磁盘IO使用率的脚本,实时查看IO使用情况,防止因为磁盘IO效率低而导致MySQL查询慢的问题

- 实时监控网卡流量的通用脚本

- 检测网卡流量,并按规定格式记录在日志中

- 指定时间内网站访问次数的监控

- nginx日志监控脚本

- python报警脚本

- 写个测试脚本不停curl请求资源触发报警

- 定时任务,由于上面脚本是监控一分钟内的日志,因此每分钟执行一次

- 网站访问状态和超时时间监控报警设置

- 服务器磁盘监控脚本(含报警邮件)

- 业务日志清理脚本

- Linux下间隔多少秒 (即以秒为单位) 去执行某条命令或某个shell脚本的操作方法

- Linux下批量ping某个网段ip的脚本

- 查看系统运行情况

- 管理docker

- Shell多线程备份数据库

- 监测 Nginx 访问日志 502 情况,并做相应动作

- 检测两台服务器指定目录下的文件一致性

- 定时清空文件内容,定时记录文件大小

- 计算文档每行出现的数字个数,并计算整个文档的数字总数

- 杀死所有脚本

- 从 FTP 服务器下载文件

- 扫描主机端口状态

- 监控 httpd 的进程数,根据监控情况做相应处理

- iptables 自动屏蔽访问网站频繁的IP

- 1)屏蔽每分钟访问超过200的IP

- 2)屏蔽每分钟SSH尝试登录超过10次的IP

- 根据web访问日志,封禁请求量异常的IP,如IP在半小时后恢复正常,则解除封禁

- 判断用户输入的是否为IP地址

本文脚本仅供参考

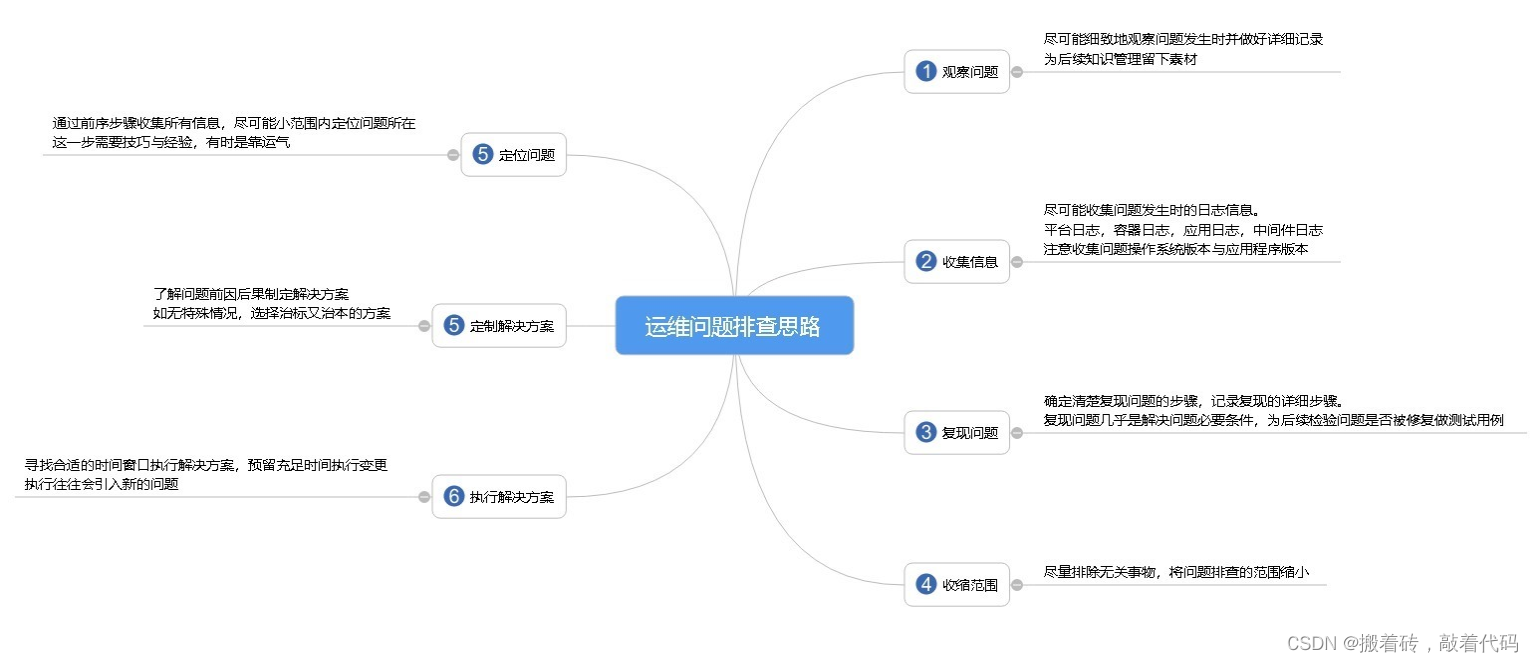

运维排查问题思路

运维排查问题的方法和命令

遇到服务器故障,问题出现的原因很少可以一下就想到。基本上都会从以下步骤入手:

(1)尽可能搞清楚问题的前因后果

不要一下子就扎到服务器前面,你需要先搞明白对这台服务器有多少已知的情况,还有故障的具体情况。不然你很可能就是在无的放矢。

必须搞清楚的问题有:

-

故障的表现是什么?无响应?报错?

-

故障是什么时候发现的?

-

故障是否可重现?

-

有没有出现的规律(比如每小时出现一次)

-

最后一次对整个平台进行更新的内容是什么(代码、服务器等)?

-

故障影响的特定用户群是什么样的(已登录的, 退出的, 某个地域的…)?

-

基础架构(物理的、逻辑的)的文档是否能找到?

-

是否有监控平台可用? (比如Munin、Zabbix、 Nagios、 New Relic… 什么都可以)

-

是否有日志可以查看?. (比如Loggly、Airbrake、 Graylog…)

最后两个是最方便的信息来源,不过别抱太大希望,基本上它们都不会有。只能再继续摸索了。

(2)有谁在?

wlast

用这两个命令看看都有谁在线,有哪些用户访问过。这不是什么关键步骤,不过最好别在其他用户正干活的时候来调试系统。有道是一山不容二虎嘛。(one cook in the kitchen is enough.)

(3)之前发生了什么?

history

查看一下之前服务器上执行过的命令。看一下总是没错的,加上前面看的谁登录过的信息,应该有点用。另外作为admin要注意,不要利用自己的权限去侵犯别人的隐私哦。

到这里先提醒一下,等会你可能会需要更新 HISTTIMEFORMAT 环境变量来显示这些命令被执行的时间。对要不然光看到一堆不知道啥时候执行的命令,同样会令人抓狂的。

(4) 现在在运行的进程是啥?

pstree -aps aux

这都是查看现有进程的。 ps aux 的结果比较杂乱, pstree -a 的结果比较简单明了,可以看到正在运行的进程及相关用户。

(5)监听的网络服务

netstat -ntlpnetstat -nulpnetstat -nxlp我一般都分开运行这三个命令,不想一下子看到列出一大堆所有的服务。netstat -nalp倒也可以。不过我绝不会用 numeric 选项 (鄙人一点浅薄的看法:IP 地址看起来更方便)。

找到所有正在运行的服务,检查它们是否应该运行。查看各个监听端口。在netstat显示的服务列表中的PID 和 ps aux 进程列表中的是一样的。

如果服务器上有好几个Java或者Erlang什么的进程在同时运行,能够按PID分别找到每个进程就很重要了。

通常我们建议每台服务器上运行的服务少一点,必要时可以增加服务器。如果你看到一台服务器上有三四十个监听端口开着,那还是做个记录,回头有空的时候清理一下,重新组织一下服务器。

(6)CPU 和内存

free -muptimetophtop注意以下问题:

还有空余的内存吗? 服务器是否正在内存和硬盘之间进行swap?

还有剩余的CPU吗? 服务器是几核的? 是否有某些CPU核负载过多了?

服务器最大的负载来自什么地方? 平均负载是多少?

(7)硬件

lspcidmidecodeethtool

有很多服务器还是裸机状态,可以看一下:

找到RAID 卡 (是否带BBU备用电池?)、 CPU、空余的内存插槽。根据这些情况可以大致了解硬件问题的来源和性能改进的办法。

网卡是否设置好? 是否正运行在半双工状态? 速度是10MBps? 有没有 TX/RX 报错?

(8) IO 性能

iostat -kx 2vmstat 2 10mpstat 2 10dstat --top-io --top-bio

这些命令对于调试后端性能非常有用。

-

检查磁盘使用量:服务器硬盘是否已满?

-

是否开启了swap交换模式 (si/so)?

-

CPU被谁占用:系统进程? 用户进程? 虚拟机?

-

dstat 是我的最爱。用它可以看到谁在进行 IO: 是不是MySQL吃掉了所有的系统资源? 还是你的PHP进程?

(9) 挂载点 和 文件系统

mountcat /etc/fstabvgspvslvsdf -hlsof +D / /* beware not to kill your box */

-

一共挂载了多少文件系统?

-

有没有某个服务专用的文件系统? (比如MySQL?)

-

文件系统的挂载选项是什么: noatime? default? 有没有文件系统被重新挂载为只读模式了?

-

磁盘空间是否还有剩余?

-

是否有大文件被删除但没有清空?

-

如果磁盘空间有问题,你是否还有空间来扩展一个分区?

(10) 内核、中断和网络

sysctl -a | grep ...cat /proc/interruptscat /proc/net/ip_conntrack /* may take some time on busy servers */netstatss -s-

你的中断请求是否是均衡地分配给CPU处理,还是会有某个CPU的核因为大量的网络中断请求或者RAID请求而过载了?

-

SWAP交换的设置是什么?对于工作站来说swappinness 设为 60 就很好, 不过对于服务器就太糟了:你最好永远不要让服务器做SWAP交换,不然对磁盘的读写会锁死SWAP进程。

-

conntrack_max 是否设的足够大,能应付你服务器的流量?

-

在不同状态下(TIME_WAIT, …)TCP连接时间的设置是怎样的?

-

如果要显示所有存在的连接,netstat 会比较慢, 你可以先用 ss 看一下总体情况。

你还可以看一下 Linux TCP tuning 了解网络性能调优的一些要点。

(11) 系统日志和内核消息

dmesgless /var/log/messagesless /var/log/secureless /var/log/auth

-

查看错误和警告消息,比如看看是不是很多关于连接数过多导致?

-

看看是否有硬件错误或文件系统错误?

-

分析是否能将这些错误事件和前面发现的疑点进行时间上的比对。

(12) 定时任务

ls /etc/cron* + catfor user in $(cat /etc/passwd | cut -f1 -d:); do crontab -l -u $user; done

-

是否有某个定时任务运行过于频繁?

-

是否有些用户提交了隐藏的定时任务?

-

在出现故障的时候,是否正好有某个备份任务在执行?

(13) 应用系统日志

这里边可分析的东西就多了, 不过恐怕你作为运维人员是没功夫去仔细研究它的。关注那些明显的问题,比如在一个典型的LAMP(Linux+Apache+Mysql+Perl)应用环境里:

-

Apache & Nginx; 查找访问和错误日志, 直接找 5xx 错误, 再看看是否有 limit_zone错误。

-

MySQL; 在mysql.log找错误消息,看看有没有结构损坏的表, 是否有innodb修复进程在运行,是否有disk/index/query 问题.

-

PHP-FPM; 如果设定了 php-slow 日志, 直接找错误信息 (php, mysql, memcache, …),如果没设定,赶紧设定。

-

Varnish; 在varnishlog 和 varnishstat 里, 检查 hit/miss比. 看看配置信息里是否遗漏了什么规则,使最终用户可以直接攻击你的后端?

-

HA-Proxy; 后端的状况如何?健康状况检查是否成功?是前端还是后端的队列大小达到最大值了?

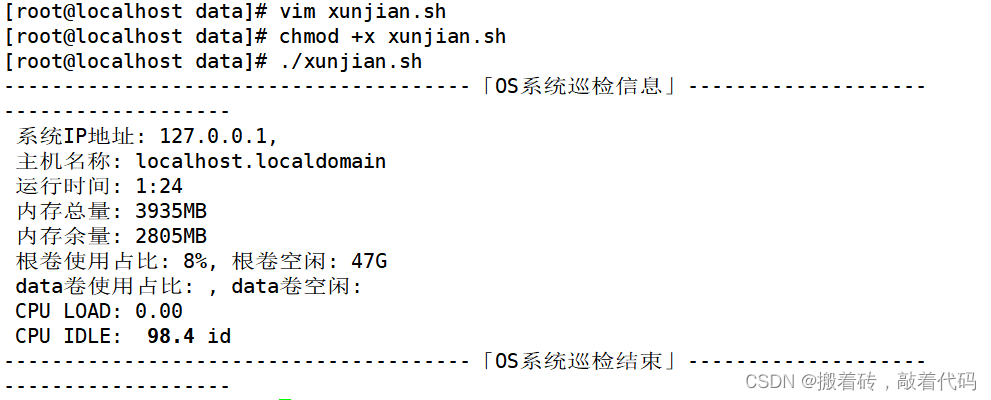

Linux运维日常巡检脚本

#!/bin/bash

#author by acrossyao

#date: 2021-02-08

#巡检脚本

echo "---------------------------------------「OS系统巡检信息」---------------------------------------"

#OS_IP=`hostname -i | awk '{print $1}'`

OS_IP=""

IPLIST=`hostname -i`

for elem in $IPLIST

do

regex="\b(25[0-5]|2[0-4][0-9]|1[0-9][0-9]|[1-9][0-9]|[1-9])\.(25[0-5]|2[0-4][0-9]|1[0-9][0-9]|[1-9][0-9]|[0-9])\.(25[0-5]|2[0-4][0-9]|1[0-9][0-9]|[1-9][0-9]|[0-9])\.(25[0-5]|2[0-4][0-9]|1[0-9][0-9]|[1-9][0-9]|[1-9])\b"

ckStep2=`echo $elem | egrep $regex | wc -l`

if [ $ckStep2 -eq 0 ]

then

aa=1

else

OS_IP+=$elem", "

fi

done

OS_HOSTNAME=`hostname`

OS_RUN_TIME=`uptime |awk '{print $3,$4}'|awk -F, '{print $1}'`

echo " 系统IP地址: $OS_IP"

echo " 主机名称: $OS_HOSTNAME"

echo " 运行时间: $OS_RUN_TIME"

#内存

OS_MEM_TAL=`free -m | grep Mem | awk '{print $2}'`

OS_MEM_FREE=`free -m | grep Mem | awk '{print $7}'`

echo " 内存总量: ${OS_MEM_TAL}MB"

echo " 内存余量: ${OS_MEM_FREE}MB"

#磁盘使用占比

OS_ROOT_DISKS_USE_PRECENT=`df -h / | grep '/'| awk '{print $5}'`

OS_ROOT_DISKS_AVAIL=`df -h / | grep '/'| awk '{print $4}'`

OS_DATA_DISKS_USE_PRECENT=`df -h | grep '/data'| awk '{print $5}'`

OS_DATA_DISKS_AVAIL=`df -h | grep '/data'| awk '{print $4}'`

echo " 根卷使用占比: ${OS_ROOT_DISKS_USE_PRECENT}, 根卷空闲: ${OS_ROOT_DISKS_AVAIL}"

echo " data卷使用占比: ${OS_DATA_DISKS_USE_PRECENT}, data卷空闲: ${OS_DATA_DISKS_AVAIL}"

#CPU

CPU_LOAD=`top -bn1 | grep load | awk '{printf "CPU LOAD: %.2f\n", $(NF-2)}'`

CPU_IDLE=`top -n1 | fgrep "Cpu(s)" | awk -F ',' '{print $4}'`

echo " ${CPU_LOAD}"

echo " CPU IDLE: ${CPU_IDLE}"

echo "---------------------------------------「OS系统巡检结束」---------------------------------------"

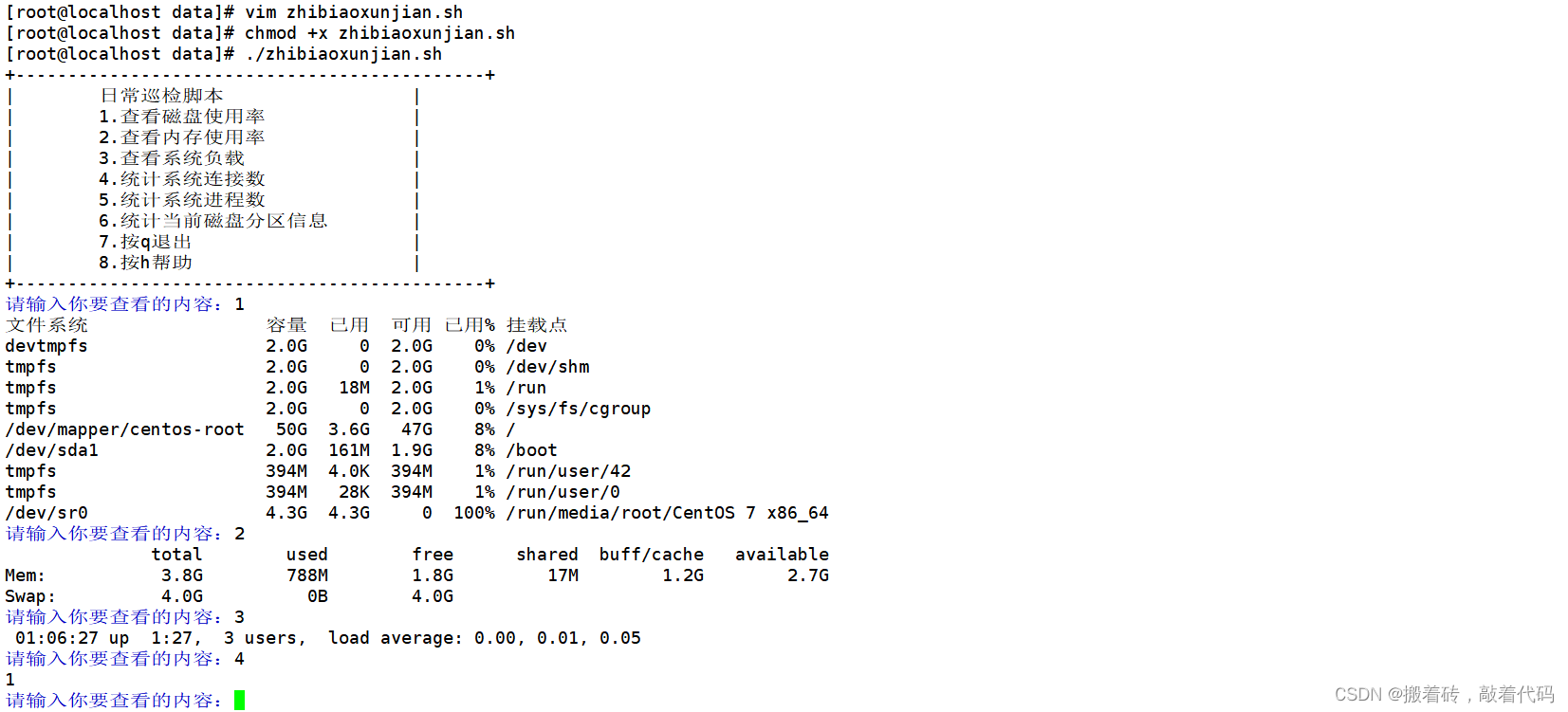

系统指标巡检脚本

#!/bin/bash

menu(){

cat <<EOF

+---------------------------------------------+

| 日常巡检脚本 |

| 1.查看磁盘使用率 |

| 2.查看内存使用率 |

| 3.查看系统负载 |

| 4.统计系统连接数 |

| 5.统计系统进程数 |

| 6.统计当前磁盘分区信息 |

| 7.按q退出 |

| 8.按h帮助 |

+---------------------------------------------+

EOF

}

menu

while true

do

echo -en "\033[34m请输入你要查看的内容:\033[0m"

read actionif [ "$action" == "q" ];thenecho "quiting...."breakfiif [ "$action" == "h" ];thenmenuficase $action in 1)df -h ;;2)free -h ;;3)uptime ;;4)ss -tan | grep -i "estab" | wc -l ;;5)ps aux | grep -v "grep" | wc -l ;;6)fdisk -l ;; *)echo "Usage: $0 {1|2|3|4|5|6|q|h}"esac

done

日常命令

1、查找当前目录下占用为0字节的文件并删除find ./ -type f -size 0 -exec rm -rf {}\; #此命令不要用于对根目录0字节文件的操作2、将系统进程按内存占用大小排列显示出来ps -e -o “%C : %p : %z : %a”|sort -k5-nr 3、将系统进程按CPU占用大小排列显示ps -e -o “%C : %p : %z : %a”|sort -nr4、匹配某文件中某一行并进行内容替换sed -i ‘/Root/s/no/yes’/etc/ssh/sshd_config #先匹配到Root,再将此行no替换为yes5、显示所有运行级别为3并开机启动的服务ls /etc/rc3.d/S* |cut -c 15- #rc3.d中S开头即为运行级别3的服务,并用cut截取第15个字符后面的内容6、取得eth0网卡的IP地址 方法1:ifconfig | grep ‘inet addr:’| grep -v ’127.0.0.1′ | cut -d:-f2 | awk ‘{ print $1}’方法2:ifconfig eth0 |grep “inet addr:” |awk ‘{print $2}’|cut -c 6-7、TCP抓包工具分析80端口数据流tcpdump -c 10000 -i eth0 -n dst port 808、查询昨天的日期date –date=yesterday9、删除所有空目录find /data -type d -empty -exec rm -rf {}; #最好不要在/目录下执行此命令10、删除5天前的文件find /data -mtime +5 -type f -exec rm -rf{};11、强制踢出终端用户pkill -KILL -t pts/112、将来自80端口的请求转发到8080端口iptables -A PREROUTING -p tcp -m tcp –dport80 -j DNAT –to-destination 127.0.0.1:808013、Linux服务器之间传文件scp ~/test.txtroot@192.168.0.10:/data/ #将个人主目录下test.txt传到远程主机的/data目录下14、对大文件进行分割split -l 1000 message.log message #按每个文件1000行来分割split -b 5m message.log message #按每个文件5M来分割

性能相关的命令

#查看当前系统load

uptime#查看系统状态和每个进程的系统资源使用状况

top#可视化显示CPU的使用状况

htop#查看每个CPU的负载信息

mpstat -P ALL 1#每隔1秒查看磁盘IO的统计信息

iostat -xkdz 1#每隔一秒查看虚拟内存的使用信息

vmstat 1#查看内存使用统计信息

free#查看网络使用信息

nicstat -z 1#类似vmstat的显示优化的工具

dstat 1#查看系统活动状态,比如系统分页统计,块设备IO统计等

sar#网络连接状态查看

netstat -s#进程资源使用信息查看

pidstat 1

pidstat -d 1#查看某个进程的系统调用信息 -p后面是进程id,-tttT 进程系统后的系统调用时间

strace -tttT -p 12670

#统计IO设备输入输出的系统调用信息

strace -c dd if=/dev/zero of=/dev/null bs=512 count=1024k#tcpdump 查看网络数据包

tcpdump -nr /tmp/out.tcpdump#块设备的读写事件信息统计

btrace /dev/sdb #iotop查看某个进程的IO操作统计信息

iotop -bod5#slabtop 查看内核 slab内存分配器的使用信息

slabtop -sc#系统参数设置

sysctl -a#系统性能指标统计信息

perf stat gzip file1#系统cpu活动状态查看

perf record -a -g -F 997 sleep 10

进程相关的命令

## processes 进程管理##ps查看当前系统执行的线程列表,进行瞬间状态,不是连续状态,连续状态需要使用top名称查看 更多常用参数请使用 man ps查看

ps##显示所有进程详细信息

ps aux##-u 显示某个用户的进程列表

ps -f -u www-data ## -C 通过名字或者命令搜索进程

ps -C apache2## --sort 根据进程cpu使用率降序排列,查看前5个进程 -pcpu表示降序 pcpu升序

ps aux --sort=-pcpu | head -5 ##-f 用树结构显示进程的层次关系,父子进程情况下

ps -f --forest -C apache2 ##显示一个父进程的所有子进程

ps -o pid,uname,comm -C apache2

ps --ppid 2359 ##显示一个进程的所有线程 -L 参数

ps -p 3150 -L ##显示进程的执行时间 -o参数

ps -e -o pid,comm,etime ##watch命令可以用来实时捕捉ps显示进程

watch -n 1 'ps -e -o pid,uname,cmd,pmem,pcpu --sort=-pmem,-pcpu | head -15' ##jobs 查看后台运行的进程 jobs命令执行的结果,+表示是一个当前的作业,减号表是是一个当前作业之后的一个作业,jobs -l选项可显示所有任务的PID,jobs的状态可以是running, stopped, Terminated,但是如果任务被终止了(kill),shell 从当前的shell环境已知的列表中删除任务的进程标识;也就是说,jobs命令显示的是当前shell环境中所起的后台正在运行或者被挂起的任务信息

jobs##查看后台运营的进程号

jobs -p##查看现在被终止或者退出的进程号

jobs -n##kill命令 终止一个前台进程可以使用Ctrl+C键 kill 通过top或者ps获取进程id号 kill [-s 信号 | -p ] [ -a ] 进程号 ...

##发送指定的信号到相应进程。不指定型号将发送SIGTERM(15)终止指定进程。关闭进程号12的进程

kill 12##等同于在前台运行PID为123的进程时按下Ctrl+C键

kill -2 123##如果任无法终止该程序可用“-KILL” 参数,其发送的信号为SIGKILL(9) ,将强制结束进程

kill -9 123##列出所有信号名称

##HUP 1 终端断线

##INT 2 中断(同 Ctrl + C)

##QUIT 3 退出(同 Ctrl + \)

##TERM 15 终止

##KILL 9 强制终止

##CONT 18 继续(与STOP相反, fg/bg命令)

##STOP 19 暂停(同 Ctrl + Z)

kill -l##得到指定信号的数值

kill -l KILL##杀死指定用户所有进程

kill -u peidalinux

kill -9 $(ps -ef | grep peidalinux) ##将后台中的命令调至前台继续运行 将进程123调至前台执行

fg 123##将一个在后台暂停的命令,变成继续执行

bg 123##该命令可以在你退出帐户/关闭终端之后继续运行相应的进程。nohup就是不挂起的意思 下面输出被重定向到myout.file文件中

nohup command > myout.file 2>&1 &##at:计划任务,在特定的时间执行某项工作,在特定的时间执行一次。

## 格式:at HH:MM YYYY-MM-DD //HH(小时):MM(分钟) YYYY(年)-MM(月份)-DD(日)

##HH[am pm]+D(天) days //HH(小时)[am(上午)pm(下午)]+days(天)

at 12:00(时间) //at命令设定12:00执行一项操作

#at>useradd aaa //在at命令里设定添加用户aaa

#ctrl+d //退出at命令

#tail -f /etc/passwd //查看/etc/passwd文件后十行是否增加了一个用户aaa##计划任务设定后,在没有执行之前我们可以用atq命令来查看系统没有执行工作任务。

atq##启动计划任务后,如果不想启动设定好的计划任务可以使用atrm命令删除。

atrm 1 //删除计划任务1##pstree命令:列出当前的进程,以及它们的树状结构 格式:pstree [选项] [pid|user]

pstree##nice命令:改变程序执行的优先权等级 应用程序优先权值的范围从-20~19,数字越小,优先权就越高。一般情况下,普通应用程序的优先权值(CPU使用权值)都是0,如果让常用程序拥有较高的优先权等级,自然启动和运行速度都会快些。需要注意的是普通用户只能在0~19之间调整应用程序的优先权值,只有超级用户有权调整更高的优先权值(从-20~19)。

nice [-n <优先等级>][--help][--version][命令]

nice -n 5 ls##sleep命令:使进程暂停执行一段时间

date;sleep 1m;date##renice命令 renice命令允许用户修改一个正在运行进程的优先权。利用renice命令可以在命令执行时调整其优先权。

##其中,参数number与nice命令的number意义相同。(1) 用户只能对自己所有的进程使用renice命令。(2) root用户可以在任何进程上使用renice命令。(3) 只有root用户才能提高进程的优先权

renice -5 -p 5200 #PID为5200的进程nice设为-5 ##pmap命令用于显示一个或多个进程的内存状态。其报告进程的地址空间和内存状态信息 #pmap PID

pmap 20367

javadump.sh

#!/bin/shDUMP_PIDS=`ps --no-heading -C java -f --width 1000 |awk '{print $2}'`

if [ -z "$DUMP_PIDS" ]; thenecho "The server $HOST_NAME is not started!"exit 1;

fiDUMP_ROOT=~/dump

if [ ! -d $DUMP_ROOT ]; thenmkdir $DUMP_ROOT

fiDUMP_DATE=`date +%Y%m%d%H%M%S`

DUMP_DIR=$DUMP_ROOT/dump-$DUMP_DATE

if [ ! -d $DUMP_DIR ]; thenmkdir $DUMP_DIR

fifor PID in $DUMP_PIDS ; do

#Full thread dump 用来查线程占用,死锁等问题$JAVA_HOME/bin/jstack $PID > $DUMP_DIR/jstack-$PID.dump 2>&1echo -e ".\c"

#打印出一个给定的Java进程、Java core文件或远程Debug服务器的Java配置信息,具体包括Java系统属性和JVM命令行参数。$JAVA_HOME/bin/jinfo $PID > $DUMP_DIR/jinfo-$PID.dump 2>&1echo -e ".\c"

#jstat能够动态打印jvm(Java Virtual Machine Statistics Monitoring Tool)的相关统计信息。如young gc执行的次数、full gc执行的次数,各个内存分区的空间大小和可使用量等信息。$JAVA_HOME/bin/jstat -gcutil $PID > $DUMP_DIR/jstat-gcutil-$PID.dump 2>&1echo -e ".\c"$JAVA_HOME/bin/jstat -gccapacity $PID > $DUMP_DIR/jstat-gccapacity-$PID.dump 2>&1echo -e ".\c"

#未指定选项时,jmap打印共享对象的映射。对每个目标VM加载的共享对象,其起始地址、映射大小及共享对象文件的完整路径将被打印出来, $JAVA_HOME/bin/jmap $PID > $DUMP_DIR/jmap-$PID.dump 2>&1echo -e ".\c"

#-heap打印堆情况的概要信息,包括堆配置,各堆空间的容量、已使用和空闲情况 $JAVA_HOME/bin/jmap -heap $PID > $DUMP_DIR/jmap-heap-$PID.dump 2>&1echo -e ".\c"

#-dump将jvm的堆中内存信息输出到一个文件中,然后可以通过eclipse memory analyzer进行分析

#注意:这个jmap使用的时候jvm是处在假死状态的,只能在服务瘫痪的时候为了解决问题来使用,否则会造成服务中断。$JAVA_HOME/bin/jmap -dump:format=b,file=$DUMP_DIR/jmap-dump-$PID.dump $PID 2>&1echo -e ".\c"

#显示被进程打开的文件信息

if [ -r /usr/sbin/lsof ]; then/usr/sbin/lsof -p $PID > $DUMP_DIR/lsof-$PID.dumpecho -e ".\c"fi

done

#主要负责收集、汇报与存储系统运行信息的。

if [ -r /usr/bin/sar ]; then/usr/bin/sar > $DUMP_DIR/sar.dump

echo -e ".\c"

fi

#主要负责收集、汇报与存储系统运行信息的。

if [ -r /usr/bin/uptime ]; then/usr/bin/uptime > $DUMP_DIR/uptime.dump

echo -e ".\c"

fi

#内存查看

if [ -r /usr/bin/free ]; then/usr/bin/free -t > $DUMP_DIR/free.dump

echo -e ".\c"

fi

#可以得到关于进程、内存、内存分页、堵塞IO、traps及CPU活动的信息。

if [ -r /usr/bin/vmstat ]; then/usr/bin/vmstat > $DUMP_DIR/vmstat.dump

echo -e ".\c"

fi

#报告与CPU相关的一些统计信息

if [ -r /usr/bin/mpstat ]; then/usr/bin/mpstat > $DUMP_DIR/mpstat.dump

echo -e ".\c"

fi

#报告与IO相关的一些统计信息

if [ -r /usr/bin/iostat ]; then/usr/bin/iostat > $DUMP_DIR/iostat.dump

echo -e ".\c"

fi

#报告与网络相关的一些统计信息

if [ -r /bin/netstat ]; then/bin/netstat > $DUMP_DIR/netstat.dump

echo -e ".\c"

fi

echo "OK!"

常用运维加固脚本

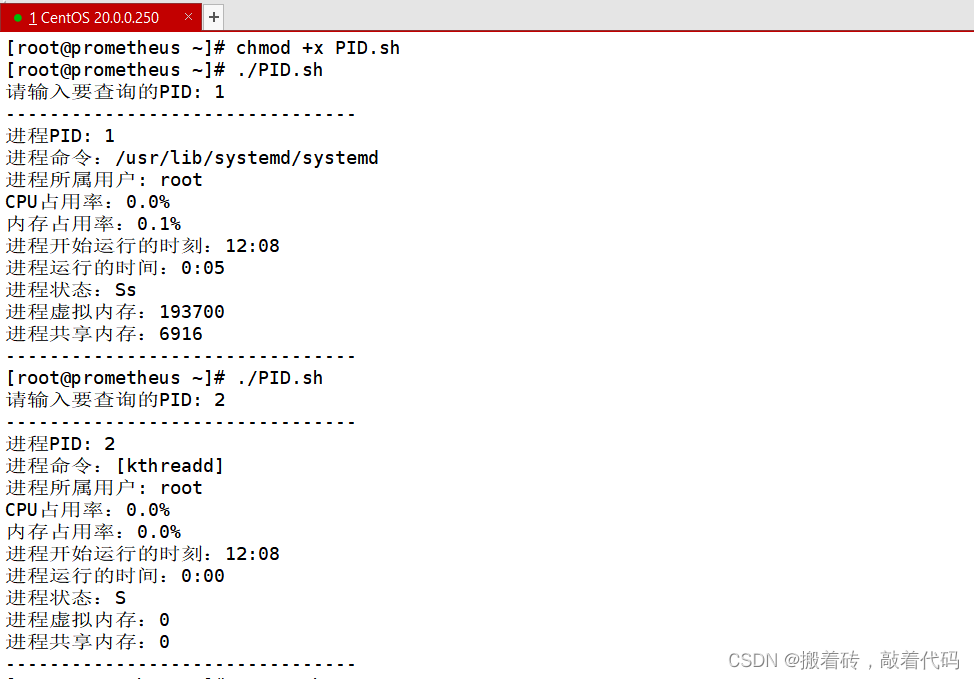

根据PID过滤进程所有信息

#! /bin/bash

# Function: 根据用户输入的PID,过滤出该PID所有的信息

read -p "请输入要查询的PID: " P

n=`ps -aux| awk '$2~/^'$P'$/{print $11}'|wc -l`

if [ $n -eq 0 ];thenecho "该PID不存在!!"exit

fi

echo "--------------------------------"

echo "进程PID: $P"

echo "进程命令:`ps -aux| awk '$2~/^'$P'$/{print $11}'`"

echo "进程所属用户: `ps -aux| awk '$2~/^'$P'$/{print $1}'`"

echo "CPU占用率:`ps -aux| awk '$2~/^'$P'$/{print $3}'`%"

echo "内存占用率:`ps -aux| awk '$2~/^'$P'$/{print $4}'`%"

echo "进程开始运行的时刻:`ps -aux| awk '$2~/^'$P'$/{print $9}'`"

echo "进程运行的时间:`ps -aux| awk '$2~/^'$P'$/{print $10}'`"

echo "进程状态:`ps -aux| awk '$2~/^'$P'$/{print $8}'`"

echo "进程虚拟内存:`ps -aux| awk '$2~/^'$P'$/{print $5}'`"

echo "进程共享内存:`ps -aux| awk '$2~/^'$P'$/{print $6}'`"

echo "--------------------------------"

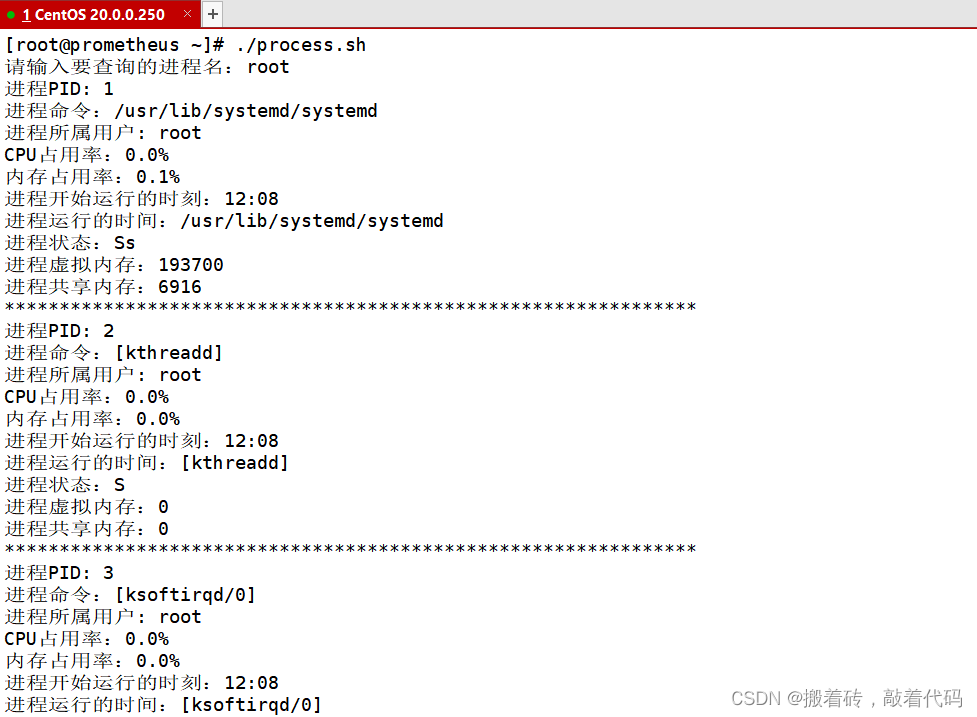

根据进程名过滤进程信息

会显示出该进程名包含的所有线程

#! /bin/bash

# Function: 根据输入的程序的名字过滤出所对应的PID,并显示出详细信息,如果有几个PID,则全部显示

read -p "请输入要查询的进程名:" NAME

N=`ps -aux | grep $NAME | grep -v grep | wc -l` ##统计进程总数

if [ $N -le 0 ];thenecho "该进程名没有运行!"

fi

i=1

while [ $N -gt 0 ]

doecho "进程PID: `ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $2}'`"echo "进程命令:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $11}'`"echo "进程所属用户: `ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $1}'`"echo "CPU占用率:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $3}'`%"echo "内存占用率:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $4}'`%"echo "进程开始运行的时刻:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $9}'`"echo "进程运行的时间:` ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $11}'`"echo "进程状态:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $8}'`"echo "进程虚拟内存:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $5}'`"echo "进程共享内存:`ps -aux | grep $NAME | grep -v grep | awk 'NR=='$i'{print $0}'| awk '{print $6}'`"echo "***************************************************************"let N-- i++

done

常用工具一键部署安装

#!/usr/bin/env bash# ---------------------------------------------------------------------------------

# 控制台颜色

BLACK="\033[1;30m"

RED="\033[1;31m"

GREEN="\033[1;32m"

YELLOW="\033[1;33m"

BLUE="\033[1;34m"

PURPLE="\033[1;35m"

CYAN="\033[1;36m"

RESET="$(tput sgr0)"

# ---------------------------------------------------------------------------------printf "${BLUE}\n"

cat << EOF

###################################################################################

# 安装常用命令工具

# 命令工具清单如下:

# 核心工具:df、du、chkconfig

# 网络工具:ifconfig、netstat、route、iptables

# IP工具:ip、ss、ping、tracepath、traceroute

# DNS工具:dig、host、nslookup、whois

# 端口工具:lsof、nc、telnet

# 下载工具:curl、wget

# 编辑工具:emacs、vim

# 流量工具:iftop、nethogs

# 抓包工具:tcpdump

# 压缩工具:unzip、zip

# 版本控制工具:git、subversion

#

###################################################################################

EOF

printf "${RESET}\n"printf "\n${GREEN}>>>>>>>>> 安装常用命令工具开始${RESET}\n"# 核心工具

printf "\n${CYAN}>>>> install coreutils(df、du)${RESET}\n"

yum install -y coreutils

printf "\n${CYAN}>>>> install chkconfig${RESET}\n"

yum install -y chkconfig# 网络工具

printf "\n${CYAN}>>>> install net-tools(ifconfig、netstat、route)${RESET}\n"

yum install -y net-tools

printf "\n${CYAN}>>>> install iptables${RESET}\n"

yum install -y iptables# IP工具

printf "\n${CYAN}>>>> install iputils(ping、tracepath)${RESET}\n"

yum install -y iputils

printf "\n${CYAN}>>>> install traceroute${RESET}\n"

yum install -y traceroute

printf "\n${CYAN}>>>> install iproute(ip、ss)${RESET}\n"

yum install -y iproute# 端口工具

printf "\n${CYAN}>>>> install lsof${RESET}\n"

yum install -y lsof

printf "\n${CYAN}>>>> install nc${RESET}\n"

yum install -y nc

printf "\n${CYAN}>>>> install netstat${RESET}\n"

yum install -y netstat# DNS工具

printf "\n${CYAN}>>>> install bind-utils(dig、host、nslookup)${RESET}\n"

yum install -y bind-utils

printf "\n${CYAN}>>>> install whois${RESET}\n"

yum install -y whois# 下载工具

printf "\n${CYAN}>>>> install curl${RESET}\n"

yum install -y curl

printf "\n${CYAN}>>>> install wget${RESET}\n"

yum install -y wget# 编辑工具

printf "\n${CYAN}>>>> install emacs${RESET}\n"

yum install -y emacs

printf "\n${CYAN}>>>> install vim${RESET}\n"

yum install -y vim# 流量工具

printf "\n${CYAN}>>>> install iftop${RESET}\n"

yum install -y iftop

printf "\n${CYAN}>>>> install nethogs${RESET}\n"

yum install -y nethogs# 抓包工具

printf "\n${CYAN}>>>> install tcpdump${RESET}\n"

yum install -y tcpdump# 压缩工具

printf "\n${CYAN}>>>> install unzip${RESET}\n"

yum install -y unzip# 版本控制工具

printf "\n${CYAN}>>>> install git${RESET}\n"

yum install -y git

printf "\n${CYAN}>>>> install subversion${RESET}\n"

yum install -y subversionprintf "\n${GREEN}<<<<<<<< 安装常用命令工具结束${RESET}\n"

常用lib库安装

lib库分为两种,一种是静态链接lib库或者叫做静态lib库,另一种叫做动态链接库dll库的lib导入库或称为lib导入库。

第一种是静态lib,包含了所有的代码实现的,是源代码文件.c或.cpp文件编译生成的,这个lib库就是文本形式的源代码编译后的二进制形式代码。

第二种就是lib导入库,这个库只是dll文件中的所有函数在dll文件中的地址的说明。

#!/usr/bin/env bash# ---------------------------------------------------------------------------------

# 控制台颜色

BLACK="\033[1;30m"

RED="\033[1;31m"

GREEN="\033[1;32m"

YELLOW="\033[1;33m"

BLUE="\033[1;34m"

PURPLE="\033[1;35m"

CYAN="\033[1;36m"

RESET="$(tput sgr0)"

# ---------------------------------------------------------------------------------printf "${BLUE}\n"

cat << EOF

###################################################################################

# 安装常见 lib

# 如果不知道命令在哪个 lib,可以使用 yum search xxx 来查找

# lib 清单如下:

# gcc gcc-c++ kernel-devel libtool

# openssl openssl-devel

# zlib zlib-devel

# pcre

###################################################################################

EOF

printf "${RESET}\n"printf "\n${GREEN}>>>>>>>>> 安装常见 lib 开始${RESET}\n"printf "\n${CYAN}>>>> install gcc gcc-c++ kernel-devel libtool${RESET}\n"

yum -y install make gcc gcc-c++ kernel-devel libtoolprintf "\n${CYAN}>>>> install openssl openssl-devel${RESET}\n"

yum -y install make openssl openssl-develprintf "\n${CYAN}>>>> install zlib zlib-devel${RESET}\n"

yum -y install make zlib zlib-develprintf "\n${CYAN}>>>> install pcre${RESET}\n"

yum -y install pcreprintf "\n${GREEN}<<<<<<<< 安装常见 lib 结束${RESET}\n"

系统检查脚本

#!/usr/bin/env bash##############################################################################

# console color

C_RESET="$(tput sgr0)"

C_BLACK="\033[1;30m"

C_RED="\033[1;31m"

C_GREEN="\033[1;32m"

C_YELLOW="\033[1;33m"

C_BLUE="\033[1;34m"

C_PURPLE="\033[1;35m"

C_CYAN="\033[1;36m"

C_WHITE="\033[1;37m"

##############################################################################printf "${C_PURPLE}"

cat << EOF

###################################################################################

# 系统信息检查脚本

###################################################################################

EOF

printf "${C_RESET}"[[ $(id -u) -gt 0 ]] && echo "请用root用户执行此脚本!" && exit 1

sysversion=$(rpm -q centos-release | cut -d- -f3)

double_line="==============================================================="

line="----------------------------------------------"# 打印头部信息

printHeadInfo() {cat << EOF

+---------------------------------------------------------------------------------+

| 欢迎使用 【系统信息检查脚本】 |

+---------------------------------------------------------------------------------+

EOF

}# 打印尾部信息

printFootInfo() {cat << EOF

+---------------------------------------------------------------------------------+

| 脚本执行结束,感谢使用!|

+---------------------------------------------------------------------------------+

EOF

}options=( "获取系统信息" "获取服务信息" "获取CPU信息" "获取系统网络信息" "获取系统内存信息" "获取系统磁盘信息" "获取CPU/内存占用TOP10" "获取系统用户信息" "输出所有信息" "退出" )

printMenu() {printf "${C_BLUE}"printf "主菜单:\n"for i in "${!options[@]}"; doindex=`expr ${i} + 1`val=`expr ${index} % 2`printf "\t(%02d) %-30s" "${index}" "${options[$i]}"if [[ ${val} -eq 0 ]]; thenprintf "\n"fidoneprintf "${C_BLUE}请输入需要执行的指令:\n"printf "${C_RESET}"

}# 获取系统信息

get_systatus_info() {sys_os=$(uname -o)sys_release=$(cat /etc/redhat-release)sys_kernel=$(uname -r)sys_hostname=$(hostname)sys_selinux=$(getenforce)sys_lang=$(echo $LANG)sys_lastreboot=$(who -b | awk '{print $3,$4}')sys_runtime=$(uptime | awk '{print $3,$4}' | cut -d, -f1)sys_time=$(date)sys_load=$(uptime | cut -d: -f5)cat << EOF

【系统信息】

系统: ${sys_os}

发行版本: ${sys_release}

系统内核: ${sys_kernel}

主机名: ${sys_hostname}

selinux状态: ${sys_selinux}

系统语言: ${sys_lang}

系统当前时间: ${sys_time}

系统最后重启时间: ${sys_lastreboot}

系统运行时间: ${sys_runtime}

系统负载: ${sys_load}

EOF

}# 获取CPU信息

get_cpu_info() {Physical_CPUs=$(grep "physical id" /proc/cpuinfo | sort | uniq | wc -l)Virt_CPUs=$(grep "processor" /proc/cpuinfo | wc -l)CPU_Kernels=$(grep "cores" /proc/cpuinfo | uniq | awk -F ': ' '{print $2}')CPU_Type=$(grep "model name" /proc/cpuinfo | awk -F ': ' '{print $2}' | sort | uniq)CPU_Arch=$(uname -m)cat << EOF

【CPU信息】

物理CPU个数:$Physical_CPUs

逻辑CPU个数:$Virt_CPUs

每CPU核心数:$CPU_Kernels

CPU型号:$CPU_Type

CPU架构:$CPU_Arch

EOF

}# 获取服务信息

get_service_info() {port_listen=$(netstat -lntup | grep -v "Active Internet")kernel_config=$(sysctl -p 2> /dev/null)if [[ ${sysversion} -gt 6 ]]; thenservice_config=$(systemctl list-unit-files --type=service --state=enabled | grep "enabled")run_service=$(systemctl list-units --type=service --state=running | grep ".service")elseservice_config=$(/sbin/chkconfig | grep -E ":on|:启用" | column -t)run_service=$(/sbin/service --status-all | grep -E "running")ficat << EOF

【服务信息】

${service_config}${line}

运行的服务:

${run_service}${line}

监听端口:

${port_listen}${line}

内核参考配置:

${kernel_config}

EOF

}# 获取系统内存信息

get_mem_info() {check_mem=$(free -m)MemTotal=$(grep MemTotal /proc/meminfo | awk '{print $2}') #KBMemFree=$(grep MemFree /proc/meminfo | awk '{print $2}') #KBlet MemUsed=MemTotal-MemFreeMemPercent=$(awk "BEGIN {if($MemTotal==0){printf 100}else{printf \"%.2f\",$MemUsed*100/$MemTotal}}")report_MemTotal="$((MemTotal/1024))" "MB" #内存总容量(MB)report_MemFree="$((MemFree/1024))" "MB" #内存剩余(MB)report_MemUsedPercent=$(free | sed -n '2p' | gawk 'x = int(( $3 / $2 ) * 100) {print x}' | sed 's/$/%/')cat << EOF

【内存信息】

内存总容量(MB): ${report_MemTotal}

内存剩余量(MB):${report_MemFree}

内存使用率: ${report_MemUsedPercent}

EOF

}# 获取系统网络信息

get_net_info() {pri_ipadd=$(ip addr | awk '/^[0-9]+: / {}; /inet.*global/ {print gensub(/(.*)\/(.*)/, "\\1", "g", $2)}')pub_ipadd=$(curl ifconfig.me -s)gateway=$(ip route | grep default | awk '{print $3}')mac_info=$(ip link | egrep -v "lo" | grep link | awk '{print $2}')dns_config=$(egrep -v "^$|^#" /etc/resolv.conf)route_info=$(route -n)cat << EOF

【网络信息】

系统公网地址:${pub_ipadd}

系统私网地址:${pri_ipadd}

网关地址:${gateway}

MAC地址:${mac_info}

路由信息:

${route_info}

DNS 信息:

${dns_config}

EOF

}# 获取系统磁盘信息

get_disk_info() {disk_info=$(fdisk -l | grep "Disk /dev" | cut -d, -f1)disk_use=$(df -hTP | awk '$2!="tmpfs"{print}')disk_percent=$(free | sed -n '2p' | gawk 'x = int(( $3 / $2 ) * 100) {print x}' | sed 's/$/%/')disk_inode=$(df -hiP | awk '$1!="tmpfs"{print}')cat << EOF

【磁盘信息】

${disk_info}

磁盘使用: ${disk_use}

磁盘使用百分比: ${disk_percent}

inode信息: ${disk_inode}

EOF

}# 获取系统用户信息

get_sys_user() {login_user=$(awk -F: '{if ($NF=="/bin/bash") print $0}' /etc/passwd)ssh_config=$(egrep -v "^#|^$" /etc/ssh/sshd_config)sudo_config=$(egrep -v "^#|^$" /etc/sudoers | grep -v "^Defaults")host_config=$(egrep -v "^#|^$" /etc/hosts)crond_config=$(for cronuser in /var/spool/cron/*; dols ${cronuser} 2> /dev/null | cut -d/ -f5; egrep -v "^$|^#" ${cronuser} 2> /dev/null;echo "";done)cat << EOF

【用户信息】

系统登录用户:

${login_user}${line}

ssh 配置信息:

${ssh_config}${line}

sudo 配置用户:

${sudo_config}${line}

定时任务配置:

${crond_config}${line}

hosts 信息:

${host_config}

EOF

}# 获取CPU/内存占用TOP10

get_process_top_info() {top_title=$(top -b n1 | head -7 | tail -1)cpu_top10=$(top -b n1 | head -17 | tail -11)mem_top10=$(top -b n1 | head -17 | tail -10 | sort -k10 -r)cat << EOF

【TOP10】

CPU占用TOP10:

${cpu_top10}

内存占用TOP10:

${top_title}${mem_top10}

EOF

}show_dead_process() {printf "僵尸进程:\n"ps -al | gawk '{print $2,$4}' | grep Z

}get_all_info() {get_systatus_infoecho ${double_line}get_service_infoecho ${double_line}get_cpu_infoecho ${double_line}get_net_infoecho ${double_line}get_mem_infoecho ${double_line}get_disk_infoecho ${double_line}get_process_top_infoecho ${double_line}get_sys_user

}main() {while [[ 1 ]]doprintMenuread optionlocal index=$[ ${option} - 1 ]case ${options[${index}]} in"获取系统信息")get_systatus_info ;;"获取服务信息")get_service_info ;;"获取CPU信息")get_cpu_info ;;"获取系统网络信息")get_net_info ;;"获取系统内存信息")get_mem_info ;;"获取系统磁盘信息")get_disk_info ;;"获取CPU/内存占用TOP10")get_process_top_info ;;"获取系统用户信息")get_sys_user ;;"输出所有信息")get_all_info > sys.logprintf "${C_GREEN}信息已经输出到 sys.log 中。${C_RESET}\n\n";;"退出")exit ;;*)clearecho "抱歉,不支持此选项" ;;esacdone

}######################################## MAIN ########################################

printHeadInfo

main

printFootInfo

printf "${C_RESET}"SPN 日常巡查脚本

SPN(Secret Private Network),面向业务的内网安全解决方案,即加密虚拟网络

#!/bin/bash

echo " ___ ___ ___/ /\ / /\ /__/\/ /:/_ / /::\ \ \:\/ /:/ /\ / /:/\:\ \ \:\/ /:/ /::\ / /:/~/:/ _____\__\:\/__/:/ /:/\:\ /__/:/ /:/ /__/::::::::\\ \:\/:/~/:/ \ \:\/:/ \ \:\~~\~~\/\ \::/ /:/ \ \::/ \ \:\ \__\/ /:/ \ \:\ \ \:\/__/:/ \ \:\ \ \:\\__\/ \__\/ \__\/

"

echo "SPN 日常巡查脚本输出"

# 清理屏幕

clearfunction bash_os() {# "系统基础信息"#内核信息kernel=$(uname -r)#操作系统版本release=$(cat /etc/redhat-release)#主机名称hostname=$HOSTNAME#当前时间及运行时间dateload=$(uptime | awk -F "," '{print $1}')# 当前登录用户数users=$(uptime | awk -F "," '{print $3}')echo -e "\n\033[32m############## 系统基础信息 #######\033[0m\n"echo -e "\033[32m------------------------------------\033[0m"echo -e "|内核信息:\033[31m $kernel \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|操作系统版本:\033[31m $release \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|当前时间及运行时间:\033[31m $dateload \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|当前登录用户数:\033[31m $users \033[0m"echo -e "\033[32m------------------------------------\033[0m"

}function memory() {# 内存相关数据统计`free -m`#总内存容量mem_total=$(free -m | awk '/Mem/{printf "%.2fG", $2/1024}')# 用户程序占用内存量mem_user=$(free -m | awk '/Mem/{printf "%.2fG", $3/1024}')# 多进程共享占用内存量mem_shared=$(free -m | awk '/Mem/{printf "%.2fG", $5/1024}')#缓存占用内存量mem_buff_cache=$(free -m | awk '/Mem/{printf "%.fMB", $(NF-1)}')#空闲内存容量mem_free=$(free -m | awk '/Mem/{printf "%.2fG", $4/1024 }')# 剩余可用内存容量mem_available=$(free -m | awk 'NR==2{printf "%.2fG",$NF/1024}')# 可用内存使用占比mem_percentage=$(free -m | awk '/Mem/{printf "%.2f", $NF/$2*100}')#总的交换分区容量swap_total=$(free -m | awk '/Swap/{printf "%.2fG", $2/1024}')#用户使用的交换分区容量swap_user=$(free -m | awk '/Swap/{printf "%.2fG",$3/1024}')#剩余交换分区容量swap_free=$(free -m | awk '/Swap/{printf "%.2fG",$4/1024}')#可用交换分区占比swap_percentage=$(free -m | awk '/Swap/{printf "%.2f",$4/$2*100}')#占用内存资源最多的10个进程列表top_proc_mem=$(ps --no-headers -eo rss,args | sort -k1 -n -r | head -10)echo -e "\n\033[32m################## 内存 ############\033[0m\n"echo -e "\033[32m------------------------------------\033[0m"echo -e "|总内存容量:\033[31m $mem_total \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|用户程序内存量:\033[31m $mem_user \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|多进程共享内存量:\033[31m $mem_shared \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|缓存占用内存量:\033[31m $mem_buff_cache \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|空闲内存容量:\033[31m $mem_free \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|剩余可用内存容量:\033[31m $mem_available \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|可用内存百分比:\033[31m $mem_percentage% \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "\033[32m############## 交换分区 #############\033[0m\n"echo -e "\033[32m------------------------------------\033[0m"echo -e "总的交换分区容量:\033[31m $swap_total \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|用户使用的交换分区容量:\033[31m $swap_user \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|剩余交换分区容量:\033[31m ${swap_free}"echo -e "\033[32m------------------------------------\033[0m"if [ $(free -m | awk '/Swap/{print $2}') -ne 0 ]; thenecho -e "|可用交换分区占比:\033[31m $swap_percentage% \033[0m"echo -e "\033[32m------------------------------------\033[0m"fiecho -e "|占用内存资源最多的10个进程列表:"echo -e "\033[31m$top_proc_mem% \033[0m"echo -e "\033[32m------------------------------------\033[0m"

}function cpu() {#CPU型号cpu_info=$(LANG=C lscpu | awk -F: '/Model name/ {print $2}')#CPU内核数量cpu_core=$(awk '/processor/{core++} END{print core}' /proc/cpuinfo)#CPU最近1/5/15分钟的平均负载load1515=$(uptime | sed 's/,/ /g' | awk '{for(i=NF-2;i<=NF;i++)print $i }' | xargs)#发生中断数量irq=$(vmstat 1 1 | awk 'NR==3{print $11}')#上下文切换数量cs=$(vmstat 1 1 | awk 'NR==3{print $12}')#占用CPU资源最多的10个进程列表top_proc_cpu=$(ps --no-headers -eo %cpu,args | sort -k1 -n -r | head -10)echo -e "\n\033[32m################## CPU 相关 ############\033[0m\n"echo -e "\033[32m------------------------------------\033[0m"echo -e "|CPU型号:\033[31m$cpu_info \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|CPU内核数量:\033[31m$cpu_core \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|CPU最近1/5/15分钟的平均负载:\033[31m$load1515 \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|CPU中断数量:\033[31m$irq \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|上下文切换数量:\033[31m$cs \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|占用CPU资源最多的10个进程列表:"echo -e "\033[31m$top_proc_cpu \033[0m"echo -e "\033[32m------------------------------------\033[0m"}function disk_io() {#分区挂载信息disk=$(df -h)# 磁盘总数disk_total=$(vmstat -D | awk 'NR==1{print $1}')# 分区总数disk_sub=$(vmstat -D | awk 'NR==2{print $1}')#磁盘分区信息lsblk_=$(lsblk -n)#写入磁盘的总块数bo=$(vmstat 1 1 | awk 'NR==3{print $10}')#从磁盘读出的块数bi=$(vmstat 1 1 | awk 'NR==3{print $9}')#每秒写磁盘块的速率wa=$(vmstat 1 1 | awk 'NR==3{print $16}')echo -e "\n\033[32m################## 磁盘IO 相关 ############\033[0m\n"echo -e "\033[32m------------------------------------\033[0m"echo -e "|磁盘总数:\033[31m$disk_total \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|分区总数:\033[31m$disk_sub \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|磁盘分区信息:"echo -e "\033[31m$lsblk_ \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|写入磁盘的总块数:\033[31m$bo \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|从磁盘读出的块数:\033[31m$bi \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|每秒写磁盘块的速率:\033[31m$wa \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|分区挂载信息:"echo -e "\033[31m$disk \033[0m"echo -e "\033[32m------------------------------------\033[0m"}function procs() {#进程数量procs=$(ps aux | wc -l)#用户的最大进程数ulimit_=$(ulimit -u)#内核设置的最大进程数pid_max=$(sysctl kernel.pid_max | awk '{print $3}')echo -e "\n\033[32m################## 进程 相关 ############\033[0m\n"echo -e "\033[32m------------------------------------\033[0m"echo -e "|进程数量:\033[31m$procs \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|用户的最大进程数:\033[31m$ulimit_ \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|内核设置的最大进程数:\033[31m$pid_max \033[0m"echo -e "\033[32m------------------------------------\033[0m"}function network() {#获取网卡流量信息,接收|发送的数据流量,单位为字节(bytes)net_monitor=$(cat /proc/net/dev | tail -n +3 | awk 'BEGIN{ print "网卡名称 入站数据流量(bytes) 出站数据流量(bytes)"} {print $1,$2,$10}' | column -t)#获取暴露端口信息ip_port=$(ss -ntulpa)#本地IP地址列表localip=$(ip a s | awk '/inet /{print $2}' )echo -e "\n\033[32m################## 网络 相关 ############\033[0m\n"echo -e "|本地IP地址列表:"echo -e "\033[31m$localip \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|获取网卡流量信息:"echo -e "\033[31m$net_monitor \033[0m"echo -e "\033[32m------------------------------------\033[0m"echo -e "|获取暴露端口信息:"echo -e "\033[31m$ip_port \033[0m"echo -e "\033[32m------------------------------------\033[0m"}case $1 in

all)bash_osmemorycpudisk_ioprocsnetwork;;

bash_os)bash_os;;

memory)memory;;

cpu)cpu;;

disk_io)disk_io;;

procs)procs;;

network)network;;

*)echo "Usage: bash_os|memory|cup|disk_io|procs|network|all";;

esac

ffmpeg脚本

FFmpeg是一套可以用来记录、转换数字音频、视频,并能将其转化为流的开源计算机程序

打开进程,并判断进程数量

原版本:

#!/bin/bash

ffmpegPid = $( ps -ef | grep -E 'ffmpeg.*$1$2$3' | grep -v 'grep' | awk '{print $2}')

if [ -z "$ffmpegPid" ]

thenthreadNum = $( ps -ef | grep ffmpeg | grep -v 'grep' | wc -l | awk '{print $1}')if [$threadNum -gt 10]then# 线程数大于10个,需要干掉ffmpeg线程echo threadNum too more!for thread in $threadNumdokill -9 ${thread}doneelsenohup ffmpeg -re -rtsp_transport tcp -i "rtsp://ip:port/dss/monitor/params?cameraid=$1%24$2&substream=$3" -vcodec libx264 -vprofile baseline -acodec aac -ar 44100 -strict -2 -ac 1 -f flv -s 1280x720 -q 10 $4 > /Users/chuxiaowei/ffmpeg$1$2$3.log 2>&1 &ps -ef | grep -E 'ffmpeg.*$1$2$3' | grep -v 'grep' | awk '{print $2}'fi

elseps -ef | grep -E 'ffmpeg.*$1$2$3' | grep -v 'grep' | awk '{print $2}'

fi

改进之后:

#!/bin/bash

ffmpegPid = $( ps -ef | grep -E 'ffmpeg.*$1$2$3' | grep -v 'grep' | awk '{print $2}')

if [ -z "$ffmpegPid" ]

thennohup ffmpeg -re -rtsp_transport tcp -i "rtsp://ip:port/dss/monitor/params?cameraid=$1%24$2&substream=$3" -vcodec libx264 -vprofile baseline -acodec aac -ar 44100 -strict -2 -ac 1 -f flv -s 1280x720 -q 10 $4 > /root/ffmpeg$1$2$3.log 2>&1 &ps -ef | grep -E 'ffmpeg.*$4*' | grep -v 'grep' | awk '{print $2}'

fi

关闭进程

#关闭进程

#!/bin/bash

ps -ef | grep -E 'ffmpeg.*$1*' | grep -v 'grep' | awk '{print $2}' | xargs kill

java jar包启动-剔除Pom中依赖

#!/bin/bash

pid=$(ps -ef | grep java | grep -E '*rtsptortmp.*' | awk '{print $2}')

echo "pid = $pid"

if [ $pid ];thenkill -9 $pidecho "kill the process rtsptortmp pid = $pid"

finohup java -Dloader.path=/root/rtsptortmplib -jar rtsptortmp-1.0-SNAPSHOT.jar --spring.profiles.active=prod > /root/logs/rtsptortmp.log 2>&1 &

tail -f /root/logs/rtsptortmp.log

Java jar包通用启动脚本

eg:

./start.sh java.jar

#!/bin/bash

pid=$(ps -ef | grep java | grep -E '*$1*' | awk '{print $2}')

echo "pid = $pid"

if [ $pid ];thenkill -9 $pidecho "kill the process pid = $pid"

finohup java -jar -Xms256m -Xmx256m $1 --spring.profiles.active=prod > /root/logs/$1.log 2>&1 &

tail -f /root/logs/$1.log

查看centos配置信息脚本

#!/bin/bashecho ======= cpu个数: =======

grep 'physical id' /proc/cpuinfo | sort -u | wc -lecho ======= cpu核数: =======

cat /proc/cpuinfo | grep "cpu cores" | uniqecho ======= cpu型号: =======

cat /proc/cpuinfo | grep 'model name' |uniqecho ======= cpu内核频率: =======

cat /proc/cpuinfo |grep MHz|uniqecho ======= cpu统计信息: =======

lscpuecho ======= 内存总数: =======

cat /proc/meminfo | grep MemTotalecho ======= 内核版本: =======

cat /proc/versionecho ======= 操作系统内核信息: =======

uname -aecho ======= 磁盘信息: =======

fdisk -l

Jenkins项目打包发布脚本

#!/bin/bash//传入的war包名称

name=$1

//war包所在目录

path=$2

//上传的war包位置

path_w=$3

//如果项目正在运行就杀死进程

if [ -f "$path/$name" ];thenecho "delete the file $name"rm -f $path/$name

elseecho "the file $name is not exist"

fi

//把jenkins上传的war包拷贝到我们所在目录

cp $path_w/$name $path/

echo "copy the file $name from $path_w to $path"//获取该项目正在运行的pid

pid=$(ps -ef | grep java | grep $name | awk '{print $2}')

echo "pid = $pid"

//如果项目正在运行就杀死进程

if [ $pid ];thenkill -9 $pidecho "kill the process $name pid = $pid"

elseecho "process is not exist"

fi

//要切换到项目目录下才能在项目目录下生成日志

cd $path

//防止被jenkins杀掉进程 BUILD_ID=dontKillMe

BUILD_ID=dontKillMe

//启动项目

nohup java -server -Xms256m -Xmx512m -jar -Dserver.port=20000 $name >> nohup.out 2>&1 &

//判断项目是否启动成功

pid_new=$(ps -ef | grep java | grep $name | awk '{print $2}')

if [ $? -eq 0 ];then

echo "this application $name is starting pid_new = $pid_new"

else

echo "this application $name startup failure"

fi

echo $! > /var/run/myClass.pid

echo "over"

注意:SQL Server以下脚本目前还不完善(AlwaysOn相关 到 Agent作业备份)

AlwaysOn相关

节点切换监控

节点切换作业控制

SQL Server 邮件脚本

Mysql-使用脚本进行分库分表备份

数据库-数据备份

备份作业

数据一致性检查

Agent作业备份

大部分脚本针对于中小数据库,由于工作性质涉及很多客户部署维护作业,所以力求总结出一套比较完善的脚本,一键部署。

AlwaysOn相关

节点切换监控

declare @role VARCHAR(8000); declare @email_conetent varchar(8000);--存放邮件正文 declare @name varchar(100);declare @lastsend int;

declare @subject_str varchar(100);set @name =(select @@servername)

set @subject_str = @name + 'always on 预警'set @role=(SELECT role FROM sys.dm_hadr_availability_replica_states WHERE is_local=1)set @lastsend = (select isnull(datediff(MINUTE,max(send_request_date), getdate()),6000) from [msdb].[dbo].[sysmail_mailitems] where subject = @subject_str)if @role >1 and @lastsend > 30 ----30分钟发送一次begin set @email_conetent=(@name+'当前节点不是主节点,发生故障转移')print(@email_conetent)

print(@lastsend)

--if @lastsend > 1--发送邮件 --邮件正文内容EXEC msdb.dbo.sp_send_dbmail @profile_name = 'DB-mail', --配置文件名称@recipients = 'KK_XXX@163.COM', --收件email地址@subject = @subject_str, --邮件主题@body = @email_conetent end

节点切换作业控制

作业可以采用手动控制或如下脚本,也可以修改作业在作业执行前增加节点判断

--------------------------判断当前节点是否为主节点 如果不是则禁用作业 -------

------------节点 切换为主节点则启用JOB ------------

DECLARE @ROLE tinyint

DECLARE @ENABLE tinyint

----判断是否是主节点 --1 主节点SELECT @role=role FROM sys.dm_hadr_availability_replica_states WHERE is_local=1--判断JOB状态 --0 禁用 1 启用

--以syspolicy_purge_history 为 参照 --如果 禁用或删除syspolicy_purge_history请修改 @ENABLE下段查询

SELECT @ENABLE = [ENABLED]

FROM MSDB.[dbo].[sysjobs]

WHERE NAME = 'syspolicy_purge_history'-----第一次切换 辅助节点没有创建CDC作业 job 则创建作业 [category_id] = 13 CDC LOG SCAN JOB

if not exists (select 1 from msdb.dbo.sysjobs where [category_id]= 13 or [category_id]= 16 ) and @ROLE = 1

begin

EXEC sys.sp_cdc_add_job @job_type = 'capture';

EXEC sys.sp_cdc_add_job @job_type = 'cleanup';

end---primary and job disable set job enable

IF @ROLE = 1 and @ENABLE = 0

BEGIN----如果存在原有作业为禁用,无法确定哪些JOB需要开启....所以此处最好手动维护作业的启用和禁用

EXEC msdb.dbo.sp_update_job@job_name = N'XXXXX',@enabled = 1 ;-----执行 CDC

EXEC msdb.dbo.sp_start_job @job_name = N'cdc.XX_capture'

EXEC msdb.dbo.sp_start_job @job_name = N'cdc.XX_cleanup'

end

---not primary and job enable set disable

IF @ROLE <> 1 and @ENABLE = 1

BEGIN

----如果存在原有作业为禁用,无法确定哪些JOB需要开启....所以此处最好手动维护作业的启用和禁用

EXEC msdb.dbo.sp_update_job@job_name = N'XXXXX',@enabled = 0 ;ENDSQL Server 邮件脚本

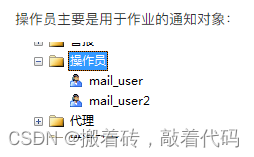

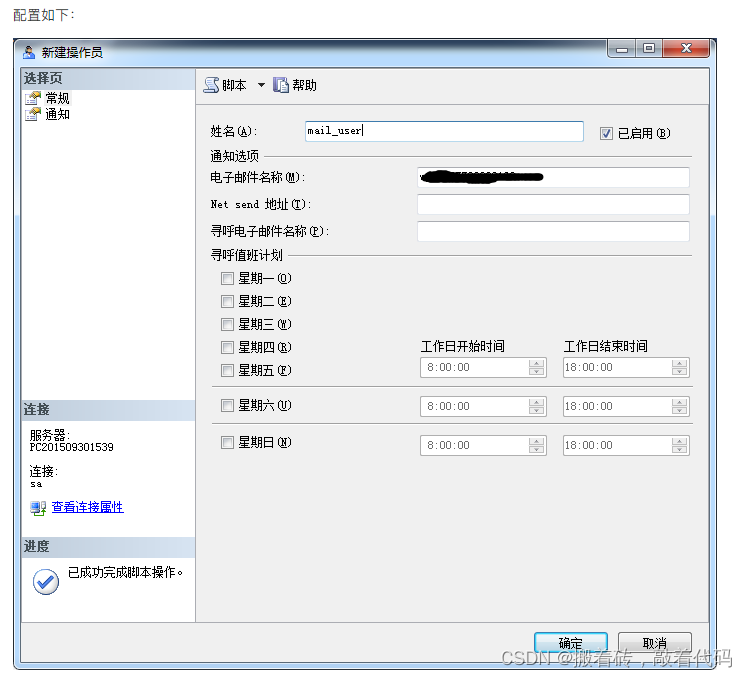

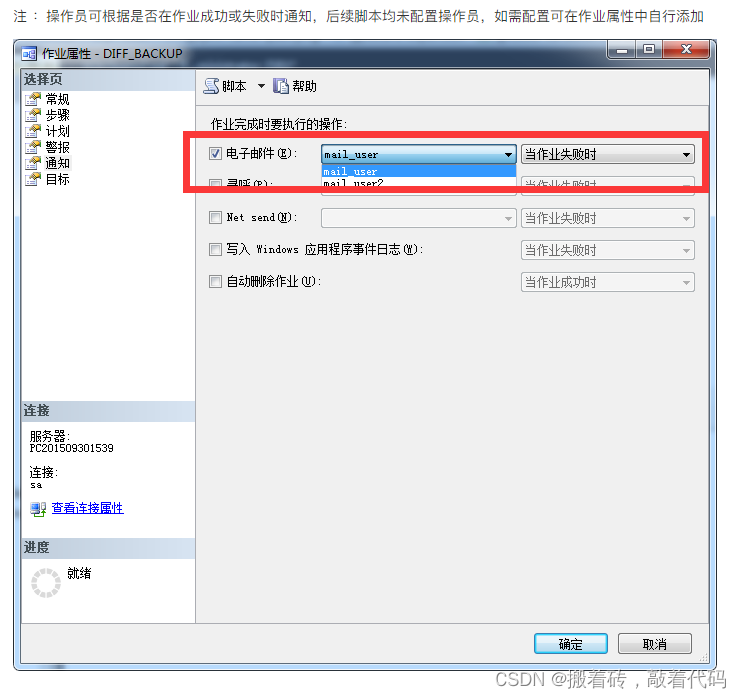

邮件主要用来监控作业是否运行成功,如果您已经配置了类似zabbix等软件请忽略

配置邮件服务

--SQL Server 并没有内置邮件服务器(Mail Server),它跟我们发送邮件一样,需要用户名和密码通过 SMTP(Simple Message Transfer Protocol)去连接邮件服务器。我们想让 SQL Server 来发送邮件,首先要告诉它用户名称,密码,服务器地址,网络传送协议,邮件服务器的端口。。。等信息。

-- 以下脚本实现了数据库邮件的配置:

----下面是具体的配置邮件步骤

----在 sa 系统帐户下运行。

--

--1. 启用 SQL Server 邮件功能。

use master

go

exec sp_configure 'show advanced options',1

go

reconfigure with override

go

exec sp_configure 'Database Mail XPs',1

go

reconfigure with override

go

--2. 在 SQL Server 中添加邮件帐户(account)

exec msdb..sysmail_add_account_sp@account_name = '163yx' -- 邮件帐户名称(SQL Server 使用),@email_address = 'kk_XXXX@163.com' -- 发件人邮件地址,@display_name = null -- 发件人姓名,@replyto_address = null,@description = null,@mailserver_name = 'smtp.163.com' -- 邮件服务器地址,@mailserver_type = 'SMTP' -- 邮件协议(SQL 2005 只支持 SMTP),@port = 25 -- 邮件服务器端口,@username = 'kk_XXXX@163.com' -- 用户名,@password = 'XXXXX' -- 密码,@use_default_credentials = 0,@enable_ssl = 0,@account_id = null--3. 在 SQL Server 中添加 profile

exec msdb..sysmail_add_profile_sp @profile_name = 'dba_profile3' -- profile 名称 ,@description = 'dba mail profile' -- profile 描述 ,@profile_id = null-- 在 SQL Server 中映射 account 和 profile

exec msdb..sysmail_add_profileaccount_sp @profile_name = 'dba_profile3' -- profile 名称 ,@account_name = '163yx' -- account 名称 ,@sequence_number = 1 -- account 在 profile 中顺序 --5. 利用 SQL Server Database Mail 功能发送邮件。

exec msdb..sp_send_dbmail @profile_name = 'dba_profile3' -- profile 名称 ,@recipients = 'kk_XXXX@163.com;kk2_XXXX@163.com' -- 收件人邮箱 ,@subject = 'SQL Server Mail 测试' -- 邮件标题 ,@body = 'Hello Mail!测试' -- 邮件内容 ,@body_format = 'TEXT' -- 邮件格式 ,@file_attachments = 'c:\a.txt' --邮件附件--6. 查看邮件发送情况:

use msdb

go

select * from sysmail_allitems

select * from sysmail_mailitems

select * from sysmail_event_log --如果不是以 sa 帐户发送邮件,则可能会出现错误:

--

--Msg 229, Level 14, State 5, Procedure sp_send_dbmail, Line 1

--EXECUTE permission denied on object 'sp_send_dbmail', database 'msdb', schema 'dbo'.

--

--这是因为,当前 SQL Server 登陆帐户(login),在 msdb 数据库中没有发送数据库邮件的权限,需要加入 msdb 数据库用户,并通过加入 sp_addrolemember 角色赋予权限。假设该SQL Server 登陆帐户名字为 “dba”

--

--use msdb

--go

--

--create user dba for login dba

--go

--

--exec dbo.sp_addrolemember @rolename = 'DatabaseMailUserRole',

-- @membername = 'dba'

--go

--

--此时,再次发送数据库邮件,仍可能有错误:

--

--Msg 14607, Level 16, State 1, Procedure sp_send_dbmail, Line 119

--profile name is not valid

--

--虽然,数据库用户 “dba” 已经在 msdb 中拥有发送邮件的权限了,但这还不够,他还需要有使用 profile:“dba_profile” 的权限。

--

--use msdb

--go

--

--exec sysmail_add_principalprofile_sp @principal_name = 'dba'

-- ,@profile_name = 'dba_profile'

-- ,@is_default = 1

--

--从上面的参数 @is_default=1 可以看出,一个数据库用户可以在多个 mail profile 拥有发送权限。--EXEC msdb.dbo.sysmail_configure_sp 'MaxFileSize', 100000000 (字节)设置邮件.note配置操作员

USE [msdb]

GO

EXEC msdb.dbo.sp_add_operator @name=N'mail_user2', @enabled=1, @pager_days=0, @email_address=N'KK_XXXX.163.COM'

GO

Mysql-使用脚本进行分库分表备份

[root@ctos3 ~]# cat bak.sh

#!/bin/bashMYUSER="root"

MYPASS="guoke123"

MYLOG="mysql -u$MYUSER -p$MYPASS -e"

MYDUMP="mysqldump -u$MYUSER -p$MYPASS -x -F"

DBLIST=$($MYLOG "show databases;" | sed 1d | grep -Ev 'info|mysq|per|sys')

DIR=/backup

[ ! -d $DIR ] && mkdir $DIR

cd $DIRfor dbname in $DBLIST

doTABLIST=$($MYLOG "show tables from $dbname;" | sed 1d)

for tabname in $TABLIST

domkdir -p $DIR/$dbname$MYDUMP $dbname $tabname --events |gzip > $DIR/${dbname}/${tabname}_$(date +%F_%T).sql.gz

done

done

数据库-数据备份

备份方案:每天全备份、6小时一次差异备份、一小时一次日志备份。

备份存储过程

存储过程创建后会保留在master库中,存储过程主要控制备份逻辑,备份路径等。

存储过程中只有一个类型参数,用于控制全备/差异/日志备份,可根据需要修改。

USE [master]

GO/****** Object: StoredProcedure [dbo].[sp_BackupDatabase] Script Date: 01/22/2015 13:52:46 ******/

SET ANSI_NULLS ON

GOSET QUOTED_IDENTIFIER ON

GO-- Author: KK-- Create date: 2016-09-27-- Description: 备份数据库,备份路径F:\KK_BackUp\ 可自行修改-- http://www.cnblogs.com/double-K/-- Parameter1: 备份类型 F=全部, D=差异, L=日志alter PROCEDURE [dbo].[sp_BackupDatabase]

@backupType CHAR(1)

AS

BEGIN

SET NOCOUNT ON;declare @filepath_backup varchar(100)

declare @dateTime varchar(30),@del_time_stamp varchar(50)

DECLARE @sqlCommand NVARCHAR(1000)---创建数据库对应文件夹

EXECUTE master.dbo.xp_create_subdir N'F:\KK_BackUp\Full\'

EXECUTE master.dbo.xp_create_subdir N'F:\KK_BackUp\Difference\'

EXECUTE master.dbo.xp_create_subdir N'F:\KK_BackUp\Log_Bak\'IF @backupType = 'F'

set @filepath_backup='F:\KK_BackUp\Full\'

IF @backupType = 'D'

set @filepath_backup='F:\KK_BackUp\Difference\'

IF @backupType = 'L'

set @filepath_backup='F:\KK_BackUp\Log_Bak\'SET ANSI_WARNINGS OFF

SET @dateTime = replace(convert(varchar,current_timestamp, 112)+'_'+convert(varchar,current_timestamp, 108),':','')----删除超过3天的备份文件

DECLARE @delete_time datetime

set @delete_time = getdate() - 3EXECUTE master.dbo.xp_delete_file 0,N'F:\kk_backup',N'trn',@delete_time,1

EXECUTE master.dbo.xp_delete_file 0,N'F:\kk_backup',N'bak',@delete_time,1SELECT @dateTime = replace(convert(varchar,current_timestamp, 112)+'_'+convert(varchar,current_timestamp, 108),':','')declare db_info cursor for

SELECT NAME,recovery_model FROM MASTER.SYS.databases

where state = 0 ---只处理online的数据库

and name not in ('tempdb','ReportServerTempDB','ReportServer') ----填写不需要备份的数据库declare @databaseName nvarchar(128)

declare @recovery_model int

OPEN db_info

fetch next from db_info into @databaseName,@recovery_model

while @@fetch_status=0

Begin ---recovery_model 1 : FULL 2 : BULK_LOGGED 3:SIMPLE

---系统数据库只全备IF @backupType = 'F' SET @sqlCommand = 'BACKUP DATABASE '+ @databaseName +' TO DISK = '''+ @filepath_backup + ''+ @databaseName +'_Full_'+@dateTime+'.BAK'' with STATS = 10, INIT, COMPRESSION, CHECKSUM 'IF @backupType = 'D' and @databaseName not in ('master','msdb','model')SET @sqlCommand = 'BACKUP DATABASE '+ @databaseName +' TO DISK = '''+ @filepath_backup + ''+ @databaseName + '_Diff_' + @dateTime + '.BAK '' WITH DIFFERENTIAL, STATS = 10, INIT, COMPRESSION'IF @backupType = 'L' and @recovery_model <> 3 and @databaseName not in ('master','msdb','model')

SET @sqlCommand = 'BACKUP LOG '+ @databaseName +' TO DISK = '''+ @filepath_backup + '' + @databaseName +'_Log_' + @dateTime + '.TRN'' with STATS = 10, INIT, COMPRESSION'

print @sqlCommandEXECUTE sp_executesql @sqlCommand fetch next from db_info into @databaseName,@recovery_model

End close db_info

deallocate db_info PRINT '-- Backup completed successfully at '+convert(varchar, getdate(), 120) SET ANSI_WARNINGS ON

END

GO备份作业

备份作业很简单,就是调用存储过程用计划控制备份频率

-- Author: KK-- Create date: 2016-09-27-- Description: 备份数据库,全备份每天一次 0点执行,差异备份6小时一次,日志备份1小时一次-- http://www.cnblogs.com/double-K/--需要备份的数据库未使用参数传递,而是选择在存储过程中指定,当添加新库时不需要修改任何脚本-- Parameter1: 备份类型 F=全部, D=差异, L=日志-------------------完整备份作业-----------------

USE [msdb]

GO/****** Object: Job [FULL_BACKUP] Script Date: 2016/9/30 12:13:12 ******/

BEGIN TRANSACTION

DECLARE @ReturnCode INT

SELECT @ReturnCode = 0

/****** Object: JobCategory [[Uncategorized (Local)]]] Script Date: 2016/9/30 12:13:12 ******/

IF NOT EXISTS (SELECT name FROM msdb.dbo.syscategories WHERE name=N'[Uncategorized (Local)]' AND category_class=1)

BEGIN

EXEC @ReturnCode = msdb.dbo.sp_add_category @class=N'JOB', @type=N'LOCAL', @name=N'[Uncategorized (Local)]'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollbackENDDECLARE @jobId BINARY(16)

EXEC @ReturnCode = msdb.dbo.sp_add_job @job_name=N'FULL_BACKUP', @enabled=1, @notify_level_eventlog=0, @notify_level_email=0, @notify_level_netsend=0, @notify_level_page=0, @delete_level=0, @description=N'系统全备份', @category_name=N'[Uncategorized (Local)]', @owner_login_name=N'sa', @job_id = @jobId OUTPUT

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

/****** Object: Step [FULL_STEP1] Script Date: 2016/9/30 12:13:12 ******/

EXEC @ReturnCode = msdb.dbo.sp_add_jobstep @job_id=@jobId, @step_name=N'FULL_STEP1', @step_id=1, @cmdexec_success_code=0, @on_success_action=1, @on_success_step_id=0, @on_fail_action=2, @on_fail_step_id=0, @retry_attempts=0, @retry_interval=0, @os_run_priority=0, @subsystem=N'TSQL', @command=N'[dbo].[sp_BackupDatabase] ''F''', @database_name=N'master', @flags=0

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_update_job @job_id = @jobId, @start_step_id = 1

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobschedule @job_id=@jobId, @name=N'EVERY_1d_zero', @enabled=1, @freq_type=4, @freq_interval=1, @freq_subday_type=1, @freq_subday_interval=0, @freq_relative_interval=0, @freq_recurrence_factor=0, @active_start_date=20160930, @active_end_date=99991231, @active_start_time=0, @active_end_time=235959, @schedule_uid=N'813653e1-4128-4f47-b378-5a26b49085d0'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobserver @job_id = @jobId, @server_name = N'(local)'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

COMMIT TRANSACTION

GOTO EndSave

QuitWithRollback:IF (@@TRANCOUNT > 0) ROLLBACK TRANSACTION

EndSave:GO-------------------日志备份作业------------------

USE [msdb]

GO/****** Object: Job [LOG_BACKUP] Script Date: 2016/9/30 12:13:25 ******/

BEGIN TRANSACTION

DECLARE @ReturnCode INT

SELECT @ReturnCode = 0

/****** Object: JobCategory [[Uncategorized (Local)]]] Script Date: 2016/9/30 12:13:25 ******/

IF NOT EXISTS (SELECT name FROM msdb.dbo.syscategories WHERE name=N'[Uncategorized (Local)]' AND category_class=1)

BEGIN

EXEC @ReturnCode = msdb.dbo.sp_add_category @class=N'JOB', @type=N'LOCAL', @name=N'[Uncategorized (Local)]'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollbackENDDECLARE @jobId BINARY(16)

EXEC @ReturnCode = msdb.dbo.sp_add_job @job_name=N'LOG_BACKUP', @enabled=1, @notify_level_eventlog=0, @notify_level_email=0, @notify_level_netsend=0, @notify_level_page=0, @delete_level=0, @description=N'系统日志备份', @category_name=N'[Uncategorized (Local)]', @owner_login_name=N'sa', @job_id = @jobId OUTPUT

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

/****** Object: Step [LOG_STEP1] Script Date: 2016/9/30 12:13:25 ******/

EXEC @ReturnCode = msdb.dbo.sp_add_jobstep @job_id=@jobId, @step_name=N'LOG_STEP1', @step_id=1, @cmdexec_success_code=0, @on_success_action=1, @on_success_step_id=0, @on_fail_action=2, @on_fail_step_id=0, @retry_attempts=0, @retry_interval=0, @os_run_priority=0, @subsystem=N'TSQL', @command=N'[dbo].[sp_BackupDatabase] ''L''', @database_name=N'master', @flags=0

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_update_job @job_id = @jobId, @start_step_id = 1

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobschedule @job_id=@jobId, @name=N'EVERY_1h', @enabled=1, @freq_type=4, @freq_interval=1, @freq_subday_type=8, @freq_subday_interval=1, @freq_relative_interval=0, @freq_recurrence_factor=0, @active_start_date=20160930, @active_end_date=99991231, @active_start_time=0, @active_end_time=235959, @schedule_uid=N'3d5ad87e-4f1d-46ef-9a24-e0f99c7d5c20'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobserver @job_id = @jobId, @server_name = N'(local)'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

COMMIT TRANSACTION

GOTO EndSave

QuitWithRollback:IF (@@TRANCOUNT > 0) ROLLBACK TRANSACTION

EndSave:GO----------------------差异备份作业

USE [msdb]

GO/****** Object: Job [DIFF_BACKUP] Script Date: 2016/9/30 12:13:19 ******/

BEGIN TRANSACTION

DECLARE @ReturnCode INT

SELECT @ReturnCode = 0

/****** Object: JobCategory [[Uncategorized (Local)]]] Script Date: 2016/9/30 12:13:19 ******/

IF NOT EXISTS (SELECT name FROM msdb.dbo.syscategories WHERE name=N'[Uncategorized (Local)]' AND category_class=1)

BEGIN

EXEC @ReturnCode = msdb.dbo.sp_add_category @class=N'JOB', @type=N'LOCAL', @name=N'[Uncategorized (Local)]'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollbackENDDECLARE @jobId BINARY(16)

EXEC @ReturnCode = msdb.dbo.sp_add_job @job_name=N'DIFF_BACKUP', @enabled=1, @notify_level_eventlog=0, @notify_level_email=0, @notify_level_netsend=0, @notify_level_page=0, @delete_level=0, @description=N'无描述。', @category_name=N'[Uncategorized (Local)]', @owner_login_name=N'sa', @job_id = @jobId OUTPUT

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

/****** Object: Step [DIFF_STEP1] Script Date: 2016/9/30 12:13:19 ******/

EXEC @ReturnCode = msdb.dbo.sp_add_jobstep @job_id=@jobId, @step_name=N'DIFF_STEP1', @step_id=1, @cmdexec_success_code=0, @on_success_action=1, @on_success_step_id=0, @on_fail_action=2, @on_fail_step_id=0, @retry_attempts=0, @retry_interval=0, @os_run_priority=0, @subsystem=N'TSQL', @command=N'[dbo].[sp_BackupDatabase] ''D''', @database_name=N'master', @flags=0

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_update_job @job_id = @jobId, @start_step_id = 1

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobschedule @job_id=@jobId, @name=N'EXERY_6h', @enabled=1, @freq_type=4, @freq_interval=1, @freq_subday_type=8, @freq_subday_interval=6, @freq_relative_interval=0, @freq_recurrence_factor=0, @active_start_date=20160930, @active_end_date=99991231, @active_start_time=0, @active_end_time=235959, @schedule_uid=N'f7514c1b-128f-4ae4-8361-9dbcbbff66c6'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobserver @job_id = @jobId, @server_name = N'(local)'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

COMMIT TRANSACTION

GOTO EndSave

QuitWithRollback:IF (@@TRANCOUNT > 0) ROLLBACK TRANSACTION

EndSave:GO

数据一致性检查

-- Author: KK-- Create date: 2016-09-27-- Description: 数据库一致性检查,每周运行及时发现数据库损坏-- 本脚本针对于中小型数据库,当数据库达到一定规模超过T级或有大表使用计算列等,可适当拆分或调整,以免checkdb时间超过维护时间窗口而影响业务-- E:\checkdb_report.txt , 输出文件的路径,检查出的错误信息或被记录进去,或直接通过作业记录查看-- http://www.cnblogs.com/double-K/--需要备份的数据库未使用参数传递,而是选择在存储过程中指定,当添加新库时不需要修改任何脚本--脚本针对中小数据库,如果数据库超过1T甚至更大,CHECKDB也是必要操作,但需要拆分文件组或更精细化检查以降低每次检查的时间,保证在指定的维护窗口完成任务。USE [msdb]

GO/****** Object: Job [CHECKDB] Script Date: 09/30/2016 15:16:01 ******/

BEGIN TRANSACTION

DECLARE @ReturnCode INT

SELECT @ReturnCode = 0

/****** Object: JobCategory [[Uncategorized (Local)]]] Script Date: 09/30/2016 15:16:01 ******/

IF NOT EXISTS (SELECT name FROM msdb.dbo.syscategories WHERE name=N'[Uncategorized (Local)]' AND category_class=1)

BEGIN

EXEC @ReturnCode = msdb.dbo.sp_add_category @class=N'JOB', @type=N'LOCAL', @name=N'[Uncategorized (Local)]'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollbackENDDECLARE @jobId BINARY(16)

EXEC @ReturnCode = msdb.dbo.sp_add_job @job_name=N'CHECKDB', @enabled=1, @notify_level_eventlog=0, @notify_level_email=0, @notify_level_netsend=0, @notify_level_page=0, @delete_level=0, @description=N'数据库一致性检查,可以发现数据库是否有损坏。', @category_name=N'[Uncategorized (Local)]', @owner_login_name=N'sa', @job_id = @jobId OUTPUT

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

/****** Object: Step [CHECKDB] Script Date: 09/30/2016 15:16:01 ******/

EXEC @ReturnCode = msdb.dbo.sp_add_jobstep @job_id=@jobId, @step_name=N'CHECKDB', @step_id=1, @cmdexec_success_code=0, @on_success_action=1, @on_success_step_id=0, @on_fail_action=2, @on_fail_step_id=0, @retry_attempts=0, @retry_interval=0, @os_run_priority=0, @subsystem=N'TSQL', @command=N'

declare db_info cursor for

SELECT NAME FROM MASTER.SYS.databases

where state = 0 ---只处理online的数据库

and name not in (''tempdb'',''ReportServerTempDB'',''ReportServer'') ----填写不需要检查的数据库declare @databaseName nvarchar(128)

declare @recovery_model int

DECLARE @sqlCommand NVARCHAR(1000)

OPEN db_info

fetch next from db_info into @databaseName

while @@fetch_status=0

Begin

SET @sqlCommand = ''DBCC CHECKDB(N''''''+ @databaseName + '''''') WITH NO_INFOMSGS''

print @sqlCommandEXECUTE sp_executesql @sqlCommand

fetch next from db_info into @databaseName

End

close db_info

deallocate db_info ', @database_name=N'master', @output_file_name=N'E:\checkdb_report.txt', --输出文件的路径,检查出的错误信息或被记录进去,或直接通过作业记录查看@flags=4

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_update_job @job_id = @jobId, @start_step_id = 1

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobschedule @job_id=@jobId, @name=N'sunday_2am', @enabled=1, @freq_type=8, @freq_interval=1, @freq_subday_type=1, @freq_subday_interval=0, @freq_relative_interval=0, @freq_recurrence_factor=1, @active_start_date=20160930, @active_end_date=99991231, @active_start_time=20000, @active_end_time=235959, @schedule_uid=N'3ade533f-5ce1-434f-98ff-b4509b2ca582'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

EXEC @ReturnCode = msdb.dbo.sp_add_jobserver @job_id = @jobId, @server_name = N'(local)'

IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback

COMMIT TRANSACTION

GOTO EndSave

QuitWithRollback:IF (@@TRANCOUNT > 0) ROLLBACK TRANSACTION

EndSave:GO

Agent作业备份

备份作业可以通过备份MSDB完成,但是保留一份脚本还是不错的,脚本为存储过程,建议一个周或一个月备份一次,可使用JOB 调用存储过程。

USE [master]

GO/****** Object: StoredProcedure [dbo].[DumpJobsql] Script Date: 02/07/2014 11:38:46 ******/

SET ANSI_NULLS ON

GOSET QUOTED_IDENTIFIER ON

GOalter PROCEDURE [dbo].[usp_DumpJobsql]

AS

BEGIN-- Author: KK-- Create date: 2016-09-27-- Description: 备份JOB,目前不支持邮件-- 生成数据一份保留在master的zzz_temp_JOB_bcp表中,另外会在目标位置生成一个 job_日期.sql-- http://www.cnblogs.com/double-K/SET NOCOUNT ONDECLARE @SV nvarchar(4)DECLARE @i_enabled TINYINTDECLARE @sql VARCHAR(max)DECLARE @i_job_name VARCHAR(1000)DECLARE @i_notify_level_eventlog INTDECLARE @i_notify_level_email INTDECLARE @i_notify_level_netsend INTDECLARE @i_notify_level_page INTDECLARE @i_delete_level INTDECLARE @i_description VARCHAR(1000)DECLARE @i_category_name VARCHAR(1000)DECLARE @i_owner_login_name VARCHAR(1000)DECLARE @i_category_class INTDECLARE @i_start_step_id INT DECLARE @i_step_name VARCHAR(1000) DECLARE @i_step_id INT DECLARE @i_cmdexec_success_code INT DECLARE @i_on_success_action INT DECLARE @i_on_success_step_id INT DECLARE @i_on_fail_action INT DECLARE @i_on_fail_step_id INT DECLARE @i_retry_attempts BIGINT DECLARE @i_retry_interval INT DECLARE @i_os_run_priority INT DECLARE @i_subsystem VARCHAR(1000) DECLARE @i_command VARCHAR(8000)DECLARE @i_database_name VARCHAR(100) DECLARE @i_flags INT DECLARE @i_class VARCHAR(10) ,@i_type VARCHAR(10)DECLARE @c_jobid UNIQUEIDENTIFIER ,@c_categoryid INTDECLARE @loop_stepid INTDECLARE @m_stepid INT DECLARE @loop_scheduleid INTDECLARE @m_scheduleid INTDECLARE @i_schedule_enabled TINYINTDECLARE @i_freq_type INTDECLARE @i_schedule_name VARCHAR(1000) DECLARE @i_freq_interval INT DECLARE @i_freq_subday_type INTDECLARE @i_freq_subday_interval INTDECLARE @i_freq_relative_interval INTDECLARE @i_freq_recurrence_factor INTDECLARE @i_active_start_date BIGINT DECLARE @i_active_end_date BIGINT DECLARE @i_active_start_time BIGINT DECLARE @i_active_end_time BIGINT DECLARE @i_schedule_uid VARCHAR(1000)SET @i_class = 'JOB'SET @i_type = 'LOCAL'if exists (select 1 from sys.objects where name = 'zzz_temp_JOB_bcp')begin delete from master..zzz_temp_JOB_bcpendelsebegin create table zzz_temp_JOB_bcp(name nvarchar(100),text nvarchar(max),sv nvarchar(4),Bak_date nvarchar(10))endDECLARE job CURSOR FOR SELECT a.job_id ,a.category_id,'服务器XX' as SV FROM msdb.dbo.sysjobs a , msdb.dbo.syscategories cWHERE a.category_id = c.category_id AND c.name NOT LIKE '%Database Maintenance%' AND c.name NOT LIKE '%REPL%'AND c.name <> 'Log Shipping'AND a.name <> 'syspolicy_purge_history'----如果需要可多服务器备份--union all--select a.job_id ,a.category_id,'服务器XXX' --from --opendatasource('SQLOLEDB','Data Source=XX.XX.XX.XX;User ID=XX;Password=XX').msdb.dbo.sysjobs a,--opendatasource('SQLOLEDB','Data Source=XX.XX.XX.XX;User ID=XX;Password=XX').msdb.dbo.syscategories c--WHERE a.category_id = c.category_id -- AND c.name NOT LIKE '%Database Maintenance%' -- AND c.name NOT LIKE '%REPL%'-- AND c.name <> 'Log Shipping'-- AND a.name <> 'syspolicy_purge_history'OPEN jobFETCH job INTO @c_jobid ,@c_categoryid,@SVWHILE @@FETCH_STATUS = 0BEGINSET @sql = ''SELECT @i_job_name = a.name ,@i_enabled = [enabled] ,@i_notify_level_eventlog = notify_level_eventlog ,@i_notify_level_email = notify_level_email ,@i_notify_level_netsend = notify_level_netsend ,@i_notify_level_page = notify_level_page ,@i_delete_level = delete_level ,@i_description = [description] ,@i_category_name = c.name ,@i_owner_login_name = ISNULL(SUSER_SNAME(a.owner_sid), N'''') ,@i_category_class = category_class FROM msdb.dbo.sysjobs a ,msdb.dbo.syscategories cWHERE a.category_id=c.category_id AND a.job_id=@c_jobid AND a.category_id = @c_categoryidSET @sql=@sql+CHAR(13)+CHAR(10) + 'USE [msdb]'SET @sql=@sql+CHAR(13)+CHAR(10) + 'GO'SET @sql=@sql+CHAR(13)+CHAR(10) + '/****** Object: Job ['+ @i_job_name +'] Script Date: '+CONVERT(VARCHAR,GETDATE(),22)+' ******/' SET @sql=@sql+CHAR(13)+CHAR(10) + 'BEGIN TRANSACTION' SET @sql=@sql+CHAR(13)+CHAR(10) + 'DECLARE @ReturnCode INT' SET @sql=@sql+CHAR(13)+CHAR(10) + 'SELECT @ReturnCode = 0'SET @sql=@sql+CHAR(13)+CHAR(10) + '/****** Object: JobCategory ['+ @i_category_name +'] Script Date: 08/20/2016 12:35:16 ******/'SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF NOT EXISTS (SELECT name FROM msdb.dbo.syscategories WHERE name=N'''+ @i_category_name +''' AND category_class='+ CAST(@i_category_class AS VARCHAR) +' )' SET @sql=@sql+CHAR(13)+CHAR(10) + 'BEGIN' SET @sql=@sql+CHAR(13)+CHAR(10) + 'EXEC @ReturnCode = msdb.dbo.sp_add_category @class=N'''+ @i_class +''', @type=N'''+ @i_type +''', @name=N'''+ @i_category_name +'''' SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback'SET @sql=@sql+CHAR(13)+CHAR(10) + '' SET @sql=@sql+CHAR(13)+CHAR(10) + 'END'SET @sql=@sql+CHAR(13)+CHAR(10) + ''SET @sql=@sql+CHAR(13)+CHAR(10) + 'DECLARE @jobId BINARY(16)' SET @sql=@sql+CHAR(13)+CHAR(10) + 'EXEC @ReturnCode = msdb.dbo.sp_add_job @job_name=N'''+ @i_job_name +''',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @enabled='+ CAST(@i_enabled AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @notify_level_eventlog='+ CAST(@i_notify_level_eventlog AS VARCHAR) +','SET @sql=@sql+CHAR(13)+CHAR(10) + ' @notify_level_email='+ CAST(@i_notify_level_email AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @notify_level_netsend='+ CAST(@i_notify_level_netsend AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @notify_level_page='+ CAST(@i_notify_level_page AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @delete_level='+ CAST(@i_delete_level AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @description=N'''+ @i_description +''',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @category_name=N'''+ @i_category_name +''',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @owner_login_name=N'''+ @i_owner_login_name +''', @job_id = @jobId OUTPUT' SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback' IF EXISTS ( SELECT TOP 1 1 FROM msdb.dbo.sysjobsteps WHERE job_id = @c_jobid )BEGINSELECT @loop_stepid = MIN(step_id) ,@m_stepid = MAX(step_id) FROM msdb.dbo.sysjobsteps WHERE job_id = @c_jobid WHILE (@loop_stepid < = @m_stepid) BEGIN SELECT @i_start_step_id = start_step_id,@i_step_name = step_name ,@i_step_id = step_id,@i_cmdexec_success_code = cmdexec_success_code ,@i_on_success_action = on_success_action ,@i_on_success_step_id = on_success_step_id ,@i_on_fail_action = on_fail_action ,@i_on_fail_step_id = on_fail_step_id ,@i_retry_attempts = retry_attempts ,@i_retry_interval = retry_interval ,@i_os_run_priority = os_run_priority ,@i_subsystem = subsystem ,@i_command = command ,@i_database_name = database_name ,@i_flags = flagsFROM msdb.dbo.sysjobs a ,msdb.dbo.sysjobsteps b WHERE a.job_id = b.job_id AND step_id = @loop_stepid AND a.job_id = @c_jobid SET @sql=@sql+CHAR(13)+CHAR(10) + '/****** Object: Step ['+ @i_step_name +'] Script Date: '+CONVERT(VARCHAR,GETDATE(),22)+' ******/' SET @sql=@sql+CHAR(13)+CHAR(10) + 'EXEC @ReturnCode = msdb.dbo.sp_add_jobstep @job_id=@jobId, @step_name=N'''+ @i_step_name +''','SET @sql=@sql+CHAR(13)+CHAR(10) + ' @step_id='+ CAST(@i_step_id AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @cmdexec_success_code='+ CAST(@i_cmdexec_success_code AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @on_success_action='+ CAST(@i_on_success_action AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @on_success_step_id='+ CAST(@i_on_success_step_id AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @on_fail_action='+ CAST(@i_on_fail_action AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @on_fail_step_id='+ CAST(@i_on_fail_step_id AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @retry_attempts='+ CAST(@i_retry_attempts AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @retry_interval='+ CAST(@i_retry_interval AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @os_run_priority='+ CAST(@i_os_run_priority AS VARCHAR) +', @subsystem=N'''+ @i_subsystem +''',' SET @sql=@sql+CHAR(13)+CHAR(10) + ISNULL(' @command=N''' + REPLACE(@i_command ,'''' ,'''''') + ''',' ,'') SET @sql=@sql+CHAR(13)+CHAR(10) + ISNULL(' @database_name=N'''+ @i_database_name +''',' ,'') SET @sql=@sql+CHAR(13)+CHAR(10) + ' @flags='+ CAST(@i_flags AS VARCHAR) SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback' SET @loop_stepid = ( SELECT TOP 1 step_id FROM msdb.dbo.sysjobsteps WHERE job_id = @c_jobid AND step_id > @loop_stepid ORDER BY step_id )ENDENDSET @sql=@sql+CHAR(13)+CHAR(10) + 'EXEC @ReturnCode = msdb.dbo.sp_update_job @job_id = @jobId, @start_step_id = '+ CAST(@i_start_step_id AS VARCHAR) SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback' IF EXISTS ( SELECT TOP 1 1 FROM msdb.dbo.sysschedules c ,msdb.dbo.sysjobschedules d WHERE c.schedule_id = d.schedule_id AND job_id = @c_jobid )BEGINSELECT @loop_scheduleid= MIN(c.schedule_id) ,@m_scheduleid = MAX(c.schedule_id) FROM msdb.dbo.sysschedules c ,msdb.dbo.sysjobschedules dWHERE c.schedule_id = d.schedule_id AND job_id = @c_jobid WHILE ( @loop_scheduleid <= @m_scheduleid ) BEGINSELECT @i_schedule_enabled = [enabled] ,@i_freq_type = freq_type ,@i_schedule_name = name,@i_freq_interval = freq_interval ,@i_freq_subday_type = freq_subday_type ,@i_freq_subday_interval = freq_subday_interval ,@i_freq_relative_interval = freq_relative_interval ,@i_freq_recurrence_factor = freq_recurrence_factor ,@i_active_start_date = active_start_date ,@i_active_end_date = active_end_date ,@i_active_start_time = active_start_time ,@i_active_end_time = active_end_time ,@i_schedule_uid = schedule_uid FROM msdb.dbo.sysschedules c LEFT JOIN msdb.dbo.sysjobschedules dON c.schedule_id = d.schedule_id WHERE d.job_id = @c_jobid AND c.schedule_id = @loop_scheduleid SET @sql=@sql+CHAR(13)+CHAR(10) + 'EXEC @ReturnCode = msdb.dbo.sp_add_jobschedule @job_id=@jobId, @name=N'''+ @i_schedule_name +''',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @enabled='+ CAST(@i_schedule_enabled AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @freq_type='+ CAST(@i_freq_type AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @freq_interval='+ CAST(@i_freq_interval AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @freq_subday_type='+ CAST(@i_freq_subday_type AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @freq_subday_interval='+ CAST(@i_freq_subday_interval AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @freq_relative_interval='+ CAST(@i_freq_relative_interval AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @freq_recurrence_factor='+ CAST(@i_freq_recurrence_factor AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @active_start_date='+ CAST(@i_active_start_date AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @active_end_date='+ CAST(@i_active_end_date AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @active_start_time='+ CAST(@i_active_start_time AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @active_end_time='+ CAST(@i_active_end_time AS VARCHAR) +',' SET @sql=@sql+CHAR(13)+CHAR(10) + ' @schedule_uid=N'''+ @i_schedule_uid +'''' SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback' SET @loop_scheduleid = ( SELECT TOP 1 c.schedule_id FROM msdb.dbo.sysschedules c ,msdb.dbo.sysjobschedules dWHERE c.schedule_id = d.schedule_id AND job_id = @c_jobid AND c.schedule_id > @loop_scheduleid ) ENDENDSET @sql=@sql+CHAR(13)+CHAR(10) + 'EXEC @ReturnCode = msdb.dbo.sp_add_jobserver @job_id = @jobId, @server_name = N''(local)''' SET @sql=@sql+CHAR(13)+CHAR(10) + 'IF (@@ERROR <> 0 OR @ReturnCode <> 0) GOTO QuitWithRollback' SET @sql=@sql+CHAR(13)+CHAR(10) + 'COMMIT TRANSACTION' SET @sql=@sql+CHAR(13)+CHAR(10) + 'GOTO EndSave' SET @sql=@sql+CHAR(13)+CHAR(10) + 'QuitWithRollback:' SET @sql=@sql+CHAR(13)+CHAR(10) + ' IF (@@TRANCOUNT > 0) ROLLBACK TRANSACTION' SET @sql=@sql+CHAR(13)+CHAR(10) + 'EndSave:' SET @sql=@sql+CHAR(13)+CHAR(10) + '' SET @sql=@sql+CHAR(13)+CHAR(10) + 'GO'PRINT @sqlinsert into master..zzz_temp_JOB_bcpSELECT @i_job_name,@sql,@SV,CONVERT(nvarchar(10),getdate(),112)FETCH NEXT FROM job INTO @c_jobid ,@c_categoryid ,@SVENDCLOSE jobDEALLOCATE jobdeclare @a nvarchar(17),@c nvarchar(1000),@name nvarchar(100),@d nvarchar(100)set @a = CONVERT (nvarchar(17),GETDATE(),112)set @name = 'F:\kk_backup\job_'+@a+'.sql'set @d = 'del ' + @name set @c = 'bcp "select text from master..zzz_temp_JOB_bcp where bak_date = CONVERT(nvarchar(10),getdate(),112)" queryout "'+ @name +'" -c -S"服务名称" -U"sa" -P"sa123456" 'print @dprint @cexec sp_configure 'show advanced options',1reconfigure with overrideexec sp_configure 'xp_cmdshell',1reconfigure with overrideEXEC master..xp_cmdshell @dEXEC master..xp_cmdshell @cexec sp_configure 'xp_cmdshell',0reconfigure with overrideexec sp_configure 'show advanced options',0reconfigure with overrideend

GO

监控某个目录是否被更改

需求:对一个目录(比如/data/test)进行监控,当这个目录下文件或子目录出现变动(如修改、创建、删除、更名等操作)时,就发送邮件!

针对上面的需求,编写shell脚本如下:

[root@centos6-vm01 opt]# vim file_monit.sh

#!/bin/bash

#此脚本用于检测linux系统重要文件是否被改动,如果改动则用邮件报警

#建议用定时任务执行此脚本,如每5分钟执行一次,也可修改此脚本用于死循环检测

#Ver:1.0

#http://www.cnblogs.com/kevingrace#定义验证文件所在目录

FileDir='/var/CheckFile'#获取主机名或自己定义

HostName=$(hostname)#定义邮件参数:xmtp地址,发送邮件帐号,发送邮件密码,接收邮件地址,邮件主题,邮件内容

Mail_Smtp="smtp.wangshibo.com"

Mail_User="notice@wangshibo.com"

Mail_Pass="notice@123"

Mail_From="notice@wangshibo.com"

Mail_To="wangshibo@wangshibo.com"

Mail_Subject="${HostName}:There are changes to system files"

Mail_Conntent="${HostName}:There are changes to system files"#定义需要验证的文件目录。这里我监控的是/data/test目录

CheckDir=(

/data/test

)#生成所定义需验证的文件样本日志函数

OldFile () {

for i in ${CheckDir[@]}

do

/bin/find ${i} -type f |xargs md5sum >> ${FileDir}/old.log

done

}

NewFile () {

for i in ${CheckDir[@]}

do

/bin/find ${i} -type f |xargs md5sum >> ${FileDir}/new.log

done

}#生成所定义文件新日志函数(注意后面发送邮件内容,\n表示换行)

SendEMail () {

/usr/local/bin/sendEmail -f $Mail_From -t $Mail_To -s $Mail_Smtp -u $Mail_Subject -xu $Mail_User -xp $Mail_Pass -m "$Mail_Conntent"\n

}

if [ ! -d ${FileDir} ]

then

mkdir ${FileDir}

fi#假如验证文件目录不存在则创建

if [ ! -f ${FileDir}/old.log ]

then

OldFile

fi#假如没有安装sendEmail则安装

if [ ! -f /usr/local/bin/sendEmail ]

then

cd /usr/local/src/

wget http://caspian.dotconf.net/menu/Software/SendEmail/sendEmail-v1.56.tar.gz

tar -xf sendEmail-v1.56.tar.gz

cd sendEmail-v1.56

cp sendEmail /usr/local/bin

chmod 0755 /usr/local/bin/sendEmail

fi#生成新验证日志

NewFile#新验证日志与样本日志进行比较

/usr/bin/diff ${FileDir}/new.log ${FileDir}/old.log >${FileDir}/diff.log

Status=$?#假如比较结果有变化,则发送邮件报警

if [ ${Status} -ne 0 ]

then

Mail_Conntent="$(grep '<' ${FileDir}/diff.log |awk '{print $3}')"

SendEMail

fi#清除新旧日志,把比较结果进行备份

/bin/mv -f ${FileDir}/diff.log ${FileDir}/diff$(date +%F__%T).log

cat /dev/null > ${FileDir}/old.log

cat /dev/null > ${FileDir}/new.log#重新生成样本日志

OldFile#删除目录内30天以前的比较结果备份文件

/bin/find ${FileDir} -type f -mtime +30 |xargs rm -f确保本机能连上shell脚本中指定的smtp服务器的25好端口

[root@centos6-vm01 opt]# telnet smtp.wangshibo.com 25

Trying 223.252.214.65...

Connected to smtp.wangshibo.com.

Escape character is '^]'.

220 icoremail.net Anti-spam GT for Coremail System (icoremail-gateway-smtp[20170531])

下面开始测试

[root@centos6-vm01 test]# cd /opt/

[root@centos6-vm01 opt]# cd /data/test/

[root@centos6-vm01 test]# ll

total 0

[root@centos6-vm01 test]# mkdir haha

[root@centos6-vm01 test]# echo "123456" > haha/heihei

[root@centos6-vm01 test]# ll

total 4

drwxr-xr-x. 2 root root 4096 Jan 10 01:42 haha

[root@centos6-vm01 test]# echo "abcdef" > test.txt

[root@centos6-vm01 test]# ll

total 8

drwxr-xr-x. 2 root root 4096 Jan 10 01:42 haha

-rw-r--r--. 1 root root 7 Jan 10 01:42 test.txt执行监控脚本

[root@centos6-vm01 test]# sh -x /opt/file_monit.sh注意:当首次执行脚本的时候,由于所监控的目录下的文件没有变动,所以不会发送邮件!查看对比后的日志

[root@centos6-vm01 test]# ll -d /var/CheckFile/

drwxr-xr-x. 2 root root 4096 Jan 10 01:44 /var/CheckFile/

[root@centos6-vm01 test]# ll /var/CheckFile/

total 4

-rw-r--r--. 1 root root 0 Jan 10 01:44 diff2018-01-10__01:44:30.log

-rw-r--r--. 1 root root 0 Jan 10 01:44 new.log

-rw-r--r--. 1 root root 166 Jan 10 01:44 old.log[root@centos6-vm01 test]# cat /var/CheckFile/diff2018-01-10__01\:44\:30.log

[root@centos6-vm01 test]# cat /var/CheckFile/new.log

[root@centos6-vm01 test]# cat /var/CheckFile/old.log

237267ea7fefa88360c22ab6fd582d7e /data/test/.hhhh.swp

5ab557c937e38f15291c04b7e99544ad /data/test/test.txt

f447b20a7fcbf53a5d5be013ea0b15af /data/test/haha/heihei==============================================================================================================================

现在开始对/data/test目录下的文件做下变动

[root@centos6-vm01 test]# echo "aaaaaa" >> test.txt