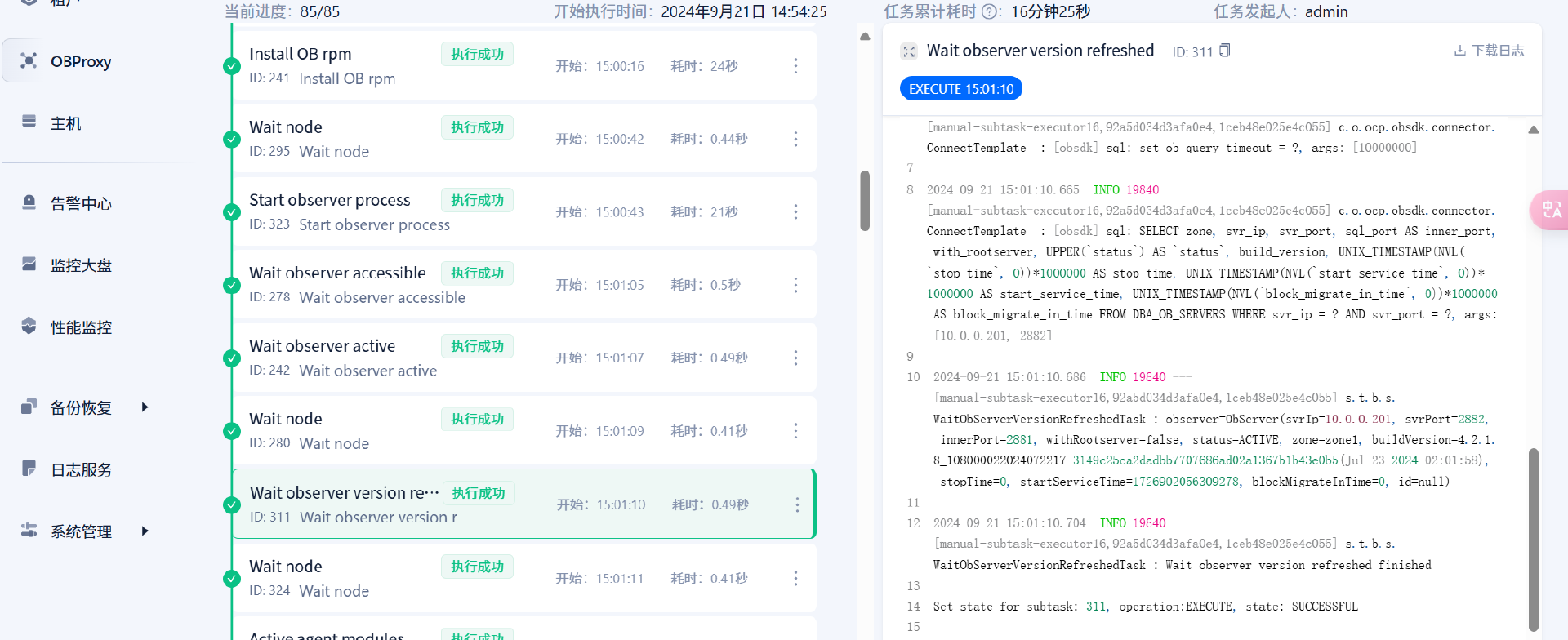

OceanBase 升级过程研究(4.2.1.6-4.2.1.8)

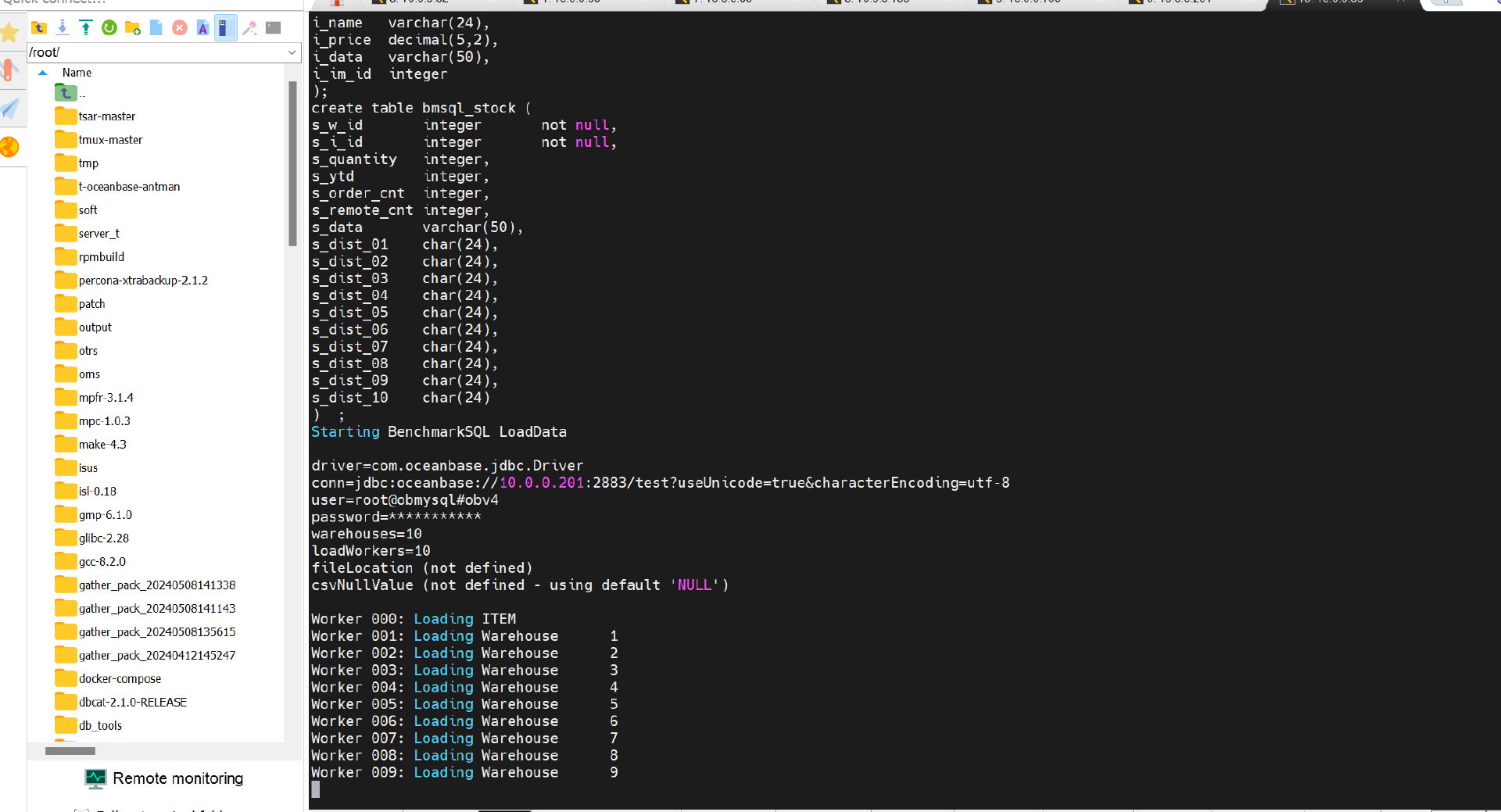

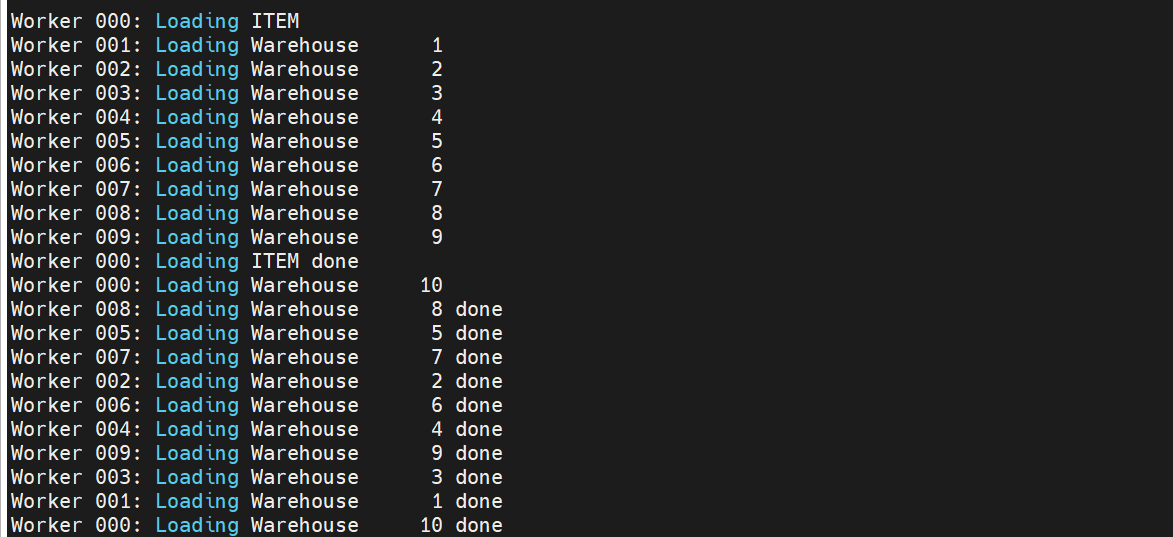

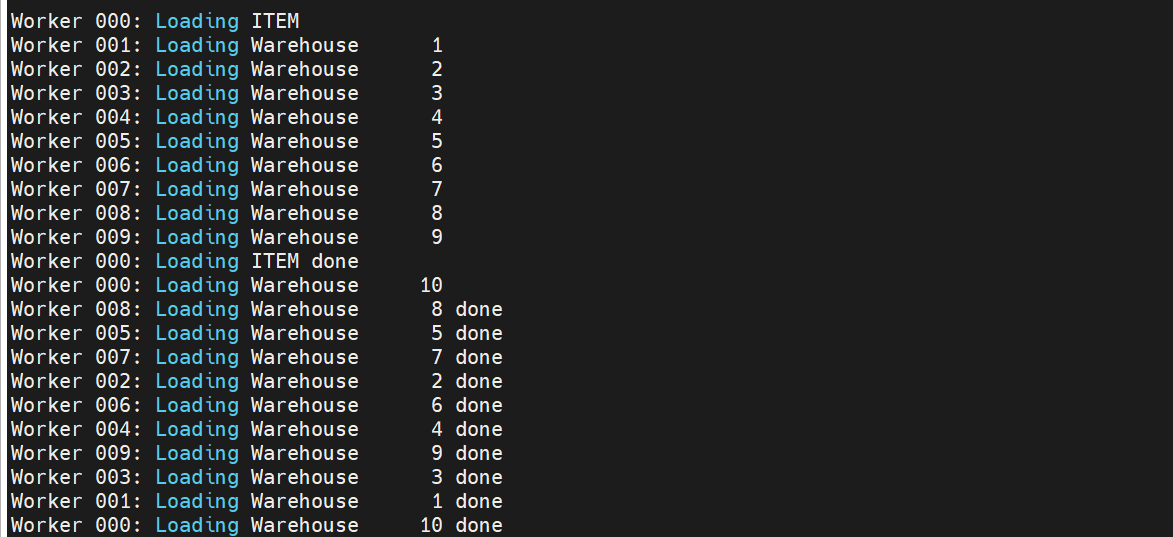

模拟业务

使用benchmark加载10仓数据模拟业务场景

升级方法

使用滚动升级方式来进行OB升级。该方法前提是OB集群必须满足官方规定的高可用架构(如果 Zone 个数小于 3,滚动升级时则无法构成多数派), 滚动升级的原理就是轮流完成每个ZONE的升级工作,由于OB属于分布式集群,当一个ZONE处于升级状态中,其余的ZONE提供服务,不影响业务

任务类型

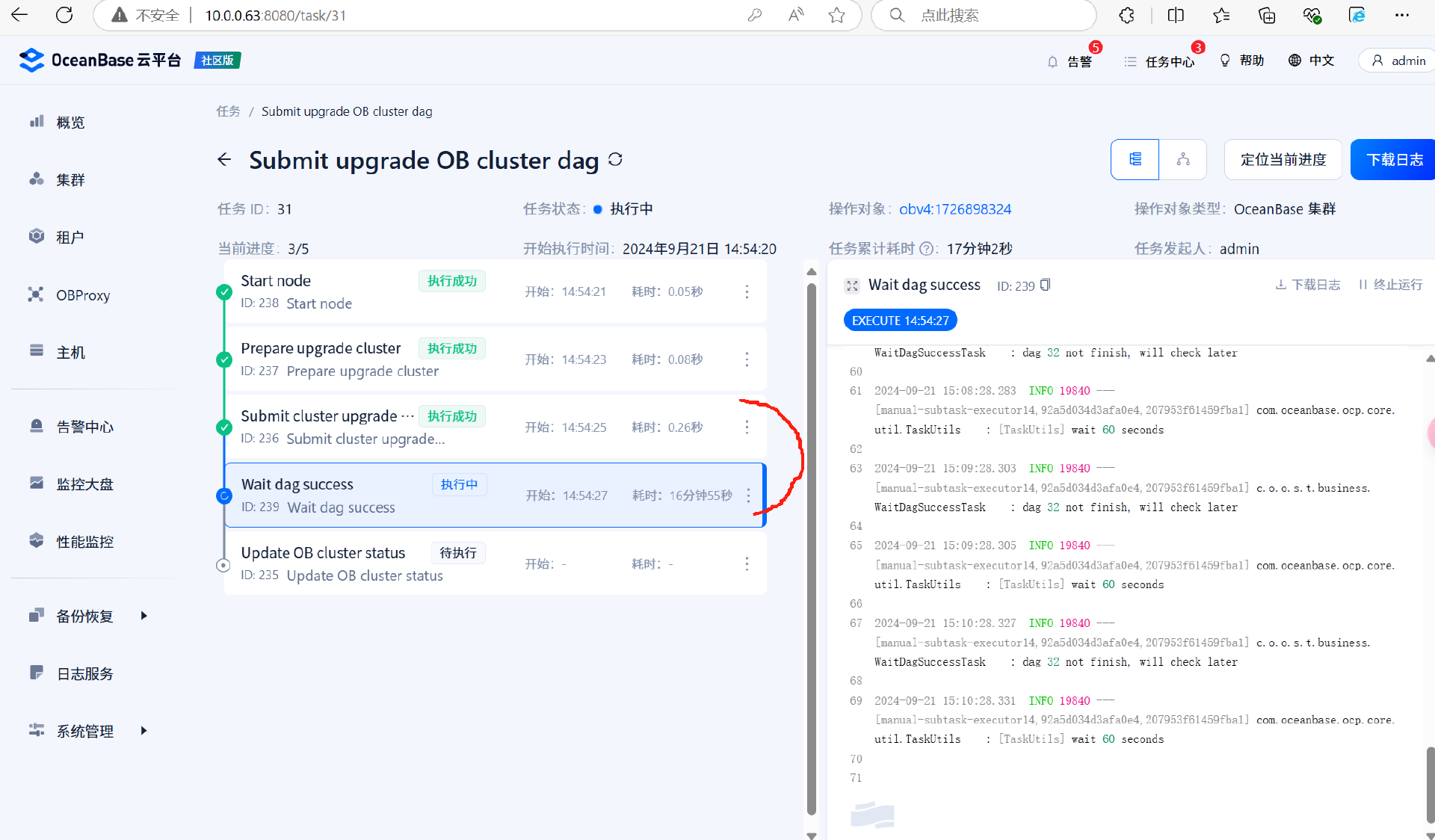

升级时会产生一个主任务及多个子任务。主任务根据每个需要替换 binary 版本的升级节点,来生成数个子任务,来逐步替换掉需要升级的 binary 文件。

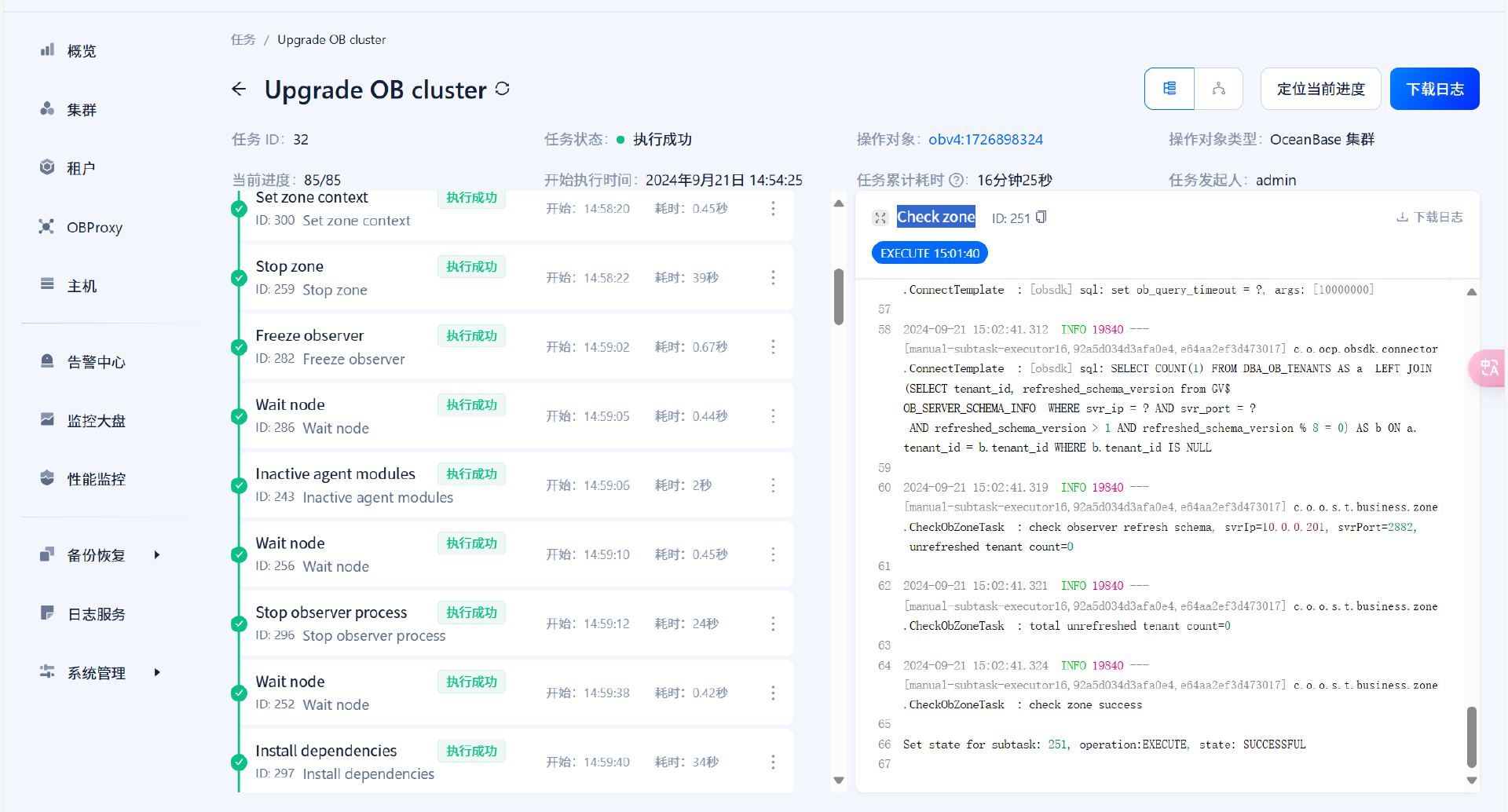

- 主任务:将升级路径中每个需要替换 binary 文件的升级节点都生成为一个子任务,用于逐步替换掉需要升级的 binary 文件。 如下图所示,

Submit cluster upgrade task即为生成一个子任务。Wait dag success为等待子任务执行完成。Submit cluster upgrade task和Wait dag success这个组合可能会执行多次,执行次数取决于升级路径中有多少个替换 binary 的节点。

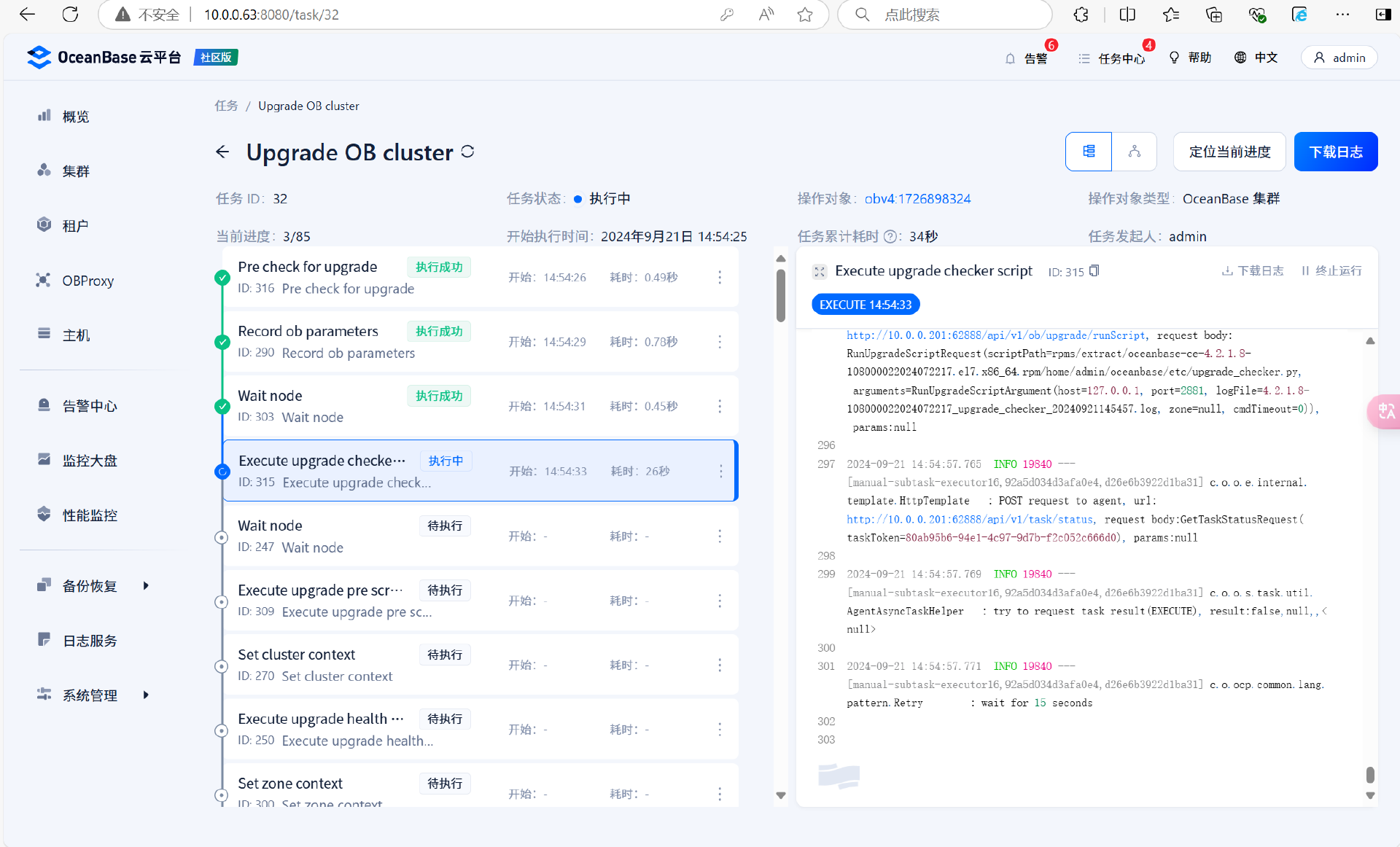

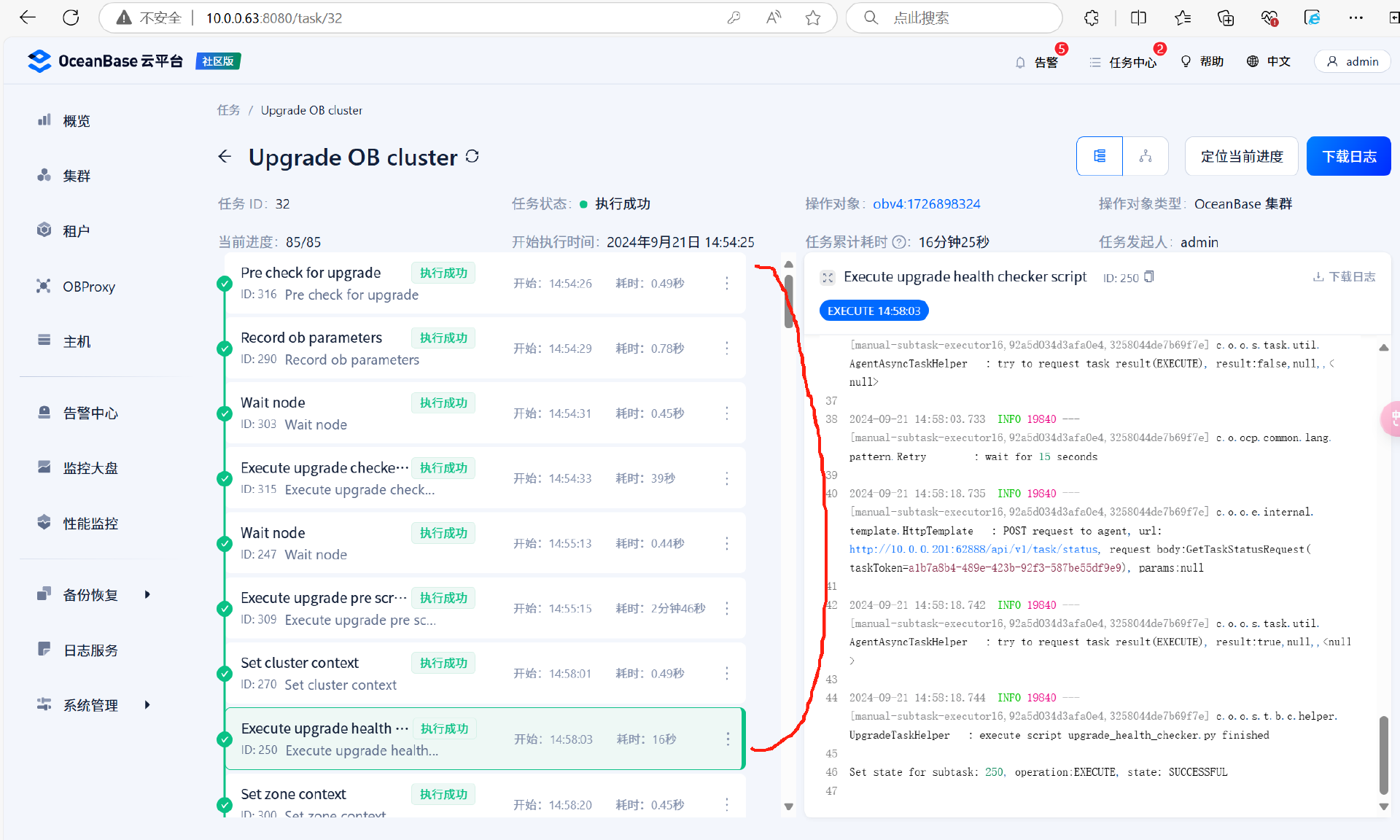

- 子任务:升级所有 OceanBase 集群版本。主要是执行升级脚本: 预检查脚本、升级 Pre 脚本、替换 OBServer 节点、升级 Post 脚本、版本检查等。

升级任务(子任务)

由于是滚动升级,所以子任务中的升级任务数量取决于ZONE的数量

升级前检查

在 set zone contaxt 任务模块前的所有任务均是升级前对集群的检查,检查租户的凭据以及运行安装目录etc下的升级检查脚本,查看当前集群是否满足升级。由于是检查操作,所以这些任务模块如果运行失败可以进行回滚。这些检查模块运行成功后开始执行ZONE的升级

upgrade_checker.py 脚本进行升级前置检查,脚本执行成功表示可以继续升级

upgrade_pre.py 该脚本主要用于执行升级前的一系列准备工作,确保集群处于适合升级的状态

upgrade_health_checker.py该脚本主要用于执行集群级别的健康检查,确保集群在升级前处于健康状态

upgrade_checker.py脚本内容

[root@sdw1 etc]# cat upgrade_checker.py

#!/usr/bin/env python

# -*- coding: utf-8 -*-import sys

import os

import mysql.connector

from mysql.connector import errorcode

import logging

import getopt

import timeclass UpgradeParams:log_filename = 'upgrade_checker.log'old_version = '4.0.0.0'

#### --------------start : my_error.py --------------

class MyError(Exception):def __init__(self, value):self.value = valuedef __str__(self):return repr(self.value)

#### --------------start : actions.py------------

class Cursor:__cursor = Nonedef __init__(self, cursor):self.__cursor = cursordef exec_sql(self, sql, print_when_succ = True):try:self.__cursor.execute(sql)rowcount = self.__cursor.rowcountif True == print_when_succ:logging.info('succeed to execute sql: %s, rowcount = %d', sql, rowcount)return rowcountexcept mysql.connector.Error, e:logging.exception('mysql connector error, fail to execute sql: %s', sql)raise eexcept Exception, e:logging.exception('normal error, fail to execute sql: %s', sql)raise edef exec_query(self, sql, print_when_succ = True):try:self.__cursor.execute(sql)results = self.__cursor.fetchall()rowcount = self.__cursor.rowcountif True == print_when_succ:logging.info('succeed to execute query: %s, rowcount = %d', sql, rowcount)return (self.__cursor.description, results)except mysql.connector.Error, e:logging.exception('mysql connector error, fail to execute sql: %s', sql)raise eexcept Exception, e:logging.exception('normal error, fail to execute sql: %s', sql)raise edef set_parameter(cur, parameter, value):sql = """alter system set {0} = '{1}'""".format(parameter, value)logging.info(sql)cur.execute(sql)wait_parameter_sync(cur, parameter, value)def wait_parameter_sync(cur, key, value):sql = """select count(*) as cnt from oceanbase.__all_virtual_sys_parameter_statwhere name = '{0}' and value != '{1}'""".format(key, value)times = 10while times > 0:logging.info(sql)cur.execute(sql)result = cur.fetchall()if len(result) != 1 or len(result[0]) != 1:logging.exception('result cnt not match')raise eelif result[0][0] == 0:logging.info("""{0} is sync, value is {1}""".format(key, value))breakelse:logging.info("""{0} is not sync, value should be {1}""".format(key, value))times -= 1if times == 0:logging.exception("""check {0}:{1} sync timeout""".format(key, value))raise etime.sleep(5)#### --------------start : opt.py --------------

help_str = \

"""

Help:

""" +\

sys.argv[0] + """ [OPTIONS]""" +\

'\n\n' +\

'-I, --help Display this help and exit.\n' +\

'-V, --version Output version information and exit.\n' +\

'-h, --host=name Connect to host.\n' +\

'-P, --port=name Port number to use for connection.\n' +\

'-u, --user=name User for login.\n' +\

'-t, --timeout=name Cmd/Query/Inspection execute timeout(s).\n' +\

'-p, --password=name Password to use when connecting to server. If password is\n' +\

' not given it\'s empty string "".\n' +\

'-m, --module=name Modules to run. Modules should be a string combined by some of\n' +\

' the following strings: ddl, normal_dml, each_tenant_dml,\n' +\

' system_variable_dml, special_action, all. "all" represents\n' +\

' that all modules should be run. They are splitted by ",".\n' +\

' For example: -m all, or --module=ddl,normal_dml,special_action\n' +\

'-l, --log-file=name Log file path. If log file path is not given it\'s ' + os.path.splitext(sys.argv[0])[0] + '.log\n' +\

'\n\n' +\

'Maybe you want to run cmd like that:\n' +\

sys.argv[0] + ' -h 127.0.0.1 -P 3306 -u admin -p admin\n'version_str = """version 1.0.0"""class Option:__g_short_name_set = set([])__g_long_name_set = set([])__short_name = None__long_name = None__is_with_param = None__is_local_opt = None__has_value = None__value = Nonedef __init__(self, short_name, long_name, is_with_param, is_local_opt, default_value = None):if short_name in Option.__g_short_name_set:raise MyError('duplicate option short name: {0}'.format(short_name))elif long_name in Option.__g_long_name_set:raise MyError('duplicate option long name: {0}'.format(long_name))Option.__g_short_name_set.add(short_name)Option.__g_long_name_set.add(long_name)self.__short_name = short_nameself.__long_name = long_nameself.__is_with_param = is_with_paramself.__is_local_opt = is_local_optself.__has_value = Falseif None != default_value:self.set_value(default_value)def is_with_param(self):return self.__is_with_paramdef get_short_name(self):return self.__short_namedef get_long_name(self):return self.__long_namedef has_value(self):return self.__has_valuedef get_value(self):return self.__valuedef set_value(self, value):self.__value = valueself.__has_value = Truedef is_local_opt(self):return self.__is_local_optdef is_valid(self):return None != self.__short_name and None != self.__long_name and True == self.__has_value and None != self.__valueg_opts =\

[\

Option('I', 'help', False, True),\

Option('V', 'version', False, True),\

Option('h', 'host', True, False),\

Option('P', 'port', True, False),\

Option('u', 'user', True, False),\

Option('t', 'timeout', True, False, 0),\

Option('p', 'password', True, False, ''),\

# 要跑哪个模块,默认全跑

Option('m', 'module', True, False, 'all'),\

# 日志文件路径,不同脚本的main函数中中会改成不同的默认值

Option('l', 'log-file', True, False)

]\def change_opt_defult_value(opt_long_name, opt_default_val):global g_optsfor opt in g_opts:if opt.get_long_name() == opt_long_name:opt.set_value(opt_default_val)returndef has_no_local_opts():global g_optsno_local_opts = Truefor opt in g_opts:if opt.is_local_opt() and opt.has_value():no_local_opts = Falsereturn no_local_optsdef check_db_client_opts():global g_optsfor opt in g_opts:if not opt.is_local_opt() and not opt.has_value():raise MyError('option "-{0}" has not been specified, maybe you should run "{1} --help" for help'\.format(opt.get_short_name(), sys.argv[0]))def parse_option(opt_name, opt_val):global g_optsfor opt in g_opts:if opt_name in (('-' + opt.get_short_name()), ('--' + opt.get_long_name())):opt.set_value(opt_val)def parse_options(argv):global g_optsshort_opt_str = ''long_opt_list = []for opt in g_opts:if opt.is_with_param():short_opt_str += opt.get_short_name() + ':'else:short_opt_str += opt.get_short_name()for opt in g_opts:if opt.is_with_param():long_opt_list.append(opt.get_long_name() + '=')else:long_opt_list.append(opt.get_long_name())(opts, args) = getopt.getopt(argv, short_opt_str, long_opt_list)for (opt_name, opt_val) in opts:parse_option(opt_name, opt_val)if has_no_local_opts():check_db_client_opts()def deal_with_local_opt(opt):if 'help' == opt.get_long_name():global help_strprint help_strelif 'version' == opt.get_long_name():global version_strprint version_strdef deal_with_local_opts():global g_optsif has_no_local_opts():raise MyError('no local options, can not deal with local options')else:for opt in g_opts:if opt.is_local_opt() and opt.has_value():deal_with_local_opt(opt)# 只处理一个returndef get_opt_host():global g_optsfor opt in g_opts:if 'host' == opt.get_long_name():return opt.get_value()def get_opt_port():global g_optsfor opt in g_opts:if 'port' == opt.get_long_name():return opt.get_value()def get_opt_user():global g_optsfor opt in g_opts:if 'user' == opt.get_long_name():return opt.get_value()def get_opt_password():global g_optsfor opt in g_opts:if 'password' == opt.get_long_name():return opt.get_value()def get_opt_timeout():global g_optsfor opt in g_opts:if 'timeout' == opt.get_long_name():return opt.get_value()def get_opt_module():global g_optsfor opt in g_opts:if 'module' == opt.get_long_name():return opt.get_value()def get_opt_log_file():global g_optsfor opt in g_opts:if 'log-file' == opt.get_long_name():return opt.get_value()

#### ---------------end----------------------#### --------------start : do_upgrade_pre.py--------------

def config_logging_module(log_filenamme):logging.basicConfig(level=logging.INFO,\format='[%(asctime)s] %(levelname)s %(filename)s:%(lineno)d %(message)s',\datefmt='%Y-%m-%d %H:%M:%S',\filename=log_filenamme,\filemode='w')# 定义日志打印格式formatter = logging.Formatter('[%(asctime)s] %(levelname)s %(filename)s:%(lineno)d %(message)s', '%Y-%m-%d %H:%M:%S')######################################## 定义一个Handler打印INFO及以上级别的日志到sys.stdoutstdout_handler = logging.StreamHandler(sys.stdout)stdout_handler.setLevel(logging.INFO)# 设置日志打印格式stdout_handler.setFormatter(formatter)# 将定义好的stdout_handler日志handler添加到root loggerlogging.getLogger('').addHandler(stdout_handler)

#### ---------------end----------------------fail_list=[]def get_version(version_str):versions = version_str.split(".")if len(versions) != 4:logging.exception("""version:{0} is invalid""".format(version_str))raise emajor = int(versions[0])minor = int(versions[1])major_patch = int(versions[2])minor_patch = int(versions[3])if major > 0xffffffff or minor > 0xffff or major_patch > 0xff or minor_patch > 0xff:logging.exception("""version:{0} is invalid""".format(version_str))raise eversion = (major << 32) | (minor << 16) | (major_patch << 8) | (minor_patch)return version#### START ####

# 1. 检查前置版本

def check_observer_version(query_cur, upgrade_params):(desc, results) = query_cur.exec_query("""select distinct value from GV$OB_PARAMETERS where name='min_observer_version'""")if len(results) != 1:fail_list.append('min_observer_version is not sync')elif cmp(results[0][0], upgrade_params.old_version) < 0 :fail_list.append('old observer version is expected equal or higher then: {0}, actual version:{1}'.format(upgrade_params.old_version, results[0][0]))logging.info('check observer version success, version = {0}'.format(results[0][0]))def check_data_version(query_cur, input_min_cluster_version):min_cluster_version = 0sql = """select distinct value from GV$OB_PARAMETERS where name='min_observer_version'"""(desc, results) = query_cur.exec_query(sql)if len(results) != 1:fail_list.append('min_observer_version is not sync')elif len(results[0]) != 1:fail_list.append('column cnt not match')else:min_cluster_version = get_version(results[0][0])input_min_cluster_version[0] = min_cluster_version# check data versionif min_cluster_version < get_version("4.1.0.0"):# last barrier cluster version should be 4.1.0.0fail_list.append('last barrier cluster version is 4.1.0.0. prohibit cluster upgrade from cluster version less than 4.1.0.0')else:data_version_str = ''data_version = 0# check compatible is samesql = """select distinct value from oceanbase.__all_virtual_tenant_parameter_info where name='compatible'"""(desc, results) = query_cur.exec_query(sql)if len(results) != 1:fail_list.append('compatible is not sync')elif len(results[0]) != 1:fail_list.append('column cnt not match')else:data_version_str = results[0][0]data_version = get_version(results[0][0])if data_version < get_version("4.1.0.0"):# last barrier data version should be 4.1.0.0fail_list.append('last barrier data version is 4.1.0.0. prohibit cluster upgrade from data version less than 4.1.0.0')else:# check target_data_version/current_data_versionsql = "select count(*) from oceanbase.__all_tenant"(desc, results) = query_cur.exec_query(sql)if len(results) != 1 or len(results[0]) != 1:fail_list.append('result cnt not match')else:tenant_count = results[0][0]sql = "select count(*) from __all_virtual_core_table where column_name in ('target_data_version', 'current_data_version') and column_value = {0}".format(data_version)(desc, results) = query_cur.exec_query(sql)if len(results) != 1 or len(results[0]) != 1:fail_list.append('result cnt not match')elif 2 * tenant_count != results[0][0]:fail_list.append('target_data_version/current_data_version not match with {0}, tenant_cnt:{1}, result_cnt:{2}'.format(data_version_str, tenant_count, results[0][0]))else:logging.info("check data version success, all tenant's compatible/target_data_version/current_data_version is {0}".format(data_version_str))# 2. 检查paxos副本是否同步, paxos副本是否缺失

def check_paxos_replica(query_cur):# 2.1 检查paxos副本是否同步(desc, results) = query_cur.exec_query("""select count(1) as unsync_cnt from GV$OB_LOG_STAT where in_sync = 'NO'""")if results[0][0] > 0 :fail_list.append('{0} replicas unsync, please check'.format(results[0][0]))# 2.2 检查paxos副本是否有缺失 TODOlogging.info('check paxos replica success')# 3. 检查是否有做balance, locality变更

def check_rebalance_task(query_cur):# 3.1 检查是否有做locality变更(desc, results) = query_cur.exec_query("""select count(1) as cnt from DBA_OB_TENANT_JOBS where job_status='INPROGRESS' and result_code is null""")if results[0][0] > 0 :fail_list.append('{0} locality tasks is doing, please check'.format(results[0][0]))# 3.2 检查是否有做balance(desc, results) = query_cur.exec_query("""select count(1) as rebalance_task_cnt from CDB_OB_LS_REPLICA_TASKS""")if results[0][0] > 0 :fail_list.append('{0} rebalance tasks is doing, please check'.format(results[0][0]))logging.info('check rebalance task success')# 4. 检查集群状态

def check_cluster_status(query_cur, min_cluster_version):# 4.1 检查是否非合并状态(desc, results) = query_cur.exec_query("""select count(1) from CDB_OB_MAJOR_COMPACTION where (GLOBAL_BROADCAST_SCN > LAST_SCN or STATUS != 'IDLE')""")if results[0][0] > 0 :fail_list.append('{0} tenant is merging, please check'.format(results[0][0]))if len(min_cluster_version) > 0 and min_cluster_version[0] < get_version("4.2.0.0"):(desc, results) = query_cur.exec_query("""select /*+ query_timeout(1000000000) */ count(1) from __all_virtual_tablet_compaction_info where max_received_scn > finished_scn and max_received_scn > 0""")if results[0][0] > 0 :fail_list.append('{0} tablet is merging, please check'.format(results[0][0]))logging.info('check cluster tablet major status success, cluster_version={0}'.format(min_cluster_version))else:logging.info('skip check cluster tablet major status, cluster_version={0}'.format(min_cluster_version))# 5. 检查是否有异常租户(creating,延迟删除,恢复中)

def check_tenant_status(query_cur):# check tenant schema(desc, results) = query_cur.exec_query("""select count(*) as count from DBA_OB_TENANTS where status != 'NORMAL'""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('results len not match')elif 0 != results[0][0]:fail_list.append('has abnormal tenant, should stop')else:logging.info('check tenant status success')# check tenant info# don't support restore tenant upgrade(desc, results) = query_cur.exec_query("""select count(*) as count from oceanbase.__all_virtual_tenant_info where tenant_role != 'PRIMARY' and tenant_role != 'STANDBY'""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('results len not match')elif 0 != results[0][0]:fail_list.append('has abnormal tenant info, should stop')else:logging.info('check tenant info success')# 6. 检查无恢复任务

def check_restore_job_exist(query_cur):(desc, results) = query_cur.exec_query("""select count(1) from CDB_OB_RESTORE_PROGRESS""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('failed to restore job cnt')elif results[0][0] != 0:fail_list.append("""still has restore job, upgrade is not allowed temporarily""")logging.info('check restore job success')def check_is_primary_zone_distributed(primary_zone_str):semicolon_pos = len(primary_zone_str)for i in range(len(primary_zone_str)):if primary_zone_str[i] == ';':semicolon_pos = ibreakcomma_pos = len(primary_zone_str)for j in range(len(primary_zone_str)):if primary_zone_str[j] == ',':comma_pos = jbreakif comma_pos < semicolon_pos:return Trueelse:return False# 7. 升级前需要primary zone只有一个

def check_tenant_primary_zone(query_cur):sql = """select distinct value from GV$OB_PARAMETERS where name='min_observer_version'"""(desc, results) = query_cur.exec_query(sql)if len(results) != 1:fail_list.append('min_observer_version is not sync')elif len(results[0]) != 1:fail_list.append('column cnt not match')else:min_cluster_version = get_version(results[0][0])if min_cluster_version < get_version("4.1.0.0"):(desc, results) = query_cur.exec_query("""select tenant_name,primary_zone from DBA_OB_TENANTS where tenant_id != 1""");for item in results:if cmp(item[1], "RANDOM") == 0:fail_list.append('{0} tenant primary zone random before update not allowed'.format(item[0]))elif check_is_primary_zone_distributed(item[1]):fail_list.append('{0} tenant primary zone distributed before update not allowed'.format(item[0]))logging.info('check tenant primary zone success')# 8. 修改永久下线的时间,避免升级过程中缺副本

def modify_server_permanent_offline_time(cur):set_parameter(cur, 'server_permanent_offline_time', '72h')# 9. 检查是否有DDL任务在执行

def check_ddl_task_execute(query_cur):(desc, results) = query_cur.exec_query("""select count(1) from __all_virtual_ddl_task_status""")if 0 != results[0][0]:fail_list.append("There are DDL task in progress")logging.info('check ddl task execut status success')# 10. 检查无备份任务

def check_backup_job_exist(query_cur):# Backup jobs cannot be in-progress during upgrade.(desc, results) = query_cur.exec_query("""select count(1) from CDB_OB_BACKUP_JOBS""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('failed to backup job cnt')elif results[0][0] != 0:fail_list.append("""still has backup job, upgrade is not allowed temporarily""")else:logging.info('check backup job success')# 11. 检查无归档任务

def check_archive_job_exist(query_cur):min_cluster_version = 0sql = """select distinct value from GV$OB_PARAMETERS where name='min_observer_version'"""(desc, results) = query_cur.exec_query(sql)if len(results) != 1:fail_list.append('min_observer_version is not sync')elif len(results[0]) != 1:fail_list.append('column cnt not match')else:min_cluster_version = get_version(results[0][0])# Archive jobs cannot be in-progress before upgrade from 4.0.if min_cluster_version < get_version("4.1.0.0"):(desc, results) = query_cur.exec_query("""select count(1) from CDB_OB_ARCHIVELOG where status!='STOP'""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('failed to archive job cnt')elif results[0][0] != 0:fail_list.append("""still has archive job, upgrade is not allowed temporarily""")else:logging.info('check archive job success')# 12. 检查归档路径是否清空

def check_archive_dest_exist(query_cur):min_cluster_version = 0sql = """select distinct value from GV$OB_PARAMETERS where name='min_observer_version'"""(desc, results) = query_cur.exec_query(sql)if len(results) != 1:fail_list.append('min_observer_version is not sync')elif len(results[0]) != 1:fail_list.append('column cnt not match')else:min_cluster_version = get_version(results[0][0])# archive dest need to be cleaned before upgrade from 4.0.if min_cluster_version < get_version("4.1.0.0"):(desc, results) = query_cur.exec_query("""select count(1) from CDB_OB_ARCHIVE_DEST""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('failed to archive dest cnt')elif results[0][0] != 0:fail_list.append("""still has archive destination, upgrade is not allowed temporarily""")else:logging.info('check archive destination success')# 13. 检查备份路径是否清空

def check_backup_dest_exist(query_cur):min_cluster_version = 0sql = """select distinct value from GV$OB_PARAMETERS where name='min_observer_version'"""(desc, results) = query_cur.exec_query(sql)if len(results) != 1:fail_list.append('min_observer_version is not sync')elif len(results[0]) != 1:fail_list.append('column cnt not match')else:min_cluster_version = get_version(results[0][0])# backup dest need to be cleaned before upgrade from 4.0.if min_cluster_version < get_version("4.1.0.0"):(desc, results) = query_cur.exec_query("""select count(1) from CDB_OB_BACKUP_PARAMETER where name='data_backup_dest' and (value!=NULL or value!='')""")if len(results) != 1 or len(results[0]) != 1:fail_list.append('failed to data backup dest cnt')elif results[0][0] != 0:fail_list.append("""still has backup destination, upgrade is not allowed temporarily""")else:logging.info('check backup destination success')def check_server_version(query_cur):sql = """select distinct(substring_index(build_version, '_', 1)) from __all_server""";(desc, results) = query_cur.exec_query(sql);if len(results) != 1:fail_list.append("servers build_version not match")else:logging.info("check server version success")# 14. 检查server是否可服务

def check_observer_status(query_cur):(desc, results) = query_cur.exec_query("""select count(*) from oceanbase.__all_server where (start_service_time <= 0 or status != "active")""")if results[0][0] > 0 :fail_list.append('{0} observer not available , please check'.format(results[0][0]))logging.info('check observer status success')# 15 检查schema是否刷新成功

def check_schema_status(query_cur):(desc, results) = query_cur.exec_query("""select if (a.cnt = b.cnt, 1, 0) as passed from (select count(*) as cnt from oceanbase.__all_virtual_server_schema_info where refreshed_schema_version > 1 and refreshed_schema_version % 8 = 0) as a join (select count(*) as cnt from oceanbase.__all_server join oceanbase.__all_tenant) as b""")if results[0][0] != 1 :fail_list.append('{0} schema not available, please check'.format(results[0][0]))logging.info('check schema status success')# 16. 检查是否存在名为all/all_user/all_meta的租户

def check_not_supported_tenant_name(query_cur):names = ["all", "all_user", "all_meta"](desc, results) = query_cur.exec_query("""select tenant_name from oceanbase.DBA_OB_TENANTS""")for i in range(len(results)):if results[i][0].lower() in names:fail_list.append('a tenant named all/all_user/all_meta (case insensitive) cannot exist in the cluster, please rename the tenant')breaklogging.info('check special tenant name success')# last check of do_check, make sure no function execute after check_fail_list

def check_fail_list():if len(fail_list) != 0 :error_msg ="upgrade checker failed with " + str(len(fail_list)) + " reasons: " + ", ".join(['['+x+"] " for x in fail_list])raise MyError(error_msg)def set_query_timeout(query_cur, timeout):if timeout != 0:sql = """set @@session.ob_query_timeout = {0}""".format(timeout * 1000 * 1000)query_cur.exec_sql(sql)# 开始升级前的检查

def do_check(my_host, my_port, my_user, my_passwd, timeout, upgrade_params):try:conn = mysql.connector.connect(user = my_user,password = my_passwd,host = my_host,port = my_port,database = 'oceanbase',raise_on_warnings = True)conn.autocommit = Truecur = conn.cursor(buffered=True)min_cluster_version = [0]try:query_cur = Cursor(cur)set_query_timeout(query_cur, timeout)check_observer_version(query_cur, upgrade_params)check_data_version(query_cur, min_cluster_version)check_paxos_replica(query_cur)check_rebalance_task(query_cur)check_cluster_status(query_cur, min_cluster_version)check_tenant_status(query_cur)check_restore_job_exist(query_cur)check_tenant_primary_zone(query_cur)check_ddl_task_execute(query_cur)check_backup_job_exist(query_cur)check_archive_job_exist(query_cur)check_archive_dest_exist(query_cur)check_backup_dest_exist(query_cur)check_observer_status(query_cur)check_schema_status(query_cur)check_server_version(query_cur)check_not_supported_tenant_name(query_cur)# all check func should execute before check_fail_listcheck_fail_list()modify_server_permanent_offline_time(cur)except Exception, e:logging.exception('run error')raise efinally:cur.close()conn.close()except mysql.connector.Error, e:logging.exception('connection error')raise eexcept Exception, e:logging.exception('normal error')raise eif __name__ == '__main__':upgrade_params = UpgradeParams()change_opt_defult_value('log-file', upgrade_params.log_filename)parse_options(sys.argv[1:])if not has_no_local_opts():deal_with_local_opts()else:check_db_client_opts()log_filename = get_opt_log_file()upgrade_params.log_filename = log_filename# 日志配置放在这里是为了前面的操作不要覆盖掉日志文件config_logging_module(upgrade_params.log_filename)try:host = get_opt_host()port = int(get_opt_port())user = get_opt_user()password = get_opt_password()timeout = int(get_opt_timeout())logging.info('parameters from cmd: host=\"%s\", port=%s, user=\"%s\", password=\"%s\", timeout=\"%s\", log-file=\"%s\"',\host, port, user, password, timeout, log_filename)do_check(host, port, user, password, timeout, upgrade_params)except mysql.connector.Error, e:logging.exception('mysql connctor error')raise eexcept Exception, e:logging.exception('normal error')raise e

[root@sdw1 etc]#

ZONE升级过程

由于采用的是滚动升级的方法。升级任务为了保障升级接断业务的稳定性,先进行一个ZONE升级,当这个ZONE升级完成后,再进行另外一个ZONE升级。即使一个ZONE正在进行升级或者升级失败,其它ZONE依然可以提供服务,保持业务的可持续性

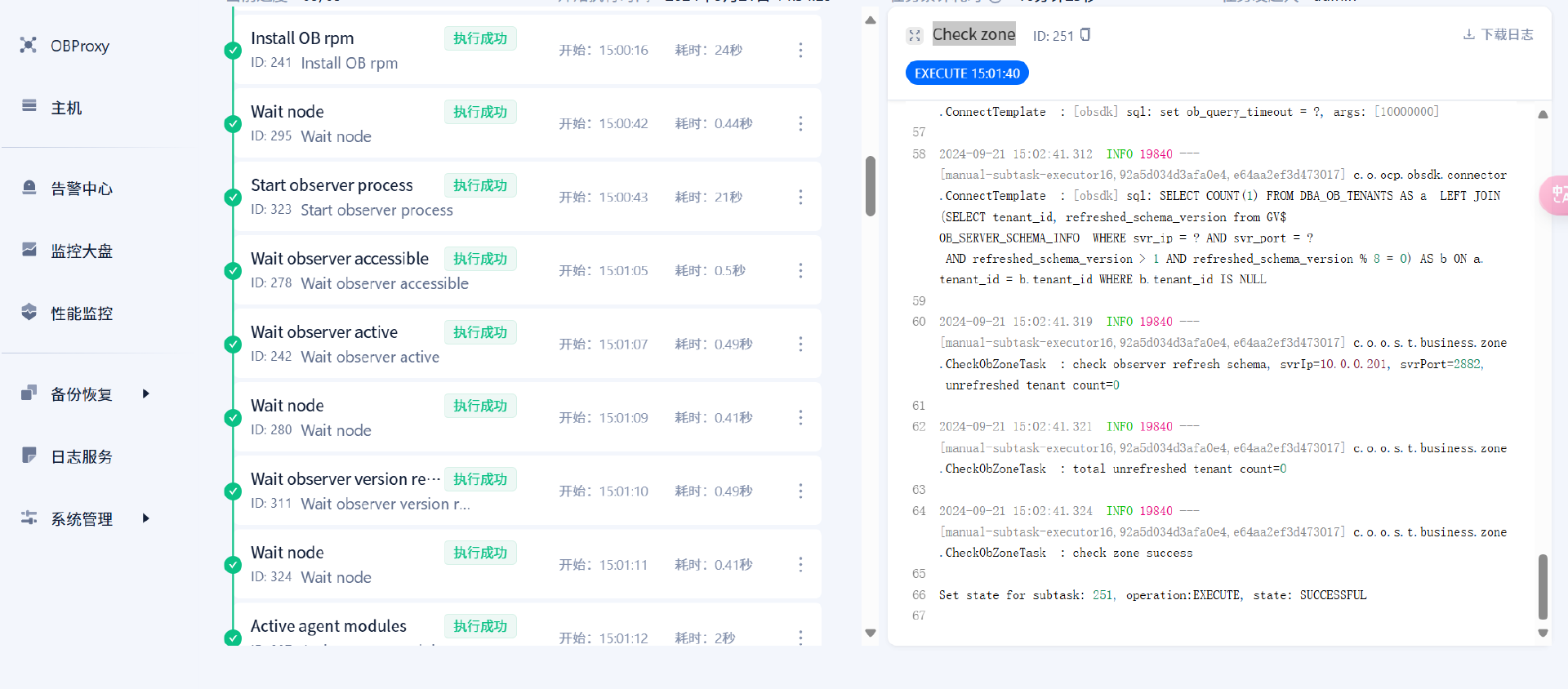

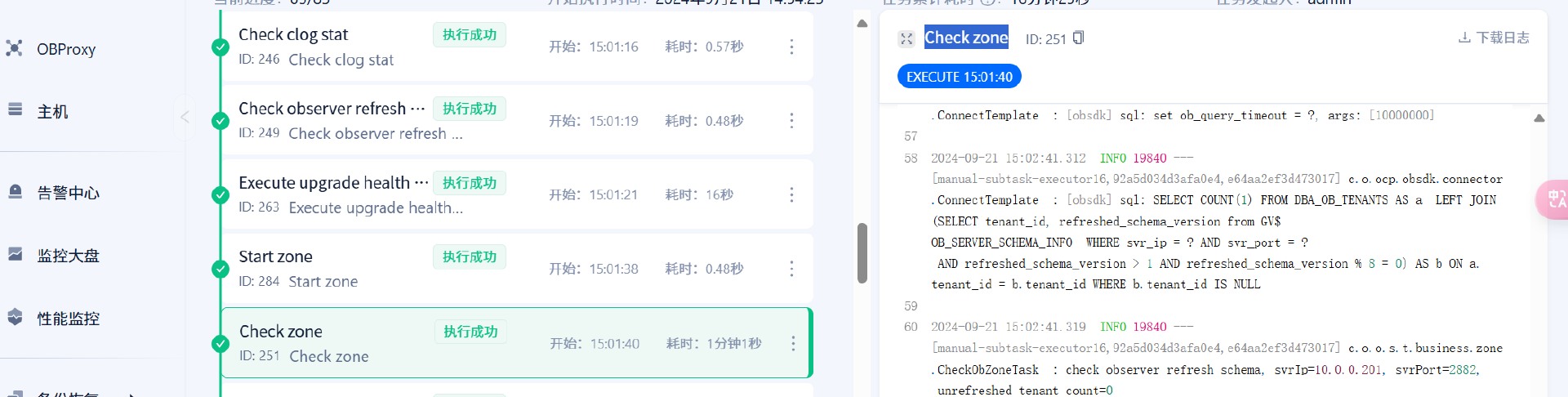

每个ZONE升级任务阶段均是以下过程:

Set zone context (开始) -> Check zone(结束)

ZONE升级任务

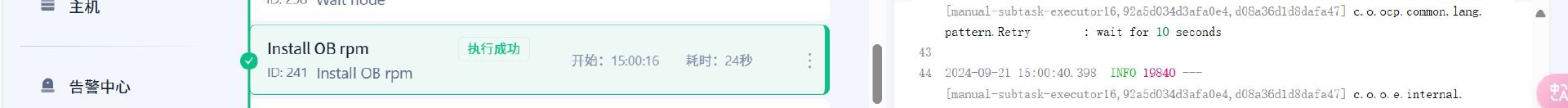

ZONE升级前会关闭该ZONE的运行状态,并且停掉observer的进程,之后下载 升级目标版本的依赖(Install dependencies) 以及 OB安装包(Install OB rpm)

依赖和安装包下载完成后,开启observer进程(Wait observer version refreshed) 以及 observer版本的刷新(Wait observer version refreshed)

observer启动成功之后,会检查 clog的状态(Check clog stat) 和 observer版本更新的情况(Check observer refresh schema) 和 集群的检查(Execute upgrade health checker script),之后开启ZONE

注意:当前zone开启成功后代表该zone已经升级成功,之后会重复以上步骤升级剩余的zone,所以升级任务的多少取决于zone以及租户的数量

查看业务情况

初始化数据完成,证明滚动升级不会对业务运行产生影响

总结

1.集群升级前会进行相应的集群检查工作,确保当前OB是否满足升级条件

2.升级任务量的多少取决于zone的多少

3.升级过程中会停止zone 与 observer ,该操作不会进行回滚,所以之前的检查任务如果出错必须查看原因,不可以进行跳过

相关文章:

OceanBase 升级过程研究(4.2.1.6-4.2.1.8)

模拟业务 使用benchmark加载10仓数据模拟业务场景 升级方法 使用滚动升级方式来进行OB升级。该方法前提是OB集群必须满足官方规定的高可用架构(如果 Zone 个数小于 3,滚动升级时则无法构成多数派), 滚动升级的原理就是轮流完成每个ZONE的升级工作,由于…...

ubuntu下怎么设置机器程序开机自启?

在 Ubuntu 中,可以通过多种方法设置程序或脚本在系统启动时自动运行。以下是几种常见方法: 方法 1:使用 crontab crontab 是一个定时任务管理工具,可以用来设置程序在开机时自动运行。 1. 打开终端,编辑当前用户的 …...

Cesium 相机系统

Cesium 的相机系统是其 3D 地球渲染引擎的重要组成部分,它控制用户在虚拟地球上的视图和交互体验。Cesium 的相机系统具备灵活性和强大的功能,允许开发者自定义视图、导航和交互方式。以下是 Cesium 相机系统的主要特点和功能: 1. 相机的基本…...

数据结构(基本概念及顺序表——c语言实现)

基本概念: 1、引入 程序数据结构算法 数据: 数值数据:能够直接参加运算的数据(数值,字符) 非数值数据:不能够直接参加运算的数据(字符串、图片等) 数据即是信息的载…...

ZYNQ程序固化——ZYNQ学习笔记7

一、ZYNQ启动过程 二、 SD卡启动实操 1、对ZYNQ进行配置添加Flash 2、添加SD卡 3、重新生成硬件信息 4、创建vitis工程文件 5、勾选板级支持包 6、对系统工程进行整体编译,生成两个Debug文件,如图所示。 7、插入SD卡,格式化为 8、考入BOOT.…...

labview使用报表工具从数据库导出数据

之前写了一篇labview从数据库导出数据到excel电子表格,但是是基于调用excel的activeX控件,有时候会有一些bug,就比如我工作机就无法显示方法,后面大哥指点才知道没有的原因是excel安装不完整。像我的工作机就没有这个选项。就需要…...

#define定义宏(2)

大家好,今天给大家分享两个技巧。 首先我们应该先了解一下c语言中字符串具有自动连接的特点。注意只有将字符串作为宏参数的时候才可以把字符串放在字符串中。 下面我们来讲讲这两个技巧 1.使用#,把一个宏参数变成对应的字符串。 2.##的作用 可以把位…...

CentOS网络配置

上一篇文章:VMware Workstation安装Centos系统 在CentOS系统中进行网络配置是确保系统能够顺畅接入网络的重要步骤。本文将详细介绍如何配置静态IP地址、网关、DNS等关键网络参数,以帮助需要的人快速掌握CentOS网络配置的基本方法和技巧。通过遵循本文的…...

基于vue框架的的网上宠物交易管理系统46sn1(程序+源码+数据库+调试部署+开发环境)带论文文档1万字以上,文末可获取,系统界面在最后面。

系统程序文件列表 项目功能:用户,宠物分类,宠物信息 开题报告内容 基于Vue框架的网上宠物交易管理系统开题报告 一、研究背景 随着互联网技术的飞速发展和人们生活水平的提高,宠物已成为许多家庭的重要成员。宠物市场的繁荣不仅体现在实体店的遍地开…...

MySQL数据库:SQL语言入门 【2】(学习笔记)

目录 2,DML —— 数据操作语言(Data Manipulation Language) (1)insert 增加 数据 (2)delete 删除 数据 truncate 删除表和数据,再创建一个新表 (3…...

MySQL深度剖析-索引原理由浅入深

什么是索引? 官方上面说索引是帮助MySQL高效获取数据的数据结构,通俗点的说,数据库索引好比是一本书的目录,可以直接根据页码找到对应的内容,目的就是为了加快数据库的查询速度。 索引是对数据库表中一列或多列的值进…...

路径规划——RRT-Connect算法

路径规划——RRT-Connect算法 算法原理 RRT-Connect算法是在RRT算法的基础上进行的扩展,引入了双树生长,分别以起点和目标点为树的根节点同时扩展随机树从而实现对状态空间的快速搜索。在此算法中以两棵随机树建立连接为路径规划成功的条件。并且&…...

数据科学与SQL:如何计算排列熵?| 基于SQL实现

目录 0 引言 1 排列熵的计算原理 2 数据准备 3 问题分析 4 小结 0 引言 把“熵”应用在系统论中的信息管理方法称为熵方法。熵越大,说明系统越混乱,携带的信息越少;熵越小,说明系统越有序,携带的信息越多。在传感…...

Redis/Codis性能瓶颈揭秘:网卡软中断的影响与优化

目录 现象回顾 问题剖析 现场分析 解决方案 总结与反思 1.调整中断亲和性(IRQ Affinity): 2.RPS(Receive Packet Steering)和 RFS(Receive Flow Steering): 近期,…...

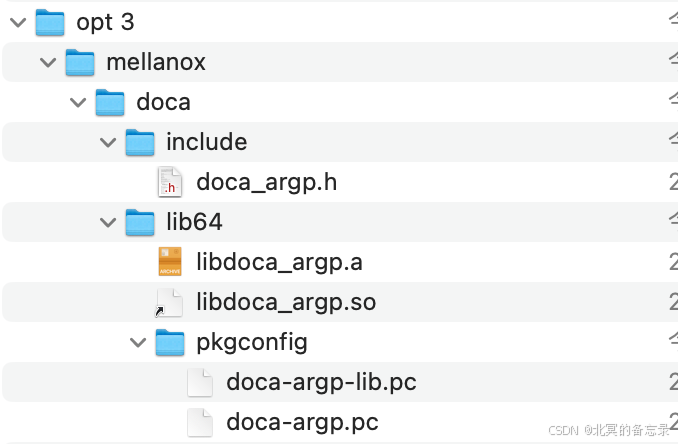

微知-DOCA ARGP参数模块的相关接口和用法(config单元、params单元,argp pipe line,回调)

文章目录 1. 背景2. 设置参数的主要流程2.1 初始化2.2 注册某个params的处理方式以及回调函数2.4 定义好前面的params以及init指定config地点后start处理argv 3. 其他4. DOCA ARGP包相关4.1 主要接口4.2 DOCA ARGP的2个rpm包4.2.1 doca-sdk-argp-2.9.0072-1.el8.x86_64.rpm4.2.…...

)

PostgreSQL高可用Patroni安装(超详细)

目录 一 安装Patroni 0 Patroni 对Python的版本要求 1 卸载原来的Python 3.6 版本 2 安装Python 3.7 之上版本 3 安装依赖 psycopg3 4 安装patroni 5 卸载 patroni 二 安装ETCD 1 使用 yum 安装 etcd 2 etcd 配置文件 3 管理 etcd 4 设置密码 5 常用命令 三 安装…...

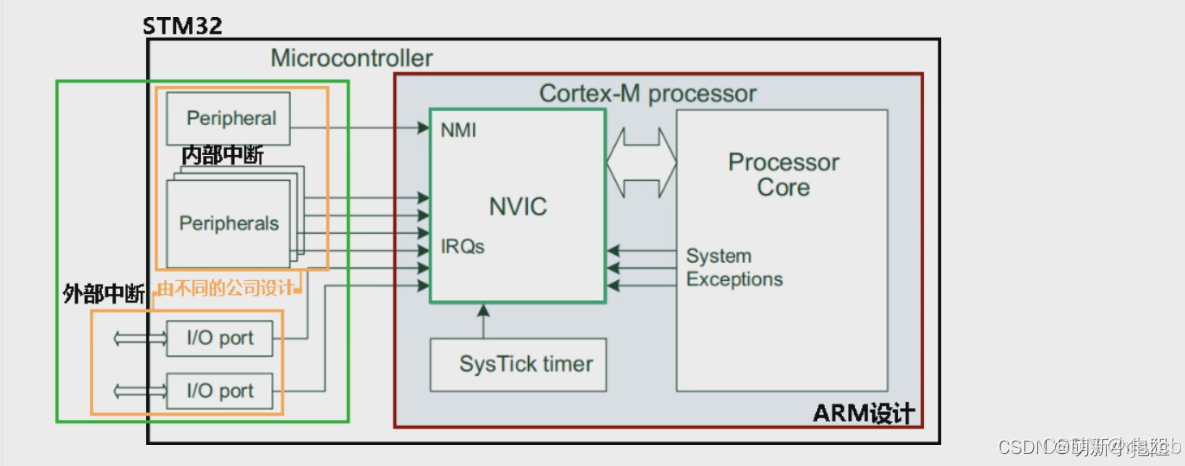

mcu之,armv7架构,contex-M4系列,时钟树,中断,IO架构(一)

写这篇文章的目的,是记录一下arm架构的32mcu,方便记忆芯片架构原理,方便我展开对,BootLoader的研究。 arm架构,时钟树,先做个记录,有空写。...

)

论文解析:基于区块链的去中心化服务选择,用于QoS感知的云制造(四区)

目录 论文解析:基于区块链的去中心化服务选择,用于QoS感知的云制造(四区) 基于区块链的去中心化云制造服务选择方法 一、核心内容概述 二、核心创新点及原理与理论 三、实验与理论分析 PBFT(实用拜占庭容错) 论文解析:基于区块链的去中心化服务选择,用于QoS感知的…...

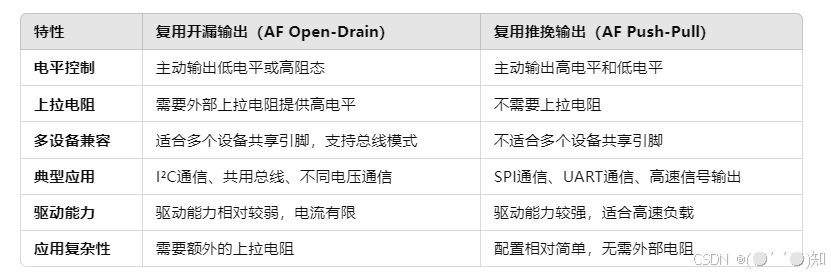

详细解析STM32 GPIO引脚的8种模式

目录 一、输入浮空(Floating Input):GPIO引脚不连接任何上拉或下拉电阻,处于高阻态 1.浮空输入的定义 2.浮空输入的特点 3.浮空输入的应用场景 4.浮空输入的缺点 5.典型配置方式 6.注意事项 二、输入上拉(Inpu…...

【hacker送书第16期】Python数据分析、挖掘与可视化、AI全能助手ChatGPT职场工作效率提升技巧与案例

解锁数据分析与AI应用的双重秘密:全面推广《Python数据分析、挖掘与可视化从入门到精通》与《AI全能助手ChatGPT职场工作效率提升技巧与案例》 前言Python数据分析、挖掘与可视化从入门到精通💕内容简介获取方式 AI全能助手ChatGPT职场工作效率提升技巧与…...

日语AI面试高效通关秘籍:专业解读与青柚面试智能助攻

在如今就业市场竞争日益激烈的背景下,越来越多的求职者将目光投向了日本及中日双语岗位。但是,一场日语面试往往让许多人感到步履维艰。你是否也曾因为面试官抛出的“刁钻问题”而心生畏惧?面对生疏的日语交流环境,即便提前恶补了…...

内存分配函数malloc kmalloc vmalloc

内存分配函数malloc kmalloc vmalloc malloc实现步骤: 1)请求大小调整:首先,malloc 需要调整用户请求的大小,以适应内部数据结构(例如,可能需要存储额外的元数据)。通常,这包括对齐调整,确保分配的内存地址满足特定硬件要求(如对齐到8字节或16字节边界)。 2)空闲…...

。】2022-5-15)

【根据当天日期输出明天的日期(需对闰年做判定)。】2022-5-15

缘由根据当天日期输出明天的日期(需对闰年做判定)。日期类型结构体如下: struct data{ int year; int month; int day;};-编程语言-CSDN问答 struct mdata{ int year; int month; int day; }mdata; int 天数(int year, int month) {switch (month){case 1: case 3:…...

[10-3]软件I2C读写MPU6050 江协科技学习笔记(16个知识点)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16...

什么?连接服务器也能可视化显示界面?:基于X11 Forwarding + CentOS + MobaXterm实战指南

文章目录 什么是X11?环境准备实战步骤1️⃣ 服务器端配置(CentOS)2️⃣ 客户端配置(MobaXterm)3️⃣ 验证X11 Forwarding4️⃣ 运行自定义GUI程序(Python示例)5️⃣ 成功效果

网络编程(UDP编程)

思维导图 UDP基础编程(单播) 1.流程图 服务器:短信的接收方 创建套接字 (socket)-----------------------------------------》有手机指定网络信息-----------------------------------------------》有号码绑定套接字 (bind)--------------…...

return this;返回的是谁

一个审批系统的示例来演示责任链模式的实现。假设公司需要处理不同金额的采购申请,不同级别的经理有不同的审批权限: // 抽象处理者:审批者 abstract class Approver {protected Approver successor; // 下一个处理者// 设置下一个处理者pub…...

20个超级好用的 CSS 动画库

分享 20 个最佳 CSS 动画库。 它们中的大多数将生成纯 CSS 代码,而不需要任何外部库。 1.Animate.css 一个开箱即用型的跨浏览器动画库,可供你在项目中使用。 2.Magic Animations CSS3 一组简单的动画,可以包含在你的网页或应用项目中。 3.An…...

在Mathematica中实现Newton-Raphson迭代的收敛时间算法(一般三次多项式)

考察一般的三次多项式,以r为参数: p[z_, r_] : z^3 (r - 1) z - r; roots[r_] : z /. Solve[p[z, r] 0, z]; 此多项式的根为: 尽管看起来这个多项式是特殊的,其实一般的三次多项式都是可以通过线性变换化为这个形式…...

JS手写代码篇----使用Promise封装AJAX请求

15、使用Promise封装AJAX请求 promise就有reject和resolve了,就不必写成功和失败的回调函数了 const BASEURL ./手写ajax/test.jsonfunction promiseAjax() {return new Promise((resolve, reject) > {const xhr new XMLHttpRequest();xhr.open("get&quo…...